系统调用

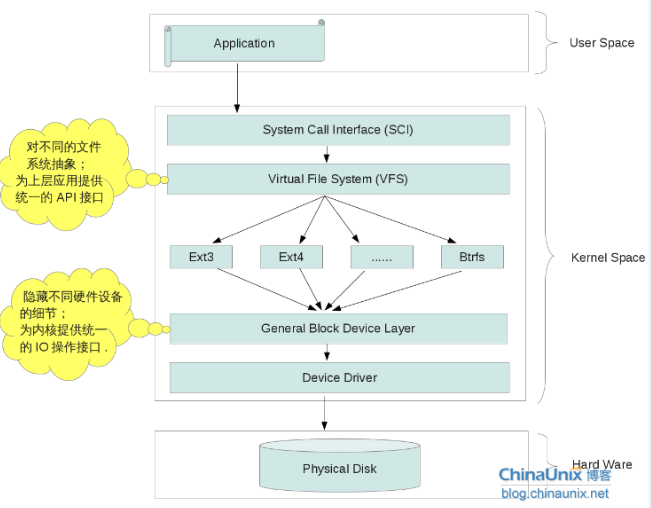

一般情况下进程不能访问内核所占内存空间也不能调用内核函数。为了和用户空间上运行的进程进行交互,内核提供了一组接口。透过该接口,应用程序可以访问硬件设备和其他操作系统资源。这组接口在应用程序和内核之间扮演了使者的角色,应用程序发送各种请求,而内核负责满足这些请求(或者让应用程序暂时搁置)。系统调用就是用户空间应用程序和内核提供的服务之间的一个接口。

系统调用在用户空间进程和硬件设备之间添加了一个中间层,其为用户空间提供了一种统一的硬件的抽象接口,保证了系统的稳定和安全,使用户程序具有可移植性。例如fork(),read(),write()等用户程序可以使用的函数都是系统调用。

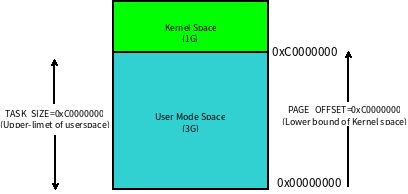

用户空间的程序无法直接执行内核代码。它们不能直接调用内核空间中的函数,因为内核驻留在受保护的地址空间上。所以,应用程序应该以某种方式通知系统,告诉内核自己需要执行一个系统调用,希望系统切换到内核态,这样内核就可以代表应用程序来执行该系统调用了。那么应用程序应该以何种方式通知系统,系统如何切换到内核态?

其实这种改变是通过软中断来实现。首先,用户程序为系统调用设置参数。其中一个参数是系统调用编号。参数设置完成后,程序执行“系统调用”指令。x86系统上的软中断由int产生。这个指令会导致一个异常:产生一个事件,这个事件会致使处理器切换到内核态并执行0x80号异常处理程序。此时的异常处理程序实际上就是系统调用处理程序,该处理程序的名字为system_call,它与硬件体系结构紧密相关。对于x86-32系统来说,该处理程序位于arch/x86/kernel/entry_32.S`文件中,代码为:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26......

ENTRY(system_call)

RING0_INT_FRAME

t miss an interrupt

TRACE_IRQS_OFF

movl TI_flags(%ebp), %ecx

testl $_TIF_ALLWORK_MASK, %ecx

jne syscall_exit_work

......

在Linux中,每个系统调用被赋予一个系统调用号。这样,通过这个独一无二的号就可以关联系统调用。当用户空间的进程执行一个系统调用的时候,这个系统调用号就被用来指明到底是要执行哪个系统调用。进程不会提及系统调用的名称。系统调用号定义文件以及形式如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14$ cat ./arch/x86/include/asm/unistd.h

1 | # cat arch/x86/include/asm/unistd_32.h |

系统调用号相当关键,一旦分配就不能再有任何变更,否则编译好的应用程序就会崩溃。Linux有一个“未实现”系统调用sys_ni_syscall(),它除了返回一ENOSYS外不做任何其他工作,这个错误号就是专门针对无效的系统调用而设的。

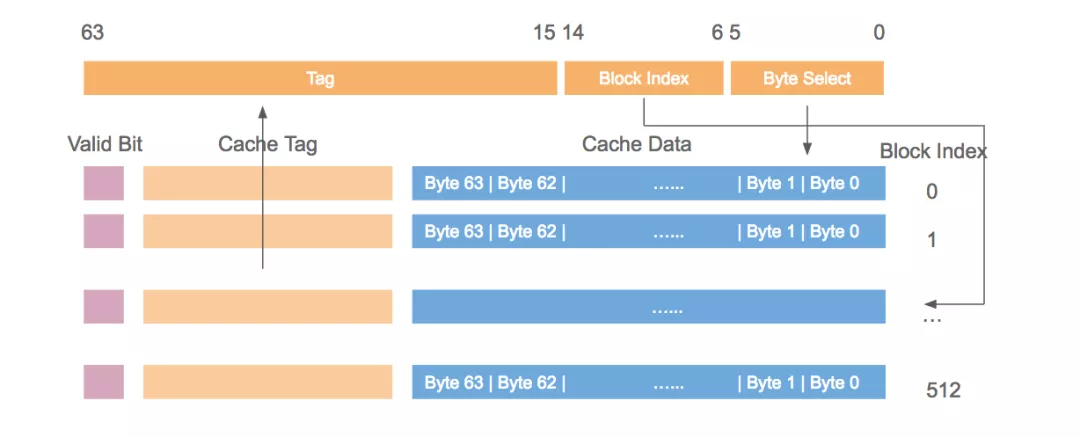

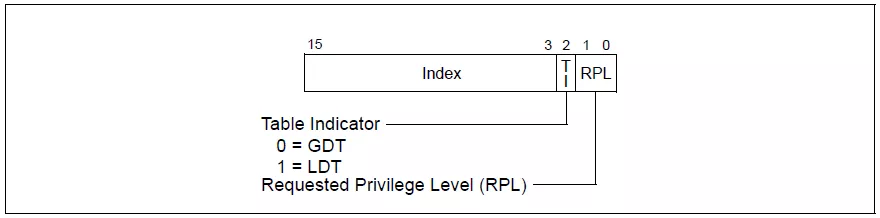

因为所有的系统调用陷入内核的方式都一样,所以仅仅是陷入内核空间是不够的。因此必须把系统调用号一并传给内核。在x86上,系统调用号是通过eax寄存器传递给内核的。在陷人内核之前,用户空间就把相应系统调用所对应的号放入eax中了。这样系统调用处理程序一旦运行,就可以从eax中得到数据。其他体系结构上的实现也都类似。

内核记录了系统调用表中的所有已注册过的系统调用的列表,存储在sys_call_table中。它与体系结构有关,32位x86一般定义在arch/x86/kernel/syscall_table_32.s文件中。这个表中为每一个有效的系统调用指定了惟一的系统调用号。sys_call_table是一张由指向实现各种系统调用的内核函数的函数指针组成的表。syscall_table_32.s文件如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26ENTRY(sys_call_table)

.long sys_restart_syscall /* 0 - old "setup()" system call, used for restarting */

.long sys_exit

.long ptregs_fork

.long sys_read

.long sys_write

.long sys_open /* 5 */

.long sys_close

.long sys_waitpid

.long sys_creat

.long sys_link

.long sys_unlink /* 10 */

.long ptregs_execve

......

.long sys_timerfd_settime /* 325 */

.long sys_timerfd_gettime

.long sys_signalfd4

.long sys_eventfd2

.long sys_epoll_create1

.long sys_dup3 /* 330 */

.long sys_pipe2

.long sys_inotify_init1

.long sys_preadv

.long sys_pwritev

.long sys_rt_tgsigqueueinfo /* 335 */

.long sys_perf_event_open

system_call()函数通过将给定的系统调用号与NR_syscalls做比较来检查其有效性。如果它大于或者等于NR syscalls,该函数就返回一ENOSYS。否则,就执行相应的系统调用。1

call *sys_call_table(,%eax, 4)

由于系统调用表中的表项是以32位(4字节)类型存放的,所以内核需要将给定的系统调用号乘以4,然后用所得的结果在该表中查询其位置。

除了系统调用号以外,大部分系统调用都还需要一些外部的参数输入。所以,在发生异常的时候,应该把这些参数从用户空间传给内核。最简单的办法就是像传递系统调用号一样把这些参数也存放在寄存器里。在x86系统上,ebx,ecx,edx,esi和edi按照顺序存放前五个参数。需要六个或六个以上参数的情况不多见,此时,应该用一个单独的寄存器存放指向所有这些参数在用户空间地址的指针。给用户空间的返回值也通过寄存器传递。在x86系统上,它存放在eax寄存器中。

下面我们看看用中断的方式如何完成系统调用功能:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

int main(int argc, const char *argv[])

{

pid_t pid;

asm volatile (

"mov $0, %%ebx\n\t"

"mov $20, %%eax\n\t" //把系统调用号20放入`eax`寄存器中,20对应于`SYS_getpid()系统调用

"int $0x80\n\t" //0x80中断

"mov %%eax, %0\n\t" //将执行结果存放在`pid`变量中

:"=m"(pid)

);

printf("int PID: %d\n", pid);

printf("api PID: %d\n", getpid());

return 0;

}

此处没有传递参数,因为getpid不需要参数。本实例执行结果为:1

2

3$ ./target_bin

int PID: 4911

api PID: 4911

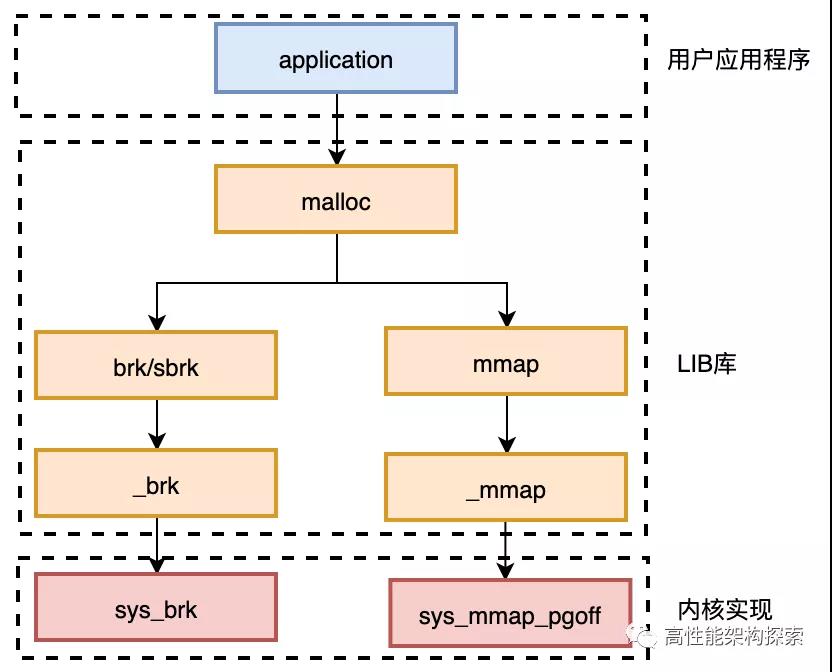

一般情况下,应用程序通过在用户空间实现的应用编程接口(API)而不是系统调用来编程。API是一个函数定义,说明了如何获得一个给定的服务,比如read()、malloc()、free()、abs()等。它有可能和系统调用形式上一致,比如read()接口就和read系统调用对应,但这种对应并非一一对应,往往会出现几种不同的API内部用到统一个系统调用,比如malloc()、free()内部利用brk()系统调用来扩大或缩小进程的堆;或一个API利用了好几个系统调用组合完成服务。更有些API甚至不需要任何系统调用——因为它不必需要内核服务,如计算整数绝对值的abs()接口。

Linux的用户编程接口遵循了在Unix世界中最流行的应用编程界面标准——POSIX标准,这套标准定义了一系列API。在Linux中(Unix也如此)这些API主要是通过C库(libc)实现的,它除了定义的一些标准的C函数外,一个很重要的任务就是提供了一套封装例程将系统调用在用户空间包装后供用户编程使用。不过封装并非必须的,如果你愿意直接调用,内核也提供了一个syscall()函数来实现调用。如下示例为使用C库调用和直接调用分别来获取当前进程ID:1

2

3

4

5

6

7

8

9

10

11

12

13

int main(int argc, const char *argv[])

{

pid_t pid, pidt;

pid = getpid();

pidt = syscall(SYS_getpid);

printf("getpid: %d\n", pid);

printf("SYS_getpid: %d\n", pidt);

return 0;

}

系统调用在内核有一个实现函数,以getpid为例,其在内核实现为:1

2

3

4

5

6

7

8

9

10

11

12

13/**

* sys_getpid - return the thread group id of the current process

*

* Note, despite the name, this returns the tgid not the pid. The tgid and

* the pid are identical unless CLONE_THREAD was specified on clone() in

* which case the tgid is the same in all threads of the same group.

*

* This is SMP safe as current->tgid does not change.

*/

SYSCALL_DEFINE0(getpid)

{

return task_tgid_vnr(current);

}

其中SYSCALL_DEFINE0为一个宏,它定义一个无参数(尾部数字代表参数个数)的系统调用,展开后代码如下:1

2

3

4asmlinkage long sys_getpid(void)

{

return current->tpid;

}

其中asmlinkage是一个编译指令,通知编译器仅从栈中提取该函数参数,所有系统调用都需要这个限定词。系统调用getpid()在内核中被定义成sys_getpid(),这是Linux所有系统调用都应该遵守的命名规则。

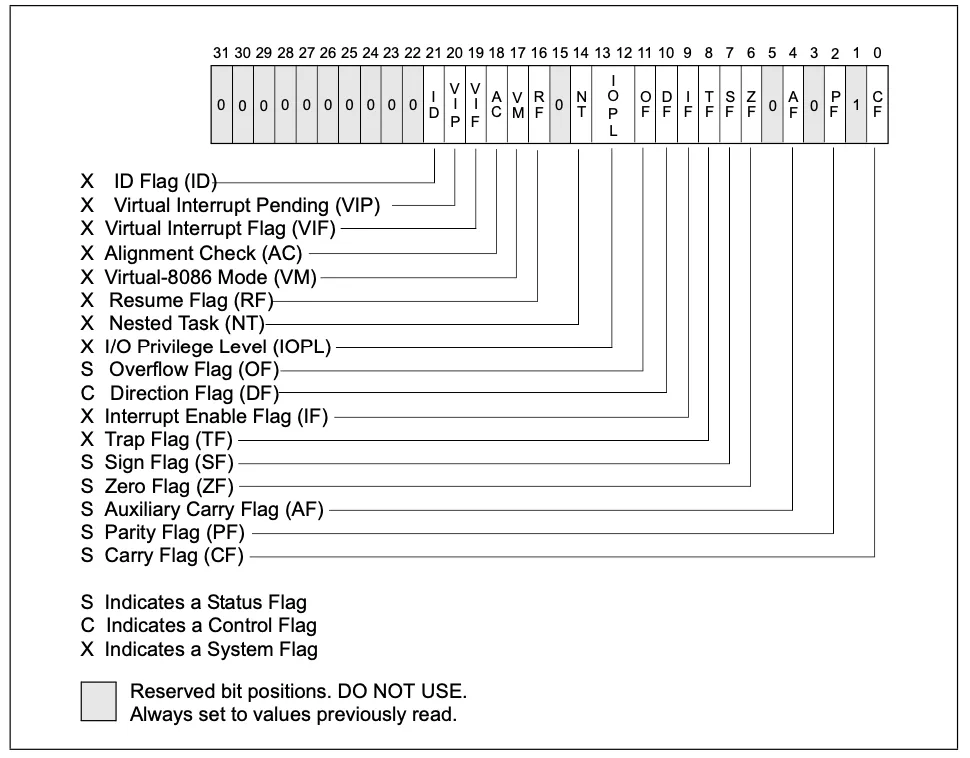

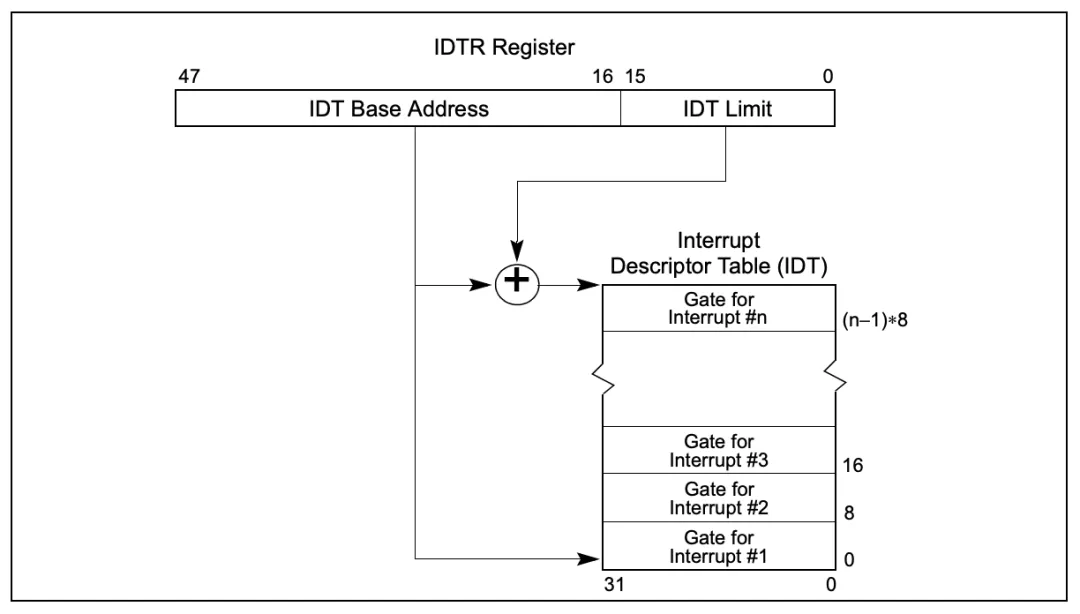

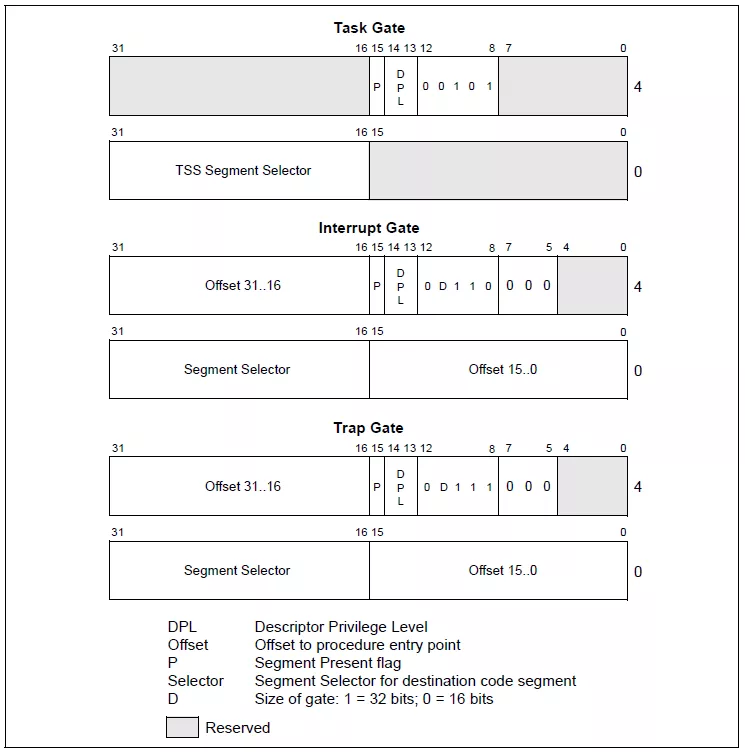

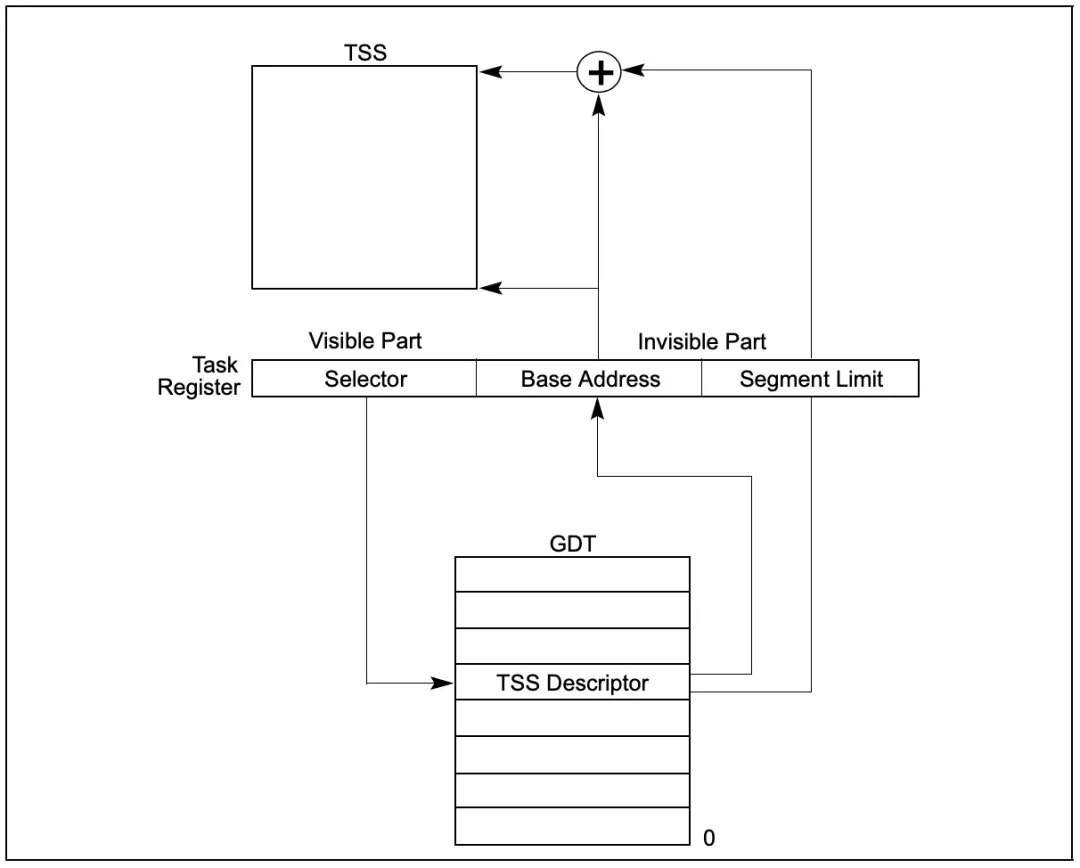

Linux中实现系统调用利用了0x86体系结构中的软件中断,也就是调用int $0x80汇编指令,这条汇编指令将产生向量为128的编程异常,此时处理器切换到内核态并执行0x80号异常处理程序。此时的异常处理程序实际上就是系统调用处理程序,该处理程序的名字为system_call(),对于x86-32系统来说,该处理程序位于arch/x86/kernel/entry_32.S文件中,使用汇编语言编写。那么所有的系统调用都会转到这里。在执行int 0x80前,系统调用号被装入eax寄存器(相应参数也会传递到其它寄存器中),这个系统调用号被用来指明到底是要执行哪个系统调用,这样系统调用处理程序一旦运行,就从eax中得到系统调用号,然后根据系统调用号在系统调用表中寻找相应服务例程(例如sys_getpid()函数)。当服务例程结束时,system_call()从eax获得系统调用的返回值,并把这个返回值存放在曾保存用户态eax寄存器栈单元的那个位置上,最后该函数再负责切换到用户空间,使用户进程继续执行。

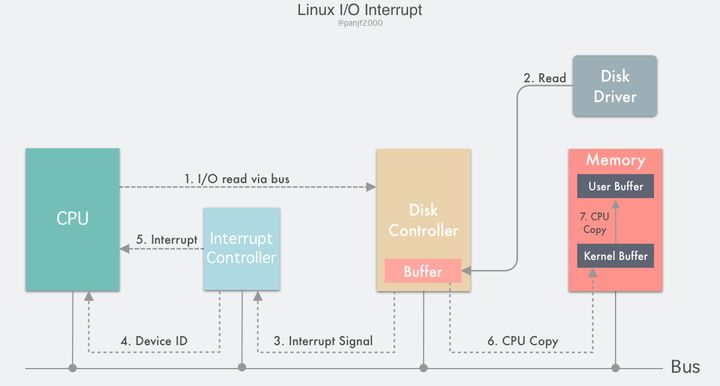

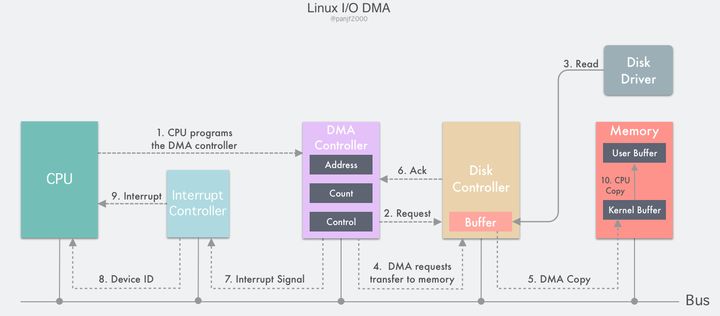

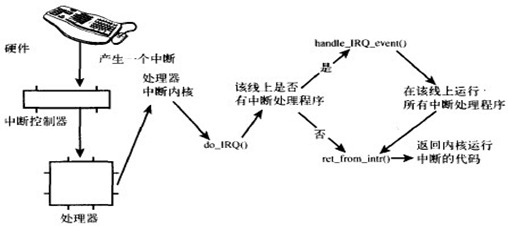

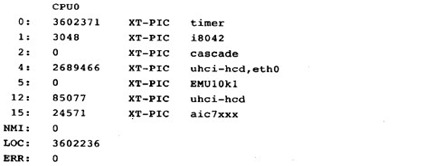

硬中断及中断处理

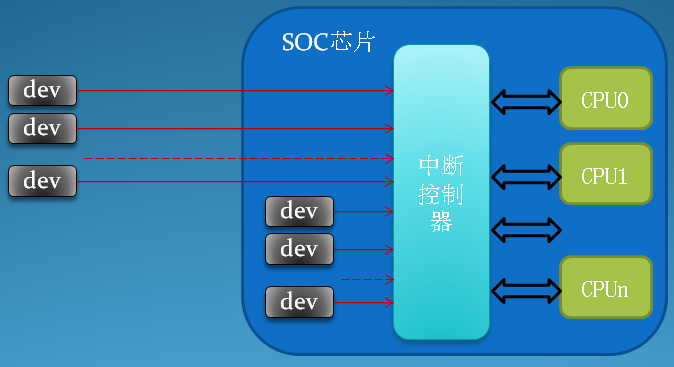

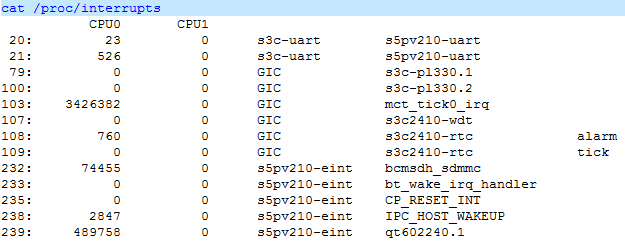

操作系统负责管理硬件设备,为了使系统和硬件设备的协同工作不降低机器性能,系统和硬件的通信使用中断的机制,也就是让硬件在需要的时候向内核发出信号,这样使得内核不用去轮询设备而导致做很多无用功。

中断使得硬件可以发出通知给处理器,硬件设备生成中断的时候并不考虑与处理器的时钟同步,中断可以随时产生。也就是说,内核随时可能因为新到来的中断而被打断。当接收到一个中断后,中断控制器会给处理器发送一个电信号,处理器检测到该信号便中断自己当前工作而处理中断。

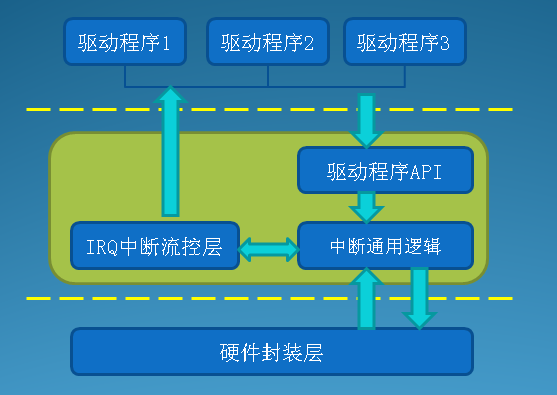

在响应一个中断时,内核会执行一个函数,该函数叫做中断处理程序或中断服务例程(ISR)。中断处理程序运行与中断上下文,中断上下文中执行的代码不可阻塞,应该快速执行,这样才能保证尽快恢复被中断的代码的执行。中断处理程序是管理硬件驱动的驱动程序的组成部分,如果设备使用中断,那么相应的驱动程序就注册一个中断处理程序。

在驱动程序中,通常使用request_irq()来注册中断处理程序。该函数在文件<include/linux/interrupt.h>中声明:1

2

3extern int __must_check

request_irq(unsigned int irq, irq_handler_t handler, unsigned long flags,

const char *name, void *dev);

第一个参数为要分配的中断号;第二个参数为指向中断处理程序的指针;第三个参数为中断处理标志。该函数实现如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82static inline int __must_check

request_irq(unsigned int irq, irq_handler_t handler, unsigned long flags,

const char *name, void *dev)

{

return request_threaded_irq(irq, handler, NULL, flags, name, dev);

}

int request_threaded_irq(unsigned int irq, irq_handler_t handler,

irq_handler_t thread_fn, unsigned long irqflags,

const char *devname, void *dev_id)

{

struct irqaction *action;

struct irq_desc *desc;

int retval;

/*

* handle_IRQ_event() always ignores IRQF_DISABLED except for

* the _first_ irqaction (sigh). That can cause oopsing, but

* the behavior is classified as "will not fix" so we need to

* start nudging drivers away from using that idiom.

*/

if ((irqflags & (IRQF_SHARED|IRQF_DISABLED)) == (IRQF_SHARED|IRQF_DISABLED)) {

pr_warning("IRQ %d/%s: IRQF_DISABLED is not guaranteed on shared IRQs\n",

irq, devname);

}

/*

* Lockdep wants atomic interrupt handlers:

*/

irqflags |= IRQF_DISABLED;

/*

* Sanity-check: shared interrupts must pass in a real dev-ID,

* otherwise we'll have trouble later trying to figure out

* which interrupt is which (messes up the interrupt freeing

* logic etc).

*/

if ((irqflags & IRQF_SHARED) && !dev_id)

return -EINVAL;

desc = irq_to_desc(irq);

if (!desc)

return -EINVAL;

if (desc->status & IRQ_NOREQUEST)

return -EINVAL;

if (!handler) {

if (!thread_fn)

return -EINVAL;

handler = irq_default_primary_handler;

}

//分配一个irqaction

action = kzalloc(sizeof(struct irqaction), GFP_KERNEL);

if (!action)

return -ENOMEM;

action->handler = handler;

action->thread_fn = thread_fn;

action->flags = irqflags;

action->name = devname;

action->dev_id = dev_id;

chip_bus_lock(irq, desc);

//将创建并初始化完在的action加入desc

retval = __setup_irq(irq, desc, action);

chip_bus_sync_unlock(irq, desc);

if (retval)

kfree(action);

if (irqflags & IRQF_SHARED) {

/*

* It's a shared IRQ -- the driver ought to be prepared for it

* to happen immediately, so let's make sure....

* We disable the irq to make sure that a 'real' IRQ doesn't

* run in parallel with our fake.

*/

unsigned long flags;

disable_irq(irq);

local_irq_save(flags);

handler(irq, dev_id);

local_irq_restore(flags);

enable_irq(irq);

}

return retval;

}

下面看一下中断处理程序的实例,以rtc驱动程序为例,代码位于<drivers/char/rtc.c>中。当RTC驱动装载时,rtc_init()函数会被调用来初始化驱动程序,包括注册中断处理函数:1

2

3

4

5

6

7

8

9

10/*

* XXX Interrupt pin #7 in Espresso is shared between RTC and

* PCI Slot 2 INTA# (and some INTx# in Slot 1).

*/

if (request_irq(rtc_irq, rtc_interrupt, IRQF_SHARED, "rtc",

(void *)&rtc_port)) {

rtc_has_irq = 0;

printk(KERN_ERR "rtc: cannot register IRQ %d\n", rtc_irq);

return -EIO;

}

处理程序函数rtc_interrupt():1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42/*

* A very tiny interrupt handler. It runs with IRQF_DISABLED set,

* but there is possibility of conflicting with the set_rtc_mmss()

* call (the rtc irq and the timer irq can easily run at the same

* time in two different CPUs). So we need to serialize

* accesses to the chip with the rtc_lock spinlock that each

* architecture should implement in the timer code.

* (See ./arch/XXXX/kernel/time.c for the set_rtc_mmss() function.)

*/

static irqreturn_t rtc_interrupt(int irq, void *dev_id)

{

/*

* Can be an alarm interrupt, update complete interrupt,

* or a periodic interrupt. We store the status in the

* low byte and the number of interrupts received since

* the last read in the remainder of rtc_irq_data.

*/

spin_lock(&rtc_lock); //保证`rtc_irq_data`不被`SMP`机器上其他处理器同时访问

rtc_irq_data += 0x100;

rtc_irq_data &= ~0xff;

if (is_hpet_enabled()) {

/*

* In this case it is HPET RTC interrupt handler

* calling us, with the interrupt information

* passed as arg1, instead of irq.

*/

rtc_irq_data |= (unsigned long)irq & 0xF0;

} else {

rtc_irq_data |= (CMOS_READ(RTC_INTR_FLAGS) & 0xF0);

}

if (rtc_status & RTC_TIMER_ON)

mod_timer(&rtc_irq_timer, jiffies + HZ/rtc_freq + 2*HZ/100);

spin_unlock(&rtc_lock);

/* Now do the rest of the actions */

spin_lock(&rtc_task_lock); //避免`rtc_callback`出现系统情况,RTC`驱动允许注册一个回调函数在每个`RTC`中断到来时执行。

if (rtc_callback)

rtc_callback->func(rtc_callback->private_data);

spin_unlock(&rtc_task_lock);

wake_up_interruptible(&rtc_wait);

kill_fasync(&rtc_async_queue, SIGIO, POLL_IN);

return IRQ_HANDLED;

}

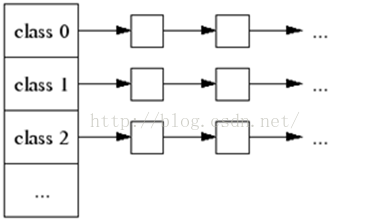

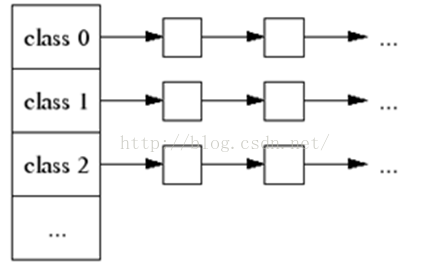

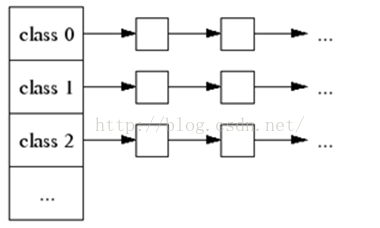

在内核中,中断的旅程开始于预定义入口点,这类似于系统调用。对于每条中断线,处理器都会跳到对应的一个唯一的位置。这样,内核就可以知道所接收中断的IRQ号了。初始入口点只是在栈中保存这个号,并存放当前寄存器的值(这些值属于被中断的任务);然后,内核调用函数do_IRQ()。从这里开始,大多数中断处理代码是用C写的。do_IRQ()的声明如下:1

unsigned int do_IRQ(struct pt_regs regs)

因为C的调用惯例是要把函数参数放在栈的顶部,因此pt_regs结构包含原始寄存器的值,这些值是以前在汇编入口例程中保存在栈上的。中断的值也会得以保存,所以,do_IRQ()可以将它提取出来,X86的代码为:1

int irq = regs.orig_eax & 0xff

计算出中断号后,do_IRQ()对所接收的中断进行应答,禁止这条线上的中断传递。在普通的PC机器上,这些操作是由mask_and_ack_8259A()来完成的,该函数由do_IRQ()调用。接下来,do_IRQ()需要确保在这条中断线上有一个有效的处理程序,而且这个程序已经启动但是当前没有执行。如果这样的话,do_IRQ()就调用handle_IRQ_event()来运行为这条中断线所安装的中断处理程序,函数位于<kernel/irq/handle.c>:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70/**

* handle_IRQ_event - irq action chain handler

* @irq: the interrupt number

* @action: the interrupt action chain for this irq

*

* Handles the action chain of an irq event

*/

irqreturn_t handle_IRQ_event(unsigned int irq, struct irqaction *action)

{

irqreturn_t ret, retval = IRQ_NONE;

unsigned int status = 0;

//如果没有设置`IRQF_DISABLED,将CPU中断打开,应该尽量避免中断关闭情况,本地中断关闭情况下会导致中断丢失。

if (!(action->flags & IRQF_DISABLED))

local_irq_enable_in_hardirq();

do { //遍历运行中断处理程序

trace_irq_handler_entry(irq, action);

ret = action->handler(irq, action->dev_id);

trace_irq_handler_exit(irq, action, ret);

switch (ret) {

case IRQ_WAKE_THREAD:

/*

* Set result to handled so the spurious check

* does not trigger.

*/

ret = IRQ_HANDLED;

/*

* Catch drivers which return WAKE_THREAD but

* did not set up a thread function

*/

if (unlikely(!action->thread_fn)) {

warn_no_thread(irq, action);

break;

}

/*

* Wake up the handler thread for this

* action. In case the thread crashed and was

* killed we just pretend that we handled the

* interrupt. The hardirq handler above has

* disabled the device interrupt, so no irq

* storm is lurking.

*/

if (likely(!test_bit(IRQTF_DIED,

&action->thread_flags))) {

set_bit(IRQTF_RUNTHREAD, &action->thread_flags);

wake_up_process(action->thread);

}

/* Fall through to add to randomness */

case IRQ_HANDLED:

status |= action->flags;

break;

default:

break;

}

retval |= ret;

action = action->next;

} while (action);

if (status & IRQF_SAMPLE_RANDOM)

add_interrupt_randomness(irq);

local_irq_disable();//关中断

return retval;

}

前面说到中断应该尽快执行完,以保证被中断代码可以尽快的恢复执行。但事实上中断通常有很多工作要做,包括应答、重设硬件、数据拷贝、处理请求、发送请求等。为了求得平衡,内核把中断处理工作分成两半,中断处理程序是上半部——接收到中断就开始执行。能够稍后完成的工作推迟到下半部操作,下半部在合适的时机被开中段执行。例如网卡收到数据包时立即发出中断,内核执行网卡已注册的中断处理程序,此处工作就是通知硬件拷贝最新的网络数据包到内存,然后将控制权交换给系统之前被中断的任务,其他的如处理和操作数据包等任务被放到随后的下半部中去执行。下一节我们将了解中断处理的下半部。

下半部机制之软中断

中断处理程序以异步方式执行,其会打断其他重要代码,其运行时该中断同级的其他中断会被屏蔽,并且当前处理器上所有其他中断都有可能会被屏蔽掉,还有中断处理程序不能阻塞,所以中断处理需要尽快结束。由于中断处理程序的这些缺陷,导致了中断处理程序只是整个硬件中断处理流程的一部分,对于那些对时间要求不高的任务,留给中断处理流程的另外一部分,也就是本节要讲的中断处理流程的下半部。

那哪些工作由中断处理程序完成,哪些工作留给下半部来执行呢?其实上半部和下半部的工作划分不存在某种严格限制,这主要取决于驱动程序开发者自己的判断,一般最好能将中断处理程序执行时间缩短到最小。中断处理程序几乎都需要通过操作硬件对中断的到达进行确认,有时还会做对时间非常敏感的工作(如拷贝数据),其余的工作基本上留给下半部来处理,下半部就是执行与中断处理密切相关但中断处理程序本身不执行的工作。一般对时间非常敏感、和硬件相关、要保证不被其它中断(特别是相同的中断)打断的这些任务放在中断处理程序中执行,其他任务考虑放在下半部执行。

那下半部什么时候执行呢?下半部不需要指定明确执行时间,只要把任务推迟一点,让它们在系统不太忙且中断恢复后执行就可以了,而且执行期间可以相应所有中断。

上半部只能通过中断处理程序实现,而下半部可以有多种机制来实现,在2.6.32版本中,有三种不同形式的下半部实现机制:软中断、tasklet、工作队列。下面来看一下这三种下半部的实现。

软中断

在start_kernerl()函数中,系统初始化软中断。1

2

3

4

5

6

7

8

9

10

11

12

13asmlinkage void __init start_kernel(void)

{

char * command_line;

extern struct kernel_param __start___param[], __stop___param[];

smp_setup_processor_id();

......

softirq_init();//初始化软中断

......

/* Do the rest non-__init'ed, we're now alive */

rest_init();

}

在softirq_init()中会注册两个常用类型的软中断,具体代码如下(位于kernel/softirq.c):1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21void __init softirq_init(void)

{

int cpu;

for_each_possible_cpu(cpu) {

int i;

per_cpu(tasklet_vec, cpu).tail =

&per_cpu(tasklet_vec, cpu).head;

per_cpu(tasklet_hi_vec, cpu).tail =

&per_cpu(tasklet_hi_vec, cpu).head;

for (i = 0; i < NR_SOFTIRQS; i++)

INIT_LIST_HEAD(&per_cpu(softirq_work_list[i], cpu));

}

register_hotcpu_notifier(&remote_softirq_cpu_notifier);

//此处注册两个软中断

open_softirq(TASKLET_SOFTIRQ, tasklet_action);

open_softirq(HI_SOFTIRQ, tasklet_hi_action);

}

注册函数open_softirq()参数含义:

nr:软中断类型action:软中断处理函数

1 | void open_softirq(int nr, void (*action)(struct softirq_action *)) |

softirq_action结构表示软中断,定义在<include/linux/interrupt.h>1

2

3

4struct softirq_action

{

void (*action)(struct softirq_action *);

}

文件<kernel/softirq.c>中定义了32个该结构体的数组:1

static struct softirq_action softirq_vec[NR_SOFTIRQS] __cacheline_aligned_in_smp;

每注册一个软中断都会占该数组一个位置,因此系统中最多有32个软中断。从上面的代码中,我们可以看到open_softirq()中。其实就是对softirq_vec数组的nr项赋值。softirq_vec是一个32元素的数组,实际上Linux内核只使用了几项:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21/* PLEASE, avoid to allocate new softirqs, if you need not _really_ high

frequency threaded job scheduling. For almost all the purposes

tasklets are more than enough. F.e. all serial device BHs et

al. should be converted to tasklets, not to softirqs.

*/

enum

{

HI_SOFTIRQ=0,

TIMER_SOFTIRQ,

NET_TX_SOFTIRQ,

NET_RX_SOFTIRQ,

BLOCK_SOFTIRQ,

BLOCK_IOPOLL_SOFTIRQ,

TASKLET_SOFTIRQ,

SCHED_SOFTIRQ,

HRTIMER_SOFTIRQ,

RCU_SOFTIRQ, /* Preferable RCU should always be the last softirq */

NR_SOFTIRQS

};

那么软中断注册完成之后,什么时候触发软中断处理函数执行呢?通常情况下,软中断会在中断处理程序返回前标记它,使其在稍后合适的时候被执行。在下列地方,待处理的软中断会被检查和执行:

- 处理完一个硬件中断以后;

- 在

ksoftirqd内核线程中; - 在那些显示检查和执行待处理的软中断的代码中,如网络子系统中。

无论如何,软中断会在do_softirq()(位于<kernel/softirq.c>中)中执行,如果有待处理的软中断,do_softirq会循环遍历每一个,调用他们的软中断处理程序。1

2

3

4

5

6

7

8

9

10

11

12

13asmlinkage void do_softirq(void) {

__u32 pending;

unsigned long flags;

//如果在硬件中断环境中就退出,软中断不可以在硬件中断上下文或者是在软中断环境中使用,使用`in_interrupt()来防止软中断嵌套,和抢占硬中断环境。

if (in_interrupt())

return; //禁止本地中断

local_irq_save(flags);

pending = local_softirq_pending();

//如果有软中断要处理,则进入__do_softirq()

if (pending)

__do_softirq();

local_irq_restore(flags);

}

下面看一下__do_softirq()的实现:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59asmlinkage void __do_softirq(void)

{

struct softirq_action *h;

__u32 pending;

int max_restart = MAX_SOFTIRQ_RESTART;

int cpu;

pending = local_softirq_pending(); //pending`用于保留待处理软中断32位位图

account_system_vtime(current);

__local_bh_disable((unsigned long)__builtin_return_address(0));

lockdep_softirq_enter();

cpu = smp_processor_id();

restart:

/* Reset the pending bitmask before enabling irqs */

set_softirq_pending(0);

local_irq_enable();

h = softirq_vec;

do {

if (pending & 1) { //如果`pending`第`n`位被设置为1,那么处理第`n`位对应类型的软中断

int prev_count = preempt_count();

kstat_incr_softirqs_this_cpu(h - softirq_vec);

trace_softirq_entry(h, softirq_vec);

h->action(h); //执行软中断处理函数

trace_softirq_exit(h, softirq_vec);

if (unlikely(prev_count != preempt_count())) {

printk(KERN_ERR "huh, entered softirq %td %s %p"

"with preempt_count %08x,"

" exited with %08x?\n", h - softirq_vec,

softirq_to_name[h - softirq_vec],

h->action, prev_count, preempt_count());

preempt_count() = prev_count;

}

rcu_bh_qs(cpu);

}

h++;

pending >>= 1; //pending`右移一位,循环检查其每一位

} while (pending); //直到`pending`变为0,pending`最多32位,所以循环最多执行32次。

local_irq_disable();

pending = local_softirq_pending();

if (pending && --max_restart)

goto restart;

if (pending)

wakeup_softirqd();

lockdep_softirq_exit();

account_system_vtime(current);

_local_bh_enable();

}

使用软中断必须要在编译期间静态注册,一般只有像网络这样对性能要求高的情况才使用软中断,文章前面我们也看到,系统中注册的软中断就那么几个。大部分时候,使用下半部另外一种机制tasklet的情况更多一些,tasklet可以动态的注册,可以被看作是一种性能和易用性之间寻求平衡的一种产物。事实上,大部分驱动程序都是用tasklet来实现他们的下半部。

下半部机制之tasklet

tasklet是利用软中断实现的一种下半部机制。tasklet相比于软中断,其接口更加简单方便,锁保护要求较低。tasklet由tasklet_struct结构体表示:1

2

3

4

5

6

7

8struct tasklet_struct

{

struct tasklet_struct *next; //链表中下一个tasklet

unsigned long state; //tasklet状态

atomic_t count; //引用计数

void (*func)(unsigned long); //tasklet处理函数

unsigned long data; //给tasklet处理函数的参数

};

tasklet还分为了高优先级tasklet与一般tasklet,前面分析软中断时softirq_init()注册的两个tasklet软中断。1

2

3

4

5

6

7

8void __init softirq_init(void)

{

......

//此处注册两个软中断

open_softirq(TASKLET_SOFTIRQ, tasklet_action);

open_softirq(HI_SOFTIRQ, tasklet_hi_action);

......

}

其处理函数分别为tasklet_action()和tasklet_hi_action()。

tasklet_action()函数实现为:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35static void tasklet_action(struct softirq_action *a)

{

struct tasklet_struct *list;

local_irq_disable();

list = __get_cpu_var(tasklet_vec).head;

__get_cpu_var(tasklet_vec).head = NULL;

__get_cpu_var(tasklet_vec).tail = &__get_cpu_var(tasklet_vec).head;

local_irq_enable();

while (list) {

struct tasklet_struct *t = list;

list = list->next;

if (tasklet_trylock(t)) {

if (!atomic_read(&t->count)) { //t->count`为零才会调用`task_struct`里的函数

if (!test_and_clear_bit(TASKLET_STATE_SCHED, &t->state))

BUG();

t->func(t->data); //设置了`TASKLET_STATE_SCHED`标志才会被遍历到链表上对应的函数

tasklet_unlock(t);

continue;

}

tasklet_unlock(t);

}

local_irq_disable();

t->next = NULL;

*__get_cpu_var(tasklet_vec).tail = t;

__get_cpu_var(tasklet_vec).tail = &(t->next);

__raise_softirq_irqoff(TASKLET_SOFTIRQ);

local_irq_enable();

}

}

tasklet_hi_action函数实现类似1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34static void tasklet_hi_action(struct softirq_action *a)

{

struct tasklet_struct *list;

local_irq_disable();

list = __get_cpu_var(tasklet_hi_vec).head;

__get_cpu_var(tasklet_hi_vec).head = NULL;

__get_cpu_var(tasklet_hi_vec).tail = &__get_cpu_var(tasklet_hi_vec).head;

local_irq_enable();

while (list) {

struct tasklet_struct *t = list;

list = list->next;

if (tasklet_trylock(t)) {

if (!atomic_read(&t->count)) {

if (!test_and_clear_bit(TASKLET_STATE_SCHED, &t->state))

BUG();

t->func(t->data);

tasklet_unlock(t);

continue;

}

tasklet_unlock(t);

}

local_irq_disable();

t->next = NULL;

*__get_cpu_var(tasklet_hi_vec).tail = t;

__get_cpu_var(tasklet_hi_vec).tail = &(t->next);

__raise_softirq_irqoff(HI_SOFTIRQ);

local_irq_enable();

}

}

这两个函数主要是做了如下动作:

- 禁止中断,并为当前处理器检索

tasklet_vec或tasklet_hi_vec链表。 - 将当前处理器上的该链表设置为`NULL,达到清空的效果。

- 运行相应中断。

- 循环遍历获得链表上的每一个待处理的`tasklet。

- 如果是多处理器系统,通过检查

TASKLET_STATE_RUN来判断这个tasklet是否正在其他处理器上运行。如果它正在运行,那么现在就不要执行,跳到下一个待处理的tasklet去。 - 如果当前这个

tasklet没有执行,将其状态设置为TASKLETLET_STATE_RUN,这样别的处理器就不会再去执行它了。 - 检查

count值是否为0,确保tasklet没有被禁止。如果tasklet被禁止,则跳到下一个挂起的tasklet去。 - 现在可以确定这个

tasklet没有在其他地方执行,并且被我们设置为执行状态,这样它在其他部分就不会被执行,并且引用计数器为0,现在可以执行tasklet的处理程序了。 - 重复执行下一个

tasklet,直至没有剩余的等待处理的tasklets。

一般情况下,都是用tasklet来实现下半部,tasklet可以动态创建、使用方便、执行速度快。下面来看一下如何创建自己的tasklet呢?

第一步,声明自己的tasklet。既可以静态也可以动态创建,这取决于选择是想有一个对tasklet的直接引用还是间接引用。静态创建方法(直接引用),可以使用下列两个宏的一个(在Linux/interrupt.h中定义):1

2DECLARE_TASKLET(name,func,data)

DECLARE_TASKLET_DISABLED(name,func,data)

这两个宏的实现为:1

2

3

4

5

这两个宏之间的区别在于引用计数器的初始值不同,前面一个把创建的tasklet的引用计数器设置为0,使其处于激活状态,另外一个将其设置为1,处于禁止状态。而动态创建(间接引用)的方式如下:1

tasklet_init(t,tasklet_handler,dev);

其实现代码为:1

2

3

4

5

6

7

8

9void tasklet_init(struct tasklet_struct *t,

void (*func)(unsigned long), unsigned long data)

{

t->next = NULL;

t->state = 0;

atomic_set(&t->count, 0);

t->func = func;

t->data = data;

}

第二步,编写tasklet处理程序。tasklet处理函数类型是void tasklet_handler(unsigned long data)。因为是靠软中断实现,所以tasklet不能休眠,也就是说不能在tasklet中使用信号量或者其他什么阻塞式的函数。由于tasklet运行时允许响应中断,所以必须做好预防工作,如果新加入的tasklet和中断处理程序之间共享了某些数据额的话。两个相同的tasklet绝不能同时执行,如果新加入的tasklet和其他的tasklet或者软中断共享了数据,就必须要进行适当地锁保护。

第三步,调度自己的tasklet。调用tasklet_schedule()(或tasklet_hi_schedule())函数,tasklet就会进入挂起状态以便执行。如果在还没有得到运行机会之前,如果有一个相同的tasklet又被调度了,那么它仍然只会运行一次。如果这时已经开始运行,那么这个新的tasklet会被重新调度并再次运行。一种优化策略是一个tasklet总在调度它的处理器上执行。

调用tasklet_disable()来禁止某个指定的tasklet,如果该tasklet当前正在执行,这个函数会等到它执行完毕再返回。调用tasklet_disable_nosync()也是来禁止的,只是不用在返回前等待tasklet执行完毕,这么做不太安全,因为没法估计该tasklet是否仍在执行。tasklet_enable()激活一个tasklet。可以使用tasklet_kill()函数从挂起的对列中去掉一个tasklet。这个函数会首先等待该tasklet执行完毕,然后再将其移去。当然,没有什么可以阻止其他地方的代码重新调度该tasklet。由于该函数可能会引起休眠,所以禁止在中断上下文中使用它。

下面来看一下函数tasklet_schedule的实现:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24static inline void tasklet_schedule(struct tasklet_struct *t)

{

//检查tasklet的状态是否为TASKLET_STATE_SCHED.如果是,说明tasklet已经被调度过了,函数返回。

if (!test_and_set_bit(TASKLET_STATE_SCHED, &t->state))

__tasklet_schedule(t);

}

void __tasklet_schedule(struct tasklet_struct *t)

{

unsigned long flags;

//保存中断状态,然后禁止本地中断。在执行tasklet代码时,这么做能够保证处理器上的数据不会弄乱。

local_irq_save(flags);

//把需要调度的tasklet加到每个处理器一个的tasklet_vec链表或task_hi_vec链表的表头上去。

t->next = NULL; *__get_cpu_var(tasklet_vec).tail = t;

__get_cpu_var(tasklet_vec).tail = &(t->next);

//唤起TASKLET_SOFTIRQ或HI_SOFTIRQ软中断,这样在下一次调用do_softirq()时就会执行该tasklet。

raise_softirq_irqoff(TASKLET_SOFTIRQ);

//恢复中断到原状态并返回。

local_irq_restore(flags);

}

tasklet_hi_schedule()函数的实现细节类似。

对于软中断,内核会选择几个特殊的实际进行处理(常见的是中 断处理程序返回时)。软中断被触发的频率有时会很好,而且还可能会自行重复触发,这带来的结果就是用户空间的进程无法获得足够的处理器时间,因为处于饥饿 状态。同时,如果单纯的对重复触发的软中断采取不立即处理的策略也是无法接受的。

内核选中的方案是不会立即处理重新触发的软中断,作为改进,当大量软中断出现的时候,内核会唤醒一组内核线程来处理这些负载。这些线程在最低优先级上运行(nice值为19)。这种这种方案能够保证在软中断负担很 重的时候用户程序不会因为得不到处理时间而处理饥饿状态。相应的,也能保证“过量”的软中断终究会得到处理。最后,在空闲系统上,这个方案同样表现良好,软中断处理得非常迅速(因为仅存的内存线程肯定会马上调度)。为了保证只要有空闲的处理器,它们就会处理软中断,所以给每个处理器都分配一个这样的线程。 所有线程的名字都叫做ksoftirad/n,区别在于n,它对应的是处理器的编号。一旦该线程被初始化,它就会执行类似下面这样的死循环:1

2

3

4

5

6

7

8

9

10

11

12

13for(;;){

if(!softirq_pending(cpu))//softirq_pending()负责发现是否有待处理的软中断

schedule(); //没有待处理软中断就唤起调度程序选择其他可执行进程投入运行

set_current_state(TASK_RUNNING);

while(softirq_pending(cpu)){

do_softirq();//有待处理的软中断,ksoftirq调用do_softirq()去处理他。

if(need_resched()) //如果有必要的话,每次软中断完成之后调用schedule函数让其他重要进程得到处理机会

schedule();

}

//当所有需要执行的操作都完成以后,该内核线程将自己设置为 TASK_INTERRUPTIBLE状态

set_current_state(TASK_INTERRUPTIBLE);

}

下半部机制之工作队列及几种机制的选择

工作队列是下半部的另外一种将工作推后执行形式。和软中断、tasklet不同,工作队列将工作推后交由一个内核线程去执行,并且该下半部总会在进程上下文中执行。这样,工作队列允许重新调度甚至是睡眠。

所以,如果推后执行的任务需要睡眠,就选择工作队列。如果不需要睡眠,那就选择软中断或`tasklet。工作队列是唯一能在进程上下文中运行的下半部实现机制,也只有它才可以睡眠。

工作队列子系统是一个用于创建内核线程的接口,通过它创建的进程负责执行由内核其他部分排到队列里的任务。它创建的这些内核线程称作工作者线程。工作队列可以让你的驱动程序创建一个专门的工作者线程来处理需要推后的工作。不过,工作队列子系统提供了一个缺省的工作者线程来处理这些工作。因此,工作队列最基本的表现形式就转变成一个把需要推后执行的任务交给特定的通用线程这样一种接口。缺省的工作线程叫做event/n。每个处理器对应一个线程,这里的n代表了处理器编号。除非一个驱动程序或者子系统必须建立一个属于自己的内核线程,否则最好还是使用缺省线程。

使用下面命令可以看到默认event工作者线程,每个处理器对应一个线程:1

2

3# ps x | grep event | grep -v grep

9 ? S 0:00 [events/0]

10 ? S 0:00 [events/1]

工作者线程使用workqueue_struct结构表示(位于<kernel/workqueue.c>中):1

2

3

4

5

6

7

8

9

10

11struct workqueue_struct {

struct cpu_workqueue_struct *cpu_wq; //该数组每一项对应系统中的一个处理器

struct list_head list;

const char *name;

int singlethread;

int freezeable; /* Freeze threads during suspend */

int rt;

struct lockdep_map lockdep_map;

}

每个处理器,每个工作者线程对应对应一个cpu_workqueue_struct结构体(位于<kernel/workqueue.c>中):1

2

3

4

5

6

7

8

9

10struct cpu_workqueue_struct {

spinlock_t lock; //保护该结构

struct list_head worklist; //工作列表

wait_queue_head_t more_work; //等待队列,其中的工作者线程因等待而处于睡眠状态

struct work_struct *current_work;

struct workqueue_struct *wq; //关联工作队列结构

struct task_struct *thread; // 关联线程,指向结构中工作者线程的进程描述符指针

} ____cacheline_aligned;

每个工作者线程类型关联一个自己的workqueue_struct,在该结构体里面,给每个线程分配一个cpu_workqueue_struct,因而也就是给每个处理器分配一个,因为每个处理器都有一个该类型的工作者线程。

所有的工作者线程都是使用普通的内核线程实现的,他们都要执行worker_thread()函数。在它初始化完以后,这个函数执行一个死循环执行一个循环并开始休眠,当有操作被插入到队列的时候,线程就会被唤醒,以便执行这些操作。当没有剩余的时候,它又会继续休眠。工作由work_struct(位于<kernel/workqueue.c>中)结构表示:1

2

3

4

5

6

7struct work_struct {

atomic_long_t data;

......

struct list_head entry;//连接所有链表

work_func_t func;

.....

};

当一个工作线程被唤醒时,它会执行它的链表上的所有工作。工作一旦执行完毕,它就将相应的work_struct对象从链表上移去,当链表不再有对象时,它就继续休眠。woker_thread()函数如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29static int worker_thread(void *__cwq)

{

struct cpu_workqueue_struct *cwq = __cwq;

DEFINE_WAIT(wait);

if (cwq->wq->freezeable)

set_freezable();

for (;;) {

//线程将自己设置为休眠状态并把自己加入等待队列

prepare_to_wait(&cwq->more_work, &wait, TASK_INTERRUPTIBLE);

if (!freezing(current) &&

!kthread_should_stop() &&

list_empty(&cwq->worklist))

schedule();//如果工作对列是空的,线程调用`schedule()函数进入睡眠状态

finish_wait(&cwq->more_work, &wait);

try_to_freeze();

//如果链表有对象,线程就将自己设为运行态,脱离等待队列

if (kthread_should_stop())

break;

//再次调用`run_workqueue()执行推后的工作

run_workqueue(cwq);

}

return 0;

}

之后由run_workqueue()函数来完成实际推后到此的工作:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32static void run_workqueue(struct cpu_workqueue_struct *cwq)

{

spin_lock_irq(&cwq->lock);

while (!list_empty(&cwq->worklist)) {

//链表不为空时,选取下一个节点对象

struct work_struct *work = list_entry(cwq->worklist.next,

struct work_struct, entry);

//获取希望执行的函数`func`及其参数`data

work_func_t f = work->func;

......

trace_workqueue_execution(cwq->thread, work);

cwq->current_work = work;

//把该结点从链表上解下来

list_del_init(cwq->worklist.next);

spin_unlock_irq(&cwq->lock);

BUG_ON(get_wq_data(work) != cwq);

//将待处理标志位`pending`清0

work_clear_pending(work);

lock_map_acquire(&cwq->wq->lockdep_map);

lock_map_acquire(&lockdep_map);

//执行函数

f(work);

lock_map_release(&lockdep_map);

lock_map_release(&cwq->wq->lockdep_map);

......

spin_lock_irq(&cwq->lock);

cwq->current_work = NULL;

}

spin_unlock_irq(&cwq->lock);

}

系统允许有多种类型工作者线程存在,默认情况下内核只有event这一种类型的工作者线程,每个工作者线程都由一个cpu_workqueue_struct结构体表示,大部分情况下,驱动程序都使用现存的默认工作者线程。

工作队列的使用很简单。可以使用缺省的events任务队列,也可以创建新的工作者线程。

第一步、创建需要推后完成的工作。1

2DECLARE_WORK(name,void (*func)(void *),void *data); //编译时静态创建

INIT_WORK(struct work_struct *work, void (*func)(void *)); //运行时动态创建

第二步、编写队列处理函数,处理函数会由工作者线程执行,因此,函数会运行在进程上下文中,默认情况下,允许相应中断,并且不持有锁。如果需要,函数可以睡眠。需要注意的是,尽管处理函数运行在进程上下文中,但它不能访问用户空间,因为内核线程在用户空间没有相应的内存映射。函数原型如下:1

void work_hander(void *data);

第三步、调度工作队列。调用schedule_work(&work);work马上就会被调度,一旦其所在的处理器上的工作者线程被唤醒,它就会被执行。当然如果不想快速执行,而是想延迟一段时间执行,调用schedule_delay_work(&work,delay),delay是要延迟的时间节拍。

默认工作者线程的调度函数其实就是做了一层封装,减少了 默认工作者线程的参数输入,如下:1

2

3

4

5

6

7

8

9int schedule_work(struct work_struct *work)

{

return queue_work(keventd_wq, work);

}

int schedule_delayed_work(struct delayed_work *dwork, unsigned long delay)

{

return queue_delayed_work(keventd_wq, dwork, delay);

}

第四步、刷新操作,插入队列的工作会在工作者线程下一次被唤醒的时候执行。有时,在继续下一步工作之前,你必须保证一些操作已经执行完毕等等。由于这些原因,内核提供了一个用于刷新指定工作队列的函数:1

void flush_scheduled_work(void);

这个函数会一直等待,直到队列中所有的对象都被执行后才返回。在等待所有待处理的工作执行的时候,该函数会进入休眠状态,所以只能在进程上下文中使用它。需要说明的是,该函数并不取消任何延迟执行的工作。取消延迟执行的工作应该调用:int cancel_delayed_work(struct work_struct *work);这个函数可以取消任何与work_struct相关挂起的工作。

下面为一个示例:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

//struct work_struct ws;

struct delayed_work dw;

void workqueue_func(struct work_struct *ws) //处理函数

{

printk(KERN_ALERT"Hello, this is shallnet!\n");

}

static int __init kwq_init(void)

{

printk(KERN_ALERT"===%s===\n", __func__);

//INIT_WORK(&ws, workqueue_func); //建需要推后完成的工作

//schedule_work(&ws); //调度工作

INIT_DELAYED_WORK(&dw, workqueue_func);

schedule_delayed_work(&dw, 10000);

return 0;

}

static void __exit kwq_exit(void)

{

printk(KERN_ALERT"===%s===\n", __func__);

flush_scheduled_work();

}

module_init(kwq_init);

module_exit(kwq_exit);

MODULE_LICENSE("GPL");

MODULE_AUTHOR("shallnet");

MODULE_DESCRIPTION("blog.csdn.net/shallnet");

上面的操作是使用缺省的工作队列,下面来看一下创建一个新的工作队列是如何操作的?

创建一个新的工作队列和与之相应的工作者线程,方法很简单,使用如下函数:1

struct workqueue_struct *create_workqueue(const char *name);

name是新内核线程的名字。比如缺省events队列的创建是这样使用的:1

2struct workqueue_struct *keventd_wq;

kevent_wq = create_workqueue("event");

这样就创建了所有的工作者线程,每个处理器都有一个。然后调用如下函数进行调度:1

2int queue_work(struct workqueue_struct *wq, struct work_struct *work);

int queue_delayed_work(struct workqueue_struct *wq,struct delayed_work *work,unsigned long delay);

最后可以调用flush_workqueue(struct workqueue_struct *wq);刷新指定工作队列。

下面为自定义新的工作队列的示例:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

struct workqueue_struct *sln_wq = NULL;

//struct work_struct ws;

struct delayed_work dw;

void workqueue_func(struct work_struct *ws)

{

printk(KERN_ALERT"Hello, this is shallnet!\n");

}

static int __init kwq_init(void)

{

printk(KERN_ALERT"===%s===\n", __func__);

sln_wq = create_workqueue("sln_wq"); //创建名为`sln_wq`的工作队列

//INIT_WORK(&ws, workqueue_func);

//queue_work(sln_wq, &ws);

INIT_DELAYED_WORK(&dw, workqueue_func); //

queue_delayed_work(sln_wq, &dw, 10000); //

return 0;

}

static void __exit kwq_exit(void)

{

printk(KERN_ALERT"===%s===\n", __func__);

flush_workqueue(sln_wq);

}

module_init(kwq_init);

module_exit(kwq_exit);

MODULE_LICENSE("GPL");

MODULE_AUTHOR("shallnet");

MODULE_DESCRIPTION("blog.csdn.net/shallnet");

使用ps可以查看到名为sln_wq的工作者线程。

在当前2.6.32版本中,我们讲了三种下半部机制:软中断、tasklet、工作队列。其中tasklet基于软中断,而工作队列靠内核线程实现。

使用软中断必须要确保共享数据的安全,因为相同类别的软中断可能在不同处理器上同时执行。在对于时间要求是否严格和执行频率很高的应用,或准备利用每一处理器上的变量或类型情形,可以考虑使用软中断,如网络子系统。

tasklet接口简单,可以动态创建,且两个通知类型的tasklet不能同时执行,所以实现起来较简单。驱动程序应该尽量选择tasklet而不是软中断。

工作队列工作于进程上下文,易于使用。由于牵扯到内核线程或上下文的切换,可能开销较大。如果你需要把任务推后到进程上下文中,或你需要休眠,那就只有使用工作队列了。

内核时钟中断

内核中很多函数是基于时间驱动的,其中有些函数需要周期或定期执行。比如有的每秒执行100次,有的在等待一个相对时间之后执行。除此之外,内核还必须管理系统运行的时间日期。

周期性产生的时间都是有系统定时器驱动的,系统定时器是一种可编程硬件芯片,它可以以固定频率产生中断,该中断就是所谓的定时器中断,其所对应的中断处理程序负责更新系统时间,也负责执行需要周期性运行的任务。

系统定时器以某种频率自行触发时钟中断,该频率可以通过编程预定,称作节拍率。当时钟中断发生时,内核就通过一种特殊的中断处理器对其进行处理。内核知道连续两次时钟中断的间隔时间,该间隔时间就称为节拍。内核就是靠这种已知的时钟中断间隔来计算实际时间和系统运行时间的。内核通过控制时钟中断维护实际时间,另外内核也为用户提供一组系统调用获取实际日期和实际时间。时钟中断对才操作系统的管理来说十分重要,系统更新运行时间、更新实际时间、均衡调度程序中个处理器上运行队列、检查进程是否用尽时间片等工作都利用时钟中断来周期执行。

内核有一个全局变量jiffies,该变量用来记录系统起来以后产生的节拍总数。系统启动是,该变量被设置为0,此后每产生一次时钟中断就增加该变量的值。jiffies每一秒增加的值就是HZ。jiffies定义于头文件<include/linux/jiffies.h>中:1

extern unsigned long volatile __jiffy_data jiffies;

对于32位unsigned long,可以存放最大值为4294967295,所以当节拍数达到最大值后还要继续增加的话,它的值就会回到0值。内核提供了四个宏(位于文件<include/linux/jiffies.h>中)来比较节拍数,这些宏可以正确处理节拍计数回绕情况。1

2

3

4

5

6

7

8

9

10

下面示例来打印出当前系统启动后经过的jiffies以及秒数:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

static int __init jiffies_init(void)

{

printk(KERN_ALERT"===%s===\n", __func__);

printk(KERN_ALERT"Current ticks is: %lu, seconds: %lu\n", jiffies, jiffies/HZ);

return 0;

}

static void __exit jiffies_exit(void)

{

printk(KERN_ALERT"===%s===\n", __func__);

}

module_init(jiffies_init);

module_exit(jiffies_exit);

MODULE_LICENSE("GPL");

MODULE_AUTHOR("shallnet");

MODULE_DESCRIPTION("blog.csdn.net/shallnet");

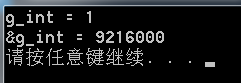

执行输出结果为:1

2

3# insmod jfs.ko

===jiffies_init===

Current ticks is: 10106703, seconds: 10106

时钟中断发生时,会触发时钟中断处理程序,始终中断处理程序部分和体系结构相关,下面简单分析一下x86体系的处理:

时钟的初始化在time_init()中,在start_kernel()中调用time_init(),如下:1

2

3

4

5

6asmlinkage void __init start_kernel(void)

{

......

time_init();

......

}

下面分析一下time_init()的实现,该函数位于文件<arch/x86/kernel/time.c>中:1

2

3

4

5

6

7

8

9

10void __init time_init(void)

{

late_time_init = x86_late_time_init;

}

static __init void x86_late_time_init(void)

{

x86_init.timers.timer_init(); //

tsc_init();

}

结构体x86_init位于arch/x86/kernel/x86_init.c中1

2

3

4

5

6

7

8struct x86_init_ops x86_init __initdata = {

......

.timers = {

.setup_percpu_clockev>--= setup_boot_APIC_clock,

.tsc_pre_init = x86_init_noop,

.timer_init = hpet_time_init,

}

}

默认timer初始化函数为:1

2

3

4

5

6void __init hpet_time_init(void)

{

if (!hpet_enable())

setup_pit_timer();

setup_default_timer_irq();

}

函数setup_default_timer_irq();注册中断处理函数:1

2

3

4

5

6

7

8

9

10void __init setup_default_timer_irq(void)

{

setup_irq(0, &irq0);

}

static struct irqaction irq0 = {

.handler = timer_interrupt,

.flags = IRQF_DISABLED | IRQF_NOBALANCING | IRQF_IRQPOLL | IRQF_TIMER,

.name = "timer"

};

对应的中断处理函数为:timer_interrupt():1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28static irqreturn_t timer_interrupt(int irq, void *dev_id)

{

/* Keep nmi watchdog up to date */

inc_irq_stat(irq0_irqs);

/* Optimized out for !IO_APIC and x86_64 */

if (timer_ack) {

/*

* Subtle, when I/O APICs are used we have to ack timer IRQ

* manually to deassert NMI lines for the watchdog if run

* on an 82489DX-based system.

*/

spin_lock(&i8259A_lock);

outb(0x0c, PIC_MASTER_OCW3);

/* Ack the IRQ; AEOI will end it automatically. */

inb(PIC_MASTER_POLL);

spin_unlock(&i8259A_lock);

}

//在此处调用体系无关的时钟处理例程

global_clock_event->event_handler(global_clock_event);

/* MCA bus quirk: Acknowledge irq0 by setting bit 7 in port 0x61 */

if (MCA_bus)

outb_p(inb_p(0x61)| 0x80, 0x61);

return IRQ_HANDLED;

}

时钟例程在系统启动时start_kernel()函数中调用tick_init()初始化:1

2

3

4void __init tick_init(void)

{

clockevents_register_notifier(&tick_notifier);

}

tick_notifier定义如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78static struct notifier_block tick_notifier = {

.notifier_call = tick_notify,

};

static int tick_notify(struct notifier_block *nb, unsigned long reason, void *dev)

{

switch (reason) {

case CLOCK_EVT_NOTIFY_RESUME:

tick_resume();

break;

default:

break;

}

return NOTIFY_OK;

}

static void tick_resume(void)

{

struct tick_device *td = &__get_cpu_var(tick_cpu_device);

unsigned long flags;

int broadcast = tick_resume_broadcast();

spin_lock_irqsave(&tick_device_lock, flags);

clockevents_set_mode(td->evtdev, CLOCK_EVT_MODE_RESUME);

if (!broadcast) {

if (td->mode == TICKDEV_MODE_PERIODIC)

tick_setup_periodic(td->evtdev, 0);

else

tick_resume_oneshot();

}

spin_unlock_irqrestore(&tick_device_lock, flags);

}

/*

* Setup the device for a periodic tick

*/

void tick_setup_periodic(struct clock_event_device *dev, int broadcast)

{

tick_set_periodic_handler(dev, broadcast);

......

}

/*

* 根据broadcast设置周期性的处理函数(kernel/time/tick-broadcast.c),这里就设置了始终中断函数timer_interrupt中调用的时钟处理例程

*/

void tick_set_periodic_handler(struct clock_event_device *dev, int broadcast)

{

if (!broadcast)

dev->event_handler = tick_handle_periodic;

else

dev->event_handler = tick_handle_periodic_broadcast;

}

/*

* ,以tick_handle_periodic为例,每一个始终节拍都调用该处理函数,而该处理过程中,主要处理工作处于tick_periodic()函数中。

*/

void tick_handle_periodic(struct clock_event_device *dev)

{

int cpu = smp_processor_id();

ktime_t next;

tick_periodic(cpu);

if (dev->mode != CLOCK_EVT_MODE_ONESHOT)

return;

next = ktime_add(dev->next_event, tick_period);

for (;;) {

if (!clockevents_program_event(dev, next, ktime_get()))

return;

if (timekeeping_valid_for_hres())

tick_periodic(cpu);

next = ktime_add(next, tick_period);

}

}

tick_periodic()函数主要有以下工作:

下面来看分析一下该函数:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18/*

* Periodic tick

*/

static void tick_periodic(int cpu)

{

if (tick_do_timer_cpu == cpu) {

write_seqlock(&xtime_lock);

/* 记录下一个节拍事件 */

tick_next_period = ktime_add(tick_next_period, tick_period);

do_timer(1);

write_sequnlock(&xtime_lock);

}

update_process_times(user_mode(get_irq_regs()));//更新所耗费的各种节拍数

profile_tick(CPU_PROFILING);

}

其中函数do_timer()(位于kernel/timer.c中)对jiffies_64做增加操作:1

2

3

4

5

6void do_timer(unsigned long ticks)

{

jiffies_64 += ticks;

update_wall_time(); //更新墙上时钟

calc_global_load(); //更新系统平均负载统计值

}

update_process_times更新所耗费的各种节拍数。1

2

3

4

5

6

7

8

9

10

11

12

13void update_process_times(int user_tick)

{

struct task_struct *p = current;

int cpu = smp_processor_id();

/* Note: this timer irq context must be accounted for as well. */

account_process_tick(p, user_tick);

run_local_timers();

rcu_check_callbacks(cpu, user_tick);

printk_tick();

scheduler_tick();

run_posix_cpu_timers(p);

}

函数run_local_timers()会标记一个软中断去处理所有到期的定时器。1

2

3

4

5

6void run_local_timers(void)

{

hrtimer_run_queues();

raise_softirq(TIMER_SOFTIRQ);

softlockup_tick();

}

在时钟中断处理函数time_interrupt()函数调用体系结构无关的时钟处理例程完成之后,返回到与体系结构的相关的中断处理函数中。以上所有的工作每一次时钟中断都会运行,也就是说如果HZ=100,那么时钟中断处理程序每一秒就会运行100次。

内核定时器和定时执行

前面章节说到了把工作推后到除现在以外的时间执行的机制是下半部机制,但是当你需要将工作推后到某个确定的时间段之后执行,使用定时器是很好的选择。

上一节内核时间管理中讲到内核在始终中断发生执行定时器,定时器作为软中断在下半部上下文中执行。时钟中断处理程序会执行update_process_times函数,在该函数中运行run_local_timers()函数来标记一个软中断去处理所有到期的定时器。如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18void update_process_times(int user_tick)

{

struct task_struct *p = current;

int cpu = smp_processor_id();

/* Note: this timer irq context must be accounted for as well. */

account_process_tick(p, user_tick);

run_local_timers();

rcu_check_callbacks(cpu, user_tick);

printk_tick();

scheduler_tick();

run_posix_cpu_timers(p);

}

void run_local_timers(void)

{

hrtimer_run_queues();

raise_softirq(TIMER_SOFTIRQ);

softlockup_tick();

}

在分析定时器的实现之前我们先来看一看使用内核定时器的一个实例,示例如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

struct timer_list sln_timer;

void sln_timer_do(unsigned long l)

{

mod_timer(&sln_timer, jiffies + HZ);

printk(KERN_ALERT"param: %ld, jiffies: %ld\n", l, jiffies);

}

void sln_timer_set(void)

{

init_timer(&sln_timer);

sln_timer.expires = jiffies + HZ; //1s

sln_timer.function = sln_timer_do;

sln_timer.data = 9527;

add_timer(&sln_timer);

}

static int __init sln_init(void)

{

printk(KERN_ALERT"===%s===\n", __func__);

sln_timer_set();

return 0;

}

static void __exit sln_exit(void)

{

printk(KERN_ALERT"===%s===\n", __func__);

del_timer(&sln_timer);

}

module_init(sln_init);

module_exit(sln_exit);

MODULE_LICENSE("GPL");

MODULE_AUTHOR("allen");

该示例作用是每秒钟打印出当前系统jiffies的值。

内核定时器由结构timer_list表示,定义在文件<include/linux/timer.h>中。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15struct timer_list {

struct list_head entry;

unsigned long expires;

void (*function)(unsigned long);

unsigned long data;

struct tvec_base *base;

void *start_site;

char start_comm[16];

int start_pid;

struct lockdep_map lockdep_map;

};

如示例,内核提供部分操作接口来简化管理定时器,

第一步、定义一个定时器:struct timer_list sln_timer;

第二步、初始化定时器数据结构的内部值。1

init_timer(&sln_timer);//初始化定时器

1 |

|

第三步、填充timer_list结构中需要的值:1

2

3sln_timer.expires = jiffies + HZ; //1s`后执行

sln_timer.function = sln_timer_do; //执行函数

sln_timer.data = 9527;

sln_timer.expires表示超时时间,它以节拍为单位的绝对计数值。如果当前jiffies计数等于或大于sln_timer.expires的值,那么sln_timer.function所指向的处理函数sln_timer_do就会执行,并且该函数还要使用长整型参数sln_timer.dat。1

void sln_timer_do(unsigned long l);

第四步、激活定时器:1

add_timer(&sln_timer); //向内核注册定时器

这样定时器就可以运行了。

add_timer()的实现如下:1

2

3

4

5void add_timer(struct timer_list *timer)

{

BUG_ON(timer_pending(timer));

mod_timer(timer, timer->expires);

}

add_timer()调用了mod_timer()。mod_timer()用于修改定时器超时时间。1

mod_timer(&sln_timer, jiffies + HZ);

由于add_timer()是通过调用mod_timer()来激活定时器,所以也可以直接使用mod_timer()来激活定时器,如果定时器已经初始化但没有激活,mod_timer()也会激活它。

如果需要在定时器超时前停止定时器,使用del_timer()函数来完成。1

del_timer(&sln_timer);

该函数实现如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29int del_timer(struct timer_list *timer)

{

struct tvec_base *base;

unsigned long flags;

int ret = 0;

timer_stats_timer_clear_start_info(timer);

if (timer_pending(timer)) {

base = lock_timer_base(timer, &flags);

if (timer_pending(timer)) {

detach_timer(timer, 1);

if (timer->expires == base->next_timer &&

!tbase_get_deferrable(timer->base))

base->next_timer = base->timer_jiffies;

ret = 1;

}

spin_unlock_irqrestore(&base->lock, flags);

}

return ret;

}

static inline void detach_timer(struct timer_list *timer,

int clear_pending)

{

struct list_head *entry = &timer->entry;

debug_deactivate(timer);

__list_del(entry->prev, entry->next);

if (clear_pending)

entry->next = NULL;

entry->prev = LIST_POISON2;

}

当使用del_timer()返回后,定时器就不会再被激活,但在多处理器机器上定时器上定时器中断可能已经在其他处理器上运行了,所以删除定时器时需要等待可能在其他处理器上运行的定时器处理I程序都退出,这时就要使用del_timer_sync()函数执行删除工作:1

del_timer_sync(&sln_timer);

该函数不能在中断上下文中使用。

该函数详细实现如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36int del_timer_sync(struct timer_list *timer)

{

unsigned long flags;

local_irq_save(flags);

lock_map_acquire(&timer->lockdep_map);

lock_map_release(&timer->lockdep_map);

local_irq_restore(flags);

for (;;) { //一直循环,直到删除`timer`成功再退出

int ret = try_to_del_timer_sync(timer);

if (ret >= 0)

return ret;

cpu_relax();

}

}

int try_to_del_timer_sync(struct timer_list *timer)

{

struct tvec_base *base;

unsigned long flags;

int ret = -1;

base = lock_timer_base(timer, &flags);

if (base->running_timer == timer)

goto out;

ret = 0;

if (timer_pending(timer)) {

detach_timer(timer, 1);

if (timer->expires == base->next_timer &&

!tbase_get_deferrable(timer->base))

base->next_timer = base->timer_jiffies;

ret = 1;

}

out:

spin_unlock_irqrestore(&base->lock, flags);

return ret;

}

一般情况下应该使用del_timer_sync()函数代替del_timer()函数,因为无法确定在删除定时器时,他是否在其他处理器上运行。为了防止这种情况的发生,应该调用del_timer_sync()函数而不是del_timer()函数。否则,对定时器执行删除操作后,代码会继续执行,但它有可能会去操作在其它处理器上运行的定时器正在使用的资源,因而造成并发访问,所有优先使用删除定时器的同步方法。

除了使用定时器来推迟任务到指定时间段运行之外,还有其他的方法处理延时请求。有的方法会在延迟任务时挂起处理器,有的却不会。实际上也没有方法能够保证实际的延迟时间刚好等于指定的延迟时间。

- 最简单的 延迟方法是忙等待,该方法实现起来很简单,只需要在循环中不断旋转直到希望的时钟节拍数耗尽。比如:

1

2

3unsigned long delay = jiffies+10; //延迟10个节拍

while(time_before(jiffies,delay))

;

这种方法当代码等待时,处理器只能在原地旋转等待,它不会去处理其他任何任务。最好在任务等待时,允许内核重新调度其它任务执行。将上面代码修改如下:1

2

3unsigned long delay = jiffies+10; //10个节拍

while(time_before(jiffies,delay))

cond_resched();

看一下cond_resched()函数具体实现代码:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

int __sched _cond_resched(void)

{

if (should_resched()) {

__cond_resched();

return 1;

}

return 0;

}

static void __cond_resched(void)

{

add_preempt_count(PREEMPT_ACTIVE);

schedule(); //最终还是调用`schedule()函数来重新调度其它程序运行

sub_preempt_count(PREEMPT_ACTIVE);

}

函数cond_resched()将重新调度一个新程序投入运行,但它只有在设置完need_resched标志后才能生效。换句话说,就是系统中存在更重要的任务需要运行。再由于该方法需要调用调度程序,所以它不能在中断上下文中使用——只能在进程上下文中使用。事实上,所有延迟方法在进程上下文中使用,因为中断处理程序都应该尽可能快的执行。另外,延迟执行不管在哪种情况下都不应该在持有锁时或者禁止中断时发生。

有时内核需要更短的延迟,甚至比节拍间隔还要短。这时可以使用内核提供的

ms、ns、us级别的延迟函数。1

2

3void udelay(unsigned long usecs); //arch/x86/include/asm/delay.h

void ndelay(unsigned long nsecs); //arch/x86/include/asm/delay.h

void mdelay(unsigned long msecs);udelay()使用忙循环将任务延迟指定的ms后执行,其依靠执行数次循环达到延迟效果,mdelay()函数是通过udelay()函数实现,如下:1

2

3

4

(__builtin_constant_p(n) && (n)<=MAX_UDELAY_MS) ? udelay((n)*1000) : \

({unsigned long __ms=(n); while (__ms--) udelay(1000);}))udelay()函数仅能在要求的延迟时间很短的情况下执行,而在高速机器中时间很长的延迟会造成溢出。对于较长的延迟,mdelay()工作良好。schedule_timeout()函数是更理想的延迟执行方法。该方法会让需要延迟执行的任务睡眠到指定的延迟时间耗尽后再重新运行。但该方法也不能保证睡眠时间正好等于指定的延迟时间,只能尽量是睡眠时间接近指定的延迟时间。当指定的时间到期后,内核唤醒被延迟的任务并将其重新放回运行队列。用法如下:1

2set_current_state(TASK_INTERRUPTIBLE); //将任务设置为可中断睡眠状态

schedule_timeout(s*HZ); //小睡一会儿,“s”秒后唤醒

唯一的参数是延迟的相对时间,单位是jiffies,上例中将相应的任务推入可中断睡眠队列,睡眠s秒。在调用函数schedule_timeout之前,不要要将任务设置成可中断或不和中断的一种,否则任务不会休眠。这个函数需要调用调度程序,所以调用它的代码必须保证能够睡眠,简而言之,调用代码必须处于进程上下文中,并且不能持有锁。

事实上schedule_timeout()函数的实现就是内核定时器的一个简单应用。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55signed long __sched schedule_timeout(signed long timeout)

{

struct timer_list timer;

unsigned long expire;

switch (timeout)

{

case MAX_SCHEDULE_TIMEOUT:

/*

* These two special cases are useful to be comfortable

* in the caller. Nothing more. We could take

* MAX_SCHEDULE_TIMEOUT from one of the negative value

* but I' d like to return a valid offset (>=0) to allow

* the caller to do everything it want with the retval.

*/

schedule();

goto out;

default:

/*

* Another bit of PARANOID. Note that the retval will be

* 0 since no piece of kernel is supposed to do a check

* for a negative retval of schedule_timeout() (since it

* should never happens anyway). You just have the printk()

* that will tell you if something is gone wrong and where.

*/

if (timeout < 0) {

printk(KERN_ERR "schedule_timeout: wrong timeout "

"value %lx\n", timeout);

dump_stack();

current->state = TASK_RUNNING;

goto out;

}

}

expire = timeout + jiffies;

//下一行代码设置了超时执行函数`process_timeout()。

setup_timer_on_stack(&timer, process_timeout, (unsigned long)current);

__mod_timer(&timer, expire, false, TIMER_NOT_PINNED); //激活定时器

schedule(); //调度其他新任务

del_singleshot_timer_sync(&timer);

/* Remove the timer from the object tracker */

destroy_timer_on_stack(&timer);

timeout = expire - jiffies;

out:

return timeout < 0 ? 0 : timeout;

}

当定时器超时时,process_timeout()函数被调用:

static void process_timeout(unsigned long __data)

{

wake_up_process((struct task_struct *)__data);

}

当任务被重新调度时,将返回代码进入睡眠前的位置继续执行,位置正好在schedule()处。

进程上下文的代码为了等待特定时间发生,可以将自己放入等待队列。但是,等待队列上的某个任务可能既在等待一个特定事件到来,又在等待一个特定时间到期,就看谁来得更快。这种情况下,代码可以简单的使用scedule_timeout()函数代替schedule()函数,这样一来,当希望指定时间到期后,任务都会被唤醒,当然,代码需要检查被唤醒的原因,有可能是被事件唤醒,也有可能是因为延迟的时间到期,还可能是因为接收到了信号,然后执行相应的操作。

进程管理分析

进程其实就是程序的执行时的实例,是处于执行期的程序。在Linux内核中,进程列表被存放在一个双向循环链表中,链表中每一项都是类型为task_struct的结构,该结构称作进程描述符,进程描述符包含一个具体进程的所有信息,这个结构就是我们在操作系统中所说的PCB(Process Control Block)。该结构定义于<include/linux/sched.h>文件中:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22struct task_struct {

volatile long state; /* -1 unrunnable, 0 runnable, >0 stopped */

void *stack;

atomic_t usage;

unsigned int flags; /* per process flags, defined below */

unsigned int ptrace;

int lock_depth; /* BKL lock depth */

......

int prio, static_prio, normal_prio;

unsigned int rt_priority;

const struct sched_class *sched_class;

struct sched_entity se;

struct sched_rt_entity rt;

......

struct task_struct *parent; /* recipient of SIGCHLD, wait4() reports */

struct list_head children; /* list of my children */

struct list_head sibling; /* linkage in my parent's children list */

......

};

该结构体中包含的数据可以完整的描述一个正在执行的程序:打开的文件、进程的地址空间、挂起的信号、进程的状态、以及其他很多信息。

在系统运行过程中,进程频繁切换,所以我们需要一种方式能够快速获得当前进程的task_struct,于是进程内核堆栈底部存放着struct thread_info。该结构中有一个成员指向当前进程的task_struct。在x86上,struct thread_info在文件<arch/x86/include/asm/thread_info.h>中定义:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18struct thread_info {

struct task_struct *task; /* 该指针存放的是指向该任务实际`task_struct`的指针 */

struct exec_domain *exec_domain; /* execution domain */

__u32 flags; /* low level flags */

__u32 status; /* thread synchronous flags */

__u32 cpu; /* current CPU */

int preempt_count; /* 0 => preemptable, <0 => BUG */

mm_segment_t addr_limit;

struct restart_block restart_block;

void __user *sysenter_return;

unsigned long previous_esp; /* ESP of the previous stack in

case of nested (IRQ) stacks

*/

__u8 supervisor_stack[0];

int uaccess_err;

};

使用current宏就可以获得当前进程的进程描述符。

每一个进程都有一个父进程,每个进程管理自己的子进程。每个进程都是init进程的子进程,init进程在内 核系统启动的最后阶段启动init进程,该进程读取系统的初始化脚本并执行其他相关程序,最终完成系统启动的整个过程。每个进程有0个或多个子进程,进程间的关系存放在进程描述符中。task_struct中有一个parent的指针,指向其父进程;还有个children的指针指向其子进程的链表。所以,对于当前进程,可以通过current宏来获得父进程和子进程的进程描述符。

下面程序打印当前进程、父进程信息和所有子进程信息:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

void sln_taskstruct_do(void)

{

struct task_struct *cur,

*parent,

*task;

struct list_head *first_child,

*child_list,

*cur_chd;

//获取当前进程信息

cur = current;

printk(KERN_ALERT"Current: %s[%d]\n",

cur->comm, cur->pid);

//获取父进程信息

parent = current->parent;

printk(KERN_ALERT"Parent: %s[%d]\n",

parent->comm, parent->pid);

//获取所有祖先进程信息

for (task = cur; task != &init_task; task = task->parent) {

printk(KERN_ALERT"ancestor: %s[%d]\n",

task->comm, task->pid);

}

//获取所有子进程信息

child_list = &cur->children;

first_child = &cur->children;

for (cur_chd = child_list->next;

cur_chd != first_child;

cur_chd = cur_chd->next) {

task = list_entry(child_list, struct task_struct, sibling);

printk(KERN_ALERT"Children: %s[%d]\n",

task->comm, task->pid);

}

}

static int __init sln_init(void)

{

printk(KERN_ALERT"===%s===\n", __func__);

sln_taskstruct_do();

return 0;

}

static void __exit sln_exit(void)

{

printk(KERN_ALERT"===%s===\n", __func__);

}

module_init(sln_init);

module_exit(sln_exit);

MODULE_LICENSE("GPL");

MODULE_AUTHOR("shallnet");

MODULE_DESCRIPTION("blog.csdn.net/shallnet");

执行结果如下:1

2

3

4

5

6

7

8 # insmod task.ko

===sln_init===

Current: insmod[4315]

Parent: bash[4032]

ancestor: insmod[4315]

ancestor: bash[4032]

ancestor: login[2563]

ancestor: init[1]

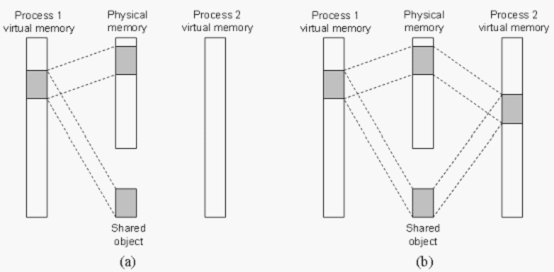

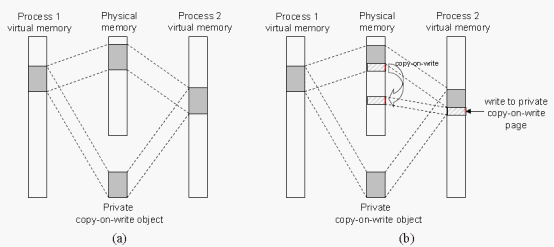

Linux操作系统提供产生进程的机制,在Linux下的fork()使用写时拷贝(copy-on-write)页实现。这种技术原理是:内存并不复制整个进程地址空间,而是让父进程和子进程共享同一拷贝,只有在需要写入的时候,数据才会被复制。也就是资源的复制只是发生在需要写入的时候才进行,在此之前都是以只读的方式共享。

Linux通过clone()系统调用实现fork(),然后clone()去调用do_fork(),do_fork()完成创建中大部分工作。库函数vfork()、__clone()都根据各自需要的参数标志去调用clone()。fork()的实际开销就是复制父进程的页表以及给子进程创建唯一的进程描述符。

用户空间的fork()经过系统调用进入内核,在内核中对应的处理函数为sys_fork(),定义于<arch/x86/kernel/process.c>文件中。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

150

151

152

153

154

155

156

157

158

159

160

161

162

163

164

165

166

167

168

169

170

171

172

173

174

175

176

177

178

179

180

181

182

183

184

185

186

187

188

189

190

191

192

193

194

195

196

197

198

199

200

201

202

203

204

205

206

207

208

209

210

211

212

213

214

215

216

217

218

219

220

221

222

223

224

225

226

227

228

229

230

231

232

233

234

235

236

237

238

239

240

241

242

243

244

245

246

247

248

249

250

251

252

253

254

255

256

257

258

259

260

261

262

263

264

265

266

267

268

269

270

271

272

273

274

275

276

277

278

279

280

281

282

283

284

285

286

287

288

289

290

291

292

293

294

295

296

297

298

299

300

301

302

303

304

305

306

307

308

309

310

311

312

313

314

315

316

317

318

319

320

321

322

323

324

325

326

327

328

329

330

331

332

333

334

335

336

337

338

339

340

341

342

343

344

345

346

347

348

349

350

351

352

353

354int sys_fork(struct pt_regs *regs)

{

return do_fork(SIGCHLD, regs->sp, regs, 0, NULL, NULL);

}

long do_fork(unsigned long clone_flags,

unsigned long stack_start,

struct pt_regs *regs,

unsigned long stack_size,

int __user *parent_tidptr,

int __user *child_tidptr)

{

struct task_struct *p;

int trace = 0;

long nr;

......

p = copy_process(clone_flags, stack_start, regs, stack_size,

child_tidptr, NULL, trace);

......

return nr;

}

static struct task_struct *copy_process(unsigned long clone_flags,

unsigned long stack_start,

struct pt_regs *regs,

unsigned long stack_size,

int __user *child_tidptr,

struct pid *pid,

int trace)

{

int retval;

struct task_struct *p;

int cgroup_callbacks_done = 0;

if ((clone_flags & (CLONE_NEWNS|CLONE_FS)) == (CLONE_NEWNS|CLONE_FS))

return ERR_PTR(-EINVAL);

/*

* Thread groups must share signals as well, and detached threads

* can only be started up within the thread group.

*/

if ((clone_flags & CLONE_THREAD) && !(clone_flags & CLONE_SIGHAND))

return ERR_PTR(-EINVAL);

/*

* Shared signal handlers imply shared VM. By way of the above,

* thread groups also imply shared VM. Blocking this case allows

* for various simplifications in other code.

*/

if ((clone_flags & CLONE_SIGHAND) && !(clone_flags & CLONE_VM))

return ERR_PTR(-EINVAL);

/*

* Siblings of global init remain as zombies on exit since they are

* not reaped by their parent (swapper). To solve this and to avoid

* multi-rooted process trees, prevent global and container-inits

* from creating siblings.

*/

if ((clone_flags & CLONE_PARENT) &&

current->signal->flags & SIGNAL_UNKILLABLE)

return ERR_PTR(-EINVAL);

retval = security_task_create(clone_flags);

if (retval)

goto fork_out;

retval = -ENOMEM;

p = dup_task_struct(current);

if (!p)

goto fork_out;

ftrace_graph_init_task(p);

rt_mutex_init_task(p);

DEBUG_LOCKS_WARN_ON(!p->hardirqs_enabled);

DEBUG_LOCKS_WARN_ON(!p->softirqs_enabled);

retval = -EAGAIN;

if (atomic_read(&p->real_cred->user->processes) >=

p->signal->rlim[RLIMIT_NPROC].rlim_cur) {

if (!capable(CAP_SYS_ADMIN) && !capable(CAP_SYS_RESOURCE) &&

p->real_cred->user != INIT_USER)

goto bad_fork_free;

}

retval = copy_creds(p, clone_flags);

if (retval < 0)

goto bad_fork_free;

/*

* If multiple threads are within copy_process(), then this check

* triggers too late. This doesn't hurt, the check is only there

* to stop root fork bombs.

*/

retval = -EAGAIN;

if (nr_threads >= max_threads)

goto bad_fork_cleanup_count;

if (!try_module_get(task_thread_info(p)->exec_domain->module))

goto bad_fork_cleanup_count;

p->did_exec = 0;

delayacct_tsk_init(p); /* Must remain after dup_task_struct() */

copy_flags(clone_flags, p);

INIT_LIST_HEAD(&p->children);

INIT_LIST_HEAD(&p->sibling);

rcu_copy_process(p);

p->vfork_done = NULL;

spin_lock_init(&p->alloc_lock);

init_sigpending(&p->pending);

p->utime = cputime_zero;

p->stime = cputime_zero;

p->gtime = cputime_zero;

p->utimescaled = cputime_zero;

p->stimescaled = cputime_zero;

p->prev_utime = cputime_zero;

p->prev_stime = cputime_zero;

p->default_timer_slack_ns = current->timer_slack_ns;

task_io_accounting_init(&p->ioac);

acct_clear_integrals(p);

posix_cpu_timers_init(p);

p->lock_depth = -1; /* -1 = no lock */

do_posix_clock_monotonic_gettime(&p->start_time);

p->real_start_time = p->start_time;

monotonic_to_bootbased(&p->real_start_time);

p->io_context = NULL;

p->audit_context = NULL;

cgroup_fork(p);

p->mempolicy = mpol_dup(p->mempolicy);

if (IS_ERR(p->mempolicy)) {

retval = PTR_ERR(p->mempolicy);

p->mempolicy = NULL;

goto bad_fork_cleanup_cgroup;

}

mpol_fix_fork_child_flag(p);

p->irq_events = 0;

p->hardirqs_enabled = 1;

p->hardirqs_enabled = 0;

p->hardirq_enable_ip = 0;

p->hardirq_enable_event = 0;

p->hardirq_disable_ip = _THIS_IP_;

p->hardirq_disable_event = 0;

p->softirqs_enabled = 1;

p->softirq_enable_ip = _THIS_IP_;

p->softirq_enable_event = 0;

p->softirq_disable_ip = 0;

p->softirq_disable_event = 0;

p->hardirq_context = 0;

p->softirq_context = 0;

p->lockdep_depth = 0; /* no locks held yet */

p->curr_chain_key = 0;

p->lockdep_recursion = 0;

p->blocked_on = NULL; /* not blocked yet */

p->bts = NULL;

p->stack_start = stack_start;

/* Perform scheduler related setup. Assign this task to a CPU. */

sched_fork(p, clone_flags);

retval = perf_event_init_task(p);

if (retval)

goto bad_fork_cleanup_policy;

if ((retval = audit_alloc(p)))

goto bad_fork_cleanup_policy;

/* copy all the process information */

if ((retval = copy_semundo(clone_flags, p)))

goto bad_fork_cleanup_audit;

if ((retval = copy_files(clone_flags, p)))

goto bad_fork_cleanup_semundo;

if ((retval = copy_fs(clone_flags, p)))

goto bad_fork_cleanup_files;

if ((retval = copy_sighand(clone_flags, p)))

goto bad_fork_cleanup_fs;

if ((retval = copy_signal(clone_flags, p)))

goto bad_fork_cleanup_sighand;

if ((retval = copy_mm(clone_flags, p)))

goto bad_fork_cleanup_signal;

if ((retval = copy_namespaces(clone_flags, p)))

goto bad_fork_cleanup_mm;

if ((retval = copy_io(clone_flags, p)))

goto bad_fork_cleanup_namespaces;

retval = copy_thread(clone_flags, stack_start, stack_size, p, regs);

if (retval)

goto bad_fork_cleanup_io;

if (pid != &init_struct_pid) {

retval = -ENOMEM;

pid = alloc_pid(p->nsproxy->pid_ns);

if (!pid)

goto bad_fork_cleanup_io;

if (clone_flags & CLONE_NEWPID) {

retval = pid_ns_prepare_proc(p->nsproxy->pid_ns);

if (retval < 0)

goto bad_fork_free_pid;

}

}

p->pid = pid_nr(pid);

p->tgid = p->pid;

if (clone_flags & CLONE_THREAD)

p->tgid = current->tgid;

if (current->nsproxy != p->nsproxy) {

retval = ns_cgroup_clone(p, pid);

if (retval)

goto bad_fork_free_pid;

}

p->set_child_tid = (clone_flags & CLONE_CHILD_SETTID) ? child_tidptr : NULL;

/*

* Clear TID on mm_release()?

*/

p->clear_child_tid = (clone_flags & CLONE_CHILD_CLEARTID) ? child_tidptr: NULL;

p->robust_list = NULL;

p->compat_robust_list = NULL;

INIT_LIST_HEAD(&p->pi_state_list);

p->pi_state_cache = NULL;

/*

* sigaltstack should be cleared when sharing the same VM

*/

if ((clone_flags & (CLONE_VM|CLONE_VFORK)) == CLONE_VM)

p->sas_ss_sp = p->sas_ss_size = 0;

/*

* Syscall tracing should be turned off in the child regardless

* of CLONE_PTRACE.

*/

clear_tsk_thread_flag(p, TIF_SYSCALL_TRACE);

clear_tsk_thread_flag(p, TIF_SYSCALL_EMU);

clear_all_latency_tracing(p);

/* ok, now we should be set up.. */

p->exit_signal = (clone_flags & CLONE_THREAD) ? -1 : (clone_flags & CSIGNAL);

p->pdeath_signal = 0;

p->exit_state = 0;

/*

* Ok, make it visible to the rest of the system.

* We dont wake it up yet.

*/

p->group_leader = p;

INIT_LIST_HEAD(&p->thread_group);

/* Now that the task is set up, run cgroup callbacks if

* necessary. We need to run them before the task is visible

* on the tasklist. */

cgroup_fork_callbacks(p);

cgroup_callbacks_done = 1;

/* Need tasklist lock for parent etc handling! */

write_lock_irq(&tasklist_lock);

/*

* The task hasn't been attached yet, so its cpus_allowed mask will

* not be changed, nor will its assigned CPU.

*

* The cpus_allowed mask of the parent may have changed after it was

* copied first time - so re-copy it here, then check the child's CPU

* to ensure it is on a valid CPU (and if not, just force it back to

* parent's CPU). This avoids alot of nasty races.

*/

p->cpus_allowed = current->cpus_allowed;

p->rt.nr_cpus_allowed = current->rt.nr_cpus_allowed;

if (unlikely(!cpu_isset(task_cpu(p), p->cpus_allowed) ||

!cpu_online(task_cpu(p))))

set_task_cpu(p, smp_processor_id());

/* CLONE_PARENT re-uses the old parent */

if (clone_flags & (CLONE_PARENT|CLONE_THREAD)) {

p->real_parent = current->real_parent;

p->parent_exec_id = current->parent_exec_id;

} else {

p->real_parent = current;

p->parent_exec_id = current->self_exec_id;

}

spin_lock(¤t->sighand->siglock);

/*

* Process group and session signals need to be delivered to just the

* parent before the fork or both the parent and the child after the

* fork. Restart if a signal comes in before we add the new process to

* it's process group.

* A fatal signal pending means that current will exit, so the new

* thread can't slip out of an OOM kill (or normal SIGKILL).

*/

recalc_sigpending();

if (signal_pending(current)) {

spin_unlock(¤t->sighand->siglock);

write_unlock_irq(&tasklist_lock);

retval = -ERESTARTNOINTR;

goto bad_fork_free_pid;

}

if (clone_flags & CLONE_THREAD) {

atomic_inc(¤t->signal->count);

atomic_inc(¤t->signal->live);

p->group_leader = current->group_leader;

list_add_tail_rcu(&p->thread_group, &p->group_leader->thread_group);

}

if (likely(p->pid)) {

list_add_tail(&p->sibling, &p->real_parent->children);

tracehook_finish_clone(p, clone_flags, trace);