Glibc 安装指南(2.6.1 → 2.9)

安装信息的来源

http://www.gnu.org/software/libc/manual/html_node/System-Configuration.html

http://www.gnu.org/software/libc/manual/html_node/Installation.html

http://www.gnu.org/software/libc/manual/html_node/Name-Service-Switch.html

要点提示

编译Glibc的时候应该尽可能使用最新的内核头文件,至少要使用 2.6.16 以上版本的内核,先前的版本有一些缺陷会导致”make check”时一些与pthreads测试相关的项目失败。使用高版本内核头文件编译的Glibc二进制文件完全可以运行在较低版本的内核上,并且当你升级内核后新内核的特性仍然可以得到充分发挥而无需重新编译Glibc。但是如果编译时使用的头文件的版本较低,那么运行在更高版本的内核上时,新内核的特性就不能得到充分发挥。更多细节可以查看[八卦故事]内核头文件传奇的跟帖部分。

推荐使用GCC-4.1以上的版本编译,老版本的GCC可能会生成有缺陷的代码。

不要在运行中的系统上安装 Glibc,否则将会导致系统崩溃,至少应当将新 Glibc 安装到其他的单独目录,以保证不覆盖当前正在使用的 Glibc 。

Glibc 不能在源码目录中编译,它必须在一个额外分开的目录中编译。这样在编译发生错误的时候,就可以删除整个编译目录重新开始。

源码树下的Makeconfig文件中有许多用于特定目的的变量,你可以在编译目录下创建一个configparms文件来改写这些变量。执行make命令的时候configparms文件中的内容将会按照Makefile规则进行解析。比如可以通过在其中设置 CFLAGS LDFLAGS 环境变量来优化编译,设置 CC BUILD_CC AR RANLIB 来指定交叉编译环境。

需要注意的是有些测试项目假定是以非 root 身份执行的,因此我们强烈建议你使用非 root 身份编译和测试 Glibc 。

配置选项

下列选项皆为非默认值[特别说明的除外]1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28--help

--version

--quiet

--config-cache

--no-create

--srcdir=DIR

--exec-prefix=EPREFIX

--bindir=DIR

--sbindir=DIR

--libexecdir=DIR

--sysconfdir=DIR

--sharedstatedir=DIR

--localstatedir=DIR

--libdir=DIR

--includedir=DIR

--oldincludedir=DIR

--datarootdir=DIR

--datadir=DIR

--infodir=DIR

--localedir=DIR

--mandir=DIR

--docdir=DIR

--htmldir=DIR

--dvidir=DIR

--pdfdir=DIR

--psdir=DIR

--build=BUILD

--host=HOST

这些选项的含义基本上通用于所有软件包,这里就不特别讲解了。需要注意的是:没有—target=TARGET选项。

—prefix=PREFIX

安装目录,默认为 /usr/local。Linux文件系统标准要求基本库必须位于 /lib 目录并且必须与根目录在同一个分区上,但是 /usr 可以在其他分区甚至是其他磁盘上。因此,如果在Linux平台上指定 —prefix=/usr ,那么基本库部分将自动安装到 /lib 目录下,而非基本库部分则会自动安装到 /usr/lib 目录中,同时将使用 /etc 作为配置目录,也就是等价于”slibdir=/lib sysconfdir=/etc”。但是如果保持默认值或指定其他目录,那么所有组件都间被安装到PREFIX目录下。

—disable-sanity-checks

真正禁用线程(仅在特殊环境下使用该选项)。

—enable-check-abi

在”make check”时执行”make check-abi”。[提示]在我的机器上始终导致check-abi-libm测试失败。

—disable-shared

不编译共享库(即使平台支持)。在支持 ELF 并且使用 GNU 连接器的系统上默认为enable 。[提示] —disable-static 选项实际上是不存在的,静态库总是被无条件的编译和安装。

—enable-profile

启用 profiling 信息相关的库文件编译。主要用于调试目的。

—enable-omitfp

编译时忽略帧指示器(使用 -fomit-frame-pointer 编译),并采取一些其他优化措施。忽略帧指示器可以提高运行效率,但是调试将变得不可用,并且可能生成含有 bug 的代码。使用这个选项还将导致额外编译带有调试信息的非优化版本的静态库(库名称以”_g”结尾)。

—enable-bounded

启用运行时边界检查(比如数组越界),这样会降低运行效率,但能防止某些溢出漏洞。

—disable-versioning

不在共享库对象中包含符号的版本信息。这样可以减小库的体积,但是将不兼容依赖于老版本 C 库的二进制程序。[提示]在我的机器上使用此选项总是导致编译失败。

—enable-oldest-abi=ABI

启用老版本的应用程序二进制接口支持。ABI是Glibc的版本号,只有明确指定版本号时此选项才有效。

—enable-stackguard-randomization

在程序启动时使用一个随机数初始化 __stack_chk_guard ,主要用来抵抗恶意攻击。

—enable-add-ons[=DIRS…]

为了减小软件包的复杂性,一些可选的libc特性被以单独的软件包发布,比如’linuxthreads’(现在已经被废弃了),他们被称为’add-ons’。要使用这些额外的包,可以将他们解压到Glibc的源码树根目录下,然后使用此选项将DIR1,DIR2,…中的附加软件包包含进来。其中的”DIR”是附加软件包的目录名。默认值”yes”表示编译所有源码树根目录下找到的附加软件包。

—disable-hidden-plt

默认情况下隐藏仅供内部调用的函数,以避免这些函数被加入到过程链接表(PLT,Procedure Linkage Table)中,这样可以减小 PLT 的体积并将仅供内部使用的函数隐藏起来。而使用该选项将把这些函数暴露给外部用户。

—enable-bind-now

禁用”lazy binding”,也就是动态连接器在载入 DSO 时就解析所有符号(不管应用程序是否用得到),默认行为是”lazy binding”,也就是仅在应用程序首次使用到的时候才对符号进行解析。因为在大多数情况下,应用程序并不需要使用动态库中的所有符号,所以默认的 “lazy binding”可以提高应用程序的加载性能并节约内存用量。然而,在两种情况下,”lazy binding”是不利的:①因为第一次调用DSO中的函数时,动态连接器要先拦截该调用来解析符号,所以初次引用DSO中的函数所花的时间比再次调用要花的时间长,但是某些应用程序不能容忍这种不可预知性。②如果一个错误发生并且动态连接器不能解析该符号,动态连接器将终止整个程序。在”lazy binding”方式下,这种情况可能发生在程序运行过程中的某个时候。某些应用程序也是不能容忍这种不可预知性的。通过关掉”lazy binding”方式,在应用程序接受控制权之前,让动态连接器在处理进程初始化期间就发现这些错误,而不要到运行时才出乱子。

—enable-static-nss

编译静态版本的NSS(Name Service Switch)库。仅在/etc/nsswitch.conf中只使用dns和files的情况下,NSS才能编译成静态库,并且你还需要在静态编译应用程序的时候明确的连接所有与NSS库相关的库才行[比如:gcc -static test.c -o test -Wl,-lc,-lnss_files,-lnss_dns,-lresolv]。不推荐使用此选项,因为连接到静态NSS库的程序不能动态配置以使用不同的名字数据库。

—disable-force-install

不强制安装当前新编译的版本(即使已存在的文件版本更新)。

—enable-kernel=VERSION

VERSION 的格式是 X.Y.Z,表示编译出来的 Glibc 支持的最低内核版本。VERSION 的值越高(不能超过内核头文件的版本),加入的兼容性代码就越少,库的运行速度就越快。

—enable-all-warnings

在编译时显示所有编译器警告,也就是使用 -Wall 选项编译。

—with-gd

—with-gd-include

—with-gd-lib

指定libgd的安装目录(DIR/include和DIR/lib)。后两个选项分别指定包含文件和库目录。

—without-fp

仅在硬件没有浮点运算单元并且操作系统没有模拟的情况下使用。x86 与 x86_64 的 CPU 都有专门的浮点运算单元。而且 Linux 有 FPU 模拟。简单的说,不要 without 这个选项!因为它会导致许多问题!

—with-binutils=DIR

明确指定编译时使用的Binutils(as,ld)所在目录。

—with-elf

指定使用 ELF 对象格式,默认不使用。建议在支持 ELF 的 Linux 平台上明确指定此选项。

—with-selinux

—without-selinux

启用/禁用 SELinux 支持,默认值自动检测。

—with-xcoff

使用XCOFF对象格式(主要用于windows)。

—without-cvs

不访问CVS服务器。推荐使用该选项,特别对于从CVS下载的的版本。

—with-headers=DIR

指定内核头文件的所在目录,在Linux平台上默认是’/usr/include’。

—without-tls

禁止编译支持线程本地存储(TLS)的库。使用这个选项将导致兼容性问题。

—without-__thread

即使平台支持也不使用TSL特性。建议不要使用该选项。

—with-cpu=CPU

在 gcc 命令行中加入”-mcpu=CPU”。鉴于”-mcpu”已经被反对使用,所以建议不要设置该选项,或者设为 —without-cpu 。

编译与测试

使用 make 命令编译,使用 make check 测试。如果 make check 没有完全成功,就千万不要使用这个编译结果。需要注意的是有些测试项目假定是以非 root 身份执行的,因此我们强烈建议你使用非 root 身份编译和测试。

测试中需要使用一些已经存在的文件(包括随后的安装过程),比如 /etc/passwd, /etc/nsswitch.conf 之类。请确保这些文件中包含正确的内容。

安装与配置

使用 make install 命令安装。比如:make install LC_ALL=C

如果你打算将此 Glibc 安装为主 C 库,那么我们强烈建议你关闭系统,重新引导到单用户模式下安装。这样可以将可能的损害减小到最低。

安装后需要配置 GCC 以使其使用新安装的 C 库。最简单的办法是使用恰当 GCC 的编译选项(比如 -Wl,—dynamic-linker=/lib/ld-linux.so.2 )重新编译 GCC 。然后还需要修改 specs 文件(通常位于 /usr/lib/gcc-lib/TARGET/VERSION/specs ),这个工作有点像巫术,调整实例请参考 LFS 中的两次工具链调整。

可以在 make install 命令行使用’install_root’变量指定安装实际的安装目录(不同于 —prefix 指定的值)。这个在 chroot 环境下或者制作二进制包的时候通常很有用。’install_root’必须使用绝对路径。

被’grantpt’函数调用的辅助程序’/usr/libexec/pt_chown’以 setuid ‘root’ 安装。这个可能成为安全隐患。如果你的 Linux 内核支持’devptsfs’或’devfs’文件系统提供的 pty slave ,那么就不需要使用 pt_chown 程序。

安装完毕之后你还需要配置时区和 locale 。使用 localedef 来配置locale 。比如使用’localedef -i de_DE -f ISO-8859-1 de_DE’将 locale 设置为’de_DE.ISO-8859-1’。可以在编译目录中使用’make localedata/install-locales’命令配置所有可用的 locale ,但是一般不需要这么做。

时区使用’TZ’环境变量设置。tzselect 脚本可以帮助你选择正确的值。设置系统全局范围内的时区可以将 /etc/localtime 文件连接到 /usr/share/zoneinfo 目录下的正确文件上。比如对于中国人可以’ln -s /usr/share/zoneinfo/PRC /etc/localtime’。

Binutils 安装指南(2.18 → 2.19.1)

安装信息的来源

源码包内的下列文件:各级目录下的configure脚本 README {bfd,binutils,gas,gold,libiberty}/README

要点提示

如果想与GCC联合编译,那么可以将binutils包的内容解压到GCC的源码目录中(tar -xvf binutils-2.19.1.tar.bz2 —strip-components=1 -C gcc-4.3.3),然后按照正常编译GCC的方法编译即可。这样做的好处之一是可以完整的将 GCC 与 Binutils 进行一次bootstrap。

推荐用一个新建的目录来编译,而不是在源码目录中。编译完毕后可以使用”make check”运行测试套件。这个测试套件依赖于DejaGnu软件包,而DejaGnu又依赖于expect,expect依赖于tcl。

如果只想编译 ld 可以使用”make all-ld”,如果只想编译 as 可以使用”make all-gas”。类似的还有 clean-ld clean-as distclean-ld distclean-as check-ld check-as 等。

配置选项

下列选项皆为非默认值[特别说明的除外]1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26--help

--version

--quiet

--config-cache

--no-create

--srcdir=DIR

--prefix=PREFIX

--exec-prefix=EPREFIX

--bindir=DIR

--sbindir=DIR

--libexecdir=DIR

--datadir=DIR

--sysconfdir=DIR

--sharedstatedir=DIR

--localstatedir=DIR

--libdir=DIR

--includedir=DIR

--oldincludedir=DIR

--infodir=DIR

--mandir=DIR

--program-prefix=PREFIX

--program-suffix=SUFFIX

--program-transform-name=PROGRAM

--build=BUILD

--host=HOST

--target=TARGET

这些选项的含义基本上通用于所有软件包,这里就不特别讲解了。

—disable-nls

禁用本地语言支持(它允许按照非英语的本地语言显示警告和错误消息)。编译时出现”undefined reference to ‘libintl_gettext’”错误则必须禁用。

—disable-rpath

不在二进制文件中硬编码库文件的路径。

—disable-multilib

禁止编译适用于多重目标体系的库。例如,在x86_64平台上,默认既可以生成64位代码,也可以生成32位代码,若使用此选项,那么将只能生成64位代码。

—enable-cgen-maint=CGENDIR

编译cgen相关的文件[主要用于GDB调试]。

- —enable-shared[=PKG[,…]]

- —disable-shared

- —enable-static[=PKG[,…]]

- —disable-static

允许/禁止编译共享或静态版本的库和可执行程序,全部可识别的PKG如下:binutils,gas,gprof,ld,bfd,opcodes,libiberty(仅支持作为静态库)。static在所有目录下的默认值都是”yes”;而shared在不同子目录下默认值不同,有些为”yes”(binutils,gas,gprof,ld)有些为”no”(bfd,opcodes,libiberty)。

—enable-install-libbfd

—disable-install-libbfd

允许或禁止安装 libbfd 以及相关的头文件( libbfd 是二进制文件描述库,用于读写目标文件”.o”,被GDB/ld/as等程序使用)。本地编译或指定—enable-shared的情况下默认值为”yes”,否则默认值为”no”。

—enable-64-bit-bfd

让BFD支持64位目标,如果希望在32位平台上编译64程序就需要使用这个选项。如果指定的目标(TARGET)是64位则此选项默认打开,否则默认关闭(即使 —enable-targets=all 也是如此)。

—enable-elf-stt-common

允许BFD生成STT_COMMON类型的ELF符号。[2.19版本新增选项]

—enable-checking

—disable-checking

允许 as 执行运行时检查。正式发布版本默认禁用,快照版本默认启用。

—disable-werror

禁止将所有编译器警告当作错误看待(因为当编译器为GCC时默认使用-Werror)。

—enable-got=target|single|negative|multigot

指定GOT的处理模式。默认值是”target”。[2.19版本新增选项]

—enable-gold

使用gold代替GNU ld。gold是Google开发的连接器,2008年捐赠给FSF,目的是取代现有的GNU ld,但目前两者还不能完兼容。[2.19版本新增选项]

—enable-plugins

启用gold连接器的插件支持。[2.19版本新增选项]

—enable-threads

编译多线程版本的gold连接器。[2.19版本新增选项]

—with-lib-path=dir1:dir2…

指定编译出来的binutils工具(比如:ld)将来默认的库搜索路径,在绝大多数时候其默认值是”/lib:/usr/lib”。这个工作也可以通过设置 Makefile 中的 LIB_PATH 变量值完成。

—with-libiconv-prefix[=DIR]

—without-libiconv-prefix

在 DIR/include 目录中搜索 libiconv 头文件,在 DIR/lib 目录中搜索 libiconv 库文件。或者根本不使用 libiconv 库。

—with-libintl-prefix[=DIR]

—without-libintl-prefix

在 DIR/include 目录中搜索 libintl 头文件,在 DIR/lib 目录中搜索 libintl 库文件。或者根本不使用 libintl 库。

—with-mmap

使用mmap访问BFD输入文件。某些平台上速度较快,某些平台上速度较慢,某些平台上无法正常工作。

—with-pic

—without-pic

试图仅使用 PIC 或 non-PIC 对象,默认两者都使用。

以下选项仅在与GCC联合编译时才有意义,其含义与GCC相应选项的含义完全一样,默认值也相同。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28--enable-bootstrap

--disable-bootstrap

--enable-languages=lang1,lang2,...

--enable-stage1-checking

--enable-stage1-languages

--disable-libada

--disable-libgcj

--disable-libgomp

--disable-libmudflap

--disable-libssp

--enable-objc-gc

--disable-cloog-version-check

--disable-ppl-version-check

--with-gnu-as

--with-gnu-ld

--with-gmp=GMPDIR

--with-gmp-include=GMPINCDIR

--with-gmp-lib=GMPLIBDIR

--with-mpfr=MPFRDIR

--with-mpfr-include=MPFRINCDIR

--with-mpfr-lib=MPFRLIBDIR

--with-cloog=CLOOGDIR

--with-cloog_include=CLOOGINCDIR

--with-cloog_lib=CLOOGLIBDIR

--with-ppl=PPLDIR

--with-ppl_include=PPLINCDIR

--with-ppl_lib=PPLLIBDIR

--with-stabs

以下选项仅用于交叉编译环境

—enable-serial-[{host,target,build}-]configure

强制为 host, target, build 顺序配置子包,如果使用”all”则表示所有子包。

—with-sysroot=dir

将 dir 看作目标系统的根目录。目标系统的头文件、库文件、运行时对象都将被限定在其中。

—with-target-subdir=SUBDIR

为 target 在 SUBDIR 子目录中进行配置。

—with-newlib

将’newlib’(另一种标准C库,主要用于嵌入式环境)指定为目标系统的C库进行使用。

—with-build-sysroot=sysroot

在编译时将’sysroot’当作指定 build 平台的根目录看待。仅在已经使用了—with-sysroot选项的时候,该选项才有意义。

—with-build-subdir=SUBDIR

为 build 在 SUBDIR 子目录中进行配置。

—with-build-libsubdir=DIR

指定 build 平台的库文件目录。默认值是SUBDIR。

—with-build-time-tools=path

在给定的path中寻找用于编译Binutils自身的目标工具。该目录中必须包含 ar, as, ld, nm, ranlib, strip 程序,有时还需要包含 objdump 程序。例如,当编译Binutils的系统的文件布局和将来部署Binutils的目标系统不一致时就需要使用此选项。

—with-cross-host=HOST

这个选项已经被反对使用,应该使用—with-sysroot来代替其功能。

以下选项意义不大,一般不用考虑它们

—disable-dependency-tracking

禁止对Makefile规则的依赖性追踪。

—disable-largefile

禁止支持大文件。[2.19版本新增选项]

—disable-libtool-lock

禁止 libtool 锁定以加快编译速度(可能会导致并行编译的失败)

—disable-build-warnings

禁止显示编译时的编译器警告,也就是使用”-w”编译器选项进行编译。

—disable-fast-install

禁止为快速安装而进行优化。

—enable-maintainer-mode

启用无用的 make 规则和依赖性(它们有时会导致混淆)

—enable-commonbfdlib

—disable-commonbfdlib

允许或禁止编译共享版本的 BFD/opcodes/libiberty 库。分析configure脚本后发现这个选项事实上没有任何实际效果。

—enable-install-libiberty

安装 libiberty 的头文件(libiberty.h),许多程序都会用到这个库中的函数(getopt,strerror,strtol,strtoul)。这个选项经过实验,没有实际效果(相当于disable)。

—enable-secureplt

使得binutils默认创建只读的 plt 项。相当于将来调用 gcc 时默认使用 -msecure-plt 选项。仅对 powerpc-linux 平台有意义。

—enable-targets=TARGET,TARGET,TARGET…

使BFD在默认格式之外再支持多种其它平台的二进制文件格式,”all”表示所有已知平台。在32位系统上,即使使用”all”也只能支持所有32位目标,除非同时使用 —enable-64-bit-bfd 选项。由于目前 gas 并不能使用内置的默认平台之外的其它目标,因此这个选项没什么实际意义。此选项在所有目录下都没有默认值。但对于2.19版本,此选项在gold子目录下的默认值是”all”。

—with-bugurl=URL

—without-bugurl

指定发送bug报告的URL/禁止发送bug报告。默认值是”http://www.sourceware.org/bugzilla/"。

—with-datarootdir=DATADIR

将 DATADIR 用作数据根目录,默认值是[PREFIX/share]

—with-docdir=DOCDIR

—with-htmldir=HTMLDIR

—with-pdfdir=PDFDIR

指定各种文档的安装目录。DOCDIR默认值的默认值是DATADIR,HTMLDIR和PDFDIR的默认值是DOCDIR。

—with-included-gettext

使用软件包中自带的 GNU gettext 库。如果你已经使用了Glibc-2.0以上的版本,或者系统中已经安装了GNU gettext软件包,那么就没有必要使用这个选项。默认不使用。

—with-pkgversion=PKG

在 bfd 库中使用”PKG”代替默认的”GNU Binutils”作为版本字符串。比如你可以在其中嵌入编译时间或第多少次编译之类的信息。

—with-separate-debug-dir=DIR

在DIR中查找额外的全局debug信息,默认值:${libdir}/debug

—with-debug-prefix-map=’A=B C=D …’

在调试信息中建立 A-B,C-D, … 这样的映射关系。默认为空。[2.19版本新增选项]

GCC 安装指南(4.3 → 4.4)

要点提示

从GCC-4.3起,安装GCC将依赖于GMP-4.1以上版本和MPFR-2.3.2以上版本。如果将这两个软件包分别解压到GCC源码树的根目录下,并分别命名为”gmp”和”mpfr”,那么GCC的编译程序将自动将两者与GCC一起编译。建议尽可能使用最新的GMP和MPFR版本。

推荐用一个新建的目录来编译GCC,而不是在源码目录中,这一点玩过LFS的兄弟都很熟悉了。另外,如果先前在编译中出现了错误,推荐使用 make distclean 命令进行清理,然后重新运行 configure 脚本进行配置,再在另外一个空目录中进行编译。

配置选项

[注意]这里仅包含适用于 C/C++ 语言编译器、十进制数字扩展库(libdecnumber)、在多处理机上编写并行程序的应用编程接口GOMP库(libgomp)、大杂烩的libiberty库、执行运行时边界检查的库(libmudflap)、保护堆栈溢出的库(libssp)、标准C++库(libstdc++) 相关的选项。也就是相当于 gcc-core 与 gcc-g++ 两个子包的选项。并不包括仅仅适用于其他语言的选项。

每一个 —enable 选项都有一个对应的 —disable 选项,同样,每一个 —with 选项也都用一个对应的 —without 选项。每一对选项中必有一个是默认值(依赖平台的不同而不同)。下面所列选项若未特别说明皆为非默认值。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26--help

--version

--quiet

--config-cache

--no-create

--srcdir=DIR

--prefix=PREFIX

--exec-prefix=EPREFIX

--bindir=DIR

--sbindir=DIR

--libexecdir=DIR

--datadir=DIR

--sysconfdir=DIR

--sharedstatedir=DIR

--localstatedir=DIR

--libdir=DIR

--includedir=DIR

--oldincludedir=DIR

--infodir=DIR

--mandir=DIR

--program-prefix=PREFIX

--program-suffix=SUFFIX

--program-transform-name=PROGRAM

--build=BUILD

--host=HOST

--target=TARGET

这些选项的含义基本上通用于所有软件包,这里就不特别讲解了。

—disable-nls

禁用本地语言支持(它允许按照非英语的本地语言显示警告和错误消息)。编译时出现”undefined reference to ‘libintl_gettext’”错误则必须禁用。

—disable-rpath

不在二进制文件中硬编码库文件的路径。

—enable-bootstrap

—disable-bootstrap

“bootstrap”的意思是用第一次编译生成的程序来第二次编译自己,然后又用第二次编译生成的程序来第三次编译自己,最后比较第二次和第三次编译的结果,以确保编译器能毫无差错的编译自身,这通常表明编译是正确的。非交叉编译的情况下enable是默认值;交叉编译的情况下,disable是默认值。提示:stage2出来的结果是”最终结果”。

—enable-checking[=LIST]

该选项会在编译器内部生成一致性检查的代码,它并不改变编译器生成的二进制结果。这样导致编译时间增加,并且仅在使用GCC作为编译器的时候才有效,但是对输出结果没有影响。在”gcc”子目录下,对从CVS下载的版本默认值是”yes”(=assert,misc,tree,gc,rtlflag,runtime),对于正式发布的版本则是”release”(=assert,runtime),在”libgcc”子目录下,默认值始终是”no”。可以从 “assert,df,fold,gc,gcac,misc,rtlflag,rtl,runtime,tree,valgrind”中选择你想要检查的项目(逗号隔开的列表,”all”表示全部),其中rtl,gcac,valgrind非常耗时。使用 —disable-checking 完全禁止这种检查会增加未能检测内部错误的风险,所以不建议这样做。

—enable-languages=lang1,lang2,…

只安装指定语言的编译器及其运行时库,可以使用的语言是:ada, c, c++, fortran, java, objc, obj-c++ ,若不指定则安装所有默认可用的语言(ada和obj-c++为非默认语言)。

—disable-multilib

禁止编译适用于多重目标体系的库。例如,在x86_64平台上,编译器默认既可以生成64位代码,也可以生成32位代码,若使用此选项,那么将只能生成64位代码。

—enable-shared[=PKG[,…]]

—disable-shared

—enable-static[=PKG[,…]]

—disable-static

允许/禁止编译共享或静态版本的库,全部可识别的库如下:libgcc,libstdc++,libffi,zlib,boehm-gc,ada,libada,libjava,libobjc,libiberty(仅支持作为静态库)。static在所有目录下的默认值都是”yes”;shared除了在libiberty目录下的默认值是”no”外,在其它目录下的默认值也都是”yes”。

—enable-decimal-float[=bid|dpd]

—disable-decimal-float

启用或禁用 libdecnumber 库符合 IEEE 754-2008 标准的 C 语言十进制浮点扩展,还可以进一步选择浮点格式(bid是i386与x86_64的默认值;dpd是PowerPC的默认值)。在 PowerPC/i386/x86_64 GNU/Linux 系统默认启用,在其他系统上默认禁用。

—disable-libgomp

不编译在多处理机上编写并行程序的应用编程接口GOMP库(libgomp)。

—disable-libmudflap

不编译执行运行时边界检查的库(libmudflap)。

—disable-libssp

不编译保护缓冲区溢出的运行时库。

—disable-symvers

禁用共享库对象中符号包含的版本信息。使用这个选项将导致 ABI 发生改变。禁用版本信息可以减小库的体积,但是将不兼容依赖于老版本库的二进制程序。它还会导致 libstdc++ 的 abi_check 测试失败,但你可以忽略这个失败。

—enable-threads=posix|aix|dce|gnat|mach|rtems|solaris|vxworks|win32|nks

—disable-threads

启用或禁用线程支持,若启用,则必须同时明确指定线程模型(不同平台支持的线程库并不相同,Linux现在一般使用posix)。这将对Objective-C编译器、运行时库,以及C++/Java等面向对象语言的异常处理产生影响。

—enable-version-specific-runtime-libs

将运行时库安装在编译器特定的子目录中(${libdir}/gcc-lib/${target_alias}/${gcc_version}),而不是默认的${libdir}目录中。另外,’libstdc++’的头文件将被安装在 ${libdir}/gcc-lib/${target_alias}/${gcc_version}/include/g++ 目录中(除非同时又指定了 —with-gxx-include-dir)。如果你打算同时安装几个不同版本的 GCC ,这个选项就很有用处了。当前,libgfortran,libjava,libmudflap,libstdc++,libobjc都支持该选项。

—enable-werror

—disable-werror

是否将所有编译器警告当作错误看待(使用-Werror来编译)。对于开发中的版本和快照默认为”yes”,对于正式发布的版本则默认为”no”。

—with-as=pathname

—with-ld=pathname

指定将来GCC使用的汇编器/连接器的位置,必须使用绝对路径。如果configure的默认查找过程找不到汇编器/连接器,就会需要该选项。或者系统中有多个汇编器/连接器,也需要它来指定使用哪一个。如果使用GNU的汇编器,那么你必须同时使用GNU连接器。

—with-datarootdir=DATADIR

将 DATADIR 用作数据根目录,默认值是[PREFIX/share]

—with-docdir=DOCDIR

—with-htmldir=HTMLDIR

—with-pdfdir=PDFDIR

指定各种文档的安装目录。DOCDIR默认值的默认值是DATADIR,HTMLDIR和PDFDIR的默认值是DOCDIR。

—with-gmp=GMPDIR

—with-gmp-include=GMPINCDIR

—with-gmp-lib=GMPLIBDIR

指定 GMP 库的安装目录/头文件目录/库目录。指定GMPDIR相当于同时指定了:GMPINCDIR=GMPDIR/include,GMPLIBDIR=GMPDIR/lib 。

—with-mpfr=MPFRDIR

—with-mpfr-include=MPFRINCDIR

—with-mpfr-lib=MPFRLIBDIR

指定 MPFR 库的安装目录/头文件目录/库目录。指定MPFRDIR相当于同时指定了:MPFRINCDIR=MPFRDIR/include,MPFRLIBDIR=MPFRDIR/lib 。

—with-cloog=CLOOGDIR

—with-cloog_include=CLOOGINCDIR

—with-cloog_lib=CLOOGLIBDIR

指定CLooG(Chunky Loop Generator)的安装目录/头文件目录/库目录。指定CLOOGDIR相当于同时指定了:CLOOGINCDIR=CLOOGDIR/include,CLOOGLIBDIR=CLOOGDIR/lib 。[GCC-4.4新增选项]

—with-ppl=PPLDIR

—with-ppl_include=PPLINCDIR

—with-ppl_lib=PPLLIBDIR

指定PPL(Parma Polyhedra Library)的安装目录/头文件目录/库目录。指定PPLDIR相当于同时指定了:PPLINCDIR=PPLDIR/include,PPLLIBDIR=PPLDIR/lib 。[GCC-4.4新增选项]

—with-gxx-include-dir=DIR

G++头文件的安装目录,默认为”prefix/include/c++/版本”。

—with-libiconv-prefix[=DIR]

—without-libiconv-prefix

在 DIR/include 目录中搜索 libiconv 头文件,在 DIR/lib 目录中搜索 libiconv 库文件。或者根本不使用 libiconv 库。

—with-libintl-prefix[=DIR]

—without-libintl-prefix

在 DIR/include 目录中搜索 libintl 头文件,在 DIR/lib 目录中搜索 libintl 库文件。或者根本不使用 libintl 库。

—with-local-prefix=DIR

指定本地包含文件的安装目录,不管如何设置—prefix,其默认值都为 /usr/local 。只有在系统已经建立了某些特定的目录规则,而不再是在 /usr/local/include 中查找本地安装的头文件的时候,该选项才使必须的。不能指定为 /usr ,也不能指定为安装GCC自身头文件的目录(默认为$libdir/gcc/$target/$version/include),因为安装的头文件会和系统的头文件混合,从而造成冲突,导致不能编译某些程序。

—with-long-double-128

—without-long-double-128

指定long double类型为 128-bit 或 64-bit(等于double) 。基于 Glibc 2.4 或以上版本编译时默认为 128-bit ,其他情况默认为 64-bit ;但是可以使用这个选项强制指定。

—with-pic

—without-pic

试图仅使用 PIC 或 non-PIC 对象,默认两者都使用。

—with-slibdir=DIR

共享库(libgcc)的安装目录,默认等于 —libdir 的值。

—with-system-libunwind

使用系统中已经安装的libunwind库,默认自动检测。

—with-system-zlib

使用系统中的libz库,默认使用GCC自带的库。

以下选项仅适用于 C++ 语言:

—disable-c99

禁止支持 C99 标准。该选项将导致 ABI 接口发生改变。

—enable-cheaders=c|c_std|c_global

为 g++ 创建C语言兼容的头文件,默认为”c_global”。

—enable-clocale[=gnu|ieee_1003.1-2001|generic]

指定目标系统的 locale 模块,默认值为自动检测。建议明确设为”gnu”,否则可能会编译出 ABI 不兼容的 C++ 库。

—enable-clock-gettime[=yes|no|rt]

指明如何获取C++0x草案里面time.clock中clock_gettime()函数:”yes”表示在libc和libposix4库中检查(而libposix4在需要的时候还可能会链接到libstdc++)。”rt”表示还额外在librt库中查找,这一般并不是一个很好的选择,因为librt经常还会连接到libpthread上,从而使得单线程的程序产生不必要的锁定开销。默认值”no”则完全跳过这个检查。[GCC-4.4新增选项]

—enable-concept-checks

打开额外的实例化库模板编译时检查(以特定的模板形式),这可以帮助用户在他们的程序运行之前就发现这些程序在何处违反了STL规则。

—enable-cstdio=PACKAGE

使用目标平台特定的 I/O 包,PACKAGE的默认值是”stdio”,也是唯一可用的值。使用这个选项将导致 ABI 接口发生改变。

—enable-cxx-flags=FLAGS

编译 libstdc++ 库文件时传递给编译器的编译标志,是一个引号界定的字符串。默认为空,表示使用环境变量 CXXFLAGS 的值。

—enable-fully-dynamic-string

该选项启用了一个特殊版本的 basic_string 来禁止在预处理的静态存储区域中放置空字符串的优化手段。参见 PR libstdc++/16612 获取更多细节。

—disable-hosted-libstdcxx

默认编译特定于主机环境的C++库。使用该选项将仅编译独立于主机环境的C++运行时库(前者的子集)。

—enable-libstdcxx-allocator[=new|malloc|mt|bitmap|pool]

指定目标平台特定的底层 std::allocator ,默认自动检测。使用这个选项将导致 ABI 接口发生改变。

—enable-libstdcxx-debug

额外编译调试版本的 libstdc++ 库文件,并默认安装在 ${libdir}/debug 目录中。

—enable-libstdcxx-debug-flags=FLAGS

编译调试版本的 libstdc++ 库文件时使用的编译器标志,默认为”-g3 -O0”

—disable-libstdcxx-pch

禁止创建预编译的 libstdc++ 头文件(stdc++.h.gch),这个文件包含了所有标准 C++ 的头文件。该选项的默认值等于hosted-libstdcxx的值。

—disable-long-long

禁止使用模板支持’long long’类型。’long long’是 C99 新引进的类型,也是 GNU 对 C++98 标准的一个扩展。该选项将导致 ABI 接口发生改变。

—enable-sjlj-exceptions

强制使用旧式的 setjmp/longjmp 异常处理模型,使用这个选项将导致 ABI 接口发生改变。默认使用可以大幅降低二进制文件尺寸和内存占用的新式的 libunwind 库进行异常处理。建议不要使用此选项。

—disable-visibility

禁止 -fvisibility 编译器选项的使用(使其失效)。

—disable-wchar_t

禁止使用模板支持多字节字符类型’wchar_t’。该选项将导致 ABI 接口发生改变。

以下选项仅用于交叉编译:

—enable-serial-[{host,target,build}-]configure

强制为 host, target, build 顺序配置子包,如果使用”all”则表示所有子包。

—with-sysroot=DIR

将DIR看作目标系统的根目录。目标系统的头文件、库文件、运行时对象都将被限定在其中。其默认值是 ${gcc_tooldir}/sys-root 。

—with-target-subdir=SUBDIR

为 target 在 SUBDIR 子目录中进行配置。

—with-newlib

将’newlib’指定为目标系统的C库进行使用。这将导致 libgcc.a 中的 __eprintf 被忽略,因为它被假定为由’newlib’提供。

—with-build-subdir=SUBDIR

为 build 在 SUBDIR 子目录中进行配置。

—with-build-libsubdir=DIR

指定 build 平台的库文件目录。默认值是SUBDIR。

—with-build-sysroot=sysroot

在编译时将’sysroot’当作指定 build 平台的根目录看待。仅在已经使用了—with-sysroot选项的时候,该选项才有意义。

—with-build-time-tools=path

在给定的path中寻找用于编译GCC自身的目标工具。该目录中必须包含 ar, as, ld, nm, ranlib, strip 程序,有时还需要包含 objdump 程序。例如,当编译GCC的系统的文件布局和将来部署GCC的目标系统不一致时就需要使用此选项。

—with-cross-host=HOST

这个选项已经被反对使用,应该使用—with-sysroot来代替其功能。

编译、测试、安装

除了使用 CFLAGS,LDFLAGS 之外,还可以使用 LIBCFLAGS,LIBCXXFLAGS 控制库文件(由stage3编译)的编译器选项。可以在 make 命令行上使用 BOOT_CFLAGS,BOOT_LDFLAGS 来控制 stage2,stage3 的编译。可以使用 make bootstrap4 来增加步骤以避免 stage1 可能被错误编译所导致的错误。可以使用 make profiledbootstrap 在编译stage1时收集一些有用的统计信息,然后使用这些信息编译最终的二进制文件,这样可以提升编译器和相应库文件的执行效率。

编译完毕后可以使用”make check”运行测试套件,然后可以和http://gcc.gnu.org/buildstat.html里面列出来的结果进行对比,只要"unexpected failures”不要太多就好说。这个测试套件依赖于DejaGnu软件包,而DejaGnu又依赖于expect,expect依赖于tcl。如果只想运行C++测试,可以使用”make check-g++”命令;如果只想运行C编译器测试,可以使用”make check-gcc”。还可以制定只运行某些单项测试:比如使用 make check RUNTESTFLAGS=”compile.exp -v” 运行编译测试。另一方面,GCC并不支持使用”make uninstall”进行卸载,建议你将GCC安装在一个特别的目录中,然后在不需要的时候直接删除这个目录。

因为GCC的安装依赖于GMP和MPFR,所以下面附上GMP和MPFR的安装信息,主要是configure选项。

优化基本原理

编译原理出于代码编译的模块化组装考虑,一般会在语义分析的阶段生成平台无关的中间代码,经过中间代码级的代码优化,而后作为输入进入代码生成阶段,产生最终运行机器平台上的目标代码,再经过一次目标代码级别的代码优化(一般和具体机器的硬件结构高度耦合,复杂且不通用)。故而出于理解编译原理的角度考虑,代码优化一般都是以中间代码级代码优化手段作为研究对象。

代码优化按照优化的代码块尺度分为:局部优化、循环优化和全局优化。即

- 局部优化:只有一个控制流入口、一个控制流出口的基本程序块上进行的优化;

- 循环优化:对循环中的代码进行的优化;

- 全局优化:在整个程序范围内进行的优化。

常见的代码优化手段

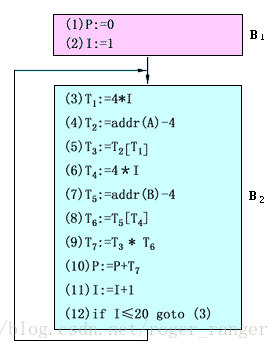

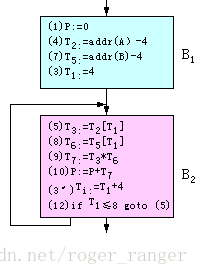

常见的代码优化技术有:删除多余运算、合并已知量和复写传播,删除无用赋值等。采用转载自《编译原理》教材中关于这些优化技术的图例快速地展示下各优化技术的具体内容。

针对目标代码:1

2

3P := 0

for I := 1 to 20 do

P := P + A[I]*B[I]

假设其翻译所得的中间代码如下

删除多余运算:分析上图的中间代码,可以发现 (3)和式 (6)属于重复计算( 因为I并没有发生变化),故而式 (6)是多余的,完全可以采用 T4∶=T1代替。

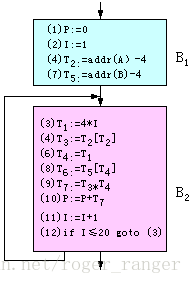

代码外提:减少循环中代码总数的一个重要办法是循环中不变的代码段外提。这种变换把循环不变运算,即结果独立于循环执行次数的表达式,提到循环的前面,使之只在循环外计算一次。针对改定的例子,显然数组A和 B的首地址在计算过程中并不改变,则作出的改动如下

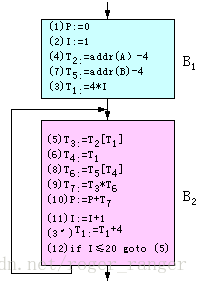

强度削弱:强度削弱的本质是把强度大的运算换算成强度小的运算,例如将乘法换成加法运算。针对上面的循环过程,每循环一次,I的值增加1,T1的值与I保持线性关系,每次总是增加4。因此,可以把循环中计算T1值的乘法运算变换成在循环前进行一次乘法运算,而在循环中将其变换成加法运算。

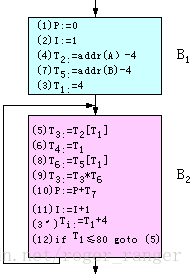

变换循环控制条件:I和T1始终保持T1=4*I的线性关系,因此可以把四元式(12)的循环控制条件I≤20变换成T1≤80,这样整个程序的运行结果不变。这种变换称为变换循环控制条件。经过这一变换后,循环中I的值在循环后不会被引用,四元式(11)成为多余运算,可以从循环中删除。变换循环控制条件可以达到代码优化的目的。

合并已知量和复写传播:四元式(3)计算4*I时,I必为1。即4*I的两个运算对象都是编码时的已知量,可在编译时计算出它的值,即四元式(3)可变为T1=4,这种变换称为合并已知量。

四元式(6)把T1的值复写到T4中,四元式(8)要引用T4的值,而从四元式(6)到四元式(8)之间未改变T4和T1的值,则将四元式(8)改为T6∶=T5[T1],这种变换称为复写传播。

删除无用赋值:式(6)对T4赋值,但T4未被引用;另外,(2)和(11)对I赋值,但只有(11)引用I。所以,只要程序中其它地方不需要引用T4和I,则(6),(2)和(11)对程序的运行结果无任何作用。我们称之为无用赋值,无用赋值可以从程序中删除。至此,我们可以得到删减后简洁的代码

基本块内的局部优化

基本块的划分

入口语句的定义如下:

- 程序的第一个语句;或者,

- 条件转移语句或无条件转移语句的转移目标语句;

- 紧跟在条件转移语句后面的语句。

有了入口语句的概念之后,就可以给出划分中间代码(四元式程序)为基本块的算法,其步骤如下:

- 求出四元式程序中各个基本块的入口语句。

- 对每一入口语句,构造其所属的基本块。它是由该入口语句到下一入口语句(不包括下一入口语句),或到一转移语句(包括该转移语句),或到一停语句(包括该停语句)之间的语句序列组成的。

- 凡未被纳入某一基本块的语句、都是程序中控制流程无法到达的语句,因而也是不会被执行到的语句,可以把它们删除。

基本块的优化手段

由于基本块内的逻辑清晰,故而要做的优化手段都是较为直接浅层次的。目前基本块内的常见的块内优化手段有:

- 删除公共子表达式

- 删除无用代码

- 重新命名临时变量 (一般是用来应对创建过多临时变量的,如t2 := t1 + 3如果后续并没有对t1的引用,则可以t1 := t1 + 3来节省一个临时变量的创建)

- 交换语句顺序

- 在结果不变的前提下,更换代数操作(如x∶=y2是需要根据运算符重载指数函数的,这是挺耗时的操作,故而可以用强度更低的x∶=y*y来代替)

根据以上原则,对如下代码进行优化给出优化的终版代码1

2

3

4

5

6t1 := 4 - 2

t2 := t1 / 2

t3 := a * t2

t4 := t3 * t1

t5 := b + t4

c := t5 * t5显然代码优化的工作不能像上面那样的人工一步步确认和遍历,显然必然要将这些优化工作公理化。而一般到涉及到数据流和控制流简化的这种阶段,都是到了图论一展身手的时候。1

2

3t1 := a + a

t1 := b + t1

c := t1 * t1

DAG(无环路有向图)应用于基本块的优化工作

在DAG图中,通过节点间的连线和层次关系来表示表示式或运算的归属关系:

- 图的叶结点,即无后继的结点,以一标识符(变量名)或常数作为标记,表示这个结点代表该变量或常数的值。如果叶结点用来代表某变量A的地址,则用addr(A)作为这个结点的标记。

- 图的内部结点,即有后继的结点,以一运算符作为标记,表示这个结点代表应用该运算符对其后继结点所代表的值进行运算的结果。

(注:该部分内容转载自教材《编译原理》第11章DAG无环路有向图应用于代码优化)

DAG构建的流程如下

- 对基本块的每一四元式,依次执行:

- 1如果NODE(B)无定义,则构造一标记为B的叶结点并定义NODE(B)为这个结点;

- 如果当前四元式是0型,则记NODE(B)的值为n,转4。

- 如果当前四元式是1型,则转2.(1)。

- 如果当前四元式是2型,则:(Ⅰ)如果NODE(C)无定义,则构造一标记为C的叶结点并定义NODE(C)为这个结点,(Ⅱ)转2.(2)。

- 2

- 如果NODE(B)是标记为常数的叶结点,则转2.(3),否则转3.(1)。

- 如果NODE(B)和NODE(C)都是标记为常数的叶结点,则转2.(4),否则转3.(2)。

- 执行op B(即合并已知量),令得到的新常数为P。如果NODE(B)是处理当前四元式时 新构造出来的结点,则删除它。如果NODE(P)无定义,则构造一用P做标记的叶结点n。置NODE(P)=n,转4.。

- 执行B op C(即合并已知量),令得到的新常数为P。如果NODE(B)或NODE(C)是处理当前四元式时新构造出来的结点,则删除它。如果NODE(P)无定义,则构造一用P做标记的叶结点n。置NODE(P)=n,转4.。

- 3.

- 检查DAG中是否已有一结点,其唯一后继为NODE(B),且标记为op(即找公共子表达式)。如果没有,则构造该结点n,否则就把已有的结点作为它的结点并设该结点为n,转4.。

- 检查DAG中是否已有一结点,其左后继为NODE(B),右后继为NODE(C),且标记为op(即找公共子表达式)。如果没有,则构造该结点n,否则就把已有的结点作为它的结点并设该结点为n。转4.。

- 4.

- 如果NODE(A)无定义,则把A附加在结点n上并令NODE(A)=n;否则先把A从NODE(A)结点上的附加标识符集中删除(注意,如果NODE(A)是叶结点,则其标记A不删除),把A附加到新结点n上并令NODE(A)=n。转处理下一四元式。

- 1如果NODE(B)无定义,则构造一标记为B的叶结点并定义NODE(B)为这个结点;

说着很复杂,下面看一个案例1

2

3

4

5

6

7

8

9

10(1) T0∶=3.14

(2) T1∶=2 * T0

(3) T2∶=R + r

(4) A∶=T1 * T2

(5) B∶=A

(6) T3∶=2 * T0

(7) T4∶=R + r

(8) T5∶=T3 * T4

(9) T6∶=R - r

(10) B∶=T5 * T6

其DAG图的构建过程如下

通过DAG图可以发现诸多的优化信息,如重复定义、无用定义等,则根据上图的DAG图可以构建最后的优化代码序列1

2

3

4 (1) S1∶=R+r

(2) A∶=6.28*S1

(3) S2∶=R-r

(4) B∶=A *S2

循环优化

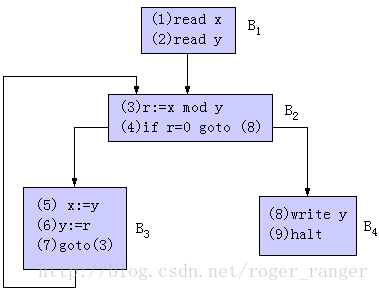

根据上面基本块的定义,我们将诸多基本块组装在一起,构建成程序循环图,如针对下面这个例子1

2

3

4

5

6

7

8

9 (1) read x

(2) read y

(3) r∶=x mod y

(4) if r=0 goto (8)

(5) x∶=y

(6) y∶=r

(7) goto (3)

(8) write y

(9) halt

则按照上面基本块的划分,可以分成四个部分,四个部分的控制流分析可知可以得到一个循环图

循环块最主要的特点是只有一个数据流和控制流入口,而出口可能有多个。循环优化的主要手段有:循环次数无关性代码外提、删除归纳变量和运算强度削弱。关于这三种手段的理解可以借助此前的描述进行类比,基本并无太多差异。

编译时的数学库问题

前言

链接是代码生成可执行文件中一个非常重要的过程。我们在使用一些库函数时,有时候需要链接库,有时候又不需要,这是为什么呢?了解一些链接的基本过程,能够帮助我们在编译时解决一些疑难问题。比如,下面就有一种奇怪的现象。

一个奇怪的链接问题

程序功能很简单,计算e的n次方。程序清单如下(代码一):1

2

3

4

5

6

7

8

int main(int argc,char *argv[])

{

double a = exp(2);

printf("%lf\n",a);

return 0;

}

编译运行:1

2

3gcc -o expTest expTest.c

./expTest

7.389056

一切似乎顺理成章,我们再来看下面这种情况,将变量b=2传入exp函数(代码二):1

2

3

4

5

6

7

8

9

int main(int argc,char *argv[])

{

int b = 2;

double a = exp(b);

printf("%lf\n",a);

return 0;

}

编译:1

2

3

4gcc -o expTest expTest.c

/tmp/ccx5lXbS.o:在函数‘main’中:

expTest.c:(.text+0x20):对‘exp’未定义的引用

collect2: error: ld returned 1 exit status

我们发现,同样的编译方法编译不过了,提示对‘exp’未定义的引用,并且抛出链接出错。

我们通过man命令查看exp函数:1

2

3

4

5

6

7

8

9

10

11

12man 3 exp

NAME

exp, expf, expl - base-e exponential function

SYNOPSIS

#include <math.h>

double exp(double x);

float expf(float x);

long double expl(long double x);

Link with -lm.

发现它除了需要包含头文件math.h外,编译时还需要使用-lm链接。

再次编译运行:1

2

3

4gcc -lm -o expTest expTest.c

/tmp/ccYT3E65.o:在函数‘main’中:

expTest.c:(.text+0x20):对‘exp’未定义的引用

collect2: error: ld returned 1 exit status

为什么还是不行呢?我们已经按照帮助手册的只是加了-lm了啊?难道是位置不对?我们换个位置试试:1

2

3gcc -o expTest expTest.c -lm

./expTest

7.389056

现在终于成功编译并运行。

分析

虽然最后终于成功编译运行,但是不免产生了几个疑问:

两段代码同样都调用了exp函数,为什么一个需要链接,一个不需要链接呢?

到底什么时候需要链接呢?

为什么链接的时候放在前面就不行呢?

我们一一解答。

1.为什么一个需要链接,一个不需要?

我们可以观察到,代码一调用exp传入的参数是常量2,代码二调用exp传入的参数是变量b,那么对于代码一会不会在运行之前就计算好了呢?

我们来看一下它们的汇编代码。

代码一:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20.LC1:

.string "%lf\n"

main:

push rbp

mov rbp, rsp

sub rsp, 32

mov DWORD PTR [rbp-20], edi

mov QWORD PTR [rbp-32], rsi

movsd xmm0, QWORD PTR .LC0[rip]

movsd QWORD PTR [rbp-8], xmm0

movsd xmm0, QWORD PTR [rbp-8]

mov edi, OFFSET FLAT:.LC1

mov eax, 1

call printf

mov eax, 0

leave

ret

.LC0:

.long 3100958126

.long 1075678820

代码二:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20.LC0:

.string "%lf\n"

main:

push rbp

mov rbp, rsp

sub rsp, 32

mov DWORD PTR [rbp-20], edi

mov QWORD PTR [rbp-32], rsi

mov DWORD PTR [rbp-4], 2

cvtsi2sd xmm0, DWORD PTR [rbp-4]

call exp

movq rax, xmm0

mov QWORD PTR [rbp-16], rax

movsd xmm0, QWORD PTR [rbp-16]

mov edi, OFFSET FLAT:.LC0

mov eax, 1

call printf

mov eax, 0

leave

ret

汇编的具体细节我们无需尽知,但是我们可以很明显地看到,第二段代码调用了exp函数(call exp指令),而第一段代码没有看到调用exp的身影。

实际上,通过汇编代码可以看到,当传入参数为常量时,就已经计算好了值(emm0寄存器为浮点运算相关寄存器),最后根本不需要调用exp函数。而对于变量型的参数,其值在运行时确定,因此需要调用。我们还可以通过ldd命令来看它们链接的库有什么不同。

对于代码一:1

2

3

4ldd expTest

linux-vdso.so.1 => (0x00007ffec079d000)

libc.so.6 => /lib/x86_64-linux-gnu/libc.so.6 (0x00007fd327744000)

/lib64/ld-linux-x86-64.so.2 (0x00007fd327b0e000)

对于代码二:1

2

3

4

5ldd expTest

linux-vdso.so.1 => (0x00007ffefdfc9000)

libm.so.6 => /lib/x86_64-linux-gnu/libm.so.6 (0x00007f9afcccb000)

libc.so.6 => /lib/x86_64-linux-gnu/libc.so.6 (0x00007f9afc901000)

/lib64/ld-linux-x86-64.so.2 (0x00007f9afcfd4000)

可以看到,第二段代码编译出来的可执行文件,多依赖了libm.so.6,也就是exp函数所在的库。

2.什么时候需要链接?

事实上,C编译器总是主动传送libc.a或libc.so给链接器,也就是说,对于使用包含在libc.a或libc.so库中的函数,是不需要在编译时手动链接的。而调用函数是否需要链接,可以使用命令“man 3 函数名“查看,如果需要链接库,最后都有说明。

3.为什么链接的时候放在前面就不行呢?

这个就涉及到链接器的工作原理了,在此只简单说明一下:链接过程中,需要进行符号解析,并且是按照顺序解析;如果库链接在前,就可能出现库中的符号不会被需要,链接器不会把它加到未解析的符号集合中,那么后面引用这个符号的目标文件就不能解析该引用,导致最后链接失败。因此链接库的一般准则是将它们放在命令行的结尾。

总结

通过前面的实例和分析,我们总结出以下几点:

调用包含于libc库中的函数不需要链接。

对于传参为常量的数学函数调用,生成可执行文件过程中可能将其优化,而无需调用该函数。

库链接一般放在命令行结尾。

通过man命令查看在调用某个函数时是否需要链接。

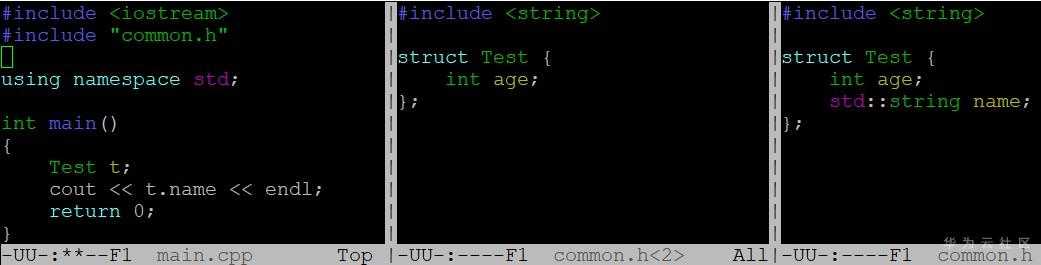

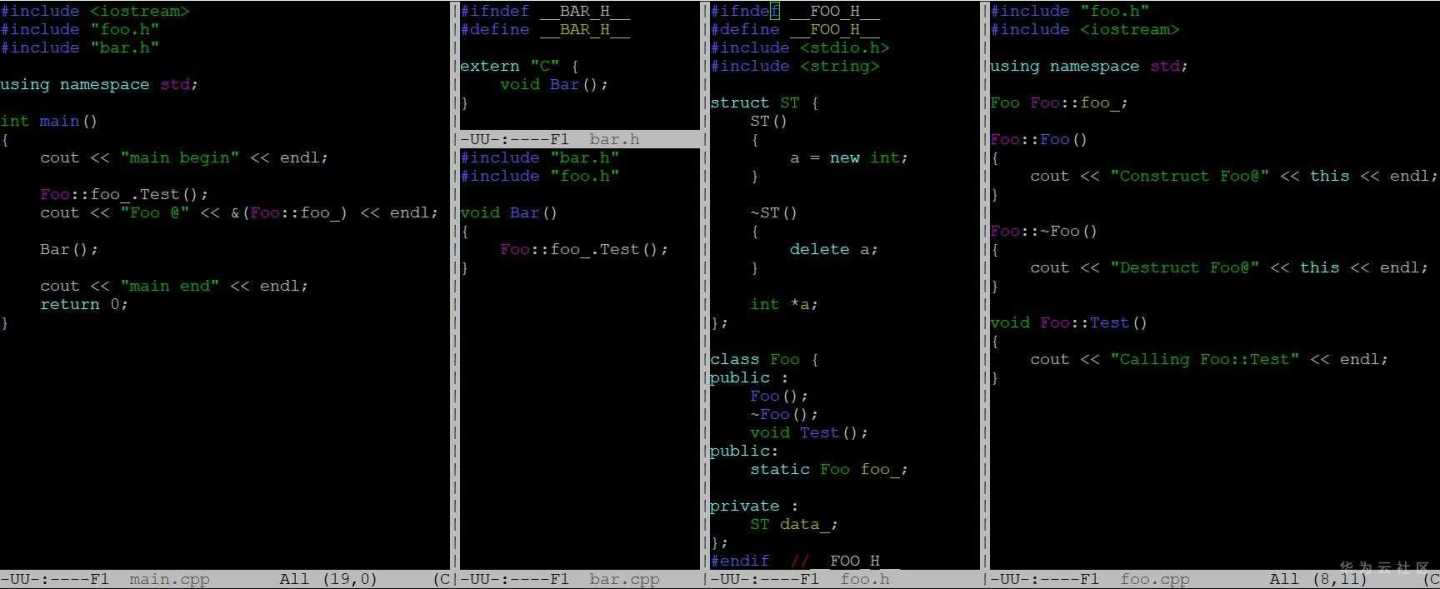

头文件遮挡

在编译过程中最诡异的问题莫过于头文件遮挡,如下代码中main.cpp包含头文件common.h,真正想用的头文件是图中最右边那个包含name

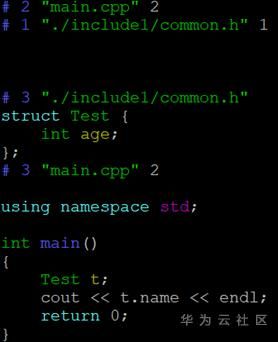

成员的文件(所在目录为./include),但在编译过程中中间的common.h(所在目录为./include1)抢先被发现,导致编译器报错:Test结构没有name成员,对程序员来讲,自己明明定义了name成员,居然说没有name这个成员,如果第一次碰到这种情况可能会怀疑人生。应对这种诡异的问题,我们可以用-E参数看下编译器预处理后的输出,如下图。

预处理文件格式如下:# linenum filename flag,表示之后的内容是从文件名为filaname的文件中第linenum行展开的,flag的取值可以是1,2,3,4,可以是用空格分开的多值,1表示接下来要展开一个新文件;2表示一个文件展开完毕;3表示接下来内容来自一个系统头文件;4表示接下来的内容应该看做是extern C形式引入的。

从展开后的输出我们可以清楚地看到Test结构确实没有定义name这个成员,并且Test这个结构是在./include1中的common.h中定义的,到此真相大白,编译器压根就没用我们定义的Test结构,而是被别的同名头文件截胡了。我们可以通过调整-I或者在头文件中带上部分路径更详细制定头文件位置来解决。

目标文件:

编译链接最终会生成各种目标文件,Linux下目标文件格式为ELF(Executable Linkable Format),详细定义见/usr/include/elf.h头文件,常见的目标文件有:可重定位目标文件,也即.o结尾的目标文件,当然静态库也归为此类;可执行文件,比如默认编译出的a.out文件;共享目标文件.so;核心转储文件,也就是core dump后产出的文件。Linux文件格式可以通过file命令查看。

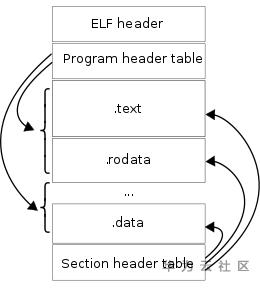

一个典型的ELF文件格式如下图所示,文件有两种视角:编译视角,以section头部表为核心组织程序;运行视角,程序头部表以segment为核心组织程序。这么做主要是为了节约存储,很多细碎的section在运行时由于对齐要求会导致很大的内存浪费,运行时通常会将权限类似的section组织成segment一起加载。

通过命令objdump和readelf可以查看ELF文件的内容。

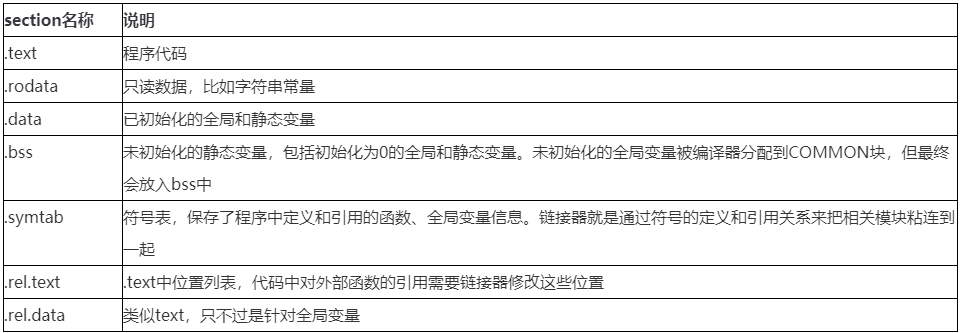

对可重定位目标文件常见的section有:

符号解析:

链接器会为对外部符号的引用修改为正确的被引用符号的地址,当无法为引用的外部符号找到对应的定义时,链接器会报undefined reference to XXXX的错误。另外一种情况是,找到了多个符号的定义,这种情况链接器有一套规则。在描述规则前需要了解强符号和弱符号的概念,简单讲函数和已初始化的全局变量是强符号,未初始化的全局变量是弱符号。

针对符号的多重定义链接器处理规则如下(作者在gcc 7.3.0上貌似规则2,3都按1处理):

- 不允许多个强符号定义,链接器会报告重复定义貌似的错误

- 如果一个强符号和多个弱符号同名,则选择强符号

- 如果符号在所有目标文件中都为弱符号,那么选择占用空间最大的一个

有了这些基础,我们先来看一下静态链接过程:

- 链接器从左到右按照命令行出现顺序扫描目标文件和静态库

- 链接器维护一个目标文件的集合E,一个未解析符号集合U,以及E中已定义的符号集合D,初始状态E、U、D都为空

- 对命令行上每个文件f,链接器会判断f是否是一个目标文件还是静态库,如果是目标文件,则f加入到E,f中未定义的符号加入到U中,已定义符号加入到D中,继续下一文件

- 如果是静态库,链接器尝试到静态库目标文件中匹配U中未定义的符号,如果m中匹配U中的一个符号,那么m就和上步中文件f一样处理,对每个成员文件都依次处理,直到U、D无变化,不包含在E中的成员文件简单丢弃

- 所有输入文件处理完后,如果U中还有符号,则出错,否则链接正常,输出可执行文件

静态库顺序

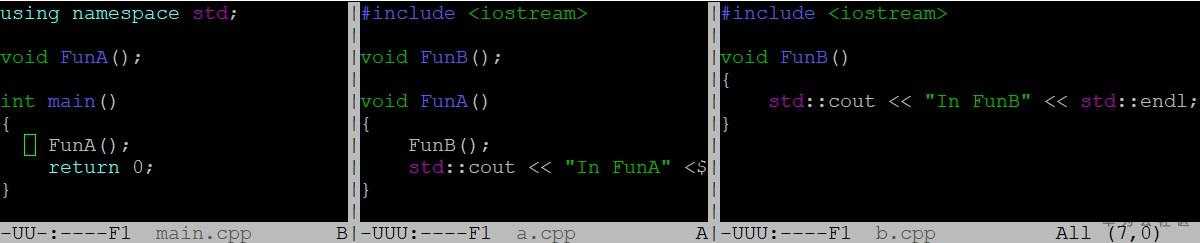

如下图所示,main.cpp依赖liba.a,liba.a又依赖libb.a,根据静态链接算法,如果用g++ main.cpp liba.a libb.a的顺序能正常链接,因为解析liba.a时未定义符号FunB会加入到上述算法的U中,然后在libb.a中找到定义,如果用g++ main.cpp libb.a liba.a的顺序编译,则无法找到FunB的定义,因为根据静态链接算法,在解析libb.a的时候U为空,所以不需要做任何解析,简单抛弃libb.a,但在解析liba.a的时候又发现FunB没有定义,导致U最终不为空,链接错误,因此在做静态链接时,需要特别注意库的顺序安排,引用别的库的静态库需要放在前面,碰到链接很多库的时候,可能需要做一些库的调整,从而使依赖关系更清晰。

动态链接:

之前大部分内容都是静态链接相关,但静态链接有很多不足:不利于更新,只要有一个库有变动,都需要重新编译;不利于共享,每个可执行程序都单独保留一份,对内存和磁盘是极大的浪费。

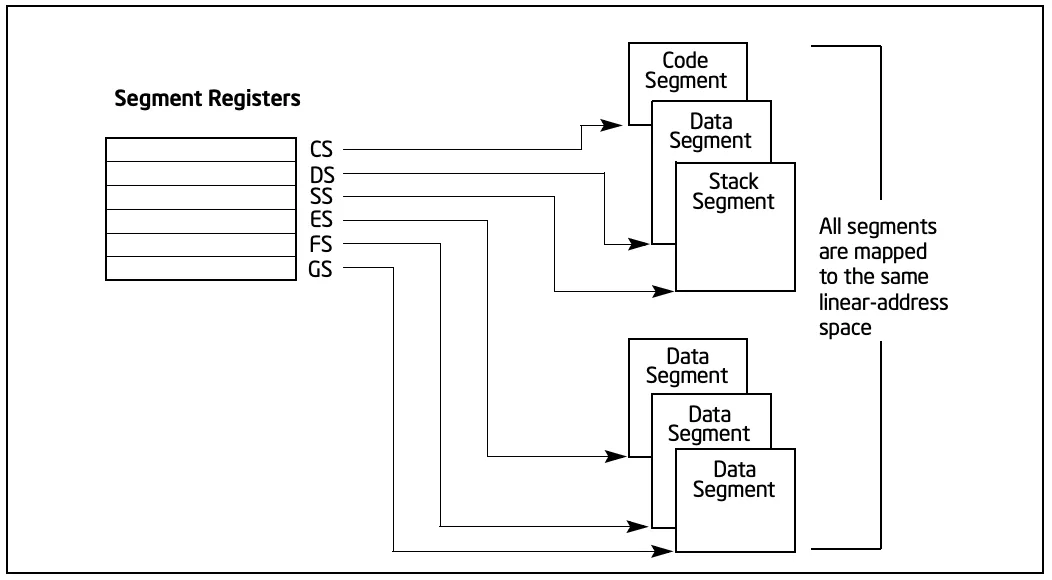

要生成动态链接库需要用到参数“-shared -fPIC”表示要生成位置无关PIC(Position Independent Code)的共享目标文件。对静态链接,在生成可执行目标文件时整个链接过程就完成了,但要想实现动态链接的效果,就需要把程序按照模块拆分成相对独立的部分,在程序运行时将他们链接成一个完整的程序,同时为了实现代码在不同程序间共享要保证代码是和位置无关的(因为共享目标文件在每个程序中被加载的虚拟地址都不一样,要保证它不管被加载在哪都能工作),而为了实现位置无关又依赖一个前提:数据段和代码段的距离总是保持不变。

由于不管在内存中如何加载一个目标模块,数据段和代码段间的距离是不变的,编译器在数据段前面引入了一个全局偏移表GOT(Global Offset Table),被引用的全局变量或者函数在GOT中都有一条记录,同时编译器为GOT中每个条目生成一个重定位记录,因为数据段是可以修改的,动态链接器在加载时会重定位GOT中的每个条目,这样就实现了PIC。

大体原理基本就这样,但具体实现时,对函数的处理和全局变量有所不同。由于大型程序函数成千上万,而程序很可能只会用到其中的一小部分,因此没必要加载的时候把所有的函数都做重定位,只有在用到的时候才对地址做修订,为此编译器引入了过程链接表PLT(Procedure Linkage Table)来实现延时绑定。PLT在代码段中,它指向了GOT中函数对应的地址,第一次调用时候,GOT存放的不是函数的实际地址,而是PLT跳转到GOT代码的后一条指令地址,这样第一次通过PLT跳转到GOT,然后通过GOT又调回到PLT的下一条指令,相当于什么也没做,紧接着PLT后面的代码会将动态链接需要的参数入栈,然后调用动态链接器修正GOT中的地址,从这以后,PLT中代码跳转到GOT的地址就是函数真正的地址,从而实现了所谓的延时绑定。

对共享目标文件而言,有几个需要关注的section:

有了以上基础后,我们看一下动态链接的过程:

- 装载过程中程序执行会跳转到动态链接器

- 动态链接器自举通过GOT、.dynamic信息完成自身的重定位工作

- 装载共享目标文件:将可执行文件和链接器本身符号合并入全局符号表,依次广度优先遍历共享目标文件,它们的符号表会不断合并到全局符号表中,如果多个共享对象有相同的符号,则优先载入的共享目标文件会屏蔽掉后面的符号

- 重定位和初始化

全局符号介入

动态链接过程中最关键的第3步可以看到,当多个共享目标文件中包含一个相同的符号,那么会导致先被加载的符号占住全局符号表,后续共享目标文件中相同符号被忽略。当我们代码中没有很好的处理命名的话,会导致非常奇怪的错误,幸运的话立刻core dump,不幸的话直到程序运行很久以后才莫名其妙的core dump,甚至永远不会core dump但是结果不正确。

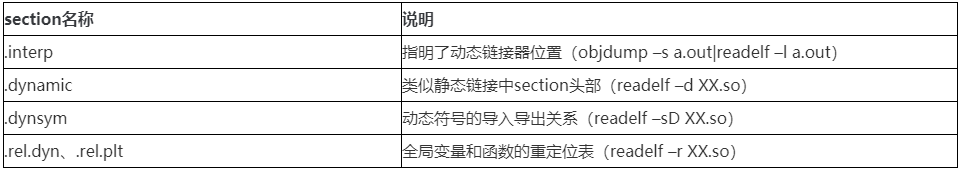

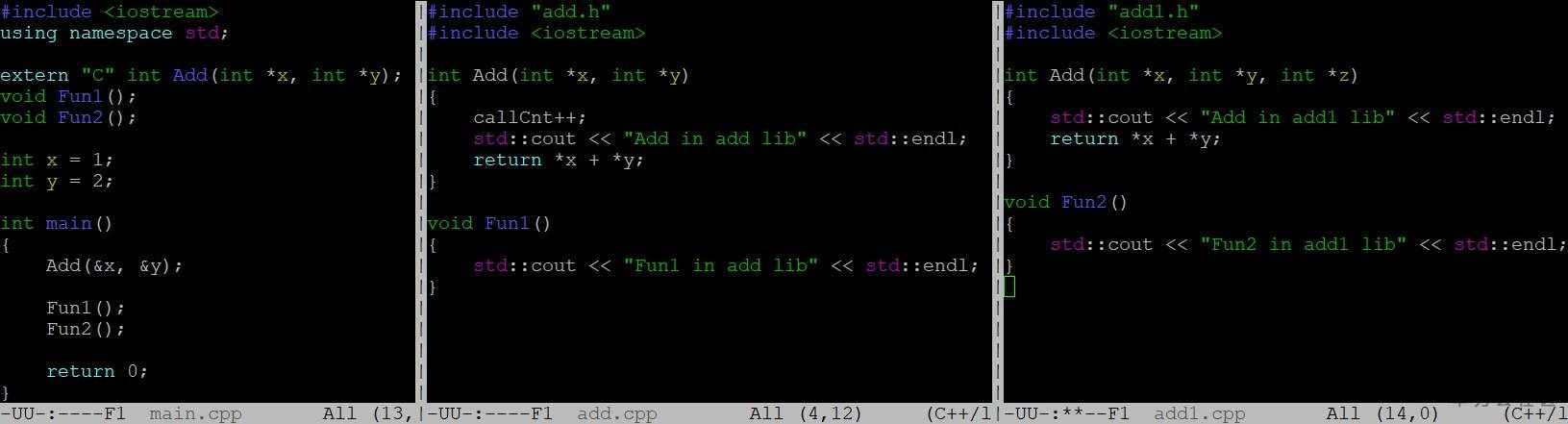

如下图所示,main.cpp中会用到两个动态库libadd.so,libadd1.so的符号,我们把重点

放在Add函数的处理上,当我们以g++ main.cpp libadd.so libadd1.so编译时,程序输出“Add in add lib”说明Add是用的libadd.so中的符号(add.cpp),当我们以g++ main.cpp libadd1.so libadd.so编译时,程序输出“Add in add1 lib”说明Add是用的libadd1.so中的符号,这时候问题就大了,调用方main.cpp中认为Add只有两个参数,而add1.cpp中认为Add有三个参数,程序中如果有这样的代码,可以预见很可能造成巨大的混乱。具体符号解析我们可以通过LD_DEBUG=all ./a.out来观察Add的解析过程,如下图所示:左边是对应libadd.so在编译时放在前面的情况,Add绑定在libadd.so中,右边对应libadd1.so放前面的情况,Add绑定在libadd1.so中。

运行时加载动态库:

有了动态链接和共享目标文件的加持,Linux提供了一种更加灵活的模块加载方式:通过提供dlopen,dlsym,dlclose,dlerror几个API,可以实现在运行的时候动态加载模块,从而实现插件的功能。

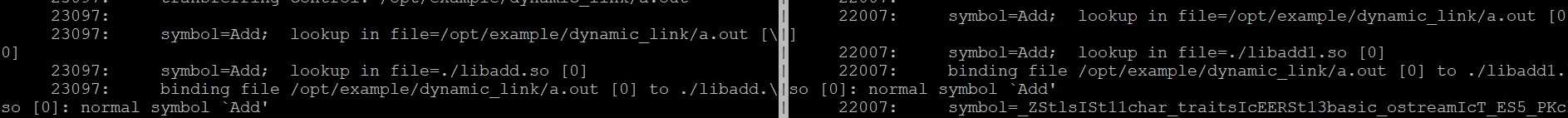

如下代码演示了动态加载Add函数的过程,add.cpp按照正常编译“g++ -fPIC –shared –o libadd.so add.cpp”成libadd.so,main.cpp通过“g++ main.cpp -ldl”编译为a.out。main.cpp中首先通过dlopen接口取得一个句柄void *handle,然后通过dlsym从句柄中查找符号Add,找到后将其转化为Add函数,然后就可以按照正常的函数使用,最后dlclose关闭句柄,期间有任何错误可以通过dlerror来获取。

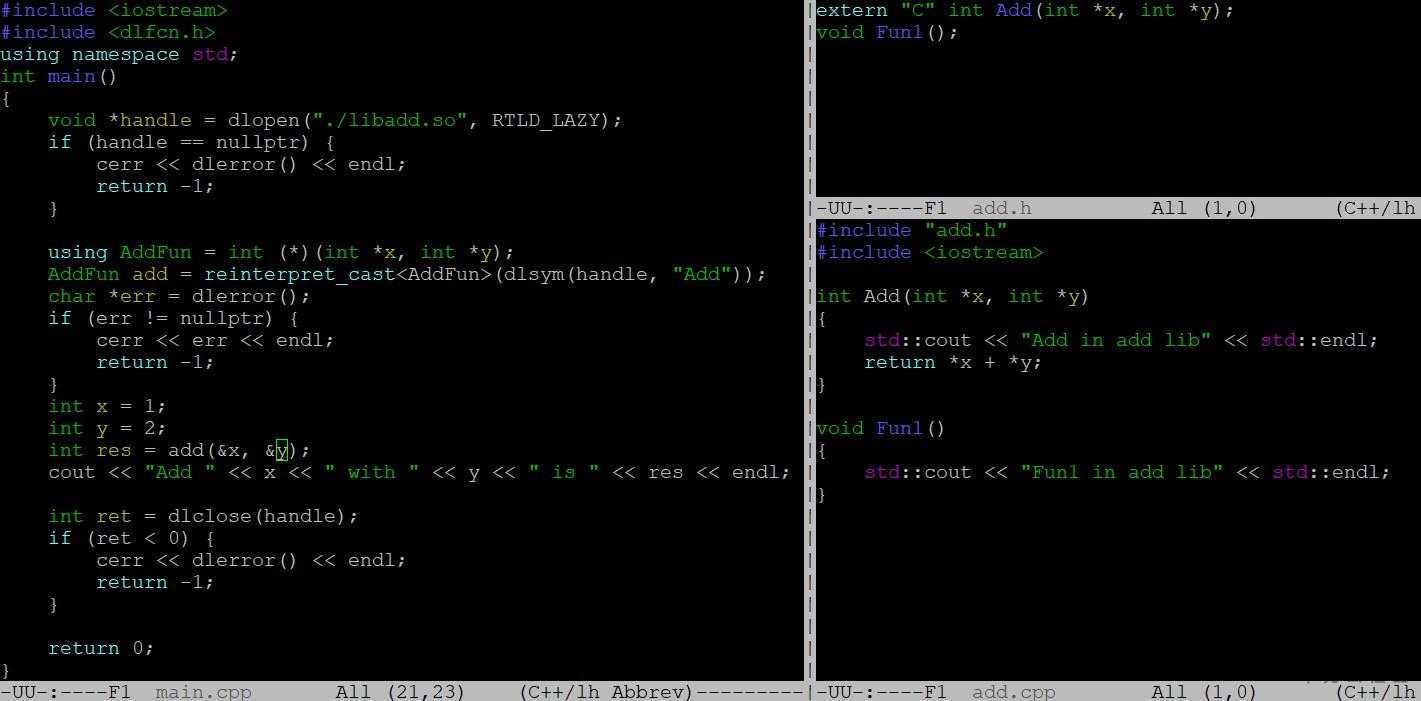

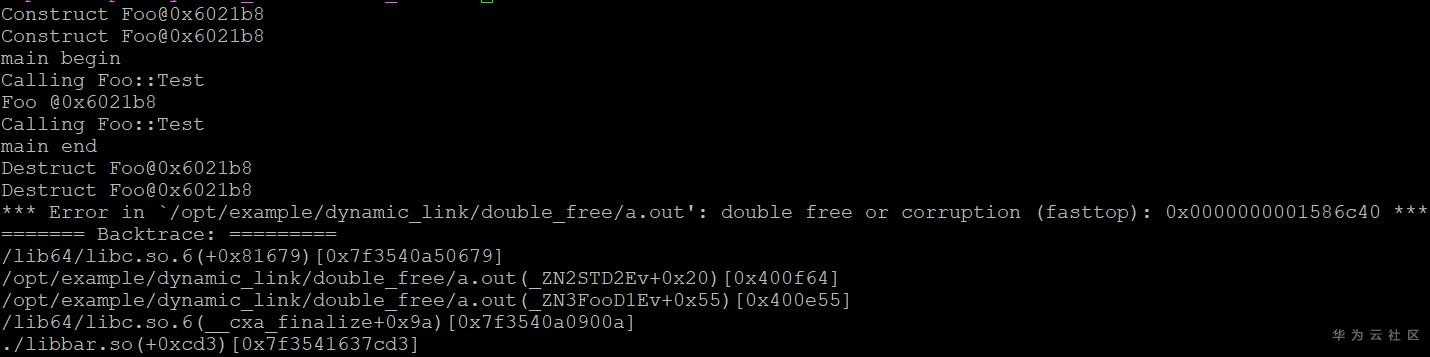

静态全局变量与动态库导致double free

在全面了解了动态链接相关知识后,我们来看一个静态全局变量和动态库纠结在一起引发的问题,代码如下,foo.cpp中有一个静态全局对象foo_,foo.cpp会编译成一个libfoo.a,bar.cpp依赖libfoo.a库,它本身会编译成libbar.so,main.cpp既依赖于libfoo.a又依赖libbar.so。

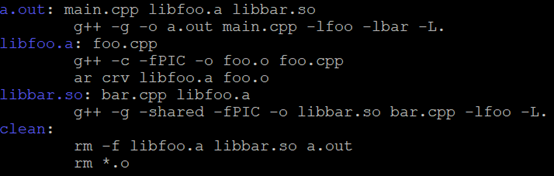

编译的makefile如下:

运行a.out会导致double free的错误。这是由于在一个位置上调用了两次析构函数造成的。之所以会这样是因为链接的时候先链接的静态库,将foo的符号解析为静态库中的全局变量,当动态链接libbar.so时,由于全局已经有符号foo,因此根据全局符号介入,动态库中对foo_的引用会指向静态库中版本,导致最后在同一个对象上析构了两次。

解决办法如下:

- 不使用全局对象

- 编译时候调换库的顺序,动态库放在前面,这样全局只会有一个foo_对象

- 全部使用动态库

- 通过编译器参数来控制符号的可见性。

库打桩机制

前言

假如由于调试需要,你希望原先代码中的malloc函数更换为你自己写好的malloc函数,该怎么办呢?如何对程序进行”偷梁换柱“?

打桩机制

LInux链接器有强大的库打桩机制,它允许你对共享库的代码进行截取,从而执行自己的代码。而为了调试,你通常可以在自己的代码中加入一些调试信息,例如,调用次数,打印信息,调用时间等等。本文将介绍三种打桩机制,分别在编译的不同阶段。

编译时打桩

编译时打桩在源代码级别进行替换。我们很容易通过#define指令来完成这件事情。首先我们定义自己的头文件mymalloc.h:1

2

void *mymalloc(size_t size)

由于在这里使用了#define指令,我们后面需要malloc的地方都会被mymalloc替代。

而mymalloc.c代码如下:

1 |

|

注意第一行,我们需要在gcc中传入编译选项MYMOCK(自定义,代码与传入的一致即可)。

我们在main.c中调用它:1

2

3

4

5

6

7

8

int main()

{

char *p = malloc(64);

free(p);

return 0;

}

编译运行:1

2

3

4$ gcc -DMYMOCK -c mymalloc.c

$ gcc -I . -o main main.c mymalloc.o

$ ./main

ptr is 0xdbd010

编译时还使用-I参数,告诉编译器从当前目录下寻找头文件malloc.h,因此,main函数中的malloc调用将会被替换成mymalloc。而在mymalloc.c中的则使用原始的malloc函数,最终达到“偷梁换柱”的效果。

实际上你也可以通过仅仅预编译来很清楚的看到其中的变化:1

$ gcc -I . -E -o main.i main.c

查看main.i,你会发现,使用malloc的地方,都被替换成了mymalloc。

小结一下前面的步骤:

- 打桩函数内部不要打桩,即mymalloc.c中要使用原始的malloc函数,不然会造成循环调用

- 通过#define指令,将外部调用malloc的地方都替换为mymalloc

- 分开编译mymalloc.c和外部调用代码,最终链接

这种方式打桩需要能够访问源代码才能完成。

链接时打桩

顾名思义,链接时打桩是在链接时替换需要的函数。Linux链接器支持用—wrap,f的方式来进行打桩,链接时符号f解析成wrap_f,还会把real_f解析成f。什么意思呢?我们修改前面mymalloc.c的代码如下:1

2

3

4

5

6

7

8

9

10

11

12

void *__real_malloc(size_t size);//注意声明

/*打桩函数*/

void *__wrap_malloc(size_t size)

{

void *ptr = __real_malloc(size);//最后会被解析成malloc

printf("ptr is %p\n",ptr);

return ptr;

}

注意将main.c中包含的malloc.h那一行去掉。

编译运行:1

2

3

4

5$ gcc -DMYMOCK mymalloc.c

$ gcc -c main.c

$ gcc -Wl,--wrap,malloc -o main main.o mymalloc.o

$ ./main

ptr is 0x95f010

我们特别关注mymalloc.c中的代码,利用链接器的打桩机制,最后在main函数中调用malloc,将会去调用wrap_malloc,而real_malloc将会被解析成真正的malloc,从而达到“偷梁换柱”的效果。

可以看到的是,这种打桩方式至少需要能够访问可重定位文件。

运行时打桩

前面两种打桩方式,一种需要访问源代码,另外一种至少要访问可重定位文件。可运行时打桩没有这么多要求。运行时打桩可以通过设置LD_PRELOAD环境变量,达到在你加载一个动态库或者解析一个符号时,先从LD_PRELOAD指定的目录下的库去寻找需要的符号,然后再去其他库中寻找。

同样我们修改mymalloc.c:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

extern FILE *stdout;

/*打桩的malloc函数*/

void *malloc(size_t size)

{

static int calltimes;

calltimes++;

/*函数指针*/

void *(*realMalloc)(size_t size) = NULL;

char *error;

realMalloc = dlsym(RTLD_NEXT,"malloc");//RTLD_NEXT

if(NULL == realMalloc)

{

error = dlerror();

fputs(error,stdout);

return NULL;

}

void *ptr = realMalloc(size);

if(1 == calltimes)

{

printf("ptr is %p\n",ptr);

}

calltimes = 0;

return ptr;

}

在mymalloc.c的代码中,由于我们自己的打桩函数也叫malloc,因此我们通过运行时链接调用malloc函数,以便获取malloc的地址,而不是直接调用。并且是以RTLD_NEXT方式。

将mymalloc.c制作成动态库1

2

3

4

5$ gcc -DMYMOCK -shared -fPIC -o libmymalloc.so mymalloc.c -ldl

$ gcc -o main main.c //重新编译main

$ LD_PRELOAD="./libmymalloc.so"

$ ./main

Segmentation fault (core dumped)

然而非常不幸的是,最后core dumped了,我们用gdb(参考《Linux常用命令-开发调试篇》)查看调用栈:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16(gdb)bt

#0 0x00007fe0ca83518e in _IO_vfprintf_internal (

s=0x7fe0cabad620 <_IO_2_1_stdout_>, format=0x7fe0cabb26dd "ptr is %p\n",

ap=ap@entry=0x7ffcbd652058) at vfprintf.c:1267

#1 0x00007fe0ca83d899 in __printf (format=<optimised out>) at printf.c:33

#2 0x00007fe0cabb26cc in malloc () from ./mymalloc.so

#3 0x00007fe0ca8551d5 in __GI__IO_file_doallocate (

fp=0x7fe0cabad620 <_IO_2_1_stdout_>) at filedoalloc.c:127

#4 0x00007fe0ca863594 in __GI__IO_doallocbuf (

fp=fp@entry=0x7fe0cabad620 <_IO_2_1_stdout_>) at genops.c:398

#5 0x00007fe0ca8628f8 in _IO_new_file_overflow (

f=0x7fe0cabad620 <_IO_2_1_stdout_>, ch=-1) at fileops.c:820

#6 0x00007fe0ca86128d in _IO_new_file_xsputn (

f=0x7fe0cabad620 <_IO_2_1_stdout_>, data=0x7fe0cabb26dd, n=7)

at fileops.c:1331

#7 0x00007fe0ca835241 in _IO_vfprintf_internal (

我们从调用栈基本可以推断,其中有反复调用,那就是说在mymalloc.c中的malloc函数中,有的语句也调用了malloc,导致了最终的反复调用。解决这种问题有两个方法:

- 避免反复调用

- 使用不调用打桩函数的函数,即不调用其中的printf

我们采用下面这种方式来避免反复调用,开始调用时,置调用次数为1,最后置0,如果发现调用次数不为0 ,则不调用。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

extern FILE *stdout;

/*打桩的malloc函数*/

void *malloc(size_t size)

{

/*调用次数+1*/

static int calltimes;

calltimes++;

/*函数指针*/

void *(*realMalloc)(size_t size) = NULL;

char *error;

realMalloc = dlsym(RTLD_NEXT,"malloc");//RTLD_NEXT

if(NULL == realMalloc)

{

error = dlerror();

fputs(error,stdout);

return NULL;

}

void *ptr = realMalloc(size);

/*如果是第一次调用,则调用printf,否则不调用*/

if(1 == calltimes)

{

printf("ptr is %p\n",ptr);

}

calltimes = 0;

return ptr;

}

当然这样的写法在多线程中也是有问题的,如何改进?

至此,就达到了我们需要的结果:1

2./main

ptr is 0x245c010

实际上,你会发现,在设置了这个环境变量的终端下,这个打桩的动作对所有程序都生效:1

2

3

4

5

6

7$ ls

ptr is 0x1f1a040

ptr is 0x1f1a680

ptr is 0x1f1a700

ptr is 0x1f1a040

ptr is 0x1f1a060

ptr is 0x1f1a040

那么怎么取消呢:1

$ unset LD_PRELOAD

在这里也可以看到,这个机制虽然强大,同样也非常危险,因为不怀好意者可以通过这种方式恶意攻击你的程序。比如说,有个程序中checkPass的接口用来校验密码,如果这个时候使用另外一个动态库,实现自己的checkPass函数,并且设置LD_PRELOAD环境变量,就可以达到跳过密码检查的目的。

总结

怎么样,是不是觉得很神奇?尤其是最后一种方式,可以达到对任何程序进行”偷梁换柱“,对于问题的定位和程序的调试非常有帮助。但是,需要特别注意的是,采用最后一种方式打桩时,最好避免打桩函数内部还调用了打桩函数,这样会导致难以预料的后果,另外由于这种打桩机制对所有程序都有效,因此也非常危险,需要特别注意。

编译器常用的一些优化方法

常量传播

常量传播,就是说在编译期时,能够直接计算出结果(这个结果往往是常量)的变量,将被编译器由直接计算出的结果常量来替换这个变量。

例:1

2

3

4

5int main(int argc,char **argv){

int x = 1;

std::cout<<x<<std::endl;

return 0;

}

上例编译器会直接用常量1替换变量x,优化成:1

2

3

4int main(int argc,char **argv){

std::cout<<1<<std::endl;

return 0;

}

常量折叠

常量折叠,就是说在编译期间,如果有可能,多个变量的计算可以最终替换为一个变量的计算,通常是多个变量的多级冗余计算被替换为一个变量的一级计算

例:1

2

3

4

5

6

7int main(int argc,char **argv){

int a = 1;

int b = 2;

int x = a + b;

std::cout<<x<<std::endl;

return 0;

}

常量折叠优化后:1

2

3

4

5int main(int argc,char **argv){

int x = 1 + 2;

std::cout<<x<<std::endl;

return 0;

}

当然,可以再进行进一步的常量替换优化:1

2

3

4int main(int argc,char **argv){

std::cout<<3<<std::endl;

return 0;

}

通常,编译优化是一件综合且连贯一致的复杂事情,下文就不再赘述了。

复写传播

复写传播,就是编译器用一个变量替换两个或多个相同的变量。

例:1

2

3

4

5

6int main(int argc,char **argv){

int y = 1;

int x = y;

std::cout<<x<<std::endl;

return 0;

}

优化后:1

2

3

4

5int main(int argc,char **argv){

int x = 1;

std::cout<<x<<std::endl;

return 0;

}

上例有两个变量y和x,但是其实是两个相同的变量,并且其它地方并未区分它们两个,所以它们是重复的,可称为“复写”,编译器可以将其优化,将x“传播”给y,只剩下一个变量x,当然,反过来优化掉x只剩下一个y也是可以的。

公共子表式消除

公共子表达式消除是说,如果一个表达式E已经计算过了,并且从先前的计算到现在的E中的变量都没有发生变化,那么E的此次出现就成为了公共子表达式,因此,编译器可判断其不需要再次进行计算浪费性能。

例:1

2

3

4

5

6

7int main(int argc,char **argv){

int a = 1;

int b = 2;

int x = (a+b) * 2 + (b+a) * 6;

std::cout<<x<<std::endl;

return 0;

}

优化后:1

2

3

4

5

6

7

8int main(int argc,char **argv){

int a = 1;

int b = 2;

int E = a + b;

int x = E * 2 + E * 6;

std::cout<<x<<std::endl;

return 0;

}

当然,也有可能会直接变成:1

2

3

4

5

6

7

8int main(int argc,char **argv){

int a = 1;

int b = 2;

int E = a + b;

int x = E * 8;

std::cout<<x<<std::endl;

return 0;

}

无用代码消除

无用代码消除指的是永远不能被执行到的代码或者没有任何意义的代码会被清除掉,比如return之后的语句,变量自己给自己赋值等等。

例:1

2

3

4

5

6int main(int argc,char **argv){

int x = 1;

int x = x;

std::cout<<x<<std::endl;

return 0;

}

上例中,x变量自我赋值显然是无用代码,将会被优化掉:1

2

3

4

5int main(int argc,char **argv){

int x = 1;

std::cout<<x<<std::endl;

return 0;

}

数组范围检查消除

如果开发语言是Java这种动态类型安全型的,那在访问数组时比如array[ ]时,Java不会像C/C++那样只是纯粹的裸指针访问,而是会在运行时访问数组元素前进行一次是否越界检查,这将会带来许多开销,如果即时编译器能根据数据流分析出变量的取值范围在[0,array.length]之间,那么在循环期间就可以把数组的上下边界检查消除,以减少不必要的性能损耗。

方法内联

这种优化方法是将比较简短的函数或者方法代码直接粘贴到其调用者中,以减少函数调用时的开销,比较重要且常用,很容易理解,就比如C++的inline关键字一样,只不过inline是开发者的手动方法内联,而编译器在分析代码和数据流之后,也有可能做出自动inline的优化。

逃逸分析

一个对象如果被其声明的方法之外的一个或多个函数所引用,那就被称为逃逸,可以通俗理解为,该对象逃逸了其原本的命名空间或者作用域,使得声明(或者定义)该对象的方法结束时,该对象不能被销毁。

通常,一个函数里的局部变量其内存空间是在栈上分配的,而对象则是在堆上分配的内存空间,在函数调用结束时,局部变量会随着栈空间销毁而自动销毁,但堆上的空间要么是依赖类似JVM的垃圾内存自动回收机制(GC),要么就得像C/C++那样的依赖开发者本身的记忆力,因此,堆上的内存分配与销毁一般开销会比栈上的大得多。

逃逸分析的基本原理就是分析对象动态作用域。如果确定一个方法不会逃逸出方法之外,那让整个对象在栈上分配内存将会是一个很不错的主意,对象所占用的内存空间就可以随栈帧而销毁。在一般应用中,不会逃逸的局部对象所占用的比例很大,如果能在编译器优化时,为其在栈上分配内存空间,那大量的对象就会随着方法结束而自动销毁了,不用依赖前面讲的GC或者记忆力,系统的压力将会小很多。

一个演示简单编译器循环优化的例子

演示用的代码例子

先来看用于演示的C代码例子:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

uint32_t gLastI;

uint32_t foo(uint32_t lo, uint32_t hi) {

uint32_t sum = 0; // (1)

for (uint32_t i = lo; i < hi; i++) { // (2)

uint32_t y = 2 * i; // (3)

if ((hi & 1) == 0) { // (4)

sum += i; // (5)

gLastI = i; // (6)

} else {

sum += y; // (7)

}

}

return sum; // (8)

}

挺简单的函数。有啥好优化的呢?——对于不熟悉编译原理的同学来说,最可能让他们意外的可能就是优化后代码的顺序与原程序的巨大差异。

ICC 17在Linux/x86-64上在-O3优化级别会把这个例子优化为等价于下面的形式:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21uint32_t foo(uint32_t lo, uint32_t hi) {

uint32_t sum = 0;

if (lo < hi) {

uint32_t n = hi - lo;

if ((hi & 1) != 0) {

for (uint32_t i = 0; i < n; i++) {

sum += lo * 2; // folded into lea

sum += i * 2; // folded into lea

}

} else {

uint32_t last_i;

for (uint32_t i = 0; i < n; i++) {

sum += lo;

last_i = lo;

lo++;

}

gLastI = last_i;

}

}

return sum;

}

实际生成的汇编长这样:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27foo:

mov edx, esi #5.35

xor eax, eax #6.11

cmp edi, edx #7.29

jae ..B1.9 # Prob 50% #7.29

mov esi, edx #5.35

mov ecx, eax #7.3

sub esi, edi #5.35

test dl, 1 #9.15

je ..B1.7 # Prob 50% #9.21

..B1.4: # Preds ..B1.2 ..B1.4

lea eax, DWORD PTR [rax+rdi*2] #7.3

lea eax, DWORD PTR [rax+rcx*2] #8.17

inc ecx #7.3

cmp ecx, esi #7.3

jb ..B1.4 # Prob 82% #7.3

jmp ..B1.9 # Prob 100% #7.3

..B1.7: # Preds ..B1.2 ..B1.7

inc ecx #7.3

add eax, edi #10.7

mov edx, edi #11.7

inc edi #7.3

cmp ecx, esi #7.3

jb ..B1.7 # Prob 82% #7.3

mov DWORD PTR gLastI[rip], edx #11.7

..B1.9: # Preds ..B1.4 ..B1.8 ..B1.1

ret #16.10

它为什么可以这样做?下面就让我简单科普一下。

编译器在优化代码的时候,只要保证最终的结果满足程序中各种依赖关系就可以了,而不必总是维持跟输入的源码相同的顺序(“program order”)。不过这个传送门中涉及的例子非常简单,只有纯直线代码,没有跳转 / 条件跳转,也没有对内存的读写,所以只要用“数据依赖”(data dependence)就足以讲解了。

而本文所用的例子则稍微复杂一点,可以涉及稍微多一些的优化的讲解。

首先在(2)开始有一个典型的for循环,在(4)有一个条件分支;这两个都是控制流操作,使这个例子涉及“控制依赖”(control dependence)。然后在(6)有一个对全局变量gLastI的写操作,这是一个内存写操作,使这个例子涉及“内存依赖”(memory dependence)——或者说正好演示了冗余写操作的情况。

副作用?

对编译器中的优化器来说,所谓“副作用”就是在当前编译单元中无法做足够分析的运算结果。这跟上层的源语言中所说的“副作用”并不总是一回事。所以当看到对程序中的副作用的讨论时,要注意清楚讨论的上下文是什么,免得误解了对方的意思。

例如说,对编译器中端的优化器来说,C语言的一个标量类型的局部变量,如果它在整个函数中都没有被取过地址,那么所有对它自身的读写运算都可以认为是“无副作用”的。这是因为这些变量是活动记录(activation record,或者说栈帧)的一部分,而一个函数被调用一次的活动记录里的内容都是这次调用独享访问的,除非程序主动通过取局部变量地址的方式来暴露出机会让别的代码能操作这些局部变量。这样编译器的优化器就可以对其做足够分析,将它们涉及的副作用都分析出来,并转换为没有副作用的形式。

而对原本的C语言来说,一般会把对局部变量的赋值(写)运算叫做“有副作用”的。

这个差异主要是来自编译器各部分的分工,以及优化器对程序的分析能力。

回顾一下一个典型的带优化的编译器的工作流程:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17 源代码

-> [ 词法分析 ]

-> 单词流

-> [ 语法分析 ]

-> 语法树 / 抽象语法树 编译器前端

-> [ 语义分析 ]

-> 带标注的语法树

-> [ 中间代码生成 ]

-> 中间代码 -------------------------

-> [ 平台无关优化 ]

-> 优化的中间代码 编译器中端

-> [ 平台相关lowering ]

-> 平台相关中间代码 --------------------------

-> [ 平台相关优化 ]

-> 优化的平台相关中间代码 编译器后端

-> [ 代码生成 ]

-> 目标代码

在这个流程中,编译器前端更关心源语言的语义,后端更关心目标平台的特性,而位于中间的中端则主要关心相对不那么语言相关、也不那么平台相关的优化。

当我们讨论源语言层面上的“副作用”,编译器前端的“语义分析”部分是必须要能正确理解这些副作用的含义(并在副作用不合理时给出警告)。然后在“中间代码生成”的部分,这些“副作用”会在中间表示中用更显式的方式表现出来,于是到编译器中端拿到中间表示的时候,就不用关心这些源语言层面的副作用了。

例如说,一个经典的不好的C代码:1

2

3

4

5int foo() {

int i = 0;

int j = i + i++;

return j;

}

在i + i++的地方有一个纯粹的对局部变量i的读操作,以及一个带有副作用(自增)的对局部变量i的读写操作,而这两个操作之间没有sequence point所以它们俩的求值顺序是未定义的。

在Clang中,语义分析的部分会对这个情况给出警告:1

2

3foo.c:3:16: warning: unsequenced modification and access to 'i' [-Wunsequenced]

int j = i + i++;

~ ^

然后Clang在生成中间代码(LLVM IR)时,会根据自己的理解选择一种求值顺序——后做i++,生成出每个操作都简单明确的中间代码,然后编译器中端(LLVM)在拿到LLVM IR之后就能根据代码的顺序准确地理解前端所做的选择:1

2

3

4

5

6

7

8

9

10

11

12

13

14; Function Attrs: nounwind

define i32 @foo() #0 {

%i = alloca i32, align 4 ; int i

%j = alloca i32, align 4 ; int j

store i32 0, i32* %i, align 4 ; i = 0

%3 = load i32, i32* %i, align 4 ; tmp3 = i

%4 = load i32, i32* %i, align 4 ; tmp4 = i

%5 = add nsw i32 %4, 1 ; tmp5 = tmp4 + 1

store i32 %5, i32* %i, align 4 ; i = tmp5

%6 = add nsw i32 %3, %4 ; tmp6 = tmp3 + tmp4

store i32 %6, i32* %j, align 4 ; j = tmp6

%7 = load i32, i32* %j, align 4 ; tmp7 = j

ret i32 %7 ; return tmp7

}

也就是Clang选择拆解副作用的方式,对应这样的C代码:1

2

3

4

5

6int foo() {

int i = 0;

int j = i + i;

i = i + 1; // side-effect of i++

return j;

}

可以看到这里生成的LLVM IR还是“有副作用”的——那3条store指令就是“副作用”。但是LLVM可以对所有没有被取地址的标量类型的局部变量都可以做完全的分析——可以找到所有对这些局部变量的读写操作并分析其中的副作用的效果——然后将IR转换到对这些局部变量来说没有副作用的形式。

例如说对上述LLVM IR跑一次mem2reg pass(或者包含mem2reg的sroa pass),会得到:1

2

3

4

5

6; Function Attrs: nounwind

define i32 @foo() #0 {

%1 = add nsw i32 0, 1 ; tmp1 = 0 + 1

%2 = add nsw i32 0, 0 ; tmp2 = 0 + 0

ret i32 %2 ; return tmp2

}

这里就没有任何副作用了,只有对局部值的简单运算。进一步做常量折叠和无用代码消除之后,就只剩下:1

2

3

4; Function Attrs: nounwind

define i32 @foo() #0 {

ret i32 0 ; return 0

}

了。

同一个例子用GCC 4.9.2来看编译器前端的理解(生成的GIMPLE):1

2

3

4

5

6

7

8

9

10

11

12

13

14foo ()

{

int i.0;

int D.1748;

int i;

int j;

i = 0;

i.0 = i;

i = i.0 + 1; // side-effect of i++

j = i.0 + i;

D.1748 = j;

return D.1748;

}

这GCC选择的求值顺序就跟Clang正好相反,先做了i++。

然后中端在分析完局部变量涉及的副作用之后,所生成的无副作用的中间代码(Tree SSA形式的GIMPLE):1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19foo ()

{

int j;

int i;

int D.1748;

int i.0;

int i.0_2;

int _5;

<bb 2>:

i_1 = 0;

i.0_2 = i_1;

i_3 = i.0_2 + 1;

j_4 = i.0_2 + i_3;

_5 = j_4;

<L0>:

return _5;

}

每个局部变量最多被赋值一次,从赋值到使用直接不用考虑别的副作用影响该变量的值,所以说“没有副作用”。

副作用与控制依赖

先说结论:没有副作用的运算可以无视控制依赖,只要满足数据依赖即可执行。

什么是控制依赖?控制依赖是说,某个运算Y的执行与否,依赖于某个带有控制流语义的运算X的结果。

例如说,1

2

3

4

5

6

7

8int foo(int a, int b, int cond) {

int c = b + 1;

int x = 0;

if (cond) {

x = a + c;

}

return x;

}

这个例子里,x = a + c就控制依赖于”if (cond)”的运算结果,只有当cond为真值的时候,x = a + c才执行。

但是”a + c”是一个没有副作用的运算,它其实放在foo()中的什么位置执行都可以——只要它所依赖的数据输入a和c都已经求好值了即可——而不必依赖于”if (cond)”的结果。这跟本文开头提到的传送门里“数据依赖”的例子一样。

所以把上述代码的a + c提取到if外面,转换成下面这样也是一样的:1

2

3

4

5

6

7

8

9int foo(int a, int b, int cond) {

int c = b + 1;

int x = 0;

int tmp = a + c;

if (cond) {

x = tmp;

}

return x;

}

又或者再向前挪一点:1

2

3

4

5

6

7

8

9int foo(int a, int b, int cond) {

int c = b + 1;

int tmp = a + c;

int x = 0;

if (cond) {

x = tmp;

}

return x;

}

也可以。

那么”x = “的部分呢?这个赋值会根据”if (cond)”的结果而影响局部变量x的值,所以要先看作有控制依赖的有副作用的操作,分析清楚之后再转换到无副作用的形式。

但是所谓“无副作用”的形式要如何表达一个变量可能经由不同的分支执行后得到不同的值呢?一种办法是SSA形式的“phi”伪函数。让我们把这个例子转成SSA形式来看:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16int foo(int a, int b, int cond) {

int c = b + 1;

int x0 = 0;

if (cond) goto condtrue; else goto condfalse;

condtrue:

int x1 = a + c;

goto aftercond;

condfalse:

goto aftercond;

aftercond:

int x2 = phi(condfalse x0, condtrue x1);

return x2;

}

这个“phi”伪函数会显式指明“如果控制来自某个分支,则选用某个值”。这就把副作用与控制依赖显式结合在一起表达出来了。

回到本文开头的例子,位于(3)的”2 * i”是一个无副作用的运算,所以它的运算位置可以被移动。例如说它可以被向下移动(sink),到真正使用它的地方,变成:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

uint32_t gLastI;

uint32_t foo(uint32_t lo, uint32_t hi) {

uint32_t sum = 0;

for (uint32_t i = lo; i < hi; i++) {

if ((hi & 1) == 0) {

sum += i;

gLastI = i;

} else {

uint32_t y = 2 * i;

sum += y;

}

}

return sum;

}

循环不变量与循环不变量外提(LICM)

就跟上一节提到的思路一样,如果通过分析可以发现在循环中有运算的值不受循环的影响,那么就可以把它提升到循环的外面。这种优化叫做循环不变量外提(LICM,loop-invariant code motion)。

以本文开头的例子来说,通过分析可以发现从(2)开始的for循环,在循环体中没有对变量hi赋过值,所以hi的值在循环内不会改变。递推出去,hi & 1是一个无副作用的运算,它的值在循环中也不会改变。同理(hi & 1) == 0的值在循环中也不会改变。

所以这个例子就可以把(4)的条件运算提取到循环外面,变成(在上一节的基础上):1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

uint32_t gLastI;

uint32_t foo(uint32_t lo, uint32_t hi) {

uint32_t sum = 0;

_Bool tmpcond = (hi & 1) == 0;

for (uint32_t i = lo; i < hi; i++) {

if (tmpcond) {

sum += i;

gLastI = i;

} else {

uint32_t y = 2 * i;

sum += y;

}

}

return sum;

}

循环判断外提(loop unswitching)

作为LICM的一种扩展,如果我们发现循环里有条件是对循环不变量来做判断的,那么就可以选择把这个判断提升到循环的外面 ,并且把原循环拆分为两个特化的版本,分别对应条件为真以及为假的情况。

这样每个版本的循环都会比原本的更简单,而假定循环是耗时的操作,是我们要有针对性优化的目标,把循环拆分成特化的版本后就可以减小循环的开销。

还是回到本文开头的例子,在上一节版本的基础上,可以进一步变换为:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

uint32_t gLastI;

uint32_t foo(uint32_t lo, uint32_t hi) {

uint32_t sum = 0;

if ((hi & 1) == 0) {

for (uint32_t i = lo; i < hi; i++) {

sum += i;

gLastI = i;

}

} else {

for (uint32_t i = lo; i < hi; i++) {

uint32_t y = 2 * i;

sum += y;

}

}

return sum;

}

跟开头演示的优化后的结果是不是越来越相似了?

内存写的下沉(store sinking)

嗯这个读起来有点怪。简单来说就是如果有连续多次对同一个位置的内存写操作,那么只有最后一个才是有意义的,前面那些只要没被用到都是无意义的,可以消除。所以这种优化也叫做“冗余内存写消除”(redundant store elimination)。

应用到循环中,如果我们在循环体中不断对某个位于内存中的变量做赋值,但却没有在循环中使用过这个赋值的结果,那么这个赋值就没有意义,可以被消除。

例如说:1

2

3for (int i = 0; i < 3; i++) {

globalVariable = i;

}

全局变量globalVariable的实体必须要被分配在内存中,所以对它的赋值是一个内存写操作(memory store)。如果我们分析一下循环的执行过程 ,就会发现这个例子实际上会执行3次对globalVariable的赋值:1

2

3globalVariable = 0

globalVariable = 1

globalVariable = 2

但在这个循环中其实并没有用到这些赋值的结果,而在循环结束时需要给外界留下的副作用只需要是globalVariable = 2。所以我们可以把这个内存写操作“下沉”(sink)到循环的后面去,变成:1

2

3

4for (int i = 0; i < 3; i++) {

/* empty loop body */

}

globalVariable = 2; // constant-folded condition: if (0 < 3)

或者稍微没那么优化的版本:1

2

3

4

5int i;

for (i = 0; i < 3; i++) {

/* empty loop body */

}

globalVariable = i - 1; // constant-folded condition: if (0 < 3)

但要注意的是:一个for循环其实是有可能一次也不执行的,所以在循环体里的赋值如果被下沉到循环后面的话,要保证该循环至少执行过一次才正确。

回到本文开头的例子,在上一节版本的基础上,把(6)对全局变量gLastI的赋值下沉到循环后面,可以变换成:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

uint32_t gLastI;

uint32_t foo(uint32_t lo, uint32_t hi) {

uint32_t sum = 0;

if (lo < hi) {

if ((hi & 1) == 0) {

for (uint32_t i = lo; i < hi; i++) {

sum += i;

}

gLastI = hi - 1;

} else {

for (uint32_t i = lo; i < hi; i++) {

uint32_t y = 2 * i;

sum += y;

}

}

}

return sum;

}

具体到ICC所选用的优化形式,它没能彻底优化掉循环中的运算,不过至少在循环中用一个局部变量来替代了全局变量作为赋值的目标,然后在循环之后才做最终的内存写操作:1

2

3

4

5

6uint32_t last_i;

for (uint32_t i = lo; i < hi; i++) {

sum += i;

last_i = i;

}

gLastI = last_i;

这仍然算是store sinking——局部变量可以被分配到寄存器里,对局部变量的赋值就不会内存写了,所以还是比对全局变量的赋值更快。

经过store sinking优化后,代码的形式已经跟ICC优化的结果非常相似了。

循环归纳变量优化(loop induction variable optimizations)

本文开头所给出的ICC优化后的版本,剩下的一些优化是跟循环归纳变量相关的。所谓“循环归纳变量”,就是值与循环轮次成线性关系的变量。

例如说最典型的for循环:1

2

3

4for (int i = 0; i < max; i++) {

int x = arr[i + 2];

/* ... */

}

局部变量i就是一个循环归纳变量,它的值跟循环轮次正好相等。我们可以分析出这个变量i的性质为:1

2

3

4init = 0

limit = max

cmp = <

step = 1

而表达式i + 2的值也是跟循环轮次成线性关系的,关系为1 * i + 2。于是这个表达式的性质就可以从变量i推算出来。

GCC与Clang对循环归纳变量的分析与优化叫做“Scalar evolutions”(简称SCEV)。

事实上,既然这是一个等差数列求和的例子,比例子中ICC编译结果更简短的形式应该是这样的:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

uint32_t gLastI;

uint32_t foo(uint32_t lo, uint32_t hi) {

if (lo < hi) {

uint32_t n = hi - lo;

if ((hi & 1) == 0) {

gLastI = hi - 1;

return (lo & 1) == 0 ? (n >> 1) * (lo + hi - 1)

: ((lo + hi - 1) >> 1) * n;

} else {

return (lo + hi - 1) * n;

}

} else {

return 0;

}

}

直接连循环都不要了。

把非常量的循环加法变换为非循环的乘法形式是实际编译器实现中比较少见的做法。更常见的反过来的优化:“强度削减”(strength reduction),把本来是乘法的运算变成加法,之类。

英特尔多核平台编程优化大赛报告

代码优化前所需时间:4.765秒

代码优化后所需时间:0.25秒(保留小数点后7位精度)

前言

本次优化使用的CPU是Intel Xeon 5130,主频为2.0GHz,同Intel酷睿2一样是基于Core Microarchitecture 的双核处理器。本次优化在Intel的工具帮助下主要针对Core Microarchitecture 系列处理器进行优化。但是由于未知原因,Intel VTune Analyzers并不能在该系统下正常工作。所以,所有使用Intel VTune Analyzers的测试均使用另外一个奔腾D 820的系统测试。

第一章主要介绍了程序的串行优化。其中有关于Intel编译器使用,以及Intel Math Kernel Library使用,Intel VTune Analyzers使用的介绍。在借助Intel工具的帮助下,结合Intel Core Microarchitectured的特性。设计出了针对L1 Cache进行优化的,高效率的串行代码。程序的执行时间从优化前的4.765秒达到了优化后的0.765秒。

第二章主要介绍了程序的并行化。首先讨论了2种并行算法的优缺点。然后选择了适合本程序的并行算法进行优化。并且在最后分析了并行化时的性能瓶颈。通过并行化,程序达到了0.437秒。

第三章主要介绍了程序的汇编优化。首先介绍了计算的数学理论。然后介绍了汇编代码的编写。最后进行了性能分析。通过该步优化程序在保留小数点后7位精度的前提下达到了0.312秒的好成绩。并且在Intel酷睿2 E6600 上测试达到了0.25秒。

串行优化

代码的基本修改和优化

首先根据主办方的要求把代码的输出精度改为小数点后7位。1

if (i%10 == 0) printf("%5d: Potential: %20.7f\n", i, pot);

在进行任何优化前代码的执行时间是4.765秒。

接着把项目转换成使用Intel C++ Compiler,代码的执行时间是4.531秒。

然后执行最基本的优化,把代码中的pow函数优化成乘法。代码如下:1

2

3distx = (r[0][j] - r[0][i])*(r[0][j] - r[0][i]);

disty = (r[1][j] - r[1][i])*(r[1][j] - r[1][i]);

distz = (r[2][j] - r[2][i])*(r[2][j] - r[2][i]);

执行时间依然为4.531秒。说明Intel编译器已经将pow函数优化掉了。

基于Intel编译器的优化

这里介绍本程序中基于Intel编译器优化技术。其中有些优化参数是可以确定的,有些优化参数需要在程序的不同阶段反复调试以确定最优方案,而有些优化技术是在后面的优化中使用的。

编译器优化级别

Intel的编译器共有如下一些主要的优化级别:

/O1:实现最基本的优化/O2:基于代码速度实现常规优化,这个也是默认的优化级别/O3:在/O2的基础上实现进一步的优化,包括Cache预读,标量转换等等,但是在某些情况下反而会减慢代码的执行速度。/Ox:实现最大化的优化,包括自动内联函数的确定,全局优化,使用EBP作为通用寄存器等。/fast:等同于/O3,/Qipo,/Qprec-div-, and/QxP。

通过测试,目前选用/O3,但是随着代码的更改,需要重新测试,选择合适的优化级别。

针对特定处理器进行优化

Intel的编译器一共支持如下3种针对特定处理器的优化:

/G:使用这个优化选项,Intel将针对特定的CPU进行优化,但是其代码依然可以在所有的CPU上执行。/Qx:使用这个优化选项,Intel将针对特定的CPU进行优化,并且产生的代码无法使用在不兼容的CPU上。/Qax:使用这个优化选项,Intel将针对特定的CPU进行优化,并且产生多份代码,在运行时根据CPU类型自动选择最优的代码。

由于本程序只需要运行在基于Core Microarchitecture 的处理器上,而无需考虑兼容性。所以本程序选择/Qx选项。并且针对运行时的酷睿2处理器,选择/QxT。但是在进行VTune测试时,由于测试平台为奔腾D 820,所以暂时使用/QxP的参数。

使用IPO

使用/Qipo可以启用Intel编译器的过程间优化(Interprocedural Optimizations)。通过过程间优化,编译器可以通过使用寄存器优化函数调用、内联函数展开、过程间常数传递、跨多文件优化等方式进一步优化程序。

此外,Intel编译器支持多文件的过程间优化,而由于本程序只有一个文件,所以并不需要使用。

但是IPO优化却会对本程序的调试带来极大的麻烦。所以本程序开发时不使用IPO优化,只有在最后的版本中才尝试使用IPO优化能否提高效率。

使用GPO

Intel编译器支持GPO(Profile-Guided Optimization)。GPO由一下三步组成。

- 第一步:使用

/Qprof-gen编译程序,产生能记录运行细节的特殊程序。 - 第二步:运行第一步产生的程序,生成动态信息文件(.dyn)。

- 第三步,使用

/Qprof-use,结合动态信息文件重新编译程序,产生更优化的程序。

通过使用GPO,Intel编译器可以更详细得了解程序的运行情况,从而根据实际情况产生更优化的代码。比如优化条件跳转,使得CPU分支预测的能力更准确,又如决定哪些函数需要内联,哪些不要内联等。

此外,基于GPO还有很多的工具方便用户开发程序。比如Code-Coverage Tool可以进行代码覆盖测试。

由于GPO收集的信息和特定的程序有关,而本程序一直在修改。所以本程序只在每个版本的最后部分使用GPO进行优化。

循环展开

循环展开(Loop Unrolling)通过在把循环语句中的内容展开从而使执行的代码速度更快。循环展开可以提高代码的并行程度,减少条件转移次数从而提高速度。另外,对于Pentium 4处理器,其分支预测功能可以精确得预测出16次迭代以内的循环,所以,如果能把循环展开到迭代次数在16次以内,对于特定的CPU可以提高分支预测准确度。

但是循环展开必须有一个度,并不是展开层数越多越好,展开层数多了,可能反而影响代码的执行速度。所以通常的做法是让编译器自己决定循环展开的层数。

Intel编译器对于循环展开有如下选项:

/Qunrolln:执行循环展开n层。/Qunroll:让Intel编译器自己决定循环展开的层数。

此外Intel编译器还提供在了程序中使用编译制导语句规定某个特定循环的展开次数。如下例指示for循环展开n层。1

2

for(i=0;i<10000;i++){……}

所以本程序使用/Qunroll参数,让Intel编译器自己决定使用循环展开的层数。但是在程序的最终优化时,如果发现Intel编译器的循环展开并不是最优的,则通过在特定循环前加上编译制导语句,使用最佳的循环展开层数。

浮点计算优化

Intel编译器提供了很多基于浮点数的优化参数,有提供精度的,也有提高速度的。对于本程序,主要使用如下优化参数。

/fp: fast或/fp: fast=1:这两个参数的等价的,同时也是默认的参数。他告诉编译器进行快速浮点计算优化。/fp: fast=2:这个参数比/fp: fast=1提供更高的优化级别,同时也可能带来更大的精度损失。

本程序使用/fp: fast=2优化,但是如果发生精度问题,可以考虑使用/fp: fast=1。

自动并行化

Intel的编译器支持自动并行化(Auto-parallelization)。通过/Qparallel可以打开编译器的自动并行化,编译器会在分析了用户的串行程序后,自动选择可以并行的部分进行并行化。自动并行化的有点是方便,不需要用户懂得专业知识,不需要更改原来的串行程序。但是缺点也是显而易见的,由于编译器并不知道用户的程序逻辑,所以无法很好得进行并行化。

使用OpenMP并行化

OpenMP是一种通用的并行程序设计语言,其通过在源代码中添加编译制导语句,提示编译器如何进行程序的并行化。OpenMP具有书写方便,不需要改变源代码结构等多种优点。Intel的编译器支持OpenMP。本次程序并不打算使用OpenMP进行并行化,而打算使用Windows Thread。但是由于本程序需要使用到Intel Math Kernel Library,而Intel Math Kernel Library中的代码支持OpenMP并行化。所以有必要使用一些基本的OpenMP设置函数。

需要使用OpenMP,需要在编译时加上/Qopenmp选项。并且在源代码中包含” omp.h”文件。

OpenMP提供了函数omp_set_num_threads(nthreads)设置OpenMP使用的线程数,由于其设置会影响到Intel Math Kernel Library,所以将其设置成1,禁止Intel Math Kernel Library的自动并行化。

向量化

Intel的编译器支持向量化(Vectorization)。可以把循环计算部分使用MMX,SSE,SSE2,SSE3,SSSE3等指令进行向量化,从而大大提高计算速度。这也是本程序串行化时的主要优化点。前面提到的针对处理器的/QaxT优化选项已经打开了向量化。将代码向量化还有许多需要注意的地方,具体的注意点和方法将在后面具体的代码中说明。这里先给出一些对向量化有用的编译制导语句以及选项。

/Qrestrict选项:当Intel编译器遇到循环中使用指针时,由于多个指针可能指向同一个地址,所以其无法保证指针指向内容的唯一性。故Intel编译器无法确定循环内数据是否存在依赖性。这是可以通过使用/Qrestrict选项与restrict关键字,指示某个指针指向内容的唯一性。从而能解决数据依赖性不确定的问题。

#pragma vector编译制导语句:该编译制导语句一共包含3个。#pragma vector always用于指示编译器忽略其他因素,进行向量化。#pragma vector aligned用于指示编译器进行向量化时使用对齐的数据读写方式。#pragma vector unaligned用于指示编译器进行向量化时使用不对齐的数据读写方式。由于在使用SSE类指令进行向量化时,需要同时处理多个数据,所以每次读写的数据长度很长,可以达到128bit。所以将要处理的数据按照128bit(16byte)对齐,使用对齐的读写指令是可以提高程序运行速度的。但是需要注意的是对于实际没有对齐的数据使用#pragma vector aligned会造成程序运行错误。

使用变量对齐指示

Intel编译器提供了__declspec(align(n))用于在定义变量时指定其需要进行n字节对齐。变量对齐对于向量化计算的读取速度有很大关系。对于向量化计算一般使用__declspec(align(16))进行对齐。另外也可以使用__declspec(align(64))指定变量对齐到Cache的行首。关于Cache的行对齐的详细讨论请见后文的分析。

数据预读

通常数据是放在内存中,当要计算时才读入CPU进行计算。由于内存到CPU的传输需要很长时间,所以CPU中有多级Cache机制。Intel编译器支持数据预读优化选项。通过/Qprefetch打开数据预读优化,编译器会在使用数据前先插入预读指令,让CPU先把数据预读到Cache中,从而加快数据的访问速度。该选项默认情况下是打开的。此外Intel还提供了数据预读的编译制导语句,通过使用#pragma prefetch语句,用户可以人为得在程序中增加数据预读指令。但是需要注意的是,数据预读指令并不是越多越好的。不恰当的数据预读指令会占用内存带宽,把有用的数据从Cache中挤出去,反而影响速度。并且Core Microarchitecture体系结构已经支持给予硬件的数据预读指令。所以本程序倾向于使用给予硬件的数据预读机制。而由于/Qprefetch默认的打开的,也没有必要特意关闭该选项,Intel编译器有能力判断哪些地方可以通过合适的数据访问模式激活硬件数据预读机制,哪些地方需要额外添加数据预读指令。

产生调试信息

通过使用/Zi选项产生调试信息以帮助调试。默认为关闭。在本程序的开发阶段,打开此选项。在开发完成后关闭此选项。

使用全局优化

通过使用/Og选项打开编译器的全局优化功能。改选项需要在本程序不同的开发阶段分别尝试是否打开以确定最优优化选项。

针对Windows程序优化

通过使用/GA选项可以打开Intel编译器的针对Windows程序优化的功能。其实通过打开/GA选项,Intel可以提高访问Windows下thread-local storage(TLS)变量的速度。TLS变量通过__declspec(thread)来定义。在本程序中,并不打算使用TLS变量。但还是打开/GA选项。

内联函数扩展

Intel编译器可以通过/Obn来定义内联函数的扩展级别。当n为0禁止用户定义的内核函数的扩展。当n为1时,根据用户定义的inline关键字进行扩展。当n为2时,根据Intel编译器的自动判断进行扩展。本次程序使用/Ob2选项。

FTZ与DAZ

在计算机内浮点数是由尾数和指数组成的。尾数通常被规范化成[1,2)之间。但是当数字接近0时,由于其指数已经无法将尾数规范成[1,2)之间,所以需要在尾数表示成0.0000xx的形式。这种表示形式称为不规范的形式。其会影响CPU的浮点计算速度。并且由于这种数非常接近0,所有有时将其表示成0并不会影响计算的结果。所以CPU的浮点控制器有2个用于控制对于不规范数处理的选项。FTZ用于将计算结果中的不规范数表示成0,DAZ用于在读入不规范数时将其表示成0。Intel编译器提供了内置的宏来方便用户设置这两个模式。这两个宏分别是_MM_SET_FLUSH_ZERO_MODE(_MM_FLUSH_ZERO_ON)和_MM_SET_DENORMALS_ZERO_MODE(_MM_DENORMALS_ZERO_ON)。用户在程序中设置了这两个模式将有助于提高浮点计算速度。但是实际上对于本程序,由于已经使用了/O3以及SSE指令集优化。所以Intel编译器已经设置好了FTZ模式,用户不必另外设置FTZ。并且由于本程序中所有的数都是计算得来的,所以只要计算时使用了FTZ,那读取数据时就不会碰到不规范的数据,所以用户也没必要设置DAZ。

编译器报告

编译器报告虽然不能直接提供优化,但是却可以让用户了解编译器处理程序的信息,给用户更改源代码提供了很多有用的信息。对于本程序,向量化是非常重要的一步,而编译器报告可以指出某个地方是由于什么原因造成没有向量化。所以本使用使用/Qvec-report3参数对向量优化进行报告。

使用Intel编译器函数进行精确时间测量

Intel编译器提供了许多特殊的函数。这类函数一般都对应一条或者几条汇编语言。其可以让用户以比汇编语言方便的方式写出性能接近汇编语言的代码。其中最主要的是对SIMD类指令的支持。当然其中还有很多其他功能的函数。比如_rdtsc()函数。

需要注意的是要使用这些函数必需打开/Oi选项。这个选项默认是打开的。

当程序需要进行精确时间测量,比如优化后需要知道某段特定的代码到底快了多少毫米时,使用Windows的时间函数已经无法满足精度要求。这是用户可以使用Intel VTune Analyzers进行测量(具体使用方法将在后面介绍)。其实CPU已经提供了一个特殊的机器指令rdtsc,使用这条指令可以读出CPU自从启动以来的时钟周期数。由于现在的CPU主频已经是上GHz了。所以,其计时精度可以达到纳秒级。Intel提供的_rdtsc()函数使得用户不必再使用汇编语言,可以像调用函数一样得到CPU的时钟周期数。例子代码如下:

注:以下代码摘自“Intel C++ Compiler Documentation”1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

int main()

{

__int64 start, stop, elaspe;

int i;

int arr[10000];

start= _rdtsc();

for(i=0; i<10000; i++)

{

arr[i]=i;

}

stop= _rdtsc();

elaspe = stop -start;

printf("Processor cycles\n %I64u\n", elaspe);

return 0;

}

经过以上编译器选项的调整,程序的运行速度已经达到了2.25秒。

使用Intel VTune Analyzers进行性能分析

Intel VTune Analyzers概述

Intel VTune Analyzers用于监视程序或者系统的各种性能,从而为用户优化程序提供有价值的数据。同时Intel VTune Analyzers也能分析其收集的信息,给出用户优化程序的建议。Intel VTune Analyzers即支持本地的数据收集,也支持远程的数据收集。在本程序中,我们只需使用其本地数据收集功能。Intel VTune Analyzers共支持3种数据收集机制。每种机制都有其自己的适用范围,详细介绍如下:

- SAMPLING:其通过使用CPU内部的监视功能来检测系统底层的各种性能事件。使用这个功能无需在执行代码中插入特定的指令,因此其几乎没有探针效应。其无法给出函数间的调用关系。但是可以把相应的事件关联到程序中某行源代码或者汇编代码上。该方法通常适用于对某段程序的微调或者针对特定性能事件的调整上。

- CALL GRAPH:其通过在程序中插入特殊的指令,来记录每个函数执行的时间。函数间的调用关系等。其有一定的探针效应。该方法通常用于对于整个比较庞大的程序,进行分析,找出其中具有性能瓶颈的函数。

- COUNTER MONITOR:其无需在程序内部插入特殊的指令,因此其几乎没有探针效应。该方法即无法显示函数间的调用关系,也没法把事件定位到具体的某行代码中。该方式是用于测试整个系统的某些性能,比如CPU占用率,内存带宽等。通常用于系统级的调试。

对于本程序。由于程序结构简单。无需进行函数间调用的分析。而主要需要进行基于特定代码的分析。特别是后期需要针对CPU内部的事件特性进行源代码级甚至是汇编级的调试。所以本次优化主要采用SAMPLING方式。

基于SAMPLING方式的分析

原理:Intel的CPU有一组性能检测寄存器,由于记录各种影响性能的事件。程序首先通过编程设定需要检测的事件,并且设定触发中断的计数值。当CPU中被检测的事件达到预设的值后触发相应的中断。Intel VTune Analyzers中的SAMPLING就是使用CPU的性能检测功能帮助用户分析程序的性能。其中有关于内存访问的事件,分支预测的事件,指令执行的事件等等。由于不同的CPU支持不同的性能事件,所以在不同的CPU上使用VTune时,所能监视的事件并不相同。

使用注意事项:SAMPLING一共支持2种统计。一种是Event,其是直接测量得到的值。另外一种是Event Ratio,其是基于多个Event计算得到的,有时更有实际意义,更直观。需要注意的是,每个Event都有一个预设的值,当这个预设的值到了以后,CPU引起中断,VTune进行统计。而这个值的设置不能太大,否则统计到的事件不够多,无法分析。也不能太小,否则频繁引起中断,会加大探针效应。用户可以在每个Event上手工设置合适的Sample After值,也可以通过选项卡上的选项,让VTune先运行一遍程序,然后根据实际的事件数量来校准触发值。对于本程序,这点尤其需要引起注意。因为本程序优化到后面时间非常短,如果不校准触发值,分析的效果会不理想。需要注意的是Clockticks和Instructions Retired这两个最基本的事件,默认是不校准触发值的,我们需要把他们调整成自动校准。此外对于某个Event的发生,大部分的中断点并不是精确的。即真正发生该事件的指令在所记录事件指令的前几条。但是有一部分属于精确事件,引起这类事件的指令正好是发生中断的前一条。

优化computePot函数

在对computePot函数向量化前,我们可以注意到distx,disty,distz三个变量都是临时变量。先将这3个变量去掉,从而可以使得Intel编译器能够更灵活得进行中间结果优化。另外最完成循环的i虽然是从0开始的,但是实际0和1并不进行计算,所以把外层循环的i设置层从2开始。代码如下:1

2

3

4

5

6for( i=2; i<NPARTS; i++ ) {

for( j=0; j<i-1; j++ ) {

dist = sqrt( (r[0][j] - r[0][i])*(r[0][j] - r[0][i]) + (r[1][j] - r[1][i])*(r[1][j] - r[1][i]) + (r[2][j] - r[2][i])*(r[2][j] - r[2][i]) );

pot += 1.0 / dist;

}

}

此时编译器显示内层循环已经向量化了。但是这个绝非我们的目标。为了提高计算开根号倒数的速度,为了使用Intel Math Kernel Library,我们需要把开根号倒数的计算先存在一组向量中,再一同计算。既将dist变量变成,dist数组,然后再对dist数组统一计算,再求和。代码如下:1

2

3

4

5

6

7

8

9

10

11for( i=2; i<NPARTS; i++ ) {

for( j=0; j<i-1; j++ ) {

dist[j] = (r[0][j] - r[0][i])*(r[0][j] - r[0][i]) + (r[1][j] - r[1][i])*(r[1][j] - r[1][i]) + (r[2][j] - r[2][i])*(r[2][j] - r[2][i]);

}

for( j=0; j<i-1; j++ ) {

dist[j] = 1.0 / sqrt(dist[j]);

}

for( j=0; j<i-1; j++ ) {

pot += dist[j];

}

}

Intel编译器提示,内部的3个循环都进行了向量化。此时出现了令人惊喜的成绩。程序的执行时间突然降到了1.453秒。使用VTune进行分析,发现Intel编译器对于开根号倒数的计算自动调用了内部的向量化代码库。注意此时,还没有使用Intel Math Kernel Library,所以这个向量代码库是Intel编译器内置的,虽然效率没有使用Intel Math Kernel Library高,但是速度已经提高了很多。

使用Intel Math Kernel Library

Intel Math Kernel Library中提供了一部分的向量函数(Vector Mathematical Functions)。这类函数提供了对于普通数学计算函数的快速的向量化计算。VML中有一个向量函数就是计算开根号倒数的。

Intel的VML库中提供了如下函数来计算整个向量中各个数的开根号倒数:1

vdInvSqrt( n, a, y )

其中n表示计算的元素个数。a是指向输入计算数据数组的头指针。y是指向输出计算数据数组的头指针。其中a和y可以相同。

要使用该函数,首先需要在头文件中包含”mkl.h”,并且链接mkl_c.lib文件和libguide40.lib文件。

除了基本计算功能外,VML还提供了一个设置模式的函数,用于设置特定的计算模式:1

vmlSetMode ( mode )

其中的mode是一个预定义宏。在我们的程序中,需要设置如下模式:

VML_LA:VML的所有向量函数都提供了2个精度的版本。精度低的版本计算速度也相对比较快。本程序只需要保留小数点后7位精度。低精度的版本符合要求,所以设定VML使用低精度的版本。VML_DOUBLE_CONSISTENT:该选项用于控制FPU的计算精度为double,其实由于我们这次使用的函数基本上是使用SSE2指令集进行计算的,和FPU没什么关系。但是也可能存在使用FPU的可能,所以设定VML使FPU的精度为double。VML_ERRMODE_IGNORE:该选项用于关闭VML的错误处理功能,本程序不需要进行错误处理。VML_NUM_THREADS_OMP_FIXED:VML函数都能使用OpenMP,根据特定的硬件环境进行并行化。而我们并不需要其进行并行化。所以使用该选项和前面提到的omp_set_num_threads(1)结合。关闭VML的自动并行化功能。

具体的代码如下:1

2

3

4

5

6

7

8

9for ( i = 2; i < NPARTS; i ++ ) {

for ( j = 0; j < i - 1; j ++ ) {

dist[j] = (r[0][j] - r[0][i]) * (r[0][j] - r[0][i]) + (r[1][j] - r[1][i]) * (r[1][j] - r[1][i]) + (r[2][j] - r[2][i]) * (r[2][j] - r[2][i]);

}

vdInvSqrt(i-1, dist, dist);

for ( j = 0; j < i - 1; j ++ ) {

pot += dist[j];

}

}

优化后出现了令人可惜可贺的成绩:0.796秒。

根据Cache大小优化Intel Math Kernel Library调用

在上面的程序中对于MKL函数的调用是每次内部循环都执行一次调用,我们知道每次执行函数的调用都是需要开销的,那是否有更优化的调用MKL方法那?下面这段话摘自Intel Math Kernel Library的说明文档上:

There are two extreme cases: so-called “short” and “long” vectors (logarithmic scale is used to show both cases). For short vectors there are cycle organization and initialization overheads. The cost of such overheads is amortized with increasing vector length, and for vectors longer than a few dozens of elements the performance remains quite flat until the L2 cache size is exceeded with the length of the vector.

从这段文字中,我们了解到对于MKL函数的调用时,所处理的向量不能太短,否则函数的建立时间开销将是非常大的,也不能太长,操作了L2 Cache,否则函数执行时访问内存的开销是很大的。不合适的长度对于函数的性能将产生指数级影响。

根据理论计算:每次执行computePot函数,总共需要执行的计算量为(1+998)*998/2=498501个。每个double类型占用8个字节,所有总共需要占用的空间为498501*8=3988008byte=3894KB。而这次进行竞赛的测试平台的CPU的L2 Cache大小为2M,由于有2个线程同时计算,平均每个线程分到的L2 Cache为1M。由于L2 Cache可能还被其他数据占据。所以为了保证所计算的数据在L2 Cache中,最好每次计算的向量长度在512KB左右。故把整个computePot函数的计算量分成8份。每份计算量的中间结果向量长度为3894KB/8=486KB。

但是实际情况并非如此,进行这种优化后,程序的执行速度反而降低了。通过分析发现原来CPU中的L1 Cache大小为32KB。数组r有3000个元素,如果每次迭代都进行vdInvSqrt调用。那dist的长度为1000个元素左右。加起来正好可以全部在L1 Cache中。而如果合并起来调用vdInvSqrt,则由于vdInvSqrt过长。其L1 Cache中存放不下,需要存放在L2 Cache中,从而反而影响了速度。看来,对于本程序,不应该根据L2 Cache进行优化,而应该根据L1 Cache进行优化。但是对于只有几个或者几十个数据就调用MKL函数,其开销还是很大的。因此本程序使用了折中的方法,对于前面非常小的几十个数据,凑足1000个放在一起进行计算,而后面的数据还是按照原来的方式计算。具体实现的代码如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21for( i = 2, k = 0; i < 47; i ++ ) {

for( j = 0; j < i - 1; j ++, k ++ ) {

dist[k] = (r[0][j] - r[0][i]) * (r[0][j] - r[0][i]) + (r[1][j] - r[1][i]) * (r[1][j] - r[1][i]) + (r[2][j] - r[2][i]) * (r[2][j] - r[2][i]);

}

}

vdInvSqrt(k, dist, dist);

for( j = 0; j < k; j ++ ) {

pot += dist[j];

}

for( i = 47; i < NPARTS; i ++ ) {

for( j = 0; j < i - 1; j ++ ) {

dist[j] = (r[0][j] - r[0][i]) * (r[0][j] - r[0][i]) + (r[1][j] - r[1][i]) * (r[1][j] - r[1][i]) + (r[2][j] - r[2][i]) * (r[2][j] - r[2][i]);

}

vdInvSqrt(i - 1, dist, dist);

for( j = 0; j < i - 1; j ++ ) {

pot += dist[j];

}

}

通过该优化,程序的性能略微有所提高,达到了0.781秒。

优化updatePositions函数

虽然updatePositions函数执行的时间非常短。但还是值得优化的。

首先进行的是基于数学的优化。我们发现在updatePositions和initPositions中,都有加0.5的计算。但是从后面的computePot的相减计算中发现,这个0.5是被抵消的,既不加0.5对结果没有影响。故去掉该加0.5的计算。另外updatePositions和initPositions中都有除以RAND_MAX的计算。而通过提取公因子的变换发现,如果此处不除以RAND_MAX而将最后的pot乘以RAND_MAX,则最后结果相同。故去掉该处的除以RAND_MAX的计算,而以在pot上一次乘以RAND_MAX为替换。具体代码如下:1

2

3

4

5

6

7

8

9

10

11

12

13void initPositions() {

int i, j;

for( i = 0; i < DIMS; i ++ )

for( j = 0; j < NPARTS; j ++ )

r[i][j] = (double) rand();

}

void updatePositions() {

int i, j;

for( i = 0; i < DIMS; i ++ )

for( j = 0; j < NPARTS; j ++ )

r[i][j] -= (double) rand();

}

在main函数中:1

2

3

4pot = 0.0;

computePot();

pot*=(double)RAND_MAX;

if (i%10 == 0) printf("%5d: Potential: %20.7f\n", i, pot);

其次需要进行updatePositions内rand函数的优化。虽然rand函数本身的执行时间非常短,但是其频繁得进行调用却影响了性能。通过查找Microsoft Visual Studio .NET 2005中提供的源代码。将其中的rand函数提取出来,进行必要的修改,并且加上inline属性。从而加快程序的调用速度。具体代码如下:1

2

3

4

5int holdrand=1;

inline int myrand (){

return( ((holdrand = holdrand * 214013L+ 2531011L) >> 16) & 0x7fff );

}

经过上述优化,代码的执行速度已经达到了0.765秒。

其他优化以及性能分析

至此,该程序串行优化部分已经一本完成。但是还有一点细小的地方需要优化。

变量对齐对于数据读取速度是非常重要的。尤其是使用SIMD指令集进行优化后,对于对齐的变量,可以使用对齐的读写指令提高速度。一般对于SIMD指令需要进行16字节对齐。但是对于本程序,由于后面要进行多线程优化,而多线程执行时基于Cache Line的共享冲突会对读写造成很大的损失。故本程序使用64字节对齐。代码如下:1

2

3

4__declspec(align(64)) int holdrand=1;

__declspec(align(64)) double r[DIMS][NPARTS];

__declspec(align(64)) double pot;

__declspec(align(64)) double dist[1048];

在computePot函数的第一次迭代中。有一处进行pot累加的地方,使用了k变量作为循环条件。但是其实该变量的确切值是可以计算出来的。通过计算出该变量的确切值,可以让Intel编译器在编译时就知道循环的次数,从而有助于优化。具体代码如下(注意1035这个值):1

2

3

4

5

6

7

8

9

10

11for( i = 2, k = 0; i < 47; i ++ ) {

for( j = 0; j < i - 1; j ++, k ++ ) {

dist[k] = (r[0][j] - r[0][i]) * (r[0][j] - r[0][i]) + (r[1][j] - r[1][i]) * (r[1][j] - r[1][i]) + (r[2][j] - r[2][i]) * (r[2][j] - r[2][i]);

}

}

vdInvSqrt(k,dist,dist);

for( j=0; j<1035; j++ ) {

pot += dist[j];

}

此外再调整以下编译器的某些优化参数,选择合适的使用。比如使用哪个编译级别,是否打开全局优化,使用IPO,使用GPO等。

并行优化

并行优化概述

在进行本程序的并行优化前先谈谈并行优化需要注意的问题。在并行优化中经常用到数据重复和计算重复的方法。所谓数据重复,就是为了保证多个线程能同时进行计算,就把数据复制多份来提高并行度。所谓计算重复,就是有时使用计算换通信的方法,提高并行度。

在对本程序进行优化前需要注意的是。测试平台使用的是基于Core Microarchitecture结构的。这个结构的双核CPU是共享L2 Cache的。但是当数据在一个核中进行修改,另外一个核去读他时,需要消耗几十个时钟周期的延迟。其代价的非常高的。这里需要注意的是,数据在Cache中是按行进行存放的,也就是说,CPU看待数据有没有被修改过是根据Cache Line的。所以2个分别被不同的核修改的数据如果存在于同一行Cache中,访问时的效率就会非常低。也就是发生了共享冲突。所以在分配变量时要尽量把不同性质的变量分配到不同的Cache Line中。我们的测试平台的L1 Cache和L2 Cache都是每行64byte的。所以前一章中的变量对齐都使用了64byte对齐。同样,在程序并行化时也需要考虑这种情况。

优化方案一

此方案使用数据重复的方法。程序可以定义2个r数组。以及2个pot数组。通过定义2个r数组,使得主线程可以在从线程使用一个r数组计算时同时更新第二个r数组。即主线程先更新r数组,然后主线程和从线程同时开始计算。但是从线程的计算量比主线程大一点。这样当主线程计算完后,可以继续更新第二个r数组,而此时从线程还在计算原来r数组的内容。当主线程更新完第二个r数组时,从线程正好完成前面的计算,并和主线程一同计算第二个r数组,依次类推。同时2个pot数组,一个给主线程计算每步的中间结果,另一个给从线程计算每步的中间结果。等计算结束后,再将其结果相加,打印。

优点:使用该方法的优点是显而易见的,理论上线程可以做到完全同步。

缺点:使用该方法的缺点是,从线程每次计算需要从主线程计算好的r数组中读取内容,由于是2个核,所以其访问延迟非常大。此外使用2个数值,每次迭代都需要将指针指向使用的数组,增加了程序的设计难度。同时计算任务分配的调优也是非常繁琐的。

由于在前一章中,我们发现updatePositions函数所花费的时间非常短。所以做到线程间的完全平衡意义并不大。

优化方案二