UNIX基础知识 UNIX体系结构 从严格意义上说,可将操作系统定义为一种软件,它控制计算机硬件资源,提供程序运行环境。我们通常将这种软件称为内核(kermel),因为它相对较小,而且位于环境的核心。

内核的接口被称为系统调用(systemcall)。公用函数库构建在系统调用接口之上,应用程序既可使用公用函数库,也可使用系统调用。

文件和目录 文件系统 UNIX文件系统是目录和文件的一种层次结构,所有东西的起点是称为根(root)的目录,这个目录的名称是一个字符“/“。

目录(directory)是一个包含目录项的文件。在逻辑上,可以认为每个目录项都包含一个文件名,同时还包含说明该文件属性的信息。文件属性是指文件类型(是普通文件还是目录等)、文件大小、文件所有者、文件权限(其他用户能否访问该文件)以及文件最后的修改时间等。stat和fstat函数返回包含所有文件属性的一个信息结构。

文件名 目录中的各个名字称为文件名(filename)。只有斜线(/)和空字符这两个字符不能出现在文件名中。斜线用来分隔构成路径名的各文件名,空字符则用来终止一个路径名。

创建新目录时会自动创建了两个文件名:.(称为点)和..(称为点点)。点指向当前目录,点点指向父目录。在最高层次的根目录中,点点与点相同。现今,几乎所有商业化的UNIX文件系统都支

路径名 由斜线分隔的一个或多个文件名组成的序列(也可以斜线开头)构成路径名(pathname),以斜线开头的路径名称为绝对路径名(absolute pathname),否则称为相对路径名(relative pathname)。相对路径名指向相对于当前目录的文件。文件系统根的名字(/)是一个特殊的绝对路径名,它不包含文件名。

不难列出一个目录中所有文件的名字,以下命令的简要实现。1 2 3 4 5 6 7 8 9 10 11 12 13 14 #include "apue.h" #include <dirent.h> int main (int arge, char *argv[]) DIR *dp; struct dirent *dirp; if (argc != 2 ) err_quif ("usage: ls directory_nane" ) a if ((dp = opendir(argv[1 ])) == NULL ) err_ays ("can't open %s" , argv[1 ]) ; while ((dirp = readdir (dp)) !- NULL ) printe ("%s\n" , dirp->d_name); closedir (dp); exit (0 ); }

在这个20行的程序中,有很多细节需要考虑。

首先,其中包含了一个头文件apue.h。本书中几乎每一个程序都包含此头文件。它包含了某些标准系统头文件,定义了许多常量及函数原型。

接下来,我们包含了一个系统头文件dirent.h。以便使用opendir和readdir的函数原型,以及dirent结构的定义。在其他一些系统里,这些定义被分成多个头文件。

main函数的声明使用了ISO C标准所使用的风格程序获取命令行的第1个参数argv[1]作为要列出其各个目录项的目录名。

因为各种不同UNIX系统目录项的实际格式是不一样的,所以使用函数opendir、readdir和closedir对目录进行处理。

opendir函数返回指向DIR结构的指针,我们将该指针传送给readdir函数。然后,在循环中调用readdir来读每个目录项。它返回一个指向dirent结构的指针,而当目录中已无目录项可读时则返回null指针。在dirent结构中取出的只是每个目录项的名字(d_name)。使用该名字,此后就可用stat函数以获得该文件的所有属性。当程序将结束时,它以参数0调用函数exit()。函数exit()终止程序。按惯例,参数0的意思是正常结束,参数值1~255则表示出错。

工作目录 每个进程都有一个工作目录(working directory),有时称其为当前工作目录(current working directory),所有相对路径名都从工作目录开始解释。进程可以用chdir函数更改其工作目录。

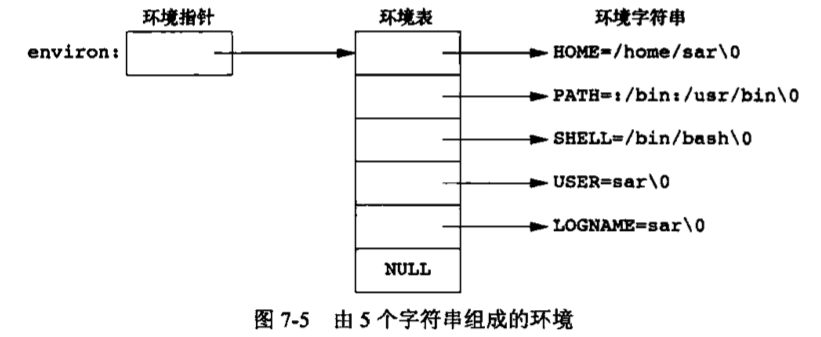

起始目录 登录时,工作目录设置为起始目录(home directory),该起始目录从口令文件中相应用户的登录项中取得

输入和输出 文件描述符 文件描述符(flle descriptor)通常是一个小的非负整数,内核用以标识一个特定进程正在访间的文件。当内核打开一个现有文件或创建一个新文件时,它都返回一个文件描述符。在读、写文件时,可以使用这个文件描述符。

标准输入、标准输出和标准错误 按惯例,每当运行一个新程序时,所有的shell都为其打开了个文件描述符,即标准输入(standard input)、标准输出(standard output)以及标准错误(standarderror)。如果不做特殊处理,则这3个描述符都链接向终端。

不带缓冲的I/O 函数open、read,write、lseek以及close提供了不带缓冲的I/O。这些函数都使用文件描述符。

如果愿意从标准输入读,并向标准输出写,则所示的程序可用于复制任一UNIX普通文件1 2 3 4 5 6 7 8 9 10 11 12 13 #include "apue.h" #define BUFFSIZE 4096 int main (void ) int n; char buf [BUFFSIZE]; while ((n = read (STDIN_FILENO, buf, BUFFSIZE)) > 0 ) if (write (STDOUT_FILENO, buf, n) != n) exc_syn ("write exror" ); if (n < 0 ) err_sys ("read error" ); exif (0 ); }

头文件<unistd.h>(apue.h中包含了此头文件)及两个常量STDIN_FILENO和STDOUT_FILENO是POSIX标准的一部分,头文件<unistd.h>包含了很多UNIX系统服务的函数原型,

两个常量STDIN_FILENO和STDOUT_FILENO定义在<unistd.h>头文件中,它们指定了标准输入和标准输出的文件描述符。在POSIX标准中,它们的值分别是0和1,但是考虑到可读性,我们将使用这些名字来表示这些常量

read函数返回读取的字节数,此值用作要写的字节数。当到达输入文件的尾时,read返回0,程序停止执行。如果发生了一个读错误,read返回-1。出错时大多数系统函数返回-1。

标准I/O 标准I/O函数为那些不带缓冲的I/O函数提供了一个带缓冲的接口。使用标准I/O函数无需担心如何选取最佳的缓冲区大小使用标准I/O函数还简化了对输入行的处理。例如,fgets函数读取一个完整的行,而read函数读取指定字节数。

我们最熟悉的标准I/O函数是printf。在调用printf的程序中,总是包含<stdio.h>,该头文件包括了所有标准I/O函数的原型。

下面的程序的功能类似于前一个调用了read和write的程序。它将标准输入复制到标准输出,也就能复制任一UNIX普通文件。1 2 3 4 5 6 7 8 9 10 11 #include "apue.h" int main (void ) int c; while ((c = getc (stdin)) != EOF) if (putc (c, stdout) == EOF) exr_sys ("output exror" ); if (ferror (stdin)) err_sys ("input error" ); exit (0 ); }

函数getc一次读取一个字符,然后函数putc将此字符写到标准输出。读到输入的最后一个字节时,getc返回常量EOF(该常量在<stdio.h>中定义)。标准I/O常量stdin和stdout也在头文件<stdio.h>中定义,它们分别表示标准输入和标准输出。

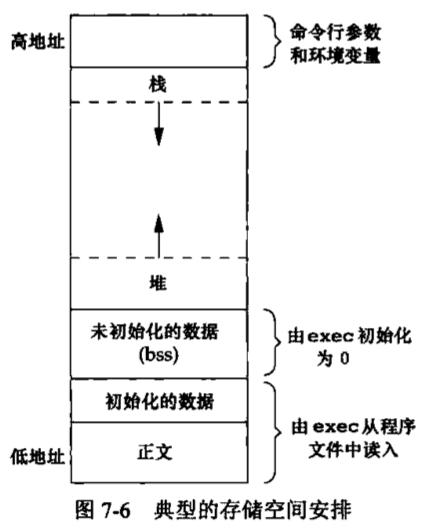

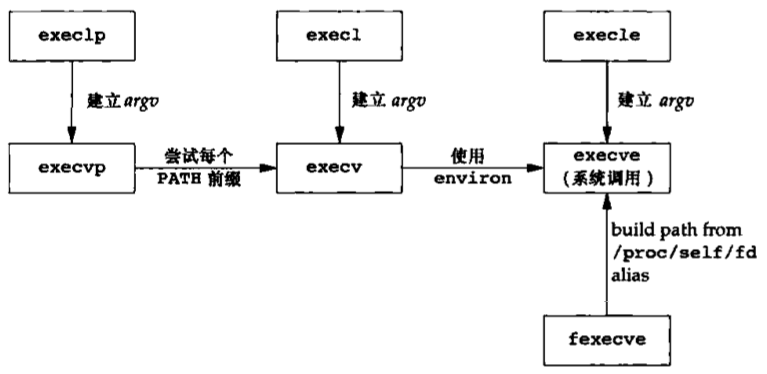

程序和进程 程序 程序(program)是一个存储在磁盘上某个目录中的可执行文件。内核使用exec函数(7个exec函数之一),将程序读入内存,并执行程序。

进程和进程ID 程序的执行实例被称为进程(process)。某些操作系统用任务(task)表示正在被执行的程序,UNIX系统确保每个进程都有一个难一的数字标识符,称为进程ID(process ID)。进程ID总是一个非负整数。

程序用于打印进程ID1 2 3 4 5 #include "apue.h" int main (void ) printf ("hello world from process ID sid\n" , (long )getpid ()); exif (0 ); }

此程序运行时,它调用函数getpid得到其进程ID。getpid返回一个pid_t数据类型。

进程控制 有3个用于进程控制的主要函数:fork、exec和waitpid。

该程序从标准输入读取命令,然后执行这些命令。它类似于shell程序的基本实施部分。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 #include "apue.h" #include <sys/wait.h> int main (void ) char buf[MAXLINE]; pid_t pid; int status; printf ("%% " ); while (fgets (buf, MAXLINE, stdin) != NULL ) { if (buf[strlen (buf) - 1 ] == '\n' ) buf[strlen (buf) - 1 ] = 0 ; if ((pid = fork()) < 0 ) { err_sys ("fork error" ); } else if (pid == 0 ) { execlp (buf, buf, (char *)0 ); err_ret ("couldn't execute: %s" , buf); exit (127 ); } if ((pid = waitpid (pid, &status, 0 )) < 0 ) err_sys ("waitpid error" ); printf ("%% " ); } exit (0 ); }

在这个30行的程序中,有很多功能需要考虑,

用标准I/O函数fgets从标准输入一次读取一行。当键入文件结束符(通常是Ctrl+D)作为行的第一个字符时,fgets返回一个null指针,于是循环停止,进程也就终止。

因为fgets返回的每一行都以换行符终止,后随一个null字节,因此用标准C函数strlen计算此字符串的长度,然后用一个null字节替换换行符。这样做是因为execlp函数要求的参数是以null结束的而不是以换行符结束的

调用fork创建一个新进程。新进程是调用进程的一个副本,我们称调用进程为父进程,新创建的进程为子进程。fork对父进程返回新的子进程的进程ID(一个非负整数),对子进程则返回0。因为fork创建一个新进程,所以说它被调用一次(由父进程),但返回两次(分别在父进程中和在子进程中)。

在子进程中,调用execlp以执行从标准输入读入的命令。这就用新的程序文件替换了子进程原先执行的程序文件。

子进程调用execlp执行新程序文件,而父进程希望等待子进程终止,这是通过调用waitpid实现的,其参数指定要等待的进程(即pid参数是子进程ID)。waitpid函数返回子进程的终止状态(status变量)。

该程序的最主要限制是不能向所执行的命令传递参数。例如不能指定要列出目录项的目录名,

线程和线程ID 通常,一个进程只有一个控制线程(thread)——某一时刻执行的一组机器指令。多个控制线程也可以充分利用多处理器系统的并行能力。

一个进程内的所有线程共享同一地址空间、文件描述符、找以及与进程相关的属性。因为它们能访问同一存储区,所以各线程在访问共享数据时需要采取同步措施以避免不一致性。与进程相同,线程也用ID标识。但是,线程ID只在它所属的进程内起作用。一个进程中的线程ID在另一个进程中没有意义。

控制线程的函数与控制进程的函数类似,但另有一套,线程模型是在进程模型建立很久之后才被引入到UNIX系统中的,然而这两种模型之间存在复杂的交互。

出错处理 当UNIX系统函数出错时,通常会返回一个负值,而且整型变量errno通常被设置为具有特定信息的值,文件<errno.h>中定义了errno以及可以赋与它的各种常量。这些常量都以字符E开头。

POSIX和ISO C将errno定义为一个符号,它扩展成为一个可修改的整形左值(Ivalue)。它可以是一个包含出错编号的整数,也可以是一个返回出错编号指针的函数。以前使用的定义是:

但是在支持线程的环境中,多个线程共享进程地址空间,每个线程都有属于它自己的局部errno以避免一个线程干扰另一个线程。例如,Linux支持多线程存取errno,将其定义为:1 2 extern int *_errno_location(vold),#detine errno (*_errno_location())

对于errno应当注意两条规则。第一条规则是:如果没有出错,其值不会被侧程清除。因此,仅当函数的返回值指明出错时,才检验其值。第二条规则是:任何函数都不会将errno值设置为0,而且在<errno.h>中定义的所有常量都不为0。

C标准定义了两个函数,它们用于打印出错信息。1 2 #include <string.h> char *strerror (int errnum)

strerror函数将errnum(通常就是errno值)映射为一个出错消息字符串,并且返回此字符串的指针。

perror函数基于errno的当前值,在标准错误上产生一条出错消息,然后返回。1 2 #include <stdio.h> void perror (const char *msg)

它首先输出由msg指向的字符串,然后是一个冒号,一个空格,接着是对应于errno值的出错消息,最后是一个换行符。1 2 3 4 5 6 7 8 9 #include "apue.h" #include cerrno.b> int main (int argc, char *argv[]) fprintf (stderr, "EACCES: %s\n" , strerror (BACCES)); errno = ENOENT; perror (argv[0 ]); exit (0 ); }

可将在<errno.h>中定义的各种出错分成两类;致命性的和非致命性的。对于致命性的错误,无法执行恢复动作。最多能做的是在用户屏幕上打印出一条出错消息或者将一条出错消息写入日志文件中,然后退出。对于非致命性的出错,有时可以较妥善地进行处理。

大多数非致命性出错是暂时的(如资源短缺),当系统中的活动较少时,这种出错很可能不会发生。与资源相关的非致命性出情包括:EAGAIN、ENFILE、ENOBUFS、ENOLCK、ENOSPC、EWOULDBLOCK,有时ENOMEM也是非致命性出错。当EBUSY指明共享资源正在使用时,也可将它作为非致命性出错处理。当EINTR中断一个慢速系统调用时,可将它作为非致命性出错处理。

对于资源相关的非致命性出错的典型恢复操作是延迟一段时间,然后重试。一些应用使用指数补偿算法,在每次选代中等待更长时间。

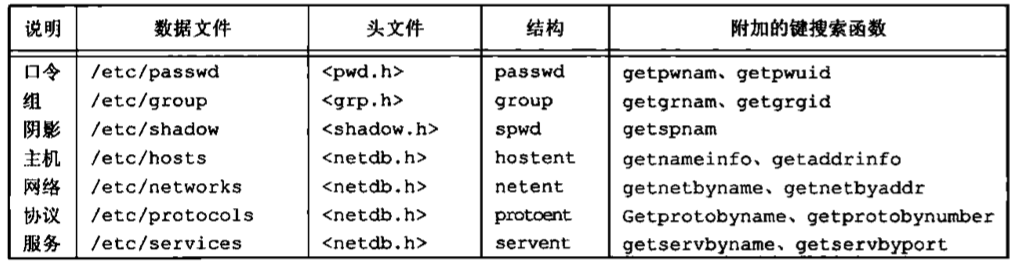

用户标识 用户ID 口令文件登录项中的用户ID(userID)是一个数值,它向系统标识各个不同的用户。系统管理员在确定一个用户的登录名的同时,确定其用户ID。用户不能更改其用户ID。

用户ID为O的用户为根用户(root)或超级用户(superuser)。在口令文件中,通常有一个登录项,其登录名为root。我们称这种用户的特权为超级用户特权。如果一个进程具有超级用户特权,则大多数文件权限检查都不再进行。某些操作系统功能只向超级用户提供。

口令文件登录项也包括用户的组D(group ID),它是一个数值。组ID也是由系统管理员在指定用户登录名时分配的。组被用于将若干用户集合到项目或部门中去。这种机制允许同组的各个成员之间共享资源。组文件将组名映射为数值的组ID。组文件通常是/etc/group。

1 2 3 4 5 #include "apue.h" int main (void ) printe ("uid = %d, gid = %d\n" , getuid (), getgid ()); exit (0 ); }

附属组ID 除了在口令文件中对一个登录名指定一个组ID外,大多数UNIX系统版本还允许一个用户属于另外一些组。这一功能是从4.2BSD开始的,它允许一个用户属于多至16个其他的组。登录时,读文件/etc/group。寻找列有该用户作为其成员的前16个记录项就可以得到该用户的附属组ID(supplementary group ID)。

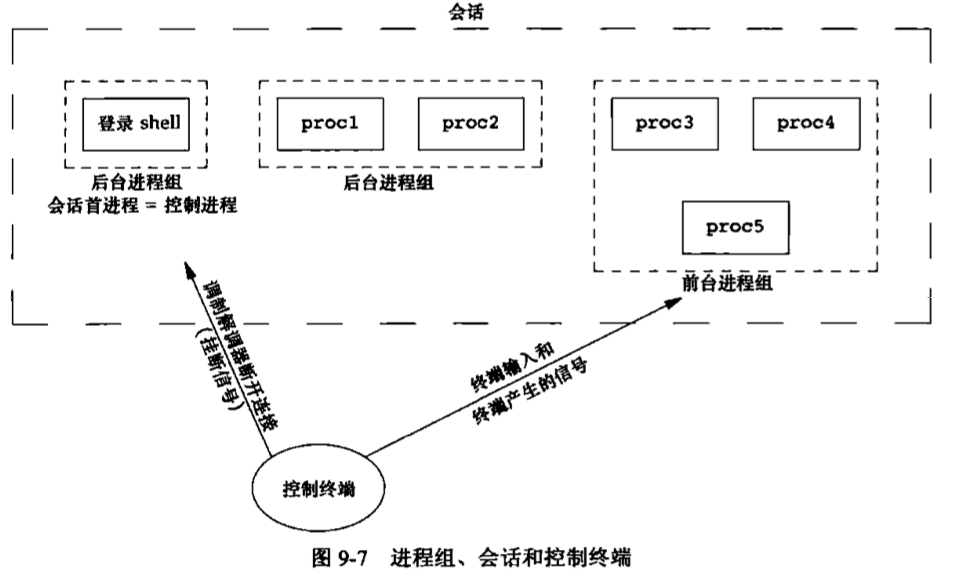

信号 信号(signa)用于通知进程发生了某种情况。进程有以下3种处理信号的方式。

忽略信号。有些信号表示硬件异常,例如,除以0或访问进程地址空间以外的存储单元等,因为这些异常产生的后果不确定,所以不推荐使用这种处理方式。

按系统默认方式处理。对于除数为0。系统默认方式是终止该进程。

提供一个函数,信号发生时调用该函数,这被称为捕捉该信号。通过提供自编的函数,我们就能知道什么时候产生了信号,并按期望的方式处理它。

很多情况都会产生信号,终端键盘上有两种产生信号的方法,分别称为中断键 (通常是Delete键成Ctrl+C)和退出键 (通常是Ctrl+\),它们被用于中断当前运行的进程。

另一种产生信号的方法是调用kill函数。在一个进程中调用此函数就可向另一个进程发送一个信号。当然这样做也有些限制:当向一个进程发送信号时,我们必须是那个进程的所有者或者是超级用户。

为了能捕捉到信号,程序需要调用signal函数,其中指定了当产生SIGINT信号时要调用的函数的名字。函数名为sig_int,当其被调用时,只是打印一条消息,然后打印一个新提示符。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 #include "apue.h" #include <ays/wait.h> statie void sig_int (int ) ; int main (void ) char buf[MAXLINE]; pid_t pid; int status; if (signal (SIGINT, sig_int) == SIG_ERR) err_sys ("signal error" ); printf ("%% " ); while (fgets (buf, MAXLINE, stdin) != NULL ) { if (buf[strlen (buf) - 1 ] == '\n' ) buf[strlen (buf) - 1 ] = 0 ; if ((pid = fork()) < 0 ) { err_sys ("fork error" ); } else if (pid == 0 ) { execlp (buf, buf, (char *)0 ); err_ret ("couldn't execute: %s" , buf); exit (127 ); } if ((pid = waitpid (pid, &status, 0 )) < 0 ) err_sys ("waitpid error" ); printf ("%% " ); } exit (0 ); } void sig_int (int signo) printf ("interrupt\n %%" ); }

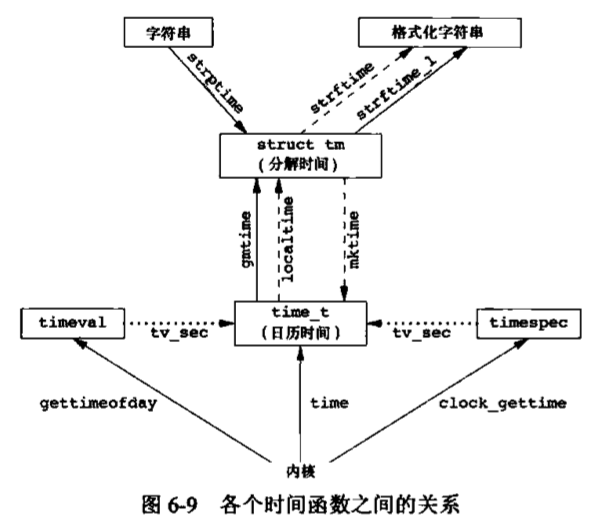

时间值 历史上,UNIX系统使用过两种不同的时间值。

日历时间。该值是自协调世界时(Coordinated Universal Time, UTC) 1970年1月1日00:00:00这个特定时间以来所经过的秒数累计值。这time_t用于保存这种时间值。

进程时间。也被称为CPU时间,用以度量进程使用的中央处理器资源。进程时间以时钟滴答计算。每秒钟曾经取为50、60或100个时钟滴答。系统基本数据类型clock_t保存这种时间值。

当度量一个进程的执行时间时,UNIX系统为一个进程维护了3个进程时间值:

时钟时间:时钟时间又称为墙上时钟时间,它是进程运行的时间总量,其值与系统中同时运行的进程数有关。

用户CPU时间:用户CPU时间是执行用户指令所用的时间量。

系统CPU时间:系统CPU时间是为该进程执行内核程序所经历的时间。

例如,每当一个进程执行一个系统服务时,如read或write,在内核内执行该服务所花费的时间就计入该进程的系统CPU时间,用户CPU时间和系统CPU时间之和常被称为CPU时间,要取得任一进程的时钟时间、用户时间和系统时间是很容易的一只要执行命令time(1),其参数是要度量其执行时间的命令,例如:1 2 3 4 5 $ ed /usr/include $ time -p grep _POSIX_SOURCE */*.h > /dev/null real 0m0.81s user 0m0.11s sys 0m0.07s

系统调用和库函数 所有的操作系统都提供多种服务的入口点。这些入口点被称为系统调用。Linux3.2.0提供了380个系统调用,FreeBSD8.0提供的系统调用超过450个。

UNIX所使用的技术是为每个系统调用在标准C库中设置一个具有同样名字的函数。用户进程用标准C调用序列来调用这些函数,然后,函数又用系统所要求的技术调用相应的内核服务。

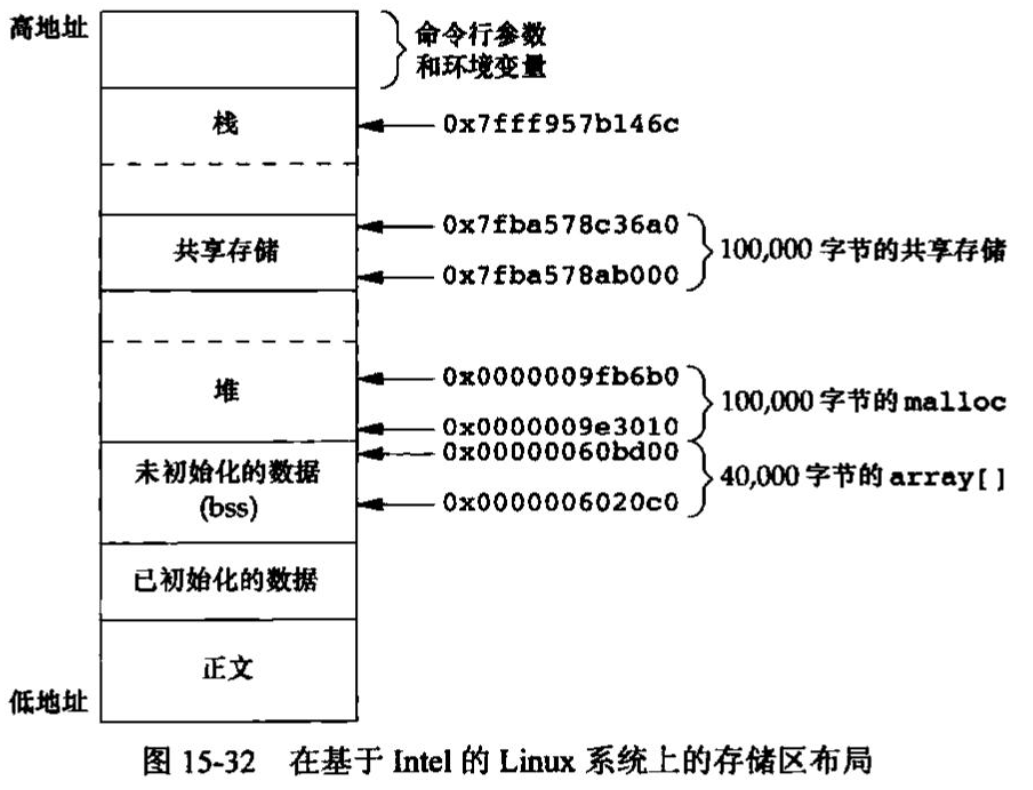

以存储空间分配函数malloc为例。UNIX系统调用中处理存储空间分配的是sbrk(2),它不是一个通用的存储器管理器。它按指定字节数增加或减少进程地址空间。如何管理该地址空间却取决于进程。存储空间分配函数malloc(3)实现一种特定类型的分配,如果我们不喜欢其操作方式,则可以定义自己的malloc函数,它很可能将使用sbrk系统调用。两者职责不同,内核中的系统调用分配一块空间给进程,而库函数malloc则在用户层次管理这一空间。

系统调用和库函数之间的另一个差别是:系统调用通常提供一种最小接口,而库函数通常提供比较复杂的功能。我们从sbrk系统调用和malloc库函数之间的差别中可以看到这一点。进程控制系统调用(tork、exec和wait)通常由用户应用程序直接调用。但是为了简化某些常见的情况, UNIX系统也提供了一些库函数,如system和popen。

文件I/O 引言 UNIX系统中的大多数文件I/O只需用到5个函数:open、read、write、lseek、close。本章描述的函数经常被称为不带缓冲的I/O (unbuffered I/O。术语不带缓冲指的是每个read和write都调用内核中的一个系统调用。

文件描述符 对于内核而言。所有打开的文件都通过文件描述符引用。文件描述符是一个非负整数。当打开一个现有文件或创建一个新文件时,内核向进程返回一个文件描述符。当读、写一个文件时,使用open或creat返回的文件描述符标识该文件,将其作为参数传送给read或write。

按照惯例,UNIX系统shell把文件描述符0与进程的标准输入关联,文件描述符1与标准输出关联,文件描述符2与标准错误关联。这是各种shell以及很多应用程序使用的惯例,与UNIX内核无关。应当把它们替换成符号常量STDIN_FILENO、STDOUT_FILENO和STDERR_FILENO以提高可读性。这些常量都在头文件<unistd.h>中定义,文件描述符的变化范围是0~OPEN_MAX-1。

函数open和openat 调用open或openat函数可以打开或创建一个文件。1 2 3 #include <fcntl.h> int open (const char *path, int oflag, .... ) int openat (int fd, const char *path, int oflag, ...)

两函数的返回值:若成功,返回文件描述符;若出错,返回-1。

我们将最后一个参数写为...。ISO C用这种方法表明余下的参数的数量及其类型是可变的。对于open函数而言,仅当创建新文件时才使用最后这个参数。在函数原型中将此参数放置在注释中。

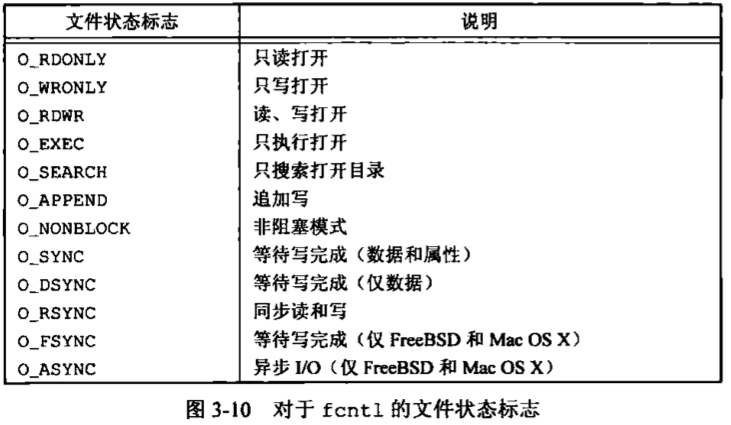

path参数是要打开或创建文件的名字。oflag参数可用来说明此函数的多个选项。用下列一个或多个常量进行“或”运算构成oflag参数(这些常量在头文件<fcntl.h>中定义)。

O_RDONLY:只读打开。O_WRONLY:只写打开。O_RDWR:读、写打开。O_EXEC:只执行打开。O_SEARCH:只搜索打开(应用于目录)。

大多数实现将O_RDONLY定义为0,O_WRONLY定义为1,O_RDWR定义为2。O_SEARCH常量的目的在于在目录打开时验证它的搜索权限。对目录的文件描述符的后续操作就不需要再次检查对该目录的搜索权限。

在这5个常量中必须指定一个且只能指定一个。下列常量则是可选的。

O_APPEND:每次写时都追加到文件的尾端。O_CLOEXEC:把FD_CIOEXEC常量设置为文件描述符标志。O_CREAT:若此文件不存在则创建它。使用此选项时,open函数需同时说明第3个参数mode,用mode指定该新文件的访问权限位O_DIRECTORY:如果path引用的不是目录,则出错。O_EXCL:如果同时指定了O_CREAT,而文件已经存在,则出错。用此可以测试一个文件是否存在,如果不存在,则创建此文件,这使测试和创建两者成为一个原子操作。O_NOCTTY:如果path引用的是终端设备,则不将该设备分配作为此进程的控制终端。O_NOFOLLOW:如果path引用的是一个符号链接,则出错。O_NONBLOCK:如果path引用的是一个FIFO、一个块特殊文件或一个字符特殊文件,则此选项为文件的本次打开操作和后续的I/O操作设置非阻塞方式。O_SYNC:使每次write等待物理I/O操作完成,包括由该write操作引起的文件属性更新所需的I/OO_TRUNC:如果此文件存在,而且为只写或读-写成功打开,则将其长度截断为00_TTY_INIT:如果打开一个还未打开的终端设备,设置非标准termios参数值,使其符合Single UNIX Specification。

下面两个标志也是可选的。

O_DSYNC:使每次write要等待物理I/O操作完成,但是如果该写操作并不影响读取刚写入的数据,则不需等待文件属性被更新,

O_DSYNC和O_SYNC标志有微妙的区别。仅当文件属性需要更断以反映文件数据变化时,O_DSYNC标志才影响文件属性。而设置O_SYNC标志后,教据和属性总是同步更新。当文件用O_DSYN标志打开,在重写其现有的部分内容时,文件时间属性不会同步更新,与此相反,如果文件是用O_SYNC标志打开,那么对该文件的每一次write都将在write返回前更新文件时间,这与是否改写现有字节或追加写文件无关。

O_RSYNC:使每一个以文件描述符作为参数进行的read操作等待,直至所有对文件同一部分挂起的写操作都完成

由open和openat函数返回的文件描述符一定是最小的未用描述符数值。这一点被某些应用程序用来在标准输入、标准输出或标准错误上打开新的文件。例如,一个应用程序可以先关闭标准输出(通常是文件描述符1),然后打开另一个文件,执行打开操作前就能了解到该文件一定会在文件描述符1上打开。

fd参数把open和openat函数区分开,共有3种可能性。

path参数指定的是绝对路径名,在这种情况下,后参数被忽略,openat函数就相当于open函数。

path参数指定的是相对路径名,后参数指出了相对路径名在文件系统中的开始地址。fd参数是通过打开相对路径名所在的目录来获取。

path参数指定了相对路径名,fd参数具有特殊值AT_FDCWD。在这种情况下,路径名在当前工作目录中获取,openat函数在操作上与open函数类似。

openat希望解决两个问题。

让线程可以使用相对路径名打开目录中的文件,而不再只能打开当前工作目录。

可以避免time of-check-to-time-of-use(TOCTTOU)错误。

TOCTTOU错误的基本思想是:如果有两个基于文件的函数调用,其中第二个调用依赖于第一个调用的结果,那么程序是脆弱的。因为两个调用并不是原子操作,在两个函数调用之间文件可能改变了,这样也就造成了第一个调用的结果就不再有效,使得程序最终的结果是错误的。文件系统命名空间中的TOCTTOU错误通常处理的就是那些颠覆文件系统权限的小把戏,这些小把戏通过骗取特权程序降低特权文件的权限控制或者让特权文件打开一个安全漏洞等方式进行。

文件名和路径名截断 在POSIX.1中,常量_POSIX_NO_TRUNC决定是要截断过长的文件名或路径名,还是返回一个出错。用fpathconf或pathconf来查询目录具体支持何种行为,到底是截断过长的文件名还是返回出错。若_POSIX_NO_TRUNC有效,则在整个路径名超过PATH_MAX,或路径名中的任一文件名超过NAME_MAX时,出错返回,并将errno设置为ENAMETOOLONG。

函数creat 也可调用creat函数创建一个新文件,1 2 #include <fcntl.h> int creat (const char path, mode_t mode)

返回值:若成功,返回为只写打开的文件描述符;若出错,返回-1。1 open (ptsh, O_WRONLY | O_CREAT | O_TRUNC, mode);

creat的一个不足之处是它以只写方式打开所创建的文件。在提供open的新版本之前,如果要创建一个临时文件,并要先写该文件,然后又读该文件,则必须先调用creat、close,然后再调用open。现在则可用下列方式调用open实现:1 open (path, O_RDWR | O_CREAT | O_TRUNC, mode);

63

函数close 可调用close函数关闭一个打开文件。1 2 #include <unistd.h> int close (int fd)

关闭一个文件时还会释放该进程加在该文件上的所有记录锁。当一个进程终止时,内核自动关闭它所有的打开文件。很多程序都利用了这一功能而不显式地用close关闭打开文件。

函数lseek 每个打开文件都有一个与其相关联的“当前文件偏移量”(current file offset)。它通常是一个非负整数,用以度量从文件开始处计算的字节数。通常,读、写操作都从当前文件偏移量处开始,并使偏移量增加所读写的字节数。按系统默认的情况,当打开一个文件时,除非指定O_APPEND选项,否则该偏移量被设置为0。可以调用lseek显式地为一个打开文件设置偏移量。1 2 #include <unistd.h> off_t lseek (int fd, off_t offuet, int whence)

对参数offset的解释与参数whence的值有关

若whence是SEEK_SET,则将该文件的偏移量设置为距文件开始处offset个字节。

若whence是SEEK CUR,则将该文件的偏移量设置为其当前值加offset,offset可为正或负。

若whence是SEEK_END,则将该文件的偏移量设置为文件长度加offset,offset可正可负。

若lseek成功执行,则返回新的文件偏移量,为此可以用下列方式确定打开文件的当前偏移量:1 2 off_t currpos;currpos = lseek(fd, 0 , SEEK_CUR);

这种方法也可用来确定所涉及的文件是否可以设置偏移量。如果文件描述符指向的是一个管道、FIFO或网络套接字,则lseek返回-1,并将errno设置为ESPIPE。

3个符号常量SEEK_SET、SEBK_CUR和SEEK_END是在System V中引入的。在System V之前,whence被指定为0(绝对偏移量)、1(相对于当前位置的偏移量)或2(相对文件尾端的偏移量)。

在lseek中的字符l表示长整型。在引入off_t教据类型之前,offset参数和返回值是长整型的。

所示的程序用于测试对其标准输入能否设置偏移量。1 2 3 4 5 6 7 8 9 #include "apue.h" int main (void ) if (lseek (STDIN_FILENO, 0 , SEEK_CUR) == -1 ) printf ("cannot seek\n" ); else printf ("seek OK\n" ); exit (0 ); }

通常,文件的当前偏移量应当是一个非负整数,但是,某些设备也可能允许负的偏移量。但对于普通文件,其偏移量必须是非负值。因为偏移量可能是负值,所以在比较lseek的返回值时应当谨慎,不要测试它是否小于0,而要测试它是否等于-1。

文件偏移量可以大于文件的当前长度,在这种情况下,对该文件的下一次写将加长该文件,并在文件中构成一个空洞,这一点是允许的。位于文件中但没有写过的字节都被读为0。文件中的空洞并不要求在磁盘上占用存储区。具体处理方式与文件系统的实现有关,当定位到超出文件尾端之后写时,对于新写的数据需要分配磁盘块,但是对于原文件尾端和新开始写位置之间的部分则不需要分配磁盘块。

所示的程序用于创建一个具有空洞的文件。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 #include "apue.h" #include <fcntl.h> char buf1[] = "abcdefghij" ;char buf2[] = "ABCDEFGHIJ" ;int main (void ) int fd; if ((fd = creat ("File.hole" , FILE_MODE)) < 0 ) err_sys ("creat error" ); if (write (fd, buf1, 10 ) != 10 ) err_sys ("buti write error" ); if (lseek (fd, 16384 , SEEK_SET) == -1 ) err_sys ("lseek exroz" ); if (write (fd, buf2, 10 ) != 10 ) exr_sys ("buf2 write excor" ), exit (0 ); }

运行该程序得到:1 2 3 4 5 6 7 8 9 $ ./a.out $ ls -l file.hoel -rw-r--r-- 1 sar 16394 Nov 25 01:01 file.hole $ od -c file.hole 0000000 a b c d e f g h i j \0 \0 \0 \0 \0 \0 0000020 \0 \0 \0 \0 \0 \0 \0 \0 \0 \0 \0 \0 \0 \0 \0 \0 * 0040000 A B C D E F G H I J 0040012

使用od(1)命令观察该文件的实际内容。命令行中的-c标志表示以字符方式打印文件内容。从中可以看到,文件中间的30个未写入字节都被读成0。每一行开始的一个7位数是以八进制形式表示的字节偏移量。

因为lseek使用的偏移量是用off_t类型表示的,所以允许具体实现根据各自特定的平台自行选择大小合适的数据类型。现今大多数平台提供两组接口以处理文件偏移量。一组使用32位文件偏移量,另一组则使用64位文件偏移量。

Single UNIX Specification向应用程序提供了一种方法,使其通过sysconf函数确定支持何种环境。图总结了定义的sysconf常量。

选项名称

说明

mame参数

_POSIX_V7_ILP32_OFF32

int、long、指针和ott_t类型是32位

_SC_V7_ILP32_OFF32

_POSIX_V7_ILP32_OFFBIG

int、long、指针类型是32位。off_t类型至少是64位

_SC_V7_ILP32_OFFBIG

_POSIX_V7_LP64_OFF64

int类型是32位,long、指针和off_t是64位

_SC_V7_LP64_OFF64

_POSIX_V7_LP64_OFFBIG

int类型是32位,long、指针和off_t类型至少是64位

_SC_V7_LP64_OFFBIG

C99编译器要求使用getconf(1)命令将所期望的数据大小模型映射为编译和链接程序所需的标志。根据每个平台支持环境的不同,可能需要不同的标志和库。

函数read 调用read函数从打开文件中读数据,1 2 #include <unistd.h> ssize_t read (int fd, vold *buf, size_t nbytes)

如read成功,则返回读到的字节数。如已到达文件的尾端,则返回0。有多种情况可使实际读到的字节数少于要求读的字节数:

读普通文件时,在读到要求字节数之前已到达了文件尾端。例如,若在到达文件尾端之前有30个字节,而要求读100个字节,则read返回30。下一次再调用read时,它将返回0(文件尾端)。

当从终端设备读时,通常一次最多读一行

当从网络读时,网络中的缓冲机制可能造成返回值小于所要求读的字节数。

当从管道或FIFO读时,如着管道包含的字节少于所需的数量,那么read将只返回实际可用的字节数。

当从某些面向记录的设备读时,一次最多返回一个记录。

当一信号造成中断,而已经读了部分数据量时。

读操作从文件的当前偏移量处开始,在成功返回之前,该偏移量将增加实际读到的字节数。POSIX.1从几个方面对read函数的原型做了更改。经典的原型定义是:1 int read (int fd, char *buf, unsigned nbytes)

首先,为了与ISO C一致,第2个参数由char*改为void*。在ISO C中,类型void*用于表示通用指针。

其次,返回值必须是一个带符号整型(ssize_t),以保证能够返回正整数字节数、0(表示文件尾端)或-1(出错)。

最后,第3个参数在历史上是一个无符号整型,这允许一个16位的实现一次读或写的数据可以多达65534个字节。

函数write 调用write函数向打开文件写数据1 2 #include <unistd.h> ssize_t write (int fd, const void *buf, size_t nbytes)

其返回值通常与参数nbytes的值相同,否则表示出错。write出错的一个常见原因是磁盘已写满,或者超过了一个给定进程的文件长度限制。

对于普通文件,写操作从文件的当前偏移量处开始。如果在打开该文件时,指定了O_APPEND选项,则在每次写操作之前,将文件偏移量设置在文件的当前结尾处。在一次成功写之后,该文件偏移量增加实际写的字节数。

I/O的效率 图3-5程序只使用read和write函数复制一个文件。1 2 3 4 5 6 7 8 9 10 11 12 13 14 #include "apue.h" #define BUFFSIZE 4096 int main (void ) int n; char buf[BUFFSIZE]; while ((n = read (STDIN_FILENO, buf, BUFFSIZE)) > 0 ) if (write (STDOUT_FILENO, buf, n) != n) err_sys ("write error" ); if (n < 0 ) err_ays ("read error" ); exif (0 ); }

关于该程序应注意以下几点。

它从标准输入读,写至标准输出,这就假定在执行本程序之前,这些标准输入、输出已由shell安排好。

考虑到进程终止时,UNIX系统内核会关闭进程的所有打开的文件描述符,所以此程序并不关闭输入和输出文件。

对UNIX系统内核而言,文本文件和二进制代码文件并无区别,所以本程序对这两种文件都有效。

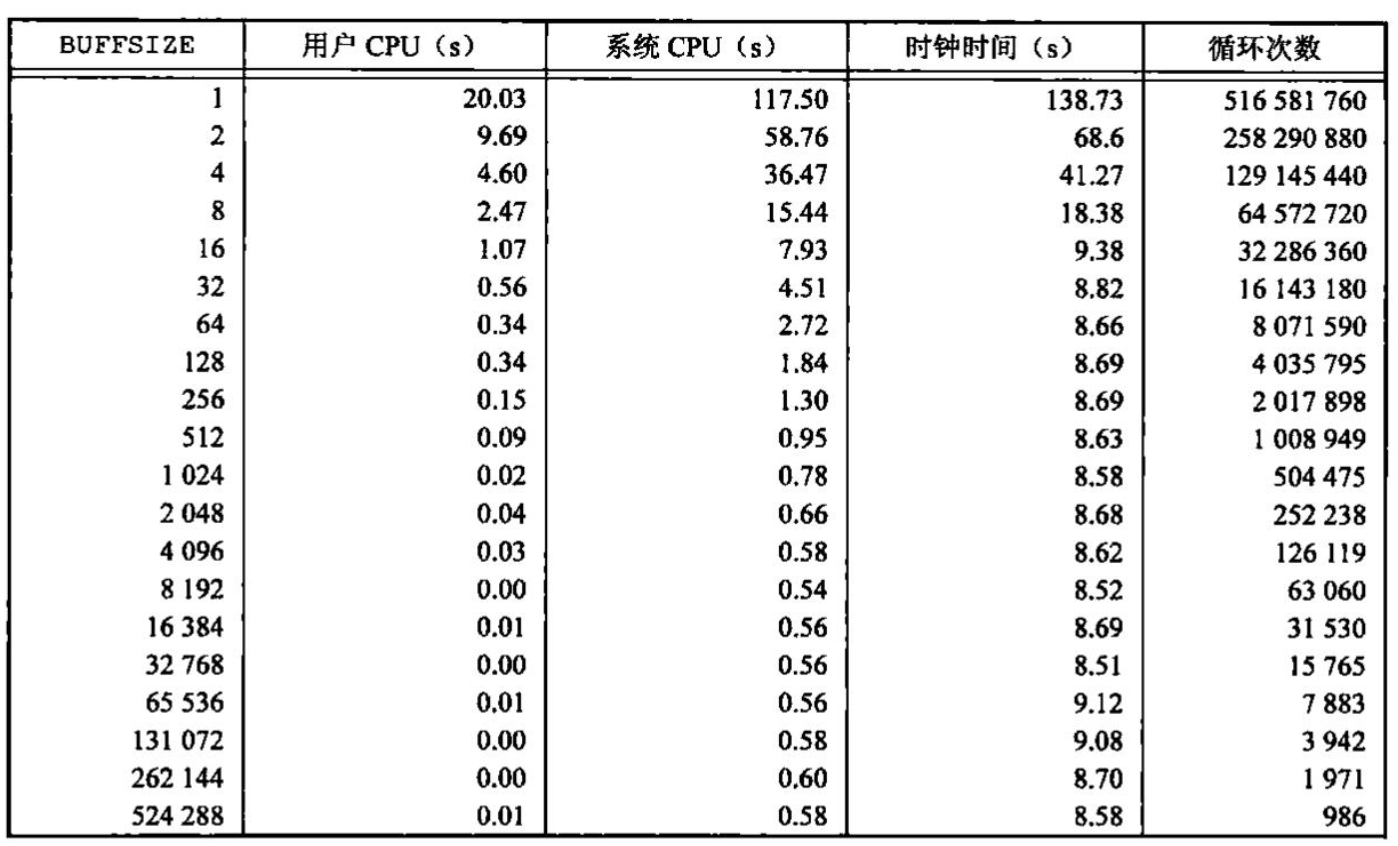

让我们先用各种不同的BUFFSIZE值来运行此程序。图显示了用20种不同的缓冲区长度,读516581760字节的文件所得到的结果。

读文件的标准输出被重新定向到/dev/null上。此测试所用的文件系统是Linux ext4文件系统,其磁盘块长度为4096字节。这也证明了系统CPU时间的几个最小值差不多出现在BUFFSIZE为4096及以后的位置,继续增加缓冲区长度对此时间几乎没有影响。

大多数文件系统为改善性能都采用某种预读(read ahcad)技术。当检测到正进行顺序读取时,系统就试图读入比应用所要求的更多数据。并假想应用很快就会读这些数据。预读的效果可以从图中看出,缓冲区长度小至32字节时的时钟时间与拥有较大缓冲区长度时的时钟时间几乎一样。

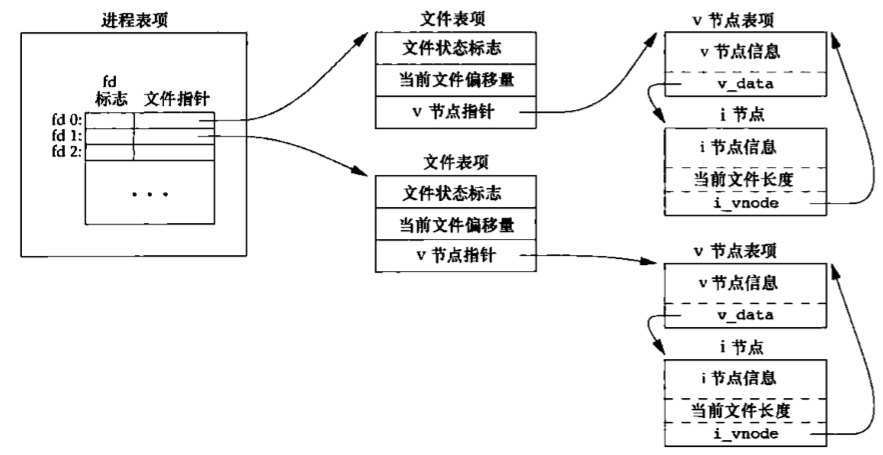

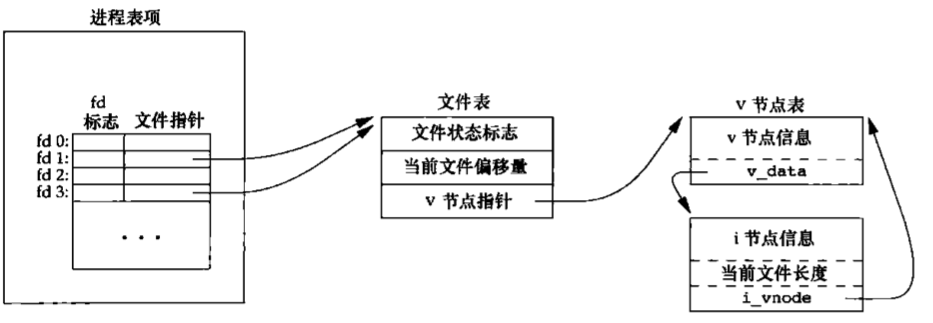

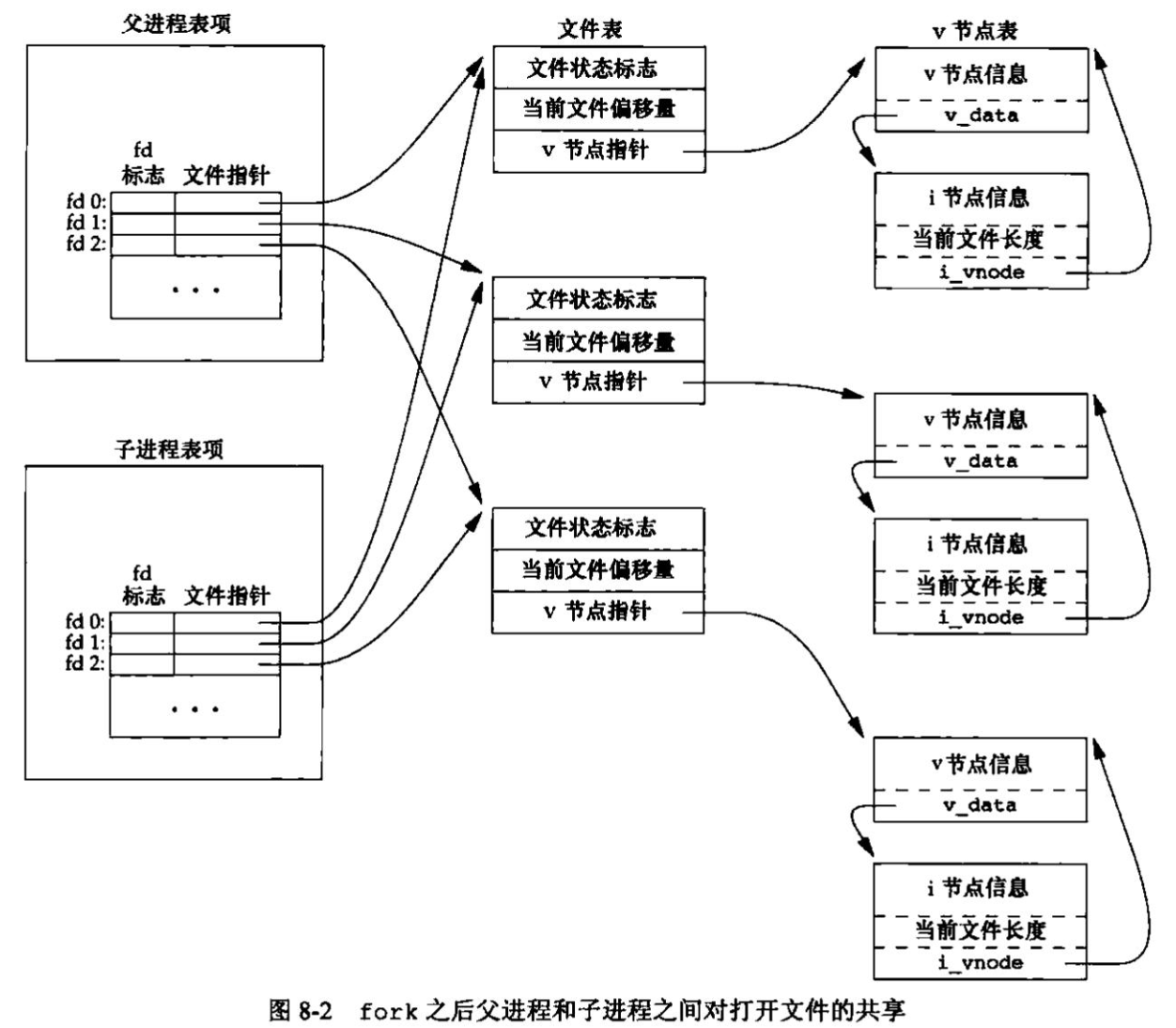

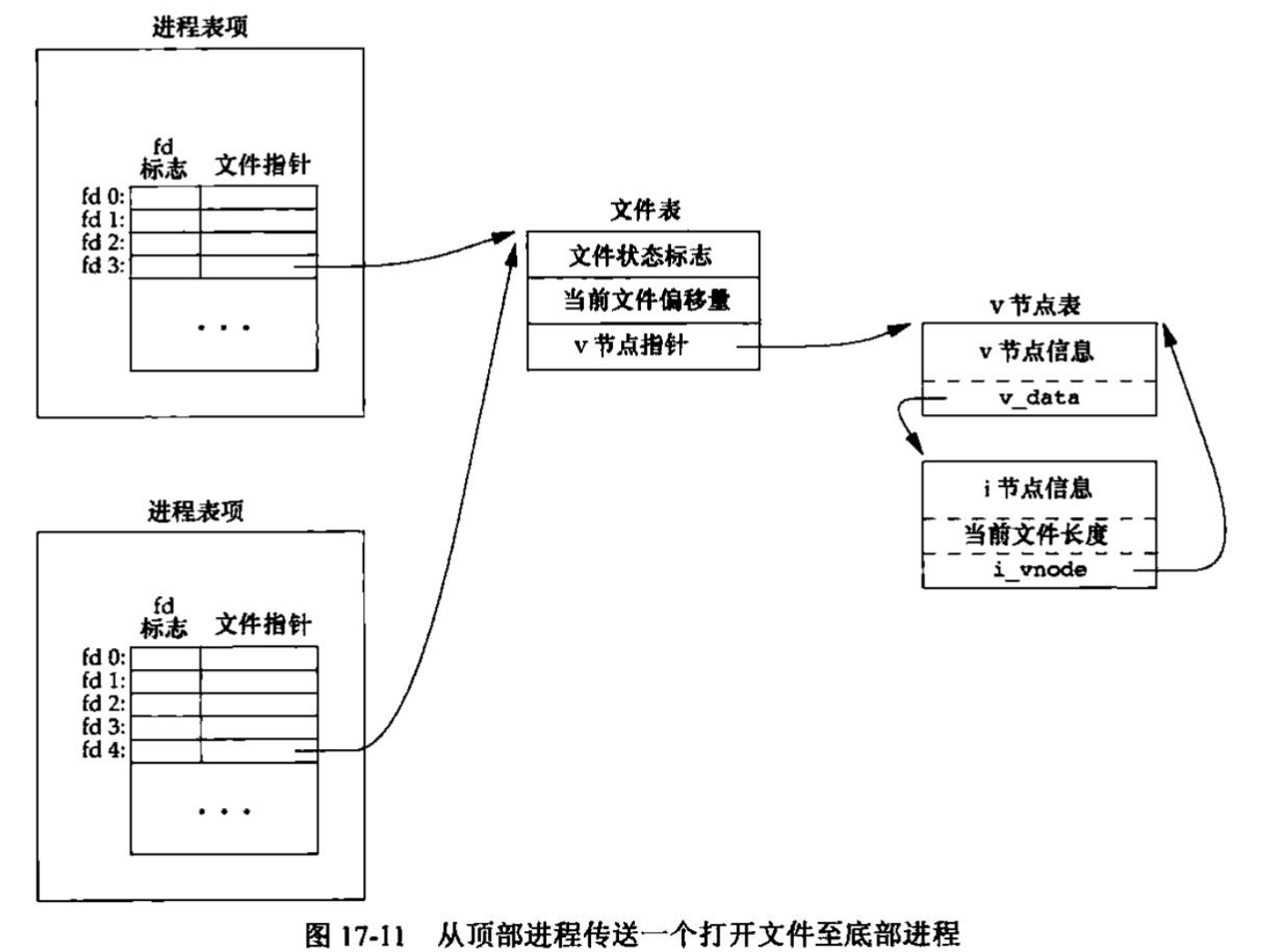

文件共享 内核使用3种数据结构表示打开文件,它们之间的关系决定了在文件共享方面一个进程对另一个进程可能产生的影响。

每个进程在进程表中都有一个记录项,记录项中包含一张打开文件描述符表,可将其视为一个矢量,每个描述符占用一项。与每个文件描述符相关联的是:

文件描述符标志(close_on_exec)

指向一个文件表项的指针

内核为所有打开文件维持一张文件表。每个文件表项包含:

文件状态标志(读、写、添写、同步和非阻塞等)

当前文件偏移量

指向该文件v节点表项的指针

每个打开文件(或设备)都有一个v节点(v-node)结构。v节点包含了文件类型和对此文件进行各种操作函数的指针。对于大多数文件,v节点还包含了该文件的i节点(i-node,索引节点)。这些信息是在打开文件时从磁盘上读入内存的。

图显示了一个进程对应的3张表之间的关系。该进程有两个不同的打开文件,一个文件从标准输入打开(文件描述符0),另一个从标准输出打开(文件描述符为1)。

创建v节点结构的目的是对在一个计算机系统上的多文体系统类型提供支持。Sun把这种文件系统称为虚拟文件系统(Virtual File System),把与文件系统无关的i节点部分称为V节点。

Linux没有将相关数据结构分为i节点和v节点,而是采用了一个与文件系统相关的i节点和一个与文件系统无关的i节点。

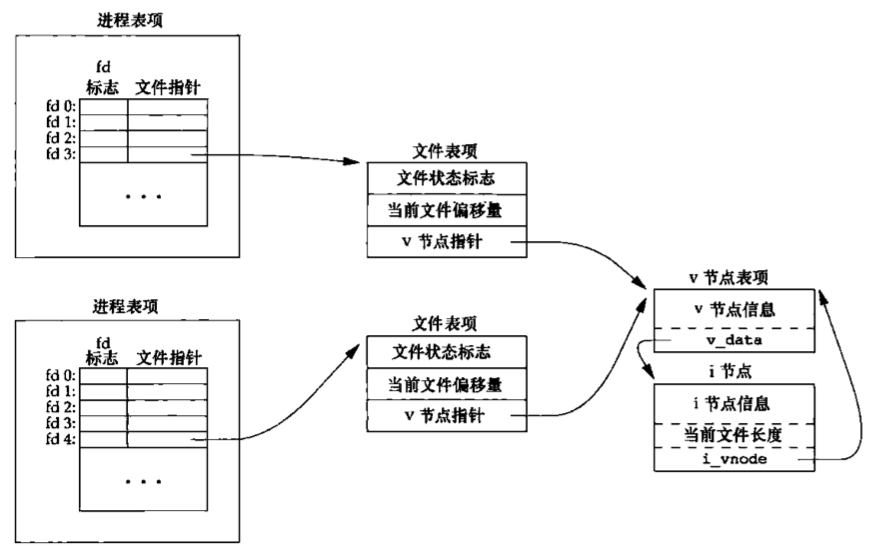

如果两个独立进程各自打开了同一文件,则有图中所示的关系。

我们假定第一个进程在文件描述符3上打开该文件,而另一个进程在文件描述符4上打开该文件。打开该文件的每个进程都获得各自的一个文件表项,但对一个给定的文件只有一个v节点表项。之所以每个进程都获得自己的文件表项,是因为这可以使每个进程都有它自己的对该文件的当前偏移量。

在完成每个write后,在文件表项中的当前文件偏移量即增加所写入的字节数。如果这导致当前文件偏移量超出了当前文件长度,则将i节点表项中的当前文件长度设置为当前文件偏移量。

如果用O_APPEND标志打开一个文件,则相应标志也被设置到文件表项的文件状态标志中。每次对这种具有追加写标志的文件执行写操作时,文件表项中的当前文件偏移量首先会被设置为i节点表项中的文件长度。这就使得每次写入的数据都追加到文件的当前尾端处。

若一个文件用lseek定位到文件当前的尾端,则文件表项中的当前文件偏移量被设置为i节点表项中的当前文件长度。

lseek函数只修改文件表项中的当前文件偏移量,不进行任何I/O操作。

可能有多个文件描述符项指向同一文件表项。在fork后也发生同样的情况,此时父进程、子进程各自的每一个打开文件描述符共享同一个文件表项。

注意,文件描述符标志和文件状态标志在作用范围方面的区别,前者只用于一个进程的一个描述符,而后者则应用于指向该给定文件表项的任何进程中的所有描述符。

原子操作 追加到一个文件 考虑一个进程,它要将数据追加到一个文件尾端。早期的UNIX系统版本并不支持open的O_APPEND选项,所以程序被编写成下列形式:1 2 3 4 if (lseek (fd, OL, 2 ) < 0 ) err_sys ("lseek error" ); if (write (fd, buf, 100 ) != 100 ) err_sys ("write error" );

对单个进程而言,这段程序能正常工作,但若有多个进程同时使用这种方法将数据追加写到同一文件,则会产生问题。

假定有两个独立的进程A和B都对同一文件进行追加写操作。每个进程都已打开了该文件,但未使用O_APPEND标志,此时,每个进程都有它自己的文件表项,但是共享一个v节点表项。假定进程A调用了lseek,它修改了当前偏移量,然后内核切换进程,进程B执行lseek也修改了当前偏移量设置为1500字节。这样造成了两个进程写入数据的重叠。

解决方法是使这lseek和write两个操作对于其他进程而言成为一个原子操作。UNIX系统为这样的操作提供了一种原子操作方法,即在打开文件时设置O_APPEND标志,这样做使得内核在每次写操作之前,都将进程的当前偏移量设置到该文件的尾漏处,于是在每次写之前就不再需要调用lseek。

函数pread和pwrite Single UNIX Specification包括了XSI扩展,该扩展允许原子性地定位并执行I/O。pread和pwrite就是这种扩展。1 2 3 4 5 6 #include <uniatd.h> ssize_t pread (int fd, void *buf, size_t nbytes, off_t offset) ssize_t pwrite (int fd, const void *buf, size_t nbytes, off_t offset)

调用pread相当于调用lseek后调用read,但是pread又与这种顺序调用有下列重要区别。

调用pread时,无法中断其定位和读操作。

不更新当前文件偏移量。

调用pwrite相当于调用lseek后调用write,但也与它们有类似的区别。

创建一个文件 对open函数的O_CREAT和O_EXCL选项,当同时指定这两个选项,而该文件又已经存在时,open将失败。我们曾提及检查文件是否存在和创建文件这两个操作是作为一个原子操作执行的。如果没有这样一个原子操作,那么可能会编写下列程序段:1 2 3 4 5 6 7 8 if ((fd = open (pathname, O_WRONLY)) < O) { if (errno = ENOENT) { if ((fd = creat (path, mode)) < 0 ) err_sys ("creat ecror" ); } else { err_sys ("open error" ); } }

如果在open和creat之间,另一个进程创建了该文件,就会出现问题。若在这两个函数调用之间,另一个进程创建了该文件,并且写入了一些数据。然后,原先进程执行这段程序中的creat,这时,刚由另一进程写入的数据就会被擦去。

一般而言,原子操作(atomic operation)指的是由多步组成的一个操作。如果该操作原子地执行,则要么执行完所有步骤,要么一步也不执行,不可能只执行所有步骤的一个子集。

函数dup和dup2 下面两个函数都可用来复制一个现有的文件描述符。1 2 3 4 5 #include <unistd.h> int dup (int fd) int dup2 (int fd, int fd2)

由dup返回的新文件描述符一定是当前可用文件描述符中的最小数值。对于dup2,可以用fd2参数指定新描述符的值。如果fd2已经打开,则先将其关闭。如若fd等于fd2,则dup2返回fd2,而不关闭它。否则,fd2的FD_CLOEXEC文件描述符标志就被清除,这样fd2在进程调用exec时是打开状态。

这些函数返回的新文件描述符与参数fd共享同一个文件表项,如图所示。

在此图中,我们假定进程启动时执行了:

当此函数开始执行时,假定下一个可用的描述符是3(这是非常可能的,因为0, 1和2都由shell打开)。因为两个描述符指向同一文件表项,所以它们共享同一文件状态标志(读、写、追加等)以及同一当前文件偏移量。

复制一个描述符的另一种方法是使用fcntl函数。实际上,调用dup(fd);等效于fcntl(fd, F_DUPFD, 0);,而调用dup2(fd, fd2);等效于close(fd2); fcntl(fd, E_DUPFD, fd2);。在后一种情况下,dup2并不完全等同于close加上fcnt1。它们之间的区别具体如下。

dup2是一个原子操作,而close和fcnt1包括两个函数调用。有可能在close和fcnt1之间调用了信号捕获函数,它可能修改文件描述符。如果不同的线程改变了文件描述符的话也会出现相同的问题。dup2和fcntl有一些不同的errno。

函数sync、fsync和fdatasync 传统的UNIX系统实现在内核中设有缓冲区高速缓存或页高速缓存,大多数磁盘I/O都通过缓冲区进行。当我们向文件写入数据时,内核通常先将数据复制到缓冲区中,然后排入队列,晚些时候再写入磁盘。这种方式被称为延迟写(delayed write)。

通常,当内核需要重用缓冲区来存放其他磁盘块数据时,它会把所有延迟写数据块写入磁盘。为了保证磁盘上实际文件系统与缓冲区中内容的一致性,UNIX系统提供了sync、fsync和fdatasync三个函数。1 2 3 4 5 6 #include <unistd.h> int fsync (int fd) int fdatasync (int fd) void sync (void )

sync只是将所有修改过的块缓冲区排入写队列,然后就返回,它并不等待实际写磁盘操作结束,通常,称为update的系统守护进程周期性地调用(一般每隔30秒)sync函数。这就保证了定期冲洗(flush)内核的块缓冲区。命令sync(1)也调用sync函数。

fsync函数只对由文件描述符fd指定的一个文件起作用,并且等待写磁盘操作结束才返回。fsync可用于数据库这样的应用程序,这种应用程序需要确保修改过的块立即写到磁盘上。

fdatasync函数类似于fsync,但它只影响文件的数据部分。而除数据外,fsync还会同步更新文件的属性。

函数fcntl fcntl函数可以改变已经打开文件的属性,1 2 3 #include <fcnti.h> int fcntl (int fd, int cmd, )

第3个参数总是一个整数,与上面所示函数原型中的注释部分对应。fcntl函数有以下5种功能

复制一个已有的描述符(cmd=F_DUPFD或F_DUPFD_CLOEXEC).

获取/设置文件描述符标志(cmd=F_GETFD或F_SETFD).

获取/设置文件状态标志(cmd=F_GETFL或F_SETFL).

获取/设置异步I/O所有权(cmd=F_GETOWN或F_SETOWN)。

获取/设置记录锁(cmd=F_GETLK、F_SETLK或F_SETLKW).

F_DUPFD:复制文件描述符fd。新文件描述符作为函数值返回。它是尚未打开的各描述符中大于或等于第3个参数值(取为整型值)中各值的最小值。新描述符与后共享同一文件表项。但是,新描述符有它自己的一套文件描述符标志,其FD_CLOEXEC文件描述符标志被清除F_DUPFD_CLOEXEC:复制文件描述符,设置与新描述符关联的FD_CLOEXEC文件描述符标志的值,返回新文件描述符F_GETFD:对应于fd的文件描述符标志作为函数值返回。当前只定义了一个文件描述符标志FD_CLOEXECF_SETFD:对于fd设置文件描述符标志。新标志值按第3个参数(取为整型值)设置F_GETFL:对应于fd的文件状态标志作为函数值返回。我们在说明open函数时,已描述了文件状态标志。

遗憾的是,5个访问方式标志(O_RDONLY、O_WRONLY、O_RDWR、O_EXEC、O_SEARCH)并不各占1位。这5个值互斥,一个文件的访问方式只能取这5个值之一。因此首先必须用屏蔽字O_ACCMODE取得访问方式位,然后将结果与这5个值中的每一个相比较

F_SETFL:将文件状态标志设置为第3个参数的值(取为整型值)。可以更改的几个标志是:O_APPEND、O_NONBLOCK、O_SYNC、O_DSYNC、O_RSYNC、O_FSYNC、O_ASYNC。F_GETOWN:获取当前接收SIGIO和SIGURG信号的进程ID或进程组IDF_SETOWN:设置接收SIGIO和SIGURG信号的进程ID或进程组ID。正的arg指定一个进程ID,负的arg表示等于arg绝对值的一个进程组ID

fcntl的返回值与命令有关。如果出错,所有命令都返回-1,如果成功则返回某个其他值。下列4个命令有特定返回值:F_DUPFD、F_GETFD、F_GETFL、F_GETOWN。第1个命令返回新的文件描述符,第2个和第3个命令返回相应的标志,最后一个命令返回一个正的进程ID或负的进程组ID

所示程序的第1个参数指定文件描述符,并对于该描述符打印其所选择的文件标志说明1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 #include "apue.h" #include <fcntl.h> int main (int argc, char *argv[]) int val; if (argc != 2 ) err_quit ("usage; a.out <descriptort>" ); if ((val = fcntl (atoi (argv[1 ]), F_GETFL, 0 )) < 0 ) err_sys ("fcntl error for id io" , atoi (argv[1 ])); switch (val & O_ACCMODE) { case O_RDONLY: printf ("read only" ); break ; case O_WRONLY: printf ("write only" ); break ; case O_RDWR: printf ("read write" ); break ; default : err_dump ("unknown access mode" ); } if (val & O_APPEND) printt (", append" ); if (val & O_NONBLOCK) printf (", nonblocking" ); if (val & O_SYNC) printf (", synchronous writes" ); # if !defined(_POSIX_C_SOURCE) && defined (O_FSYNC) && (O_FSYNC != 0_SYNC) if (val & O_FSYNC) printf (", synchronous writes" ); #endif putchar ('\n' ); exif (0 ); }

注意,我们使用了功能测试宏_POSIX_C_SOURCE,并且条件编译了POSIX.1中没有定义的文件访问标志。

在修改文件描述符标志或文件状态标志时必须谨慎,先要获得现在的标志值,然后按照期望修改它,最后设置新标志值。不能只是执行F_SETFD或F_SETFL命令,这样会关闭以前设置的标志位。下程序对于一个文件描述符设置一个或多个文件状态标志的函数。1 2 3 4 5 6 7 8 9 10 #include "apue.h" #include <fcntl.h> void set_fl (int fd, int flags) int val; if ((val = fcntl (fd, F_GETFL, 0 )) < 0 ) err_sys ("fcntl F_GETFL error" ); val |= flags; if (fcntl (fd, F_SETFL, val) < 0 ) err_sys ("fcntl F_SETTL error" ); }

如果将中间的一条语句改为:

就构成另一个函数,我们称为clr_fl,并将在后面某些例子中用到它。此语句使当前文件状态标志值val与flags的反码进行逻辑”与”运算。

在UNIX系统中,通常write只是将数据排入队列,而实际的写磁盘操作则可能在以后的某个时刻进行。而数据库系统则需要使用O_SYNC,这样一来,当它从write返回时就知道数据已确实写到了磁盘上,以免在系统异常时产生数据丢失程序运行时,设置O_SYNC标志会增加系统时间和时钟时间。

比较fsync和fdatasync,两者都更新文件内容,用了O_SYNC标志,每次写入文件时都更新文件内容。每一种调用的性能依赖很多因素,包括底层的操作系统实现、磁盘驱动器的速度以及文件系统的类型。

我们的程序在一个描述符(标准输出)上进行操作,但是根本不知道由shell打开的相应文件的文件名。因为这是shell打开的,因此不能在打开时按我们的要求设置O_SYNC标志。使用fcntl,我们只需要知道打开文件的描述符,就可以修改描述符的属性。在讲解非阻塞管道时还会用到fcntl,因为对于管道,我们所知的只有其描述符。

函数ioctl ioctl函数一直是I/O操作的杂物箱。终端I/O是使用ioctl最多的地方1 2 3 4 #include <unistd.h> #include <sys/ioctl.h> int ioctl (int fd, int request, ...)

ioctl函数是Single UNIX Specification标准的一个扩展部分。UNIX系统实现用它进行很多杂项设备操作。有些实现甚至将它扩展到用于普通文件。

对于ISO C原型,它用省略号表示其余参数。但是,通常只有另外一个参数,它常常是指向一个变量或结构的指针。通常,还要求另外的设备专用头文件。例如,除POSIX.1所说明的基本操作之外,终端I/O的ioctl命令都需要头文件<termios.h>。

每个设备驱动程序可以定义它自己专用的一组ioctl命令,系统则为不同种类的设备提供通用的ioctl命令。图中总结了FreeBSD支持的通用ioctl命令的一些类别。

类别

常量名

头文件

ioctl数

盘标号

DIOxxx

<sys/disklabel.h>4

文件I/O

FIOxxx

<sys/filio.h>14

磁带I/O

MTIOxxx

<sys/mtio.h>11

套接字I/O

SIOxxx

<sys/sockio.k>73

终端I/O

TIOxxx

<aya/ttycom.h>43

磁带操作使我们可以在磁带上写一个文件结束标志、倒带、越过指定个数的文件或记录等,对这些设备进行操作最容易的方法就是使用ioctl。

/dev/fd 较新的系统都提供名为/dev/fd的目录,其目录项是名为0、1、2等的文件。打开文件/dev/fd/n等效于复制操述符n(假定描述符n是打开的)。

在下列函数调用中;1 fd = open ("/dev/fd/0" , node);

大多数系统忽略它所指定的mode,而另外一些系统则要求mode必须是所引用的文件(在这里是标准输入)初始打开时所使用的打开模式的一个子集。因为上面的打开等效于

所以描述符0和fd共享同一文件表项。例如,若描述符0先前被打开为只读,那么我们也只能对fd进行读操作。即使系统忽略打开模式,而且下列调用是成功的:1 fd = open ("/dev/fd/0" , O_RDWR);

我们仍然不能对fd进行写操作。

Linux实现中的/dev/fd是个例外。它把文件描述符映射成指向底层物理文件的符号链接。例如,当打开/dev/fd/0时,事实,上正在打开与标准输入关联的文件,因此返回的新文件描述符的模式与/dev/fd文件描述符的模式其实并不相关。

我们也可以用/dev/fd作为路径名参数调用creat,这与调用open时用O_CREAT作为第2个参数作用相同。例如,若一个程序调用creat,并且路径名参数是/dev/fd/1,那么该程序仍能工作。

某些系统提供路径名/dev/stdin、/dev/stdout和/dev/stderr,这些等效于/dev/fd/0、/dev/fd/1和/dev/fd/2。/dev/fd文件主要由shell使用,它允许使用路径名作为调用参数的程序,能用处理其他路径名的相同方式处理标准输入和输出。例如,cat(1)命令对其命令行参数采取了一种特殊处理,它将单独的一个字符“-”解释为标准输入。例如:1 filter file2 | cat file1 - file3 | lpr

首先cat读file1,按着读其标准输入(也就是filter file2命令的输出),然后读file3,如果支持/dev/fd,则可以删除cat对“-”的特殊处理,于是我们就可键入下列命令行;1 filter file2 | cat file1 /dev/fd/0 file3 | lpr

作为命令行参数的“-”特指标准输入或标准输出,这已由很多程序采用。但是这会带来一些问题,例如,如果用”-”指定第一个文件,那么看来就像指定了命令行的一个选项。/dev/fd则提高了文件名参数的一致性,也更加清晰。

文件和目录 函数stat、fstat、fstatat和lstat 本章主要讨论4个stat函数以及它们的返回信息。1 2 3 4 5 6 #include <sys/stat.h> int stat (const char *restrict pathmame, struct stat *restrict buf) int fstat (int fd, struct stat *buf) int lstat (const char *restrict pathmame, struct stat *restrict buf) int fatatat (int fd, const char *restrict pathname, struct stat *restrict buf, int flag) 所有4 个函数的返回值,若成功,返回0 ;若出错,返回-2

一旦给出pathname,stat函数将返回与此命名文件有关的信息结构。fstat函数获得已在描述符fd上打开文件的有关信息。lstat函数类似于stat,但是当命名的文件是一个符号链接时,lstat返回该符号链接的有关信息,而不是由该符号链接引用的文件的信息。

fstatat函数为一个相对于当前打开目录(由fd参数指向)的路径名返回文件统计信息。flag参数控制着是否跟随着一个符号链接。当AT_SYMLINK_NOFOLLOW标志被设置时,fstatat不会跟随符号链接,而是返回符号链接本身的信息。否则,在默认情况下,返同的是符号链接所指向的实际文件的信息。如果fd参数的值是AT_FDCWD,并且pathname参数是一个相对路径名,fstatat会计算相对于当前目录的pathname参数。如果pathname是一个绝对路径,后参数就会被忽略。这两种情况下,根据flag的取值,fstatat的作用就跟stat或lstat一样。

第2个参数buf是一个指针,它指向一个我们必须提供的结构。函数来填充由buf指向的结构。结构的实际定义可能随具体实现有所不同,但其基本形式是:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 struct stat {mode_t st_mode; ino_t st_ino; dev_t st_dev; dev_t st_rdev; nlink_t st_nlink; uid_t st_uid; gid_t st_gid; off_t st_sizesstruct tinespec st_atime; struct timespec st_mtime; struct tinespec st_ctime; blksize_t st_blksizes blkcnt_t st_blocks; };

timespec结构类型按照秒和纳秒定义了时间,至少包括下面两个字段:1 2 time_t tv_sec;long tv_nsec;

使用stat函数最多的地方可能就是ls -l命令,用其可以获得有关一个文件的所有信息。

文件类型 至此我们已经介绍了两种不同的文件类型:普通文件和目录。UNIX系统的大多数文件是普通文件或目录,但是也有另外一些文件类型。文件类型包括如下几种,

普通文件 (regular file)。这是最常用的文件类型,这种文件包含了某种形式的数据。至于这种数据是文本还是二进制数据,对于UNIX内核而言并无区别。对普通文件内容的解释由处理该文件的应用程序进行。

一个值得注意的例外是二进制可执行文件。为了执行程序,内被必须理解其格式。

目录文件 (directory file)。这种文件包含了其他文件的名字以及指向与这些文件有关信息的指针。对一个目录文件具有读权限的任进程都可以读该目录的内容,但只有内核可以直接写目录文件。块特殊文件 (block special file)。这种类型的文件提供对设备(如磁盘)带缓冲的访问,每次访问以固定长度为单位进行。字符特殊文件 (character special fle),这种类型的文件提供对设备不带缓冲的访问,每次访问长度可变。系统中的所有设备要么是字符特殊文件,要么是块特殊文件。FIFO 。这种类型的文件用于进程间通信,有时也称为命名管道(named pipe)。套接字 (socket)。这种类型的文件用于进程间的网络通信。套接字也可用于在一台宿主机上进程之间的非网络通信。符号链接 (symbolic link)。这种类型的文件指向另一个文件。

文件类型信息包含在stat结构的st_mode成员中。可以用表中的宏确定文件类型。这些宏的参数都是stat结构中的st_mode成员。

宏

文件类型

S_ISREG()管通文件

S_ISDIR()目录文件

S_ISCHR()字符特殊文件

S_ISBLK()块特殊文件

S_ISFIFO()管道或FIFO

S_ISLNK()符号链接

S_ISSOCK()套楼字

POSIX.1允许实现将进程间通信(IPC)对象(如消息队列和信号量等)说明为文件。表中的宏可用来从stat结构中确定IPC对象的类型。这些宏与上表中的不同,它们的参数并非st_mode,而是指向stat结构的指针。

宏

对象的类型

S_TYPEISMQ()消息队列

S_TYPEISSEM()信号量

S_TYPEISSHM()共享存储对象

程序取其命令行参数,然后针对每一个命令行参数打印其文件类型。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 #include "apue.h" int main (int argc, char *argv[]) int i; struct stat buf; char *ptr; for (i = 1 ; i < argc; i ++) { printf ("%s: " , argv[i]); if (lstat (argv[i], &buf) < 0 ) { err.ret ("lstat error" ); continue ; } if (S_ISREG (buf.st_mode)) ptr = "regular" ; else if (S_ISDIR (buf.st_mode)) ptr = "directory" ; else if (S_ISCHR (buf.st_mode)) ptr = "chacacter special" ; else if (S_ISBLK (buf.st_mode)) ptr = "block special" , else if (S_ISFIFO (buf.st_mode)) ptr = "fifo" ; else if (S_ISLNK (buf.st_mode)) ptr = "symbolic link" ; else if (S_ISSOCK (buf.st_mode)) ptr = "Socket" ; else ptz = "*** unknown mode ***" ; printl ("%s\n" , ptr); exit (0 ); }

早期的UNIX版本并不提供S_ISxxx宏,于是就需要将st_mode与屏蔽字S_IFMT进行逻辑“与”运算,然后与名为S_IFxxx的常量相比较。大多数系统在文件<sys/stat.h>中定义了此屏蔽字和相关的常量。如若查看此文件,则可找到S_ISDIR宏定义为:1 #define S_ISDIR (mode) (((mode) & S_IFMT) == S_IFDIR)

设置用户ID和设置组ID 与一个进程相关联的ID有6个或更多

通常,有效用户ID等于实际用户ID,有效组ID等于实际组ID。每个文件有一个所有者和组所有者,所有者由stat结构中的st_uid指定,组所有者则由st_gid指定。

当执行一个程序文件时,进程的有效用户ID通常就是实际用户ID,有效组ID通常是实际组ID。但是可以在文件模式字(st_mode)中设置一个特殊标志,其含义是“当执行此文件时,将进程的有效用户ID设置为文件所有者的用户ID(st_uid)”。与此相类似,在文件模式字中可以设置另一位。它将执行此文件的进程的有效组ID设置为文件的组所有者ID(st_gid)。在文件模式字中的这两位被称为设置用户ID(set-user-ID)位和设置组ID(set-group-ID)位。

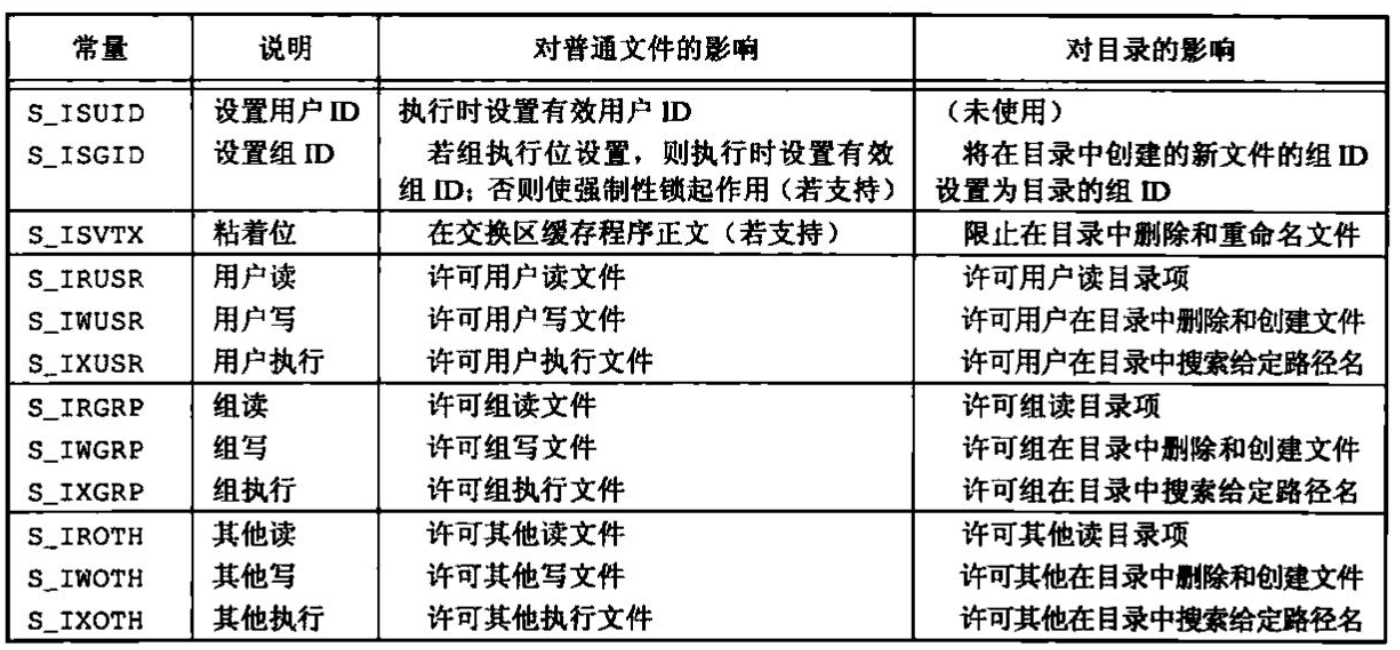

文件访问权限 st_mode值也包含了对文件的访问权限位。当提及文件时,指的是前面所提到的任何类型的文件。所有文件类型(目录、字符特别文件等)都有访问权限(access permission)。每个文件有9个访问权限位,可将它们分成3类:

st_mode屏蔽

含义

S_IRUSR

用户读

S_IWUSR

用户写

S_IXUSR

用户执行

S_IRGRP

组读

S_IWGRP

组写

S_IXGRP

组执行

S_IROTH

其他读

S_IWOTH

其他写

S_IXOTH

其他执行

在前3行中,术语用户指的是文件所有者(owner)。chmod(1)命令用于修改这9个权限位。该命令允许我们用u表示用户(所有者),用g表示组,用o表示其他。

3类访问权限(即读、写及执行)以各种方式由不同的函数使用。我们将这些不同的使用方式汇总在下面。

第一个规则是,我们用名字打开任一类型的文件时,对该名字中包含的每一个目录,包括它可能隐含的当前工作目录都应具有执行权限。这就是为什么对于目录其执行权限位常被称为搜索位的原因。

例如,为了打开文件/usr/include/stdio.h,需要对目录/、/usr和/usr/inciude具有执行权限。然后,需要具有对文件本身的适当权限,这取决于以何种模式打开它。

如果当前目录是/usr/include,那么为了打开文件stdio.h,需要对当前目录有执行权限。这是隐含当前目录的一个示例,打开stdio.h文件与打开./stdio.h作用相同。

注意,对于目录的读权限和执行权限的意义是不相同的。读权限允许我们读目录,获得在该目录中所有文件名的列表。当一个目录是我们要访问文件的路径名的一个组成部分时,对该目录的执行权限使我们可通过该目录(也就是搜索该目录),寻找一个特定的文件名

对于一个文件的读权限决定了我们是否能够打开现有文件进行读操作。

对于一个文件的写权限决定了我们是否能够打开现有文件进行写操作。

为了在open函数中对一个文件指定O_TRUNC标志,必须对该文件具有写权限。

为了在一个目录中创建一个新文件,必须对该目录具有写权限和执行权限。

为了删除一个现有文件,必须对包含该文件的目录具有写权限和执行权限。对该文件本身则不需要有读、写权限。

如果用7个exec函数中的任何一个执行某个文件,都必须对该文件具有执行权限。该文件还必须是一个普通文件。

进程每次打开、创建或删除一个文件时,内核就进行文件访问权限测试,而这种测试可能涉及文件的所有者(st_uid和st_gid)、进程的有效ID(有效用户ID和有效组ID)以及进程的附属组ID(若支持的话)。两个所有者ID是文件的性质,而两个有效ID和附属组ID则是进程的性质。内核进行的测试具体如下。

若进程的有效用户D是0(超级用户),则允许访问。这给予了超级用户对整个文件系统进行处理的最充分的自由。

若进程的有效用户ID等于文件的所有者ID(也就是进程拥有此文件),那么如果所有者适当的访问权限位被设置,则允许访问;否则拒绝访问。适当的访问权限位指的是,若进程为读而打开该文件,则用户读位应为1;若进程为写而打开该文件,则用户写位应为1;若进程将执行该文件,则用户执行位应为1.

若进程的有效组ID或进程的附属组ID之一等于文件的组D,那么如果组适当的访问权限位被设置,则允许访问:否则拒绝访问,

若其他用户适当的访问权限位被设置,则允许访问:否则拒绝访问。

按顺序执行这4步。注意,如果进程拥有此文件(第2步),则按用户访问权限批准或拒绝该进程对文件的访问——不查看组访问权限。类似地,若进程并不拥有该文件。但进程属于某个适当的组,则按组访问权限批准或拒绝该进程对文件的访问——不查看其他用户的访问权限。

新文件和目录的所有权 新文件的用户ID设置为进程的有效用户ID。关于组ID,POSIX.1允许实现选择下列之一作为新文件的组ID。

新文件的组D可以是进程的有效组ID.

新文件的组ID可以是它所在目录的组ID.

使用POSIX.I所允许的第二个选项(继承目录的组ID)使得在某个目录下创建的文件和目录都具有该目录的组ID。于是文件和目录的组所有权从该点向下传递。

函数access和faccessat 当用open函数打开一个文件时,内核以进程的有效用户ID和有效组ID为基础执行其访问权限测试。有时,进程也希望按其实际用户ID和实际组ID来测试其访问能力。即使一个进程可能已经通过设置用户ID以超级用户权限运行,它仍可能想验证其实际用户能否访问一个给定的文件。access和faccessat函数是按实际用户ID和实际组ID进行访问权限测试的。1 2 3 4 #include <unistd.h> int access (const char *pathmame, int mode) :int faccessat(int fd, const char *pathname, int mode, int flag);

其中,如果测试文件是否已经存在,mode就为F_OK;否则mode是表中所列常量的按位或。

mode

说明

R_OK

测试读权限

W_OK

测试写权限

X_OK

测试执行权限

faccessat函数与access函数在下面两种情况下是相同的:一种是pathname参数为绝对路径,另一种是fd参数取值为AT_FDCWD而pathname参数为相对路径。否则,faccessat计算相对于打开目录(由fd参数指向)的pathname。

flag参数可以用于改变faccessat的行为,如果flag设置为AT_EACCESS,访问检查用的是调用进程的有效用户ID和有效组ID,而不是实际用户ID和实际组ID。

下文显示了access函数的使用方法。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 #include "apue.h" #include <fcntl.h> int main (int argc, char *argv[]) if (argc != 2 ) err_quit ("usage: a.out <pathname>" ); if (access (argv[1 ], R_OK) < 0 ) err_ret ("access error for %s" , argv[1 ]); else printf ("read access OK\n" ); if (open (argv[1 ], O_RDONLY) < 0 ) err_ret ("open error for %s" , argv[1 ]); else printf ("open for reading OK\n" ); exit (0 ); }

在本例中,尽管open函数能打开文件,但通过设置用户ID程序可以确定实际用户不能正常读指定的文件。

函数umask umask函数为进程设置文件模式创建屏蔽字,并返回之前的值。1 2 3 #include <sys/stat.h> mode_t umask (mode_t cmask)

其中,参数cmask是之前列出的9个常量(S_IRUSR、S_IWUSR等)中的若干个按位“或”构成的。

在进程创建一个新文件或新目录时,就一定会使用文件模式创建屏蔽字。在文件模式创建屏蔽字中为1的位,在文件mode中的相应位一定被关闭。

程序创建了两个文件,创建第一个时,umask值为0,创建第二个时,umask值禁止所有组和其他用户的访问权限1 2 3 4 5 6 7 8 9 10 11 12 13 #include "apue.h" #include <fenti.h> #define RWRWRW(S_IRUSR | S_IWUSR | S_IRGRP | S_IWGRP | S_IROTH | S_IWOTH) int main (void ) umask (0 ); if (creat ("foo" , RWRWRW) < 0 ) err_sys ("creat error for foo" ); umask (S_IRGRP | S_IWGRP | S_IROTH | S_IWOTH); if (creat ("bar" , RWRWRW) < 0 ) err_ays ("creat error for bar" ); exif (0 ); }

若运行此程序可得如下结果,从中可见访问权限位是如何设置的。1 2 3 4 5 6 7 8 9 $ umask ;先打印当前文件模式创建屏蔽字 002 $ ./a.out $ ls -l foo bar -rw------- 1 sar 0 Dec 7 21:20 bar -rw-rw-rw- 1 sar 0 Dec 7 21:20 foo $ umask ;观察文件模式创建屏蔽字是否更改 002

UNIX系统的大多数用户从不处理他们的umask值。通常在登录时,由shell的启动文件设置一次,然后,再不改变。尽管如此,当编写创建新文件的程序时,如果我们想确保指定的访问权限位已经激活,那么必须在进程运行时修改umask值。例如,如果我们想确保任何用户都能读文件,则应将umask设置为0。否则,当我们的进程运行时,有效的umask值可能关闭该权限位。

用户可以设置umask值以控制他们所创建文件的默认权限。该值表示成八进制数,一位代表一种要屏蔽的权限。设置了相应位后,它所对应的权限就会被拒绝。常用的几种umask值是002、022和027。002阻止其他用户写入你的文件,022阻止同组成员和其他用户写入你的文件,027阻止同组成员写你的文件以及其他用户读、写或执行你的文件。

屏蔽位

含义

0400

用户读

0200

用户写

0100

用户执行

0040

组读

0020

组写

0010

组执行

0004

其他读

0002

其他写

0001

其他执行

函数chmod、fchmod和fchmodat chmod、fchmod和fchmodat这3个函数使我们可以更改现有文件的访问权限。1 2 3 4 5 #include <ays/stat.h> int chmod (const char *pathname, mode_t mode) int fchmod (int fd, mode_t mode) int fchmodat (int fd, const char *pathname, mode_t mode, int flag)

chmod函数在指定的文件上进行操作,而fchmod函数则对已打开的文件进行操作。fchmodat函数与chmod函数在下面两种情况下是相同的:一种是pathname参数为绝对路径,另一种是fd参数取值为AT_FDCWD而pathname参数为相对路径。否则,fchmodat计算相对于打开目录(由fd参数指向)的pathname。flag参数可以用于改变fchmodat的行为,当设置了AT_SYMLINK_NOFOLLOW标志时,fchmodat并不会跟随符号链接。

为了改变一个文件的权限位,进程的有效用户D必须等于文件的所有者ID,或者该进程必须具有超级用户权限。参数mode是常量的按位或。

mode

说明

S_ISUID

执行时设置用户D

S_ISGID

执行时设置组D

S_ISVTX

保存正文(粘着位)

S_IRWXU

用户(所有者)读、写和执行

S_IRUSR

用户(所有者)读

S_IWUSR

用户(所有者)写

S_IXUSR

用户(所有者)执行

S_IRWXG

组读、写和执行

S_IRGRP

组读

S_IWGRP

组写

S_IXGRP

组执行

S_IRWXO

其他读、写和执行

S_IROTH

其他读

S_IWOTH

其他写

S_IXOTH

其他执行

注意,有9项是取自之前的9个文件访问权限位。我们另外加了6个,它们是两个设置ID常量(S_ISUID和S_ISGID)、保存正文常量(S_ISVTX)以及3个组合常量(S_IRWXU、S_IRWXG和S_IRWXO)。

程序修改了这两个文件的模式,1 2 3 4 5 6 7 8 9 10 11 12 #include "apue.h" int main (void ) struct stat statbuf; if (stat ("foo" , &statbuf) < 0 ) err_ays ("stat error for foo" ); if (chmod ("foo" , (statbuf.st_mode & ~S_IXGRP) | S_ISGID) < 0 ) err_sys ("chmod error for foo" ); if (chmod ("bar" , S_IRUSR | S_IWUSR I S_IRGRP | S_IROTH) < 0 ) exr_sys ("chmod error for bar" ); exit (0 );

在运行程序后,这两个文件的最后状态是:1 2 3 $ ls -l foo bax -rw-r--r-- 1 sar 0 Dec 7 21:20 bar -rw-rwSrw- 1 sar 0 Dec 7 21:20 foo

在本例中,不管文件bar的当前权限位如何,我们都将其权限设置为一个绝对值。对文件foo,我们相对于其当前状态设置权限。为此,先调用stat获得其当前权限,然后修改它。我们显式地打开了设置组ID位、关闭了组执行位。

chmod函数在下列条件下自动清除两个权限位。

Solaris等系统对用于普通文件的粘着位赋予了特殊含义,在这些系统上如果我们试图设置普通文件的粘着位(S_ISVTX),且又没有超级用户权限,那么mode中的粘着位自动被关闭。这意味着只有超级用户才能设置普通文件的粘着位。这样做的理由是防止恶意用户设置粘着位,由此影响系统性能。

新创建文件的组ID可能不是谓用进程所属的组。特别地,如果新文件的组ID不等于进程的有效组ID或者进程附属组ID中的一个,而且进程没有超级用户权限,那么设置组ID位会被自动被关闭。这就防止了用户创建一个设置组ID文件,而该文件是由并非该用户所属的组拥有的。

粘着位 S_ISVTX如果一个可执行程序文件的这一位被设置了,那么当该程序第一次被执行,在其终止时,程序正文部分的一个副本仍被保存在交换区(程序的正文部分是机器指令)。

这使得下次执行该程序时能较快地将其装载入内存。其原因是:通常的UNIX文件系统中,文件的各数据块很可能是随机存放的,相比较而言,交换区是被作为一个连续文件来处理的。对于在交换区中可以同时存放的设置了粘着位的文件数是有限制的,以免过多占用交换区空间,但无论如何这是一个有用的技术。因为在系统再次自举前,文件的正文部分总是在交换区中,这正是名字中“粘着”的由来。后来的UNIX版本称它为保存正文位 (saved-textbit),因此也就有了常量S_ISVTX。

如果对一个目录设置了粘着位,只有对该目录具有写权限的用户并且满足下列条件之一,才能删除或重命名该目录下的文件:

目录/tmp和/var/tmp是设置粘着位的典型候选者,任何用户都可在这两个目录中创建文件。任一用户(用户、组和其他)对这两个目录的权限通常都是读、写和执行。但是用户不应能删除或重命名属于其他人的文件,为此在这两个目录的文件模式中都设置了粘着位。

函数chown、fchown、fchownat和1chown 下面几个chown函数可用于更改文件的用户ID和组ID。如果两个参数owner或group中的任意一个是-1,则对应的ID不变。1 2 3 4 5 6 #include <unistd.h> int chown (const char *pathnome, uid_t owner, gid_t group) int fchown (int fd, uid_t owner, gid_t group) int fchownat (int fd, const char *pathrame, uid_t owner, gid_t group, int flag) int lchown (const char *pariname, uid_t owner, gid_t group)

除了所引用的文件是符号链接以外,这4个函数的操作类似。在符号链接情况下,lchown和fchownat(设置了AT_SYMLINK_NOFOLLOW标志)更改符号链接本身的所有者,而不是该符号链接所指向的文件的所有者。

fchown函数改变fd参数指向的打开文件的所有者,既然它在一个已打开的文件上操作,就不能用于改变符号链接的所有者,fchownat函数与chown或者lchown函数在下面两种情况下是相同的;一种是pathname参数为绝对路径,另一种是fd参数取值为AT_PDCND而pathname参数为相对路径。在这两种情况下,如果flag参数中设置了AT_SYMLINK_NOFOLLOW标志,fchownat与lchown行为相同,如果flag参数中清除了AT_SYMLINK_NOFOLLOW标志,则fchownat与chown行为相同。如果fd参数设置为打开目录的文件描述符,并且pathname参数是一个相对路径名,fchownat函数计算相对于打开目录的pathname。

_POSIX_CHOWN_RESTRICTED常量可选地定义在头文件<unistd.h>中,而且总是可以用pathconf或fpathconf函数进行查询。此选项还与所引用的文件有关一可在每个文件系统基础上,使该选项起作用或不起作用。在下文中,如提及“若_POSIX_CHOWN_RESTRICTED生效”,则表示“这适用于我们正在淡及的文件”,而不管该实际常量是否在头文件中定义。

若_POSIX_CHOWN_RESTRICTED对指定的文件生效,则

只有超级用户进程能更改该文件的用户ID:

如果进程拥有此文件(其有效用户ID等于该文件的用户ID),参数owner等于-1或文件的用户ID,并且参数group等于进程的有效组ID成进程的附属组ID之一,那么一个非超级用户进程可以更改该文件的组ID

这意味着,当_POSIX_CHOWN_RESTRICTED有效时,不能更改其他用户文件的用户ID。你可以更改你所拥用的文件的组ID,但只能改到你所属的组。如果这些函数由非超级用户进程调用,则在成功返回时,该文件的设置用户ID位和设置组ID位都被清除。

文件长度 stat结构成员st_size表示以字节为单位的文件的长度。此字段只对普通文件、目录文件和符号链接有意义。

对于普通文件,其文件长度可以是0,在开始读这种文件时,将得到文件结束(end-of-file)指示。对于目录,文件长度通常是一个数(如16或512)的整倍数。

对于符号链接,文件长度是在文件名中的实际字节数。例如,在下面的例子中,文件长度7就是路径名usr/lib的长度:1 lrwxrwxrwx 1 root 7 Sep 25 07:14 lib -> usr/1ib

(注意,因为符号链接文件长度总是由st_size指示,所以它并不包含通常C语言用作名字结尾的null字节。)

现今,大多数现代的UNIX系统提供字段st_blksize和st_blocks。其中,第一个是对文件I/O较合适的块长度,第二个是所分配的实际512字节块块数。为了提高效率,标准I/O库也试图一次读、写st_blksize个字节。

文件中的空洞 我们提及普通文件可以包含空洞。空洞是由所设置的偏移量超过文件尾端,并写入了某些数据后造成的。作为一个例子,考虑下列情况:1 2 3 4 $ ls -l core -rw-r--r-- 8483248 Nov 18 12:18 core $ du -s core 272 core

文件core的长度稍稍超过8MB,可是du命令报告该文件所使用的磁盘空间总量是272个512字节块(即139264字节)。很明显,此文件中有很多空洞。

对于没有写过的字节位置,read函数读到的字节是0。如果执行下面的命令,可以看出正常的I/O操作读整个文件长度:1 2 $ wc -c core 8483248 core

带-c选项的wc(l)命令计算文件中的字符数(字节)。

如果使用实用程序(如cat(1)复制这个文件,那么所有这些空洞都会被填满,其中所有实际数据字节皆填写为0。1 2 3 4 5 6 7 $ cat core > core.copy $ ls -l oore* -rw-r--r-- 1 sar 8483248 Nov 18 12:18 core -rw-rw-r-- 1 sar 8483248 Nov 18 12:27 core.copy $ du -s core* 272 core 16592 core.copy

从中可见,新文件所用的实际字节数是8495 104(512 x 16592)。此长度与ls命令报告的长度不同,其原因是,文件系统使用了若干块以存放指向实际数据块的各个指针。

文件截断 有时我们需要在文件尾端处截去一些数据以缩短文件。将一个文件的长度截断为0是一个特例,在打开文件时使用O_TRUNC标志可以做到这一点。为了截断文件可以调用函数truncate和ftruncate。1 2 3 4 #include <unistd.h> int truncate (const char *puthoume, ott_t lempth) int ftruncate (int fd, off_c length) i两个函数的返回值,若成功,返回0;若出错。返回-1

这两个函数将一个现有文件长度裁断为length。如果该文件以前的长度大于length,则超过length以外的数据就不再能访问。如果以前的长度小于length,文件长度将增加,在以前的文件尾端和新的文件尾端之间的数据将读作0(也就是可能在文件中创建了一个空洞)。

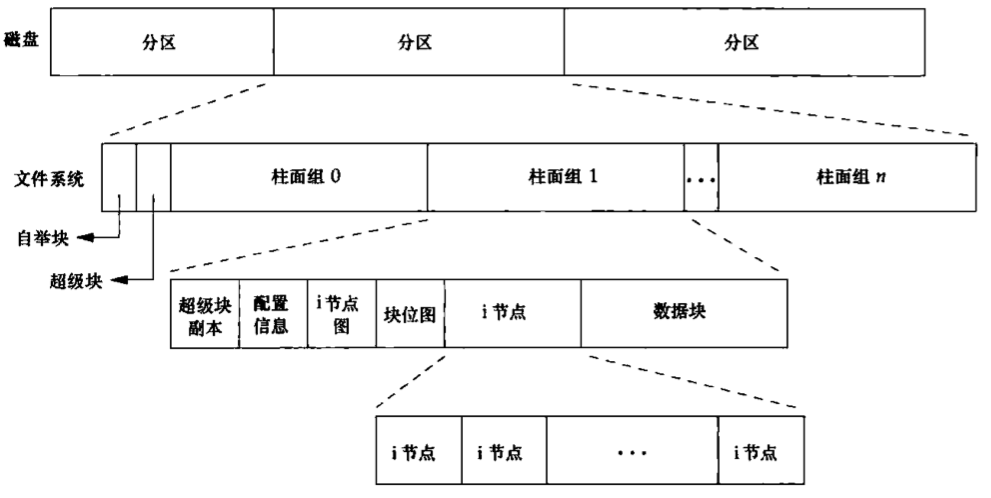

文件系统 目前,正在使用的UNIX文件系统有多种实现。例如. Solaris支持多种不同类型的磁盘文件系统:传统的基于BSD的UNIX文件系统(称为UFS),读、写DOS格式软盘的文件系统(称为PCFS),以及读CD的文件系统(称为HSFS)。UFS是以Berkeiey快速文件系统为基础的。

我们可以把一个磁盘分成一个或多个分区。每个分区可以包含一个文件系统,i节点是固定长度的记录项,它包含有关文件的大部分信息。

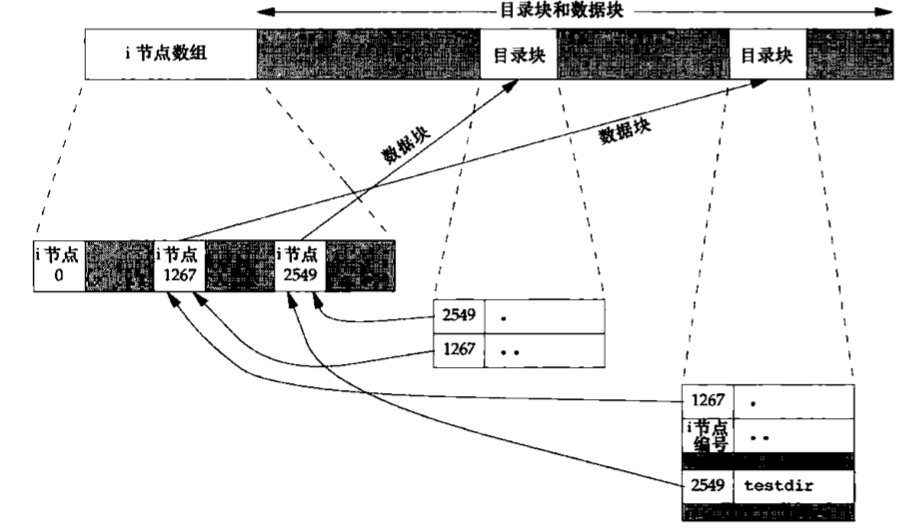

如果更仔细地观察一个柱面组的i节点和数据块部分,则可以看到下图中所示的情况。

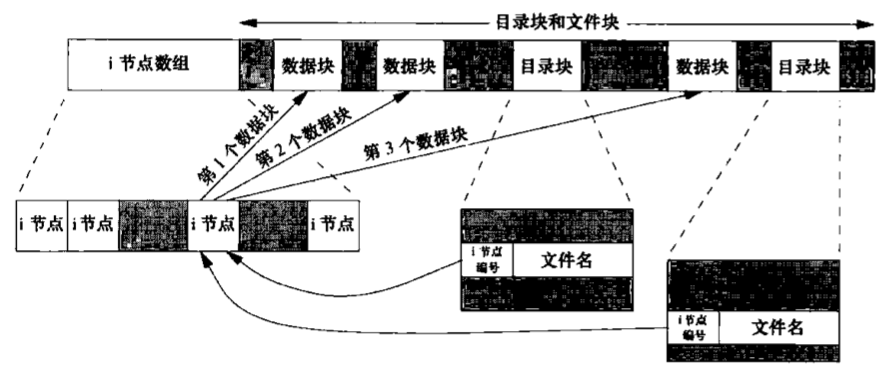

在图中有两个目录项指向同一个i节点。每个i节点中都有一个链接计数,其值是指向该i节点的目录项数。只有当链接计数减少至0时,才可删除该文件。这也是为什么删除一个目录项的函数被称之为unlink而不是delete的原因。在stat结构中,链接计数包含在st_nlink成员中,其基本系统数据类型是nlink_t。这种链接类型称为硬链接。

另外一种链接类型称为符号链接(symbolic link)。符号链接文件的实际内容(在数据块中)包含了该符号链接所指向的文件的名字。在下面的例子中,目录项中的文件名是3个字符的字符串lib,而在该文件中包含了7个字节的数据usr/lib:1 lrwxrwxrwx l root 7 sep 25 07:14 lib -> /urs/lib

该i节点中的文件类型是S_IFLNK,于是系统知道这是一个符号链接。

i节点包含了文件有关的所有信息,文件类型、文件访问权限位、文件长度和指向文件数据块的指针等。stat结构中的大多数信息都取自1节点。只有两项重要数据存放在目录项中:文件名和i节点编号。i节点编号的数据类型是ino_t。

因为目录项中的节点编号指向同一文件系统中的相应节点,一个目录项不能指向另一个文件系统的i节点。

当在不更换文件系统的情况下为一个文件重命名时,该文件的实际内容并未移动,只需构造一个指向现有i节点的新目录项,并删除老的目录项。链接计数不会改变。例如,为将文件/usr/lib/foo重命名为/usr/foo,如果目录/usr/lib和/usr在同一文件系统中,则文件foo的内容无需移动。

假定我们在工作目录中构造了一个新目录:

下图显示了其结果。注意,该图显式地显示了.和..目录项。编号为2549的i节点,其类型字段表示它是一个目录,链接计数为2。任何一个叶目录(不包含任何其他目录的目录)的链接计数总是2。数值2来自于命名该目录(testdir)的目录项以及在该目录中的.项。

编号为1267的i节点,其类型字段表示它是一个目录,链接计数大于或等于3。它大于或等于3的原因是,至少有3个目录项指向它一个是命名它的目录项,第二个是在该目录中的.项,第三个是在其子目录testdir中的..项。注意,在父目录中的每一个子目录都使该父目录的链接计数增加1。

函数1ink、linkat、unlink、unlinkat和remove 如上节所述。任何一个文件可以有多个目录项指向其i节点。创建一个指向现有文件的链接的方法是使用link函数或linkat函数1 2 3 4 #include <unistd.h> int link (const char *existingpath, const chaz *newpath) int linkat (int efd, const char *existingpash, int nfd, const char *newpath, int flag)

这两个函数创建一个新目录项newpath,它引用现有文件existingpath。如果newpath已经存在,则返回出错。只创建newpath中的最后一个分量,路径中的其他部分应当已经存在。

对于linkat函数,现有文件是通过efd和existingpath参数指定的,新的路径名是通过nfd和newpath参数指定的。默认情况下,如果两个路径名中的任一个是相对路径,那么它需要通过相对于对应的文件描述符进行计算。如果两个文件描述符中的任一个设置为AT_FDCWD,那么相应的路径名(如果它是相对路径)就通过相对于当前目录进行计算。如果任一路径名是绝对路径,相应的文件描述符参数就会被忽略

当现有文件是符号链接时,由flag参数来控制linkat函数是创建指向现有符号链接的链接还是创建指向现有符号链接所指向的文件的链接。如果在flag参数中设置了AT_SYMLINK_FOLLOW标志,就创建指向符号链接目标的链接。如果这个标志被清除了,则创建一个指向符号链接本身的链接。

创建新目录项和增加链接计数应当是一个原子操作。虽然POSIX.1允许实现支持跨越文件系统的链接,但是大多数实现要求现有的和新建的两个路径名在同一个文件系统中。如果实现支持创建指向一个目录的硬链接,那么也仅限于超级用户才可以这样做。其理由是这样做可能在文件系统中形成循环,大多数处理文件系统的实用程序都不能处理这种情况。因此,很多文件系统实现不允许对于目录的硬链接

为了剩除一个现有的目录项,可以调用unlink函数。1 2 3 4 #include <unistd.h> int unlink (const char *pathname) int unlinkat (int fd, const char *pathnome, int flag)

这两个函数删除目录项,并将由pathname所引用文件的链接计数减1。如果对该文件还有其他链接,则仍可通过其他链接访问该文件的数据。如果出错,则不对该文件做任何更改。我们在前面已经提及,为了解除对文件的链接,必须对包含该目录项的目录具有写和执行权限。如果对该目录设置了粘着位,则对该目录必须具有写权限,并且具备下面三个条件之一:

只有当链接计数达到0时,该文件的内容才可被删除。另一个条件也会阻止删除文件的内容——只要有进程打开了该文件,其内容也不能剩除。关闭一个文件时,内核首先检查打开该文件的进程个数:如果这个计数达到0,内核再去检查其链接计数:如果计数也是0,那么就删除该文件的内容。

如果pathname参数是相对路径名,那么unlinkat函数计算相对于由fd文件描述符参数代表的目录的路径名。如果fd参数设置为AT_FDCWD,那么通过相对于调用进程的当前工作目录来计算路径名。如果pathname参数是绝对路径名,那么fd参数被忽略。

flag参数给出了一种方法,使调用进程可以改变unlinkat函数的默认行为,当AT_REMOVEDIR标志被设置时,unlinkat函数可以类似于rmdir一样删除目录。如果这个标志被清除,unlinkat与unlink执行同样的操作。

程序打开一个文件,然后解除它的链接。执行该程序的进程然后睡眠15秒,接着就终止1 2 3 4 5 6 7 8 9 10 11 12 #include "apue.h" #include <fcnt1.h> int main (void ) { if (open("tempfile" , O_RDWR) < 0 ) err_sys("open error" ); if (unlink("tempfile" ) < 0 ) err_sys ("unlink error" ); printt("flle unlinked\n" ); sleep(15 ); printt("done\n" ); exit (0 );

运行该程序,其结果是:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 $ ls -l tempfile -rw-r----- 1 sar 413265408 Jan 21 07:14 tempfile $ df / home Filesystem lK-blocks Used Avallable Use% Mounted on /dev/hda4 11021440 1956332 9065108 18% /home $ ./a.out & 1364 $ file unlinked ls -l tempfile ls : tempfile: No such tile or directory $ df /home Filesystem lK-blocks Used Available Use% Mounted on /dev/hda4 11021440 1956332 9065108 18% /home $ done df /home Filesysten lK-blocks Used Available Use% mounted on /dev/hda4 11021440 1552352 9469088 15% /home

unlink的这种特性经常被程序用来确保即使是在程序崩溃时,它所创建的临时文件也不会遭留下来。进程用open或creat创建一个文件,然后立即调用unlink,因为该文件仍旧是打开的,所以不会将其内容删除,只有当进程关闭该文件或终止时(在这种情况下,内核关闭该进程所打开的全部文件),该文件的内容才被剥除,如果pathname是符号链接,那么uniink删除该符号链接,而不是删除由该链接所引用的文件。给出符号链接名的情况下,没有一个函数能剩除由该链接所引用的文件。

如果文件系统支持的话,超级用户可以调用unlink,其参数pathname指定一个目录,但是通常应当使用rmdir函数,而不使用unlink这种方式。

我们也可以用remove函数解除对一个文件或目录的链接。对于文件,remove的功能与unlink相同。对于目录,remove的功能与rmdir相同。1 2 3 #include <stdio.h> int remove (const char *pathname)

ISO C指定remove函数删除一个文件,这更改了UNIX历来使用的名字unlink,其原因是实现C标准的大多数察UNIX系统并不支持文件链接;

函数rename和renameat 文件或目录可以用rename函数或者renameat函数进行重命名。1 2 3 4 #include <stdio.h> int rename (const char *oldname, const char *newname) int renameat (int oldfd, const char *oldname, int newfd, const char *newname)

根据oldname是指文件、目录还是符号链接,有几种情况需要加以说明。我们也必须说明如果newname已经存在时将会发生什么。

如果oldname指的是一个文件而不是目录,那么为该文件或符号链接重命名。在这种情况下,如果newname已存在,则它不能引用一个目录。如果newname已存在,而且不是一个目录,则先将该目录项删除然后将oldname重命名为newname。对包含oldname的目录以及包含newname的目录,调用进程必须具有写权限,因为将更改这两个目录。

如若oldname指的是一个目录,那么为该目录重命名。如果newname已存在,则它必须引用一个目录,而且该目录应当是空目录。如果newname存在(而且是一个空目录),则先将其剩除,然后将oldname重命名为newname。另外,当为一个目录重命名时,newname不能包含oldname作为其路径前缀。例如,不能将/usr/foo重命名为/usr/foo/testdir,因为旧名字(/usr/foo)是新名字的路径前缀,因而不能将其删除。

如着oldname成newname引用符号链接,则处理的是符号链接本身,而不是它所引用的文件。

不能对.和..重命名。更确切地说, .和..都不能出现在oldname和newname的最后部分。

作为一个特例,如果oldname和newname引用同一文件,则函数不做任何更改而成功返回。

如若newname已经存在,则调用进程对它需要有写权限(如同剧除情况一样)。另外,调用进程将删除oldname目录项,并可能要创建newname目录项,所以它需要对包含oldname及包含newname的目录具有写和执行权限。

除了当oldname或newname指向相对路径名时,其他情况下renameat函数与rename函数功能相同,如果oldhame参数指定了相对路径,就相对于oldfd参数引用的目录来计算oldname。类似地,如果newname指定了相对路径,就相对于newfd引用的目录来计算newname。oldfd或newfd参数(或两者)都能设置成AT_FDCWD,此时相对于当前目录来计算相应的路径名。

符号链接 符号链接是对一个文件的间接指针,硬链接直接指向文件的i节点。引入符号链接的原因是为了避开硬链接的限制:

硬链接通常要求链接和文件位于同一文件系统中,

只有超级用户才能创建指向目录的硬链接(在底层文件系统支持的情况下)。

对符号链接以及它指向何种对象并无任何文件系统限制,任何用户都可以创建指向目录的符号链接。符号链接一般用于将一个文件或整个目录结构移到系统中另一个位置。当使用以名字引用文件的函数时,应当了解该函数是否处理符号链接。也就是该函数是否跟随符号链接到达它所链接的文件。如若该函数具有处理符号链接的功能,则其路径名参数引用由符号链接指向的文件。否则,一个路径名参数引用链接本身,而不是由该链接指向的文件。

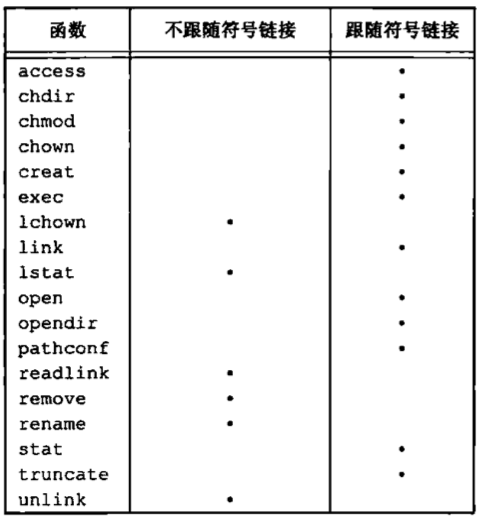

下表列出了本章中所说明的各个函数是否处理符号链接。在表中没有列出mkdir、mkinfo、mknod和rmdir这些函数,其原因是,当路径名是符号链接时,它们都出错返回。以文件描述符作为参数的一些函数(如fstat、fchmod等)也未在该表中列出,其原因是,对符号链接的处理是由返回文件描述符的函数(通常是open)进行的。chown是否跟随符号链接取决于实现。

上表的一个例外是,同时用O_CREAT和O_EXCL两者调用open函数。在此情况下,若路径名引用符号链接,open将出错返回,errno设置为EEXIST,这种处理方式的意图是堵寨一个安全性漏洞,以防止具有特权的进程被诱骗写错误的文件。

使用符号链接可能在文件系统中引入循环。大多数查找路径名的函数在这种情况发生时都将出错返回,errno值为ELOOP。

用open打开文件时,如果传递给open函数的路径名指定了一个符号链接,那么open跟随此链接到达所指定的文件。若此符号链接所指向的文件并不存在,则open返回出错,表示它不能打开该文件。这可能会使不熟悉符号链接的用户感到迷惑,例如:1 2 3 4 5 6 7 8 $ ln -s /no/such/file myfile $ ls myfile myfile $ cat myfile cat : myfile: No such tile or directory$ ls -l myfile lrwxrwxrwx 1 sar 13 Jan 22 00:26 myfile -> /no/such/file

文件myfile存在,但cat却称没有这一文件。其原因是myfile是个符号链接,由该符号链接所指向的文件并不存在。ls命令的-l选项给我们两个提示:第一个字符是l,它表示这是一个符号链接,而->也表明这是一个符号链接。ls命令还有另一个选项-F,它会在符号链接的文件名后加一个@符号,在未使用-l选项时,这可以帮助我们识别出符号链接。

创建和读取符号链接 可以用symlink或symlinkat函数创建一个符号链接。1 2 3 4 #include <unistd.h> int symlink (const char *actualpath, const char *sympath) int symlinkat (const char *actualpath, int fd, const char *sympath)

函数创建了一个指向actualpath的新目录项sympath。在创建此符号链接时,并不要求actualpath已经存在。并且,actualpath和sympath并

symlinkat函数与symlink函数类似,但sympath参数根据相对于打开文件描述符引用的目录(由fd参数指定)进行计算。如果sympath参数指定的是绝对路径或者fd参数设置了AT_FDCWD值,那么symlinkat就等同于symlink函数。

因为open函数跟随符号链接,所以需要有一种方法打开该链接本身,并读该链接中的名字。readlink和readlinkat函数提供了这种功能。1 2 3 4 #include <unistd.b> ssize_t readlink (const char *restriet parhname, char *restrict buf, size_t bufsize) ssize_t readlinkat (int fd, const char * restrict pathrame, char *restrict buf, size_t bufsize)

两个函数组合了open、read和close的所有操作。如果函数成功执行,则返回读入buf的字节数。在buf中返回的符号链接的内容不以null字节终止。当pathname参数指定的是绝对路径名或者fd参数的值为AT_FDCWD,readlinkat函数的行为与readlink相同。但是,如果fd参数是一个打开目录的有效文件描述符并且pathname参数是相对路径名,则readlinkat计算相对于由fd代表的打开目录的路径名。

文件的时间 每个文件属性所保存的实际精度依赖于文件系统的实现。对于把时间戳记录在秒级的文件系统来说,纳秒这个字段就会被填充为0。对于时间戳的记录精度高于秒级的文件系统来说,不足秒的值被转换成纳秒并记录在纳秒这个字段中。对每个文件维护3个时间字段,它们的意义示于表。

字段

说明

例子

ls(l)选项

st_atim

文件数据的最后访问时间

read

-u

st_ntim

文件教据的最后修改时间

write

默认

st_ctim

节点状态的最后更改时间

chmod、chown

-c

注意,修改时间(st_mtim)和状态更改时间(st_ctim)之间的区别。修改时间是文件内容最后一次被修改的时间。状态更改时间是该文件的i节点最后一次被修改的时间。因为i节点中的所有信息都是与文件的实际内容分开存放的,所以,要记录文件数据修改时间和更改i节点中信息的时间。

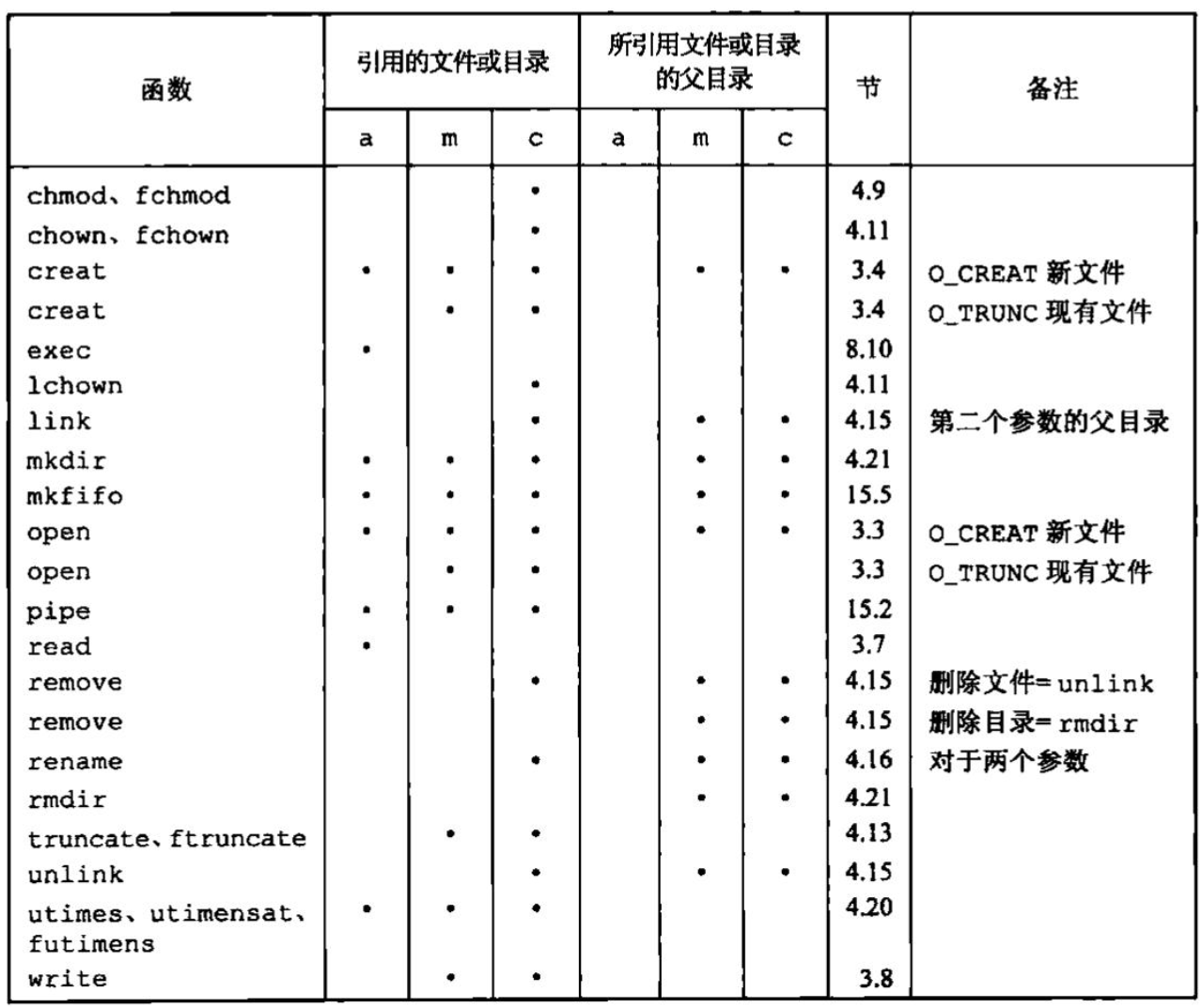

图列出了我们已说明过的各种函数对这3个时间的作用。增加、删除或修改目录项会影响到它所在目录相关的3个时间。这就是在图中包含两列的原因,其中一列是与该文件(或目录)相关的3个时间,另一列是与所引用的文件(或目录)的父目录相关的3个时间。例如,创建一个新文件影响到包含此新文件的目录,也影响该新文件的i节点。但是,读或写一个文件只影响该文件的i节点,而对目录则无影响。

函数futimens、utimensat和utimes 一个文件的访问和修改时间可以用以下几个函数更改。futimens和utimensat函数可以指定纳秒级精度的时间戳。用到的数据结构是与stat函数族相同的timespec结构。1 2 3 4 #include <sys/stat.h> int futimens (int fd, const struct timespec times[2 ]) int utimensat (int fd, const char *path, const struct timespec times[2 ], int flag)

这两个函数的times数组参数的第一个元素包含访问时间,第二元素包含修改时间。这两个时间值是日历时间。不足秒的部分用纳秒表示,时间戳可以按下列4种方式之一进行指定:

如果times参数是一个空指针,则访问时间和修改时间两者都设置为当前时间。

如果times参数指向两个timespec结构的数组,任一数组元素的tv_nsec字段的值为UTIME_NOW,相应的时间戳就设置为当前时间,忽略相应的tv_sec字段。

如果times参数指向两个timespec结构的数组,任一数组元素的tv_nsec字段的值为UTIME_OMIT,相应的时间戳保持不变,忽略相应的tv_sec字段。

如果rimes参数指向两个timespec结构的数组,且tv_nsec字段的值为既不是UTIME_NOW也不是UTIME_OMIT,在这种情况下,相应的时间戳设置为相应的tv_sec和tv_nsec字段的值。

执行这些函数所要求的优先权取决于times参数的值。

如果times是一个空指针,或者任一tv_nsec字段设为UTIME_NOW,则进程的有效用户ID必须等于该文件的所有者ID进程对该文件必须具有写权限,或者进程是一个超级用户进程。

如果times是非空指针,并且任一tv_nsec字段的值既不是UTIME_NOW也不是UTIME_OMIT,则进程的有效用户ID必须等于该文件的所有者ID,或者进程必须是一个超级用户进程。对文件只具有写权限是不够的

如果times是非空指针,并且两个tv_nec字段的值都为UTIME_OMIT,就不执行任何的权限检查

futimens函数需要打开文件来更改它的时间,utimensat函数提供了一种使用文件名更改文件时间的方法。pathname参数是相对于fd参数进行计算的,fd要么是打开目录的文件描述符,要么设置为特殊值AT_FDCWD。如果pathname指定了绝对路径,那么fd参数被忽略,utimensat的flag参数可用于进一步修改默认行为,如果设置了AT_SYMLINK_NOFOLLOW标志,则符号链接本身的时间就会被修改。默认的行为是跟随符号链接,并把文件的时间改成符号链接的时间。

1 2 3 #include <sys/time.h> int utimes (const char *pathname, const struct timeval times[2 ])

utimes函数对路径名进行操作。times参数是指向包含两个时间戳(访问时间和修改时间)元素的数组的指针,两个时间戳是用秒和微妙表示的。1 2 3 4 struct timeval {time_t tv_sec; long tv_usec; };

注意,我们不能对状态更改时间st_ctim(i节点最近被修改的时间)指定一个值,因为调用utimes函数时,此字段会被自动更新。

程序使用带O_TRUNC选项的open函数将文件长度截断为0,但并不更改其访问时间及修改时间。为了做到这一点,首先用stat函数得到这些时间,然后截断文件,最后再用futimens函数重置这两个时间。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 #include "apue.h" #include <fcntl.h> int main (int argc, char *argv[]) int i, fd; struct stat statbuf; struct timespec times[2 ]; for (i = 1 ; i < argc; i++) { if (stat (argv[i], &statbuf) < 0 ) { err_ret ("%s: stat error" , argv[i]); continue ; } if ((fd = open (argv[i], O_RDWR | O_TRUNC)) < 0 ) { err_ret ("%s: open error" , argv[i]); continue ; } times[0 ] = statbuf.st_atin; times[1 ] = statbuf.st_mtim; if (futimens (fd, times) < 0 ) err_ret ("%s: futinens error" , argv[i]); close (fd); } exit (0 ); }

函数mkdir, mkdirat和rmdir 用mkdir和mkdirat函数创建目录,用rmdir函数删除目录。1 2 3 4 #include <ays/stat.h> int mkdir (const char *pathname, mode_t mode) int mkdirat (int fd, const char *pathname, mode_t mode)

这两个函数创建一个新的空目录。其中.和..目录项是自动创建的。所指定的文件访问权限mode由进程的文件模式创建屏蔽字修改。常见的错误是指定与文件相同的mode(只指定读、写权限)。但是,对于目录通常至少要设置一个执行权限位,以允许访问该目录中的文件名。

mkdirat函数与mkdir函数类似。当fd参数具有特殊值AT_FDCWD或者pathname参数指定了绝对路径名时,mkdirat与mkdir完全一样。否则,fd参数是一个打开目录,相对路径名根据此打开目录进行计算。

用rmdir函数可以删除一个空目录。空目录是只包含.和..这两项的目录。1 2 3 #include <unistd.h> int rmdir (const char *pathname)

如果调用此函数使目录的链接计数成为0,并且也没有其他进程打开此目录,则释放由此目录占用的空间。如果在链接计数达到0时,有一个或多个进程打开此目录,则在此函数返回前删除最后一个链接及.和..项。另外,在此目录中不能再创建新文件。但是在最后一个进程关闭它之前并不释放此目录。

读目录 对某个目录具有访问权限的任一用户都可以读该目录,但是,为了防止文件系统产生混乱,只有内核才能写目录。1 2 3 4 5 6 7 8 9 10 11 12 #include <dirent.h> DIR *opendir (const char *pathname) ;DIR *fdopendir (int fd) ;struct dirent *readdir (DIR *dp);void rewinddir (DIR *dp) int closedir (DIR *dp) long telldir (DIR* dp) void seekdir (DIR* dp, long loc)

fdopendir函数提供了一种方法,可以把打开文件描述符转换成目录处理函数需要的DIR结构。定义在头文件<dirent.h>中的dirent结构与实现有关。实现对此结构所做的定义至少包含下列两个成员:1 2 ino_t d_ino; char d_name[];

注意,d_name项的大小并没有指定,但必须保证它能包含至少NAME_MAX个字节(不包含终止null字节)。因为文件名是以null字节结束的,所以在头文件中如何定义数组d_name并无多大关系,数组大小并不表示文件名的长度。

DIR结构是一个内部结构,上述7个函数用这个内部结构保存当前正在被读的目录的有关信息。其作用类似于FILE结构。FILE结构由标准I/O库维护。

opendir执行初始化操作,使第一个readdir返回目录中的第一个目录项。DIR结构由fdopendir创建时,readdir返回的第一项取决于传给fdopendir函数的文件描述符相关联的文件偏移量。注意,目录中各目录项的顺序与实现有关。它们通常并不按字母顾序排列。

我们将使用这些对目录进行操作的例程编写一个遍历文件层次结构的程序,其目的是得到各种类型的文件计数。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 #include "apue.h" #include <dirent.h> #include <limits.h> typedef int Myfunc (const char *, const struct stat *, int ) static Myfunc myfunc;static int myftw (char *, Myfunc *) static int dopath (Myfunc *) static long nreg, ndir, nblk, nchr, nfifo, nslink, nsock, ntot;int main (int argc, char *argv[]) int ret; if (argc != 2 ) err_quit ("usage: ftw <starting-pathname>" ); ret = myftw (argv[1 ], myfunc); ntot = nreg + ndir + nblk + nchr + nfifo + nslink + nsock; if (ntot == 0 ) ntot = 1 ; printf ("regular files = %7ld, %5.2f %%\n" , nreg, nreg*100.0 /ntot); printf ("directories = %7ld, %5.2f %%\n" , ndir, ndir*100.0 /ntot); printf ("block special = %7ld, %5.2f %%\n" , nblk, nblk*100.0 /ntot); printf ("char special = %7ld, %5.2f %%\n" , nchr, nchr*100.0 /ntot); printf ("FIFOs = %7ld, %5.2f %%\n" , nfifo, nfifo*100.0 /ntot); printf ("symbolic links = %7ld, %5.2f %%\n" , nslink, nslink*100.0 /ntot); printf ("sockets = %7ld, %5.2f %%\n" , nsock, nsock*100.0 /ntot); exit (ret); } #define FTW_F 1 #define FTW_D 2 #define FTW_DNR 3 #define FTW_NS 4 static char *fullpath; static size_t pathlen;static int myftw (char *pathname, Myfunc *func){ fullpath = path_alloc (&pathlen); if (pathlen <= strlen (pathname)) { pathlen = strlen (pathname) * 2 ; if ((fullpath = realloc (fullpath, pathlen)) == NULL ) err_sys ("realloc failed" ); } strcpy (fullpath, pathname); return (dopath (func)); } static int dopath (Myfunc* func){ struct stat statbuf; struct dirent *dirp; DIR *dp; int ret, n; if (lstat (fullpath, &statbuf) < 0 ) return (func (fullpath, &statbuf, FTW_NS)); if (S_ISDIR (statbuf.st_mode) == 0 ) return (func (fullpath, &statbuf, FTW_F)); if ((ret = func (fullpath, &statbuf, FTW_D)) != 0 ) return (ret); n = strlen (fullpath); if (n + NAME_MAX + 2 > pathlen) { pathlen *= 2 ; if ((fullpath = realloc (fullpath, pathlen)) == NULL ) err_sys ("realloc failed" ); } fullpath[n++] = '/' ; fullpath[n] = 0 ; if ((dp = opendir (fullpath)) == NULL ) return (func (fullpath, &statbuf, FTW_DNR)); while ((dirp = readdir (dp)) != NULL ) { if (strcmp (dirp->d_name, "." ) == 0 || strcmp (dirp->d_name, ".." ) == 0 ) continue ; strcpy (&fullpath[n], dirp->d_name); if ((ret = dopath (func)) != 0 ) break ; } fullpath[n-1 ] = 0 ; if (closedir (dp) < 0 ) err_ret ("can't close directory %s" , fullpath); return (ret); } static int myfunc (const char *pathname, const struct stat *statptr, int type) switch (type) { case FTW_F: switch (statptr->st_mode & S_IFMT) { case S_IFREG: nreg++; break ; case S_IFBLK: nblk++; break ; case S_IFCHR: nchr++; break ; case S_IFIFO: nfifo++; break ; case S_IFLNK: nslink++; break ; case S_IFSOCK: nsock++; break ; case S_IFDIR: err_dump ("for S_IFDIR for %s" , pathname); } break ; case FTW_D: ndir++; break ; case FTW_DNR: err_ret ("can't read directory %s" , pathname); break ; case FTW_NS: err_ret ("stat error for %s" , pathname); break ; default : err_dump ("unknown type %d for pathname %s" , type, pathname); } return (0 ); }

函数chdir、fchdir和getcwd 每个进程都有一个当前工作目录,此目录是搜索所有相对路径名的起点。当用户登录到UNIX系统时,其当前工作目录通常是口令文件(/etc/passwd)中该用户登录项的第6个字段一用户的起始目录(home directory)。当前工作目录是进程的一个属性,起始目录则是登录名的一个属性。进程调用chdir或fchdir函数可以更改当前工作目录。1 2 3 4 #include <unistd.h> int chdir (const char *pathame) int fchdir (int fd)

在这两个函数中,分别用pathname或打开文件描述符来指定新的当前工作目录。

因为当前工作目录是进程的一个属性,所以它只影响调用chdir的进程本身,而不影响其他进程。1 2 3 4 5 6 7 #include "apue.h" int main (void ) if (chdir ("/tmp" ) < 0 ) err_sys ("chdir failed" ); printe ("chdir to /tmp succeeded\n" ); exit (0 ); }

如果编译图4-23程序,并且调用其可执行目标代码文件mycd,则可以得到下列结果:1 2 3 4 5 6 $ pwd /usr/lib $ mycd chdir to /tmp succeeded$ pwd /usr/lib

从中可以看出,执行mycd命令的shell的当前工作目录并没有改变,这是shell执行程序工作方式的一个副作用。每个程序运行在独立的进程中,shell的当前工作目录并不会随着程序调用chdir而改变。

为了改变shell进程自己的工作目录,shell应当直接调用chdir函数,为此,cd命令内建在shell中,因为内核必须维护当前工作目录的信息,所以我们应能获取其当前值。遗憾的是,内核为每个进程只保存指向该目录v节点的指针等目录本身的信息,并不保存该目录的完整路径名。

函数getcwd从当前工作目录(.)开始,用..找到其上一级目录,然后读其目录项,直到该目录项中的i节点编号与工作目录i节点编号相同,这样地就找到了其对应的文件名,逐层上移,直到遇到根,这样就得到了当前工作目录完整的绝对路径名。1 2 3 #include <unistd.h> char *getcwd (char *buf, size_t size)

必须向此函数传递两个参数,一个是缓冲区地址buf,另一个是缓冲区的长度size(以字节为单位)。该缓冲区必须有足够的长度以容纳绝对路径名再加上一个终止null字节,否则返回出错。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 int main (void ) char *ptr; size_t size; if (chdir ("/usr/spool/uucppublic" ) < 0 ) err_sys ("chdir failed" ); ptr = path_alloc (&size); if (getcwd (ptr, size) == NULL ) err_sys ("getcwd failed" ); printf ("cwd = %s\n" , ptr); exit (0 ); }

在更换工作目录之前,我们可以调用getcwd函数先将其保存起来。在完成了处理后,就可将所保存的原工作目录路径名作为调用参数传送给chdir。fchdir函数向我们提供了一种完成此任务的便捷方法。

在更换到文件系统中的不同位置前,无需调用getcwd函数,而是使用open打开当前工作目录,然后保存其返回的文件描述符。当希望回到原工作目录时,只要简单地将该文件描述符传送给fchdir。

设备特殊文件 st_dev和st_rdev这两个字段经常引起混淆

每个文件系统所在的存储设备都由其主、次设备号表示。设备号所用的数据类型是基本系统数据类型dev_t。主设备号标识设备驱动程序;次设备号标识特定的子设备。

我们通常可以使用两个宏;major和minor来访问主、次设备号,大多数实现都定义这两个宏。这就意味着我们无需关心这两个数是如何存放在dev_t对象中的。

系统中与每个文件名关联的st_dev值是文件系统的设备号,该文件系统包含了这一文件名以及与其对应的i节点。

只有字符特殊文件和块特殊文件才有st_rdev值。此值包含实际设备的设备号。

程序为每个命令行参数打印设备号,另外,若此参数引用的是字符特殊文件或块特殊文件,则还打印该特殊文件的st_rdev值。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 int main (int argc, char *argv[]) int i; struct stat buf; for (i = 1 ; i < argc; i++) { printf ("%s: " , argv[i]); if (stat (argv[i], &buf) < 0 ) { err_ret ("stat error" ); continue ; } printf ("dev = %d/%d" , major (buf.st_dev), minor (buf.st_dev)); if (S_ISCHR (buf.st_mode) || S_ISBLK (buf.st_mode)) { printf (" (%s) rdev = %d/%d" , (S_ISCHR (buf.st_mode)) ? "character" : "block" , major (buf.st_rdev), minor (buf.st_rdev)); } printf ("\n" ); } exit (0 ); }

文件访问权限位小结 我们已经说明了所有文件访问权限位,其中某些位有多种用途。列出了所有这些权限位,以及它们对普通文件和目录文件的作用。最后9个常量还可以分成如下3组:

S_IRWXU = S_IRUSR | S_IWUSR | S_IXUSRS_IRWXG = S_IRGRP | S_IWGRP | S_IXGRPS_IRWXO = S_IROTH | S_IWOTH | S_IXOTH

标准I/O库 流和FILE对象 对于标准I/O库,它们的操作是围绕流(stream)进行的。当用标准I/O库打开或创建一个文件时,我们已使一个流与一个文件相关联。对于ASCII字符集,一个字符用一个字节表示。标准I/O文件流可用于单字节或多字节字符集。流的定向(stream’s orientation)决定了所读、写的字符是单字节还是多字节的。当一个流最初被创建时,它并没有定向。如若在未定向的流上使用一个多字节I/O函数(见<wchar.h>),则将该流的定向设置为宽定向的。若在未定向的流上使用一个单字节I/O函数,则将该流的定向设为字节定向的。只有两个函数可改变流的定向。freopen函数清除一个流的定向;fwide函数可用于设置流的定向。1 2 3 4 #include <stdio.h> #include <wchar.h> int fwide (FILE *fp, int mode)

根据mode参数的不同值,fwide函数执行不同的工作。

如若mode参数值为负,fwide将试图使指定的流是字节定向的。

如若mode参数值为正,fwide将试图使指定的流是宽定向的。

如若mode参数值为0,fwide将不试图设置流的定向,但返回标识该流定向的值。

注意,fwide并不改变已定向流的定向。还应注意的是,fwide无出错返回。

当打开一个流时,标准I/O函数fopen返回一个指向FILE对象的指针。该对象通常是一个结构,它包含了标准I/O库为管理该流需要的所有信息,包括用于实际I/O的文件描述符、指向用于该流缓冲区的指针、缓冲区的长度、当前在缓冲区中的字符数以及出错标志等。应用程序没有必要检验FILE对象。为了引用一个流,需将FILE指针作为参数传递给每个标准I/O函数。在本书中,我们称指向FILE对象的指针(类型为FILE*)为文件指针。

标准输入、标准输出和标准错误 对一个进程预定义了3个流,并且这3个流可以自动地被进程使用,它们是:标准输入 、标准输出 和标准错误 。这些流引用的文件与文件描述符STDIN_FILENO,STDOUT_FILENO和STDERR_FILENO所引用的相同。这3个标准I/O流通过预定义文件指针stdin、stdout和stderr加以引用。这3个文件<stdio.h>中。

缓冲 标准I/O库提供缓冲的目的是尽可能减少使用read和write调用的次数。它也对每个I/O流自动地进行缓冲管理。标准I/O提供了以下3种类型的缓冲:

全缓冲。在这种情况下,在填满标准I/O缓冲区后才进行实际操作。对于驻留在磁盘上的文件通常是由标准I/O库实施全缓冲的。在一个流上执行第一次I/O操作时,相关标准I/O函数通常调用malloc获得需使用的缓冲区,flush说明标准I/O缓冲区的写操作。缓冲区可由标准I/O例程自动flush,或者可以调用函数fflush冲洗一个流。

行缓冲。在这种情况下,当在输入和输出中遇到换行符时,标准I/O库执行I/O操作。这允许我们一次输出一个字符,但只有在写了一行之后才进行实际I/O操作。当流涉及一个终端时(如标准输入和标准输出),通常使用行缓冲。

对于行缓冲有两个限制。第一,因为标准I/O库用来收集每一行的缓冲区的长度是固定的,所以只要填满了缓冲区,那么即使还没有写一个换行符,也进行I/O操作。

第二,任何时候只要通过标准I/O库要求从(a)一个不带缓冲的流,或者(b)一个行缓冲的流得到输入数据,那么就会flush所有行缓冲输出流。很明显,从一个不带缓冲的流中输入需要从内核获得数据。

不带缓冲。标准I/O库不对字符进行缓冲存储。例如,用标准I/O函数fputs写15个字符到不带缓冲的流中,我们就期望这15个字符能立即输出。

标准错误流stderr通常是不带缓冲的,这就使得出错信息可以尽快显示出来,而不管它们是否含有一个换行符。

ISOC要求下列缓冲特征。

当且仅当标准输入和标准输出并不指向交互式设备时,它们才是全缓冲的。

标准错误决不会是全缓冲的。

但是,这并没有告诉我们如果标准输入和标准输出指向交互式设备时,它们是不带缓冲的还是行缓冲的;以及标准错误是不带缓冲的还是行缓冲的。很多系统默认使用下列类型的缓冲:

标准错误是不带缓冲的

若是指向终端设备的流,则是行缓冲的;否则是全缓冲的。

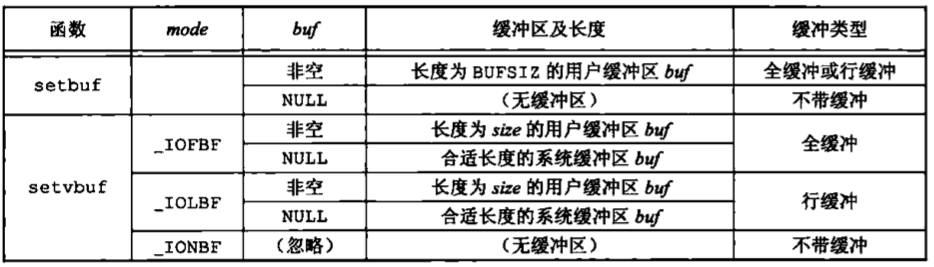

对任何一个给定的流,如果我们并不喜欢这些系统默认,则可调用下列两个函数中的一个更改缓冲类型1 2 3 4 #include <stdio.h> void setbuf (FILE *restrict fp, char *restrict buf) int setvbuf (FILE *restrict fp, char *restrict buf, int mode, size_t site)

这些函数一定要在流已被打开后调用,因为每个函数都要求一个有效的文件指针作为它们的第一个参数,而且也应在对该流执行任何一个其他操作之前调用。

可以使用setbuf函数打开或关闭缓冲机制。为了带缓冲进行I/O,参数buf必须指向一个长度为BUFSIZ的缓冲区(该常量定义在<stdio.h>中)。通常在此之后该流就是全缓冲的,但是如果该流与一个终端设备相关,那么某些系统也可将其设置为行缓冲的。为了关闭缓冲,将buf没置为NULL。

使用setvbuf,我们可以精确地说明所需的缓冲类型。这是用mode参数实现的:

_IOFBF:全缓冲_IOLBF:行缓冲_IONBF:不带缓冲

如果指定一个不带缓冲的流,则忽略buf和size参数。如果指定全缓冲或行缓冲,则buf和size可选择地指定一个缓冲区及其长度。如果该流是带缓冲的,而buf是NULL,则标准I/O库将自动地为该流分配适当长度的缓冲区。适当长度指的是由常量BUFSIZ所指定的值。

图5-1列出了这两个函数的动作,以及它们的各个选项。

要了解,如果在一个函数内分配一个自动变量类的标准I/O缓冲区。则从该函数返回之前,必须关闭该流。另外,其些实现将缓冲区的一部分用于存放它自己的

任何时候,我们都可强制冲洗一个流1 2 3 #include <stdio.h> int fflush (FILE *fp)

此函数使该流所有未写的数据都被传送至内核。作为一种特殊情形,如若fp是NULL,则此函数将导致所有输出流被冲洗。

打开流 下列3个函数打开一个标准I/O流。1 2 3 4 5 #include <stdio.h> FILE *fopen (const char *restrict pathname, const char *restrict type) ;FILE *freopen (const char *restrict pathname, const char *restrict type, FILE *restrict fp) ;FILE *fdopen (int fd, const char *type) ;

这3个函数的区别如下。

fopen函数打开路径名为pathname的一个指定的文件。freopen函数在一个指定的流上打开一个指定的文件,如果该流已经打开,则先关闭该流。若该流已经定向,则使用freopen清除该定向。此函数一般用于将一个指定的文件打开为一个预定义的流:标准输入、标准输出或标准错误。fdopen函数取一个已有的文件描述符(我们可能从open、dup、dup2、fcntl、pipe、socket、socketpair、accept函数得到此文件描述符),并使一个标准的I/O流与该描述符相结合。此函数常用于由创建管道和网络通信通道函数返回的描述符,因为这些特殊类型的文件不能用标准I/O函数fopen打开,所以我们必须先调用设备专用函数以获得一个文件描述符,然后用fdopen使一个标准I/O流与该描述符相结合。

fopen和freopen是ISO C的所属部分。而ISO C并不涉及文件描述符,所以仅有POSIX.1具有fdopen。

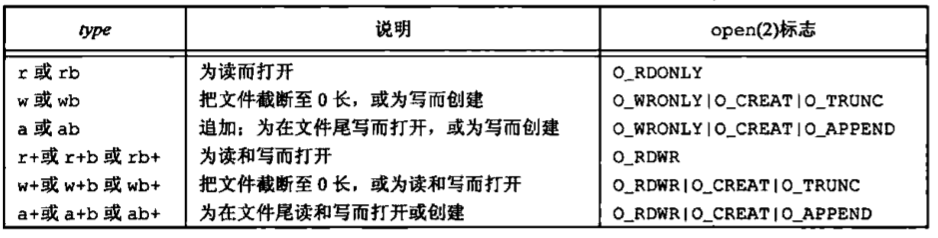

type参数指定对该I/O流的读、写方式,ISO C规定type参数可以有15种不同的值,如表所示。

使用字符b作为type的一部分,这使得标准I/O系统可以区分文本文件和二进制文件。因为UNIX内核并不对这两种文件进行区分,所以在UNIX系统环境下指定字符b作为type的一部分实际上并无作用。

对于fdopen,type参数的意义稍有区别。因为该描述符已被打开,所以fdopen为写而打开并不截断该文件。另外,标准I/O追加写方式也不能用于创建该文件,当用追加写类型打开一个文件后,每次写都将数据写到文件的当前尾端处。如果有多个进程用标准I/O追加写方式打开同一文件,那么来自每个进程的数据都将正确地写到文件中。

在涉及多个进程时,为了正确地支持追加写方式,该文件必须用O_APPEND标志打开。在每次写前,做一次lseek操作同样也不能正确工作。

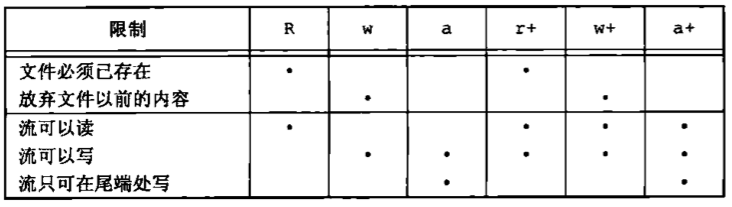

当以读和写类型打开一个文件时(type中+号),具有下列限制。

如果中间没有fflush、fseek、fsetpos或rewind,则在输出的后面不能直接跟随输入。

如果中间没有fseek、fsetpos或rewind,或者一个输入操作没有到达文件尾端,则在输入操作之后不能直接跟随输出。

图中列出了打开一个流的6种不同的方式。

注意,在指定w或a类型创建一个新文件时,我们无法说明该文件的访问权限位。POSIX.I要求实现使用如下的权限位集来创建文件。1 S_IRUSR | S_IWUSR | S_IRGRP | S_IWGRP | S_IROTH | S_IWOTH

除非流引用终端设备,否则按系统默认,流被打开时是全缓冲的。若流引用终端设备,则该流是行缓冲的。一旦打开了流,那么在对该流执行任何操作之前,如果希望,则可使用前节所述的setbuf和setvbuf改变缓冲的类型。

调用fclose关闭一个打开的流1 2 3 #include <stdio.h> int fclose (FILE *fp) ;

在该文件被关闭之前,冲洗缓冲中的输出数据。缓冲区中的任何输入数据被丢弃。如果标准I/O库已经为该流自动分配了一个缓冲区,则释放此缓冲区。当一个进程正常终止时,则所有带未写缓冲数据的标准I/O流都被冲洗,所有打开的标准I/O流都被关闭。

读和写流 一旦打开了流,则可在3种不同类型的非格式化I/O中进行选择,对其进行读、写操作。

每次一个字符的I/O,一次读或写一个字符,如果流是带缓冲的,则标准I/O函数处理所有缓冲。

每次一行的I/O。如果想要一次读或写一行,则使用fgets和fputs。每行都以一个换行符终止。当调用fgets时,应说明能处理的最大行长。

直接I/O。fread和fwrite函数支持这种类型的I/O。每次I/O操作读或写某种数量的对象,而每个对象具有指定的长度。这两个函数常用于从二进制文件中每次读或写一个结构。

直接I/O也被称为:二进制I/O、一次一个对象I/O、面向记录的I/O或面向结构的I/O。

输入函数 以下3个函数可用于一次读一个字符。1 2 3 4 5 #include <stdio.h> int getc (FILE *fp) int fgetc (FILE *fp) int getchar (void )

函数getchar等同于getc(stdin)。前两个函数的区别是,getc可被实现为宏,而fgetc不能实现为宏。这意味着以下几点。

getc的参数不应当是具有副作用的表达式,因为它可能会被计算多次。因为fgetc一定是个函数,所以可以得到其地址。这就允许将fgetc的地址作为一个参数传送给另一个函数。

调用fgetc所需时间很可能比调用getc要长,因为调用函数所需的时间通常长于调用宏。

这3个函数在返回下一个字符时,将其unsigned char类型转换为int类型。说明为无符号的理由是,如果最高位为1也不会使返回值为负。要求整型返回值的理由是,这样就可以返回所有可能的字符值再加。上一个已出错或已到达文件尾端的指示值。在<stdio.h>中的常量EOF被要求是一个负值,其值经常是-1。这就意味着不能将这3个函数的返回值存放在一个字符变量中,以后还要将这些函数的返回值与常量EOF比较。

注意,不管是出错还是到达文件尾端,这3个函数都返回同样的值。为了区分这两种不同的情况,必须调用ferror或feof。1 2 3 4 5 #include <stdio.h> int ferror (FILE *fp) int feof (FILE *fp) void clearerr (FILE *fp) :

在大多数实现中,为每个流在FILE对象中维护了两个标志;

调用clearerr可以清除这两个标志。从流中读取数据以后,可以调用ungetc将字符再压送回流中。1 2 3 #include <stdio.h> int ungete (int c, FILE *fp) ;

压送回到流中的字符以后又可从流中读出,但读出字符的顺序与压送回的顺序相反。不能回送EOF。但是当已经到达文件尾端时,仍可以回送一个字符。下次读将返回该字符,再读则返回EOF。之所以能这样做的原因是,一次成功的ungetc调用会清除该流的文件结束标志。

当正在读一个输入流,并进行某种形式的切词或记号切分操作时,会经常用到回送字符操作。如果标准I/O库不提供回送能力,就需将该字符存放到一个我们自己的变量中,并设置一个标志以便判别在下一次需要一个字符时是调用getc,还是从我们自己的变量中取用这个字符,用ungetc压送回字符时,并没有将它们写到底层文件或设备中,而是将它们写回标准I/O库的波缓冲区中。

输出函数 对应于上面所述的每个输入函数都有一个输出函数。1 2 3 4 5 #include <stdio.h> int putc (int c, FILE *fp) int fputc (int c, FILE *fp) int putchar (int c)

与输入函数一样,putchar(c)等同于putc(c, stdout),putc可被实现为宏,而fputc不能实现为宏。

每次一行I/O 下面两个函数提供每次输入一行的功能。1 2 3 4 #include <stdio.h> char *fgets (char *restrict buf, int n, FILE *restrict fp) :char *gets(char *buf);

这两个函数都指定了缓冲区的地址,读入的行将送入其中。gets从标准输入读,而fgets则从指定的流读。对于fgets,必须指定缓冲的长度n。此函数一直读到下一个换行符为止,但是不超过n-1个字符,读入的字符被送入缓冲区。该缓冲区以null字节结尾。如若该行包括最后一个换行符的字符数超过n-1。则fgets只返回一个不完整的行,但是,缓冲区总是以null字节结尾,对fgets的下一次调用会继续读该行。

gets是一个不推荐使用的函数。其问题是调用者在使用gets时不能指定缓冲区的长度。这样就可能造成缓冲区溢出(如若该行长于缓冲区长度),写到缓冲区之后的存储空间中,从而产生不可预料的后果。gets与fgets的另一个区别是,gets并不将换行符存入缓冲区中。

虽然ISO C要求提供gets,但请使用fgets,而不要使用gets。

fputs和puts提供每次输出一行的功能1 2 3 4 #include <atdio.h> int fputs (const char *restrict str, FILE *restrict fp) int puts (const char *str)

函数puts将一个以null字节终止的字符串写到指定的流,尾端的终止符null不写出。注意,这并不一定是每次输出一行,因为字符串不需要换行符作为最后一个非null字节。通常,在null字节之前是一个换行符,但并不要求总是如此。

puts将一个以null字节终止的字符串写到标准输出,终止符不写出。但是,puts随后又将一个换行符写到标准输出。

标准I/O的效率 下面的程序使用getc和putc将标准输入复制到标准输出。这两个例程可以实现为宏。1 2 3 4 5 6 7 8 9 10 #include "apue.h" int main (void ) { int c; while ((c = getc(stdin )) != EOF) if (putc(c, stdout ) == EOF) err_sys ("output error" ); if (ferror (stdin )) err_sys("input error" ); exit (0 ); }

二进制I/O 提供了下列两个函数以执行二进制I/O操作。1 2 3 4 #include <stdio.h> size_t fread (void *restrict ptr, size_t size, size_t nobj, FILE *restrict fp) ;size_t fwrite (const void *restrict ptr, size_t size, size_t nobj, FILE *restrict fp) ;

这些函数有以下两种常见的用法。

读或写一个二进制数组。例如,为了将一个浮点数组的第2~5个元素写至一文件上,可以编写如下程序:1 2 3 float data[10 ];if (fwrite(&data[2 ], aizeof(float ), 4 , fp) != 4 ) err_sys("fwrite error" );

其中,指定size为每个数组元素的长度,nobj为欲写的元素个数。

读或写一个结构。例如,可以编写如下程序;1 2 3 4 5 6 7 struct { short count; long total; char name[NAMESIZE]; } item; if (fwrite(&item, sizeof (item), 1 , fp) != 1 ) err_sys("fwrite error" );

其中,指定size为结构的长度,nobj为1 (要写的对象个数),将这两个例子结合起来就可读或写一个结构数组。为了做到这一点,size应当是该结构的sizeof,noby应是该数组中的元素个数。

fread和fwrite返回读或写的对象数。对于读,如果出错或到达文件尾端,则此数字可以少于nobj。在这种情况,应调用ferror或feof以判断究竟是那一种情况。对于写,如果返回值少于所要求的nobj,则出错,使用二进制I/O的基本问题是,它只能用于读在同一系统上已写的数据。

当在一个系统上写的数据,要在另一个系统上进行处理时,这两个函数可能就不能正常工作,其原因是:

在一个结构中,同一成员的偏移最可能随编译程序和系统的不同而不同(由于不同的对齐要求)。

某些编译程序使结构中的各成员紧密包装(这可以节省存储空间,而运行性能则可能有所下降);

或者准确对齐(以便在运行时易于存取结构中的各成员)。

这意味着即使在同一个系统上,一个结构的二进制存放方式也可能因编译程序选项的不同而不同。

用来存储多字节整数和浮点值的二进制格式在不同的系统结构间也可能不同。

定位流 有3种方法定位标准I/O流。

ftell和fseek函数。这两个函数都假定文件的位置可以存放在一个长整型中。ftello和fseeko函数。这两个函数使文件偏移量可以不必一定使用长整型。它们使用off_t数据类型代替了长整型。fgetpos和fsetpos函数。这两个函数使用一个抽象数据类型fpos_t记录文件的位置。这种数据类型可以根据需要定义为一个足够大的数,用以记录文件位置。

需要移植到非UNIX系统上运行的应用程序应当使用fgetpos和fsetpos1 2 3 4 5 6 #include <stdio.h> long ftell (FILE *fp) int fseek (FILE *fp, long offset, int whence) void rewind (FILE *fp)

对于一个二进制文件,其文件位置指示器是从文件起始位置开始度量,并以字节为度量单位的。ftell用于二进制文件时,其返回值就是这种字节位置。为了用fseek定位一个二进制文件,必须指定一个字节offset,以及解释这种偏移量的方式。whence的值与lseek函数的相同:SEEK_SET表示从文件的起始位置开始,SEEK_CUR表示从当前文件位置开始,SEEK_END表示从文件的尾端开始。

对于文本文件,它们的文件当前位置可能不以简单的字节偏移量来度量。这主要也是在非UNIX系统中,它们可能以不同的格式存放文本文件。为了定位一个文本文件,whence一定要是SEEK_SET。而且offset只能有两种值,0(后退到文件的起始位置),或是对该文件的ftell所返回的值。使用rewind函数也可将一个流设置到文件的起始位置。

除了偏移量的类型是off_t而非long以外,ftello函数与ftell相同,fseeko函数与fseek相同。1 2 3 4 5 #include <atdio.h> off_t ftello (FILE *fp) int fseeko (FILE *fp, off_t offset, int whence)

实现可将off_t类型定义为长于32位。

fgetpos和fsetpos两个函数是ISO C标准引入的。1 2 3 4 #include <stdio.h> int fgetpos (FILE *restrict fp, fpos_e *restrict pos) int fsetpos (FILE *fp, const fpos_t *pos)

fgetpos将文件位置指示器的当前值存入由pos指向的对象中。在以后调用fsetpos时,可以使用此值将流重新定位至该位置

格式化I/O 格式化输出 格式化输出是由5个printf函数来处理的1 2 3 4 5 6 7 8 9 #include <stdio.h> int printf (const char *restrict format, ...) int fprintf (FILE *restzict fp, const char *restrict format, ...) int dprintf (int fd, const char *restrict format, ...) int sprintf (char *restrict buf, const char *restrict format, ...) int snprintr (char *restrict buf, size_t m, const char *restrict format, ...)

printf将格式化数据写到标准输出,fprintf写至指定的流,dprintf写至指定的文件描述符,sprintf将格式化的字符送入数组buf中。sprintf在该数组的尾端自动加一个null字节,但该字符不包括在返回值中。

注意,sprintf函数可能会造成由buf指向的缓冲区的溢出。为了解决这种缓冲区溢出问题,引入了snprintf函数。在该函数中,缓冲区长度是一个显式参数,超过缓冲区尾的所有字符都被丢弃。如果缓冲区足够大,snprintf函数就会返回写入缓冲区的字符数。与sprintf相同,该返回值不包括结尾的null字节。若snprintf函数返回小于缓冲区长度n的正值,那么没有截断输出。若发生了一个编码的错误,snprintf返回负值。

虽然dprintf不处理文件指针,但我们仍然把它包括在处理格式化输出的函数中。注意,使用dprintf不需要调用fdopen将文件描述符转换为文件指针。

格式说明控制其余参数如何编写,以后又如何显示。每个参数按照转换说明编写,转换说明以百分号%开始,除转换说明外,格式字符串中的其他字符将按原样,不经任何修改被复制输出。转换说明有4个可选择的部分,下面将它们都示于方括号中:1 %[flags] [fldwidth] [precision] [lenmodifier]convtype

标志

说明

‘(撇号)将整数按千位分组字符

-在字段内左对齐输出

+总是显示带符号转换的正负号

(空格)如果第一个字符不是正负号,则在其前面加上一个空格

#指定另一种转换形式(例如。对于十六进制格式,加0x前缀

0添加前号0(而非空格)进行填充

fldwidth说明最小字段宽度。转换后参数字符数若小于宽度,则多余字符位置用空格填充。字段宽度是一个非负十进制数,或是一个星号*。precision说明整型转换后最少输出数字位数、浮点数转换后小数点后的最少位数、 字符串转换后最大字节数。精度是一个点.,其后跟随一个可选的非负十进制数或一个星号*。

宽度和精度字段两者皆可为*。此时,一个整型参数指定宽度或精度的值。该整型参数正好位于被转换的参数之前。lenmodifier说明参数长度。其可能的值示于表中。

长度修饰符

说明

hh

将相应的参数按signed或unsigned char类型输出

h

将相应的参数按signed成unelgned short类型输出

l

将相应的参数按signed或unsigned long或宽字符类型输出

ll

将相应的参数按signed或unsigned long long类型输出

j

intmax_t或uintmax_t

z

size_t

t

ptrdiff_t

L

long double

convtype不是可选的。它控制如何解释参数。下表中列出了各种转换类型字符。

转换类型

说明

d、i

有符号十进制

o

无符号八进制

u

无符号十进制

x、X

无符号十六进制

f、F

双精度浮点数

e、E

指数格式双精度浮点数

g、G

根据转换后的值解释为f、F、e或E

a、A

十六进制指数格式双精度浮点数

c

字符(若带长度修饰符l,为宽字符)

s

字符串(若带长度修饰符l,为宽字符)

p

指向void的指针

n

到目前为止,此printf调用输出的字符的数目将被写入到指针所指向的带符号整型中

%

一个%字符

C

宽字符(XSI扩展,等效于lc)

S

宽字符串(XSI扩展,等效于ls)

下列5种printf族的变体类似于上面的5种,但是可变参数表(…)替换成了arg。1 2 3 4 5 6 7 8 9 10 #include <stdarg.h> #include <atdio.h> int vprintf (const char *restrict format, va_list arg) ;int vfprintf (FILE *restrict fp, const char *restrict format, va_list arg) ;int vdprintf (int fd, const char *restrict format, va_list arg) ;int vsprintf (char *restrict buf, const char *restrict format, va_list arg) ;int vsnprintf (char *restrict buf, size_t m, const char *restrict format, va_list arg) ;

格式化输入 执行格式化输入处理的是3个scanf函数。1 2 3 4 5 #include <stdio.h> int scanf (const char *restrict format, ...) ;int fscanf (FILE *restrict fp, const char *restrict format, ...) ;int sscanf (const char *restrict buf, const char *restrict format, ...) ;

scanf族用于分析输入字符串,并将字符序列转换成指定类型的变量。在格式之后的各参数包含了变量的地址,用转换结果对这些变量赋值。

格式说明控制如何转换参数,以便对它们赋值。转换说明以*字符开始。除转换说明和空白字符外,格式字符串中的其他字符必须与输入匹配。若有一个字符不匹配,则停止后续处理,不再读输入的其余部分。

一个转换说明有3个可选择的部分,下面将它们都示于方括号中:1 %[*| [fldwidth] [m] [lenmodifier)convtype

可选择的星号*用于抑制转换。按照转换说明的其余部分对输入进行转换,但转换结果并不存放在参数中。

fldwidth说明最大宽度(即最大字符数)。lenmodifier说明要用转换结果赋值的参数大小。由printf函数族支持的长度修饰符同样得到scanf族函数的支持。

convtype字段类似于printf族的转换类型字段,但两者之间还有些差别。一个差别是,作为一种选项,输入中带符号的可赋予无符号类型。例如,输入流中的-1可被转换成4294967295赋予无符号整型变量。

在字段宽度和长度修饰符之间的可选项m是赋值分配符。它可以用于%c、%s以及%[转换符,迫使内存缓冲区分配空间以接纳转换字符串。在这种情况下,相关的参数必须是指针地址,分配的缓冲区地址必须复制给该指针。如果调用成功,该缓冲区不再使用时,由调用者负责通过调用free函数来释放该缓冲区。

与printf族相同,scanf族也使用由<stdarg.h>说明的可变长度参数表。1 2 3 4 5 6 #include <stdarg.h> #include <stdio.h> int vscanf (const char *restrict format, va_list arg) ;int vfscant (FILE *restrict fp, const char *restrict format, va_list arg) ;int vsscanf (const char *restrict buf, const char *restrict format, va_list arg) ;

实现细节 在UNIX中,标准I/O库最终都要调用第3章中说明的I/O例程,每个标准I/O流都有一个与其相关联的文件描述符,可以对一个流调用fileno函数以获得其描述符。1 2 3 #include <stdio.h> int fileno (FILE *fp) ;

如果要调用dup或fcntl等函数,则需要此函数。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 #include "apue.h" void pr_stdio (const char *, FILE *) ;int is_unbuffered (FILE *) ;int is_linebuffered (FILE *) ;int buffer_size (FILE *) ;int main (void ) { FILE *fp; fputs ("enter any character\n" , stdout ); if (getchar() == EOF) err_sys("getchar error" ); fputs ("one line to standard error\n" , stderr ); pr_stdio("stdin" , stdin ); pr_stdio("stdout" , stdout ); pr_stdio("stderr" , stderr ); if ((fp = fopen("/etc/passwd" , "r" )) == NULL ) err_sys("fopen error" ); if (getc(fp) == EOF) err_sys("getc error" ); pr_stdio("/etc/passwd" , fp); exit (0 ); } void pr_stdio (const char *name, FILE *fp) { printf ("stream = %s, " , name); if (is_unbuffered(fp)) printf ("unbuffered" ); else if (is_linebuffered(fp)) printf ("line buffered" ); else printf ("fully buffered" ); printf (", buffer size = %d\n" , buffer_size(fp)); } #if defined(_IO_UNBUFFERED) int is_unbuffered (FILE *fp) { return (fp->_flags & _IO_UNBUFFERED); } int is_linebuffered (FILE *fp) { return (fp->_flags & _IO_LINE_BUF); } int buffer_size (FILE *fp) { return (fp->_IO_buf_end - fp->_IO_buf_base); } #elif defined(__SNBF) int is_unbuffered (FILE *fp) { return (fp->_flags & __SNBF); } int is_linebuffered (FILE *fp) { return (fp->_flags & __SLBF); } int buffer_size (FILE *fp) { return (fp->_bf._size); } #elif defined(_IONBF) #ifdef _LP64 #define _flag __pad[4] #define _ptr __pad[1] #define _base __pad[2] #endif int is_unbuffered (FILE *fp) { return (fp->_flag & _IONBF); } int is_linebuffered (FILE *fp) { return (fp->_flag & _IOLBF); } int buffer_size (FILE *fp) { #ifdef _LP64 return (fp->_base - fp->_ptr); #else return (BUFSIZ); #endif } #else #error unknown stdio implementation! #endif

注意,在打印缓冲状态信息之前,先对每个流执行I/O操作,第一个I/O操作通常就造成为该流分配缓冲区。

如果运行程序两次,一次使3个标准流与终端相连接,另一次使它们重定向到普通文件,则所得结果是:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 $ ./a.out enter any character one line to standard error stream = stdin, line buffered, buffer size = 1024 stream = atdout, line buffered, butter size = 1024 stream = stderr, unbuffered, buffer size = 1 stream = /etc/passwd, fully butfered, buffer 8120 = 4096 $ ./a.out < /etc/group > std.out 2> atd.ext $ cat std.err one line to standard error $ cat std.out enter any character stream = stdin, fully buffered, buffer size = 4096 stream = stdout, fully buffered, buffer size = 4096 strean = stderr, unbuffered, buffer size = 1 stream = /etc/passwd, fully buffered, buffer size = 4096

从中可见,该系统的默认是:当标准输入、输出连至终端时,它们是行缓冲的。行缓冲的长度是1024字节。注意,这并没有将输入、输出的行长限制为1024字节,这只是缓冲区的长度。如果要将2048字节的行写到标准输出,则要进行两次write系统调用。当将这两个流重新定向到普通文件时,它们就变成是全缓冲的,其缓冲区长度是该文件系统优先选用的I/O长度(从stat结构中得到的st_blksize值)。从中也可看到,标准错误如它所应该的那样是不带缓冲的,而普通文件按系统默认是全缓冲的。

临时文件 ISO C标准I/O库提供了两个函数以帮助创建临时文件。1 2 3 4 5 #include <stdio.h> char *tmpnam (char *ptr) ;FILE *tmptile (void ) ;

tmpnam函数产生一个与现有文件名不同的一个有效路径名字符串。每次调用它时,都产生一个不同的路径名,最多调用次数是TMP_MAX。TMP_MAX定义在<stdio.h>中。虽然ISO C定义了TMP_MAX,但该标准只要求其值至少应为25。

若ptr是NULL,则所产生的路径名存放在一个静态区中,指向该静态区的指针作为函数值返回。后续调用tmpnam时,会重写该静态区(这意味着,如果我们调用此函数多次,而且想保存路径名,则我们应当保存该路径名的副本,而不是指针的副本)。如若ptr不是NULL,则认为它应该是指向长度至少是L_tmpnam个字符的数组(常量L_tmpnam定义在头文件<stdio.h>中)。所产生的路径名存放在该数组中,pr也作为函数值返回。

tmpfile创建一个临时二进制文件(类型wb+),在关闭该文件或程序结束时将自动删除这种文件。注意,UNIX对二进制文件不进行特殊区分。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 #include "apue.h" int main (void ) { char name[L_tmpnam], line[MAX_LINE]; FILE *fp; printf ("%s\n" , tmpnam(NULL ) ); tmpnam(name); printf ("%s\n" , name); if ((fp = tmpfile()) == NULL ) err_sys("tmpfile error" ); fputs ("one line of outputin" , fp); rewind(tp); if (fgets(line, sizeof (line), fp) == NULL ) err_sys ("fgets error" ); fputs (line, stdout ); exit (0 ); }

tmpfile函数经常使用的标准UNIX技术是先调用tmpnam产生一个唯一的路径名,然后,用该路径名创建一个文件,并立即unlink它。对一个文件解除链接并不删除其内容,关闭该文件时才删除其内容。而关闭文件可以是显式的,也可以在程序终止时自动进行。

Single UNIX Specification为处理临时文件定义了另外两个函数: mkdtemp和mkstemp,它们是XSI的扩展部分。1 2 3 4 5 #include <atd11b.h> char *mkdtemp (char *template) ;int mkstemp (char *template) ;

mkdtemp函数创建了一个目录,该目录有一个唯一的名字;mkstemp函数创建了一个文件,该文件有一个唯一的名字。名字是通过template字符串进行选择的。这个字符串是后6位设置为xxxxxx的路径名。函数将这些占位符替换成不同的字符来构建一个唯一的路径名。如果成功的话,这两个函数将修改template字符串反映临时文件的名字。

由mkdtemp函数创建的目录使用下列访问权限位集:S_IRUSR | S_IWUSR | S_IXUSR。注意,调用进程的文件模式创建屏蔽字可以进一步限制这些权限。如果目录创建成功,mkdtemp返回新目录的名字。

mkstemp函数以唯一的名字创建一个普通文件并,且打开该文件,该函数返回的文件描述符以读写方式打开。由mkstemp创建的文件使用访问权限位S_IRUSR | S_IWUSR。与temptile不同,mkstemp创建的临时文件并不会自动删除。如果希望从文件系统命名空间中删除该文件,必须自己对它解除链接。

使用tmpnam和tempnam至少有一个缺点:在返回唯一的路径名和用该名字创建文件之间存在一个时间窗口,在这个时间窗口中,另一进程可以用相间的名字创建文件。因此应该使用tmpfile和mkstemp函数,因为它们不存在这个问题。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 #include "apue.h" #include <errno.h> void make_temp (char *template) ;int main () { char good_template[] = "/tmp/dirXXXXXX" ; char *bad_template = "/tmp/dirXXXXXX" ; printf ("trying to create first temp file...\n" ); make_temp(good_template); printf ("trying to create second temp file...\n" ); make_temp(bad_template); exit (0 ); } void make_temp (char *template) { int fd; struct stat sbuf ; if ((fd = mkstemp(template)) < 0 ) err_sys("can't create temp file" ); printf ("temp name = %s\n" , template); close(fd); if (stat(template, &sbuf) < 0 ) { if (errno == ENOENT) printf ("file doesn't exist\n" ); else err_sys("stat failed" ); } else { printf ("file exists\n" ); unlink(template); } }

运行程序,得到:1 2 3 4 5 6 $ ./a.out trying to create tirmt temp file... temp name = /tmp/dirUmBT7h file exists trying to create second temp file.. Segmentation fault

两个模板字符串声明方式的不同带来了不同的运行结果。对于第一个模板,因为使用了数组,名字是在栈上分配的。但第二种情况使用的是指针,在这种情况下,只有指针自身驻留在栈上。编译器把字符串存放在可执行文件的只读段,当mkstemp函数试图修改字符申时,出现了段错误。

内存流 我们已经看到,标准I/O库把数据缓存在内存中,因此每次一字符和每次一行的I/O更有效。我们也可以通过调用setbuf或setvbuf函数让I/O库使用我们自己的缓冲区。在SUSv4中支持了内存流。这就是标准I/O流,虽然仍使用FILE指针进行访问,但其实并没有底层文件。所有的I/O都是通过在缓冲区与主存之间来回传送字节来完成的。即便这些流看起来像文件流,它们的某些特征使其更适用于字符串操作。

有3个函数可用于内存流的创建,第一个是fmemopen函数。1 2 3 #include <stdio.h> FILE *fmemopen (void *restrict buf, size_t size, const char *restrict type) ;

fmemopen函数允许调用者提供缓冲区用于内存流:buf参数指向缓冲区的开始位置,size参数指定了缓冲区大小的字节数。如果buf参数为空, fmemopen函数分配size字节数的缓冲区。在这种情况下,当流关闭时缓冲区会被释放。

type参数控制如何使用流。type可能的取值如表。

type

说明

r或rb

为读而打开

w或wb

为写而打开

a或ab

追加:为在第一个null字节处写而打开

r+或r+b或rb+

为读和写打开

w+或w+b或wb+

把文件截断至0长,为读和写而打开

a+或a+b或ab+