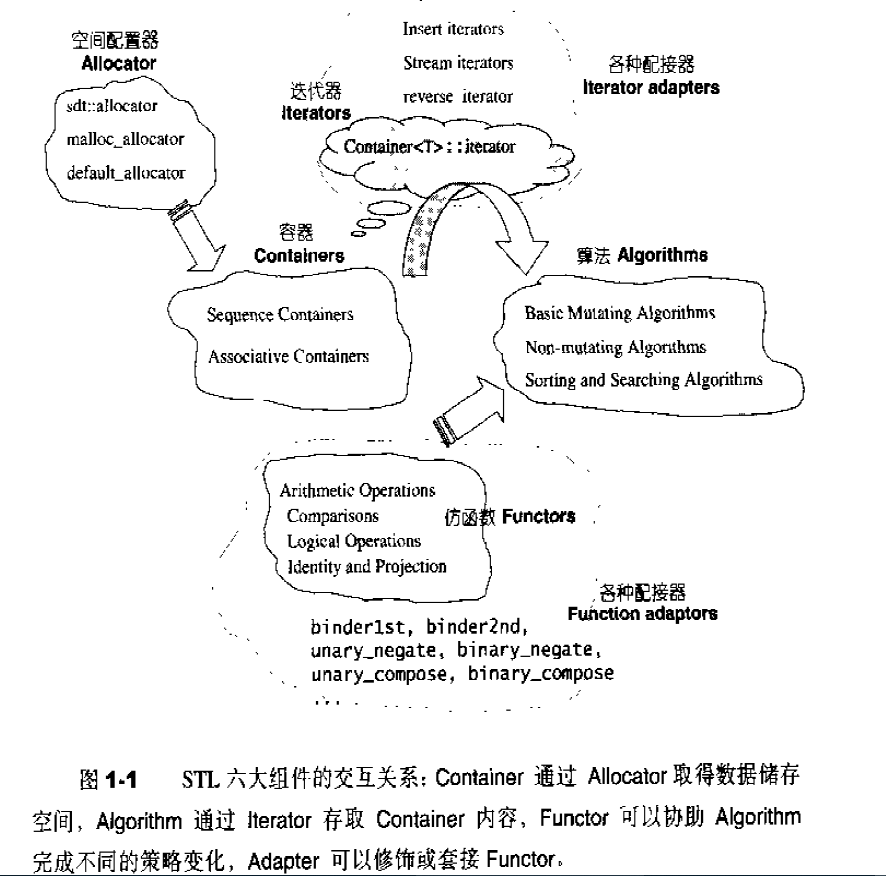

第一章:STL概论和版本简介 STL六大组件

容器:各种数据结构,如:vector、list、deque、set、map、主要用来存放数据。

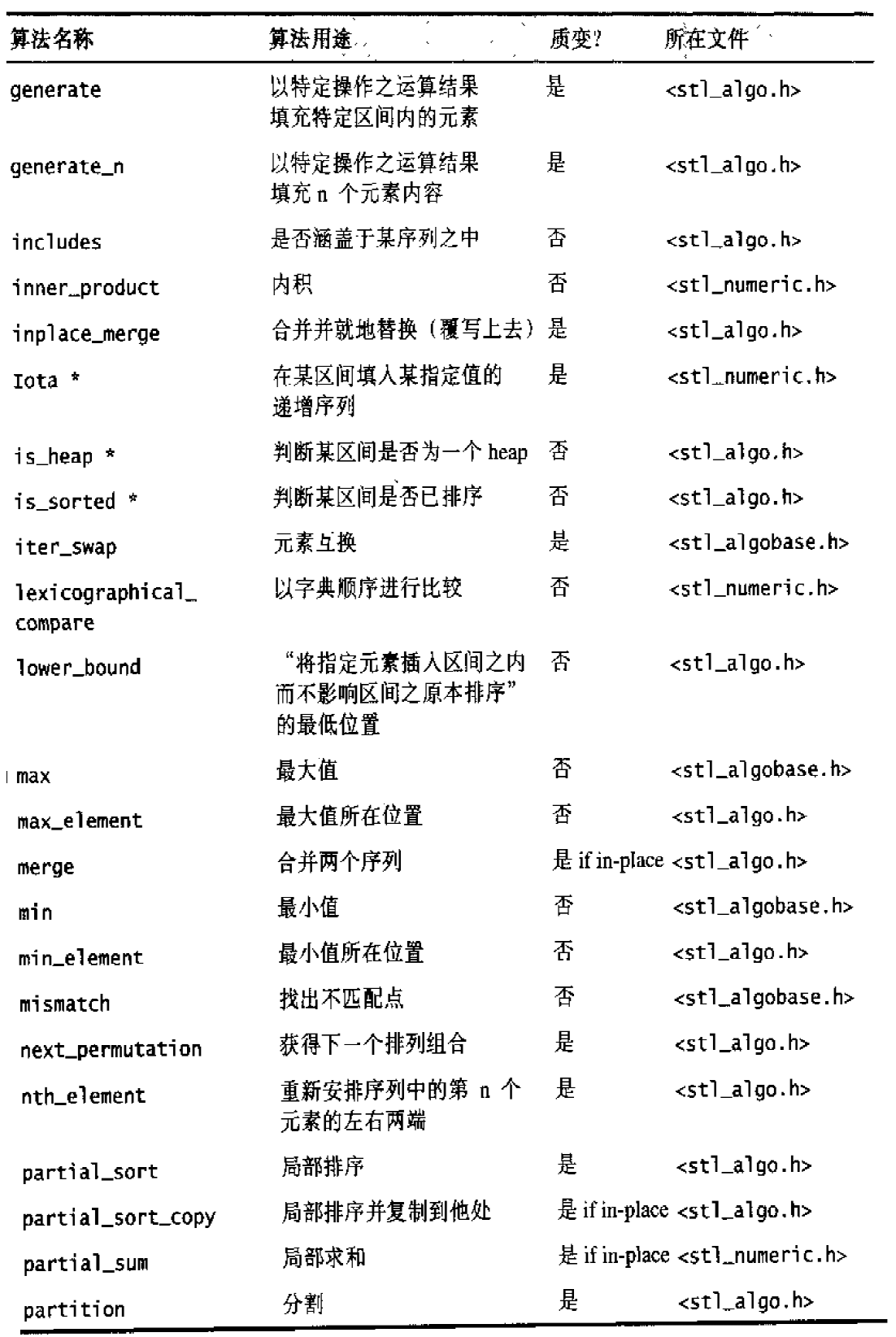

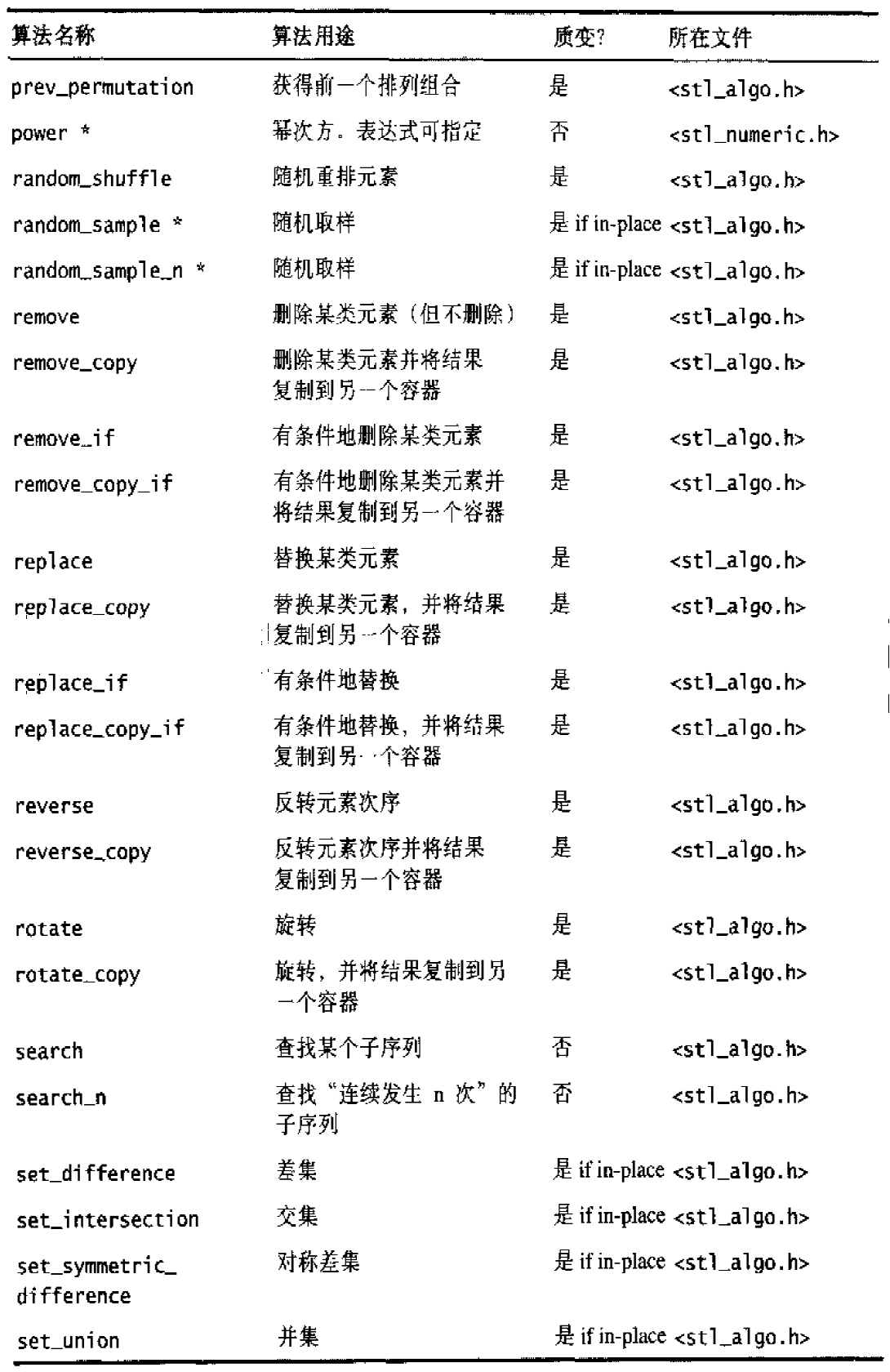

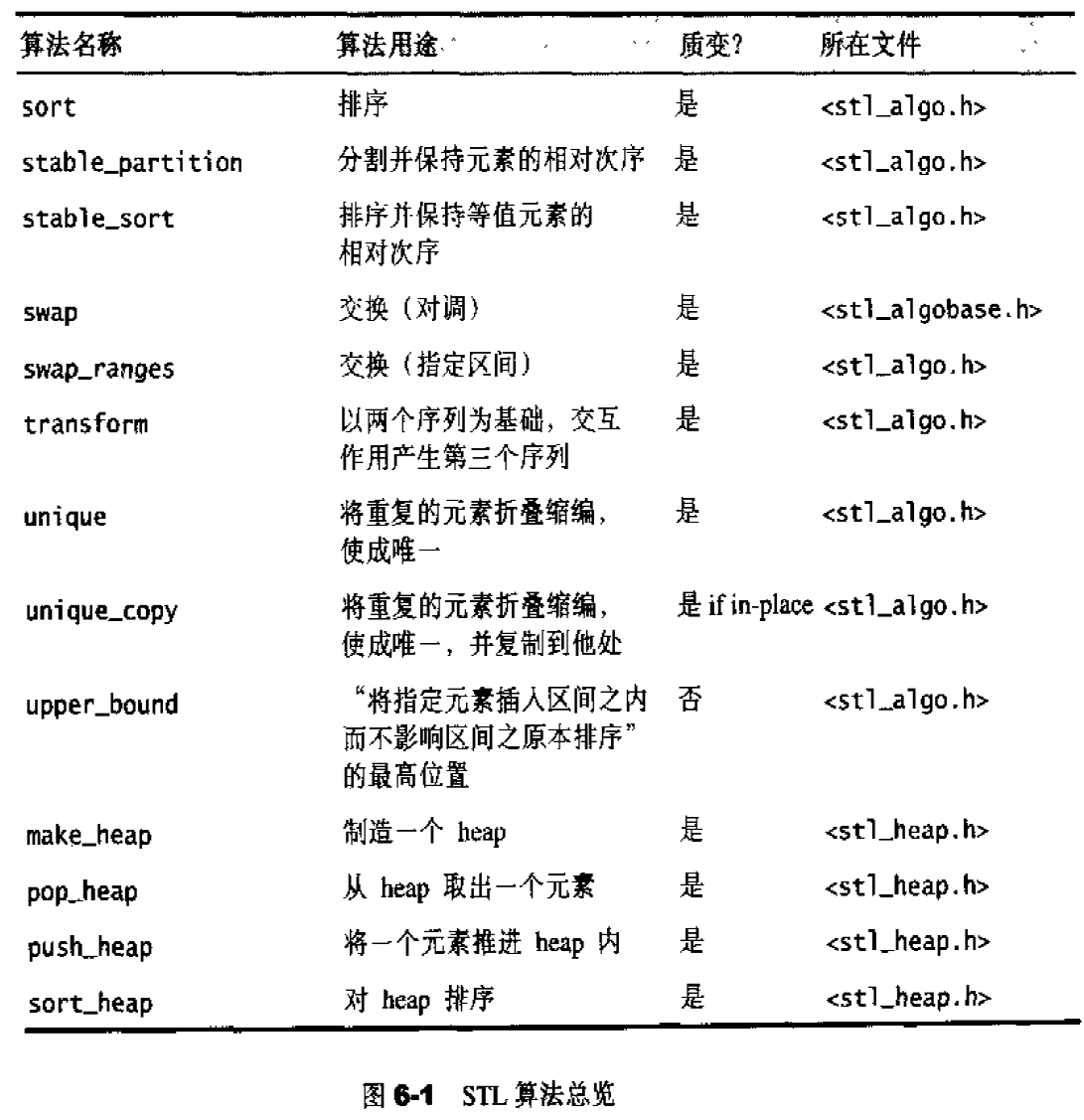

算法:各种常见算法,如:sort、search、copy、erase

迭代器:扮演算法和容器中的中介。迭代器是一种将operator*、operator->、operator++、operator--等指针相关操作予以重载的class template。所有的容器均有自己独特的迭代器,实现对容器内数据的访问

仿函数:行为类似函数,可作为算法的某种策略。仿函数是一种重载了operator()的class或class template。一般指针函数可视为狭义的仿函数。

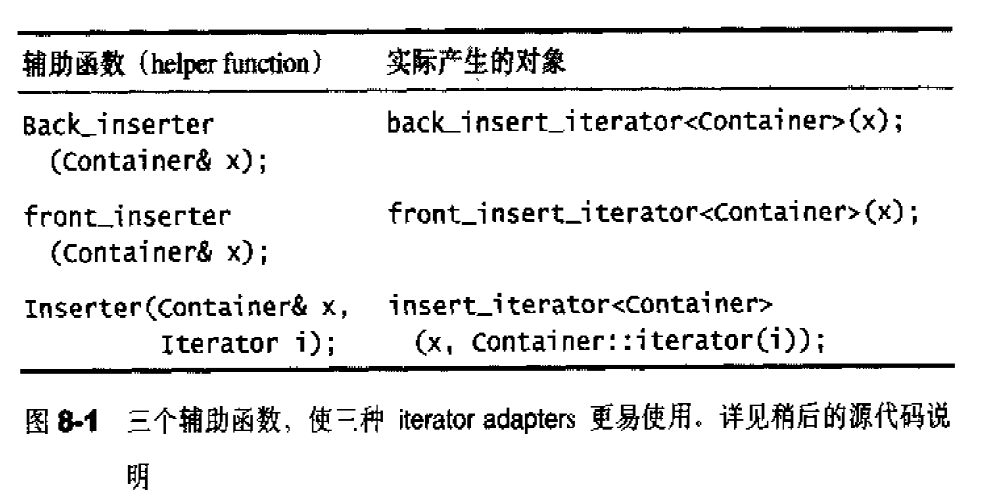

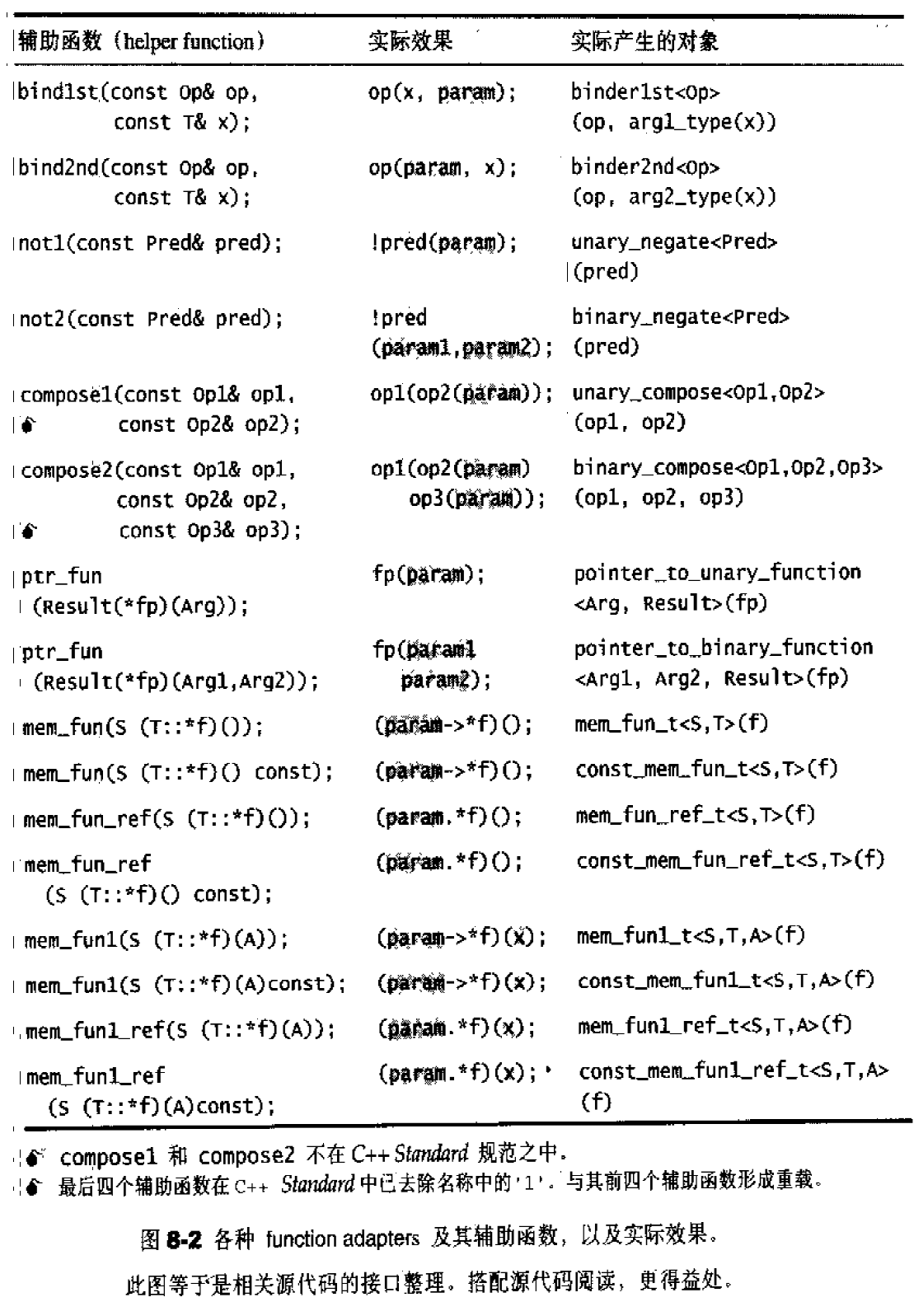

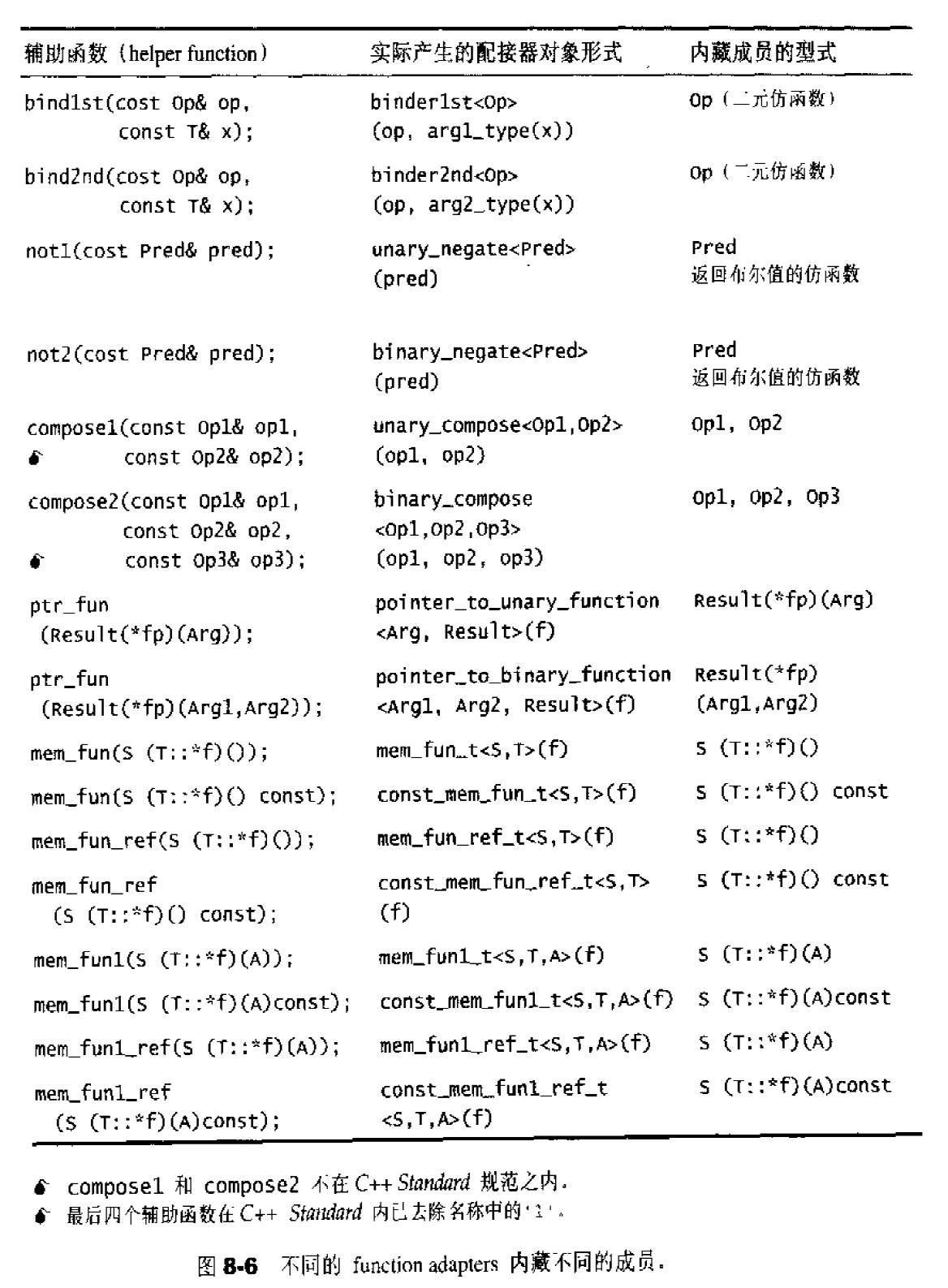

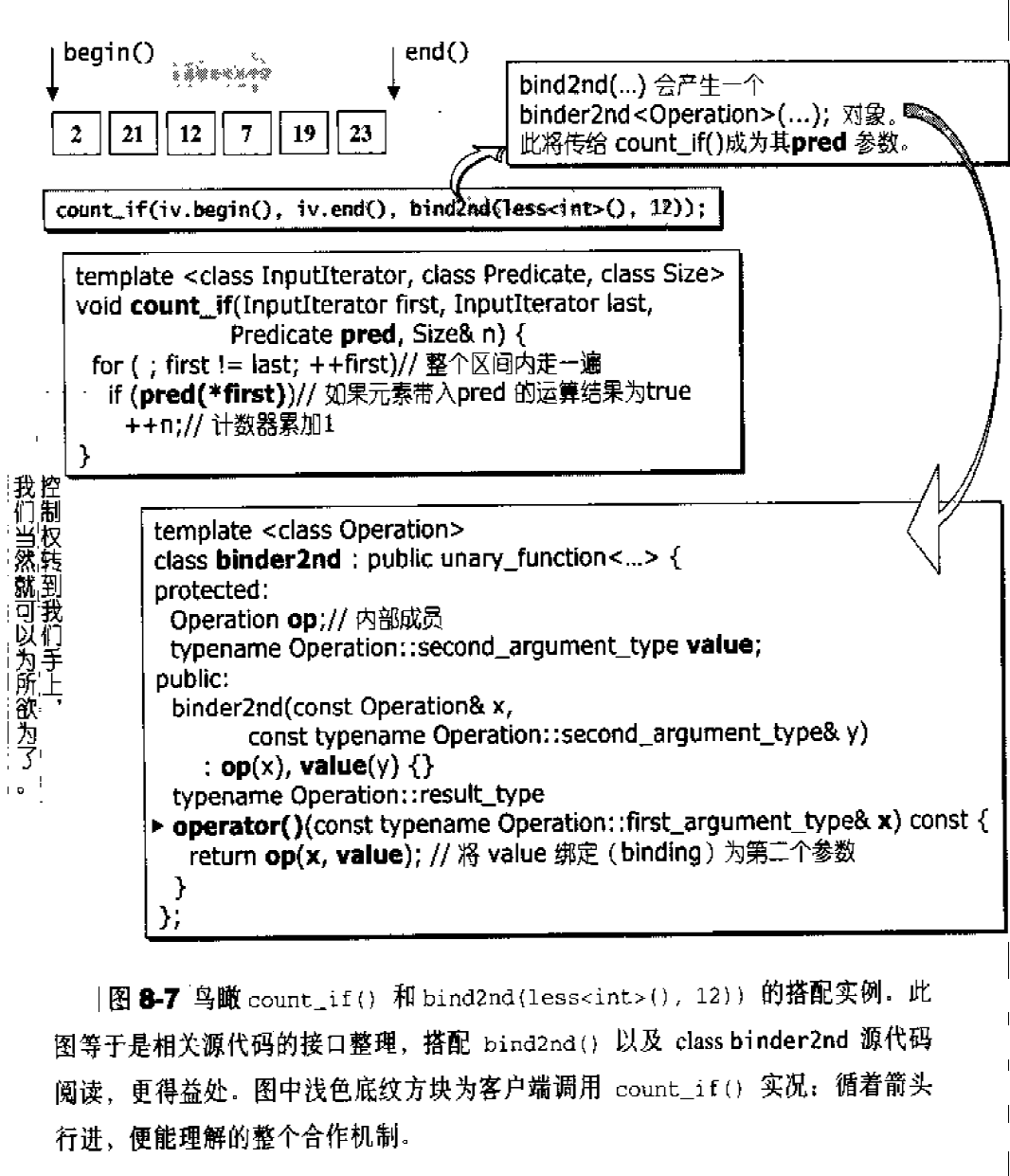

配接器(adapters): 修饰容器、仿函数、迭代器接口。例如STL提供的queue和stack,虽然看似容器,但是只能算一种容器配接器,因为它们的底部完全借助deque,所有操作都由底层的deque供应。

配置器(allocators):负责空间配置和管理,配置器是一个实现了动态空间配置、空间管理、空间释放的class template.

各组件间的关系

由于STL已成为C++标准程序库的大脉系,因此:目前所有的C++编译器一定支持有一份STL。STL并非以二进制代码面貌出现,而是以源代码面貌供应。某些STL版本同时存在具扩展名和无扩展名的两份文件,例如Visual C++的版本同时具备<vectorr.h>和<vector>。某些STL版本只存在具扩展名的头文件,例如C++ Builder的RaugeWave版本只有<vector.h>。某些STL版本不仅有一线装配,还有二线装配,例如GNU C++的SGI版本不但有一线的<vector.h>和<vector>,还有二线的<stl_vector.h>。

Container通过Allocator取得数据储存空间,Algorithm通过Iterator存取Container内容,Functor可以协助Algorithm完成不同的策略变化,Adapter可以修饰或套接Functor。

SGI STL头文件分布

C++标准规范下的C头文件:cstdio,csyflib,cstring,…

C++标准程序库中不属于STL范畴者:stream,string,…

STL标准头文件(无扩展名):vector,deque,list,map,…

C++标准定案前,HP所规范的STL头文件:vector.h,deque.h,list.h,…

SGI STL内部文件(STL真正实现与此):stl_vector.h,stl_deque.h,stl_algo.h,…

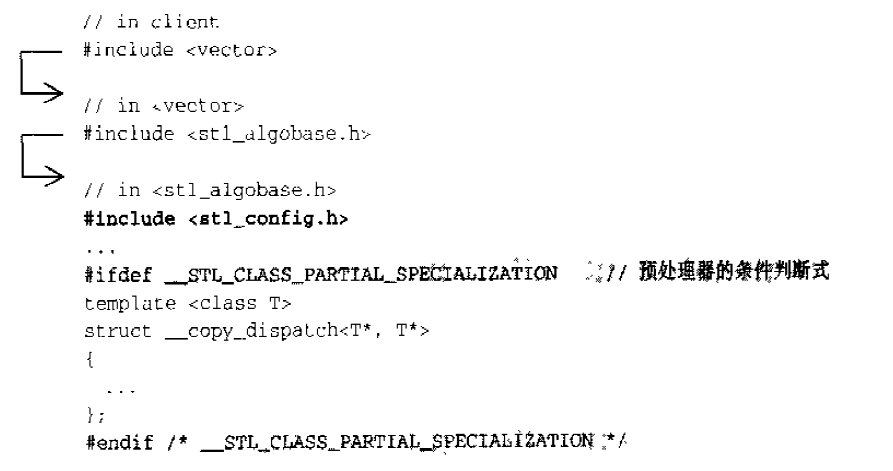

不同的编译器对C++语言的支持程度不尽相同。作为一个希望具备广泛移植能力的程序库,SGI STL准备了一个环境组态文件<stl_config.h>,其中定义了许多常量,标示某些组态的成立与否,所有STL头文件都会直接或间接包含这个组态文件,并以条件式写法,让预处理器根据各个常量决定取舍哪一段程序代码,例如:

<stl_config.h>文件起始处有一份常量定义说明,针对各家不同的编译器及可能的版本给予常量设定。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 227 228 229 230 231 232 233 234 235 236 237 238 239 240 241 242 243 244 245 246 #ifndef __STL_CONFIG_H #define __STL_CONFIG_H #ifdef _PTHREADS # define __STL_PTHREADS #endif # if defined(__sgi) && !defined(__GNUC__) # if !defined(_BOOL) # define __STL_NEED_BOOL # endif # if !defined(_TYPENAME_IS_KEYWORD) # define __STL_NEED_TYPENAME # endif # ifdef _PARTIAL_SPECIALIZATION_OF_CLASS_TEMPLATES # define __STL_CLASS_PARTIAL_SPECIALIZATION # endif # ifdef _MEMBER_TEMPLATES # define __STL_MEMBER_TEMPLATES # endif # if !defined(_EXPLICIT_IS_KEYWORD) # define __STL_NEED_EXPLICIT # endif # ifdef __EXCEPTIONS # define __STL_USE_EXCEPTIONS # endif # if (_COMPILER_VERSION >= 721) && defined(_NAMESPACES) # define __STL_USE_NAMESPACES # endif # if !defined(_NOTHREADS) && !defined(__STL_PTHREADS) # define __STL_SGI_THREADS # endif # endif # ifdef __GNUC__ # include <_G_config.h> # if __GNUC__ < 2 || (__GNUC__ == 2 && __GNUC_MINOR__ < 8) # define __STL_STATIC_TEMPLATE_MEMBER_BUG # define __STL_NEED_TYPENAME # define __STL_NEED_EXPLICIT # else # define __STL_CLASS_PARTIAL_SPECIALIZATION # define __STL_FUNCTION_TMPL_PARTIAL_ORDER # define __STL_EXPLICIT_FUNCTION_TMPL_ARGS # define __STL_MEMBER_TEMPLATES # endif # if !defined(_NOTHREADS) && __GLIBC__ >= 2 && defined(_G_USING_THUNKS) # define __STL_PTHREADS # endif # ifdef __EXCEPTIONS # define __STL_USE_EXCEPTIONS # endif # endif # if defined(__SUNPRO_CC) # define __STL_NEED_BOOL # define __STL_NEED_TYPENAME # define __STL_NEED_EXPLICIT # define __STL_USE_EXCEPTIONS # endif # if defined(__COMO__) # define __STL_MEMBER_TEMPLATES # define __STL_CLASS_PARTIAL_SPECIALIZATION # define __STL_USE_EXCEPTIONS # define __STL_USE_NAMESPACES # endif # if defined(_MSC_VER) # if _MSC_VER > 1000 # include <yvals.h> # else # define __STL_NEED_BOOL # endif # define __STL_NO_DRAND48 # define __STL_NEED_TYPENAME # if _MSC_VER < 1100 # define __STL_NEED_EXPLICIT # endif # define __STL_NON_TYPE_TMPL_PARAM_BUG # define __SGI_STL_NO_ARROW_OPERATOR # ifdef _CPPUNWIND # define __STL_USE_EXCEPTIONS # endif # ifdef _MT # define __STL_WIN32THREADS # endif # endif # if defined(__BORLANDC__) # define __STL_NO_DRAND48 # define __STL_NEED_TYPENAME # define __STL_LIMITED_DEFAULT_TEMPLATES # define __SGI_STL_NO_ARROW_OPERATOR # define __STL_NON_TYPE_TMPL_PARAM_BUG # ifdef _CPPUNWIND # define __STL_USE_EXCEPTIONS # endif # ifdef __MT__ # define __STL_WIN32THREADS # endif # endif # if defined(__STL_NEED_BOOL) typedef int bool ; # define true 1 # define false 0 # endif # ifdef __STL_NEED_TYPENAME # define typename # endif # ifdef __STL_NEED_EXPLICIT # define explicit # endif # ifdef __STL_EXPLICIT_FUNCTION_TMPL_ARGS # define __STL_NULL_TMPL_ARGS <> # else # define __STL_NULL_TMPL_ARGS # endif # ifdef __STL_CLASS_PARTIAL_SPECIALIZATION # define __STL_TEMPLATE_NULL template<> # else # define __STL_TEMPLATE_NULL # endif # if defined(__STL_USE_NAMESPACES) && !defined(__STL_NO_NAMESPACES) # define __STD std # define __STL_BEGIN_NAMESPACE namespace std { # define __STL_END_NAMESPACE } # define __STL_USE_NAMESPACE_FOR_RELOPS # define __STL_BEGIN_RELOPS_NAMESPACE namespace std { # define __STL_END_RELOPS_NAMESPACE } # define __STD_RELOPS std # else # define __STD # define __STL_BEGIN_NAMESPACE # define __STL_END_NAMESPACE # undef __STL_USE_NAMESPACE_FOR_RELOPS # define __STL_BEGIN_RELOPS_NAMESPACE # define __STL_END_RELOPS_NAMESPACE # define __STD_RELOPS # endif # ifdef __STL_USE_EXCEPTIONS # define __STL_TRY try # define __STL_CATCH_ALL catch(...) # define __STL_RETHROW throw # define __STL_NOTHROW throw() # define __STL_UNWIND(action) catch(...) { action; throw; } # else # define __STL_TRY # define __STL_CATCH_ALL if (false) # define __STL_RETHROW # define __STL_NOTHROW # define __STL_UNWIND(action) # endif #ifdef __STL_ASSERTIONS # include <stdio.h> # define __stl_assert(expr) \ if (!(expr)) { fprintf (stderr , "%s:%d STL assertion failure: %s\n" , \ __FILE__, __LINE__, # expr); abort(); } #else # define __stl_assert(expr) #endif #endif

可能困惑的C++语法 stl_config.h中的各种组态(configuration) 组态3__STL_STATIC_TEMPLATE_MEMBER_BUG。如果编译器无法处理static member of template classes(模板类静态成员)就定义1 2 3 4 5 6 7 8 template <typename T>class test {public : static int _data; } int test<int >::_data=1 ;int test<char >::_data=2 ;

组态5__STL_CLASS_PARTIAL_SPECIALIZATION。如果编译器支持 partial specialization of class templates(模板类偏特化)就定义。在模板类一般化设计之外(全特化),针对某些template做特殊设计。“所谓的partial specialization的另一个意思是提供另一份template定义式,而其本身仍是templatized”。全特化就是所有的模板都为具体的类。T*特化允许用指针类型匹配的模式(也只能匹配指针类型)。const T*特化允许使用指向const的指针类型匹配(也只能匹配指向const的指针)。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 template <class I ,class O >struct test { test () { cout << "I, O" <<endl; } }; template <class T >struct test <T* ,T*> { test () { cout << "T* ,T*" << endl; } }; template <class T >struct test <const T* ,T*> { test () { cout << "const T* ,T*" << endl; } }; int main () test<int , char > obj1; test<int *, int *> obj2; test<const int *, int *> obj3; }

组态6__STL_FUNCTION_TMPL_PARTIAL_ORDER。如果编译器支持partial ordering of function templates或者说partial specialization of function templates就定义。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 template <class T ,class Alloc =alloc>class vec {public : void swap (vec<T, Alloc>&) { cout << "swap1()" << endl; } }; #ifdef __STL_FUNCTION_TMPL_PARTIAL_ORDER template <class T , class Alloc = alloc>inline void swap (vec<T, Alloc>& a, vec<T, Alloc>& b) { a.swap (b); }#endif int main () vec<int > a, b; swap (a, b); }

组态8__STL_MEMBER_TEMPLATES。如果编译器支持template members of classes(模板类内嵌套模板) 就定义。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 class vec {public : typedef T value_type; typedef value_type* iterator; template <class I> void insert (iterator position, I first, I last) { cout << "insert()" << endl; } }; int main () int ia[5 ] = { 0 ,1 ,2 ,3 ,4 }; vec<int > a; vec<int >::iterator ite; a.insert (ite, ia, ia + 5 ); }

组态10__STL_LIMITED_DEFAULT_TEMPLATES。如果编译器支持一个template参数可以根据前一个template的参数设置就定义。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 template <class T ,class Alloc =alloc,size_t BufSiz=0 >class deque {public : deque () { cout << deque () << endl; } }; template <class T ,class Sequence =deque<T>>class stack {public : stack () { cout << "Stack" << endl; } private : Sequence c; }; int main () stack<int > x; }

组态11__STL_NON_TYPE_TMPL_PARAM_BUG。测试类模板是否使用非类型模板参数(non-type template parameters) 。当以类型(type)作为模板参数的时候,代码中未决定的是类型;

当以一般的数字(non-type)作为模板参数的时候,代码中待定的内容便是某些数值。使用者这种模板必须要显示指定数值,模板才能实例化。通常它们只能是常数整数(constant integral values )包括枚举,或者是指向外部链接的指针。不能把float,class-type类型的对象,内部链接(internal linkage )对象,作为非类型模板参数。1 2 3 4 5 template <class T ,class Alloc =alloc,size_t BufSiz=0 > class deque {public : deque () { cout << deque () << endl; } };

__STL_NULL_TMPL_ARGS。直接理解为若允许bound friend template(约束模板友元) 则定义为 <> ,否则为空。1 friend bool ooperator== __STL_NULL_TMPL_ARGS(const stack&,const stack&);

1 friend bool ooperator== <>(const stack&,const stack&);

bound friend template(约束模板友元) 即友元类型取决于类被初始化时的类型,但程序必须在类外为友元提供模板定义。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 template <class T ,class Sequence =deque<T>>class stack { friend bool operator == <T>(const stack<T>&, const stack<T>&); friend bool operator < <T>(const stack<T>&, const stack<T>&); friend bool operator == <T>(const stack&, const stack&); friend bool operator < <T>(const stack&, const stack&); friend bool operator == <>(const stack&, const stack&); friend bool operator < <>(const stack&, const stack&); public : stack () { cout << "Stack" << endl; } private : Sequence c; };

__STL_TEMPLATE_NULL即template <>显示的模板特化 。1 2 3 4 5 #ifdef __STL_CLASS_PARTIAL_SPECIALIZATION # define __STL_TEMPLATE_NULL template<> #else # define __STL_TEMPLATE_NULL #endif

模板特化(class template explicit specialization) 即指定一种或多种模板形参的实际值或实际类型,作为特殊情况。(与模板类型偏特化不同!)1 2 3 4 5 6 template <class type > struct __type_traits { ...};__STL_TEMPLATE_NULL struct __type_traits <char > { ... }; template <class Key > struct hash { };__STL_TEMPLATE_NULL struct hash <char > { ... }; __STL_TEMPLATE_NULL struct hash <unsgned char > { ... };

经展开后:1 2 3 4 5 6 template <class type > struct __type_traits { ...};template <> struct __type_traits <char > { ... };template <class Key > struct hash { };template <> struct hash <char > { ... };template <> struct hash <unsgned char > { ... };

临时对象的产生与应用 刻意制造一些临时对象,在类型名之后直接加一对(),并指定初值,使用时相当于调用该类的临时对象的()操作。常用于仿函数与算法的搭配上。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 template <typename T>class print {public : void operator () (const T& elem) cout << elem << " " ; } }; template <typename T>class plus {public : T operator () (const T& x, const T& y) const { return x + y; } }; int main () vector<int > ai ({ 1 ,2 ,3 ,4 ,5 }) ; for_each(ai.begin (), ai.end (), print <int >()); int a = 5 , b = 3 ; print <int >()(plus <int >()(a, b)); }

print<int>的一个临时对象。这个对象将被传入进for_each()中。

静态常量整数成员在class内部直接初始化 如果class内含const static integral data member,那么根据C++规格,我们可以在class之内直接给予初值。所谓integral泛指所有的整数型别(包括浮点数),不单只是指int,下面是一个例子:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 #include <iostream> using namespace std;template <typename T>class testClass { public : static const double _datai=1.2 ; static const long _datal=3L ; static const char _datac='c' ; }; int main () cout<<testClass<int >::_datai<<endl; cout<<testClass<int >::_datal<<endl; cout<<testClass<int >::_datac<<endl; }

一般,非const的static数据成员是不能在类的内部初始化,但是,我们可以为静态成员提供const整数类型的类内初始值。

例如,下面的情况会报错:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 #include <iostream> using namespace std;template <typename T>class testClass { public : static double _datai=1.2 ; static const long _datal=3L ; static const char _datac='c' ; }; int main () cout<<testClass<int >::_datai<<endl; cout<<testClass<int >::_datal<<endl; cout<<testClass<int >::_datac<<endl; }

如果加了const 或者constexpr之后,就可以在类内进行初始化了。

对于static成员,如果在类的内部提供了一个初值,则成员在类外的定义不能再指定一个初始值了。例如:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 #include <iostream> using namespace std;template <typename T>class testClass { public : static const double _datai=1.2 ; static const long _datal=3L ; static const char _datac='c' ; }; template <typename T>const double testClass<T>::_datai=8.8 ;int main () cout<<testClass<int >::_datai<<endl; cout<<testClass<int >::_datal<<endl; cout<<testClass<int >::_datac<<endl; }

下面的情况是允许的,直接在定义的时候提供初始值或者在类内提供初始值之后只在类外定义但不提供初始值。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 #include <iostream> using namespace std;template <typename T>class testClass { public : static const double _datai; static const long _datal=3L ; static const char _datac='c' ; }; template <typename T>const double testClass<T>::_datai=8.8 ;int main () cout<<testClass<int >::_datai<<endl; cout<<testClass<int >::_datal<<endl; cout<<testClass<int >::_datac<<endl; }

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 #include <iostream> using namespace std;template <typename T>class testClass { public : static const double _datai=1.2 ; static const long _datal=3L ; static const char _datac='c' ; }; template <typename T>const double testClass<T>::_datai;int main () cout<<testClass<int >::_datai<<endl; cout<<testClass<int >::_datal<<endl; cout<<testClass<int >::_datac<<endl; }

increment/decrement/dereference操作符 increment/dereference操作符在迭代器的实现上占有非常重要的地位,因为任何一个迭代器都必须实现出前进(increment,operator++)和取值(dereference,operator*)功能,前者还分为前置式(prefix)和后置式(Postfix)两种。有写迭代器具备双向移动功能,那么就必须再提供decrement操作符(也分前置式和后置式),下面是一个例子:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 #include <iostream> using namespace std;class INT { friend ostream& operator <<(ostream& os,const INT& i); public : INT (int i):m_i (i){} INT& operator ++() { ++(this ->m_i); return *this ; } const INT operator ++(int ) { INT temp=*this ; ++(*this ); return temp; } INT& operator --() { --(this ->m_i); return *this ; } const INT operator --(int ) { INT temp=*this ; --(*this ); return temp; } int & operator *() const { return (int &)m_i; } private : int m_i; }; ostream& operator <<(ostream& os,const INT &i) { os<<'[' <<i.m_i<<']' ; return os; } int main () INT I (5 ) ; cout<<I++; cout<<++I; cout<<I--; cout<<--I; cout<<*I; }

前闭后开区间表示法 任何一个STL算法,都需要获得由一对迭代器(泛型指针)所标示的区间,用以表示操作范围,这一对迭代器所标示的是个所谓的前闭后开区间,以[first,last)表示,也就是说,整个实际范围从first开始,直到last-1.迭代器last所指的是“最后一个元素的下一位置”。这种off by one(偏移一格,或说pass the end)的标示法,带来了很多方便,例如下面两个STL算法的循环设计,就显得干净利落:1 2 3 4 5 6 7 8 9 10 11 12 13 14 template <class InputIterator,class T>InputIterator find (InputIterator first,InputIterator last,const T&value) while (first!=last&&*first!=value) ++first; return first; } template <class InputIterator ,class Function >Function for_each (InputIterator first,InputIterator last,Function f) for (;first!=last;++first) f (*first); return f; }

function call 操作符 函数调用操作(C++语法中的左右小括号)也可以被重载。

许多STL算法都提供了两个版本,一个用于一般情况(例如排序时以递增方式排列),一个用于特殊情况(例如排序时由使用者指定以何种特殊关系进行排列),像这种情况,需要用户指定某个条件或某个策略,而条件或策略的背后由一整组操作构成,便需要某种特殊的东西来代表这“一整组操作”。

代表“一整组操作“的,当然是函数,过去C语言时代,欲将函数当做参数传递,唯有通过函数指针才能达成,例如:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 #include <iostream> #include <cstdlib> using namespace std;int fcmp (const void * elem1,const void * elem2) int main () int ia[10 ]={32 ,92 ,67 ,58 ,10 ,4 ,25 ,52 ,59 ,54 }; for (int i=0 ;i<10 ;i++) cout<<ia[i]<<" " ; cout<<endl; qsort (ia,sizeof (ia)/sizeof (int ),sizeof (int ),fcmp); for (int i=0 ;i<10 ;i++) cout<<ia[i]<<" " ; cout<<endl; } int fcmp (const void * elem1,const void * elem2) const int *i1=(const int *)elem1; const int *i2=(const int *)elem2; if (*i1<*i2) return -1 ; else if (*i1==*i2) return 0 ; else if (*i1>*i2) return 1 ; }

但是函数指针有缺点,最重要的是它无法持有自己的状态(所谓局部状态,local states),也无法达到组件技术中的可适配性(adaptability)——也就是无法再将某些修饰条件加诸于其上面而改变其状态。

为此,STL算法的特殊版本所接受的所谓“条件”或“策略”或“一整组操作”,都以仿函数形式呈现。所谓仿函数(functor)就是使用起来像函数一样的东西。如果你针对么某个class进行operator()重载,它就是一个仿函数,至于要成为一个可配接的仿函数,还需要做一些额外的努力。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 #include <iostream> using std::cout;using std::endl;template <class T >struct plus { T operator () (const T& x,const T& y) const {return x+y;} }; template <class T >struct minus { T operator () (const T& x,const T& y) const {return x-y;} }; int main () plus<int > plusObj; minus<int > minusObj; cout<<plusObj (3 ,5 )<<endl; cout<<minusObj (3 ,5 )<<endl; cout<<plus <int >()(43 ,50 )<<endl; cout<<minus <int >()(43 ,50 )<<endl; }

空间配置器 以STL的运用角度而言,空间配置器是最不需要介绍的东西,它总是隐藏在一切组件(更具体地说是指容器,container)的背后,默默工作,默默付出。但若以STL的实现角度而言,第一个需要介绍的就是空间配置器,因为整个STL的操作对象(所有的数据)都存放在容器之内,而容器一定需要配置空间以置放资料。

为什么不说allocator是内存配置器而说它是空间配置器呢?因为空间不一定是内存,空间也可以是磁盘或其它辅助存储介质。是的,你可以一个allocator,直接向硬盘取空间,以下介绍的是SGI STL提供的配置器,配置的对象是内存。

空间配置器的标准接口 根据STL的规范,以下是allocator的必要接口:

allocator::value_typeallocator::pointerallocator::const_pointerallocator::referenceallocator::const_referenceallocator::size_typeallocator::difference_typeallocator::rebind:一个嵌套的class template,class rebind<U>拥有唯一的成员other,那是一个typedef,代表allocator<U>allocator::allocator():default constuctorallocator::allocator(const allocator&):copy constructortemplate<class U>allocator::allocator(const allocator<U>&):泛化的copy constructorallocator::~allocator():destructorpointer allocator::address(reference x)const:返回某个对象的地址,算式a.address(x)等同于&xconst_pointer allocator::address(const_reference x)const:返回某个const对象的地址,算式a.address(x)等同于&xpointer allocator::allocate(size_type n,const void* =0):配置空间,足以存储n个T对象,第二参数是个提示,实际上可能会利用它来增进区域性,或完全忽略之void allocator::deallocate(pointer p,size_type n):归还先前配置的空间size_type allocator::max_size() const:返回可成功分配的最大量void allocator::construct(pointer p,const T& x):等同于new((void*)p) T(x)void allocator::destroy(pointer p):等同于p->~T()

设计一个简单的空间配置器, JJ::allocator 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 #include "stdafx.h" #include <new> #include <cstddef> #include <cstdlib> #include <climits> #include <iostream> #include <vector> using namespace std;namespace JJ{ template <typename T>inline T* _allocate(ptrdiff_t size, T*){ set_new_handler (0 ); T* tmp = (T*)(::operator new ((size_t )(size *sizeof (T)))); if (tmp == 0 ) { cerr << "out of memory!" << endl; exit (1 ); } return tmp; } template <typename T>inline void _deallocate(T* buffer){ ::operator delete (buffer) } template <typename T1,typename T2>inline void _construct(T1* p,const T2& value){ new (p) T1 (value); } template <typename T>inline void _destroy(T* ptr){ ptr->T (); } template <typename T>class allocator { public : typedef T value_type; typedef T* pointer; typedef const T* const_pointer; typedef T& reference; typedef const T& const_reference; typedef size_t size_type; typedef ptrdiff_t difference_type; template <typename U> struct rebind { typedef allocator<U> other; }; pointer allocate (size_type n, const void *hint=0 ) { return _allocate((difference_type)n, (pointer)0 ); } void deallocate (pointer p, size_type n) { _deallocate(p); } void construct (pointer p, const T& value) { _construct(p,value); } void destroy (pointer p) { _destroy(p); } pointer address (reference x) { return (pointer)&x; } const_pointer const_address (const_reference x) { return (const_pointer)&x; } size_type max_size () const { return size_type (UINT_MAX/sizeof (T)); } }; } int main () int ia[5 ] = {0 ,1 ,2 ,3 ,4 }; unsigned int i; vector<int ,JJ::allocator<int >> ivv (ia,ia+5 ); vector<int ,std::allocator<int > > iv (ia,ia+5 ); for (i = 0 ; i < iv.size (); ++i) std::cout << iv[i] << " " ; cout << endl; system ("pause" ); return 0 ; }

具备次配置力的 SGI 空间配置器 SGI STL的配置器与众不同,它与标准规范不同,其名称是alloc而非allocator。如果要在程序中明白采用SGI配置器,那么应该这样写:1 vector<int , std::alloc> iv;

配置器名字为alloc,不接受任何参数。标准配置器的名字是allocator,而且可以接受参数。比如VC中写法:1 vector<int , std::allocator<int > > iv;

SGI STL的每一个容器都已经指定了缺省配置其alloc。我们很少需要自己去指定空间配置器。比如vector容器的声明:1 2 3 4 template <class T , class Alloc = alloc>class vector {}

SGI标准的空间配置器allocator 其实SGI也定义了一个符合部分标准,名为allocator的配置器,但是它自己不使用,也不建议我们使用,主要原因是效率不佳。它只是把C++的操作符::operator new和::operator delete做了一层简单的封装而已。下面仅仅贴出代码:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 #ifndef DEFALLOC_H #define DEFALLOC_H #include <new.h> #include <stddef.h> #include <stdlib.h> #include <limits.h> #include <iostream.h> #include <algobase.h> template <class T >inline T* allocate (ptrdiff_t size, T*) set_new_handler (0 ); T* tmp = (T*)(::operator new ((size_t )(size * sizeof (T)))); if (tmp == 0 ) { cerr << "out of memory" << endl; exit (1 ); } return tmp; } template <class T >inline void deallocate (T* buffer) ::operator delete (buffer) } template <class T >class allocator {public : typedef T value_type; typedef T* pointer; typedef const T* const_pointer; typedef T& reference; typedef const T& const_reference; typedef size_t size_type; typedef ptrdiff_t difference_type; pointer allocate (size_type n) { return ::allocate ((difference_type)n, (pointer)0 ); } void deallocate (pointer p) deallocate (p); } pointer address (reference x) { return (pointer)&x; } const_pointer const_address (const_reference x) { return (const_pointer)&x; } size_type init_page_size () { return max (size_type (1 ), size_type (4096 /sizeof (T))); } size_type max_size () const { return max (size_type (1 ), size_type (UINT_MAX/sizeof (T))); } }; class allocator <void > {public : typedef void * pointer; }; #endif

SGI特殊的空间配置器std::alloc 一般而言,我们所习惯的C++内存配置器操作和释放操作时这样的:1 2 3 class FOO { ...};FOO* pf=new FOO; delete pf;

调用::operator new配置内存

调用FOO::FOO()构造对象内容

delete算式也内含两个阶段操作:

调用FOO::~FOO()对对象析构

调用::operator delete释放内存

为了精密分工,SGI allocator将两个阶段分开:

内存配置操作由alloc:allocate负责,内存释放由alloc:deallocate负责;对象构造操作由::contructor()负责,对象析构由::destroy()负责。

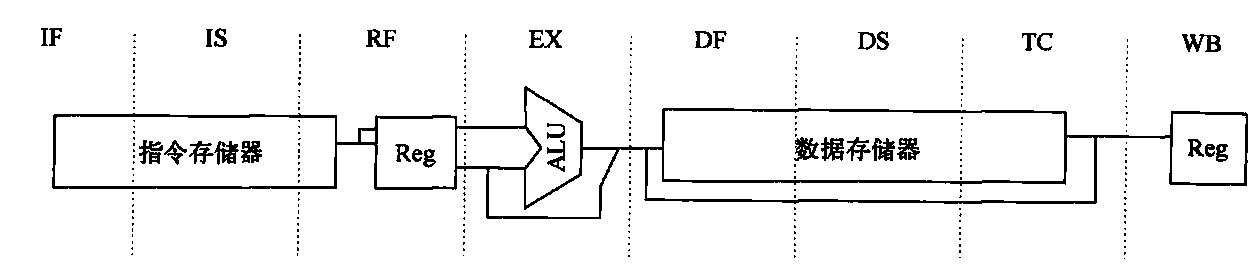

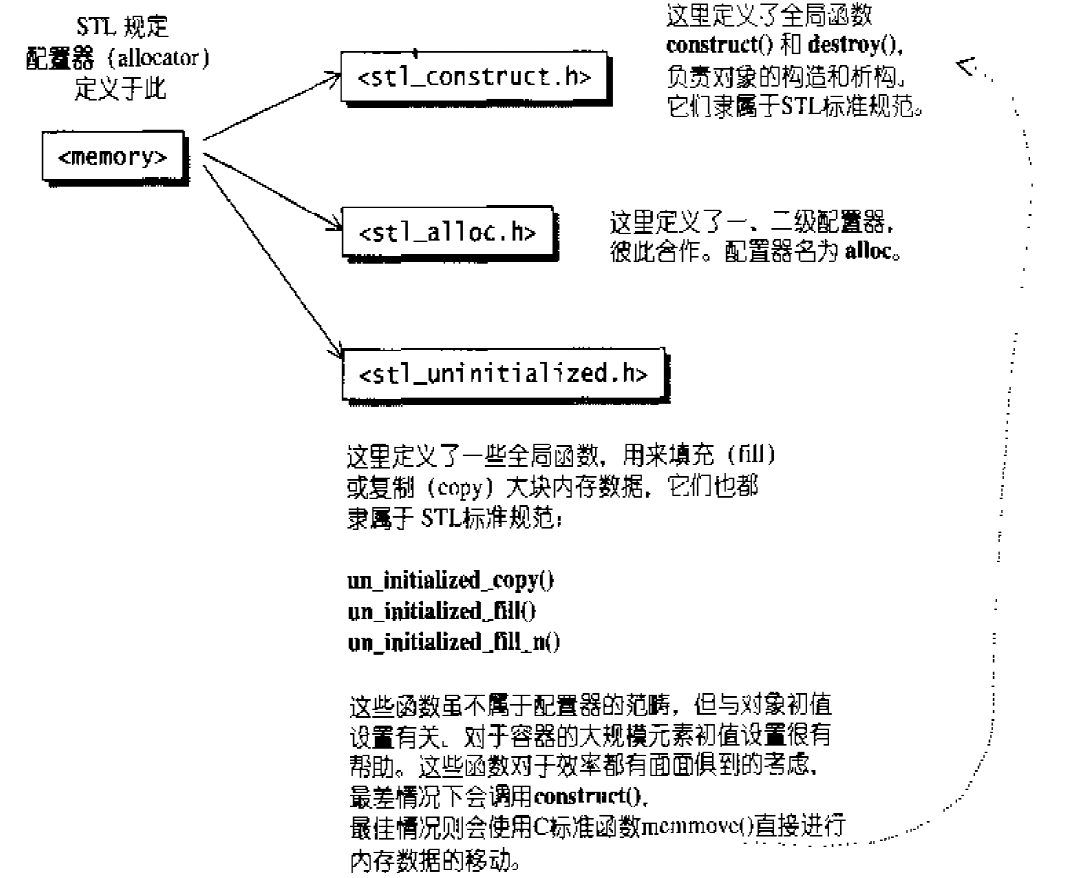

STL标准告诉我们,配置器定义在头文件<memory>中,它里面又包括两个文件:1 2 #include <stl_alloc.h> #include <stl_construct.h>

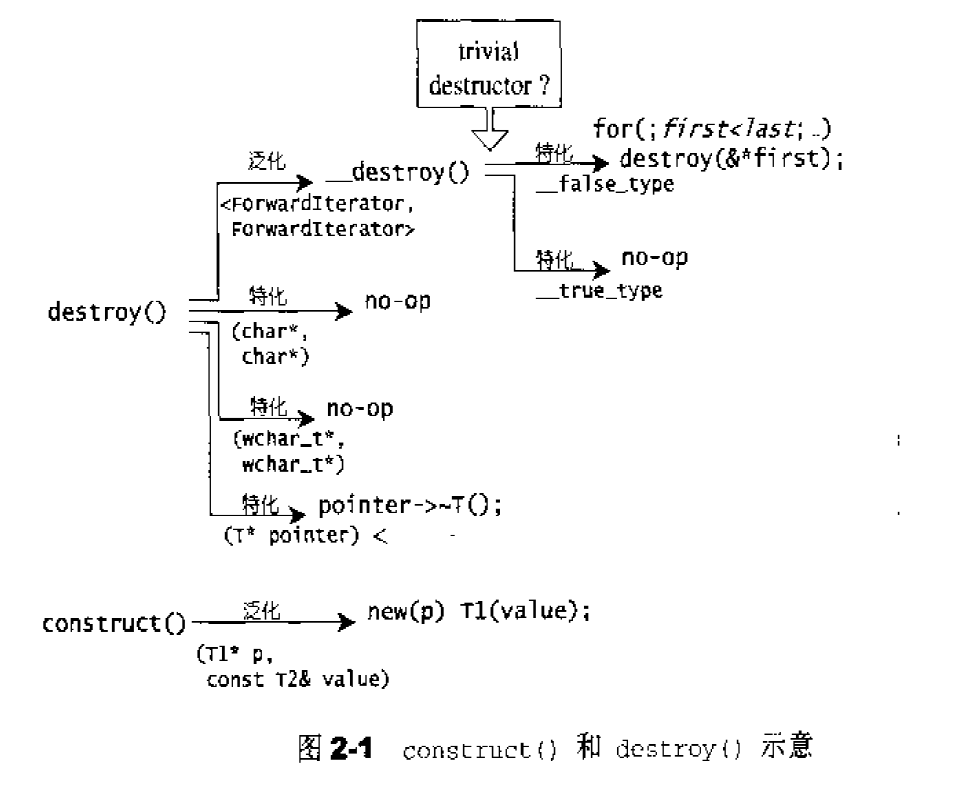

<stl_construct.h>定义了两个基本函数:构造用的construct()和析构用的destroy()。

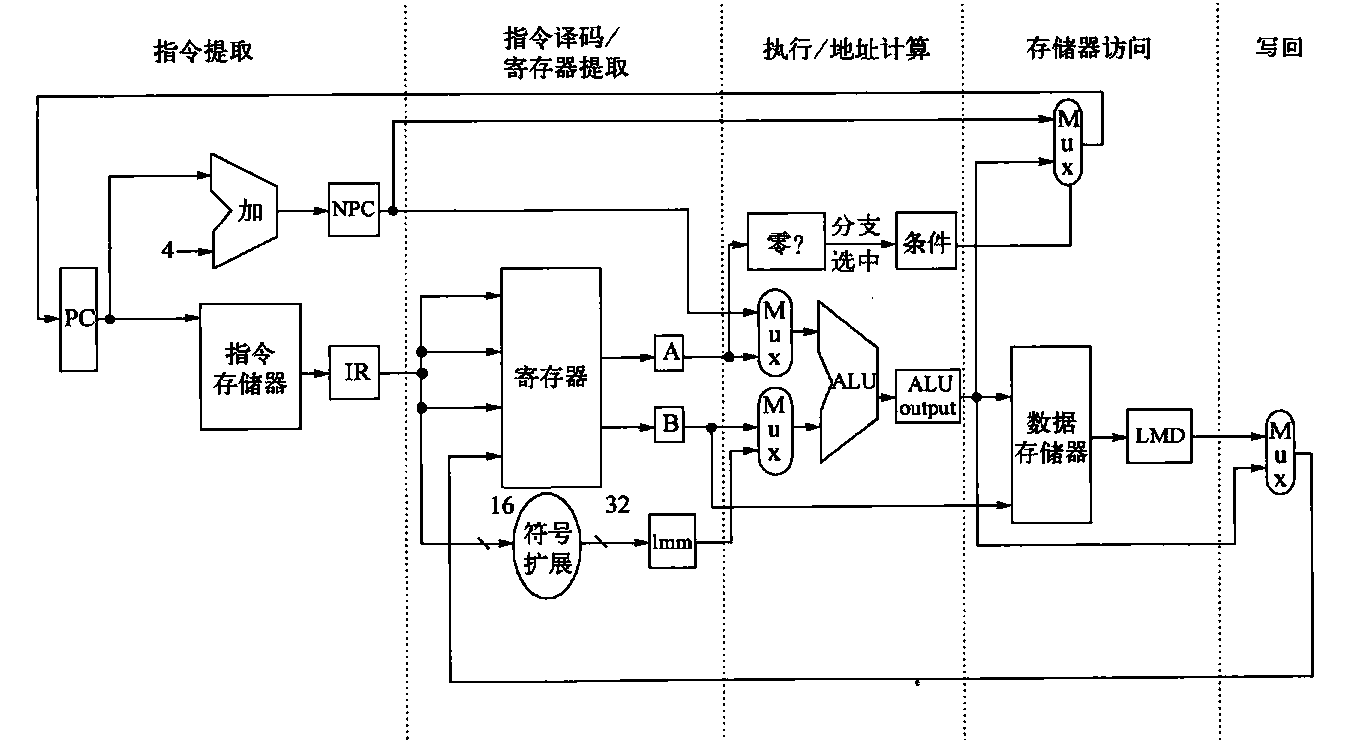

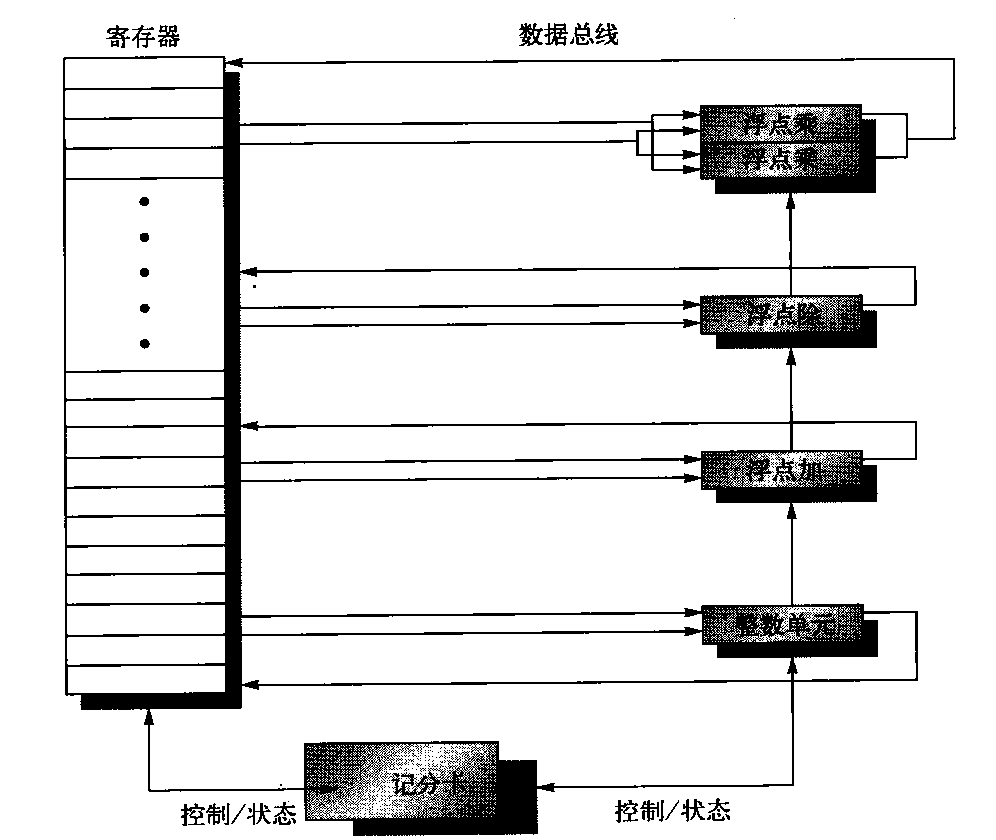

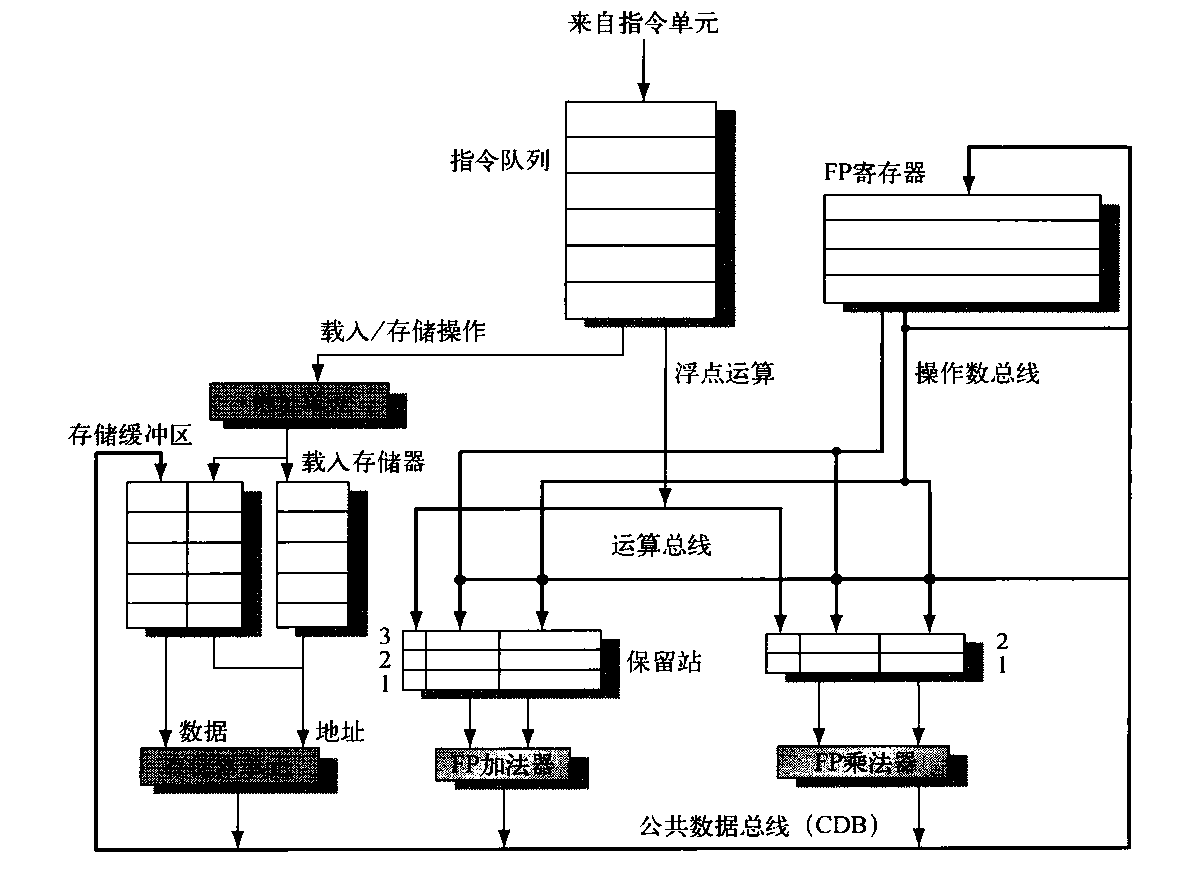

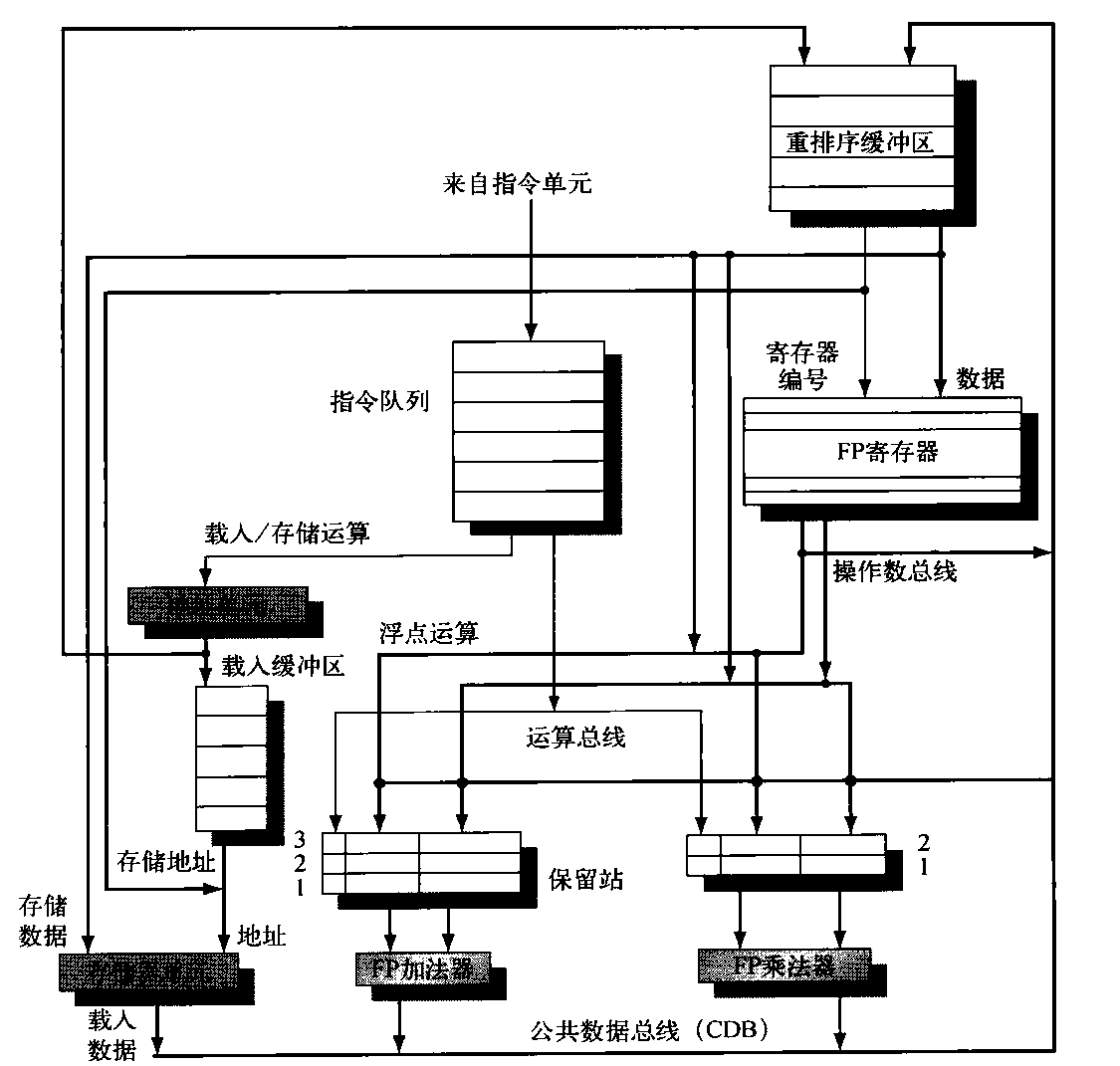

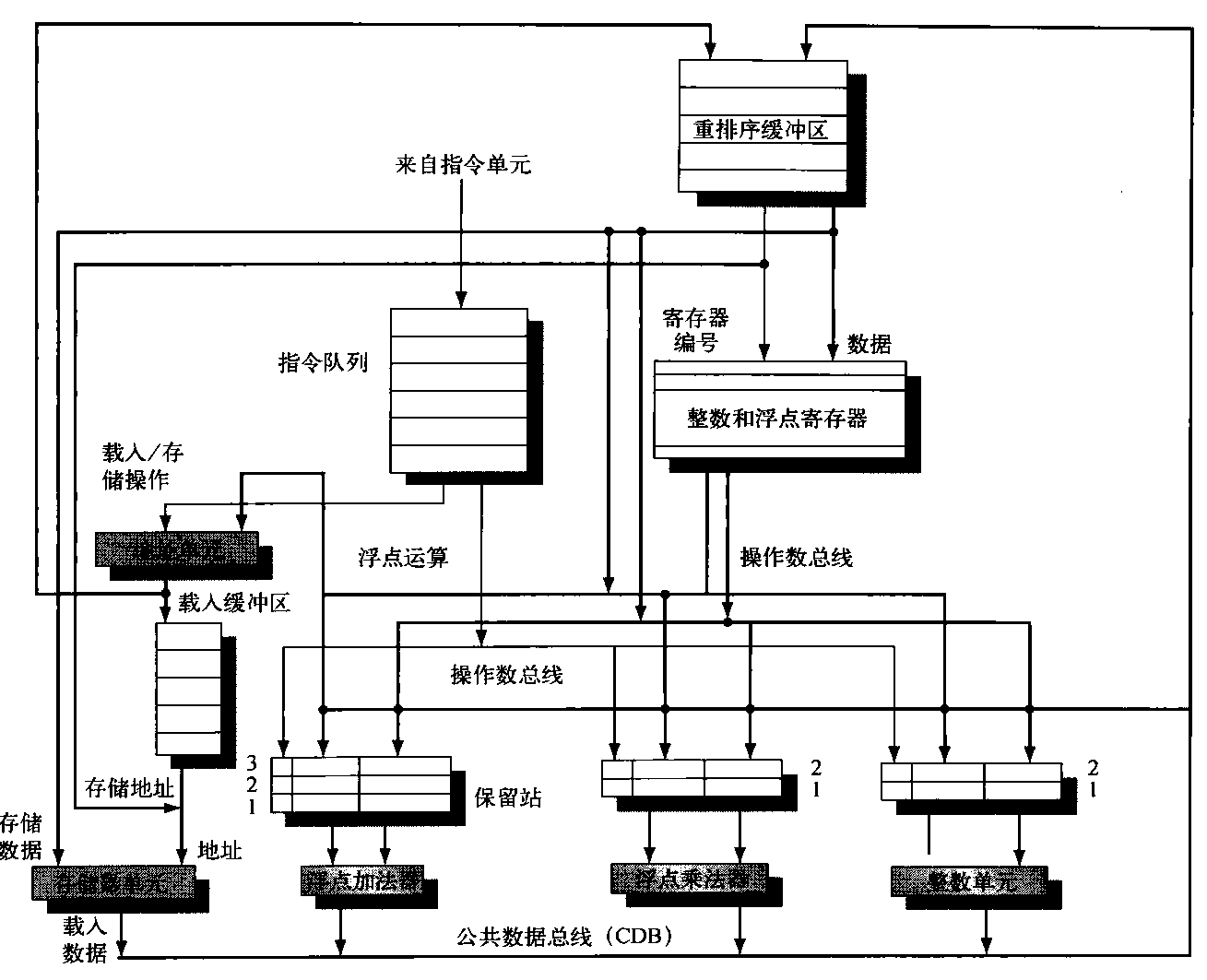

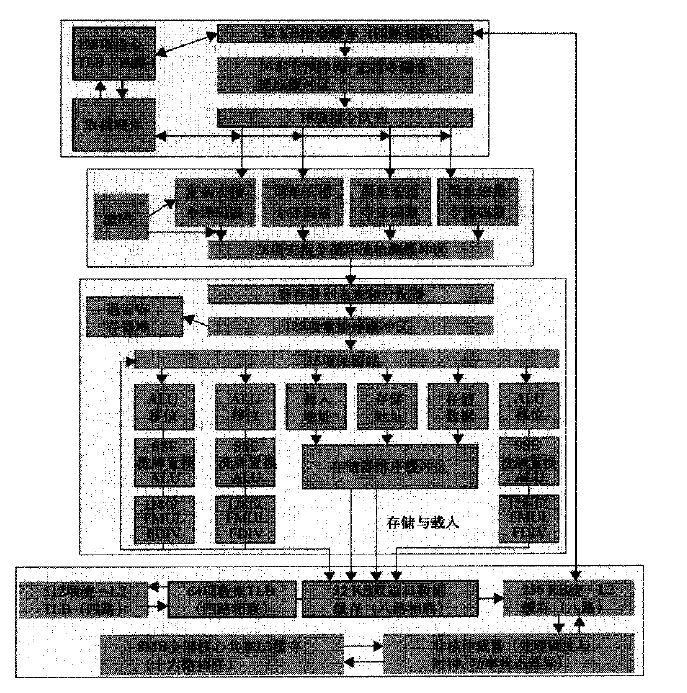

下图显示了其结构:

构造函数析构的基本工具:construct()和destroy() 下面是<stl_constuct.h>的部分内容:

函数construct()使用了定位new操作符,其源代码:1 2 3 4 template <class T1 , class T2 >inline void construct (T1* p, const T2& value) new (p) T1 (value); }

第一个版本较简单,接受一个指针作为参数,直接调用对象的析构函数即可,其源代码:1 2 3 4 template <class T >inline void destroy (T* pointer) pointer->~T (); }

下面看其源代码:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 template <class ForwardIterator >inline void destroy (ForwardIterator first, ForwardIterator last) __destroy(first, last, value_type (first)); } template <class ForwardIterator , class T >inline void __destroy(ForwardIterator first, ForwardIterator last, T*) { typedef typename __type_traits<T>::has_trivial_destructor trivial_destructor; __destroy_aux(first, last, trivial_destructor ()); } template <class ForwardIterator > inline void __destroy_aux(ForwardIterator, ForwardIterator, __true_type) {}template <class ForwardIterator >inline void __destroy_aux(ForwardIterator first, ForwardIterator last, __false_type) { for ( ; first < last; ++first) destroy (&*first); }

char*和wchar_t*定义了特化版本:1 2 inline void destroy (char *, char *) inline void destroy (wchar_t *, wchar_t *)

stl_construct.h中。

这两个作为构造、析构之用的函数被设计为全局函数,符合STL的规范。此外,STL还规定配置器必须拥有名为construct()和destroy()的两个成员函数。

上述construct()接收一个指针p和一个初值value,该函数的用途就是将初值设定到指针所指的空间上。C++的placement new运算可用来完成这一任务。

destroy()有两个版本,第一版本接受一个指针,准备将该指针所指之物析构掉。这很简单,直接调用该对象的析构函数即可。第二版本接受first和last迭代器,准备将[first,last)范围内的所以对象析构掉。我们不知道这个范围有多大,万一很大,而每个对象的析构函数都无关痛痒(所谓的trivial destructor),那么一次次调用这些无关痛痒的析构函数,对效率是一种伤害。因此,这里先利用value_type()获得迭代器所指对象的型别,再利用_type_traits<T>判断该型别的析构函数是否无关痛痒。若是(_true_type),则什么也不做就结束;若否,(_false_type),这才以循环方式巡访整个范围,并在循环中每经历一个对象就调用一个版本的destroy()。

空间的配置和释放,std::alloc 对象构造前的空间配置和对象析构后的空间释放,由<stl_alloc.h>负责,SGI对此的设计哲学如下:

向system heap要求空间

考虑多线程状态

考虑内存不足时的应变措施

考虑过多“小型区块”可能造成的内存碎片问题

C++的内存配置基本操作是::operator new(),内存释放基本操作是::operator delete()。这两个全局函数相当于C的malloc()和free()函数。是的,正是如此,SGI正是以malloc()和free()完成内存的配置和释放。

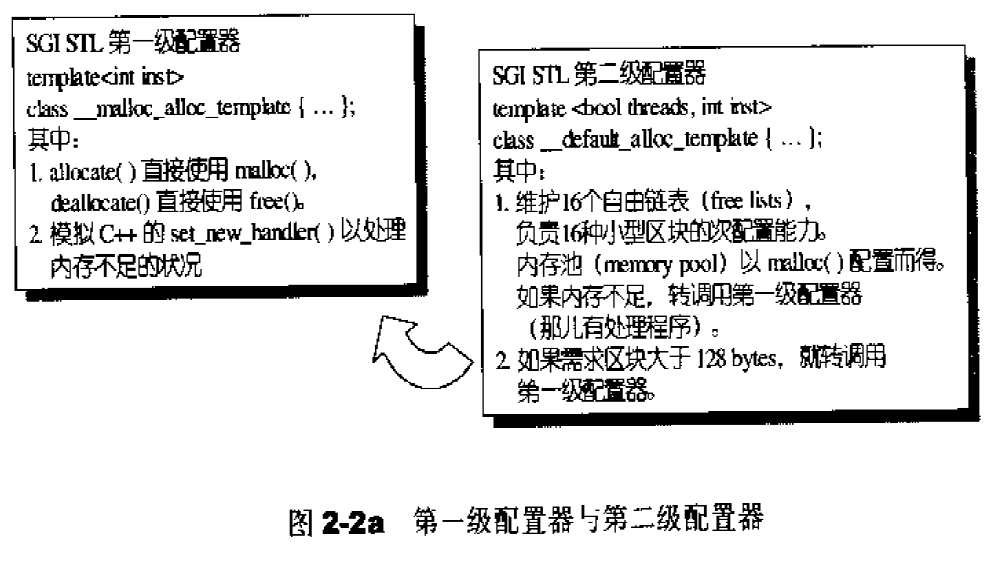

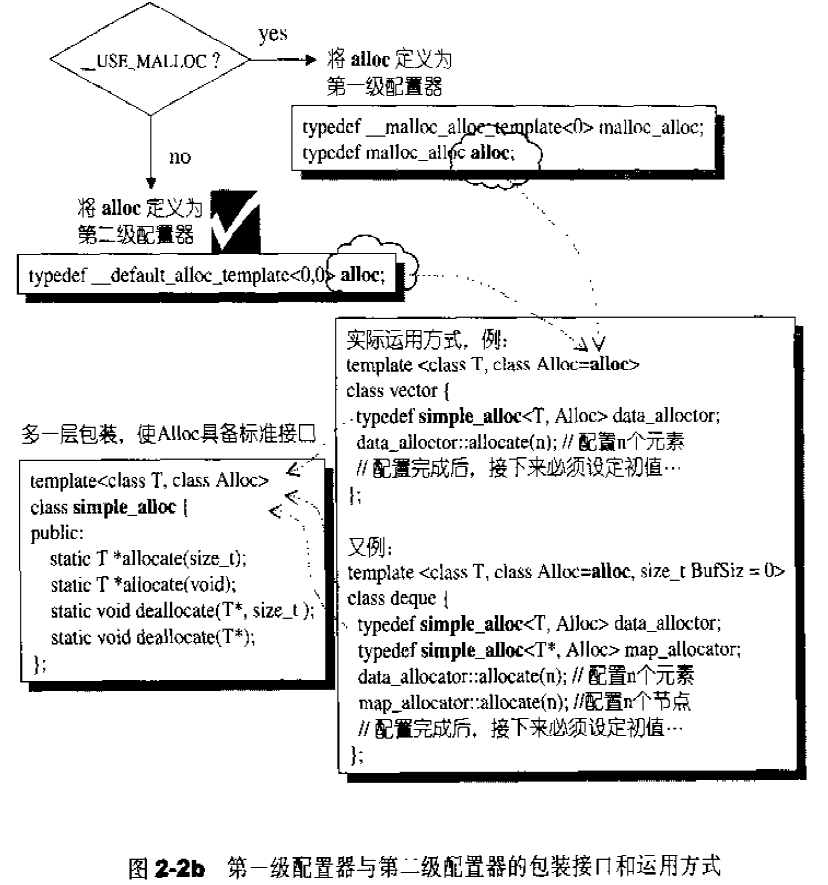

考虑到小型区块所可能造成的内存碎片问题。SGI设计了双层配置器,第一级配置器直接使用malloc()和free(),第二级配置器则视情况采用不同的策略;当配置区块超过128bytes时,视之为“足够大”,便调用第一级配置器;当配置区块小于128bytes时,视之为“过小”,为了降低额外负担,便采用复杂的memory pool整理方式,而不再求助于第一级配置器。整个设计究竟是开放第一级配置器或是同时开放第二级配置器,取决于_USE_MALLOC是否被定义:1 2 3 4 5 6 7 8 9 # ifdef __USE_MALLOC ... typedef __malloc_alloc_template<0 > malloc_alloc;typedef malloc_alloc alloc; # else ... typedef __default_alloc_template<__NODE_ALLOCATOR_THREADS, 0 > alloc; #endif

__malloc_alloc_template就是第一级配置器,__default_alloc_template就是第二级配置器。

无论alloc被定义为第一级或者是第二级配置器,SGI还为它包装一个接口如下,使配置器的接口能够符合STL规格:1 2 3 4 5 6 7 8 9 10 11 12 13 template <class T , class Alloc >class simple_alloc {public : static T *allocate (size_t n) { return 0 == n? 0 : (T*) Alloc::allocate (n * sizeof (T)); } static T *allocate (void ) { return (T*) Alloc::allocate (sizeof (T)); } static void deallocate (T *p, size_t n) { if (0 != n) Alloc::deallocate (p, n * sizeof (T)); } static void deallocate (T *p) { Alloc::deallocate (p, sizeof (T)); }};

sizeof(T))。SGI STL容器全都用这个simple_alloc接口。1 2 3 4 5 6 7 8 9 10 template <class T , class Alloc = alloc> class vector {protected : typedef simple_alloc<value_type, Alloc> data_allocator; void deallocate () if (...) data_allocator::deallocate (start, end_of_storage - start); } };

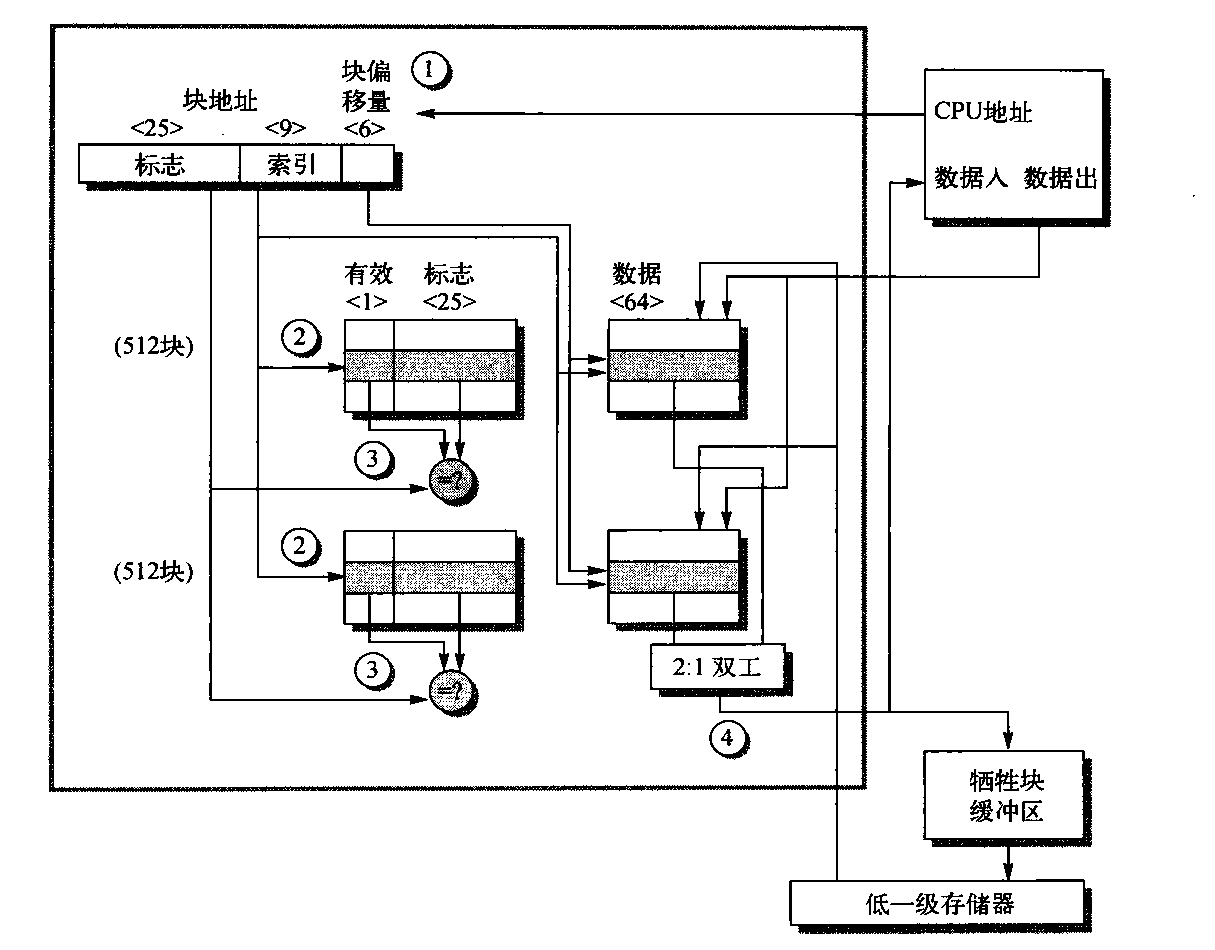

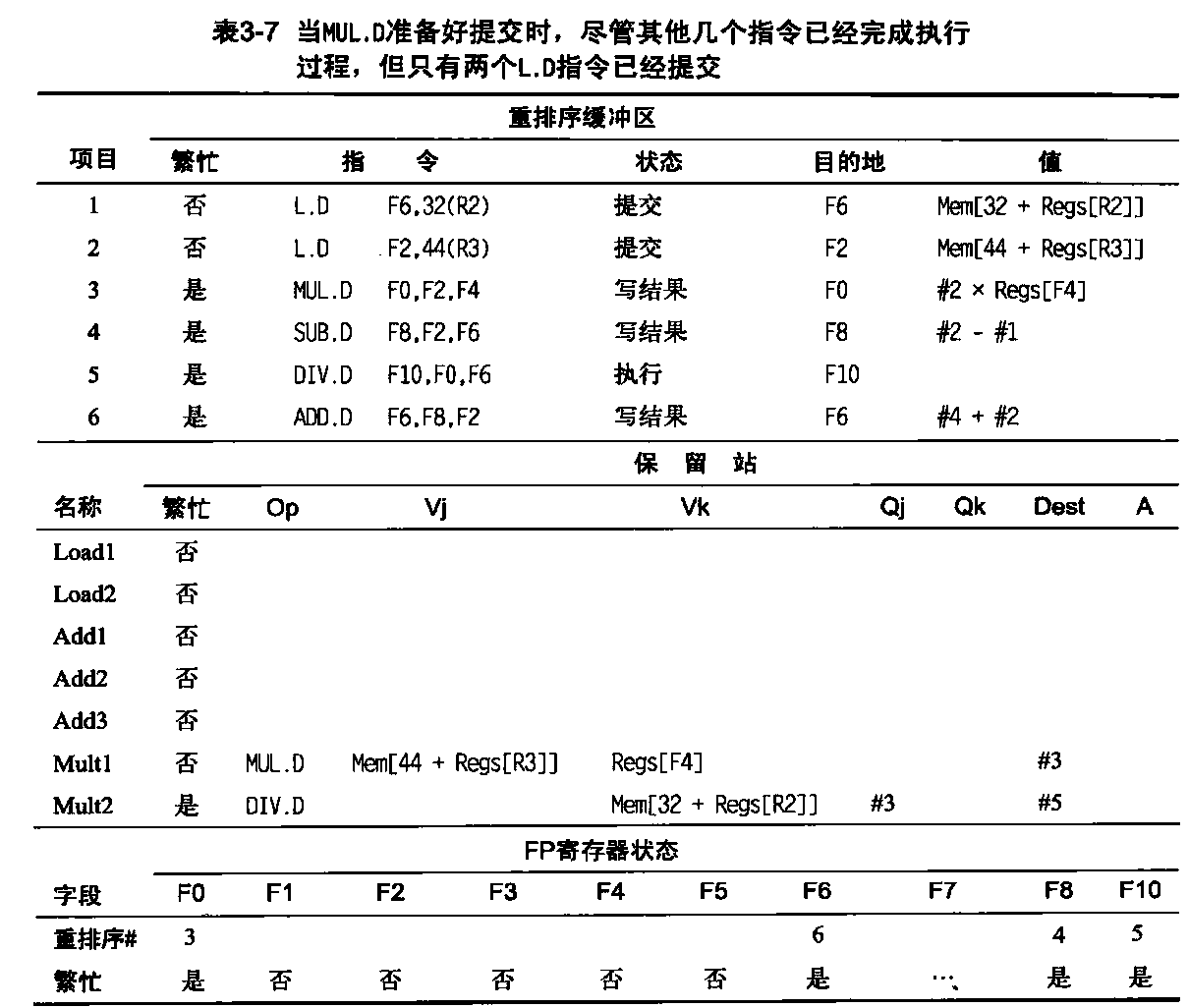

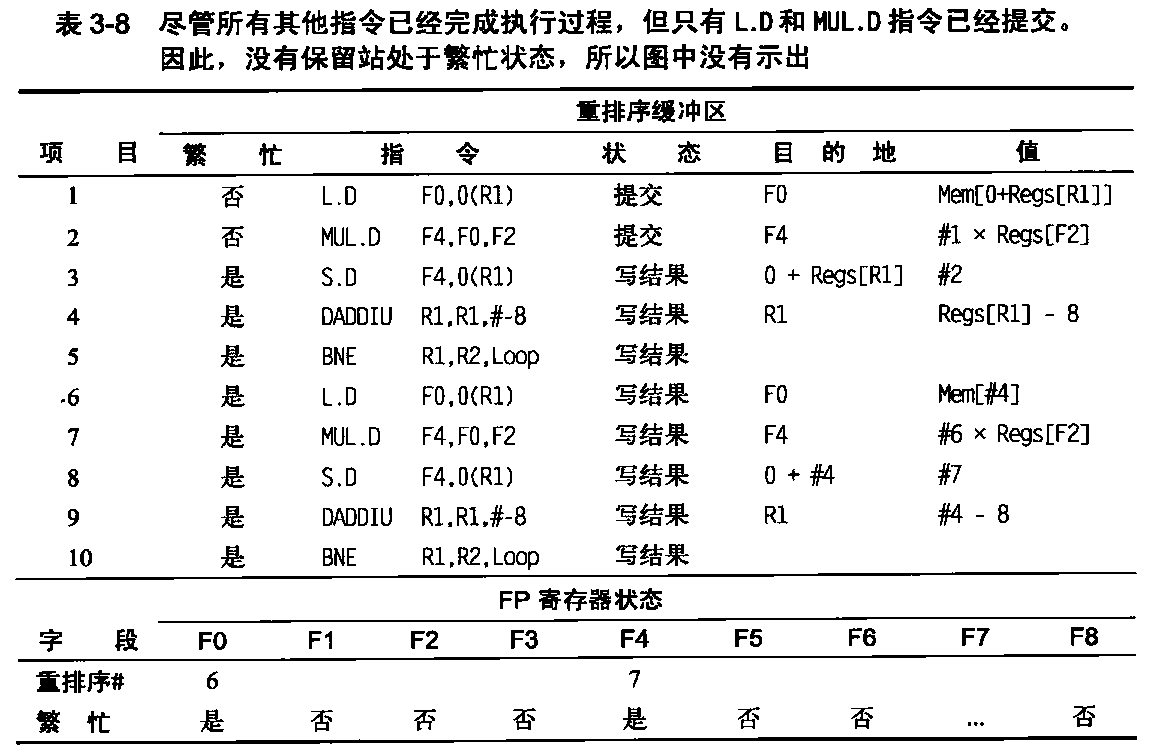

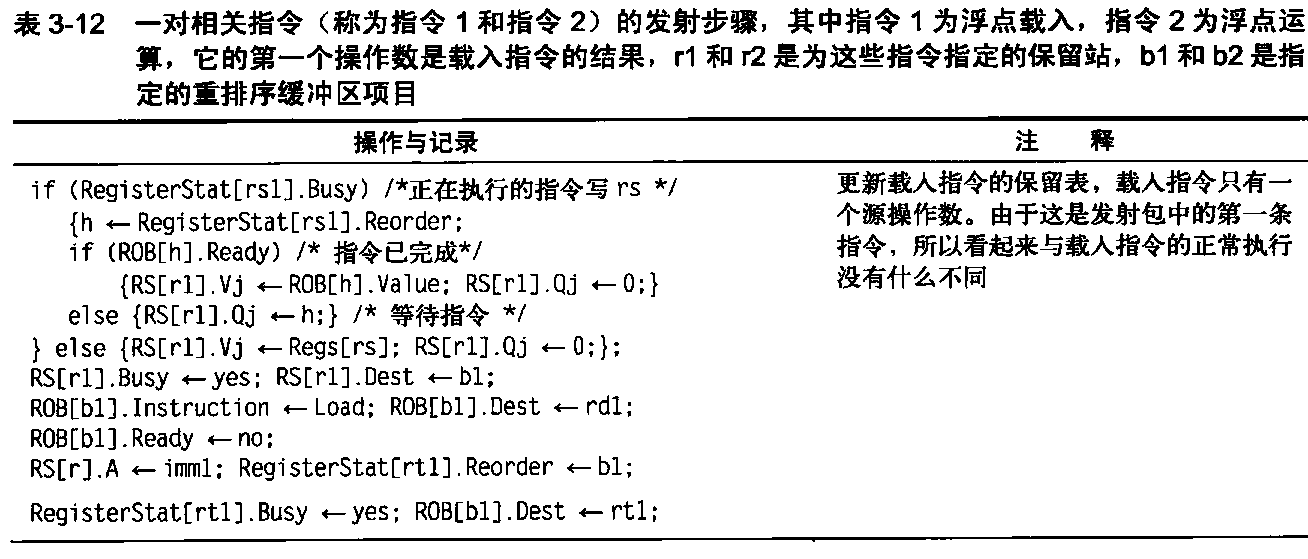

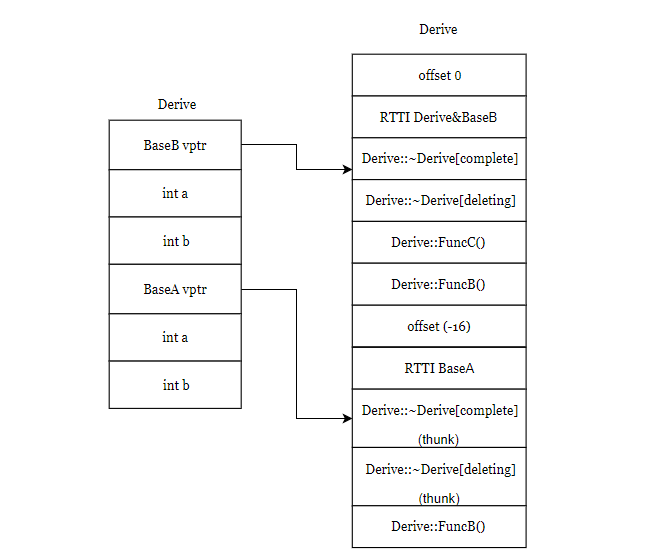

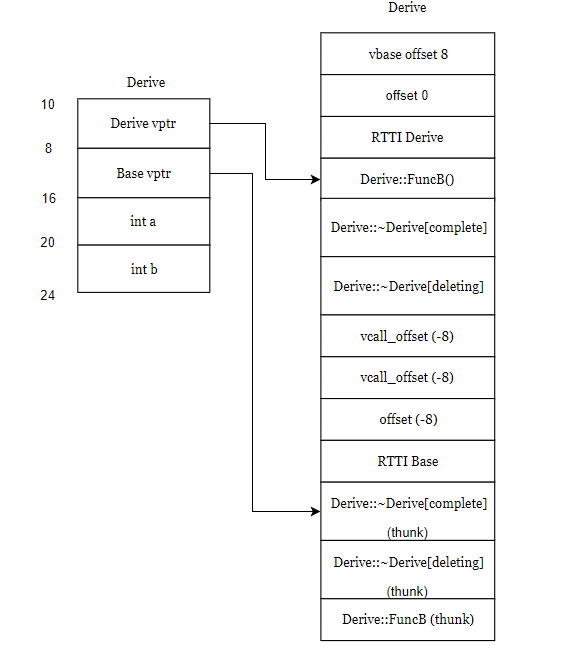

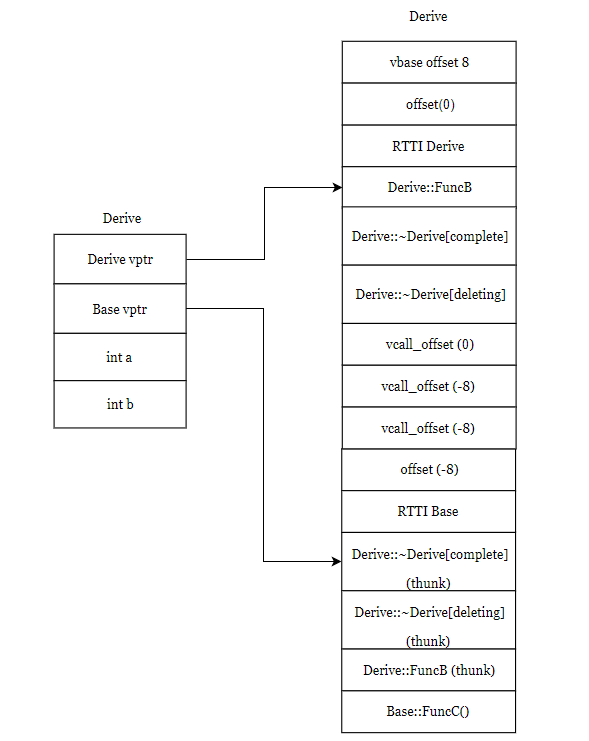

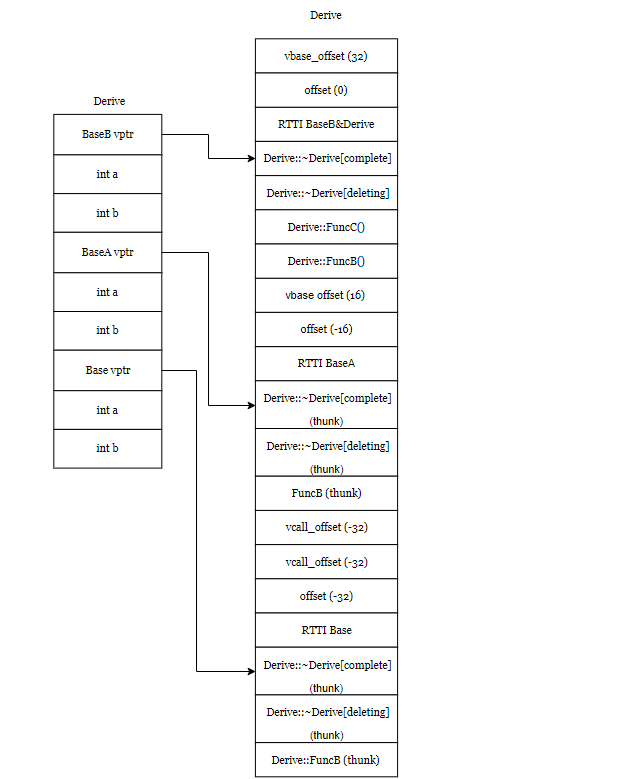

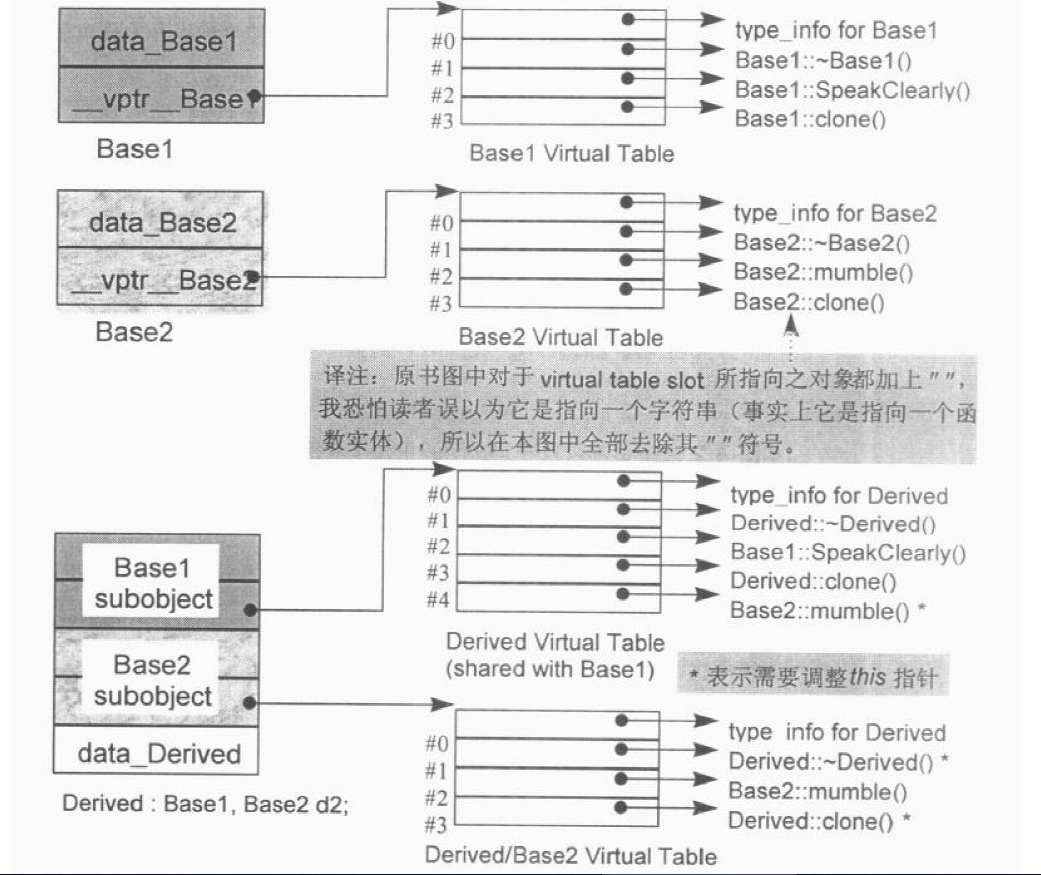

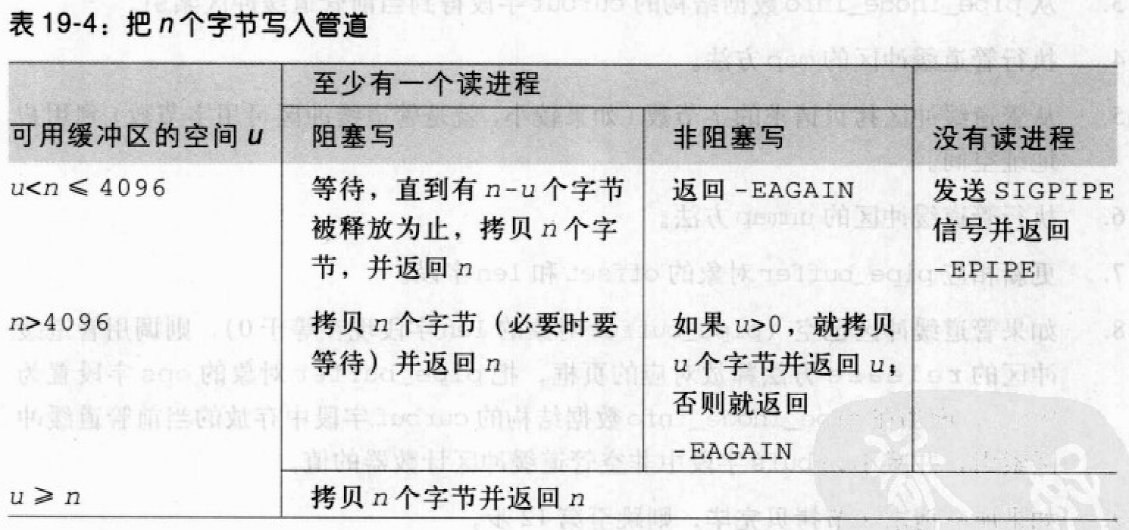

一、二级配置器的关系如下:

第一级和第二级配置器的包装接口和运用方式如下:

第一级配置器__malloc_alloc_template剖析 首先我们观察第一级配置器:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 #if 0 # include <new> # define __THROW_BAD_ALLOC throw bad_alloc #elif !defined(__THROW_BAD_ALLOC) # include <iostream.h> # define __THROW_BAD_ALLOC cerr << "out of memory" << endl; exit(1) #endif template <int inst> class __malloc_alloc_template { private : static void *oom_malloc (size_t ) static void *oom_realloc (void *, size_t ) static void (* __malloc_alloc_oom_handler) () public : static void * allocate (size_t n) void *result =malloc (n); if (0 == result) result = oom_malloc (n); return result; } static void deallocate (void *p, size_t ) free (p); } static void * reallocate (void *p, size_t , size_t new_sz) void * result =realloc (p, new_sz); if (0 == result) result = oom_realloc (p, new_sz); return result; } static void (* set_malloc_handler(void (*f)())) () void (* old)() = __malloc_alloc_oom_handler; __malloc_alloc_oom_handler = f; return (old); } }; template <int inst> void (* __malloc_alloc_template<inst>::__malloc_alloc_oom_handler)() = 0 ; template <int inst> void * __malloc_alloc_template<inst>::oom_malloc (size_t n) { void (* my_malloc_handler)(); void *result; for (;;) { my_malloc_handler = __malloc_alloc_oom_handler; if (0 == my_malloc_handler) { __THROW_BAD_ALLOC; } (*my_malloc_handler)(); result = malloc (n); if (result) return (result); } } template <int inst> void * __malloc_alloc_template<inst>::oom_realloc (void *p, size_t n) { void (* my_malloc_handler)(); void *result; for (;;) { my_malloc_handler = __malloc_alloc_oom_handler; if (0 == my_malloc_handler) { __THROW_BAD_ALLOC; } (*my_malloc_handler)(); result = realloc (p, n); if (result) return (result); } } typedef __malloc_alloc_template<0 > malloc_alloc;

第一级配置器直接使用malloc(),free(),realloc()等C函数执行实际的内存配置、释放、重配置操作,并实现出类似C++ new handler机制。它有独特的out-of-memory内存处理机制:在抛出std::bad_alloc异常之前,调用内存不足处理例程尝试释放空间,如果用户没有定义相应的内存不足处理例程,那么还是会抛出异常。

所谓C++ new handler机制是,你可以要求系统在内存配置要求无法被满足时,调用一个你所指定的函数。换句话说,一旦::operator new无法完成任务,在丢出std::bad_alloc异常状态之前,会先调用由客户端指定的处理例程,该处理例程通常即被称为new-handler。new-handler解决内存不足的做法有特定的模式。

请注意,SGI第一级配置器的allocate()和realloc()都是在调用malloc()和realloc()不成功后,改调用oom_malloc()和oom_realloc()。后两者都有内循环,不断调用“内存不足处理例程”,期望在某次调用之后,获得足够的内存而圆满完成任务。但如果“内存不足处理例程”并未被客户端设定,oom_malloc()和oom_realloc()便老实不客气地调用__THROW_BAD_ALLOC,丢出bad_alloc异常信息,或利用exit(1)硬生生中止程序。

记住,设计“内存不足处理例程”是客端的责任,设定“内存不足处理例程”也是客端的责任。

第二级配置器__default_alloc_template剖析 相比第一级配置器,第二级配置器多了一些机制,避免小额区块造成内存的碎片。不仅仅是碎片的问题,配置时的额外负担也是一个大问题。因为区块越小,额外负担所占的比例就越大。

额外负担是指动态分配内存块的时候,位于其头部的额外信息,包括记录内存块大小的信息以及内存保护区(判断是否越界) 。要想了解详细信息,请参考MSVC或者其他malloc实现。

SGI STL第二级配置器具体实现思想如下:

如果要分配的区块大于128bytes,则移交给第一级配置器处理。

如果要分配的区块小于128bytes,则以内存池管理(memory pool),又称之次层配置(sub-allocation):每次配置一大块内存,并维护对应的自由链表(free-list)。下次若有相同大小的内存需求,则直接从free-list中取。如果有小额区块被释放,则由配置器回收到free-list中——是的,别忘了,配置器除了负责配置,也负责回收。

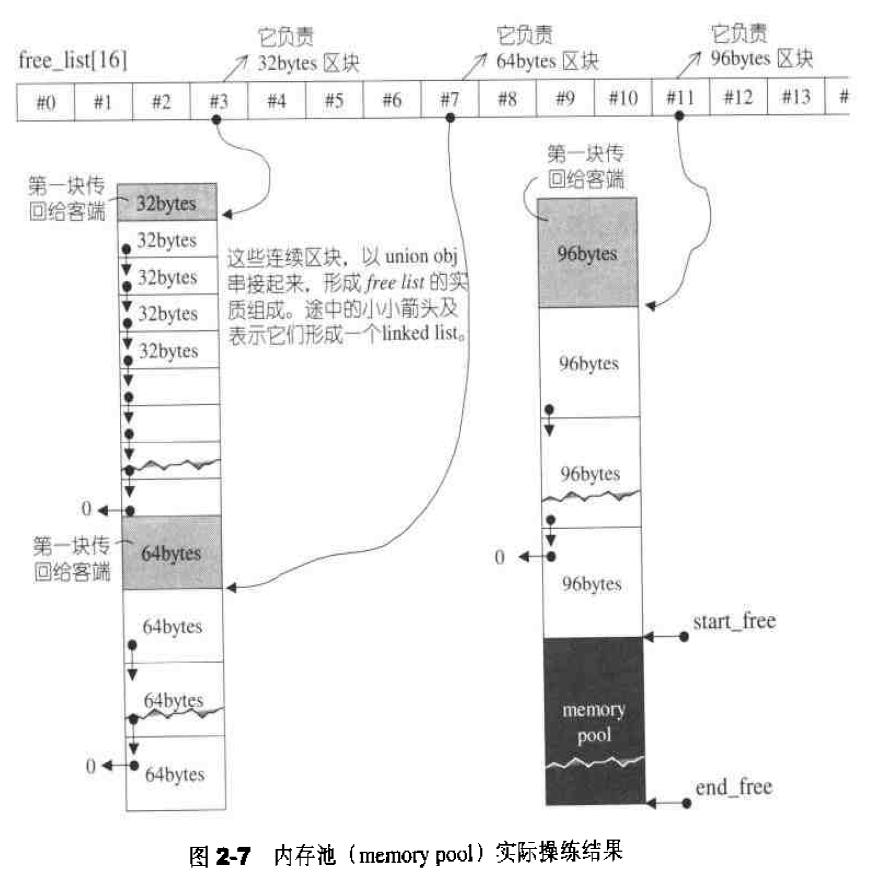

在第二级配置器中,小额区块内存需求大小都被上调至8的倍数,比如需要分配的大小是30bytes,就自动调整为32bytes。系统中总共维护16个free-lists,各自管理大小为8,16,…,128bytes的小额区块。

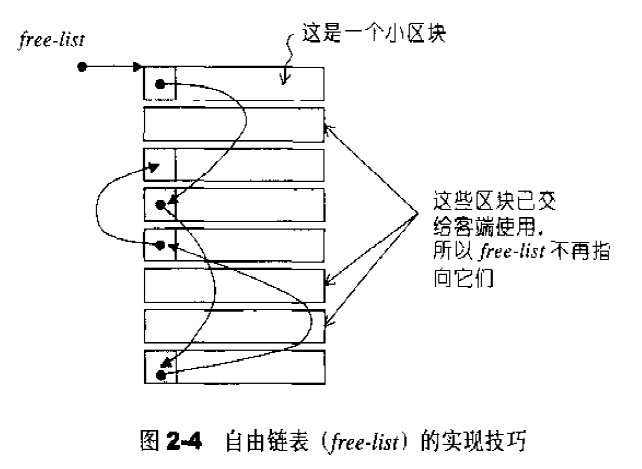

为了维护链表,需要额外的指针,为了避免造成另外一种额外的负担,这里采用了一种技术:用union表示链表节点结构:1 2 3 4 union obj { union obj * free_list_link; char client_data[1 ]; };

下面是第二级配置器的部分实现内容:1 2 3 enum {__ALIGN=8 }; enum {__MAX_BYTES=128 }; enum {__NFREELISTS=__MAX_BYRES/__ALIGN};

以下是第二级配置器总体实现代码概览:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 template <bool threads, int inst>class __default_alloc_template {private : # ifndef __SUNPRO_CC enum {__ALIGN = 8 }; enum {__MAX_BYTES = 128 }; enum {__NFREELISTS = __MAX_BYTES/__ALIGN}; # endif static size_t ROUND_UP (size_t bytes) return (((bytes) + __ALIGN-1 ) & ~(__ALIGN - 1 )); } __PRIVATE: union obj { union obj * free_list_link; char client_data[1 ]; }; private :# ifdef __SUNPRO_CC static obj * __VOLATILE free_list[]; # else static obj * __VOLATILE free_list[__NFREELISTS]; # endif static size_t FREELIST_INDEX (size_t bytes) return (((bytes) + __ALIGN-1 )/__ALIGN - 1 ); } static void *refill (size_t n) static char *chunk_alloc (size_t size, int &nobjs) static char *start_free; static char *end_free; static size_t heap_size; static void * allocate (size_t n) static void deallocate (void *p, size_t n) static void * reallocate (void *p, size_t old_sz, size_t new_sz) template <bool threads, int inst>char *__default_alloc_template<threads, inst>::start_free = 0 ;template <bool threads, int inst>char *__default_alloc_template<threads, inst>::end_free = 0 ;template <bool threads, int inst>size_t __default_alloc_template<threads, inst>::heap_size = 0 ;template <bool threads, int inst>__default_alloc_template<threads, inst>::obj * __VOLATILE __default_alloc_template<threads, inst> ::free_list[ # ifdef __SUNPRO_CC __NFREELISTS # else __default_alloc_template<threads, inst>::__NFREELISTS # endif ] = {0 , 0 , 0 , 0 , 0 , 0 , 0 , 0 , 0 , 0 , 0 , 0 , 0 , 0 , 0 , 0 , };

空间配置函数allocate() __default_alloc_template拥有配置器的标准接口函数allocate(),此函数首先判断区块大小,要分配的区块小于128bytes,调用第一级配置器。否则,向对应的free-list寻求帮助。对应的free list有可用的区块,直接拿过来用。如果没有可用的区块,调用函数refill()为`free list重新填充空间。代码如下:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 static void * allocate (size_t n) { obj * __VOLATILE * my_free_list; obj * __RESTRICT result; if (n > (size_t ) __MAX_BYTES) { return (malloc_alloc::allocate (n)); } my_free_list = free_list + FREELIST_INDEX (n); # ifndef _NOTHREADS lock lock_instance; # endif result = *my_free_list; if (result == 0 ) { void *r = refill (ROUND_UP (n)); return r; } *my_free_list = result -> free_list_link; return (result); };

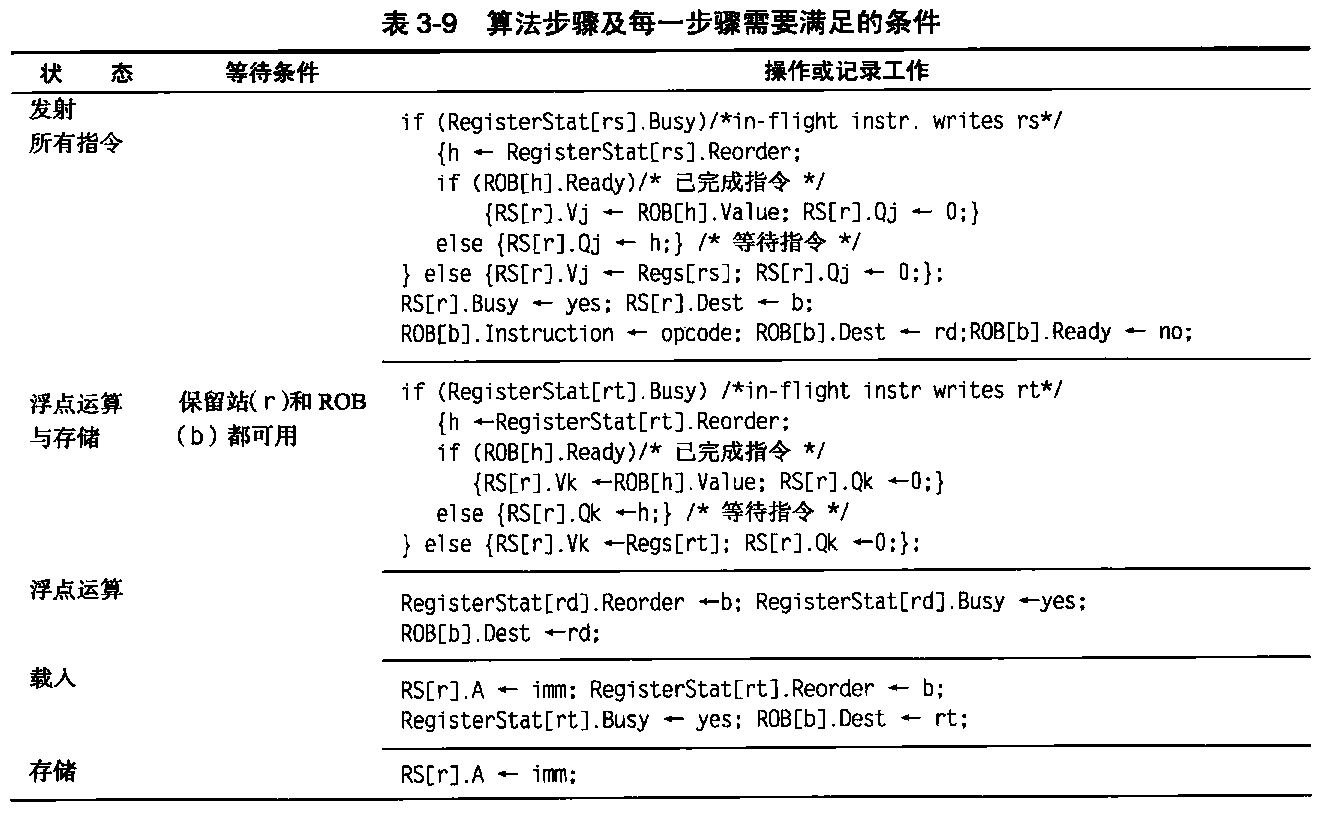

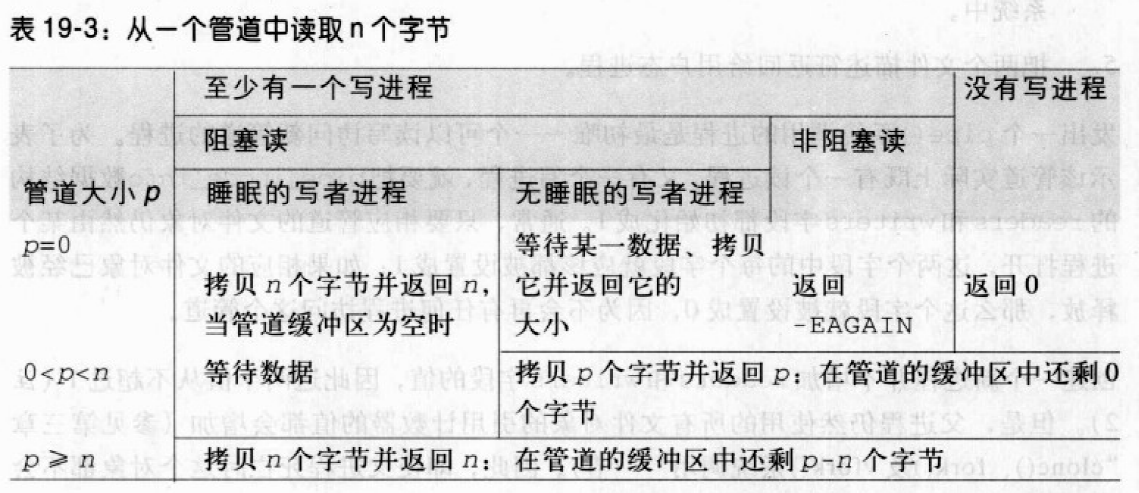

这里需要注意的是,每次都是从对应的free list的头部取出可用的内存块。图示如下:

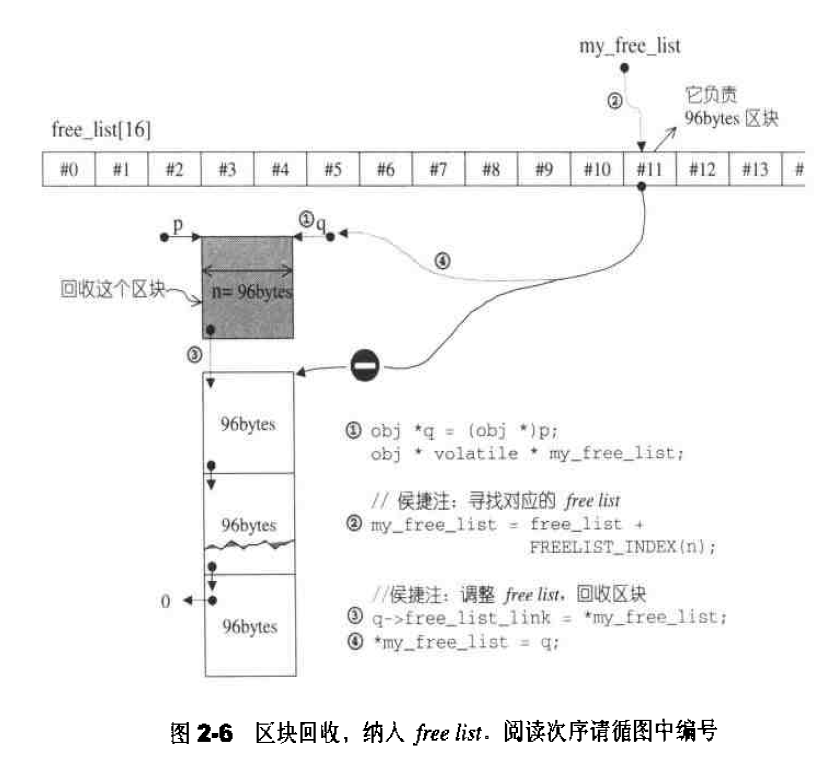

空间释放函数 身为一个配置器,__default_alloc_template拥有配置器的标准接口函数deallocate(),此函数首先判断区块大小,大于128bytes调用第一级配置器。否则,找出对应的free list,将区块回收。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 static void deallocate (void * p, size_t n) obj *q = (obj *)p; obj * volatile * my_free_list; if (n > (size_t ) __MAX_BYTES) { malloc_alloc::deallocate (p, n); return ; } my_free_list = free_list + FREELIST_INDEX (n); q->free_list_link = *my_free_list; *my_free_list = q; }

为free list填充空间 当发现对应的free list没有可用的空闲区块时,就需要调用refill()函数重新填充空间。新的空间将取自于内存池(将经由chunk_alloc()完成)。缺省取得20个新节点(新区块),但万一内存池空间不足,获得的节点数(区块数)可能小于20,内存池的管理后面会讲到。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 template <bool threads, int inst>void * __default_alloc_template<threads, inst>::refill (size_t n){ int nobjs = 20 ; char * chunk = chunk_alloc (n, nobjs); obj * __VOLATILE * my_free_list; obj * result; obj * current_obj, * next_obj; int i; if (1 == nobjs) return (chunk); my_free_list = free_list + FREELIST_INDEX (n); result = (obj *)chunk; *my_free_list = next_obj = (obj *)(chunk + n); for (i = 1 ; ; i++) { current_obj = next_obj; next_obj = (obj *)((char *)next_obj + n); if (nobjs - 1 == i) { current_obj -> free_list_link = 0 ; break ; } else { current_obj -> free_list_link = next_obj; } } return (result); }

内存池 从内存池中取空间供free list使用,是chunk_alloc()的工作。具体实现思想如下:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 template <bool threads, int inst>char *__default_alloc_template<threads, inst>::chunk_alloc (size_t size, int & nobjs) { char * result; size_t total_bytes = size * nobjs; size_t bytes_left = end_free - start_free; if (bytes_left >= total_bytes) { result = start_free; start_free += total_bytes; return (result); } else if (bytes_left >= size) { nobjs = bytes_left/size; total_bytes = size * nobjs; result = start_free; start_free += total_bytes; return (result); } else { size_t bytes_to_get = 2 * total_bytes + ROUND_UP (heap_size >> 4 ); if (bytes_left > 0 ) { obj * __VOLATILE * my_free_list = free_list + FREELIST_INDEX (bytes_left); ((obj *)start_free) -> free_list_link = *my_free_list; *my_free_list = (obj *)start_free; } start_free = (char *)malloc (bytes_to_get); if (0 == start_free) { int i; obj * __VOLATILE * my_free_list, *p; for (i = size; i <= __MAX_BYTES; i += __ALIGN) { my_free_list = free_list + FREELIST_INDEX (i); p = *my_free_list; if (0 != p) { *my_free_list = p -> free_list_link; start_free = (char *)p; end_free = start_free + i; return (chunk_alloc (size, nobjs)); } } end_free = 0 ; start_free = (char *)malloc_alloc::allocate (bytes_to_get); } heap_size += bytes_to_get; end_free = start_free + bytes_to_get; return (chunk_alloc (size, nobjs)); } }

chunk_alloc()函数以end_free - start_free来判断内存池的数量:

内存池剩余空间完全满足20个区块的需求量,则直接取出对应大小的空间。

内存池剩余空间不能完全满足20个区块的需求量,但是足够供应一个及一个以上的区块,则取出能够满足条件的区块个数的空间。

内存池剩余空间不能满足一个区块的大小,则需要利用malloc()从heap中配置内存,为内存池注入活水。

举个例子,见图2-7,假设程序一开始,客端就调用chunk_alloc(32,2O),于是malloc()配置40个32 bytes区块,其中第1个交出,另19个交给free_list[3]维护,余20个留给内存池。接下来客端调用chunk_alloc(64,20),此时free_1ist[7]空空如也,必须向内存池要求支持,内存池只够供应(32*20)/M = 10个64 bytes区块,就把这10个区块返回,第1个交给客端、余9个由free_list[7]维护。此时内存池全空,接下来再调用chunk_alloc(96, 20),此时free_list[11]空空如也,必须向内存池要求支持,而内存池此时也是空的,于是以malloc()配置40+n(附加量)个96 bytes区块, 其中第1个交出,另19个交给free_list[11]维护,余20+n(附加量)个区块留给内存池。

万一山穷水尽,整个system heap空问都不够了(以至无法为内存池注入活水源头),malloc()行动失败,chunk_alloc()就四处寻找有无“尚有未用区块,且区块够大”之free lists。找到了就挖一块交出,找不到就调用第一级配置器,第一级配置器其实也是使用malloc()来配置内存,但它有out-of-memory处理机制(类似new-handler机制),或许有机会释放其它的内存拿来此处使用。如果可以,就成功,否则发出bad_alloc异常。

以上便是整个第二级空间配置器的设计。

回想一些那个提供配置器标准接口的simple_alloc:1 2 3 4 template <class T , class Alloc >class simple_alloc { ... };

SGI容器通常以这种方式来使用配置器:1 2 3 4 5 6 7 8 9 10 template <class T ,class Alloc =alloc> class vector{public : typedef T value_type; ... protected : typedef simple_alloc<value_type,Alloc> data_allocator; ... };

其中第二个template参数所使用的缺省参数alloc,可以是第一级配置器也可以是第二级配置器。不过,SGI STL已经把它设为第二级配置器。

deallocate() 如果需要回收的区块大于128bytes,则调用第一级配置器。如果需要回收的区块小于128bytes,找到对应的free-list,将区块回收。注意是将区块放入free -list的头部。SGI STL源代码:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 static void deallocate (void *p, size_t n) { obj *q = (obj *)p; obj * __VOLATILE * my_free_list; if (n > (size_t ) __MAX_BYTES) { malloc_alloc::deallocate (p, n); return ; } my_free_list = free_list + FREELIST_INDEX (n); # ifndef _NOTHREADS lock lock_instance; # endif q -> free_list_link = *my_free_list; *my_free_list = q; }

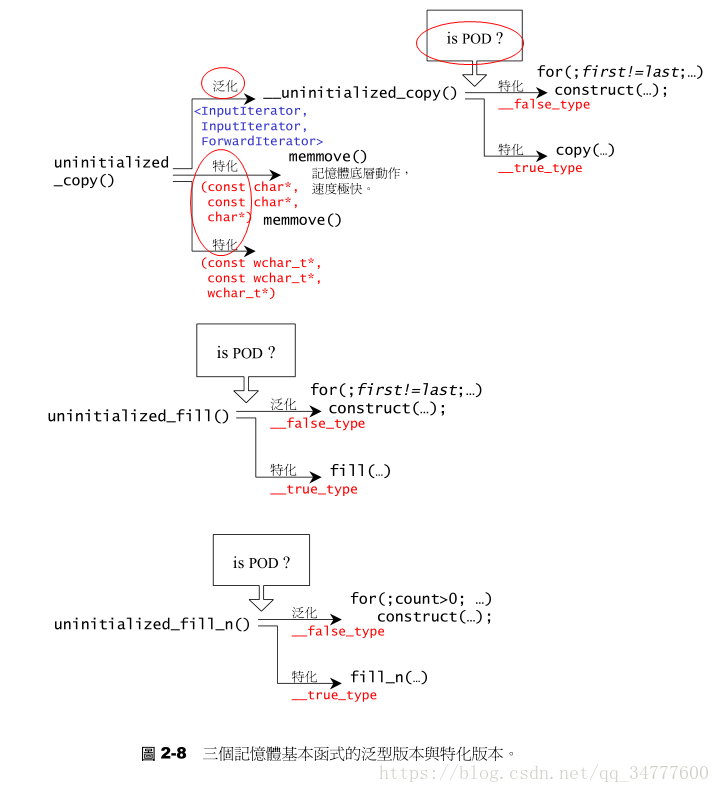

内存基本处理工具 STL定义有五个全局函数,作用于未初始化空间上,这样的功能对于容器的实现很有帮助。前两个函数是用于构造的construct()和用于析构的destroy(),另三个函数是uninitialized_copy(),uninitialized_fill(),uninitialized_fill_n,分别对应于高层次函数copy()、fill()、fill_n()——这些都是STL算法。

uninitialized_copy 1 2 3 template <class InputIterator ,class ForwardIterator >ForwardIterator uninitialized_copy (InputIterator first,InputIterator last,ForwardIterator result) ;

uninitialized_copy()使我们能够将内存的配置和对象的构造行为分离开来,如果作为输出目的地的[result,result+(last-first))范围内的每一个迭代器都指向为初始化区域,则uninitialized_copy()会使用copy constructor,给身为输入来源之[first,last)范围内的每一个对象产生一份复制品,放进输出范围中。换句话说,针对输入范围内的每一个迭代器i,该函数会调用construct(&*(result+(i-first)),*i),产生*i的复制品,放置于输出范围的相对位置上。

如果你需要实现一个容器,uninitialized_copy()这样的函数会为你带来很大的帮助,因为容器的全区间构造函数通常以两个步骤完成:

配置内存块,足以包含范围内的所有元素

使用uninitialized_copy(),在该内存区块上构造元素。

C++标志规格书要求uninitialized_copy()具有“commit or rollback”语意,意思是要么“构造出所有必要的元素”,要么(当有任何一个copy constructor失败时)“不构造任何东西。

uninitialized_fill 1 2 3 template <class ForwardIterator ,class T >ForwardIterator uninitialized_fill (ForwardIterator first,ForwardIterator last,const T& x) ;

uninitialized_fill()也能够使我们将内存配置与对象的构造行为分离开来。如果[first,last)范围内的每个迭代器都指向未初始化的内存,那么uninitialized_fill()会在该范围内产生x(上式第三个参数)的复制品。换句话说,uninitialized_fill()会针对操作范围内的每个迭代器i,调用construct(&*i,x),在i所指之处产生x的复制品。

与uninitialized_copy()一样,uninitialized_fill()必须具备“commit or rollback”语意,换句话说,它要么产生出所有必要元素,要么不产生任何元素,如果有任何一个copy constructor丢出异常(exception),uninitialized_fill(),必须能够将已产生的所有元素析构掉。

uninitialized_fill_n 1 2 3 template <class ForwardIterator ,class Size ,class T >ForwardIterator uninitialized_fill_n (ForwardIterator first,Size n,const T& x) ;

uninitialized_fill_n()能使我们将内存配置与对象构造行为分离开来,它会为指定范围内的所有元素设定相同的初值。

如果[first,first+n)范围内的每一个迭代器都指向未初始化的内存,那么uninitialized_fill_n()会调用 copy constructor,在该范围内产生x(上式第三个参数——的复制品。也就是说,面对[first,first+n)范围内的每个迭代器i,uninitialized_fill_n()会调用construct(&*i,x),在对应位置产生x的复制品。

uninitialized_fill_n()也具有“commit or rollback”语意:要么产生所有必要的元素,否则就不产生任何元素。如果任何一个copy constructor丢出异常(exception),uninitialized_fill_n()必须析构已产生的所有元素。

以下分别介绍这三个函数的实现法,其中所呈现的iterators(迭代器)、value_type()、_type_traits、_true_type、_false_type、is_POD_type等实现技术,都在后面介绍。

uninitialized_fill_n() 本函数接受三个参数:

迭代器first指向欲初始化空间的起始处;n表示欲初始化空间的大小;x表示初值。

1 2 3 4 template <class ForwardIterator ,class Size ,class T >inline ForwardInterator uninitialized_fill_n (ForwardIterator first, Size n, const T& x) return __uninitialized_fill_n(first, n, x, value_type (first)); }

这个函数的逻辑是,首先萃取出迭代器first的value_type,然后判断是否是POD型别:1 2 3 4 5 template <class ForwardIterator , class Size , class T , class T1 >inline ForwardInterator __uninitialized_fill_n(ForwardIterator first, Size n, const T& x, T1*) { typedef typename __type_traits<T1>::is_POD_type is_POD; return __uninitialized_fill_n_aux(first, n, x, is_POD ()); }

POD意为Plain Old Data,也就是标量型别,或传统的C struct型别,可以用最有效率的初值填写手法,而对non_POD型别采取最保险的做法。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 template <class ForwardIterator ,class Size ,class T >inline ForwardInterator __uninitialized_fill_n_aux(ForwardIterator first, Size n, const T& x, __true_type) { return fill_n (first, n, x); } template <class ForwardIterator ,class Size ,class T >inline ForwardInterator __uninitialized_fill_n_aux(ForwardIterator first, Size n, const T& x, __false_type) { ForwardIterator cur = first; for (; n > 0 ; --n, ++ cur) construct (&*cur, x); return cur; }

uninitialized_copy() uninitialized_copy()接受三个函数:

迭代器first指向输入端的起始位置

迭代器last指向输入端的结束位置

迭代器rsult指向输出端(欲初始化空间)的起始处

1 2 3 4 template <class InputIterator , class ForwardIterator >inline ForwardInterator uninitialized_copy (InputIterator first, InputIterator last, ForwardIterator result) return __uninitialized_copy(first, last, result, value_type (result)); }

这个函数的逻辑是,首先萃取出迭代器result的value_type,然后判断是否是POD型别:1 2 3 4 5 template <class InputIterator , class ForwardIterator , class T >inline ForwardInterator __uninitialized_copy(InputIterator first, InputIterator last, ForwardIterator result, T*) { typedef typename __type_traits<T>::is_POD_type is_POD; return __uninitialized_copy_aux(first, last, result, is_POD ()); }

POD可以用最有效率的初值填写手法,而对non_POD型别采取最保险的做法。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 template <class InputIterator , class ForwardIterator >inline ForwardInterator __uninitialized_copy_aux(InputIterator first, InputIterator last, ForwardIterator result, __true_type) { return copy (first, last, result); } template <class InputIterator , class ForwardIterator >ForwardInterator __uninitialized_copy_aux(InputIterator first, InputIterator last, ForwardIterator result, __false_type) { ForwardIterator cur = first; for (; first != last; ++ first, ++ cur) construct (&*cur, *first); return cur; }

针对char*和wchar_t*两种型别,可以采用最具效率的做法memmove执行复制行为:1 2 3 4 5 6 7 8 9 inline char * uninitialized_copy (const char * first, const char * last, char * result) memmove (rseult, first, last-first); return result + (last - first); } inline wchar_t * uninitialized_copy (const wchar_t * first, const wchar_t * last, wchar_t * result) memmove (rseult, first, sizeof (wchar_t ) * (last-first)); return result + (last - first); }

uninitialized_fill_n() 本函数接受三个参数:

迭代器first指向欲初始化空间的起始处;

迭代器last指向输出端的结束处;

x表示初值。

1 2 3 4 template <class ForwardIterator , class T >inline void uninitialized_fill (ForwardIterator first, ForwardIterator last, const T& x) __uninitialized_fill(first, last, x, value_type (first)); }

这个函数的逻辑是,首先萃取出迭代器first的value_type,然后判断是否是POD型别:1 2 3 4 5 template <class ForwardIterator , class T , class T1 >inline void __uninitialized_fill(ForwardIterator first, ForwardIterator last, const T& x, T1*) { typedef typename __type_traits<T1>::is_POD_type is_POD; return __uninitialized_fill_aux(first, last, x, is_POD ()); }

POD意为Plain Old Data,也就是标量型别,或传统的C struct型别,可以用最有效率的初值填写手法,而对non_POD型别采取最保险的做法。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 template <class ForwardIterator , class T >inline void __uninitialized_fill_aux(ForwardIterator first, ForwardIterator last, const T& x, __true_type) { fill (first, last, x); } template <class ForwardIterator ,class Size ,class T >inline void __uninitialized_fill_aux(ForwardIterator first, ForwardIterator last, const T& x, __false_type) { ForwardIterator cur = first; for (; cur != last; ++ cur) construct (&*cur, x); }

迭代器概念与traits编程技法 迭代器是一种抽象的设计概念,现实程序语言中并没有直接对应于这个概念的实物。

迭代器设计思维——STL关键所在 不论是泛型思维或STL的实际运用,迭代器都扮演这重要的角色。STL的中心思想在于:将数据容器和算法分开,彼此独立设计,最后再以一贴胶着剂将它们撮合在一起。容器和算法的泛型化,从技术的角度来看是并不困难,C++的class template和function templates可分别达成目标。

以下是容器、算法、迭代器的合作展示,以算法find()为例,它接受两个迭代器和一个“搜索目标”:1 2 3 4 5 6 7 template <class InputIterator ,class T >InputIterator find (InputIterator first,InputIterator last,const T& value) while (first=!last&&*first!=value) ++first; return first; }

find()便能够对不同的容器进行直接操作:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 #include <vector> #include <list> #include <deque> #include <algorithm> #include <iostream> using namespace std;int main () const int arraySize=7 ; int ia[arraySize]={0 ,1 ,2 ,3 ,4 ,5 ,6 }; vector<int > ivect (ia,ia+arraySize) ; list<int > ilist (ia,ia+arraySize) ; deque<int > ideque (ia,ia+arraySize) ; vector<int >::iterator it1=find (ivect.begin (),ivect.end (),4 ); if (it1!=ivect.end ()) cout<<"4 found. " <<*it1<<endl; else cout<<"4 not found." <<endl; list<int >::iterator it2=find (ilist.begin (),ilist.end (),6 ); if (it2==ilist.end ()) cout<<"6 not found. " <<endl; else cout<<"6 found. " <<*it2<<endl; deque<int >::iterator it3=find (ideque.begin (),ideque.end (),8 ); if (it3==ideque.end ()) cout<<"8 not found." <<endl; else cout<<"8 found. " <<*it3<<endl; }

迭代器是一种smart pointer 迭代器是一种行为类似指针的对象,而指针的各种行为中最常见也最重要的便是内容提领(dereference)和成员访问(member access),因此,迭代器最重要的编程工作就是对operator*和operator->进行重载工作。关于这一点,C++标准库有一个auto_ptr可供我们参考。这是一个用来包含原生指针的对象,声名狼藉的内存泄露问题可借此获得解决。auto_ptr用法如下,和原生指针一模一样:1 2 3 4 5 6 7 void func () auto_ptr<string> ps (new string("jjhou" )) ; cout<<*ps<<endl; cout<<ps->size ()<<endl; }

new动态配置一个初值为”jjhou”的string对象,并将所得的结果(一个原生指针)作为auto_ptr<string>对象的初值。注意,auto_ptr尖括号内放的是”原生指针所指对象“的型别,而不是原生指针的型别。

auto_ptr的源代码在头文件<memory>中:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 template <class T >class auto_ptr {public : explicit auto_ptr (T *p=0 ) :pointee(p) { template <class U> auto_ptr (auto_ptr<U>& rhs) :pointee(rhs.release()) { } ~auto_ptr () {delete pointee;} template <class U > auto_ptr<T>& operator =(auto_ptr<U> &rhs) { if (this !=rhs) reset (ths.release ()); return *this ; } T& operator *() const { return *pointee;} T* operator ->() const { return pointee;} T* get () const {return pointee;} private : T *pointee; };

有了模仿对象,现在我们来为list(链表)设计一个迭代器,假设list及其节点的结构如下:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 #include <iostream> using namespace std;template <class T >class ListItem { public : ListItem (T value):_value(value), _next(NULL ){} T value () { return _value; } void setNext (ListItem<T> *newNode) _next = newNode; } ListItem* getNext () { return _next; } private : T _value; ListItem* _next; }; template <class T >class List { public : List ():_size(0 ) { _front = _end = NULL ; } void insert_front (T value) ListItem<T> *newNode = new ListItem <T>(value); if (_size == 0 ) { _end = _front = newNode; } else { newNode -> setNext (_front); _front = newNode; } _size++; } void insert_end (T value) ListItem<T> *newNode = new ListItem <T>(value); if (_size == 0 ) { _end = _front = newNode; } else { _end -> setNext (newNode); _end = _end -> getNext (); } _size++; } void display () ListItem<T>* temp = _front; while (temp != _end -> getNext ()) { printf ("%d " , temp -> value ()); temp = temp -> getNext (); } printf ("\n" ); } void getSize () printf ("%d\n" , _size); } ListItem<T>*front () { return _front; } ListItem<T>*back () { return _end; } private : ListItem<T>* _end; ListItem<T>* _front; long _size; }; template <class Item >struct ListIter { Item* ptr; ListIter (Item* p = 0 ):ptr (p) {} Item& operator * () const {return *ptr;} Item* operator -> () const {return ptr;} ListIter& operator ++() { ptr = ptr -> getNext (); return *this ; } ListIter operator ++(int ) { ListIter tmp = *this ; ++*this ; return tmp; } bool operator ==(const ListIter& i)const { return ptr == i.ptr; } bool operator !=(const ListIter& i)const { return ptr != i.ptr; } }; ListIter<ListItem<int > > find (ListIter<ListItem<int > > &begin, ListIter<ListItem<int > > &end, int value) { ListIter<ListItem<int > > first = begin; ListIter<ListItem<int > > last = end; while ( first != last -> getNext ()) { if (first -> value () != value) { first++; } else { return first; } } return end -> getNext (); }

并且加上测试程序:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 int main () List<int > m_ListItor; for (int i = 0 ; i < 6 ; i++) { m_ListItor.insert_front (i); m_ListItor.insert_end (i + 2 ); } m_ListItor.display (); ListIter<ListItem<int > > begin (m_ListItor.front ()); ListIter<ListItem<int > > end (m_ListItor.back ()); ListIter<ListItem<int > > iter; iter = find (begin, end, 3 ); if (iter == end -> getNext ()) { printf ("%s" , "not found" ); } else { printf ("%d\n" , iter -> value ()); } iter = find (begin, end, 8 ); if (iter == end -> getNext ()) { printf ("%s" , "not found" ); } else { printf ("%d" , iter -> value ()); } return 0 ; }

以上可以看出,为了完成一个针对List而设计的迭代器,我们必须暴露太多有关于List实现细节,在main函数中制作begin()和end()两个迭代器,我们暴露了ListItem,在ListIter class中为了达成operator++,我们暴露了ListItem的操作函数getNext(),如果不是为了迭代器,ListItem是要完全隐藏起来不曝光的。换句话说只有对ListItem的实现细节特别了解,才能设计出迭代器,既然这无法避免,干脆把迭代器的设计工作交给 List 的设计者,如此一来,所有实现细节反而不被使用者发现,这也是为什么 STL 的每一种容器都有自己专属的迭代器的原因。

迭代器相应型别 在算法运用迭代器的时候,很可能用到起相应型别(即迭代器所指之物的型别),但C++支持sizeof ,并无typeof。可以利用function template的参数推导机制 。

函数参数的情况1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 #include <iostream> using namespace std;template <class I ,class T >void func_impl (I iter,T t) T tmp; } template <class I >void func (I iter) func_impl (iter,*iter); } int main () int i; func (&i); }

我们以func()为对外接口,却把实际操作全部置于func_impl()之中。由于func_impl()是一个function template,一旦被调用,编译器会自动进行template参数推导,于是导出型别,顺利解决了问题。迭代器相应型别(associated types)不只是“迭代器所指对象的型别”一种而已。根据经验,最常用的相应型别有五种,然而并非任何情况下任何一种都可利用上述的template参数推导机制来取得,我们需要更全面的解法。

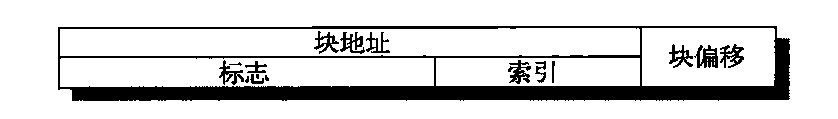

Traits编程技法——STL源代码门钥 迭代器所指对象的型别,称为该迭代器的value type,上述的参数型别推导技巧虽然可用于value,却非全面可用:万一value type必须用于函数的传回值,就束手无策了,毕竟函数的”template参数推导机制”推而导之的只是参数,无法推导函数的返回值类型。

声明内嵌类型是个好主意:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 #include <iostream> using namespace std;template <class T >class MyIter {public : typedef T value_type; T* ptr; MyIter (T* p=0 ):ptr (p){} T& operator *()const { return *ptr; } }; template <class I >typename I::value_typefunc (I ite){ return *ite; } int main () MyIter<int > ite (new int (8 )) ; cout<<func (ite); }

注意,func()的返回类型必须加上关键词,因为是一个template参数,在它被编译器具现化之前,编译器对此一无所悉,换句话说,编译器此时并不知道MyIter<T>::value_type代表的是一个型别或是一个member function或是一个data member。关键词的用意在于告诉编译器这是一个型别,如此才能顺利通过编译。但是并不是所有迭代器都是class,原生指针就不是,如果不是就无法为它定义内嵌型别,但STL(以及整个泛型思维)绝对必须接受原生指针作为一种迭代器,所以上面这样还不够。template partial speciahzation可以做到。

Partial Specialization(偏特化)的意义 如果class template 拥有一个以上的template参数,我们可以针对其中某个(或数个,但非全部)template参数进行特化工作。换句话说,我们可以在泛化设计中提供一个特化版本(也就是将泛化版本中的某些template参数赋予明确的指定)。例如,面对以下这么一个class template:1 2 template <typename T>class C { ... };

我们便很容易接受它有一个形式如下的partial specialization1 2 template <typename T>class C <T* { ... };

有了这项利器,我们便可以解决前述“内嵌型别”未能解决的问题。先前的问题是,原生指针并非class,因此无法为它们定义内嵌型别。现在,我们可以针对“迭代器之template参数为指针”者,设计特别版的迭代器。

下面这个class template专门用来“萃取”迭代器的特性,而value type正是迭代器的特性之一:1 2 3 4 5 6 7 #include <iostream> using namespace std;template <class T >struct iterator_traits { typedef typename I::vlue_type value_type; };

这个所谓的traits,其意义是,如果I定义自己的value type,那么通过这个traits的作用,萃取出来的value_type就是I::value_type。换句话说,如果I定义有自己的value type ,那个func()可以改写成这样:1 2 3 4 5 6 template <class T >typename iteraotr_traits<T>::value_type func (T ite) { return *ite; }

iterator_traites拥有一个partial specializations如下:1 2 3 4 5 template <class >struct iterator_traits <T*>{ typedef T value_type; };

于是,原生指针int*虽然不是一种class type ,亦可通过traits取其value type。这就解决了先前的问题。但是注意针对“指向常数对象的指针(pointer-to-const)”,下面这个式子得到什么结果:1 iterator_traits<const int *>::value_type

1 2 3 4 template <class T >struct iterator_traits <const T*>{ typedef T value_type; };

*int或const int*,都可以通过traits取出正确的(我们所期望的)value type。

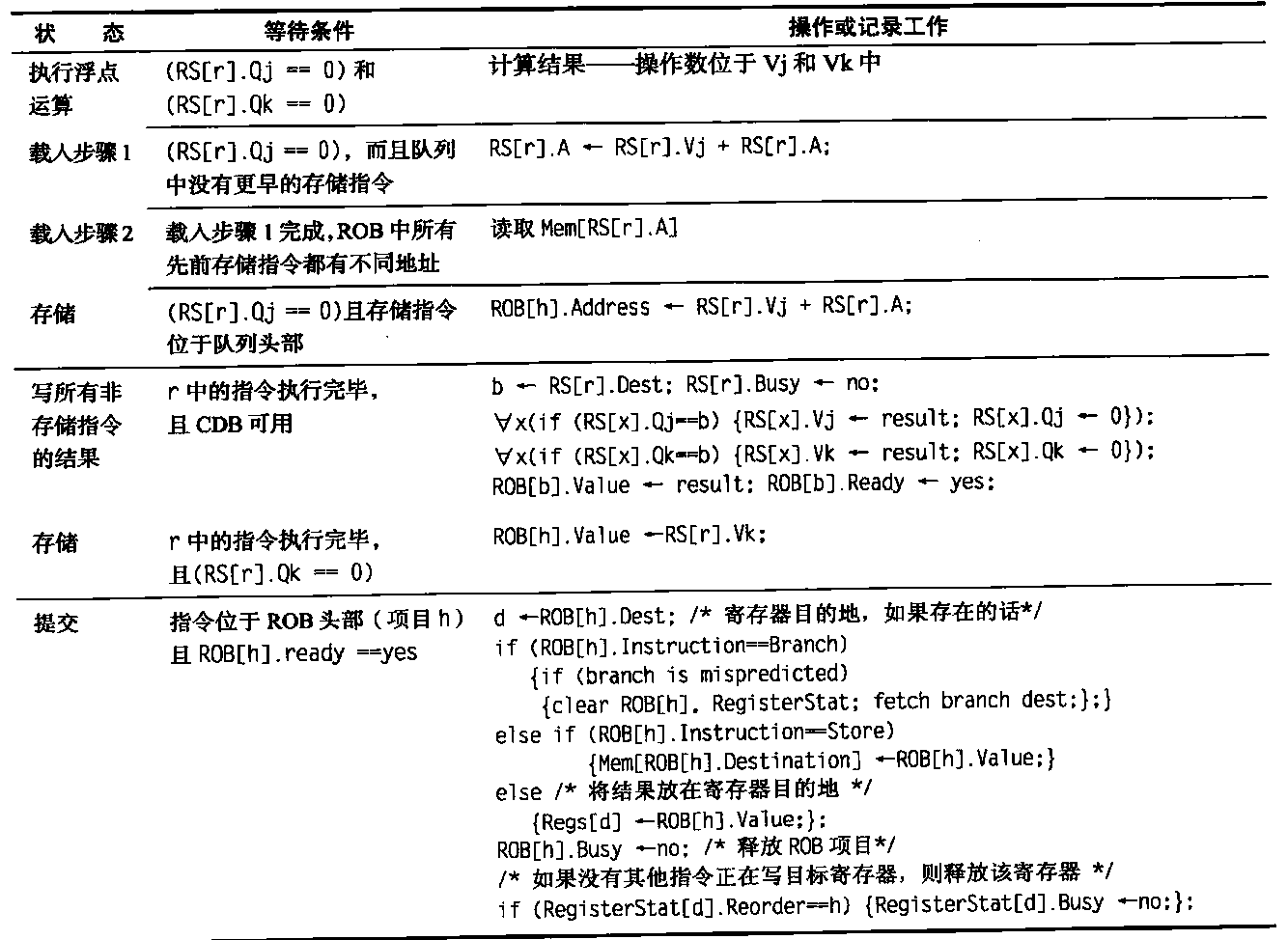

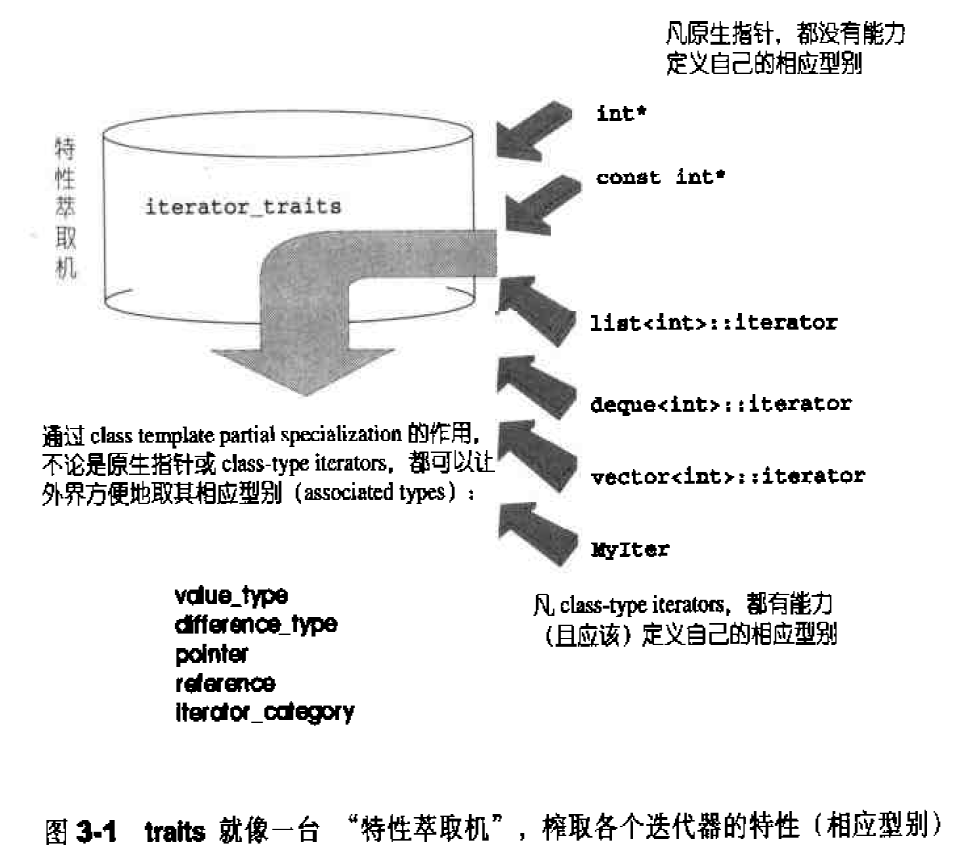

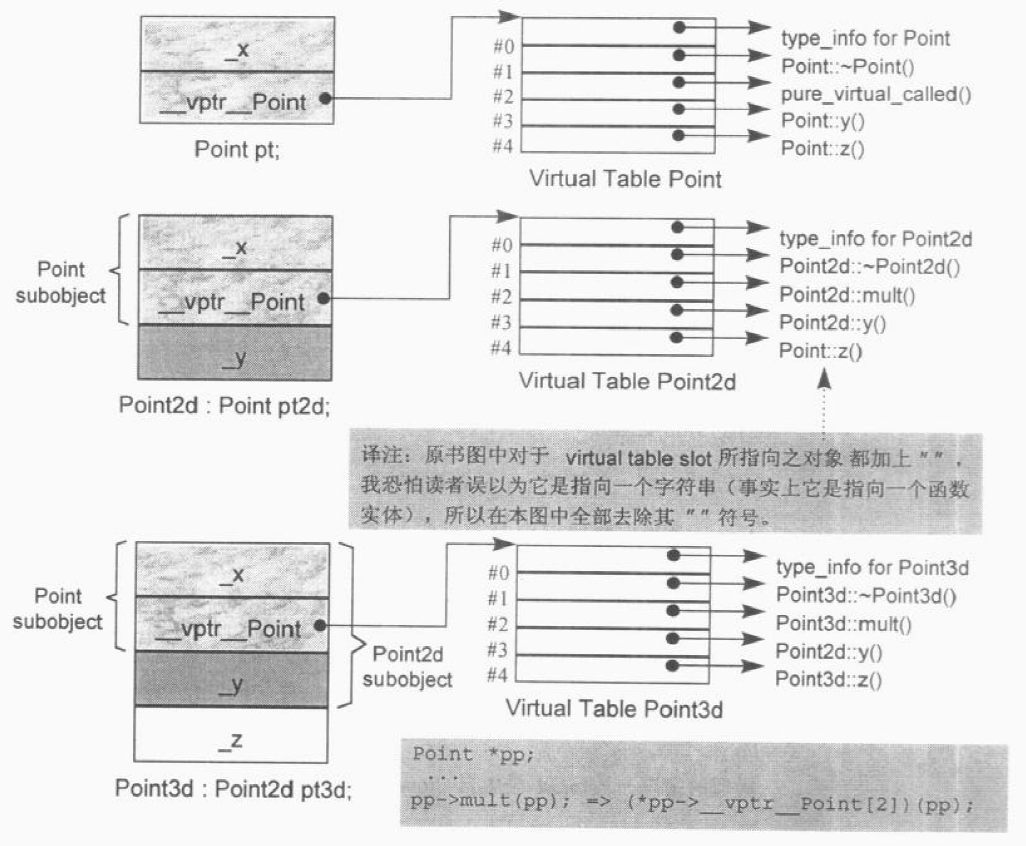

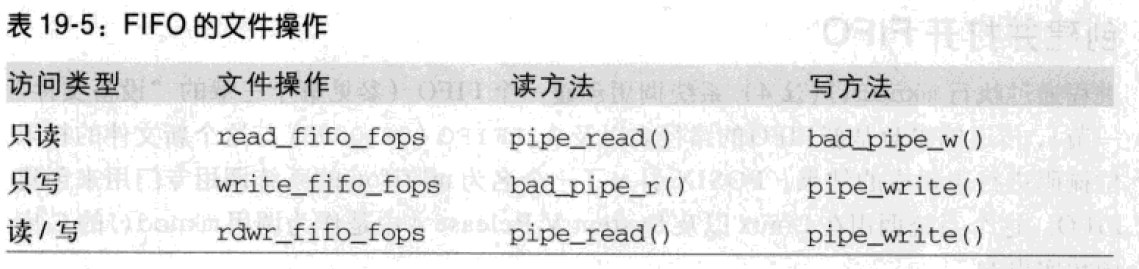

下图说明了traits所扮演的“特性萃取机”角色,萃取各个迭代器的特性。这里所谓的迭代器特性,指的是迭代器的相应型别。当然,若要这个“特性萃取机”traits嫩够有效运作,每一个迭代器必须遵守约定,自行以内嵌型别定义的方式定义出相应型别。这是一个约定,谁不遵守约定,谁就不能兼容STL这个大家庭。

根据经验,最常用到的迭代器相应型别有五种:value type,difference type,pointer,reference,iterator categoly。如果你希望你所开发的容器能与STL水乳交融,一定要为你的容器的迭代器定义这五种相应型别。“特性萃取机”traits会很忠实地将其原汁原味榨取出来:

1 2 3 4 5 6 7 temp1ate <class I > struct itarator_traits { typedef typename I::iterator_category iterator_category; typedef typename I::value_type value_type; typedef typename I::difference_type difference_type; typedef typename I::pointer pointer; typedef typename I::reference reference;

iterator_traits`必须针对传入的型别为pointer及pointer-to-const者,设计特化版本,稍后数节为你展示如何进行。

迭代器相应型别之一:value type 所谓value type,是指迭代器所指对象的型别 。任何一个打算与STL算法有完美搭配的class,都应该定义自己的value type内嵌型别,例如STL中的vector定义:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 template <class T ,class Alloc = alloc>class vector { public : typedef T value_type; typedef value_type* pointer; typedef const value_type* const_pointer; typedef value_type* iterator; typedef const value_type* const_iterator; typedef value_type& reference; typedef const value_type& const_reference; typedef size_t s ize_type; typedef ptrdiff_t difference_type; ... };

迭代器相应型别之二:difference type difference type用来表示两个迭代器之间的距离,因此它也可以用来表示一个容器的最大容量,因为对于连续空间的容器而言,头尾之间的距离就是其最大容量。如果一个泛型算法提供计数功能,例如STL的count(),其传回值就必须使用迭代器的diference type:1 2 3 4 5 6 7 8 9 template <class I ,class T >typename iterator_traits<I>::difference_type count (I first, I last, const T& value) typename iterator_traits<I>::difference_type n=0 ; for (;first!=last;++first) if (*first == value) ++n; return n; }

ptrdiff_L作为原生指针的difference type:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 template <class I >struct iterator_traits { ... typedef typename I::difference_type difference_type; }; template <class T >struct iterator_traits <T*> { ... typedef ptrdiff_L difference_type; }; template <class T >struct iterator_traits <const T*> { ... typedef ptrdiff_t difference_type; };

1 typename iterator_traits<I>::difference_type;

迭代器相应型别之三:reference type 从“迭代器所指之物的内容是否允许改变”的角度观之,迭代器分为两种:不允许改变“所指对象之内容”者 ,称为constant iterators,例如const int* pic;允许改变“所指对象之内容”者 ,称为 mutable iterators,例如int* pi。 当我们对一个 mutable iterators做解引用时,获得的应该是个左值(lvalue) ,可以被赋值。1 2 3 4 int * pi = new int (5 );const int * pci = new int (9 );*pi = 7 ; *pci = 1 ;

在 C++中,函数如果要返回左值,都是以by reference的方式进行 ,所以当p是个mutable iterators时,如果其value type是T,那么*p的型别不应该是T,应该是T&。将此道理扩充,如果p是一个 constant iterators,其value type是 T,那么*p的型别不应该是const T,而应该是const T&。*p的型别,即所谓的reference type。

迭代器相应型别之四:pointer type pointers和 references 在C++中有非常密切的关连。 如果“传回一个左值,令它代表p所指之物”是可能的,那么“传回一个左值,令它代表p所指之物的位址”也一定可以。 我们能够传回一个 pointer,指向迭代器所指之物。

这些相应型别已在先前的ListIter class中出现过:1 2 Item& operator *() const { return *ptr; } Item* operator ->() const { return ptr; }

Item&便是ListIter的reference type而Item*便是其pointer type。

现在把reference type和pointer type这两个相应型别加入traits内:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 template <class I >struct iterator_traits { typedef typename I::pointer pointer; typedef typename I::reference reference; } template <class T >struct iterator_traits <T*> { ... typedef T* pointer; typedef T& reference; }; template <class T >struct iterator_traits <const T*> { ... typedef const T* pointer; typedef const T& reference; };

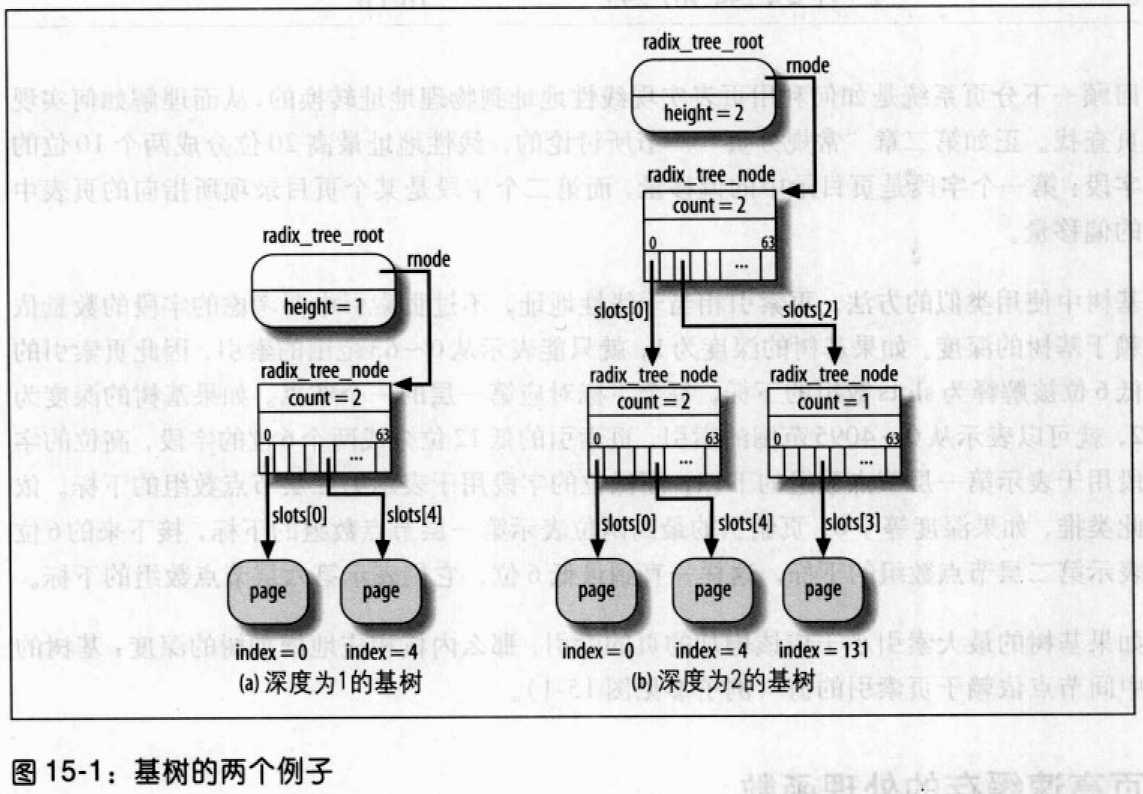

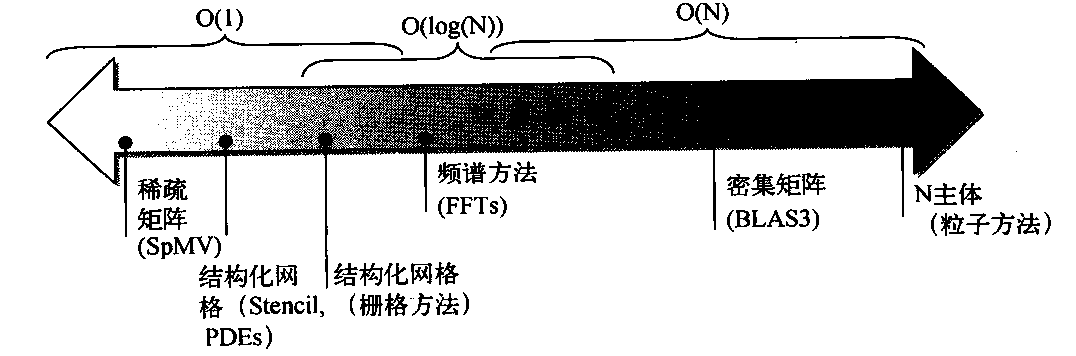

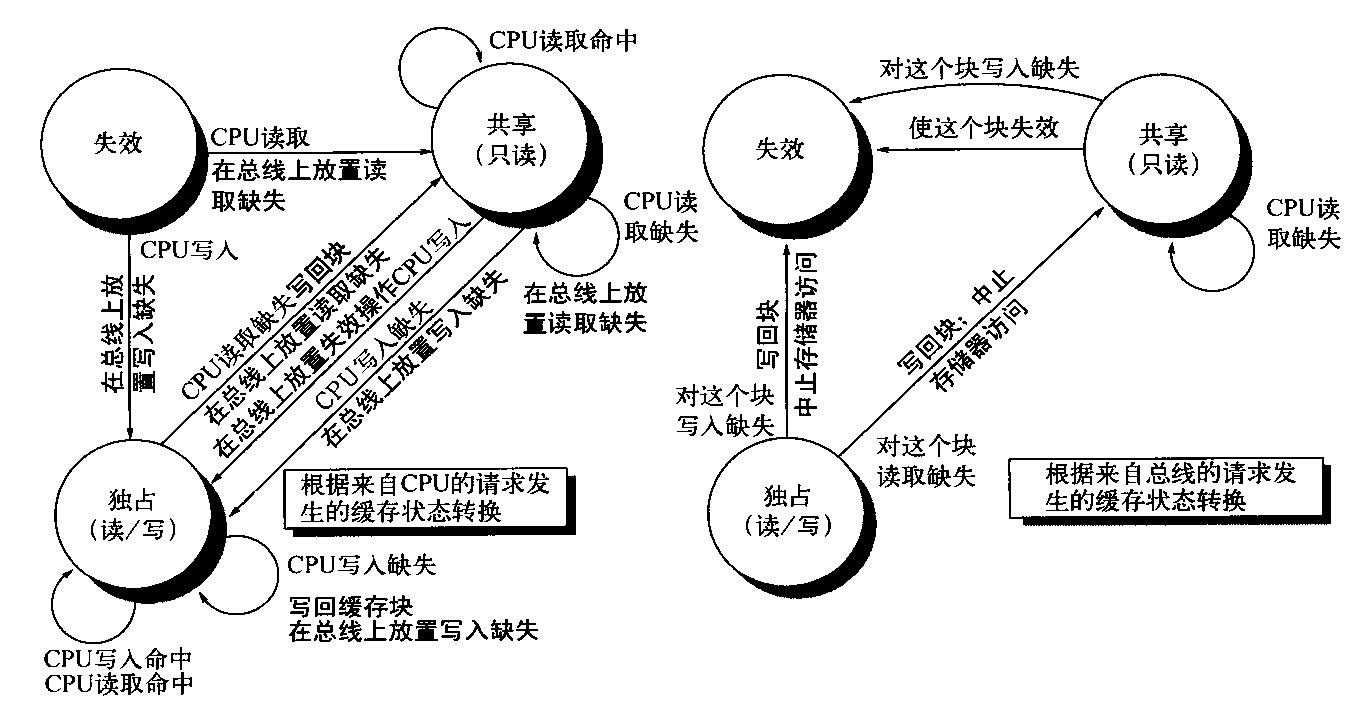

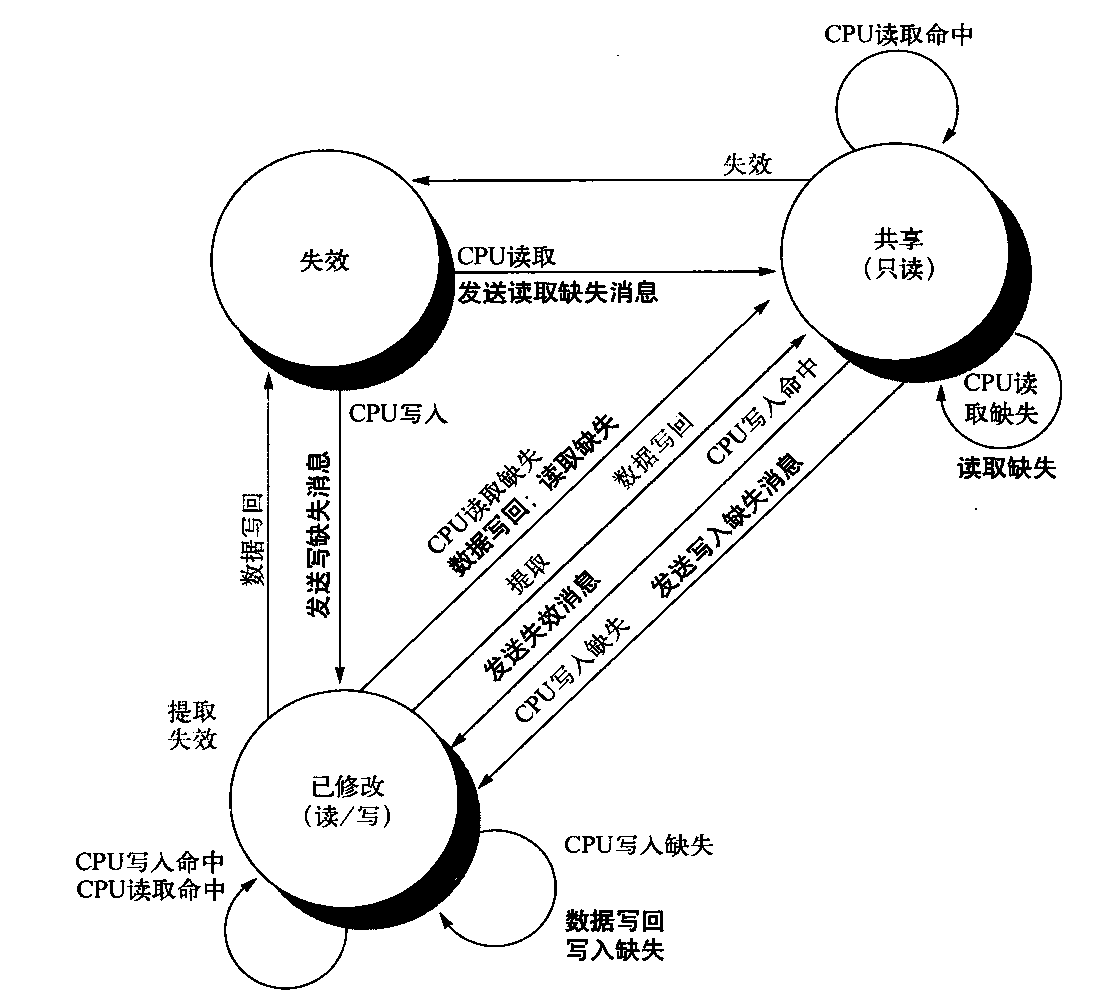

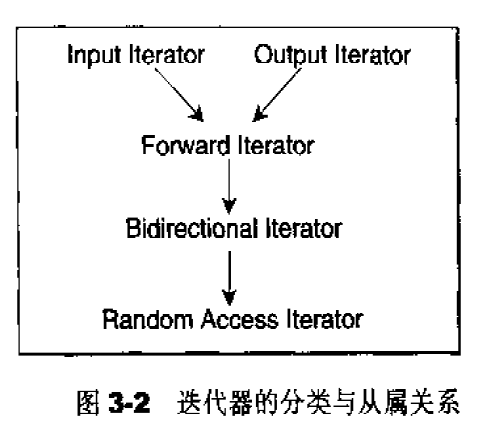

迭代器相应型别之五:iterator_category 最后一个(第五个)迭代器的相应型别会引发较大规模的写代码工程。在那之前,我必须先讨论迭代器的分类。

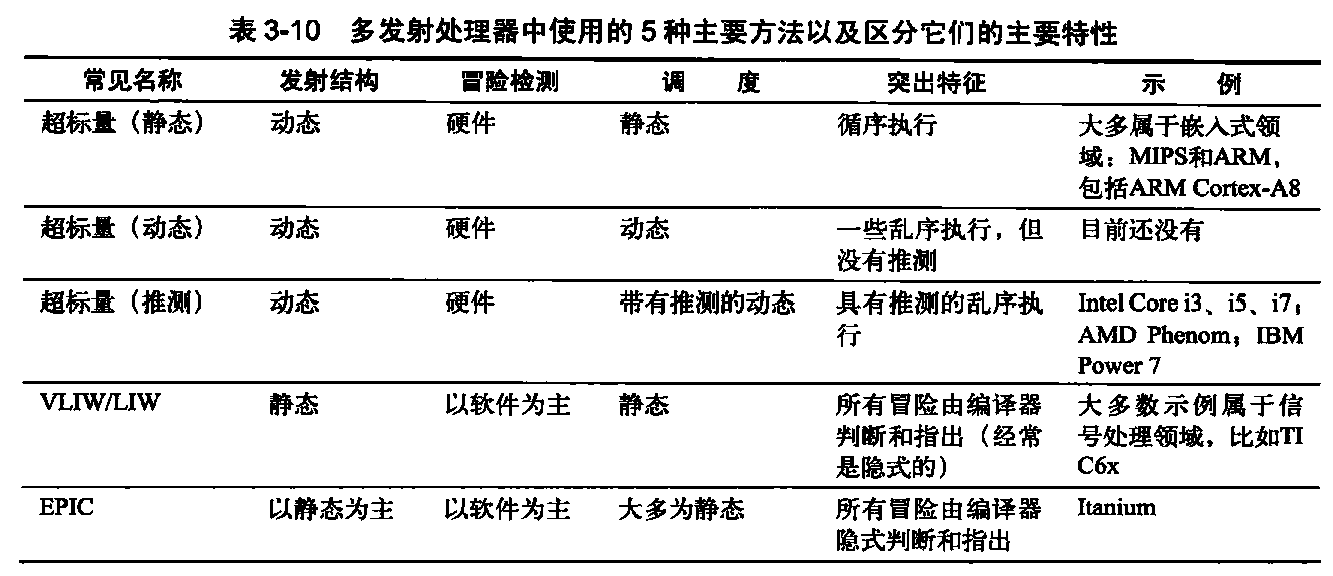

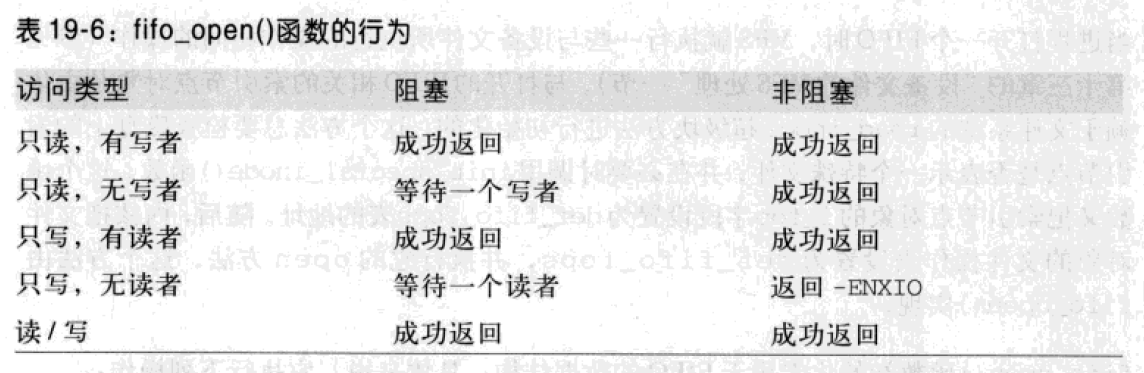

根据移动特性与施行操作,迭代器被分为五类:

Input lterator:这种迭代器所指的对象,不允许外界改变。只读(read only)。

Output terator:唯写(write only)。

Forward lterator:允许“写入型”算法(例如replace())在此种迭代器所形成的区间上进行读写操作。

Bidirectiona lterator:可双向移动。某些算法需要逆向走访某个迭代器区间(例如逆向拷贝某范围内的元素),可以使用Biairectional lterators。

Random Access lterator:前四种迭代器都只供应一部分指针算术能力(前三种支持operator++,第四种再加上operator--),第五种则涵盖所有指针算术能力,包括p+n,p-n,p[n],p1-p2,p1<p2。

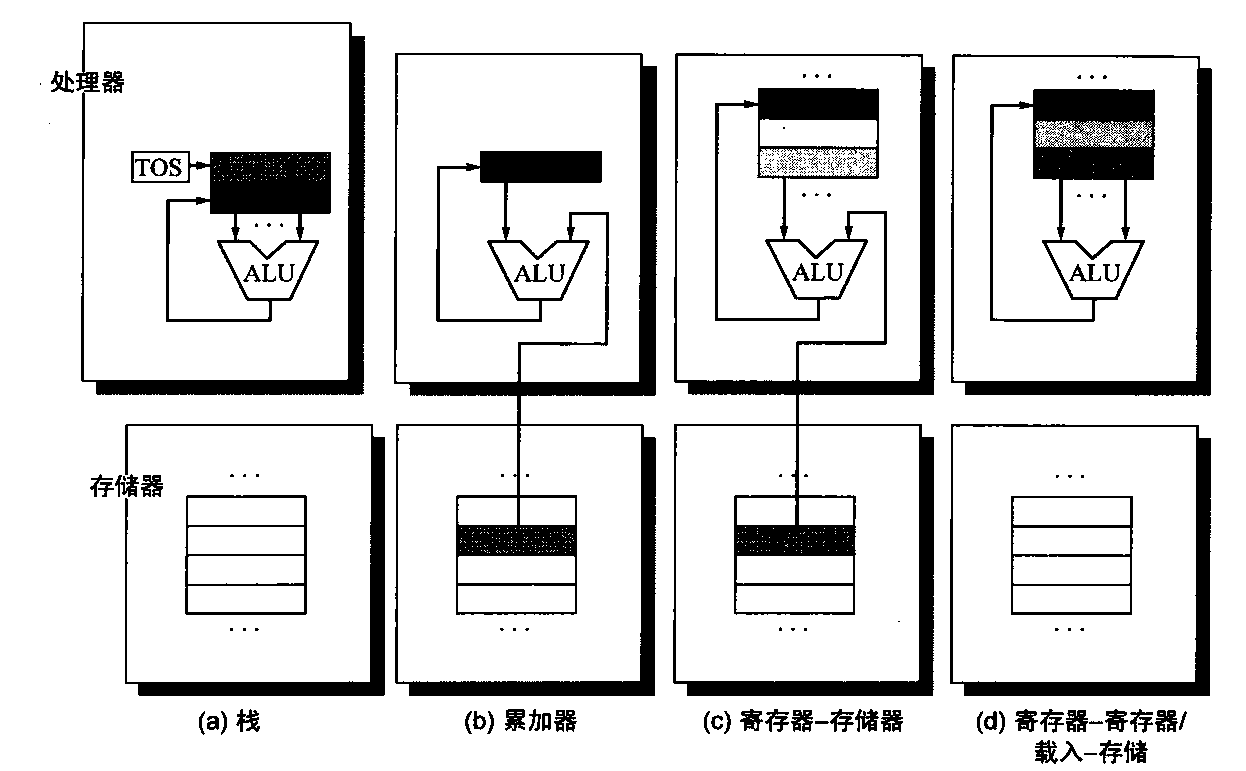

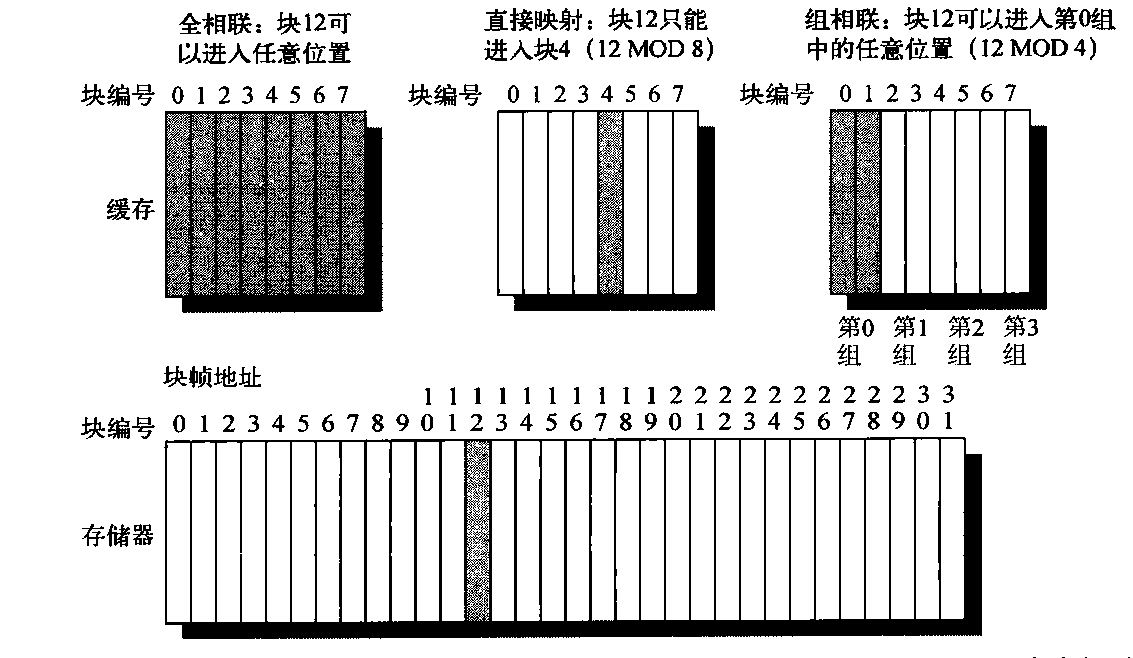

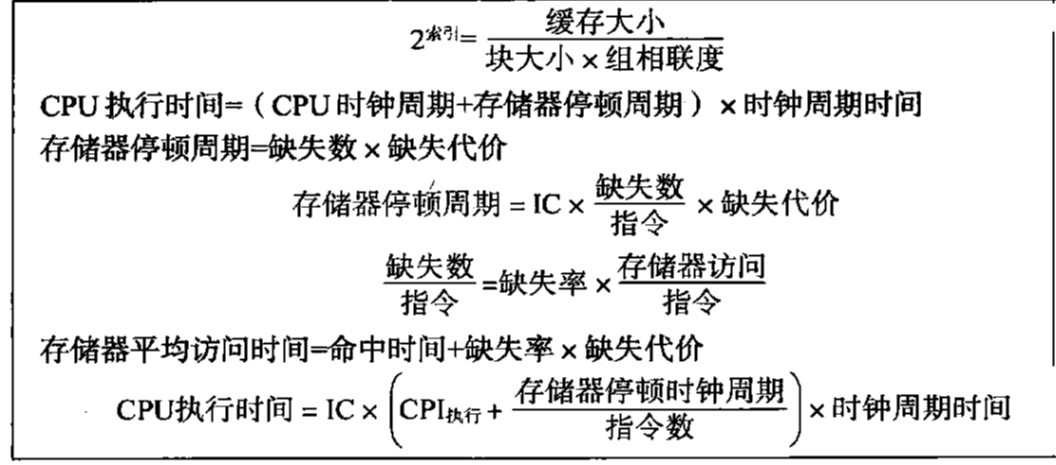

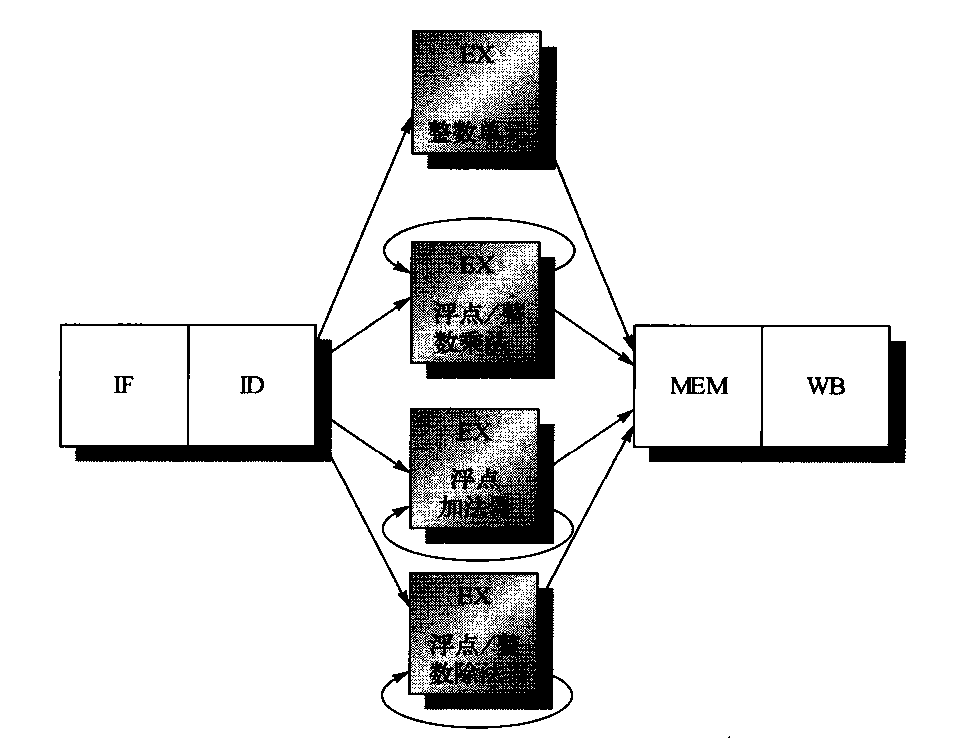

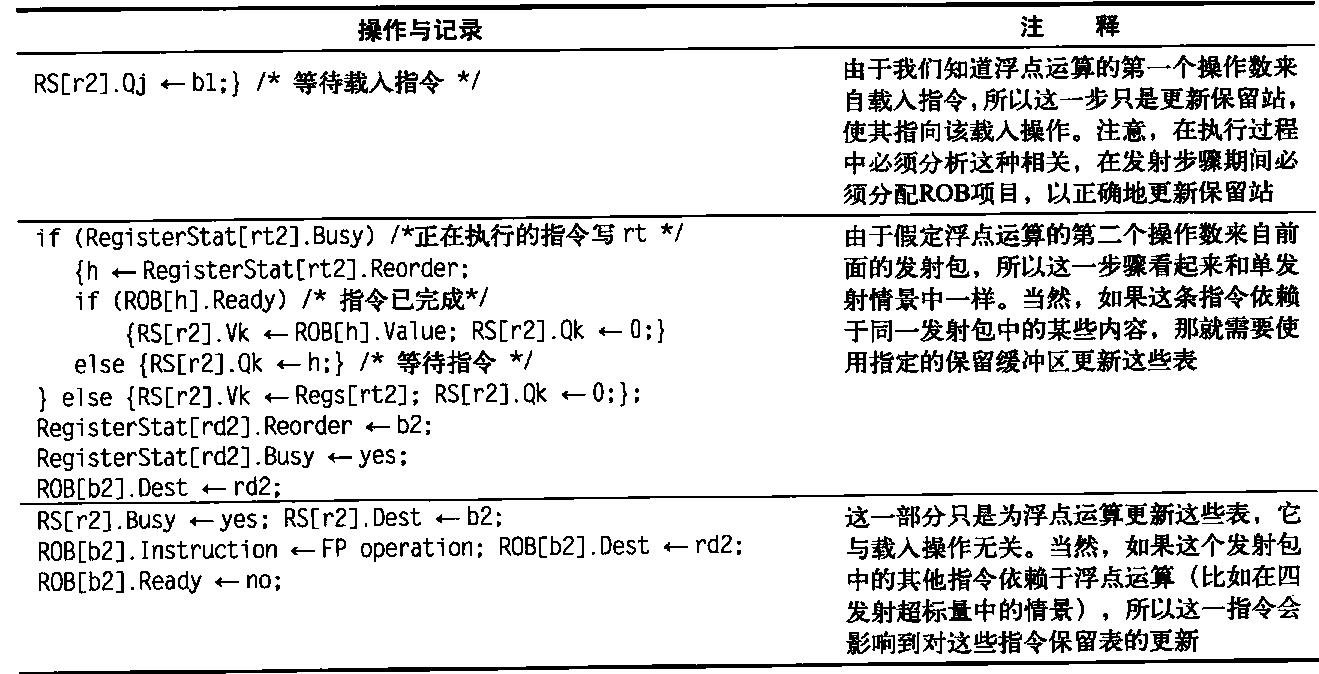

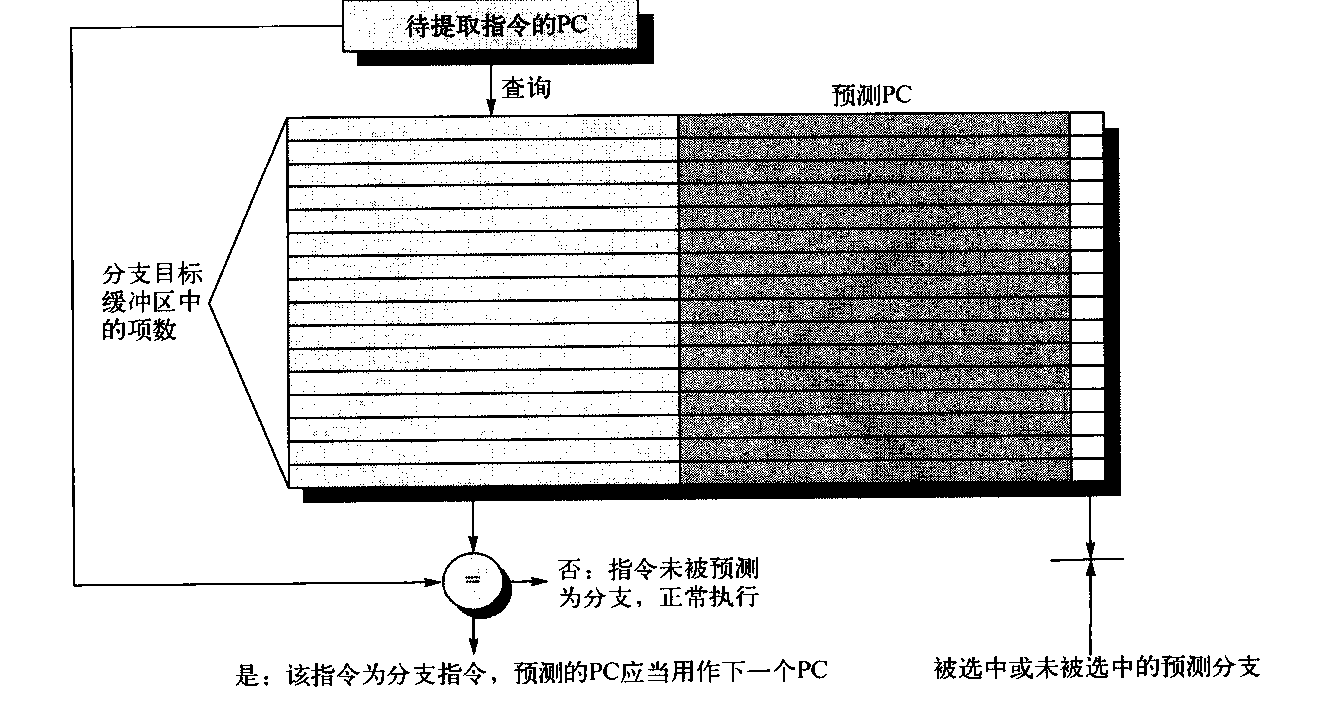

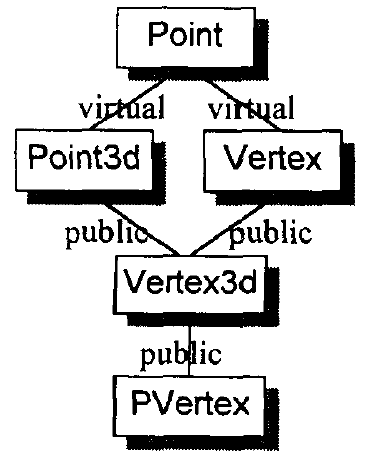

迭代器的分类与从属关系如下图所示:

设计算法时,如果可能,我们尽量针对上图中某种迭代器提供一个明确定义,并针对更强化的某种迭代器提供另一定义,这样才能在不同情况下提供最大效率。假设有个算法接受 Forward Iterator,你以 Random Access Iterator 喂给它,也可用,但是可用不一定最佳。

下面以advanced()函数为例,介绍各类迭代器的性能差异。该函数有两个参数,迭代器p和数值n,函数内部将p累进n次,下面有三个定义,一个针对Input iterator,一个针对Bidirectional iterator,另一个针对Random Access iterator。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 template <class InputIterator,class Distance>void advanced_II (InputIterator& i, Distance n) while (n--) ++i; } template <class BidirectionalIterator, class Distance>void advanced_BI (BidirectionalIterator& i, Distance n) if (n>=0 ) while (n--) ++i; else while (n++) --i; } template <class RandomAccessIterator, class Distance>void advanced_RAI (RandomAccessIterator& i,Distance n) i += n; }

当程序调用advance()时,应该调用哪一份函数定义呢?通常会将三者合一,下面是一种做法:1 2 3 4 5 6 7 8 9 10 template <class InputIterator , class Distance >void advanced (InputIterator& i, Distance n) if (is_random_access_iterator (i)) advanced_RAI (i,n); else if (is_bidirectional_iterator (i)) advanced_BI (i,n); else advanced_II (i,n); }

advanced()添加第三个参数,即“迭代器类型”这个参数,然后利用traits萃取出迭代器的种类。下面五个classes,即代表五种迭代器类型:1 2 3 4 5 struct input_iterator_tag {};struct output_iterator_tag {};struct forward_iterator_tag : public input_iterator_tag {};struct bidirectional_iterator_tag : public forward_iterator_tag {};struct random_access_iterator_tag : public bidirectional_iterator_tag {};

__advance(),然后利用第三参数重新定义上面的advance()函数。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 template <class InputIterator , class Distance >inline void __advanced(InputIterator& i, Distance n, input_iterator_tag){ while (n--) ++i; } template <class ForwardIterator ,class Distance >inline void __advanced(ForwardIterator& i, Distance n, forward_iterator_tag){ advance (i,n,input_iterator_tag); } template <class BidirectionalIterator , class Distance >inline void __advanced(BidirectionalIterator& i, Distance n, bidirectional_iterator_tag){ if (n>=0 ) while (n--) ++i; else while (n++) --i; } template <class RandomAccessIterator , class Distance >inline void __advanced(RandomAccessIterator& i, Distance n, random_access_iterator_tag){ i += n; }

__advance()。这一上层接口只需两个参数,当它准备将工作转给上述的__advance()时,才自行加上第三参数:迭代器类型。因此,这个上层函数必须有能力从它所获得的迭代器中推导出其类型——这份工作自然交给traits机制:1 2 3 4 5 template <class InputIterator, class Distance>inline void advanced (InputIterator& i, Distance n) __advance(i,n,iterator_traits<InputIterator>::iterator_categoty ()); }

iterator_traits<InputIterator>::iterator_categoty()将产生一个临时对象,其类别应该为前述5个迭代器类型之一。根据这个类别编译器决定调用哪个__advance()重载函数。

任何一个迭代器,其类型永远应该落在“该迭代器所隶属之各种类型中”,最强化的那个。同时,STL算法命名规则:以算法所能接受之最低阶迭代器类型,来为其迭代器型别参数命名 ,因此advance()中template参数名称为InputIterator。

消除“单纯传递调用的函数” 由于各个迭代器之间存在着继承关系,“传递调用”的行为模式自然存在,即如果不重载Forward Iterators或BidirectionalIterator时,统统都会传递调用InputIterator版的函数。

std::iterator的保证 任何迭代器都应该提供五个内嵌相应类别,以利于traits萃取。STL提供了一个iteratots class如下,如果每个新设计的迭代器都继承自它,则可以保证符合STL规范(即需要提供五个迭代器相应的类型)。1 2 3 4 5 6 7 8 9 template <class Category , class T , class Distance = ptrdiff_t , class Pointer = T*, class Reference = T&> struct iterator { typedef Category iterator_category; typedef T value_type; typedef Distance difference_type; typedef Pointer pointer; typedef Reference reference; };

iterator class 不含成员,纯粹只是类型定义,所以继承它不会造成任何负担。由于后三个参数都有默认值,新的迭代器只需提供前两个参数即可。

SGI STL的私房菜:__type_traits traits编程技法很棒,适度弥补了 C++ 语言本身的不足。 STL只对迭代器加以规范,制定出iterator_traits这样的东西。 SGI 把这种技法进一步扩大到迭代器以外的世界,于是有了所谓的__type_traits。

iterator_traits负责萃取迭代器的特性, __type_traits则负责萃取型别(type)的特性。 型别特性是指:这个型别是否具备non-trivial defalt ctor ?是否具备 non-trivial copy ctor?是否具备 non-trivial assignment operator?是否具备 non-trivial dtor?如果答案是否定的,我们在对这个型别进行建构、解构、拷贝、赋值等动作时,就可以采用最有效率的措施,而采用内存直接处理动作如malloc()、memcpy()等等,获得最高效率。这对于大规模而动作频繁的容器,有着显著的效率提升!

type_traits提供了一种机制,允许针对不同的型别属性,在编译时期完成函数派送决定,如果我们事先知道是否有trivial copy constructor,便能够帮助我们确定是否可以使用memcpy()或memmove()。

根据iterator_traits得来的经验,我们希望程序中可以这样运用__type_traits<T>,T代表任意型别:1 2 3 4 5 __type_traits<T>::has_trivial_default_constructor __type_traits<T>::has_trivial_copy_constructor __type_traits<T>::has_trivial_assignment_operator __type_traits<T>::has_trivial_destructor __type_traits<T>::is_POD_type

1 2 struct __true_type {};struct __false_type {};

为了达成上述五个式子,__type_traits应该定义一些typedefs,其值不是_true_type就是_false_type。1 2 3 4 5 6 7 8 9 10 template <class type >struct __type_traits { typedef __true_type this_dummy_member_must_be_first; typedef __false_type has_trivial_default_constructor; typedef __false_type has_trivial_copy_constructor; typedef __false_type has_trivial_assignment_operator; typedef __false_type has_trivial_destructor; typedef __false_type is_POD_type; };

SGI把所有内嵌型别都定义为_false_type为了定义出最保守的值,然后再针对每一个标量型别(scalar types)设计适当的_type_traits特化版本,这样就解决了问题。上述_type_traits可以接受任何型别的参数,五个typedefs将经由以下管道获得实值:

一般具现体(gerera1 instantiation),内含对所有型别都必定有效的保守值。上述各个has_trivial_xxx型别都被定义为_false_type,就是对所有型别都必定有效的保守值。

经过声明的特化版本,例如<type_traits.h>内对所有C++标量型别(scalar types)提供了对应的特化声明。稍后展示

某些编译器会自动为所有型别提供适当的特化版本

以下是<type_traits.h>对所有C++标量类型所定义的__type_traits特化版本:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 __STL_TEMPLATE_NULL struct __type_traits <char > { typedef __true_type has_trivial_default_constructor; typedef __true_type has_trivial_copy_constructor; typedef __true_type has_trivial_assignment_operator; typedef __true_type has_trivial_destructor; typedef __true_type is_POD_type; }; __STL_TEMPLATE_NULL struct __type_traits <int > { typedef __true_type has_trivial_default_constructor; typedef __true_type has_trivial_copy_constructor; typedef __true_type has_trivial_assignment_operator; typedef __true_type has_trivial_destructor; typedef __true_type is_POD_type; }; template <class T >struct __type_traits <T*> { typedef __true_type has_trivial_default_constructor; typedef __true_type has_trivial_copy_constructor; typedef __true_type has_trivial_assignment_operator; typedef __true_type has_trivial_destructor; typedef __true_type is_POD_type; };

前面第二章提到过的uninitialized_fill_n等函数就在实现中使用了__type_traits机制。1 2 3 4 5 template <class ForwardIterator , class Size , class T >inline ForwardIterator __uninitialized_fill_n(ForwardIterator first, Size n, const T& x) { return __uninitialized_fill_n(first, n, x, vaule_type (first)); }

该函数以x为蓝本,自迭代器first开始构造n个元素,首先以value_type()萃取出迭代器first的value_type,再利用__type_traits判断该类型是否为POD类型。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 template <class ForwardIterator , class Size , class T , class T1 >inline ForwardIterator __uninitialized_fill_n(ForwardIterator first, Size n, const T& x, T1*) { typedef typename __type_traits<T1>::is_POD_type is_POD; return __uninitialized_fill_n_aux(first, n, x, is_POD ()); } template <class ForwardIterator , class Size , class T >ForwardIterator __uninitialized_fill_n_aux(ForwardIterator first, Size n, const T& x, __false_type) { ForwardIterator cur = first; __STL_TRY { for ( ; n > 0 ; --n, ++cur) construct (&*cur, x); return cur; } template <class ForwardIterator , class Size , class T >inline ForwardIterator__uninitialized_fill_n_aux(ForwardIterator first, Size n, const T& x, __true_type) { return fill_n (first, n, x); } template <class OutputIter , class _Size , class _Tp >OutputIter fill_n (OutputIter first, Size n, const Tp& value) { for ( ; n > 0 ; --n, ++first) *first = value; return first; }

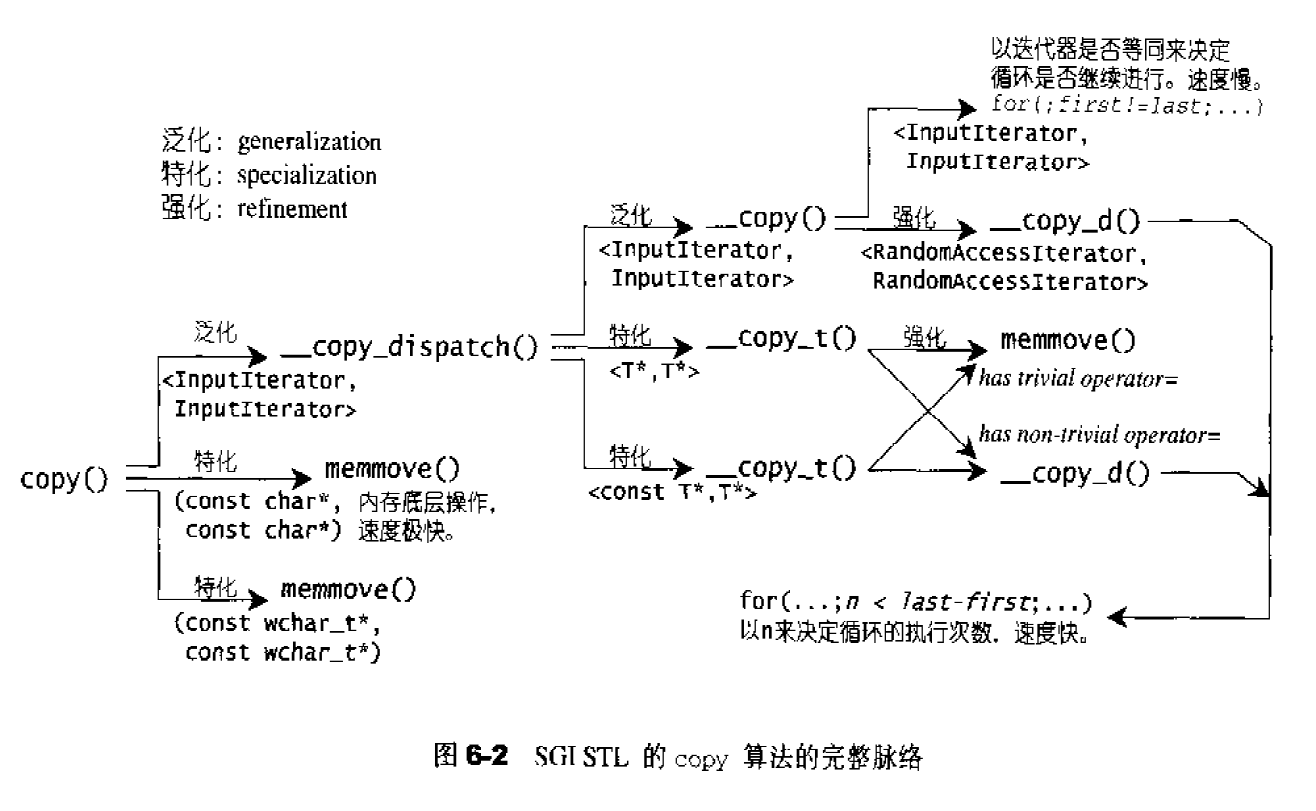

第二个例子是copy()全局函数(泛型算法之一〕,这个函数有非常多的特化〔specialization)与强化(refinement)版本。最基本的想法是这样:1 2 3 4 5 6 7 8 9 10 template <c1ass T> inline void copy (T* source, T* destination, int n) copy (source, destination, n, typename __type_traits<T>:::has_trivial_copy_constructor ()); } template <class T > void copy (T* source, T* destination, int n, __false_type) template <class T > void copy (T* source, T* destination, int n, __true_type)

以上只是针对“函数参数为原生指针”的情况而做的设计。

如果你是SGI STL的用户,你可以在自己的程序中充分运用这个__type_traits,假设我自行定义了一个shape c1ass,__type_traits会对它产生什么效应呢?如果编译器够厉害,__type_traits针对shape萃取出来的每一个特性,其结果将取决于我的Shape是否有trivial default ctor,或triviai copy ctor,或trivial assignment operator, 或trivial dtor而定。但对大部分缺乏这种特异功能的编译器而言,type_traits针对Shape萃取出来的每一个特性都是` false_type,即使shape是个POD型别。这样的结果当然过于保守、但是别无选择,除非我针对shape,自行设计一个__type_traits`特化版本,明白地告诉编译器以下事实(举例):1 2 3 4 5 6 7 8 template <class type >struct __type_traits <Shape> { typedef __true_type has_trivial_default_constructor; typedef __false_type has_trivial_copy_constructor; typedef __false_type has_trivial_assignment_operator; typedef __false_type has_trivial_destructor; typedef __false_type is_POD_type; };

一个简单的判断标准是,如果class内含指针成员,并且对它进行动态内存配置,那么这个class就要实现出自己的non-trival-xxx。

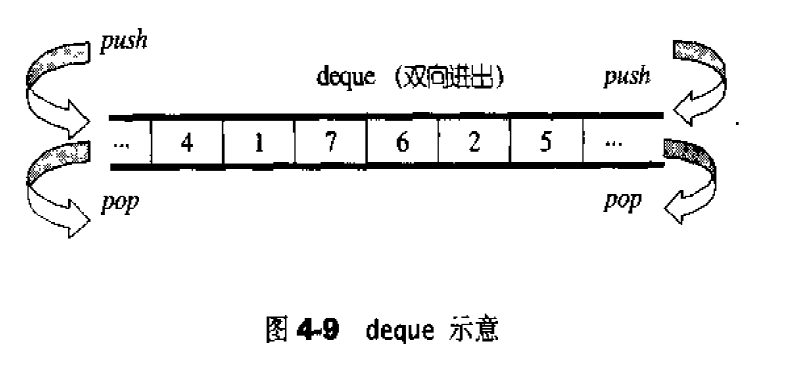

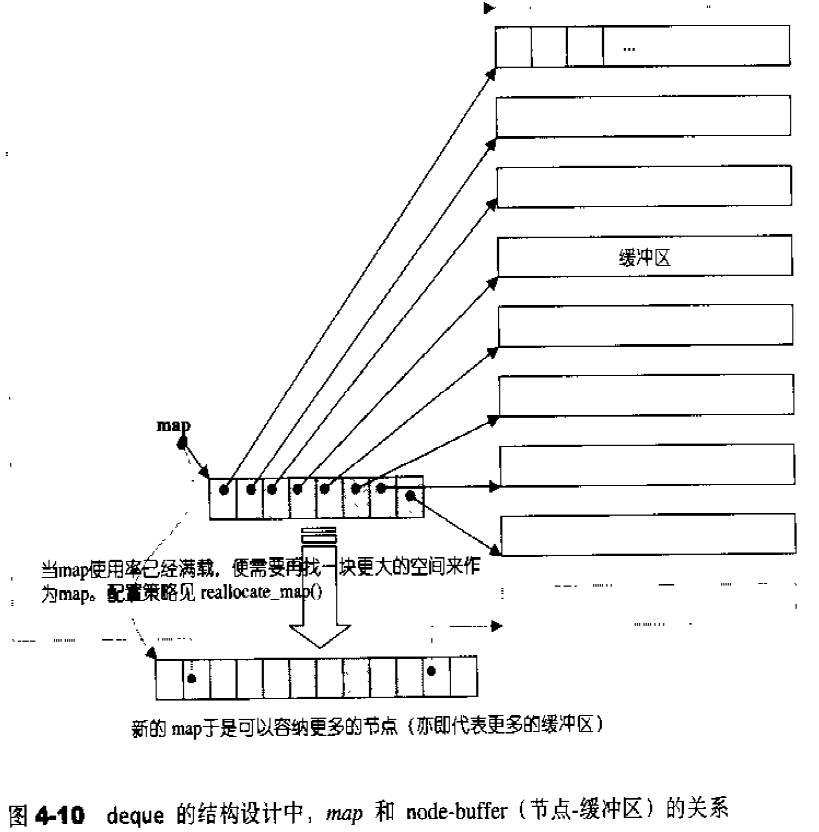

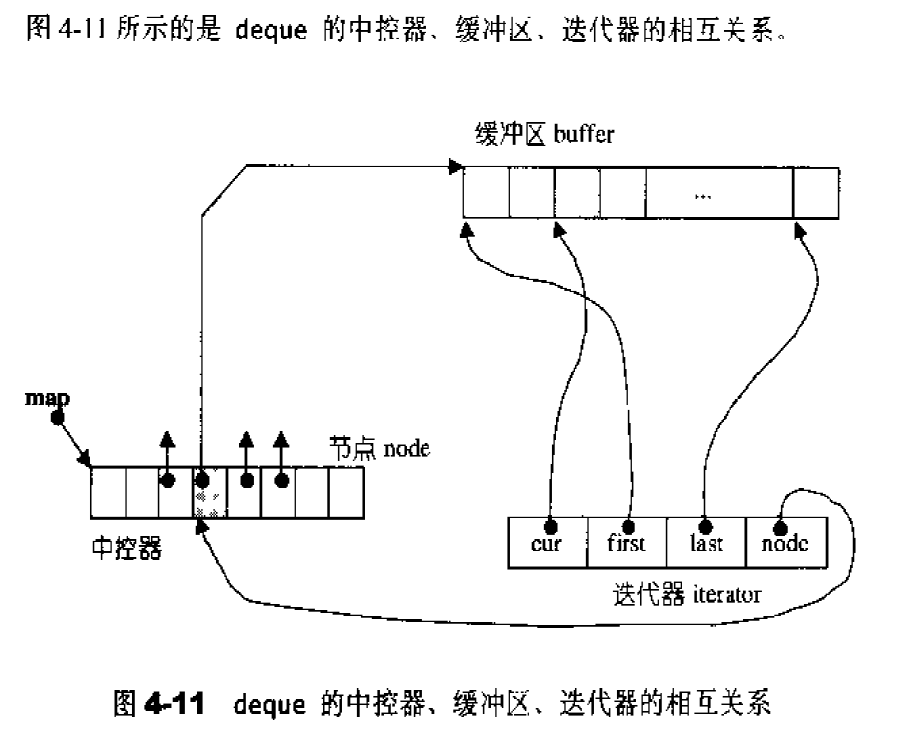

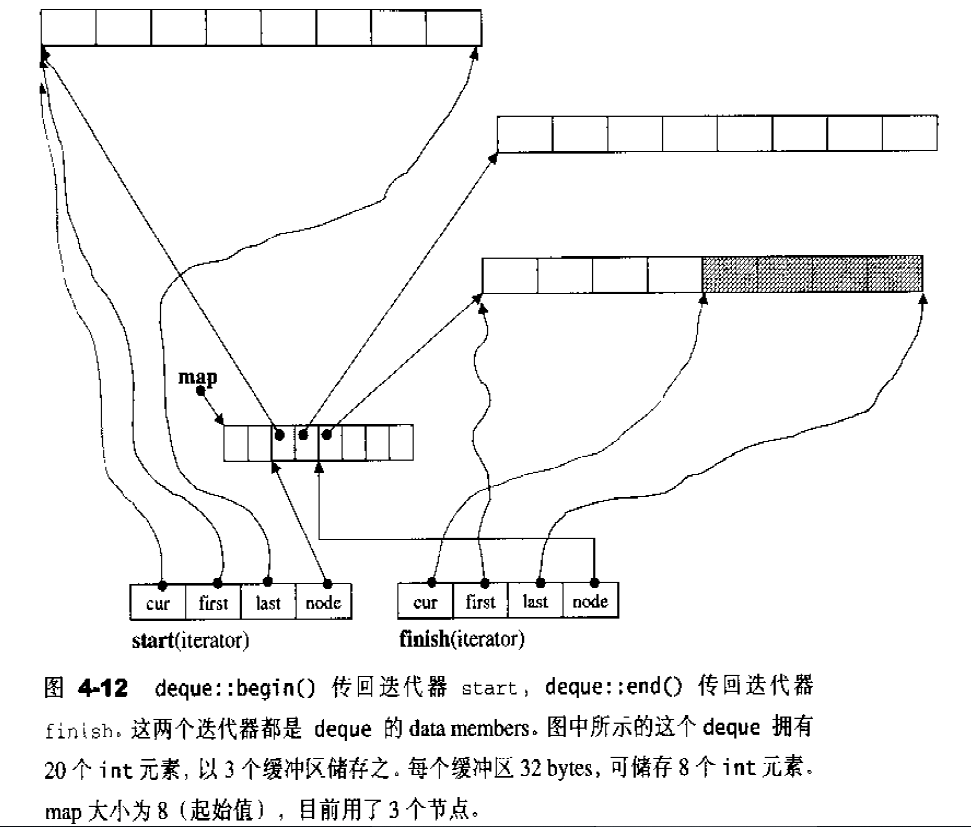

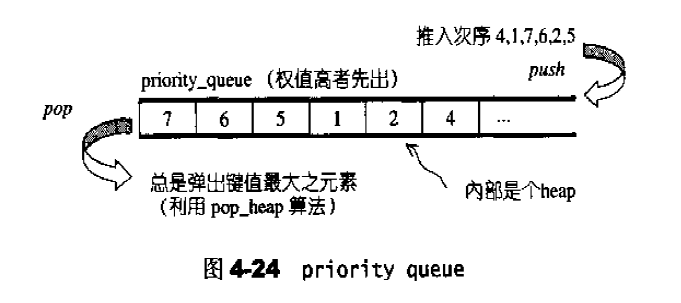

序列式容器 容器的概观与分类 容器,置物之所也。研究数据的特定排列方式,以利于搜寻或排序或其他特殊目的,这一专门学科称为数据结构。几乎可以说,任何特定的数据结构都是为了实现某种特定的算法。

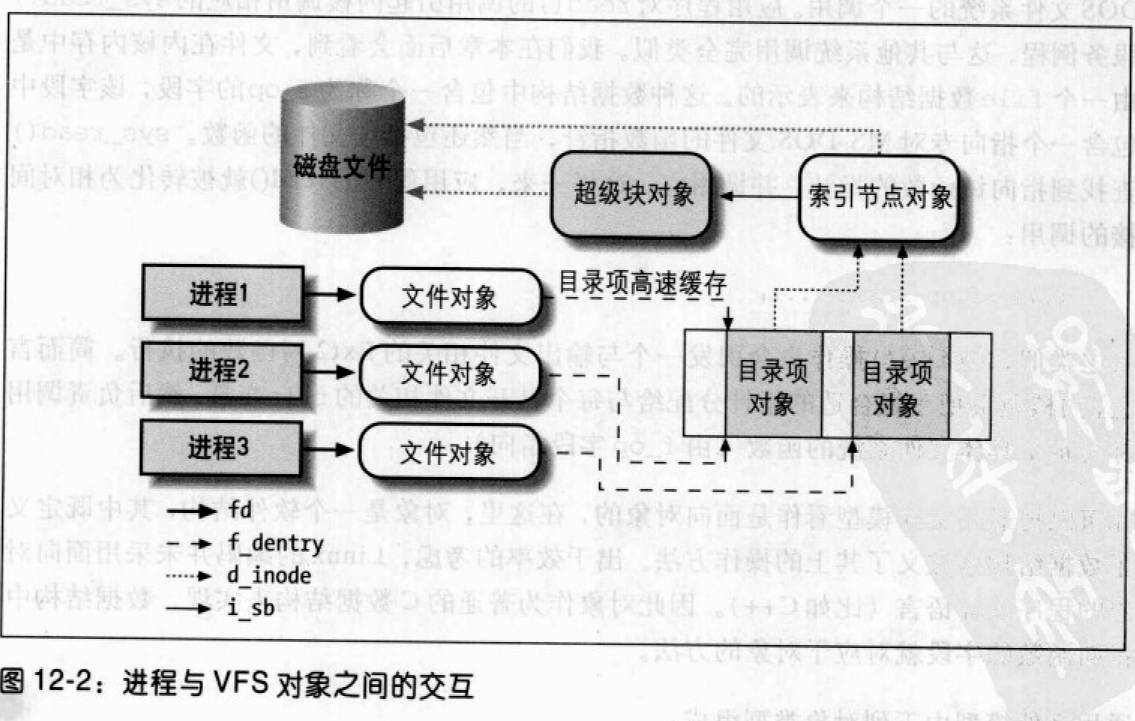

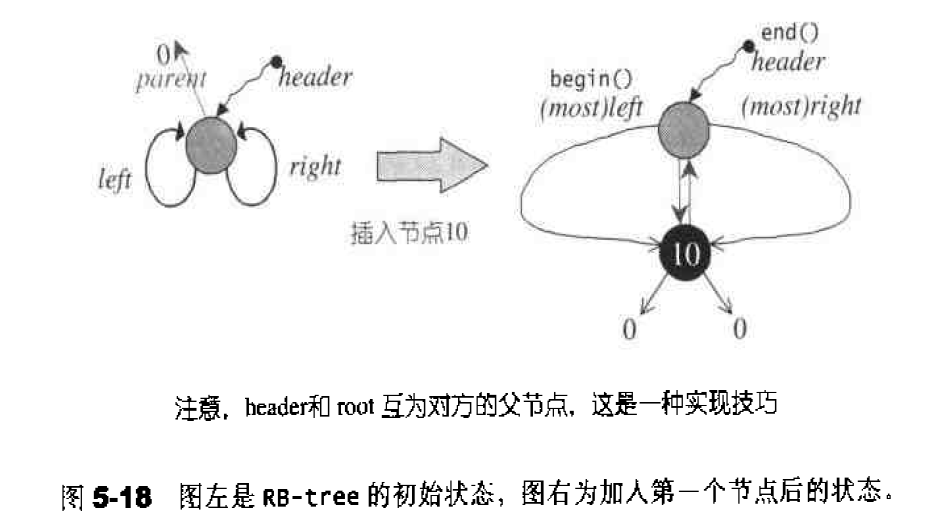

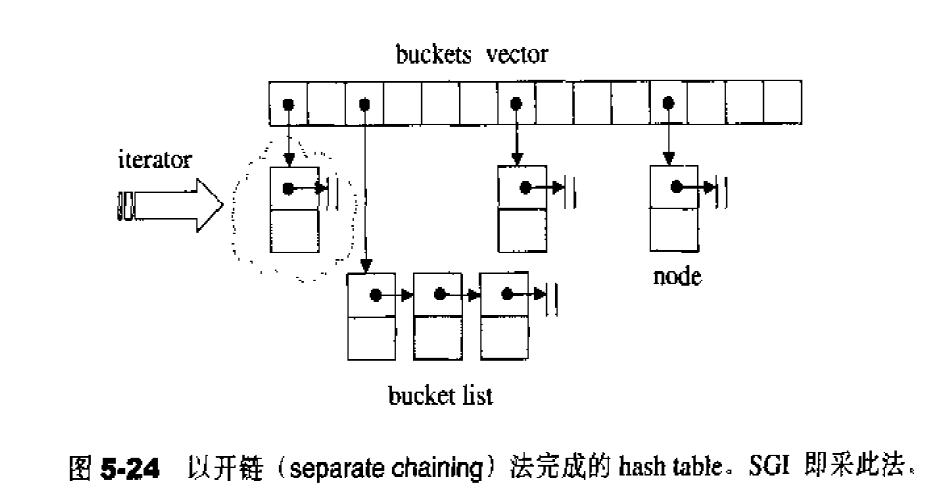

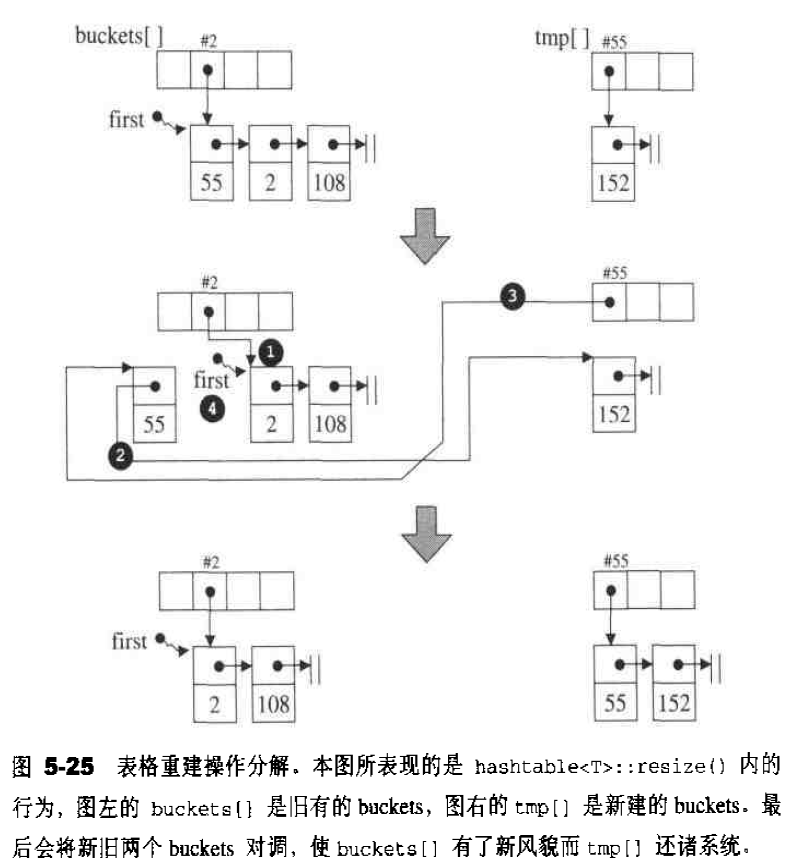

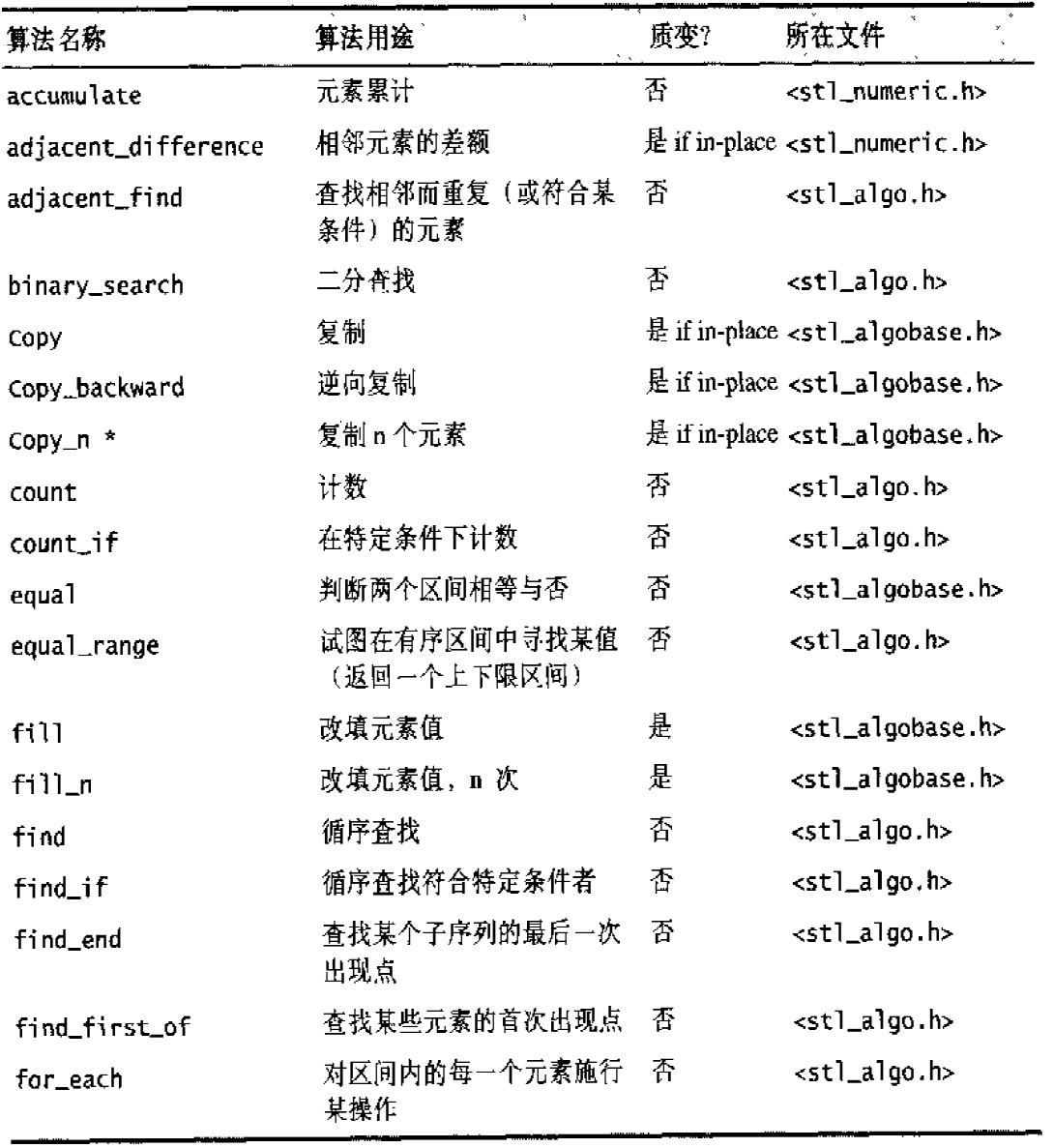

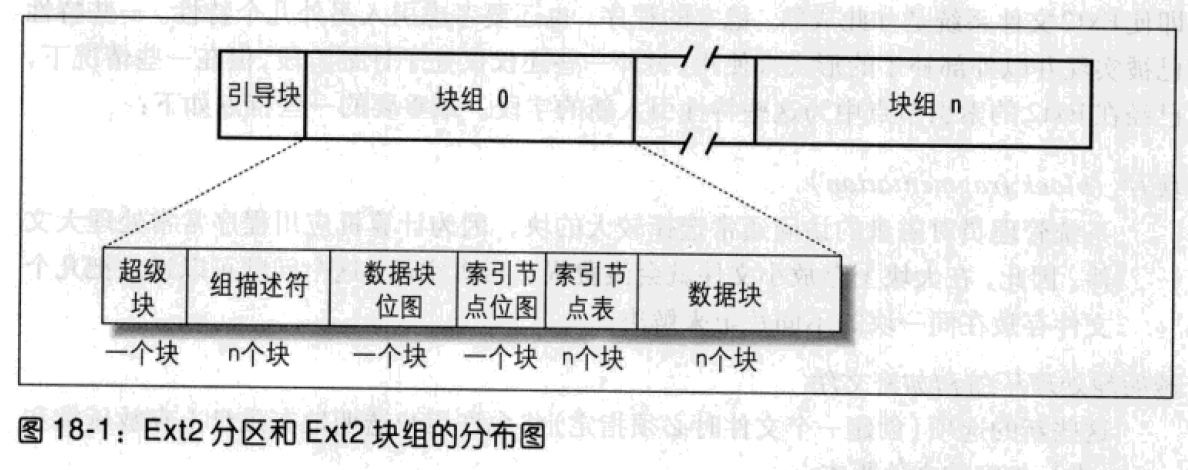

SGI STL的各个容器(本图以内缩方式来表达基层与衍生层的关系)。

这里所谓的衍生 ,并非派生关系,而是内含关系。例如,heap内含一个vector,priority-queue内含一个heap,stack和queue都内含一个deque,set/map/multiset/multimap都内含一个RB-tree,hash_set/hash_map/hash_multiset/hash_multimap都内含一个hashtabe。

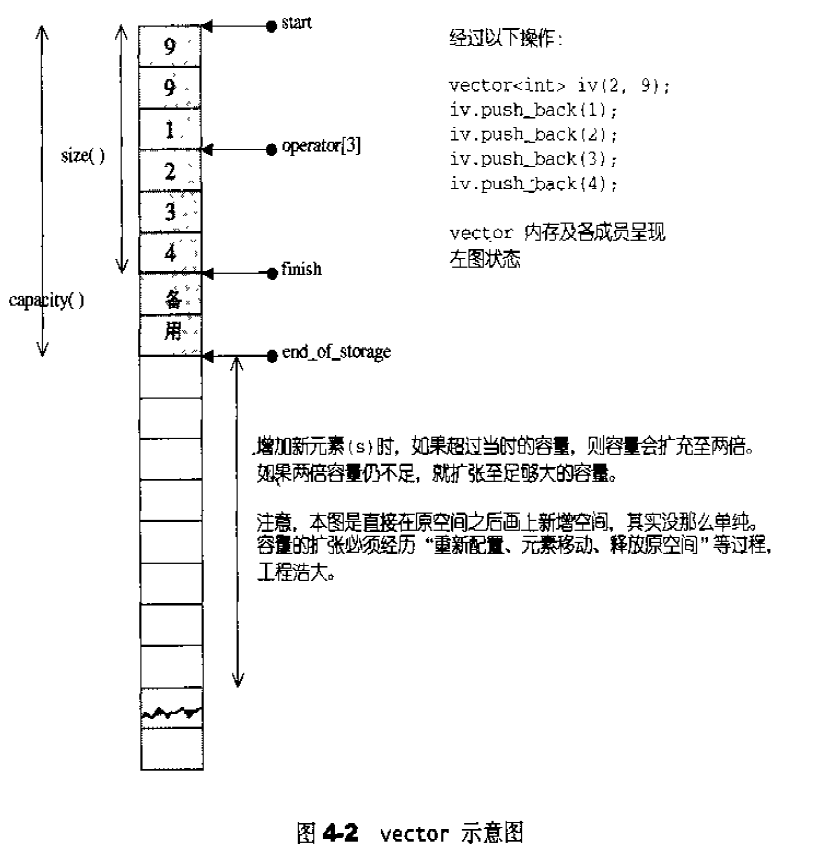

vector概述 vector的数据安排以及操作方式,与array非常相似。两者的唯一差别在于空间的运用的灵活性。array是静态空间,一旦配置了就不能改变;vector的动态空间 ,随着元素的加入,它的内部机制会自行扩充空间以容纳新元素。vector的实现技术,关键在于对其大小的控制以及重新配置时的数据移动效率。

vector的内部定义如下:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 template <class T , class Alloc = alloc>class vector {public : typedef T value_type; typedef value_type* pointer; typedef value_type* iterator; typedef value_type& reference; typedef size_t size_type; typedef ptrdiff_t difference_type; protected : typedef simple_alloc<value_type, Alloc> data_allocator; iterator start; iterator finish; iterator end_of_storage; void insert_aux (iterator position, const T& x) void deallocate () if (start) data_allocator::deallocate (start, end_of_storage - start); } void fill_initialize (size_type n, const T& value) start = allocate_and_fill (n, value); finish = start + n; end_of_storage = finish; } public : iterator begin () { return start; } const_iterator begin () const { return start; } iterator end () { return finish; } const_iterator end () const { return finish; } reverse_iterator rbegin () { return reverse_iterator (end ()); } const_reverse_iterator rbegin () const { return const_reverse_iterator (end ()); } reverse_iterator rend () { return reverse_iterator (begin ()); } const_reverse_iterator rend () const { return const_reverse_iterator (begin ()); } size_type size () const { return size_type (end () - begin ()); } size_type max_size () const { return size_type (-1 ) / sizeof (T); } size_type capacity () const { return size_type (end_of_storage - begin ()); } bool empty () const return begin () == end (); } reference operator [](size_type n) { return *(begin () + n); } const_reference operator [](size_type n) const { return *(begin () + n); } vector () : start (0 ), finish (0 ), end_of_storage (0 ) {} vector (size_type n, const T& value) { fill_initialize (n, value); } vector (int n, const T& value) { fill_initialize (n, value); } vector (long n, const T& value) { fill_initialize (n, value); } explicit vector (size_type n) fill_initialize (n, T ()); } ~vector () { destroy (start, finish); deallocate (); } reference front () { return *begin (); } const_reference front () const { return *begin (); } reference back () { return *(end () - 1 ); } const_reference back () const { return *(end () - 1 ); } void push_back (const T& x) if (finish != end_of_storage) { construct (finish, x); ++finish; } else insert_aux (end (), x); } iterator insert (iterator position, const T& x) { size_type n = position - begin (); if (finish != end_of_storage && position == end ()) { construct (finish, x); ++finish; } else insert_aux (position, x); return begin () + n; } void pop_back () --finish; destroy (finish); } iterator erase (iterator position) { if (position + 1 != end ()) copy (position + 1 , finish, position); --finish; destroy (finish); return position; } iterator erase (iterator first, iterator last) { iterator i = copy (last, finish, first); destroy (i, finish); finish = finish - (last - first); return first; } void resize (size_type new_size, const T& x) if (new_size < size ()) erase (begin () + new_size, end ()); else insert (end (), new_size - size (), x); } void resize (size_type new_size) resize (new_size, T ()); } void clear () erase (begin (), end ()); } protected : iterator allocate_and_fill (size_type n, const T& x) { iterator result = data_allocator::allocate (n); __STL_TRY { uninitialized_fill_n (result, n, x); return result; } __STL_UNWIND(data_allocator::deallocate (result, n)); } };

vector 的迭代器 vector 维护的是一个连续的线性空间,所以不论其元素型别如何,普通指针都可以作为 vector 的迭代器而满足所有必要条件,因为 vector 迭代器所需要的操作行为,如operator*,operator->,operator++,operator–,operator+,operator-,operator+=,operator-=,普通指针天生就具备。vector 支持随机存取,而普通指针正有这样的能力。所以,vector 提供的是 Random Access Iterators。1 2 3 4 5 6 7 8 template <class T , class Alloc = alloc>class vector{ public : typedef T value_type; typedef value_type* iterator; ... }

1 2 vector<int >::iterator ivite; vector<Shape>::iterator svite;

int*,svite 的型别就是Shape*。

vector数据结构 vector采用线性连续空间的数据结构。它以两个迭代器start和finish分别指向配置的来的连续空间中目前已被使用的范围,并以迭代器end_of_storage指向整块连续空间(含备用空间)的尾端:1 2 3 4 5 6 7 8 template <class T ,class Alloc = alloc> class vector{ ... protected : iterator start ; iterator finish ; iterator end_of_storage ; };

vector构造与内存管理 vector缺省使用alloc作为空间配置器,并据此另外定义了一个data_allocator,为的是更方便以元素大小为配置单位:1 2 3 4 5 6 template <class T , class Alloc = alloc> class vector{protected : typedef simple_alloc<value_type,Alloc> data_allocator; ... }

data_allocator::allocate(n)表示配置n个元素空间。

vector提供许多constructors,其中一个允许我们指定空间大小及初值。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 vector (size_type n, const T& value) { fill_initialize (n, value); } void fill_initialize (n, value) start = allocate_and_fill (n, value); finish = start + n; end_of_storage = finish; } iterator allocate_and_fill (size_type n, const T& x) { iterator result = data_allocator::allocate (n); uninitialized_fill_n (result, n, x); return result; }

uninitialized_fill_n()会根据第一参数的类型决定使用算法fill_n或反复调用construct()完成任务。

当我们以push_back()将新元素插入vector尾端时,该函数先检查是否还有备用空间,如果有就直接在备用空间上构造元素,并调整迭代器finish,使vector变大。如果没有备用空间,就扩充空间(重新配置、移动数据、释放原空间):1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 void push_back (const T& x) if (finish != end_of_storage) { construct (finish, x); ++finish; } else insert_aux (end (), x); } template <class T , class Alloc > void vector<T, Alloc>::insert_aux (iterator position, const T&x){ if (finish != end_of_storage){ construct (finish, *(finish - 1 )); ++finish; T x_copy = x; copy_backward (position, finish - 2 , finish - 1 ); *position = x_copy; } else { const size_type old_size = size (); const size_type new_size = old_size != 0 ? 2 * old_size : 1 ; iterator new_start = data_allocator::allocate (new_size); iterator new_finish = new_start; try { new_finish = uninitialized_copy (start, position, new_start); construct (new_finish, x); ++new_finish; new_finish = uninitialzed_copy (position, finish, new_finish); } catch (excetion e){ destroy (new_start, new_finish); data_allocator::deallocate (new_start, new_size); throw ; } destroy (begin (), end ()); deallocator (); start = new_start; finish = new_finish; end_of_storage = new_start + new_size; } }

1 2 3 4 5 6 7 8 9 10 11 template <class BidirectionalIterator1, class BidirectionalIterator2> BidirectionalIterator2 copy_backward ( BidirectionalIterator1 first, BidirectionalIterator1 last, BidirectionalIterator2 result) ; 参数: first, last 指出被复制的元素的区间范围[first,last). result 指出复制到目标区间的具体位置[result-(last-first),result) 返回值: 返回一个迭代器,指出已被复制元素区间的起始位置

所谓动态增加大小,并不是在原空间之后接续空间(因为无法包装原空间之后尚有可配置的空间),而是以原大小的两倍另外配置一块较大的空间,然后将原来内容拷贝过来,然后才开始在原内容之后构造新元素,并释放原空间。因此对vector的任何操作,一旦引起空间重新配置,指向原vector的所有迭代器就都失效了。

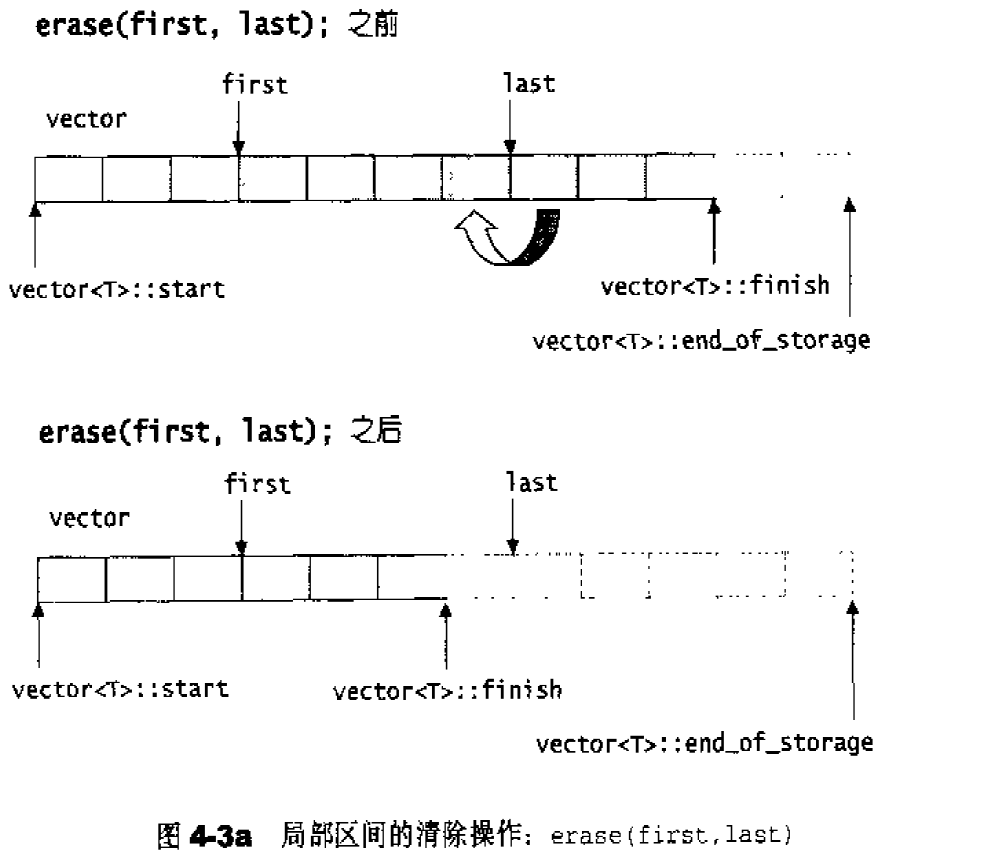

vector的元素操作 pop_back()实现:1 2 3 4 void pop_back () --finish; destory (finish); }

erase()实现:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 iterator erase (iterator first,iterator last) { iterator i=copy (last,finish,first); destroy (i,finish); finish=finish-(last-first); } iterator erase (iterator position) { if (position+1 !=end ()) copoy (position+1 ,finish,position); --finish; destory (finish); return position; } void clear () erase (begin (),end ());}

copy()函数具体实现:1 2 3 4 5 6 7 8 template <class InputIterator , class OutputIterator >inline OutputIterator __copy(InputIterator first, InputIterator last, OutputIterator result, input_iterator_tag){for ( ; first != last; ++result, ++first)*result = *first; return result;}

1 2 for ( ; last != finish; ++first, ++last)*first = *last;

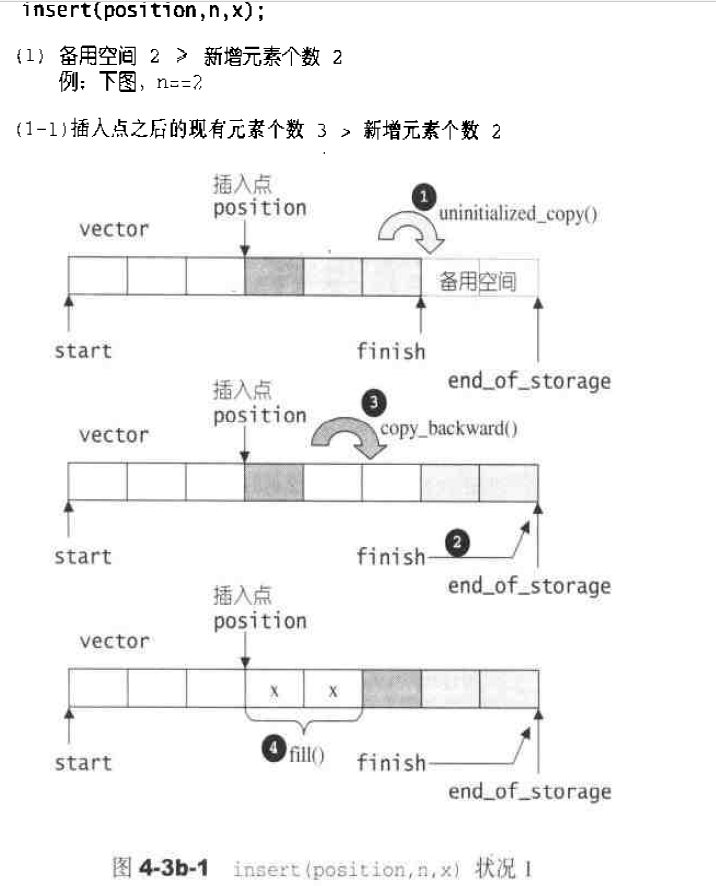

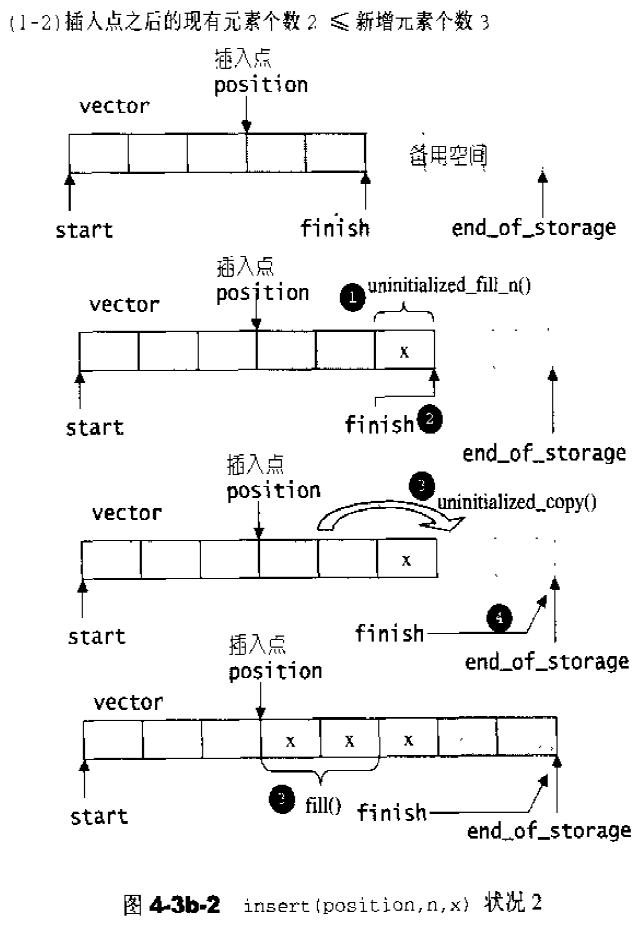

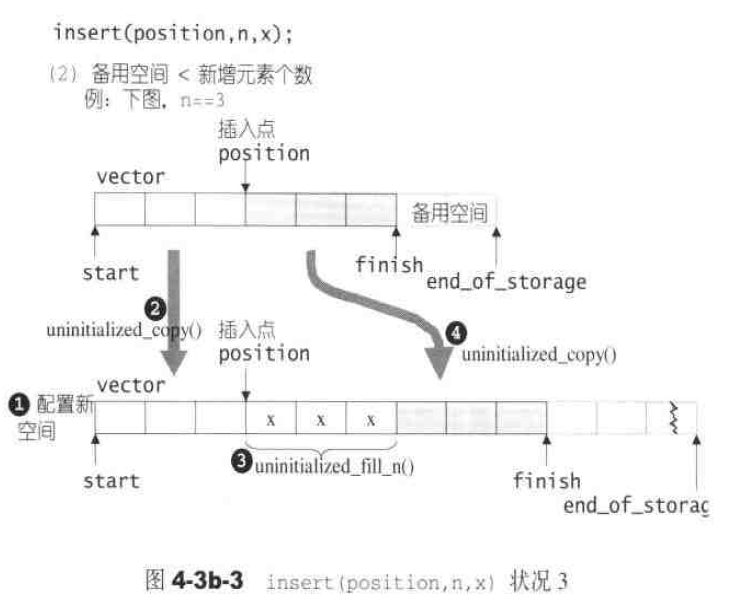

insert()实现,根据备用空间和插入元素的多少分为以下三种情况:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 template <class T , class Alloc >void vector<T, Alloc>::insert (iterator position, size_type n, const T& x) { if (n != 0 ) { if (size_type (end_of_storage - finish) >= n) { T x_copy = x; const size_type elems_after = finish - position; iterator old_finish = finish; if (elems_after > n) { uninitialized_copy (finish - n, finish, finish); finish += n; copy_backward (position, old_finish - n, old_finish); fill (position, position + n, x_copy); } else { uninitialized_fill_n (finish, n - elems_after, x_copy); finish += n - elems_after; uninitialized_copy (position, old_finish, finish); finish += elems_after; fill (position, old_finish, x_copy); } } else { const size_type old_size = size (); const size_type len = old_size + max (old_size, n); iterator new_start = data_allocator::allocate (len); iterator new_finish = new_start; __STL_TRY { new_finish = uninitialized_copy (start, position, new_start); new_finish = uninitialized_fill_n (new_finish, n, x); new_finish = uninitialized_copy (position, finish, new_finish); } # ifdef __STL_USE_EXCEPTIONS catch (...) { destroy (new_start, new_finish); data_allocator::deallocate (new_start, len); throw ; } # endif destroy (start, finish); deallocate (); start = new_start; finish = new_finish; end_of_storage = new_start + len; } } }

list list概述 相比于vector的连续线性空间,list显得更为复杂;但list每次插入或删除一个元素时,就将配置或释放一个元素。因此,list对于空间的运用有绝对的精准,一点也不浪费。对于任何位置的插入或元素删除,list永远是常数时间。

list的节点 下面是STL list的节点结构,显然是一个双向链表。1 2 3 4 5 6 7 template <class T >struct __list_node { typedef void * void_pointer; void_pointer prev; void_pointer next; T data; };

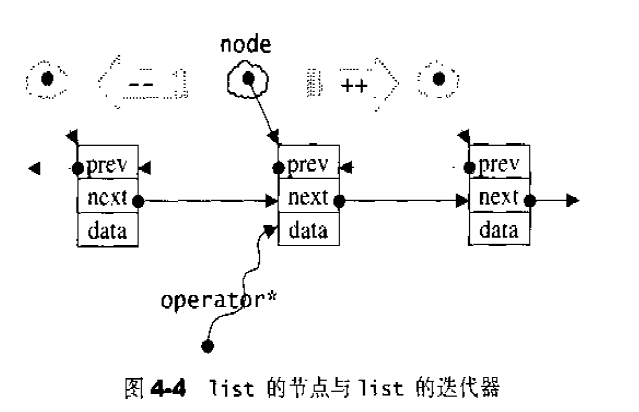

list的迭代器 list中的元素由于都是节点,不保证在存储空间中连续存在。list迭代器必须有能力指向list的节点,并有能力正确递增递减取值存取等操作。其迭代器递增时取用的是下一个节点,递减时取用上一个节点,取值时取的是节点的数据值,成员存取时取用的是节点的成员。

由于list是双向链表,迭代器必须具备前移、后移的能力,因此,list提供的是Bidirectional Iterators;list的插入和接合操作都不会导致原有迭代器失效,但vector的插入可能造成存储空间重新分配,导致原有的迭代器全部失效。甚至list的删除操作也只有指向被删除元素的那个迭代器失效,其他迭代器不受影响。

以下是list迭代器的设计:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 template <class T , class Ref , class Ptr >struct __list_iterator { typedef __list_iterator<T, P&, T*> iterator; typedef __list_iterator<T, Ref, Ptr> self; typedef bidirectionla_iterator_tag iterator_category; typedef T value_type; typedef Ptr pointer; typedef Ref reference; typedef __list_node<T>* link_type; typedef size_t size_type; typedef ptrdiff_t difference_type; link_type node; __list_iterator(link_type x) : node (x) {} __list_iterator() {} __list_iterator(const iterator& x) : node (x.node) {} bool operator ==(const self& x) const { return node == x.node; } bool operator !=(const self& x) const { return node != x.node; } reference operator *() const { return (*node).data; } pointer operator ->() const { return &(operator *()); } self& operator ++() { node = (link_type)((*node).next); return *this ; } self operator ++(int ) { self tmp = *this ; ++*this ; return tmp; } self& operator --() { node = (link_type)((*node).prev); return *this ; } self operator --(int ) { self tmp = *this ; --*this ; return tmp; } };

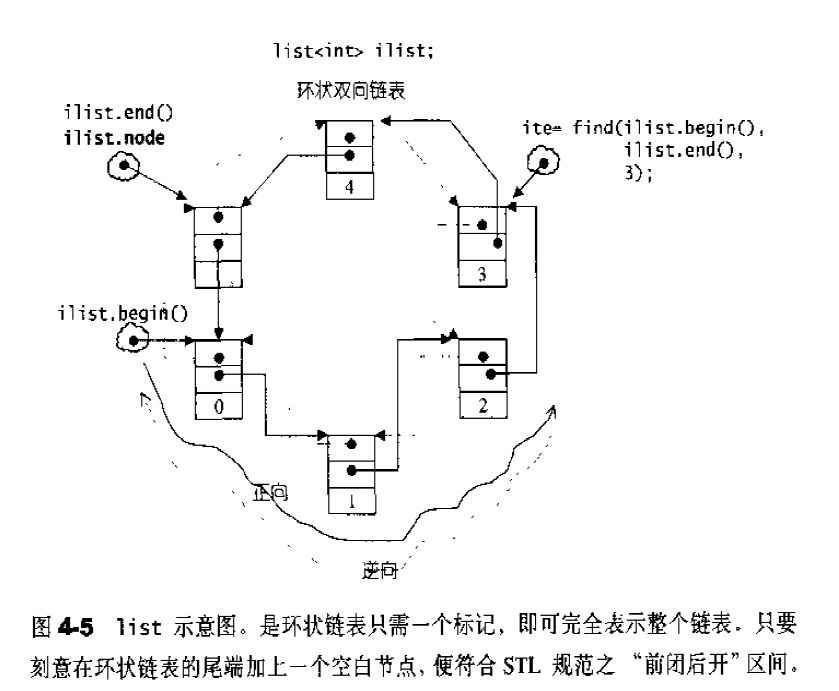

list的数据结构 SGI list是一个双向链表,而且是一个环状双向链表:1 2 3 4 5 6 7 8 9 template <class T ,class Alloc = alloc> class list{protected : typedef __list_node<T> list_node ; public : typedef list_node* link_type ; protected : link_type node ; };

如果让指针 node 指向刻意置于尾端的一个空白节点, node 便能符合 STL 对于“前闭后开”区间的要求,成为 last 迭代器。1 2 3 4 5 6 7 8 9 10 11 12 13 iterator begin () { return (link_type) ((*node).next); }iterator end () { return node; }bool empty () const return node->next == node; }size_type size () const { size_type result = 0 ; distance (begin (), end (), result); return result; } reference front () { return *begin (); }reference back () { return *(--end ()); }

list的构造与内存管理 list采用list_node_allocator来配置节点空间,以下四个函数分别用来配置、释放、构造、销毁一个节点。1 2 3 4 5 6 7 8 template <class T ,class Alloc = alloc> class list{protected : typedef __list_node<T> list_node ; typedef simple_alloc<list_node,Alloc> list_node_allocator; ... };

list_node_allocator(n)表示配置n个节点空间,配置、释放、构造、销毁。1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 link_type get_node () { return list_node_allocator::allocate (); } void put_node (link_type p) deallocate (p); }link_type create_node (const T& x) { link_type p = get_node (); construct (&p->data, x); return p; } void destroy_node (link_type p) destroy (&p->data); put_node (p); }

list提供了默认的构造函数,使得可以创建一个空list:1 2 3 4 5 6 7 8 public : list () { empty_initialize (); } protected : void empty_initialize () node = get_node (); node->next = node; node->prev = node; }

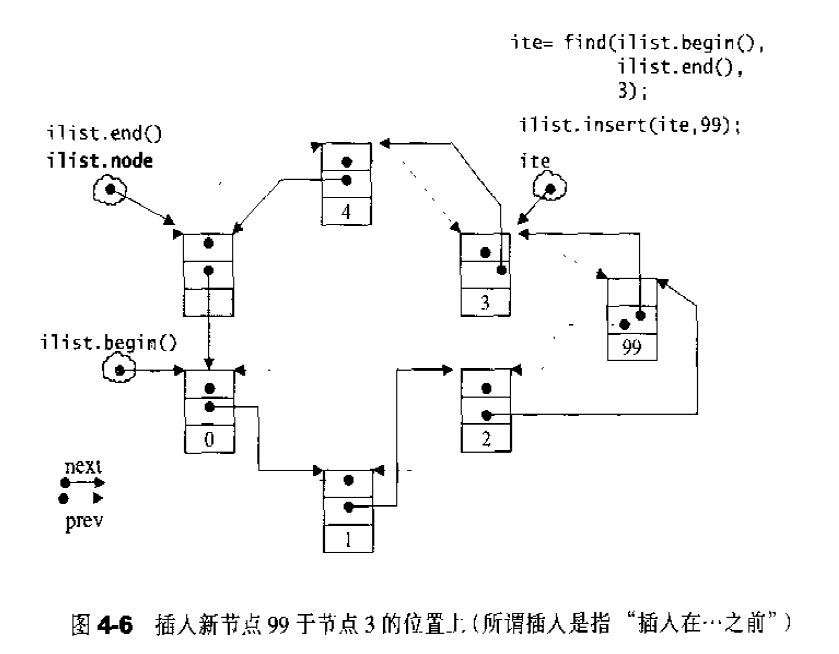

当我们以push_back()将新元素插入list尾端时,此函数内部调用insert(),insert()是一个重载函数,最简单的一种如下:1 2 3 4 5 6 7 8 iterator insert (iterator position, const T& x) { link_type tmp = create_node (x); tmp->next = position.node; tmp->prev = position.node->prev; (link_type (position.node->prev))->next = tmp; position.node->prev =tmp; return tmp; }

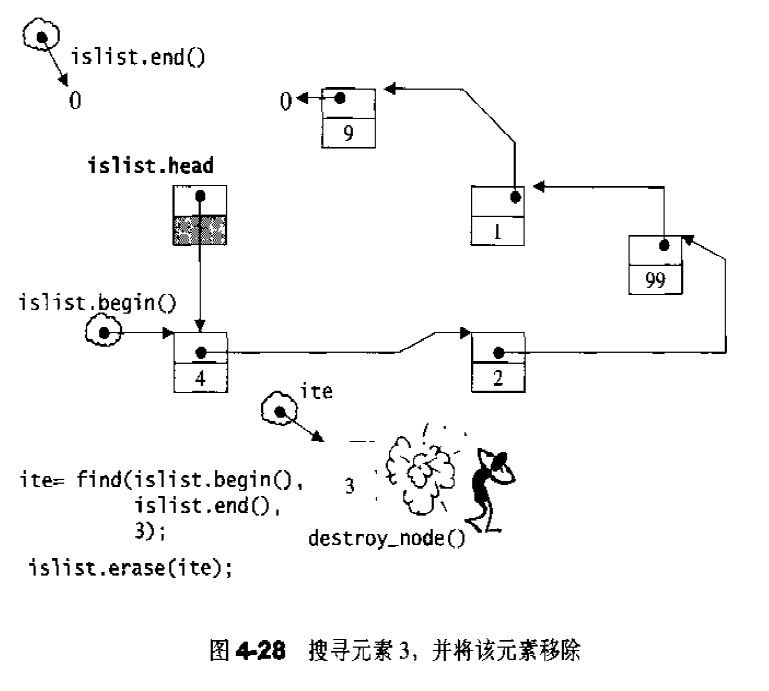

当连续插入5个节点之后,list的状态如图,如果希望在list内部的某处插入新节点,首先必须确定插入位置,例如希望在数据为3的节点处插入一个数据值为99的节点,可以:1 2 3 ilite = find (li.begin, li.end (), 3 ); if (ilite != 0 ) il.insert (ilite, 99 );

list的元素操作 push_front()函数:将新元素插入于list头端,内部调用insert()函数。1 void push_front (const T&x) insert (begin (),x); }

push_back()函数:将新元素插入于list尾端,内部调用insert()函数。1 void push_back (const T& x) insert (end (),x); }

erase()函数:移除迭代器position所指节点。1 2 3 4 5 6 7 8 iterator erase (iterator position) { link_type next_node=link_type (position.node->next); link_type prev_node=link_type (position.node->prev); prev_node->next=next_node; next_node->prev=prev_node; destroy_node (position.node); return iterator (next_node); }

pop_front()函数:移除头结点,内部调用erase()函数。1 void pop_front () erase (begin ()); }

pop_back()函数:移除尾结点,内部调用erase()函数。1 2 3 4 void pop_back () iterator i = end (); erase (--i); }

clear()函数:清除所有节点:1 2 3 4 5 6 7 8 9 10 11 12 13 14 template <class T , class Alloc > void list<T, Alloc>::clear () { link_type cur = (link_type) node->next; while (cur != node) { link_type tmp = cur; cur = (link_type) cur->next; destroy_node (tmp); } node->next = node; node->prev = node; }

remove():将数值为value的所有元素移除1 2 3 4 5 6 7 8 9 10 11 12 template <class T , class Alloc >void list<T, Alloc>::remove (const T& value) { iterator first = begin (); iterator last = end (); while (first != end) { iterator next = first; ++ next; if (*first == value) erase (first); first = next; } }

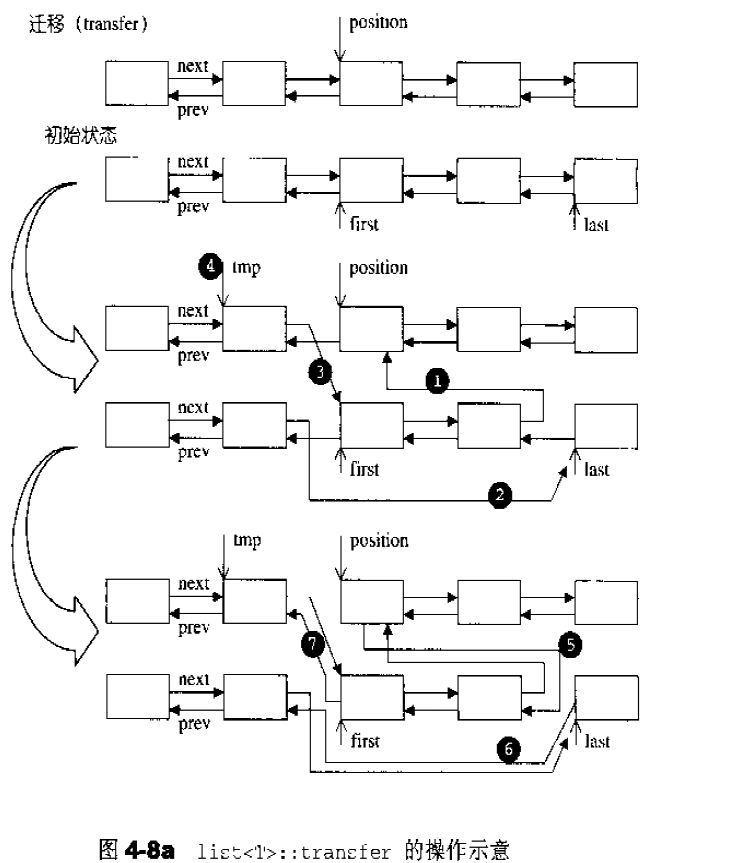

transfer()迁移函数:将[ frirst , last ) 内所有元素移动到position之前。1 2 3 4 5 6 7 8 9 10 11 void transfer (iterator position, iterator first, iterator last) if (position != last) { (*(link_type ((*last.node).prev))).next = position.node; (*(link_type ((*first.node).prev))).next = last.node; (*(link_type ((*position.node).prev))).next = first.node; link_type tmp = link_type ((*position.node).prev); (*position.node).prev = (*last.node).prev; (*last.node).prev = (*first.node).prev; (*first.node).prev = tmp; } }

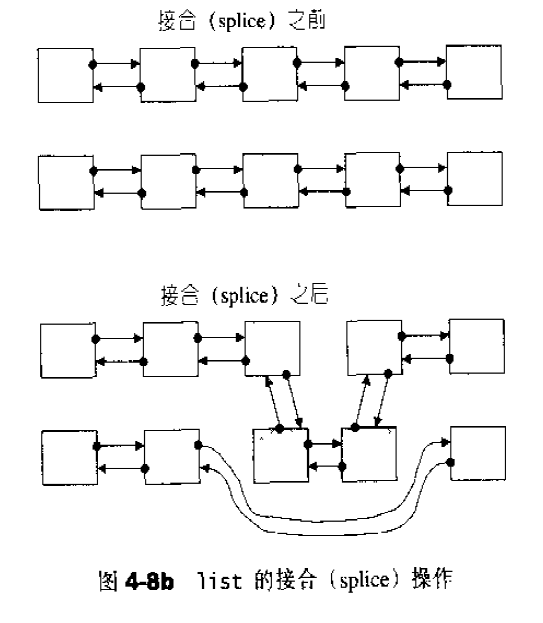

list公开提供的是所谓的接合操作splice,splice结合操作将连续范围的元素从一个list移动到另一个list的某个定点。

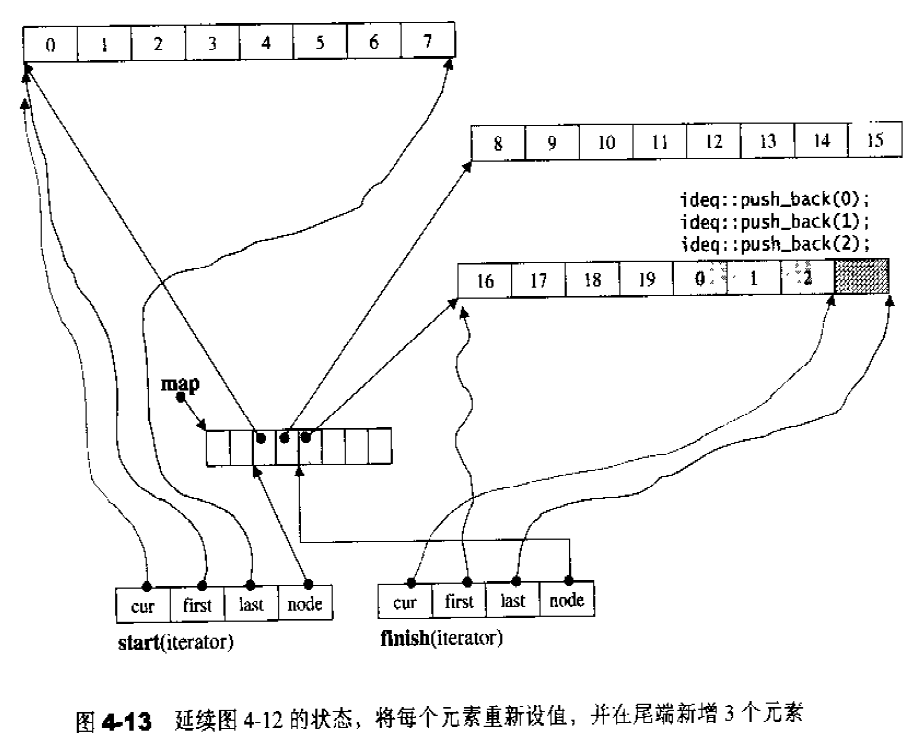

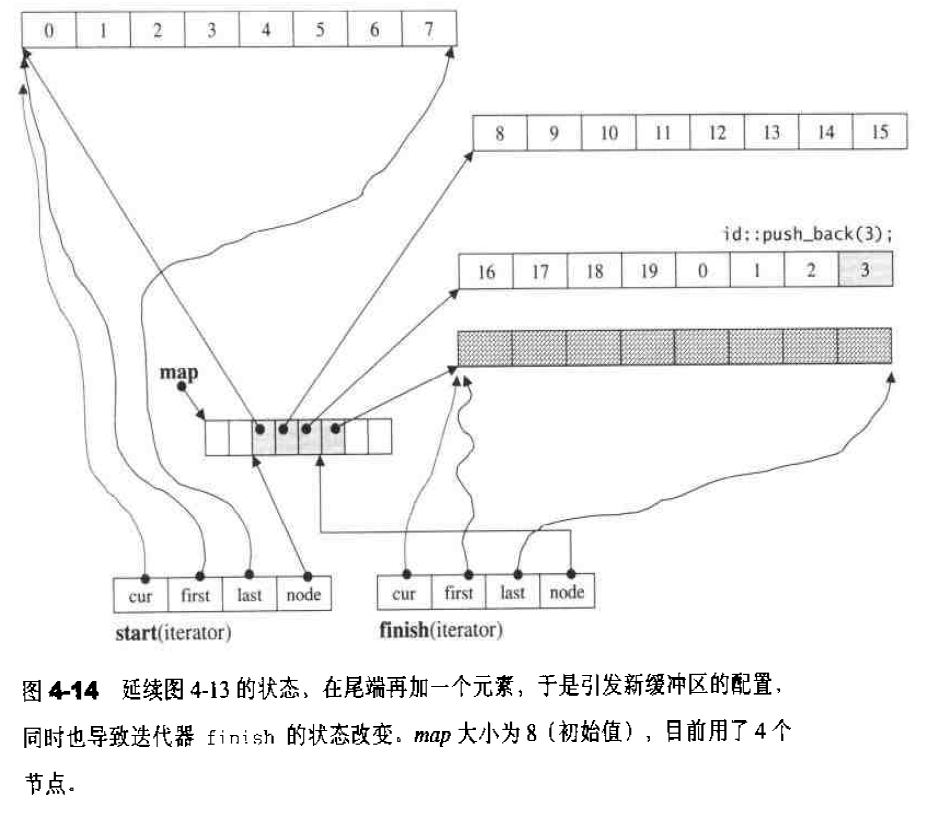

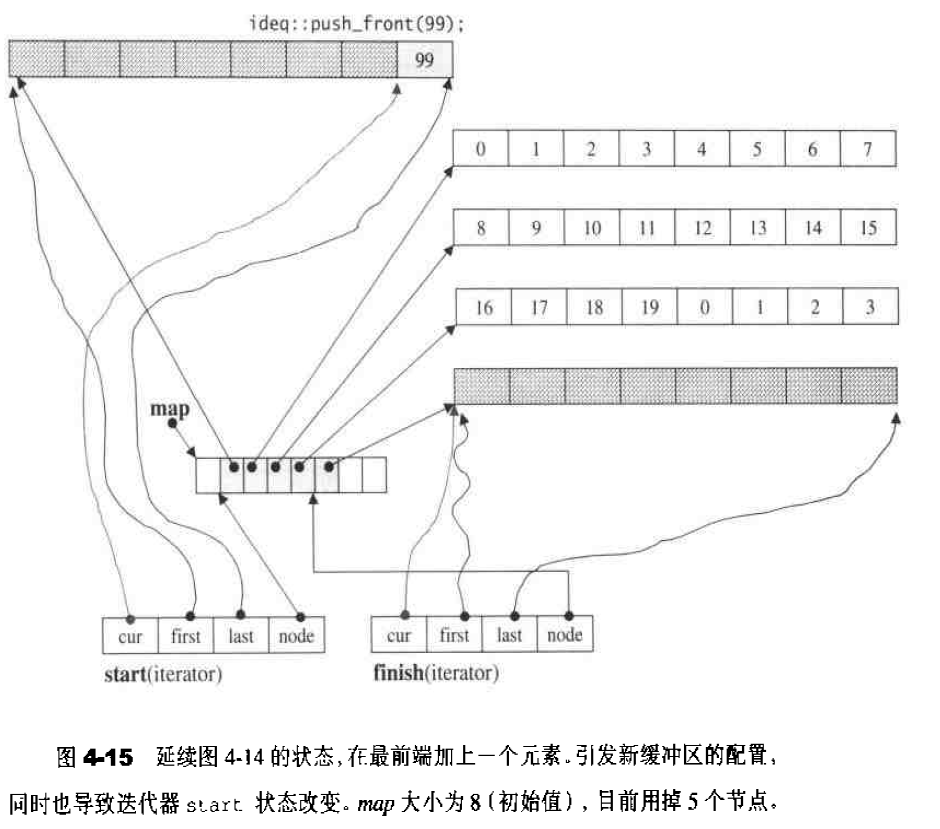

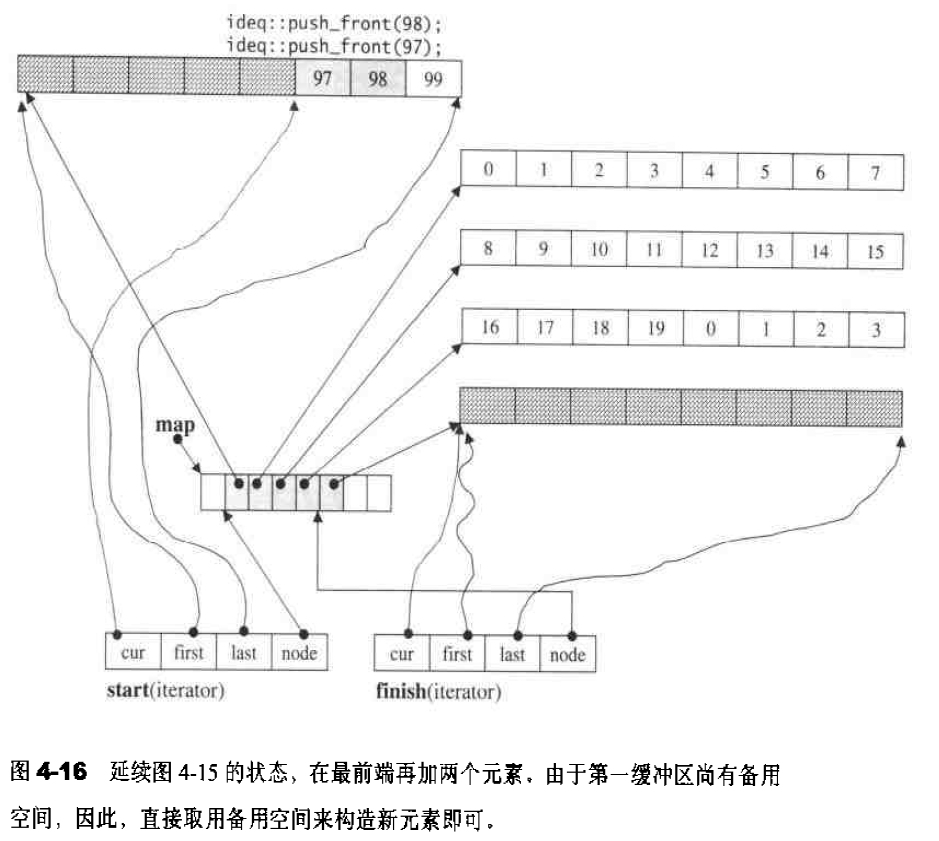

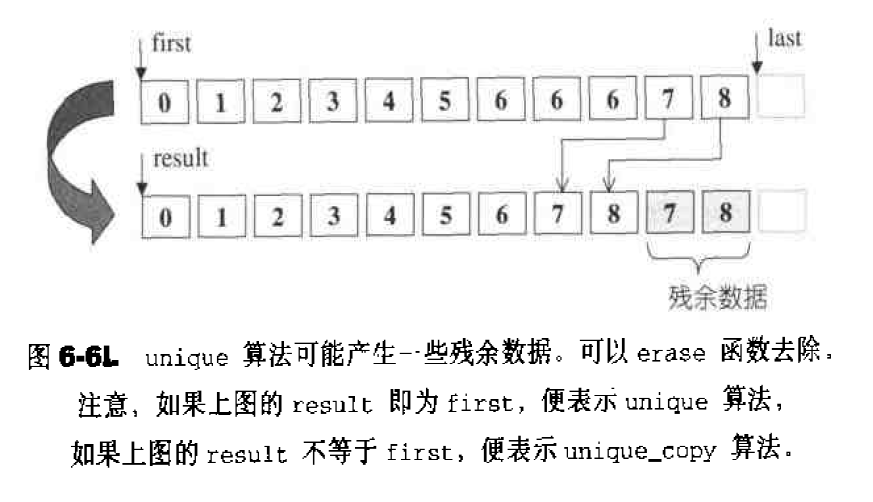

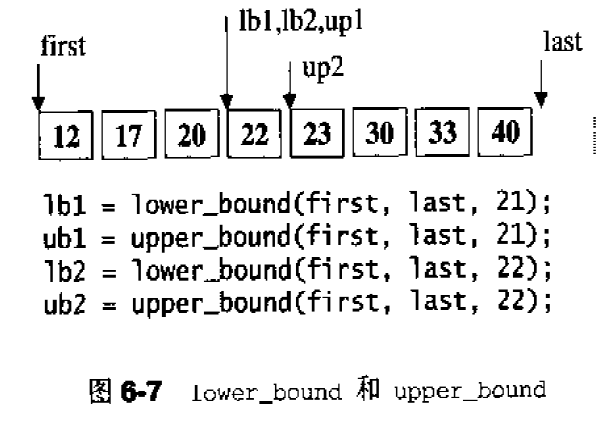

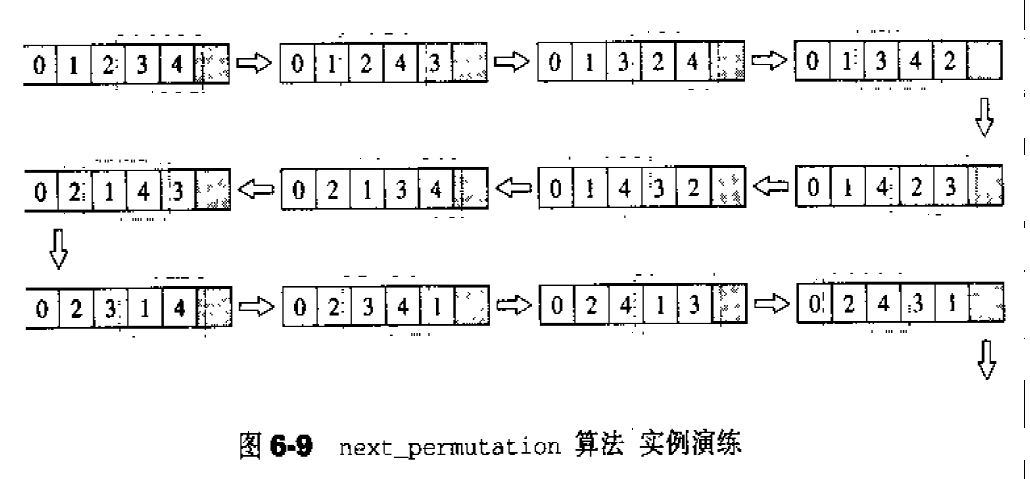

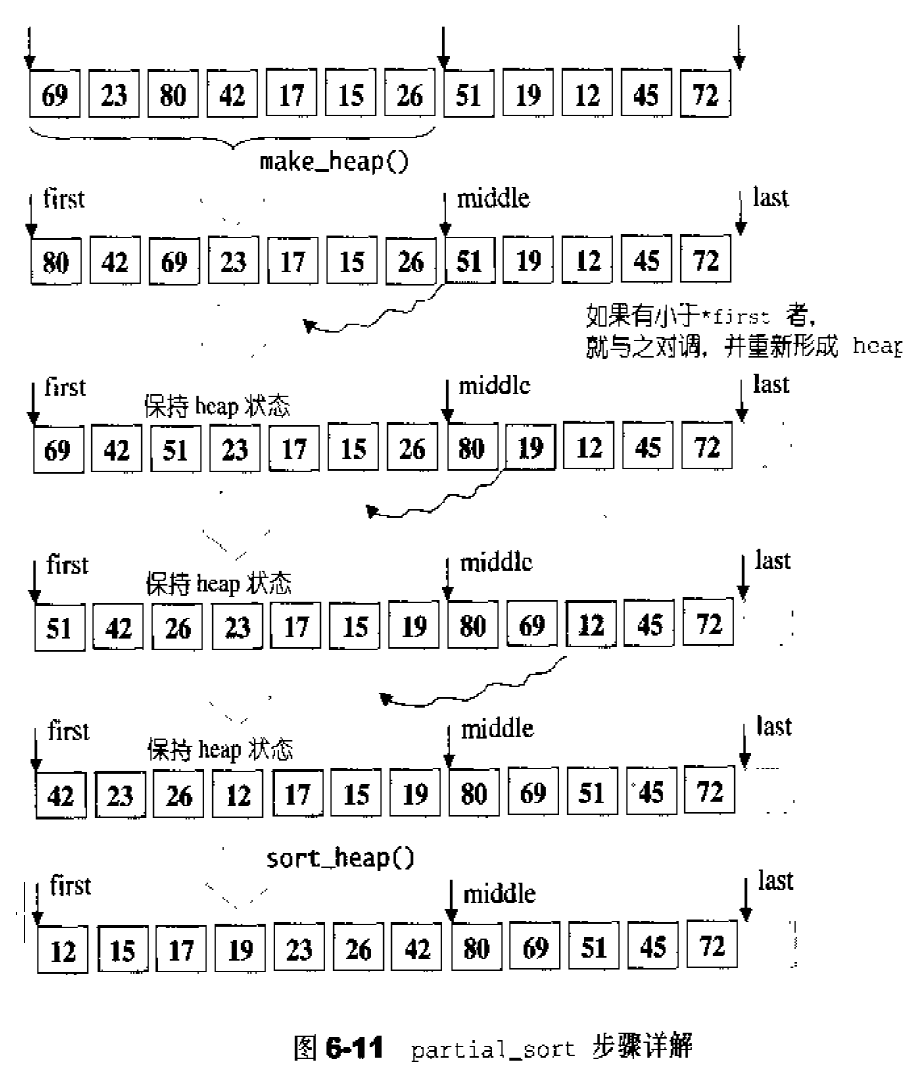

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 int iv[5 ] = { 5 ,6 ,7 ,8 ,9 };list<int > ilist2 (iv,iv+5 ) ; ite = find (ilist.begin (),ilist.end (),99 ); ilist.splice (ite,ilist2); ilist.reverse (); ilist.sort (); void splice (iterator position, list& x) if (!x.empty ()) transfer (position, x.begin (), x.end ()); } void splice (iterator position, list&, iterator i) iterator j = i; ++j; if (position == i || position == j) return ; transfer (position, i, j); }