decltype简介

我们之前使用的typeid运算符来查询一个变量的类型,这种类型查询在运行时进行。RTTI机制为每一个类型产生一个type_info类型的数据,而typeid查询返回的变量相应type_info数据,通过name成员函数返回类型的名称。同时在C++11中typeid还提供了hash_code这个成员函数,用于返回类型的唯一哈希值。RTTI会导致运行时效率降低,且在泛型编程中,我们更需要的是编译时就要确定类型,RTTI并无法满足这样的要求。编译时类型推导的出现正是为了泛型编程,在非泛型编程中,我们的类型都是确定的,根本不需要再进行推导。

而编译时类型推导,除了我们说过的auto关键字,还有本文的decltype。

decltype与auto关键字一样,用于进行编译时类型推导,不过它与auto还是有一些区别的。decltype的类型推导并不是像auto一样是从变量声明的初始化表达式获得变量的类型,而是总是以一个普通表达式作为参数,返回该表达式的类型,而且decltype并不会对表达式进行求值。

decltype用法

推导出表达式类型

1 | int i = 4; |

与using/typedef合用,用于定义类型。

1 | using size_t = decltype(sizeof(0));//sizeof(a)的返回值为size_t类型 |

这样和auto一样,也提高了代码的可读性。

重用匿名类型

在C++中,我们有时候会遇上一些匿名类型,如:1

2

3

4

5struct

{

int d ;

doubel b;

}anon_s;

而借助decltype,我们可以重新使用这个匿名的结构体:1

decltype(anon_s) as ;//定义了一个上面匿名的结构体

泛型编程中结合auto,用于追踪函数的返回值类型

这也是decltype最大的用途了。1

2

3

4

5template <typename _Tx, typename _Ty>

auto multiply(_Tx x, _Ty y)->decltype(_Tx*_Ty)

{

return x*y;

}

decltype推导四规则

- 如果e是一个没有带括号的标记符表达式或者类成员访问表达式,那么的decltype(e)就是e所命名的实体的类型。此外,如果e是一个被重载的函数,则会导致编译错误。

- 否则 ,假设e的类型是T,如果e是一个将亡值,那么decltype(e)为T&&

- 否则,假设e的类型是T,如果e是一个左值,那么decltype(e)为T&。

- 否则,假设e的类型是T,则decltype(e)为T。

标记符指的是除去关键字、字面量等编译器需要使用的标记之外的程序员自己定义的标记,而单个标记符对应的表达式即为标记符表达式。例如:1

int arr[4]

则arr为一个标记符表达式,而arr[3]+0不是。

我们来看下面这段代码:1

2

3int i=10;

decltype(i) a; //a推导为int

decltype((i))b=i;//b推导为int&,必须为其初始化,否则编译错误

仅仅为i加上了(),就导致类型推导结果的差异。这是因为,i是一个标记符表达式,根据推导规则1,类型被推导为int。而(i)为一个左值表达式,所以类型被推导为int&。

通过下面这段代码可以对推导四个规则作进一步了解1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44int i = 4;

int arr[5] = { 0 };

int *ptr = arr;

struct S{ double d; }s ;

void Overloaded(int);

void Overloaded(char);//重载的函数

int && RvalRef();

const bool Func(int);

//规则一:推导为其类型

decltype (arr) var1; //int 标记符表达式

decltype (ptr) var2;//int * 标记符表达式

decltype(s.d) var3;//doubel 成员访问表达式

//decltype(Overloaded) var4;//重载函数。编译错误。

//规则二:将亡值。推导为类型的右值引用。

decltype (RvalRef()) var5 = 1;

//规则三:左值,推导为类型的引用。

decltype ((i))var6 = i; //int&

decltype (true ? i : i) var7 = i; //int& 条件表达式返回左值。

decltype (++i) var8 = i; //int& ++i返回i的左值。

decltype(arr[5]) var9 = i;//int&. []操作返回左值

decltype(*ptr)var10 = i;//int& *操作返回左值

decltype("hello")var11 = "hello"; //const char(&)[9] 字符串字面常量为左值,且为const左值。

//规则四:以上都不是,则推导为本类型

decltype(1) var12;//const int

decltype(Func(1)) var13=true;//const bool

decltype(i++) var14 = i;//int i++返回右值

这里需要提示的是,字符串字面值常量是个左值,且是const左值,而非字符串字面值常量则是个右值。

这么多规则,对于我们写代码的来说难免太难记了,特别是规则三。我们可以利用C++11标准库中添加的模板类is_lvalue_reference来判断表达式是否为左值:1

cout << is_lvalue_reference<decltype(++i)>::value << endl;

结果1表示为左值,结果为0为非右值。

同样的,也有is_rvalue_reference这样的模板类来判断decltype推断结果是否为右值。

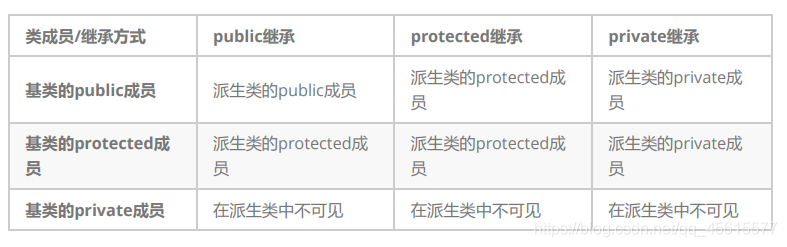

几种继承及其特点

public的变量和函数在类的内部外部都可以访问。

protected的变量和函数只能在类的内部和其派生类中访问。

private修饰的元素只能在类内访问。

成员默认属性

- struct的成员默认是公有的

- class的成员默认是私有的

- class继承默认是私有继承

- struct的继承默认是公有的

公有继承方式(public)

注意事项:

- 基类的私有成员,子类不可以访问

- 基类的保护成员,子类可以继承为自己的保护成员,在派生类可以访问,在外部不可以访问。

- 基类的公有成员,子类可以继承为自己的公有成员。在派生类可以访问,在外部也可以访问。

保护继承(protected)

- 基类公有成员,子类中继承为自己的保护成员,在派生类可以访问,在外部不可以访问

- 基类保护成员,子类中继承为自己的保护成员,在派生类可以访问,在外部不可以访问

- 基类私有成员,子类一样不可以访问基类的私有成员。

私有继承(private)

私有继承方式的,就是在继承时,把protected变成private,它需要注意的事项为:

- 基类公有成员,子类中继承为自己的私有成员,在派生类可以访问,在外部不可以访问。

- 基类保护成员,子类中继承为自己的私有成员,在派生类可以访问,在外部不可以访问。

- 基类私有成员,子类一样不可以访问基类的私有成员,

三种继承方式比较

从上面的结果来看,私有继承和保护继承作用完全一样。仔细一想其实还是有区别,区别是如果派生类再一次去派生其它类时,对于刚才的私有继承来说,再派生的类将得不到任何成员。而对于刚才的保护继承,仍能够得到基类的公有和保护成员。

派生类是可以访问基类保护的数据成员,但是还有一些私有数据成员,派生类是无法访问的,并且为提醒类的独立性,我们还是希望通过调用基类的成员函数去初始化这些成员变量,所以派生类是通过调用基类的构造函数,实现对成员变量的初始化。

继承中的作用域

- 在继承体系中基类和派生类都有独立的作用域。

- 子类和父类中有同名成员,子类成员将屏蔽父类对同名成员的直接访问,这种情况叫隐藏,也叫重定义。(在子类成员函数中,可以使用 基类::基类成员 显示访问)

- 需要注意的是如果是成员函数的隐藏,只需要函数名相同就构成隐藏。

- 注意在实际中在继承体系里面最好不要定义同名的成员。

什么叫同名隐藏,我们用代码看一下1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28class Base

{

public:

void fun()

{

cout << "Base::fun()" << endl;

}

};

// 子类 父类

class D :public Base // 继承

{

public:

void fun()

{

cout << "D::fun()" << endl;

}

void show()

{

cout << "D::shoe()" << endl;

}

};

void main()

{

D d;

Base *pb = &d;

pb->fun();// 只能访问子类中父类所有的fun函数

d.fun(); // 只能访问子类自己的fun函数

}

派生类的默认成员函数

- 派生类的构造函数必须调用基类的构造函数初始化基类的那一部分成员。如果基类没有默认的构造函 数,则必须在派生类构造函数的初始化列表阶段显示调用。

- 派生类的拷贝构造函数必须调用基类的拷贝构造完成基类的拷贝初始化。

- 派生类的operator=必须要调用基类的operator=完成基类的复制。

- 派生类的析构函数会在被调用完成后自动调用基类的析构函数清理基类成员。因为这样才能保证派生类 对象先清理派生类成员再清理基类成员的顺序。

- 派生类对象初始化先调用基类构造再调派生类构造。

- 派生类对象析构清理先调用派生类析构再调基类的析构

继承与静态成员

基类定义了static静态成员,则整个继承体系里面只有一个这样的成员。无论派生出多少个子类,都只有一个static成员实例 。

同样我们看代码 如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66//继承与静态成员

//基类定义了static静态成员,则整个继承体系里面只有一个这样的成员。无论派生出多少个子类,都只有一个static成员实例 。如下

class Test

{

public:

Test()

{

count++;

}

public:

int GetCount()const

{

return count;

}

//int GetCount()const

//{

// return GetOBJCount();

//}

private:

static int count;// 类的静态成员必须在类外初始化

//因为静态成员属于整个类,而不属于某个对象,如果在类内初始化,会导致每个对象都包含该静态成员,这是矛盾的

};

int Test::count = 0;

class D1 :public Test

{

public:

//int GetCount()const

//{

// return GetOBJCount();

//}

};

class D2 :public Test

{

public:

//int GetCount()const

//{

// return GetOBJCount();

//}

};

class D3 :public Test

{

public:

//int GetCount()const

//{

// return GetOBJCount();

//}

};

class D4 :public Test

{

public:

//int GetCount()const

//{

// return GetOBJCount();

//}

};

void main()

{

D1 d1;

cout << d1.GetCount() << endl;

D2 d2;

cout << d2.GetCount() << endl;

D3 d3;

cout << d3.GetCount() << endl;

D4 d4;

cout << d4.GetCount() << endl;

}

基类定义了static静态成员,则整个继承体系里面只有一个这样的成员。无论派生出多少个子类,都只有一 个static成员实例 。

static修饰的成员,只能在类中进行声明,类外定义,原因是因为静态成员属于整个类,而不属于某个对象,如果在类内初始化,会导致每个对象都包含该静态成员,这是矛盾的。

多态性

(1)解释多态性:函数的多种不同的实现方式即为多态

(2)必要性:在继承中,有时候基类的一些函数在派生类中也是有用的,但是功能不够全或者两者的功能实现方式就是不一样的,这个时候就希望重载那个基类的函数,但是为了不再调用这个函数时,出现不知道调用基类的还是子类的情况出现,于是就提出了多态。如果语言不知多态,则不能称为面向对象的。

(3)多态性是如何实现的:多态是实现是依赖于虚函数来实现的,之所以虚函数可以分清楚当前调用的函数是基类的还是派生类的,主要在于基类和派生类分别有着自己的虚函数表,再调用虚函数时,它们是通过去虚函数表去对应的函数的。

其实虚函数表的本质就是一种迟后联编的过程,正常编译都是先期联编的,但是当代码遇到了virtual时,就会把它当做迟后联编,但是为了迟后编译,就生成了局部变量–虚函数表,这就增大了一些空间上的消耗。(前提是两个函数的返回类型,参数类型,参数个数都得相同,不然就起不到多态的作用)

使用虚函数的一些限制

- 只有类成员函数才能声明为虚函数,这是因为虚函数只适用于有继承关系的类对象中。

- 静态成员函数不能说明为虚函数,因为静态成员函数不受限与某个对象,整个内存中只有一个,所以不会出现混淆的情况

- 内联函数不可以被继承,因为内联函数是不能子啊运行中动态的确认其位置的。

- 构造函数不可以被继承。

- 析构函数可以被继承,而且通常声明为虚函数。

纯虚函数

(1)解释:虚函数是在基类中被声明为virtual,并在派生类中重新定义的成员函数,可实现成员函数的动态重载。纯虚函数的声明有着特殊的语法格式:virtual 返回值类型成员函数名(参数表)=0;

(2)必要性:在很多情况下,基类本身生成对象是不合情理的。例如,动物作为一个基类可以派生出老虎、孔雀等子类,但动物本身生成对象明显不合常理。为了解决上述问题,引入了纯虚函数的概念,将函数定义为纯虚函数(方法:virtual ReturnType Function()= 0;),则编译器要求在派生类中必须予以重载以实现多态性。同时含有纯虚拟函数的类称为抽象类,它不能生成对象。

(3)抽象类的解释:包含纯虚函数的类称为抽象类。由于抽象类包含了没有定义的纯虚函数,所以不能定义抽象类的对象。在C++中,抽象类只能用于被继承而不能直接创建对象的类(Abstract Class)。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

using namespace std;

class A

{

public :

virtual void fun() = 0;

};

class B :public A

{

public :

virtual void fun()

{

cout << "B: " << endl;

}

};

int main()

{

B b;

b.fun();

return 0;

}

继承权限

- public继承

- 公有继承的特点是基类的公有成员和保护成员作为派生类的成员时,都保持原有的状态,而基类的私有成员任然是私有的,不能被这个派生类的子类所访问

- protected继承

- 保护继承的特点是基类的所有公有成员和保护成员都成为派生类的保护成员,并且只能被它的派生类成员函数或友元函数访问,基类的私有成员仍然是私有的.

- private继承

- 私有继承的特点是基类的所有公有成员和保护成员都成为派生类的私有成员,并不被它的派生类的子类所访问,基类的成员只能由自己派生类访问,无法再往下继承

模板类的继承

模板类的继承包括四种:

1.(普通类继承模板类)1

2

3

4

5

6

7

8template<class T>

class TBase{

T data;

……

};

class Derived:public TBase<int>{

……

};

2.(模板类继承了普通类(非常常见))1

2

3

4

5

6

7

8class TBase{

……

};

template<class T>

class TDerived:public TBase{

T data;

……

};

3.(类模板继承类模板)1

2

3

4

5

6

7

8

9

10template<class T>

class TBase{

T data1;

……

};

template<class T1,class T2>

class TDerived:public TBase<T1>{

T2 data2;

……

};

4.(模板类继承类模板,即继承模板参数给出的基类)1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

using namespace std;

class BaseA{

public:

BaseA(){cout<<"BaseA founed"<<endl;}

};

class BaseB{

public:

BaseB(){cout<<"BaseB founed"<<endl;}

};

template<typename T, int rows>

class BaseC{

private:

T data;

public:

BaseC():data(rows){

cout<<"BaseC founed "<< data << endl;}

};

template<class T>

class Derived:public T{

public:

Derived():T(){cout<<"Derived founed"<<endl;}

};

void main()

{

Derived<BaseA> x;// BaseA作为基类

Derived<BaseB> y;// BaseB作为基类

Derived<BaseC<int, 3> > z; // BaseC<int,3>作为基类

}

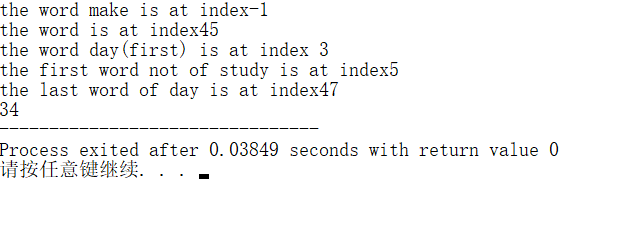

reverse函数

C++ < algorithm > 中定义的reverse函数用于反转在[first,last)范围内的顺序1

2template <class BidirectionalIterator>

void reverse (BidirectionalIterator first,BidirectionalIterator last);

例如,交换vector容器中元素的顺序1

2vector<int> v={1,2,3,4,5};

reverse(v.begin(),v.end());//v的值为5,4,3,2,1

当然,你也可以通过它方便的反转string类的字符串1

2string str="C++REVERSE";

reverse(str.begin(),str.end());//str结果为ESREVER++C

该函数等价于通过调用iter_swap来交换元素位置1

2

3

4

5

6

7

8

9template <class BidirectionalIterator>

void reverse (BidirectionalIterator first, BidirectionalIterator last)

{

while ((first!=last)&&(first!=--last))

{

std::iter_swap (first,last);

++first;

}

}

C++中constexpr作用

constexpr 是 C++ 11 标准新引入的关键字,不过在讲解其具体用法和功能之前,读者需要先搞清楚 C++ 常量表达式的含义。

所谓常量表达式,指的就是由多个(≥1)常量组成的表达式。换句话说,如果表达式中的成员都是常量,那么该表达式就是一个常量表达式。这也意味着,常量表达式一旦确定,其值将无法修改。

实际开发中,我们经常会用到常量表达式。以定义数组为例,数组的长度就必须是一个常量表达式:1

2

3

4

5

6

7// 1)

int url[10];//正确

// 2)

int url[6 + 4];//正确

// 3)

int length = 6;

int url[length];//错误,length是变量

上述代码演示了 3 种定义 url 数组的方式,其中第 1、2 种定义 url 数组时,长度分别为 10 和 6+4,显然它们都是常量表达式,可以用于表示数组的长度;第 3 种 url 数组的长度为 length,它是变量而非常量,因此不是一个常量表达式,无法用于表示数组的长度。

常量表达式的应用场景还有很多,比如匿名枚举、switch-case 结构中的 case 表达式等,感兴趣的读者可自行编码测试,这里不再过多举例。

我们知道,C++ 程序的执行过程大致要经历编译、链接、运行这 3 个阶段。值得一提的是,常量表达式和非常量表达式的计算时机不同,非常量表达式只能在程序运行阶段计算出结果;而常量表达式的计算往往发生在程序的编译阶段,这可以极大提高程序的执行效率,因为表达式只需要在编译阶段计算一次,节省了每次程序运行时都需要计算一次的时间。

对于用 C++ 编写的程序,性能往往是永恒的追求。那么在实际开发中,如何才能判定一个表达式是否为常量表达式,进而获得在编译阶段即可执行的“特权”呢?除了人为判定外,C++11 标准还提供有 constexpr 关键字。

constexpr 关键字的功能是使指定的常量表达式获得在程序编译阶段计算出结果的能力,而不必等到程序运行阶段。C++ 11 标准中,constexpr 可用于修饰普通变量、函数(包括模板函数)以及类的构造函数。

注意,获得在编译阶段计算出结果的能力,并不代表 constexpr 修饰的表达式一定会在程序编译阶段被执行,具体的计算时机还是编译器说了算。

constexpr修饰普通变量

C++11 标准中,定义变量时可以用 constexpr 修饰,从而使该变量获得在编译阶段即可计算出结果的能力。

值得一提的是,使用 constexpr 修改普通变量时,变量必须经过初始化且初始值必须是一个常量表达式。举个例子:1

2

3

4

5

6

7

8

9

using namespace std;

int main()

{

constexpr int num = 1 + 2 + 3;

int url[num] = {1,2,3,4,5,6};

couts<< url[1] << endl;

return 0;

}

程序执行结果为:1

2

读者可尝试将 constexpr 删除,此时编译器会提示“url[num] 定义中 num 不可用作常量”。

可以看到,程序第 6 行使用 constexpr 修饰 num 变量,同时将 “1+2+3” 这个常量表达式赋值给 num。由此,编译器就可以在编译时期对 num 这个表达式进行计算,因为 num 可以作为定义数组时的长度。

有读者可能发现,将此示例程序中的 constexpr 用 const 关键字替换也可以正常执行,这是因为 num 的定义同时满足“num 是 const 常量且使用常量表达式为其初始化”这 2 个条件,由此编译器会认定 num 是一个常量表达式。

注意,const 和 constexpr 并不相同,关于它们的区别,我们会在下一节做详细讲解。

另外需要重点提出的是,当常量表达式中包含浮点数时,考虑到程序编译和运行所在的系统环境可能不同,常量表达式在编译阶段和运行阶段计算出的结果精度很可能会受到影响,因此 C++11 标准规定,浮点常量表达式在编译阶段计算的精度要至少等于(或者高于)运行阶段计算出的精度。

constexpr修饰函数

constexpr 还可以用于修饰函数的返回值,这样的函数又称为“常量表达式函数”。

注意,constexpr 并非可以修改任意函数的返回值。换句话说,一个函数要想成为常量表达式函数,必须满足如下 4 个条件。

1) 整个函数的函数体中,除了可以包含 using 指令、typedef 语句以及 static_assert 断言外,只能包含一条 return 返回语句。

举个例子:1

2

3

4constexpr int display(int x) {

int ret = 1 + 2 + x;

return ret;

}

注意,这个函数是无法通过编译的,因为该函数的返回值用 constexpr 修饰,但函数内部包含多条语句。

如下是正确的定义 display() 常量表达式函数的写法:1

2

3

4constexpr int display(int x) {

//可以添加 using 执行、typedef 语句以及 static_assert 断言

return 1 + 2 + x;

}

可以看到,display() 函数的返回值是用 constexpr 修饰的 int 类型值,且该函数的函数体中只包含一个 return 语句。

2) 该函数必须有返回值,即函数的返回值类型不能是 void。

举个例子:1

2

3constexpr void display() {

//函数体

}

像上面这样定义的返回值类型为 void 的函数,不属于常量表达式函数。原因很简单,因为通过类似的函数根本无法获得一个常量。

3) 函数在使用之前,必须有对应的定义语句。我们知道,函数的使用分为“声明”和“定义”两部分,普通的函数调用只需要提前写好该函数的声明部分即可(函数的定义部分可以放在调用位置之后甚至其它文件中),但常量表达式函数在使用前,必须要有该函数的定义。

举个例子:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

using namespace std;

//普通函数的声明

int noconst_dis(int x);

//常量表达式函数的声明

constexpr int display(int x);

//常量表达式函数的定义

constexpr int display(int x){

return 1 + 2 + x;

}

int main()

{

//调用常量表达式函数

int a[display(3)] = { 1,2,3,4 };

cout << a[2] << endl;

//调用普通函数

cout << noconst_dis(3) << endl;

return 0;

}

//普通函数的定义

int noconst_dis(int x) {

return 1 + 2 + x;

}

程序执行结果为:1

23

6

读者可自行将 display() 常量表达式函数的定义调整到 main() 函数之后,查看编译器的报错信息。

可以看到,普通函数在调用时,只需要保证调用位置之前有相应的声明即可;而常量表达式函数则不同,调用位置之前必须要有该函数的定义,否则会导致程序编译失败。

4) return 返回的表达式必须是常量表达式,举个例子:1

2

3

4

5

6

7

8

9

10

11

12

using namespace std;

int num = 3;

constexpr int display(int x){

return num + x;

}

int main()

{

//调用常量表达式函数

int a[display(3)] = { 1,2,3,4 };

return 0;

}

该程序无法通过编译,编译器报“display(3) 的结果不是常量”的异常。

常量表达式函数的返回值必须是常量表达式的原因很简单,如果想在程序编译阶段获得某个函数返回的常量,则该函数的 return 语句中就不能包含程序运行阶段才能确定值的变量。

注意,在常量表达式函数的 return 语句中,不能包含赋值的操作(例如 return x=1 在常量表达式函数中不允许的)。另外,用 constexpr 修改函数时,函数本身也是支持递归的,感兴趣的读者可自行尝试编码测试。

constexpr修饰类的构造函数

对于 C++ 内置类型的数据,可以直接用 constexpr 修饰,但如果是自定义的数据类型(用 struct 或者 class 实现),直接用 constexpr 修饰是不行的。

举个例子:1

2

3

4

5

6

7

8

9

10

11

12

13

14

using namespace std;

//自定义类型的定义

constexpr struct myType {

const char* name;

int age;

//其它结构体成员

};

int main()

{

constexpr struct myType mt { "zhangsan", 10 };

cout << mt.name << " " << mt.age << endl;

return 0;

}

此程序是无法通过编译的,编译器会抛出“constexpr不能修饰自定义类型”的异常。

当我们想自定义一个可产生常量的类型时,正确的做法是在该类型的内部添加一个常量构造函数。例如,修改上面的错误示例如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

using namespace std;

//自定义类型的定义

struct myType {

constexpr myType(char *name,int age):name(name),age(age){};

const char* name;

int age;

//其它结构体成员

};

int main()

{

constexpr struct myType mt { "zhangsan", 10 };

cout << mt.name << " " << mt.age << endl;

return 0;

}

程序执行结果为:1

zhangsan 10

可以看到,在 myType 结构体中自定义有一个构造函数,借助此函数,用 constexpr 修饰的 myType 类型的 my 常量即可通过编译。

注意,constexpr 修饰类的构造函数时,要求该构造函数的函数体必须为空,且采用初始化列表的方式为各个成员赋值时,必须使用常量表达式。

前面提到,constexpr 可用于修饰函数,而类中的成员方法完全可以看做是“位于类这个命名空间中的函数”,所以 constexpr 也可以修饰类中的成员函数,只不过此函数必须满足前面提到的 4 个条件。

举个例子:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

using namespace std;

//自定义类型的定义

class myType {

public:

constexpr myType(const char *name,int age):name(name),age(age){};

constexpr const char * getname(){

return name;

}

constexpr int getage(){

return age;

}

private:

const char* name;

int age;

//其它结构体成员

};

int main()

{

constexpr struct myType mt { "zhangsan", 10 };

constexpr const char * name = mt.getname();

constexpr int age = mt.getage();

cout << name << " " << age << endl;

return 0;

}

程序执行结果为:1

zhangsan 10

注意,C++11 标准中,不支持用 constexpr 修饰带有 virtual 的成员方法。

constexpr修饰模板函数

C++11 语法中,constexpr 可以修饰模板函数,但由于模板中类型的不确定性,因此模板函数实例化后的函数是否符合常量表达式函数的要求也是不确定的。

针对这种情况下,C++11 标准规定,如果 constexpr 修饰的模板函数实例化结果不满足常量表达式函数的要求,则 constexpr 会被自动忽略,即该函数就等同于一个普通函数。

举个例子:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

using namespace std;

//自定义类型的定义

struct myType {

const char* name;

int age;

//其它结构体成员

};

//模板函数

template<typename T>

constexpr T dispaly(T t){

return t;

}

int main()

{

struct myType stu{"zhangsan",10};

//普通函数

struct myType ret = dispaly(stu);

cout << ret.name << " " << ret.age << endl;

//常量表达式函数

constexpr int ret1 = dispaly(10);

cout << ret1 << endl;

return 0;

}

程序执行结果为:1

2zhangsan 10

10

可以看到,示例程序中定义了一个模板函数 display(),但由于其返回值类型未定,因此在实例化之前无法判断其是否符合常量表达式函数的要求:

第 20 行代码处,当模板函数中以自定义结构体 myType 类型进行实例化时,由于该结构体中没有定义常量表达式构造函数,所以实例化后的函数不是常量表达式函数,此时 constexpr 是无效的;

第 23 行代码处,模板函数的类型 T 为 int 类型,实例化后的函数符合常量表达式函数的要求,所以该函数的返回值就是一个常量表达式。

附录

1 |

|

代码说明:

- 以上代码演示了如何在编译期计算3的阶乘。

- 在C++11之前,在编译期进行数值计算必须使用模板元编程技巧。具体来说我们通常需要定义一个内含编译期常量value的类模板(也称作元函数)。这个类模板的定义至少需要分成两部分,分别用于处理一般情况和特殊情况。

- 代码示例中Factorial元函数的定义分为两部分:

- 当模板参数大于0时,利用公式 N!=N*(N-1)! 递归调用自身来计算value的值。

- 当模板参数为0时,将value设为1这个特殊情况下的值。

- 在C++11之后,编译期的数值计算可以通过使用constexpr声明并定义编译期函数来进行。相对于模板元编程,使用constexpr函数更贴近普通的C++程序,计算过程显得更为直接,意图也更明显。

- 但在C++11中constexpr函数所受到的限制较多,比如函数体通常只有一句return语句,函数体内既不能声明变量,也不能使用for语句之类的常规控制流语句。

- 如factorial函数所示,使用C++11在编译期计算阶乘仍然需要利用递归技巧。

- C++14解除了对constexpr函数的大部分限制。在C++14的constexpr函数体内我们既可以声明变量,也可以使用goto和try之外大部分的控制流语句。

- 如factorial2函数所示,使用C++14在编译期计算阶乘只需利用for语句进行常规计算即可。

- 虽说constexpr函数所定义的是编译期的函数,但实际上在运行期constexpr函数也能被调用。事实上,如果使用编译期常量参数调用constexpr函数,我们就能够在编译期得到运算结果;而如果使用运行期变量参数调用constexpr函数,那么在运行期我们同样也能得到运算结果。

- 代码第32行所演示的是在运行期使用变量n调用constexpr函数的结果。

- 准确的说,constexpr函数是一种在编译期和运行期都能被调用并执行的函数。出于constexpr函数的这个特点,在C++11之后进行数值计算时,无论在编译期还是运行期我们都可以统一用一套代码来实现。编译期和运行期在数值计算这点上得到了部分统一。

const的用法

const是不改变的。在C和C++中,我们使用关键字const来使程序元素保持不变。const关键字可以在C++程序的许多上下文中使用。它可以用于:变量、指针、函数参数和返回类型、类数据成员、类成员函数、对象。

- 修饰变量,说明该变量不可以被改变;

- 修饰指针,分为指向常量的指针(pointer to const)和自身是常量的指针(常量指针,const pointer);

- 修饰引用,指向常量的引用(reference to const),用于形参类型,即避免了拷贝,又避免了函数对值的修改;

- 修饰成员函数,说明该成员函数内不能修改成员变量。

下面的声明都是什么意思?1

2

3

4

5const int a; a是一个常整型数

int const a; a是一个常整型数

const int *a; a是一个指向常整型数的指针,整型数是不可修改的,但指针可以

int * const a; a为指向整型数的常指针,指针指向的整型数可以修改,但指针是不可修改的

int const * a const; a是一个指向常整型数的常指针,指针指向的整型数是不可修改的,同时指针也是不可修改的

const变量

如果你用const关键字做任何变量,你就不能改变它的值。同样,必须在声明的时候初始化常数变量。

Example:1

2

3

4

5

6int main

{

const int i = 10;

const int j = i + 10; // works fine

i++; // this leads to Compile time error

}

上面的代码中,我们使 i 成为常量,因此如果我们试图改变它的值,我们将得到编译时错误。尽管我们可以用它来代替其他变量。

指针与const关键字

指针也可以使用const关键字来声明。当我们使用const和指针时,我们可以用两种方式来做:可以把const应用到指针指向的地方,或者我们可以使指针本身成为一个常数。

指向const变量的指针:

意味着指针指向一个const变量。1

const int* u;

这里,表示u是一个指针,可以指向const int类型变量。指针指向的内容不可改变。简称左定值,因为const位于*号的左边。

我们也可以这样写,1

char const* v;

表示v是指向const类型的char的指针。

指向const变量的指针非常有用,因为它可以用来使任何字符串或数组不可变

const指针

为了使指针保持不变,我们必须把const关键字放到右边。对于const指针p其指向的内存地址不能够被改变,但其内容可以改变。简称,右定向。因为const位于*号的右边。1

2int x = 1;

int* const w = &x;

里,w是一个指针,它是const,指向一个int,现在我们不能改变指针,这意味着它总是指向变量x但是可以改变它指向的值,通过改变x的值。

当你想要一个可以在值中改变但不会在内存中移动的存储器时,常量指针指向一个变量是很有用的。因为指针总是指向相同的内存位置,因为它是用const关键字定义的,但是那个内存位置的值可以被更改。

左定值,右定向,const修饰不变量

const函数参数和返回类型

1 | void f(const int i) |

注意几个要点:

①对于内置数据类型,返回const或非const值,不会有任何影响。1

2

3

4

5

6

7

8

9

10const int h()

{

return 1;

}

int main()

{

const int j = h();

int k = h();

}

j和k都将被赋值为1。不会出现错误。

②对于用户定义的数据类型,返回const,将阻止它的修改。此时返回的值不能作为左值使用,既不能被赋值,也不能被修改。const 修饰返回的指针或者引用,是否返回一个指向 const 的指针,取决于我们想让用户干什么。

③在程序执行时创建的临时对象总是const类型。值传递的 const 修饰传递,一般这种情况不需要 const 修饰,因为函数会自动产生临时变量复制实参值。

当 const 参数为指针时,可以防止指针被意外篡改。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

using namespace std;

void Cpf(int *const a)

{

cout<<*a<<" ";

*a = 9;

}

int main(void)

{

int a = 8;

Cpf(&a);

cout<<a; // a 为 9

system("pause");

return 0;

}

自定义类型的参数传递,需要临时对象复制参数,对于临时对象的构造,需要调用构造函数,比较浪费时间,因此我们采取 const 外加引用传递的方法。并且对于一般的 int、double 等内置类型,我们不采用引用的传递方式。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

using namespace std;

class Test

{

public:

Test(){}

Test(int _m):_cm(_m){}

int get_cm()const

{

return _cm;

}

private:

int _cm;

};

void Cmf(const Test& _tt)

{

cout<<_tt.get_cm();

}

int main(void)

{

Test t(8);

Cmf(t);

system("pause");

return 0;

}

④如果一个函数有一个非const参数,它在发出调用时不能传递const参数。1

2

3

4void t(int*)

{

// function logic

}

如果我们把一个const int参数传递给函数t,会出现错误。

⑤但是,一个具有const类型参数的函数,可以传递一个const类型参数以及一个非const参数。1

2

3

4void g(const int*)

{

// function logic

}

这个函数可以有一个int,也可以有const int类型参数。

const修饰函数返回值

(1)指针传递

如果返回const data,non-const pointer,返回值也必须赋给const data,non-const pointer。因为指针指向的数据是常量不能修改。1

2

3

4

5

6

7

8

9

10

11const int * mallocA(){ ///const data,non-const pointer

int *a=new int(2);

return a;

}

int main()

{

const int *a = mallocA();

///int *b = mallocA(); ///编译错误

return 0;

}

(2)值传递

如果函数返回值采用“值传递方式”,由于函数会把返回值复制到外部临时的存储单元中,加const 修饰没有任何价值。所以,对于值传递来说,加const没有太多意义。

所以:

- 不要把函数

int GetInt(void)写成const int GetInt(void)。 - 不要把函数

A GetA(void)写成const A GetA(void),其中A 为用户自定义的数据类型。

将类数据成员定义为const

这些是类中的数据变量,使用const关键字定义。它们在声明期间未初始化。它们的初始化在构造函数中完成。1

2

3

4

5

6

7

8

9

10

11

12

13

14class Test

{

const int i;

public:

Test (int x) : i(x)

{

}

};

int main()

{

Test t(10);

Test s(20);

}

在这个程序中,i 是一个常量数据成员,在每个对象中它的独立副本将会出现,因此它使用构造函数对每个对象进行初始化。一旦初始化,它的值就不能改变

把类对象定义为const

当一个对象被声明或使用const关键字创建时,它的数据成员在对象的生命周期中永远不会被改变。

语法:1

const class_name object;

例如,如果在上面定义的类测试中,我们想要定义一个常数对象,我们可以这样做:1

const Test r(30);

将类的成员函数定义为const

const成员函数决不会修改对象中的数据成员。注意:const关键字不能与static关键字同时使用,因为static关键字修饰静态成员函数,静态成员函数不含有this指针,即不能实例化,const成员函数必须具体到某一实例。

如果有个成员函数想修改对象中的某一个成员怎么办?这时我们可以使用mutable关键字修饰这个成员,mutable的意思也是易变的,容易改变的意思,被mutable关键字修饰的成员可以处于不断变化中。

const成员函数不能调用非const成员函数,因为非const成员函数可以会修改成员变量。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

using namespace std;

class Point{

public :

Point(int _x):x(_x){}

void testConstFunction(int _x) const{

///错误,在const成员函数中,不能修改任何类成员变量

x=_x;

///错误,const成员函数不能调用非onst成员函数,因为非const成员函数可以会修改成员变量

modify_x(_x);

}

void modify_x(int _x){

x=_x;

}

int x;

};

语法:1

return_type function_name() const;

const对象和const成员函数的例子:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37class StarWars

{

public:

int i;

StarWars(int x) // constructor

{

i = x;

}

int falcon() const // constant function

{

/*

can do anything but will not

modify any data members

*/

cout << "Falcon has left the Base";

}

int gamma()

{

i++;

}

};

int main()

{

StarWars objOne(10); // non const object

const StarWars objTwo(20); // const object

objOne.falcon(); // No error

objTwo.falcon(); // No error

cout << objOne.i << objTwo.i;

objOne.gamma(); // No error

objTwo.gamma(); // Compile time error

}

输出结果:1

2

3Falcon has left the Base

Falcon has left the Base

10 20

在这里,我们可以看到,const成员函数永远不会改变类的数据成员,并且它可以与const和非const对象一起使用。但是const对象不能与试图改变其数据成员的成员函数一起使用。

关于const的疑问:

const常量的判别标准:

- 只有字面量初始化的const常量才会进入符号表

- 使用其他变量初始化的const常量仍然是只读变量

- 被volatile修饰的const常量不会进入符号表

注意:

- const引用的类型与初始化变量的类型相同时:初始化变量成为只读变量

- const引用的类型与初始化变量的类型不相同时:初生成一个新的只读变量

Example:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

int main()

{

const int x = 1; //字面量初始化,此时x为常量,进入符号表

const int& rx = x; //rx代表只读变量

int& nrx = const_cast<int&>(rx); //去掉rx的只读属性

nrx = 5; //改变了nrx内存空间的值

printf("x = %d\n", x); // 1

printf("rx = %d\n", rx); // 5

printf("nrx = %d\n", nrx); // 5

printf("&x = %p\n", &x); // &x = 002CFD80

printf("&rx = %p\n", &rx); // &x = 002CFD80

printf("&nrx = %p\n", &nrx); // &x = 002CFD80

//输出的地址相同,说明了x、rx、nrx代表同样的内存空间

volatile const int y = 2;//volatile代表易变的

int* p = const_cast<int*>(&y);

*p = 6;

printf("y = %d\n", y); //y = 6

printf("p = %p\n", p); //p = 001BF928

//判别是否是常量是编译器在编译时能不能确认它的值

const int z = y;

p = const_cast<int*>(&z);

*p = 7;

printf("z = %d\n", z); // z = 7

printf("p = %p\n", p); //p = 001BF910

char c = 'c';

char& rc = c;

const int& trc = c;

rc = 'a';

printf("c = %c\n", c); // c = a

printf("rc = %c\n", rc);// rc = a

printf("trc = %c\n", trc);//trc = c

//变量c是char类型,而trc是int类型,所以生成了一个新的只读变量

return 0;

}

输出结果:

const与#define的区别

- const定义的常量是变量带类型,而#define定义的只是个常数不带类型;

- define只在预处理阶段起作用,简单的文本替换,而const在编译、链接过程中起作用;

- define只是简单的字符串替换没有类型检查。而const是有数据类型的,是要进行判断的,可以避免一些低级错误;

- define预处理后,占用代码段空间,const占用数据段空间;

- const不能重定义,而define可以通过#undef取消某个符号的定义,进行重定义;

- define独特功能,比如可以用来防止文件重复引用。

const重载

可以看下面的代码:

1 | struct A { |

这段代码输出的是这样:

1 | non const |

const修饰的对象调用的是使用const修饰的方法,非const对象调用的是非const的方法。

看下面的这段代码:

1 | A a; |

其实到底层,函数可能会变成这样:

1 | func(A* a); |

函数是在代码段,对象是在数据段,调用不同对象的函数,其实只不过是同一个函数,传递了不同的数据参数而已。

上面的是把对象的this指针传进去。

再回到上面的代码:

1 | struct A { |

可以理解为:

1 | int count(A *); |

咦,这不就是重载吗,难道还有const重载?

还真有,看下这段代码:

1 | struct A { |

输出如下:

1 | const |

所以得出结论:

不只是参数类型和个数不同会产生重载,const修饰的参数也会有重载。

但是只有当const修饰的是指针或者引用类型时才可以,普通的int和const int会编译失败的,具体大家可以自己写代码试试。

宏定义#define的理解与资料整理

利用define来定义 数值宏常量

#define宏定义是个演技非常高超的替身演员,但也会经常耍大牌的,所以我们用它要慎之又慎。它可以出现在代码的任何地方,从本行宏定义开始,以后的代码就就都认识这个宏了;也可以把任何东西定义成宏。因为编译器会在预编译的时候用真身替换替身,而在我们的代码里面却又用常常用替身来帮忙。

看例子:1

在此后的代码中你尽可以使用PI 来代替3.141592654,而且你最好就这么做。不然的话,如果我要把PI 的精度再提高一些,你是否愿意一个一个的去修改这串数呢?你能保证不漏不出错?而使用PI 的话,我们却只需要修改一次(这是十分高效的)。

这种情况还不是最要命的,我们再看一个例子:1

如果你在代码里不用ERROR_POWEROFF 这个宏而用-1,尤其在函数返回错误代码的时候(往往一个开发一个系统需要定义很多错误代码)。肯怕上帝都无法知道-1 表示的是什么意思吧。这个-1,我们一般称为“魔鬼数”,上帝遇到它也会发狂的。所以,我奉劝你代码里一定不要出现“魔鬼数”。(这里是从代码可读性的角度进行考虑!)

但是我们利用define来定义数值类型的数据,一般只是用来定义 常量 ,如果 要定义一些变量,则可以使用c语言中const这个关键字。

我们已经讨论了const 这个关键字,我们知道const 修饰的数据是有类型的,而define 宏定义的数据没有类型。为了安全,我建议你以后在定义一些宏常数的时候用const代替,编译器会给const 修饰的只读变量做类型校验,减少错误的可能。

但一定要注意const修饰的不是常量而是readonly 的变量,const 修饰的只读变量不能用来作为定义数组的维数,也不能放在case 关键字后面。

利用define来定义 字符串宏常量

除了定义宏常数之外,经常还用来定义字符串,尤其是路径:1

2

噢,到底哪一个正确呢?如果路径太长,一行写下来比较别扭怎么办?用反斜杠接续符 ‘\’ 啊:1

还没发现问题?这里用了4 个反斜杠,到底哪个是接续符?回去看看接续符反斜杠。

反斜杠作为接续符时,在本行其后面不能再有任何字符,空格都不行。所以,只有最后一个反斜杠才是接续符。至于A)和B),那要看你怎么用了,既然define 宏只是简单的替换,那给ENG_PATH_1 加上双引号不就成了:“ENG_PATH_1”。

但是请注意:有的系统里规定路径的要用双反斜杠“\\”,比如(这是正确的版本):1

用define 宏定义注释符号

上面对define 的使用都很简单,再看看下面的例子:1

2

3

4

5

BSC my single-line comment

BMC my multi-line comment EMC

D)和E)都错误,为什么呢?因为注释先于预处理指令被处理,当这两行被展开成//…或/…/时,注释已处理完毕,此时再出现//…或/…/自然错误。

因此,试图用宏开始或结束一段注释是不行的。

用define 宏定义表达式

这些都好理解,下面来点有“技术含量”的,定义一年有多少秒:1

这个定义没错吧?很遗憾,很有可能错了,至少不可靠。你有没有考虑在16 位系统下把这样一个数赋给整型变量的时候可能会发生溢出?一年有多少秒也不可能是负数吧。

改一下:1

又出现一个问题,这里的括号到底需不需要呢?继续看一个例子,定义一个宏函数,求x 的平方:1

#define SQR (x) x * x

对不对?试试:假设x 的值为10,SQR (x)被替换后变成10*10。没有问题。

再试试:假设x 的值是个表达式10+1,SQR (x)被替换后变成10+1*10+1。问题来了,这并不是我想要得到的。怎么办?括号括起来不就完了?1

最外层的括号最好也别省了,看例子,求两个数的和:1

如果x 的值是个表达式5*3,而代码又写成这样:SUM (x)* SUM (x)。替换后变成:(5*3)+(5*3)*(5*3)+(5*3)。又错了!所以最外层的括号最好也别省了。我说过define是个演技高超的替身演员,但也经常耍大牌。要搞定它其实很简单,别吝啬括号就行了。

注意这一点:宏函数被调用时是以实参代换形参。而不是“值传送”。

宏定义中的空格

另外还有一个问题需要引起注意,看下面例子:1

编译器认为这是定义了一个宏:SUM,其代表的是(x) (x)+(x)。

为什么会这样呢?其关键问题还是在于SUM 后面的这个空格。所以在定义宏的时候一定要注意什么时候该用空格,什么时候不该用空格。这个空格仅仅在定义的时候有效,在使用这个宏函数的时候,空格会被编译器忽略掉。也就是说,上一节定义好的宏函数SUM(x)在使用的时候在SUM 和(x)之间留有空格是没问题的。比如:SUM(3)和SUM (3)的意思是一样的。

undef

#undef是用来撤销宏定义的,用法如下:1

2

3

4

5

…

// code

//下面的代码就不能用PI 了,它已经被撤销了宏定义。

写好C语言,漂亮的宏定义很重要,使用宏定义可以防止出错,提高可移植性,可读性,方便性 等等。下面列举一些成熟软件中常用得宏定义:

防止一个头文件被重复包含1

2

3

4

5

6

7

//头文件内容

重新定义一些类型

防止由于各种平台和编译器的不同,而产生的类型字节数差异,方便移植。这里已经不是#define的范畴了。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20typedef unsigned char boolean; /* Boolean value type. */

typedef unsigned long int uint32; /* Unsigned 32 bit value */

typedef unsigned short uint16; /* Unsigned 16 bit value */

typedef unsigned char uint8; /* Unsigned 8 bit value */

typedef signed long int int32; /* Signed 32 bit value */

typedef signed short int16; /* Signed 16 bit value */

typedef signed char int8; /* Signed 8 bit value */

//下面的不建议使用

typedef unsigned char byte; /* Unsigned 8 bit value type. */

typedef unsigned short word; /* Unsinged 16 bit value type. */

typedef unsigned long dword; /* Unsigned 32 bit value type. */

typedef unsigned char uint1; /* Unsigned 8 bit value type. */

typedef unsigned short uint2; /* Unsigned 16 bit value type. */

typedef unsigned long uint4; /* Unsigned 32 bit value type. */

typedef signed char int1; /* Signed 8 bit value type. */

typedef signed short int2; /* Signed 16 bit value type. */

typedef long int int4; /* Signed 32 bit value type. */

typedef signed long sint31; /* Signed 32 bit value */

typedef signed short sint15; /* Signed 16 bit value */

typedef signed char sint7; /* Signed 8 bit value */

得到指定地址上的一个字节或字1

2

求最大值和最小值1

2

得到一个field在结构体(struct)中的偏移量1

2

得到一个结构体中field所占用的字节数1

按照LSB格式把两个字节转化为一个Word1

按照LSB格式把一个Word转化为两个字节1

2

3

得到一个变量的地址(word宽度)1

2

得到一个字的高位和低位字节1

2

返回一个比X大的最接近的8的倍数1

#define RND8( x ) ((((x) + 7) / 8 ) * 8 )

将一个字母转换为大写1

判断字符是不是10进值的数字1

判断字符是不是16进值的数字1

2

3

防止溢出的一个方法1

返回数组元素的个数1

返回一个无符号数n尾的值MOD_BY_POWER_OF_TWO(X,n)=X%(2^n)1

2

对于IO空间映射在存储空间的结构,输入输出处理1

2

3

4

5

6

使用一些宏跟踪调试

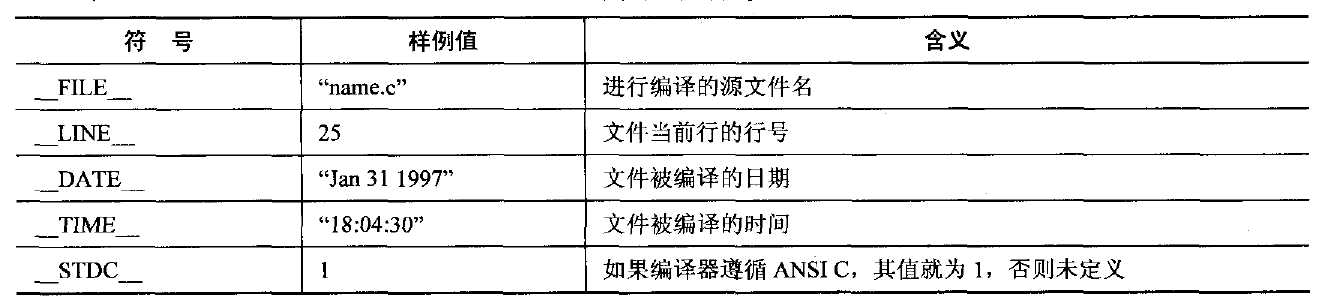

ANSI标准说明了五个预定义的宏名。它们是:1

2

3

4

5__LINE__

__FILE__

__DATE__

__TIME__

__STDC__

可以定义宏,例如:

当定义了_DEBUG,输出数据信息和所在文件所在行1

2

3

4

5

宏定义防止使用错误,用小括号包含。例如:1

用do{}while(0)语句包含多语句防止错误,例如:1

2

应用时:1

2

3if(….)

DO(a,b); //产生错误

else

解决方法: 代码就只会执行一次。和直接加花括号有什么区别呢。哦对,不能随便在程序中,任意加{},组成代码块的。1

2

new 操作符

当你写这种代码:1

string *ps = new string("Memory Management");

你使用的new是new操作符。这个操作符就象sizeof一样是语言内置的。你不能改变它的含义,它的功能总是一样的。它要完毕的功能分成两部分。第一部分是分配足够的内存以便容纳所需类型的对象。第二部分是它调用构造函数初始化内存中的对象。new操作符总是做这两件事情,你不能以不论什么方式改变它的行为。

operator new

你所能改变的是怎样为对象分配内存。

new操作符调用一个函数来完毕必需的内存分配,你可以重写或重载这个函数来改变它的行为。new操作符为分配内存所调用函数的名字是operator new。

函数operator new 通常这样声明:1

void * operator new(size_t size);

返回值类型是void*,由于这个函数返回一个未经处理(raw)的指针。未初始化的内存。參数size_t确定分配多少内存。

你能添加额外的參数重载函数operator new,可是第一个參数类型必须是size_t。

你一般不会直接调用operator new,可是一旦这么做。你能够象调用其他函数一样调用它:1

void *rawMemory = operator new(sizeof(string));

操作符operator new将返回一个指针,指向一块足够容纳一个string类型对象的内存。就象malloc一样,operator new的职责仅仅是分配内存。

它对构造函数一无所知。operator new所了解的是内存分配。把operator new 返回的未经处理的指针传递给一个对象是new操作符的工作。当你的编译器遇见这种语句:1

string *ps = new string("Memory Management");

它生成的代码或多或少与以下的代码相似:1

2

3

4void *memory = operator new(sizeof(string)); // 得到未经处理的内存,为String对象

call string::string("Memory Management")

on *memory; // 内存中的对象

string *ps = static_cast<string*>(memory); // 使ps指针指向新的对象

注意第二步包括了构造函数的调用,你做为一个程序猿被禁止这样去做。你的编译器则没有这个约束,它能够做它想做的一切。

因此假设你想建立一个堆对象就必须用new操作符。不能直接调用构造函数来初始化对象。(总结:operator new是用来分配内存的函数,为new操作符调用。能够被重载(有限制))

placement new

有时你确实想直接调用构造函数。在一个已存在的对象上调用构造函数是没有意义的,由于构造函数用来初始化对象。而一个对象只能在给它初值时被初始化一次。

可是有时你有一些已经被分配可是尚未处理的的(raw)内存,你须要在这些内存中构造一个对象。你能够使用一个特殊的operator new ,它被称为placement new。

以下的样例是placement new怎样使用,考虑一下:1

2

3

4

5

6

7

8

9

10class Widget {

public:

Widget(int widgetSize);

...

};

Widget * constructWidgetInBuffer(void *buffer,int widgetSize)

{

return new (buffer) Widget(widgetSize);

}

这个函数返回一个指针。指向一个Widget对象,对象在转递给函数的buffer里分配。

当程序使用共享内存或memory-mapped I/O时这个函数可能实用,由于在这样程序里对象必须被放置在一个确定地址上或一块被例程分配的内存里。

在constructWidgetInBuffer里面。返回的表达式是:new (buffer) Widget(widgetSize)

这初看上去有些陌生,可是它是new操作符的一个使用方法,须要使用一个额外的变量(buffer)。当new操作符隐含调用operator new函数时。把这个变量传递给它。被调用的operator new函数除了带有强制的參数size_t外,还必须接受void*指针參数。指向构造对象占用的内存空间。这个operator new就是placement new,它看上去象这样:1

2

3

4void * operator new(size_t, void *location)

{

return location;

}

这可能比你期望的要简单,可是这就是placement new须要做的事情。毕竟operator new的目的是为对象分配内存然后返回指向该内存的指针。在使用placement new的情况下,调用者已经获得了指向内存的指针。由于调用者知道对象应该放在哪里。placement new必须做的就是返回转递给它的指针。。

(总结:placement new是一种特殊的operator new,作用于一块已分配但未处理或未初始化的raw内存)

小结

让我们从placement new回来片刻,看看new操作符(new operator)与operator new的关系,(new操作符调用operator new)你想在堆上建立一个对象,应该用new操作符。它既分配内存又为对象调用构造函数。假设你只想分配内存,就应该调用operator new函数;它不会调用构造函数。假设你想定制自己的在堆对象被建立时的内存分配过程,你应该写你自己的operator new函数。然后使用new操作符,new操作符会调用你定制的operator new。假设你想在一块已经获得指针的内存里建立一个对象。应该用placement new。

Deletion and Memory Deallocation

为了避免内存泄漏,每一个动态内存分配必须与一个等同相反的deallocation相应。

函数operator delete与delete操作符的关系与operator new与new操作符的关系一样。当你看到这些代码:1

2

3string *ps;

...

delete ps; // 使用delete 操作符

你的编译器会生成代码来析构对象并释放对象占有的内存。

Operator delete用来释放内存。它被这样声明:1

2

3

4

5

6

7void operator delete(void *memoryToBeDeallocated);

···

因此, delete ps; 导致编译器生成类似于这种代码:

```C++

ps->~string(); // call the object's dtor

operator delete(ps); // deallocate the memory the object occupied

这有一个隐含的意思是假设你仅仅想处理未被初始化的内存,你应该绕过new和delete操作符,而调用operator new 获得内存和operator delete释放内存给系统:1

2

3

4

5void *buffer = operator new(50*sizeof(char)); // 分配足够的内存以容纳50个char

//没有调用构造函数

...

operator delete(buffer); // 释放内存

// 没有调用析构函数

这与在C中调用malloc和free等同。

假设你用placement new在内存中建立对象,你应该避免在该内存中用delete操作符。

由于delete操作符调用operator delete来释放内存,可是包括对象的内存最初不是被operator new分配的。placement new仅仅是返回转递给它的指针。谁知道这个指针来自何方?而你应该显式调用对象的析构函数来解除构造函数的影响:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16// 在共享内存中分配和释放内存的函数 void * mallocShared(size_t size);

void freeShared(void *memory);

void *sharedMemory = mallocShared(sizeof(Widget));

Widget *pw = // 如上所看到的,

constructWidgetInBuffer(sharedMemory, 10); // 使用

// placement new

...

delete pw; // 结果不确定! 共享内存来自

// mallocShared, 而不是operator new

pw->~Widget(); // 正确。 析构 pw指向的Widget,

// 可是没有释放

//包括Widget的内存

freeShared(pw); // 正确。 释放pw指向的共享内存

// 可是没有调用析构函数

如上例所看到的,假设传递给placement new的raw内存是自己动态分配的(通过一些不经常使用的方法),假设你希望避免内存泄漏,你必须释放它。

数组

如何分配数组?会发生什么?1

string *ps = new string[10]; // allocate an array of objects

被使用的new仍然是new操作符,可是建立数组时new操作符的行为与单个对象建立有少许不同。

第一是内存不再用operator new分配,取代以等同的数组分配函数,叫做operator new[](常常被称为array new)。

它与operator new一样能被重载。

在这种编译器下定制数组内存分配是困难的。由于它须要重写全局operator new。这可不是一个能轻易接受的任务。

缺省情况下,全局operator new处理程序中全部的动态内存分配,所以它行为的不论什么改变都将有深入和普遍的影响。并且全局operator new有一个正常的签名(normal signature)。

第二个不同是new操作符调用构造函数的数量。对于数组,在数组里的每个对象的构造函数都必须被调用:1

2

3string *ps = new string[10]; // 调用operator new[]为10个string对象分配内存,

// 然后对每一个数组元素调用string对象的缺省构造函数。

相同当delete操作符用于数组时,它为每一个数组元素调用析构函数,然后调用operator delete来释放内存。

就象你能替换或重载operator delete一样,你也替换或重载operator delete[]。

static关键字

首先说一下内存的五个区:

- 栈(stack):由编译器自动分配释放,存放函数的参数值,局部变量的值(除static),其操作方式类似于数据结构中的栈。

- 堆(heap):一般由程序员分配释放,若程序员不释放,程序结束时可能由OS回收。注意它与数据结构中的堆(优先队列)是两回事,分配方式倒是类似于链表。

- 全局区(静态区):全局变量和静态变量的存储是放在一块的,初始化的全局变量和静态变量在一块区域,未初始化的全局变量和未初始化的静态变量在相邻的另一块区域(BSS),程序结束后由系统释放。

- 文字常量区:常量字符串就是放在这里的,如char str[]=”hello”,程序结束后由系统释放,区别const修饰的变量。

- 程序代码区:存放函数体的二进制代码。

作用

- 修饰普通变量,修改变量的存储区域和生命周期,使变量存储在静态区,在 main 函数运行前就分配了空间,如果有初始值就用初始值初始化它,如果没有初始值系统用默认值初始化它。

- 修饰普通函数,表明函数的作用范围,仅在定义该函数的文件内才能使用。在多人开发项目时,为了防止与他人命名空间里的函数重名,可以将函数定位为 static。

- 修饰成员变量,修饰成员变量使所有的对象只保存一个该变量,而且不需要生成对象就可以访问该成员。

- 修饰成员函数,修饰成员函数使得不需要生成对象就可以访问该函数,但是在 static 函数内不能访问非静态成员。

- 在函数体,一个被声明为静态的变量在这一函数被调用过程中维持其值不变。

- 在模块内(但在函数体外),一个被声明为静态的变量可以被模块内所用函数访问,但不能被模块外其它函数访问。它是一个本地的全局变量。

- 在模块内,一个被声明为静态的函数只可被这一模块内的其它函数调用。那就是,这个函数被限制在声明它的模块的本地范围内使用

- 类内的static成员变量属于整个类所拥有,不能在类内进行定义,只能在类的作用域内进行定义

- 类内的static成员函数属于整个类所拥有,不能包含this指针,只能调用static成员函数

全局变量和static变量的区别

- 全局变量(外部变量)的说明之前再冠以static就构成了静态的全局变量。

- 全局变量本身就是静态存储方式,静态全局变量当然也是静态存储方式。

- 这两者在存储方式上并无不同。这两者的区别在于非静态全局变量的作用域是整个源程序,当一个源程序由多个原文件组成时,非静态的全局变量在各个源文件中都是有效的。

- 而静态全局变量则限制了其作用域,即只在定义该变量的源文件内有效,在同一源程序的其它源文件中不能使用它。由于静态全局变量的作用域限于一个源文件内,只能为该源文件内的函数公用,因此可以避免在其他源文件中引起错误。

- static全局变量与普通的全局变量的区别是static全局变量只初始化一次,防止在其他文件单元被引用。

static函数与普通的函数作用域不同。尽在本文件中。只在当前源文件中使用的函数应该说明为内部函数(static),内部函数应该在当前源文件中说明和定义。

对于可在当前源文件以外使用的函数应该在一个头文件中说明,要使用这些函数的源文件要包含这个头文件。static函数与普通函数最主要区别是static函数在内存中只有一份,普通静态函数在每个被调用中维持一份拷贝程序的局部变量存在于(堆栈)中,全局变量存在于(静态区)中,动态申请数据存在于(堆)

static 变量

静态局部变量保存在全局数据区(静态区),而不是保存在栈中,每次的值保持到下一次调用,直到下次赋新值。

- static全局变量与普通的全局变量有什么区别:static全局变量只初使化一次,防止在其他文件单元中被引用;

- static局部变量和普通局部变量有什么区别:static局部变量只被初始化一次,下一次依据上一次结果值;

- static函数与普通函数有什么区别:static函数在内存中只有一份,普通函数在每个被调用中维持一份拷贝

static 成员变量

定义必须在类定义体的外部,在类的内部只是声明,声明必须加static,定义不需要。static类对象必须要在类外进行初始化,static修饰的变量先于对象存在,所以static修饰的变量要在类外初始化;1

2

3

4

5

6

7

8

9

10

11

12class A

{

public:

// 声明static变量,任何声明都不可初始化,如extern外部变量

static int a;

private:

static int b;

};

// 定义static成员变量,可初始化

int A::a = 5;

// 私有静态成员变量,不能直接用类名调用或者对象调用,只能在类内调用

int A::b = 1;

跟类相关的,跟具体的类的对象无关,为所有实例所共享,某个类的实例修改了该静态成员变量,其修改值为该类的其它所有实例所见。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

using namespace std;

class A

{

public:

// 声明static变量,任何声明都不可初始化,如extern外部变量

static int a;

private:

static int b;

public:

static int getAValue()

{

return this.a;

}

};

// 定义static成员变量,可初始化

int A::a = 5;

// 私有静态成员变量,不能直接用类名调用或者对象调用,只能在类内调用

int A::b = 1;

int main(int argc, char *argv[])

{

// new 两个个实例(对象)

A * instanceA = new A();

A * instanceB = new A();

// 改变值,均输出1

instanceA->a = 1;

cout << A::a << endl;

cout << instanceA->getAValue() << endl;

cout << instanceB->getAValue() << endl;

return 0;

}

static 函数

1 |

|

1 |

|

【编译】1

g++ a.cpp b.cpp -o ab.exe

【输出】1

2a = 5

hello world

如果在a.cpp中的int a = 5;定义前面加上static修饰,那么再次去编译,就会b.cpp报未定义错误。如果在a.cpp中的void printHello()函数前加static修饰,再次去编译,一样会报未定义错误。很明显,所有未加static修饰的函数和全局变量具有全局可见性,其他的源文件也能够访问。static修饰函数和变量这一特性可以在不同的文件中定义同名函数和同名变量,而不必担心命名冲突。static可以用作函数和变量的前缀,对于函数来讲,static的作用仅限于隐藏。这有点类似于C++中的名字空间。

static 成员函数

同样的和成员变量一样,跟类相关的,跟具体的类的对象无关,可以通过类名来调用。static成员函数里面不能访问非静态成员变量,也不能调用非静态成员函数。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

using namespace std;

class A

{

public:

void printStr()

{

printf("hello world");

}

static void print()

{

// 错误,静态成员函数不能调用非静态成员函数

printStr();

}

};

int main(int argc, char *argv[])

{

return 0;

}

静态成员函数没有this隐含指针修饰,存在一种情况,用const修饰类的成员函数(写在函数的最后,不是前面,前面是返回值为常量),表示该函数不能修改该类的状态,如不能在改函数里修改成员变量(除去mutable修饰的外),因为该函数存在一个隐式的this,const修饰后为const this,但是当static修饰成员函数的时候是没有this指针的,所以不能同时用static和const修饰同一个成员函数,不过可以修饰同一个成员变量。

static成员函数不能被virtual修饰,static成员不属于任何对象或实例,所以加上virtual没有任何实际意义;

虚函数的实现是为每一个对象分配一个vptr指针,而vptr是通过this指针调用的,所以不能为virtual

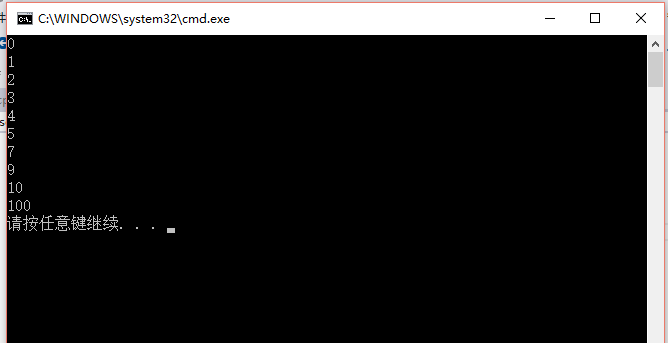

vector和set使用sort方法进行排序

C++中vector和set都是非常方便的容器,

sort方法是algorithm头文件里的一个标准函数,能进行高效的排序,默认是按元素从小到大排序

将sort方法用到vector和set中能实现多种符合自己需求的排序

首先sort方法可以对静态的数组进行排序1

2

3

4

5

6

7

8

9

using namespace std;

int main(){

int a[10] = { 9, 0, 1, 2, 3, 7, 4, 5, 100, 10 };

sort(a, a +10);

for (int i = 0; i < 10; i++)

cout << a[i] << endl;

return 0;

}

运行结果如下:

这里可以看到是sort(a,a+10),但是数组a一共只有9个元素,为什么是a+10而不是a+9呢?

因为sort方法实际上最后一位地址对应的数是不取的,

而且vector,set,map这些容器的end()取出来的值实际上并不是最后一个值,而end的前一个才是最后一个值!

需要用prev(xxx.end()),才能取出容器中最后一个元素。

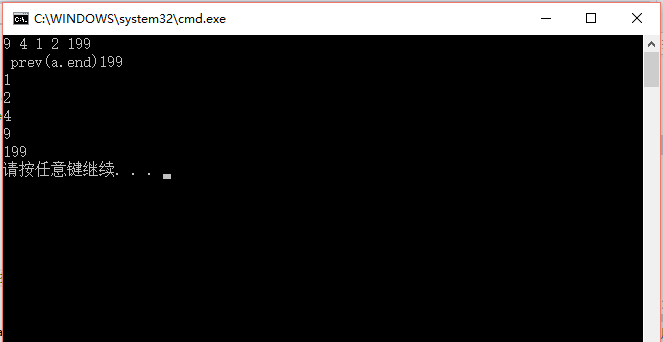

对vector使用sort函数

第一种情形:基本类型,如vector<int>,vector<double>,vector<string>也是可以的1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

using namespace std;

int main(){

vector<int> a;

int n = 5;

while (n--){

int score;

cin >> score;

a.push_back(score);

}

//cout <<" a.end()"<< *a.end() << endl; 执行这句话会报错!

cout << " prev(a.end)" << *prev(a.end()) << endl;

sort(a.begin(), a.end());

for (vector<int>::iterator it = a.begin(); it != a.end(); it++){

cout << *it << endl;

}

return 0;

}

看到了吗,实际上end的前一个指针指向的元素才是插入时的最后一个值!

排序后从小大大。

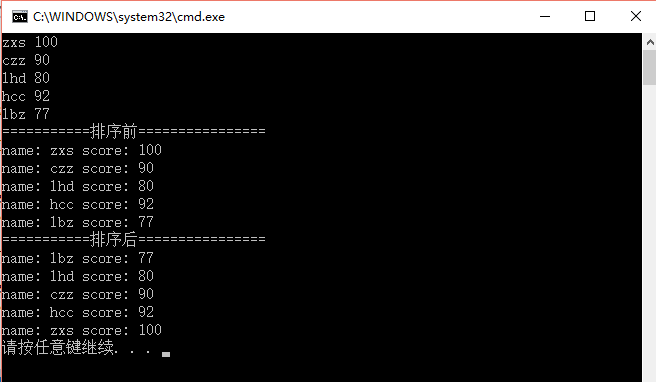

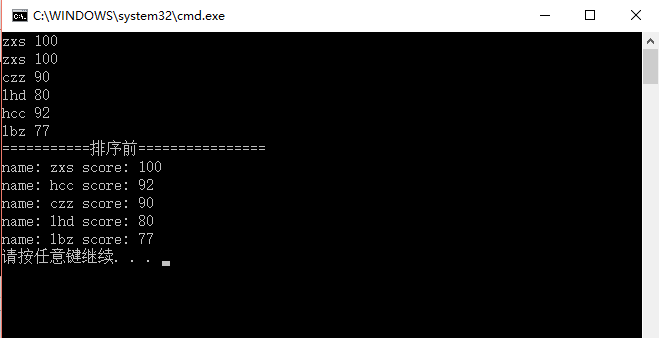

第二种情形:用自定义的结构体进行sort算法,

这时候需要自己定义个比较函数,因为sort算法是基于容器中的元素是可以两两比较的,然后从小到大排序,所以要自定义怎么样才是小于(’<’)

1 |

|

对于set做类似的操作。

set是一个集合,内部的元素不会重复,同时它会自动进行排序,也是从小到大

而且set的insert方法没有insert(a,cmp)这种重载,所以如果要把结构体插入set中,我们就要重载’<’运算符。

set方法在插入的时候也是从小到大的,那么我们重载一下<运算符让它从大到小排序1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

using namespace std;

struct student{

char name[10];

int score;

};

//自定义“小于”

bool comp(const student &a, const student &b){

return a.score < b.score;

}

bool operator < (const student & stu1,const student &stu2){

return stu1.score > stu2.score;

}

int main(){

//vector<student> vectorStudents;

set<student> setStudents;

//int n = 5;

int n = 6;

while (n--){

student oneStudent;

string name;

int score;

cin >> name >> score;

strcpy(oneStudent.name, name.c_str());

oneStudent.score = score;

setStudents.insert(oneStudent);

}

cout << "===========排序前================" << endl;

for (set<student>::iterator it = setStudents.begin(); it != setStudents.end(); it++){

cout << "name: " << it->name << " score: " << it->score << endl;

}

//sort(setStudents.begin(), setStudents.end(), comp);

//cout << "===========排序后================" << endl;

//for (set<student>::iterator it = setStudents.begin(); it != setStudents.end(); it++){

// cout << "name: " << it->name << " score: " << it->score << endl;

//}

return 0;

}

restrict与GCC的编译优化

restrict是C99标准中新添加的关键字,对于从C89标准开始起步学习C语言的同学来说,第一次看到restrict还是相当陌生的。简单说来,restrict关键字是编程者对编译器所做的一个“承诺”:使用restrict修饰过的指针,它所指向的内容只能经由该指针(或从该指针继承而来的指针,如通过该指针赋值或做指针运算而得到的其他指针)修改,而不会被其他不相干的指针所修改。

有了编程者的承诺,编译器便可以对一些通过指针的运算进行大胆的优化了。

观察编译器优化的最好办法当然是查看编译后的汇编代码。Wikipedia上有一个很好的例子,测试环境:Ubuntu 11.04 (x86-64) + Linux 2.6.38 + gcc 4.5.2。测试代码如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

void multi_add(int* restrict p1, int* restrict p2, int* restrict pi)

void multi_add(int* p1, int* p2, int* pi)

{

*p1 += *pi;

*p2 += *pi;

}

int main()

{

int a = 1, b = 2;

int inc = 1;

// increase both a and b by 1

multi_add(&a, &b, &inc);

// print the result

printf("a = %d, b = %d\n", a, b);

}

multi_add函数的功能很简单,将p1和p2指针所指向的内容都加上pi指针的内容。为了测试方便,使用了条件编译指令:如果定义RES宏,则使用带restrict的函数声明。

分别编译出两个版本的程序:1

2gcc restrict.c -o without_restrict

gcc restrict.c -o with_restrict -DRES --std=c99

使用objdump查看目标文件的汇编代码(-d选项表示disassemble):1

objdump -d without_restrict

PS:gcc默认使用的是AT&T汇编,与很多同学在初次学习汇编时接触的Intel x86汇编有些不同

除了表示上的细微符号差别,最大的区别是src/dest的顺序,两者恰好相反:1

2

3Intel : mov eax 2 (先dest后src)

AT&T : mov %2 %eax (先src后dest)

然而这次的结果让人失望:两个版本的程序拥有一模一样的multi_add函数,汇编代码如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21push %rbp

mov %rsp,%rbp

mov %rdi,-0x8(%rbp)

mov %rsi,-0x10(%rbp)

mov %rdx,-0x18(%rbp)

mov -0x8(%rbp),%rax

mov (%rax),%edx

mov -0x18(%rbp),%rax

mov (%rax),%eax

add %eax,%edx

mov -0x8(%rbp),%rax

mov %edx,(%rax)

mov -0x10(%rbp),%rax

mov (%rax),%edx

mov -0x18(%rbp),%rax

mov (%rax),%eax

add %eax,%edx

mov -0x10(%rbp),%rax

mov %edx,(%rax)

leaveq

retq

其中寄存器rdi存放p1的地址,rsi存放p2的地址,rdx存放的是pi的地址。大段的汇编代码,无非是将寄存器中的内容mov到栈上的临时变量上,再把临时变量的值mov进寄存器进行加法运算。

难道restrict关键字没有任何作用?我怀疑很可能是编辑器优化程度不够。这次,使用-O1重新编译源代码并反汇编,终于观察到差别:

未使用restrict的版本:1

2

3

4mov (%rdx), %eax

add %eax, (%rdi)

mov (%rdx), %eax

add %eax, (%rsi)

使用了restrict的版本:1

2

3mov (%rdx), %eax

add %eax, (%rdi)

add %eax, (%rsi)

可以看出,-O1的编译优化还是很给力的,所有运算直接在寄存器中进行,不再蛋疼地先mov进栈变量,再mov进寄存器进行add运算(在这个简单的例子中,确实没有必要)。

最大的区别在于将rdx寄存器间接引用的值mov进eax的语句只在一开始执行了1次。可以理解,当程序员“承诺”这些指针都是相互独立不再干扰时,pi指针的内容在函数范围内可以视之为常量,只需要load进寄存器一次。

而没有restrict关键字时,即使程序中没有对pi的内容进行操作,编译器仍然不能保证pi的内容在函数范围内是常量:因为有pointer aliasing的可能,即p1和p2指向的内容和pi相关(简单情况:p1和pi实际是同一个指针)。

需要注意的是,restrict是程序员给出的“承诺“,编译器没有指针的合法使用进行检查的职责,也没有这样的能力。

事实上,打开restrict关键字,如果这样调用:1

multi_add(&a, &b, &a);

编译器不会报错。(事实上编译期完全有能力检查出简单alias的pointer)

而使用不同的编译优化级别(不优化,-O1, -O2),则产生了相当不同的结果。

- 不优化 :

a = 2, b = 4 - -O1 :

a = 2, b = 3 - -O2以上:

a = 2, b = 4

前面已经提到,没有开启-O选项时,gcc没有对restrict关键字进行优化(至少在这个例子中),所以应当是正确的行为(尽管此行为可能与编写multi_add函数的初衷不符合)

在O1下,restrict被优化,pi的值一开始即被缓存,所以产生了a和b都增加了1的结果

那么为什么O2以上,行为又开始变得正确了呢?

继续反汇编代码,发现-O2以上时,multi_add函数本身代码保持不变(确实在O1已经优化的相当简洁了),但main函数已经面目全非了:调用multi_add的代码已经改变,准确地说:

multi_add函数已经不再被main调用了

这里不再列出相关的汇编代码,因为这里的优化策略是相当复杂的。在这个例子中,由于a和b都是常量,a和b的值直接在编译期被算了出来,并放入寄存器中进行后续printf的调用。

可以看出,restrict确实是优化的利器。但是如果不仔细使用,它还是相当危险的,甚至能够导致在不同的优化级别下,出现完全不同的程序行为。

volatile

why volatile

volatile 关键词,最早出现于20世纪70年代,被用于处理 MMIO(Memory-mapped I/O) 带来的问题。在引入 MMIO 之后,一块内存地址既有可能是真正的内存,也有可能是映射的一个I/O端口。因此,读/写一个内存地址,既有可能是真正地操作内存,也有可能是读/写一个I/O设备。

那么 MMIO 为什么需要引入 volatile 关键词呢?我们结合下面这段示例代码进行解释:1

2

3

4

5

6

7

8

9unsigned int *p = FunB();

unsigned int a;

unsigned int b;

a = *p; // 语句1

b = *p; // 语句2

*p = a; // 语句3

*p = b; // 语句4

在上述代码片段中,指针p既有可能指向一个内存地址,也有可能指向一个I/O设备。如果指针p指向的是I/O设备,那么语句1和语句2中的变量a和变量b,就会接收到I/O设备的连续两个字节。但是,指针p也有可能指向内存地址,这种情况下,编译器就会进行语句优化,编译器的优化策略会判断变量a和变量b同时从同一个内存地址读取数据,因此在执行完语句1之后,直接将变量a赋值给变量b。对于指针p指向I/O设备的这种情况,就需要防止编译器进行此优化,即不能假设指针b指向的内容不变(对应 volatile 的易变性特性)。

同样,语句3和语句4也有类似的问题,编译器发现将变量a和b同时赋值给指针p是无意义的,因此可能会优化语句3中的赋值操作,而仅仅保留语句4。对于指针p指向I/O设备的情况,也需要防止编译器将类似的写操作给优化消失了(对应 volatile 的不可优化特性)。

对于I/O设备,编译器不能随意交互指令的顺序,因为指令顺序一变,写入I/O设备的内容也就发生变化了(对应 volatile 的顺序性)。

为了满足 MMIO 的这三点需求,就有了 volatile 关键字。

IN C/C++

在C/C++语言中,使用 volatile 关键字声明的变量(或对象)通常具有与优化、多线程相关的特殊属性。通常,volatile 关键字用来阻止(伪)编译器对其认为的、无法“被代码本身”改变的代码(变量或对象)进行优化。如在C/C++中,volatile 关键字可以用来提醒编译器使用 volatile 声明的变量随时有可能改变,因此编译器在代码编译时就不会对该变量进行某些激进的优化,故而编译生成的程序在每次存储或读取该变量时,都会直接从内存地址中读取数据。相反,如果该变量没有使用 volatile 关键字进行声明,则编译器可能会优化读取和存储操作,可能暂时使用寄存器中该变量的值,而如果这个变量由别的程序(线程)更新了的话,就会出现(内存中与寄存器中的)变量值不一致的现象。

定义为volatile的变量是说这变量可能会被意想不到地改变,即在你程序运行过程中一直会变,你希望这个值被正确的处理,每次从内存中去读这个值,而不是因编译器优化从缓存的地方读取,比如读取缓存在寄存器中的数值,从而保证volatile变量被正确的读取。

在单任务的环境中,一个函数体内部,如果在两次读取变量的值之间的语句没有对变量的值进行修改,那么编译器就会设法对可执行代码进行优化。由于访问寄存器的速度要快过RAM(从RAM中读取变量的值到寄存器),以后只要变量的值没有改变,就一直从寄存器中读取变量的值,而不对RAM进行访问。

而在多任务环境中,虽然在一个函数体内部,在两次读取变量之间没有对变量的值进行修改,但是该变量仍然有可能被其他的程序(如中断程序、另外的线程等)所修改。如果这时还是从寄存器而不是从RAM中读取,就会出现被修改了的变量值不能得到及时反应的问题。

因为访问寄存器要比访问内存单元快的多,所以编译器一般都会作减少存取内存的优化,但有可能会读脏数据。当要求使用volatile声明变量值的时候,系统总是重新从它所在的内存读取数据,即使它前面的指令刚刚从该处读取过数据。精确地说就是,遇到这个关键字声明的变量,编译器对访问该变量的代码就不再进行优化,从而可以提供对特殊地址的稳定访问;如果不使用valatile,则编译器将对所声明的语句进行优化。(简洁的说就是:volatile关键词影响编译器编译的结果,用volatile声明的变量表示该变量随时可能发生变化,与该变量有关的运算,不要进行编译优化,以免出错。加了volatile修饰的变量,编译器将不对其相关代码执行优化,而是生成对应代码直接存取原始内存地址)。

一个定义为volatile的变量是说这变量可能会被意想不到地改变,这样,编译器就不会去假设这个变量的值了。精确地说就是,优化器在用到这个变量时必须每次都小心地重新读取这个变量的值,而不是使用保存在寄存器里的备份。一般说来,volatile用在如下的几个地方:

- 并行设备的硬件寄存器(如:状态寄存器)

- 中断服务程序中修改的供其它程序检测的变量需要加volatile;

- 多任务环境下各任务间共享的标志应该加volatile;

- 存储器映射的硬件寄存器通常也要加volatile说明,因为每次对它的读写都可能有不同意义;

在C/C++语言中,使用 volatile 关键字声明的变量具有三种特性:易变的、不可优化的、顺序执行的。下面分别对这三种特性进行介绍。

易变的

volatile 在词典中的主要释义就是“易变的”。

在 C/C++ 语言中,volatile 的易变性体现在:假设有读、写两条语句,依次对同一个 volatile 变量进行操作,那么后一条的读操作不会直接使用前一条的写操作对应的 volatile 变量的寄存器内容,而是重新从内存中读取该 volatile 变量的值。

上述描述的(部分)示例代码如下:1

2

3

4volatile int nNum = 0; // 将nNum声明为volatile

int nSum = 0;

nNum = FunA(); // nNum被写入的新内容,其值会缓存在寄存器中

nSum = nNum + 1; // 此处会从内存(而非寄存器)中读取nNum的值

不可优化的

在 C/C++ 语言中,volatile 的第二个特性是“不可优化性”。volatile 会告诉编译器,不要对 volatile 声明的变量进行各种激进的优化(甚至将变量直接消除),从而保证程序员写在代码中的指令一定会被执行。

上述描述的(部分)示例代码如下:1

2

3volatile int nNum; // 将nNum声明为volatile

nNum = 1;

printf("nNum is: %d", nNum);

在上述代码中,如果变量 nNum 没有声明为 volatile 类型,则编译器在编译过程中就会对其进行优化,直接使用常量“1”进行替换(这样优化之后,生成的汇编代码很简介,执行时效率很高)。而当我们使用 volatile 进行声明后,编译器则不会对其进行优化,nNum 变量仍旧存在,编译器会将该变量从内存中取出,放入寄存器之中,然后再调用 printf() 函数进行打印。

顺序执行的

在 C/C++ 语言中,volatile 的第三个特性是“顺序执行特性”,即能够保证 volatile 变量间的顺序性,不会被编译器进行乱序优化。

说明:C/C++ 编译器最基本优化原理:保证一段程序的输出,在优化前后无变化。

为了对本特性进行深入了解,下面以两个变量(nNum1 和 nNum2)为例(既然存在“顺序执行”,那描述对象必然大于一个),结合如下示例代码,介绍 volatile 的顺序执行特性。1

2

3

4int nNum1;

int nNum2;

nNum2 = nNum1 + 1; // 语句1

nNum1 = 10; // 语句2

在上述代码中:

- 当 nNum1 和 nNum2 都没有使用 volatile 关键字进行修饰时,编译器会对“语句1”和“语句2”的执行顺序进行优化:即先执行“语句2”、再执行“语句1”;

- 当 nNum2 使用 volatile 关键字进行修饰时,编译器也可能会对“语句1”和“语句2”的执行顺序进行优化:即先执行“语句2”、再执行“语句1”;

- 当 nNum1 和 nNum2 都使用 volatile 关键字进行修饰时,编译器不会对“语句1”和“语句2”的执行顺序进行优化:即先执行“语句1”、再执行“语句2”;

说明:上述论述可通过观察代码的生成的汇编代码进行验证。

volatile与多线程语义

对于多线程编程而言,在临界区内部,可以通过互斥锁(mutex)保证只有一个线程可以访问该临界区的内容,因此临界区内的变量不需要是 volatile 的;而在临界区外部,被多个线程访问的变量应声明为 volatile 的,这也符合了 volatile 的原意:防止编译器缓存(cache)了被多个线程并发用到的变量。

不过,需要注意的是,由于 volatile 关键字的“顺序执行特性”并非会完全保证语句的顺序执行(如 volatile 变量与非volatile 变量之间的操作;又如一些 CPU 也会对语句的执行顺序进行优化),因此导致了对 volatile 变量的操作并不是原子的,也不能用来为线程建立严格的 happens-before 关系。

对于上述描述,示例代码如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20int nNum1 = 0;

volatile bool flag = false;

thread1()

{

// some code

nNum1 = 666; // 语句1

flag = true; // 语句2

}

thread2()

{

// some code

if (true == flag)

{

// 语句3:按照程序设计的预想,此处的nNum1的值应为666,并据此进行逻辑设计

}

}

在上述代码中,我们的设计思路是先执行 thread1() 中的“语句1”、“语句2”、再执行 thread2() 中的“语句3”,不过实际上程序的执行结果未必如此。根据 volatile 的“顺序性”,非 volatile 变量 nNum1 和 volatile 变量 flag 的执行顺序,可能会被编译器(或 CPU)进行乱序优化,最终导致thread1中的“语句2”先于“语句1”执行,当“语句2”执行完成但“语句1”尚未执行时,此时 thread2 中的判断语句“if (true == flag)”是成立的,但实际上 nNum1 尚未进行赋值为666(语句1尚未执行),所以在判断语句中针对 nNum1 为666的前提下进行的相关操作,就会有问题了。

这是一个在多线程编程中,使用 volatile 不容易发现的问题。

实际上,上述多线程代码想实现的就是一个 happens-before 语义,即保证 thread1 代码块中的所有代码,一定要在 thread2 代码块的第一条代码之前完成。使用互斥锁(mutex)可以保证 happens-before 语义。但是,在 C/C++ 中的 volatile 关键词不能保证这个语义,也就意味着在多线程环境下使用 C/C++ 的 volatile 关键词,如果不够细心,就可能会出现上述问题。

说明:由于 Java 语言的 volatile 关键字支持 Acquire、Release 语义,因此 Java 语言的 volatile 能够用来构建 happens-before 语义。也就是说,前面提到的 C/C++ 中 volatile 在多线程下使用出现的问题,在 Java 语言中是不存在的。

不保证原子性

volatile只保证其“可见性”,不保证其“原子性”。

执行count++;这条语句由3条指令组成:

- 将 count 的值从内存加载到 cpu 的某个 寄存器r;

- 将 寄存器r 的值 +1,结果存放在 寄存器s;

- 将 寄存器s 中的值写回内存。

所以,如果有多个线程同时在执行 count++,在某个线程执行完第(3)步之前,其它线程是看不到它的执行结果的。(这里有疑惑:线程同时执行count++,为了保证其原子性,为何不加mutex lock?而是寻求volatile?)

在没有volatile的时候,执行完count++,执行结果其实是写到CPU缓存中,没有马上写回到内存中,后续在某些情况下(比如CPU缓存不够用)再将CPU缓存中的值flush到内存。因为没有存到内存里,其他线程是不能及时看到执行结果的。

在有volatile的时候,执行完count++,执行结果写入缓存中,并同时写入内存中,所以可以保证其它线程马上看到执行的结果。

但是,volatile 并没有保证原子性,在某个线程执行(1)(2)(3)的时候,volatile 并没有锁定 count 的值,也就是并不能阻塞其他线程也执行(1)(2)(3)。可能有两个线程同时执行(1),所以(2)计算出来一样的结果,然后(3)存回的也是同一个值。

考虑下面一段代码:1

2

3

4

5int some_int = 100;

while(some_int == 100)

{

//your code

}

因为编译器认为some_int没被改变过,一直是100。但是在多线程时,如果执行完第一行,但是还没执行到第三行时,另一个线程修改了some_int,while就不能进入循环了。加了volatile后,阻止了编译器优化,每次读到some_int会从内存中读取,而不是本线程的寄存去(当然这会损失效率)。这就是volatile的作用。

一句话总结:volatile保证线程能读到最新的数据,因为是从内存中读取,且存入内存中。而不是线程各自的寄存器中读写。

inline 内联函数

内联函数和普通函数相比可以加快程序运行的速度,因为不需要中断调用,在编译的时候内联函数可以直接嵌入到目标代码中。

- 相当于把内联函数里面的内容写在调用内联函数处;

- 相当于不用执行进入函数的步骤,直接执行函数体;

- 相当于宏,却比宏多了类型检查,真正具有函数特性;

- 编译器一般不内联包含循环、递归、switch 等复杂操作的内联函数;

- 在类声明中定义的函数,除了虚函数的其他函数都会自动隐式地当成内联函数。

- 作为类成员接口函数来读写类的私有成员或者保护成员,会提高效率

1 | // 声明1(加 inline,建议使用) |

编译器对 inline 函数的处理步骤

- 将 inline 函数体复制到 inline 函数调用点处;

- 为所用 inline 函数中的局部变量分配内存空间;

- 将 inline 函数的的输入参数和返回值映射到调用方法的局部变量空间中;

- 如果 inline 函数有多个返回点,将其转变为 inline 函数代码块末尾的分支(使用 GOTO)。

优点

- 内联函数同宏函数一样将在被调用处进行代码展开,省去了参数压栈、栈帧开辟与回收,结果返回等,从而提高程序运行速度。

- 内联函数相比宏函数来说,在代码展开时,会做安全检查或自动类型转换(同普通函数),而宏定义则不会。

- 在类中声明同时定义的成员函数,自动转化为内联函数,因此内联函数可以访问类的成员变量,宏定义则不能。

- 内联函数在运行时可调试,而宏定义不可以。

缺点

- 代码膨胀。内联是以代码膨胀(复制)为代价,消除函数调用带来的开销。如果执行函数体内代码的时间,相比于函数调用的开销较大,那么效率的收获会很少。另一方面,每一处内联函数的调用都要复制代码,将使程序的总代码量增大,消耗更多的内存空间。

- inline 函数无法随着函数库升级而升级。inline函数的改变需要重新编译,不像 non-inline 可以直接链接。

- 是否内联,程序员不可控。内联函数只是对编译器的建议,是否对函数内联,决定权在于编译器。

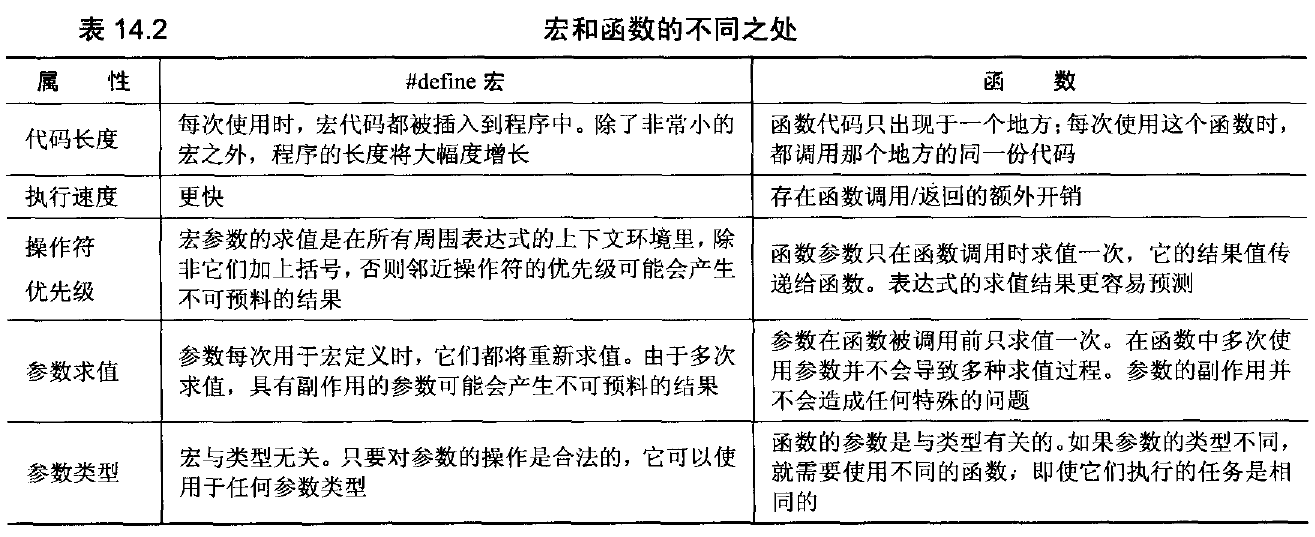

内联函数和宏定义的区别

内联函数以代码复杂为代价,它以省去函数调用的开销来提高执行效率。所以一方面如果内联函数体内代码执行时间相比函数调用开销较大,则没有太大的意义;另一方面每一处内联函数的调用都要复制代码,消耗更多的内存空间,因此以下情况不宜使用内联函数:

- 函数体内的代码比较长,将导致内存消耗代价

- 函数体内有循环,函数执行时间要比函数调用开销大

主要区别

- 内联函数在编译时展开,宏在预编译时展开

- 内联函数直接嵌入到目标代码中,宏是简单的做文本替换

- 内联函数有类型、语法判断等功能,而宏没有

- 内联函数是函数,宏不是

- 宏定义时要注意书写(参数要括起来)否则容易出现歧义,内联函数不会产生歧义

- 内联函数代码是被放到符号表中,使用时像宏一样展开,没有调用的开销,效率很高;

- 在使用时,宏只做简单字符串替换(编译前)。而内联函数可以进行参数类型检查(编译时),且具有返回值。

- 内联函数可以作为某个类的成员函数,这样可以使用类的保护成员和私有成员,进而提升效率。而当一个表达式涉及到类保护成员或私有成员时,宏就不能实现了。

union

联合(union)是一种节省空间的特殊的类,一个 union 可以有多个数据成员,但是在任意时刻只有一个数据成员可以有值。当某个成员被赋值后其他成员变为未定义状态。联合有如下特点:

- 默认访问控制符为 public

- 可以含有构造函数、析构函数

- 不能含有引用类型的成员

- 不能继承自其他类,不能作为基类

- 不能含有虚函数

- 匿名 union 在定义所在作用域可直接访问 union 成员

- 匿名 union 不能包含 protected 成员或 private 成员

- 全局匿名联合必须是静态(static)的

C++11 标准规定,任何非引用类型都可以成为联合体的数据成员,这种联合体也被称为非受限联合体。例如:1

2

3

4

5

6

7

8

9

10

11

12

13

14class Student{

public:

Student(bool g, int a): gender(g), age(a) {}

private:

bool gender;

int age;

};

union T{

Student s; // 含有非POD类型的成员,gcc-5.1.0 版本报错

char name[10];

};

int main(){

return 0;

}

上面的代码中,因为 Student 类带有自定义的构造函数,所以是一个非 POD 类型的,这导致编译器报错。这种规定只是 C++ 为了兼容C语言而制定,然而在长期的编程实践中发现,这种规定是没有必要的。

C++11 允许非 POD 类型

C++98 不允许联合体的成员是非 POD 类型,但是 C++11 取消了这种限制。POD 是英文 Plain Old Data 的缩写,用来描述一个类型的属性。POD 类型一般具有以下几种特征(包括 class、union 和 struct等):

- 没有用户自定义的构造函数、析构函数、拷贝构造函数和移动构造函数。

- 不能包含虚函数和虚基类。

- 非静态成员必须声明为 public。

- 类中的第一个非静态成员的类型与其基类不同

- 在类或者结构体继承时,满足以下两种情况之一:

- 派生类中有非静态成员,且只有一个仅包含静态成员的基类;

- 基类有非静态成员,而派生类没有非静态成员。

- 所有非静态数据成员均和其基类也符合上述规则(递归定义),也就是说 POD 类型不能包含非 POD 类型的数据。

- 此外,所有兼容C语言的数据类型都是 POD 类型(struct、union 等不能违背上述规则)。

1 | class B1{}; |

class B2 的第一个非静态成员 b 是基类类型,所以它不是 POD 类型。

1 | class B1 { static int n; }; |

对于 B2,派生类 B2 中有非静态成员,且只有一个仅包含静态成员的基类 B1,所以它是 POD 类型。对于 B3,基类 B2 有非静态成员,而派生类 B3 没有非静态成员,所以它也是 POD 类型。

C++11 允许联合体有静态成员

C++11 删除了联合体不允许拥有静态成员的限制。例如:1

2

3

4

5

6union U {

static int func() {

int n = 3;

return n;

}

};

需要注意的是,静态成员变量只能在联合体内定义,却不能在联合体外使用,这使得该规则很没用。

非受限联合体的赋值注意事项

C++11 规定,如果非受限联合体内有一个非 POD 的成员,而该成员拥有自定义的构造函数,那么这个非受限联合体的默认构造函数将被编译器删除;其他的特殊成员函数,例如默认拷贝构造函数、拷贝赋值操作符以及析构函数等,也将被删除。

这条规则可能导致对象构造失败,请看下面的例子:1

2

3

4

5

6

7

8

9

10

using namespace std;

union U {

string s;

int n;

};

int main() {

U u; // 构造失败,因为 U 的构造函数被删除

return 0;

}

在上面的例子中,因为 string 类拥有自定义的构造函数,所以 U 的构造函数被删除;定义 U 的类型变量 u 需要调用默认构造函数,所以 u 也就无法定义成功。

解决上面问题的一般需要用到 placement new,代码如下:1

2

3

4

5

6

7

8

9

10

11

12

13

using namespace std;

union U {

string s;

int n;

public:

U() { new(&s) string; }

~U() { s.~string(); }

};

int main() {

U u;

return 0;

}

构造时,采用placement new将 s 构造在其地址 &s 上,这里placement new的唯一作用只是调用了一下 string 类的构造函数。注意,在析构时还需要调用 string 类的析构函数。

非受限联合体的匿名声明和“枚举式类”

匿名联合体是指不具名的联合体(也即没有名字的联合体),一般定义如下:1

2

3union U{

union { int x; }; //此联合体为匿名联合体

};

可以看到,联合体 U 内定义了一个不具名的联合体,该联合体包含一个 int 类型的成员变量,我们称这个联合体为匿名联合体。

同样的,非受限联合体也可以匿名,而当非受限的匿名联合体运用于类的声明时,这样的类被称为“枚举式类”。示例如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

using namespace std;

class Student{

public:

Student(bool g, int a): gender(g), age(a){}

bool gender;

int age;

};

class Singer {

public:

enum Type { STUDENT, NATIVE, FOREIGENR };

Singer(bool g, int a) : s(g, a) { t = STUDENT; }

Singer(int i) : id(i) { t = NATIVE; }

Singer(const char* n, int s) {

int size = (s > 9) ? 9 : s;

memcpy(name , n, size);

name[s] = '\0';

t = FOREIGENR;

}

~Singer(){}

private:

Type t;

union {

Student s;

int id;

char name[10];

};

};

int main() {

Singer(true, 13);

Singer(310217);

Singer("J Michael", 9);

return 0;

}

上面的代码中使用了一个匿名非受限联合体,它作为类 Singer 的“变长成员”来使用,这样的变长成员给类的编写带来了更大的灵活性,这是 C++98 标准中无法达到的。

assert()

断言,是宏,而非函数。assert宏的原型定义在 <assert.h>(C)、<cassert>(C++)中,其作用是如果它的条件返回错误,则终止程序执行。可以通过定义 NDEBUG 来关闭 assert,但是需要在源代码的开头,include <assert.h> 之前。

assert()会对表达式expression进行检测:

- 如果expression的结果为 0(条件不成立),那么断言失败,表明程序出错,

assert()会向标准输出设备(一般是显示器)打印一条错误信息,并调用 abort() 函数终止程序的执行。 - 如果expression的结果为非 0(条件成立),那么断言成功,表明程序正确,

assert()不进行任何操作。

参数:

- expression:要检测的表达式。如果表达式的值为 0,那么断言失败,程序终止执行;如果表达式的值为非 0,那么断言成功,assert() 不进行任何操作。

assert() 的用法和机制

assert()的用法很简单,我们只要传入一个表达式,它会计算这个表达式的结果:如果表达式的结果为“假”,assert()会打印出断言失败的信息,并调用abort()函数终止程序的执行;如果表达式的结果为“真”,assert()就什么也不做,程序继续往后执行。

下面是一个具体的例子:1

2

3

4

5

6

7

8

9

10

int main(){

int m, n, result;

scanf("%d %d", &m, &n);

assert(n != 0); //写作 assert(n) 更加简洁

result = m / n;

printf("result = %d\n", result);

return 0;

}

NDEBUG 宏

如果查看<assert.h>头文件的源码,会发现assert()被定义为下面的样子:1

2

3

4

5

6

这意味着,一旦定义了NDEBUG宏,assert()就无效了。

NDEBUG是”No Debug“的意思,也即“非调试”。有的编译器(例如 Visual Studio)在发布(Release)模式下会定义 NDEBUG 宏,在调试(Debug)模式下不会定义定义这个宏;有的编译器(例如 Xcode)在发布模式和调试模式下都不会定义 NDEBUG 宏,这样当我们以发布模式编译程序时,就必须自己在编译参数中增加NDEBUG宏,或者在包含<assert.h>头文件之前定义NDEBUG宏。

调试模式是程序员在测试代码期间使用的编译模式,发布模式是将程序提供给用户时使用的编译模式。在发布模式下,我们不应该再依赖assert()宏,因为程序一旦出错,assert()会抛出一段用户看不懂的提示信息,并毫无预警地终止程序执行,这样会严重影响软件的用户体验,所以在发布模式下应该让assert()失效。

修改上面的代码,在包含<assert.h>之前定义NDEBUG宏:1

2

3

4

5

6

7

8

9

10

11

int main(){

int m, n, result;

scanf("%d %d", &m, &n);

assert(n);

result = m / n;

printf("result = %d\n", result);

return 0;

}

当以发布模式编译这段代码时,assert()就会失效。如果希望继续以调试模式编译这段代码,去掉NDEBUG宏即可。

注意事项

使用assert()时,被检测的表达式最好不要太复杂,以下面的代码为例:assert( expression1 && expression2 && expression3);

当发生错误时,assert()只会告诉我们expression1 && expression2 && expression3整个表达式为不成立,但是这个大的表达式还包含了三个小的表达式,并且它们之间是&&运算,任何一个小表达式为不成立都会导致整个表达式为不成立,这样我们就无法推断到底是expression1有问题,还是expression2或者expression3有问题,从而给排错带来麻烦。

这里我们应该遵循使用assert()的一个原则:每次断言只能检验一个表达式。根据这个原则,上面的代码应改为:1

2

3assert(expression1);

assert(expression2);

assert(expression3);

如此,一旦程序出错,我们就知道是哪个小的表达式断言失败了,从而快速定位到有问题的代码。

使用assert()的另外一个注意事项是:不要用会改变环境的语句作为断言的表达式。请看下面的代码:1

2

3

4

5

6

7

8

9

10

int main(){

int i = 0;

while(i <= 110){

assert(++i <= 100);

printf("我是第%d行\n",i);

}

return 0;

}

在 Debug 模式下运行,程序循环到第 101 次时,i 的值为 100,++i <= 100不再成立,断言失败,程序终止运行。

在 Release 模式下运行,编译参数中设置了NDEBUG宏(如果编译器没有默认设置,那么需要你自己来设置),assert()会失效,++i <= 100这个表达式也不起作用了,while()无法终止,成为一个死循环。

定义了NDEBUG宏后,assert(++i <= 100)会被替换为((void)0)。

pair类型

pair类型的定义和初始化

pair类型是在有文件utility中定义的,pair类型包含了两个数据值,通常有以下的一些定义和初始化的一些方法:1

2

3pair<T1, T2> p;

pair<T1, T2> p(v1, v2);

make_pair(v1, v2)

上述第一种方法是定义了一个空的pair对象p,第二种方法是定义了包含初始值为v1和v2的pair对象p。第三种方法是以v1和v2值创建的一个新的pair对象。

pair对象的一些操作

除此之外,pair对象还有一些方法,如取出pair对象中的每一个成员的值:1

2p.first

p.second

一个例子:1

2

3

4

5

6

7

8

9

10

11

12

13

using namespace std;

int main(){

pair<int, string> p1(0, "Hello");

printf("%d, %s\n", p1.first, p1.second.c_str());

pair<int, string> p2 = make_pair(1, "World");

printf("%d, %s\n", p2.first, p2.second.c_str());

return 0;

}

map

标准库map类型是一种以键-值(key-value)存储的数据类型。

- 第一个可以称为关键字(key),每个关键字只能在map中出现一次;

- 第二个可能称为该关键字的值(value);

map以模板(泛型)方式实现,可以存储任意类型的数据,包括使用者自定义的数据类型。Map主要用于资料一对一映射(one-to-one)的情況,map內部的实现自建一颗红黑树,这颗树具有对数据自动排序的功能。在map内部所有的数据都是有序的。

以下分别从以下的几个方面总结:

- map对象的定义和初始化

- map对象的基本操作,主要包括添加元素,遍历等

map对象的定义和初始化

map是键-值对的组合,有以下的一些定义的方法:1

2

3map<k, v> m;

map<k, v> m(m2);

map<k, v> m(b, e);

上述第一种方法定义了一个名为m的空的map对象;第二种方法创建了m2的副本m;第三种方法创建了map对象m,并且存储迭代器b和e范围内的所有元素的副本。

map的value_type是存储元素的键以及值的pair类型,键为const。

使用map得包含map类所在的头文件1

map对象是模板类,需要关键字和存储对象两个模板参数:1

std:map<int, string> personnel;

这样就定义了一个用int作为索引,并拥有相关联的指向string的指针.

为了使用方便,可以对模板类进行一下类型定义,1

typedef aap<int,CString> UDT_MAP_INT_CSTRING;

map共提供了6个构造函数,这块涉及到内存分配器这些东西,略过不表,在下面我们将接触到一些map的构造方法,这里要说下的就是,我们通常用如下方法构造一个map:1

map<int, string> mapStudent;

map中元素的插入

在map中元素有两种插入方法:

- 使用下标

- 使用insert函数

在map中使用下标访问不存在的元素将导致在map容器中添加一个新的元素。

insert函数的插入方法主要有如下:

m.insert(e)m.insert(beg, end)m.insert(iter, e)

上述的e一个value_type类型的值。beg和end标记的是迭代器的开始和结束。

两种插入方法如下面的例子所示:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

using namespace std;

int main(){

map<int, int> mp;

for (int i = 0; i < 10; i ++){

mp[i] = i;

}

for (int i = 10; i < 20; i++){

mp.insert(make_pair(i, i));

}

map<int, int>::iterator it;

for (it = mp.begin(); it != mp.end(); it++){

printf("%d-->%d\n", it->first, it->second);

}

return 0;

}

另外的方法:

1 | // 定义一个map对象 |

以上三种用法,虽然都可以实现数据的插入,但是它们是有区别的,当然了第一种和第二种在效果上是完成一样的,用insert函数插入数据,在数据的 插入上涉及到集合的唯一性这个概念,即当map中有这个关键字时,insert操作是不能在插入数据的,但是用数组方式就不同了,它可以覆盖以前该关键字对 应的值,用程序说明如下:1

2mapStudent.insert(map<int, string>::value_type (001, "student_one"));

mapStudent.insert(map<int, string>::value_type (001, "student_two"));

map中元素的查找和读取

注意:上述采用下标的方法读取map中元素时,若map中不存在该元素,则会在map中插入。

因此,若只是查找该元素是否存在,可以使用函数count(k),该函数返回的是k出现的次数;若是想取得key对应的值,可以使用函数find(k),该函数返回的是指向该元素的迭代器。

上述的两个函数的使用如下所示:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

using namespace std;

int main(){

map<int, int> mp;

for (int i = 0; i < 20; i++){

mp.insert(make_pair(i, i));

}

if (mp.count(0)){

printf("yes!\n");

}else{

printf("no!\n");

}

map<int, int>::iterator it_find;

it_find = mp.find(0);

if (it_find != mp.end()){

it_find->second = 20;

}else{

printf("no!\n");

}

map<int, int>::iterator it;

for (it = mp.begin(); it != mp.end(); it++){

printf("%d->%d\n", it->first, it->second);

}

return 0;

}

从map中删除元素

从map中删除元素的函数是erase(),该函数有如下的三种形式:1

2

3m.erase(k)

m.erase(p)

m.erase(b, e)

第一种方法删除的是m中键为k的元素,返回的是删除的元素的个数;第二种方法删除的是迭代器p指向的元素,返回的是void;第三种方法删除的是迭代器b和迭代器e范围内的元素,返回void。

如下所示:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

using namespace std;

int main(){

map<int, int> mp;

for (int i = 0; i < 20; i++){

mp.insert(make_pair(i, i));

}

mp.erase(0);

mp.erase(mp.begin());

map<int, int>::iterator it;

for (it = mp.begin(); it != mp.end(); it++){

printf("%d->%d\n", it->first, it->second);

}

return 0;

}

map的基本操作函数:

C++ maps是一种关联式容器,包含“关键字/值”对

begin()返回指向map头部的迭代器clear()删除所有元素count()返回指定元素出现的次数empty()如果map为空则返回trueend()返回指向map末尾的迭代器equal_range()返回特殊条目的迭代器对erase()删除一个元素find()查找一个元素get_allocator()返回map的配置器insert()插入元素key_comp()返回比较元素key的函数lower_bound()返回键值>=给定元素的第一个位置max_size()返回可以容纳的最大元素个数rbegin()返回一个指向map尾部的逆向迭代器rend()返回一个指向map头部的逆向迭代器size()返回map中元素的个数swap()交换两个mapupper_bound()返回键值>给定元素的第一个位置value_comp()返回比较元素value的函数

stack

| 函数名 | 功能 | 复杂度 |

|---|---|---|

| size() | 返回栈的元素数 | O(1) |

| top() | 返回栈顶的元素 | O(1) |

| pop() | 从栈中取出并删除元素 | O(1) |

| push(x) | 向栈中添加元素x | O(1) |

| empty() | 在栈为空时返回true | O(1) |

贴一些代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

using namespace std;

int main()

{

stack<int> S;

S.push(3);

S.push(7);

S.push(1);

cout << S.size() << " ";

cout << S.top() << " ";

S.pop();

cout << S.top() << " ";

S.pop();

cout << S.top() << " ";

S.push(5);

cout << S.top() << " ";

S.pop();

cout << S.top() << endl;

return 0;

}

queues

C++队列是一种容器适配器,它给予程序员一种先进先出(FIFO)的数据结构。

- back() 返回一个引用,指向最后一个元素

- empty() 如果队列空则返回真

- front() 返回第一个元素

- pop() 删除第一个元素

- push() 在末尾加入一个元素

- size() 返回队列中元素的个数

队列可以用线性表(list)或双向队列(deque)来实现(注意vector container 不能用来实现queue,因为vector 没有成员函数pop_front!):1

2queue<list<int>> q1

queue<deque<int>> q2

其成员函数有“判空(empty)” 、“尺寸(Size)” 、“首元(front)” 、“尾元(backt)” 、“加入队列(push)” 、“弹出队列(pop)”等操作。

例:1

2

3

4

5

6

7

8int main()

{

queue<int> q;

q.push(4);

q.push(5);

printf("%d\n",q.front());

q.pop();

}

Priority Queues

C++优先队列类似队列,但是在这个数据结构中的元素按照一定的断言排列有序。

empty()如果优先队列为空,则返回真pop()删除第一个元素push()加入一个元素size()返回优先队列中拥有的元素的个数top()返回优先队列中有最高优先级的元素

优先级队列可以用向量(vector)或双向队列(deque)来实现(注意list container 不能用来实现queue,因为list 的迭代器不是任意存取iterator,而pop 中用到堆排序时是要求randomaccess iterator 的!):

priority_queue<vector<int>, less<int>> pq1; 使用递增less函数对象排序 priority_queue<deque<int>, greater<int>> pq2; 使用递减greater函数对象排序 - 其成员函数有“判空(empty)” 、“尺寸(Size)” 、“栈顶元素(top)” 、“压栈(push)” 、“弹栈(pop)”等。

priority_queue模版类有三个模版参数,元素类型,容器类型,比较算子。其中后两个都可以省略,默认容器为vector,默认算子为less,即小的往前排,大的往后排(出队时序列尾的元素出队)。

初学者在使用priority_queue时,最困难的可能就是如何定义比较算子了。如果是基本数据类型,或已定义了比较运算符的类,可以直接用STL的less算子和greater算子——默认为使用less算子,即小的往前排,大的先出队。如果要定义自己的比较算子,方法有多种,这里介绍其中的一种:重载比较运算符。优先队列试图将两个元素x和y代入比较运算符(对less算子,调用x

例:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

using namespace std;

class T {

public:

int x, y, z;

T(int a, int b, int c):x(a), y(b), z(c)

{

}

};

bool operator < (const T &t1, const T &t2)

{

return t1.z < t2.z; // 按照z的顺序来决定t1和t2的顺序

}

int main()

{

priority_queue<T> q;

q.push(T(4,4,3));

q.push(T(2,2,5));

q.push(T(1,5,4));

q.push(T(3,3,6));

while (!q.empty())

{

T t = q.top();

q.pop();

cout << t.x << " " << t.y << " " << t.z << endl;

}

return 1;

}

输出结果为(注意是按照z的顺序从大到小出队的):1

2

3

43 3 6

2 2 5

1 5 4

4 4 3

再看一个按照z的顺序从小到大出队的例子:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

using namespace std;

class T

{

public:

int x, y, z;

T(int a, int b, int c):x(a), y(b), z(c)

{

}

};

bool operator > (const T &t1, const T &t2)

{

return t1.z > t2.z;

}

main()

{

priority_queue<T, vector<T>, greater<T> > q;

q.push(T(4,4,3));

q.push(T(2,2,5));

q.push(T(1,5,4));

q.push(T(3,3,6));

while (!q.empty())

{

T t = q.top();

q.pop();

cout << t.x << " " << t.y << " " << t.z << endl;

}

return 1;

}

输出结果为:1

2

3

44 4 3

1 5 4

2 2 5

3 3 6

vector的内部实现原理及基本用法

本文基于STL vector源代码,但是不考虑分配器allocator,迭代器iterator,异常处理try/catch等内容,同时对_Ucopy()、 _Umove()、 _Ufill()函数也不会过度分析。

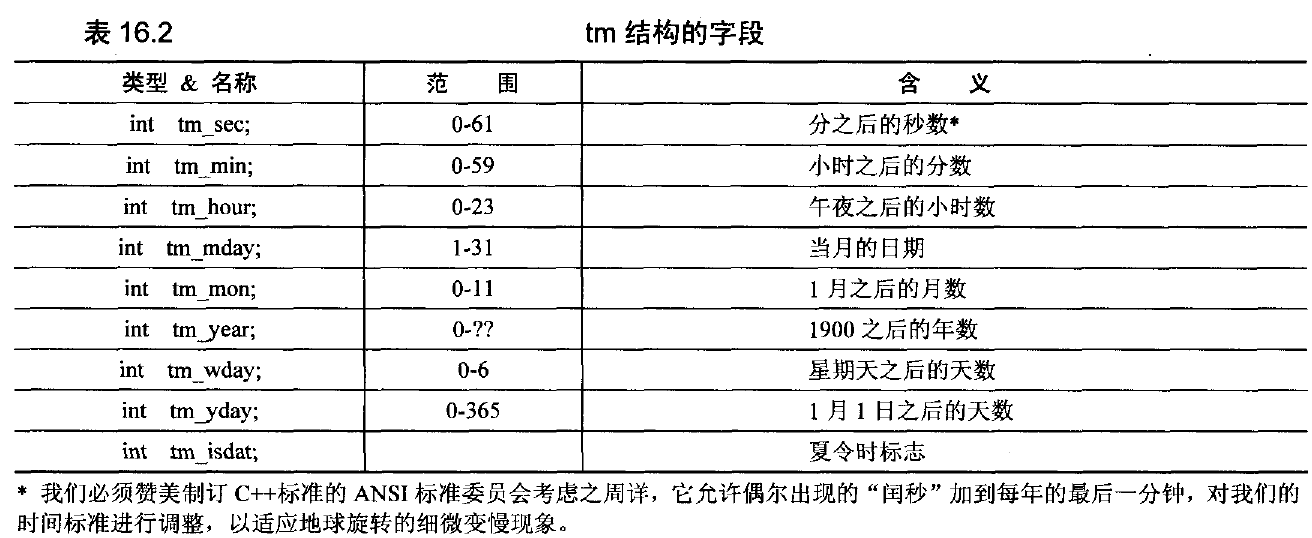

vector的定义

1 | template<class _Ty, |

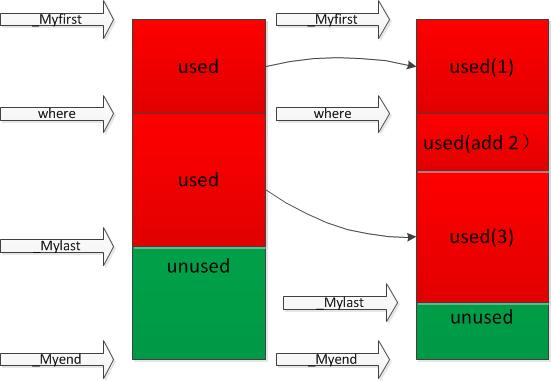

简单理解,就是vector是利用上述三个指针来表示的,基本示意图如下:

两个关键大小:

- 大小:

size=_Mylast - _Myfirst; - 容量:

capacity=_Myend - _Myfirst;

分别对应于resize()、reserve()两个函数。size表示vector中已有元素的个数,容量表示vector最多可存储的元素的个数;为了降低二次分配时的成本,vector实际配置的大小可能比客户需求的更大一些,以备将来扩充,这就是容量的概念。即capacity>=size,当等于时,容器此时已满,若再要加入新的元素时,就要重新进行内存分配,整个vector的数据都要移动到新内存。二次分配成本较高,在实际操作时,应尽量预留一定空间,避免二次分配。

构造与析构

构造

vector的构造函数主要有以下几种:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17vector() : _Mybase()

{ // construct empty vector

_Buy(0);

}

explicit vector(size_type _Count) : _Mybase()

{ // construct from _Count * _Ty()

_Construct_n(_Count, _Ty());

}

vector(size_type _Count, const _Ty& _Val) : _Mybase()

{ // construct from _Count * _Val

_Construct_n(_Count, _Val);

}