单处理器计算(一)

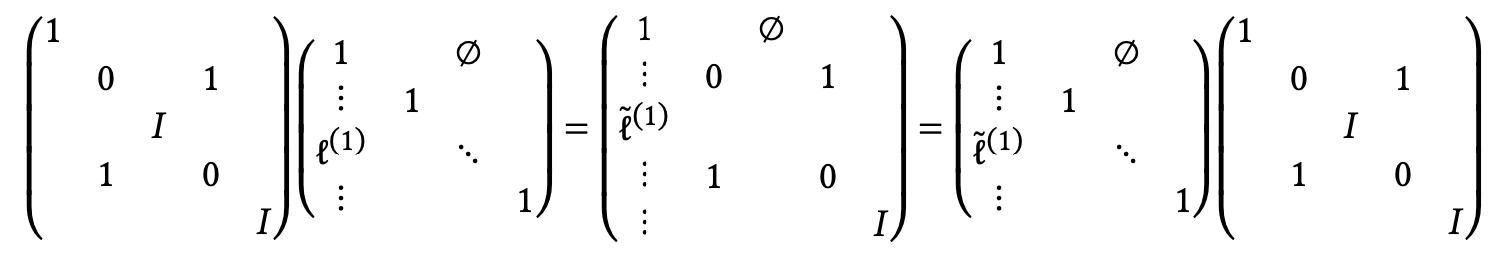

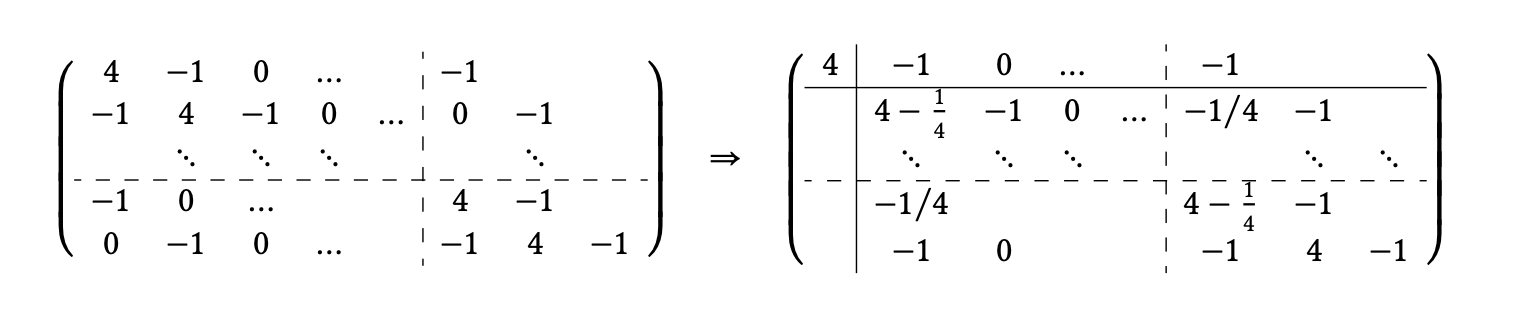

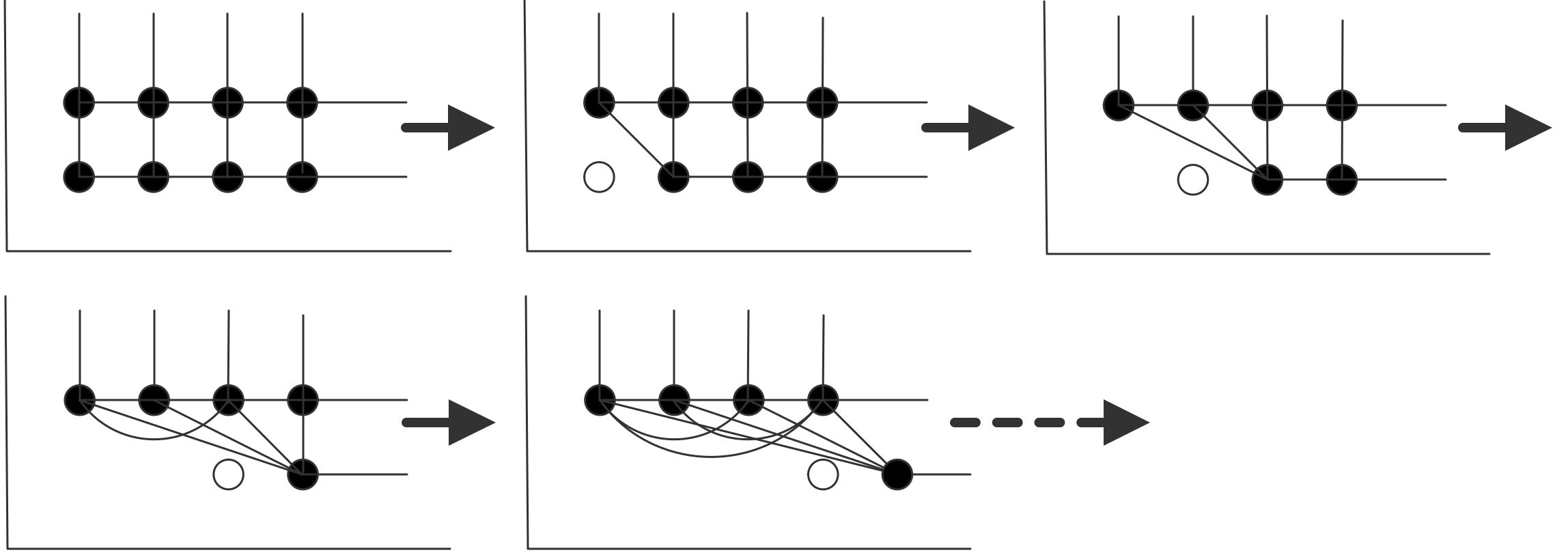

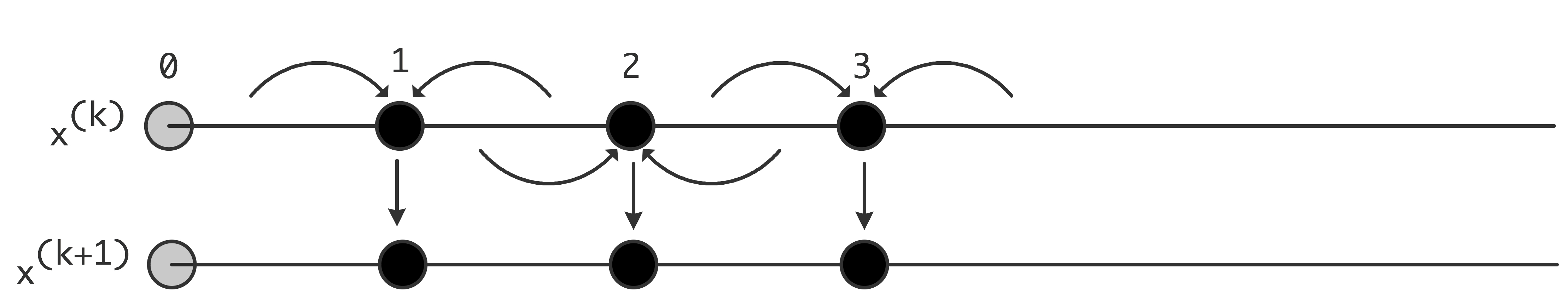

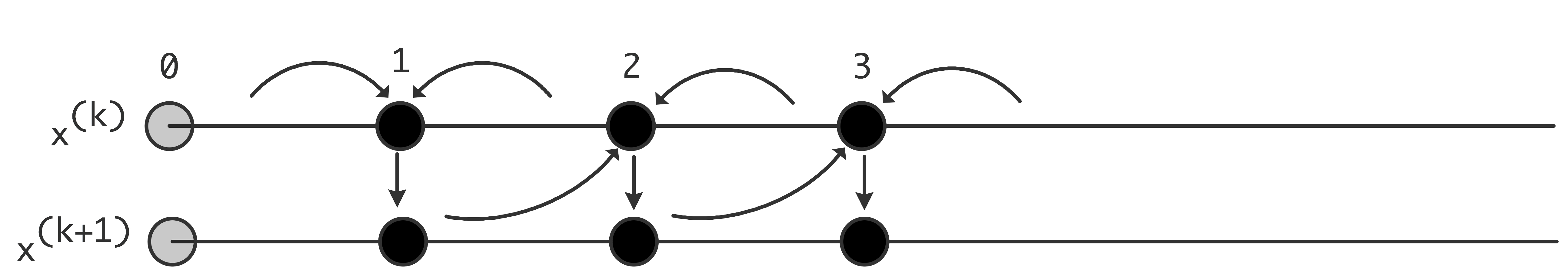

翻自:《Introduction to High Performance Scientific Computing》-Victor Eijkhout

了解计算机体系结构对于编写高效、科学的代码具有十分重要的作用。两段基于不同处理器架构编写的代码,其计算结果可能相同,但速度差异可能从几个百分点到几个数量级之间不等。显然,仅仅把算法放到计算机上是不够的,计算机架构也是至关重要的内容。

有些问题可以在单个中央处理单元(CPU)上解决,而有些问题则需要由多个处理器组成的并行计算机解决。我们将在下一章详细介绍并行计算机,但即便是使用并行计算机处理,也需要首先了解单个CPU的情况。

在该部分,我们将重点关注CPU及其内存系统内部发生的事情。首先讨论指令如何执行,研究处理器核心中的运算;最后,由于内存访问通常比处理器执行指令要慢得多,因此我们将重点关注内存、处理器以及处理器内部的数据移动情况;“flops(每秒浮点操作数)计数”作为预测代码性能的时代已经一去不复返了。这种差异实际上是一个不断增长的趋势,所以随着时间的推移,处理内存流量的问题变得越来越重要,而非逐渐销声匿迹。

这一章中,我们将对CPU设计是如何影响性能的,以及如何编写优化性能的代码等问题有一个清晰的认识。想学习更多细节,请参阅关于PC架构的在线书籍[114],以及关于计算机架构的标准工作,Hennesey和Patterson[97]。

冯·诺依曼架构

虽然各类计算机在处理器细节上存在很多不同,但也有许多相似之处。总的看来,它们都采用了「冯·诺伊曼架构」(von Neumann architectures)。该架构主要包含:存储程序和数据的内存,以及一个在“获取、执行、存储周期”中对数据进行操作的指令处理单元。

注释 1: 具有指定指令序列的模型也称为「控制流」(control flow),与「数据流」(data flow)相对应。

由于指令和数据共同存储在一个处理器中,这使得冯·诺依曼架构区别于早期或一些其他特殊用途的硬接线当代处理器,能够允许修改或生成其他程序。这给我们提供了编辑器和编译器:计算机可以将程序视为数据进行处理。

注释 2: 存储程序的概念允许一个正在运行的程序修改其源代码。然而,人们很快就意识到这将导致代码变得难以维护,因此在实际中很少见到。

本书将不会讨论编译器将高级语言翻译成机器指令的过程,而是讨论如何编写高质量的程序以确保底层运行的效率。

在科学计算中,我们通常只关注数据在程序执行期间如何移动,而非程序代码具体如何。大多数应用中,程序与数据似乎是分开存储的。与高级语言不同,处理器执行的机器指令通常会指定操作的名称,操作数和结果的位置。这些位置不是表示为内存位置,而是表示为「寄存器」(registers)位置:即在CPU中被称作内存的一小部分。

注释 3: 我们很少分析到内存的架构,尽管它们已经存在。20世纪80年代的Cyber 205超级计算机可以同时有三个数据流,两个从内存到处理器,一个从处理器到内存。这样的架构只有在内存能够跟上处理器速度的情况下才可行,而现在已经不是这样了。

下面是一个简单的C语言例子:

1 | void store(double *a, double *b, double *c) { |

及其X86汇编输出,由gcc -O2 -S -o - store.c得到:

1 | .text |

(程序演示的为64位系统输出;32位系统可以添加-m64指令输出)

这段程序的指令有:

- 从内存加载到寄存器;

- 执行加法操作;

- 将结果写回内存。

每条指令的处理如下:

- 指令获取:根据「程序计数器」(program counter)的指示将下一条指令装入进程。此处我们不考虑这是如何发生以及从哪里发生的问题。

- 指令解码:处理器检查指令以确定操作和操作数。

- 内存获取:必要时,数据将从内存取到寄存器中。

- 执行:执行操作,从寄存器读取数据并将数据写回寄存器。

数组的情况稍微复杂一些:加载(或存储)的元素被确定为数组的基址后会加上一个偏移量。

在某种程度上,现代CPU在程序员看来就像冯·诺伊曼机器,但也有各种例外。首先,虽然内存看起来为随机寻址,但在实际中存在着「局部性」(locality)的概念:一旦一个数据项被加载,相邻的项将更有效地加载,而重新加载初始项也会更快。

简单数据加载的另一个复杂之处是,当前的CPU同时操作多条指令,这些指令被称为“「正在执行」(in flight)”,这意味着它们处于不同的完成阶段。当然,与这些同步指令一起,它们的输入和输出也以重叠的方式在内存和处理器之间移动。这是超标量CPU体系结构的基本思想,也被称为「指令级并行」(Instruction Level Parallelism,ILP)。因此,虽然每个指令可能需要几个时钟周期才能完成,但处理器可以在合适的情况下每个周期完成一条指令;在某些情况下,每个周期可以完成多条指令。

CPU的处理速度处在千兆赫级(G),意味着处理器的速度是决定计算机性能的主要因素。速度虽然与性能紧密联系,但实际情况却更为复杂:一些算法被CPU所限制,此时进程的速度是最重要的制约;另外一些算法受到内存的限制,总线速度和缓存大小等方面是影响该问题的关键。

在科学计算中,第二种情况相当显著,因此在本章中,我们将大量关注将数据从内存转移到处理器的过程,而对实际处理器的关注相对较少。

当代处理器

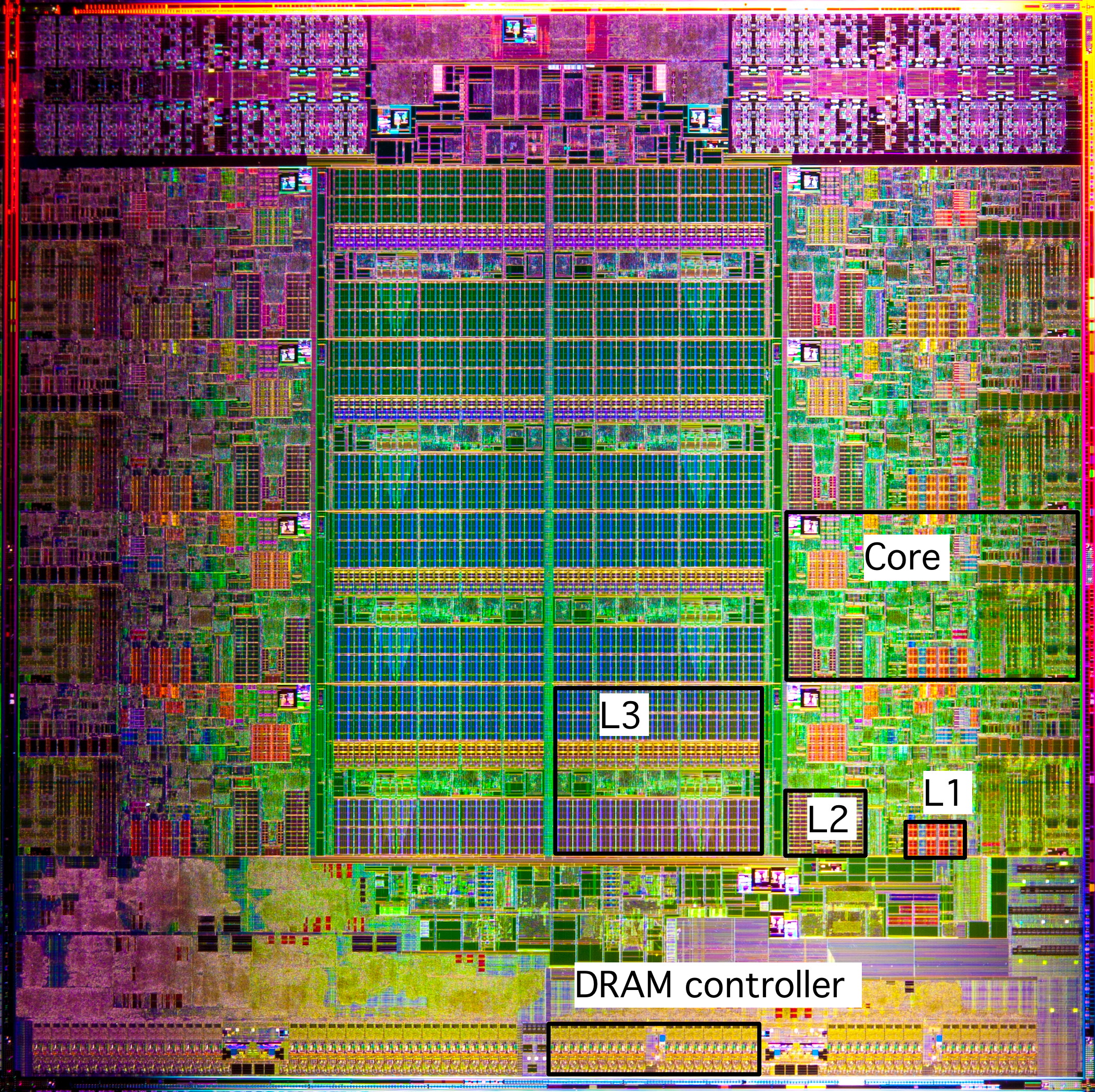

当代处理器极为复杂,在这一节中,我们将简短地介绍一下其组成部分。下图是Intel Sandy Bridge处理器的芯片图。这种芯片大约一英寸大小,包含近十亿个晶体管。

处理核心

冯·诺依曼模型中只有一个执行指令的实体。自21世纪初以来,这种情况并没有显著的增长。上图所示的Sandy Bridge有8个核,每个核都是执行指令流的独立单元。在本章中,我们将主要讨论单个核心的各个方面;第1.4节将讨论多核的集成方面。

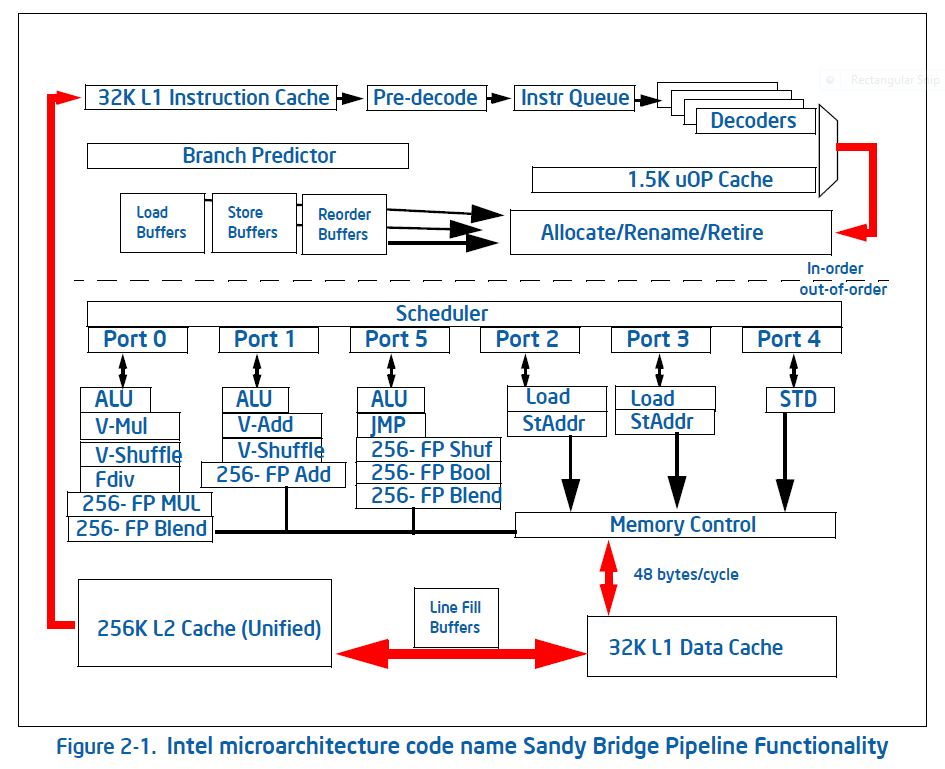

指令处理

冯·诺伊曼模型也是不现实的,因为它假设所有的指令都严格按照顺序执行。在过去的二十年中,处理器越来越多地使用了无序指令处理,即指令可以按照不同于用户程序指定的顺序进行处理。当然,处理器只有在不影响执行结果的情况下才允许对指令重新排序!

在图1.2中,你可以看到与指令处理有关的各种单元:这种聪明的做法实际上要花费相当多的能源及大量的晶体管。正因如此,包括第一代英特尔Xeon Phi协处理器,Knights Corner在内的处理器都采取了使用顺序指令处理的策略。然而,在下一代Knights Landing中,这种做法却由于性能不佳而被淘汰。

浮点单元

在科学计算中,我们最感兴趣的是处理器如何处理浮点数据。而并非整数或布尔值的运算。因此,核心在处理数值数据方面具有相当的复杂性。

例如,过去的处理器只有一个「浮点单元」(FPU),而现在的它们有多个且能够同时执行的浮点单元。

例如,加法和乘法通常是分开的;如果编译器可以找到独立的加法和乘法操作,就可以同时调度它们从而使处理器的性能翻倍。在某些情况下,一个处理器会有多个加法或乘法单元。

另一种提高性能的方法是使用「乘加混合运算」(Fused Multiply-Add,FMA)单元,它可以在与单独的加法或乘法相同的时间内执行指令$x \leftarrow ax +b$。配合流水线操作,这意味着处理器在每个时钟周期内有几个浮点运算的渐近速度。

顺便说一句,很少有用除法当制约因素的算法。在现代CPU中,除法操作的优化程度远不及加法和乘法。除法操作可能需要10或20个时钟周期,而CPU可以有多个加法和/或乘法单元(渐进地)使之每个周期都可以产生一个结果。下表为多个处理器架构的浮点能力(每个核心),以及8个操作数的DAXPY周期数

| 处理器 | 年份 | 加/乘/乘加混合 单元(个数$\times$宽度) | daxpy cycles(arith vs load/store) |

|---|---|---|---|

| MIPS R10000 | 1996 | $1\times 1+1\times 1+0$ | 8/24 |

| Alpha EV5 | 1996 | $1\times 1+1\times 1+0$ | 8/12 |

| IBM Power5 | 2004 | $0+0+2\times 1$ | 4/12 |

| AMD Bulldozer | 2011 | $2\times 2+2\times 2+0$ | 2/4 |

| Intel Sandy Bridge | 2012 | $1\times 4+1\times 4+0$ | 2/4 |

| Intel Haswell | 2014 | $0+0+2\times 4$ | 1/2 |

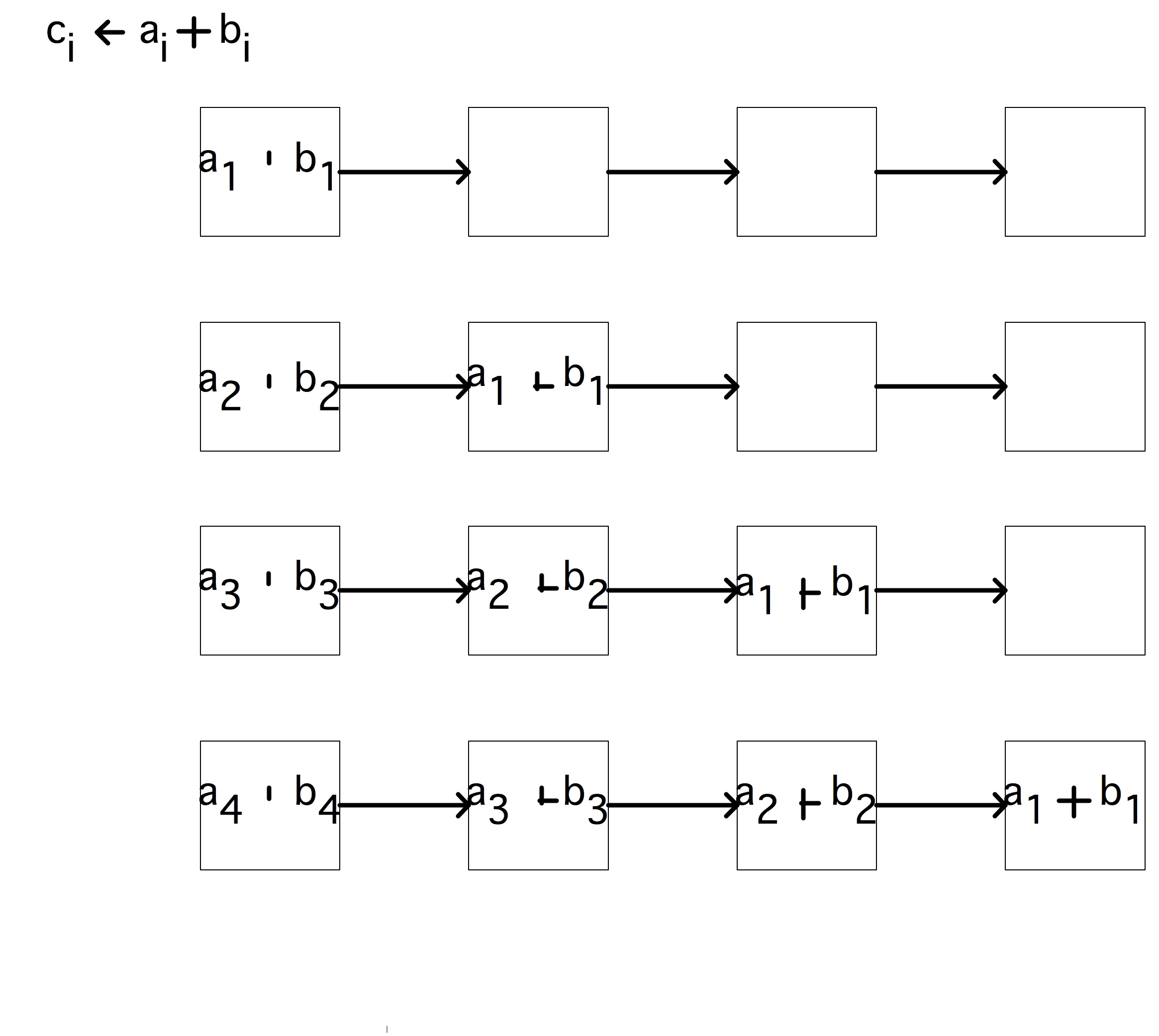

流水线

处理器的浮点加乘单元是流水线式的,其效果是独立的操作流可以以每个时钟周期一个结果的渐近速度执行。流水线背后的思想如下:假设一个操作由若干个简单操作组成,并且每个子操作在处理器中都有独立的硬件。如果我们现在有多个操作要执行,我们可以通过让所有的子操作同步执行来获得加速:每个操作将其结果交给下一个操作,并接受前一个操作的输入。

注释4 这与排队救火的过程非常类似,是一种收缩算法。

例如,加法指令可以包含以下组件:

- 指令解码,包括查找操作数的位置。

- 将操作数复制到寄存器中(数据获取)。

- 调整指数;加法$.35 \times10^{-1} + .6 \times 10^{−2}$变成$.35 \times 10^{-1} + .06 \times 10^{−1}$。

- 执行尾数的加法,在这个例子中是$.41$。

- 将结果归一化,在本例中为$.41 \times 10^{−1}$。(本例中归一化并未执行任何操作,$.3 \times 100 + .8 \times 100$和$.35 \times 10^{−3} +(−.34)\times 10^{−3}$做了很大的调整)

这些部分通常被称为流水线的“「深度」(stages)”或“「阶段」(segments)”。

如果按照顺序执行,上文中每个组件设计为1个时钟周期,则整个过程需要6个时钟周期。然而,如果每个操作都有自己对应的硬件,我们就可以在少于12个周期内执行两个操作:

- 第一个操作执行解码;

- 第一个操作获取数据,同时第二个操作执行解码;

- 同时执行第一操作的第三阶段和第二操作的第二阶段;

- 以此类推。

可以看到,第一个操作仍然需要6个时钟周期,但第二个操作只需再延后一个周期就能同时完成。

对流水线获得的加速做一个正式的分析:在传统的浮点单元上,产生$n$个结果需要花费时间为 $t(n)=n\ell\tau$,其中$\ell$是状态个数,而$\tau$是时钟周期。结果产生的速率是$t(n)/n$的倒数:$r_{serial}\equiv(\ell \tau)^{-1}$

另一方面,对于流水线的浮点单元,时间是$t(n)=[s+l+n-1]t$其中$s$是设置成本;第一次执行时必须要经历一个完整的串行阶段,但在此后,处理器将在每个周期获得更多的收益。可以记作公式

表示线性时间,加上偏移量。流水线示意图描述如下:

练习1.1 请对比传统FPU和流水线FPU的速度差异。证明结果速率依赖于$n$:给出$r(n)$和$r_\infty = \lim\limits_{n\rightarrow \infty}r(n)$的公式。在非流水线情况下$r$的加速极限是什么样?它需要多长时间才能接近极限情况?注意到$n=n_{1/2}$,可以得到$r(n)=r_\infty/2$,这通常被用做$n_{1/2}$的定义。

由于向量处理器同时处理多个指令,因此这些指令必须是独立且相互之间没有依赖关系的。$∀_i:a_i\leftarrow b_i + c_i$有独立的加法运算;$\forall_i:a_{i+1}\leftarrow a_ib_i+c_i$将一次迭代$(a_i)$的结果输入到下一次迭代的输入$(a_{i+1}=…)$,所以这些操作并非独立。

与传统的CPU相比,流水线处理器可以将操作速度提高4、5甚至6倍。在上世纪80年代,当第一台向量计算机成功上市时,这样的加速效率十分常见。现在,CPU可以有20个阶段的流水线,是否意味着它们的速度非常快?这个问题有点复杂。芯片设计者不断提高主频,流水线部分不再能够在一个周期内完成他们的工作,所以他们进一步分裂。有时甚至有一些时间片段什么也没有发生:但这段时间是又是必须的,以确保数据可以及时传输到芯片的不同部分。

人们能从流水线CPU得到的改进是有限的,为了追求更高的性能,计算机科学家们尝试了几种不同的流水线设计。例如,Cyber 205有单独的加法和乘法流水线,可以将一个流水线输入另一个流水线,而无需先将数据返回内存。像 $∀_i: a_i\leftarrow b_i + c·d_i$这样的操作被称为“「链接三元组」(linked triads)”(因为到内存的路径数量,一个输入操作数必须是标量)。

练习1.2 分析链接三元组的加速和$n_{1/2}$。

另一种提高性能的方法是使用多个相同的流水线。NEC SX系列完善了这种设计。例如,有4条流水线时,$∀_i:a_i\leftarrow b_i +c_i$操作将对模块4进行拆分,以便第一条流水线对索引$i = 4·j$操作,第二条流水线对索引$i = 4·j + 1$操作,以此类推。

练习1.3 分析具有多个并行操作流水线处理器的速度提升情况和$n_{1/2}$。也就是说,假设有$p$个执行相同指令的独立流水线,每条流水线都可以处理的操作数流。

(你可能想知道我们为什么在这里提到一些相当老的计算机:真正的流水线超级计算机已经不存在了。在美国,Cray X1是该系列的最后一款,而在日本,只有NEC还在生产。然而,现在CPU的功能单元是流水线的,所以这个概念仍然很重要。)

练习1.4 如下操作

1 | for (i) { |

不能由流水线处理,因为在操作的一次迭代的输入和前一次迭代的输出之间存在依赖关系。但是,我们可以将循环转换为数学上等价的循环,并且可能更有效地计算。导出一个表达式,该表达式从$x[i]$中计算$x[i+2]$而不涉及$x[i+1]$。这就是所谓的「递归加倍」(recursive doubling)。假设有足够的临时存储空间。参考如下:

- 做初步计算;

- 计算$x[i],x[i+2],x[i+4],…$,并从这些中

- 计算缺失项$x[i+1],x[i+3],…$

通过给出$T_0(n)$和$T_s(n)$的计算公式,分析了该格式的有效性。你能想到为什么初步计算在某些情况下可能不那么重要吗?

收缩计算

上面描述的流水线操作是「收缩算法」(systolic algorithm)的一种情况。在20世纪80年代和90年代,有研究使用流水线算法并构建特殊硬件——「脉动阵列」 (systolic arrays)来实现它们[125]。这也与「现场可编程门阵列」(Field-Programmable Gate Arrays,FPGA)的计算连接,其中脉动阵列是由软件定义的。

峰值性能

现代CPU由于流水线的存在,时钟速度和峰值性能之间存在着较为简单的关系。由于每个FPU可以在一个周期内产生一个结果,所以峰值性能是时钟速度乘以独立FPU的数量。浮点运算性能的衡量标准是“「每秒浮点运算」(floating point operations per second)”,缩写为flops。考虑到现在计算机的速度,你会经常听到浮点运算被表示为“gigaflops”:$10^9$次浮点运算的倍数。

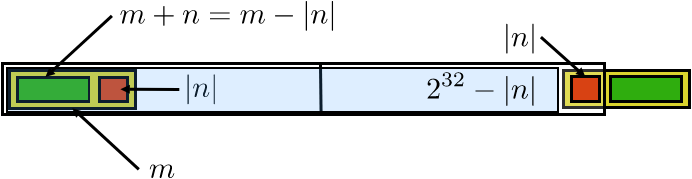

8位,16位,32位,64位

处理器的特征通常是可以处理多大的数据块。这可以联系到

- 处理器和内存之间路径的宽度:一个64位的浮点数是否可以在一个周期内加载,还是分块到达处理器。

- 内存的寻址方式:如果地址被限制为16位,只有64,000字节可以被识别。早期的PC有一个复杂的方案,用段来解决这个限制:用段号和段内的偏移量来指定一个地址。

- 单个寄存器中的数值位数,特别是用于操作数据地址的整数寄存器的大小;参见前一点。(浮点寄存器通常更大,例如在x86体系结构中是80位。)这也对应于处理器可以同时操作的数据块的大小。

- 浮点数的大小:如果CPU的算术单元被设计成有效地乘8字节数(“双精度”;见3.2.2节),那么一半大小的数字(“单精度”)有时可以以更高的效率处理,而对于更大的数字(“四倍精度”),则需要一些复杂的方案。例如,一个四精度的数字可以由两个双精度的数字来模拟,指数之间有一个固定的差异。

这些测量值不一定相同。例如,原来的奔腾处理器有64位数据总线,但有一个32位处理器。另一方面,摩托罗拉68000处理器(最初的苹果Macintosh)有一个32位CPU,但16位的数据总线。

第一个英特尔微处理器4004是一个4位处理器,它可以处理4位的数据块。如今,64位处理器正在成为标准。

缓存(Caches):芯片上的内存

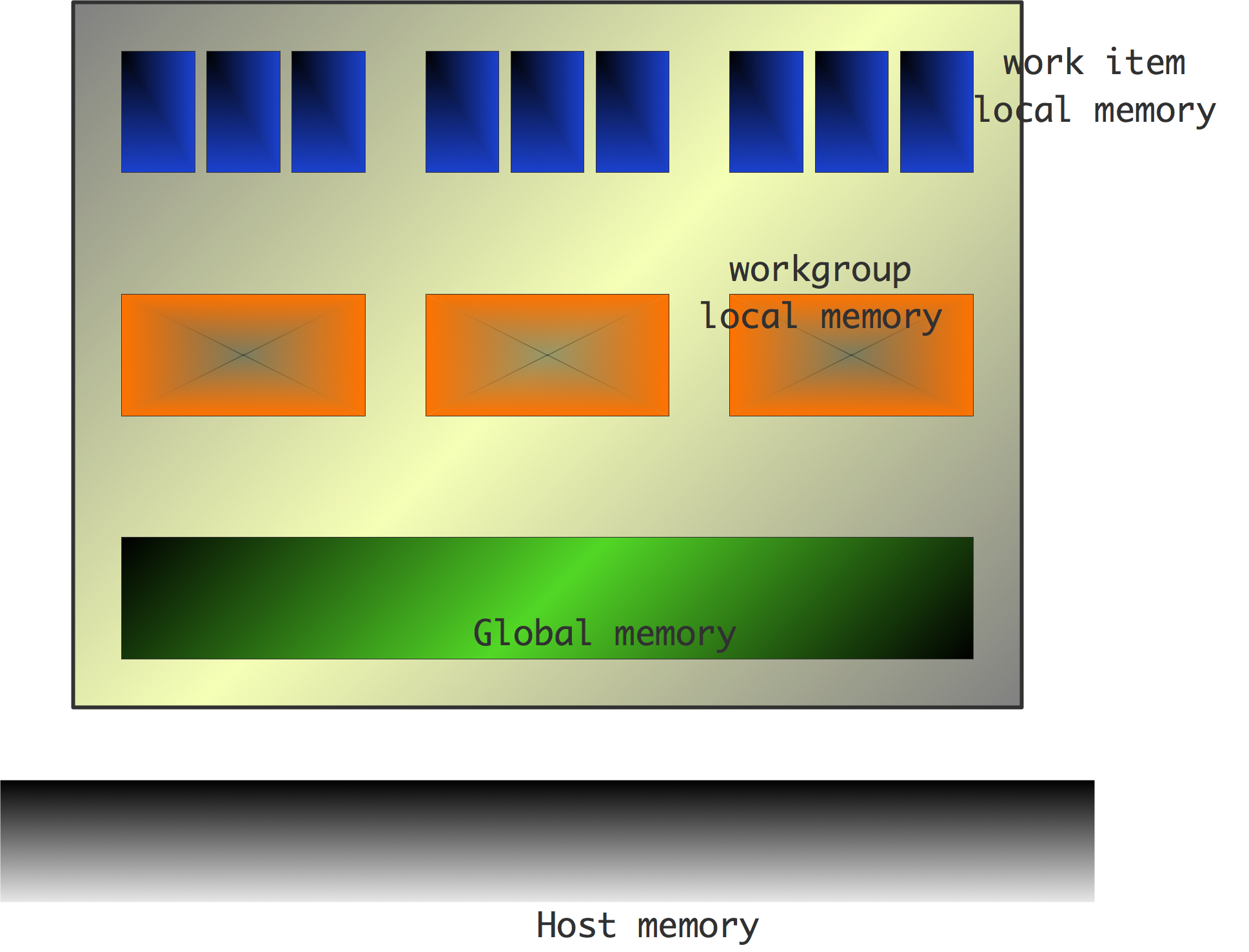

计算机内存的大部分是在与处理器分离的芯片中。然而,通常有少量的片上内存(通常是几兆字节),这些被称为「高速缓存」(cache)。后面我们将会详细解释。

图形、控制器、专用硬件

“消费型”和“服务器型”处理器之间的一个区别是,消费型芯片在处理器芯片上花了相当大的空间用于图形处理。手机和平板电脑的处理器甚至可以有专门的安全电路或mp3播放电路。处理器的其他部分专门用于与内存或I/O子系统通信。我们将不在本书中讨论这些方面。

超标量处理和指令级并行性

在冯·诺伊曼模型中,处理器通过控制流进行操作:指令之间线性地或通过分支相互跟踪,而不考虑它们涉及哪些数据。随着处理器变得越来越强大,一次可以执行多条指令,就有必要切换到数据流模型。这种超标量处理器分析多个指令以找到数据相关性,并行执行彼此不依赖的指令。

这个概念也被称为「指令级并行」(Instruction Level Parallelism,ILP),它被各种机制推动:

- 多发射(multiple-issue):独立指令可同时启动;

- 流水线(pipelining):上文提到,算术单元可以在不同的完成阶段处理多个操作;

- 分支预测和推测执行(branch prediction and speculative execution):编译器可以“预测”条件指令的值是否为真,然后相应地执行这些指令;

- 无序执行(out-of-order execution):如果指令之间不相互依赖,并且执行效率更高,则指令可以重新排列;

- 预取(prefetching):数据可以在实际遇到任何需要它的指令之前被推测地请求(这将在后面进一步讨论)。

在上面我们看到了浮点操作上下文中的流水线操作。事实上,不仅是浮点运算,当代处理器的整个CPU都是流水线的,任何类型的指令都将尽快被放入指令流水线中。注意,这个流水线不再局限于相同的指令:现在,流水线的概念被概括为同时 “在执行 “的任何指令流。

随着主频的增加,处理器流水线的长度也在增加,以使分段在更短的时间内可被执行。可以看到,更长的流水线有着更大的$n_{1/2}$,因此需要更多的独立指令来使流水线以充分的效率运行。当达到指令级并行性的极限时,使流水线变长(或者称为“更深”)将不再有好处。因此,芯片设计者们通常转向多核架构以更高效地利用芯片上的晶体管。

这些较长的流水线的第二个问题是:如果代码到达一个分支点(一个条件或循环中的测试),就不清楚要执行的下一条指令是什么。在该点上,流水线就会会停止。例如,CPU总是假设测试结果是正确的,因此采取了「分支预测执行」(speculative execution)。如果代码随后接受了另一个分支(这称为分支错误预测),则必须刷新流水线并重新启动。执行流中产生的延迟称为「分支惩罚」(branch penalty)。

内存层次结构

冯·诺伊曼体系结构中,数据立即从内存加载到处理器,并在处理器中进行操作。然而这是不现实的,因为这一过程中会有「访存墙」(memory wall)[204]的存在:内存速度过慢,无法和处理器速度相匹配。具体来说,单次加载可能需要1000个周期,而处理器每个周期可以执行若干个操作。(在长时间等待加载之后,下一个加载可能会更快,但对处理器来说仍然太慢)

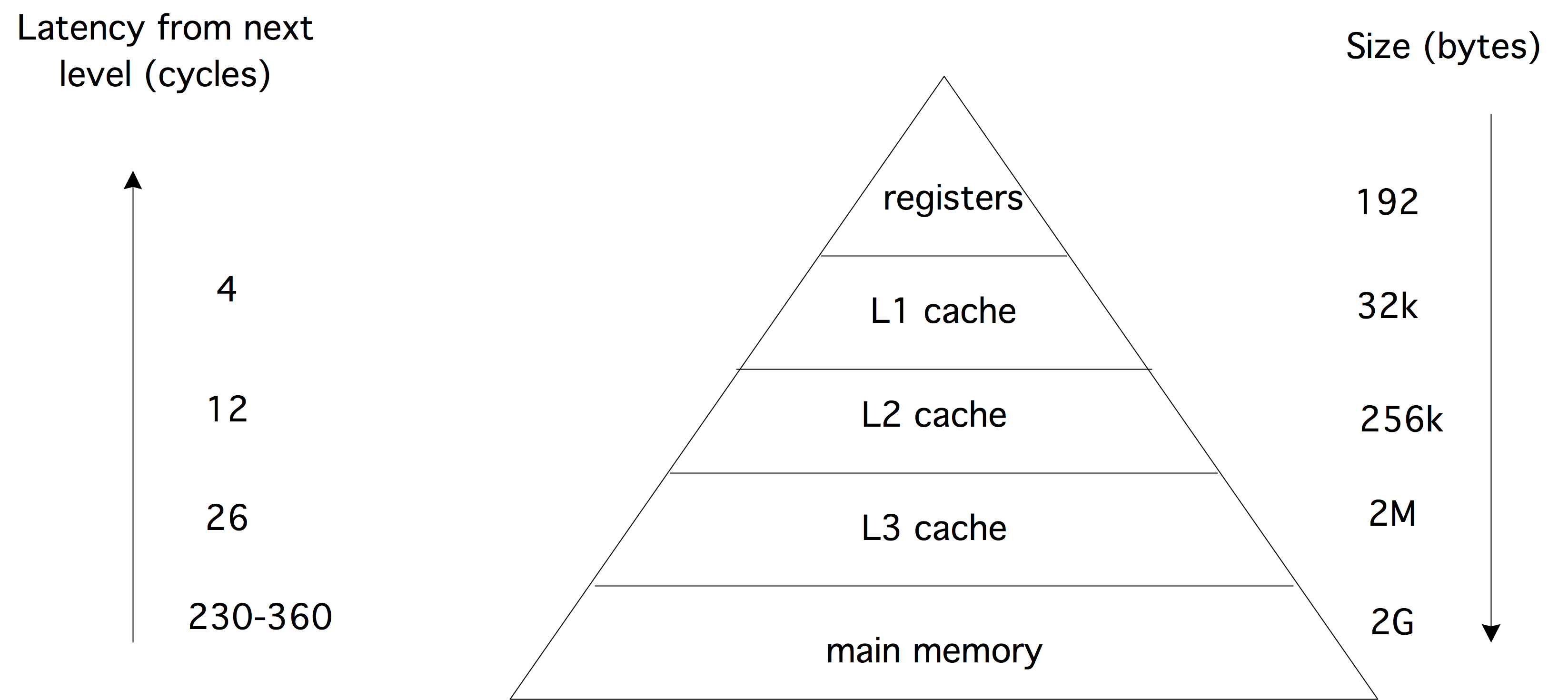

实际上,在FPU和内存之间会有不同的存储器级别:寄存器和缓存,一起称为「存储器层级结构」(memory hierarchy)。它们可以更快速地从内存中读取一些最近使用的数据以缓解访存墙的问题。当然,这是在数据被多次使用的前提下。这类「数据复用」(data reuse)问题将在后面进行更详细的讨论。

寄存器和缓存都在不同程度上比内存快;寄存器的速度越快,其存储量就越小。寄存器的大小和速度之间的矛盾产生了一个有趣的博弈,我们将随后讨论这些问题。

接下来,我们将讨论内存层次结构的各部分并分析其在执行过程所需的理论基础。

总线

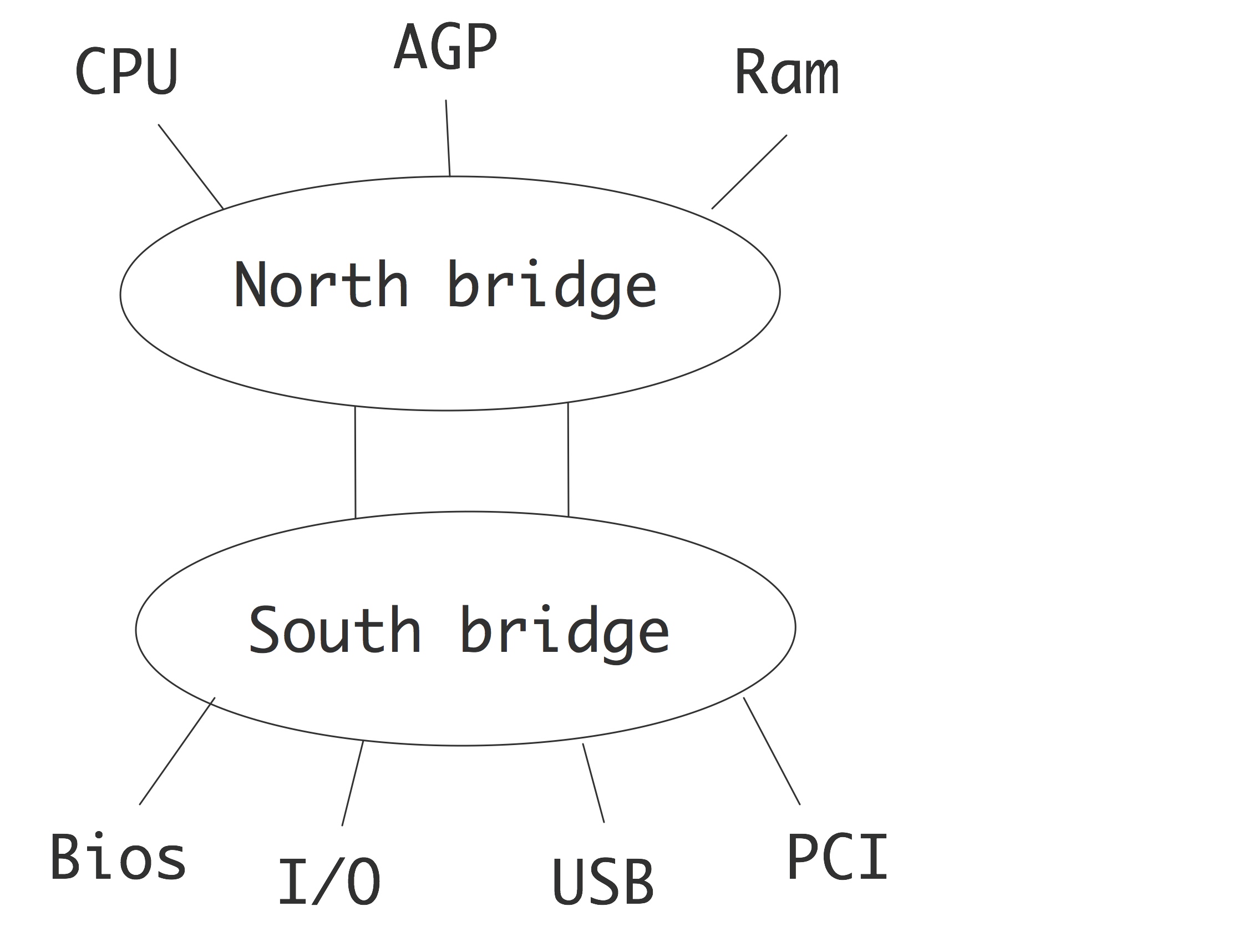

在计算机中,将数据从处理器移动到CPU、磁盘控制器或屏幕的线路被称为「总线」(busses)。对我们来说最重要的是连接CPU和内存的「前端总线」(Front-Side Bus,FSB)。在当前较为流行的架构中,这被称为“「北桥」(north bridge)”,与连接外部设备(除了图形控制器)的“「南桥」(south bridge)”相对。

总线通常比处理器的速度慢,其时钟频率作为CPU时钟频率的一部分,数值上略高于1GHz,这也正是引入缓存的原因之一;事实上,一个处理器可以在每个时钟周期中消耗大量数据项。除了频率之外,总线的带宽也由每个时钟周期可移动的比特数决定。在目前的体系结构中,这通常是64或128。我们现在将更详细地讨论这个问题。

延迟和带宽

寄存器中访问数据几乎是瞬时的,而将数据从内存加载到寄存器是进行任何操作之前的一个必要步骤,加载的过程会导致大量的延迟,下面我们将细化这一过程。

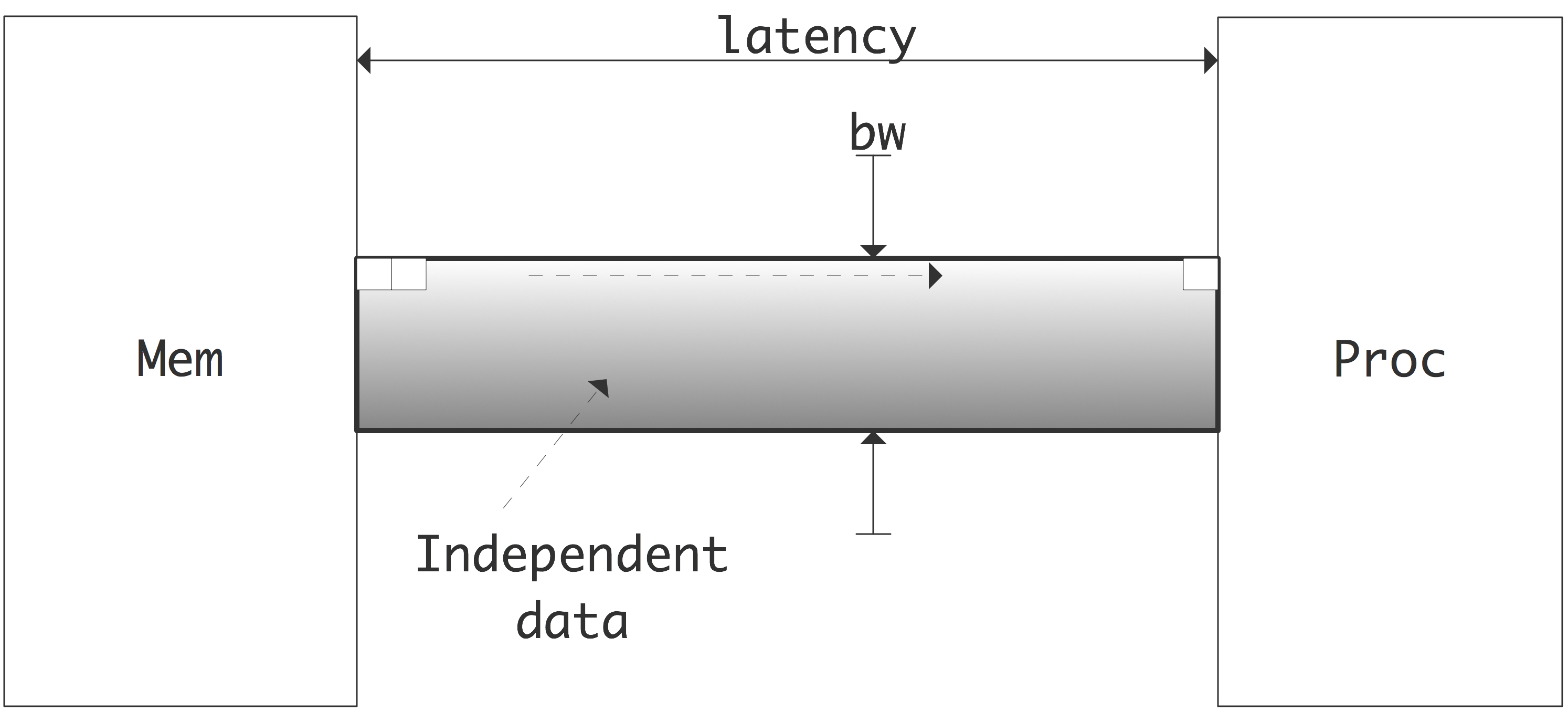

有两个重要的概念来描述数据的移动:「延迟和带宽」(latency and bandwidth)。这里的假设是,请求一组数据会引起初始延迟;如果这一项是该组数据的第一个项,则通常是连续的内存地址范围,而该组数据的其余部分将以一个固定的时间周期不再延迟到达。

「延迟」:为处理器发出内存项请求到内存项实际到达之间的延迟。我们可以区分不同的延迟,比如从内存到缓存的传输,缓存到寄存器的传输,或者将它们总结为内存和处理器之间的延迟。延迟是以(纳米)秒或时钟周期来衡量的。如果处理器按照在汇编代码中的顺序去执行指令,则在从内存中提取数据时经常会停止;这也被称为「内存延迟」(memory stall)。低延迟非常重要。在实际中,许多处理器都有指令的“无序执行”情况,即允许它们在等待所请求的数据时执行其他操作。程序员可以考虑这一点,并以一种实现延迟隐藏的方式编写代码;「图形处理单元」(GPU)可以在线程之间快速切换,以实现延迟隐藏。

「带宽」:为克服初始延迟后,数据到达目的地的速率。带宽以字节(千字节k、兆字节m、千兆字节g)/秒或每个时钟周期来衡量。两个存储层之间的带宽通常是通道的周期速度(总线速度)和总线宽度的乘积:总线时钟的每个周期中可以同时发送的比特数。

延迟和带宽的概念通常结合在一个公式中,表示消息从开始到结束所花费的时间: $T(n)=\alpha+\beta n$

其中$\alpha$是延迟,$\beta$是带宽的倒数:即每字节所用的时间。

通常,距离处理器越远,延迟就越长,带宽就越低。因此我们希望处理器尽量使用缓存中的数据而非内存,例如考虑向量加法

1 | for(i) |

每次迭代执行一个浮点操作,现代CPU可以通过流水线技术在一个时钟周期内完成这一操作。但是,每次迭代都需要加载两个数字并写入一个数字,总共需要24字节的内存流量(实际上,$a[i]$在写入之前就被加载了,所以每次迭代有4次内存访问,总共32字节)。典型的内存带宽数字(参见图1.5)远远没有接近24(或32)字节每周期。这意味着,在没有缓存的情况下,算法性能可能受到内存性能的限制。当然,缓存不会加速每一个操作,但这对我们的例子并没有影响。我们将会在1.7节中讨论高效利用缓存的编程策略。

当我们讨论从一个处理器向另一个处理器发送数据时,延迟和带宽的概念也会出现在并行计算机中。

寄存器

每个处理器内部都有少量类似内存的结构:「寄存器」(registers)或「寄存器堆」(registers file)。寄存器是处理器实际操作的对象:例如

1 | a := b + c |

实际过程为

- 将b的值从内存中装入寄存器,

- 将c的值从内存中装入另一个寄存器,

- 计算和并将其写入另一个寄存器,然后

- 将计算后的总和写回a的内存位置。

查看汇编代码(例如编译器的输出)就可以看到显式的加载、计算和存储指令。

像加或乘这样的计算指令只能在寄存器上操作。例如,在汇编语言中我们会看到如下指令

1 | addl %eax %edx |

它将一个寄存器的内容添加到另一个寄存器。正如在这个示例指令中看到的,与内存地址相反,寄存器没有编号,而是具有在汇编指令中引用的不同名称。通常,一个处理器有16或32个浮点寄存器;英特尔安腾(Intel Itanium)的128个浮点寄存器是例外。

寄存器具有高带宽和低延迟,因为它们是处理器的一部分。可以将进出寄存器的数据移动看作是瞬时的。

在本章中,我们会发现从内存中读取数据的时间开销较大。因此,尽可能将数据留在寄存器中是一种简单的优化策略。例如,如果上面的计算后面跟着一个语句

1 | a := b + c |

a的计算值就可以留在寄存器中。编译器通常会帮助我们完成这种优化:编译器不会生成存储和重新加载a的指令。我们就称a停留在寄存器中。

将值保存在寄存器中通常是为了避免重新计算新的变量。例如,在

1 | t1 = sin(alpha) * x + cos(alpha) * y; |

正弦和余弦值可能会保留在寄存器中。我们可以通过显式地引入临时数量来帮助编译器:

1 | s = sin(alpha); c = cos(alpha); |

当然,寄存器的数量是有限制的;试图在寄存器中保留太多的变量被称为「寄存器漫溢」(register spill),这会降低代码的性能。

如果变量出现在内部循环中,那么将该变量保存在寄存器中尤为重要。在计算

1 | for i = 1, length |

中,变量c可能会被编译器保存在寄存器中,而在

1 | for k =1, nevctors |

最好是显式地引入一个临时变量来保存$c[k]$。在C语言中,你可以通过将变量声明为寄存器变量来提示编译器将变量保存在寄存器中:

1 | register double t; |

译者注:声明寄存器格式并不能完全使变量存储在寄存器中,这仅仅起到提示寄存器的作用,如果想完全控制寄存器的执行,则需要编写汇编代码。

缓存

在包含指令即时输入和输出数据的寄存器和大量数据可以长期存放的内存之间,有各种级别的高速缓冲存储器,它们比内存具有更低的延迟和更高的带宽,并将数据保存一段时间。

数据从内存通过高速缓存到达寄存器的好处是,如果一组数据在第一次使用后不久就要被复用,由于它仍然在缓存中,因此访问的速度比从内存中引入数据要快得多。

从历史的角度来看,存储器层次结构的概念早在1946年就已经被讨论过了[25],当时提出的原因是内存技术发展较为缓慢。

示例

例如,假设一个变量$x$被使用了两次,它的两次使用间隔较大,以至于会留在寄存器中:

1 | ... = ... x ..... //执行x的指令 |

汇编代码为:

- 将$x$从内存加载到寄存器中,并对其进行操作;

- 执行中间的指令;

- 将$x$从内存加载到寄存器中,并对其进行操作;

使用缓存,汇编代码保持不变,但内存系统的实际行为现在变成:

- 将$x$从内存加载到缓存中,并从缓存加载到寄存器中,执行操作;

- 执行中间其他的指令;

- 从内存中请求$x$,但由于它仍然在缓存中,因此直接从缓存中加载,继续操作。

由于从缓存加载比从主存加载要快,因此计算速度将会更快。缓存的容量较小,所以数值不能无限期地保存在那里。我们将在下面的讨论中看到它的含义。

缓存和寄存器之间有一个重要的区别:虽然数据是通过显式的汇编指令移入寄存器的,但从内存到缓存的移动完全是由硬件完成的。因此,缓存的使用和重用不在程序员的直接控制范围之内。稍后,特别是在1.6.2和1.7节中,我们将看到如何间接影响缓存的使用。

缓存标签

上面没有提及在缓存中找到某个项的机制,但每个缓存位置都有一个标记,以便我们有足够多的信息来找到某个缓存项与内存的映射。

缓存级别、速度和大小

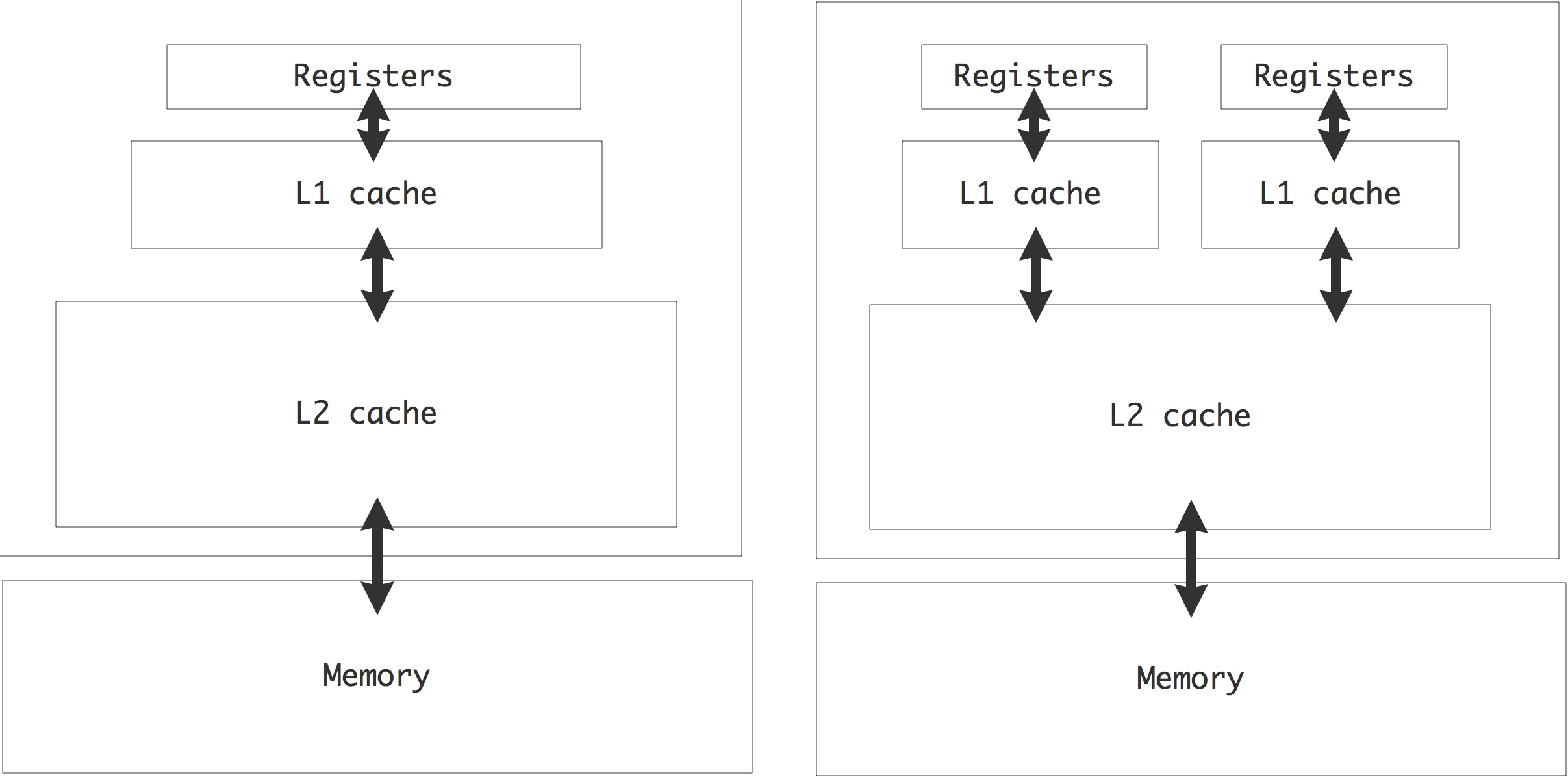

缓存通常被称为“level 1”和“level 2”(简称L1和L2)缓存;有些处理器可能有L3缓存。L1和L2缓存位于处理器的芯片上;L3缓存则在芯片外部。L1缓存的容量很小,通常在16Kbyte左右。相比之下,第2级(如果有,则是第3级)缓存容量则较大,最多可达几兆字节,但速度也随之下降。与可扩展的内存不同,缓存的大小是固定的。如果某个版本的处理器芯片上附带了一个较大的缓存,那么它的价格通常相当昂贵。

某些操作所需的数据在传送到处理器的过程中被复制到不同的缓存中。如果在一些指令之后,又需要一个数据项,计算机会首先在L1缓存中搜索它;如果没有找到,就在L2缓存中搜索;如果没有找到,就从内存中加载。在缓存中找到数据称为「缓存命中」(cache hit),没有找到数据则称为「缓存失效」(cache miss)。

图1.5展示了缓存层次结构的基本情况,本例是针对Intel Sandy Bridge芯片:缓存越接近FPU,其速度越快,容量越小。

- 从寄存器加载数据是如此之快,以致于它不会成为阻碍算法执行速度的限制。另一方面,寄存器的数量很少。每个核心有16个通用寄存器和16个SIMD寄存器。

- L1缓存很小,但是每个周期保持了32字节的带宽,即4个双精度数。这足以为两个操作分别加载两个操作数,但请注意,内核实际上每个周期可以执行4个操作。因此,为了达到峰值速度,某些操作数需要留在寄存器中:通常,L1带宽足以满足大约一半的峰值性能。

- L2和L3缓存的带宽名义上与L1相同。然而,部分带宽将在缓存一致性问题上浪费。

- 主内存访问带宽大于100个周期,带宽为4.5字节/周期,约为L1带宽的1/7。然而,这个带宽是由一个处理器芯片的多个核心共享的,因此有效的带宽是这个数字的一个小数。大多数集群每个节点也有多个「插槽」(socket,即处理器芯片),通常是2或4个,因此一些带宽花费在维持缓存一致性上(参见1.4节),再次减少了每个芯片的可用带宽。

在L1上,指令和数据有单独的缓存;L2和L3的缓存则同时包含数据和指令。

可以看到,越来越大的缓存无法足够快地向处理器提供数据。因此,有必要以这样一种方式编码,即数据尽可能地保存在最高缓存级别。我们将在本章的其余部分详细讨论这个问题。

练习 1.5 L1缓存比L2缓存小,如果有L3缓存,则L2要比L3小。给出一个实际的和理论上的原因。

缓存失效的类型

缓存失效有三种类型。

正如在上面的例子中看到的,第一次引用数据时,总是会导致缓存丢失,这被称为「强制失效」(compulsory miss),因为这些是不可避免的。这是否意味着在第一次需要数据项时,我们要一直等待它?不一定:第1.3.5节解释了硬件如何通过预测下一步需要什么数据来帮助你。

下一种类型的缓存丢失是由于工作集的大小造成的:「容量失效」(capacity miss)是由于数据被覆盖,因为缓存不能包含所有问题数据(第1.3.4.6节讨论了处理器如何决定要覆盖哪些数据)。如果你想要避免这种类型的失误,需要将问题划分为足够小的块,以便数据可以在缓存中停留相当长的时间。当然,这是在假设数据项被多次操作的前提下,所以把数据项保存在缓存中是有意义的;这将在第1.6.1节中讨论。

最后,由于一个数据项被映射到与另一个相同的缓存位置而导致的「冲突失效」(conflict miss),而这两个数据项仍然是计算所需要的,并且可能有更好的候选者需要被驱逐。这将在1.3.4.10节中讨论。

在多核上下文中还有另外一种类型的缓存丢失:「无效失效」(invalidation miss)。如果缓存中的某个项因为另一个内核改变了相应内存地址的值而失效,就会发生这种情况。内核将不得不重新加载这个地址。

复用是关键

一个或多个缓存的存在并不能立即保证高性能:这在很大程度上取决于代码的内存访问模式,以及如何充分利用缓存。第一次引用一个项时,它被从内存复制到缓存,并通过处理器的寄存器。缓存的存在并没有以任何方式减少延迟和带宽。当同一项第二次被引用时,它可能在缓存中被找到,因此在延迟和带宽方面的成本大大降低:缓存比主存有更短的延迟和更高的带宽。

我们的结论是,首先,算法必须有数据复用的机会。如果每个数据项只被使用一次(就像除了两个向量之外),不存在复用,则缓存的存在在很大程度上是无关紧要的。只有当缓存中的项被多次引用时,代码才会从缓存增加的带宽和减少的延迟中受益;详细的讨论请参见1.6.1节。例如,矩阵向量乘法$𝑦=𝐴𝑥$,其中$𝑥$的每个元素都在$𝑛$操作中使用,其中$𝑛$是矩阵维数。

其次,算法理论上可能有复用的机会,但需要以较为明显的复用方式进行编码。我们将在1.6.2节中解决这些问题。后者尤其重要。

有些问题很小,可以完全放在缓存中,至少在L3缓存中是这样。这是在进行「基准测试」(benchmarking)时需要注意的一点,因为它对处理器性能的描述过于乐观。

替换策略

高速缓存和寄存器中的数据仅由硬件决定,而非由程序员控制。同样地,当缓存或寄存器中的数据在一段时间内没有被引用,并且其他数据需要放在那里时,系统就会决定什么时候覆盖这些数据。下面,我们将详细介绍缓存如何做到这一点,但在整合一个总体原则,一个「最近最少使用」(Least Recently Used,LRU)替换:如果缓存已满,需要放入新数据,最近最少使用的数据从缓存中刷新,这意味着它是覆盖在新项目,因此不再访问。LRU是目前最常见的替换策略;其他的策略还有:「先进先出」(First In First Out,FIFO)或「随机替换」。

练习 1.6 LRU替换策略与直接映射缓存和关联缓存有什么关系?

练习 1.7 描绘一个简单的场景,并给出一些(伪)代码,以论证LRU比FIFO更适合作为替代策略。

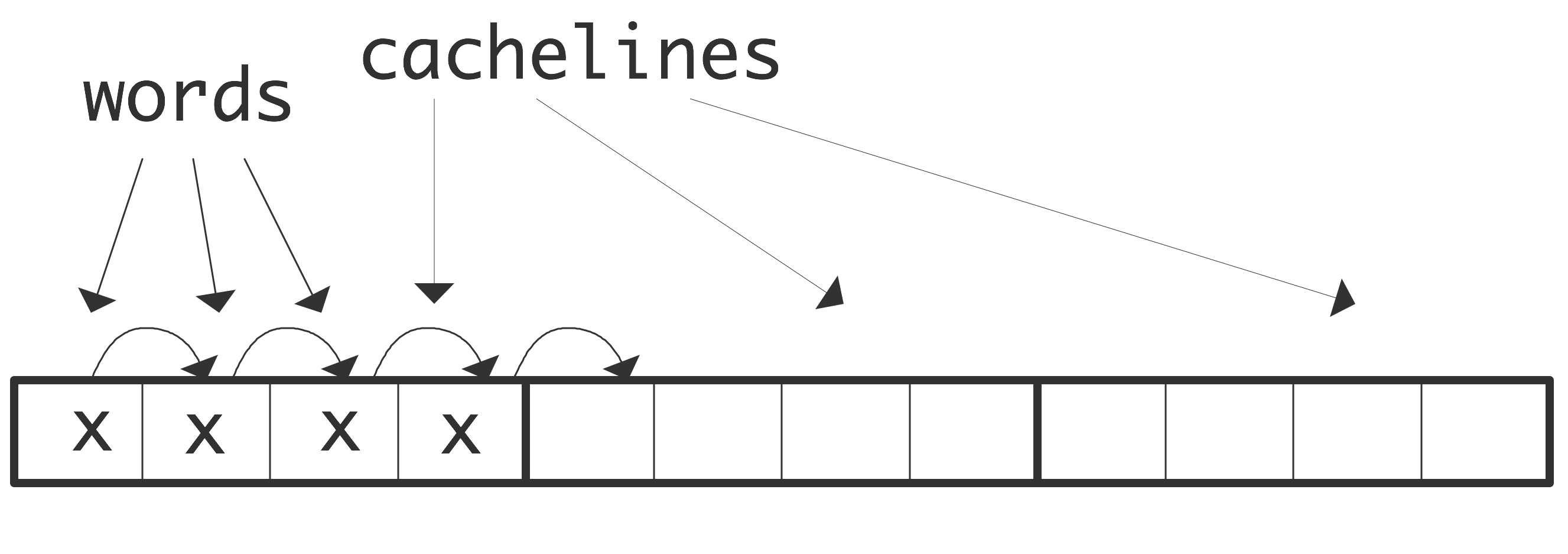

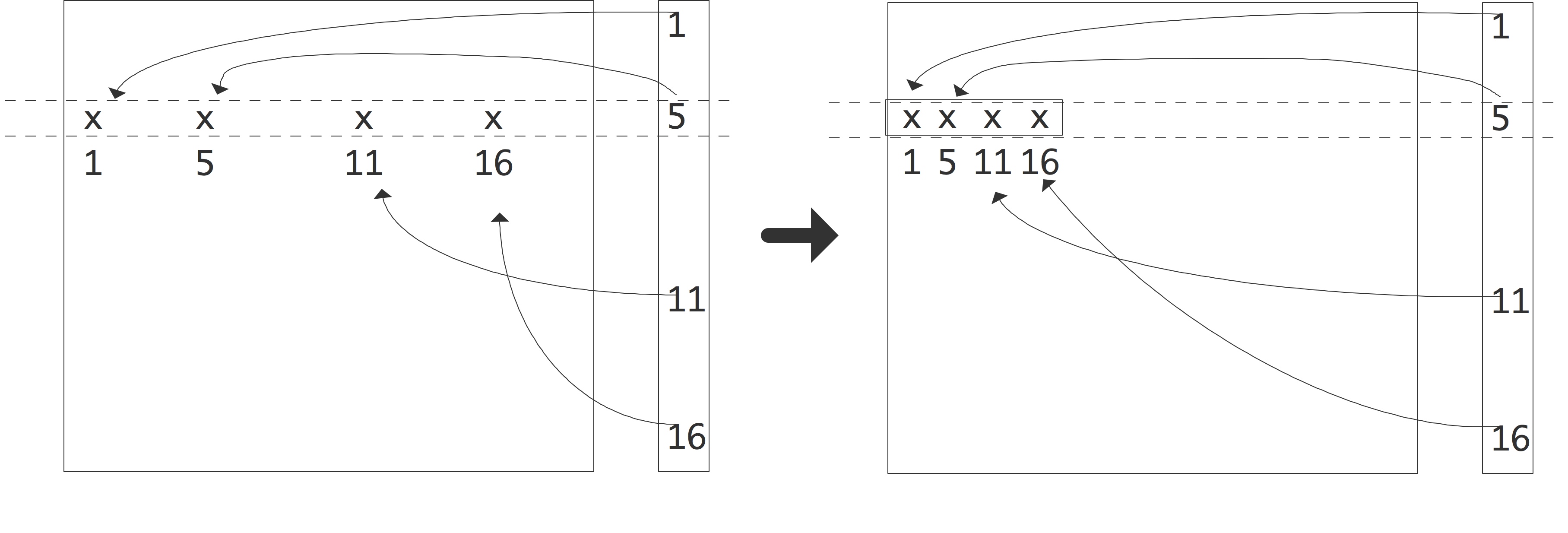

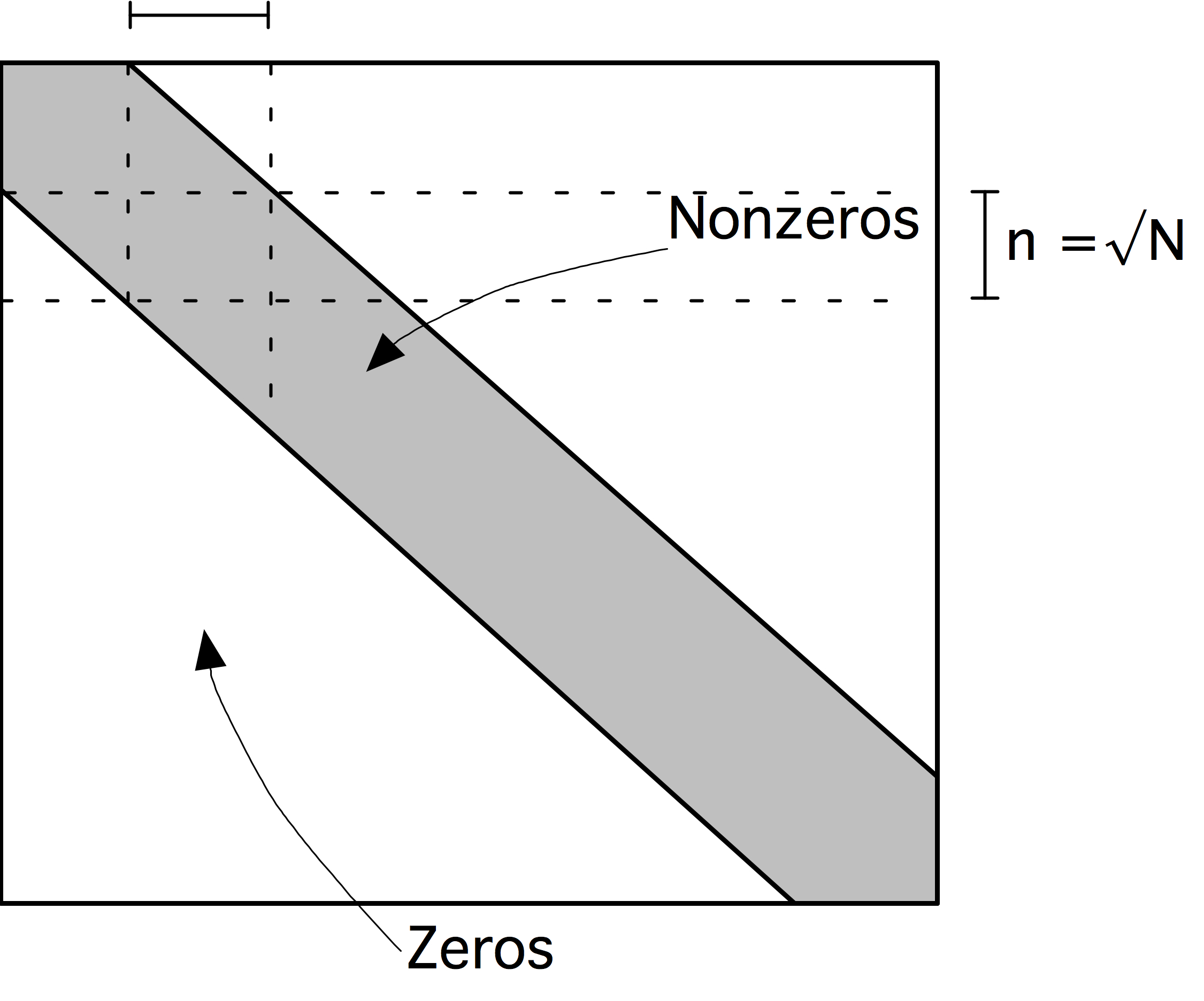

缓存线

在内存和高速缓存之间或多个高速缓存之间的数据移动不是用单个字节,甚至字来完成的。相反,移动数据的最小单位称为「高速缓存线」(cache line),有时也称为「高速缓存块」(cache block)。一个典型的缓存行是64或128字节长,在科学计算中意味着8或16个双精度浮点数。移动到L2缓存的数据的缓存线大小可能比移动到L1缓存的数据大。

高速缓存线的第一个设计初衷是便于实际应用:它简化了所涉及的电路。由于许多代码显示出空间局部性,缓存线的存在有着非同寻常的意义。1.6.2章。

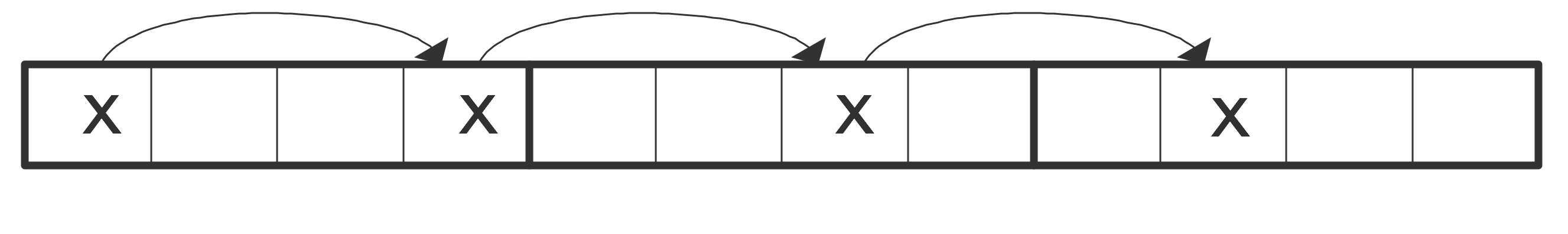

反之,我们现在需要利用数据的局部性编写高质量代码,因为任何内存访问都需要传输几个字符(参见1.7.4节中的一些例子)。在加载缓存线后,我们希望尽可能地使用一同加载进来的其他数据以实现高效利用资源,因为同一缓存线上的内容访实际上是自由且方便的。这种现象在通过「跨步访问」(stride access)数组的代码中是十分常见的:以规则的时间间隔读取或写入元素。

Stride 1 连续访问数组中的元素:

1 | for (i=0; i<N; i++) |

让我们用一个例子来说明:每个缓存线上有4个字。请求第一个元素将包含它的整个缓存线加载到缓存中。然后,对第2、3和4个元素的请求可以从缓存中得到满足,这意味着实现了高带宽和低延迟。

Stride 2 跨步访问数组中的元素:

1 | for (i=1; i<N; i+=stride) |

意味着在每个缓存线中只有某些元素被使用。我们用Stride = 3来说明这一点:第一个元素加载一个缓存线,该也包含第二个元素。然而,第三个元素在下一个缓存上,因此加载它会引起主内存的延迟和带宽。第四个元素也是如此。加载四个元素现在需要加载三条缓存线而不是一条,这意味着三分之二的可用带宽被浪费了。(如果没有注意到常规访问模式的硬件机制,并先发制人地加载进一步的缓存线,第二种情况也会导致三倍于第一种情况的延迟;见1.3.5)

有些应用程序自然会导致大于1的进步,例如,只访问一个复数数组的实数部分(关于复数实际实现的一些注释,请参阅3.7.6节)。另外,使用递归加倍的方法通常具有非单位步长的代码结构

1 | for (i=0; i<N/2; i++) |

在这个关于缓存线的讨论中,我们隐式地假设缓存线的开头也是一个单词的开头,不管是整数还是浮点数。实际情况中往往并非如此:一个8字节的浮点数可以放置在两个缓存线之间的边界上。可以想象,这将极大程度上影响程序性能。第37.1.3节讨论了实际中处理缓存线边界对齐的方法。

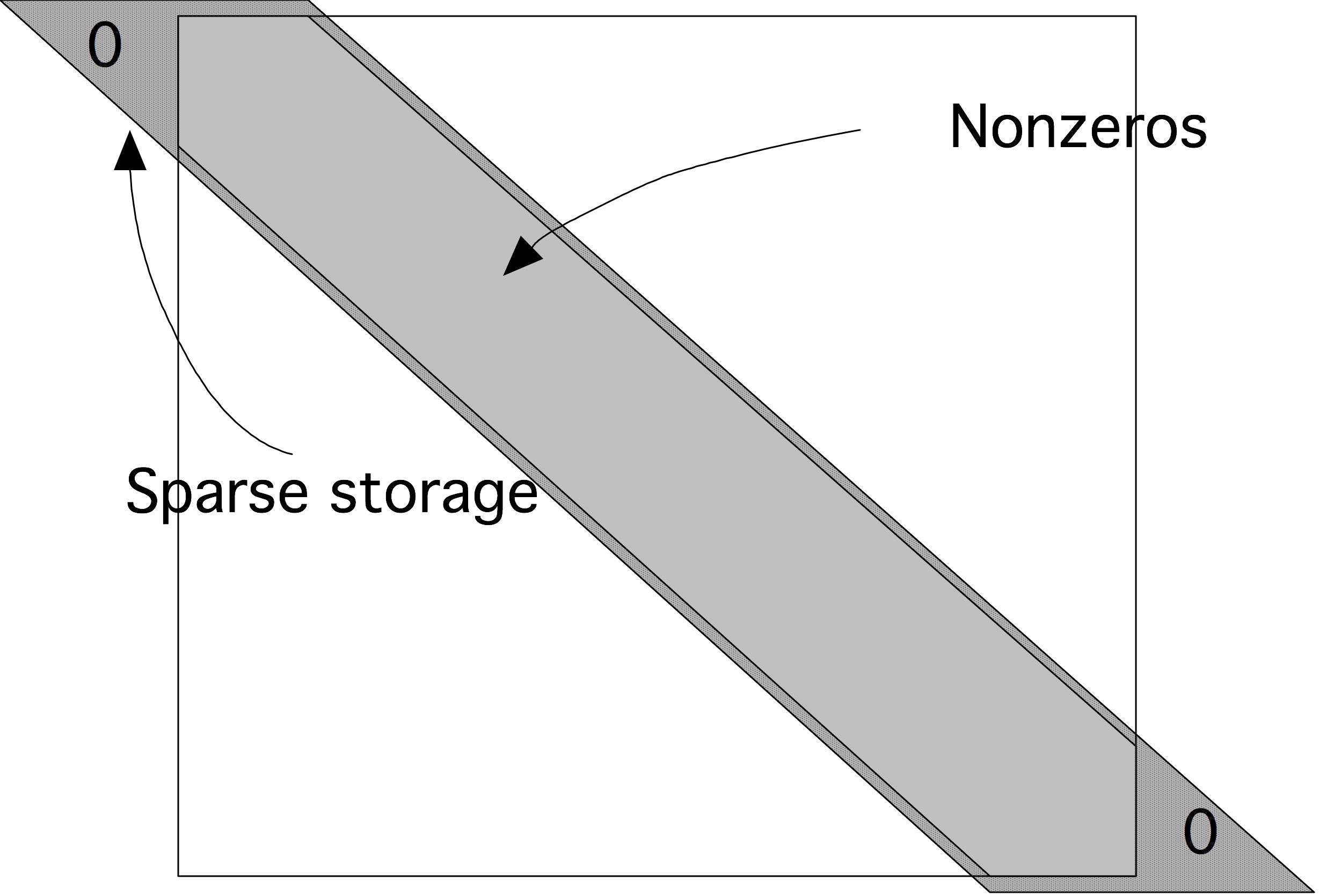

缓存映射

越接近FPU的缓存速度越快,其容量也更小。但即便最大的缓存也比内存容量小的多。在第1.3.4.6节中,我们已经讨论了如何做出保留哪些元素和替换哪些元素的决定。

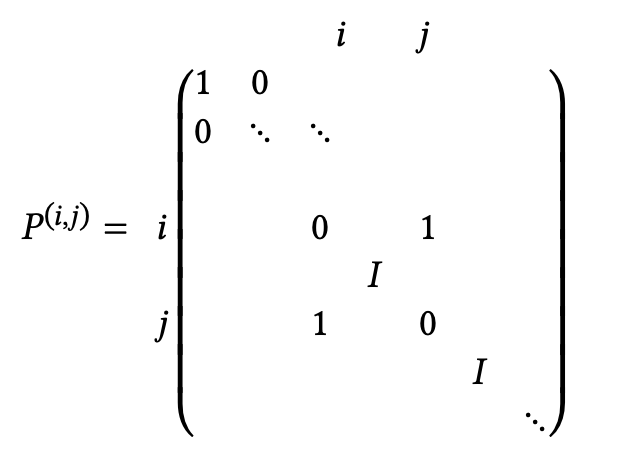

现在我们将讨论缓存映射的问题,也就是“如果一个条目被放在缓存中,它会被放在哪里”的问题。这个问题通常是通过将项目的(主存)地址映射到缓存中的地址来解决的,这就导致了“如果两个项目映射到同一个地址会怎么样”的问题。

直接映射缓存

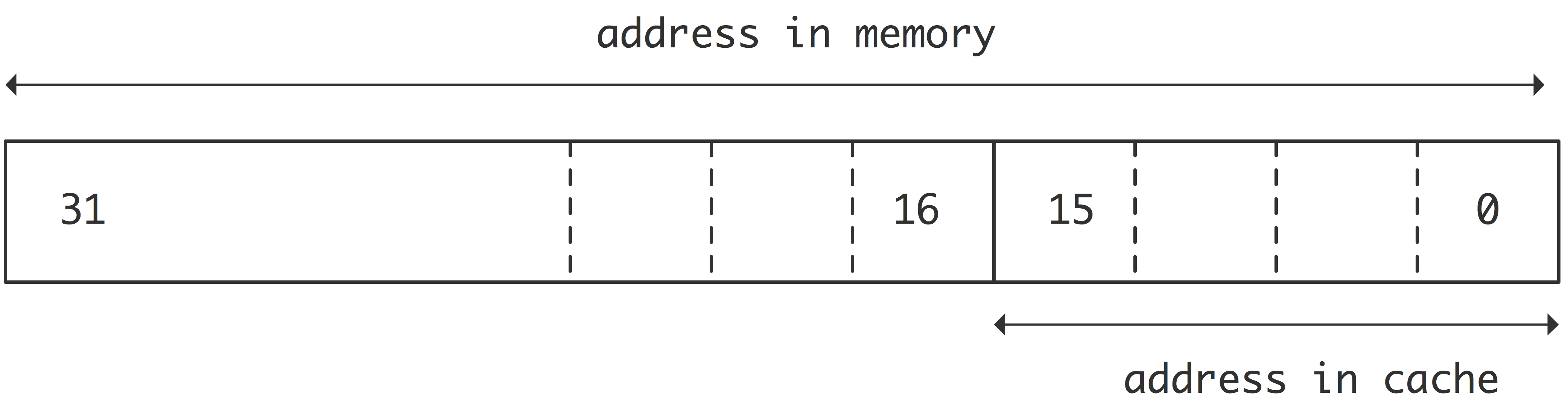

最简单的缓存映射策略是「直接映射」(direct mapping)。假设内存地址是32位长,因此它们可以寻址4G字节;进一步假设缓存有8K个字,也就是64K字节,需要16位来寻址。直接映射从每个内存地址取最后(“最低有效”)16位,并使用这些作为缓存中的数据项的地址;参见图1.8。

直接映射的效率非常高,因为它的地址计算速度非常快,导致了较低的延迟,但在实际应用中存在一个问题。如果两个被8K字分隔的条目被寻址,它们将被映射到相同的缓存位置,这将使某些计算效率低下。例子:

1 | double A[3][8192]; |

或在Fortran中:

1 | real*8 A(8192,3); |

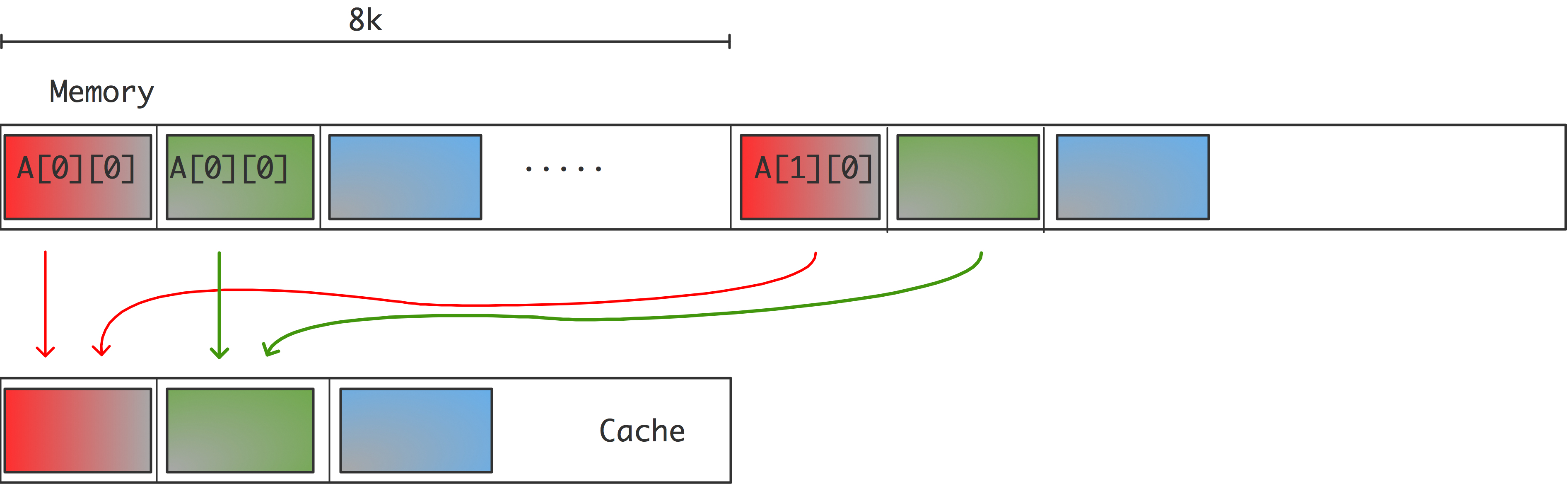

此处,$[0] [i]$,$[1] [i]$和$[2] [i]$ (或者$a(i,1)$,$a(i,2)$,$a(i,3)$)的位置对于每个$i$来说是8K的,所以它们地址的最后16位是相同的,因此它们将被映射到缓存中的相同位置;参见图1.9。

现在,循环的执行情况将如下:

- $a [0] [0]$处的数据被带入高速缓存和寄存器中,这产生了一定的延时。和这个元素一起,整个高速缓存行被转移。

- 在$[1] [0]$处的数据被带入缓存(和寄存器中),连同其整个缓存行,以一些延迟为代价。由于这个缓存行和第一个缓存行被映射到相同的位置,所以第一个缓存行被覆盖。

- 为了写入输出,包含$a[2] [0]$的缓存行被带入内存。这又被映射到同一位置,导致刚刚加载的$a[1] [0]$的缓存行被刷新。

- 在下一次迭代中,需要$a[0] [1]$,它和$a[0] [0]$在同一个缓存行。然而,这个缓存行已经被刷新了,所以它需要从主内存或更深的缓存层中被重新带入。在这样做的时候,它覆盖了保存$a[2] [0]$的缓存行。

- $a[1] [1]$的情况类似:它在$a[1] [0]$的缓存行上,不幸的是,它已经被上一步覆盖了。

如果一个缓存行有四个字,我们可以看到,循环的每四次迭代都涉及到八个$a$元素的传输的元素,而如果不是因为缓存冲突,两个元素就足够了。

练习 1.8 在直接映射高速缓存的例子中,从内存到高速缓存的映射是通过使用32位内存地址的最后16位作为高速缓存地址完成的。如果使用前16位(”最有意义的”)作为缓冲区地址,那么这个例子中的问题就会消失。为什么在一般情况下这不是一个好的解决方案?

注释5:到目前为止,我们一直假装缓存是基于虚拟内存地址的。实际上,缓存是基于内存中数据的物理地址,这取决于将虚拟地址映射到内存页的算法。

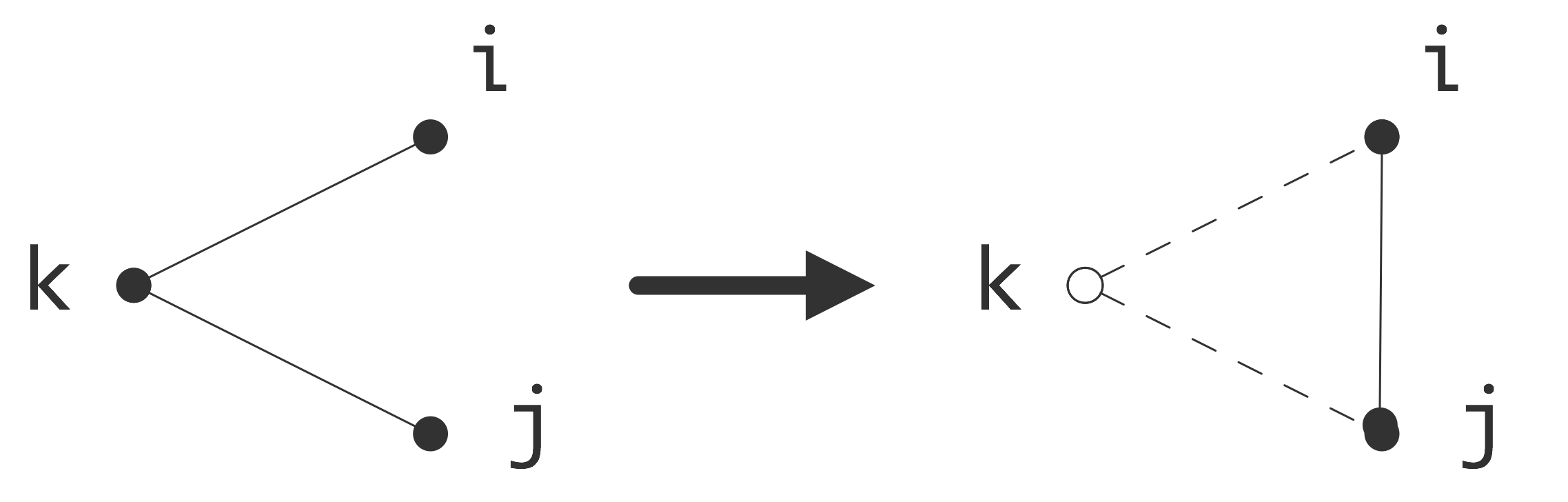

关联式缓存

如果任何数据项目都可以进入任何缓存位置,那么上一节中概述的缓存冲突问题就会得到解决。在这种情况下,除了缓存被填满之外,不会有任何冲突,在这种情况下,缓存替换策略(第1.3.4.6节)会刷新数据,为新来的项目腾出空间。这样的缓存被称为「全关联映射」(fully associative mapping)的,虽然它看起来是最好的,但它的构建成本很高,而且在使用中比直接映射的缓存慢得多。

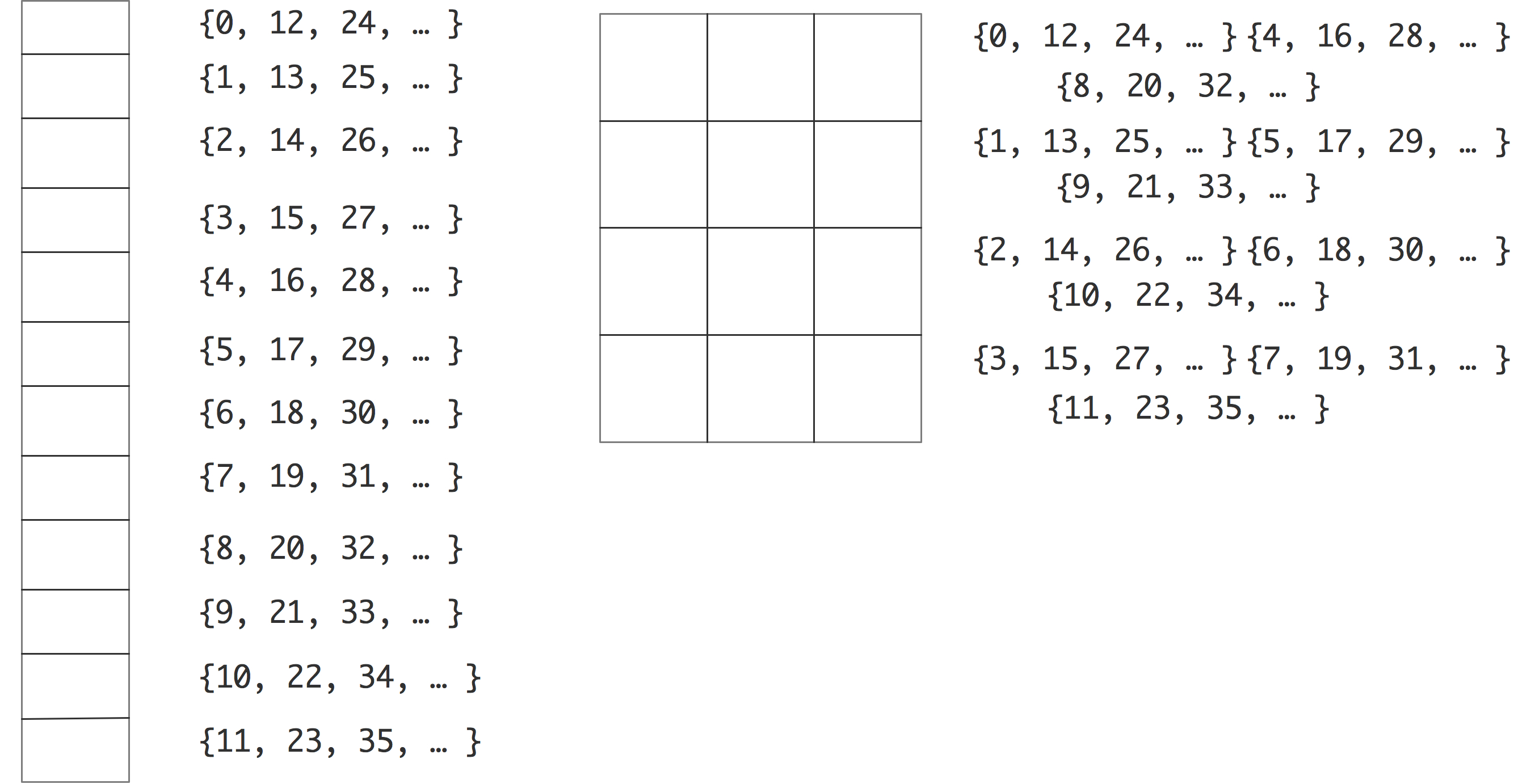

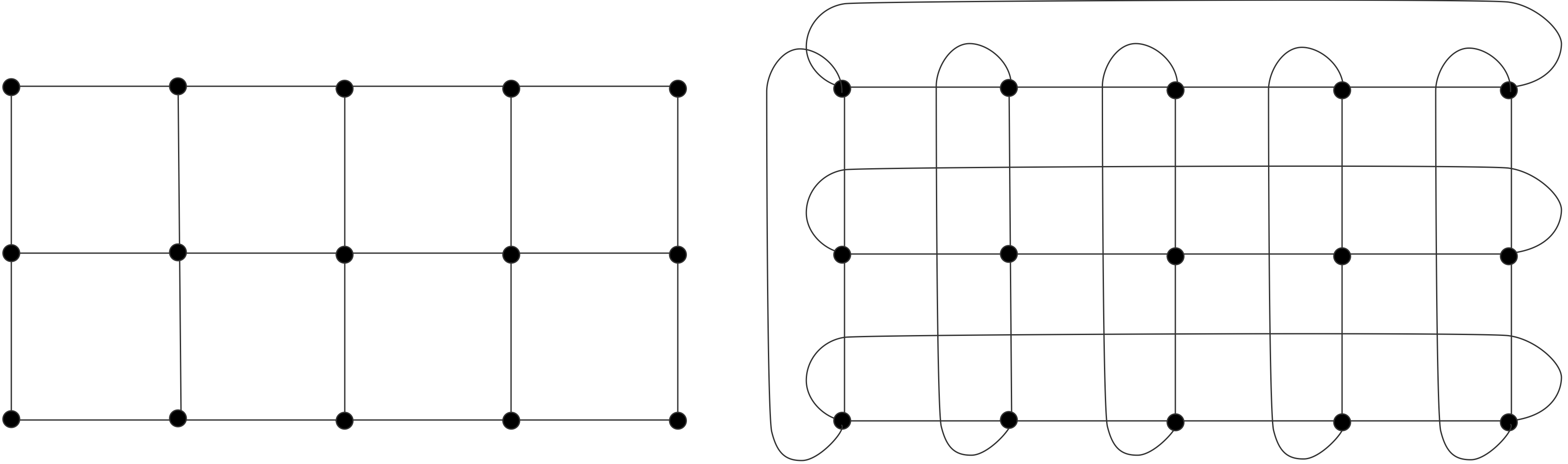

正因如此,最常见的解决方案是建立一个「k-路关联缓存」($𝑘$-way associative mapping),其中$𝑘$至少是两个。在这种情况下,一个数据项可以进入任何一个$𝑘$缓存位置。代码必须要有$𝑘+1$路冲突,才会像上面的例子那样过早地刷新数据。在这个例子中,$𝑘=2$的值就足够了,但在实践中经常会遇到更高的值。图1.10展示了一个直接映射的和一个三向关联的缓冲区的内存地址与缓冲区位置的映射情况。两个缓冲区都有12个元素,但是它们的使用方式不同。直接映射的高速缓存(左边)在内存地址0和12之间会有冲突,但是在三向关联高速缓存中,这两个地址可以被映射到三个元素中的任何一个。

作为一个实际的例子,英特尔Woodcrest处理器有一个32K字节的L1缓存,它是8路设置的关联性,缓存行大小为64字节,L2缓存为4M字节,是8路设置的关联性,缓存行大小为64字节。另一方面,AMD Barcelona芯片的L1缓存是2路关联,L2缓存是8路关联。更高路关联性显然是可取的,但是会使处理器变得更慢,因为确定一个地址是否已经在缓存中变得更加复杂。由于这个原因,在速度最重要的地方,L1高速缓存的关联性通常比L2低。

练习 1.9 用你喜欢的语言写一个小型的高速缓存模拟器。假设一个有32个条目的$k$方式的同构缓存和一个16位地址的架构。对$𝑘=1, 2, 4, …$进行以下实验。

让$k$模拟高速缓存的关联性。

写下从16位内存地址到32/𝑘缓存地址的转换。

生成32个随机机器地址,并模拟将其存储在缓存中。

由于高速缓存有32个条目,最佳情况下这32个地址都可以存储在高速缓存中。这种情况实际发生的几率很小,往往一个地址的数据会在另一个地址与之冲突时被驱逐出缓存(意味着它被覆盖)。记录在模拟结束时,32个地址中,有多少地址被实际存储在缓存中。将步骤3做100次,并绘制结果;给出中位数和平均值,以及标准偏差。观察一下,增加关联性可以提高存储地址的数量。其极限行为是什么?(为了获得奖励,请做一个正式的统计分析)

缓存内存与普通内存的对比

那么,缓冲存储器有什么特别之处;为什么我们不把它的技术用于所有的存储器?

缓存通常由静态随机存取存储器(SRAM)组成,它比用于主存储器的动态随机存取存储器(DRAM)更快,但也更昂贵,每一位需要5-6个晶体管,而不是一个,而且耗电量更大。

加载与存储

在上述描述中,在程序中访问的所有数据都需要在使用这些数据的指令执行之前被移入高速缓存。这对读取的数据和写入的数据都适用。然而,已经写入的数据,如果不再需要(在一定的合理时间内),就没有理由留在缓存中,可能会产生冲突或驱逐仍然可以重复使用的数据。出于这个原因,编译器通常支持流式存储:一个纯粹输出的连续数据流将被直接写入内存,而不被缓存。

预取流

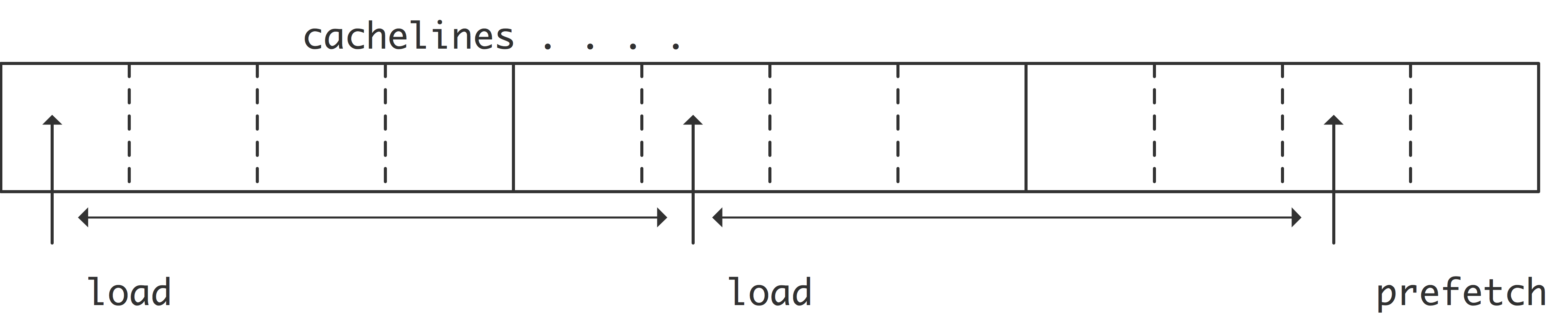

在传统的冯·诺依曼模型中(第1.1节),每条指令都包含其操作数的位置,所以实现这种模型的CPU会对每个新的操作数进行单独请求。在实践中,往往后续的数据项在内存中是相邻的或有规律的间隔。内存系统可以通过查看高速缓存的数据模式来检测这种数据模式,并请求「预取数据流」(prefetch data stream);

在最简单的形式下,CPU会检测到来自两个连续的高速缓存行的连续加载,并自动发出对接下来的高速缓存行的请求。如果代码对第三条高速缓存线发出实际请求,这个过程可以重复或扩展。由于这些高速缓存行现在是在需要提前从内存中取出,所以预取有可能消除除前几个数据项之外的所有延迟。

现在我们需要重新审视一下缓存失效的概念。从性能的角度来看,我们只对缓存失效的停顿感兴趣,也就是说,在这种情况下,计算必须等待数据被带入。不在缓存中的数据,但在其他指令还在处理的时候可以被带入,这不是一个问题。如果 “L1缺失 “被理解为只是 “缺失时的停顿”,那么术语 “L1缓存重新填充 “被用来描述所有的缓存线负载,无论处理器是否在它们上面停顿。

由于预取是由硬件控制的,所以它也被描述为「硬件预取」(hardware prefetch)。预取流有时可以从软件中控制,例如通过「源语」(intrinsic)。

由程序员引入预取是对一些因素的谨慎平衡[94]。其中最重要的是预取距离:从预取开始到需要数据时的周期数。在实践中,这通常是一个循环的迭代次数:预取指令请求未来迭代的数据。

并发和内存传输

在关于内存层次的讨论中,我们提出了一个观点:内存比处理器慢。如果这还不够糟糕的话,利用内存提供的所有带宽甚至不是小事。换句话说,如果你不仔细编程,你会得到比你根据可用带宽所期望的更少的性能。让我们来分析一下。

内存系统的带宽通常为每周期一个以上的浮点数,所以你需要每周期发出那么多请求来利用可用的带宽。即使在零延迟的情况下也是如此;由于存在延迟,数据从内存中出来并被处理需要一段时间。因此,任何基于第一个数据的计算而请求的数据都必须在延迟至少等于内存延迟的情况下请求。

为了充分利用带宽,在任何时候都必须有相当于带宽乘以延迟的数据量在运行。由于这些数据必须是独立的,我们得到了 「Little 定律」[147]。

这在图1.12中得到了说明。维护这种并发性的问题并不是程序没有这种并发性,而是程序要让编译器和运行时系统识别它。例如,如果一个循环遍历了一个长的数组,编译器就不会发出大量的内存请求。预取机制(1.3.5节)会提前发出一些内存请求,但通常不够。因此,为了使用可用的带宽,多个数据流需要同时进行。因此,我们也可以将 「Little 定律」表述为

内存bank

上面,我们讨论了与带宽有关的问题。你看到内存,以及在较小程度上的缓存,其带宽低于处理器可以最大限度地吸收的带宽。这种情况实际上比上面的讨论看起来还要糟糕。由于这个原因,内存通常被分为交错的内存组:在四个内存组中,字0、4、8…在0组,字1、5、9…在1组,依此类推。

假设我们现在按顺序访问内存,那么这样的4路交错式内存可以维持4倍于单个内存组的带宽。不幸的是,按跨度2访问将使带宽减半,而更大的跨度则更糟糕。如果两个连续的操作访问同一个内存bank,我们就会说到内存bank冲突[7]。在实践中,内存库的数量会更多,因此,小跨度的内存访问仍然会有完整的广告带宽。例如,Cray-1有16个banks,而Cray-2有1024个。

练习 1.10 证明在有质数的bank时,任何达到该质数的跨步都是无冲突的。你认为为什么这个解决方案没有在实际的内存架构中被采用?

在现代处理器中,DRAM仍然有bank,但由于有缓存的存在,其影响较小。然而,GPU有内存组,没有缓存,所以它们遭受了与老式超级计算机相同的一些问题。

练习 1.11 对一个数组的元素进行求和的递归加倍算法是

1 | for (s=2; s<2*n; s*=2) |

分析该算法的bank冲突。假设$𝑛=2^p$,bank有$2^k$元素,其中$𝑘 < 𝑝$。同时考虑到这是一个并行算法,内循环的所有迭代都是独立的,因此可以同时进行。另外,我们可以使用递归减半法

1 | for (s=(n+1)/2; s>1; s/=2) |

再次分析,bank的混乱情况。这种算法更好吗?在并行情况下呢?

缓存存储器也可以使用bank。例如,AMD巴塞罗那芯片的L1缓存中的缓存线是16个字,分为两个8个字的交错库。这意味着对高速缓存线的元素进行顺序访问是有效的,但串联访问的性能就会下降。

TLB、页和虚拟内存

一个程序的所有数据可能不会同时出现在内存中。这种情况可能由于一些原因而发生:

- 计算机为多个用户服务,所以内存并不专门用于任何一个用户。

- 计算机正在运行多个程序,这些程序加起来需要的内存超过了物理上可用的内存。

- 一个单一的程序所使用的数据可能超过可用的内存。

基于这些原因,计算机使用虚拟内存:如果需要的内存比可用的多,某些内存块会被写入磁盘。实际上,磁盘充当了真实内存的延伸。这意味着一个数据块可以出现在内存的任何地方,事实上,如果它被换入和换出,它可以在不同时间出现在不同位置。交换不是作用于单个内存位置,而是作用于内存页:连续的内存块,大小从几千字节到几兆字节。(在早期的操作系统中,将内存移至磁盘是程序员的责任。互相替换的内存页被称为覆盖层)

由于这个原因,我们需要一个从程序使用的内存地址到内存中实际地址的翻译机制,而且这种翻译必须是动态的。一个程序有一个 “逻辑数据空间”(通常从地址0开始),是编译后的代码中使用的地址,在程序执行过程中需要将其翻译成实际的内存地址。出于这个原因,有一个页表,指定哪些内存页包含哪些逻辑页。

大页

在非常不规则的应用中,例如数据库,页表会变得非常大,因为更多或更少的随机数据被带入内存。然而,有时这些页面显示出某种程度的集群,这意味着如果页面大小更大,需要的页面数量将大大减少。由于这个原因,操作系统可以支持大的页面,通常大小为2Mb左右。(有时会使用’巨大的页面’;例如,英特尔Knights Landing有Gigabyte页面)

大页面的好处取决于应用:如果小页面没有足够的集群,使用大页面可能会使内存过早地被大页面的未使用部分填满。

TLB

然而,通过查找该表进行地址转换是很慢的,所以CPU有一个「转译后备缓冲器」(Translation Look-aside Buffer,TLB)。TLB是一个经常使用的页表项的缓存:它为一些页提供快速的地址转换。如果一个程序需要一个内存位置,就会查询TLB,看这个位置是否真的在TLB所记忆的页面上。如果是这样,逻辑地址就被翻译成物理地址;这是一个非常快速的过程。在TLB中没有记住该页的情况被称为TLB缺失,然后查询页面查找表,如果有必要,将需要的页面带入内存。TLB是(有时是完全)关联的(1.3.4.10节),使用LRU策略(1.3.4.6节)。

一个典型的TLB有64到512个条目。如果一个程序按顺序访问数据,它通常只在几个页面之间交替进行,而且不会出现TLB缺失。另一方面,一个访问许多随机内存位置的程序可能会因为这种错过而出现速度下降。目前正在使用的页面集被称为 “工作集”。

第1.7.5节和附录37.5讨论了一些简单的代码来说明TLB的行为。

[这个故事有一些复杂的情况。例如,通常有一个以上的TLB。第一个与L2缓存相关,第二个与L1相关。在AMD Opteron中,L1 TLB有48个条目,并且是完全(48路)关联的,而L2 TLB有512个条目,但只是4路关联的。这意味着实际上可能存在TLB冲突。在上面的讨论中,我们只谈到了L2 TLB。之所以能与L2缓存而不是主内存相关联,是因为从内存到L2缓存的转换是确定性的]。

使用大页也可以减少潜在的TLB缺失次数,因为可以减少工作页的集合。

单处理器计算(二)

多核架构

近年来,传统的处理器芯片设计已经达到了性能的极限。主要由于

- 主频已经不能再增加,因为这会增大功耗,使芯片发热过大;见1.8.1节。

- 从代码中提取更多的指令级并行(ILP)变得困难,要么是由于编译器的限制,要么是由于内在可用的并行量有限,要么是由于分支预测使之无法实现(见1.2.5节)。

从单个处理器芯片中获得更高的利用率的方法之一是,从进一步完善单个处理器的策略,转向将芯片划分为多个处理 “核心”。这些独立的内核可以在不相关的任务上工作,或者通过引入数据的并行性(第2.3.1节),以更高的整体效率协作完成一个共同的任务[163]。

注释6 另一个解决方案是英特尔的超线程,它可以让一个处理器混合几个指令流的指令。这方面的好处在很大程度上取决于具体情况。然而,这种机制在GPU中也得到了很好的利用,见2.9.3节。讨论见2.6.1.9节。

这就解决了上述两个问题:

- 两个主频较低的内核可以拥有与主频较高的单个处理器相同的吞吐量;因此,多个内核的能效更高。

- 指令级并行现在被明确的任务并行化所取代,由程序员管理。

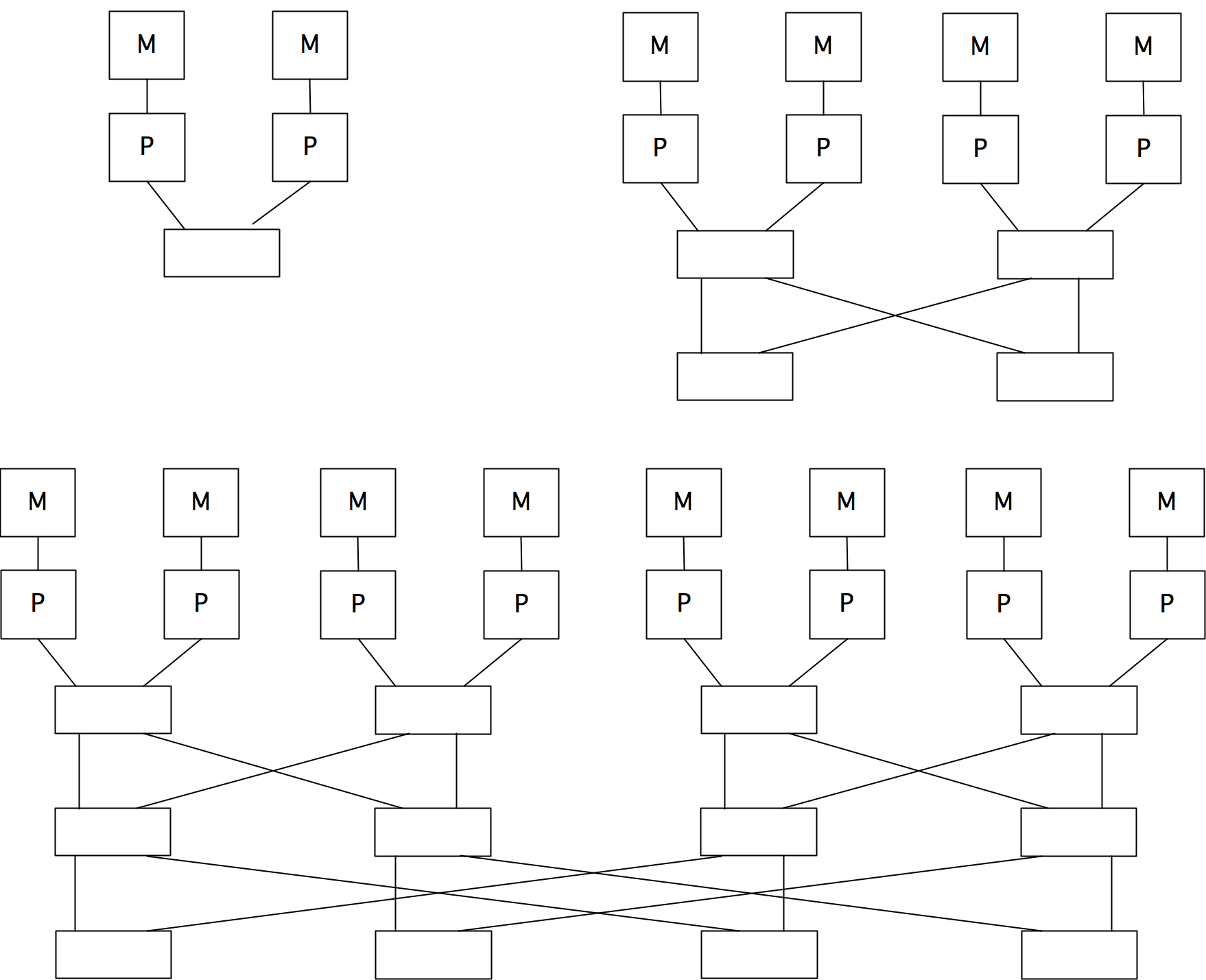

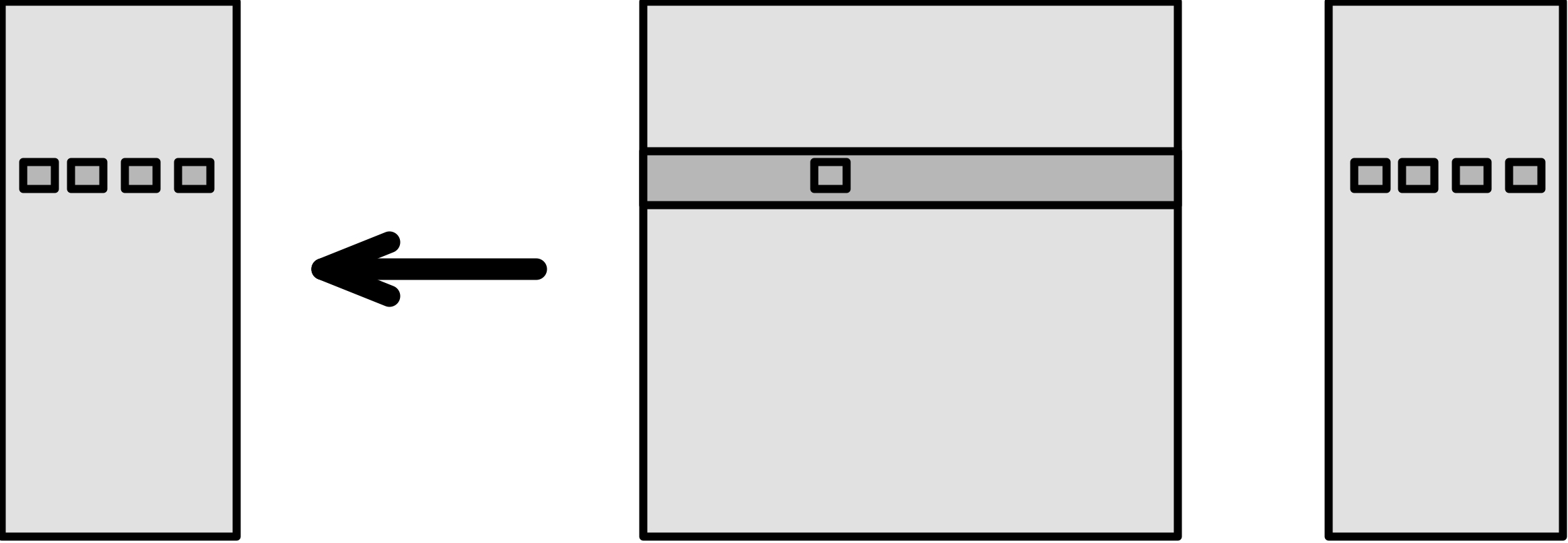

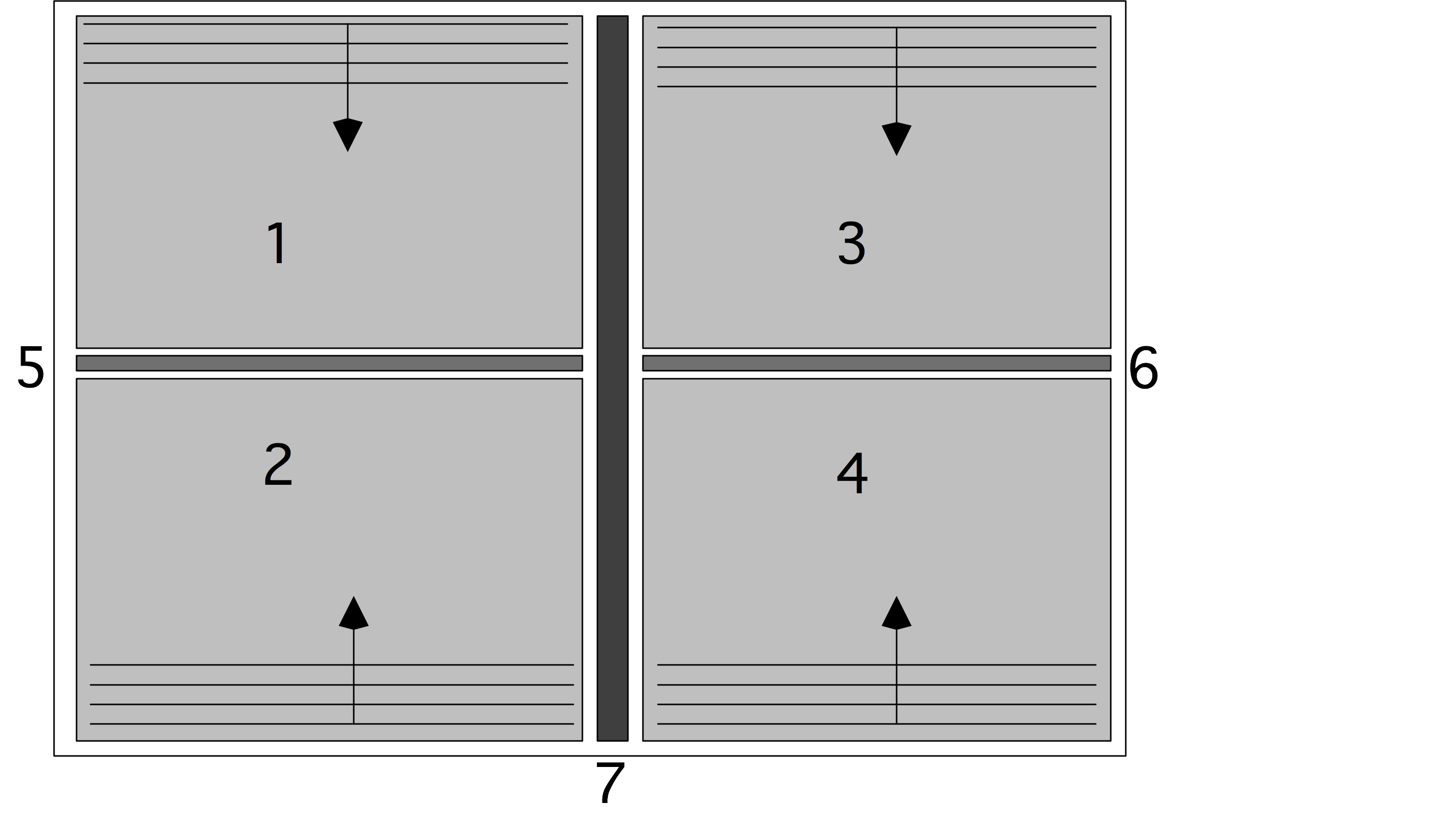

虽然第一代多核CPU只是在同一个芯片上的两个处理器,但后来的几代CPU都加入了L3或L2缓存,在两个处理器核心之间共享;见图1.13。

L3或L2缓存,在两个处理器内核之间共享;见图1.13,这种设计使内核能够有效地联合处理同一问题。内核仍然会有自己的L1高速缓存。

而这些独立的高速缓存造成了高速缓存的一致性问题;见下面1.4.1节。

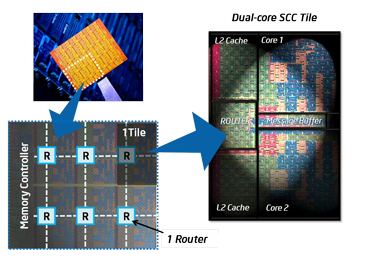

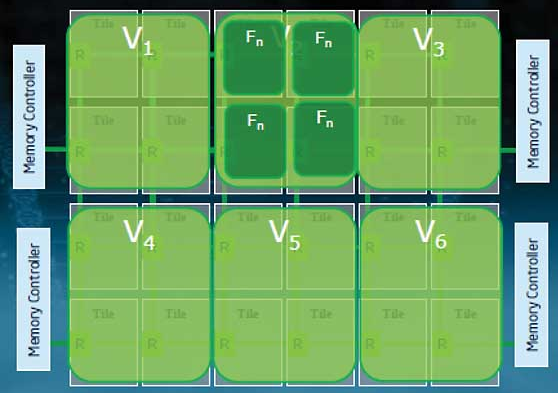

我们注意到,”处理器 “这个词现在是模糊的:它可以指芯片,也可以指芯片上的处理器核心。由于这个原因,我们大多谈论的是整个芯片的「插槽」(socket)和包含一个算术和逻辑单元并有自己的寄存器的部分的核心(core)。目前,具有4或6个内核的CPU很常见,甚至在笔记本电脑中也是如此,英特尔和AMD正在销售12个内核的芯片。核心数量在未来可能会上升。英特尔已经展示了一个80核的原型,它被开发成48核的 “单芯片云计算机”,如图1.14所示。这个芯片的结构有24个双核 “瓦片”,通过一个二维网状网络连接。只有某些瓦片与内存控制器相连,其他的瓦片除了通过片上网络外,无法到达内存。

通过这种共享和私有缓存的混合,多核处理器的编程模型正在成为共享和分布式内存的混合体。

核心(Core):各个内核都有自己的私有L1缓存,这是一种分布式内存。上面提到的英特尔80核原型,其核心以分布式内存的方式进行通信。

插槽(Socket):在一个插座上,通常有一个共享的二级缓存,这是内核的共享内存。

节点(Node):在一个 “节点 “或主板上可以有多个插座,访问同一个共享内存。

网络(Network):需要分布式内存编程(见下一章)来让节点进行通信。

从历史上看,多核结构在多处理器共享内存设计中已有先例(第2.4.1节),如Sequent Symmetry和Alliant FX/8。从概念上讲,程序模型是相同的,但现在的技术允许将多处理器板缩小到多核芯片上。

缓存一致性

在并行处理中,如果一个以上的处理器拥有同一个数据项的副本,就有可能发生冲突失效。确保所有的缓存数据都是主内存的准确副本,这个问题被称为「缓存一致性」(cache coherence):如果一个处理器改变了它的副本,则另一个副本也需要更新。

在分布式内存架构中,数据集通常在处理器上被不连续地分割,所以只有在用户知道的情况下才会出现数据的冲突副本,而处理这个问题则是由用户决定的。共享内存的情况更微妙:由于进程访问相同的主内存,似乎冲突实际上是不可能的。然而,处理器通常有一些私有缓存,包含来自内存的数据副本,所以冲突失效的副本可能发生。这种情况特别出现在多核设计中。

假设两个核在它们的(私有)L1高速缓存中有一个相同数据的副本,其中一个修改了它的副本。现在另一个核心的缓存数据不再是其对应的准确副本:处理器将使该项目副本失效,事实上也是其整个缓存线失效。当该进程需要再次访问该项目时,它需要重新加载该缓存线。另一种方法是,任何改变数据的内核都要将该缓存线发送给其他内核。这个策略的开销可能更大,因为其他内核不可能有一个缓存线的副本。

这个更新或废止缓存线的过程被称为「维护缓存一致性」(maintaining cache coherence),它是在处理器的一个非常低的层次上完成的,不需要程序员参与。(这使得更新内存位置成为一个原子操作;关于这一点,请看2.6.1.5节)。然而,这将减慢计算速度,并且浪费了核心的带宽,而这些带宽本来是可以用来加载或存储操作数的。

缓存行相对于主存中的数据项的状态通常被描述为以下几种情况之一。

Scratch:缓存行不包含该项目副本。

Valid:缓存行是主内存中数据的正确拷贝。

Reserved:缓存行是该数据的唯一副本。

- Dirty:缓存行已被修改,但尚未写回主内存。

- Invalid:缓存线上的数据在其他处理器上也存在(它没有被保留),并且另一个进程修改了它的数据副本。

一个更简单的变体是修改后的共享无效(MSI)一致性协议,在一个给定的核心上,一个缓存线可以处于以下状态。

- Modified:缓存线已经被修改,需要写到备份仓库。这个写法可以在行被驱逐时进行,也可以立即进行,取决于回写策略。

- Shared:该行至少存在于一个缓存中且未被修改。

- Invalid:该行在当前缓存中不存在,或者它存在但在另一个缓存中的副本已被修改。

这些状态控制着高速缓存线在内存和高速缓存之间的移动。例如,假设一个核对一个缓存线进行读取,而这个缓存线在该核上是无效的。然后,它可以从内存中加载它,或者从另一个高速缓存中获取它,这可能更快。(找出一个行是否存在于另一个缓冲区(状态为M或S)被称为「监听」(snooping);另一种方法是维护「标签目录」(tag directory;见下文)。如果该行是共享的,现在可以简单地复制;如果它在另一个高速缓存中处于M状态,该核心首先需要把它写回内存。

练习 1.12 考虑两个处理器,内存中的一个数据项 $x$,以及这两个处理器的私有缓存中的缓存线$x_1,x_2$,这两个缓存线被映射到这两个处理器。描述在两个处理器上读写 $x_1$ 和 $x_2$ 的状态之间的转换。同时指出哪些行为会导致内存带宽被使用。(这个过渡列表是一个有限状态自动机(FSA),见第19节)。

MSI协议的变种增加了一个 “独占 “或 “拥有 “状态,以提高工作效率。

缓存一致性的解决方案

有两种实现缓存一致性的基本机制:「监听」(snooping)和基于「标签目录」(tag directory)的方案。

在监听机制中,任何对数据的请求都会被发送到所有的缓冲区,如果数据存在于任何地方,就会被返回;否则就会从内存中检索。这个方案的一个变形为,一个核心 “监听 “所有的总线流量,这样当另一个核心修改它的拷贝时,它就可以使自己的缓存线拷贝失效或更新。缓存失效比更新的代价要小,因为它是一个位操作,而更新涉及到复制整个高速缓存线。

练习 1.13 什么条件下更新才是更优方案?写一个简单的缓存模拟器来评估这个问题。

由于监听通常涉及到向所有核心广播信息,所以它的规模不能超过最少的核心数量。一个可以更好地扩展的解决方案是使用一个标签目录:一个中央目录,它包含了一些缓存中存在的数据的信息,以及具体在哪个缓存中。对于拥有大量内核的处理器(如英特尔Xeon Phi),该目录可以分布在各个内核上。

伪共享

如果内核访问不同的项目,就可能会出现缓存一致性问题。例如,

1 | double x,y; |

可能会在内存中紧挨着分配 $x$ 和 $y$,所以它们很有可能落在同一个缓存线上。现在,如果一个核心更新 $x$,另一个更新 $y$,这个缓存线就会在核心之间不断移动。这就是所谓的「伪共享」(false sharing)。

最常见的错误共享情况发生在线程更新一个数组的连续位置时。例如,在下面的OpenMP片段中,所有线程都在更新自己在部分结果数组中的位置。

1 | local_results = new double[num_threads]; |

虽然没有实际的竞争条件(如果线程都更新global_result变量就会有),但这段代码的性能会很低,因为带有local_result数组的缓存线会不断被废止。

标签目录

在具有分布式但连贯的缓存的多核处理器中(如英特尔Xeon Phi),标签目录本身也可以是分布式的。这增加了缓存查找的延迟。

在多核芯片上进行计算

多核处理器可以通过各种方式提高性能。首先,在桌面情况下,多个内核实际上可以运行多个程序。更重要的是,我们可以利用并行性来加快单个代码的执行速度。这可以通过两种不同的方式实现。

MPI库(2.6.3.3节)通常用于通过网络连接的处理器之间的通信。然而,它也可以在单个多核处理器中使用:然后通过共享内存拷贝实现MPI调用。

另外,我们可以使用共享内存和共享缓存,并使用线程系统,如OpenMP(第2.6.2节)进行编程。这种模式的优点是并行性可以更加动态,因为运行时系统可以在程序运行过程中设置和改变线程和内核之间的对应关系。

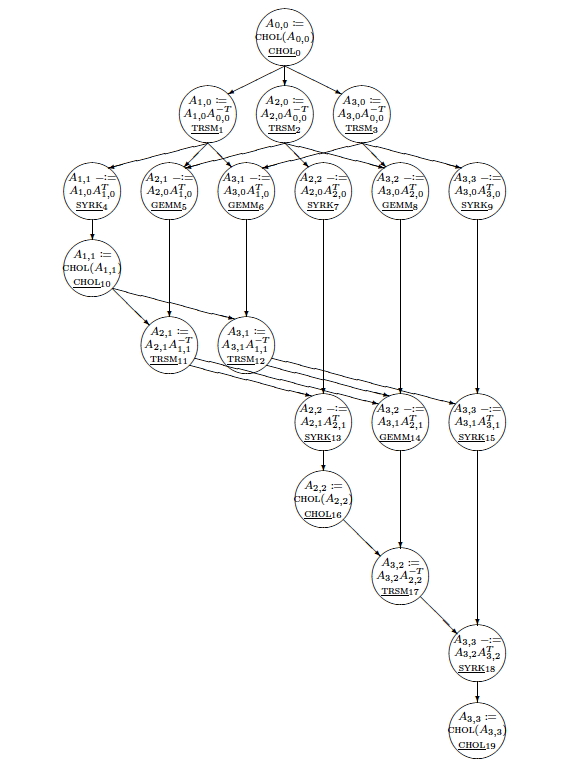

我们将比较详细地讨论多核芯片上线性代数操作的调度;第6.12节。

TLB shootdown

第1.3.8.2节解释了TLB是如何用于缓存从逻辑地址,也就是逻辑页到物理页的转换。TLB是插槽内存单元的一部分,所以在多插槽设计中,一个插槽上的进程有可能改变页面映射,这使得其他插槽的映射不正确。

解决这个问题的一个办法叫做TLB shootdown:改变映射的进程会产生一个处理器间中断,从而导致其他处理器重建他们的TLB。

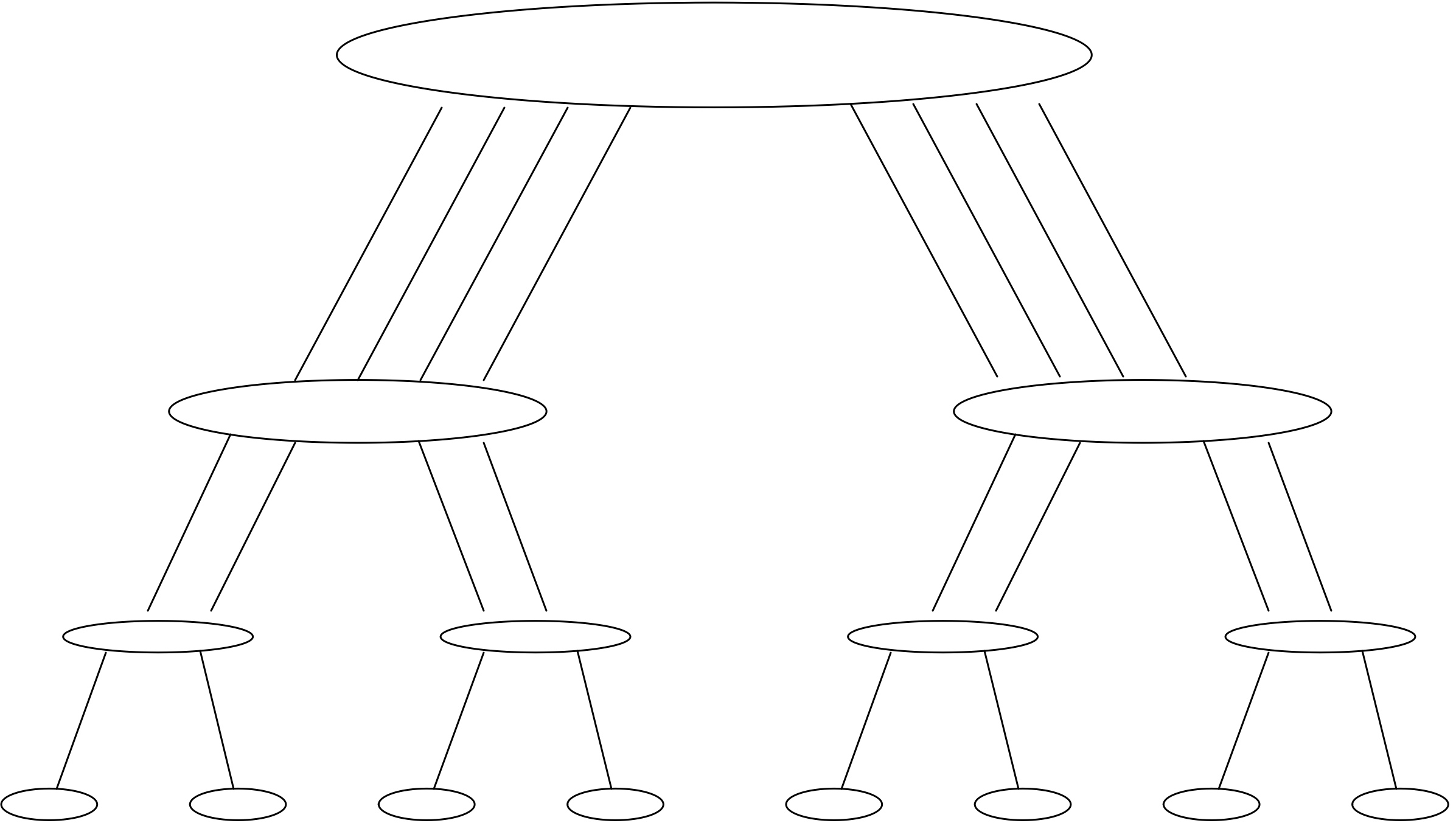

节点架构和插槽

在前面的章节中,我们已经通过内存层次结构,访问了寄存器和各种缓存级别,以及它们可以被私有或共享的程度。在内存层次结构的最底层是所有内核共享的内存。它的范围从低级别的笔记本电脑的几千兆字节到一些超级计算机中心的几兆字节。

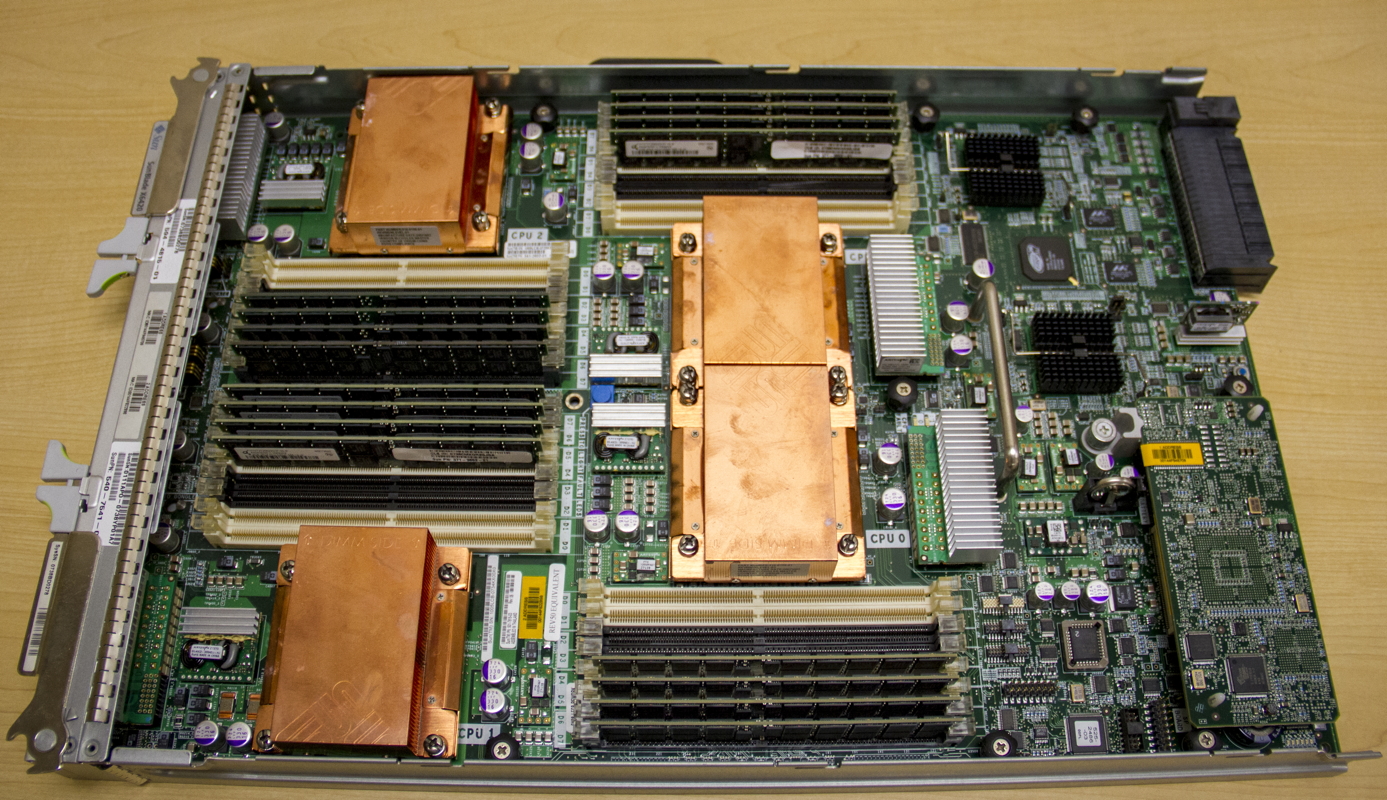

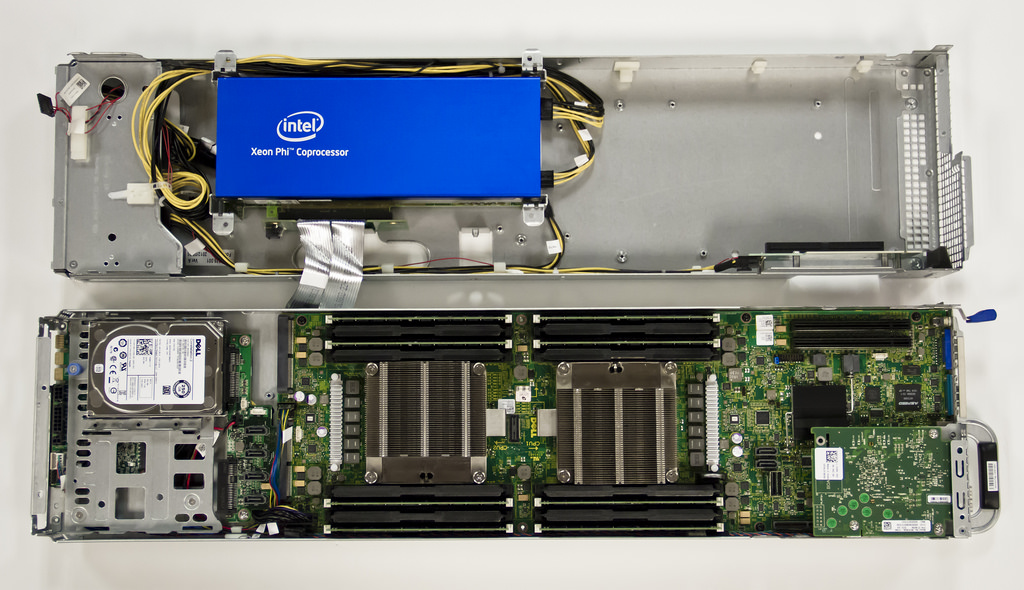

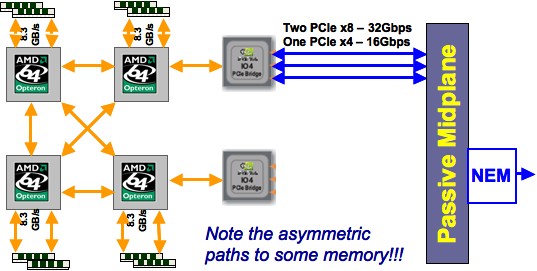

虽然这个内存是在所有核心之间共享的,但它有一些结构。这源于一个事实,即集群节点可以有一个以上的插槽,即处理器芯片。节点上的共享内存通常分布在直接连接到一个特定插槽的库中。例如,图1.15显示了TACC Ranger集群超级计算机(已停产)的四插槽节点和TACC Stampede集群超级计算机的两插槽节点,后者包含一个英特尔至强Phi协处理器。在这两个设计中,你可以清楚地看到直接连接到插槽上的内存芯片。

这是一个「非一致内存访问」(Non-Uniform Memory Access,NUMA)架构的例子:对于在某个核心上运行的进程,连接到其插槽上的内存比连接到另一个插座上的内存访问速度略快。

这方面的一个结果就是First-touch现象。动态分配的内存在第一次被写入之前实际上并没有被分配。现在考虑下面的OpenMP(2.6.2节)代码。

1 | double *array = (double*)malloc(N*sizeof(double)); |

由于First-touch,数组被完全分配到插槽的主线程内存上。在随后的并行循环中,其他插槽的核心将对它们操作的内存有较慢的访问。

这里的解决方案是将初始化循环也做成并行的,即使其中的工作量几乎可以忽略不计。

局部性和数据复用

算法的执行不仅包含计算操作,也包含数据传输部分,事实上,数据传输可能是影响算法效率的主要因素。由于缓存和寄存器的存在,数据传输量可以通过编程的方式最小化,使数据尽可能地留在处理器附近。这部分是一个巧妙编程的问题,但我们也可以看看理论上的问题:算法是否一开始就允许这样做。

事实证明,在科学计算中,数据往往主要与在某种意义上靠近的数据互动,这将导致数据的局部性;1.6.2节。通常这种局部性来自于应用的性质,就像第四章看到的PDEs的情况。在其他情况下,如分子动力学(第7章),没有这种内在的局部性,因为所有的粒子都与其他粒子相互作用,为了获得高性能,需要相当的编程技巧。

数据复用和计算密度

在前面的章节中,我们了解到处理器的设计有些不平衡:加载数据比执行实际操作要慢。这种不平衡对于主存储器来说是很大的,而对于各种高速缓存级别来说则较小。因此,我们有动力将数据保存在高速缓存中,并尽可能地保持数据的复用量。

当然,我们首先需要确定计算是否允许数据被重复使用。为此,我们定义了一个算法的计算密度如下。

- 如果$n$是一个算法所操作的数据项的数量,而$f(n)$是它所需要的操作的数量,那么算术强度就是$f(n)/n$。

(我们可以用浮点数或字节来衡量数据项。后者使我们更容易强度与处理器的硬件规格相关联)

计算密度也与延迟隐藏有关:即你可以减轻计算活动背后的数据加载对性能的负面影响的概念。要做到这一点,你需要比数据加载更多的计算来使这种隐藏有效。而这正是计算强度的定义:每一个字节/字/数字加载的高比率操作。

示例:向量操作

考虑到向量加法

这涉及到三次内存访问(两次加载和一次存储)和每次迭代的一次操作,给出的算术强度为1/3。axpy(表示 “$a$乘以 $x$ 加 $y$ “)操作

有两个操作,但内存访问的数量相同,因为 $a$ 的一次性负载被摊销了。因此,它比简单的加法更有效率,重用率为2/3。因此,它比简单的加法更有效,重用率为2/3。

内积计算

在结构上类似于axpy操作,每次迭代涉及一个乘法和加法,涉及两个向量和一个标量。然而,现在只有两个加载操作,因为 $s$ 可以保存在寄存器中,只在循环结束时写回内存。这里的重用是1。

示例:矩阵操作

考虑矩阵乘法

这涉及 $3𝑛^2$ 个数据项和 $2𝑛^3$ 个运算,属于高阶运算。算术强度为 $O(n)$,每个数据项将被使用𝑂(𝑛)次。这意味着,通过适当的编程,这种操作有可能通过将数据保存在快速缓存中来克服带宽/时钟速度的差距。

练习 1.14 根据上述定义,矩阵-矩阵乘积作为一种操作,显然具有数据重用性。矩阵-矩阵乘积显然具有数据复用。请你论证一下,这种复用并不是自然形成的,是什么决定了初始算法中国呢缓存是否对数据进行复用?

[在这次讨论中,我们只关心某个特定实现的操作数,而不是数学操作。例如,有一些方法可以在少于$O(n^3)$的操作中执行矩阵-矩阵乘法和高斯消除算法[189, 167]。然而,这需要不同的实现方式,在内存访问和重用方面有自己的分析]。

矩阵与矩阵乘积是LINPACK基准[51]的核心;见2.11.4节。如果将其作为评价计算机从能的标准则结果可能较为乐观:矩阵与矩阵的乘积是一个具有大量数据复用的操作,因此这对内存带宽并不敏感,对于并行计算及而言,这对网络通信也并不敏感。通常情况下,计算机在Linpack基准测试中会达到其峰值性能的60-90%,而其他测试标准得到的数值则可能较低。

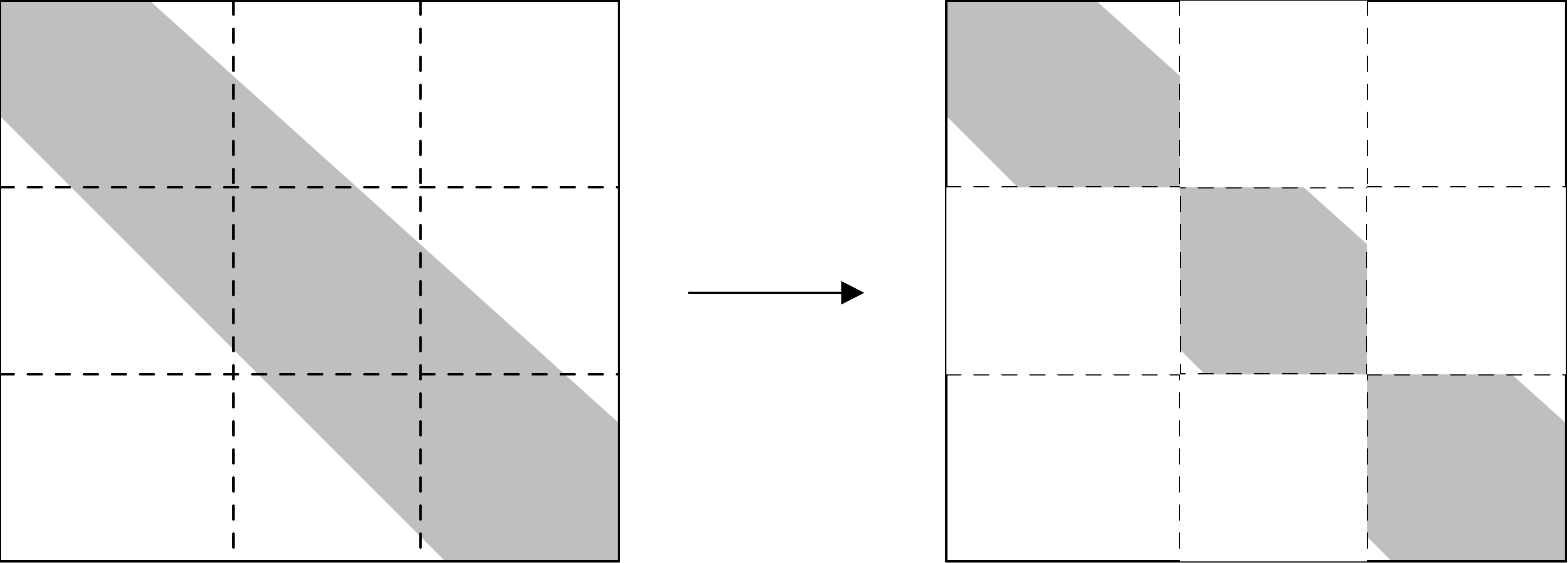

Roofline模型

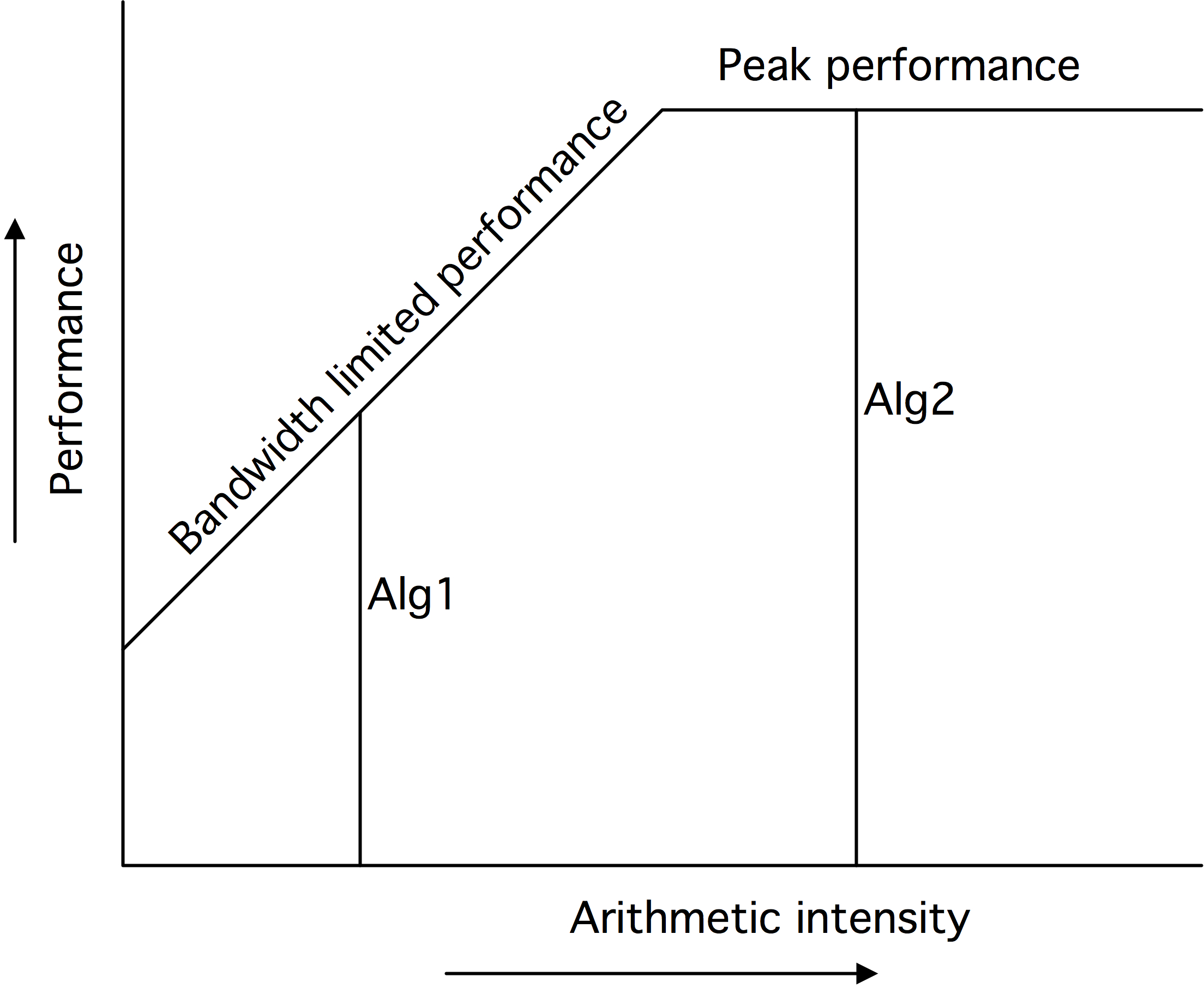

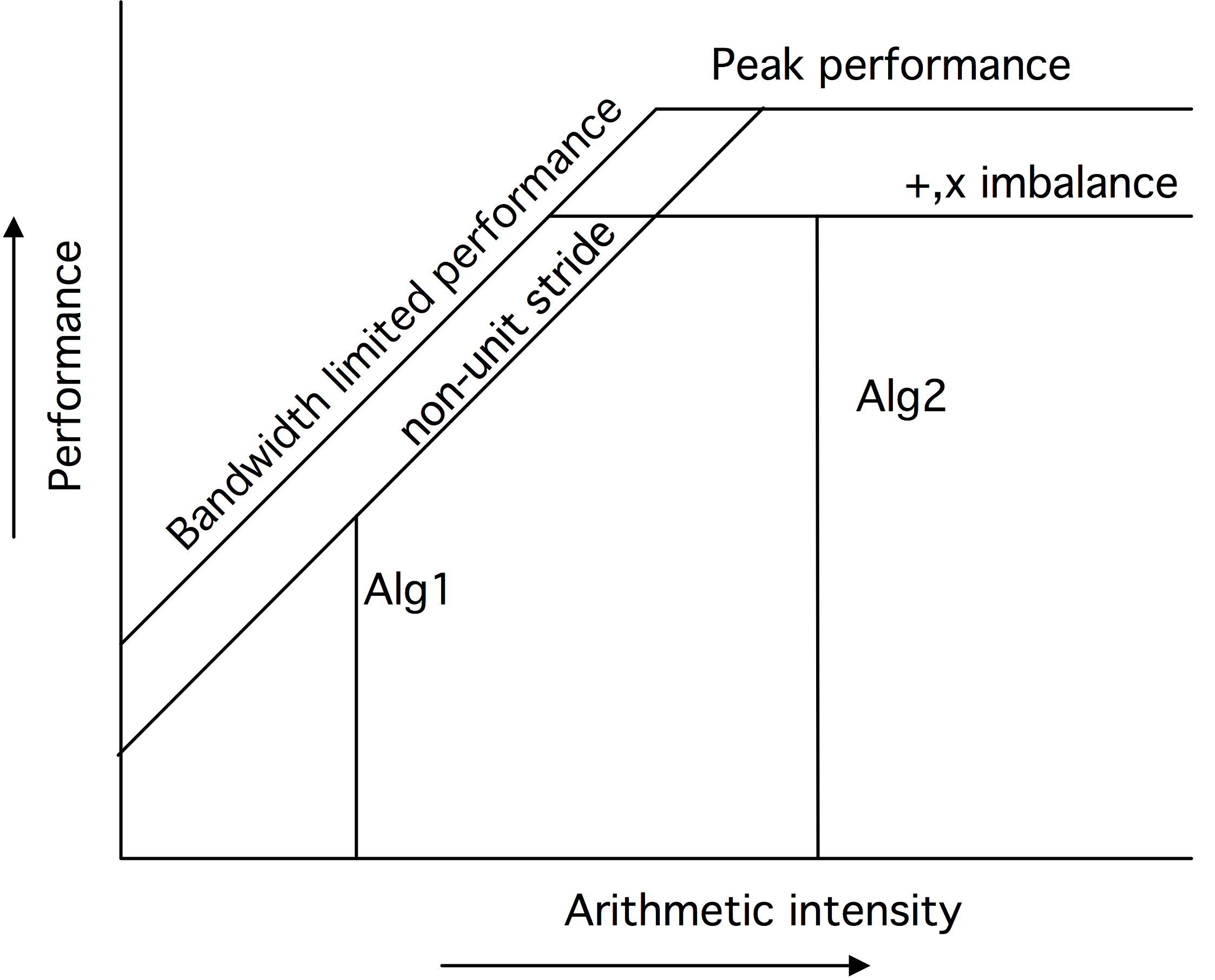

有一种平价计算及性能的理想模型,就是所谓的「屋脊线」(roofline model)模型[202],该模型指出:性能受两个因素的制约,如图1.16的第一个图所示。

图中顶部的横线所表示的峰值性能是对性能的绝对约束3,只有在CPU的各个方面(流水线、多个浮点单元)都完美使用的情况下才能达到。这个数字的计算纯粹是基于CPU的特性和时钟周期;假定内存带宽不是一个限制因素。

每秒的操作数受限于带宽、绝对数和计算密度的乘积。

这是由图中的线性增长线所描述的。

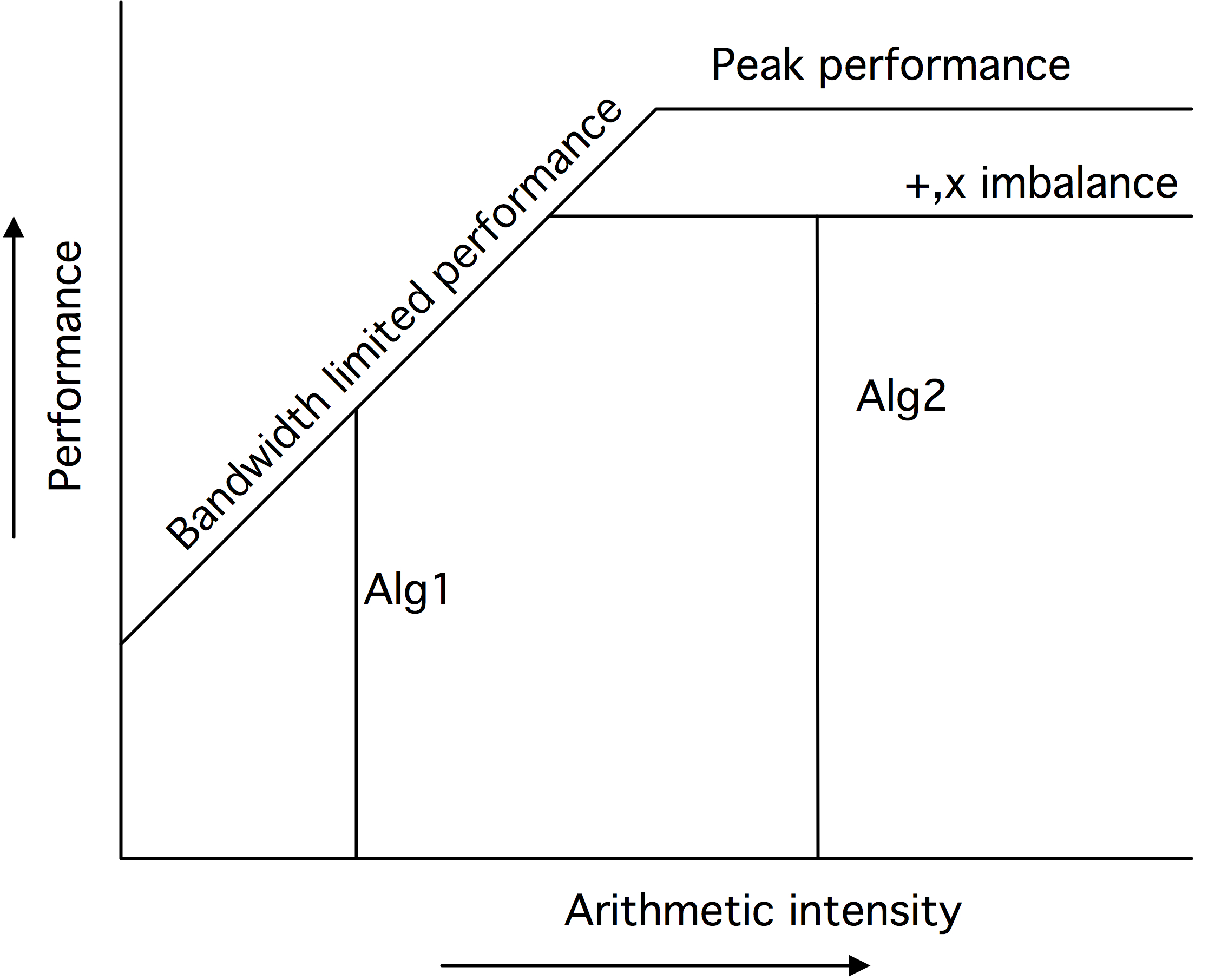

Roofline模型优雅地指出了影响性能的因素。例如,如果一个算法没有使用全部的SIMD宽度,这种不平衡会降低可达到的峰值。图1.16中的第二张图显示了降低上限的各种因素。还有各种降低可用带宽的因素,比如不完善的数据隐藏。这在第三张图中由倾斜的屋顶线的降低表示。

对于一个给定的计算密度,其性能是由其垂直线与Roofline相交的位置决定的。如果这是在水平部分,那么该计算被称为受「计算约束」(compute-bound):性能由处理器的特性决定,而带宽不是问题。另一方面,如果这条垂直线与屋顶的倾斜部分相交,那么计算被称为受「带宽约束」(bandwidth-bound):性能由内存子系统决定,处理器的全部能力没有被使用。

练习 1.15 如何确定一个给定的程序内核是受到带宽约束还是计算约束的?

局部性

由于从缓存中读取数据的时间开销要小于从内存中读取,我们当然希望以这种方式进行编码,进而使缓存中的数据最大程度上得到复用。虽然缓存中的数据不受程序员的控制,甚至编写汇编语言也无法控制(在Cell处理器和一些GPU中,低级别的内存访问可以由程序员控制),但在大多数CPU中,知道缓存的行为,明确什么数据在缓存中,并在一定程度上控制它,还是有可能的。

这里的两个关键概念是「时间局部性」(temporal locality)和「空间局部性」(spatial locality)。时间局部性是最容易解释的:即数据使用一次后短时间内再次被使用。由于大多数缓存使用LRU替换策略,如果在两次引用之间被引用的数据少于缓存的大小,那么该元素仍然会存在缓存之中,进而实现快速访问。而对于其他的替换策略,例如随机替换,则不能保证同样结果。

时间局部性

下面为时间局部性的例子,考虑重复使用一个长向量:

1 | for (loop=0; loop<10; loop++) { |

$x$ 的每个元素将被使用10次,但是如果向量(加上其他被访问的数据)超过了缓存的大小,每个元素将在下一次使用前被刷新。因此,$x[i]$ 的使用并没有表现出时间局部性:再次使用时的时间间隔太远,使得数据无法停留在缓存中。

如果计算的结构允许我们交换循环。

1 | for (i=0; i<N; i++) { |

$x$ 的元素现在被反复使用,因此更有可能留在缓存中。这个重新排列的代码在使用 $x[i]$ 时显示了更好的时间局部性。

空间局部性

空间局部性的概念要稍微复杂一些。如果一个程序引用的内存与它已经引用过的内存 “接近”,那么这个程序就被认为具有空间局部性。经典的冯·诺依曼架构中只有一个处理器和内存,此时空间局部性并不突出,因为内存中的一个地址可以像其他地址一样被快速检索。然而,在一个有缓存的现代CPU中,情况就不同了。上面我们已经看到了两个空间局部性的例子。

由于数据是以缓存线而不是单独的字或字节为单位移动的,因此以这样的方式进行编码,因此使缓存线所有的元素都得到应用是有所裨益的,在下列循环中

1

2

3for (i=0; i<N*s; i+=s){

... x[i] ...

}空间局部性体现为函数所进行的跨步递减$s$。

设 $S$ 为缓存线的大小,那么当 $s$ 的范围从$1 …. S$,每个缓存线使用的元素数就会从S下降到1。相对来说,这增加了循环中的内存流量花销:如果$s=1$,我们为每个元素加载$1/S$的缓存线;如果$s=S$,我们为每个元素加载一个缓存线。这个效果在1.7.4节中得到了证明。

第二个值得注意的空间局部性的例子是TLB(1.3.8.2节)。如果一个程序引用的元素距离很近,它们很可能在同一个内存页上,通过TLB的地址转换会很迅速。另一方面,如果一个程序引用了许多不同的元素,它也将引用许多不同的页。由此产生的TLB缺失是时间花销十分庞大;另见1.7.5节。

练习 1.16 请考虑以下对 $n$ 数字 $x[i]$ 进行求和的算法的伪码,其中 $n$ 是2的倍数。

1 | for s=2,4,8,...,n/2,n: |

分析该算法的空间和时间局部性,并将其与标准算法进行对比

1 | sum = 0 |

练习 1.17 考虑以下代码,并假设nvectors相比于缓存很小,而长度很大。

1 | for (k=0; k<nvectors; k++) |

以下概念与该代码的性能有什么关系。

- 复用(Reuse)

- 缓存尺寸(Cache size)

- 关联性(Associativity)

下面这段交换了循环的代码的性能是更好还是更差,为什么?

1 | for (i=0; i<length; i++) |

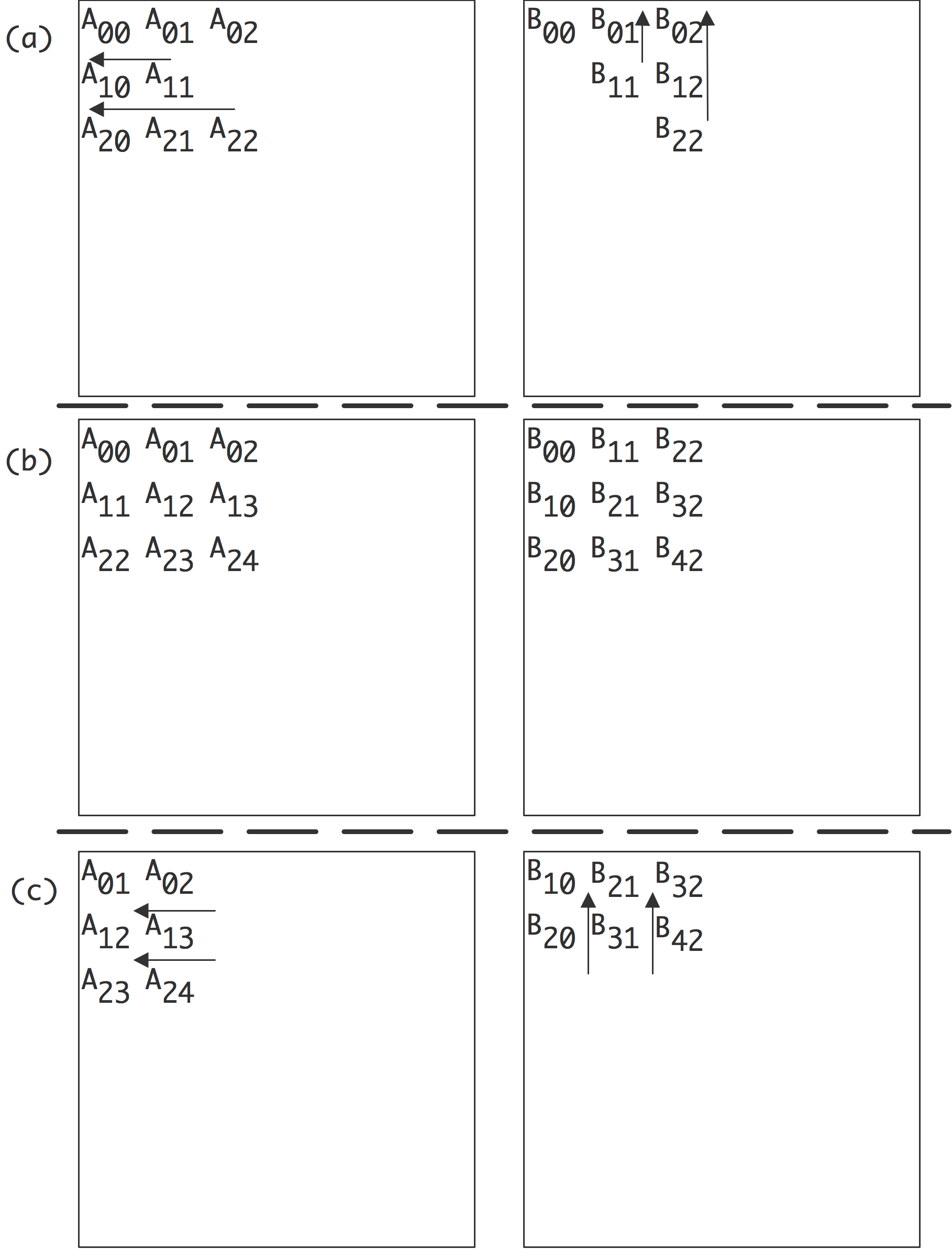

局部性示例

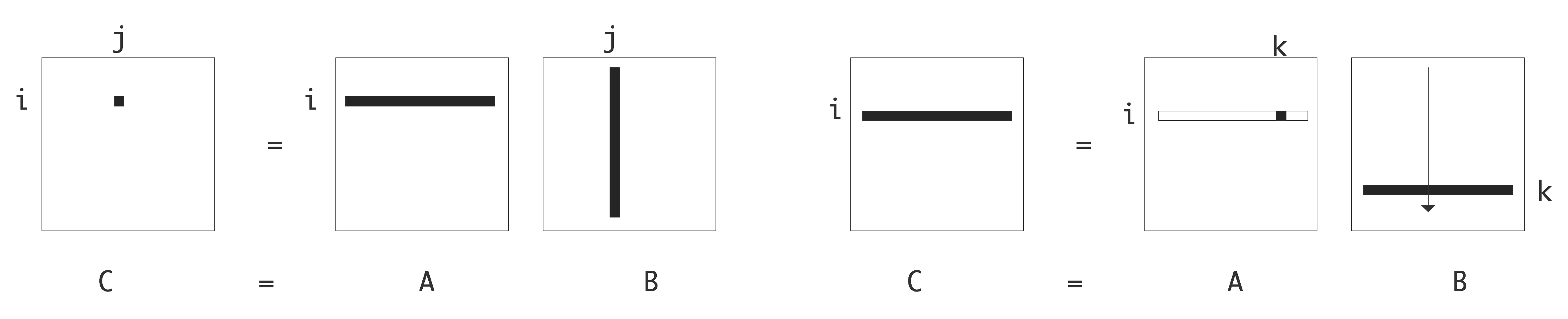

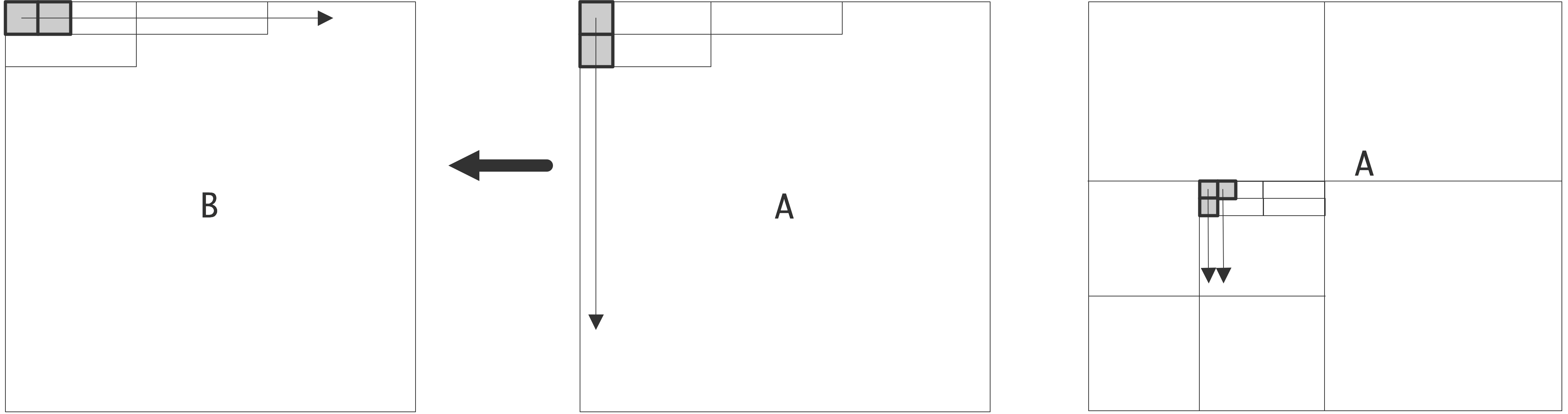

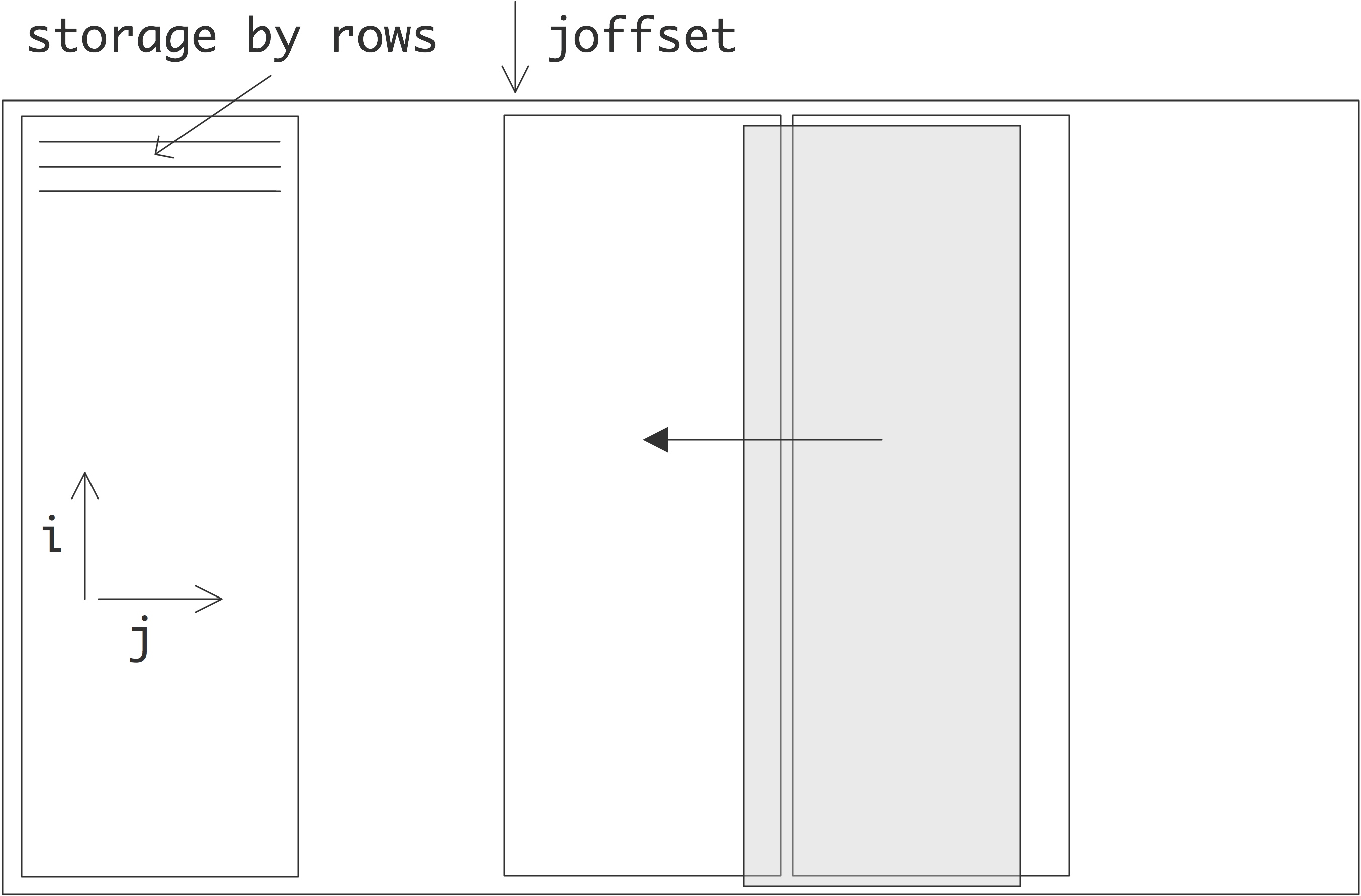

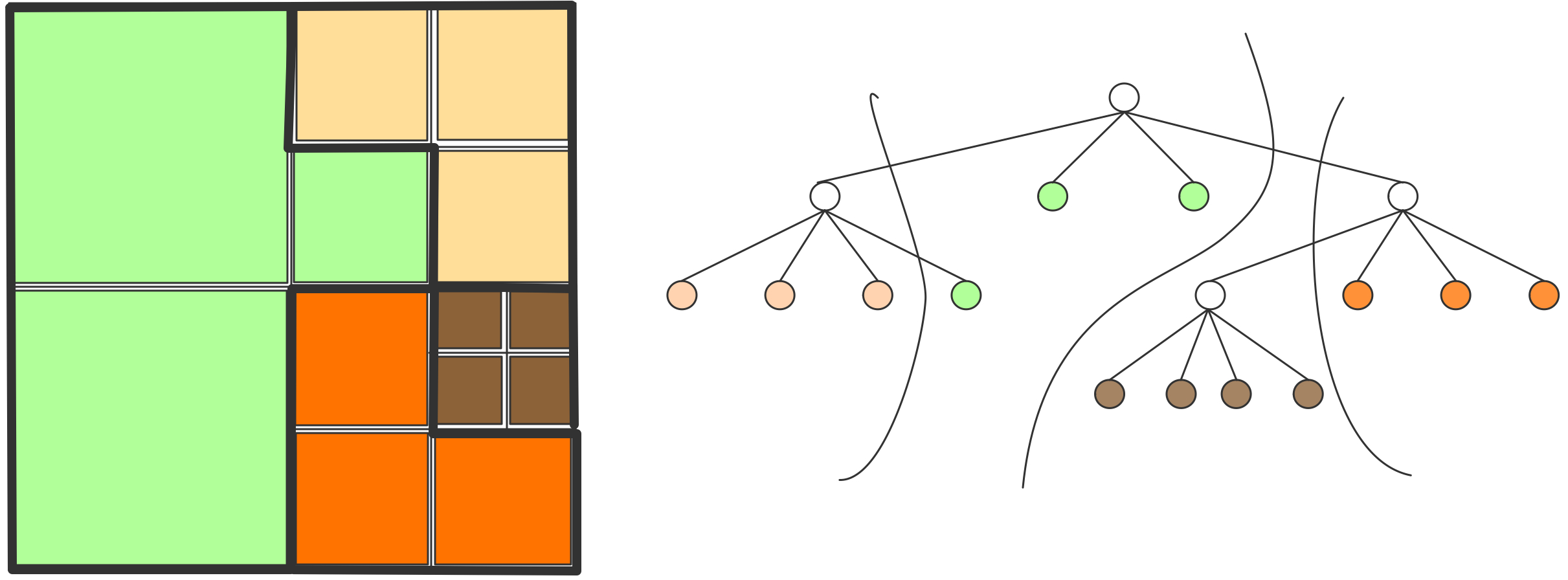

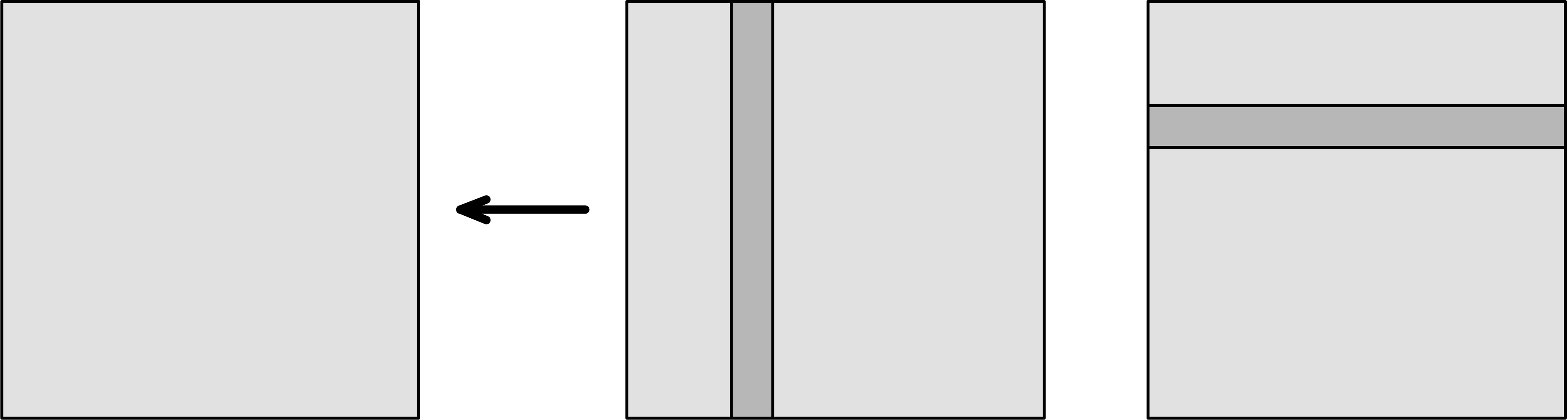

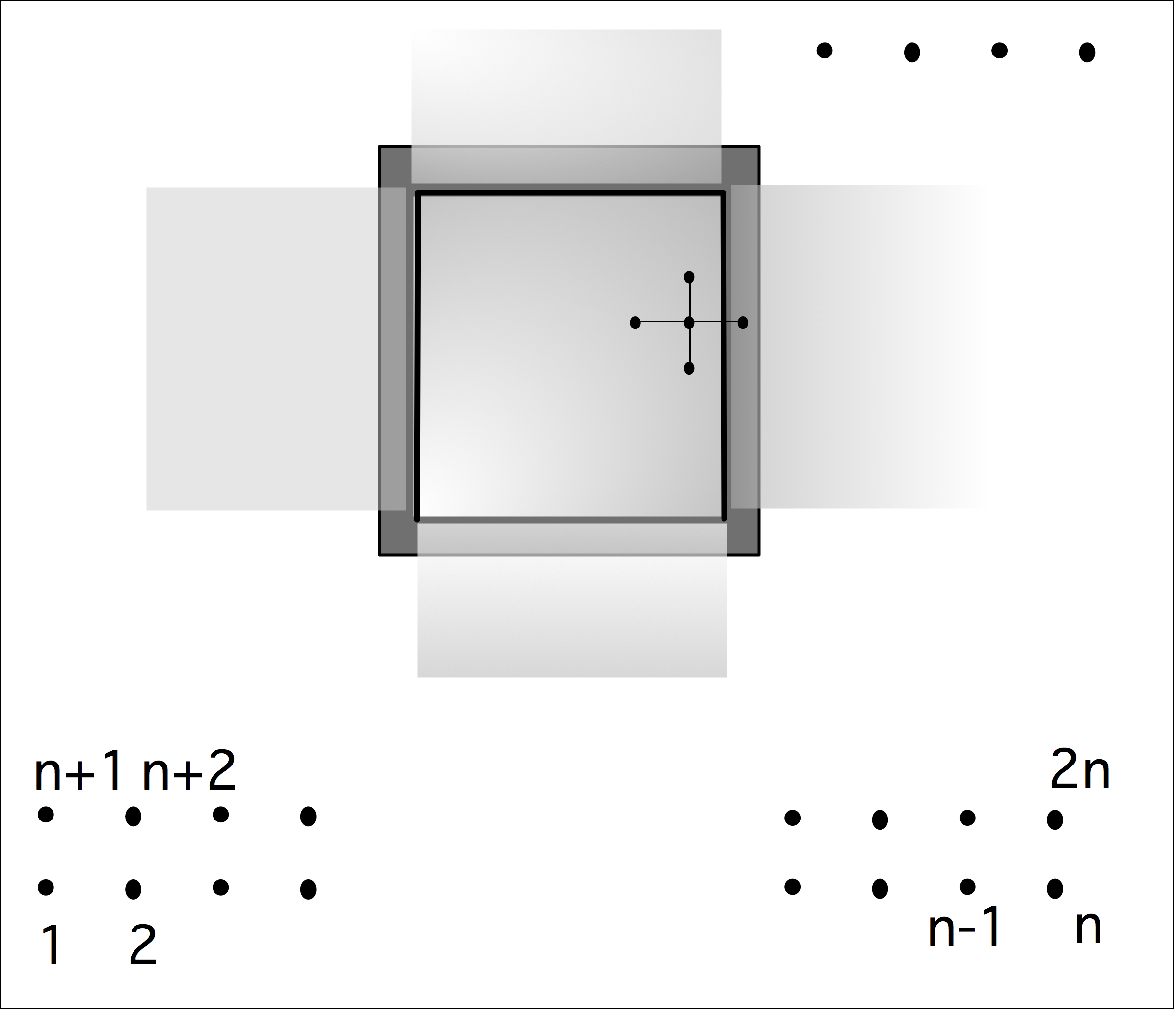

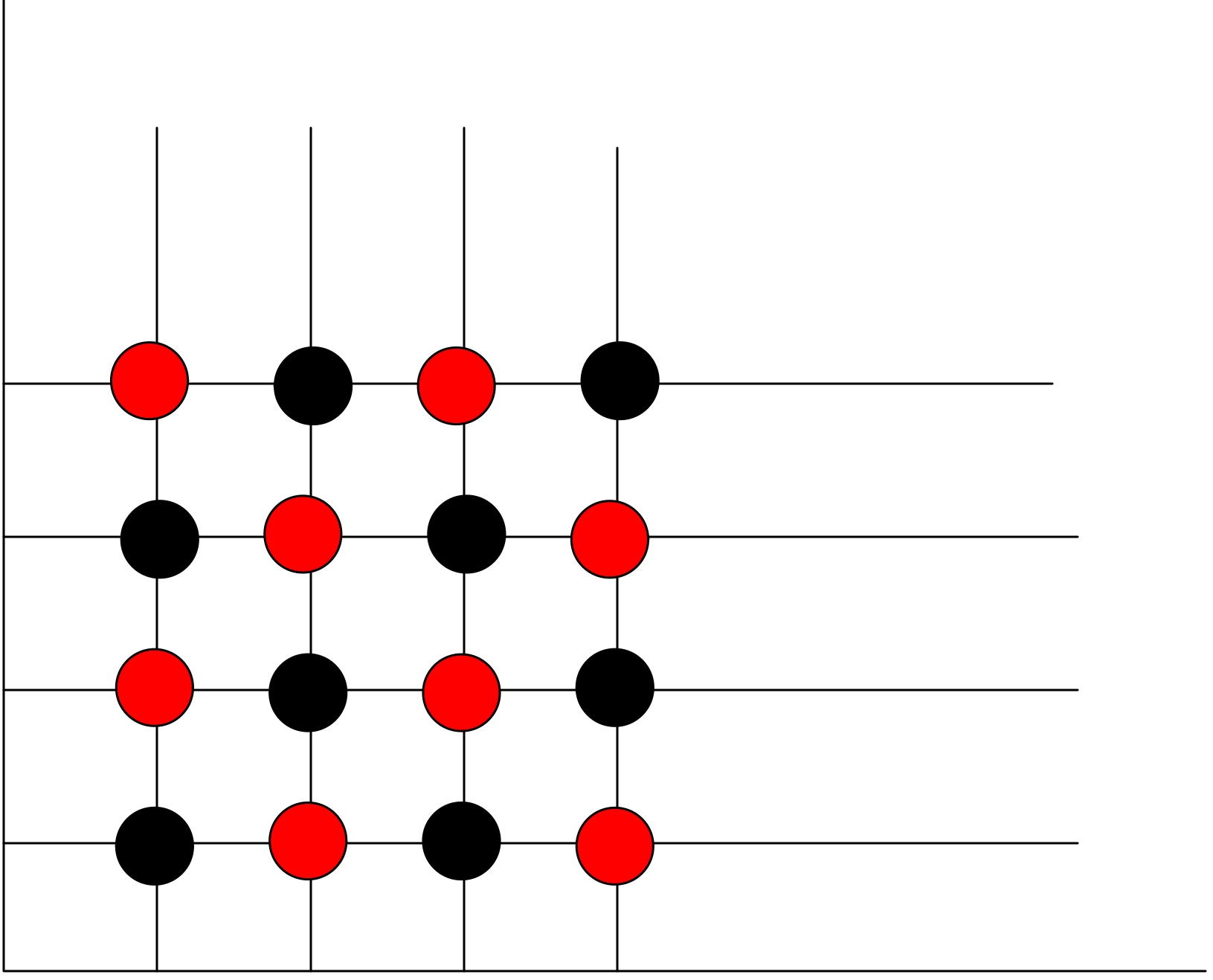

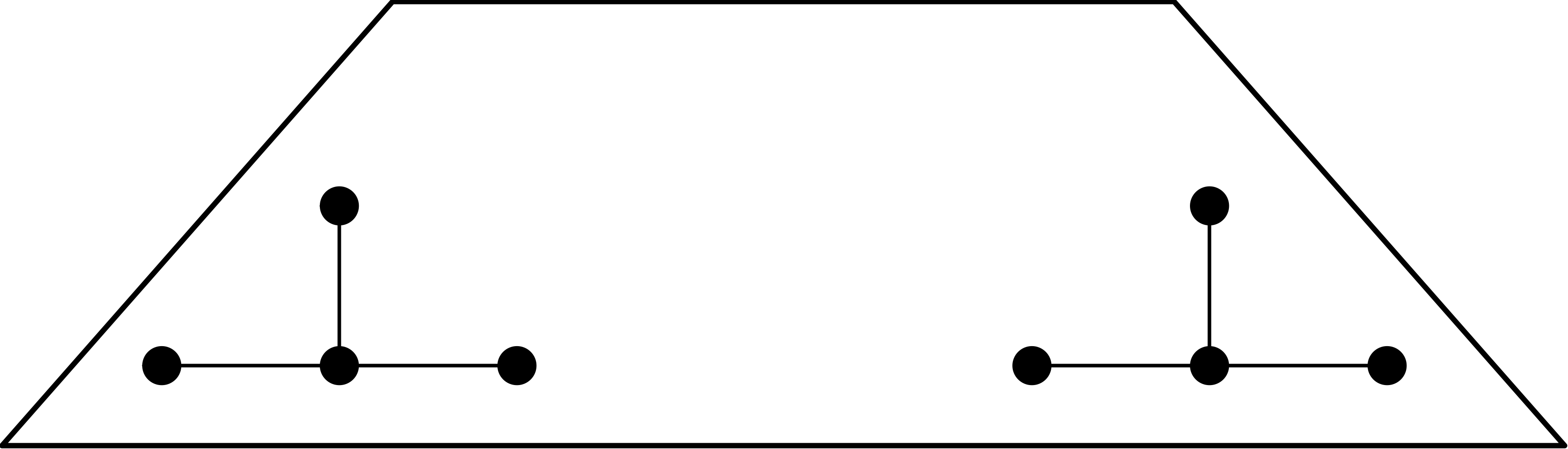

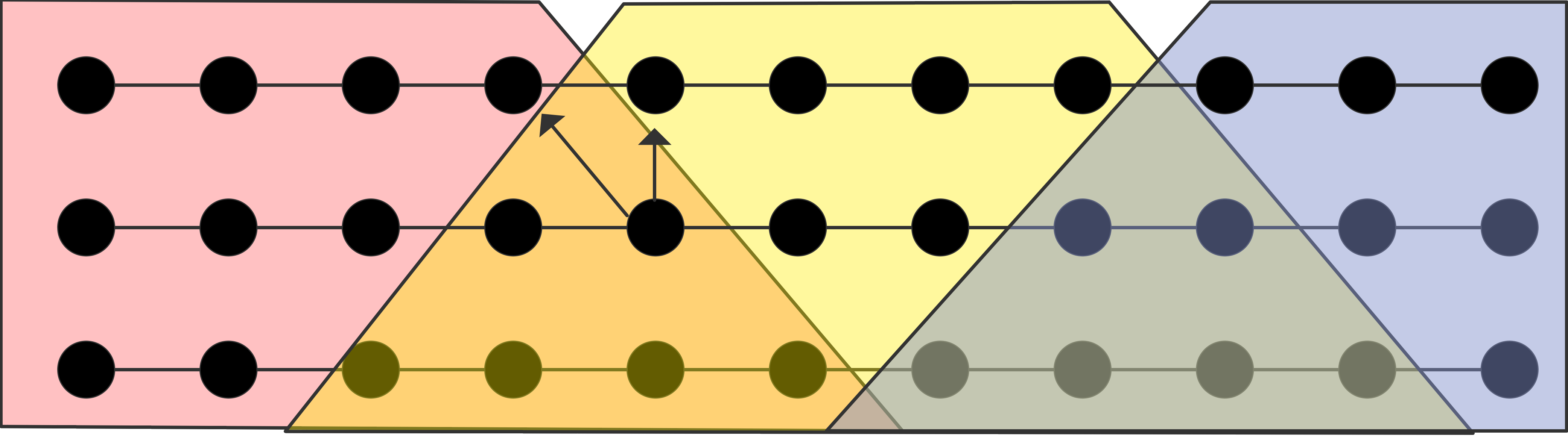

让我们看一个实际的例子。矩阵与矩阵的乘法 $C \leftarrow A ·B $可以用几种方法计算。我们比较两种实现方式,假设所有的矩阵都是按行存储的,且缓存大小不足以存储整个行或列。

1 | for i=1..n |

1 | for i=1..n |

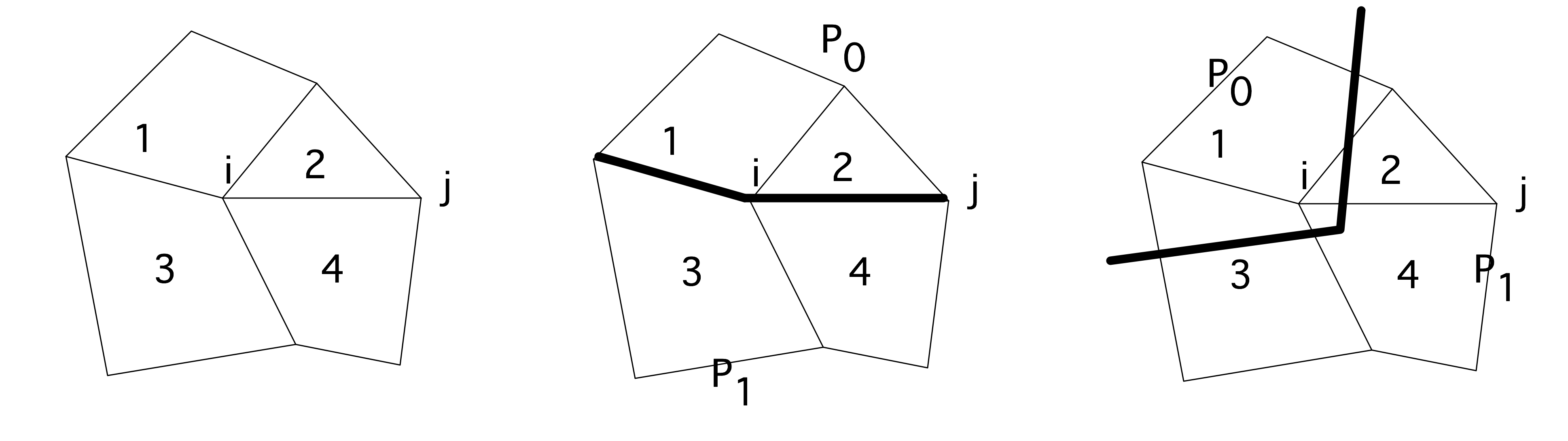

这些实现如图1所示。 第一个实现构建了 $(i, j)$ 元素

$A$ 的一行与 $B$ 的一列的内积来更新 $C$,在第二行中,$B$ 的一行是通过对 $A$ 的元素进行缩放来更新。$A$ 的元素来更新 $B$ 的行数。

我们的第一个观察结果是,这两种实现都确实计算了 $C \leftarrow C + A ·B$,并且它们都花费了大约 $2n^3$ 的操作。然而,它们的内存行为,包括空间和时间的局部性是非常不同的。

$c[i,j]$ :在第一个实现中,$c[i,j]$在内部迭代中是不变的,这构成了时间局部性,所以它可以被保存在寄存器中。因此,$C$ 的每个元素将只被加载和存储一次。

在第二个实现中,$c[i,j]$ 将在每个内部迭代中被加载和存储。特别是,这意味着现在有 $𝑛^3$ 次存储操作,比第一次实现多了$n$。

$a[i,k]$:在这两种实现中,$a[i,k]$元素都是按行访问的,所以有很好的空间局部性,因为每个加载的缓存线都会被完全使用。在第二个实现中,$a[i,k]$在内循环中是不变的,这构成了时间局部性;它可以被保存在寄存器中。因此,在第二种情况下,$A$只被加载一次,而在第一种情况下则是$n$次。

$b[k,j]$:这两种实现方式在访问矩阵 $B$ 的方式上有很大不同。首先,$b[k,j]$ 从来都是不变的,所以它不会被保存在寄存器中,而且 $B$ 在两种情况下都会产生 $𝑛^3$ 的内存负载。但是,访问模式不同。

在第二种情况下,$b[k,j]$ 是按行访问的,所以有很好的空间局部性性:缓存线在被加载后将被完全利用。

在第一种实现中,$b[k,j]$ 是通过列访问的。由于矩阵的行存储,一个缓存线包含了一个行的一部分,所以每加载一个缓存线,只有一个元素被用于列的遍历。这意味着第一个实现对 $B$ 的加载量要比缓存线长度的系数大。也有可能是TLB的影响。

请注意,我们并没有对这些实现的代码性能做任何绝对的预测,甚至也没有对它们的运行时间做相对比较。这种预测是很难做到的。然而,上面的讨论指出了与广泛的经典CPU相关的问题。

练习 1.18 乘积 $C \leftarrow A ⋅B$ 的实现算法较多。请考虑以下情况。

1 | for k=1..n: |

分析矩阵 $C$ 的内存流量,并表明它比上面给出的两种算法更糟糕。

核心局部性

上述空间和时间局部性的概念主要是程序的属性,尽管诸如高速缓存线长度和高速缓存大小这样的硬件属性在分析局部性的数量方面发挥了作用。还有第三种类型的局部性与硬件有更密切的联系:「核心局部性」(core locality)。

如果空间上或时间上接近的写访问是在同一个核心或处理单元上进行的,那么代码的执行就会表现出核心局部性。这里的问题是缓存一致性的问题,两个核心在他们的本地存储中都有某个缓存线的副本。如果它们都从该缓存中读取,那就没有问题了。但是,如果他们中的一个对它进行了写操作,一致性协议就会把这个缓存线复制到另一个核心的本地存储中。这需要占用宝贵的内存带宽,所以要避免这种情况。

核心局部性不仅仅是一个程序的属性,而且在很大程度上也是程序的并行执行方式。

单处理器计算(三)

高性能编程策略

在本节中,我们将简要介绍不同的编程方式如何影响代码的性能。想要了解更多,见Goedeker和Hoisie的书[78]。

本章中所有的性能结果都是在TACC Ranger集群的AMD Opteron处理器上获得的[173]。

峰值性能

厂家出于营销的目的,定义了CPU的“峰值速度”。由于一个流水线上的浮点单元可以渐进地在每个周期产生一个结果,我们可以把理论上的「峰值性能」(peak performance)定义为时钟速度(以每秒ticks为单位)、浮点单元数量和核心数量的乘积。该峰值速度在实际中是无法实现的,很少有代码能接近它。Linpack基准是衡量接近峰值的评判标准之一;该基准的并行版本作为”top 500”的评分标准。

流水线

在前文中,我们了解到现代CPU中的浮点运算单元是以流水线形式进行的,流水线需要一些独立的操作才能有效地运行。典型的可流水线操作是向量加法;不能流水线操作的一个例子是计算内积和:

1 | for (i=0; i<N; i++) |

$s$ 既被读又被写,使得加法流水线中止。启用流水线的一个方法是循环展开

1 | for (i = 0; i < N/2-1; i ++) { |

现在,在累积之间有两个独立的乘法。通过一点索引优化,这就变成了

1 | for (i = 0; i < N/2-1; i ++) { |

关于这段代码的第一个观察点是,我们隐式地使用了加法的结合律和交换律:虽然同样的量被加起来,但它们现在实际上是以不同的顺序加起来的。正如你将在后面的内容看到的,在计算机运算中,这并不能保证得到完全相同的结果。

在进一步的优化中,我们将每条指令的加法和乘法部分分离开来。希望在积累等待乘法结果的时候,中间的指令能让处理器忙起来,实际上是增加了每秒的操作数。

1 | for (i = 0; i < N/2-1; i ++) { |

最后,我们意识到,我们可以将加法从乘法中移开的最远距离是将它放在下一次迭代的乘法前面

1 | for (i = 0; i < N/2-1; i ++) { |

当然,我们可以将循环展开超过2层。虽然我们期望因为更长的流水线操作序列而提高性能,但大量的循环展开需要大量的寄存器。对寄存器的要求超过了CPU所拥有的数量,这就是所谓的「寄存器漫溢」(register spill),将降低程序性能。

另一个需要注意的问题是,操作的总数不太可能被展开因子所除。这就需要在循环之后进行清理代码,以考虑到最后的迭代。因此,展开的代码比直接的代码更难写,人们已经写了一些工具来自动执行这种源到源的转换。

表1.2中给出了内积循环展开操作的周期时间,最多为六次。请注意,在展开层数达到4时,时间并没有显示展示出单调的性质。这种变化是由于各种与内存有关的因素造成的。

| 1 | 2 | 3 | 4 | 5 | 6 |

|---|---|---|---|---|---|

| 6794 | 507 | 340 | 359 | 334 | 528 |

内积操作的周期时间,最多展开六次。

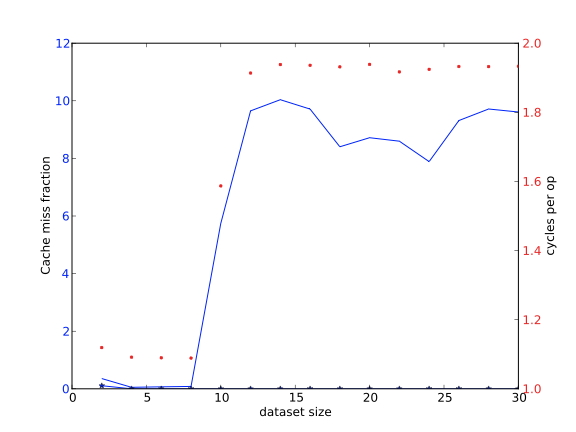

缓存尺寸

上面我们了解到,从L1移动数据可以比从L2移动数据有更低的延迟和更高的带宽,而L2又比L3或内存快。这很容易用重复访问相同数据的代码来证明

1 | for (i=0; i<NRUNS; i++) |

如果尺寸参数允许数组填入缓存,那么操作会相对较快。随着数据集大小的增长,它的一部分将从L1缓存中转移至其他部分,所以操作的速度将由L2缓存的延迟和带宽决定。这可以从图1.18中看出。每个操作的平均周期数与数据集大小的关系图如下:

练习 1.19 试论证:如果有一个足够大规模的问题和LRU替换策略(第1.3.4.6节),基本上L1中的所有数据都会在外循环的每次迭代中被替换。你能不能写一个例子,让一些L1的数据保持不变?

通常情况下,可以通过安排操作来将数据保留在L1缓存中。例如,在我们的例子中,我们可以编写

1 | for (b=0; b<size/l1size; b++) { |

假设L1大小与数据集大小平均分配。这种策略被称为「缓存模块化」(cache blocking)或「缓存复用模块化」(blocking for cache reuse)。

在下面的循环中,针对不同的缓存大小值,测量每个周期的内存访问次数。如果观察到时间与缓冲区大小无关,请让编译器生成一个优化报告。对于英特尔的编译器使用-qopt-report

1 | for (int irepeat=0; irepeat<how_many_repeats; irepeat++) { |

论证发生了什么。你能找到防止循环交换的方法吗?

练习 1.21 为了得到模块化的代码,$j$的循环被分割成一个块的循环和一个块元素的内循环;然后i的外循环被替换成块的循环。在这个特殊的例子中,你也可以简单地交换i和j的循环。为什么这不是最佳性能?

注释 7 模块化的代码可能会改变表达式的评估顺序。由于浮点运算不是关联性的,所以模块化不是编译器允许进行的转换。

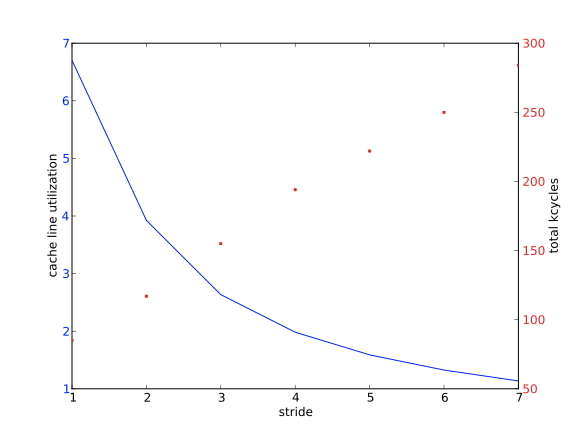

缓存线与跨步访问

由于数据是以连续的块状形式从内存转移到缓存中的,称为「缓存线」(cache line),没有利用缓存线中所有数据的代码要付出带宽的代价。这可以从一个简单的代码中看出来

1 | for (i=0,n=0; i<L1WORDS; i++,n+=stride) |

此处执行的是固定操作数。但随着跨度的增加,我们预计运行时间也会增加,这在图1.19中得到了证实。

图中还显示了高速缓存线的复用率在下降,定义为向量元素的数量除以L1失误的数量。

下表为:在Frontera的56个核心上,每个核心的数据量为3.2M,每次操作的时间(纳秒)是跨度的函数。

| stride | nsec/word 56 cores, 3M |

56 cores, .3M | 28 cores, 3M |

|---|---|---|---|

| 1 | 7.268 | 1.368 | 1.841 |

| 2 | 13.716 | 1.313 | 2.051 |

| 3 | 20.597 | 1.319 | 2.852 |

| 4 | 27.524 | 1.316 | 3.259 |

| 5 | 34.004 | 1.329 | 3.895 |

| 6 | 40.582 | 1.333 | 4.479 |

| 7 | 47.366 | 1.331 | 5.233 |

| 8 | 53.863 | 1.346 | 5.773 |

滞后的影响可以通过处理器的带宽和缓存行为来缓解。考虑在TACC的Frontera集群的英特尔Cascadelake处理器上的一些运行情况(每个插槽28个核,双插槽,每个节点总共56个核)。我们测量了一个简单的流媒体内核的每操作时间,使用递增的步长。上表在第二栏中报告了每个操作时间确实随着步长的增加而线性上升。

然而,这是对一个溢出二级缓存的数据集而言的。如果我们让这个运行包含在二级缓存中,就像第三列中报告的那样,这种增加就会消失,因为有足够的带宽可以从二级缓存中全速流式传输数据。

TLB

正如前面文章所解释的,转译后备缓冲器(TLB)维护着一个经常使用的内存页及其位置的小列表;寻址位于这些页上的数据比不在其中的数据快得多。因此,人们希望以这样的方式编写代码,使访问的页数保持在低水平。 考虑以两种不同的方式遍历一个二维数组的元素的代码。

1 |

|

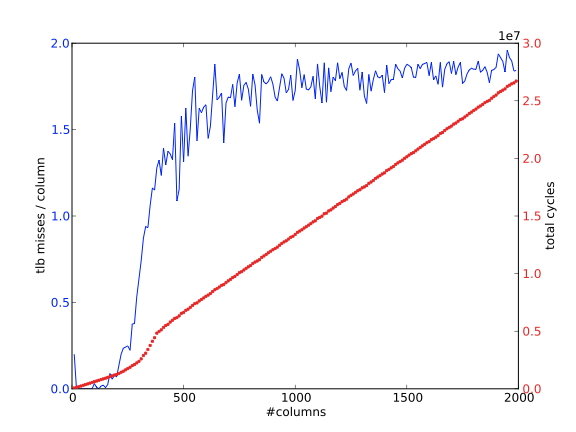

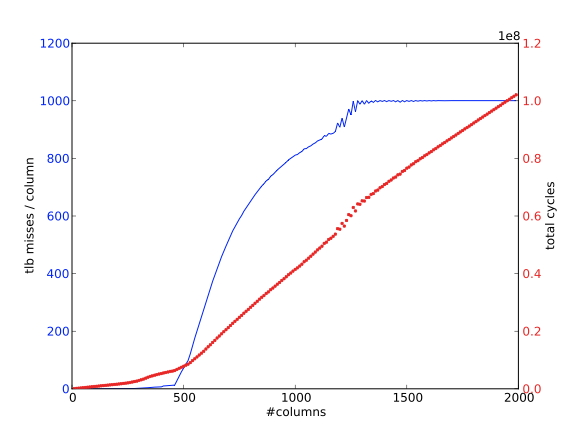

结果(源代码见附录37.5)绘制在图1.21和1.20中。

每列的TLB缺失次数与列数的函数关系;数组的逐列遍历

使用 $m=1000$ 意味着,在AMD Opteron上有512个双倍的页面,我们每列大约需要两个页面。我们运行这个例子,绘制 “TLB缺失 “的数量,也就是说,一个页面被引用的次数没有被记录在TLB中。

- 在最初的遍历中,这确实是发生的情况。在我们接触到一个元素,并且TLB记录了它所在的页面后,该页面上的所有其他元素随后被使用,所以没有进一步的TLB缺失发生。图1.20显示,随着𝑛的增加,每列的TLB缺失次数大约为2次。

- 在第二次遍历中,我们为第一行的每一个元素接触一个新的页面。第二行的元素将在这些页面上,因此,只要列的数量少于TLB条目的数量,这些页面仍将被记录在TLB中。随着列数的增加,TLB的数量也在增加,最终每个元素的访问都会有一个TLB缺失。图1.21显示,在列数足够多的情况下,每列的TLB缺失次数等于每列的元素数。

缓存关联性

有许多算法是通过对一个问题的递归划分来工作的,例如快速傅里叶变换(FFT)算法。因此,这类算法的代码经常在长度为2的幂的向量上操作。不幸的是,这可能会与CPU的某些架构特征产生冲突,其中许多涉及到2的幂。

每列的TLB缺失次数与列数的函数关系;数组的按列遍历

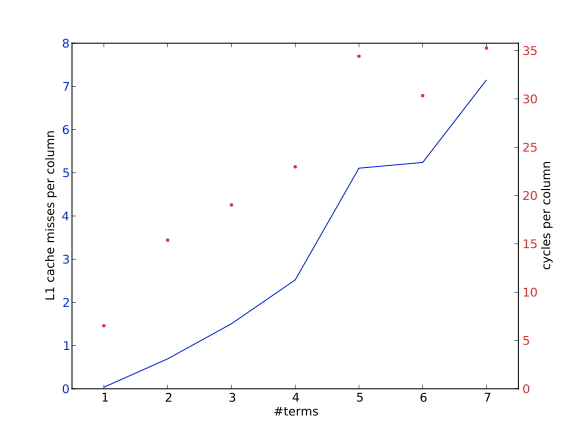

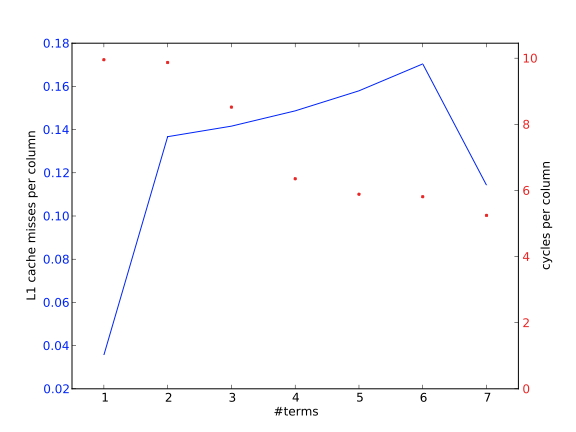

在前面,我们看到了将少量向量相加的操作是如何进行的

对于直接映射的缓冲区或具有关联性的集合关联缓冲区是一个问题。

我们以AMD Opteron为例,它有一个64K字节的L1高速缓存,而且是双向设置的关联性。由于设置了关联性,该缓存可以处理两个地址被映射到同一个缓存位置,但不能处理三个或更多。因此,我们让向量的大小 $n=4096$ 个双倍数,我们测量了让 $m=1, 2, ….$ 的缓存缺失和周期的影响。

首先,我们注意到我们是按顺序使用向量的,因此,在一个有8个双倍数的缓存线中,我们最好能看到1/8倍于向量数量𝑚的缓存丢失率。相反,在图1.22中,我们看到了一个与𝑚成正比的速率,这意味着确实有缓存行被立即驱逐。这里的例外是𝑚=1的情况,双向关联性允许两个向量的缓存线留在缓存中。

对比图1.23,我们使用了一个稍长的向量长度,所以具有相同$j$的位置不再被映射到同一个缓存位置。因此,我们看到的缓存缺失率约为1/8,而周期数较少,相当于完全重复使用了缓存线。

有两点需要注意的是:由于处理器会使用预取流,所以缓存缺失数实际上比理论预测的要低。其次,在图1.23中,我们看到时间随着 $m$ 的增加而减少;这可能是由于负载和存储操作之间逐渐形成了有利的平衡。由于各种原因,存储操作比负载的开销更大。

L1高速缓存的缺失次数和每个$j$列累积的周期数,向量长度为4096

L1缓存丢失的次数和每个𝑗列累积的周期数,向量长度4096+8

循环嵌套

如果代码中有两层独立的循环嵌套,我们可以自由选择将哪个循环设置为外循环。

练习 1.22 给出一个可以交换与不能交换的双层循环例子,可以的话请使用本书中的实际案例。

「C与Fortran的比较」:如果我们的循环使用了一个二维数组的 $(i, j)$ 索引,对于Fortran来说,通常最好让 $i$ 索引在内,而对于C语言, $j$索引最好在内部。

练习 1.23 试给出两种理由说明这对性能更加。

上述内容并不是一条硬性规定,决定循环的因素有许多,例如:循环的大小和其他等。在矩阵与向量乘积中,改变循环的顺序会改变输入和输出向量的使用方式。

并行模式:如果我们使用OpenMP优化循环,我们通常希望令外部循环次数比内部要多,因为短的内循环有助于编译器向量化操作;如果使用的是GPU优化,则尽量将大循环放在内部,并行工作的单元不应该有分支或循环。

另一方面,如果你的目标是GPU,你希望大循环是内循环。并行工作的单元不应该有分支或循环。

循环分块

在某些情况下,可以通过将一个循环分解成两个嵌套的循环来提高性能:一个是用于迭代空间中的块的外循环,一个是穿过块的内循环。这就是所谓的「循环分块」(loop tiling):(短的)内循环为块,其许多连续的实例构成了迭代空间。

例如

1 | for (i=0; i<n; i++) |

变为

1 | bs = ... /* the blocksize */ |

对于单一循环而言,这可能不会产生任何影响,但在某些情况下就可能会产生影响。例如,如果一个数组被重复使用,但它太大,无法装入缓存。

1 | for (n=0; n<10; n++) |

那么循环分块可能会导致一种情况,即数组被划分为适合缓存的块

1 | bs = ... /* the blocksize */ |

由于这个原因,循环叠加也被称为「缓存模块化」(cache blocking)。块的大小取决于在循环体中访问多少数据;理想情况下,我们会尽量使数据在L1缓存中得到重用,但也有可能为L2重用进行模块化。当然,L2重用的性能不会像L1重用那样高。

分析一下这个例子。 $x$什么时候被带入缓存,什么时候被重新使用,什么时候被刷新?在这个例子中,所需的缓冲区大小是多少?重写这个例子,用一个常数

1 |

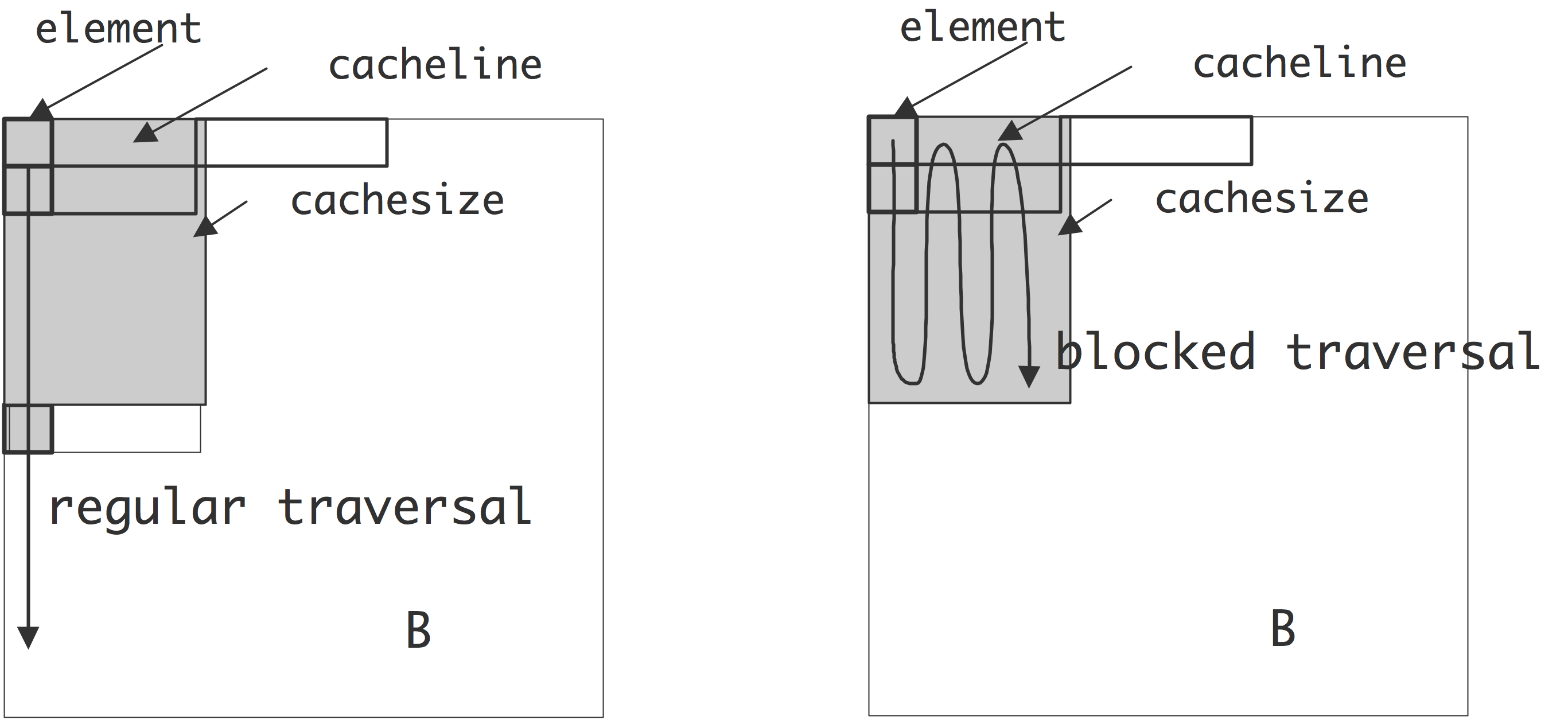

下面观察矩阵转置 $A \leftarrow Bt$ 。通常情况下,我们会遍历输入和输出矩阵。

1 | // regular.c |

使用模块化,这就变成了

1 | // blocked.c |

与上面的例子不同,输入和输出的每个元素只被触及一次,所以没有直接的重复使用。然而,缓存线是可以重复使用的。

图1.24显示了其中一个矩阵是如何以与它的存储顺序不同的顺序被遍历的,比如说按列存储,而按行存储。这样做的结果是,每个元素的加载都会传输一个缓存线,其中只有一个元素会被立即使用。在常规的遍历中,这种缓存线流很快就溢出了缓存,而且没有重复使用。然而,在模块化遍历中,在需要这些行的下一个元素之前,只有少量的缓存行被遍历了。因此,缓存线是可以重复使用的,也就是空间局部性。

通过模块化获得性能的最重要的例子是矩阵,矩阵积,循环展开。前面,我们研究了矩阵与矩阵的乘法,得出的结论是在高速缓存中可以保留的数据很少。通过循环展开可以改善这种情况。例如,这个乘法的标准写法是

1 | for i=1..n |

只能通过优化使 $c[i,j]$ 保持在寄存器中。

1 | for i=1..n |

假设 $a$ 是按行存储的,使用循环平铺法,我们可以将 $a[i,:]$ 的部分内容保留在缓存中。

1 | for kk=1..n/bs |

优化策略

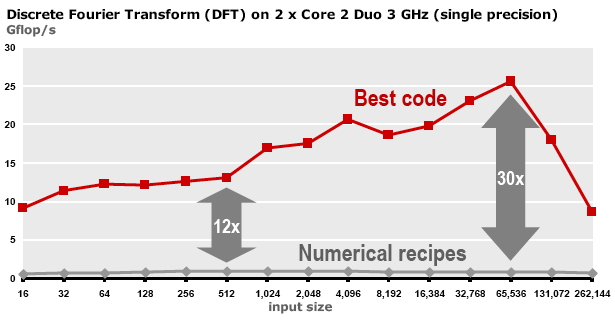

离散傅里叶变换的初始和优化后的性能对比

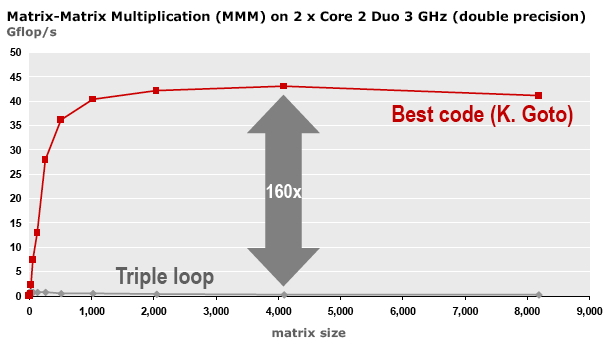

矩阵与矩阵乘积的初始实现和优化后的性能对比

图1.25和1.26显示,一个操作的原始实现(有时称为 “参考实现”)和优化实现的性能之间可能存在很大的差异。然而,优化并没有套路可循。由于使用模块化,循环展开后的操作是正常深度的2倍,矩阵与矩阵乘积变成了深度为6的循环;最佳的模块大小也取决于具体的目标架构等因素。

我们提出以下参考

- 编译器无法提取接近最佳性能的东西。

- 有一些自动调整项目,用于自动生成根据架构进行调整的实现。这种方法可以是适度的,也可以是非常成功的。这些项目中最著名的是用于Blas内核的Atlas[199]和用于变换的Spiral[172]。

缓存感知和缓存无关编程

区别于寄存器和内存可以在(汇编)代码中寻址,缓存的使用是隐式的。即便在汇编语言中程序员也不能显式地将某个数据加载到某个缓冲区。

然而,仍然存在“「缓存感知」(cache aware)”的方式进行编程。若一段代码的复用操作数小于缓冲区大小,这些数据经过第一次访问后将在第二次访问时暂时停留在缓存中;另一方面,若数据量超过了缓存的大小,那么在访问的过程中,它将部分或全部被冲出缓存。

我们可以通过实验来证明这个现象。用一个非常精确的计数器:

1 | for (x=0; x<NX; x++) |

将花费$N$的线性时间,直到$a$填满缓存的时候。一个更容易理解的方法是计算归一化的时间,基本上是每次执行内循环的时间。

1 | t = time(); |

归一化的时间将是恒定的,直到阵列$a$填满缓存,然后增加,最终再次持平。(见1.7.3节的详细讨论)解释是,只要 $a[0]…a[N-1]$ 适合在L1缓存中,内循环就会使用L1缓存中的数据。访问的速度由L1缓存的延迟和带宽决定。当数据量的增长超过L1缓存的大小时,部分或全部的数据将从L1缓存中刷出,而性能将由L2缓存的特性决定。让数据量进一步增长,性能将再次下降到由主内存的带宽决定的线性行为。

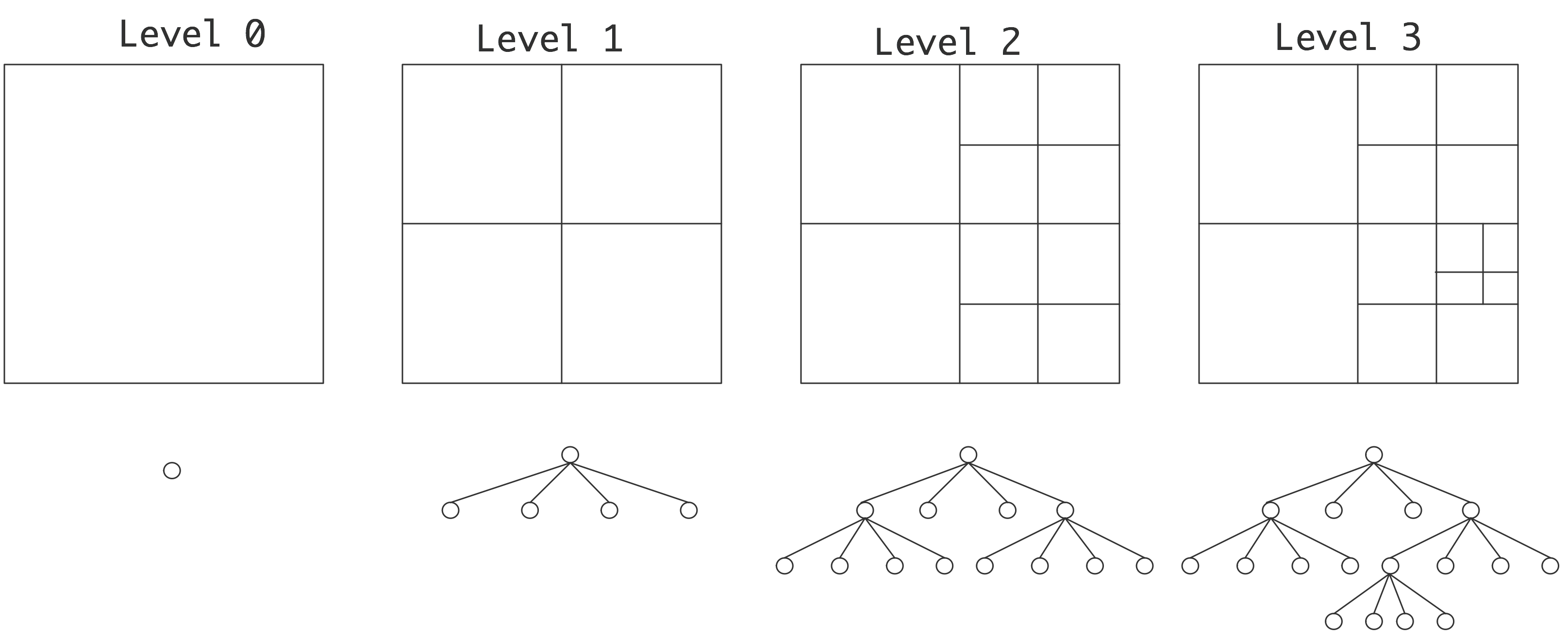

如果知道高速缓存的大小,在如上的情况下,就有可能安排算法来最佳地使用高速缓存。但是,每个处理器的缓存大小是不同的,所以这使得我们的代码不能移植,或者至少其高性能不能移植。另外,对多级缓存模块化也很复杂。由于这些原因,有些人主张采用「缓存无关编程」(cache oblivious programming)[70]。

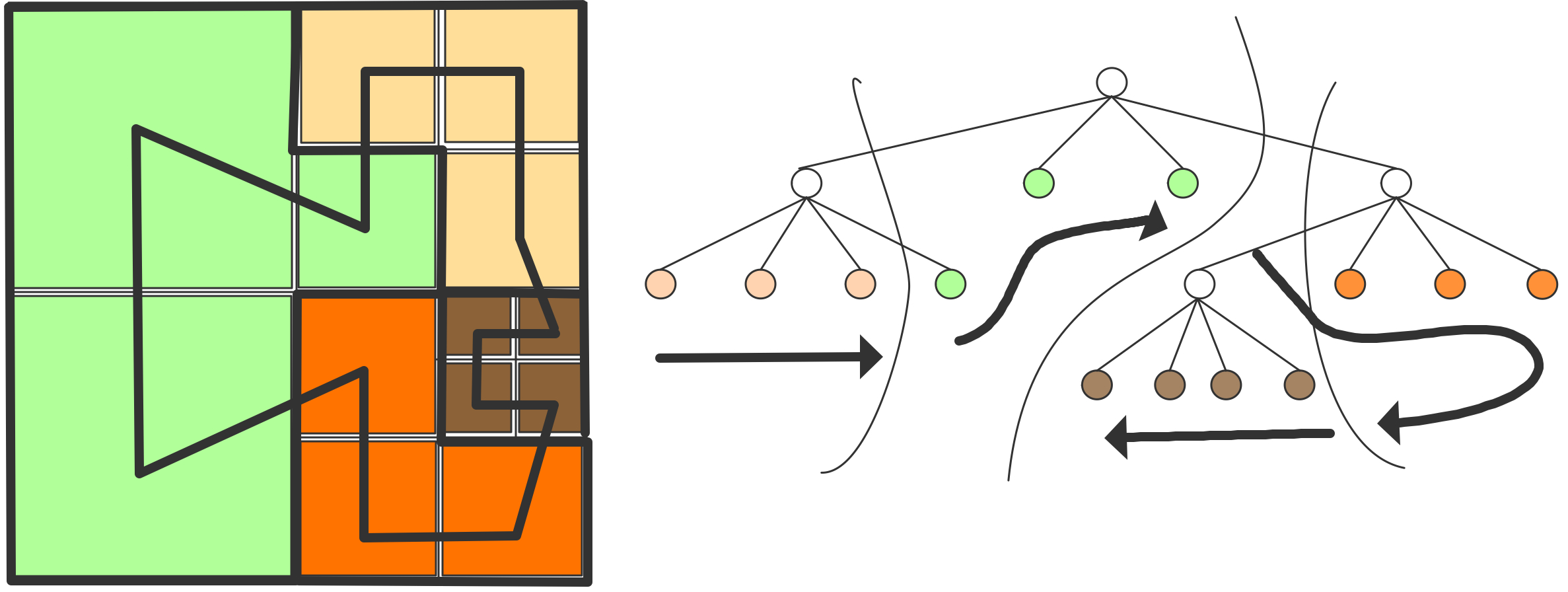

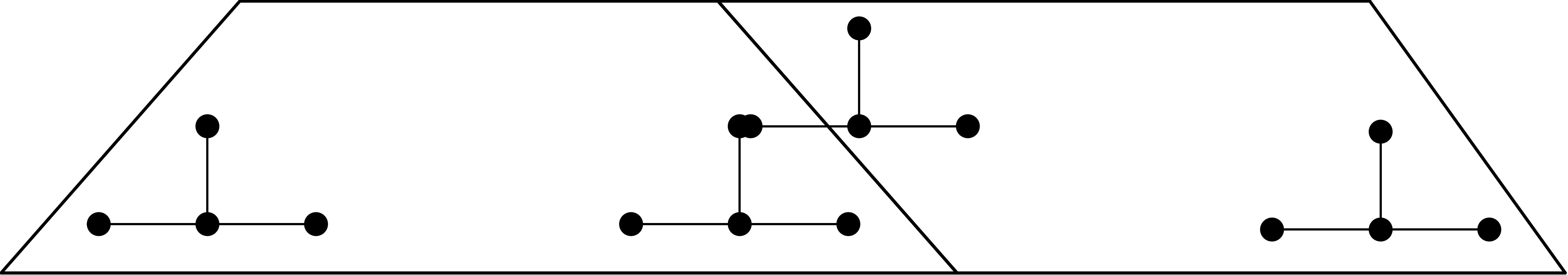

缓存无关编程可以被描述为一种自动使用所有级别的缓存层次的编程方式。这通常是通过使用「分治」(divide-and-conquer)的策略来实现的,也就是对问题进行递归细分。

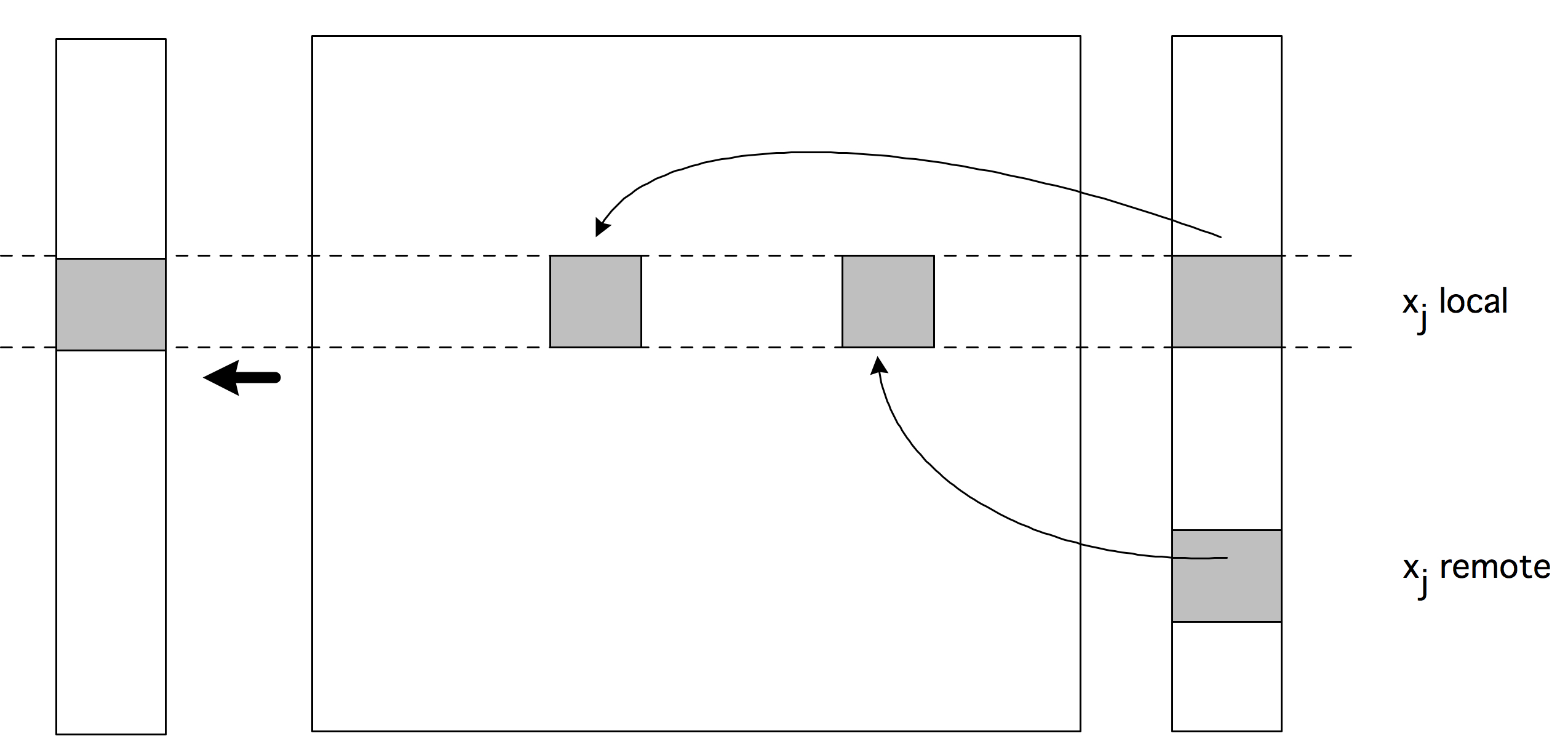

缓存无关编程的一个简单例子是矩阵转置操作 $B \leftarrow At$。首先我们观察到,两个矩阵的每个元素都被访问一次,所以唯一的重用是在缓存线的利用上。如果两个矩阵都是按行存储的,我们按行遍历 $B$,那么 $A$ 是按列遍历的,每访问一个元素就加载一条缓存线。如果行数乘以每条缓存线的元素数超过了缓存容量,那么在重新使用之前,行将被更新。

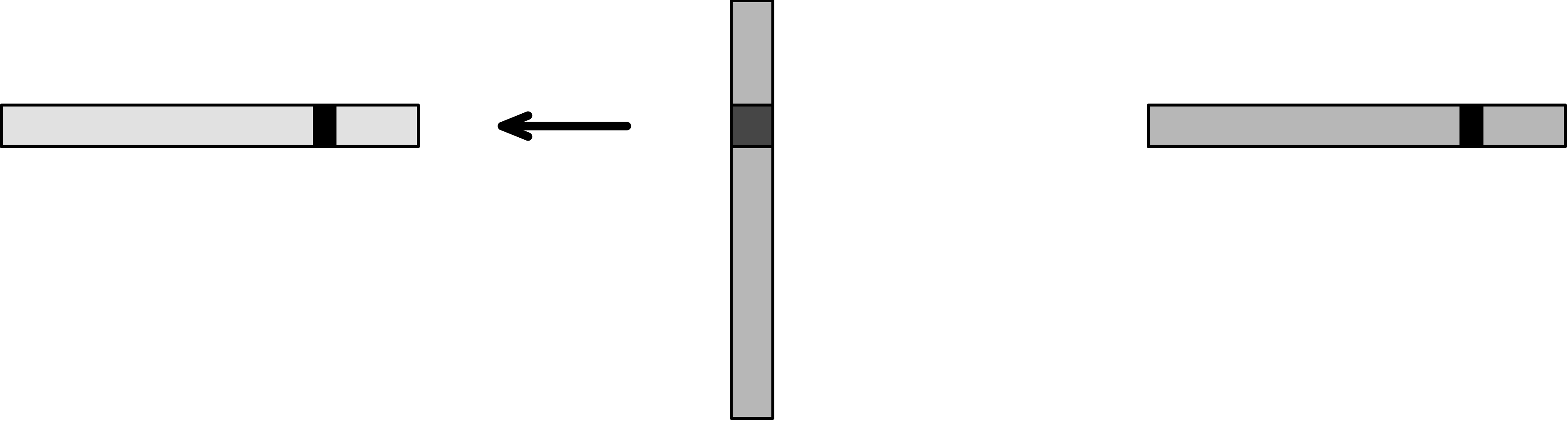

矩阵转置操作,源矩阵的简单和递归遍历

在缓存无关的实现中,我们将$A$和$B$划分为2$\times$2的块矩阵,并递归计算$B_{11} \leftarrow A_{11}^t, B_{12} \leftarrow A_{21}^t$ 等等,见上图。在递归的某一点上,块$A_{ij}$现在将小到足以容纳在缓存中,并且$A$的缓存线将被完全使用。因此,这个算法比简单的算法提高了一个系数,等于缓存线的大小。

缓存遗忘的策略通常可以产生改进,但它不一定是最佳的。在矩阵与矩阵乘积中,它比朴素的算法有所改进,但是它还不如一个明确设计为优化使用缓存的算法[85]。

参见第6.8.4节关于模版计算中的此类技术的讨论。

矩阵与向量乘积的案例研究

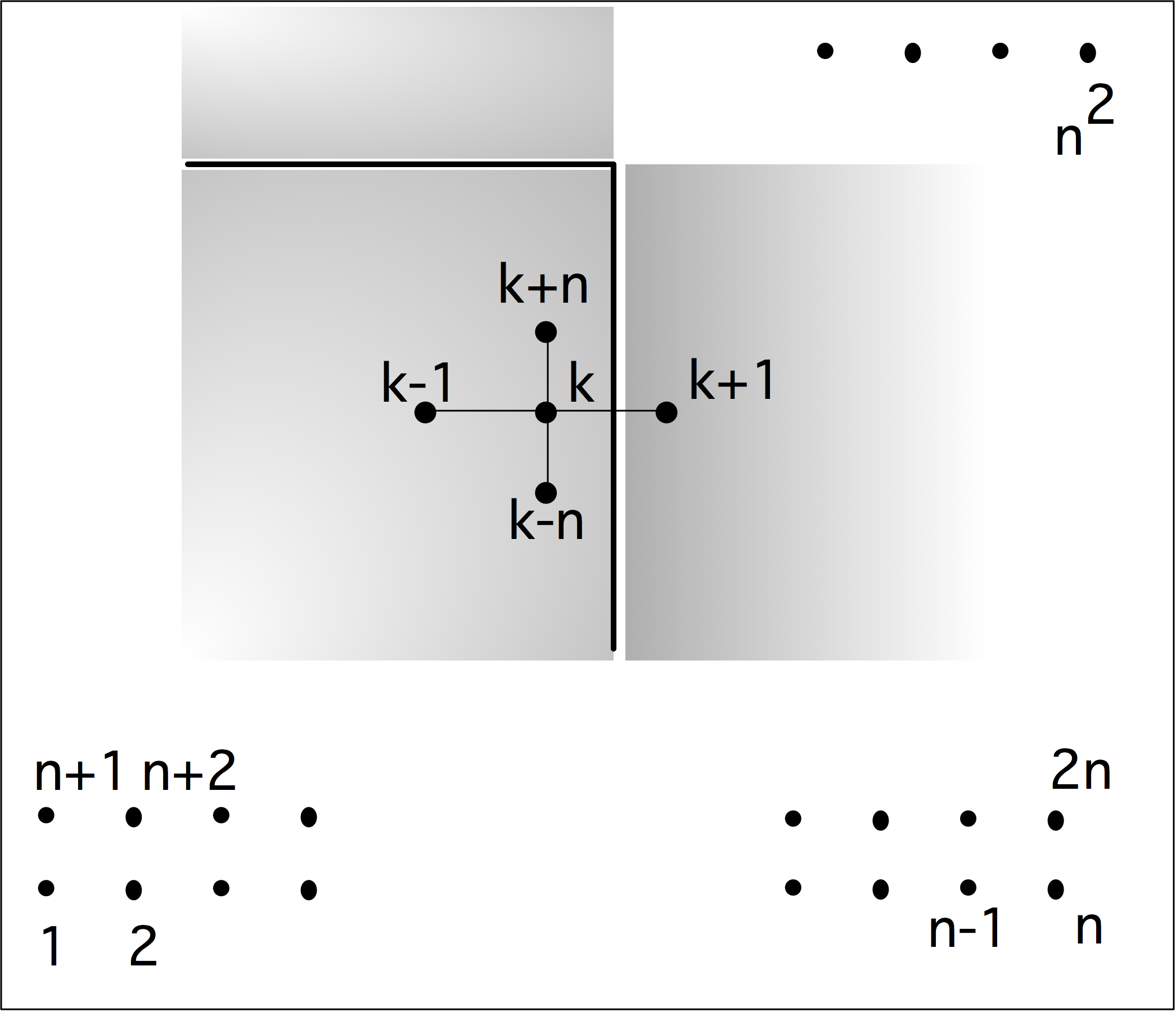

考虑如下的矩阵向量乘积:

这涉及到对$n^2+2n$数据项的 $2n^2$操作,所以重用率为𝑂(1):内存访问和操作的顺序相同。然而,我们注意到,这里涉及到一个双循环,而且$x,y$向量只有一个索引,所以其中的每个元素都被多次使用。

利用这种理论上的再利用并非易事。在

1 | /* variant 1*/ |

元素$y[i]$ 似乎被重复使用。然而,这里给出的语句会在每次内存迭代中把$y[i]$写入内存,我们必须把循环写成:

1 | /* variant 2 */ |

以保证重复使用。这个变体使用了$2n^2$的负载和$n$的存储。

这个代码片段只是明确地利用了$y$的重复使用。如果缓冲区太小,不能容纳整个向量$x$和$a$的一列,$x$的每个元素仍然在每个外层迭代中被重复加载。将循环反转为

1 | /* variant 3 */ |

暴露了$x$的重复使用,特别是如果我们把它写成:

1 | /* variant 3 */ |

此外,我们现在有$2n^2+n$的负载,与variant 2相当,但有$n^2$的存储,这是一个更高的顺序。

我们有可能重复使用$𝑥$和$𝑦$,但这需要更复杂的编程。这里的关键是将循环分成若干块。比如说

1 | for (i=0; i<M; i+=2){ |

这也被称为「循环展开」(loop unrolling),或「Strip mining」。循环展开的层数由可用寄存器的数量决定。

拓展探究

功率消耗

高性能计算机的另一个重要话题是其功耗。在这里,我们需要区分单个处理器芯片的功耗和一个完整的集群的功耗。

随着芯片上组件数量的增加,其功耗也会增加。幸运的是,在一个反作用的趋势下,芯片特征的小型化同时也在减少必要的功率。假设特征尺寸$\lambda$(想想看:导线的直径)按比例缩小到$s\lambda$,其中$s<1$。为了保持晶体管中的电场不变,通道的长度和宽度、氧化物厚度、基质浓度密度和工作电压都按相同的因素进行缩放。

缩放属性的推导

「恒电场按比例缩小」(constant field scaling)或Dennard缩放的特性[18, 44]是对电路微型化时的特性的理想情况描述。一个重要的结果是,当芯片特征变小时,功率密度保持不变,而频率同时增加。从电路理论中得出的基本属性是,如果我们将特征尺寸缩小$s$。

| 属性 | 情况 |

|---|---|

| Feature size | ~s |

| Voltage | ~s |

| Current | ~s |

| Frequency | ~s |

则可以推导:

而由于电路的总尺寸也随着 $ s^2$ 的减少而减少,功率密度不变。因此,在一个点路上放置更多的晶体管也可能从根本上不改变冷却问题。

这一结果可以被认为是「摩尔定律」(Moore’s law)背后的驱动力,摩尔定律指出,处理其中的晶体管数量每18个月翻一番。一个程序所需的与频率有关的部分功率来自于对电路电容的充电和放电,因此

| 状态 | 公式 |

|---|---|

| 充电 | q = CV |

| 工作 | W=qV=$CV^2$ |

| 功率 | W/time = WF = CV^2F |

这一分析可以用来证明引入多核处理器的合理性。

多核

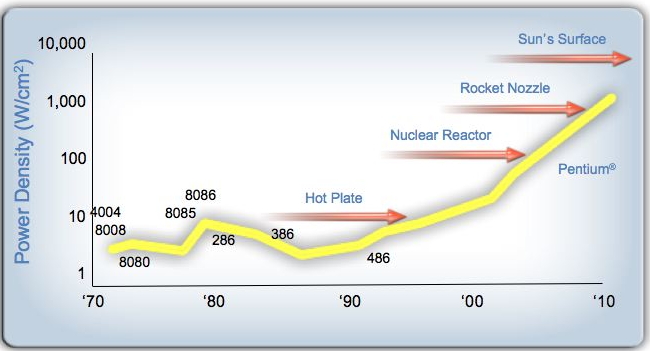

在2010年左右,元件的微型化几乎已经停滞不前了,因为降低电压已经达到了峰值。频率也不能扩大,因为这将提高芯片的发热量,导致芯片的发热量过大,下图给出了一种戏剧化的例子。说明了一个芯片所产生的热量,如果采用单核结构:

如果趋势继续下去,CPU的预计散热量情况 - (由Pat Helsinger提供)

处理器的趋势仍在继续。

一个结论是:计算机设计正在面临一道「功率墙」(power wall),单核的复杂性不能再增加了(所以我们不能再增加ILP和流水线深度),提高性能的唯一途径是增加明确可见的并行性。这一发展导致了当前一带多核处理器的出现。这也是GPU以其简化的处理设计并因此降低能耗而具有吸引力的原因。回顾上述共识,讲一个处理器与两个频率为一般的处理器进行比较,这应该具有相同的计算能力,对吗?由于我们降低了频率,如果我们保持相同的工业技术,我们可以降低电压。

理想情况下,两个处理器核心的总电功率为:

在实际中,电容会上升到2以上,而电压则不可能完全下降2,所以更可能是$P_{multi}\approx 0.4 \times P$ 当然,集成方面的问题在实践中要复杂一些[19];重要的结论是,现在为了降低功率(或者反过来说,为了在保持功率不变的情况下进一步提高性能),我们现在必须开始并行编程。

计算机总功率

并行计算机的总功率由每个处理器的功率和全部的处理机器数量决定。目前,这通常是几兆瓦。根据上述推理,增加处理器数量所需的功率增加已经不能被更多的高能效处理器所消耗,所以当并行计算机从petascale(2008年IBM的 Roadrunner达到)到预计的exascale时,功率正在成为压倒一切的考虑因素。

在最近几代的处理器中,功率正在成为压倒一切的考虑因素,并且在不可能的地方产生影响。例如:「单指令多数据」(Single Instruction Multiple Data,SIMD)设计是由解码的功率成本决定的。

操作系统影响

HPC从业人员通常不怎么担心操作系统(OS)。然而,有时可以感觉到操作系统的存在进而影响到性能。其原因是「周期性中断」(periodic interrupt),即操作系统每秒中断当前进程100次以上,以让另一个进程或系统守护进程拥有一个时间片。

如果只运行一个程序,我们不希望出现开销和抖动,以及进程运行时间的不可预测性,这就引入了一个问题。因此,已经存在的计算机基本上不需要有操作系统来提高性能。

周期性中断有进一步的负面影响。例如,它污染了高速缓存和TLB。作为抖动的细微影响,它降低了依赖线程间障碍的代码的性能,比如经常发生在OpenMP中。

特别是在金融应用中,非常严格的同步是很重要的,我们采用了一种Linux内核模式,周期性定时器每秒只跳动一次,而不是数百次。这就是所谓的tickless内核。

复习题

判断真假,若为假则请你给出解释

练习 1.25 判断

1 | for (i=0; i<N; i++) |

对a和b中的每个元素都遍历一次,所以每个元素都会有一次缓存丢失。

练习 1.26 请举例说明3路关联缓存会有冲突,但4路缓存不会有冲突的代码片段。

练习 1.27 考虑用一个$N\times N$的矩阵向量积。在执行这个操作时,需要多大的缓存容量才会出现强制性的缓存丢失?你的答案取决于操作的实现方式:分别回答矩阵的行和列的遍历,你可以假设矩阵总是按行存储。

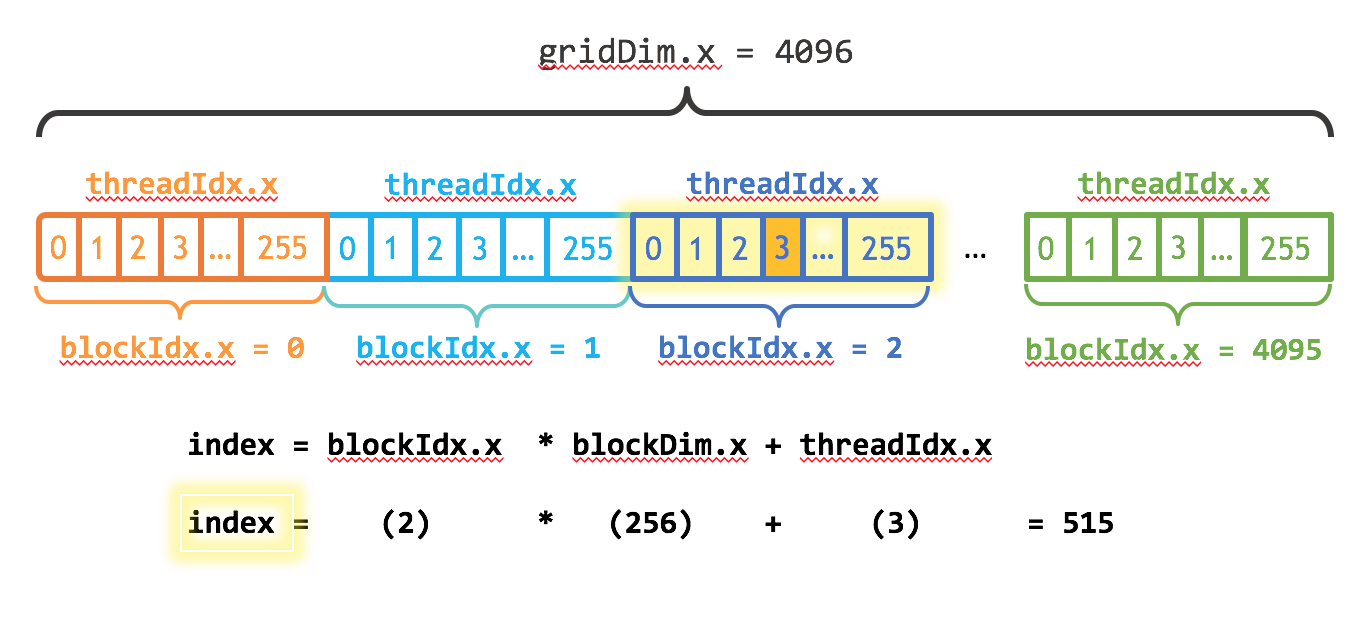

并行计算

规模最大且运算能力最强的计算机通常被称为 “超级计算机”。在过去的二十年里,超级计算机的概念无一例外地指向拥有多个CPU且可同时处理一个问题的机器——并行计算机。

我们很难精确定义并行的概念,因为它在不同的层面上有着不同的含义。在上一章中,同一个CPU内部可以有若干条指令同时“执行”,这是所谓的「指令级并行」(instruction-level parallelism,ILP)。指令级并行并不在用户的控制范围内,而是由编译器和CPU共同决定。另一种并行的概念为多个处理器同时处理一条以上的指令,每个处理器都在自己所在的电路板上,这种并行可以由用户显式地调度。

这一章中,我们将分析这种更明确的并行类型,支持它的硬件,使其成为可能的编程,以及分析它的概念。

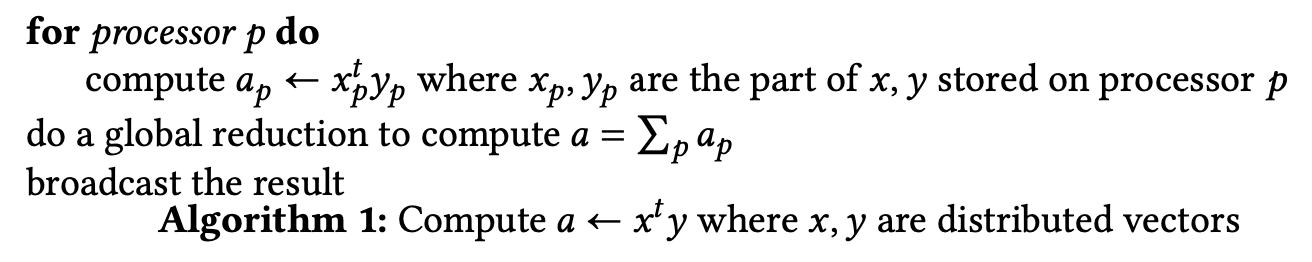

引言

在科学计算中,我们常常需要处理大量且有规律的操作。有没有一种并行计算机可以加快这项工作?假设我们需要执行$n$步操作,且每一步操作在单处理器上需要花费的时间为$t$,那么使用$p$个处理器,我们能否在$t/p$的时间内完成这些工作?

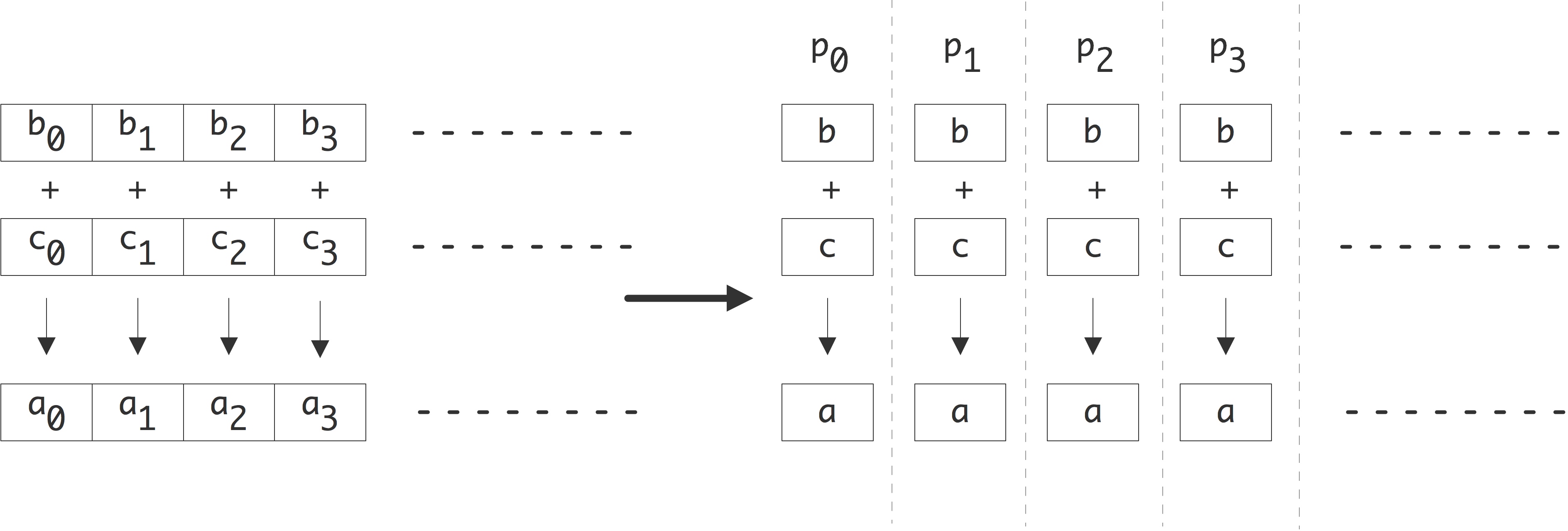

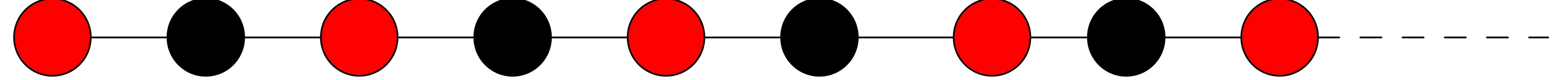

让我们先从一个简单的例子开始。假设需要将两个长度为$n$的向量相加:

1 | for (i=0; i<n; i++) |

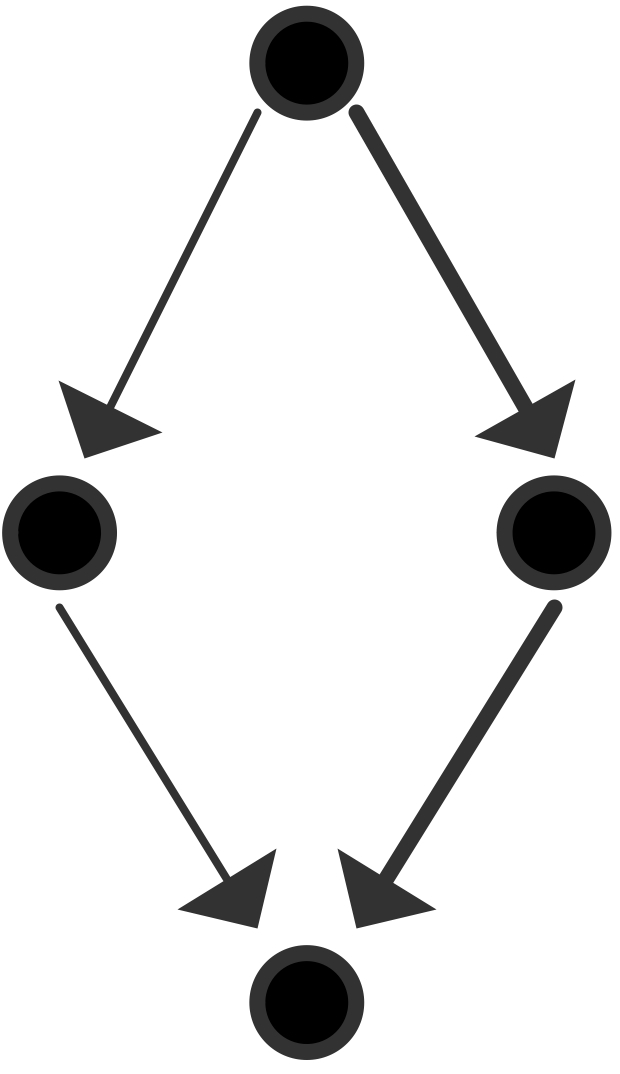

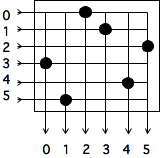

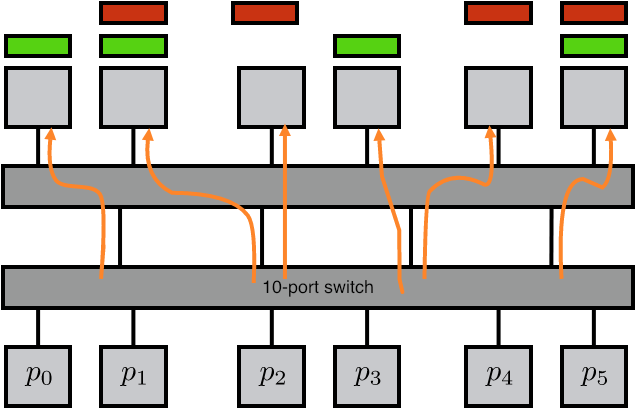

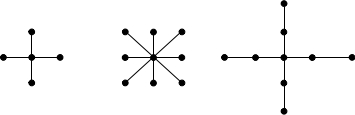

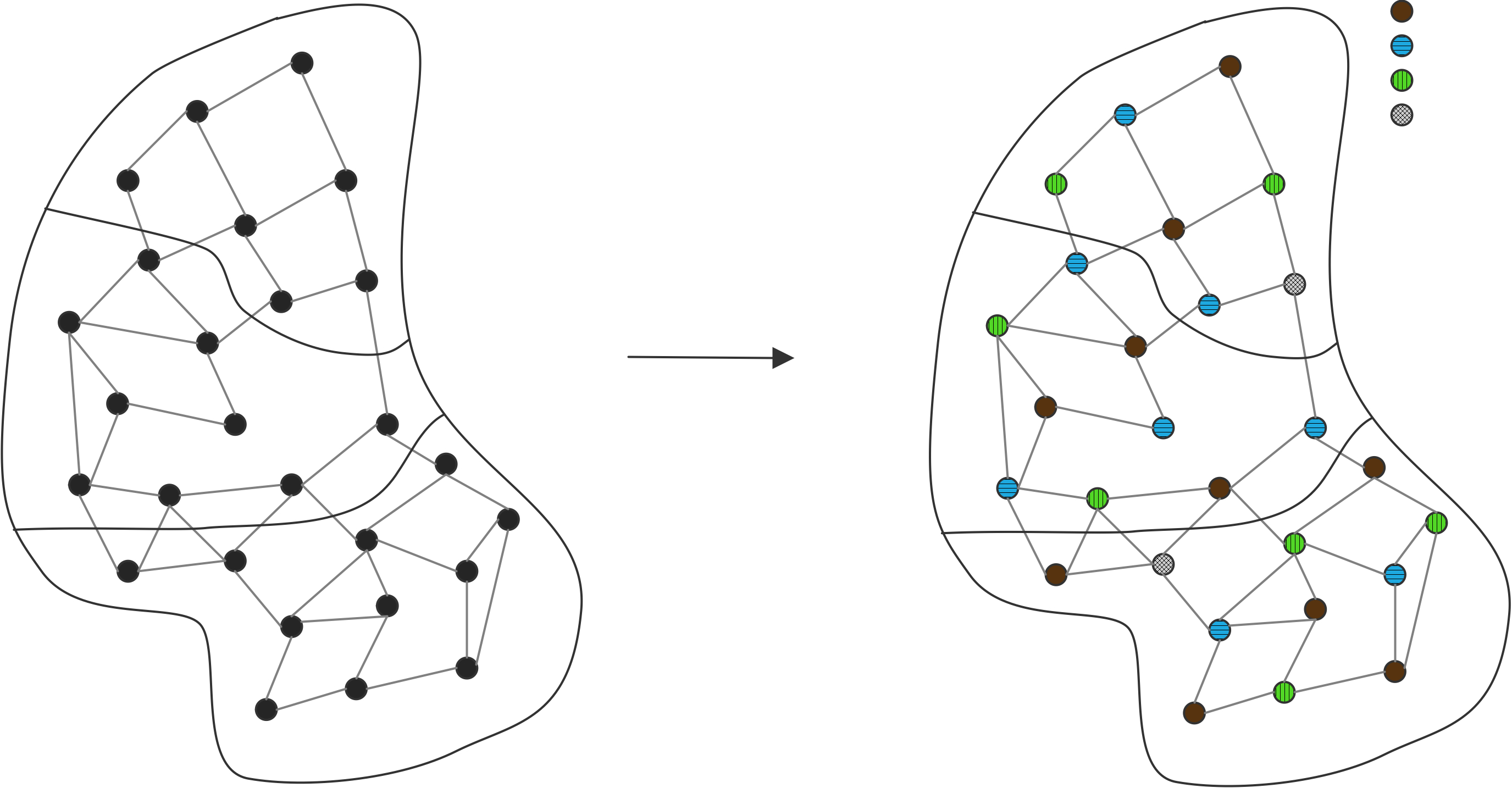

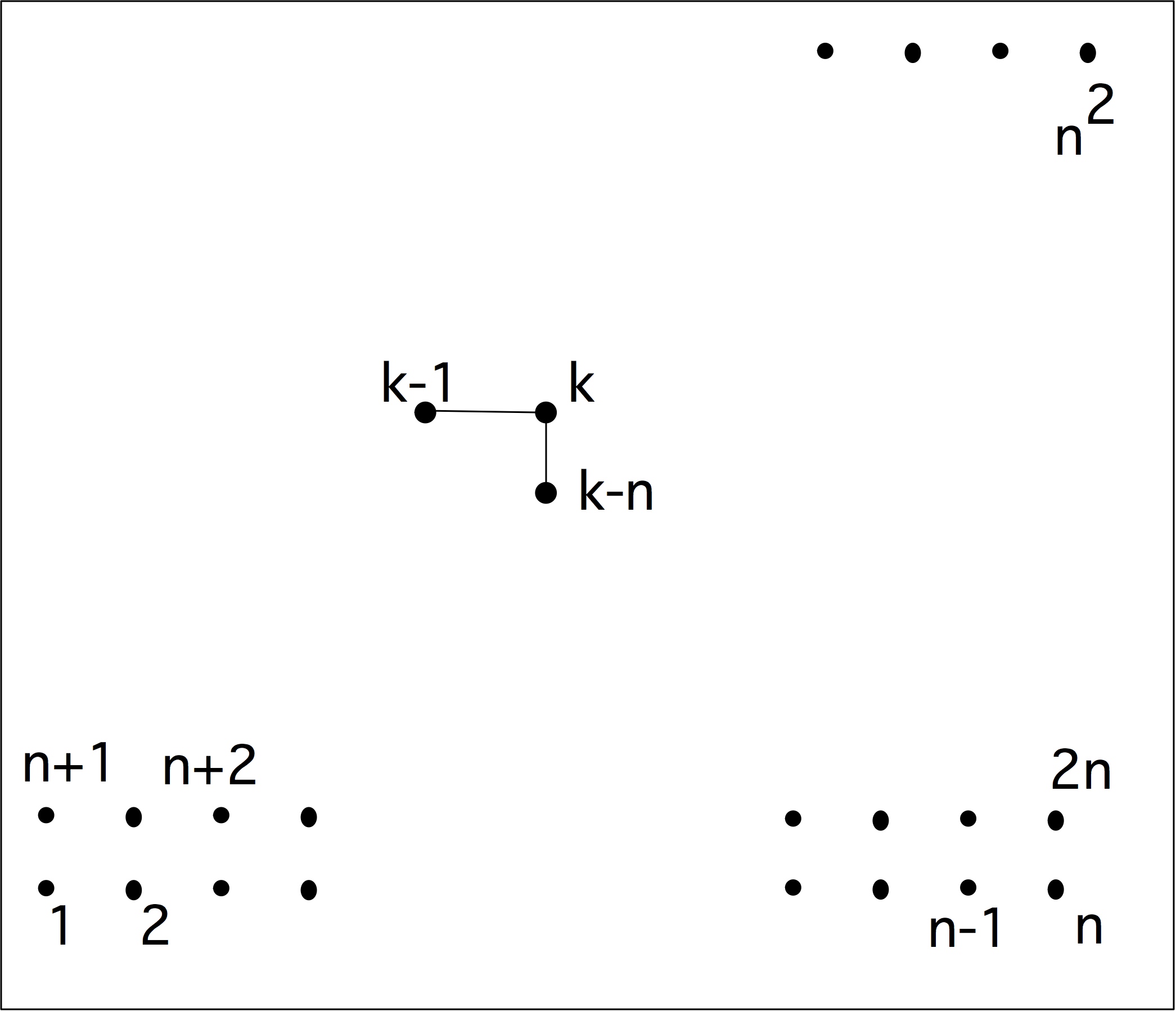

最多可以用$n$个处理器来完成。下图所示中,每个处理器都存储一个a,b,c,且各自执行单一指令:a=b+c。

一般情况下,每个处理器执行的指令类似于

1 | for (i=my_low; i<my_high; i++) |

程序执行的时间随着处理器数量的增加而线性减少。若定义每步操作为单位时间,原始算法耗时$n$,而在$p$个处理器上的并行执行需要的时间为$n/p$,并行后的速度是原来的$p$倍。

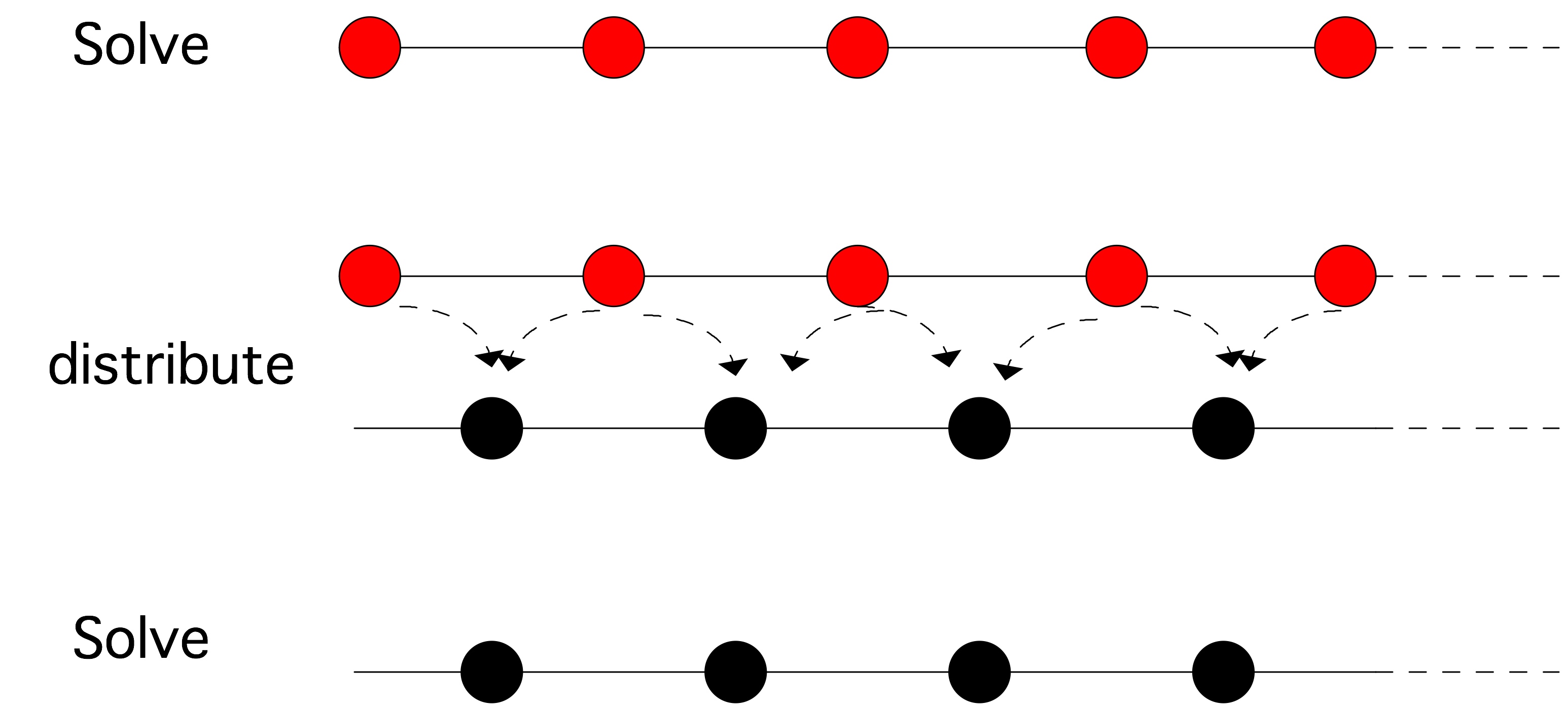

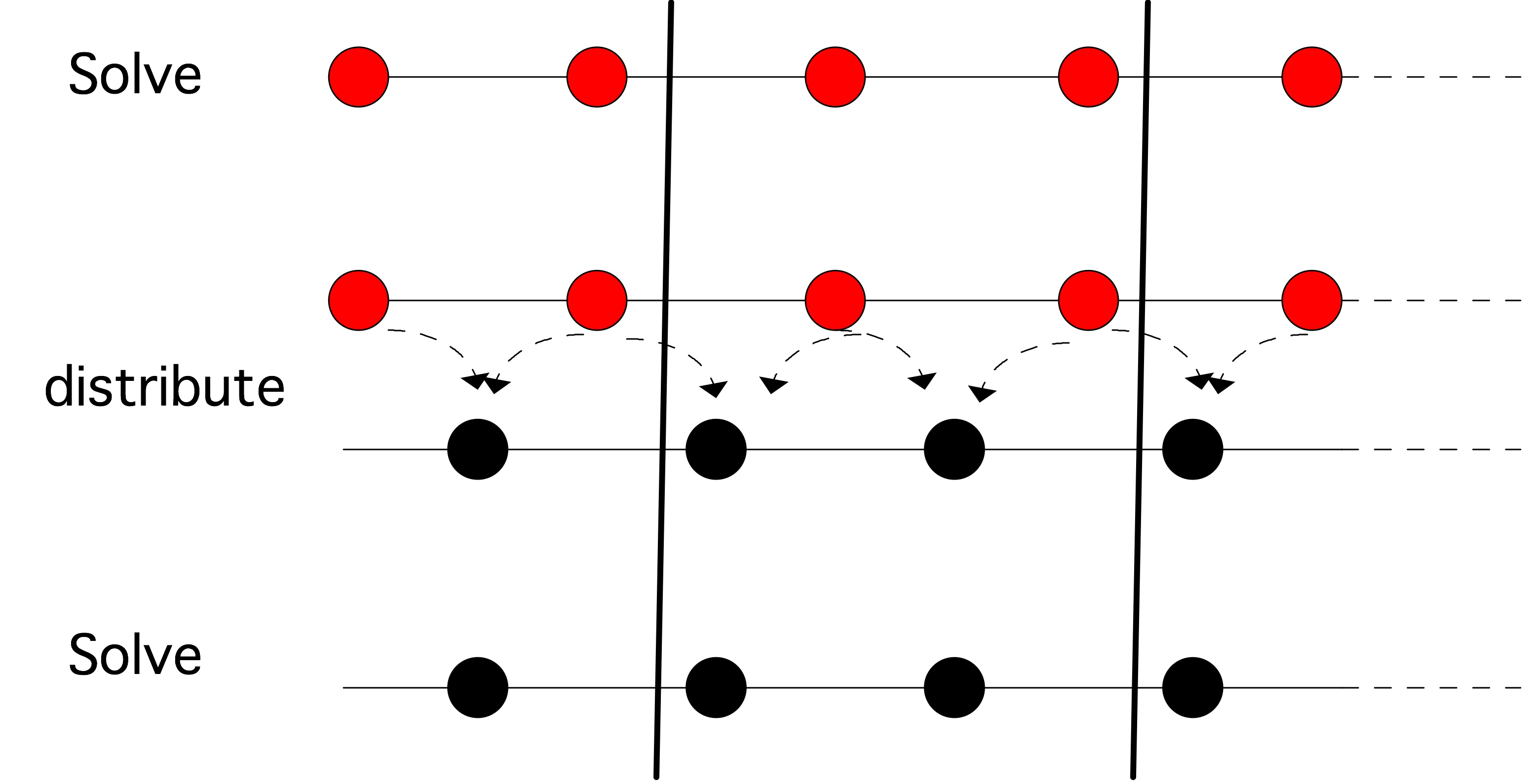

输入一个向量而得到一个标量的操作通常称为规约(reduction)

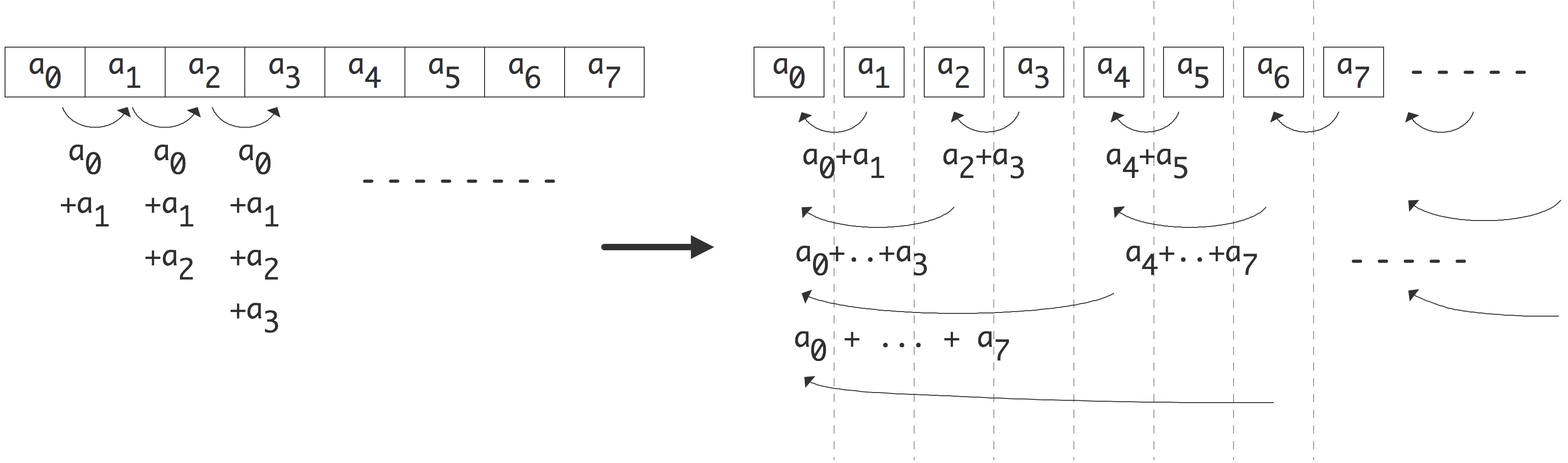

下面我们考虑对向量内各元素求和,假设每个处理器只包含一个数组中的元素,顺序执行:

1 | s = 0; |

这段代码的并行情况并不明显,但如果我们将循环改写成:

1 | for (s=2; s<2*n; s*=2) |

则可以找到相应的方法将其并行化:外循环的每一次迭代现在都是一个可以由$n/s$处理器并行完成的循环。由于外循环将经过 $log_2n$次迭代,我们可以看到新算法的运行时间缩短为$n/p⋅log_2n$。并行算法的速度比原来快了 $p/log_2n$倍。

从这两个简单的例子中可以看到并行计算的一些特点:

算法被稍加改写后可以成为并行算法。

并行算法并不一定能达到理想加速效果。

此外,第一种情况下每个处理器的$x_i, y_i$都在本地存储,这不会造成额外的时间开销;但在第二种情况下,处理器之间需要进行数据通信,这又会造成大量的开销。

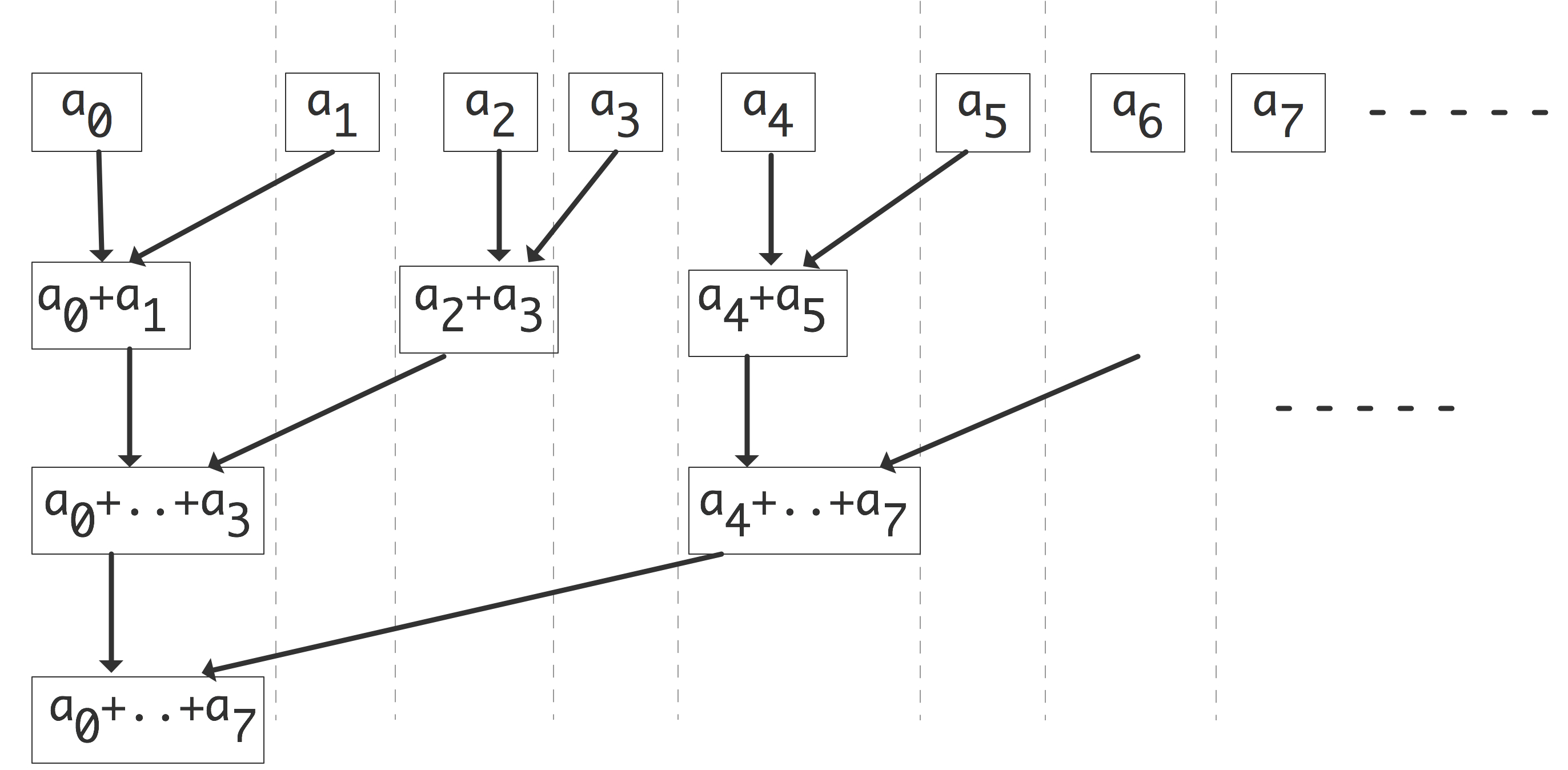

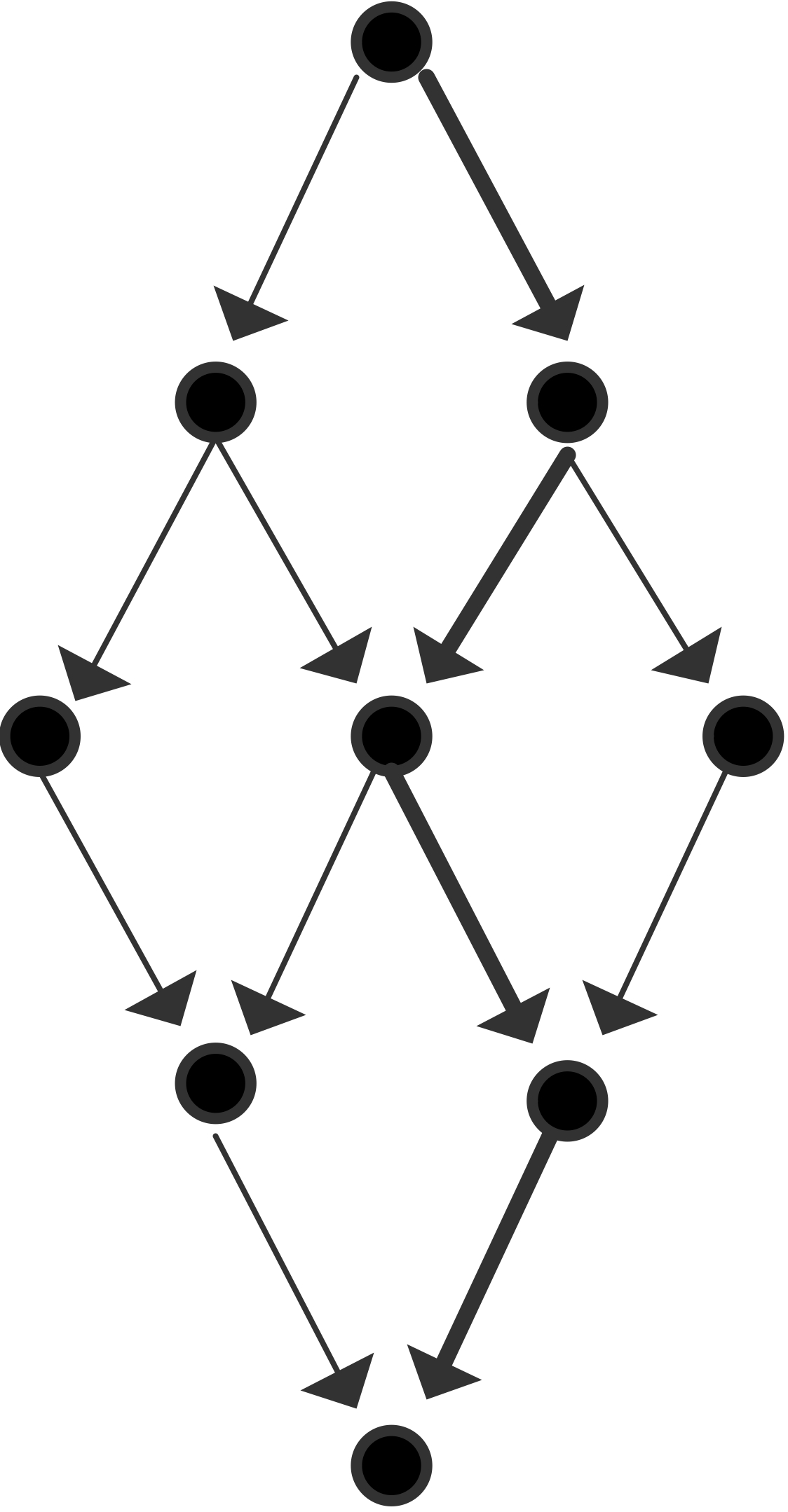

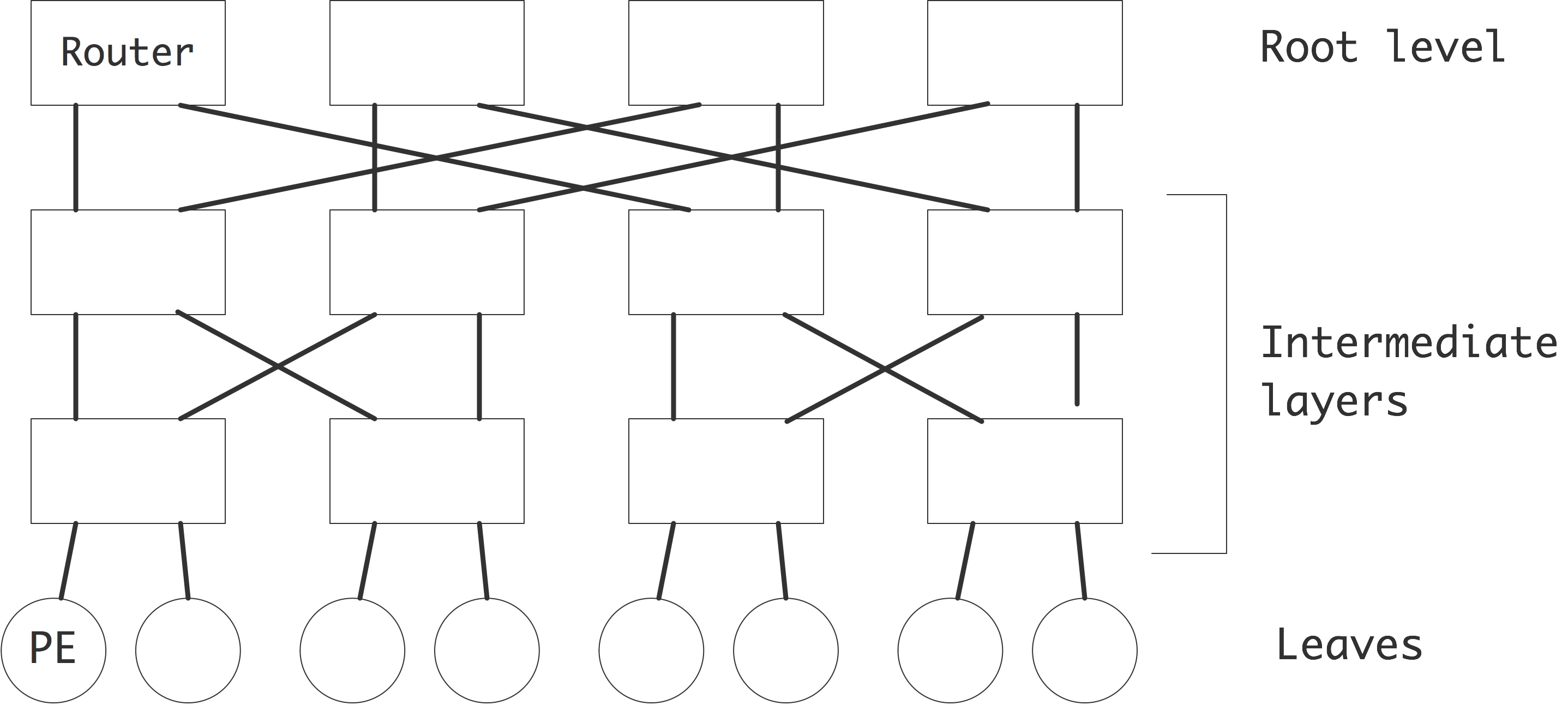

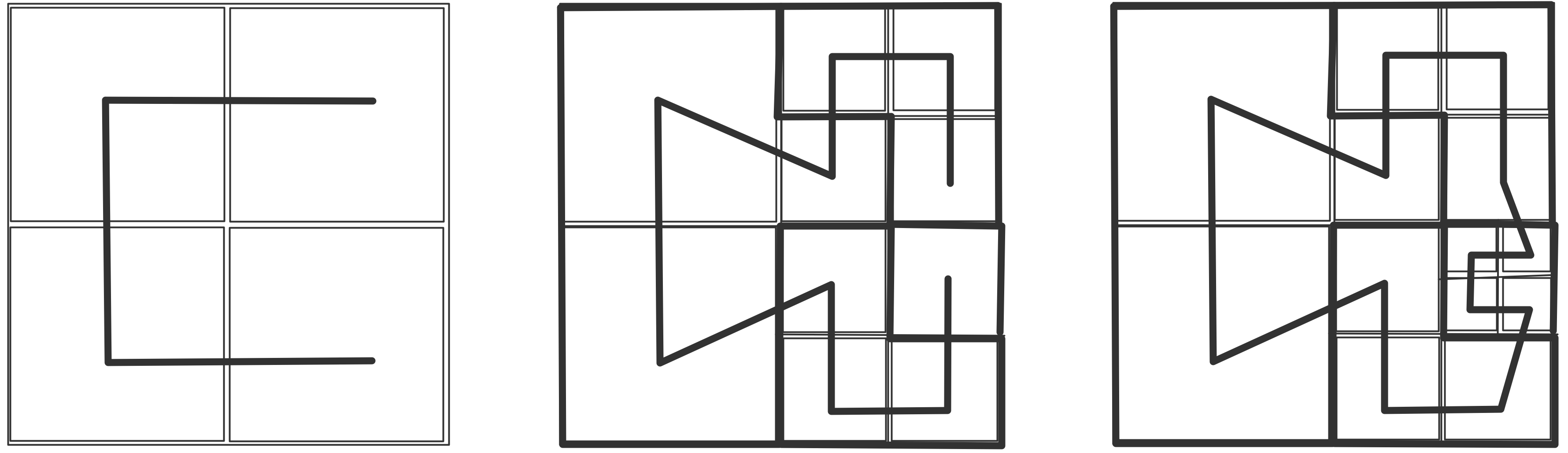

下面我们讨论通信。我们可以把上图右半部分的并行算法变成一个树状图,把输入定义为树的节点,将所有的加和操作视为内部节点,总和作为根节点。如果一个节点是另一个节点的(部分)和的输入,则有一条从一个节点到另一个节点的边。在这个树状图中,可同时计算的元素放置在同一层级;每一级有时被称为「超步计算」(superstep)。垂直排列的节点意味着计算是在同一处理器上完成的,从一个处理器到另一个处理器的箭头对应着一次通信。树状图中的排列顺序并非唯一。如果节点在一个超步或水平层级上重新排列,就会出现不同的通信模式。

练习 2.1 考虑将超步内的节点放在随机处理器上。表明如果没有两个节点出现在同一个处理器上,那么最多只能进行两倍于图中的通信数量。

练习 2.2 你能画出在每个处理器上留下总和结果的计算图吗?有一种解决方案需要两倍的超步,也有一种解决方案需要相同的数量。在这两种情况下,图不再是一棵树,而是一个更普遍的「有向无环图」(Directed Acyclic Graph,DAG)。

处理器之间通常通过网络连接,由于网络之间传输数据需要时间,我们引入处理器之间距离的概念。在上文树状图中,处理器的排列是线性的,这与它们在排序中的等级有关。如果网络只连接一个处理器和它的邻节点,外循环的每一次迭代都会增加通信的距离。

练习 2.3 假设一个加法操作需要一个单位时间,而把一个数字从一个处理器移到另一个处理器也需要同样的单位时间。证明通信时间等于计算时间。

现在假设从处理器$p$发送一个数字到$p \pm k$需要时间$k$。说明现在并行算法的执行时间与顺序时间是一样的。求和的例子做了一个不现实的假设,即每个处理器最初只存储一个向量元素:实际上我们会有$p < n$,每个处理器都会存储一些向量元素。明显的策略是给每个处理器一个连续的元素序列,但有时明显的策略并不是最好的。

练习 2.4 考虑用4个处理器对8个元素求和的情况。表明图2.3中的一些边不再对应于实际通信。现在考虑用4个处理器对16个元素进行求和。这次通信边的数量是多少?

这些关于算法适应性、效率和通信的问题,对所有的并行计算都是至关重要的。在本章中,我们将以各种形式回到这些问题上。

功能性并行与数据级并行

从上面的介绍中,我们可以将并行概念定义为:在程序的执行过程中寻找独立的操作。这些独立的操作往往其执行逻辑相同,只是用于不同的数据项。我们把这种情况称为「数据级并行」(data parallelism):同一操作被并行地应用于许多数据元素,这在科学计算中是十分常见的。并行性往往源于这样一个事实:一个数据集(向量、矩阵、图……)被分散到许多处理器上,每个处理器都在处理其数据的一部分。

如果是单指令操作,传统上多采用数据级并行;如果是在子程序下处理,则通常称为「任务并行」(task parallelism)。

我们一定可以找到这样一种场景,使得指令之间相互独立且无依赖关系。一般情况下,编译器根据指令级并行来分析、运行代码:一条独立的指令可以被赋予给一个独立的浮点单元,也可以在优化寄存器时被重新排列。(同样参考2.5.2节)。

指令级并行是功能性并行的一种情况;功能并行可以通过连接相互独立的子程序来获得。在更高层次上,功能并行可以通过包含独立的子程序来获得,通常称为任务并行;见2.5.3节。

功能性并行的一些例子是蒙特卡洛模拟,以及其他穿越参数化搜索空间的算法。一个参数化的搜索空间,如布尔可满足性问题。

算法中的并行性与代码中的并行性

有时程序可以直接并行化处理,例如上文讨论的向量加法;有时我们很难找到简易的并行策略,例如在6.10.2节中将要讨论线性递归;而有些情况下,代码看起来可能没办法并行,但我们可以从理论上进行并行化处理。

练习 2.5 回答下列有关双循环$i,j$的问题。

1 | for i in [1:N]: |

1 | for i in [1:N]: |

- 内循环的迭代是否独立,也就是说,它们是否可以同时执行?

- 外循环的迭代是否独立?

- 如果$x[1,1]$是已知的,说明$x[2,1]$和$x[1,2]$可以独立计算。

- 这是否让你对并行化策略有了一个想法?

我们将在第6.10.1节讨论这个难题的解决方案。总的来说,第6章的全部内容都将是关于科学计算算法中内在的并行性数量。

理论概念

使用并行计算机有两个重要原因:获得更多的内存或者获得更高的性能。用更多的内存的原因很容易解释,因为总内存是各个内存的总和;而并行计算机的速度则较难描述。本节将对采用并行架构后的措施和理论速度进行拓展讨论。

定义

加速比和效率

对比同一个程序在单处理器上运行的时间与$p$个处理器上的运行时间可以得到加速比,设$T_1$是在单个处理器上的执行时间,$T_p$是在$p$个处理器上的运行时间,则加速比为$S_p=T_1/T_p$(有时$T_1$被定义为 “在单个处理器上解决问题的最短时间”,这允许在单个处理器上使用不同于并行的算法)。 在理想情况下,$T_p=T_1/p$,但在实际中往往难以达到,因此$S_p\leqslant p$。为了衡量我们离理想的加速有多远,我们引入了效率$E_p = S_p/p$。显然,$0<E_p≤1$。

上面的定义会产生一个问题:某个需要并行解决的问题由于规模太大,无法在任何一个单独的处理器上运行;反之,将单处理器上的问题拆解在多处理器上,由于每个处理器上的数据非常少,因此可能会得到一个十分扭曲的结果。下面我们将讨论更现实的速度提升措施。

有各种原因导致实际速度低于𝑝。首先,使用多个处理器意味着额外的通信开销;其次,如果处理器并未分配到完全相同的工作量,则会产生一部分的闲置,就会造成「负载不均衡」(load unbalance),再次降低实际速度;最后,代码运行可能依赖其原有顺序。

处理器之间的通信是效率损失的一个重要来源。显然,一个不用通信就能解决的问题是非常有效的。这类问题实际上由许多完全独立的计算组成被称为「高度并行」(embarrassingly parallel),它们拥有接近完美的加速比和效率。

练习 2.6 加速比大于处理器数量被称为「超线性加速」(superlinear speedup)。请给出一个理论上的论据,为什么这种情况不会发生。

在实践中,超线性加速可能发生。例如,假设一个问题太大,无法装入内存,一个处理器只能通过交换数据到磁盘来解决。如果同一个问题适合在两个处理器的内存中解决,那么速度的提升很可能大于2,因为磁盘交换不再发生。拥有更少或更局部的数据也可以改善代码的缓存行为。

代价最优

在达不到理想加速比的情况下,我们可以将理想加速比与实际加速之间的差异定义为「额外开销」(overhead):

我们也可以把它解释为在单个处理器上模拟并行算法,与实际的最佳串行算法之间的差异。

我们以后会看到两种不同类型的开销。

并行算法可以与串行算法有本质上的不同。例如,排序算法的复杂度为$O(nlogn)$,但并行双调排序(8.6 节)的复杂度为$O(nlog^2n)$。

并行算法可以有来自于过程或并行化的开销,比如发送消息的成本。我们在6.2.2节中分析了矩阵与向量乘积中的通信开销。

如果一个并行算法与串行算法达到了数量级差距,那么该算法就被称为「代价最优」(cost-optimal)。

练习 2.7 上面的额外开销定义隐含地假定开销是不可并行的。在上述两个例子的背景下讨论这个假设。

渐近论

如果我们忽略一些限制,比如处理器的数量,或者它们之间的互连的物理特性,我们可以就推导出关于并行计算效率极限的理论结果。本节将简要介绍这些结果,并讨论它们与现实中高性能计算的联系。

例如,考虑矩阵与矩阵乘法$𝐶=𝐴𝐵$,它需要$2𝑁$步操作,其中$𝑁$是矩阵规模的大小。由于对$𝐶$元素的操作之间没有依赖性,我们可以并行地执行。如果我们有$𝑁^2$处理器,我们可以将每个处理器分配给$𝐶$中的$(𝑖,𝑗)$坐标,并让它在$2𝑁$时间内计算$c_{ij}$。因此,这个并行操作的效率为1,是最优的。

练习 2.8 证明这个算法忽略了关于内存的严重问题。

如果矩阵被保存在共享内存中,那么从每个内存位置同时读多少次?内存位置进行多少次读取?

如果处理器将输入和输出都保存在本地存储器中,那么有多少重复?

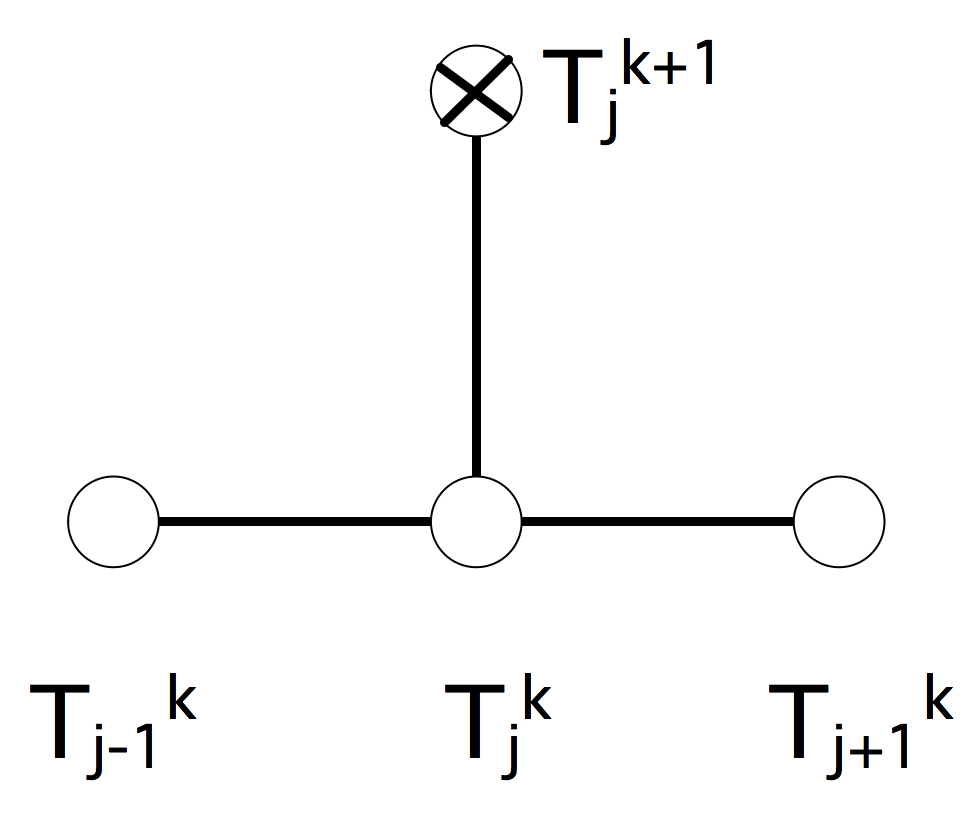

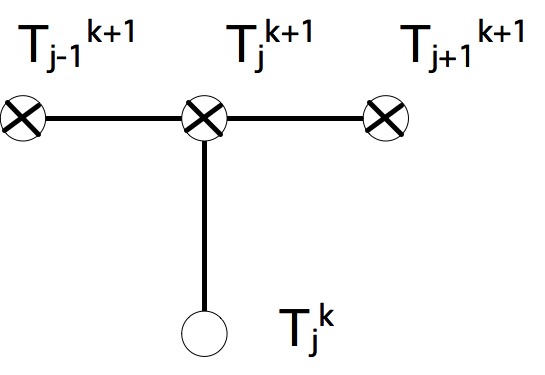

将𝑁数字$\{𝑥\}_{i=1…N}$相加,可以在对数𝑁时间内由𝑁/2个处理器完成。作为一个简单的例子,考虑$n$数之和:$𝑠 = \sum_{i=1}^n a_i$。如果我们有$n/2$个处理器,我们可以计算:

- 定义$s_i^{(0)} = a_i$

- 迭代$j=1,…,log_2n$:

- 计算$n/2^j$ 部分和$s_{i}^{(j)}=s_{2 i}^{(j-1)}+s_{2 i+1}^{(j-1)}$

我们看到,$n/2$ 个处理器在 $log_2n$的时间内总共完成了$n$的操作(应该如此)。这个并行方案的效率是$𝑂(1/ log_2 n)$,是一个缓慢下降的$n$的函数。

练习 2.9 请指出,使用刚才的并行加法方案,用$𝑁^3/2$个处理器在对数$log_2N$时间内完成两个矩阵的相乘所得的效率是多少?

现在,我们可以提出一个合理的理论问题

如果我们有无限多的处理器,矩阵与矩阵乘法的最低时间复杂度是多少?

是否有更快的算法仍然具有𝑂(1)的效率?

这类问题已经被前人研究过了(例如,见[100]),但它们对高性能计算没有什么影响。

对这些理论界线的第一个反对意见是,它们隐含地假定了某种形式的共享内存。事实上,这种算法模型被称为「PRAM模型」(Parallel Random Access Machine),是「RAM模型」(Random Access Machine)在共享内存系统上的扩展。该模型假设所有处理器共享一个连续的内存空间。此外,模型还允许同一位置上同时进行多个访问。这在实际应用中,特别是在扩大问题规模和处理器数量的情况下是不可能的。对PRAM模型的另一个反对意见是,即使在单个处理器上,它也忽略了内存的层次结构;1.3节。

但是,即使我们把分布式内存考虑在内,这个结果仍然是不现实的。上述求和算法确实可以在分布式内存中不变地工作,只是我们必须考虑随着进一步迭代,活跃处理器之间的距离会增加。如果处理器是由一个线性数组连接起来的,那么活跃处理器之间的 “跳跃 “次数就会增加一倍,渐进地,迭代的计算时间也会随之增加。总的执行时间变为𝑛/2,考虑到我们在问题上投入了这么多处理器,这个结果显然令人感到失望。

如果处理器是以超立方体拓扑结构连接的呢(2.7.5节)?不难看出,求和算法确实可以在$log_2n$的时间内完成。然而,当$𝑛\rightarrow \infty$时,我们能否建立一个由$n$节点组成的超立方体序列,并保持两个连接的通信时间不变?由于通信时间取决于延迟,而延迟部分取决于总线的长度,所以我们必须担心最近的邻居之间的物理距离。

这里的关键问题是,超立方体(𝑛维的物体)是否可以被嵌入到三维空间中,同时保持连接的邻居之间的距离(以米计算)不变。很容易看出,3维网格可以任意放大,同时保持总线的单位长度,但对于超立方体来说,这个问题并不明确。在这里,导线的长度可能会随着$n$的增加而增加,这就与电子的有限速度相抵触。

我们草拟了一个证明(详见[65]),即在我们的三维世界和有限的光速下,对于$𝑛$处理器上的问题,无论互连方式如何,速度都被限制在$\sqrt[4]{n}$。该论点如下。考虑一个涉及在一个处理器上收集最终结果的操作。假设每个处理器占用一个单位体积的空间,在单位时间内产生一个结果,并且在单位时间内可以发送一个数据项。那么,在一定的时间内,最多只有半径为$t$的球中的处理器,即$𝑂(𝑡^3)$处理器可以对最终结果做出贡献;所有其他处理器都离得太远。那么,在时间$T$内,能够对最终结果做出贡献的操作数$\int_{0}^{T} t^{3} d t=O\left(T^{4}\right)$.在时间$T$内,这意味着,最大的可实现的速度提升是串行时间的四次方根。

最后,”如果我们有无限多的处理器怎么办 “这个问题本身并不现实,但请先不要急着将它抛弃,我们在后面提出弱可扩展性问题时还会讨论它(第2.2.5节)。”如果我们让问题的大小和处理器的数量成比例增长怎么办”。这个问题是合理的,因为它与购买更多的处理器是否可以运行更大的问题,以及如果可以的话,有什么 “好处 “等非常实际的考虑相一致。

阿姆达尔定律

无法达到理想加速比的一个原因是,部分代码依赖固有顺序执行。假设有5%的代码必须串行执行,那么这部分的时间将不会随着处理器的数量增加而减少。因此,对该代码的提速被限制在20的系数。这种现象被称为「阿姆达尔定律」(Amdahl’s Law)[4],下面我们将对其进行表述。

令$F_s$分别为代码的串行部分,$F_p$为代码的并行部分(更严格地说法应该为:”可并行 “部分)。那么$F_p + F_s = 1$。在$p$个处理器上的并行执行时间$T_p$是串行执行的部分$T_1F_s$和可并行化的部分$T_1F_p/P$之和。

随着处理器数量的增加,当$𝑃 \rightarrow \infty $时,现有的并行执行时间已经接近代码的串行部分的时间。$T_P\downarrow T_1F_s$。我们的结论是,加速受限于$S_P \leqslant 1/F_s$,效率是一个递减函数$E \sim 1/P$。

代码的串行部分可以由I/O操作等内容组成。然而,并行的代码中也有一些部分实际上是串行的。考虑一个执行单个循环的程序,其中的所有迭代都可以独立计算。显然,这段代码没有提供任何的并行化障碍。然而,通过将循环分割成许多部分(每个处理器一个),每个处理器现在必须处理循环开销:计算边界和完成测试。只要有处理器,这种开销就会被复制很多次。实际上,循环开销是代码的一个串行部分。

练习 2.10 我们来做一个具体的例子。假设一段代码的执行需要1秒,可并行部分在单个处理器上需要1000秒。如果该代码在100个处理器上执行,其速度和效率是多少?对于500个处理器来说,速度和效率又是多少?请保留最多两位有效数字。

练习 2.11 调查阿姆达尔定律的含义:如果处理器的数量$P$增加,代码的并行部分必须如何增加才能保持固定的效率?

有通信开销的阿姆达尔定律

尽管阿姆达尔定律十分准确的指出了并行后速度的提升情况,但由于通信开销的存在,实际的性能相比于理论性能仍有所降低。让我们细化一下方程(2.1)的模型(见[137, p. 367])。

其中$T_c$是一个固定的通信时间。为了评估这种通信开销的影响,我们假设代码是完全可并行的,即$F_p=1$。可以发现:

为了使之接近$p$,我们需要$T_c<<T_1/p$或$p<<T_1/T_c$。换句话说,处理器的数量增长不应超过标量执行时间和通信开销的比例。

古斯塔法森定律

阿姆达尔定律认为只增加处理器数量并不会对并行加速结果有明显的提升。其隐含假设是:越来越多的处理器上执行同一个固定计算。然而在实际中情况并非如此:通常有一种方法可以扩大问题的规模(在第四章中我们将学习 “离散化 “的概念),人们根据可用处理器的数量来调整问题规模的大小。

一个更现实的假设是,有一个独立于问题大小的顺序部分,以及可以任意复制的并行部分。为了正式说明这一点,让我们从并行程序的执行时开始:

现在我们有两种可能的$T_1$的定义。首先是在$T$中设置$p=1$得到的$T_1$(说服自己这实际上与$T_p$相同)。然而,我们需要的是$T_1$,它描述的是完成并行程序所有操作的时间。(见图2.4)。

这给我们提供了一个加速比

从这个公式我们可以看出。

加速仍以𝑝为界。

…它仍是一个正数。

对于一个给定的𝑝,它又是顺序分数的一个递减函数。

练习 2.12 重写方程(2.3),用$p$和$F_p$表示速度的提高。效率$E_p$的渐近行为是什么?

与阿姆达尔定律一样,如果我们把通信开销包括在内,我们可以研究古斯塔法森定律的行为。让我们回到一个完全可并行问题的方程(2.2),并将其近似为

现在,在问题逐渐放大的假设下,$T_c,T_1$成为$p$的函数。我们看到,如果$T_1(p)\sim pT_c(p)$,我们得到的线性加速是远离1的恒定分数。一般来说,我们不能进一步进行这种分析;在6.2.2节,你会看到一个例子的详细分析。

阿姆达尔定律和混合结构

上文我们已经认识了分布式和共享内存式的混合结构,这导致阿姆达尔定律的一种新型变式:

假设我们有$p$节点,每个节点有$c$核,$F_p$描述了使用$𝑐$路线程并行的代码的比例。我们假设整个代码在$p$节点上是完全并行的。理想的速度是$p_c$,理想的并行运行时间是$T_1/(pc)$,但实际运行时间是

练习 2.13 证明加速$T_1/T_p$,$c$可以用$p/F_s$近似。

在最初的阿姆达尔定律中,提速被顺序部分限制在一个固定的数字$1/F_s$,在混合结构中,它被任务并行部分限制在$p/F_s$。

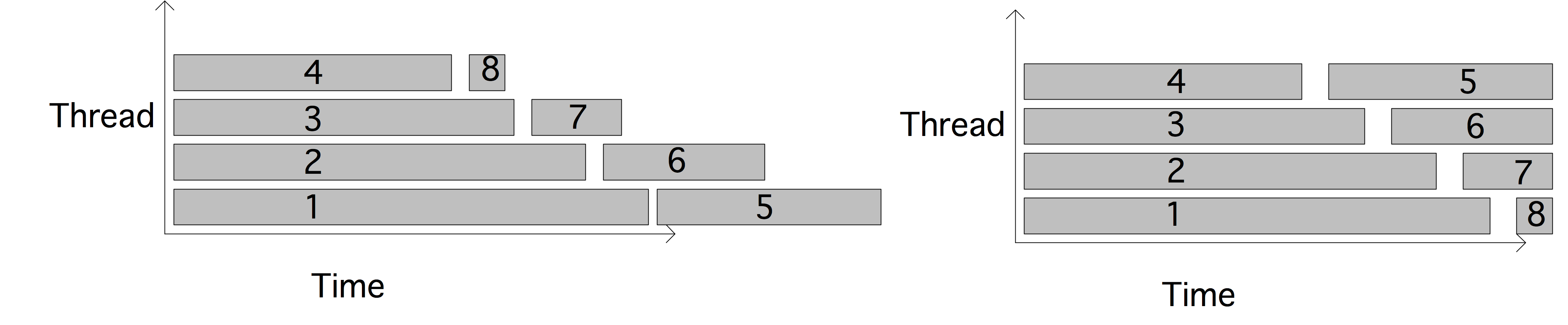

关键路径和布伦特定理

上面关于加速和效率的定义,以及对阿姆达尔定律和古斯塔法森定律的讨论都隐含了一个假设,即并行工作可以被任意细分。正如你在第2.1节的求和例子中所看到的,然而事实情况并不总是这样:操作之间可能存在依赖关系,这限制了可以采用的并行量。

我们将「关键路径」(critical path)定义为最长度的依赖关系链(可能是非唯一的),这个长度有时被称为「跨度」(span)。由于关键路径上的任务需要一个接一个地执行,关键路径的长度是并行执行时间的一个下限。

为了使这些概念准确,我们定义了以下概念。

定义 1

- $T_1$:计算在单个处理器上花费的时间

- $T_p$:计算在$p$处理器上花费的时间

- $T_\infty$:如果有无限的处理器,计算所需的时间。

- $P_\infty$:$T_p=T_\infty$的$p$值。

有了这些概念,我们可以将算法的「平均并行度」(average parallelism)定义为$T_1/T_\infty$,而关键路径的长度为$T_\infty$。

现在我们将通过展示一个任务及其依赖关系的图来进行一些说明。为了简单起见,我们假设每个节点是一个单位时间的任务。

可以使用的最大处理器数量为3,平均并行度为9/5;效率最大的是$p=2$。

可以使用的最大处理器数量是4,这也是平均并行度;图中说明了一个效率为$\equiv 1$的$P=3$的并行化。

根据这些例子,你可能会发现有两种极端情况:如果每个任务都恰好依赖于其他任务,你会得到一个依赖链。

- 如果每个任务都精确地依赖于其他任务,你会得到一个依赖链,并且对于任何$T_p= T_1$。

- 另一方面,如果所有的任务都是独立的(并且$p$除以它们的数量),你会得到$T_p = T_1/p$,对于任何$p$。

- 在一个比上一个稍微不那么琐碎的情况下,考虑关键路径的长度为$m$,在这些$m$的每一步中,有$p-1$个独立的任务,或者至少:只依赖于前一步的任务。这样,每一个$m$步骤中都会有完美的并行性,我们可以表达为$T_p=T_1/T_p=m +(T_1-m)/p$。

最后这句话实际上在一般情况下是成立的。这被称为 “「布伦特定理」(Brent’s Theorem)”。

命题 1:设$m$为任务总数,$p$为处理器数量,$t$为关键路径的长度。那么计算可以在

证明:将计算分成几步,使$i+1$各步中的任务相互独立,而只依赖于步骤$i$。设步骤中的任务数为$s_i$ ,则该步骤的时间为$\lceil \frac{s_i}{p}\rceil$ 。将其相加得出

练习 2.14 考虑一棵深度为$d$的树,即有$2^d - 1$的节点,以及一个搜索$\max_\limits{n \in \text { nodes }} f(n)$。

假设所有的节点都需要被访问:我们对它们的值没有任何了解或排序。分析在$p$处理器上的并行运行时间,你可以假设$p=2q$,其中$q<d$。这与你从布伦特定理和阿姆达尔定律得到的数字有什么关系?

可扩展性

上文说过,使用越来越多数量的处理器处理一个给定的问题是没有意义的:每个节点上的处理器都没有足够有效地运行。在实践中,并行计算的用户要么选择与问题规模相匹配的处理器数量,要么在相应增加的处理器数量上解决一系列越来越大的问题。在这两种情况下,都很难谈及速度提升。因此我们使用了「可扩展性」(scalability)的概念。

我们区分了两种类型的可扩展性。所谓的「强可扩展性」(strong scalability)实际上与上面讨论的加速相同。我们说,如果一个程序在越来越多的处理器上进行分割,它显示出完美或接近完美的速度,也就是说,执行时间随着处理器数量的增加而线性下降,那么这个程序就显示出强大的可伸缩性。在效率方面,我们可以将其描述为。

通常情况下,人们会遇到类似 “这个问题可以扩展到500个处理器 “的说法,这意味着在500个处理器以下,速度不会明显低于最佳状态。这个问题不一定要在一个处理器上解决:通常使用一个较小的数字,如64个处理器,作为判断可扩展性的基线。

更有趣的是,「弱可扩展性」(weak scalability)是一个定义更模糊的术语。它描述了执行的行为,当问题的大小和处理器的数量都在增长时,但每个处理器的数据量却保持不变。由于操作数和数据量之间的关系可能很复杂,所以诸如加速等措施很难报告。如果这种关系是线性的,可以说每个处理器的数据量保持不变,并报告说随着处理器数量的增加,并行执行时间是不变的。(你能想到工作和数据之间的关系是线性的应用吗?哪里不是呢?)

练习 2.15 我们可以将强扩展性表述为运行时间与处理器数量成反比。

证明在对数图上,也就是将运行时间的对数与处理器数量的对数相比较,你会得到一条斜率为-1的直线。你能提出一种处理不可并行部分的方法吗,也就是说,运行时间$t=c_1+c_2/p$?

练习 2.16 假设你正在研究一个代码的弱可扩展性。在运行了几种规模和相应数量的进程之后,你发现在每一种情况下,翻转率都是大致相同的。论证该代码确实是弱可扩展的。

练习 2.17 在上面的讨论中,我们总是隐含地比较一个串行算法和该算法的并行形式。然而,在第2.2.1节中,我们注意到,有时提速被定义为一个并行算法与同一问题的最佳顺序算法的比较。考虑到这一点,请将运行时间为$(\log𝑛)^2$的并行排序算法(例如双调排序;第8节)与运行时间为$n\log n$的最佳串行算法进行比较。

证明在$n=p$的弱可扩展情况下,速度提升为$p/ \log p$。证明在强可扩展情况下,加速是$n$的一个递减函数。

注释 8 一则历史轶事.

Message: 1023110, 88 lines

Posted: 5:34pm EST, Mon Nov 25/85, imported: ….

Subject: Challenge from Alan Karp

To: Numerical-Analysis, … From GOLUB@SU-SCORE.ARPA

I have just returned from the Second SIAM Conference on Parallel Processing for Scientific Computing in Norfolk, Virginia. There I heard about 1,000 processor systems, 4,000 processor systems, and even a proposed 1,000,000 processor system. Since I wonder if such systems are the best way to do general purpose, scientific computing, I am making the following offer. I will pay $100 to the first person to demonstrate a speedup of at least 200 on a general purpose, MIMD computer used for scientific computing.

This offer will be withdrawn at 11:59

PM on 31 December 1995.

这一点通过扩大问题的规模得到了满足。

等效性

在上述弱可扩展性的定义中,我们指出,在问题规模$N$和处理器数量$P$之间的某种关系下,效率将保持不变。我们可以使之精确化,并将等效率曲线定义为$𝑁$,$𝑃$之间的关系,使效率恒定[86]。

可扩展性到底是什么意思?

在工业界的说法中,”可扩展性 “一词有时被应用于架构或整个计算机系统。

可扩展的计算机是由少量的基本部件设计而成的,没有单一的瓶颈部件,因此计算机可以在其设计的扩展范围内逐步扩展,为一组明确定义的可扩展的应用提供线性递增的性能。通用可扩展计算机提供广泛的处理、内存大小和I/O资源。可扩展性是指可扩展计算机的性能增量是线性的程度”[11]。

在科学计算中,可扩展性是一个算法的属性,以及它在一个架构上的并行化方式,特别是注意到数据的分布方式。在第6.2.2节中,你会发现对矩阵与向量乘积操作的分析:按块行分布的矩阵原来是不可扩展的,但按子矩阵分布的二维是可以的。

缩放模拟

在大多数关于弱扩展的讨论中,我们都假设工作量和存储量是线性关系,这并不总是如此。例如,对于$N^2$的数据,矩阵-矩阵乘积的操作复杂度为$N^3$。如果线性地增加处理器的数量,并保持每个进程的数据不变,工作可能会随着功率的增加而上升。

如果模拟随时间变化的PDEs,也会有类似的效果。(这里,总功是每个时间步骤的功和时间步骤数的乘积。这两个数字是相关的;在第4.1.2节中,你看到时间步长有一定的最小尺寸,是空间离散化的一个函数。因此,时间步数将随着每个时间步数的工作上升而上升。

在本节中,我们不是从算法运行的角度来研究可扩展性,而是研究模拟时间$S$和运行时间$T$是恒定的情况,我们看看这对我们需要的内存量有何影响。这相当于我们有一个模拟,在一定的运行时间内模拟了一定量的现实世界的时间;现在你买了一台更大的计算机,你想知道在相同的运行时间和保持相同的模拟时间内,你能解决多大的问题。换句话说,如果你能在一天内计算出两天的天气预报,你不希望当你买了更大的电脑后,它开始花费三天时间。

让 $m$为每个处理器的内存$P$为处理器的数量,得出

如果𝑑是问题的空间维数,通常是2或3,我们可以得到

为了稳定起见,这将时间步长$\Delta t$限制为

(注意到第四章没有讨论双曲的情况)在模拟时间$S$的情况下,我们发现

如果我们假设各个时间步骤是完全可并行的,也就是说,我们使用显式方法,或带有最优求解器的隐式方法,我们发现运行时间为

令$T/S=C$,则

也就是说,每个处理器的内存量随着处理器数量的增加而减少。(最后一句话中缺少的步骤是什么?)

进一步分析这个结果,我们发现

代入𝑀=𝑃𝑚,我们最终发现

也就是说,我们可以使用的每个处理器的内存会随着处理器数量的高次方而减少。

其他的缩放措施

上面的阿姆达尔定律是以在一个处理器上的执行时间来表述的。在许多实际情况下,这是不现实的,因为并行执行的问题对任何一个处理器来说都太大了。一些公式的处理给了我们在某种程度上等同的数量,但不依赖于这个单处理器的数量[159]。

首先,将定义$S_p(n)=\frac{T_1(n)}{T_p(n)}$应用于强可扩展,我们发现$T_1(n)/n$是每次操作的串行时间。它的倒数$n/T_1(n)$可以称为串行计算率,表示为$R_1(n)$。同样可以定义 “并行计算率”

我们发现

在强可扩展中,$R_1(n)$将是一个常数,所以我们做一个加速的对数图,纯粹是基于测量$T_p(n)$。

并发;异步和分布式计算

即使在非并行的计算机上,也有一个同时执行多个进程的问题。操作系统通常有一个时间切片的概念,在这个概念中,所有活动的进程都被赋予CPU的指令,在一小段时间内轮流执行。通过这种方式,串行可以模拟一个并行机器;当然,这种做法效率较低。

然而,即使不运行并行程序,时间切片也是有用的。操作系统会有一些独立的进程(例如编辑器,收到的邮件,等等),它们都需要保持活跃,或多或少地运行。这种独立进程的困难在于,它们有时需要访问相同的资源。两个进程都需要相同的两个资源,而每个进程都得到一个,这被称为「死锁」(deadlock)。资源争夺的一个著名的形式化被称为「哲学家进餐」(dining philosophers)问题。

研究这种独立进程的领域有多种说法,如「并发性」(concurrency)、「异步计算」(asynchronous computing)或「分布式计算」(distributed computing)。并发这一术语描述了我们正在处理同时活动的任务,它们的行动之间没有时间串行。分布式计算这一术语来源于数据库系统等应用,在这些应用中,多个独立的客户需要访问一个共享数据库。

本书将不多讨论这个话题。第2.6.1节讨论了支持时间切片的线程机制;在现代多核处理器上,线程可以用来实现共享内存并行计算。

《Communicating Sequential Processes》一书对并发进程之间的交互进行了分析[109]。其他作者使用拓扑结构来分析异步计算[103]。

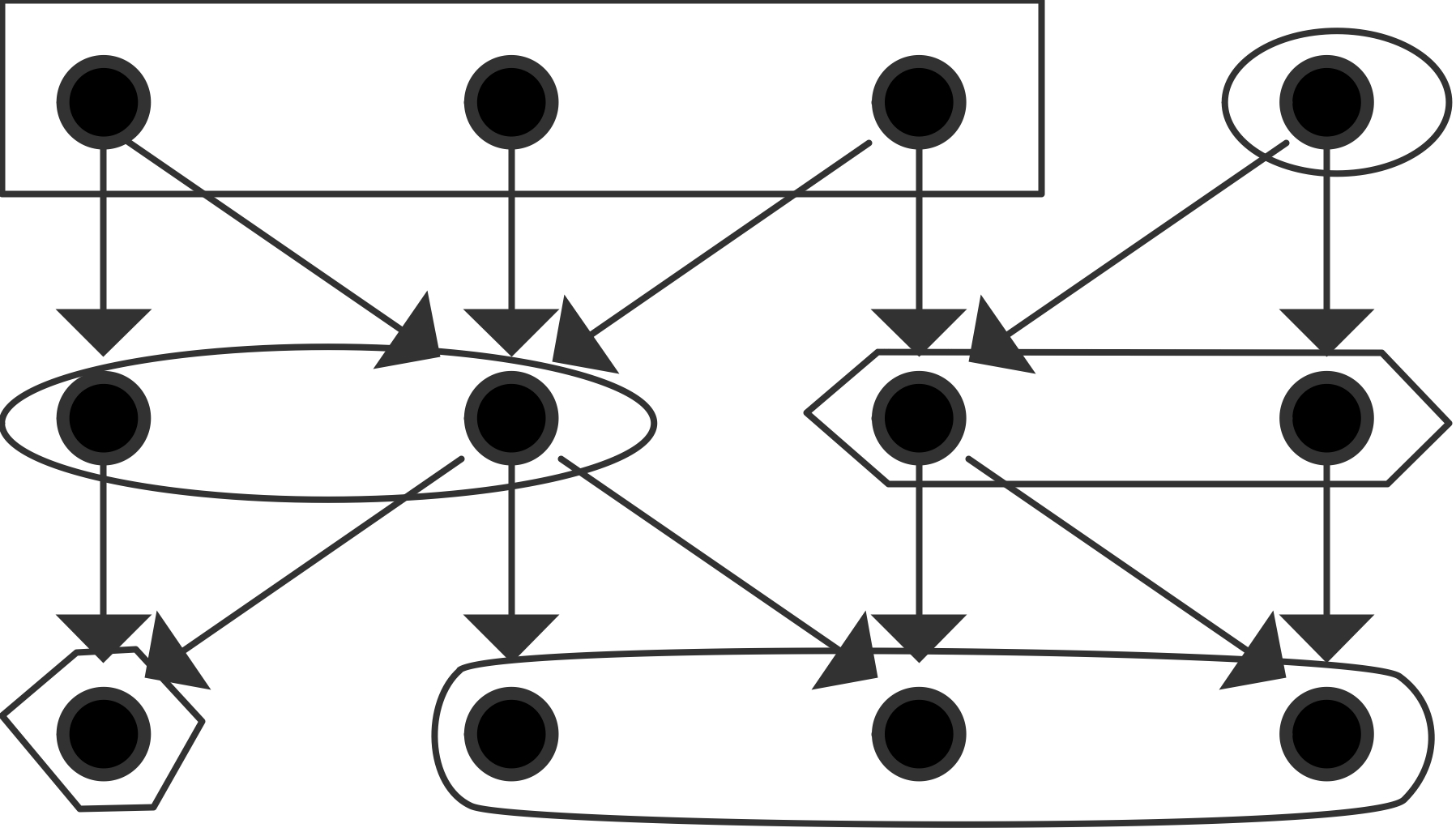

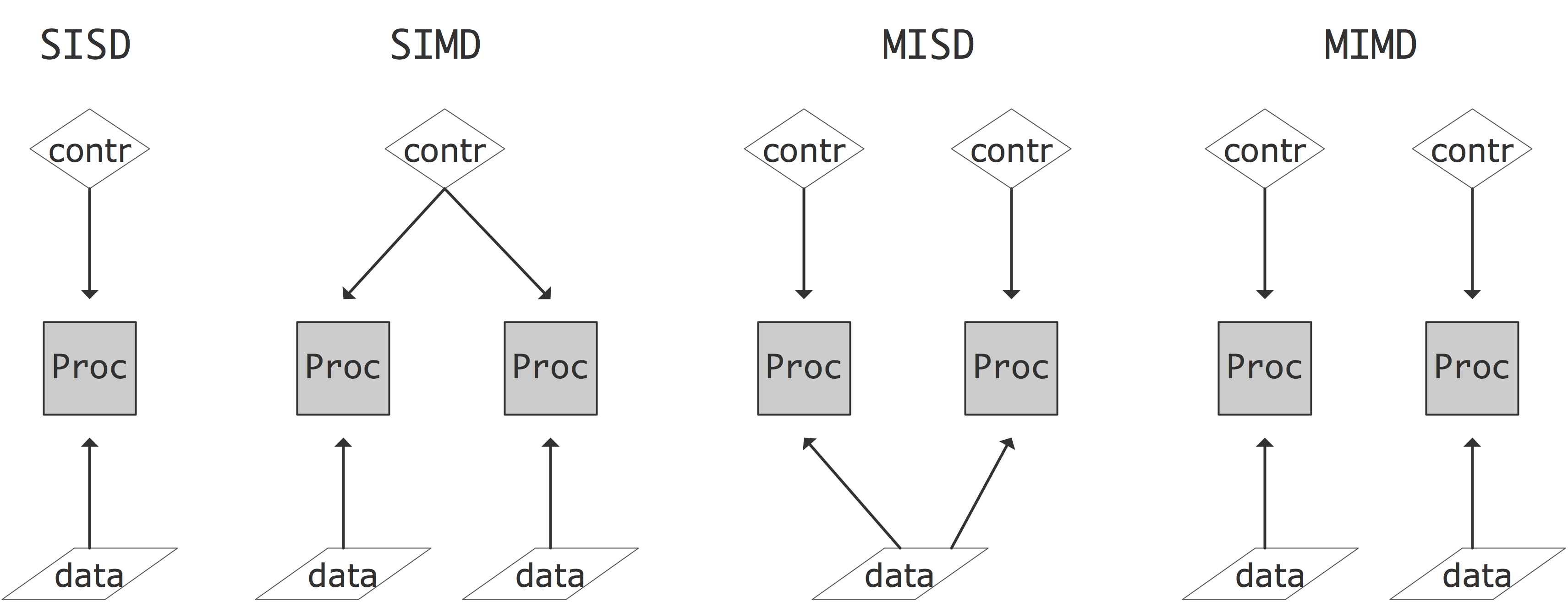

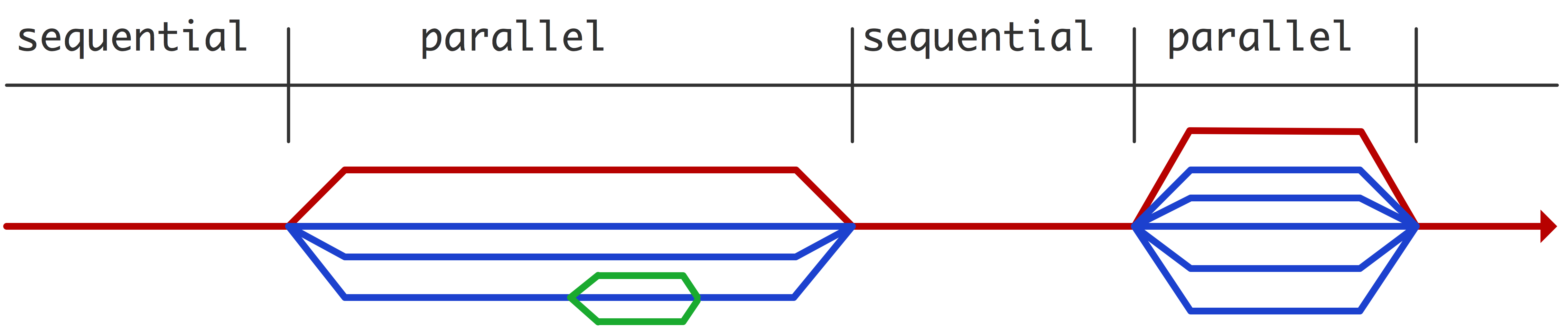

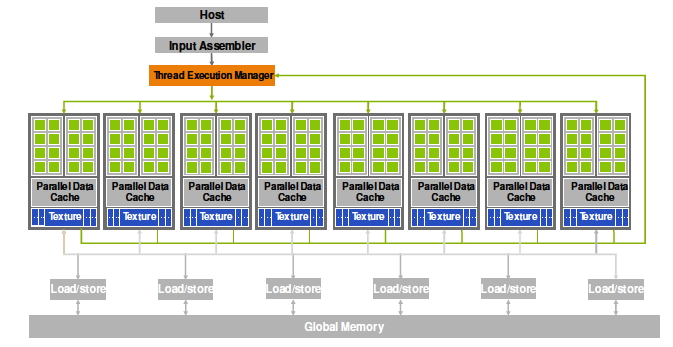

并行计算机架构

相当一段时间以来,超级计算机都是某种并行计算机,即允许同时执行多个指令或指令序列的架构。福林(Flynn)[66]提出了一种描述这种架构的各种形式的方法。Flynn的分类法通过数据流和控制流是共享的还是独立的来描述结构。结果有以下四种类型(也见图2.5)。

- 「单指令单数据」(Single Instruction Single Data,SISD):这是传统的CPU结构:在任何时候只有一条指令被执行,对一个数据项进行操作。

- 「单指令多数据」(Single Instruction Multiple Data,SIMD):在这种计算机类型中,可以有多个处理器,每个处理器对自己的数据项进行操作,但它们都在对该数据项执行相同的指令。向量计算机(2.3.1.1节)通常也被定性为SIMD。

- 「多指令单数据」(Multiple Instruction Single Data,MISD):目前还没有符合这种描述的架构;人们可以说,安全关键应用的冗余计算就是MISD的一个例子。

- 「多指令多数据」(Multiple Instruction Multiple Data,MIMD):这里有多个CPU对多个数据项进行操作,每个都执行独立的指令。目前大多数并行计算机都属于这种类型。

现在我们将更详细地讨论SIMD和MIMD架构。

SIMD

SIMD类型的并行计算机同时对一些数据项进行相同的操作。这种计算机的CPU的设计可以相当简单,因为算术单元不需要单独的逻辑和指令解码单元:所有的CPU都是锁步执行相同的操作。这使得SIMD计算机在对数组的操作上表现出色,如

1 | for (i=0; i<N; i++) a[i] = b[i]+c[i]; |

而且,由于这个原因,它们也经常被称为「阵列处理器」(array processors)。科学代码通常可以写得很好,使很大一部分时间花在阵列操作上。

另一方面,有些操作不能在阵列处理器上有效执行。例如,评估递归的若干项$x_{i+1}=ax_i+b_i$涉及许多加法和乘法,但它们是交替进行的,因此每次只能处理一种类型的操作。这里没有同时作为加法或乘法输入的数字阵列。

为了允许对数据的不同部分进行不同的指令流,处理器会有一个 “屏蔽位”,可以被设置来阻止指令的执行。在代码中,这通常看起来像

1 | while(x>0) { |

将相同的操作同时应用于一些数据项的编程模型,被称为「数据并行」(data parallelism)。

这种数组操作可以在物理模拟中出现,但另一个重要来源是图形应用。对于这种应用,阵列处理器中的处理器可能比PC中的处理器弱得多:通常它们实际上是位处理器,一次只能对一个位进行操作。按照这种思路,ICL在20世纪80年代有4096个处理器的DAP[115],固特异在20世纪70年代制造了一个16K处理器的MPP[10]。

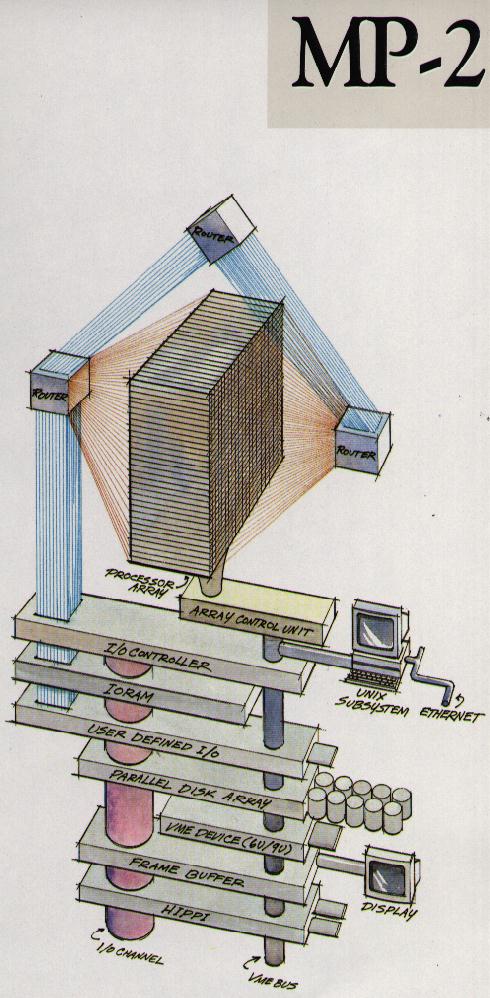

后来,连接机(CM-1、CM-2、CM-5)相当流行。虽然第一台连接机有位处理器(16个到一个芯片),但后来的型号有能够进行浮点运算的传统处理器,并不是真正的SIMD架构。所有这些都是基于超立方体互连网络;见2.7.5节。另一家拥有商业上成功的阵列处理器的制造商是MasPar;图2.6说明了该架构。你可以清楚地看到一个方形阵列处理器的单一控制单元,加上一个做全局操作的网络。

基于阵列处理的超级计算机已经不存在了,但是SIMD的概念以各种形式存在着。例如,GPU是基于SIMD的,通过其CUDA编程语言强制执行。另外,英特尔Xeon Phi有一个强大的SIMD组件。早期的设计SIMD架构的初衷是尽量减少必要的晶体管数量,而这些现代协处理器则是考虑到电源功率。与浮点运算相比,处理指令(称为指令问题)在时间、能源和所需的芯片地产方面实际上是昂贵的。因此,使用 SIMD 是在后两项措施上节约成本的一种方式。

流水线

许多计算机都是基于向量处理器或流水线处理器的设计。第一批商业上成功的超级计算机,Cray-1和Cyber205都属于这种类型。近来,Cray-X1和NEC SX系列都采用了向量流水线。在TOP 500 中领先3年的 “地球模拟器 “计算机[178],就是基于NEC SX处理器的。

虽然基于流水线处理器的超级计算机明显是少数,但流水线现在在作为集群基础的超标量CPU中是主流。一个典型的CPU有流水线的浮点单元,通常有独立的加法和乘法单元。

然而,现代超标量CPU的流水线与更老式的向量单元的流水线有一些重要区别。这些向量计算机中的流水线单元并不是CPU中的集成浮点单元,而是可以更好地看作是附属于本身具有浮点单元的CPU的向量单元。向量单元有矢量寄存器,其长度一般为64个浮点数;通常没有 “向量缓存”。向量单元的逻辑也比较简单,通常可以通过明确的向量指令来寻址。另一方面,超标量CPU完全集成在CPU中,面向利用非结构化代码中的数据流。

CPU和GPU中的真SIMD

真正的SIMD阵列处理可以在现代CPU和GPU中找到,在这两种情况下,都是受到图形应用中需要的并行性的启发。

英特尔和AMD的现代CPU,以及PowerPC芯片,都有向量指令,可以同时执行一个操作的多个实例。在英特尔处理器上,这被称为「SIMD流扩展」(Streaming Extensions,SSE)或「高级矢量扩展」(Advanced Vector Extensions,AVX)。这些扩展最初是用于图形处理的,在这种情况下,往往需要对大量的像素进行相同的操作。通常情况下,数据必须是总共128位,这可以分为两个64位实数,四个32位实数,或更多更小的块,如4位。

AVX指令是基于高达512位宽的SIMD,也就是说,可以同时处理8个浮点数。就像单次浮点运算对寄存器中的数据进行操作一样(第1.3.3节),向量运算使用「向量寄存器」(vector registers)。向量寄存器中的位置有时被称为「SIMD流水线」(SIMD lanes)。

SIMD的使用主要是出于功耗的考虑。解码指令实际上比执行指令更耗电,所以SIMD并行是一种节省功耗的方法。

目前的编译器可以自动生成SSE或AVX指令;有时用户也可以插入pragmas,例如英特尔的编译器。

1 | void func(float *restrict c, float *restrict a, float *restrict b, int n) |

这些扩展的使用通常要求数据与缓存行边界对齐(第1.3.4.7节),所以有一些特殊的allocate和free调用可以返回对齐的内存。

OpenMP的第4版还有指示SIMD并行性的指令。

更大规模的阵列处理可以在GPU中找到。一个GPU包含大量的简单处理器,通常以32个一组的形式排列。每个处理器组只限于执行相同的指令。因此,这是SIMD处理的真正例子。进一步的讨论,见2.9.3节。

MIMD/SPMD计算机

到目前为止,现在最常见的并行计算机结构被称为多指令多数据(MIMD):处理器执行多条可能不同的指令,每条指令都在自己的数据上。说指令不同并不意味着处理器实际上运行不同的程序:这些机器大多以「单程序多数据」(Single Program Multiple Data,SPMD)模式运行,即程序员在并行处理器上启动同一个可执行文件。由于可执行程序的不同实例可以通过条件语句采取不同的路径,或执行不同数量的循环迭代,它们一般不会像SIMD机器上那样完全同步。如果这种不同步是由于处理器处理不同数量的数据造成的,那就叫做「负载不均衡」(load unbalance,),它是导致速度不完美的一个主要原因;见2.10节。

MIMD计算机有很大的多样性。其中一些方面涉及到内存的组织方式,以及连接处理器的网络。除了这些硬件方面,这些机器还有不同的编程方式。我们将在下面看到所有这些方面。现在的许多机器被称为「集群」(clusters)。它们可以由定制的或商品的处理器组成(如果它们由PC组成,运行Linux,并通过以太网连接,它们被称为Beowulf集群[93]);由于处理器是独立的,它们是MIMD或SPMD模型的例子。

不同类型的内存访问

在介绍中,我们将并行计算机定义为多个处理器共同处理同一问题的设置。除了最简单的情况,这意味着这些处理器需要访问一个联合的

数据池。在上一章中,你看到了即使是在单个处理器上,内存也很难跟上处理器的需求。对于并行机器来说,可能有几个处理器想要访问同一个内存位置,这个问题变得更加糟糕。我们可以通过它们在协调多个进程对联合数据池的多次访问问题上所采取的方法来描述并行机器。

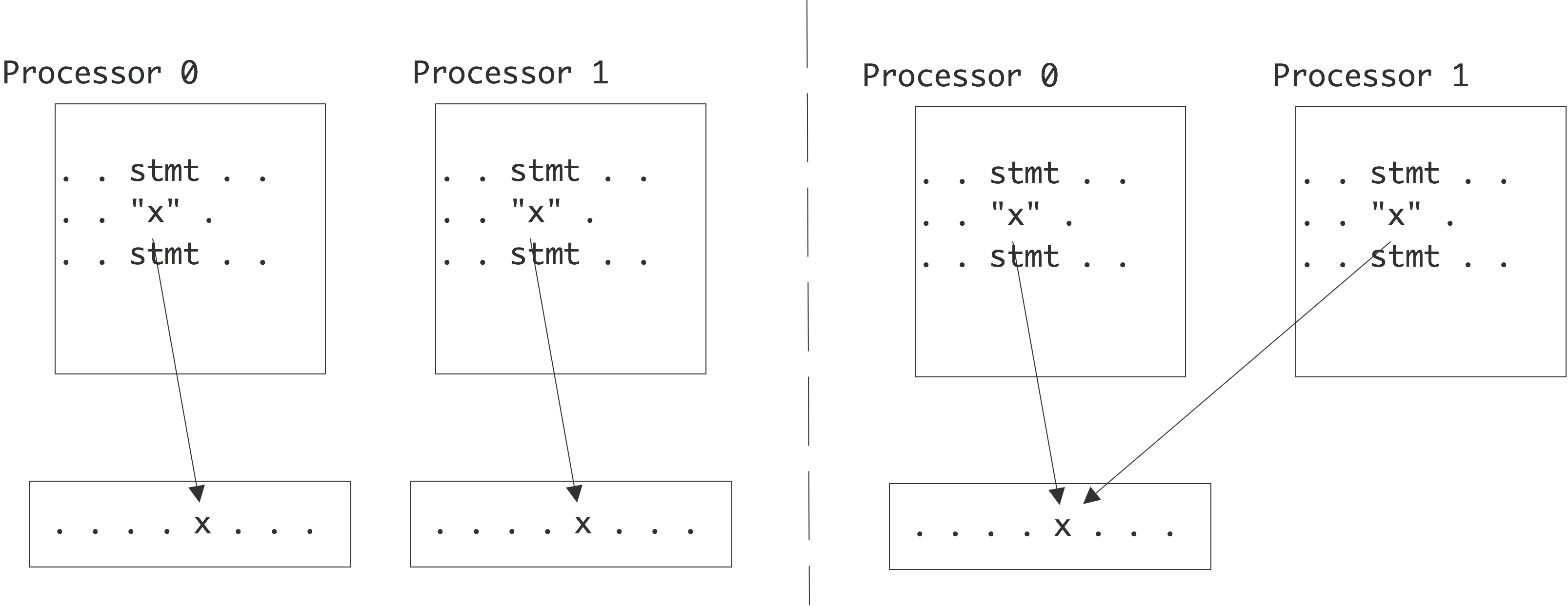

这里的主要区别在于「分布式内存」(distributed memory)和「共享内存」(shared memory)之间的区别。在分布式内存中,每个处理器有自己的物理内存,更重要的是有自己的地址空间。因此,如果两个处理器引用一个变量$x$,他们会访问自己本地内存中的一个变量。另一方面,在共享内存中,所有处理器都访问相同的内存;我们也说它们有一个「共享地址空间」(shared address space)。因此,如果两个处理器都引用一个变量$x$,它们就会访问同一个内存位置。

对称多核处理器:统一内存访问

如果任何处理器都可以访问任何内存位置,并行编程就相当简单。由于这个原因,制造商有很大的动力来制造架构,使处理器看不到一个内存位置和另一个内存位置之间的区别:每个处理器都可以访问任何内存位置,而且访问时间没有区别。这被称为「统一内存访问」(Uniform Memory Access,UMA),基于这一原则的架构的编程模型通常被称为「对称多处理」(Symmetric Multi Processing,SMP)。

有几种方法可以实现SMP架构。目前的台式电脑可以有几个处理器通过一条内存总线访问一个共享的内存;例如,苹果公司在市场上销售一种带有2个六核处理器的机型。处理器之间共享的内存总线只适用于少量的处理器;对于更多的处理器,可以使用连接多个处理器和多个内存bank的横梁。

在多核处理器上,有一种不同类型的统一内存访问:各核通常有一个共享的高速缓存,通常是L3或L2高速缓存。

非统一内存访问

基于共享内存的UMA方法显然只限于少量的处理器。十字架网络是可以扩展的,所以它们似乎是最好的选择。然而,在实践中,人们将具有本地内存的处理器放在一个具有交换网络的配置中。这导致了一种情况,即一个处理器可以快速访问自己的内存,而其他处理器的内存则较慢。这就是所谓的NUMA的一种情况:一种使用物理分布式内存的策略,放弃统一的访问时间,但保持逻辑上的共享地址空间:每个处理器仍然可以访问任何内存位置。

上图说明了TACC Ranger集群的四插槽主板的NUMA情况。每个芯片都有自己的内存(8Gb),但是主板的行为就像处理器可以访问一个32Gb的共享池。很明显,访问另一个处理器的内存比访问本地内存要慢。此外,请注意,每个处理器有三个连接,可以用来访问其他内存,但最右边的两个芯片使用一个连接来连接网络。这意味着访问对方的内存只能通过一个中间处理器进行,减缓了传输速度,并占用了该处理器的连接。

虽然NUMA方法对程序员来说很方便,但它为系统提供了一些挑战。想象一下,两个不同的处理器在其本地(缓存)内存中都有一个内存位置的副本。如果一个处理器改变了这个位置的内容,这个变化必须被传播到其他处理器上。如果两个处理器都试图改变一个内存位置的内容,程序的行为会变得不确定。

保持一个内存位置的副本同步被称为「缓存一致性」(cache coherence)(详见1.4.1节);使用这种方法的多处理器系统有时被称为 “缓存一致性的NUMA “或ccNUMA架构。

将NUMA发挥到极致,有可能有一个软件层,使网络连接的处理器看起来在共享内存上运行。这被称为「分布式共享内存」(distributed shared memory)或「虚拟共享内存」(virtual shared memory)。在这种方法中,管理程序提供了一个共享内存API,通过翻译系统调用到分布式内存管理。这种共享内存API可以被Linux内核所利用,它可以支持4096个线程。

在目前的供应商中,只有SGI(UV系列)和Cray(XE6)的市场产品具有大规模的NUMA。两者都对分区全局地址空间(PGAS)语言提供了强有力的支持;见2.6.5节。有一些厂商,如ScaleMP,为普通集群上的分布式共享内存提供了软件解决方案。

逻辑上和物理上的分布式内存

对内存访问问题最极端的解决方案是提供不仅在物理上,而且在逻辑上也是分布式的内存:处理器有自己的地址空间,不能直接看到其他处理器的内存。这种方法通常被称为 “分布式内存”,但这个术语是不明显的,因为我们必须分别考虑内存是否是分布式的和是否是分布式的问题。请注意,NUMA也有物理上的分布式内存;它的分布式性质对于程序员来说并不明显。

在逻辑和物理的分布式内存中,一个处理器与另一个处理器交换信息的唯一方式是通过网络明确传递信息。你将在2.6.3.3节中看到更多关于这方面的内容。

这种类型的架构有一个显著的优势,即它可以扩展到大量的处理器:IBM蓝色基因已经建立了超过20万个处理器。另一方面,这也是最难编程的一种并行系统。

存在上述类型之间的各种混合体。事实上,大多数现代集群会有NUMA节点,但节点之间是分布式内存网络。

并行计算(二)

并行计算中的粒度

一个程序有多少并行度?事实上,大部分指令都可以并行执行,但我们要考虑并行后的代价:并行后程序是否变得简单?以及并行后加速效率是否明显等问题。

本节的讨论主要是在概念层面上进行的;后面将详细介绍如何对并行进行实际编程。

数据并行化

对于有简单主体循环的程序来说,遍历大数据集的操作相当常见。

1 | for (i=0; i<1000000; i++) |

这样的代码被认为是「数据并行」(data parallelism)或「细粒度并行」(fine-grained parallelism)的一个实例。如果我们有和数组元素一样多的处理器,那么并行后的代码将非常简单:每个处理器将在其本地数据上执行

1 | a = 2*b |

如果代码主要由数组的循环组成,它可以在所有处理器锁步的情况下有效执行。基于这种思想设计的并行架构早已存在,事实上处理器只能以锁步方式工作。这种数组上的完全并行操作出现在计算机图形学中,图像的每个像素都被独立处理。因此,GPU的并行就是基于数据并行的。

继续上面的例子,考虑以下操作

在数据并行机器上,可以实现为

其中shiftleft/right指令导致一个数据项被发送到数字较低或较高为1的处理器。 为了使第二个例子有效,有必要使每个处理器能够与其近邻快速通信,并使第一个和最后一个处理器彼此通信。

在各种情况下,如图形中的 “模糊 “操作,对二维数据的操作是有意义的。

因此,处理器必须能够将数据移动到二维网格中的相邻处。

指令级并行

在ILP中,并行性仍然是在单个指令的层面上,但这些指令不一定是相似的。例如,在

这两个赋值是独立的,因此可以同时执行。编译器可以帮助我们处理这种并行。事实上,识别ILP对于从现代超标量CPU中获得良好的性能至关重要。

任务并行

数据和指令级并行的另一种应用为「任务并行」(task parallelism),是指可以并行执行的整个子程序。例如,在树形数据结构中的搜索可以按以下方式实现。

1 | if optimal (root) then |

这个例子中的搜索任务是不同步的,而且任务数量也不固定。在实际应用中,任务过多并不是一个很好的策略,因为处理器只在一个任务上工作时其效率才最高。上面的例子可以略加改写为:

1 | while there are tasks left do |

(之前的两个伪代码之间有一个微妙的区别。在第一个代码中,任务是自我调度的:每个任务都会衍生出两个新的任务。第二个代码是一个Manager-Worker Paradigm的例子:一个贯穿整个程序执行过程的中心任务负责派生和分配节点任务。)

与数据并行不同,该方案中数据对处理器的分配不是事先确定的。因此,这种并行模式最适合于线程编程,例如通过OpenMP库的并行。下面考虑另一个高度任务并行的例子:

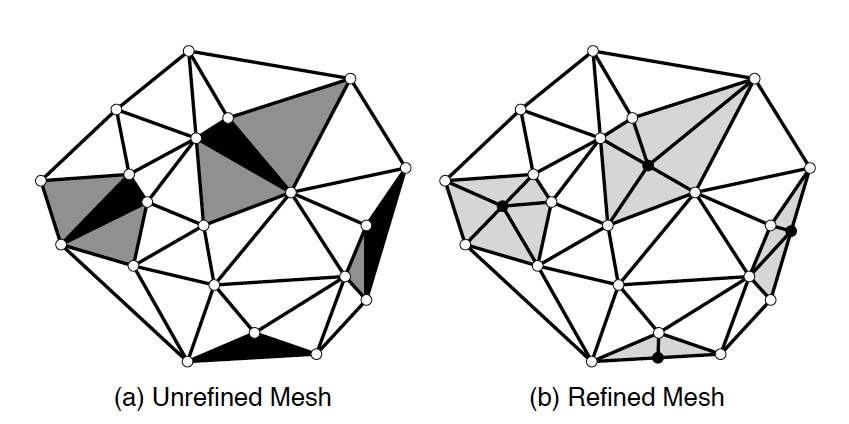

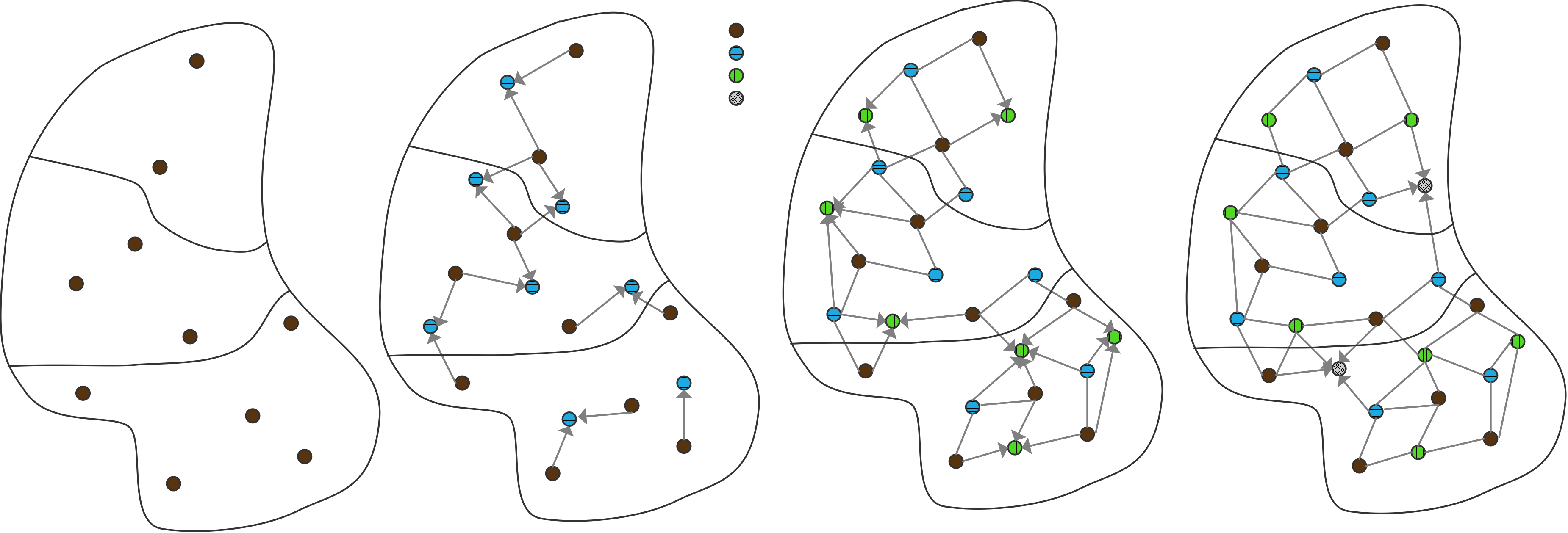

在最简单的情况下,一个有限元网格是覆盖二维物体的三角形的集合。由于应该避免过于尖锐的角度,「Delauney网格细化」(Delauney mesh refinement)过程可以选择某些三角形,用形状更好的三角形取代它们。图2.9说明了这一点:黑色的三角形违反了一些角度条件,所以要么它们自己被细分,要么它们与一些相邻的三角形(呈现为灰色)连接,然后共同被重新细分。

伪代码参考如下。

1 | Mesh m = /* read in initial mesh */ |

很明显,该算法是由一个必须在所有进程之间共享的工作列表(或任务队列)数据结构驱动的。再加上动态分配数据给进程,这意味着这种不规则的并行性适合于共享内存编程,而在分布式内存中则较难做到。

高度并行

单处理器的计算通常需要在众多不同的输入上进行。如果计算的数据不存在相关依赖,且不需要任何特定情况,则被称为「高度并行」(embarrassingly parallel)或「便捷并行」(conveniently parallel)计算。这种并行可以发生在几个层面。在诸如计算Mandelbrot set或评估国际象棋游戏中的棋子的例子中,一个子程序级别的计算被调用了许多参数值。在一个更粗略的层面上,可能是一个简单的程序需要对许多输入进行运行。在这种情况下,整体计算被称为「参数扫描」(parameter sweep)。

中粒度的数据并行化

上述数据并行假定了有与数据元素同样多的处理器。在实际中,处理器内存通常会很大,且处理的数据数量要远远大于处理器数量。因此,数组被分组到子数组的处理器上。伪代码如下

1 | my_lower_bound = // some processor-dependent number |

这种模式有数据并行的特点,因为在大量的数据项上执行的操作是相同的。它也可以被看作是任务并行,因为每个处理器执行的代码部分较大,而且不一定对同等大小的数据块进行操作。

任务粒度

在前面的小节中,我们考虑了寻找并行工作的不同层次,或者说划分工作的不同方式,以便找到并行性。还有另一种方法:我们将并行方案的「粒度」(granularity)定义为一个处理元素在不得不与其他处理元素进行通信或同步之前可以执行的工作量(或任务大小)。

在ILP中,我们处理的是非常细粒度的并行,就像一条指令或几条指令一样。在真正的任务并行中,颗粒度要粗得多。

有趣的是,我们可以自行选择数据并行中的任务大小。SIMD机器上,我们选择的是单指令粒度,但操作可以被分为中等大小的任务。因此,在处理器数量和总问题规模之间的适当平衡下,数据并行的操作可以在分布式内存集群上执行。

练习 2.18 讨论为一个数据并行操作选择合适的粒度,如在二维网格上进行平均化。表明存在一个表面到体积的效应:通信量比计算量低一阶。这意味着,即使通信比计算慢得多,增加任务量仍然会得到一个平衡的执行。

如果试图加大任务规模以减小通信开销,则会导致另一个问题:集合操作时可能会有不同运行时间的任务,导致负载不均衡。一种解决办法是使用过度分解:创建比处理元素更多的任务,并将多个任务分配给一个处理器(或动态分配任务)以平衡不规则的运行时间。这就是所谓的「动态调度」(dynamic scheduling)。

并行编程

并行编程比串行编程更复杂。虽然对于后者来说,大多数编程语言的操作原理是相似的(除了一些例外,如函数式语言或逻辑语言),但有多种方法来处理并行问题。让我们来探讨一下其中的一些概念和实际问题。

并行编程的策略有多种。我们很难做出一个能自动将串行程序转变为并行程序的编译器。除了弄清楚哪些操作是独立的问题之外,最主要的问题是,在并行环境中定位数据的问题是非常困难的。编译器需要考虑整个代码,而不是一次一个子程序。

较为有效的方法是:用户编写串行程序,同时给出哪些计算可以并行化或数据改如何分配的指示。明确指出操作的并行性是在OpenMP中进行的;指出数据分布并将并行性留给编译器和运行时是PGAS语言的基础。这种方法在共享内存中效果最好。

到目前为止最难的并行编程方式,同时也是实际中效果最好的并行方式,就是把一切留给程序员,让程序员管理一切。这种方法在分布式内存编程的情况下是必要的。

线程并行

我们将简要介绍一下 “线程”。为了解释什么是「线程」(thread),我们首先需要从技术上了解什么是「进程」(process)。一个unix进程对应于对应于单个程序的执行。因此,它在内存中拥有

程序代码,以机器语言指令的形式存在。

「堆」(heap),包含malloc创建的数组。

「栈」(stack),包含快速变化的信息,如「程序计数器」(program counter,PC),它显示了当前正在执行的结构。堆栈中包含快速变化的信息,如表明当前正在执行的程序计数器,以及具有本地范围的数据项,以及计算的中间结果。

这个过程可以有多个线程;这些线程的相似之处在于它们看到相同的程序代码和堆,但它们有自己的栈。因此,一个线程是通过进程执行的一个独立 “股”。

进程可以属于不同的用户,或者是一个用户并发运行的不同程序,因此它们有自己的数据空间。另一方面,线程是一个进程的一部分,因此它们共享进程堆。线程可以有一些私有数据,例如通过拥有自己的数据栈,但它们的主要特征是它们可以在相同的数据上进行协作。

叉形连接机制

线程是动态的,它们可以在程序执行过程中被创建。(这与MPI模型不同,在MPI模型中,每个处理器运行一个进程,它们都是在同一时间创建和销毁的)。当程序启动后,处于活跃状态的线程称为「主线程」(main thread),其他线程通过主线程「生成」(thread spawning)创建,主线程需等待其完成,称为「生成-汇合模型」(fork-join)。从同一个线程生成出来并同时活动的一组线程被称为「线程组」(thread team)。

线程的硬件支持

上面所描述的线程是一种软件结构。在并行计算机出现之前,线程是可能的;例如,它们被用来处理操作系统中的独立活动。在没有并行硬件的情况下,操作系统将通过多任务或时间切片来处理线程:每个线程将定期使用CPU的一小部分时间。(从技术上讲,Linux内核通过任务的概念来处理进程和线程;任务被保存在一个列表中,并定期被激活或取消)

这可以导致更高的处理器利用率,因为一个线程的指令可以在另一个线程等待数据时被处理。(在传统的CPU上,线程之间的切换是有些耗费精力的(超线程机制是个例外),但在GPU上则不然,事实上,它们需要许多线程才能达到高性能)。

在现代多核处理器上,有一种明显的支持线程的方法:每个核有一个线程,可以有效地使用硬件的并行执行。共享内存允许线程看到相同的数据,但这也会导致问题。

线程实例

下面的例子,严格来说是在Unix上运行,在Windows上是行不通的,它清楚地说明了fork-join的模型。它使用pthreads库来生成一些任务,这些任务都会更新一个全局计数器。由于线程共享相同的内存空间,它们确实看到并更新相同的内存位置。

1 |

|

事实上,这段代码给出了正确的结果,但这是一个巧合:它之所以发生,只是因为更新变量比创建线程要快得多。(在多核处理器上,出错的机会将大大增加)。如果人为地增加更新的时间,我们将不再得到正确的结果。

1 | void adder() { |

现在所有的线程都读出了sum的值,等待一段时间(估计是在计算什么),然后再更新。

这可以通过在应该是 “互斥 “的代码区域上设置一个锁来解决。

1 | pthread_mutex_t lock; |

锁定和解锁命令保证了没有两个线程可以干扰对方的更新。关于pthreads的更多信息,请参见例如https://computing.llnl.gov/tutorials/pthreads。

上下文

在上面的例子和它的sleep命令版本中,我们忽略了一个事实,即有两种类型的数据参与其中。首先,变量s是在线程生成部分之外创建的。因此,这个变量是「共享」(shared)的。另一方面,变量t是在每个生成的线程中创建一次的。我们称其为「私有」(private)数据。

一个线程可以访问的所有数据的总和被称为其「上下文」(context)。它包含了私有和共享数据,以及线程正在进行的计算的临时结果。(还包含程序计数器和堆栈指针。如果现在不知道这些是什么,请不用担心)

创建的线程比处理器的内核多是很有可能的,所以处理器可能需要在不同线程的执行之间进行切换。这就是所谓的「上下文切换」(context switch)。

普通的CPU进行上下文切换会造成时间开销,所以只有在线程工作的粒度足够高时,我们才会这样执行。下面几种情况则较为常见

- 有硬件支持多线程的CPU,通过「超线程」(hyperthreading)或Intel Xeon Phi来实现

- GPU,它实际上依赖于快速上下文切换。

- 某些其他 “奇特 “的架构,如Cray XMT。

竞争条件、线程安全和原子操作

共享内存使程序员的工作变得简单,因为每个处理器都可以访问所有的数据:处理器之间不需要明确的数据通信。另一方面,多个进程/处理器也可以写到同一个变量,这是潜在问题的来源。

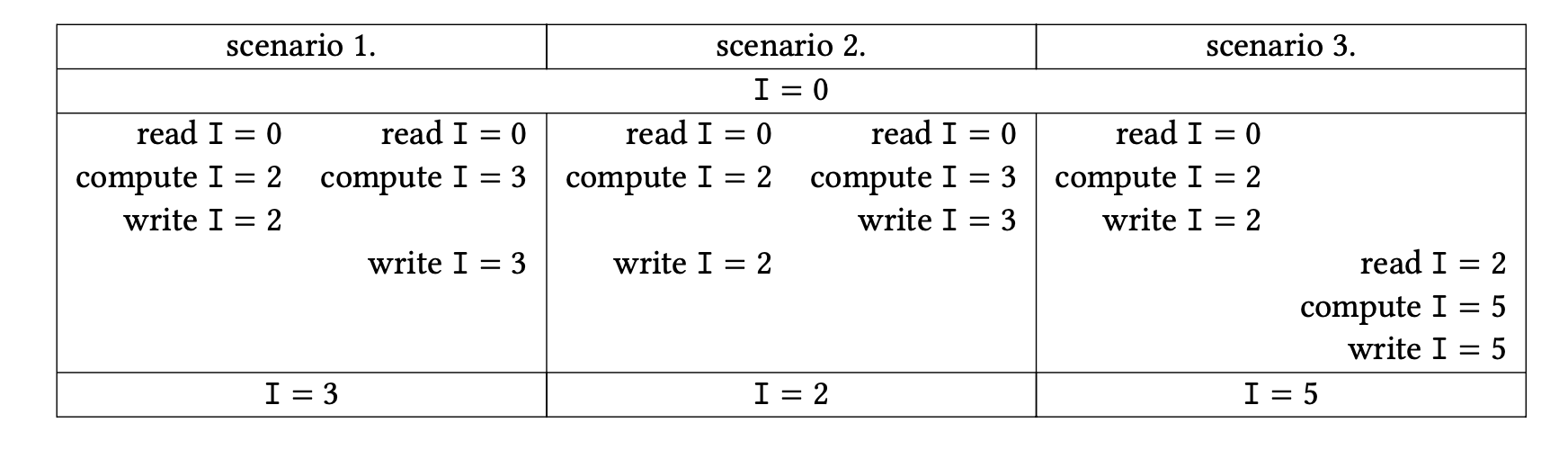

假设两个进程都试图递增一个整数变量I。

进程1:I=I+2

进程2:I=I+3

如果该变量是一个由独立进程计算的累加,这是一个合法的活动。这两个更新的结果取决于处理器读取和写入变量的顺序。

图2.12说明了三种情况。这种情况下,最终结果取决于哪个线程先执行,被称为「竞争条件」(race condition)或「数据竞争」(data race)。一个正式的定义是:如果有两个语句$S_1$,$S_2$,数据竞争为

- 两个语句之间不存在因果关系

- 都是访问一个位置$L$;并且

- 至少有一个访问是写操作。

这种冲突性更新的一个非常实际的例子是内积计算。

1 | for (i=0; i<1000; i++) |

这里的乘积是真正独立的,所以我们可以选择让循环迭代并行进行,例如由它们自己的线程进行。然而,所有的线程都需要更新同一个变量的总和。

无论是串行执行还是线程执行,代码的行为都是一样的,这叫做「线程安全」(thread safe)。从上面的例子可以看出,缺乏线程安全通常是由于对共享数据的处理。这意味着程序越是使用本地数据,它是线程安全的机会就越大。不幸的是,有时线程需要写到共享/全局数据,例如,当程序进行「规约」(reduction)时。

解决这个问题的方法基本上有两种。一种是,我们将共享变量的这种更新宣布为代码的「临界区」(critical section)。这意味着临界区的指令(在内积的例子中,”从内存中读取和,更新,写回内存”)一次只能由一个线程来执行。特别是,它们需要完全由一个线程执行,然后其他线程才能启动它们,所以上面的模糊问题不会出现。当然,上述代码片段非常常见,以至于像OpenMP这样的系统有专门的机制来处理它,把它声明为一个减少操作。

例如,临界区可以通过信号机制[47]来实现。在每个临界区的周围,会有两个原子操作控制着一个信号灯,即一个信号柱。第一个遇到信号灯的进程将降低信号灯,并开始执行临界区。其他进程看到已经降低的信号灯,并等待。当第一个进程完成临界区时,它执行第二条指令,提高信号灯,允许其中一个等待的进程进入临界区。

解决共享数据的共同访问的另一种方法是在某些内存区域设置一个临时「锁」(lock)。如果对临界区的共同执行是可能的,例如,如果它实现了对数据库或哈希表的写入,那么这种解决方案可能是比较好的。在这种情况下,一个进程进入临界区将阻止任何其他进程写入数据,即使他们可能是写入不同的位置;那么锁定被访问的特定数据项是一个更好的解决方案。

锁的问题是,它们通常存在于操作系统层面。这意味着它们的速度相对较慢。由于我们希望上述内积循环的迭代能以浮点单元的速度执行,或者至少以内存总线的速度执行,所以这是不可接受的。

这方面的一个实现是「事务内存」(transactional memory),硬件本身支持原子操作;这个术语来自于数据库事务,它有一个类似的完整性问题。在交易型内存中,一个进程将执行正常的内存更新,除非处理器检测到与另一个进程的更新有冲突。在这种情况下,更新(”事务”)被取消并重新尝试,一个处理器锁定内存,另一个处理器等待锁定。这是一个优雅的解决方案;然而,取消事务可能会带来一定的「流水线冲洗」(pipeline flushing)和缓存线失效的代价。

内存模型和串行一致性

上面提到的竞争条件现象意味着一些程序的结果可能是非确定性的,这取决于指令的执行顺序。还有一个因素在起作用,它被称为处理器和/或语言使用的「内存模型」(memory model)[2]。内存模型控制一个线程或内核的活动如何被其他线程或内核看到。

例如,考虑

初始:A=B=0;,然后

进程1:A=1;x=B。

进程2:B=1;y=A。

如上所述,我们有三种情况,我们通过给出一个全局性的语句序列来描述这些情况。

| 场景 1. | 场景 2. | 场景 3. |

|---|---|---|

| $A\leftarrow 1$ | $A\leftarrow 1$ | $B\leftarrow 1$ |

| $x\leftarrow B$ | $B\leftarrow 1$ | $y\leftarrow A$ |

| $B\leftarrow 1$ | $x\leftarrow B$ | $A\leftarrow 1$ |

| $y\leftarrow A$ | $y\leftarrow A$ | $x\leftarrow B$ |

| $x=0, y=1$ | $x=1, y=1$ | $x=1, y=0$ |

(在第二种情况下,语句1,2和3,4都可以颠倒过来,但结果不会改变。)

这三种不同的结果可以被描述为是由尊重局部排序的状态要素的全局排序来计算的。这被称为「串行一致性」(sequential consistency):并行的结果与顺序执行是一致的,该顺序执行将并行计算交错进行,尊重它们的本地语句排序。

保持串行一致性的代价是很昂贵的:它意味着对一个变量的任何改变都需要立即在所有其他线程上可见,或者对一个线程上的变量的任何访问都需要咨询所有其他线程。

在一个「松弛内存模型」(relaxed memory model)中,有可能会得到一个不符合顺序的结果。假设在上面的例子中,编译器决定对两个进程的语句重新排序,因为读写是独立的。实际上,我们得到了第四种情况。

| 场景 4. |

|---|

| $x\leftarrow B$ |

| $y\leftarrow A$ |

| $A\leftarrow 1$ |

| $B\leftarrow 1$ |

| $x=0, y=0$ |

导致结果$𝑥=0$,$𝑦=0$,这在上面的串行一致模型下是不可能的。(有寻找这种依赖关系的算法[127])。串行一致意味着

1 | integet n |

效果应该与下述相同

1 | n=0 |

有了串行一致性,就不再需要声明原子操作或临界区;然而,这对模型的实现提出了强烈的要求,所以可能导致代码的低效。

亲和性

线程编程非常灵活,可以根据需要有效地创建并行性。然而,本书的很大一部分内容是关于科学计算中数据移动的重要性,在线程编程中不能忽视这一方面。

在多核处理器的背景下,任何线程都可以被安排到任何核上,这没有什么直接的问题。然而,如果你关心的是高性能,这种灵活性会带来意想不到的代价。你想让某些线程只在某些核心上运行,有各种原因。由于操作系统允许迁移线程,可能你只是想让线程留在原地。

- 如果一个线程迁移到不同的核心,而该核心有自己的缓存,你就会失去原来的缓存内容,不必要的内存转移就会发生。

- 如果一个线程迁移了,没有什么可以阻止操作系统把两个线程放在一个核心上,而让另一个核心完全不使用。这显然导致了不太完美的速度提升,即使线程的数量等于核心的数量。

我们称亲和性为「线程亲和性」(thread affinity)或「进程亲和性」(process affinity)与核心之间的映射。亲和性通常表示为一个掩码:对允许一个线程运行的位置的描述。例如,考虑一个双插槽的节点,每个插槽有四个核心。有了两个线程和插槽的亲和力,我们就有了以下的「关联掩码」(affinity mask)。

| thread | socket 0 | socket 1 |

|---|---|---|

| 0 | 0-1-2-3 | |

| 1 | 4-5-6-7 |

对于核心亲和性,面具取决于亲和力类型。典型的策略是 “接近 “和 “扩散”。在亲和关系密切的情况下,掩码可以是

| thread | socket 0 | socket 1 |

|---|---|---|

| 0 | 0 | |

| 1 | 1 |

在同一个插槽上有两个线程意味着它们可能共享一个二级缓存,所以如果它们共享数据,这种策略是合适的。

另一方面,随着「亲和性扩散」(spread affinity),线程被进一步分开。

| thread | socket 0 | socket 1 |

|---|---|---|

| 0 | 0 | |

| 1 | 4 |

这种策略对于带宽受限的应用来说更好,因为现在每个线程都拥有一个插槽的带宽,而不是在 “关闭 “的情况下不得不分享它。

如果分配了所有的内核,关闭和分散策略会导致不同的安排。

| socket 0 | socket 1 |

|---|---|

| 0-1-2-3 | |

| 4-5-6-7 |

相对于

| socket 0 | socket 1 |

|---|---|

| 0-2-4-6 | |

| 1-3-5-7 |

亲和性也可以被认为是一种将执行与数据绑定的策略。

考虑一下这段代码:

1 | for (i=0; i<ndata; i++) // this loop will be done by threads |

第一个循环,通过访问𝑥的元素,将内存带入高速缓存或页表。第二个循环以同样的顺序访问元素,所以为了性能,固定的亲和性是正确的决定。

在其他情况下,固定的映射不是正确的解决方案。

1 | for (i=0; i<ndata; i++) // produces loop |

在这第二个例子中,要么程序必须被改造,要么程序员必须实际维护一个任务队列。

- 第一次接触:从 “把执行放在数据所在的地方 “的角度来考虑亲和性是很自然的。然而,在实践中,相反的观点有时是有意义的。例如,图2.8显示了一个集群节点的共享内存实际上是如何分布的。因此,一个线程可以连接到一个插槽,但数据可以由操作系统分配到任何一个插槽上。操作系统经常使用的机制被称为first-touch策略。

- 当程序分配数据时,操作系统实际上并不创建数据。

- 相反,数据的内存区域是在线程第一次访问它时创建的。

- 因此,第一个接触该区域的线程实际上导致数据被分配到其插槽的内存中。

练习 2.19 用下面的代码解释一下这个问题。

1 | // serial initialization |

关于内存策略的深入讨论,见[134]。

Cilk Plus

还有其他基于线程的编程模型存在。例如,英特尔Cilk Plus(http://www.cilkplus.org/)是一套C/C++的扩展,程序员可以用它创建线程。

1 | //串行代码 |

1 | //Clik 代码 |

在这个例子中,变量rst被两个可能独立的线程更新。这种更新的语义,也就是如何解决同时写入等冲突的精确定义,是由串行一致性定义的;见2.6.1.6节。

超线程与多线程的比较

在上面的例子中,你看到在一个程序运行过程中产生的线程基本上都是执行相同的代码,并且可以访问相同的数据。因此,在硬件层面上,一个线程是由少量的局部变量唯一决定的,比如它在代码中的位置(程序计数器)和它所参与的当前计算的中间结果。

超线程是英特尔的一项技术,让多个线程真正同时使用处理器,这样处理器的一部分将得到最佳利用。

如果一个处理器在执行一个线程和另一个线程之间切换,它将保存一个线程的本地信息,并加载另一个线程的信息。与运行整个程序相比这样做的成本并不高,但与单条指令的成本相比可能很昂贵。因此,超线程不一定能带来性能的提高。

某些架构有对多线程的支持。这意味着硬件实际上对多个线程的本地信息有明确的存储,而且线程之间的切换可以非常快。GPU和英特尔Xeon Phi架构就是这种情况,每个内核可以支持多达四个线程。

OpenMP

OpenMP是对编程语言C和Fortran的一个扩展。它的主要并行方法是循环的并行执行:基于「编译器指令」(compiler directives),预处理器可以安排循环迭代的并行执行。

由于OpenMP是基于线程的,它的特点是「动态并行」(dynamic parallelism):在代码的一个部分和另一个部分之间,并行运行的执行流的数量可以变化。并行性是通过创建并行区域来声明的,例如表明一个循环嵌套的所有迭代都是独立的,然后运行时系统将使用任何可用的资源。

OpenMP不是一种语言,而是对现有的C和Fortran语言的一种扩展。它主要通过在源代码中插入指令来操作,由编译器进行解释。与MPI不同,它也有少量的库调用,但这些不是重点。最后,还有一个运行时系统来管理并行的执行。

与MPI相比,OpenMP的一个重要优势在于它的可编程性:可以从一个串行代码开始,通过「增量并行化」(incremental parallelization)来改造它。相比之下,将串行代码转化为分布式内存MPI程序是一个全有或全无的事情。

许多编译器,如gcc或Intel编译器,支持OpenMP扩展。在Fortran中,OpenMP指令被放在注释语句中;在C中,它们被放在#pragma CPP指令中,用来表示编译器特定的扩展。因此,对于不支持OpenMP的编译器来说,OpenMP代码看起来仍然像合法的C或Fortran语句。程序需要链接到OpenMP运行库,其行为可以通过环境变量来控制。

关于OpenMP的更多信息,见[31]和http://openmp.org/wp/。

OpenMP示例

OpenMP使用的最简单的例子是并行循环。

1 |

|

很明显,所有的迭代都可以独立执行,并且以任何顺序执行。然后,pragma CPP指令将这个事实传达给编译器。

有些循环在概念上是完全并行的,但在实现上不是。

1 | for (i=0; i<ProblemSize; i++) { |

这里看起来好像每个迭代都在向一个共享变量t写和读。然而,t实际上是一个临时变量,是每个迭代的局部。应该是可并行的代码,但由于这样的结构而不能并行,这被称为非线程安全。

OpenMP指出,临时变量对每个迭代都是私有的,如下所示。

1 |

|

如果一个标量确实是共享的,OpenMP有各种机制来处理这个问题。例如,共享变量通常出现在规约操作中。

1 | s = 0; |

正如上面所看到的,串行代码可以较为轻易地并行化。

迭代到线程的分配是由运行时系统完成的,但用户可以指导这种分配。我们主要关注迭代次数多于线程的情况:如果有$P$个线程和$N$个迭代,并且$N > P$,如何将迭代$i$分配给线程?

最简单的分配是使用「Round-robin任务调度」(round-robin task scheduling, a static scheduling),这是一种静态的调度策略,线程$p$获得迭代$p\times (N/P), …, (p + 1) \times (N/P) - 1$。这样做的好处是,如果一些数据在迭代之间被重复使用,它将留在执行该线程的处理器的数据缓存中。另一方面,如果迭代涉及的工作量不同,进程可能会遭受静态调度的负载不均衡。在这种情况下,动态调度策略的效果会更好,每个线程在完成当前迭代后就开始对下一个未处理的迭代进行工作。

我们可以用schedule关键字来控制OpenMP对循环迭代的调度,它的值包括静态和动态。也可以指出一个chunksize,它可以控制一起分配给线程的迭代块的大小。如果省略了chunksize,OpenMP将把迭代分成和线程数量一样多的块。

练习2.20 假设有$t$个线程,代码为

1 | for (i=0; i<N; i++) { |

如果指定chunksize为1,那么迭代0、𝑡、2𝑡……进入第一个线程,1、1+𝑡、1+2𝑡……进入第二个线程,依此类推。讨论一下为什么从性能的角度看这是一个糟糕的策略。提示:查一下「伪共享」(false sharing)的定义。什么是一个好的chunksize?

通过消息传递的分布式内存编程

虽然OpenMP程序和使用其他共享内存范式编写的程序看起来仍然非常像串行程序,但对于消息传递代码来说,情况并非如此。在我们详细讨论消息传递接口(MPI)库之前,我们先来看看并行代码编写方式的这种转变。

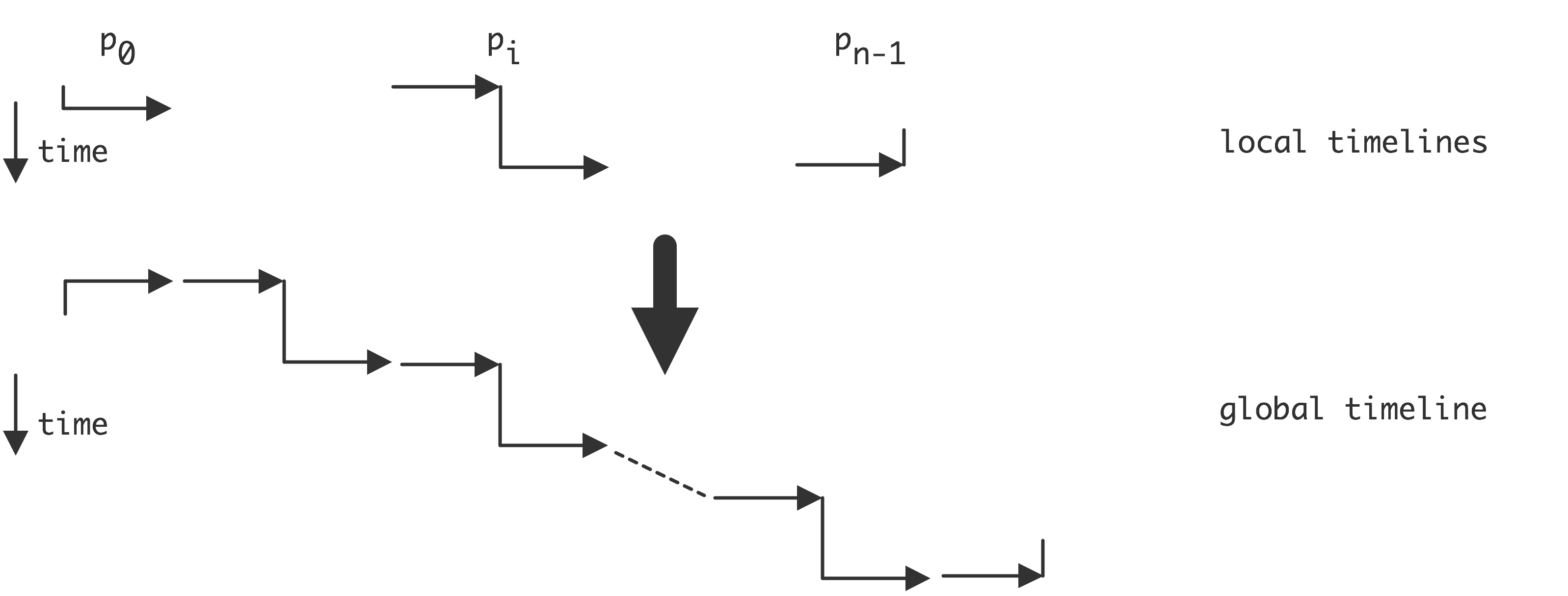

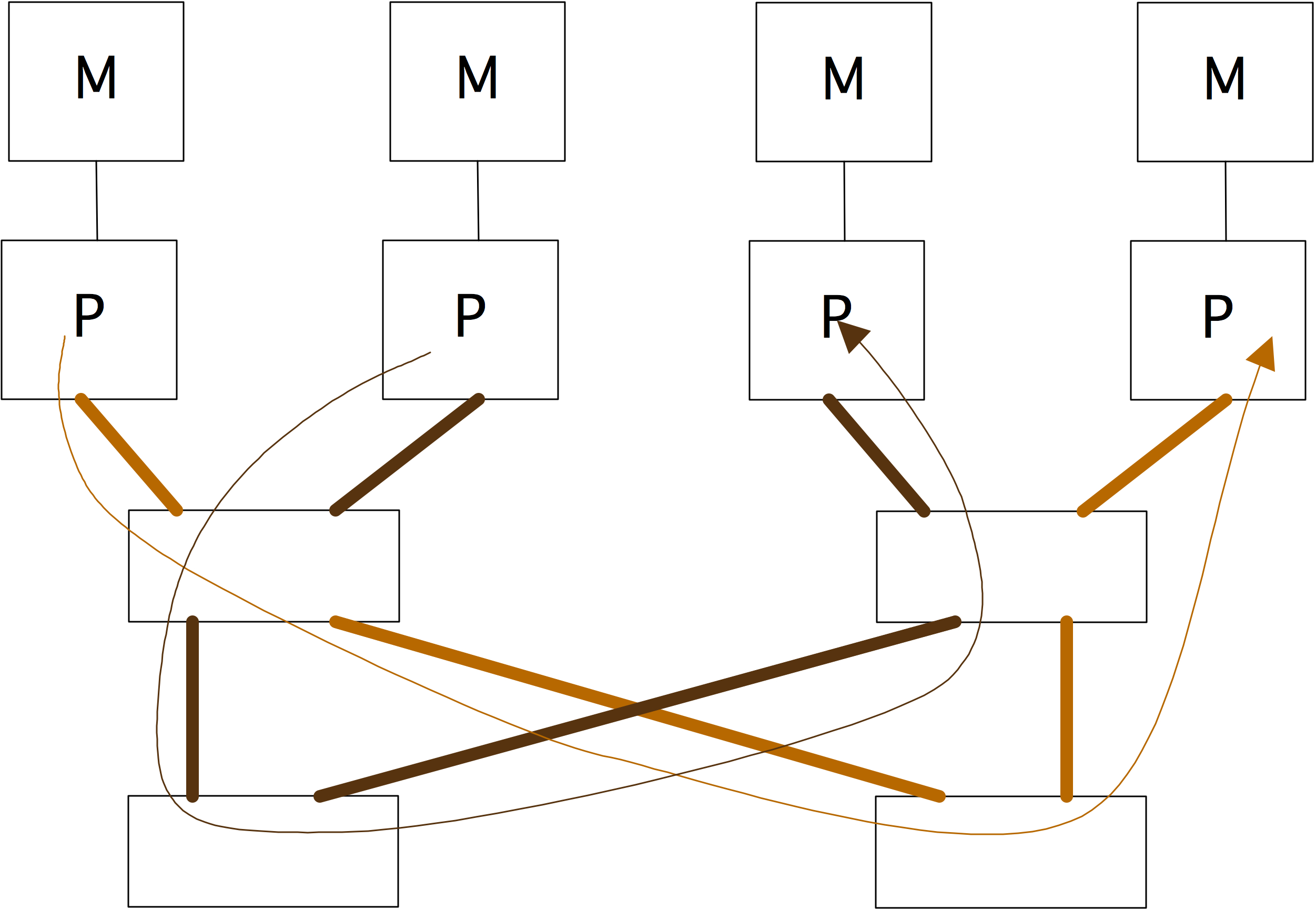

分布式编程中的全局视野与局部视野

在观察者看来,一个并行算法与它的实际编程方式之间可能存在明显的差异。考虑这样的情况:我们有一个处理器$\{P_i\}_{i=0…p-1}$的数组,每个处理器包含数组𝑥和𝑦中的一个元素,并且$P_i$计算

这方面的全局描述可以是

每个处理器$𝑃_𝑖$(最后一个除外)都将其$𝑃_𝑖$元素发送给$𝑃_{𝑖+1}$。

除了第一个之外,每个$𝑃_𝑖$处理器都从他们的邻居$𝑃_{𝑖-1}$那里收到一个$𝑥$元素,并且

他们将其添加到自己的$𝑦$元素中。

然而,在一般情况下,我们不能用这些全局术语来编码。在SPMD模型中,每个处理器执行相同的代码,而整体算法是这些单独行为的结果。本地程序只能访问本地数据—其他一切都需要用发送和接收操作来沟通—而且处理器知道自己的编号。

一种可能的写法是

- 如果是第0个处理器,什么都不做;否则从左边接收一个元素,增加一个𝑥元素。

- 如果是最后一个处理器,什么都不做。否则,将我的𝑦元素发送到右边。

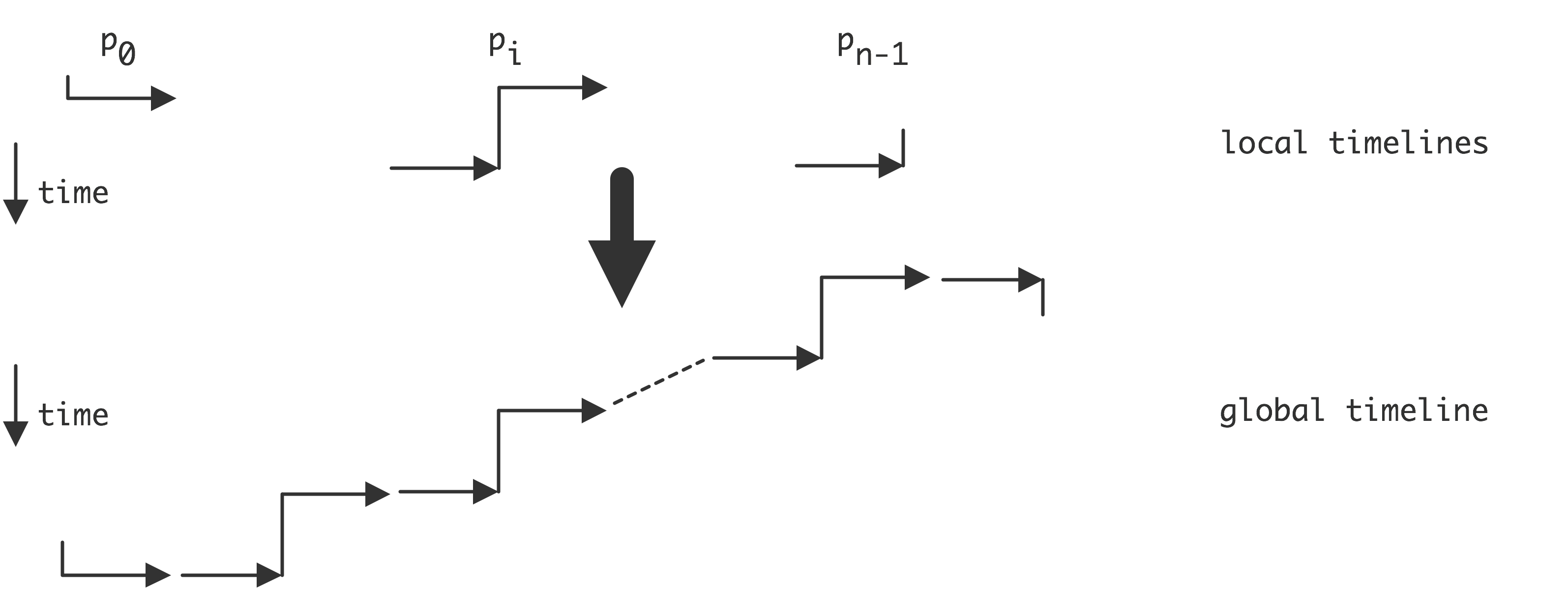

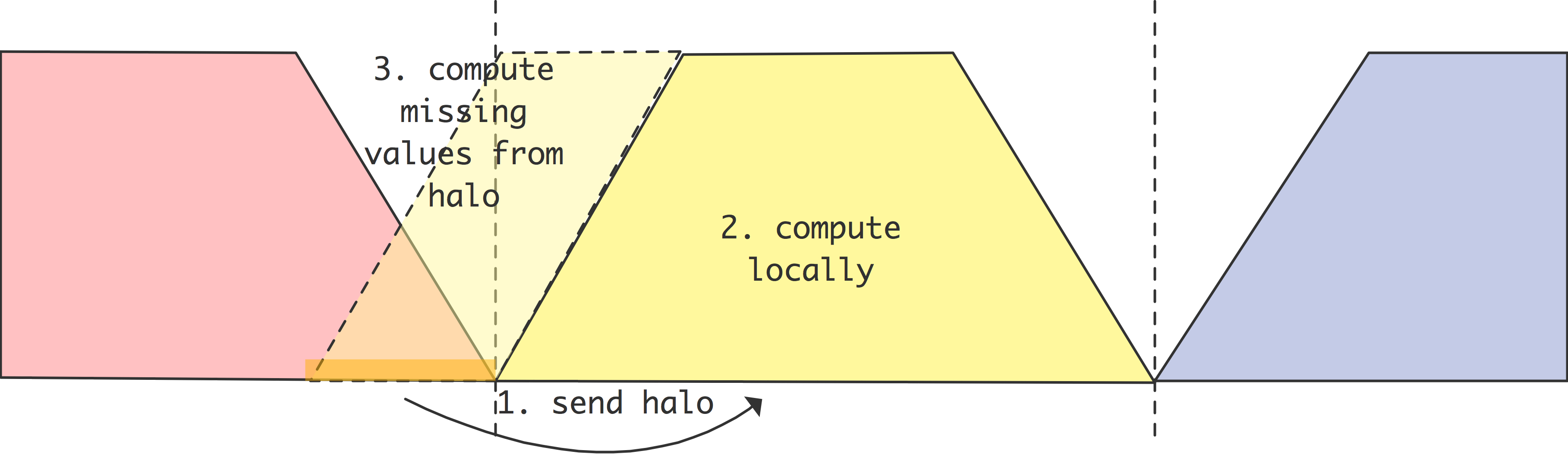

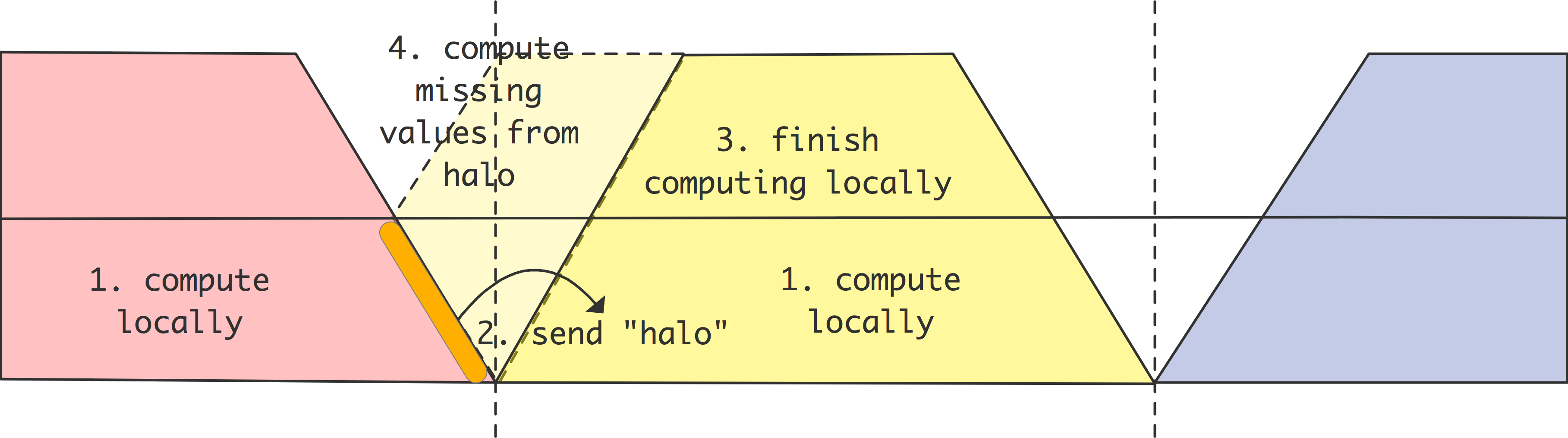

首先,我们看一下发送和接收是所谓的「阻塞通信」(blocking communication)的情况:发送指令在实际收到发送的项目之前不会结束,而接收指令则等待相应的发送。这意味着处理器之间的发送和接收必须被仔细配对。现在我们将看到,这可能导致在通往高效代码的路上出现各种问题。

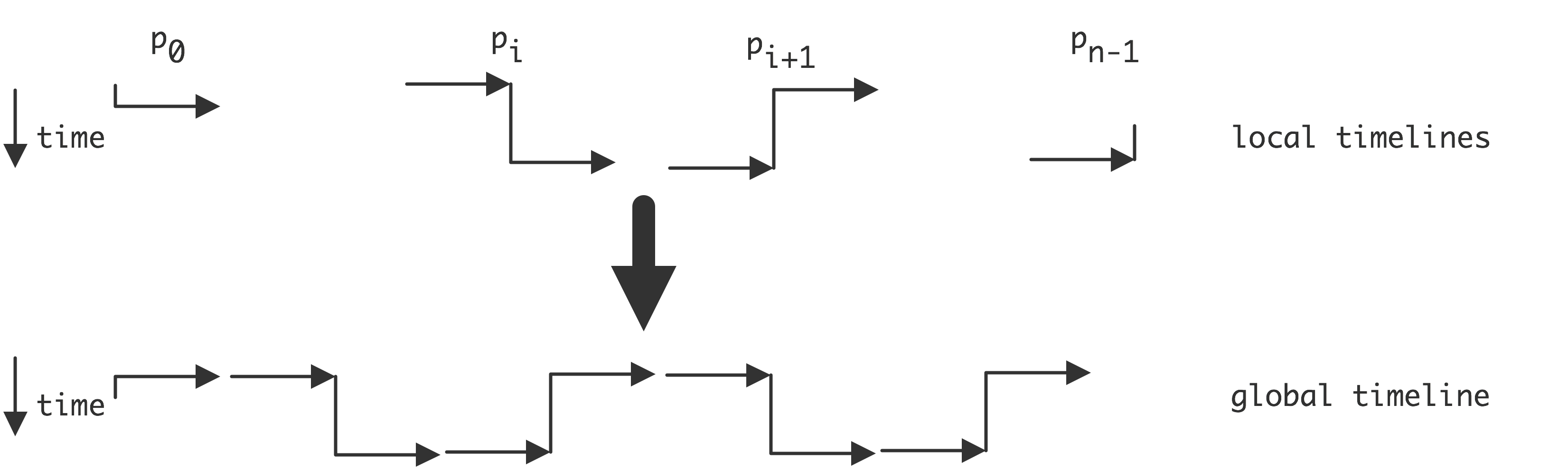

图2.13展示了上述解决方案,我们展示了描述本地处理器代码的局部时间线,以及由此产生的全局行为。你可以看到,处理器不是在同一时间工作的:我们得到的是序列化的执行。

如果我们把发送和接收操作倒过来呢?

- 如果不是最后一个处理器,就把我的𝑥元素发送到右边。

- 如果不是第一个处理器,从左边接收一个𝑥元素,并将其添加到𝑦元素中。

向右边发送数据的算法的局部和结果的全局视野:

向右边发送数据的算法的局部和结果的全局视野:

向右边发送数据的算法的局部和结果的全局视图:

图2.14说明了这一点,你可以看到我们再次得到一个序列化的执行,只不过现在处理器是从右到左激活的。

如果方程2.5中的算法是循环的:

问题会更加严重。现在,最后一个处理器无法开始接收,因为它被阻止向0号处理器发送𝑥𝑛-1。这种情况下,程序无法进展,因为每个处理器都在等待另一个处理器,这被称为「死锁」(deadlock)。

获得高效代码的解决方案是使尽可能多的通信同时发生。毕竟,在算法中没有串行的依赖性。因此,我们对算法的编程如下

- 奇数处理器,先发后收。

- 偶数处理器,先收后发。

图2.15说明了这一点,我们看到现在的执行是并行的。

练习 2.21 再看一下图2.3中的并行规约。其基本动作是 - 接收来自邻居的数据

- 将其添加到自己的数据中

- 将结果发送出去。

正如在图中看到的,至少有一个处理器不发送数据,其他的处理器在发送结果之前可能会做不同次数的接收。编写节点代码,使SPMD程序实现分布式规约。提示:用二进制写每个处理器的编号。该算法使用的步骤数等于该位串的长度。

- 假设一个处理器收到一条消息,用步数表示到该消息的原点的距离。

- 每个处理器最多发送一条消息。用二进制处理器编号来表示发生这种情况的步骤。

阻塞和非阻塞通信

阻断指令的原因是为了防止网络中的数据积累。如果一条发送指令在相应的接收指令开始之前完成,网络将不得不在这段时间内将数据储存在某个地方。考虑一个简单的例子:

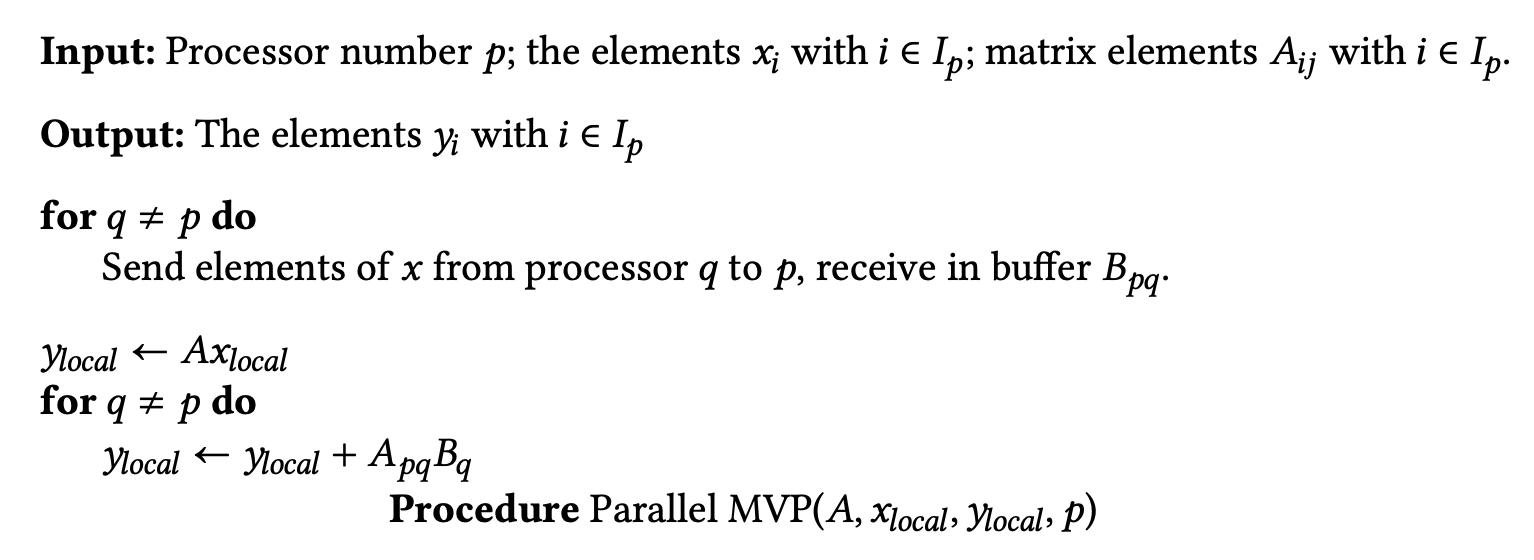

1 | buffer = ... ; // 生成一些数据 |