原文:https://www.dingmos.com/index.php/archives/4/

lab1

实验分为三个部分:

- 熟悉汇编语言、QEMU x86模拟器、PC上电启动过程

- 检查我们的6.828内核的boot loader程序,它位于lab的boot目录下。

- 深入研究6.828内核本身的初始模板,位于kernel目录下。

MIT6.828 实验环境配置

使用命令行创建了一个目录~/6.828,在该目录下初始化一个git仓库1

~/6.828$ git init

把JOS系统源码clone到本地1

~/6.828$ git clone https://pdos.csail.mit.edu/6.828/2017/jos.git lab

安装QEMU这个仿真器需要先安装包。1

2

3

4

5sudo apt-get install libsdl1.2-dev

sudo apt-get install libglib2.0-dev

sudo apt-get install libz-dev

sudo apt-get install libpixman-1-dev

sudo apt-get install libtool*

打开qemu所在目录,进行configuration1

sudo ./configure --disable-kvm --disable-werror --prefix=$HMOE --target-list="i386-softmmu x86_64-softmmu"

最后进行安装。1

sudo make && make install

安装包时频繁出现依赖问题,把apt-get换成了aptitude无用;最后是换了源解决的,可能是因为在安装中断后更换了源,换回去就好了。

之后又报了Werror。在配置的时候处理werror解决。1

sudo ./configure --disable-werror --prefix==/usr/local --target-list="i386-softmmu x86_64-softmmu"

QUMU安装好之后,make lab下的代码报错:1

2lib/printfmt.c:41: undefined reference to `__udivdi3'

lib/printfmt.c:49: undefined reference to `__umoddi3'

ARM是精简指令集,对求余和除法操作基本上不支持。linux内核源码linux/arch/arm/lib/lib1funcs.S实现支持除法、求模操作等操作的库函数。本来应该多研究下,但是发现有现成的解决方案,我开发环境是64gcc,但需要的是32位,所以安装32位gcc解决问题。1

sudo apt-get install gcc-multilib

再次进行make,成功!1

2

3

4

5

6

7~/6.828/lab$ sudo make

+ ld obj/kern/kernel

+ as boot/boot.S

+ cc -Os boot/main.c

+ ld boot/boot

boot block is 390 bytes (max 510)

+ mk obj/kern/kernel.img

之后需要make qemu,又报错了:1

2

3

4

5/bin/sh: 1: /home/yuhao/qemu/: Permission denied

/home/yuhao/qemu/ -drive file=obj/kern/kernel.img,index=0,media=disk,format=raw -serial mon:stdio -gdb tcp::26000

make: execvp: /home/yuhao/qemu/: Permission denied

GNUmakefile:156: recipe for target 'qemu' failed

make: *** [qemu] Error 127

应该是qemu的可执行文件配置错误,改一下env.mk。在执行启动简单映像的命令后,又有错误:1

2GLib-WARNING **:21:58:30.131:gmem.c:489:不支持自定义内存分配vtable

(qemu-system-x86_64:23983):Gtk-WARNING **:21:58:30.175:无法打开显示:

出现此问题是因为glib2错误(https://bugzilla.redhat.com/show_bug.cgi?id=1594304)。

此问题的另一方面是Red Hat和CentOS存储库包含过时的QEMU版本(最近是4)。

- 用qemu-kvm而不是qemu-system-x86_64:https://www.tecmint.com/install-manage-virtual-machines-in-centos/

- 从fedora仓库重新安装/更新所有QEMU软件包(https://copr-be.cloud.fedoraproject.org/results/fcomida/qemu-4/fedora-30-x86_64/00910942-qemu/)`rpm -i /path/to/file/file_name.rpm`

- 自己编译QEMU(https://www.qemu.org/download/#source)。

1 | wget https://download.qemu.org/qemu-4.1.0-rc2.tar.xz |

运行成功的话终端就会打印出以下字符:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17/home/yuhao/6.828/qemu/i386-softmmu/qemu-system-i386 -drive file=obj/kern/kernel.img,index=0,media=disk,format=raw -serial mon:stdio -gdb tcp::26000 -D qemu.log

VNC server running on 127.0.0.1:5900

6828 decimal is XXX octal!

entering test_backtrace 5

entering test_backtrace 4

entering test_backtrace 3

entering test_backtrace 2

entering test_backtrace 1

entering test_backtrace 0

leaving test_backtrace 0

leaving test_backtrace 1

leaving test_backtrace 2

leaving test_backtrace 3

leaving test_backtrace 4

leaving test_backtrace 5

Welcome to the JOS kernel monitor!

Type 'help' for a list of commands.

键入kerninfo,值得注意的是,此内核监视器“直接”在模拟PC的“原始(虚拟)硬件”上运行。1

2

3

4

5

6

7

8K> kerninfo

Special kernel symbols:

_start 0010000c (phys)

entry f010000c (virt) 0010000c (phys)

etext f0101acd (virt) 00101acd (phys)

edata f0113060 (virt) 00113060 (phys)

end f01136a0 (virt) 001136a0 (phys)

Kernel executable memory footprint: 78KB

细节记录

- PC中BIOS大小为64k, 物理地址范围0x000f0000-0x000fffff

- PC 开机首先0xfffff0处执行 jmp [0xf000,0xe05b] 指令。在gdb中使用si(Step Instruction)进行跟踪。

使用gdb进行调试1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29$ make gdb

GNU gdb (GDB) 6.8-debian

Copyright (C) 2008 Free Software Foundation, Inc.

License GPLv3+: GNU GPL version 3 or later <http://gnu.org/licenses/gpl.html>

This is free software: you are free to change and redistribute it.

There is NO WARRANTY, to the extent permitted by law. Type "show copying"

and "show warranty" for details.

This GDB was configured as "i486-linux-gnu".

+ target remote localhost:26000

The target architecture is assumed to be i8086

[f000:fff0] 0xffff0: ljmp $0xf000,$0xe05b

0x0000fff0 in ?? ()

+ symbol-file obj/kern/kernel

(gdb) si

[f000:e05b] 0xfe05b: cmpw $0xffc8,%cs:(%esi) # 比较大小,改变PSW

0x0000e05b in ?? ()

(gdb) si

[f000:e062] 0xfe062: jne 0xd241d416 # 不相等则跳转

0x0000e062 in ?? ()

(gdb) si

[f000:e066] 0xfe066: xor %edx,%edx # 清零edx

0x0000e066 in ?? ()

(gdb) si

[f000:e068] 0xfe068: mov %edx,%ss

0x0000e068 in ?? ()

(gdb) si

[f000:e06a] 0xfe06a: mov $0x7000,%sp

0x0000e06a in ?? ()

BIOS运行过程中,它设定了中断描述符表,对VGA显示器等设备进行了初始化。在初始化完PCI总线和所有BIOS负责的重要设备后,它就开始搜索软盘、硬盘、或是CD-ROM等可启动的设备。最终,当它找到可引导磁盘时,BIOS从磁盘读取引导加载程序并将控制权转移给它。

Part 2: The Boot Loader

机器的物理地址空间有如下布局:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29+------------------+ <- 0xFFFFFFFF (4GB)

| 32-bit |

| memory mapped |

| devices |

| |

/\/\/\/\/\/\/\/\/\/\

/\/\/\/\/\/\/\/\/\/\

| |

| Unused |

| |

+------------------+ <- depends on amount of RAM

| |

| |

| Extended Memory |

| |

| |

+------------------+ <- 0x00100000 (1MB)

| BIOS ROM |

+------------------+ <- 0x000F0000 (960KB)

| 16-bit devices, |

| expansion ROMs |

+------------------+ <- 0x000C0000 (768KB)

| VGA Display |

+------------------+ <- 0x000A0000 (640KB)

| |

| Low Memory |

| |

+------------------+ <- 0x00000000

对于6.828,我们将使用传统的硬盘启动机制,这意味着我们的boot loader必须满足于512字节。

boot loader由一个汇编语言源文件boot/boot.S和一个C源文件boot/main.c组成。

boot.S

BIOS将boot.S这段代码从硬盘的第一个扇区load到物理地址为0x7c00的位置,同时CPU工作在real mode。

boot.S需要将CPU的工作模式从实模式转换到32位的保护模式, 并且 jump 到 C 语言程序。

源码阅读,知识点:

- cli (clear interrupt)

- cld (clear direction flag)

df: 方向标志位。在串处理指令中,控制每次操作后si,di的增减。(df=0,每次操作后si、di递增;df=1,每次操作后si、di递减)。

为了向前兼容早期的PC机,A20地址线接地,所以当地址大于1M范围时,会默认回滚到0处。所以在转向32位模式之前,需要使能A20。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15seta20.1:

inb $0x64,%al # Wait for not busy

testb $0x2,%al

jnz seta20.1

movb $0xd1,%al # 0xd1 -> port 0x64

outb %al,$0x64

seta20.2:

inb $0x64,%al # Wait for not busy

testb $0x2,%al

jnz seta20.2

movb $0xdf,%al # 0xdf -> port 0x60

outb %al,$0x60

test 逻辑运算指令,对两个操作数进行AND操作,并且修改PSW, test 与 AND 指令唯一不同的地方是,TEST 指令不修改目标操作数。

test al, 00001001b ;测试位 0 和位 3

lgdt gdtdesc, 加载全局描述符表,暂时不管全局描述表是如何生成的。cr0, control register,控制寄存器。- CR0中包含了6个预定义标志,0位是保护允许位PE(Protedted Enable),用于启动保护模式,如果PE位置1,则保护模式启动,如果PE=0,则在实模式下运行。

1 | # Switch from real to protected mode, using a bootstrap GDT |

调试boot.S

设置一个断点在地址0x7c00处,这是boot sector被加载的位置。然后让程序继续运行直到这个断点。跟踪/boot/boot.S文件的每一条指令,同时使用boot.S文件和系统为你反汇编出来的文件obj/boot/boot.asm。你也可以使用GDB的x/i指令来获取去任意一个机器指令的反汇编指令,把源文件boot.S文件和boot.asm文件以及在GDB反汇编出来的指令进行比较。

追踪到bootmain函数中,而且还要具体追踪到readsect()子函数里面。找出和readsect()c语言程序的每一条语句所对应的汇编指令,回到bootmain(),然后找出把内核文件从磁盘读取到内存的那个for循环所对应的汇编语句。找出当循环结束后会执行哪条语句,在那里设置断点,继续运行到断点,然后运行完所有的剩下的语句。

下面我们将分别分析一下这道练习中所涉及到的两个重要文件,它们一起组成了boot loader。分别是/boot/boot.S和/boot/main.c文件。其中前者是一个汇编文件,后者是一个C语言文件。当BIOS运行完成之后,CPU的控制权就会转移到boot.S文件上。所以我们首先看一下boot.S文件。

/boot/boot.S:1

2

3

4.globl start

start:

.code16 # Assemble for 16-bit mode

cli # Disable interrupts

这几条指令就是boot.S最开始的几句,其中cli是boot.S,也是boot loader的第一条指令。这条指令用于把所有的中断都关闭。因为在BIOS运行期间有可能打开了中断。此时CPU工作在实模式下。1

cld # String operations increment

这条指令用于指定之后发生的串处理操作的指针移动方向。在这里现在对它大致了解就够了。

1 | # Set up the important data segment registers (DS, ES, SS). |

这几条命令主要是在把三个段寄存器,ds,es,ss全部清零,因为经历了BIOS,操作系统不能保证这三个寄存器中存放的是什么数。所以这也是为后面进入保护模式做准备。

1 | # Enable A20: |

这部分指令就是在准备把CPU的工作模式从实模式转换为保护模式。我们可以看到其中的指令包括inb,outb这样的IO端口命令。所以这些指令都是在对外部设备进行操作。0x64端口属于键盘控制器804x,名称是控制器读取状态寄存器。

不断的检测bit1。bit1的值代表输入缓冲区是否满了,也就是说CPU传送给控制器的数据,控制器是否已经取走了,如果CPU想向控制器传送新的数据的话,必须先保证这一位为0。所以这三条指令会一直等待这一位变为0,才能继续向后运行。

当0x64端口准备好读入数据后,现在就可以写入数据了,所以19~20这两条指令是把0xd1这条数据写入到0x64端口中。当向0x64端口写入数据时,则代表向键盘控制器804x发送指令。这个指令将会被送给0x60端口。

D1指令代表下一次写入0x60端口的数据将被写入给804x控制器的输出端口。可以理解为下一个写入0x60端口的数据是一个控制指令。

然后21~24号指令又开始再次等待,等待刚刚写入的指令D1,是否已经被读取了。

如果指令被读取了,25~26号指令会向控制器输入新的指令,0xdf。这个指令的含义是,使能A20线,代表可以进入保护模式了。

1 | 27 # Switch from real to protected mode, using a bootstrap GDT |

首先31号指令lgdt gdtdesc,是把gdtdesc这个标识符的值送入全局映射描述符表寄存器GDTR中。这个GDT表是处理器工作于保护模式下一个非常重要的表。这条指令的功能就是把关于GDT表的一些重要信息存放到CPU的GDTR寄存器中,其中包括GDT表的内存起始地址,以及GDT表的长度。这个寄存器由48位组成,其中低16位表示该表长度,高32位表该表在内存中的起始地址。所以gdtdesc是一个标识符,标识着一个内存地址。从这个内存地址开始之后的6个字节中存放着GDT表的长度和起始地址。我们可以在这个文件的末尾看到gdtdesc,如下:

1 | 1 # Bootstrap GDT |

其中第3行的gdt是一个标识符,标识从这里开始就是GDT表了。可见这个GDT表中包括三个表项(4,5,6行),分别代表三个段,null seg,code seg,data seg。由于xv6其实并没有使用分段机制,也就是说数据和代码都是写在一起的,所以数据段和代码段的起始地址都是0x0,大小都是0xffffffff=4GB。

在第4~6行是调用SEG()子程序来构造GDT表项的。这个子函数定义在mmu.h中,形式如下: 1

2

3

4

可见函数需要3个参数,一是type即这个段的访问权限,二是base,这个段的起始地址,三是lim,即这个段的大小界限。gdt表中的每一个表项的结构:1

2

3

4

5

6

7

8struct gdt_entry_struct {

limit_low: resb 2

base_low: resb 2

base_middle : resb 1

access: resb 1

granularity: resb 1

base_high: resb 1

}

每个表项一共8字节,其中limit_low就是limit的低16位。base_low就是base的低16位,依次类推。

然后在gdtdesc处就要存放这个GDT表的信息了,其中0x17是这个表的大小-1 = 0x17 = 23,至于为什么不直接存表的大小24,根据查询是官方规定的。紧接着就是这个表的起始地址gdt。

1 | 27 # Switch from real to protected mode, using a bootstrap GDT |

再回到刚才那里,当加载完GDT表的信息到GDTR寄存器之后。紧跟着3个操作,32~34指令。 这几步操作明显是在修改CR0寄存器的内容。CR0寄存器还有CR1~CR3寄存器都是80x86的控制寄存器。其中$CR0_PE的值定义于”mmu.h”文件中,为0x00000001。可见上面的操作是把CR0寄存器的bit0置1,CR0寄存器的bit0是保护模式启动位,把这一位值1代表保护模式启动。

1 | 35 ljmp $PROT_MODE_CSEG, $protcseg |

这只是一个简单的跳转指令,这条指令的目的在于把当前的运行模式切换成32位地址模式

1 | protcseg: |

修改这些寄存器的值。这些寄存器都是段寄存器,如果刚刚加载完GDTR寄存器我们必须要重新加载所有的段寄存器的值,而其中CS段寄存器必须通过长跳转指令,即23号指令来进行加载。这样才能是GDTR的值生效。

1 | # Set up the stack pointer and call into C. |

接下来的指令就是要设置当前的esp寄存器的值,然后准备正式跳转到main.c文件中的bootmain函数处。我们接下来分析一下这个函数的每一条指令:

1 | // read 1st page off disk |

这里面调用了一个函数readseg,这个函数在bootmain之后被定义了:1

void readseg(uchar *pa, uint count, uint offset);

它的功能从注释上来理解应该是,把距离内核起始地址offset个偏移量存储单元作为起始,将它和它之后的count字节的数据读出送入以pa为起始地址的内存物理地址处。

所以这条指令是把内核的第一个页(4MB = 4096 = SECTSIZE8 = 5128)的内容读取的内存地址ELFHDR(0x10000)处。其实完成这些后相当于把操作系统映像文件的elf头部读取出来放入内存中。

读取完这个内核的elf头部信息后,需要对这个elf头部信息进行验证,并且也需要通过它获取一些重要信息。

elf文件:elf是一种文件格式,主要被用来把程序存放到磁盘上。是在程序被编译和链接后被创建出来的。一个elf文件包括多个段。对于一个可执行程序,通常包含存放代码的文本段(text section),存放全局变量的data段,存放字符串常量的rodata段。elf文件的头部就是用来描述这个elf文件如何在存储器中存储。

1 | 2 if (ELFHDR->e_magic != ELF_MAGIC) |

elf头部信息的magic字段是整个头部信息的开端。并且如果这个文件是格式是ELF格式的话,文件的elf->magic域应该是=ELF_MAGIC的,所以这条语句就是判断这个输入文件是否是合法的elf可执行文件。

1 | 4 ph = (struct Proghdr *) ((uint8_t *) ELFHDR + ELFHDR->e_phoff); |

我们知道头部中一定包含Program Header Table。这个表格存放着程序中所有段的信息。通过这个表我们才能找到要执行的代码段,数据段等等。所以我们要先获得这个表。

这条指令就可以完成这一点,首先elf是表头起址,而phoff字段代表Program Header Table距离表头的偏移量。所以ph可以被指定为Program Header Table表头。

1 | 5 eph = ph + ELFHDR->e_phnum; |

由于phnum中存放的是Program Header Table表中表项的个数,即段的个数。所以这步操作是吧eph指向该表末尾。

1 | 6 for (; ph < eph; ph++) |

这个for循环就是在加载所有的段到内存中。ph->paddr根据参考文献中的说法指的是这个段在内存中的物理地址。ph->off字段指的是这一段的开头相对于这个elf文件的开头的偏移量。ph->filesz字段指的是这个段在elf文件中的大小。ph->memsz则指的是这个段被实际装入内存后的大小。通常来说memsz一定大于等于filesz,因为段在文件中时许多未定义的变量并没有分配空间给它们。

所以这个循环就是在把操作系统内核的各个段从外存读入内存中。

1 | 8 ((void (*)(void)) (ELFHDR->e_entry))(); |

e_entry字段指向的是这个文件的执行入口地址。所以这里相当于开始运行这个文件。也就是内核文件。 自此就把控制权从boot loader转交给了操作系统的内核。

分析完了程序后,来完成Exercise要求我们做的事情:

在一个terminal中cd到lab目录下,执行make qemu-gdb。再开一个 terminal执行make gdb。

因为BIOS会把boot loader加载到0x7c00的位置,因此设置断点b *0x7c00。再执行c,会看到QUMU终端上显示Booting from hard disk。

执行x/30i 0x7c00就能看到与boot.S中类似的汇编代码了。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31(gdb) b *0x7c00

Breakpoint 1 at 0x7c00

(gdb) c

Continuing.

[ 0:7c00] => 0x7c00: cli

Breakpoint 1, 0x00007c00 in ?? ()

(gdb) x/30i 0x7c00

=> 0x7c00: cli

0x7c01: cld

0x7c02: xor %eax,%eax

0x7c04: mov %eax,%ds

0x7c06: mov %eax,%es

0x7c08: mov %eax,%ss

0x7c0a: in $0x64,%al

0x7c0c: test $0x2,%al

0x7c0e: jne 0x7c0a

0x7c10: mov $0xd1,%al

0x7c12: out %al,$0x64

0x7c14: in $0x64,%al

0x7c16: test $0x2,%al

0x7c18: jne 0x7c14

0x7c1a: mov $0xdf,%al

0x7c1c: out %al,$0x60

0x7c1e: lgdtl (%esi)

0x7c21: fs jl 0x7c33

0x7c24: and %al,%al

0x7c26: or $0x1,%ax

0x7c2a: mov %eax,%cr0

0x7c2d: ljmp $0xb866,$0x87c32

0x7c34: adc %al,(%eax)

这条gdb指令是把存放在0x7c00以及之后30字节的内存里面的指令反汇编出来,我们可以拿它直接和boot.S以及在obj/boot/boot.asm进行比较,这三者在指令上没有区别,只不过在源代码中,我们指定了很多标识符比如set20.1,.start,这些标识符在被汇编成机器代码后都会被转换成真实物理地址。比如set20.1就被转换为0x7c0a,那么在obj/boot/boot.asm中还把这种对应关系列出来了,但是在真实执行时,即第一种情况中,就看不到set20.1标识符了,完全是真实物理地址。

加载内核

接下来我们分析boot loader的C语言部分。

首先熟悉以下C指针。 编译运行pointer.c结果。 可以发现 a[],b的地址相差很多,因为两者所存放的段不同。1

2

3

4

5

6

7

81: a = 0xbfa8bdbc, b = 0x9e3a160, c = (nil)

2: a[0] = 200, a[1] = 101, a[2] = 102, a[3] = 103

3: a[0] = 200, a[1] = 300, a[2] = 301, a[3] = 302

4: a[0] = 200, a[1] = 400, a[2] = 301, a[3] = 302

5: a[0] = 200, a[1] = 128144, a[2] = 256, a[3] = 302

// b = a + 4

6: a = 0xbfa8bdbc, b = 0xbfa8bdc0, c = 0xbfa8bdbd

ELF格式非常强大和复杂,但大多数复杂的部分都是为了支持共享库的动态加载,在6.828课程中并不会用到。在本课程中,我们可以把ELF可执行文件简单地看为带有加载信息的标头,后跟几个程序部分,每个程序部分都是一个连续的代码块或数据,其将被加载到指定内存中。

我们所需要关心的Program Section是:

- .text : 可执行指令

- .rodata: 只读数据段,例如字符串常量。(但是,我们不会费心设置硬件来禁止写入。)

- .data : 存放已经初始化的数据

- .bss : 存放未初始化的变量, 但是在ELF中只需要记录.bss的起始地址和长度。Loader and program必须自己将.bss段清零。

每个程序头的ph-> p_pa字段包含段的目标物理地址(在这种情况下,它实际上是一个物理地址,尽管ELF规范对该字段的实际含义含糊不清)

BIOS会将引导扇区的内容加载到 0x7c00 的位置,引导程序也就从0x7C00的位置开始执行。我们通过-Ttext 0x7C00将链接地址传递给boot / Makefrag中的链接器,因此链接器将在生成的代码中生成正确的内存地址。

除了部分信息之外,ELF头中还有一个对我们很重要的字段,名为e_entry。该字段保存程序中入口点的链接地址:程序应该开始执行的代码段的存储地址。 在反汇编代码中,可以看到最后call 了 0x10018地址。1

2((void (*)(void)) (ELFHDR->e_entry))();

7d6b: ff 15 18 00 01 00 call *0x10018

在0x7d6b 打断点后,c 再si一次,发现实际跳转地址位0x10000c1

2

3

4

5

6

7

8

9(gdb) b *0x7d6b

Breakpoint 3 at 0x7d6b

(gdb) c

Continuing.

=> 0x7d6b: call *0x10018

Breakpoint 3, 0x00007d6b in ?? ()

(gdb) si

=> 0x10000c: movw $0x1234,0x472

与实际执行objdump -f kernel的 结果一致。1

2

3

4../kern/kernel: file format elf32-i386

architecture: i386, flags 0x00000112:

EXEC_P, HAS_SYMS, D_PAGED

start address 0x0010000c

Part3:The Kernel

我们现在将开始更详细地研究JOS内核。(最后你会写一些代码!)。与引导加载程序一样,内核从一些汇编语言代码开始,这些代码设置可以使C语言代码正确执行。

使用虚拟内存来解决位置依赖问题

操作系统内核通常被链接到非常高的虚拟地址(例如0xf0100000)下运行,以便留下处理器虚拟地址空间的低地址部分供用户程序使用。 在下一个lab中,这种安排的原因将变得更加清晰。

许多机器在地址范围无法达到0xf0100000,因此我们无法指望能够在那里存储内核。相反,我们将使用处理器的内存管理硬件将虚拟地址0xf0100000(内核代码期望运行的链接地址)映射到物理地址0x00100000(引导加载程序将内核加载到物理内存中)。尽管内核的虚拟地址足够高,可以为用户进程留下大量的内存空间,在物理地址中内核将会被加载到1MB的位置,仅次于BIOS。

现在,我们只需映射前4MB的物理内存,这足以让我们启动并运行。 我们使用kern/entrypgdir.c中手写的,静态初始化的页面目录和页表来完成此操作。 现在,你不必了解其工作原理的细节,只需注意其实现的效果。

实现虚拟地址,有一个很重要的寄存器CR0-PG:

PG:CR0的位31是分页(Paging)标志。当设置该位时即开启了分页机制;当复位时则禁止分页机制,此时所有线性地址等同于物理地址。在开启这个标志之前必须已经或者同时开启PE标志。即若要启用分页机制,那么PE和PG标志都要置位。

Exercise 7

- 使用QEMU和GDB跟踪到JOS内核并停在

movl %eax,%cr0。 检查内存为0x00100000和0xf0100000。 现在,使用stepi GDB命令单步执行该指令。 再次检查内存为0x00100000和0xf0100000。 确保你了解刚刚发生的事情。

注意实验文档上所说的,硬件实现的页表转换机制将0xf0000000等那些f打头的16进制地址转到0x00100000。GDB调试设置断点时,设置的是物理地址,不是逻辑地址,所以断点设置为kernel的入口地址。

b *0x10000c

1

不知为何,断点设置到0x100000不行,可能是因为代码段中那一段标号和段标识我不认识。

0x100000处的反汇编代码如下1

2

3

4

5

6

7

8

9

10.globl entry

entry:

movw $0x1234,0x472 # warm boot

f0100000: 02 b0 ad 1b 00 00 add 0x1bad(%eax),%dh

f0100006: 00 00 add %al,(%eax)

f0100008: fe 4f 52 decb 0x52(%edi)

f010000b: e4 .byte 0xe4

f010000c <entry>:

f010000c: 66 c7 05 72 04 00 00 movw $0x1234,0x472

执行过程如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28(gdb) c

Continuing.

The target architecture is assumed to be i386

=> 0x10000c: movw $0x1234,0x472

Breakpoint 1, 0x0010000c in ?? ()

(gdb) s

Cannot find bounds of current function

(gdb) si

=> 0x100015: mov $0x112000,%eax

0x00100015 in ?? ()

(gdb) si

=> 0x10001a: mov %eax,%cr3

0x0010001a in ?? ()

(gdb) si

=> 0x10001d: mov %cr0,%eax

0x0010001d in ?? ()

(gdb) si

=> 0x100020: or $0x80010001,%eax

0x00100020 in ?? ()

(gdb) si

=> 0x100025: mov %eax,%cr0

0x00100025 in ?? ()

(gdb) si

=> 0x100028: mov $0xf010002f,%eax

0x00100028 in ?? ()

(gdb)

当执行到movl %eax,%cr0时,停下,此时查看两处内存结果如下。1

2

3

4

5

6

7=> 0x100025: mov %eax,%cr0

0x00100025 in ?? ()

(gdb) x/1x 0x00100000

0x100000: 0x1badb002

(gdb) x/1x 0xf0100000

0xf0100000 <_start+4026531828>: 0x00000000

(gdb)

因为0xf0100000处不是我们真正装载内核的地方,逻辑地址0xf0100000被映射成了0x00100000,所以低地址处有内容,高地址处无内容。

当单步执行完movl %eax,%cr0 时,停下,此时查看两处内存结果如下。1

2

3

4

5

6

7=> 0x100028: mov $0xf010002f,%eax

0x00100028 in ?? ()

(gdb) x/1x 0x00100000

0x100000: 0x1badb002

(gdb) x/1x 0xf0100000

0xf0100000 <_start+4026531828>: 0x1badb002

(gdb)

可以看到高地址处和低地址处值相同了。

原因其实在实验指导书里写着。

Once CR0_PG is set, memory references are virtual addresses that get translated by the virtual memory hardware to physical addresses. entry_pgdir translates virtual addresses in the range 0xf0000000 through 0xf0400000 to physical addresses 0x00000000 through 0x00400000, as well as virtual addresses 0x00000000 through 0x00400000 to physical addresses 0x00000000 through 0x00400000.

首先明确cr0是什么。cr0全称是control register 0.下面是wiki中的解释。

The CR0 register is 32 bits long on the 386 and higher processors. On x86-64 processors in long mode, it (and the other control registers) is 64 bits long. CR0 has various control flags that modify the basic operation of the processor.

| Bit | Name | Full Name | Description |

|---|---|---|---|

| 0 | PE | Protected Mode Enable | If 1, system is in protected mode, else system is in real mode |

| 1 | MP | Monitor co-processor | Controls interaction of WAIT/FWAIT instructions with TS flag in CR0 |

| 2 | EM | Emulation | If set, no x87 floating-point unit present, if clear, x87 FPU present |

| 3 | TS | Task switched | Allows saving x87 task context upon a task switch only after x87 instruction used |

| 4 | ET | Extension type | On the 386, it allowed to specify whether the external math coprocessor was an 80287 or 80387 |

| 5 | NE | Numeric error | Enable internal x87 floating point error reporting when set, else enables PC style x87 error detection |

| 16 | WP | Write protect | When set, the CPU can’t write to read-only pages when privilege level is 0 |

| 18 | AM | Alignment mask | Alignment check enabled if AM set, AC flag (in EFLAGS register) set, and privilege level is 3 |

| 29 | NW | Not-write through | Globally enables/disable write-through caching |

| 30 | CD | Cache disable | Globally enables/disable the memory cache |

| 31 | PG | Paging | If 1, enable paging and use the § CR3 register, else disable paging. |

把eax赋给cr0时,eax=0x80110001,对应上面的标志位就能知道发出了什么控制信息。最关键的是PG,这个信号打开了页表机制,以后都会自动将 0xf0000000 到 0xf0400000 的虚拟(逻辑)地址转成 0x00000000 到 0x00400000 的物理地址。

所以此处会自动把0xf0100000转换成0x00100000,所以两者的值相等。

如果映射机制失败,我觉得jmp *%eax之后会失败。因为此时eax的值是0xf010002f,如果没有地址映射,那会指向这个物理高地址,而不是本应指向的0x100000附近的低地址,就会出错。1

2

3

4

5

6

7

8

9

10

11

12=> 0x100025: mov $0xf010002c,%eax

0x00100025 in ?? ()

(gdb)

=> 0x10002a: jmp *%eax

0x0010002a in ?? ()

(gdb)

=> 0xf010002c <relocated>: add %al,(%eax)

relocated () at kern/entry.S:74

74 movl $0x0,%ebp # nuke frame pointer

(gdb)

Remote connection closed

(gdb)

上面是注释掉movl %eax,%cr0之后的调试结果。果然,跳转之后的第一条指令就报错了。

在entry.S中说:1

The kernel (this code) is linked at address ~(KERNBASE + 1 Meg),

在程序编译后,被链接到高地址处。在kernel.ld链接脚本文件里指定了。1

2/* Link the kernel at this address: "." means the current address */

. = 0xF0100000;

但是bootloader 实际把kernel加载到了0x100000的位置

格式化输出到控制台

激动人心的时刻到了,我们终于到了能对设备进行操作的阶段了。能打印出信息,是实现交互的开始,也是我们之后调试的一个重要途径。

大多数人都把printf()这样的函数认为是理所当然的,有时甚至认为它们是C语言的“原语“。但在OS内核中,我们必须自己实现所有I/O.

阅读kern/printf.c,lib/printfmt.c,kern/console.c三个源代码,理清三者之间的关系。

printf.c基于printfmt()和 kernel console’s cputchar();

Exercise 8

我们省略了一小段代码 - 使用“%o”形式的模式打印八进制数所需的代码。 查找并填写此代码片段。1

2

3

4

5

6case 'o':

// Replace this with your code.

putch('0', putdat);

num = getuint(&ap, lflag);

base = 8;

goto number;

就是把%u的代码复制一遍,base 改为 8 就差不多了,并不复杂。

Explain the interface between printf.c and console.c. Specifically, what function does console.c export? How is this function used by printf.c?

printf.c中使用了console.c中的cputchar函数,并封装为putch函数。并以函数形参传递到printfmt.c中的vprintfmt函数,用于向屏幕上输出一个字符。

解释console.c中的一段代码。

2

3

4

5

6

7

8

9

10

11

12

if (crt_pos >= CRT_SIZE) {

// 显示字符数超过CRT一屏可显示的字符数

int i;

// 清除buf中"第一行"的字符

memmove(crt_buf, crt_buf + CRT_COLS, (CRT_SIZE - CRT_COLS) * sizeof(uint16_t));

// CRT显示器需要对其用空格擦写才能去掉本来以及显示了的字符。

for (i = CRT_SIZE - CRT_COLS; i < CRT_SIZE; i++)

crt_buf[i] = 0x0700 | ' ';

// 显示起点退回到最后一行起始

crt_pos -= CRT_COLS;

}

首先理解几个宏定义和函数

CRT_ROWS,CRT_COLS:CRT显示器行列最大值, 此处是25x80ctr_buf在初始化时指向了显示器I/O地址

memmove从ctr_buf+CTR_COLS复制到ctr_buf中,就是清除掉第一行的数据,把最后一行给空出来,2~n行的数据(CRT_SIZE - CRT_COLS)个,移动到1~n-1行的位置。

跟踪执行以下代码,在调用

cprintf()时,fmt,ap指向什么?

1 | int x = 1, y = 3, z = 4; |

在kern/init.c的i386_init()下加入代码,就可以直接测试;加Lab1_exercise8_3标号的目的是为了在kern/kernel.asm反汇编代码中容易找到添加的代码的位置。可以看到地址在0xf0100080处1

2

3

4

5

6

7

8

9

10

11// lab1 Exercise_8

{

cprintf("Lab1_Exercise_8:\n");

int x = 1, y = 3, z = 4;

//

Lab1_exercise8_3:

cprintf("x %d, y %x, z %d\n", x, y, z);

unsigned int i = 0x00646c72;

cprintf("H%x Wo%s", 57616, &i);

}

调试过程fmt=0xf010478d , ap=0xf0118fc4; fmt指向字符串,ap指向栈顶1

cprintf (fmt=0xf010478d "x %d, y %x, z %d\n") at kern/printf.c:27

可以看到以上地址处就存了字符串

1 | (gdb) x/s 0xf010478d |

引用一段Github上大神做的labclpsz/mit-jos-2014的execise8中的一段话。

从这个练习可以看出来,正是因为C函数调用实参的入栈顺序是从右到左的,才使得调用参数个数可变的函数成为可能(且不用显式地指出参数的个数)。但是必须有一个方式来告诉实际调用时传入的参数到底是几个,这个是在格式化字符串中指出的。如果这个格式化字符串指出的参数个数和实际传入的个数不一致,比如说传入的参数比格式化字符串指出的要少,就可能会使用到栈上错误的内存作为传入的参数,编译器必须检查出这样的错误。

4.运行以下代码,输出结果是什么。

1 | unsigned int i = 0x00646c72; |

调试输出了He110 World。57616的十六进制形式为E110,因为是小端机,i的在内存中为0x72,0x6c,0x64,0x00,对应ASCII为rld\0。

初始化

打开文件kern/entry.S,按ctrl+f查找关键字,找找stack这个词出现在哪里,看看每次出现的含义。

77行处将一个宏变量bootstacktop的值赋值给了寄存器esp。而bootstacktop出现在bootstack下,bootstack出现在.data段下,这是数据段。可以肯定,这就是栈了。通过93行.space指令,在bootstack位置处初始化了KSTKSIZE这么多的空间。KSTKSIZE在inc/memlayout.h里面定义,是8*PGSIZE,而PGSIZE在inc/mmu.h中定义,值为4096。

栈在内核入口的汇编代码中初始化,是通过一个汇编指令.space,大小是8 * 4096。接下来看看栈的位置。

查看反汇编代码obj/kern/kernel.asm,bootstacktop的值为0xf010f000。这就是栈的位置,准确来说,是栈顶,栈将向地址值更小的方向生长。

栈的行为

在正式运行一段代码之前,esp寄存器需要先初始化,正如前文所说。这个初始化可以是手动完成的,如kern/entry.S,也可以是自动完成的,如call指令。程序运行时,esp保存的地址以下的内存,都是栈可以生长,但尚未生长到的。esp表示的是“栈顶地址”stack top。

x86栈指针esp寄存器纸箱栈的最低地址。这个地址之下的都是空闲的。将一个值压入栈需要减小栈指针,同时把值写到栈指针之前指向的地方。在32位机器上,栈只能存储32位的值,esp只能被4整除。

程序“压栈”,就是减小esp,并在刚刚esp指向的位置上写入数据。

还有一个寄存器ebp,意思是base pointer,记录的是当前函数栈的开头。没有指令会自动更新ebp的值,但是任何C编译器都要遵守这个规定,写汇编的程序员也是,调用函数时必须写指令更新ebp寄存器。

调用函数

在执行新的函数callee代码之前,先保存旧函数caller的栈的位置。这样一来,callee才可以返回到正确的指令上。通过ebp寄存器的值,Debugger可以迅速找到调用这个函数的函数,一路找到最开始执行这个函数的函数,这种操作称为backtrace。

看到反汇编代码obj/kern/kernel.asm中,所有C函数的第一个指令都是push %ebp,保存了旧的栈地址。第二个指令都是mov %esp, %ebp,将当前栈地址,也就是函数的栈的开头,保存到ebp。

函数返回

函数返回时,寄存器eip,也就是Instruction Pointer,跳转到调用本函数的call指令的下一个指令,且esp增加。栈是向下增长的,所以这其实是在“弹出”。调用函数时,函数接受的参数都被压栈,故返回时相应弹出。

Exercise 10

在obj/kern/kernel.asm找到test_backtrace函数,并设置断点。进行调试。1

2

3

4

5

6

7

8

9void test_backtrace(int x)

{

cprintf("entering test_backtrace %d\n", x);

if (x > 0)

test_backtrace(x-1);

else

mon_backtrace(0, 0, 0);

cprintf("leaving test_backtrace %d\n", x);

}

test_backtrace函数对应的汇编代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39f0100040: 55 push %ebp

f0100041: 89 e5 mov %esp,%ebp

f0100043: 56 push %esi

f0100044: 53 push %ebx

f0100045: e8 5b 01 00 00 call f01001a5 <\_\_x86.get_pc_thunk.bx>

f010004a: 81 c3 be 12 01 00 add $0x112be,%ebx

f0100050: 8b 75 08 mov 0x8(%ebp),%esi

f0100053: 83 ec 08 sub $0x8,%esp

f0100056: 56 push %esi

f0100057: 8d 83 18 07 ff ff lea -0xf8e8(%ebx),%eax

f010005d: 50 push %eax

f010005e: e8 cf 09 00 00 call f0100a32 <cprintf>

f0100063: 83 c4 10 add $0x10,%esp

f0100066: 85 f6 test %esi,%esi

f0100068: 7f 2b jg f0100095 <test\_backtrace+0x55>

f010006a: 83 ec 04 sub $0x4,%esp

f010006d: 6a 00 push $0x0

f010006f: 6a 00 push $0x0

f0100071: 6a 00 push $0x0

f0100073: e8 f4 07 00 00 call f010086c <mon\_backtrace>

f0100078: 83 c4 10 add $0x10,%esp

f010007b: 83 ec 08 sub $0x8,%esp

f010007e: 56 push %esi

f010007f: 8d 83 34 07 ff ff lea -0xf8cc(%ebx),%eax

f0100085: 50 push %eax

f0100086: e8 a7 09 00 00 call f0100a32 <cprintf>

}

f010008b: 83 c4 10 add $0x10,%esp

f010008e: 8d 65 f8 lea -0x8(%ebp),%esp

f0100091: 5b pop %ebx

f0100092: 5e pop %esi

f0100093: 5d pop %ebp

f0100094: c3 ret

f0100095: 83 ec 0c sub $0xc,%esp

f0100098: 8d 46 ff lea -0x1(%esi),%eax

f010009b: 50 push %eax

f010009c: e8 9f ff ff ff call f0100040 <test\_backtrace>

f01000a1: 83 c4 10 add $0x10,%esp

f01000a4: eb d5 jmp f010007b <test\_backtrace+0x3b>

观察test_backtrace函数调用栈

下面开始观察test_backtrace函数的调用栈。%esp存储栈顶的位置,%ebp存储调用者栈顶的位置,%eax存储x的值,这几个寄存器需要重点关注,因此我使用gdb的display命令设置每次运行完成后自动打印它们的值,此外我也设置了自动打印栈内被用到的那段内存的数据,以便清楚观察栈的变化情况。Let’s go.

进入test_backtrace(5)1

2

3f01000d1: c7 04 24 05 00 00 00 movl $0x5,(%esp)

f01000d8: e8 63 ff ff ff call f0100040 <test\_backtrace>

f01000dd: 83 c4 10 add $0x10,%esp

test_backtrace函数的调用发生在i386_init函数中,传入的参数x=5.我们将从这里开始跟踪栈内数据的变化情况。各寄存器及栈内的数据如下所示。可见,共有两个4字节的整数被压入栈:

输入参数的值(也就是5)。

call指令的下一条指令的地址(也就是f01000dd)。1

2

3

4

5%esp = 0xf010ffdc

%ebp = 0xf010fff8

// stack info

0xf010ffe0: 0x00000005 // 第1次调用时的输入参数:5

0xf010ffdc: 0xf01000dd // 第1次调用时的返回地址

进入test_backtrace函数后,涉及栈内数据修改的指令可以分为三部分:

- 函数开头,将部分寄存器的值压栈,以便函数结束前可以恢复。

- 调用cprintf前,将输入参数压入栈。

- 在第2次调用test_backtrace前,将输入参数压入栈。

1 | // function start |

进入test_backtrace(4)

在即将进入test_backtrace(4)前,栈内数据如下所示。1

2

3

4

5

6

7

8

9

10

11

12%esp = 0xf010ffc0

%ebp = 0xf010ffd8

// stack info

0xf010ffe0: 0x00000005 // 第1次调用时的输入参数:5

0xf010ffdc: 0xf01000dd // 第1次调用时的返回地址

0xf010ffd8: 0xf010fff8 // 第1次调用时寄存器%ebp的值

0xf010ffd4: 0x10094 // 第1次调用时寄存器%esi的值

0xf010ffd0: 0xf0111308 // 第1次调用时寄存器%ebx的值

0xf010ffcc: 0xf010004a // 残留数据,不需关注

0xf010ffc8: 0x00000000 // 残留数据,不需关注

0xf010ffc4: 0x00000005 // 残留数据,不需关注

0xf010ffc0: 0x00000004 // 第2次调用时的输入参数

进入mon_backtrace(0, 0, 0)

在即将进入mon_backtrace(0, 0, 0)前,栈内数据如下所示。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52%esp = 0xf010ff20

%ebp = 0xf010ff38

// stack info

0xf010ffe0: 0x00000005 // 第1次调用时的输入参数:5

0xf010ffdc: 0xf01000dd // 第1次调用时的返回地址

0xf010ffd8: 0xf010fff8 // 第1次调用开始时寄存器%ebp的值

0xf010ffd4: 0x10094 // 第1次调用开始时寄存器%esi的值

0xf010ffd0: 0xf0111308 // 第1次调用开始时寄存器%ebx的值

0xf010ffcc: 0xf010004a // 预留空间,不需关注

0xf010ffc8: 0x00000000 // 预留空间,不需关注

0xf010ffc4: 0x00000005 // 预留空间,不需关注

0xf010ffc0: 0x00000004 // 第2次调用时的输入参数:4

0xf010ffbc: 0xf01000a1 // 第2次调用时的返回地址

0xf010ffb8: 0xf010ffd8 // 第2次调用开始时寄存器%ebp的值

0xf010ffb4: 0x00000005 // 第2次调用开始时寄存器%esi的值

0xf010ffb0: 0xf0111308 // 第2次调用开始时寄存器%ebx的值

0xf010ffac: 0xf010004a // 预留空间,不需关注

0xf010ffa8: 0x00000000 // 预留空间,不需关注

0xf010ffa4: 0x00000004 // 预留空间,不需关注

0xf010ffa0: 0x00000003 // 第3次调用时的输入参数:3

0xf010ff9c: 0xf01000a1 // 第3次调用时的返回地址

0xf010ff98: 0xf010ffb8 // 第3次调用开始时寄存器%ebp的值

0xf010ff94: 0x00000004 // 第3次调用开始时寄存器%esi的值

0xf010ff90: 0xf0111308 // 第3次调用开始时寄存器%ebx的值

0xf010ff8c: 0xf010004a // 预留空间,不需关注

0xf010ff88: 0xf010ffb8 // 预留空间,不需关注

0xf010ff84: 0x00000003 // 预留空间,不需关注

0xf010ff80: 0x00000002 // 第4次调用时的输入参数:2

0xf010ff7c: 0xf01000a1 // 第4次调用时的返回地址

0xf010ff78: 0xf010ff98 // 第4次调用开始时寄存器%ebp的值

0xf010ff74: 0x00000003 // 第4次调用开始时寄存器%esi的值

0xf010ff70: 0xf0111308 // 第4次调用开始时寄存器%ebx的值

0xf010ff6c: 0xf010004a // 预留空间,不需关注

0xf010ff68: 0xf010ff98 // 预留空间,不需关注

0xf010ff64: 0x00000002 // 预留空间,不需关注

0xf010ff60: 0x00000001 // 第5次调用时的输入参数:1

0xf010ff5c: 0xf01000a1 // 第5次调用时的返回地址

0xf010ff58: 0xf010ff78 // 第5次调用开始时寄存器%ebp的值

0xf010ff54: 0x00000002 // 第5次调用开始时寄存器%esi的值

0xf010ff50: 0xf0111308 // 第5次调用开始时寄存器%ebx的值

0xf010ff4c: 0xf010004a // 预留空间,不需关注

0xf010ff48: 0xf010ff78 // 预留空间,不需关注

0xf010ff44: 0x00000001 // 预留空间,不需关注

0xf010ff40: 0x00000000 // 第6次调用时的输入参数:0

0xf010ff3c: 0xf01000a1 // 第6次调用时的返回地址

0xf010ff38: 0xf010ff58 // 第6次调用开始时寄存器%ebp的值

0xf010ff34: 0x00000001 // 第6次调用开始时寄存器%esi的值

0xf010ff30: 0xf0111308 // 第6次调用开始时寄存器%ebx的值

0xf010ff2c: 0xf010004a // 预留空间,不需关注

0xf010ff28: 0x00000000 // 第7次调用时的第1个输入参数:0

0xf010ff24: 0x00000000 // 第7次调用时的第2个输入参数:0

0xf010ff20: 0x00000000 // 第7次调用时的第3个输入参数:0

mon_backtrace函数目前内部为空,不需关注。

退出mon_backtrace(0, 0, 0):通过add $0x10, %esp语句,将输入参数及预留的4字节从栈中清除。此时%esp = 0xf010ff30,%ebp = 0xf010ff38.

退出test_backtrace(0):连续3个pop语句将ebx, esi和ebp寄存器依次出栈,然后通过ret语句返回。其他1~5的退出过程类似,不再赘述。

实现backtrace

Lab中的练习要求我们实现一个backtrace函数,能够打印函数调用的地址和传给函数的参数值。其实CLion的Debugger就有这个功能:

我们要实现的函数,就是可以获得函数此时的ebp寄存器的值、返回的地址、和获得参数的值。

查找mon_backtrace,来到已经准备好的一个函数。函数中写了Your code here注释,让我们在这里实现backtrace功能。我的实现如下:1

2

3

4

5

6

7

8

9

10

11uint32_t ebp = read_ebp(); // 拿到ebp的值,类型和函数read_ebp的返回类型一致

int *ebp_base_ptr = (int *)ebp; // 转化为指针

uint32_t eip = ebp_base_ptr[1]; // 拿到返回地址

cprintf("ebp %x, eip %x, args ", ebp, eip);

int *args = ebp_base_ptr + 2; // 拿到进入函数之前的栈地址

for (int i = 0; i < 5; ++i) { // 输出参数

cprintf("%x ", *(args+i));

}

cprintf("\n");

我们把读取到的ebp的值转化为了int*类型,这样转化使得对指针的加减法步长和栈中元素长度一致。在x86机器中,地址和int类型同质,长度都是4字节。这样转换之后,无论是加法,还是中括号[]索引,改变的地址都是4字节,而不是1字节,可以恰好改变一个元素的长度。

来看打印得到结果:1

ebp f010ef58, eip f01000a1, args 0 0 0 f010004a f0110308

给函数传的3个参数的值均为0,和打印结果一致!

eip的值正是调用完函数mon_backtrace后一个指令的地址,可以查看反汇编代码obj/kern/kernel.asm,调用函数指令如下:1

2

3

4

5

6

7

8 mon_backtrace(0, 0, 0);

f0100093: 83 ec 04 sub $0x4,%esp

f0100096: 6a 00 push $0x0

f0100098: 6a 00 push $0x0

f010009a: 6a 00 push $0x0

f010009c: e8 e1 07 00 00 call f0100882 <mon_backtrace>

f01000a1: 83 c4 10 add $0x10,%esp

f01000a4: eb d3 jmp f0100079 <test_backtrace+0x39>

倒数第二行指令地址正是0xf01000a1!

读取Symbol Table

这个练习要求我们研究函数debuginfo_eip的实现,弄清楚命名为__STAB_*的几个宏的来历和作用,以及将backtrace功能作为命令加入console功能中。

命名为__STAB_*的宏最早在文件kern/kernel.ld中26行出现,__STABSTR_*则在下面一点的34行出现。这个连接器的配置文件,要求连接器生成elf文件时,分配两个segment给到.stab和.stabstr,正如连接器也分配了.data等segment一样。

运行objdump -h obj/kern/kernel查看分配的segment的信息,有关部分如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26obj/kern/kernel: file format elf32-i386

Sections:

Idx Name Size VMA LMA File off Algn

0 .text 00001bad f0100000 00100000 00001000 2**4

CONTENTS, ALLOC, LOAD, READONLY, CODE

1 .rodata 000006f4 f0101bc0 00101bc0 00002bc0 2**5

CONTENTS, ALLOC, LOAD, READONLY, DATA

2 .stab 000043b1 f01022b4 001022b4 000032b4 2**2

CONTENTS, ALLOC, LOAD, READONLY, DATA

3 .stabstr 00001987 f0106665 00106665 00007665 2**0

CONTENTS, ALLOC, LOAD, READONLY, DATA

4 .data 00009300 f0108000 00108000 00009000 2**12

CONTENTS, ALLOC, LOAD, DATA

5 .got 00000008 f0111300 00111300 00012300 2**2

CONTENTS, ALLOC, LOAD, DATA

6 .got.plt 0000000c f0111308 00111308 00012308 2**2

CONTENTS, ALLOC, LOAD, DATA

7 .data.rel.local 00001000 f0112000 00112000 00013000 2**12

CONTENTS, ALLOC, LOAD, DATA

8 .data.rel.ro.local 00000044 f0113000 00113000 00014000 2**2

CONTENTS, ALLOC, LOAD, DATA

9 .bss 00000648 f0113060 00113060 00014060 2**5

CONTENTS, ALLOC, LOAD, DATA

10 .comment 0000002a 00000000 00000000 000146a8 2**0

CONTENTS, READONLY

运行objdump -G obj/kern/kernel,查看符号列表Symbol Table,得到有关函数和文件的信息,以下粘贴了部分kern/monitor.c文件有关的信息。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15obj/kern/kernel: file format elf32-i386

Contents of .stab section:

Symnum n_type n_othr n_desc n_value n_strx String

...

375 FUN 0 0 f0100882 1790 mon_backtrace:F(0,1)

376 PSYM 0 0 00000008 1603 argc:p(0,1)

377 PSYM 0 0 0000000c 1768 argv:p(0,2)

378 PSYM 0 0 00000010 1780 tf:p(0,5)

379 SLINE 0 59 00000000 0

380 SOL 0 0 f0100896 601 ./inc/x86.h

381 SLINE 0 214 00000014 0

382 SOL 0 0 f0100898 1541 kern/monitor.c

...

知道了__STAB_*的来历,看看它们的作用。文件kern/kdebug.c中函数debuginfo_eip142行调用了这几个宏,整个函数和同一个文件里面的另一个函数stab_binsearch的目的是从.stab和.stabstr两个segment中读取出想要的debug信息,装进一个Eipdebuginfo结构体中。

按照提示,我们首先可以调用read_ebp函数来获取当前ebp寄存器的值。ebp寄存器的值实际上是一个指针,指向当前函数的栈帧的底部(而esp寄存器指向当前函数的栈顶)。我们可以把整个调用栈看做一个数组,其中每个元素均为4字节的整数,并以ebp指针的值为数组起始地址,那么ebp[1]存储的就是函数返回地址,也就是题目中要求的eip的值,ebp[2]以后存储的是输入参数的值。由于题目要求打印5个输入参数,因此需要获取ebp[2]~ebp[6]的值。这样第一条栈信息便可打印出来。

那么怎么打印下一条栈信息呢?还得从ebp入手。当前ebp指针存储的恰好是调用者的ebp寄存器的值,因此当前ebp指针又可以看做是一个链表头,我们通过链表头就可以遍历整个链表。举个例子:假设有A、B、C三个函数,A调用B,B调用C,每个函数都对应有一个栈帧,栈帧的底部地址均存储在当时的ebp寄存器中,不妨记为a_ebp, b_ebp和c_ebp,那么将有c_ebp -> b_ebp -> a_ebp,用程序语言表示就是:a_ebp = (uint32_t *)*b_ebp和b_ebp = (uint32_t *)*c_ebp。

还有一个问题:怎么知道遍历何时结束呢?题目中提示可以参考kern/entry.S,于是我打开此文件,果然找打答案:内核初始化时会将ebp设置为0,因此当我们检查到ebp为0后就应该结束了。1

2

3

4# Clear the frame pointer register (EBP)

# so that once we get into debugging C code,

# stack backtraces will be terminated properly.

movl $0x0,%ebp # nuke frame pointer

1 | int mon_backtrace(int argc, char **argv, struct Trapframe *tf) |

输出结果1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

226828 decimal is 15254 octal!

entering test_backtrace 5

entering test_backtrace 4

entering test_backtrace 3

entering test_backtrace 2

entering test_backtrace 1

entering test_backtrace 0

Stack backtrace:

ebp f010ff18 eip f0100078 args 00000000 00000000 00000000 f010004a f0111308

ebp f010ff38 eip f01000a1 args 00000000 00000001 f010ff78 f010004a f0111308

ebp f010ff58 eip f01000a1 args 00000001 00000002 f010ff98 f010004a f0111308

ebp f010ff78 eip f01000a1 args 00000002 00000003 f010ffb8 f010004a f0111308

ebp f010ff98 eip f01000a1 args 00000003 00000004 00000000 f010004a f0111308

ebp f010ffb8 eip f01000a1 args 00000004 00000005 00000000 f010004a f0111308

ebp f010ffd8 eip f01000dd args 00000005 00001aac f010fff8 f01000bd 00000000

ebp f010fff8 eip f010003e args 00000003 00001003 00002003 00003003 00004003

leaving test_backtrace 0

leaving test_backtrace 1

leaving test_backtrace 2

leaving test_backtrace 3

leaving test_backtrace 4

leaving test_backtrace 5

debuginfo_eip函数实现根据地址寻找行号的功能

解决这个问题的关键是熟悉stabs每行记录的含义,我折腾了一两小时才搞清楚。首先,使用objdump -G obj/kern/kernel > output.md将内核的符号表信息输出到output.md文件,在output.md文件中可以看到以下片段:1

2

3

4

5

6

7Symnum n_type n_othr n_desc n_value n_strx String

118 FUN 0 0 f01000a6 2987 i386_init:F(0,25)

119 SLINE 0 24 00000000 0

120 SLINE 0 34 00000012 0

121 SLINE 0 36 00000017 0

122 SLINE 0 39 0000002b 0

123 SLINE 0 43 0000003a 0

这个片段是什么意思呢?首先要理解第一行给出的每列字段的含义:

Symnum是符号索引,换句话说,整个符号表看作一个数组,Symnum是当前符号在数组中的下标n_type是符号类型,FUN指函数名,SLINE指在text段中的行号n_othr目前没被使用,其值固定为0n_desc表示在文件中的行号n_value表示地址。特别要注意的是,这里只有FUN类型的符号的地址是绝对地址,SLINE符号的地址是偏移量,其实际地址为函数入口地址加上偏移量。比如第3行的含义是地址f01000b8(=0xf01000a6+0x00000012)对应文件第34行。

理解stabs每行记录的含义后,调用stab_binsearch便能找到某个地址对应的行号了。由于前面的代码已经找到地址在哪个函数里面以及函数入口地址,将原地址减去函数入口地址即可得到偏移量,再根据偏移量在符号表中的指定区间查找对应的记录即可。代码如下所示:1

2

3

4

5

6stab_binsearch(stabs, &lfun, &rfun, N_SLINE, addr - info->eip_fn_addr);

if (lfun <= rfun)

{

info->eip_line = stabs[lfun].n_desc;

}

给内核模拟器增加backtrace命令,并在mon_backtrace中增加打印文件名、函数名和行号

给内核模拟器增加backtrace命令。很简单,在kern/monitor.c文件中模仿已有命令添加即可。1

2

3

4

5static struct Command commands[] = {

{ "help", "Display this list of commands", mon_help },

{ "kerninfo", "Display information about the kernel", mon_kerninfo },

{ "backtrace", "Display a backtrace of the function stack", mon_backtrace },

};

在mon_backtrace中增加打印文件名、函数名和行号

经过上面的探索,这个问题就很容易解决了。在mon_backtrace中调用debuginfo_eip来获取文件名、函数名和行号即可。注意,返回的Eipdebuginfo结构体的eip_fn_name字段除了函数名外还有一段尾巴,比如test_backtrace:F(0,25),需要将”:F(0,25)”去掉,可以使用printf("%.*s", length, string)来实现。代码如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23int mon_backtrace(int argc, char **argv, struct Trapframe *tf)

{

uint32_t *ebp;

struct Eipdebuginfo info;

int result;

ebp = (uint32_t *)read_ebp();

cprintf("Stack backtrace:\r\n");

while (ebp)

{

cprintf(" ebp %08x eip %08x args %08x %08x %08x %08x %08x\r\n", ebp, ebp[1], ebp[2], ebp[3], ebp[4], ebp[5], ebp[6]);

memset(&info, 0, sizeof(struct Eipdebuginfo));

result = debuginfo_eip(ebp[1], &info);

if (0 != result)

cprintf("failed to get debuginfo for eip %x.\r\n", ebp[1]);

else

cprintf("\t%s:%d: %.*s+%u\r\n", info.eip_file, info.eip_line, info.eip_fn_namelen, info.eip_fn_name, ebp[1] - info.eip_fn_addr);

ebp = (uint32_t *)*ebp;

}

return 0;

}

输出结果如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19Stack backtrace:

ebp f010ff18 eip f0100078 args 00000000 00000000 00000000 f010004a f0111308

kern/init.c:16: test_backtrace+56

ebp f010ff38 eip f01000a1 args 00000000 00000001 f010ff78 f010004a f0111308

kern/init.c:16: test_backtrace+97

ebp f010ff58 eip f01000a1 args 00000001 00000002 f010ff98 f010004a f0111308

kern/init.c:16: test_backtrace+97

ebp f010ff78 eip f01000a1 args 00000002 00000003 f010ffb8 f010004a f0111308

kern/init.c:16: test_backtrace+97

ebp f010ff98 eip f01000a1 args 00000003 00000004 00000000 f010004a f0111308

kern/init.c:16: test_backtrace+97

ebp f010ffb8 eip f01000a1 args 00000004 00000005 00000000 f010004a f0111308

kern/init.c:16: test_backtrace+97

ebp f010ffd8 eip f01000dd args 00000005 00001aac f010fff8 f01000bd 00000000

kern/init.c:43: i386_init+55

ebp f010fff8 eip f010003e args 00000003 00001003 00002003 00003003 00004003

{standard input}:0: <unknown>+0

```:q

lab2

简介

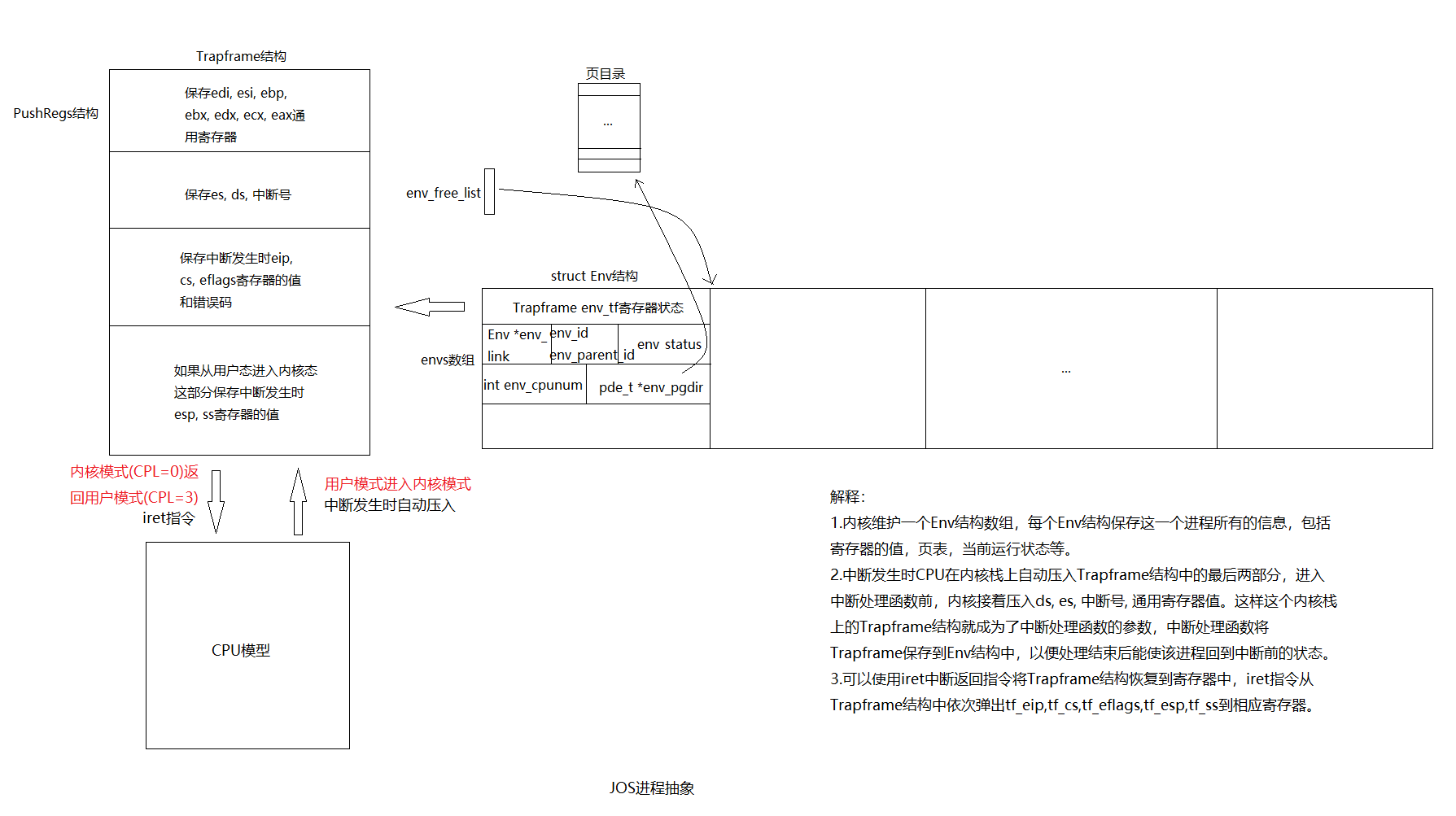

在本实验中,我们将编写操作系统的内存管理代码。 内存管理有两个组成部分。

第一个部分是内核的物理内存分配器,以致于内核可以分配和释放内存。 分配器将以4096字节为操作单位,称为一个页面。 我们的任务是维护一个数据结构,去记录哪些物理页面是空闲的,哪些是已分配的,以及共享每个已分配页面的进程数。 我们还要编写例程来分配和释放内存页面。

内存管理的第二个组件是虚拟内存,它将内核和用户软件使用的虚拟地址映射到物理内存中的地址。 当指令使用内存时,x86硬件的内存管理单元(MMU)执行映射,查询一组页表。 我们根据任务提供的规范修改JOS以设置MMU的页面表。

lab2包含的新源文件:

- inc/memlayout.h

- kern/pmap.c

- kern/pmap.h

- kern/kclock.h

- kern/kclock.c

memlayout.h描述了虚拟地址空间的布局,这是我们需要通过修改pmap.c实现的。memlayout.h和pmap.h定义了PageInfo结构,可以通过这个结构来跟踪那个物理地址是空闲的。kclock.c和kclock.h操作系统的时钟。

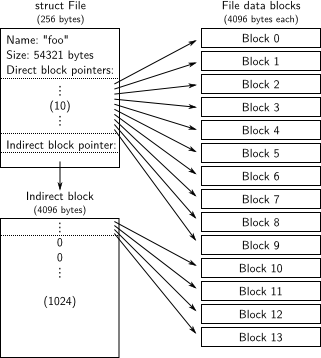

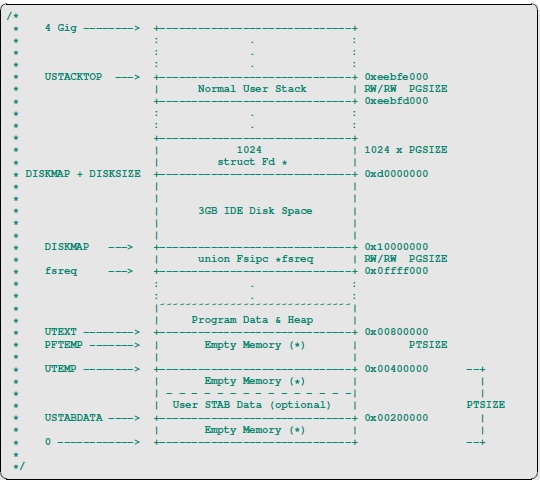

memlayout.h给贴心的画了个图,很形象的表述了虚拟地址的分布。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

Virtual memory map: Permissions

kernel/user

4 Gig --------> +------------------------------+

| | RW/--

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

: . :

: . :

: . :

|~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~| RW/--

| | RW/--

| Remapped Physical Memory | RW/--

| | RW/--

KERNBASE, ----> +------------------------------+ 0xf0000000 --+

KSTACKTOP | CPU0's Kernel Stack | RW/-- KSTKSIZE |

| - - - - - - - - - - - - - - -| |

| Invalid Memory (*) | --/-- KSTKGAP |

+------------------------------+ |

| CPU1's Kernel Stack | RW/-- KSTKSIZE |

| - - - - - - - - - - - - - - -| PTSIZE

| Invalid Memory (*) | --/-- KSTKGAP |

+------------------------------+ |

: . : |

: . : |

MMIOLIM ------> +------------------------------+ 0xefc00000 --+

| Memory-mapped I/O | RW/-- PTSIZE

ULIM, MMIOBASE --> +------------------------------+ 0xef800000

| Cur. Page Table (User R-) | R-/R- PTSIZE

UVPT ----> +------------------------------+ 0xef400000

| RO PAGES | R-/R- PTSIZE

UPAGES ----> +------------------------------+ 0xef000000

| RO ENVS | R-/R- PTSIZE

UTOP,UENVS ------> +------------------------------+ 0xeec00000

UXSTACKTOP -/ | User Exception Stack | RW/RW PGSIZE

+------------------------------+ 0xeebff000

| Empty Memory (*) | --/-- PGSIZE

USTACKTOP ---> +------------------------------+ 0xeebfe000

| Normal User Stack | RW/RW PGSIZE

+------------------------------+ 0xeebfd000

| |

| |

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

. .

. .

. .

|~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~|

| Program Data & Heap |

UTEXT --------> +------------------------------+ 0x00800000

PFTEMP -------> | Empty Memory (*) | PTSIZE

| |

UTEMP --------> +------------------------------+ 0x00400000 --+

| Empty Memory (*) | |

| - - - - - - - - - - - - - - -| |

| User STAB Data (optional) | PTSIZE

USTABDATA ----> +------------------------------+ 0x00200000 |

| Empty Memory (*) | |

0 ------------> +------------------------------+ --+

(*) Note: The kernel ensures that "Invalid Memory" is *never* mapped.

"Empty Memory" is normally unmapped, but user programs may map pages

there if desired. JOS user programs map pages temporarily at UTEMP.

回顾:未初始化完成的内存映射

在Lab 1中,我们做了一个虚拟内存映射,将0xf0000000-0xf0400000映射到物理地址0x00000000-00400000,总共大小为4MB。如果访问任何超出这个范围的虚拟地址,CPU都会出错。

在之后写代码时,代码中的地址都是虚拟地址,翻译成物理地址的过程是硬件实现的,我们不应该想着如何直接操作物理地址。但是,有时将地址转化物理地址可以方便一些操作,在文件inc/memlayout.h和kern/pmap.h中提供了一些宏和函数,方便我们做这样的地址换算。

首先提供了宏KERNBASE,注释说所有物理地址都被映射到这里,值为0xf0000000,正是我们映射的地址。所谓所有,就是已经映射过的地址,不包括还没映射的地址。1

2// All physical memory mapped at this address

宏函数KADDR调用了函数_kaddr,将物理地址转化成内核地址,或称虚拟地址,也就是在物理地址的数值上加上了KERNBAE。此时的“所有”物理地址,范围还很小,因为其它的内存映射还没有建立,故可以这样简单地操作。其它内存映射建立之后,物理地址转化为虚拟地址的过程将很复杂。1

2

3

4

5

6

7

8

9

10

11/* This macro takes a physical address and returns the corresponding kernel

* virtual address. It panics if you pass an invalid physical address. */

static inline void*

_kaddr(const char *file, int line, physaddr_t pa)

{

if (PGNUM(pa) >= npages)

_panic(file, line, "KADDR called with invalid pa %08lx", pa);

return (void *)(pa + KERNBASE);

}

相应的反向过程将虚拟地址转化为物理地址,宏函数PADDR做了这样的事情。也就是在输入的虚拟地址上减去KERNBASE,非常简单。1

2

3

4

5

6

7

8

9

10

11

12

13

14/* This macro takes a kernel virtual address -- an address that points above

* KERNBASE, where the machine's maximum 256MB of physical memory is mapped --

* and returns the corresponding physical address. It panics if you pass it a

* non-kernel virtual address.

*/

static inline physaddr_t

_paddr(const char *file, int line, void *kva)

{

if ((uint32_t)kva < KERNBASE)

_panic(file, line, "PADDR called with invalid kva %08lx", kva);

return (physaddr_t)kva - KERNBASE;

}

以下为把页转换为物理地址和把物理地址转成页,或者把页转成虚拟地址。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19static inline physaddr_t

page2pa(struct PageInfo *pp)

{

return (pp - pages) << PGSHIFT;

}

static inline struct PageInfo*

pa2page(physaddr_t pa)

{

if (PGNUM(pa) >= npages)

panic("pa2page called with invalid pa");

return &pages[PGNUM(pa)];

}

static inline void*

page2kva(struct PageInfo *pp)

{

return KADDR(page2pa(pp));

}

Part 1任务总览

Lab 2 Part 1让我们完成内核内存初始化,而用户区User Level内存初始化在后面的part中完成。

初始化操作集中在文件kern/pmap.c的函数mem_init中,在内核初始化函数i386_init中调用。在这个part中,我们开始写这个函数以及它将调用的函数,只需要写到check_page_alloc函数的调用之前即可。check_page_alloc这一行之上进行的操作汇总如下。

- 直接调用硬件查看可以使用的内存大小,也就是函数i386_detect_memory。

- 创建一个内核初始化时的page目录,并设置权限。

- 创建用于管理page的数组,初始化page分配器组件。

- 测试page分配器组件。

需要我们写的函数有:

- boot_alloc,page未初始化时的分配器。

- page_init, page_alloc, page_free,page分配器组件。

- mem_init,总的内存初始化函数。

完成分配器之后,我们的目标是让虚拟地址有基础。进程需要更多内存,向内核发出请求,内核利用分配器,将一个由分配器决定的物理地址和由进程决定的虚拟地址关联到一起,称为映射。这是后面的Lab的内容,本文只关心分配,不关心任何形式的映射。

va_list va_start等等

VA函数(variable argument function),参数可变函数。理解这个操作,头脑中需要有栈的概念,参数按序(从右到左)压栈,第一个参数在低地址位置。函数原型为1

2

3

4

5

6

7

8

9

10

11typedef char* va_list;

// 以4字节为单位对齐

// 求得参数栈的第一个参数地址

// 这里很巧妙,ap+SIZE指向下一个参数地址,再返回总体减去size(即又指回了当前变量)

va_list ap定义一个变差变量apva_start(ap, last)初始化ap,得到可变参数列表的第一个参数的确切地址。实际就是指向参数堆栈的栈顶va_arg(ap, type)已知变量类型为type的情况下,获得下一个变参变量va_end(ap)结束操作

entry_pgdir的写法也是内存映射的一个重要部分。1

2

3

4

5

6

7

8

9

10__attribute__((__aligned__(PGSIZE)))

pde_t entry_pgdir[NPDENTRIES] = {

// Map VA's [0, 4MB) to PA's [0, 4MB)

// 在数组定义中,这是什么写法?

[0]

= ((uintptr_t)entry_pgtable - KERNBASE) + PTE_P,

// Map VA's [KERNBASE, KERNBASE+4MB) to PA's [0, 4MB)

[KERNBASE>>PDXSHIFT]

= ((uintptr_t)entry_pgtable - KERNBASE) + PTE_P + PTE_W

};

两个内存分配器

有两个分配器,一个是正式的Page分配器,在之后的所有情况下我们都使用这个。另一个是在Page分配器初始化完成之前使用的,更加原始、简单。

在page分配器初始化完成之前,内核在初始化的过程中使用boot_alloc函数分配内存,也可称为boot分配器。这个分配器非常原始,在page分配器初始化完成后,务必不可调用boot_alloc分配内存,以免出现莫名其妙的错误。

page分配器

Page分配器操作内存是以page为单位的,之后几乎所有管理内存的机制都是以page为单位。page就是将所有的内存地址分成长度相同的一个个区块,每个的长度都是4096Bytes。所有可以分配的内存都注册到一个链表中,通过分配器,可以方便地拿到一个未分配的page。

内存管理组件维护一个链表,称为free list,这个链表将所有未分配的page连起来。需要分配内存时,将链表头部对应的page返回,并将链表头部更新为链表中的下一个元素。

在inc/memlayout.h中定义了这样的结构体,pp_ref是指向这个页面的指针数量,指针pp_link就是链表中常用的next指针。1

2

3

4

5

6

7

8

9

10

11struct PageInfo {

// Next page on the free list.

struct PageInfo *pp_link;

// pp_ref is the count of pointers (usually in page table entries)

// to this page, for pages allocated using page_alloc.

// Pages allocated at boot time using pmap.c's

// boot_alloc do not have valid reference count fields.

uint16_t pp_ref;

};

创建了一个struct PageInfo的数组,数组中第i个成员代表内存中第i个page。故物理地址和数组索引很方便相换算。初始化时,形成一个链表,所有可分配的page都以struct PageInfo的形式存在于链表上。要通过分配器拿到一个page,也就是读取链表开头的节点,这个节点就对应一个page。1

2extern struct PageInfo *pages;

extern size_t npages;

初始化函数page_init将所有的pp_link初始化指向与自己相邻的PageInfo,如下,这是初步实现,后续还有更新:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33//

// Initialize page structure and memory free list.

// After this is done, NEVER use boot_alloc again. ONLY use the page

// allocator functions below to allocate and deallocate physical

// memory via the page_free_list.

//

void

page_init(void)

{

// The example code here marks all physical pages as free.

// However this is not truly the case. What memory is free?

// 1) Mark physical page 0 as in use.

// This way we preserve the real-mode IDT and BIOS structures

// in case we ever need them. (Currently we don't, but...)

// 2) The rest of base memory, [PGSIZE, npages_basemem * PGSIZE)

// is free.

// 3) Then comes the IO hole [IOPHYSMEM, EXTPHYSMEM), which must

// never be allocated.

// 4) Then extended memory [EXTPHYSMEM, ...).

// Some of it is in use, some is free. Where is the kernel

// in physical memory? Which pages are already in use for

// page tables and other data structures?

//

// Change the code to reflect this.

// NB: DO NOT actually touch the physical memory corresponding to

// free pages!

size_t i;

for (i = 0; i < npages; i++) {

pages[i].pp_ref = 0;

pages[i].pp_link = page_free_list;

page_free_list = &pages[i];

}

}

这样初始化的操作是在kern/pmap.c中完成的。大概来说,初始化就是拉了这样一个链表,并且将指针page_free_list指向链表的开头。分配内存时,若读取page_free_list指针得到NULL,则说明分配器已经给完了它能够管理的内存,再也给不出来了。

分配器组件的函数都是在操作PageInfo指针,也就是pages数组中的元素,而不是直接操作每个page的地址。如分配函数page_alloc返回的是一个PageInfo,释放page的函数page_free接受的也是一个PageInfo指针。将这个指针和pages数组开头地址做差,可以得到这个PageInfo在数组中的索引,也就可以换算出相应物理地址。

在文件kern/pmap.h中,已经写好了一个函数page2kva,接受一个PageInfo指针,返回得到相应page的虚拟地址。我们可以直接使用这个函数进行换算,这样得到的是虚拟地址,要得到物理地址,还需要在此基础上将地址的数值减去0xf0000000,宏PADDR做了这件事情。

内核的其他代码通过函数page_alloc从free list取出一个page,返回当前page_free_list指针,并令page_free_list指针指向原链表中的下一个元素。

讲义中要求我们实现文件kern/pmap.c中的函数page_alloc,注释中写的比较清楚,分配一个物理页首先需要判断是否还有free的page,如果没有的话就返回NULL。之后从page_free_list中拿出一个page,因为page的指针还指向下一个free_page,所以free_page_list需要指向target->pp_link,同时target->pp_link置空。如果需要把页置为0的话,需要转成物理地址然后调用memset。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31// Allocates a physical page. If (alloc_flags & ALLOC_ZERO), fills the entire

// returned physical page with '\0' bytes. Does NOT increment the reference

// count of the page - the caller must do these if necessary (either explicitly

// or via page_insert).

//

// Be sure to set the pp_link field of the allocated page to NULL so

// page_free can check for double-free bugs.

//

// Returns NULL if out of free memory.

//

// Hint: use page2kva and memset

struct PageInfo *

page_alloc(int alloc_flags)

{

// out of memory

if (page_free_list == NULL) {

// no changes made so far of course

return NULL;

}

struct PageInfo *target = page_free_list;

page_free_list = page_free_list->pp_link; // update free list pointer

target->pp_link = NULL; // set to NULL according to notes

char *space_head = page2kva(target); // extract kernel virtual memory

if (alloc_flags & ALLOC_ZERO) {

// zero the page according to flags

memset(space_head, 0, PGSIZE);

}

return target;

}

要释放一个page,也就是将这个page放回链表。将page_free_list指针指向这个PageInfo结构体,并设置这个结构体的pp_link为之前的page_free_list指针。放回链表的这个page也就变成了free list的开头。

讲义中要求我们实现文件kern/pmap.c中的函数page_free,给的提示足够多了:1

2

3

4

5

6

7

8

9

10

11

12

13

14// Return a page to the free list.

// (This function should only be called when pp->pp_ref reaches 0.)

void

page_free(struct PageInfo *pp)

{

// Fill this function in

// Hint: You may want to panic if pp->pp_ref is nonzero or

// pp->pp_link is not NULL.

if (pp->pp_ref != 0 || pp->pp_link != NULL)

panic("Page double free or freeing a referenced page...\n");

pp->pp_link = page_free_list;

page_free_list = pp;

}

page分配器boot_alloc

page分配组件完成初始化之前,使用boot_alloc函数分配内存,pages数组就是这个函数分配的。

函数接受一个参数,代表要多少字节内存。函数将这个字节数上调到page大小的边界,也就是调整为离这个字节数最近的4096的整数倍,以求每次分配都是以page为单位的。这个分配器只能在page分配器初始化完成之前使用,之后一律使用page分配器。

实现非常简单,如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29static void *

boot_alloc(uint32_t n)

{

static char *nextfree; // virtual address of next byte of free memory

char *result;

if (!nextfree) {

extern char end[];

nextfree = ROUNDUP((char *) end, PGSIZE);

}

// special case according to notes

if (n == 0) {

return nextfree;

}

// note before update

result = nextfree;

nextfree = ROUNDUP(n, PGSIZE) + nextfree;

// out of memory panic

if (nextfree > (char *)0xf0400000) {

panic("boot_alloc: out of memory, nothing changed, returning NULL...\n");

nextfree = result; // reset static data

return NULL;

}

return result;

}

第一次调用这个函数时,必须初始化nextfree指针。这个初始化也很简单,确定了内核本身在内存中的位置后,让boot_alloc函数在内核所占空间的内存之后的第一个page开始分配。表现为代码,就是从连接器中拿到内核的最后一个字节的地址end,将这个指针的数值上调到4096的整数倍。

其中,需要注意的一个是end到底是什么,另一个是ROUNDUP这个宏。其中,end指向内核的bss段的末尾。利用objdump -h kernel可以看出,bss段已经是内核的最后一段。因此,end 指向的是第一个未使用的虚拟内存地址。而ROUNDUP定义在inc/types.h中。

这个end指针是连接器产生的,可以看连接配置文件kern/kernel.ld的53行左右,end指向内核的最后一个字节的下一个字节。

内核内存布局和分配器初始化

这里正式讲解page分配器的初始化,也就是page_init函数的实现,正确初始化之后的分配器才可以正确使用page_alloc, page_free等函数。要知道分配器如何初始化,就要理解内核内存的布局Layout。

获得物理内存信息

在初始化内存组件的函数mem_init中,首先调用了函数i386_detect_memory获得了内存硬件信息。追踪一下这个函数的调用,底层实现在kern/kclock.c中,通过一系列汇编指令向硬件要信息。汇编指令如何执行的,我们暂且不关心。

最终得到的内存信息是两个整数npages, npages_basemem,分别代表现有内存的page个数,以及在拓展内存之前的page个数。这些属于原始硬件信息,获得这个信息是为了确定一段IO映射区的位置。

接着研究现有内存布局。

内存布局

在文件kern/memlayout.h中,有一个虚拟内存的布局示意图,这个示意图主要描绘用户区内存分配,而不是指出物理内存分布,故我们暂时不细看它。地址0xf0000000以上的区域,也就是我们现在已经映射的区域,是我们关心的区域。宏KERNBASE就是0xf0000000,同时这个地址也是内核栈的开端。以下为了讲述方便,所有地址都是物理内存。

初始化的重要一步是弄清楚哪些物理地址可以分配,哪些不可以。这也就是弄清楚内存布局的意义所在。

我们从KERNBASE开始想起。回顾Lab 1我们知道,内存0xf0000-0x100000是BIOS映射区,在这之前又是ROM映射区,这段空间不能使用,不能被分配器分配出去。查看讲义,我们知道,地址0xa0000-0x100000是ROM, BIOS等IO使用的内存,不可以被分配,初始化时应排除这部分空间。在文件inc/memlayout.h中,宏IOPHYSMEM定义了这段IO段内存的开头。

在IOPHYSMEM之前还有一些内存没有分配,这部分内存是可以使用的。函数i386_detect_memory得到的npages_basemem就是这一段的长度,初始化page分配器时应该包含这一段。可以验证一下,npages_basemem的值为160,这么多个page总的大小为160 * 4096 = 655360 = 0xa0000,确实是IOPHYSMEM

从0x100000开始以上的内存就是内核,可以回顾Lab 1中探索内核结构的结果,内核的.text区的虚拟地址为0xf0100000,物理地址正是0x100000。文件inc/memlayout.h中定义的宏EXTPHYSMEM就是0x100000,意思是BIOS以上的内存,称为拓展区,其上限由RAM硬件大小决定。

如果你不记得内核的装载方式,可以使用指令objdump -h obj/kern/kernel查看。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26% obj/kern/kernel: file format elf32-i386

Sections:

Idx Name Size VMA LMA File off Algn

0 .text 00002a4d f0100000 00100000 00001000 2**4

CONTENTS, ALLOC, LOAD, READONLY, CODE

1 .rodata 00000bd0 f0102a60 00102a60 00003a60 2**5

CONTENTS, ALLOC, LOAD, READONLY, DATA

2 .stab 000050d1 f0103630 00103630 00004630 2**2

CONTENTS, ALLOC, LOAD, READONLY, DATA

3 .stabstr 00001bc3 f0108701 00108701 00009701 2**0

CONTENTS, ALLOC, LOAD, READONLY, DATA

4 .data 00009300 f010b000 0010b000 0000c000 2**12

CONTENTS, ALLOC, LOAD, DATA

5 .got 00000008 f0114300 00114300 00015300 2**2

CONTENTS, ALLOC, LOAD, DATA

6 .got.plt 0000000c f0114308 00114308 00015308 2**2

CONTENTS, ALLOC, LOAD, DATA

7 .data.rel.local 00001000 f0115000 00115000 00016000 2**12

CONTENTS, ALLOC, LOAD, DATA

8 .data.rel.ro.local 00000060 f0116000 00116000 00017000 2**5

CONTENTS, ALLOC, LOAD, DATA

9 .bss 00000681 f0116060 00116060 00017060 2**5

CONTENTS, ALLOC, LOAD, DATA

10 .comment 00000012 00000000 00000000 000176e1 2**0

CONTENTS, READONLY

内核占用了拓展区的开头,这些空间不应该被分配器管辖,不应该初始化到链表上。在初始化page分配器之前,调用了几次boot_alloc,这是内核运行时重要数据,他们占用的空间也不应该被分配器管辖。

分配器应该管辖最后一次调用boot_alloc分配的空间之后的空间,这个空间开头的地址可以直接通过boot_alloc(0)得到。

剩余的内存可以自由使用,分配器初始化是应该把链表拉到剩余的空间去。

分配器初始化

mem_init函数中需要添加以下两行,为所有页分配空间:

1 | ////////////////////////////////////////////////////////////////////// |

初始化就是拉链表,并注意排除不应该纳入分配器管辖的空间。总结上面对内存布局的研究,纳入分配器管辖的总共有两部分,分别是basemem部分,也就是0x0-0xa0000,和boot_alloc最后分配的空间的后面的部分,排除了内核,和一些boot_alloc取得的空间。

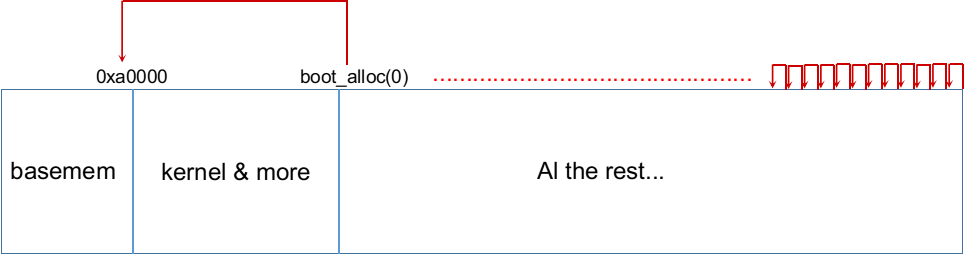

boot_alloc即将分配的空间可以给函数传0直接得到,这是函数的特殊处理。由于boot_alloc以page为单位分配,这样得到的地址是一个page的首地址,这个page的索引可以轻易获得:1

i = PADDR(boot_alloc(0)) / PGSIZE;

最后分配得到的应该如下图所示,其中basemem部分省略了指针指向。

完整实现如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37// 1.mark page 0 as in use

// 这样我们就可以保留实模式IDT和BIOS结构,以备不时之需。

pages[0].pp_ref = 1;

// pages[0].pp_link = NULL;

// page_free_lis = &pages[0];

// 被注释掉的这两句不对,因为这个开头的页不能放到free_list中被分配。

// 2. The rest of base memory, [PGSIZE, npages_basemem * PGSIZE)is free.

size_t i;

for (i = 1; i < npages_basemem; i++) {

pages[i].pp_ref = 0;

pages[i].pp_link = page_free_list;

page_free_list = &pages[i];

}

// 3. Then comes the IO hole[IOPHYSMEM, EXTPHYSMEM), which must

// never be allocated.

for (; i < EXTPHYSMEM/PGSIZE; i ++) {

pages[i].pp_ref = 1;

}

// 4. Then extended memory [EXTPHYSMEM, ...).

// 还要注意哪些内存已经被内核、页表使用了!

// first需要向上取整对齐。同时此时已经工作在虚拟地址模式(entry.S对内存进行了映射)下,

// 需要求得first的物理地址

physaddr_t first_free_addr = PADDR(boot_alloc(0));

size_t first_free_page = first_free_addr/PGSIZE;

for(; i < first_free_page; i ++) {

pages[i].pp_ref = 1;

}

// mark other pages as free

for(; i < npages; i ++) {

pages[i].pp_ref = 0;

pages[i].pp_link = page_free_list;

page_free_list = &pages[i];

}

可以在inc/memlayout.h中找到 IO hole 的定义,可回顾lab 1:1

2

3

4

5// At IOPHYSMEM (640K) there is a 384K hole for I/O. From the kernel,

// IOPHYSMEM can be addressed at KERNBASE + IOPHYSMEM. The hole ends

// at physical address EXTPHYSMEM.

第四种情况略有难度,实际需要利用boot_alloc函数来找到第一个能分配的页面。相同的思想在已经写好的check_free_page_list函数中也可以找到。关键代码:1

size_t first_free_address = PADDR(boot_alloc(0));

尤其需要注意的是,由于boot_alloc返回的是内核虚拟地址 (kernel virtual address),一定要利用 PADDR 转为物理地址。在 kern/pmap.h 中可以找到 PADDR 的定义,实际就是减了一个 F0000000。

完成以上步骤,编译运行,看到check_page_alloc() succeeded!则成功。

Lab 2 Part 2:内核内存映射

上一篇Part 1实现了分配器,用的是非常简单的链表管理方式。分配器实现的是剩余空间管理Free Space Management,有了剩余空间管理,接下来就是实际使用这些空间了。

这个part帮助我们正式建立虚拟内存Virtual Memory和物理内存Physical Memory之间的关系,明确了概念,完成了实现。在很多操作系统教材中,内存映射放在Free Space Management之前讲。在真正实现内存管理的时候,必须先有分配器、后有其它的,和讲解知识相反。

虚拟地址、线性地址和物理地址

虚拟地址有段选择器和段内偏移组成,线性地址则是在段地址翻译之后、页地址翻译之前的地址,物理地址则是在段地址翻译、页地址翻译之后的最终的地址,是你从硬件中取数据的地址。1

2

3

4

5

6

7

8

9

Selector +--------------+ +-----------+

---------->| | | |

| Segmentation | | Paging |

Software | |-------->| |----------> RAM

Offset | Mechanism | | Mechanism |

---------->| | | |

+--------------+ +-----------+

Virtual Linear Physical

C 指针是虚拟地址的“偏移量”组件。在boot/boot.S中,我们安装了一个全局描述符表 (GDT),它通过将所有段基地址设置为 0 并将限制设置为 0xffffffff 来有效地禁用段转换。因此“选择器”不起作用,线性地址总是等于虚拟地址的偏移量。在实验 3 中,我们将不得不与分段进行更多交互以设置权限级别,但是对于记忆翻译,我们可以在整个 JOS 实验中忽略分段,而只关注页面翻译。

回想一下,在实验 1 的第 3 部分中,我们安装了一个简单的页表,以便内核可以在其链接地址 0xf0100000 处运行,即使它实际上加载到 ROM BIOS 上方的物理内存中 0x00100000。这个页表只映射了 4MB 的内存。在本实验中您要为 JOS 设置的虚拟地址空间布局中,我们将扩展它以映射从虚拟地址 0xf0000000 开始的前 256MB 物理内存,并映射虚拟地址空间的许多其他区域。

x86内存管理机制

虚拟、线性和物理地址

- 虚拟地址

- 最原始的地址,也是 C/C++ 指针使用的地址。由前 16bit 段 (segment) 选择器和后 32bit 段内的偏移 (offset) 组成,显然一个段大小为 4GB。通过虚拟地址可以获得线性地址。

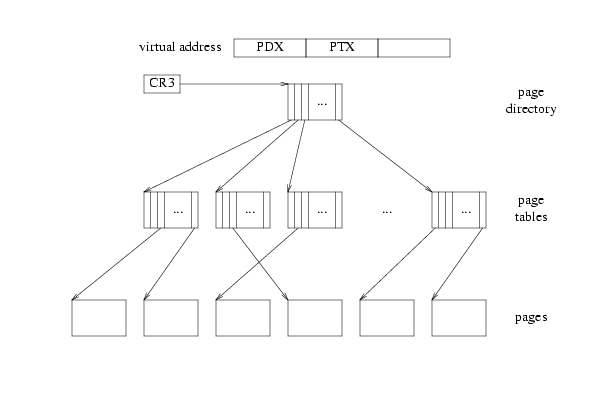

- 线性地址

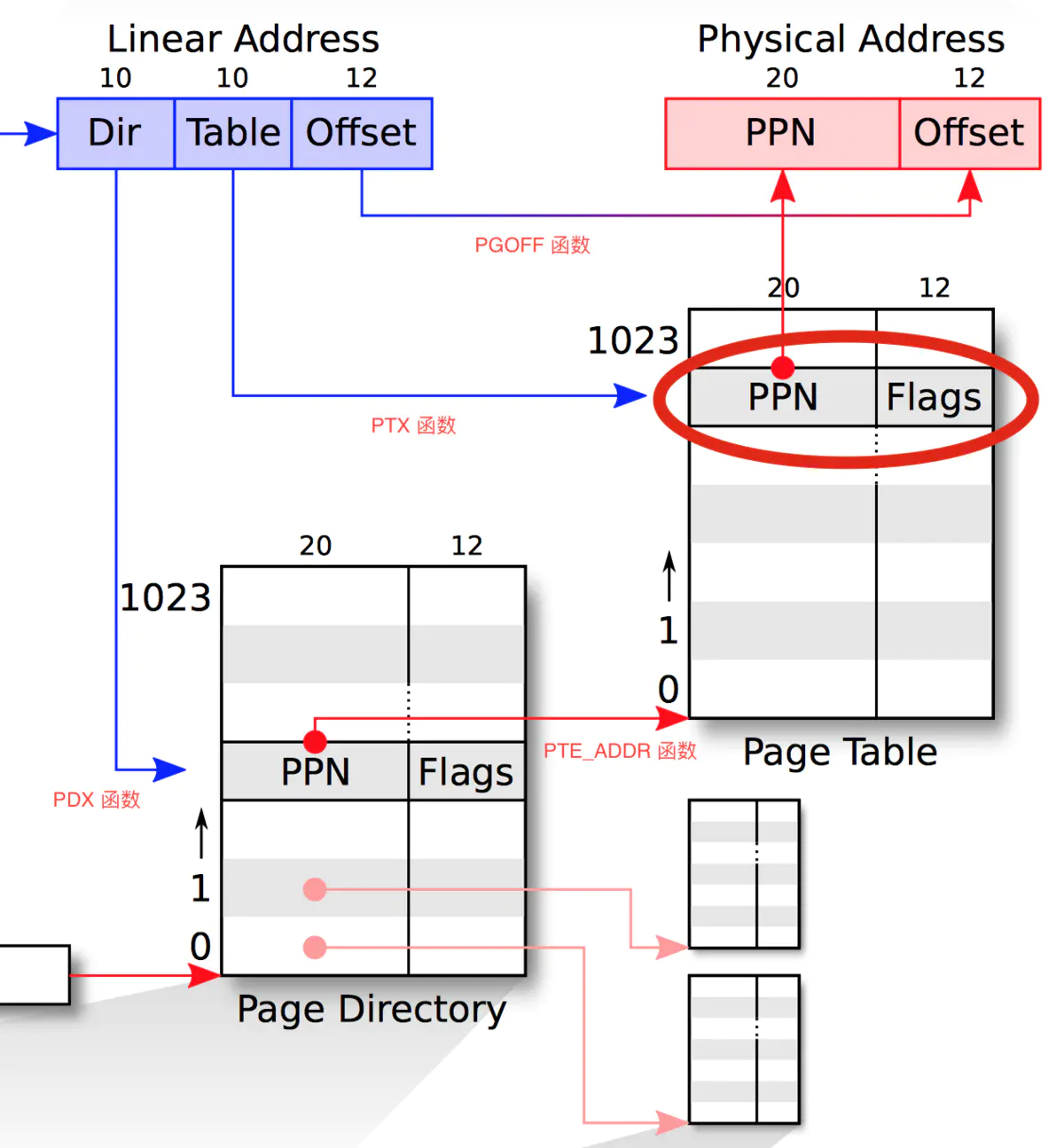

- 前 10bit 为页目录项(page directory entry, PDE),即该地址在页目录中的索引。中间 10bit 为页表项(page table entry, PTE),代表在页表中的索引,最后 12bit 为偏移,也就是每页 4kB。通过线性地址可以获得物理地址。

- 物理地址

- 经过段转换以及页面转换,最终在 RAM 的硬件总线上的地址。

两步映射总览

x86建立了两次映射,程序给出地址,经过这两次翻译之后,才输出从到总线交给内存芯片。这两次映射分别为Segment Translation和Page Translation。

Segment Translation将虚拟地址转化为线性地址Linear Address,Page Translation将线性地址转化为物理地址,也就是真正用来索引内存的地址。

在我们的项目中,还没有对Segment Translation做特殊处理。Lab讲义中说明了,Segment Translation没有映射虚拟地址,线性地址和虚拟地址相同。后文中统一使用“虚拟地址”同时代指虚拟地址和线性地址,因为它们就是一样的。

我们暂时没有使用复杂的Segment Translation,所以Page Translation就是我们的重点,以下简单介绍Segment Translation,着重理解Page Translation。

Segment Translation

Segment Translation的过程可以如下图表示:

由一个事先指定的selector选择器,从一个描述符表descriptor table中读出一个描述符descriptor。由这个描述符读出一个基地址base address,虚拟地址作为一种偏置offset,加到基地址上,就得到了linear address。

描述符表Descriptor Table

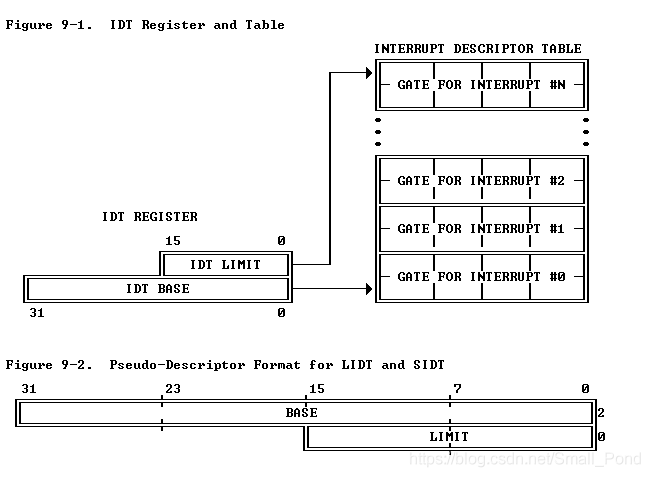

描述符表必须事先指定,虚拟地址中不包含关于描述符表的信息。

有两种描述符表,分别为全局描述符表Global Descriptor Table (GDT)和本地描述符表Local Descriptor Table (LDT),分别使用寄存器GDTR,LDTR获得。x86有访问这些寄存器的指令,我们没有直接使用,也就不关心了。

描述符Descriptor

通过selector索引描述符表得到的描述符,除了基地址之外,也包含了其他信息,具体结构如下图:

这是两种不同的结构,其中的区别只有DPL和TYPE之间的那个bit,以及TYPE的位置,我们暂时不关心它们的区别。这里需要注意的是P域,也就是Segment Present bit,表示这个segment是否在内存中,之后的Page Translation也有类似机制。

选择符Selector

选择符不但有描述符表的索引,还有选择描述符表GDT/LDT的bit,以及发出的请求所在的优先级,用于区分User Level Access和Kernel Level Access。我们也暂时不关心它们的区别。结构如下:

和segment有关的寄存器

虚拟地址只是一个segment的偏置,本身不包含和segment有关的信息。当前使用的描述符表、描述符选择符,都要另外存储在一些寄存器里面。当使用和跳转有关的指令call, jmp时,这些寄存器被隐式地访问了,从而帮助计算新的地址。

segment寄存器有两个部分,可以直接操作和读取的是16bit的selector域,修改selector域之后,硬件自动将对应的描述符从描述符表中读取进不显示的descriptor域,这样就方便了后续操作。

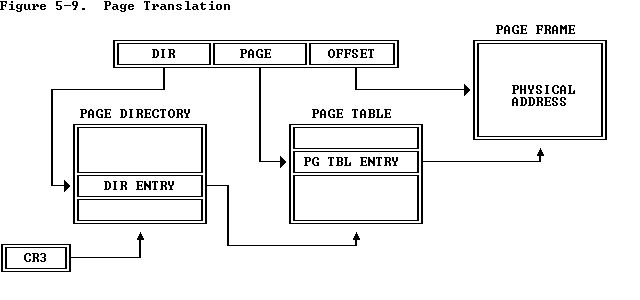

Page Translation

虚拟地址,也就是线性地址,被拆成了三部分,都是一种索引index,分别索引的是Page Directory, Page Table, Page Frame。从page directory中读出page table的地址,在从读到的page table地址中读到page frame的地址,索引page frame之后,就得到相应物理地址上的内容。

对于开发者来说,page directory, page table都是两个数组,拿到page directory的头部指针,和虚拟地址一起,就可以确定物理地址。

每个域对应长度

线性地址,也就是虚拟地址,的格式如下:

每个域包含bit的个数,也就是长度,决定了每个域对应的数组的长度。我们可以很方便地得到每个域对应的长度:1

2

3page_len = 2 ** 12 = 4096 // OFFSET

page_table_len = 2 ** 10 = 1024 // PAGE

page_dir_len = 2 ** 10 = 1024 // DIR

如果你不太理解这种计算方法,可以回到最开始的排列组合。每个bit代表两种状态,有n个bit也就有2^n种状态,也就是这个域可以产生多少索引。

以上计算出了每个域的长度,单位不是字节,而是索引个数。

这些长度应该这样看。一个page directory指向1024个page directory entry,一个page directory entry指向了1024个page table,一个page table entry指向了1024个page frame,一个page frame中包含4096Bytes。

Entry格式

page directory entry, page table entry具有相同格式,如下:

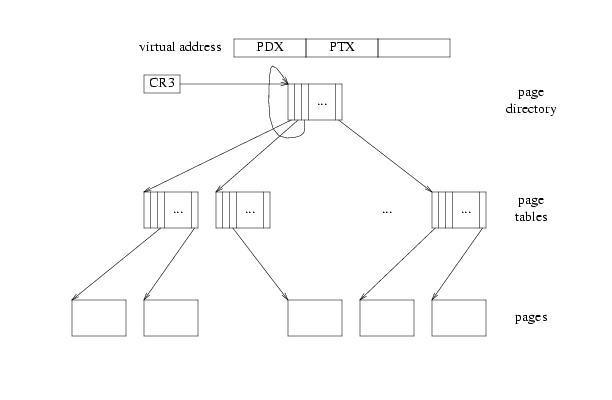

DIR, PAGE域长度相同,而entry的格式也相同,说明page directory和page table其实是相同结构的嵌套。可以把page directory理解为高一级的page table,整个内存管理形成两个层级。一个page table自身就是一个page,是page directory管理的,而page table又管理了page frame。

同理,我们可以把虚拟地址拆得更细,从而创造更多的层级,不过这是CPU设计的事情了。

对于page directory来说,entry中12-31位上的PAGE FRAME ADDRESS就是一个page table的基地址。对于page table来说,这个地址是一个page frame的基地址。通过一个虚拟地址,获得3个索引,一次访问这3个结构,就可以得到物理地址了。

这里还要注意一下,bit 0是Present Bit,表示当前entry中的信息是否可以用于映射。要是Present Bit设置为0,则这个entry不包含有效信息。索引各种page directory/table时,必须先检查这个bit。

entry中的其他部分暂时不使用。

可以使用的工具代码

在开始写代码之前,需要看看项目中已经提供好了哪些可以使用的工具。

首先是上个part中写好的分配器,boot_alloc已经不使用了,主要是page_alloc/page_free在使用。然后就是三个头文件mmu.h, memlayout.h, pmap.h中的各种小函数了

在 JOS 中,由于只有一个段,所以虚拟地址数值上等于线性地址。

JOS 内核常常需要读取或更改仅知道物理地址的内存。例如,添加一个到页表的映射要求分配物理内存来存储页目录并初始化内存。然而,内核和其他任何程序一样,无法绕过虚拟内存转换这个步骤,因此不能直接使用物理地址。JOS 将从 0x00000000 开始的物理内存映射到 0xf0000000 的其中一个原因就是需要使内核能读写仅知道物理地址的内存。为了把物理地址转为虚拟地址,内核需要给物理地址加上 0xf0000000。这就是 KADDR 函数做的事。

同样,JOS 内核有时也需要从虚拟地址获得物理地址。内核的全局变量和由 boot_alloc 分配的内存都在内核被加载的区域,即从0xf0000000开始的地方。因此,若需要将虚拟地址转为物理地址,直接减去0xf0000000即可。这就是 PADDR 函数做的事。

mmu.h

1 | // 线性地址 'la' 可以被分成三块: |

还有一些页表以及页目录会用到的标识位,exercise 4 中用得到的用中文注释:1

2

3

4

5

6

7

8

9

10// Page table/directory entry flags.

根据虚拟地址取出Page Table Entry

这里开始实现Lab讲义中指定要实现的函数,先是pgdir_walk函数,在文件kern/pmap.c中。这个函数接受一个page directory和一个虚拟地址,要求得到虚拟地址在这个page directory下对应的page table entry。

先拆分虚拟地址,根据虚拟地址取出page directory/table/frame中的索引。用到的三个宏函数在文件mmu.h中,也就是通过移位>>和与&从一串bit中取出一些bit。需要完成如图的转换,返回对应的页表地址,即红圈圈出的部分的虚拟地址:

1 | pte_t * |

需要将PageInfo结构体的指针转换为物理地址,而不是虚拟地址。这个操作的依据是80386 Programmer’s Reference Manual的规定,在entry中放置的一定是物理地址。更新完page directory entry之后,原函数pgdir_walk根据虚拟地址中的索引,从新的page directory entry中获得新的page table地址,并返回。

通过宏函数KADDR转化为虚拟地址,而不是直接从page directory entry中读取出来的物理地址。

映射一段空间

第二个要实现的函数是boot_map_region,这个函数将虚拟地址中的几个page映射到连续的物理地址上。代码很简单,利用刚刚写好的函数pgdir_walk,给参数create传1,就可以方便地建立page table。1

2

3

4

5

6

7

8

9

10

11

12

13

14static void

boot_map_region(pde_t *pgdir, uintptr_t va, size_t size, physaddr_t pa, int perm)

{

// Fill this function in

pte_t *pgtab;

size_t end_addr = va + size;

for (;va < end_addr; va += PGSIZE, pa += PGSIZE) {

pgtab = pgdir_walk(pgdir, (void *)va, 1);

if (!pgtab) {

return;

}

*pgtab = pa | perm | PTE_P;

}

}

boot_map_region中的 for 循环一开始就判断va > end_addr。这是显然的,因为end_addr = 0xf0000000 + 0x1000000 = 0x00000000。因此,实际上boot_map_region的更佳实现是直接用页数,避免溢出。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17static void

boot_map_region(pde_t *pgdir, uintptr_t va, size_t size, physaddr_t pa, int perm)

{

// Fill this function in

pte_t *pgtab;

size_t pg_num = PGNUM(size);

cprintf("map region size = %d, %d pages\n",size, pg_num);

for (size_t i = 0; i < pg_num; i ++) {

pgtab = pgdir_walk(pgdir, (void *)va, 1);

if (!pgtab) {

return;

}

*pgtab = pa | perm | PTE_P;

va += PGSIZE;

pa += PGSIZE;

}

}

注释中提示我们,这是静态映射,不要增加每个page对应的PageInfo结构体的引用计数pp_ref。

根据各个函数的依赖关系,下一个编写page_lookup函数。作用是查找虚拟地址对应的物理页描述。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16struct PageInfo *

page_lookup(pde_t *pgdir, void *va, pte_t **pte_store)

{

// 参数1: 页目录指针

// 参数2: 线性地址,JOS 中等于虚拟地址

// 参数3: 指向页表指针的指针

// 返回: 页描述结构体指针

pte_t *pgtab = pgdir_walk(pgdir, va, 0); // 不创建,只查找

if (!pgtab) {

return NULL; // 未找到则返回 NULL

}

if (pte_store) {

*pte_store = pgtab; // 附加保存一个指向找到的页表的指针

}

return pa2page(PTE_ADDR(*pgtab)); // 返回页面描述

}

此处再次用到了PTE_ADDR这个宏。其作用是将页表指针指向的内容转为物理地址。这里还是要注意,从page table中拿出page frame的为物理地址,不是虚拟地址。

page_remove函数作用是移除一个虚拟地址与对应的物理页的映射。1

2

3

4

5

6

7

8

9

10

11

12

13

14void

page_remove(pde_t *pgdir, void *va)

{

// Fill this function in

pte_t *pgtab;

pte_t **pte_store = &pgtab;

struct PageInfo *pInfo = page_lookup(pgdir, va, pte_store);

if (!pInfo) {

return;

}

page_decref(pInfo);

*pgtab = 0; // 将内容清0,即无法再根据页表内容得到物理地址。

tlb_invalidate(pgdir, va); // 通知tlb失效。tlb是个高速缓存,用来缓存查找记录增加查找速度。

}

函数还减小了PageInfo结构体的引用计数pp_ref,并让TLB缓存失效了。

page_insert函数作用是建立一个虚拟地址与物理页的映射,与page_remove对应。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27int

page_insert(pde_t *pgdir, struct PageInfo *pp, void *va, int perm)

{

// 参数1: 页目录指针

// 参数2: 页描述结构体指针

// 参数3: 线性地址,JOS 中等于虚拟地址

// 参数4: 权限

// 返回: 成功(0),失败(-E_NO_MEM)

pte_t *pgtab = pgdir_walk(pgdir, va, 1); // 查找该虚拟地址对应的页表项,不存在则建立。

if (!pgtab) {

return -E_NO_MEM; // 空间不足

}

if (*pgtab & PTE_P) {

// 页表项已经存在,即该虚拟地址已经映射到物理页了

if (page2pa(pp) == PTE_ADDR(*pgtab)) {

// 如果映射到与之前相同的页,仅更改权限,不增加引用

*pgtab = page2pa(pp) | perm | PTE_P;

return 0;

} else {

// 如果是更新映射的物理页,则要删除之前的映射关系

page_remove(pgdir, va);

}

}

*pgtab = page2pa(pp) | perm | PTE_P;

pp->pp_ref++;

return 0;

}

需要注意的是,如果同样的虚拟页映射到了同样的物理页,如果不做特殊处理仍然调用page_remove后再增加引用次数,可能会出现以下情况:

- 当该物理页

ref = 1,经过page_remove后会被加入空闲页链表。然而,在函数最后还需要增加其引用计数,导致page_free_list中出现了非空闲页。

课程中希望尽量不要做特例处理,即避免使用if,于是可以这么改进:

1 | int |

以上只要区分开了entry中保存的都是物理地址就好弄了。

Page Table组织总结

在Lab 2中,我们让代码跑过了各种check_*函数,但是没有对其中的原理充分深究。这里总结一下。

内核的内存管理是以page为单位的,称为一个Page Frame,一个page的大小是4096Bytes,也就是4KB。内核使用free list链表的方式管理尚未分配的空间,实现非常简单。

要使用内存,必须建立虚拟地址映射。无论是C代码还是汇编代码,要访问内存,都是通过虚拟地址。C代码中,所有指针的值都必须为虚拟地址,代码才能正确执行,否则*访问不到想要的地址。

虚拟地址映射是通过一个二级table实现的,两个层级分别被称为Page Directory和Page Table。两者在结构上没有区别,只是相同结构的相互嵌套。虚拟地址不包含任何table的地址,只包含table的索引。必须事先指定好Page Directory的地址,利用这个地址得到Page Directory Entry,从而得到Page Table地址,从而得到Page Frame地址,需要且仅需要指定Page Directory地址。Page Directory地址是寄存器cr3,设置cr3的行为会导致硬件执行切换Page Directory配套的一系列操作。

在函数mem_init之前,内核加载时简单地初始化了一个Page Directory,将0xf0000000开始的一段地址映射到0x0开始的一段地址,以方便正式初始化虚拟地址映射之前的操作。在mem_init函数的最后,我们需要初始化一个真正的kern_pgdir,并将寄存器cr3设置为它的地址。

最终得到的虚拟地址布局为文件memlayout.h中的注释(再来一遍,这个图画的真的太好了):1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63/*

* Virtual memory map: Permissions

* kernel/user

*

* 4 Gig --------> +------------------------------+

* | | RW/--

* ~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

* : . :

* : . :

* : . :

* |~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~| RW/--

* | | RW/--

* | Remapped Physical Memory | RW/--

* | | RW/--

* KERNBASE, ----> +------------------------------+ 0xf0000000 --+

* KSTACKTOP | CPU0's Kernel Stack | RW/-- KSTKSIZE |

* | - - - - - - - - - - - - - - -| |

* | Invalid Memory (*) | --/-- KSTKGAP |

* +------------------------------+ |

* | CPU1's Kernel Stack | RW/-- KSTKSIZE |

* | - - - - - - - - - - - - - - -| PTSIZE

* | Invalid Memory (*) | --/-- KSTKGAP |

* +------------------------------+ |

* : . : |

* : . : |

* MMIOLIM ------> +------------------------------+ 0xefc00000 --+

* | Memory-mapped I/O | RW/-- PTSIZE

* ULIM, MMIOBASE --> +------------------------------+ 0xef800000

* | Cur. Page Table (User R-) | R-/R- PTSIZE

* UVPT ----> +------------------------------+ 0xef400000

* | RO PAGES | R-/R- PTSIZE

* UPAGES ----> +------------------------------+ 0xef000000

* | RO ENVS | R-/R- PTSIZE

* UTOP,UENVS ------> +------------------------------+ 0xeec00000

* UXSTACKTOP -/ | User Exception Stack | RW/RW PGSIZE

* +------------------------------+ 0xeebff000

* | Empty Memory (*) | --/-- PGSIZE

* USTACKTOP ---> +------------------------------+ 0xeebfe000

* | Normal User Stack | RW/RW PGSIZE

* +------------------------------+ 0xeebfd000

* | |

* | |

* ~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

* . .

* . .

* . .

* |~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~|

* | Program Data & Heap |

* UTEXT --------> +------------------------------+ 0x00800000

* PFTEMP -------> | Empty Memory (*) | PTSIZE

* | |

* UTEMP --------> +------------------------------+ 0x00400000 --+

* | Empty Memory (*) | |

* | - - - - - - - - - - - - - - -| |

* | User STAB Data (optional) | PTSIZE

* USTABDATA ----> +------------------------------+ 0x00200000 |

* | Empty Memory (*) | |

* 0 ------------> +------------------------------+ --+

*

* (*) Note: The kernel ensures that "Invalid Memory" is *never* mapped.

* "Empty Memory" is normally unmapped, but user programs may map pages

* there if desired. JOS user programs map pages temporarily at UTEMP.

*/

建立映射的函数们

我们已经写好了很多函数,在把它们用起来之前,再浏览一遍它们的目的。

首先是分配器,对未分配的物理内存进行管理。在初始化函数mem_init中调用page_init初始化了这个分配器,之后通过page_alloc,page_free获取和释放page。

要正确建立映射,首先需要正确方便地索引Page Directory,Page Table。函数pgdir_walk,根据指定Page Directory索引出Page Table Entry。函数page_lookup基于pgdir_walk,进一步得到这个Page Table Entry对应的物理地址。

地址映射可以建立或移除,我们都写好了方便的函数。函数boot_map_region用于给内核做映射,只处理0xf0000000以上虚拟空间。函数page_insert,page_remove处理其他空间的映射,分别建立映射、移除映射。

其他函数对以上起辅助作用。

为内核建立虚拟地址映射

Lab 2 Part 3要求我们补全函数mem_init后面的部分,也就是给内核配置好kern_pgdir,并设置寄存器cr3。在这里使用的函数都是boot_map_region。

JOS 将处理器的 32 位线性地址空间分为两部分。我们将在 lab3 中开始加载和运行的用户环境(进程)将控制下部的布局和内容,而内核始终保持对上部的完全控制。分隔线由inc/memlayout.h中的符号ULIM随意定义,为内核保留大约 256MB 的虚拟地址空间。这就解释了为什么我们需要在实验室 1 中给内核一个如此高的链接地址:否则内核的虚拟地址空间将没有足够的空间同时映射到它下面的用户环境。

权限和故障隔离

由于内核和用户内存都存在于每个环境的地址空间中,我们将不得不在 x86 页表中使用权限位来允许用户代码仅访问地址空间的用户部分。否则用户代码中的错误可能会覆盖内核数据,导致崩溃或更微妙的故障;用户代码也可能窃取其他环境的私人数据。请注意,可写权限位PTE_W会影响用户和内核代码!

用户环境将无权访问ULIM之上的任何内存,而内核将能够读写此内存。对于地址范围[UTOP,ULIM),内核和用户环境都有相同的权限:可以读但不能写这个地址范围。该地址范围用于向用户环境公开某些只读的内核数据结构。最后,UTOP下面的地址空间是供用户环境使用的;用户环境将设置访问此内存的权限。

JOS 将处理器的 32 位线性地址分为用户环境(低位地址)以及内核环境(高位地址)。分界线在inc/memlayout.h中定义为ULIM:1

2

3

4

5

6

7

// Kernel stack.

// Memory-mapped IO.

其中PTSIZE被定义为一个页目录项映射的 Byte,一个页目录中有1024个页表项,每个页表项可映射一个物理页。故为 4MB。可算得 ULIM = 0xf0000000 - 0x00400000 - 0x00400000 = 0xef800000,可通过查看inc/memlayout确认。

我们还需要给物理页表设置权限以确保用户只能访问用户环境的地址空间。否则,用户的代码可能会覆盖内核数据,造成严重后果。用户环境应该在高于 ULIM 的内存中没有任何权限,而内核则可以读写着部分内存。在 UTOP( 0xeec00000) 到 ULIM 的 12MB 区间中,存储了一些内核数据结构。内核以及用户环境对这部分地址都只具有 read-only 权限。低于 UTOP 的内存则由用户环境自由设置权限使用。