求二进制数中1的个数

问题描述

任意给定一个32位无符号整数n,求n的二进制表示中1的个数,比如n = 5(0101)时,返回2,n = 15(1111)时,返回4

这也是一道比较经典的题目了,相信不少人面试的时候可能遇到过这道题吧,下面介绍了几种方法来实现这道题。

普通法

移位+计数,这种方法的运算次数与输入n最高位1的位置有关,最多循环32次。1

2

3

4

5

6

7

8

9

10

11int BitCount(unsigned int n)

{

unsigned int c =0 ; // 计数器

while (n >0)

{

if((n &1) ==1) // 当前位是1

++c ; // 计数器加1

n >>=1 ; // 移位

}

return c ;

}

一个更精简的版本如下1

2

3

4

5

6

7int BitCount1(unsigned int n)

{

unsigned int c =0 ; // 计数器

for (c =0; n; n >>=1) // 循环移位

c += n &1 ; // 如果当前位是1,则计数器加1

return c ;

}

快速法

这种方法速度比较快,其运算次数与输入n的大小无关,只与n中1的个数有关。如果n的二进制表示中有k个1,那么这个方法只需要循环k次即可。其原理是不断清除n的二进制表示中最右边的1,同时累加计数器,直至n为0,代码如下1

2

3

4

5

6

7

8

9int BitCount2(unsigned int n)

{

unsigned int c =0 ;

for (c =0; n; ++c)

{

n &= (n -1) ; // 清除最低位的1

}

return c ;

}

为什么n &= (n – 1)能清除最右边的1呢?因为从二进制的角度讲,n相当于在n - 1的最低位加上1。举个例子,8(1000)= 7(0111)+ 1(0001),所以8 & 7 = (1000)&(0111)= 0(0000),清除了8最右边的1(其实就是最高位的1,因为8的二进制中只有一个1)。再比如7(0111)= 6(0110)+ 1(0001),所以7 & 6 = (0111)&(0110)= 6(0110),清除了7的二进制表示中最右边的1(也就是最低位的1)。

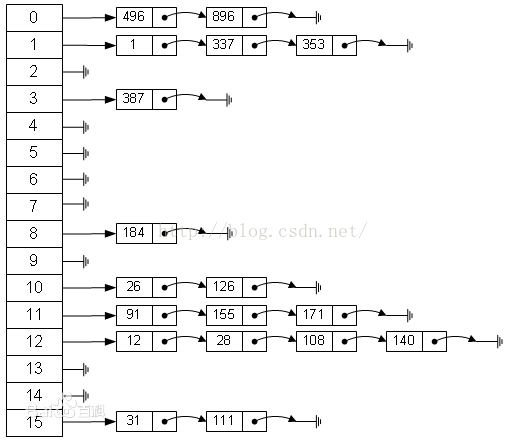

查表法

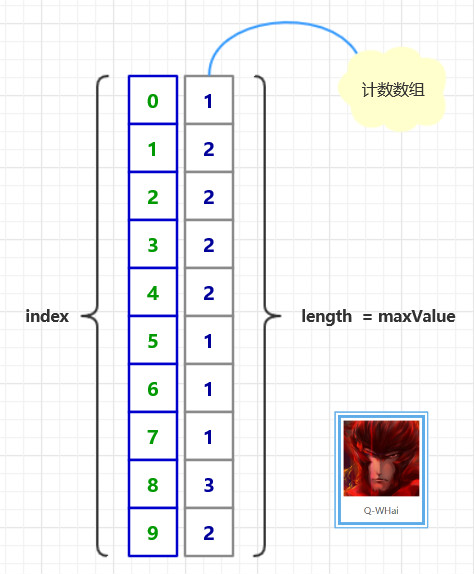

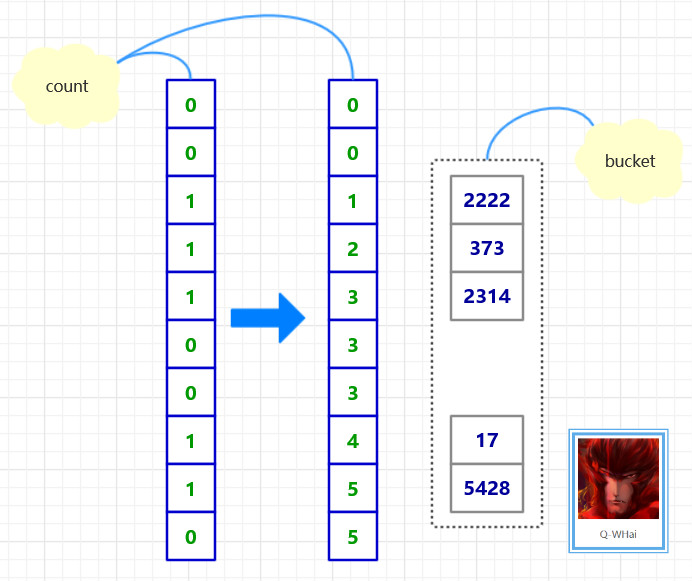

动态建表

由于表示在程序运行时动态创建的,所以速度上肯定会慢一些,把这个版本放在这里,有两个原因

- 介绍填表的方法,因为这个方法的确很巧妙。

- 类型转换,这里不能使用传统的强制转换,而是先取地址再转换成对应的指针类型。也是常用的类型转换方法。

1 | int BitCount3(unsigned int n) |

先说一下填表的原理,根据奇偶性来分析,对于任意一个正整数n

- 如果它是偶数,那么n的二进制中1的个数与n/2中1的个数是相同的,比如4和2的二进制中都有一个1,6和3的二进制中都有两个1。为啥?因为n是由n/2左移一位而来,而移位并不会增加1的个数。

- 如果n是奇数,那么n的二进制中1的个数是n/2中1的个数+1,比如7的二进制中有三个1,7/2 = 3的二进制中有两个1。为啥?因为当n是奇数时,n相当于n/2左移一位再加1。

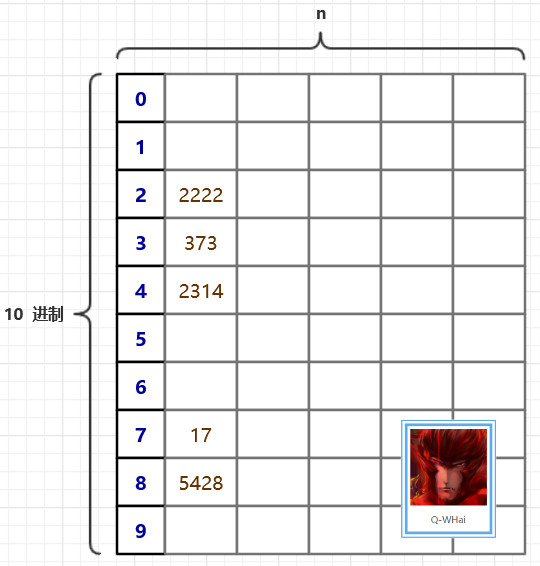

再说一下查表的原理

对于任意一个32位无符号整数,将其分割为4部分,每部分8bit,对于这四个部分分别求出1的个数,再累加起来即可。而8bit对应2^8 = 256种01组合方式,这也是为什么表的大小为256的原因。

注意类型转换的时候,先取到n的地址,然后转换为unsigned char*,这样一个unsigned int(4 bytes)对应四个unsigned char(1 bytes),分别取出来计算即可。举个例子吧,以87654321(十六进制)为例,先写成二进制形式-8bit一组,共四组,以不同颜色区分,这四组中1的个数分别为4,4,3,2,所以一共是13个1,如下面所示。

10000111 01100101 01000011 00100001 = 4 + 4 + 3 + 2 = 13

静态表-4bit

原理和8-bit表相同,详见8-bit表的解释1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18int BitCount4(unsigned int n)

{

unsigned int table[16] =

{

0, 1, 1, 2,

1, 2, 2, 3,

1, 2, 2, 3,

2, 3, 3, 4

} ;

unsigned int count =0 ;

while (n)

{

count += table[n &0xf] ;

n >>=4 ;

}

return count ;

}

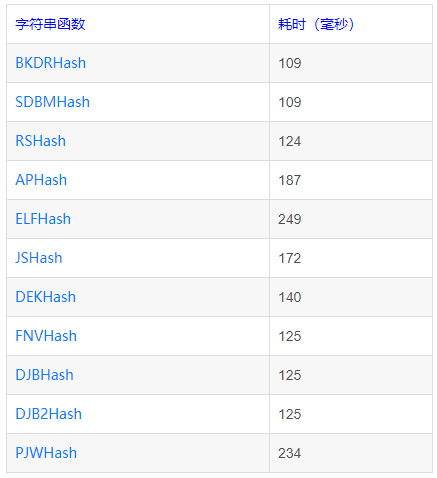

静态表-8bit

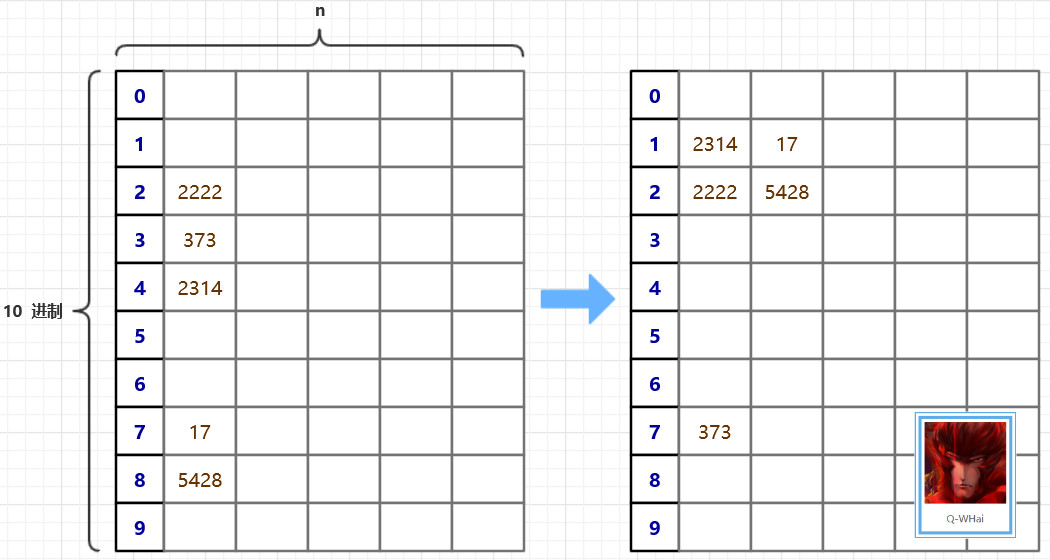

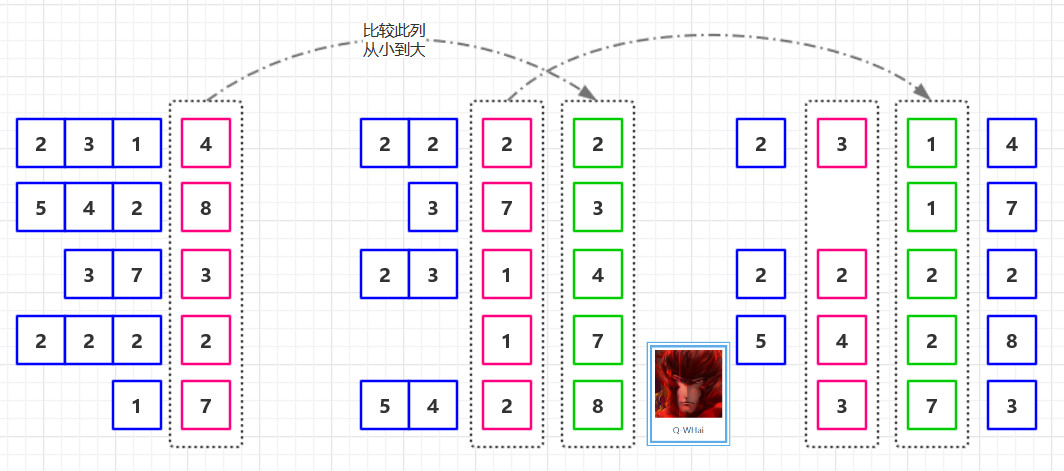

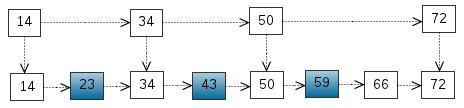

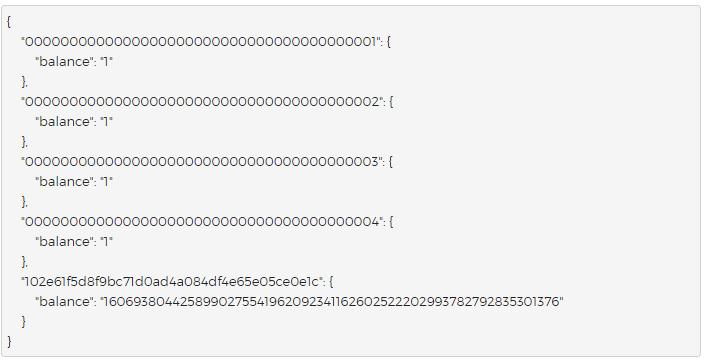

首先构造一个包含256个元素的表table,table[i]即i中1的个数,这里的i是[0-255]之间任意一个值。然后对于任意一个32bit无符号整数n,我们将其拆分成四个8bit,然后分别求出每个8bit中1的个数,再累加求和即可,这里用移位的方法,每次右移8位,并与0xff相与,取得最低位的8bit,累加后继续移位,如此往复,直到n为0。所以对于任意一个32位整数,需要查表4次。以十进制数2882400018为例,其对应的二进制数为10101011110011011110111100010010,对应的四次查表过程如下:红色表示当前8bit,绿色表示右移后高位补零。

第一次(n & 0xff) 10101011110011011110111100010010

第二次((n >> 8) & 0xff) 00000000101010111100110111101111

第三次((n >> 16) & 0xff)00000000000000001010101111001101

第四次((n >> 24) & 0xff)00000000000000000000000010101011

1 | int BitCount7(unsigned int n) |

当然也可以搞一个16bit的表,或者更极端一点32bit的表,速度将会更快。

平行算法

网上都这么叫,我也这么叫吧,不过话说回来,的确有平行的意味在里面,先看代码,稍后解释

1 | int BitCount4(unsigned int n) |

速度不一定最快,但是想法绝对巧妙。 说一下其中奥妙,其实很简单,先将n写成二进制形式,然后相邻位相加,重复这个过程,直到只剩下一位。

1 | int BitCount5(unsigned int n) |

最喜欢这个,代码太简洁啦,只是有个取模运算,可能速度上慢一些。区区两行代码,就能计算出1的个数,到底有何奥妙呢?为了解释的清楚一点,我尽量多说几句。

第一行代码的作用:先说明一点,以0开头的是8进制数,以0x开头的是十六进制数,上面代码中使用了三个8进制数。

将n的二进制表示写出来,然后每3bit分成一组,求出每一组中1的个数,再表示成二进制的形式。比如n = 50,其二进制表示为110010,分组后是110和010,这两组中1的个数本别是2和3。2对应010,3对应011,所以第一行代码结束后,tmp = 010011,具体是怎么实现的呢?由于每组3bit,所以这3bit对应的十进制数都能表示为2^2 a + 2^1 b + c的形式,也就是4a + 2b + c的形式,这里a,b,c的值为0或1,如果为0表示对应的二进制位上是0,如果为1表示对应的二进制位上是1,所以a + b + c的值也就是4a + 2b + c的二进制数中1的个数了。举个例子,十进制数6(0110)= 4 1 + 2 1 + 0,这里a = 1, b = 1, c = 0, a + b + c = 2,所以6的二进制表示中有两个1。现在的问题是,如何得到a + b + c呢?注意位运算中,右移一位相当于除2,就利用这个性质!

4a + 2b + c 右移一位等于2a + b

4a + 2b + c 右移量位等于a

然后做减法

4a + 2b + c –(2a + b) – a = a + b + c,这就是第一行代码所作的事,明白了吧。

第二行代码的作用:在第一行的基础上,将tmp中相邻的两组中1的个数累加,由于累加到过程中有些组被重复加了一次,所以要舍弃这些多加的部分,这就是&030707070707的作用,又由于最终结果可能大于63,所以要取模。

需要注意的是,经过第一行代码后,从右侧起,每相邻的3bit只有四种可能,即000, 001, 010, 011,为啥呢?因为每3bit中1的个数最多为3。所以下面的加法中不存在进位的问题,因为3 + 3 = 6,不足8,不会产生进位。

tmp + (tmp >> 3)-这句就是是相邻组相加,注意会产生重复相加的部分,比如tmp = 659 = 001 010 010 011时,tmp >> 3 = 000 001 010 010,相加得

001 010 010 011

000 001 010 010

001 011 100 101

011 + 101 = 3 + 5 = 8。(感谢网友Di哈指正。)注意,659只是个中间变量,这个结果不代表659这个数的二进制形式中有8个1。

注意我们想要的只是第二组和最后一组(绿色部分),而第一组和第三组(红色部分)属于重复相加的部分,要消除掉,这就是&030707070707所完成的任务(每隔三位删除三位),最后为什么还要%63呢?因为上面相当于每次计算相连的6bit中1的个数,最多是111111 = 77(八进制)= 63(十进制),所以最后要对63取模。

位标志法

1 | struct _byte |

指令法

使用微软提供的指令,首先要确保你的CPU支持SSE4指令,用Everest和CPU-Z可以查看是否支持。1

2unsigned int n =127 ;

unsigned int bitCount = _mm_popcnt_u32(n) ;

快速幂、快速幂取模

大数模幂运算的缺陷

快速幂取模算法的引入是从大数的小数取模的朴素算法的局限性所提出的,在朴素的方法中我们计算一个数比如5^1003%31是非常消耗我们的计算资源的,在整个计算过程中最麻烦的就是我们的5^1003这个过程

- 缺点1:在我们在之后计算指数的过程中,计算的数字不都拿得增大,非常的占用我们的计算资源(主要是时间,还有空间)

- 缺点2:我们计算的中间过程数字大的恐怖,我们现有的计算机是没有办法记录这么长的数据的,所以说我们必须要想一个更加高效的方法来解决这个问题

快速幂的引入

我们首先从优化的过程开始一步一步优化我们的模幂算法

1.朴素模幂运算过程:1

2

3

4

5#define ans=1

for(int i=1;i<=b;i++)

{

ans*=a;

}

根据我们上面说的,这种算法是非常的无法容忍的,我们在计算的过程中出现的两个缺点在这里都有体现

在这里我们如果要做优化的话,我肥就是每个过程中都加一次模运算,但是我们首先要记住模运算是非常的消耗内存资源的,在计算的次数非常的大的时候,我们是没有办法忍受这种时间耗费的

2.快速幂引入:

在讲解快速幂取模算法之前,我们先将几个必备的知识

1.对于取模运算:(a*b)%c=(a%c)*(b%c)%c,这个是成立的:也是我们实现快速幂的基础。之后我们来看看快速幂的核心本质。

在这里,我们对指数动了一些手脚,核心思想在于:将大数的幂运算拆解成了相对应的乘法运算,利用上面的式子,始终将我们的运算的数据量控制在c的范围以下,这样我们可以客服朴素的算法的缺点二,我们将计算的数据量压缩了很大一部分,当指数非常大的时候这个优化是更加显著的,我们用Python来做一个实验来看看就知道我们优化的效率有多高了

1 | from time import * |

实验结果:1

2

3

4

5

6

7底数:5

指数:1003

模:12

朴素算法结果5

朴素算法耗时:3.289952

快速幂算法结果5

快速幂算法耗时:0.006706

我们现在知道了快速幂取模算法的强大了,我们现在来看核心原理:对于任何一个整数的模幂运算:a^b%c,对于b我们可以拆成二进制的形式:1

b=b0+b1*2+b2*2^2+...+bn*2^n

这里我们的b0对应的是b二进制的第一位,那么我们的a^b运算就可以拆解成1

a^b0*a^b1*2*...*a^(bn*2^n)

对于b来说,二进制位不是0就是1,那么对于bx为0的项我们的计算结果是1就不用考虑了,我们真正想要的其实是b的非0二进制位。那么假设除去了b的0的二进制位之后我们得到的式子是1

a^(bx*2^x)*...*a(bn*2^n)

这里我们再应用我们一开始提到的公式,那么我们的a^b%c运算就可以转化为1

(a^(bx*2^x)%c)*...*(a^(bn*2^n)%c)

这样的话,我们就很接近快速幂的本质了1

(a^(bx*2^x)%c)*...*(a^(bn*2^n)%c)

我们会发现令1

2

3A1=(a^(bx*2^x)%c)

...

An=(a^(bn*2^n)%c)

这样的话,An始终是A(n-1)的平方倍(当然加进去了取模匀速那),依次递推。现在,我们基本的内容都已经了解到了,现在我们来考虑实现它:1

2

3

4

5

6

7

8

9

10

11

12int quick(int a,int b,int c)

{

int ans=1; //记录结果

a=a%c; //预处理,使得a处于c的数据范围之下

while(b!=0)

{

if(b&1) ans=(ans*a)%c; //如果b的二进制位不是0,那么我们的结果是要参与运算的

b>>=1; //二进制的移位操作,相当于每次除以2,用二进制看,就是我们不断的遍历b的二进制位

a=(a*a)%c; //不断的加倍

}

return ans;

}

现在,我们的快速幂已经讲完了。我们来大致的推演一下快速幂取模算法的时间复杂度。首先,我们会观察到,我们每次都是将b的规模缩小了2倍,那么很显然,原本的朴素的时间复杂度是O(n)。快速幂的时间复杂度就是O(logn)无限接近常熟的时间复杂度无疑逼朴素的时间复杂度优秀很多,在数据量越大的时候,者中优化效果越明显。

OJ例题

POJ1995题意:快速幂版题1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42#include"iostream"

#include"cstdio"

#include"cstring"

#include"cstdlib"

using namespace std;

int ans=0;

int a,b;

int c;

int quick(int a,int b,int c)

{

int ans=1;

a=a%c;

while(b!=0)

{

if(b&1) ans=(ans*a)%c;

b>>=1;

a=(a*a)%c;

}

return ans;

}

int main()

{

int for_;

int t;

scanf("%d",&t);

while(t--)

{

ans=0;

scanf("%d%d",&c,&for_);

for(int i=1;i<=for_;i++)

{

scanf("%d%d",&a,&b);

ans=(ans+quick(a,b,c))%c;

}

printf("%d\n",ans);

}

return 0;

}

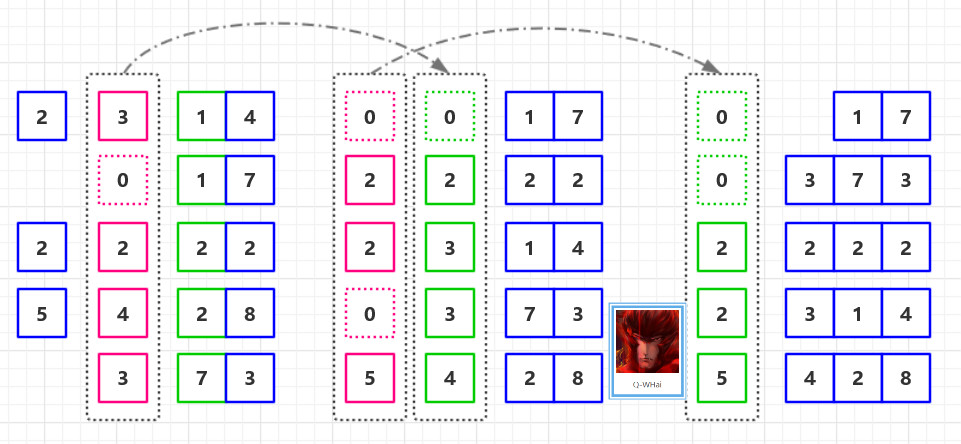

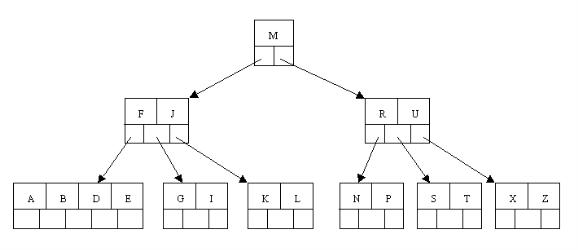

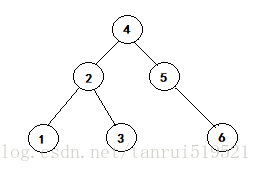

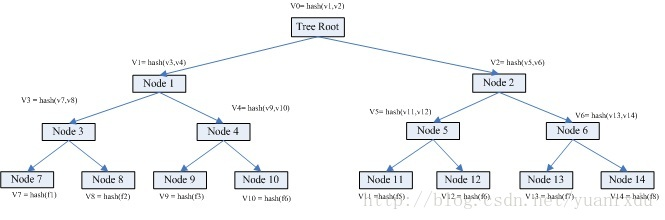

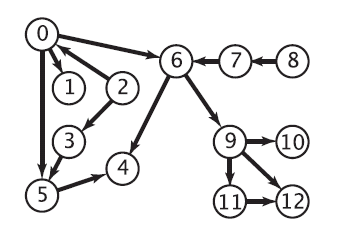

二叉树

- 所有非叶子结点至多拥有两个儿子(Left和Right);

- 所有结点存储一个关键字;

- 非叶子结点的左指针指向小于其关键字的子树,右指针指向大于其关键字的子树;

二叉树的搜索,从根结点开始,如果查询的关键字与结点的关键字相等,那么就命中;否则,如果查询关键字比结点关键字小,就进入左儿子;如果比结点关键字大,就进入右儿子;如果左儿子或右儿子的指针为空,则报告找不到相应的关键字;如果二叉树的所有非叶子结点的左右子树的结点数目均保持差不多(平衡),那么二叉树的搜索性能逼近二分查找;但它比连续内存空间的二分查找的优点是,改变二叉树结构(插入与删除结点)不需要移动大段的内存数据,甚至通常是常数开销;

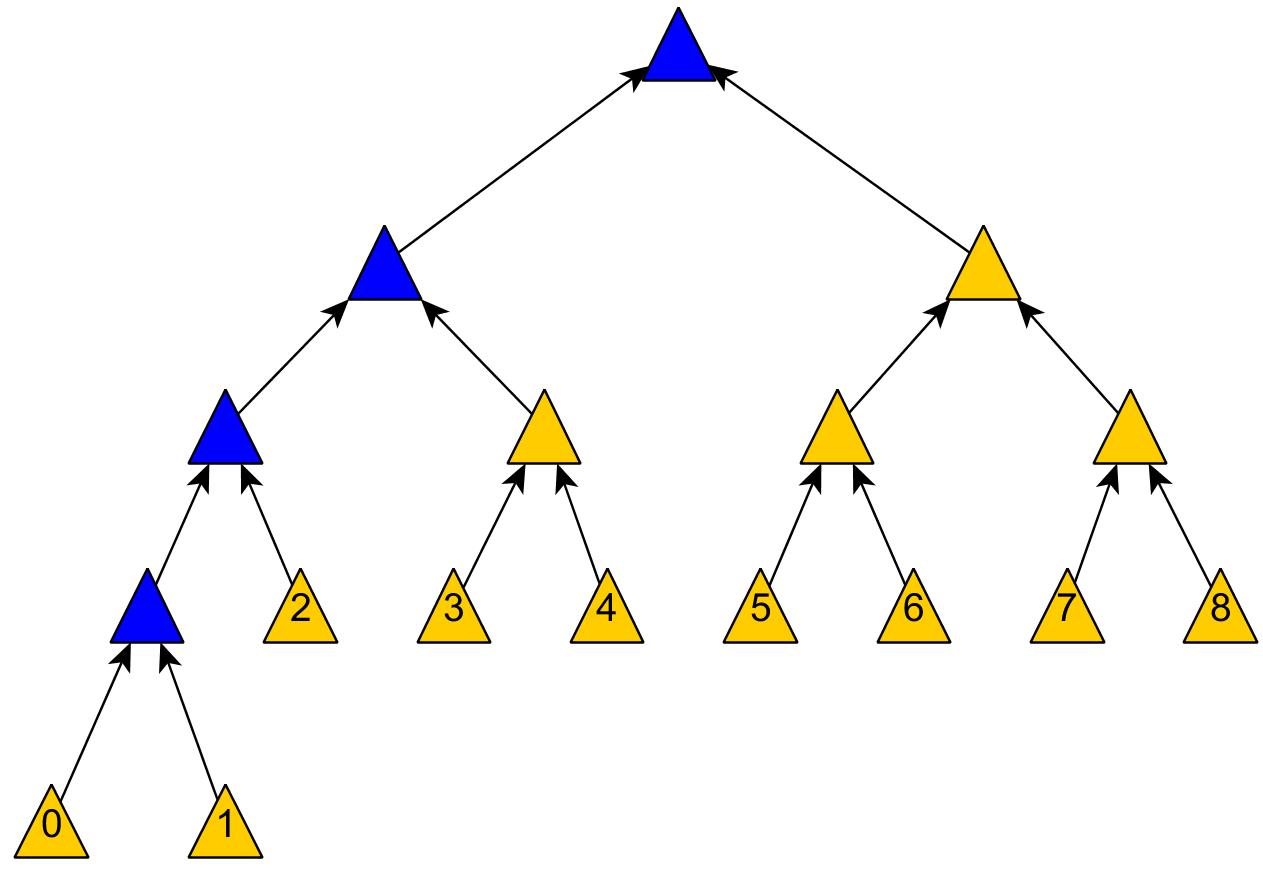

但二叉树在经过多次插入与删除后,有可能导致不同的结构:

右边也是一个二叉树,但它的搜索性能已经是线性的了;同样的关键字集合有可能导致不同的树结构索引;所以,使用二叉树还要考虑尽可能让二叉树保持左图的结构,和避免右图的结构,也就是所谓的“平衡”问题;实际使用的二叉树都是在原二叉树的基础上加上平衡算法,即“平衡二叉树”;如何保持二叉树结点分布均匀的平衡算法是平衡二叉树的关键;平衡算法是一种在二叉树中插入和删除结点的策略。

1 | class TreeNode{ |

二叉树的题目普遍可以用递归和迭代的方式来解

- 求二叉树的最大深度

1 | int maxDeath(TreeNode node){ |

- 求二叉树的最小深度

1 | int getMinDepth(TreeNode root){ |

- 求二叉树中节点的个数

1 | int numOfTreeNode(TreeNode root){ |

- 求二叉树中叶子节点的个数

1 | int numsOfNoChildNode(TreeNode root){ |

- 求二叉树中第k层节点的个数

1 | int numsOfkLevelTreeNode(TreeNode root,int k){ |

- 判断二叉树是否是平衡二叉树

1 | boolean isBalanced(TreeNode node){ |

- 判断二叉树是否是完全二叉树

1 | boolean isCompleteTreeNode(TreeNode root){ |

- 两个二叉树是否完全相同

1 | boolean isSameTreeNode(TreeNode t1,TreeNode t2){ |

- 两个二叉树是否互为镜像

1 | boolean isMirror(TreeNode t1,TreeNode t2){ |

- 翻转二叉树or镜像二叉树

1 | TreeNode mirrorTreeNode(TreeNode root){ |

- 求两个二叉树的最低公共祖先节点

1 | TreeNode getLastCommonParent(TreeNode root,TreeNode t1,TreeNode t2){ |

- 二叉树的前序遍历

迭代解法

1 | ArrayList<Integer> preOrder(TreeNode root){ |

- 二叉树的中序遍历

1 | ArrayList<Integer> inOrder(TreeNode root){ |

- 二叉树的后序遍历

1 | ArrayList<Integer> postOrder(TreeNode root){ |

- 前序遍历和后序遍历构造二叉树

1 | TreeNode buildTreeNode(int[] preorder,int[] inorder){ |

- 在二叉树中插入节点

1 | TreeNode insertNode(TreeNode root,TreeNode node){ |

- 输入一个二叉树和一个整数,打印出二叉树中节点值的和等于输入整数所有的路径

1 | void findPath(TreeNode r,int i){ |

- 二叉树的搜索区间

给定两个值 k1 和 k2(k1 < k2)和一个二叉查找树的根节点。找到树中所有值在 k1 到 k2 范围内的节点。即打印所有x (k1 <= x <= k2) 其中 x 是二叉查找树的中的节点值。返回所有升序的节点值。

1 | ArrayList<Integer> result; |

- 二叉树的层次遍历

1 | ArrayList<ArrayList<Integer>> levelOrder(TreeNode root){ |

- 二叉树内两个节点的最长距离

二叉树中两个节点的最长距离可能有三种情况:

- 左子树的最大深度+右子树的最大深度为二叉树的最长距离

- 左子树中的最长距离即为二叉树的最长距离

- 右子树种的最长距离即为二叉树的最长距离

因此,递归求解即可

1 | private static class Result{ |

- 不同的二叉树

给出 n,问由 1…n 为节点组成的不同的二叉查找树有多少种?

1 | int numTrees(int n ){ |

- 判断二叉树是否是合法的二叉查找树(BST)

一棵BST定义为:

- 节点的左子树中的值要严格小于该节点的值。

- 节点的右子树中的值要严格大于该节点的值。

- 左右子树也必须是二叉查找树。

一个节点的树也是二叉查找树。

1 | public int lastVal = Integer.MAX_VALUE; |

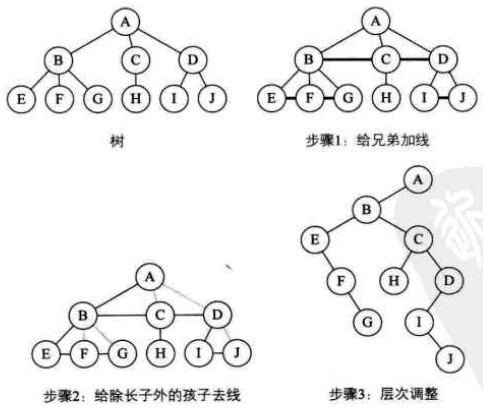

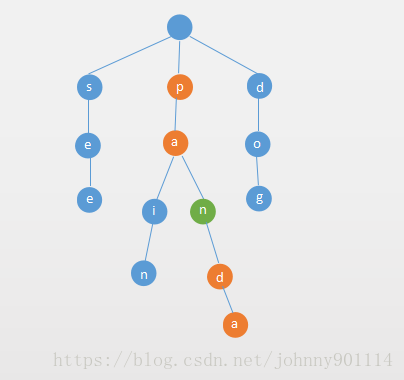

树转换为二叉树

- 加线。在所有兄弟结点之间加一条连线。

- 去线。树中的每个结点,只保留它与第一个孩子结点的连线,删除它与其它孩子结点之间的连线。

- 层次调整。以树的根节点为轴心,将整棵树顺时针旋转一定角度,使之结构层次分明。(注意第一个孩子是结点的左孩子,兄弟转换过来的孩子是结点的右孩子)

森林转换为二叉树

- 把每棵树转换为二叉树。

- 第一棵二叉树不动,从第二棵二叉树开始,依次把后一棵二叉树的根结点作为前一棵二叉树的根结点的右孩子,用线连接起来。

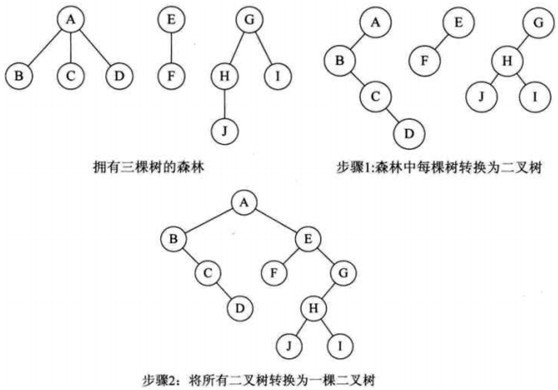

二叉树转换为树

是树转换为二叉树的逆过程。

- 加线。若某结点X的左孩子结点存在,则将这个左孩子的右孩子结点、右孩子的右孩子结点、右孩子的右孩子的右孩子结点…,都作为结点X的孩子。将结点X与这些右孩子结点用线连接起来。

- 去线。删除原二叉树中所有结点与其右孩子结点的连线。

- 层次调整。

二叉树转换为森林

假如一棵二叉树的根节点有右孩子,则这棵二叉树能够转换为森林,否则将转换为一棵树。

- 从根节点开始,若右孩子存在,则把与右孩子结点的连线删除。再查看分离后的二叉树,若其根节点的右孩子存在,则连线删除…。直到所有这些根节点与右孩子的连线都删除为止。

- 将每棵分离后的二叉树转换为树。

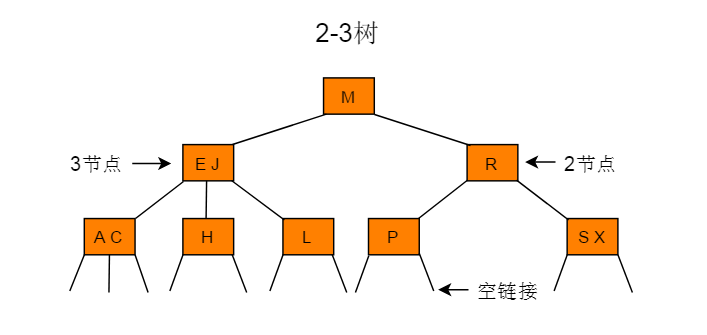

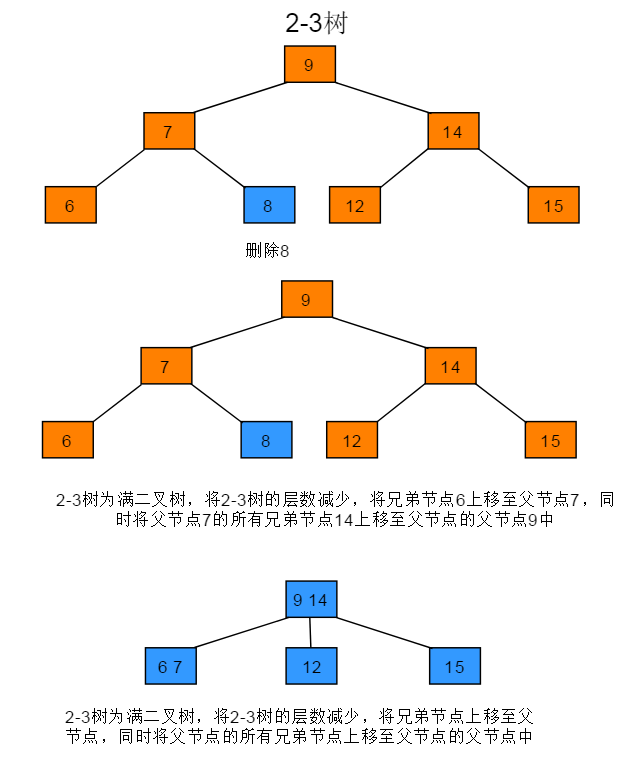

2-3 树

2-3 树的定义如下:

- 2-3 树要么为空要么具有以下性质:

- 对于 2- 节点,和普通的 BST 节点一样,有一个数据域和两个子节点指针,两个子节点要么为空,要么也是一个2-3树,当前节点的数据的值要大于左子树中所有节点的数据,要小于右子树中所有节点的数据。

- 对于 3- 节点,有两个数据域 a 和 b 和三个子节点指针,左子树中所有的节点数据要小于a,中子树中所有节点数据要大于 a 而小于 b ,右子树中所有节点数据要大于 b 。

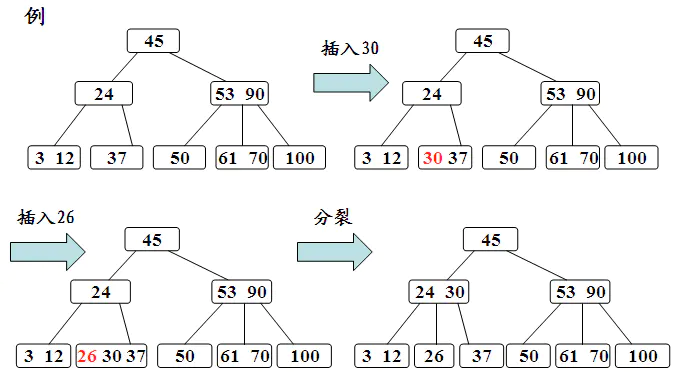

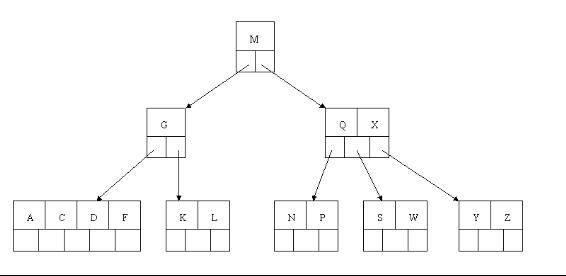

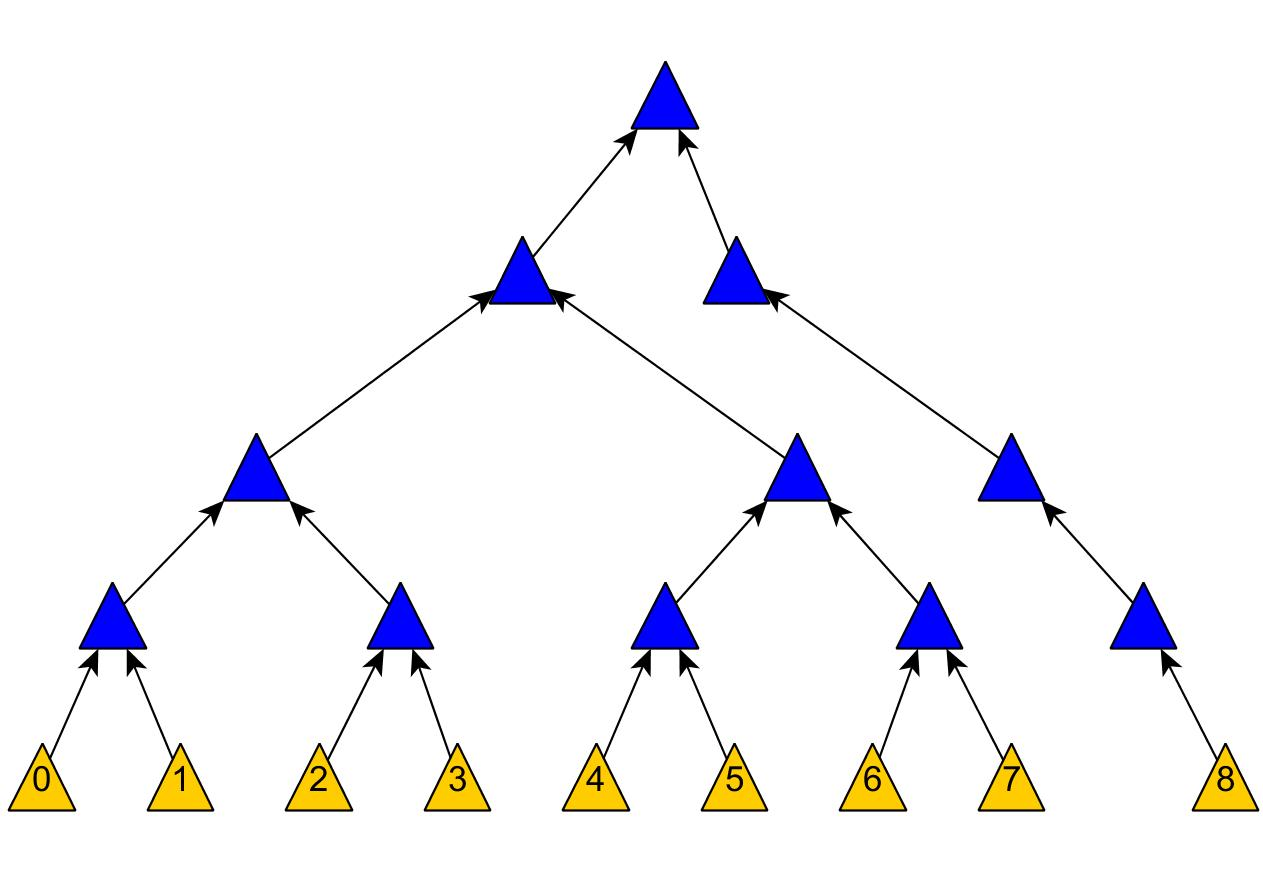

例如图 2.1 所示的树为一棵 2-3 树:

2-3 树性质

性质:

- 对于每一个结点有 1 或者 2 个关键码。

- 当节点有一个关键码的时,节点有 2 个子树。

- 当节点有 2 个关键码时,节点有 3 个子树。

- 所有叶子点都在树的同一层。

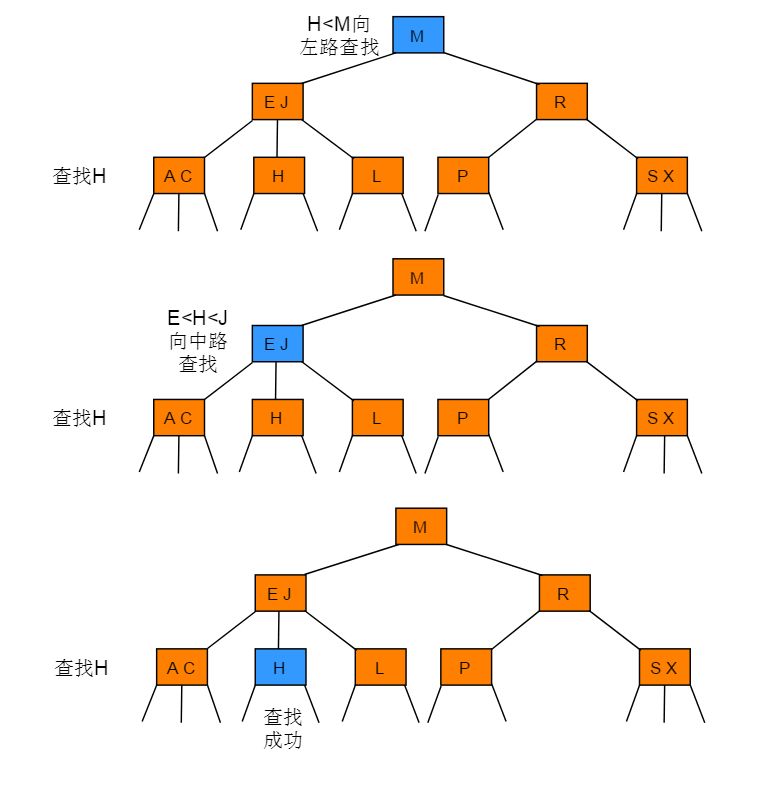

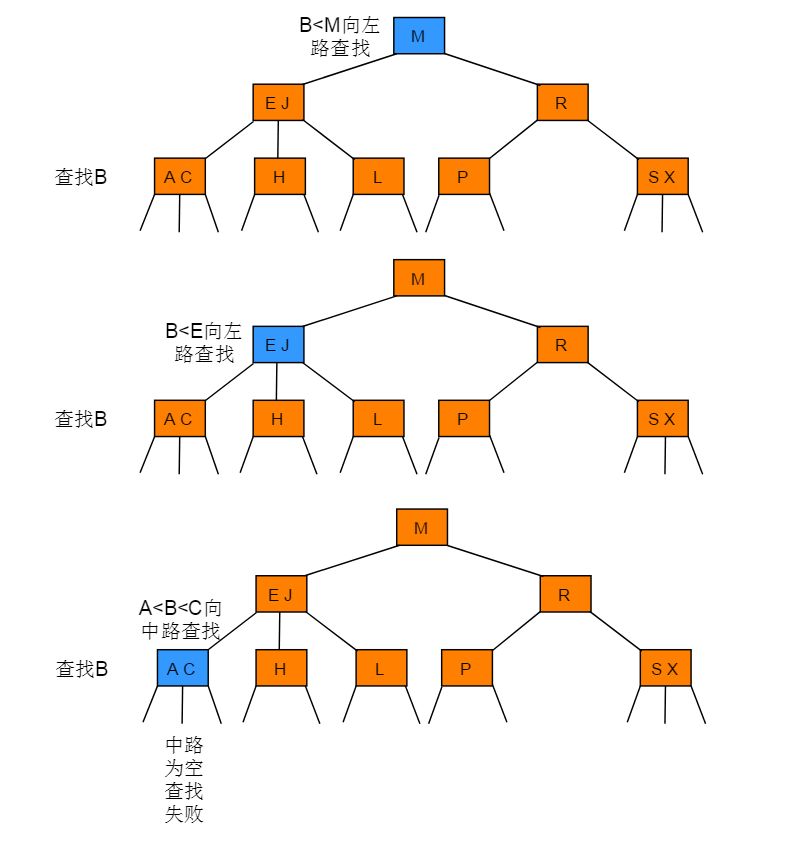

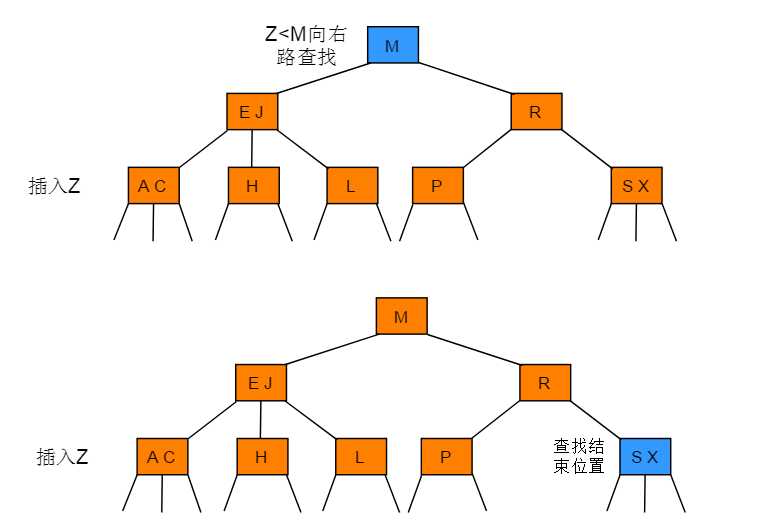

2-3树查找

2-3 树的查找类似二叉搜索树的查找过程,根据键值的比较来决定查找的方向。

例如在图 2.1 所示的 2-3 树中查找键为H的节点:

例如在图 2.1 所示的 2-3 树中查找键为 B 的节点:

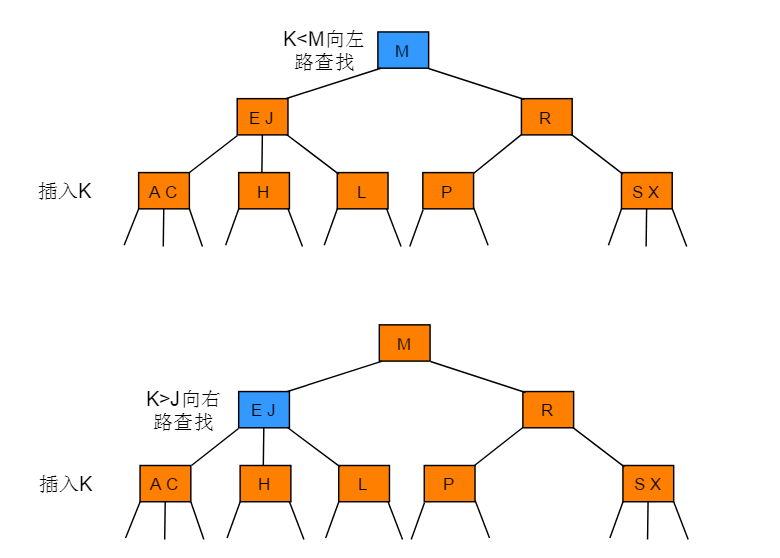

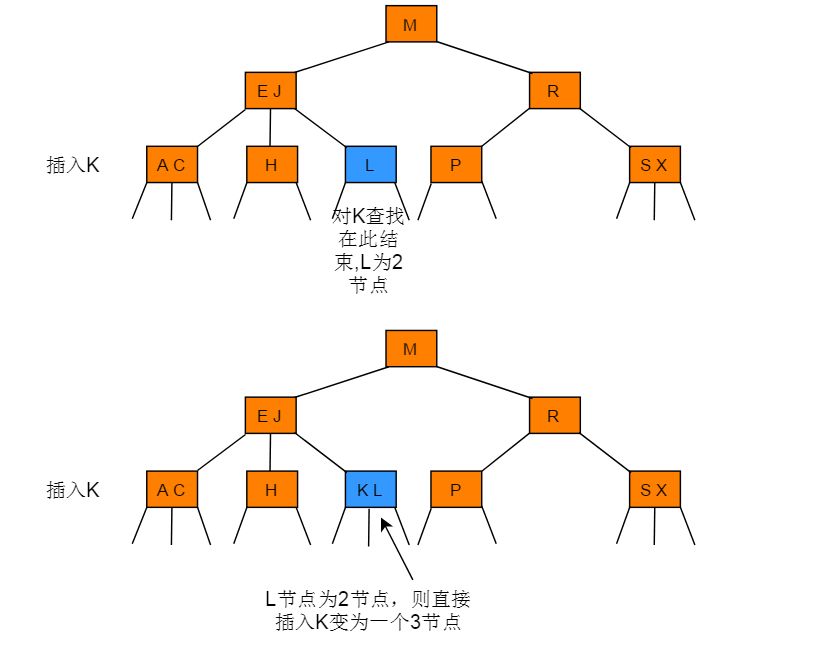

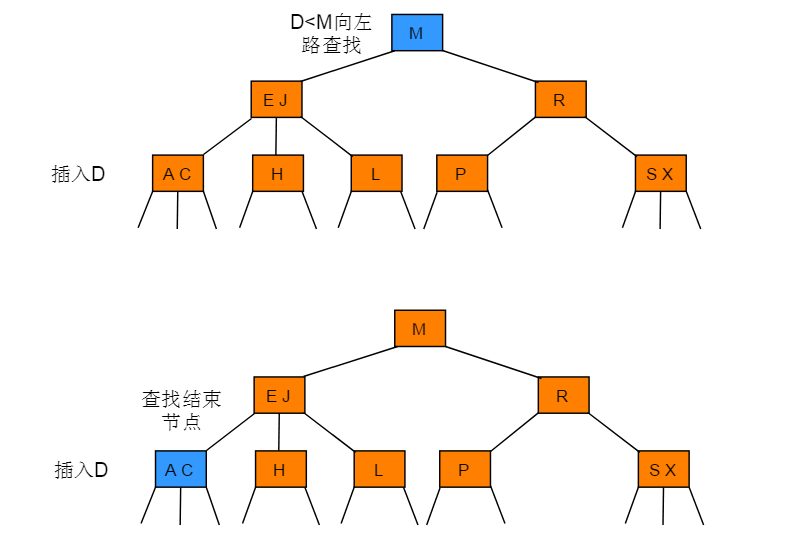

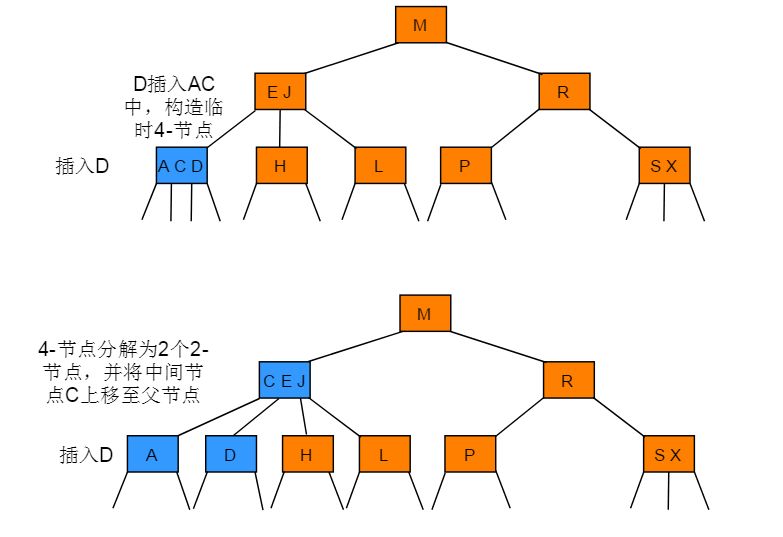

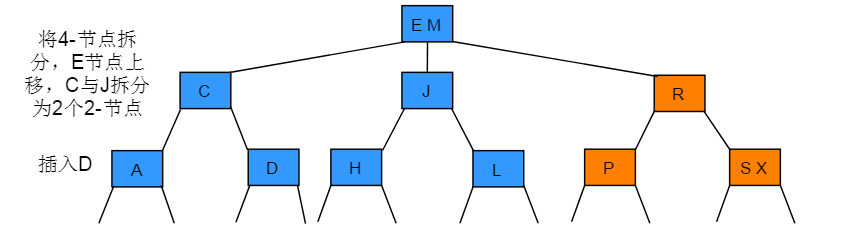

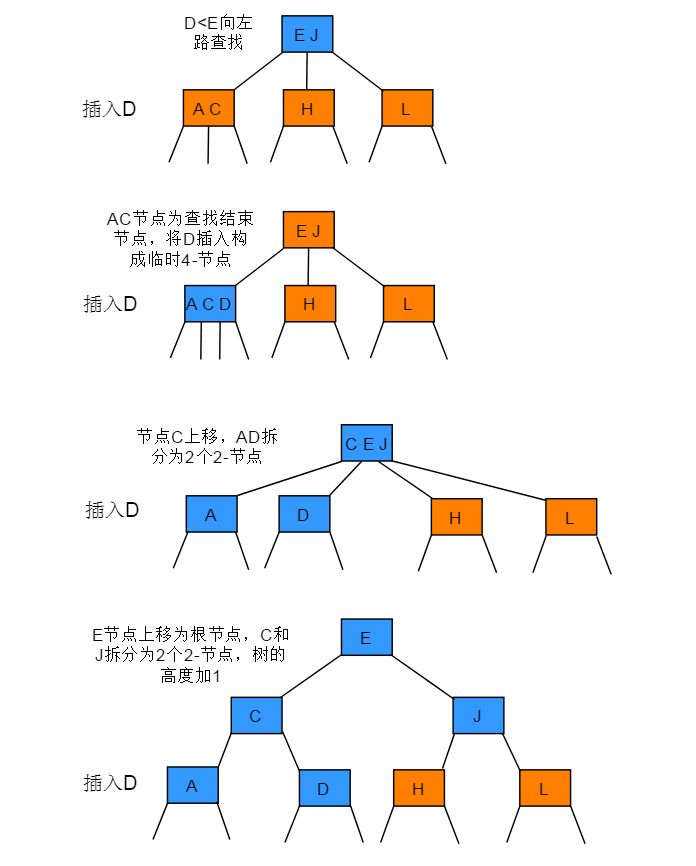

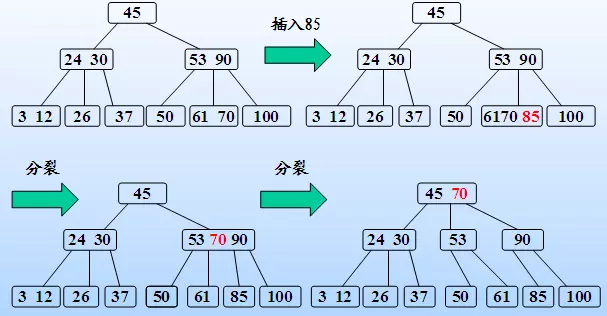

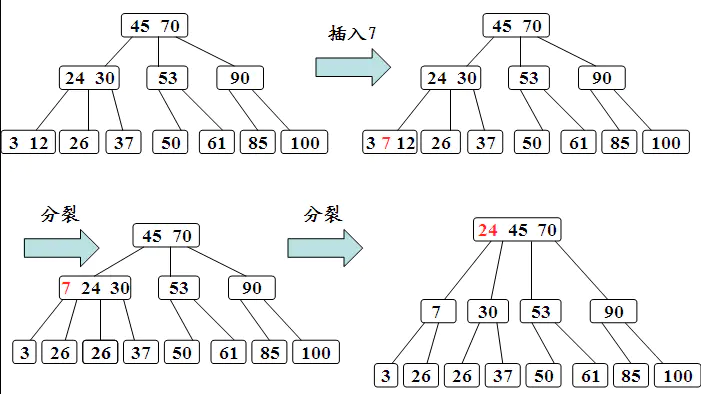

2-3树插入

在树的插入之前需要对带插入的节点进行一次查找操作,若树中已经有此节点则不予插入,若没有查找到此节点则记录未命中查找结束时访问的最后一个节点。

空树的插入最简单,创建一个节点即可,这里不予赘述。

对于非空树插入主要分为 4 种情况:

- 向 2- 节点中插入新节点

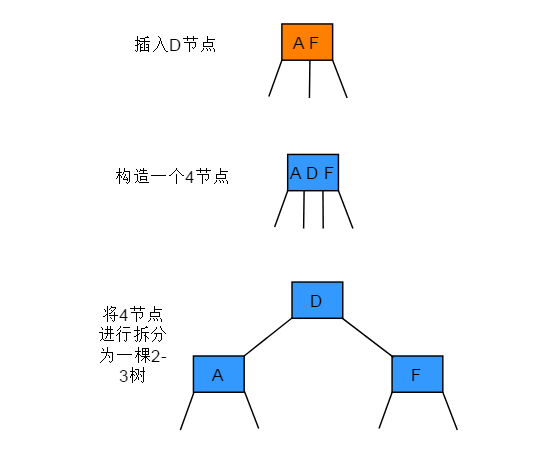

- 向一棵只含 3- 节点的树中插入新节点

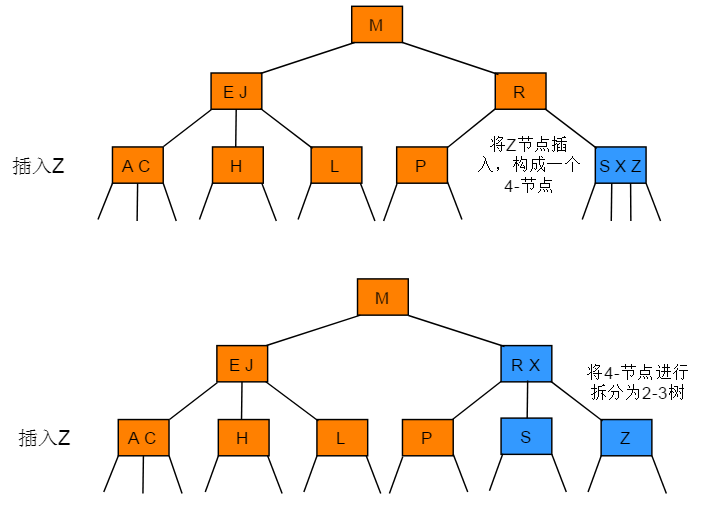

- 向一个父节点为 2- 节点的 3- 节点中插入新节点

- 向一个父节点为 3- 节点的 3- 节点中插入新节点

向2-节点中插入新节点的操作步骤:如果未命中查找结束于一个 2-节点,直接将 2- 节点替换为一个 3- 节点,并将要插入的键保存在其中。

图解:

向一棵只含 3- 节点的树中插入新节点的操作步骤:先临时将新键存入唯一的 3- 节点中,使其成为一个 4- 节点,再将它转化为一颗由 3 个 2- 节点组成的 2-3 树,分解后树高会增加 1。

图解:

向一个父节点为 2- 节点的 3- 节点中插入新节点的操作步骤:先构造一个临时的 4- 节点并将其分解,分解时将中键移动到父节点中(中键移动后,其父节点中的位置由键的大小确定)

图解:

向一个父节点为3-节点的3-节点中插入新节点的操作步骤:插入节点后一直向上分解构造的临时4-节点并将中键移动到更高层双亲节点,直到遇到一个-2节点并将其替换为一个不需要继续分解的3-节点,或是到达树根(3-节点)。

图解:

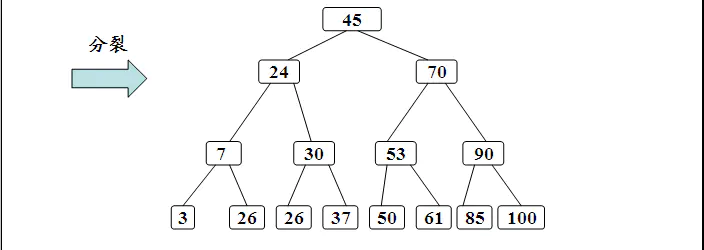

分解根节点

操作步骤:如果从插入节点到根节点的路径上全是3-节点(包含根节点在内),根节点将最终被替换为一个临时的4-节点,将临时的4-节点分解为3个2-节点,分解后树高会增加1。

图解:

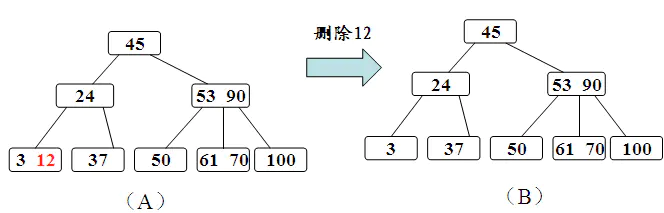

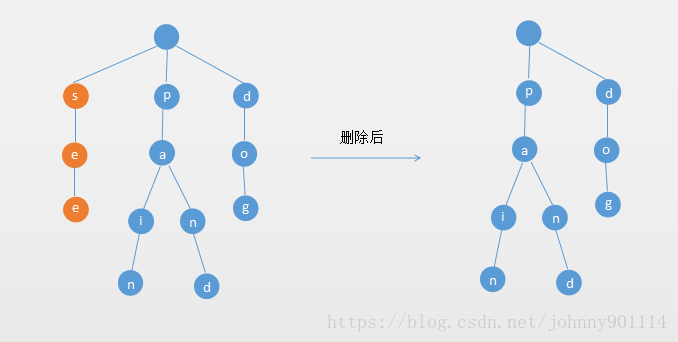

2-3树删除

删除之前,先要对2-3树进行一次命中的查找,查找成功才可以进行删除操作。删除节点大概分为3种情形

- 删除非叶子节点。

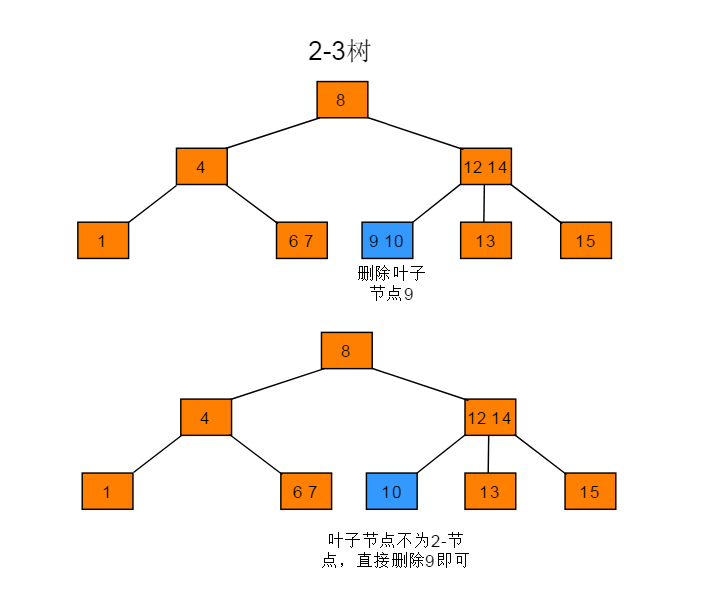

- 删除不为2-节点的叶子节点。

- 删除为2-节点的叶子节点。

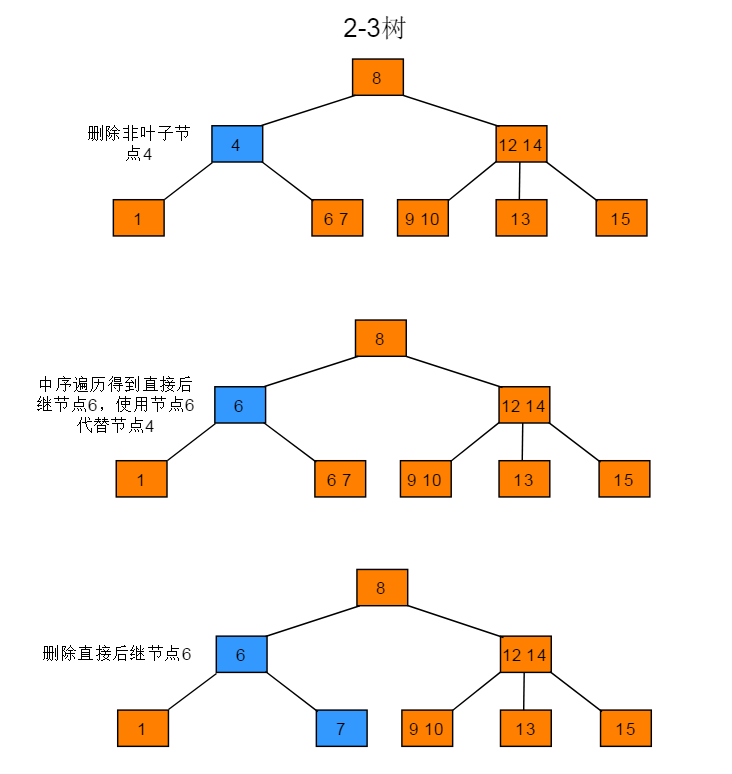

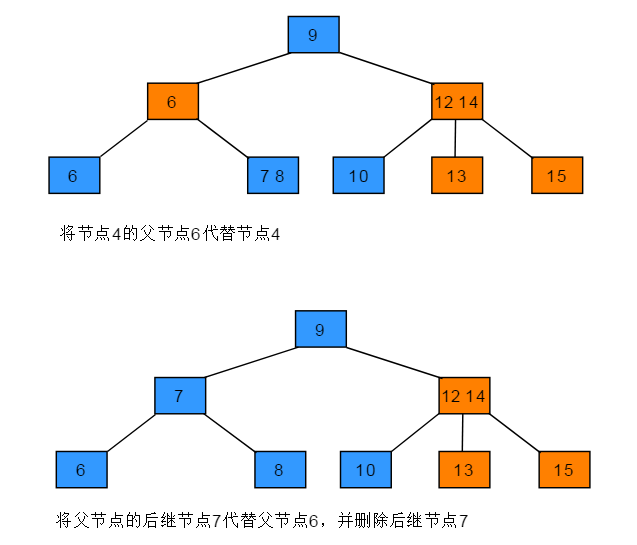

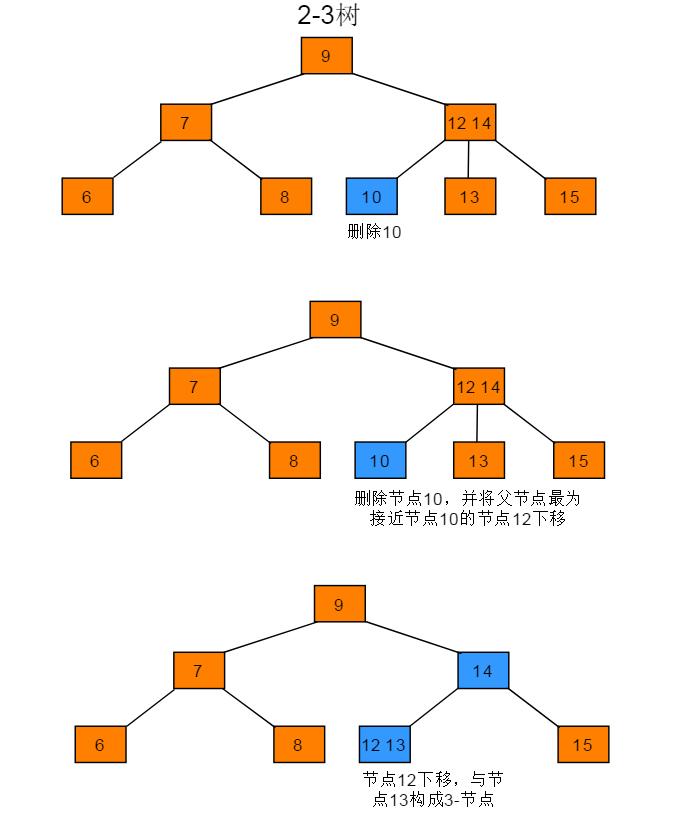

删除非叶子节点

操作步骤:使用中序遍历下的直接后继节点key来覆盖当前待删除节点key,再删除用来覆盖的后继节点key。

图解:

删除不为2-节点的叶子节点操作步骤:删除不为2-节点的叶子节点,直接删除节点即可。**

图解:

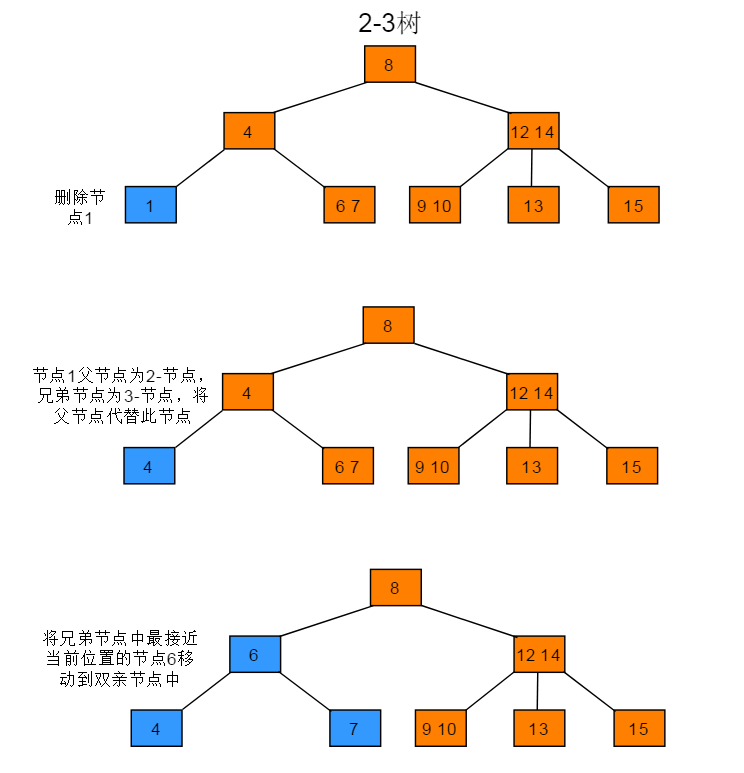

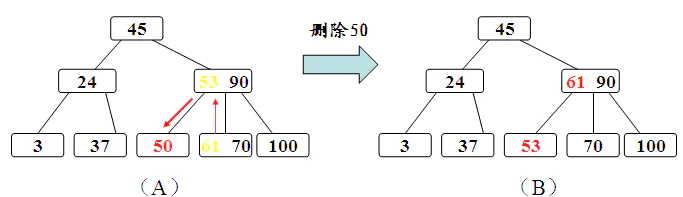

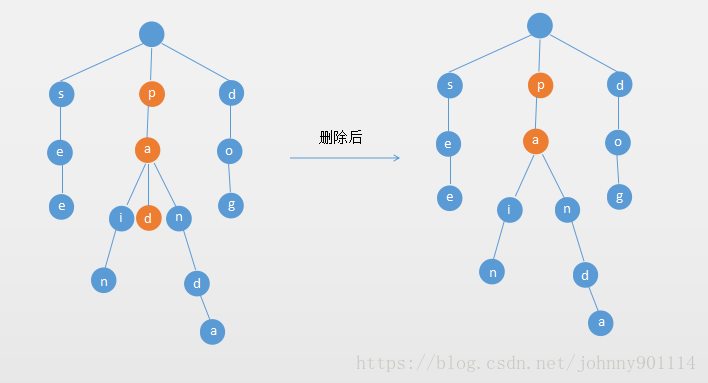

删除为2-节点的叶子节点

删除为2-节点的叶子节点的步骤相对复杂,删除节点后需要做出相应判断,并根据判断结果调整树结构。主要分为四种情形:

删除节点为2-节点,父节点为2-节点,兄弟节点为3-节点的操作步骤:当前待删除节点的父节点是2-节点、兄弟节点是3-节点,将父节点移动到当前待删除节点位置,再将兄弟节点中最接近当前位置的key移动到父节点中。

图解:

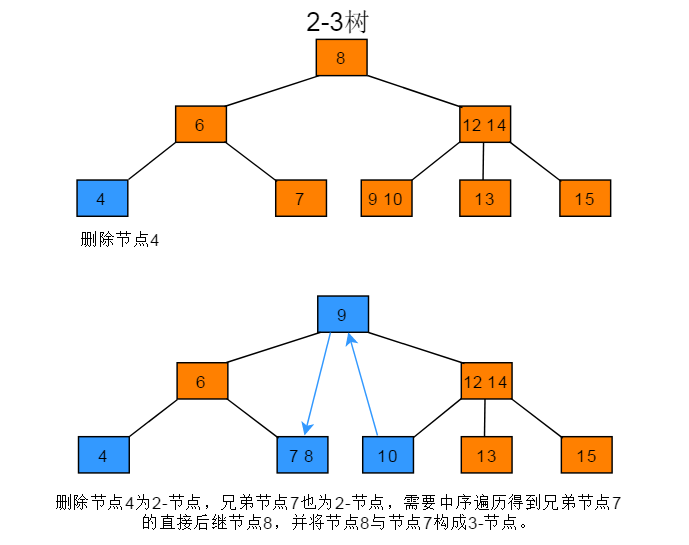

删除节点为2-节点,父节点为2-节点,兄弟节点为2-节点的操作步骤:当前待删除节点的父节点是2-节点、兄弟节点也是2-节点,先通过移动兄弟节点的中序遍历直接后驱到兄弟节点,以使兄弟节点变为3-节点;再进行6.3.1的操作。

图解:

删除节点为2-节点,父节点为3-节点的操作步骤:当前待删除节点的父节点是3-节点,拆分父节点使其成为2-节点,再将再将父节点中最接近的一个拆分key与中孩子合并,将合并后的节点作为当前节点。

图解:

2-3树为满二叉树,删除叶子节点的操作步骤:若2-3树是一颗满二叉树,将2-3树层树减少,并将当前删除节点的兄弟节点合并到父节点中,同时将父节点的所有兄弟节点合并到父节点的父节点中,如果生成了4-节点,再分解4-节点。

图解:

2-3-4树

2-3-4树是对2-3树的概念扩展,包括了4节点的使用。一个4节点中包含小中大三个元素和四个孩子(要么有四个孩子要么没有,不存在其他情况),如果某个4节点有孩子的话,左子树包含小于最小元素的元素;第二子树包含大于最小元素,小于第二元素的元素;第三子树包含大于第二元素,小于最大元素的元素;右子树包含大于最大元素的元素。

总结

先找插入结点,若结点有空(即2-结点),则直接插入。如结点没空(即3-结点),则插入使其临时容纳这个元素,然后分裂此结点,把中间元素移到其父结点中。对父结点亦如此处理。(中键一直往上移,直到找到空位,在此过程中没有空位就先搞个临时的,再分裂。)

2-3树插入算法的根本在于这些变换都是局部的:除了相关的结点和链接之外不必修改或者检查树的其他部分。每次变换中,变更的链接数量不会超过一个很小的常数。所有局部变换都不会影响整棵树的有序性和平衡性。

同时,通过上面树的深度增加的例子,可以看出2-3树和标准二叉树不同,标准的二叉树的的深度是由上到下的增加的,而2-3树的深度生长是由下至上的。

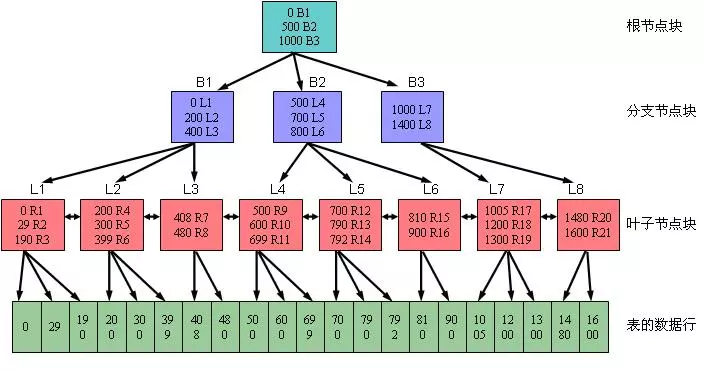

B-树

定义:B-树是一类树,包括B-树、B+树、B*树等,是一棵自平衡的搜索树,它类似普通的平衡二叉树,不同的一点是B-树允许每个节点有更多的子节点。

一个 m 阶的B树满足以下条件:

- 每个结点至多拥有m棵子树;

- 根结点至少拥有两颗子树(存在子树的情况下);

- 除了根结点以外,其余每个分支结点至少拥有 m/2 棵子树;

- 所有的叶结点都在同一层上;

- 有 k 棵子树的分支结点则存在 k-1 个关键码,关键码按照递增次序进行排列;

- 关键字数量需要满足ceil(m/2)-1 <= n <= m-1;

B树上大部分的操作所需要的磁盘存取次数和B树的高度是成正比的,在B树中可以检查多个子结点,由于在一棵树中检查任意一个结点都需要一次磁盘访问,所以B树避免了大量的磁盘访问。

B-树是专门为外部存储器设计的,如磁盘,它对于读取和写入大块数据有良好的性能,所以一般被用在文件系统及数据库中。

定义只需要知道B-树允许每个节点有更多的子节点即可(多叉树)。子节点数量一般在上千,具体数量依赖外部存储器的特性。

先来看看为什么会出现B-树这类数据结构。

传统用来搜索的平衡二叉树有很多,如 AVL 树,红黑树等。这些树在一般情况下查询性能非常好,但当数据非常大的时候它们就无能为力了。原因当数据量非常大时,内存不够用,大部分数据只能存放在磁盘上,只有需要的数据才加载到内存中。一般而言内存访问的时间约为 50 ns,而磁盘在 10 ms 左右。速度相差了近 5 个数量级,磁盘读取时间远远超过了数据在内存中比较的时间。这说明程序大部分时间会阻塞在磁盘 IO 上。那么我们如何提高程序性能?减少磁盘 IO 次数,像 AVL 树,红黑树这类平衡二叉树从设计上无法“迎合”磁盘。

平衡二叉树是通过旋转来保持平衡的,而旋转是对整棵树的操作,若部分加载到内存中则无法完成旋转操作。其次平衡二叉树的高度相对较大为 log n(底数为2),这样逻辑上很近的节点实际可能非常远,无法很好的利用磁盘预读(局部性原理),所以这类平衡二叉树在数据库和文件系统上的选择就被 pass 了。

空间局部性原理:如果一个存储器的某个位置被访问,那么将它附近的位置也会被访问。

我们从“迎合”磁盘的角度来看看B-树的设计。

索引的效率依赖与磁盘 IO 的次数,快速索引需要有效的减少磁盘 IO 次数,如何快速索引呢?索引的原理其实是不断的缩小查找范围,就如我们平时用字典查单词一样,先找首字母缩小范围,再第二个字母等等。平衡二叉树是每次将范围分割为两个区间。为了更快,B-树每次将范围分割为多个区间,区间越多,定位数据越快越精确。那么如果节点为区间范围,每个节点就较大了。所以新建节点时,直接申请页大小的空间(磁盘存储单位是按 block 分的,一般为 512 Byte。磁盘 IO 一次读取若干个 block,我们称为一页,具体大小和操作系统有关,一般为 4 k,8 k或 16 k),计算机内存分配是按页对齐的,这样就实现了一个节点只需要一次 IO。

多叉的好处非常明显,有效的降低了B-树的高度,为底数很大的 log n,底数大小与节点的子节点数目有关,一般一棵B-树的高度在 3 层左右。层数低,每个节点区确定的范围更精确,范围缩小的速度越快(比二叉树深层次的搜索肯定快很多)。上面说了一个节点需要进行一次 IO,那么总 IO 的次数就缩减为了 log n 次。B-树的每个节点是 n 个有序的序列(a1,a2,a3…an),并将该节点的子节点分割成 n+1 个区间来进行索引(X1< a1, a2 < X2 < a3, … , an+1 < Xn < anXn+1 > an)。

点评:B树的每个节点,都是存多个值的,不像二叉树那样,一个节点就一个值,B树把每个节点都给了一点的范围区间,区间更多的情况下,搜索也就更快了,比如:有1-100个数,二叉树一次只能分两个范围,0-50和51-100,而B树,分成4个范围 1-25, 25-50,51-75,76-100一次就能筛选走四分之三的数据。所以作为多叉树的B树是更快的。

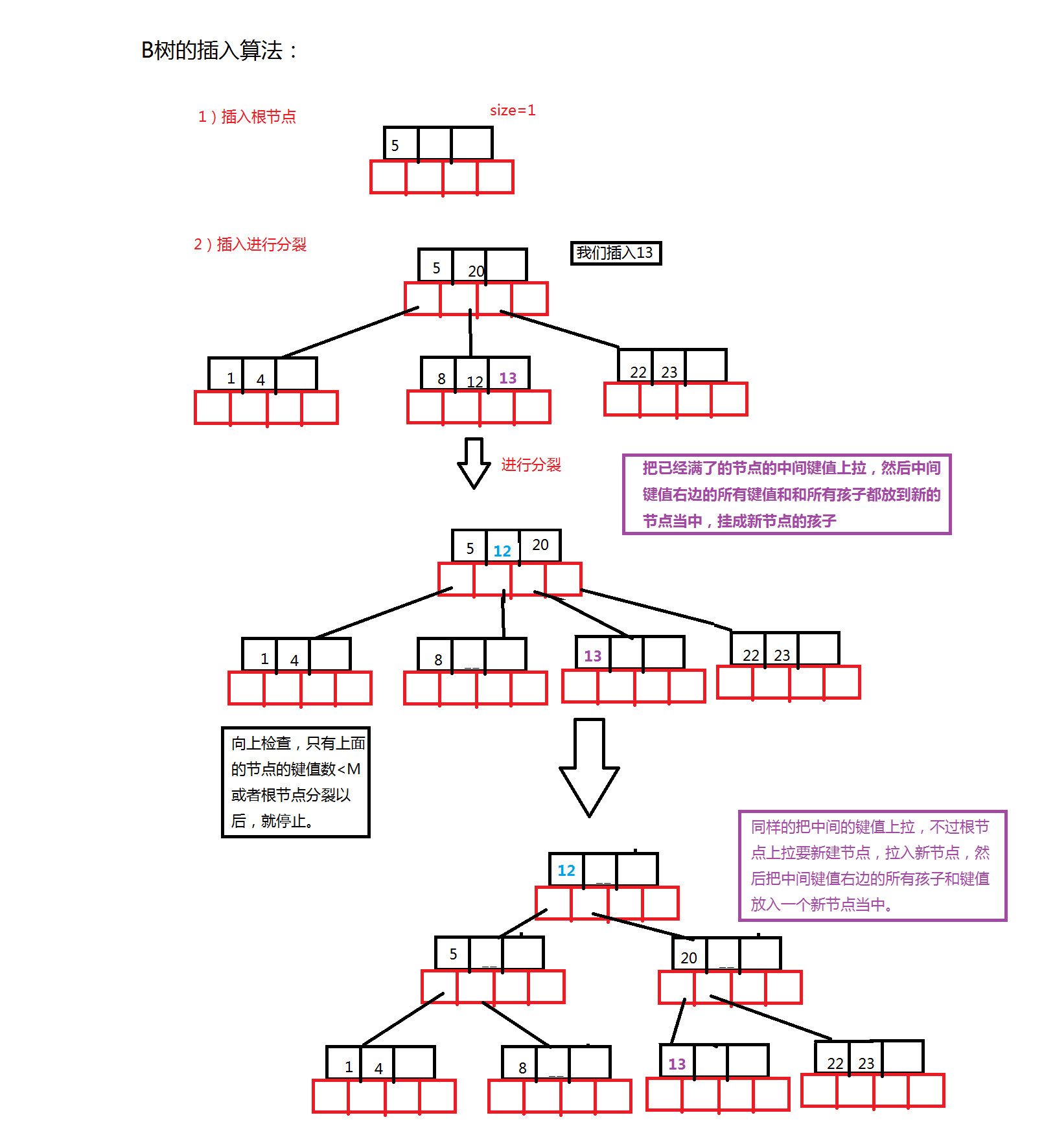

插入

新结点一般插在第h层,通过搜索找到对应的结点进行插入,那么根据即将插入的结点的数量又分为下面几种情况。

如果该结点的关键字个数没有到达m-1个,那么直接插入即可;

如果该结点的关键字个数已经到达了m-1个,那么根据B树的性质显然无法满足,需要将其进行分裂。分裂的规则是该结点分成两半,将中间的关键字进行提升,加入到父亲结点中,但是这又可能存在父亲结点也满员的情况,则不得不向上进行回溯,甚至是要对根结点进行分裂,那么整棵树都加了一层。

其过程如下:

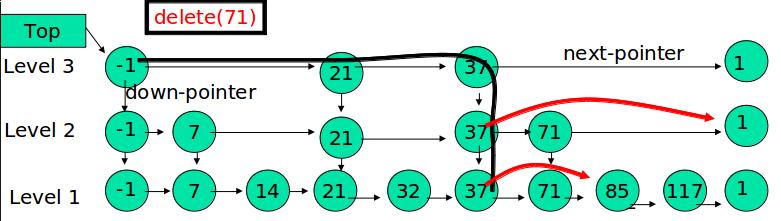

删除

同样的,我们需要先通过搜索找到相应的值,存在则进行删除,需要考虑删除以后的情况,

- 如果该结点拥有关键字数量仍然满足B树性质,则不做任何处理;

- 如果该结点在删除关键字以后不满足B树的性质(关键字没有到达ceil(m/2)-1的数量),则需要向兄弟结点借关键字,这有分为兄弟结点的关键字数量是否足够的情况。

- 如果兄弟结点的关键字足够借给该结点,则过程为将父亲结点的关键字下移,兄弟结点的关键字上移;

- 如果兄弟结点的关键字在借出去以后也无法满足情况,即之前兄弟结点的关键字的数量为ceil(m/2)-1,借的一方的关键字数量为ceil(m/2)-2的情况,那么我们可以将该结点合并到兄弟结点中,合并之后的子结点数量少了一个,则需要将父亲结点的关键字下放,如果父亲结点不满足性质,则向上回溯;

- 其余情况参照BST中的删除。

其过程如下:

B-树是一种多路搜索树(并不是二叉的):

- 定义任意非叶子结点最多只有M个儿子;且M>2;

- 根结点的儿子数为[2, M];

- 除根结点以外的非叶子结点的儿子数为[M/2, M];

- 每个结点存放至少M/2-1(取上整)和至多M-1个关键字;(至少2个关键字)

- 非叶子结点的关键字个数=指向儿子的指针个数-1;

- 非叶子结点的关键字:K[1], K[2], …, K[M-1];且K[i] < K[i+1];

- 非叶子结点的指针:P[1], P[2], …, P[M];其中P[1]指向关键字小于K[1]的子树,P[M]指向关键字大于K[M-1]的子树,其它P[i]指向关键字属于(K[i-1], K[i])的子树;

- 所有叶子结点位于同一层;

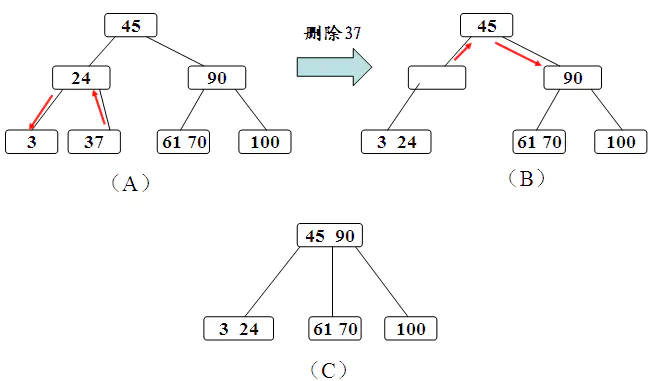

如:(M=3)

来模拟下查找文件29的过程:

- 根据根结点指针找到文件目录的根磁盘块1,将其中的信息导入内存。【磁盘IO操作1次】

- 此时内存中有两个文件名17,35和三个存储其他磁盘页面地址的数据。根据算法我们发现17<29<35,因此我们找到指针p2。

- 根据p2指针,我们定位到磁盘块3,并将其中的信息导入内存。【磁盘IO操作2次】

- 此时内存中有两个文件名26,30和三个存储其他磁盘页面地址的数据。根据算法我们发现26<29<30,因此我们找到指针p2。

- 根据p2指针,我们定位到磁盘块8,并将其中的信息导入内存。【磁盘IO操作3次】

- 此时内存中有两个文件名28,29。根据算法我们查找到文件29,并定位了该文件内存的磁盘地址。

生成从空树开始,逐个插入关键字。但是由于B-树节点关键字必须大于等于[ceil(m/2)-1],所以每次插入一个关键字不是在树中添加一个叶子结点,而是首先在最底层的某个非终端节点中添加一个“关键字”,该结点的关键字不超过m-1,则插入完成;否则要产生结点的“分裂”,将一半数量的关键字元素分裂到新的其相邻右结点中,中间关键字元素上移到父结点中。

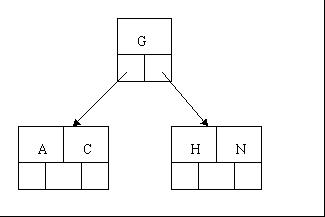

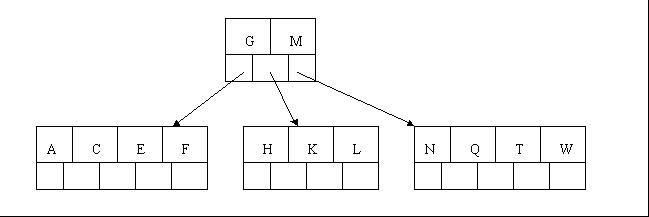

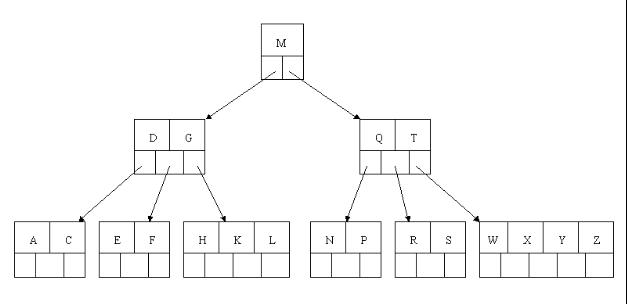

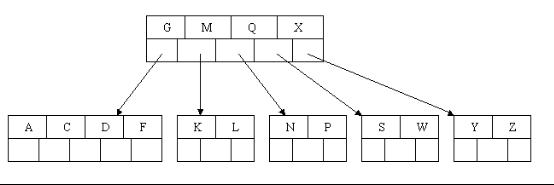

1、咱们通过一个实例来逐步讲解下。插入以下字符字母到一棵空的B 树中(非根结点关键字数小了(小于2个)就合并,大了(超过4个)就分裂):C N G A H E K Q M F W L T Z D P R X Y S,首先,结点空间足够,4个字母插入相同的结点中,如下图:

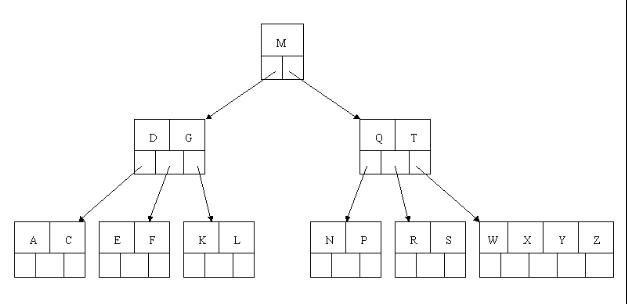

2、当咱们试着插入H时,结点发现空间不够,以致将其分裂成2个结点,移动中间元素G上移到新的根结点中,在实现过程中,咱们把A和C留在当前结点中,而H和N放置新的其右邻居结点中。如下图:

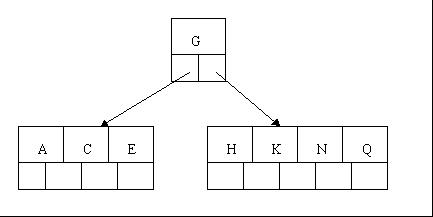

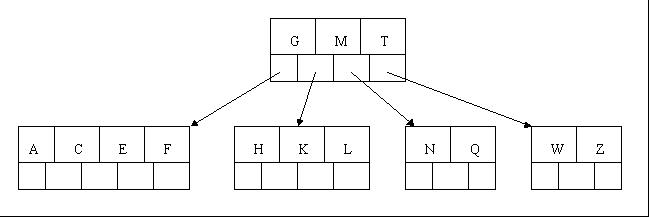

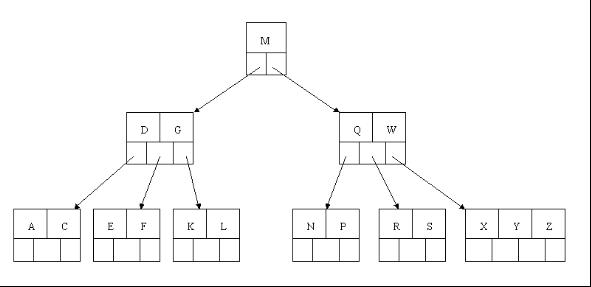

3、当咱们插入E,K,Q时,不需要任何分裂操作

4、插入M需要一次分裂,注意M恰好是中间关键字元素,以致向上移到父节点中

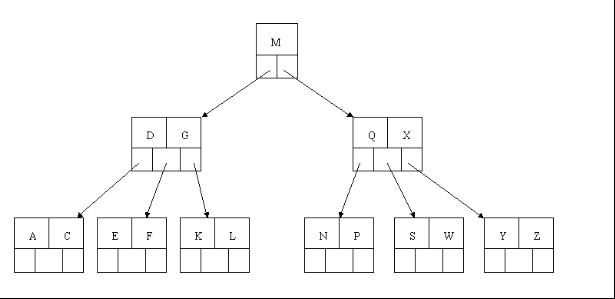

5、插入F,W,L,T不需要任何分裂操作

6、插入Z时,最右的叶子结点空间满了,需要进行分裂操作,中间元素T上移到父节点中,注意通过上移中间元素,树最终还是保持平衡,分裂结果的结点存在2个关键字元素。

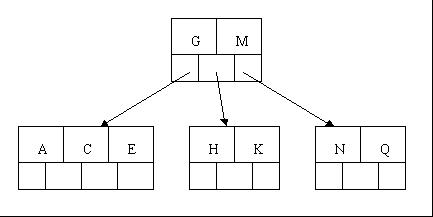

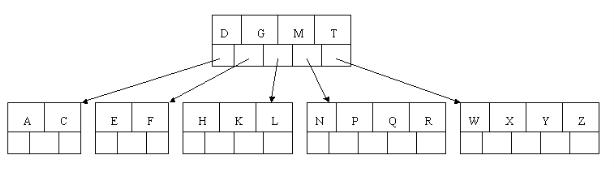

7、插入D时,导致最左边的叶子结点被分裂,D恰好也是中间元素,上移到父节点中,然后字母P,R,X,Y陆续插入不需要任何分裂操作(别忘了,树中至多5个孩子)。

8、最后,当插入S时,含有N,P,Q,R的结点需要分裂,把中间元素Q上移到父节点中,但是情况来了,父节点中空间已经满了,所以也要进行分裂,将父节点中的中间元素M上移到新形成的根结点中,注意以前在父节点中的第三个指针在修改后包括D和G节点中。这样具体插入操作的完成。

删除操作

首先查找B树中需删除的元素,如果该元素在B树中存在,则将该元素在其结点中进行删除,如果删除该元素后,首先判断该元素是否有左右孩子结点,如果有,则上移孩子结点中的某相近元素到父节点中,然后是移动之后的情况;如果没有,直接删除后,移动之后的情况。

删除元素,移动相应元素之后,如果某结点中元素数目(即关键字数)小于ceil(m/2)-1,则需要看其某相邻兄弟结点是否丰满(结点中元素个数大于ceil(m/2)-1)(还记得第一节中关于B树的第5个特性中的c点么?:c)除根结点之外的结点(包括叶子结点)的关键字的个数n必须满足:(ceil(m / 2)-1) <= n <= m-1。m表示最多含有m个孩子,n表示关键字数。在本小节中举的一颗B树的示例中,关键字数n满足:2<=n<=4),如果丰满,则向父节点借一个元素来满足条件;如果其相邻兄弟都刚脱贫,即借了之后其结点数目小于ceil(m/2)-1,则该结点与其相邻的某一兄弟结点进行“合并”成一个结点,以此来满足条件。那咱们通过下面实例来详细了解吧。

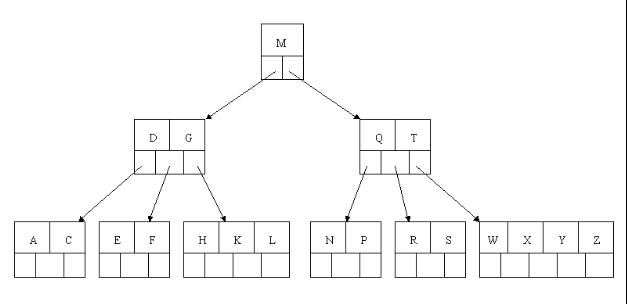

以上述插入操作构造的一棵5阶B树(树中最多含有m(m=5)个孩子,因此关键字数最小为ceil(m / 2)-1=2。还是这句话,关键字数小了(小于2个)就合并,大了(超过4个)就分裂)为例,依次删除H,T,R,E。

1、首先删除元素H,当然首先查找H,H在一个叶子结点中,且该叶子结点元素数目3大于最小元素数目ceil(m/2)-1=2,则操作很简单,咱们只需要移动K至原来H的位置,移动L至K的位置(也就是结点中删除元素后面的元素向前移动)

2、下一步,删除T,因为T没有在叶子结点中,而是在中间结点中找到,咱们发现他的继承者W(字母升序的下个元素),将W上移到T的位置,然后将原包含W的孩子结点中的W进行删除,这里恰好删除W后,该孩子结点中元素个数大于2,无需进行合并操作。

3、下一步删除R,R在叶子结点中,但是该结点中元素数目为2,删除导致只有1个元素,已经小于最小元素数目ceil(5/2)-1=2,而由前面我们已经知道:如果其某个相邻兄弟结点中比较丰满(元素个数大于ceil(5/2)-1=2),则可以向父结点借一个元素,然后将最丰满的相邻兄弟结点中上移最后或最前一个元素到父节点中(有没有看到红黑树中左旋操作的影子?),在这个实例中,右相邻兄弟结点中比较丰满(3个元素大于2),所以先向父节点借一个元素W下移到该叶子结点中,代替原来S的位置,S前移;然后X在相邻右兄弟结点中上移到父结点中,最后在相邻右兄弟结点中删除X,后面元素前移。

4、最后一步删除E,删除后会导致很多问题,因为E所在的结点数目刚好达标,刚好满足最小元素个数(ceil(5/2)-1=2),而相邻的兄弟结点也是同样的情况,删除一个元素都不能满足条件,所以需要该节点与某相邻兄弟结点进行合并操作;首先移动父结点中的元素(该元素在两个需要合并的两个结点元素之间)下移到其子结点中,然后将这两个结点进行合并成一个结点。所以在该实例中,咱们首先将父节点中的元素D下移到已经删除E而只有F的结点中,然后将含有D和F的结点和含有A,C的相邻兄弟结点进行合并成一个结点。

5、也许你认为这样删除操作已经结束了,其实不然,在看看上图,对于这种特殊情况,你立即会发现父节点只包含一个元素G,没达标(因为非根节点包括叶子结点的关键字数n必须满足于2=<n<=4,而此处的n=1),这是不能够接受的。如果这个问题结点的相邻兄弟比较丰满,则可以向父结点借一个元素。假设这时右兄弟结点(含有Q,X)有一个以上的元素(Q右边还有元素),然后咱们将M下移到元素很少的子结点中,将Q上移到M的位置,这时,Q的左子树将变成M的右子树,也就是含有N,P结点被依附在M的右指针上。所以在这个实例中,咱们没有办法去借一个元素,只能与兄弟结点进行合并成一个结点,而根结点中的唯一元素M下移到子结点,这样,树的高度减少一层。

为了进一步详细讨论删除的情况,再举另外一个实例:这里是一棵不同的5序B树,那咱们试着删除C

于是将删除元素C的右子结点中的D元素上移到C的位置,但是出现上移元素后,只有一个元素的结点的情况。

又因为含有E的结点,其相邻兄弟结点才刚脱贫(最少元素个数为2),不可能向父节点借元素,所以只能进行合并操作,于是这里将含有A,B的左兄弟结点和含有E的结点进行合并成一个结点。

这样又出现只含有一个元素F结点的情况,这时,其相邻的兄弟结点是丰满的(元素个数为3>最小元素个数2),这样就可以想父结点借元素了,把父结点中的J下移到该结点中,相应的如果结点中J后有元素则前移,然后相邻兄弟结点中的第一个元素(或者最后一个元素)上移到父节点中,后面的元素(或者前面的元素)前移(或者后移);注意含有K,L的结点以前依附在M的左边,现在变为依附在J的右边。这样每个结点都满足B树结构性质。

从以上操作可看出:除根结点之外的结点(包括叶子结点)的关键字的个数n满足:(ceil(m / 2)-1) <= n <= m-1,即2<=n<=4。这也佐证了咱们之前的观点。删除操作完。

B-树的搜索,从根结点开始,对结点内的关键字(有序)序列进行二分查找,如果命中则结束,否则进入查询关键字所属范围的儿子结点;重复,直到所对应的儿子指针为空,或已经是叶子结点;

B-树的特性:

- 关键字集合分布在整颗树中;

- 任何一个关键字出现且只出现在一个结点中;

- 搜索有可能在非叶子结点结束;

- 其搜索性能等价于在关键字全集内做一次二分查找;

- 自动层次控制;

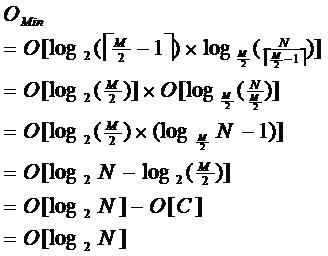

由于限制了除根结点以外的非叶子结点,至少含有M/2个儿子,确保了结点的至少利用率,其最底搜索性能为:

其中,M为设定的非叶子结点最多子树个数,N为关键字总数;所以B-树的性能总是等价于二分查找(与M值无关),也就没有B树平衡的问题;由于M/2的限制,在插入结点时,如果结点已满,需要将结点分裂为两个各占M/2的结点;删除结点时,需将两个不足M/2的兄弟结点合并;

B+树

B+树是B-树的变体,也是一种多路搜索树:

- 其定义基本与B-树同,除了:

- 非叶子结点的子树指针与关键字个数相同;

- 非叶子结点的子树指针P[i],指向关键字值属于[K[i], K[i+1])的子树(B-树是开区间);

- 为所有叶子结点增加一个链指针;

- 所有关键字都在叶子结点出现;

B+的搜索与B-树也基本相同,区别是B+树只有达到叶子结点才命中(B-树可以在非叶子结点命中),其性能也等价于在关键字全集做一次二分查找。B+树的主要优点:非终端结点仅仅起高层索引作用,而B树非终端结点的关键字除作子树分界外,本身还是实际记录的有效关键字(含记录指针),因此相同的结点空间,B+树可以设计的阶树比B树大,相同的索引,B+树的索引层数比B树少,因此检索速度比B树快。此外,B+树叶子结点包含完整的索引信息,可以较方便地表示文件的稀疏索引。最后,B+树的检索、插入和删除都在叶子结点进行,比B树相对简单。

B+的特性:

- 所有关键字都出现在叶子结点的链表中(稠密索引),且链表中的关键字恰好是有序的;

- 不可能在非叶子结点命中;

- 非叶子结点相当于是叶子结点的索引(稀疏索引),叶子结点相当于是存储(关键字)数据的数据层;

- 更适合文件索引系统;

B树和B+树的区别是由于B+树和B具有这不同的存储结构所造成的区别,以一个m阶树为例。

- 关键字的数量不同;B+树中分支结点有m个关键字,其叶子结点也有m个,其关键字只是起到了一个索引的作用,但是B树虽然也有m个子结点,但是其只拥有m-1个关键字。

- 存储的位置不同;B+树中的数据都存储在叶子结点上,也就是其所有叶子结点的数据组合起来就是完整的数据,但是B树的数据存储在每一个结点中,并不仅仅存储在叶子结点上。

- 分支结点的构造不同;B+树的分支结点仅仅存储着关键字信息和儿子的指针(这里的指针指的是磁盘块的偏移量),也就是说内部结点仅仅包含着索引信息。

- 查询不同;B树在找到具体的数值以后,则结束,而B+树则需要通过索引找到叶子结点中的数据才结束,也就是说B+树的搜索过程中走了一条从根结点到叶子结点的路径。

B*树

是B+树的变体,在B+树的非根和非叶子结点再增加指向兄弟的指针;

B*树定义了非叶子结点关键字个数至少为(2/3)*M,即块的最低使用率为2/3(代替B+树的1/2);

B+树的分裂:当一个结点满时,分配一个新的结点,并将原结点中1/2的数据复制到新结点,最后在父结点中增加新结点的指针;B+树的分裂只影响原结点和父结点,而不会影响兄弟结点,所以它不需要指向兄弟的指针;

B*树的分裂:当一个结点满时,如果它的下一个兄弟结点未满,那么将一部分数据移到兄弟结点中,再在原结点插入关键字,最后修改父结点中兄弟结点的关键字(因为兄弟结点的关键字范围改变了);如果兄弟也满了,则在原结点与兄弟结点之间增加新结点,并各复制1/3的数据到新结点,最后在父结点增加新结点的指针;

所以,B*树分配新结点的概率比B+树要低,空间使用率更高;

实现

根据B树的特点,我们首先可以写出B树的整体的结构。

B树结构

B树的结构我们定义需要参考规则,我们首先是需要给出保存键值的一个数组,这个数组的大小取决与我们定义的M,然后我们根据规则,可以得到一个保存M+1个子的一个数组,然后当然为了方便访问,parent指针,然后要有一个记录每个节点中键值个数的一个size。

所以定义如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20template <typename K,int M>

struct BTreeNode

{

K _keys[M]; //用来保存键值。

BTreeNode<K, M>* _sub[M + 1]; //用来保存子。

BTreeNode<K, M>* _parent;

size_t _size;

BTreeNode()

:_parent(NULL)

, _size(0)

{

int i = 0;

for ( i = 0; i < M; i++)

{

_keys[i] = K();

_sub[i] = K();

}

_sub[i] = K();

}

};

B树的查找

对于AVL,BST,红黑树,B树这些高级的数据结构而言,查找算法是非常重要的。我们首先确定返回值,对于这种关于key和key-value的数据结构,参考map和set,我们让它返回一个pair的一个结构体。

pair结构体的定义在std中是1

2

3

4

5

6template<typename K,typename V>

struct pair

{

K key;

V value;

}

我们只需要让这个里面的value变为bool值,value返回以后说明的是存不存就可以了。

接下来的思路就是从根节点进行和这个节点当中的每一个key比较,如果=那么就返回找到了,如果小于,那么就到这个节点左面的子节点中找,如果大了,就继续向后面的键值进行查找。如果相等那么就返回。

示例代码:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43pair <Node*, int> Find(const K &key)

{

Node* cur = _root;

Node* parent = NULL;

while (cur)

{

size_t i = 0;

while (i < cur->_size)

{

//如果小于当前,向后

if (cur->_keys[i] < key)

{

i++;

}

//如果大于,

else if (cur->_keys[i]>key)

{

cur = cur->_sub[i];

parent = cur;

break;

}

//相等,返回这个节点

else

{

return pair<Node *, int>(NULL, -1);

}

}

if (key > cur->_sub[i + 1])

{

cur = cur->_sub[i];

}

//为了防止出现我返回空指针操作,如果是空指针,那么就返回父亲

if (cur != NULL && i == cur->_size)

{

parent = cur;

cur = cur->_sub[i];

}

}

return pair<Node *, int>(parent, 1);

}

B树的插入

示例代码:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128bool Insert(const K &key)

{

//首先来考虑空树的情况

if (_root == NULL)

{

//给这个节点中添加key,并且让size++。

_root = new Node;

_root->_keys[0] = key;

_root->_size++;

return true;

}

//使用通用的key-value结构体来保存找到的key所在的节点。

pair<Node*,int > ret=Find(key);

//在这里来看这个节点是否存在,存在就直接return false。

if (ret.second == -1)

{

return false;

}

Node* cur = ret.first;

K newKey = key;

Node *sub = NULL;

//此时表示考虑插入。

while (1)

{

//向cur里面进行插入,如果没满插入,满了就进行分裂。

InsetKey(cur, newKey, sub);

//小于M,这样就可以直接插入

if (cur->_size < M)

{

return true;

}

//如果==M,那么就应该进行分裂

//首先找到中间的节点

size_t mid = cur->_size / 2;

//创建一个节点,用来保存中间节点右边所有的节点和子节点。

Node * tmp = new Node;

size_t j = 0;

//进行移动sub以及所有的子接点。

for (size_t i = mid + 1; i < cur->_size; i++)

{

tmp->_keys[j] = cur->_keys[i];

cur->_keys[i] = K();

cur->_size--;

tmp->_size++;

j++;

}

//移动子串

for (j = 0; j < tmp->_size + 1; j++)

{

tmp->_sub[j] = cur->_sub[mid + 1 + j];

if (tmp->_sub[j])

{

tmp->_sub[j]->_parent = tmp;

}

cur->_sub[mid + 1 + j] = NULL;

}

//进行其他的移动

//分裂的条件就是要么分裂根,要么就是分裂子节点,要么就是所在节点的节点数小于M。

//考虑根分裂,分裂的时候创建节点,然后把中间节点上拉,记得要更改最后的parent

if (cur->_parent == NULL)

{

_root = new Node();

_root->_keys[0] = cur->_keys[mid];

cur->_keys[mid] = K();

cur->_size--;

_root->_size++;

_root->_sub[0] = cur;

cur->_parent = _root;

_root->_sub[1] = tmp;

tmp->_parent = _root;

return true;

}

//分裂如果不是根节点,那么就把mid节点插入到上一层节点中,然后看上一层节点是否要分裂。注意修改cur和sub

else

{

newKey = cur->_keys[mid];

cur->_keys[mid] = K();

cur->_size--;

cur = cur->_parent;

sub = tmp;

sub->_parent = cur;

}

}

}

void InsetKey(Node* cur, const K &key, Node* sub)

{

int i = cur->_size - 1;

while (i>=0)

{

//进行插入

if (key > cur->_keys[i])

{

break;

}

//进行移动

else

{

cur->_keys[i + 1] = cur->_keys[i];

cur->_sub[i + 2] = cur->_sub[i + 1];

}

i--;

}

//进行插入

cur->_keys[i + 1] = key;

//插入子

cur->_sub[i + 2] = sub;

//如果没满,只需要对size++;

if (cur->_size < M)

{

cur->_size++;

}

}

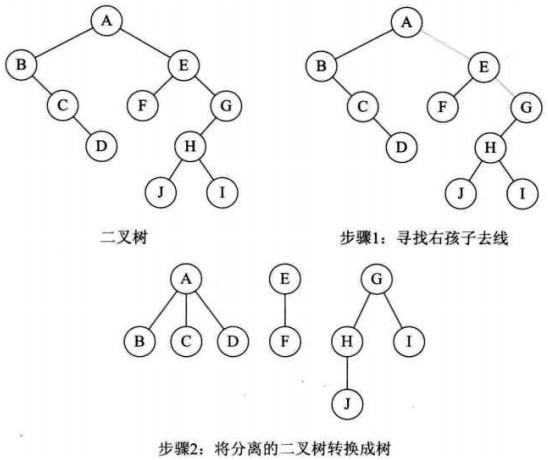

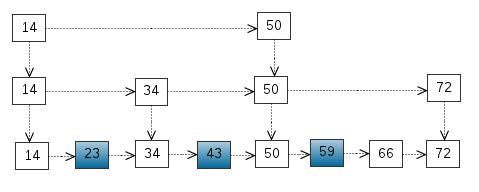

深入浅出分析LSM树

LSM树数据结构定义

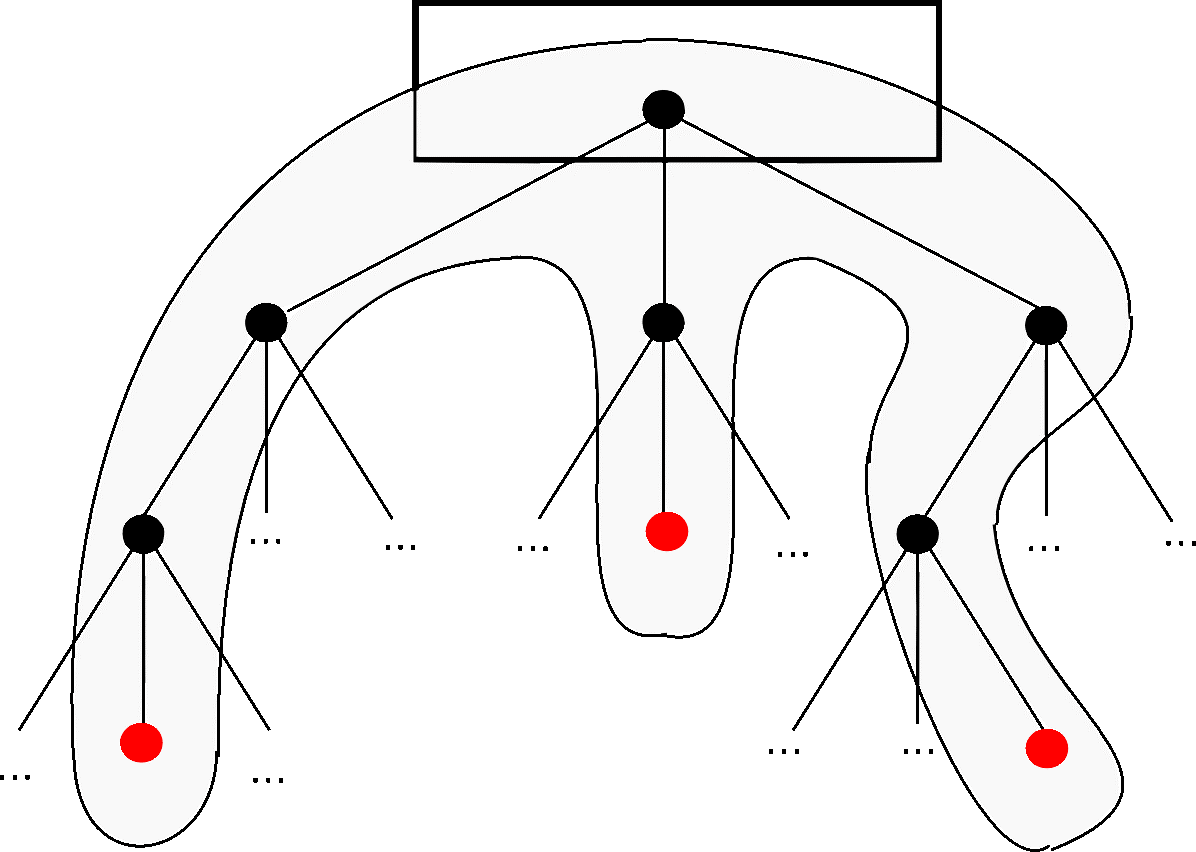

LSM树并没有一种固定死的实现方式,更多的是一种将:

“磁盘顺序写” + “多个树(状数据结构)” + “冷热(新老)数据分级” + “定期归并” + “非原地更新”这几种特性统一在一起的思想。

为了方便后续的讲解分析,我们尝试先对LSM树做一个定义。

LSM树的定义:

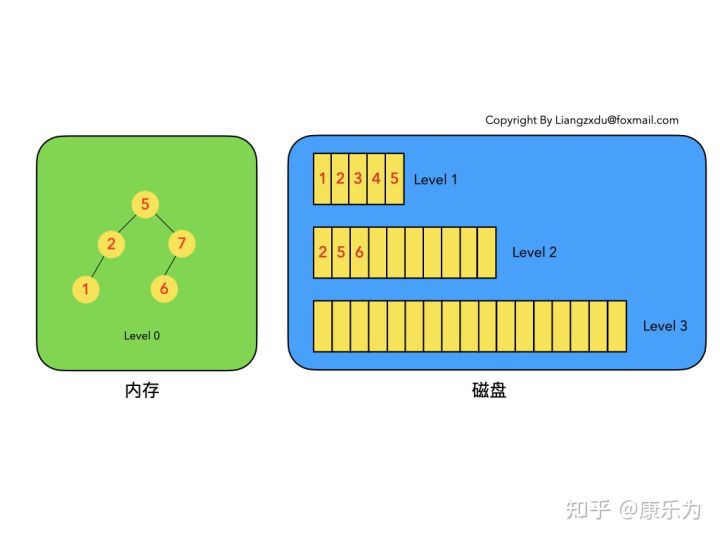

- LSM树是一个横跨内存和磁盘的,包含多颗”子树”的一个森林。

- LSM树分为Level 0,Level 1,Level 2 … Level n 多颗子树,其中只有Level 0在内存中,其余Level 1-n在磁盘中。

- 内存中的Level 0子树一般采用排序树(红黑树/AVL树)、跳表或者TreeMap等这类有序的数据结构,方便后续顺序写磁盘。

- 磁盘中的Level 1-n子树,本质是数据排好序后顺序写到磁盘上的文件,只是叫做树而已。

- 每一层的子树都有一个阈值大小,达到阈值后会进行合并,合并结果写入下一层。

- 只有内存中数据允许原地更新,磁盘上数据的变更只允许追加写,不做原地更新。

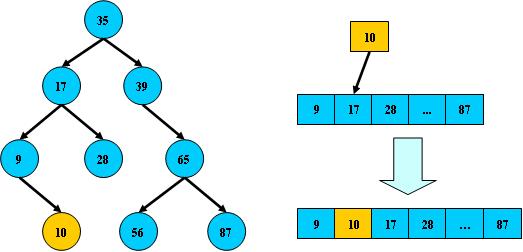

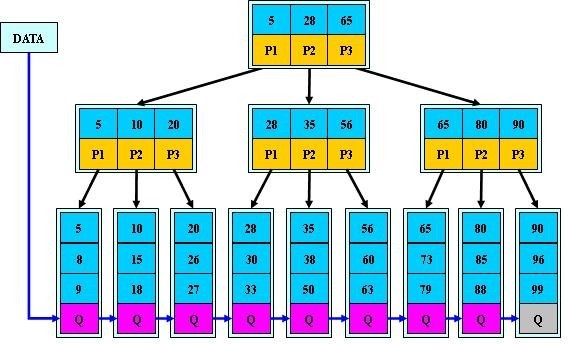

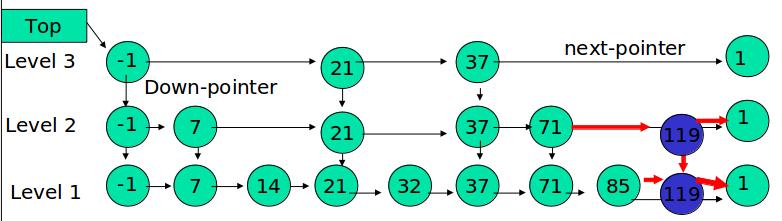

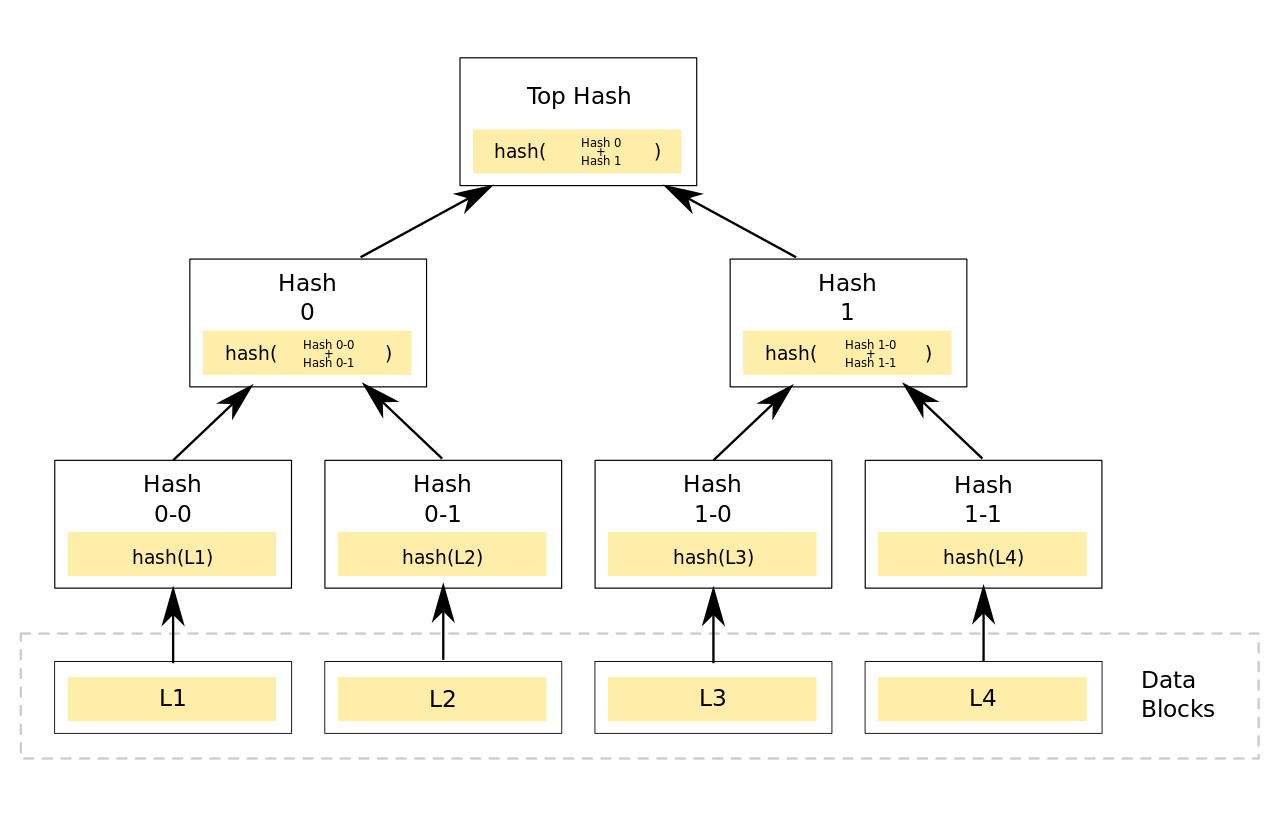

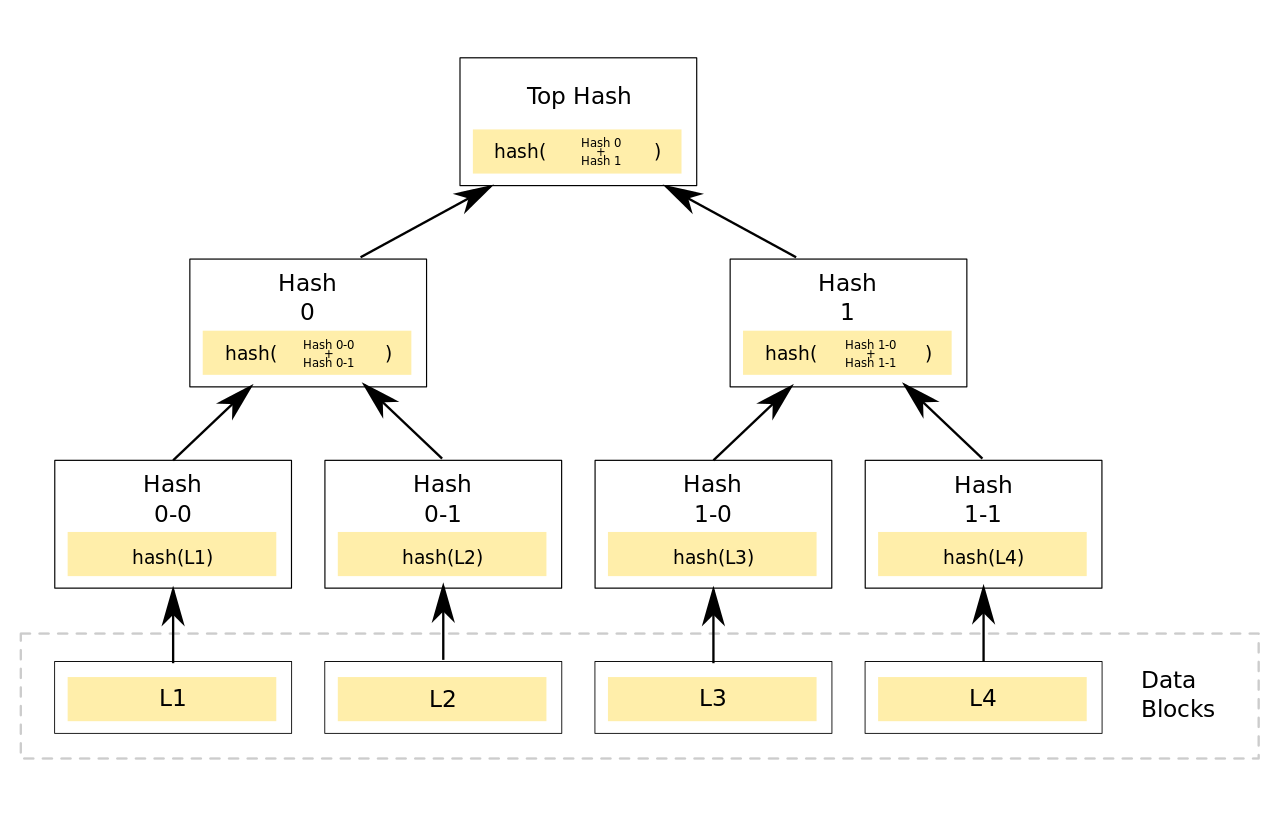

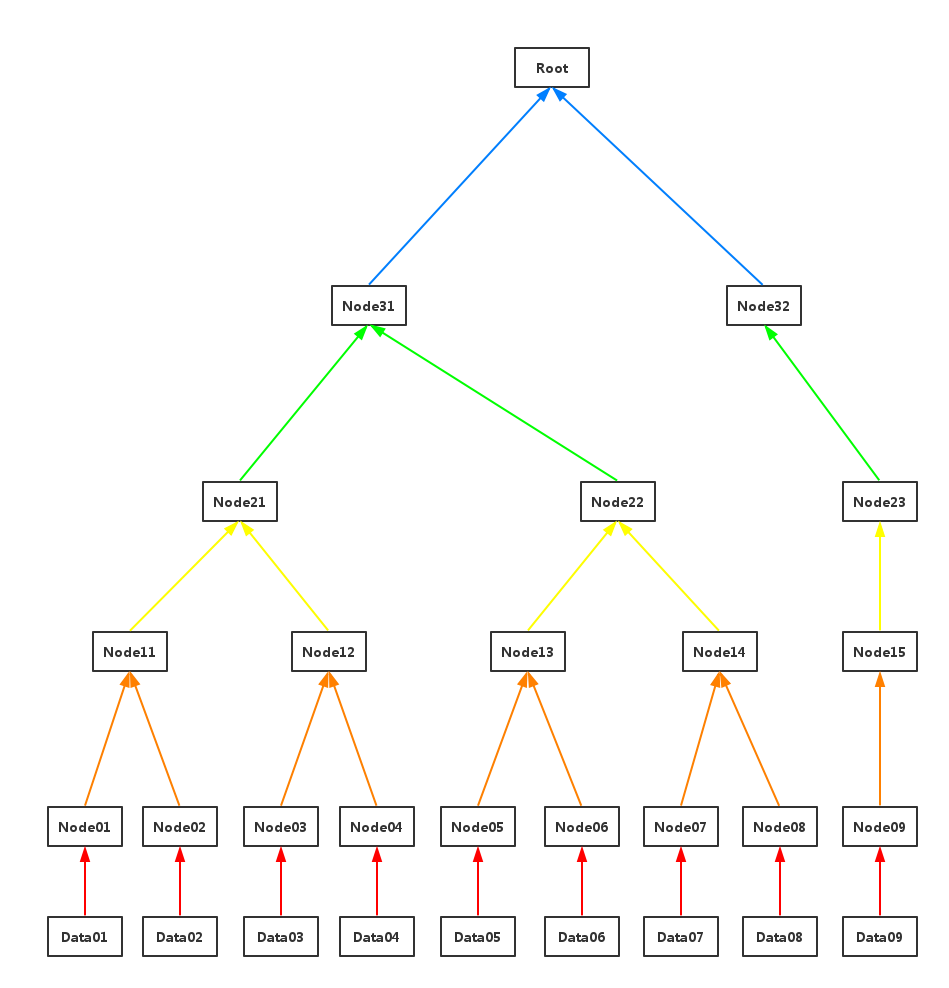

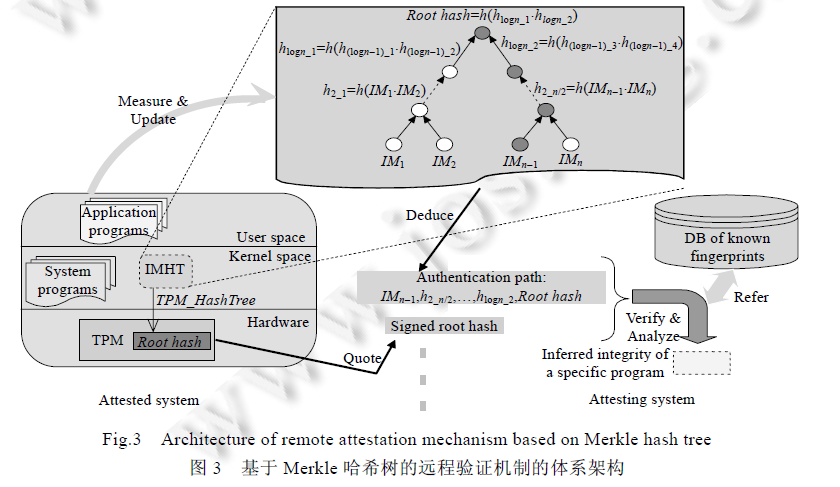

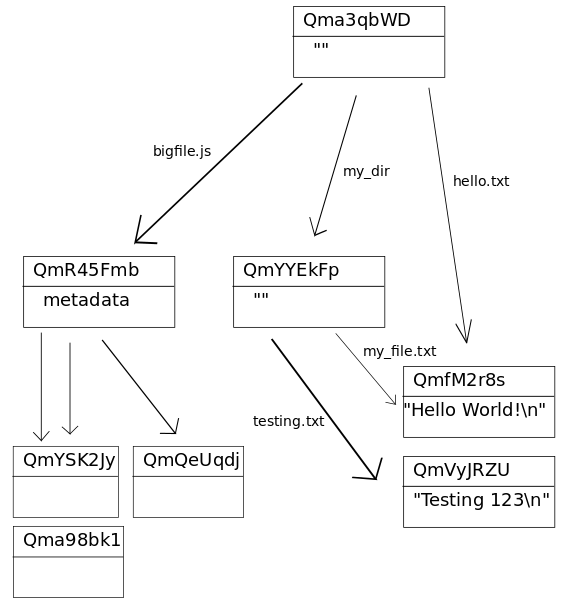

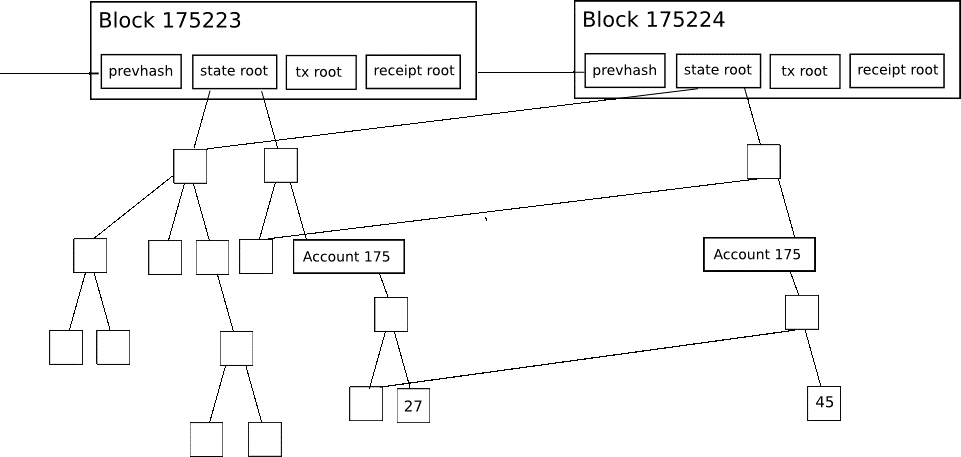

以上6条定义组成了LSM树,如图1所示。

- 图1中分成了左侧绿色的内存部分和右侧蓝色的磁盘部分(定义1)。

- 图1左侧绿色的内存部分只包含Level 0树,右侧蓝色的磁盘部分则包含Level 1-n等多棵”树”(定义2)

- 图1左侧绿色的内存部分中Level 0是一颗二叉排序树(定义3)。注意这里的有序性,该性质决定了LSM树优异的读写性能。

- 图1右侧蓝色的磁盘部分所包含的Level 1到Level n多颗树,虽然叫做“树”,但本质是按数据key排好序后,顺序写在磁盘上的一个个文件(定义4) ,注意这里再次出现了有序性。

- 内存中的Level 0树在达到阈值后,会在内存中遍历排好序的Level 0树并顺序写入磁盘的Level 1。同样的,在磁盘中的Level n(n>0)达到阈值时,则会将Level n层的多个文件进行归并,写入Level n+1层。(定义5)

- 除了内存中的Level 0层做原地更新外,对已写入磁盘上的数据,都采用Append形式的磁盘顺序写,即更新和删除操作并不去修改老数据,只是简单的追加新数据。图1中右侧蓝色的磁盘部分,Level 1和Level 2均包含key为2的数据,同时图1左侧绿色内存中的Level 0树也包含key为2的数据节点。(定义6)

下面我们遵循LSM树的6条定义,通过动图对LSM树的增、删、改、查和归并进行详细分析。

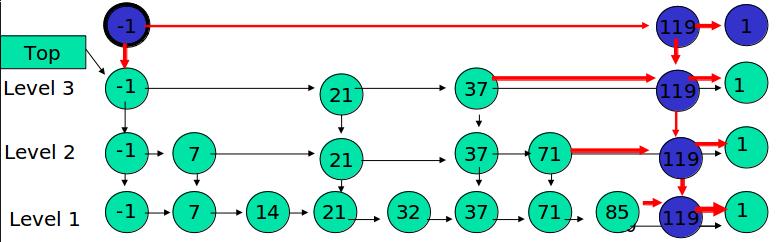

插入操作

LSM树的插入较简单,数据无脑往内存中的Level 0排序树丢即可,并不关心该数据是否已经在内存或磁盘中存在。(已经存在该数据的话,则场景转换成更新操作,详见第四部分)

图2展示了,新数据直接插入Level 0树的过程。

如上图2所示,我们依次插入了key=9、1、6的数据,这三个数据均按照key的大小,插入内存里的Level 0排序树中。该操作复杂度为树高log(n),n是Level 0树的数据量,可见代价很低,能实现极高的写吞吐量。

删除操作

LSM树的删除操作并不是直接删除数据,而是通过一种叫“墓碑标记”的特殊数据来标识数据的删除。

删除操作分为:待删除数据在内存中、待删除数据在磁盘中 和 该数据根本不存在 三种情况。

待删除数据在内存中:

如图3所示,展示了待删除数据在内存中的删除过程。我们不能简单地将Level 0树中的黄色节点2删除,而是应该采用墓碑标记将其覆盖(思考题:为什么不能直接删除而是要用墓碑标记覆盖呢)

待删除数据在磁盘中

如图4所示,展示了待删除数据在磁盘上时的删除过程。我们并不去修改磁盘上的数据(理都不理它),而是直接向内存中的Level 0树中插入墓碑标记即可。

待删除数据根本不存在:

这种情况等价于在内存的Level 0树中新增一条墓碑标记,场景转换为情况3.2的内存中插入墓碑标记操作。

综合看待上述三种情况,发现不论数据有没有、在哪里,删除操作都是等价于向Level 0树中写入墓碑标记。该操作复杂度为树高log(n),代价很低。

修改操作

LSM树的修改操作和删除操作很像,也是分为三种情况:待修改数据在内存中、在磁盘中和 该数据根本不存在。

待修改数据在内存中:

如图5所示,展示了待修改数据在内存中的操作过程。新的蓝色的key=7的数据,直接定位到内存中Level 0树上黄色的老的key=7的位置,将其覆盖即可。

待修改数据在磁盘中:

如图6所示,展示了待修改数据在磁盘中的操作过程。LSM树并不会去磁盘中的Level 1树上原地更新老的key=7的数据,而是直接将新的蓝色的节点7插入内存中的Level 0树中。

该数据根本不存在:

此场景等价于情况b,直接向内存中的Level 0树插入新的数据即可。

综上4.1、4.2、4.3三种情况可以看出,修改操作都是对内存中Level 0进行覆盖/新增操作。该操作复杂度为树高log(n),代价很低。

我们会发现,LSM树的增加、删除、修改(这三个都属于写操作)都是在内存中倒腾,完全没涉及到磁盘操作,所以速度飞快,写吞吐量高的离谱。。。

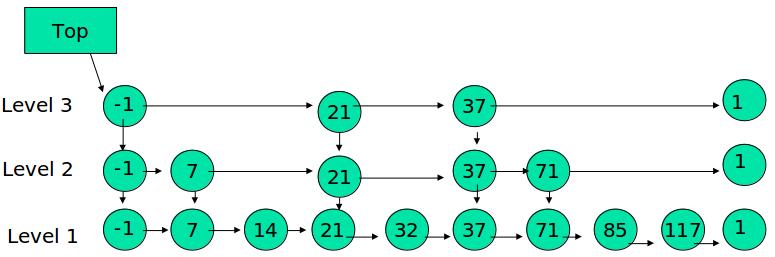

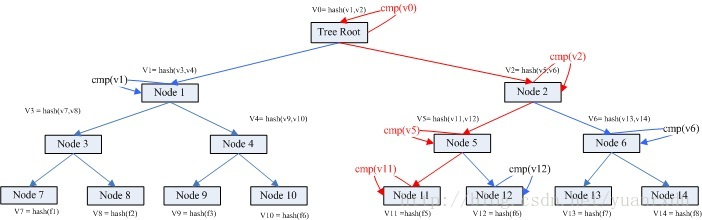

查询操作

LSM树的查询操作会按顺序查找Level 0、Level 1、Level 2 … Level n 每一颗树,一旦匹配便返回目标数据,不再继续查询。该策略保证了查到的一定是目标key最新版本的数据(有点MVCC的感觉)。

我们来分场景分析:依然分为 待查询数据在内存中 和 待查询数据在磁盘中 两种情况。

待查询数据在内存中:

如图7所示,展示了待查询数据在内存中时的查询过程。

沿着内存中已排好序的Level 0树递归向下比较查询,返回目标节点即可。我们注意到磁盘上的Level 1树中同样包括一个key=6的较老的数据。但LSM树查询的时候会按照Level 0、1、2 … n的顺序查询,一旦查到第一个就返回,因此磁盘上老的key=6的数据没人理它,更不会作为结果被返回。

待查询数据在磁盘中:

如图8所示,展示了待查询数据在磁盘上时的查询过程。

先查询内存中的Level 0树,没查到便查询磁盘中的Level 1树,还是没查到,于是查询磁盘中的Level 2树,匹配后返回key=6的数据。

综合上述两种情况,我们发现,LSM树的查询操作相对来说代价比较高,需要从Level 0到Level n一直顺序查下去。极端情况是LSM树中不存在该数据,则需要把整个库从Level 0到Level n给扫了一遍,然后返回查无此人(可以通过 布隆过滤器 + 建立稀疏索引 来优化查询操作)。代价大于以B/B+树为基本数据结构的传统RDB存储引擎。

合并操作

合并操作是LSM树的核心(毕竟LSM树的名字就叫: 日志结构合并树,直接点名了合并这一操作)

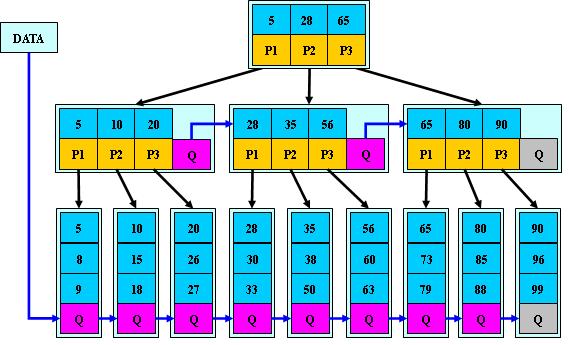

之所以在增、删、改、查这四个基本操作之外还需要合并操作:一是因为内存不是无限大,Level 0树达到阈值时,需要将数据从内存刷到磁盘中,这是合并操作的第一个场景;二是需要对磁盘上达到阈值的顺序文件进行归并,并将归并结果写入下一层,归并过程中会清理重复的数据和被删除的数据(墓碑标记)。我们分别对上述两个场景进行分析:

内存数据写入磁盘的场景:

如图9所示,展示了内存中Level 0树在达到阈值后,归并写入磁盘Level 1树的场景。

对内存中的Level 0树进行中序遍历,将数据顺序写入磁盘的Level 1层即可,我们可以看到因为Level 0树是已经排好序的,所以写入的Level 1中的新块也是有序的(有序性保证了查询和归并操作的高效)。此时磁盘的Level 1层有两个Block块。

磁盘中多个块的归并:

如图10所示,该图展示了磁盘中Level 1层达到阈值时,对其包含的两个Block块进行归并,并将归并结果写入Level 2层的过程。

我们注意到key=5和key=7的数据同时存在于较老的Block 1和较新的Block 2中。而归并的过程是保留较新的数据,于是我们看到结果中,key=5和7的数据都是红色的(来自于较新的Block2)。

综上我们可以看到,不论是场景6.1还是场景6.2,由于原始数据都是有序的,因此归并的过程只需要对数据集进行一次扫描即可,复杂度为O(n)。

优缺点分析

以上便是对LSM树的增、删、改、查和归并五种核心操作的详细分析。

可以看到LSM树将增、删、改这三种操作都转化为内存insert + 磁盘顺序写(当Level 0满的时候),通过这种方式得到了无与伦比的写吞吐量。

LSM树的查询能力则相对被弱化,相比于B+树的最多3~4次磁盘IO,LSM树则要从Level 0一路查询Level n,极端情况下等于做了全表扫描。(即便做了稀疏索引,也是lg(N0)+lg(N1)+…+lg(Nn)的复杂度,大于B+树的lg(N0+N1+…+Nn)的时间复杂度)。

同时,LSM树只append追加不原地修改的特性引入了归并操作,归并操作涉及到大量的磁盘IO,比较消耗性能,需要合理设置触发该操作的参数。

综上我们可以给出LSM树的优缺点:

优:增、删、改操作飞快,写吞吐量极大。

缺:读操作性能相对被弱化;不擅长区间范围的读操作; 归并操作较耗费资源。

总结

以上是对LSM树基本操作以及优缺点的分析,我们可以据此得出LSM树的设计原则:

- 先内存再磁盘

- 内存原地更新

- 磁盘追加更新

- 归并保留新值

如果说B/B+树的读写性能基本平衡的话,LSM树的设计原则通过舍弃部分读性能,换取了无与伦比的写性能。该数据结构适合用于写吞吐量远远大于读吞吐量的场景,得到了NoSQL届的喜爱和好评。

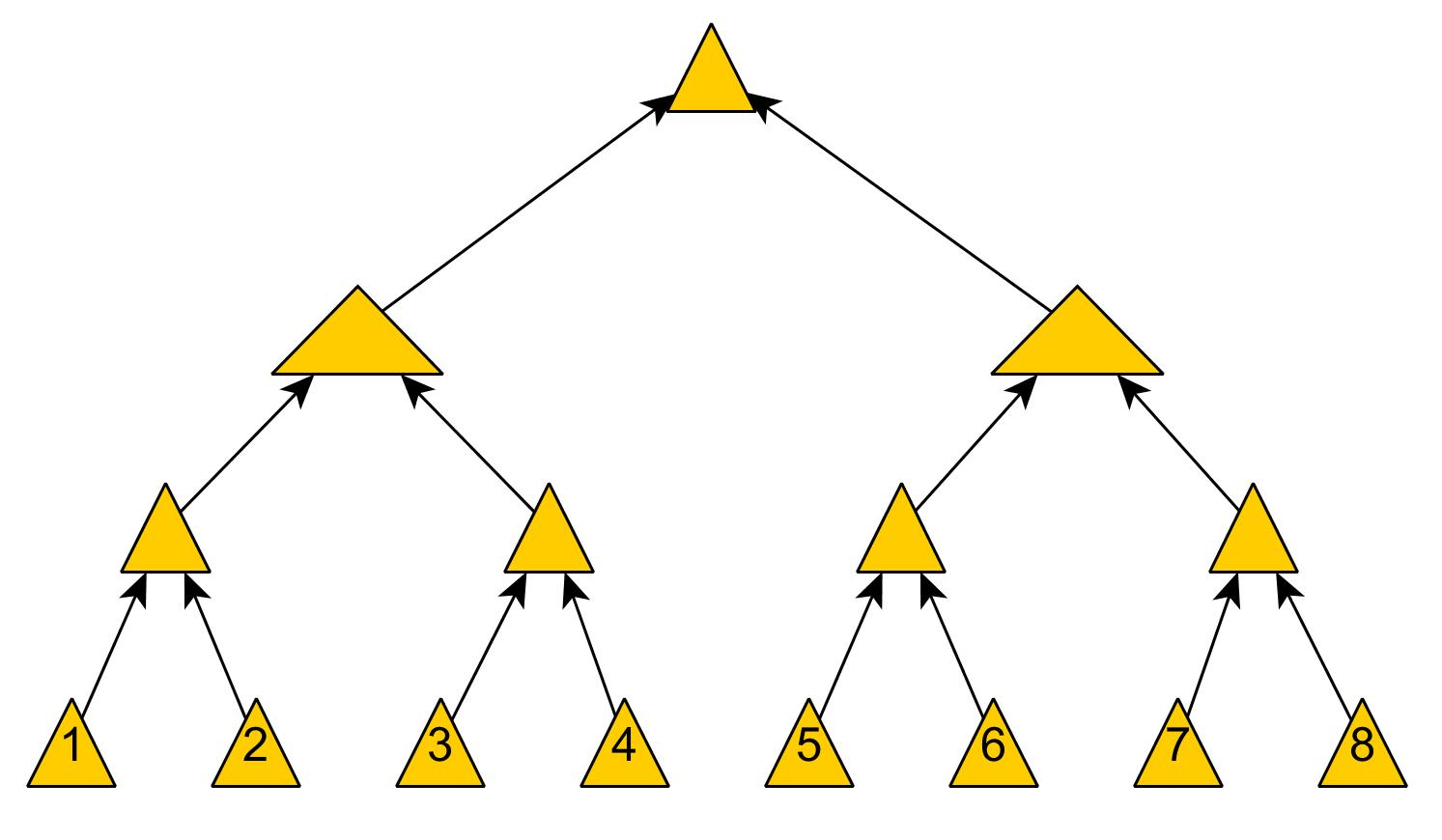

平衡二叉树详解

二叉搜索树(Binary Sort Tree)

二叉搜索树,又称之为二叉排序树(二叉查找树),它或许是一棵空树,或许是具有以下性质的二叉树:

- 若他的左子树不为空,则左子树上所有节点的值都小于根节点的值

- 若它的右子树不为空,则右子树上所有节点的值都大于根节点的值

- 它的左右子树也分别是二叉搜索树

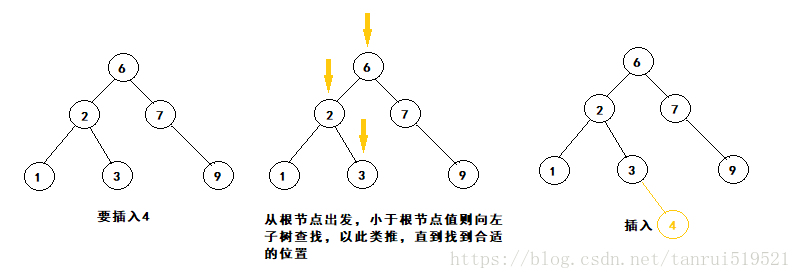

二叉搜索树的这种特性,使得我们在此二叉树上查找某个值就很方便了,从根节点开始,若要寻找的值小于根节点的值,则在左子树上去找,反之则去右子树查找,知道找到与值相同的节点。插入节点也是一样的道理,从根节点出发,所要插入的值,若小于根节点则去左子树寻找该节点所对应的位置,反之去右子树寻找,直到找到该节点合适的位置。

二叉平衡搜索树(AVL)

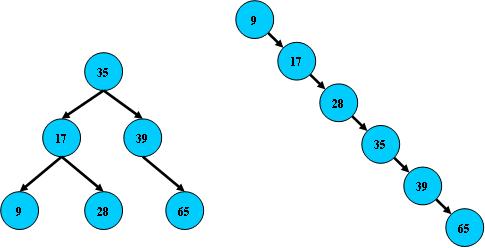

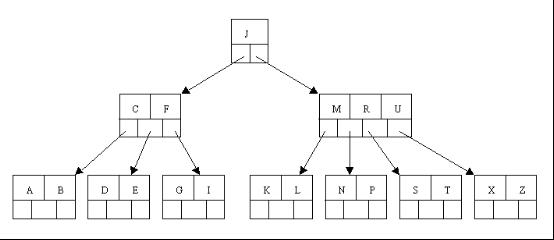

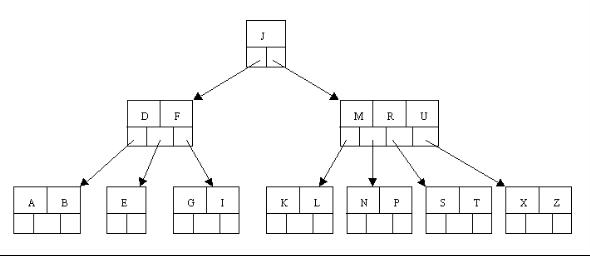

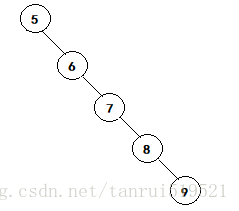

前面提到了二叉搜索树,我们知道,二叉搜索树的特性便于我们进行查找插入删除等一系列操作,其时间复杂度为O(logn),但是,如果遇见最差的情况,比如以下这棵树:

这棵树,说是树,其实它已经退化成链表了,但从概念上来看,它仍是一棵二叉搜索树,只要我们按照逐次增大,如1、2、3、4、5、6的顺序构造一棵二叉搜索树,则形如上图。那么插入的时间复杂度就变成了O(n),导致这种糟糕的情况原因是因为这棵树极其不平衡,右树的重量远大于左树,因此我们提出了叫平衡二叉搜索树的结构,又称之为AVL树,是因为平衡二叉搜索树的发明者为Adel’son-Vel’skii 和Landis二人。

平衡二叉搜索树,它能保持二叉树的高度平衡,尽量降低二叉树的高度,减少树的平均查找长度。

AVL树的性质:

- 左子树与右子树高度之差的绝对值不超过1

- 树的每个左子树和右子树都是AVL树

- 每一个节点都有一个平衡因子(balance factor),任一节点的平衡因子是-1、0、1(每一个节点的平衡因子 = 右子树高度 - 左子树高度)

做到了这点,这棵树看起来就比较平衡了,那么如何生成一棵AVL树呢?算法相对来说复杂,随着新节点的加入,树自动调整自身结构,达到新的平衡状态,这就是我们想要的AVL树。我们先要分析,为什么树会失衡?是由于插入了一个新的元素。

- 当子树的根结点的平衡因子为+1时,它是左倾斜的(left-heavy)。

- 当子树的根结点的平衡因子为 -1时,它是右倾斜的(right-heavy)。

- 一颗子树的根结点的平衡因子就代表该子树的平衡性。

- 保持所有子树几乎都处于平衡状态,AVL树在总体上就能够基本保持平衡。

AVL树的基本查找、插入结点的操作和二叉树的操作一样。但是,当向AVL树中插入一个结点后,还有一些额外的工作要做。首先,必须计算因插入操作对平衡因子带来的改变。其次,如果任何平衡因子变成了+/-2,就必须从这个结点开始往下重新平衡这颗树,这个重新平衡的过程就称为旋转。

在AVL树中,插入一个节点是什么样的过程呢?总结如下:

- AVL树首先是二叉搜索树。我们要根据二叉搜索树的插入节点方式进行插入

- AVL树有判断该树是否平衡的平衡因子,我们要根据平衡因子来对树进行选择调整

具体步骤:

- 判断该树是不是NULL,若为NULL,则直接插入

2· 若不为NULL,找到需要插入节点的位置(用pParent标记双亲,方便插入节点)pCur - 插入节点pCur

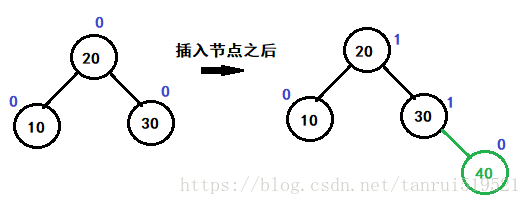

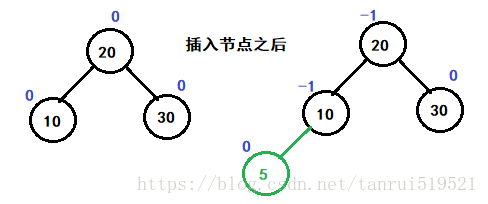

- 更新pParent的平衡因子。然后判断该树是否要调整

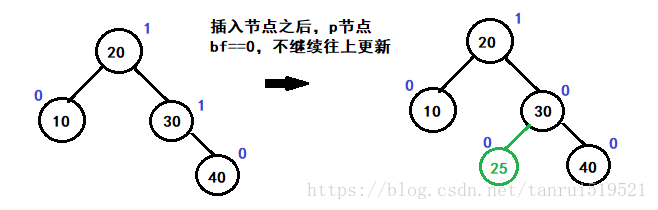

- 若更新后的pParent平衡因子为0的话,pParent在插入新节点之前只有左孩子或者只有右孩子,此时树的高度不变,该树仍然为AVL

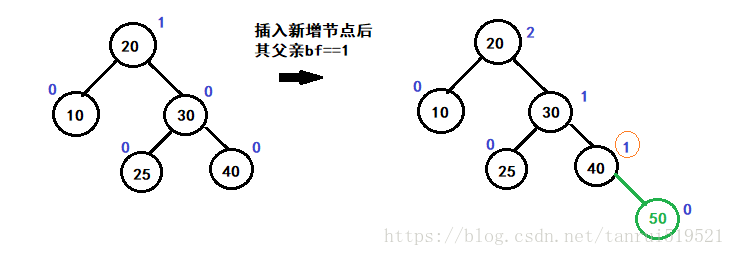

- 若更新后的pParent平衡因子为1或者-1的话,pParent在插入节点前是叶子节点,此时的高度可能发生改变,我们要从pParent节点开始,向上判断调整其祖先节点

- 若平衡因子不满足上面的两种情况,说明该树已经不平衡,需要调整。具体情况见下面,局部调整完后,上面的树已经满足AVL。

插入节点代码实现如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78template <class K, class V>

bool AVLTree<K, V>::AVLInsert(K key, V val)

{

//1.根节点为空,直接插入

if (_root == NULL)

{

_root = new Node(key, val);

return true;

}

//2.根节点不为空

else

{

Node* cur = _root;

Node* parent =NULL;

//a)找到要插入节点的位置

while (cur)

{

parent = cur;

if (cur->_key > key)

cur = cur->_left;

else if (cur->_key < key)

cur = cur->_right;

else

return false; //不允许出现重复元素的节点

}

//b)插入新节点

cur = new Node(key, val);

if (parent->_key > key)

{

parent->_left = cur;

cur->_parent = parent;

}

else

{

parent->_right = cur;

cur->_parent = parent;

}

//c)插入完成后,调整平衡因子

while (parent)

{

if (cur == parent->_left)//插入节点在左子树父节点bf--,反之++

parent->_bf--;

else

parent->_bf++;

//1)插入新节点后,parent->bf==0;说明高度没变,平衡,返回

if (parent->_bf == 0)

break;

//2)插入节点后parent->_bf==-1||parent->_bf==1;说明子树高度改变,则继续向上调整

else if (parent->_bf == -1 || parent->_bf == 1)

{

cur = parent;

parent = parent->_parent;

}

//3)插入节点后parent->_bf==-2||parent->_bf==2;说明已经不平衡,需要旋转

else

{

if (parent->_bf == 2)

{

if (cur->_bf == 1)

RotateL(parent);

else// (cur->_bf == -1)

RotateRL(parent);

}

else//parent->_bf == -2

{

if (cur->_bf == -1)

RotateR(parent);

else// (cur->_bf == 1)

RotateLR(parent);

}

break;

}

}//end while (parent)

return true;

}

}

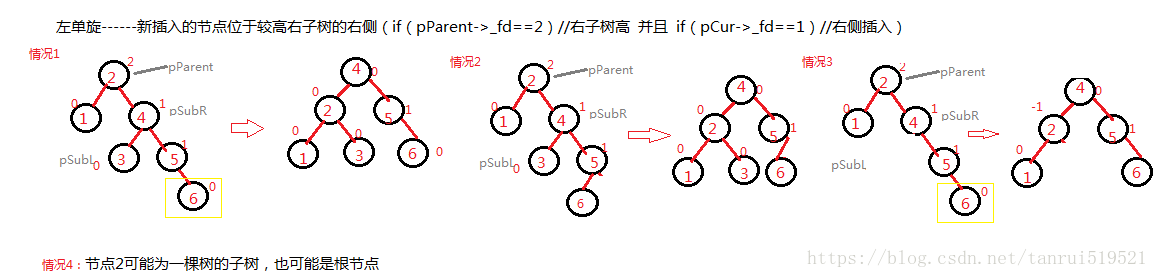

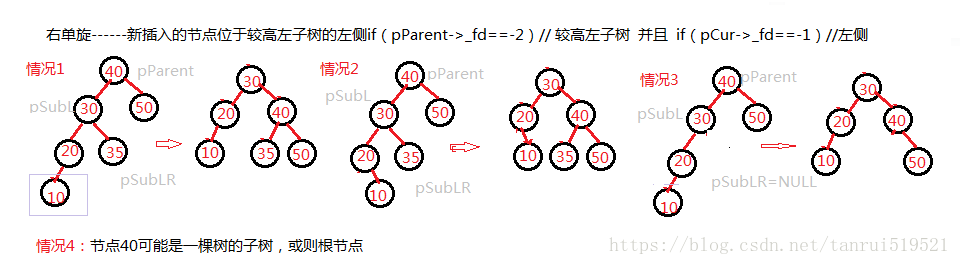

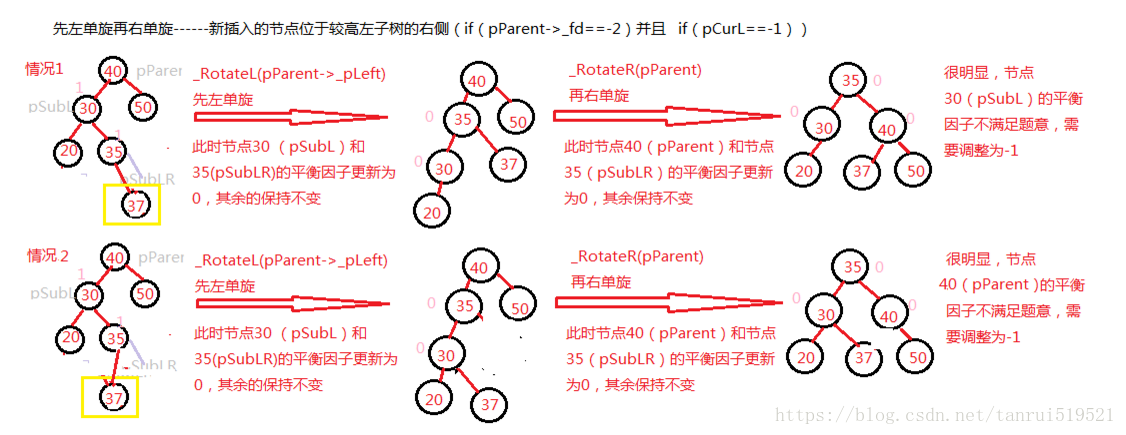

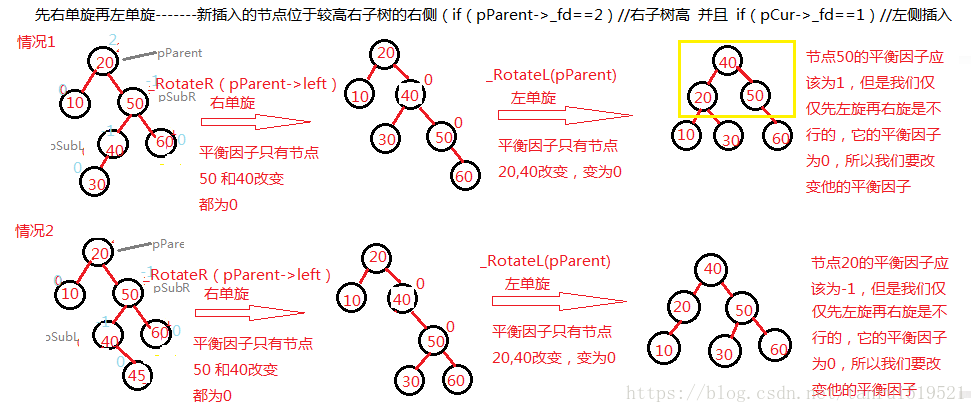

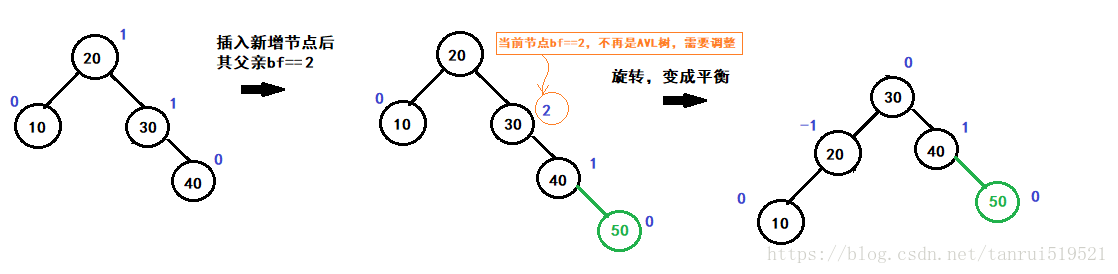

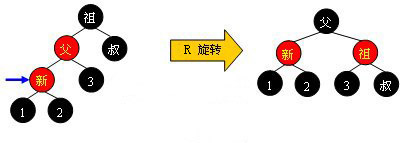

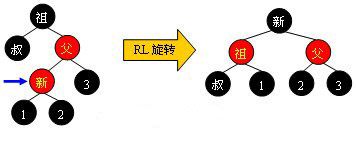

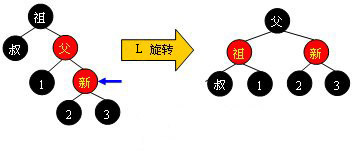

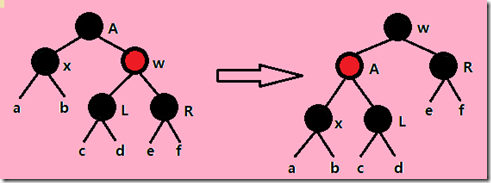

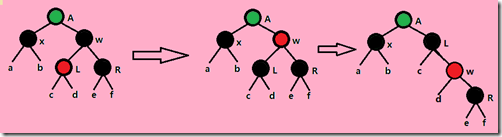

当树不平衡时,我们需要做出旋转调整,有四种调整方法。以下是节点调平的四种情况。

AVL树的自平衡操作——旋转

AVL树的旋转总体来说分为四种情况:

- 左单旋

- 右单旋

- 左右双旋

- 右左双旋

接下来,我们通过图解来认识这四种节点调平方式

左单旋(逆时针旋转)

代码实现如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29template <class K, class V>

void AVLTree<K, V>::RotateL(Node* parent)

{

Node* subR = parent->_right;

Node* subRL = subR->_left;

Node* pParent = parent->_parent;

parent->_right = subRL;

if (subRL)

subRL->_parent = parent;

subR->_left = parent;

parent->_parent = subR;

if (parent == _root)

{

_root = subR;

_root->_parent = NULL;

}

else

{

if (pParent->_left = parent)

pParent->_left = subR;

else

pParent->_right = subR;

subR->_parent = pParent;

}

parent->_bf = subR->_bf = 0;

}

右单旋(顺时针旋转)

代码实现如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35template <class K, class V>

void AVLTree<K, V>::RotateR(Node* parent)

{

Node* subL = parent->_left;

Node* subLR = subL->_right;

Node* ppNode = parent->_parent;

parent->_left = subLR;

if (subLR)

subLR->_parent = parent;

subL->_right = parent;

parent->_parent = subL;

if (_root == parent)

{

_root = subL;

subL->_parent = NULL;

}

else

{

if (ppNode->_right == parent)

{

ppNode->_right = subL;

}

else

{

ppNode->_left = subL;

}

subL->_parent = ppNode;

}

subL->_bf = parent->_bf = 0;

}

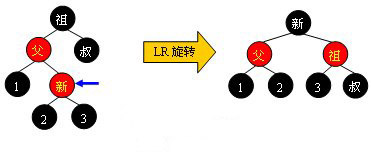

左右双旋

代码实现如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31template <class K, class V>

void AVLTree<K, V>::RotateLR(Node* parent)

{

Node* subL = parent->_left;

Node* subLR = subL->_right;

int bf = subLR->_bf;

RotateL(parent->_left);

RotateR(parent);

if (bf == 0)

{

subLR->_bf = subL->_bf = parent->_bf = 0;

}

else if (bf == 1)

{

parent->_bf = 0;

subL->_bf = -1;

subLR->_bf = 0;

}

else if (bf == -1)

{

parent->_bf = 1;

subL->_bf = 0;

subLR->_bf = 0;

}

else

{

assert(false);

}

}

右左双旋

代码实现如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31template <class K, class V>

void AVLTree<K, V>::RotateRL(Node* parent)

{

Node* subR = parent->_right;

Node* subRL = subR->_left;

int bf = subRL->_bf;

RotateR(parent->_right);

RotateL(parent);

if (bf == 0)

{

subRL->_bf = subR->_bf = parent->_bf = 0;

}

else if (bf == 1)

{

subR->_bf = 0;

parent->_bf = -1;

subRL->_bf = 0;

}

else if (bf == -1)

{

parent->_bf = 0;

subR->_bf = 1;

subRL->_bf = 0;

}

else

{

assert(false);

}

}

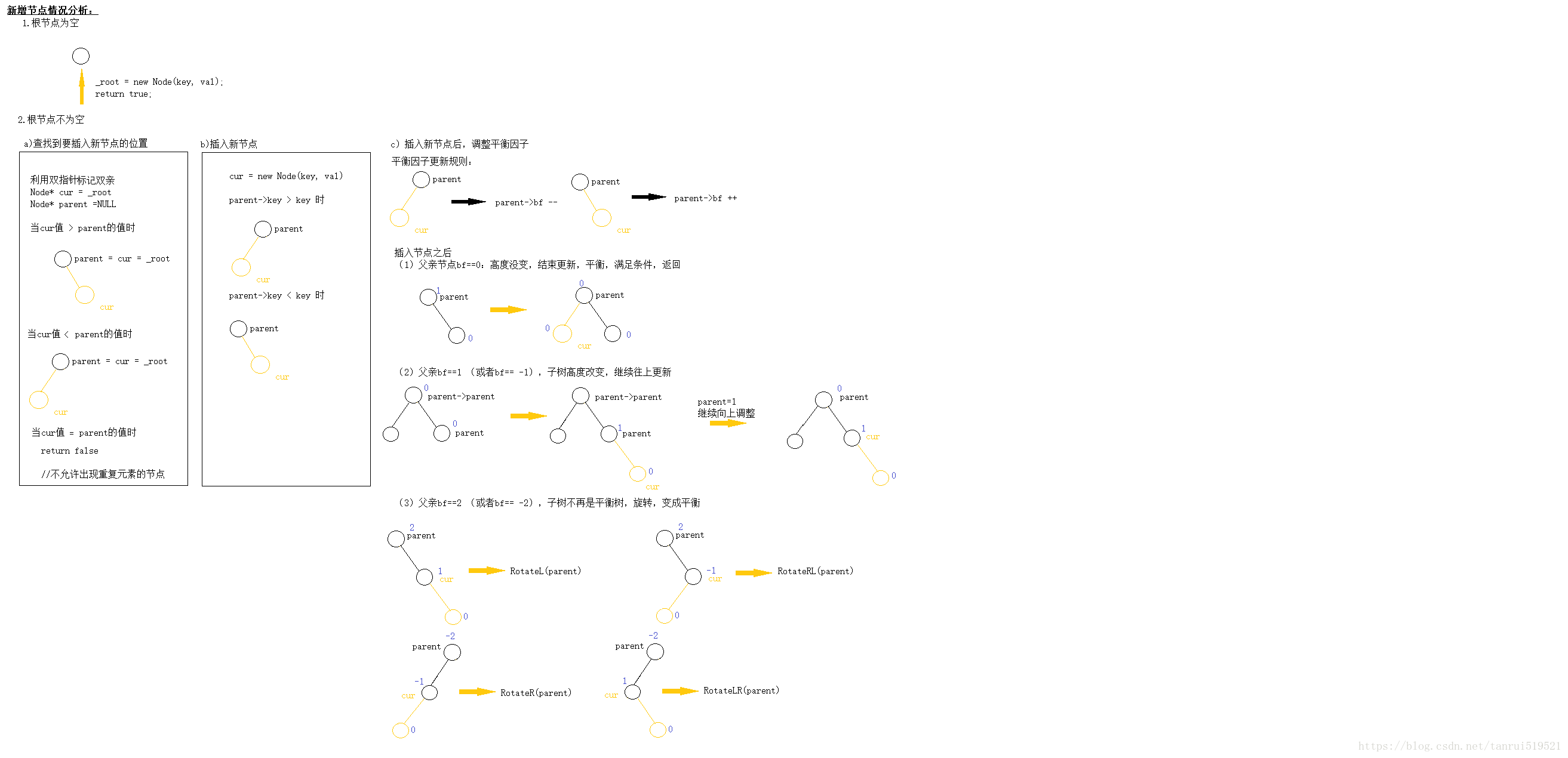

平衡因子更新

我们知道AVL树的每一个节点都有一个平衡因子,那么在AVL树插入节点时,其自平衡操作保证了AVL树始终保持平衡状态,但是在每一次插入节点时,都可能会导致节点平衡因子的改变,因此,当插入节点时,我们应当注意平衡因子的更新,这直接关系到之后判断插入节点后的数是否仍为AVL树。

平衡因子更新原则:——平衡因子与节点本身无关,只与其左右子树相关

- 新增节点bf恒为1

- 右子树结点增加,父亲bf ++

- 左子树结点增加,父亲bf —

- 若插入节点,更新平衡因子之后

- 父亲节点bf==0:高度没变,结束更新,平衡,满足条件,返回

- 父亲bf==1 (或者bf== -1),子树高度改变,继续往上更新

- 父亲bf==2 (或者bf== -2),子树不再是平衡树,旋转,变成平衡

1 |

|

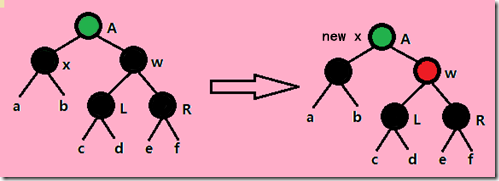

更清晰的一个图

旋转操作用来重新平衡树的某个部分。通过重新安排结点 ,使结点之间的关系始终保持左子结点小于父结点,父结点小于右子结点。使得该树仍然是一颗二叉搜索树。旋转过后,旋转子树中的所有结点的平衡因子都为+1、-1或0。

AVL树的旋转类型有4种, 分别是LL(left-left)旋转、LR(left-right)旋转、RR(right-right)旋转和RL(right-left)旋转。

为方便理解在何时执行哪一种旋转,设x代表刚插入AVL树中的结点,设A为离x最近且平衡因子更改为2的绝对值的祖先。

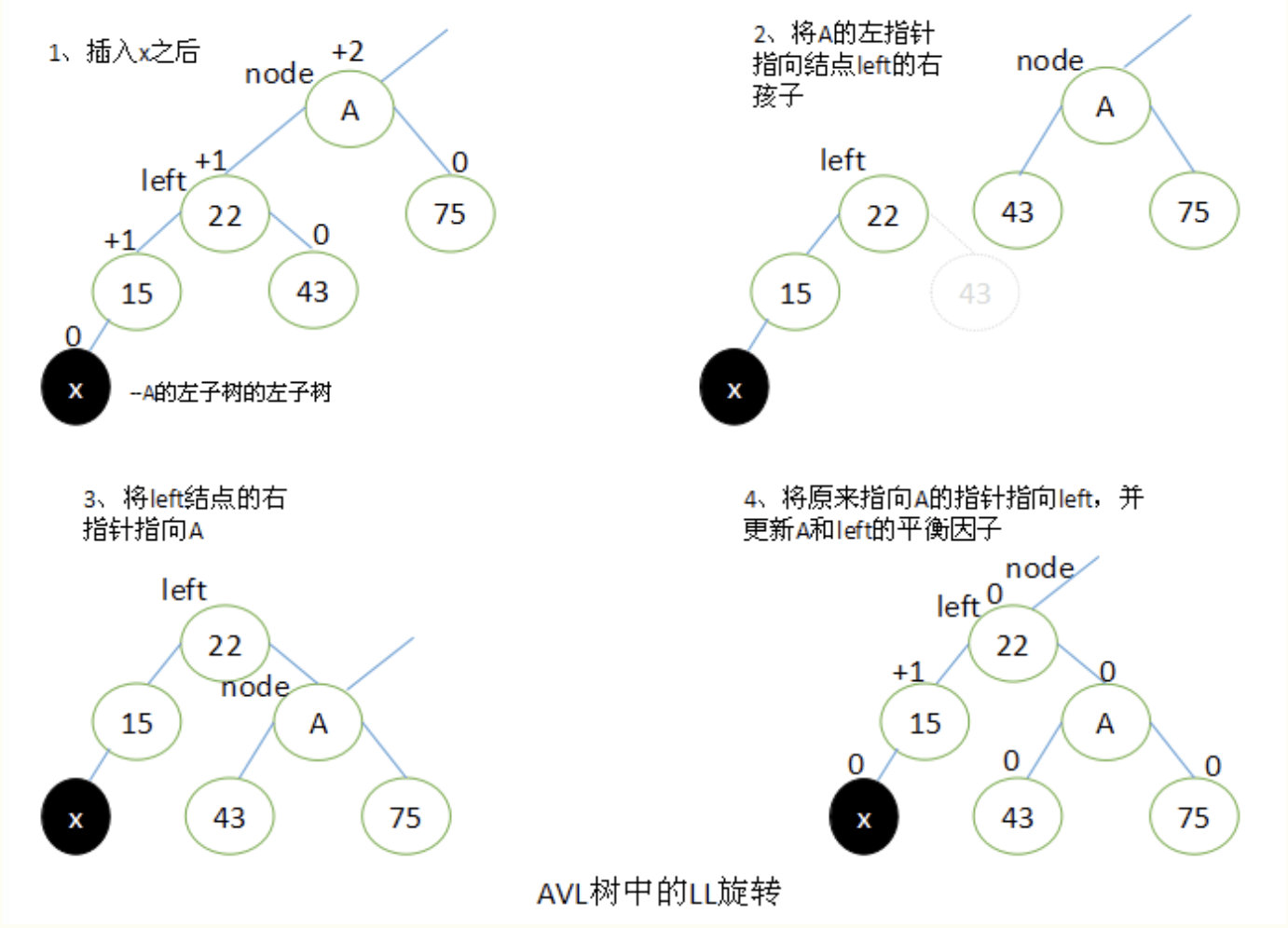

LL旋转

如下图所示,当x位于A的左子树的左子树上时,执行LL旋转。

设left为A的左子树,要执行LL旋转,将A的左指针指向left的右子结点,left的右指针指向A,将原来指向A的指针指向left。

旋转过后,将A和left的平衡因子都改为0。所有其他结点的平衡因子没有发生变化。

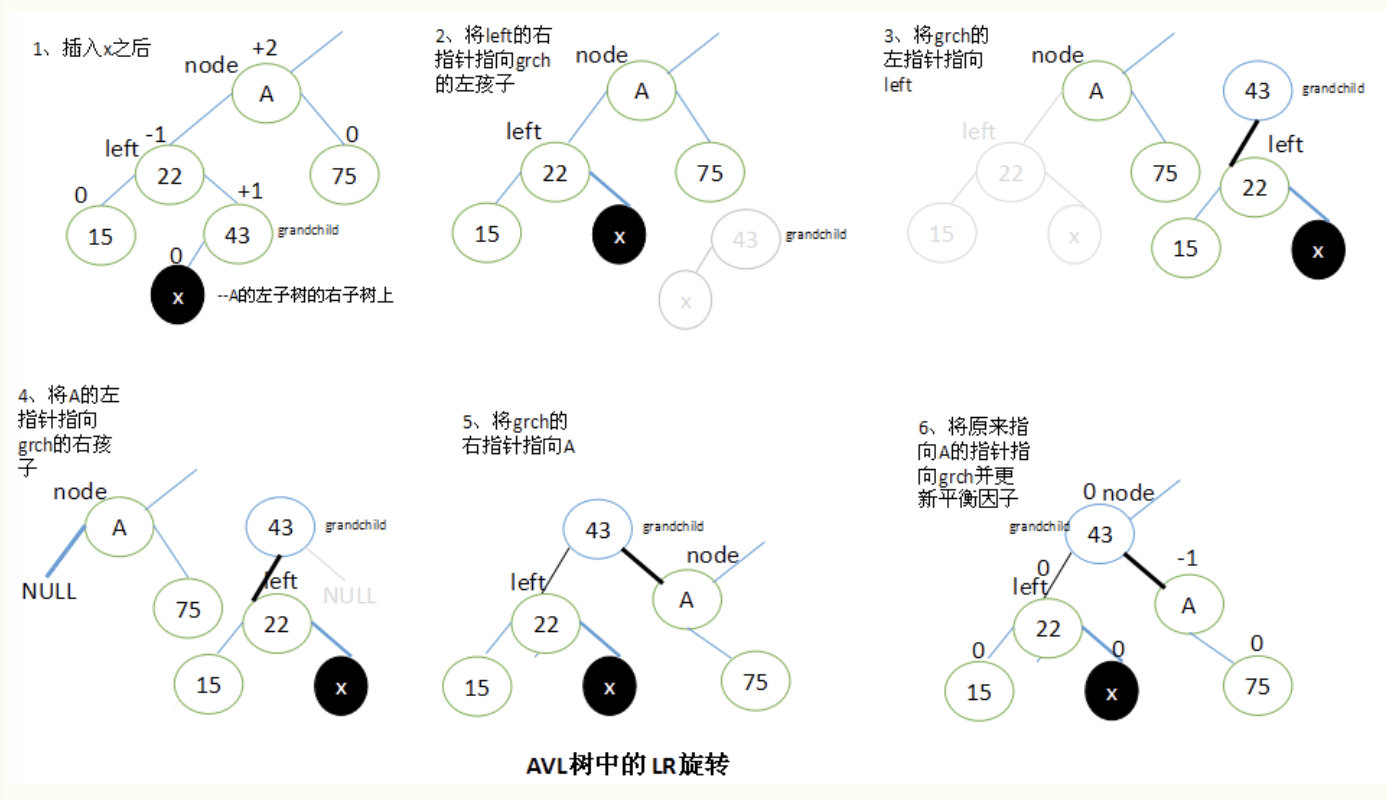

LR旋转

当x位于A的左子树的右子树上时,执行LR旋转。

设left是A的左子结点,并设A的子孙结点grandchild为left的右子结点。

要执行LR旋转,将left的右子结点指向grandchild的左子结点,grandchild的左子结点指向left,A的左子结点指向grandchild的右子结点,再将grandchild的右子结点指向A,最后将原来指向A的指针指向grandchild。

执行LR旋转之后,调整结点的平衡因子取决于旋转前grandchild结点的原平衡因子值。

- 如果grandchild结点的原始平衡因子为+1,就将A的平衡因子设为-1,将left的平衡因子设为0。

- 如果grandchild结点的原始平衡因子为0,就将A和left的平衡因子都设置为0。

- 如果grandchild结点的原始平衡因子为-1,就将A的平衡因子设置为0,将left的平衡因子设置为+1。

在所有的情况下,grandchild的新平衡因子都是0。所有其他结点的平衡因子都没有改变。

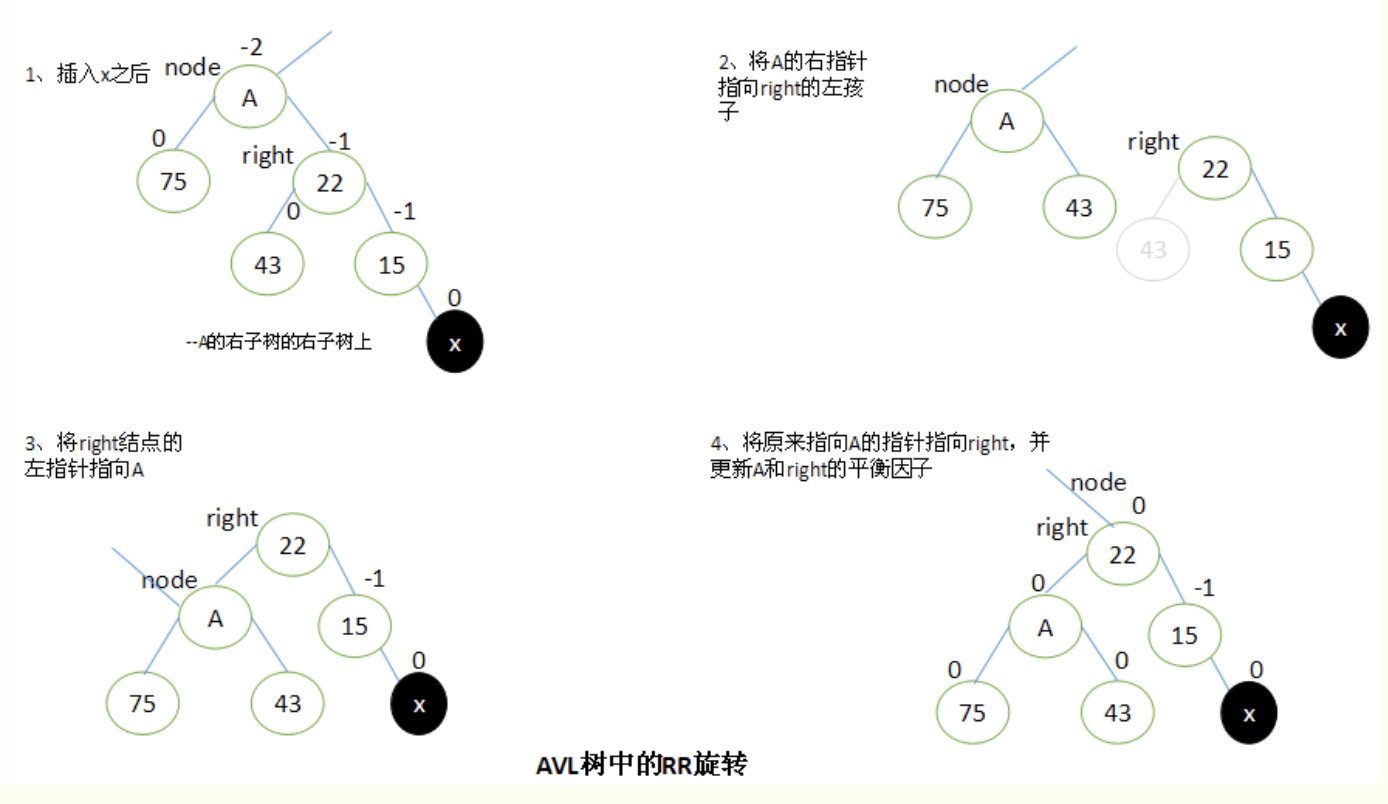

RR旋转

当x位于A的右子树的右子树上时,执行RR旋转。

RR旋转与LL旋转是对称的关系。

设A的右子结点为Right。要执行RR旋转,将A的右指针指向right的左子结点,right的左指针指向A,原来指向A的指针修改为指向right。

完成旋转以后,将A和left的平衡因子都修改为0。所有其他结点的平衡因子都没有改变。

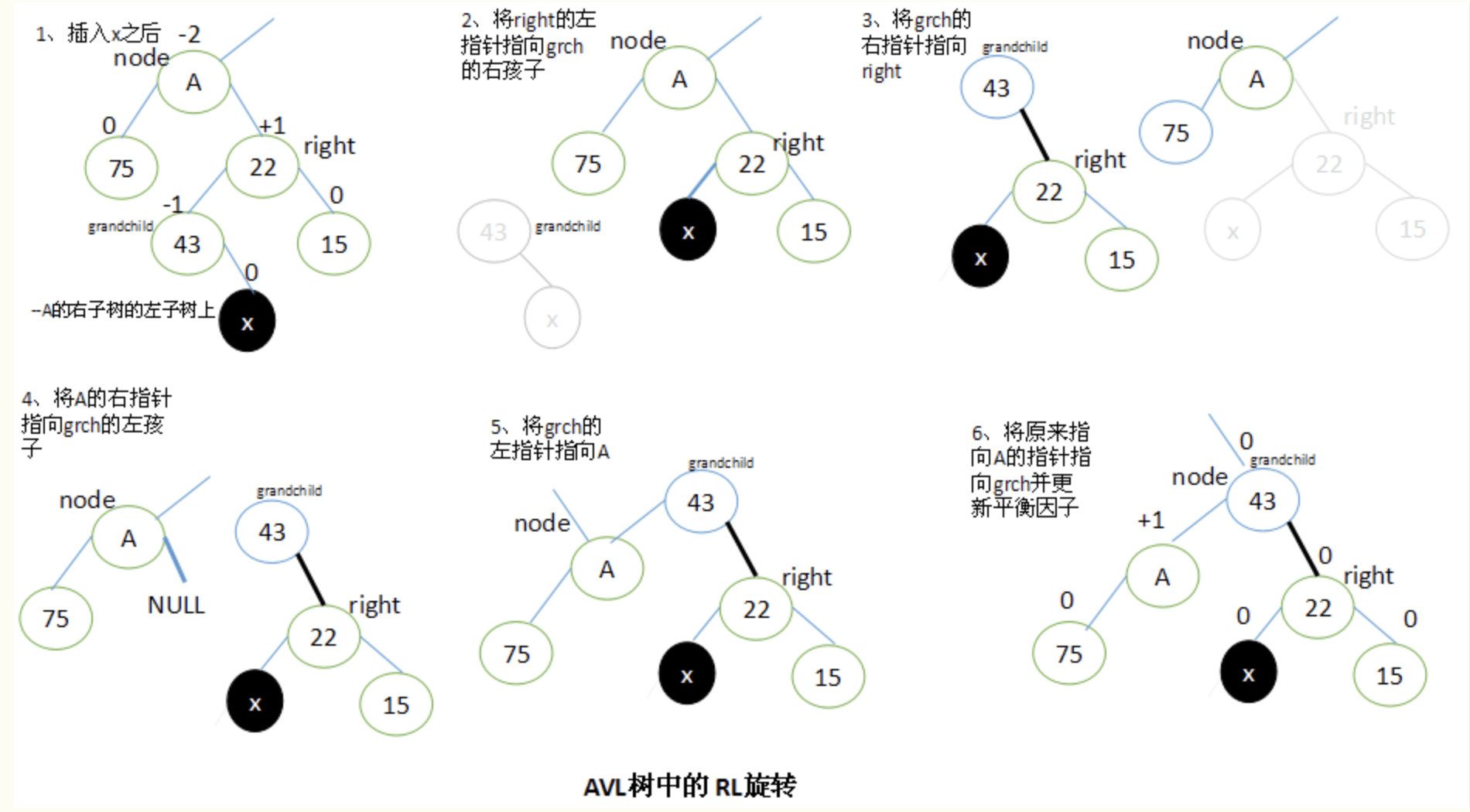

RL旋转

当x位于A的右子树的左子树上时,执行RL旋转。

RL旋转与LR旋转是对称的关系。

设A的右子结点为right,right的左子结点为grandchild。要执行RL旋转,将right结点的左子结点指向grandchild的右子结点,将grandchild的右子结点指向right,将A的右子结点指向grandchild的左子结点,将grandchild的左子结点指向A,最后将原来指向A的指针指向grandchild。

执行RL旋转以后,调整结点的平衡因子取决于旋转前grandchild结点的原平衡因子。这里也有三种情况需要考虑:

- 如果grandchild的原始平衡因子值为+1,将A的平衡因子更新为0,right的更新为-1;

- 如果grandchild的原始平衡因子值为 0,将A和right的平衡因子都更新为0;

- 如果grandchild的原始平衡因子值为-1,将A的平衡因子更新为+1,right的更新为0;

在所有情况中,都将grandchild的新平衡因子设置为0。所有其他结点的平衡因子不发生改变。

AVL树的删除操作

同插入操作一样,删除结点时也有可能破坏平衡性,这就要求我们删除的时候要进行平衡性调整。

首先在整个二叉树中搜索要删除的结点,如果没搜索到直接返回不作处理,否则执行以下操作:

- 要删除的节点是当前根节点T。

- 如果左右子树都非空。在高度较大的子树中实施删除操作。分两种情况:

- 左子树高度大于右子树高度,将左子树中最大的那个元素赋给当前根节点,然后删除左子树中元素值最大的那个节点。

- 左子树高度小于右子树高度,将右子树中最小的那个元素赋给当前根节点,然后删除右子树中元素值最小的那个节点。

- 如果左右子树中有一个为空,那么直接用那个非空子树或者是NULL替换当前根节点即可。

- 如果左右子树都非空。在高度较大的子树中实施删除操作。分两种情况:

- 要删除的节点元素值小于当前根节点T值,在左子树中进行删除。

- 递归调用,在左子树中实施删除。

- 这个是需要判断当前根节点是否仍然满足平衡条件,

- 如果满足平衡条件,只需要更新当前根节点T的高度信息。

- 否则,需要进行旋转调整:

- 如果T的左子节点的左子树的高度大于T的左子节点的右子树的高度,进行相应的单旋转。否则进行双旋转。

- 要删除的节点元素值大于当前根节点T值,在右子树中进行删除。

1 | 下面给出详细代码实现: |

红黑树详解

转载请标明出处,原文地址:http://blog.csdn.net/hackbuteer1/article/details/7740956

红黑树概述

红黑树和我们以前学过的AVL树类似,都是在进行插入和删除操作时通过特定操作保持二叉查找树的平衡,从而获得较高的查找性能。不过自从红黑树出来后,AVL树就被放到了博物馆里,据说是红黑树有更好的效率,更高的统计性能。这一点在我们了解了红黑树的实现原理后,就会有更加深切的体会。

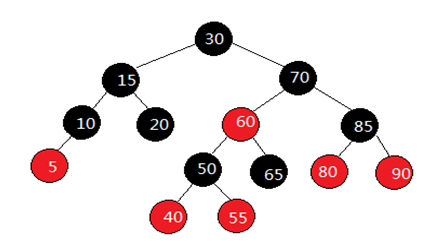

红黑树和AVL树的区别在于它使用颜色来标识结点的高度,它所追求的是局部平衡而不是AVL树中的非常严格的平衡。学过数据结构的人应该都已经领教过AVL树的复杂,但AVL树的复杂比起红黑树来说简直是小巫见大巫,红黑树才是真正的变态级数据结构。由于STL中的关联式容器默认的底层实现都是红黑树,因此红黑树对于后续学习STL源码还是很重要的,有必要掌握红黑树的实现原理和源码实现。红黑树是AVL树的变种,红黑树通过一些着色法则确保没有一条路径会比其它路径长出两倍,因而达到接近平衡的目的。所谓红黑树,不仅是一个二叉搜索树,而且必须满足以下规则:

- 每个节点不是红色就是黑色。

- 根节点为黑色。

- 如果节点为红色,其子节点必须为黑色。

- 任意一个节点到到NULL(树尾端)的任何路径,所含之黑色节点数必须相同。

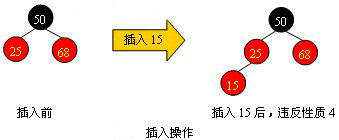

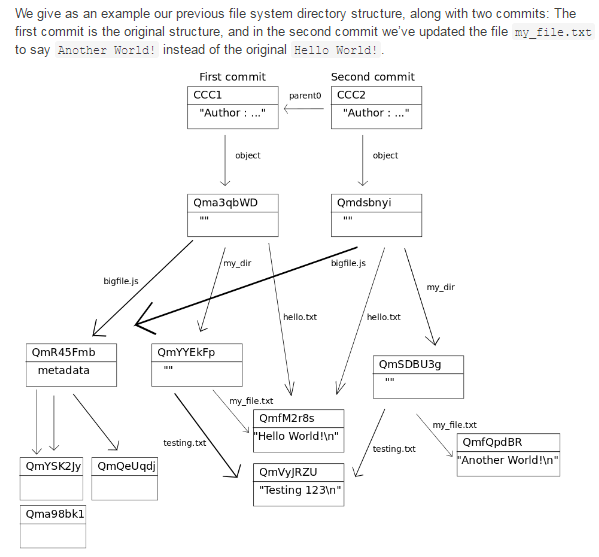

上面的这些约束保证了这个树大致上是平衡的,这也决定了红黑树的插入、删除、查询等操作是比较快速的。 根据规则4,新增节点必须为红色;根据规则3,新增节点之父节点必须为黑色。当新增节点根据二叉搜索树的规则到达其插入点时,却未能符合上述条件时,就必须调整颜色并旋转树形,如下图:

假设我们为上图分别插入节点3、8、35、75,根据二叉搜索树的规则,插入这四个节点后,我们会发现它们都破坏了红黑树的规则,因此我们必须调整树形,也就是旋转树形并改变节点的颜色。

红黑树上结点的插入

在讨论红黑树的插入操作之前必须要明白,任何一个即将插入的新结点的初始颜色都为红色。这一点很容易理解,因为插入黑点会增加某条路径上黑结点的数目,从而导致整棵树黑高度的不平衡。但如果新结点的父结点为红色时(如下图所示),将会违反红黑树的性质:一条路径上不能出现相邻的两个红色结点。这时就需要通过一系列操作来使红黑树保持平衡。

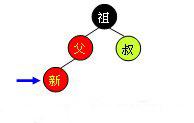

为了清楚地表示插入操作以下在结点中使用“新”字表示一个新插入的结点;使用“父”字表示新插入点的父结点;使用“叔”字表示“父”结点的兄弟结点;使用“祖”字表示“父”结点的父结点。插入操作分为以下几种情况:

黑父

如下图所示,如果新节点的父结点为黑色结点,那么插入一个红点将不会影响红黑树的平衡,此时插入操作完成。红黑树比AVL树优秀的地方之一在于黑父的情况比较常见,从而使红黑树需要旋转的几率相对AVL树来说会少一些。

红父

如果新节点的父结点为红色,这时就需要进行一系列操作以保证整棵树红黑性质。如下图所示,由于父结点为红色,此时可以判定,祖父结点必定为黑色。这时需要根据叔父结点的颜色来决定做什么样的操作。青色结点表示颜色未知。由于有可能需要根结点到新点的路径上进行多次旋转操作,而每次进行不平衡判断的起始点(我们可将其视为新点)都不一样。所以我们在此使用一个蓝色箭头指向这个起始点,并称之为判定点。

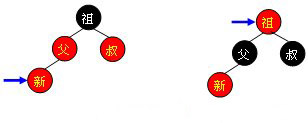

红叔

当叔父结点为红色时,如下图所示,无需进行旋转操作,只要将父和叔结点变为黑色,将祖父结点变为红色即可。但由于祖父结点的父结点有可能为红色,从而违反红黑树性质。此时必须将祖父结点作为新的判定点继续向上(迭代)进行平衡操作。

需要注意的是,无论“父节点”在“叔节点”的左边还是右边,无论“新节点”是“父节点”的左孩子还是右孩子,它们的操作都是完全一样的(其实这种情况包括4种,只需调整颜色,不需要旋转树形)。

黑叔

当叔父结点为黑色时,需要进行旋转,以下图示了所有的旋转可能:

Case 1:

Case 2:

Case 3:

Case 4:

可以观察到,当旋转完成后,新的旋转根全部为黑色,此时不需要再向上回溯进行平衡操作,插入操作完成。需要注意,上面四张图的“叔”、“1”、“2”、“3”结点有可能为黑哨兵结点。

其实红黑树的插入操作不是很难,甚至比AVL树的插入操作还更简单些。红黑树的插入操作源代码如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

150

151

152

153

154

155

156

157

158

159

160// 元素插入操作 insert_unique()

// 插入新值:节点键值不允许重复,若重复则插入无效

// 注意,返回值是个pair,第一个元素是个红黑树迭代器,指向新增节点

// 第二个元素表示插入成功与否

template<class Key, class Value, class KeyOfValue, class Compare, class Alloc>

pair<typename rb_tree<Key, Value, KeyOfValue, Compare, Alloc>::iterator, bool>

rb_tree<Key, Value, KeyOfValue, Compare, Alloc>::insert_unique(const Value &v){

rb_tree_node* y = header; // 根节点root的父节点

rb_tree_node* x = root(); // 从根节点开始

bool comp = true;

while(x != 0) {

y = x;

comp = key_compare(KeyOfValue()(v), key(x)); // v键值小于目前节点之键值?

x = comp ? left(x) : right(x); // 遇“大”则往左,遇“小于或等于”则往右

}

// 离开while循环之后,y所指即插入点之父节点(此时的它必为叶节点)

iterator j = iterator(y); // 令迭代器j指向插入点之父节点y

if(comp) // 如果离开while循环时comp为真(表示遇“大”,将插入于左侧)

{

if(j == begin()) // 如果插入点之父节点为最左节点

return pair<iterator, bool>(_insert(x, y, z), true);

else // 否则(插入点之父节点不为最左节点)

--j; // 调整j,回头准备测试

}

if(key_compare(key(j.node), KeyOfValue()(v) )) // 新键值不与既有节点之键值重复,于是以下执行安插操作

return pair<iterator, bool>(_insert(x, y, z), true);

// 以上,x为新值插入点,y为插入点之父节点,v为新值

// 进行至此,表示新值一定与树中键值重复,那么就不应该插入新值

return pair<iterator, bool>(j, false);

}

// 真正地插入执行程序 _insert()

template<class Key, class Value, class KeyOfValue, class Compare, class Alloc>

typename<Key, Value, KeyOfValue, Compare, Alloc>::_insert(base_ptr x_, base_ptr y_, const Value &v)

{ // 参数x_ 为新值插入点,参数y_为插入点之父节点,参数v为新值

link_type x = (link_type) x_;

link_type y = (link_type) y_;

link_type z; // key_compare 是键值大小比较准则。应该会是个function object

if(y == header || x != 0 || key_compare(KeyOfValue()(v), key(y) )) {

z = create_node(v); // 产生一个新节点

left(y) = z; // 这使得当y即为header时,leftmost() = z

if(y == header) {

root() = z;

rightmost() = z;

}

else if(y == leftmost()) // 如果y为最左节点

leftmost() = z; // 维护leftmost(),使它永远指向最左节点

}

else {

z = create_node(v); // 产生一个新节点

right(y) = z; // 令新节点成为插入点之父节点y的右子节点

if(y == rightmost())

rightmost() = z; // 维护rightmost(),使它永远指向最右节点

}

parent(z) = y; // 设定新节点的父节点

left(z) = 0; // 设定新节点的左子节点

right(z) = 0; // 设定新节点的右子节点

// 新节点的颜色将在_rb_tree_rebalance()设定(并调整)

_rb_tree_rebalance(z, header->parent); // 参数一为新增节点,参数二为根节点root

++node_count; // 节点数累加

return iterator(z); // 返回一个迭代器,指向新增节点

}

// 全局函数

// 重新令树形平衡(改变颜色及旋转树形)

// 参数一为新增节点,参数二为根节点root

inline void _rb_tree_rebalance(_rb_tree_node_base* x, _rb_tree_node_base*& root) {

x->color = _rb_tree_red; //新节点必为红

while(x != root && x->parent->color == _rb_tree_red) // 父节点为红

{

if(x->parent == x->parent->parent->left) // 父节点为祖父节点之左子节点

{

_rb_tree_node_base* y = x->parent->parent->right; // 令y为伯父节点

if(y && y->color == _rb_tree_red) // 伯父节点存在,且为红

{

x->parent->color = _rb_tree_black; // 更改父节点为黑色

y->color = _rb_tree_black; // 更改伯父节点为黑色

x->parent->parent->color = _rb_tree_red; // 更改祖父节点为红色

x = x->parent->parent;

}

else // 无伯父节点,或伯父节点为黑色

{

if(x == x->parent->right) // 如果新节点为父节点之右子节点

{

x = x->parent;

_rb_tree_rotate_left(x, root); // 第一个参数为左旋点

}

x->parent->color = _rb_tree_black; // 改变颜色

x->parent->parent->color = _rb_tree_red;

_rb_tree_rotate_right(x->parent->parent, root); // 第一个参数为右旋点

}

}

else // 父节点为祖父节点之右子节点

{

_rb_tree_node_base* y = x->parent->parent->left; // 令y为伯父节点

if(y && y->color == _rb_tree_red) // 有伯父节点,且为红

{

x->parent->color = _rb_tree_black; // 更改父节点为黑色

y->color = _rb_tree_black; // 更改伯父节点为黑色

x->parent->parent->color = _rb_tree_red; // 更改祖父节点为红色

x = x->parent->parent; // 准备继续往上层检查

}

else // 无伯父节点,或伯父节点为黑色

{

if(x == x->parent->left) // 如果新节点为父节点之左子节点

{

x = x->parent;

_rb_tree_rotate_right(x, root); // 第一个参数为右旋点

}

x->parent->color = _rb_tree_black; // 改变颜色

x->parent->parent->color = _rb_tree_red;

_rb_tree_rotate_left(x->parent->parent, root); // 第一个参数为左旋点

}

}

}//while

root->color = _rb_tree_black; // 根节点永远为黑色

}

// 左旋函数

inline void _rb_tree_rotate_left(_rb_tree_node_base* x, _rb_tree_node_base*& root)

{

// x 为旋转点

_rb_tree_node_base* y = x->right; // 令y为旋转点的右子节点

x->right = y->left;

if(y->left != 0)

y->left->parent = x; // 别忘了回马枪设定父节点

y->parent = x->parent;

// 令y完全顶替x的地位(必须将x对其父节点的关系完全接收过来)

if(x == root) // x为根节点

root = y;

else if(x == x->parent->left) // x为其父节点的左子节点

x->parent->left = y;

else // x为其父节点的右子节点

x->parent->right = y;

y->left = x;

x->parent = y;

}

// 右旋函数

inline void _rb_tree_rotate_right(_rb_tree_node_base* x, _rb_tree_node_base*& root)

{

// x 为旋转点

_rb_tree_node_base* y = x->left; // 令y为旋转点的左子节点

x->left = y->right;

if(y->right != 0)

y->right->parent = x; // 别忘了回马枪设定父节点

y->parent = x->parent; // 令y完全顶替x的地位(必须将x对其父节点的关系完全接收过来)

if(x == root)

root = y;

else if(x == x->parent->right) // x为其父节点的右子节点

x->parent->right = y;

else // x为其父节点的左子节点

x->parent->left = y;

y->right = x;

x->parent = y;

}

算法导论书上给出的红黑树的性质如下,跟STL源码剖析书上面的4条性质大同小异。

- 每个结点或是红色的,或是黑色的

- 根节点是黑色的

- 每个叶结点(NIL)是黑色的

- 如果一个节点是红色的,则它的两个儿子都是黑色的。

- 对于每个结点,从该结点到其子孙结点的所有路径上包含相同数目的黑色结点。

从红黑树上删除一个节点,可以先用普通二叉搜索树的方法,将节点从红黑树上删除掉,然后再将被破坏的红黑性质进行恢复。我们回忆一下普通二叉树的节点删除方法:Z指向需要删除的节点,Y指向实质结构上被删除的结点,如果Z节点只有一个子节点或没有子节点,那么Y就是指向Z指向的节点。如果Z节点有两个子节点,那么Y指向Z节点的后继节点(其实前趋也是一样的),而Z的后继节点绝对不可能有左子树。因此,仅从结构来看,二叉树上实质被删除的节点最多只可能有一个子树。

现在我们来看红黑性质的恢复过程:如果Y指向的节点是个红色节点,那么直接删除掉Y以后,红黑性质不会被破坏。操作结束。如果Y指向的节点是个黑色节点,那么就有几条红黑性质可能受到破坏了。首先是包含Y节点的所有路径,黑高度都减少了一(第5条被破坏)。其次,如果Y的有红色子节点,Y又有红色的父节点,那么Y被删除后,就出现了两个相邻的红色节点(第4条被破坏)。最后,如果Y指向的是根节点,而Y的子节点又是红色的,那么Y被删除后,根节点就变成红色的了(第2条被破坏)。其中,第5条被破坏是让我们比较难受的。因为这影响到了全局。这样动作就太大太复杂了。而且在这个条件下,进行其它红黑性质的恢复也很困难。

所以我们首先解决这个问题:如果不改变含Y路径的黑高度,那么树的其它部分的黑高度就必须做出相应的变化来适应它。所以,我们想办法恢复原来含Y节点的路径的黑高度。做法就是:无条件的把Y节点的黑色,推到它的子节点X上去。(X可能是NIL节点)。这样,X就可能具有双重黑色,或同时具有红黑两色,也就是第1条性质被破坏了。但第1条性质是比较容易恢复的:

- 如果X是同时具有红黑两色,那么好办,直接把X涂成黑色,就行了。而且这样把所有问题都解决了。因为将X变为黑色,2、4两条如果有问题的话也会得到恢复,算法结束。

- 如果X是双黑色,那么我们希望把这种情况向上推一直推到根节点(调整树结构和颜色,X的指向新的双黑色节点,X不断向上移动),让根节点具双黑色,这时,直接把X的一层黑色去掉就行了(因为根节点被包含在所有的路径上,所以这样做所有路径同时黑高减少一,不会破坏红黑特征)。

下面就具体地分析如何恢复1、2、4三个可能被破坏的红黑特性:我们知道,如果X指向的节点是有红黑两色,或是X是根节点时,只需要简单的对X进行一些改变就行了。要对除X节点外的其它节点进行操作时,必定是这样的情况:X节点是双层黑色,且X有父节点P。由知可知,X必然有兄弟节点W,而且这个W节点必定有两个子节点。(因为这是原树满足红黑条件要求而自然具备的。X为双黑色,那么P的另一个子节点以下一定要有至少两层的节点,否则黑色高度不可能和X路径一致)。所以我们就分析这些节点之间如何变形,把问题限制在比较小的范围内解决。另一个前提是:X在一开始,肯定是树底的叶节点或是NIL节点,所以在递归向上的过程中,每一步都保证下一步进行时,至少X的子树是满足红黑特性的。因此子树的情况就可以认为是已经正确的了,这样,分析就只限制在X节点,X的父节点P和X的兄弟节点W,以及W的两个子节点中。

下面仅仅考虑X原本是黑色的情况即可。在这种情况下,X此时应该具有双重黑色,算法的过程就是将这多出的一重黑色向上移动,直到遇到红节点或者根节点。接着往下分析,会遇到4种情况,实际上是8种,因为其中4种是相互对称的,这可以通过判断X是其父节点的右孩子还是左孩子来区分。下面我们以X是其父节点的左孩子的情况来分析这4种情况,实际上接下来的调整过程,就是要想方设法将经过X的所有路径上的黑色节点个数增加1。

具体分为以下四种情况:(下面针对x是左儿子的情况讨论,右儿子对称)

Case1:X的兄弟W是红色(想办法将其变为黑色)。由于W是红色的,因此其儿子节点和父节点必为黑色,只要将W和其父节点的颜色对换,在对父节点进行一次左旋转,便将W的左子节点放到了X的兄弟节点上,X的兄弟节点变成了黑色,且红黑性质不变。但还不算完,只是暂时将情况1转变成了下面的情况2或3或4。

Case2:X的兄弟节点W是黑色的,而且W的两个子节点都是黑色的。此时可以将X的一重黑色和W的黑色同时去掉,而转加给他们的父节点上,这是X就指向它的父节点了,因此此时父节点具有双重颜色了。这一重黑色节点上移。

如果父节点原来是红色的,现在又加一层黑色,那么X现在指向的这个节点就是红黑两色的,直接把X(也就是父节点)着为黑色。问题就已经完整解决了。如果父节点现在是双层黑色,那就以父节点为新的X进行向上的下一次的递归。

Case3:X的兄弟节点W是黑色的,而且W的左子节点是红色的,右子节点是黑色的。此时通过交换W和其左子节点的颜色并进行一次向右旋转就可转换成下面的第四种情况。注意,原来L是红色的,所以L的子节点一定是黑色的,所以旋转中L节点的一个子树挂到之后着为红色的W节点上不会破坏红黑性质。变形后黑色高度不变。

Case4:X的兄弟节点W是黑色的,而且W的右子节点是红色的。这种情况下,做一次左旋,W就处于根的位置,将W保持为原来的根的位置的颜色,同时将W的两个新的儿子节点的颜色变为黑色,去掉X的一重黑色。这样整个问题也就得到了解决。递归结束。(在代码上,为了标识递归结束,我们把X指向根节点)

因此,只要按上面四种情况一直递归处理下去,X最终总会指向根结点或一个红色结点,这时我们就可以结束递归并把问题解决了。

以上就是红黑树的节点删除全过程。

总结:如果我们通过上面的情况画出所有的分支图,我们可以得出如下结论

- 插入操作:解决的是 红-红 问题

- 删除操作:解决的是 黑-黑 问题

即你可以从分支图中看出,需要往上遍历的情况为红红(插入),或者为黑黑黑(删除)的情况,如果你认真分析并总结所有的情况后,并坚持下来,红黑树也就没有想象中的那么恐怖了,并且很美妙;

详细的红黑树删除节点的代码如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

150

151

152

153

154

155

156

157

158

159

160

161

162

163

164

165

166

167

168

169

170

171

172

173

174

175

176

177

178

179

180

181

182

183

184

185

186

187

188

189

190

191

192

193

194

195

196

197

198

199

200

201

202

203

204

205

206

207

208

209

using namespace std;

// 定义节点颜色

enum COLOR {

BLACK = 0,

RED

};

// 红黑树节点

typedef struct RB_Tree_Node {

int key;

struct RB_Tree_Node *left;

struct RB_Tree_Node *right;

struct RB_Tree_Node *parent;

unsigned char RB_COLOR;

} RB_Node;

// 红黑树,包含一个指向根节点的指针

typedef struct RBTree {

RB_Node* root;

} *RB_Tree;

// 红黑树的NIL节点

static RB_Tree_Node NIL = {0, 0, 0, 0, BLACK};

void Init_RBTree(RB_Tree pTree) // 初始化一棵红黑树

{

pTree->root = PNIL;

}

// 查找最小键值节点

RB_Node* RBTREE_MIN(RB_Node* pRoot)

{

while (PNIL != pRoot->left)

{

pRoot = pRoot->left;

}

return pRoot;

}

// 查找指定节点的后继节点

RB_Node* RBTREE_SUCCESSOR(RB_Node* pRoot)

{

if (PNIL != pRoot->right)

{

return RBTREE_MIN(pRoot->right);

}

// 节点没有右子树的时候,进入下面的while循环

RB_Node* pParent = pRoot->parent;

while((PNIL != pParent) && (pRoot == pParent->right))

{

pRoot = pParent;

pParent = pRoot->parent;

}

return pParent;

}

// 红黑树的节点删除

RB_Node* Delete(RB_Tree pTree , RB_Node* pDel)

{

RB_Node* rel_delete_point;

if(pDel->left == PNIL || pDel->right == PNIL)

rel_delete_point = pDel;

else

rel_delete_point = RBTREE_SUCCESSOR(pDel);

// 查找后继节点

RB_Node* delete_point_child;

if(rel_delete_point->right != PNIL)

{

delete_point_child = rel_delete_point->right;

}

else if(rel_delete_point->left != PNIL)

{

delete_point_child = rel_delete_point->left;

}

else

{

delete_point_child = PNIL;

}

delete_point_child->parent = rel_delete_point->parent;

if(rel_delete_point->parent == PNIL) // 删除的节点是根节点

{

pTree->root = delete_point_child;

}

else if(rel_delete_point == rel_delete_point->parent->right)

{

rel_delete_point->parent->right = delete_point_child;

}

else

{

rel_delete_point->parent->left = delete_point_child;

}

if(pDel != rel_delete_point)

{

pDel->key = rel_delete_point->key;

}

if(rel_delete_point->RB_COLOR == BLACK)

{

DeleteFixUp(pTree , delete_point_child);

}

return rel_delete_point;

}

/*算法导论上的描述如下:

RB-DELETE-FIXUP(T, x)

1 while x ≠ root[T] and color[x] = BLACK

2 do if x = left[p[x]]

3 then w ← right[p[x]]

4 if color[w] = RED

5 then color[w] ← BLACK Case 1

6 color[p[x]] ← RED Case 1

7 LEFT-ROTATE(T, p[x]) Case 1

8 w ← right[p[x]] Case 1

9 if color[left[w]] = BLACK and color[right[w]] = BLACK

10 then color[w] ← RED Case 2

11 x p[x] Case 2

12 else if color[right[w]] = BLACK

13 then color[left[w]] ← BLACK Case 3

14 color[w] ← RED Case 3

15 RIGHT-ROTATE(T, w) Case 3

16 w ← right[p[x]] Case 3

17 color[w] ← color[p[x]] Case 4

18 color[p[x]] ← BLACK Case 4

19 color[right[w]] ← BLACK Case 4

20 LEFT-ROTATE(T, p[x]) Case 4

21 x ← root[T] Case 4

22 else (same as then clause with "right" and "left" exchanged)

23 color[x] ← BLACK */

//接下来的工作,很简单,即把上述伪代码改写成c++代码即可

void DeleteFixUp(RB_Tree pTree , RB_Node* node)

{

while(node != pTree->root && node->RB_COLOR == BLACK)

{

if(node == node->parent->left)

{

RB_Node* brother = node->parent->right;

if(brother->RB_COLOR==RED) //情况1:x的兄弟w是红色的。

{

brother->RB_COLOR = BLACK;

node->parent->RB_COLOR = RED;

RotateLeft(node->parent);

}

else //情况2:x的兄弟w是黑色的,

{

if(brother->left->RB_COLOR == BLACK && brother->right->RB_COLOR == BLACK) //w的两个孩子都是黑色的

{

brother->RB_COLOR = RED;

node = node->parent;

}

else

{

if(brother->right->RB_COLOR == BLACK) //情况3:x的兄弟w是黑色的,w的右孩子是黑色(w的左孩子是红色)

{

brother->RB_COLOR = RED;

brother->left->RB_COLOR = BLACK;

RotateRight(brother);

brother = node->parent->right; //情况3转换为情况4

} //情况4:x的兄弟w是黑色的,且w的右孩子时红色的

brother->RB_COLOR = node->parent->RB_COLOR;

node->parent->RB_COLOR = BLACK;

brother->right->RB_COLOR = BLACK;

RotateLeft(node->parent);

node = pTree->root;

}//else

}//else

}

else //同上,原理一致,只是遇到左旋改为右旋,遇到右旋改为左旋即可。其它代码不变。

{

RB_Node* brother = node->parent->left;

if(brother->RB_COLOR == RED)

{

brother->RB_COLOR = BLACK;

node->parent->RB_COLOR = RED;

RotateRight(node->parent);

}

else

{

if(brother->left->RB_COLOR==BLACK && brother->right->RB_COLOR == BLACK)

{

brother->RB_COLOR = RED;

node = node->parent;

}

else

{

if(brother->left->RB_COLOR==BLACK)

{

brother->RB_COLOR = RED;

brother->right->RB_COLOR = BLACK;

RotateLeft(brother);

brother = node->parent->left; //情况3转换为情况4

}

brother->RB_COLOR = node->parent->RB_COLOR;

node->parent->RB_COLOR = BLACK;

brother->left->RB_COLOR = BLACK;

RotateRight(node->parent);

node = pTree->root;

}

}

}

}//while

node->RB_COLOR = BLACK; //如果X节点原来为红色,那么直接改为黑色

}

斜堆之图文解析和C语言的实现

概要

本章介绍斜堆。和以往一样,本文会先对斜堆的理论知识进行简单介绍,然后给出C语言的实现。后续再分别给出C++和Java版本的实现;实现的语言虽不同,但是原理如出一辙,选择其中之一进行了解即可。若文章有错误或不足的地方,请不吝指出!

目录

- 斜堆的介绍

- 斜堆的基本操作

- 斜堆的C实现(完整源码)

- 斜堆的C测试程序

转载请注明出处:http://www.cnblogs.com/skywang12345/p/3638493.html

斜堆的介绍

斜堆(Skew heap)也叫自适应堆(self-adjusting heap),它是左倾堆的一个变种。和左倾堆一样,它通常也用于实现优先队列。它的合并操作的时间复杂度也是O(lg n)。

相比于左倾堆,斜堆的节点没有”零距离”这个属性。除此之外,它们斜堆的合并操作也不同。斜堆的合并操作算法如下:

(01) 如果一个空斜堆与一个非空斜堆合并,返回非空斜堆。

(02) 如果两个斜堆都非空,那么比较两个根节点,取较小堆的根节点为新的根节点。将”较小堆的根节点的右孩子”和”较大堆”进行合并。

(03) 合并后,交换新堆根节点的左孩子和右孩子。

第(03)步是斜堆和左倾堆的合并操作差别的关键所在,如果是左倾堆,则合并后要比较左右孩子的零距离大小,若右孩子的零距离 > 左孩子的零距离,则交换左右孩子;最后,在设置根的零距离。

头文件

1 |

|

SkewNode是斜堆对应的节点类。

合并

1 | /* |

merge_skewheap(x, y)的作用是合并x和y这两个斜堆,并返回得到的新堆。merge_skewheap(x, y)是递归实现的。

添加

1 | /* |

insert_skewheap(heap, key)的作用是新建键值为key的结点,并将其插入到斜堆中,并返回堆的根节点。

删除

1 | /* |

delete_skewheap(heap)的作用是删除斜堆的最小节点,并返回删除节点后的斜堆根节点。

斜堆的C实现(完整源码)

斜堆的头文件(skewheap.h)1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

typedef int Type;

typedef struct _SkewNode{

Type key; // 关键字(键值)

struct _SkewNode *left; // 左孩子

struct _SkewNode *right; // 右孩子

}SkewNode, *SkewHeap;

// 前序遍历"斜堆"

void preorder_skewheap(SkewHeap heap);

// 中序遍历"斜堆"

void inorder_skewheap(SkewHeap heap);

// 后序遍历"斜堆"

void postorder_skewheap(SkewHeap heap);

// 获取最小值(保存到pval中),成功返回0,失败返回-1。

int skewheap_minimum(SkewHeap heap, int *pval);

// 合并"斜堆x"和"斜堆y",并返回合并后的新树

SkewNode* merge_skewheap(SkewHeap x, SkewHeap y);

// 将结点插入到斜堆中,并返回根节点

SkewNode* insert_skewheap(SkewHeap heap, Type key);

// 删除结点(key为节点的值),并返回根节点

SkewNode* delete_skewheap(SkewHeap heap);

// 销毁斜堆

void destroy_skewheap(SkewHeap heap);

// 打印斜堆

void print_skewheap(SkewHeap heap);

斜堆的实现文件(skewheap.c)1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

150

151

152

153

154

155

156

157

158

159

160

161

162

163

164

165

166

167

168

169

170

171

172

173

174

175

176

177

178

179

180

181

182

183

184

185

186/**

* C语言实现的斜堆

*

* @author skywang

* @date 2014/03/31

*/

/*

* 前序遍历"斜堆"

*/

void preorder_skewheap(SkewHeap heap)

{

if(heap != NULL)

{

printf("%d ", heap->key);

preorder_skewheap(heap->left);

preorder_skewheap(heap->right);

}

}

/*

* 中序遍历"斜堆"

*/

void inorder_skewheap(SkewHeap heap)

{

if(heap != NULL)

{

inorder_skewheap(heap->left);

printf("%d ", heap->key);

inorder_skewheap(heap->right);

}

}

/*

* 后序遍历"斜堆"

*/

void postorder_skewheap(SkewHeap heap)

{

if(heap != NULL)

{

postorder_skewheap(heap->left);

postorder_skewheap(heap->right);

printf("%d ", heap->key);

}

}

/*

* 交换两个节点的内容

*/

static void swap_skewheap_node(SkewNode *x, SkewNode *y)

{

SkewNode tmp = *x;

*x = *y;

*y = tmp;

}

/*

* 获取最小值

*

* 返回值:

* 成功返回0,失败返回-1

*/

int skewheap_minimum(SkewHeap heap, int *pval)

{

if (heap == NULL)

return -1;

*pval = heap->key;

return 0;

}

/*

* 合并"斜堆x"和"斜堆y"

*

* 返回值:

* 合并得到的树的根节点

*/

SkewNode* merge_skewheap(SkewHeap x, SkewHeap y)

{

if(x == NULL)

return y;

if(y == NULL)

return x;

// 合并x和y时,将x作为合并后的树的根;

// 这里的操作是保证: x的key < y的key

if(x->key > y->key)

swap_skewheap_node(x, y);

// 将x的右孩子和y合并,

// 合并后直接交换x的左右孩子,而不需要像左倾堆一样考虑它们的npl。

SkewNode *tmp = merge_skewheap(x->right, y);

x->right = x->left;

x->left = tmp;

return x;

}

/*

* 新建结点(key),并将其插入到斜堆中

*

* 参数说明:

* heap 斜堆的根结点

* key 插入结点的键值

* 返回值:

* 根节点

*/

SkewNode* insert_skewheap(SkewHeap heap, Type key)

{

SkewNode *node; // 新建结点

// 如果新建结点失败,则返回。

if ((node = (SkewNode *)malloc(sizeof(SkewNode))) == NULL)

return heap;

node->key = key;

node->left = node->right = NULL;

return merge_skewheap(heap, node);

}

/*

* 取出根节点

*

* 返回值:

* 取出根节点后的新树的根节点

*/

SkewNode* delete_skewheap(SkewHeap heap)

{

SkewNode *l = heap->left;

SkewNode *r = heap->right;

// 删除根节点

free(heap);

return merge_skewheap(l, r); // 返回左右子树合并后的新树

}

/*

* 销毁斜堆

*/

void destroy_skewheap(SkewHeap heap)

{

if (heap==NULL)

return ;

if (heap->left != NULL)

destroy_skewheap(heap->left);

if (heap->right != NULL)

destroy_skewheap(heap->right);

free(heap);

}

/*

* 打印"斜堆"

*

* heap -- 斜堆的节点

* key -- 节点的键值

* direction -- 0,表示该节点是根节点;

* -1,表示该节点是它的父结点的左孩子;

* 1,表示该节点是它的父结点的右孩子。

*/

static void skewheap_print(SkewHeap heap, Type key, int direction)

{

if(heap != NULL)

{

if(direction==0) // heap是根节点

printf("%2d is root\n", heap->key);

else // heap是分支节点

printf("%2d is %2d's %6s child\n", heap->key, key, direction==1?"right" : "left");

skewheap_print(heap->left, heap->key, -1);

skewheap_print(heap->right,heap->key, 1);

}

}

void print_skewheap(SkewHeap heap)

{

if (heap != NULL)

skewheap_print(heap, heap->key, 0);

}

斜堆的测试程序(skewheap_test.c)1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51/**

* C语言实现的斜堆

*

* @author skywang

* @date 2014/03/31

*/

void main()

{

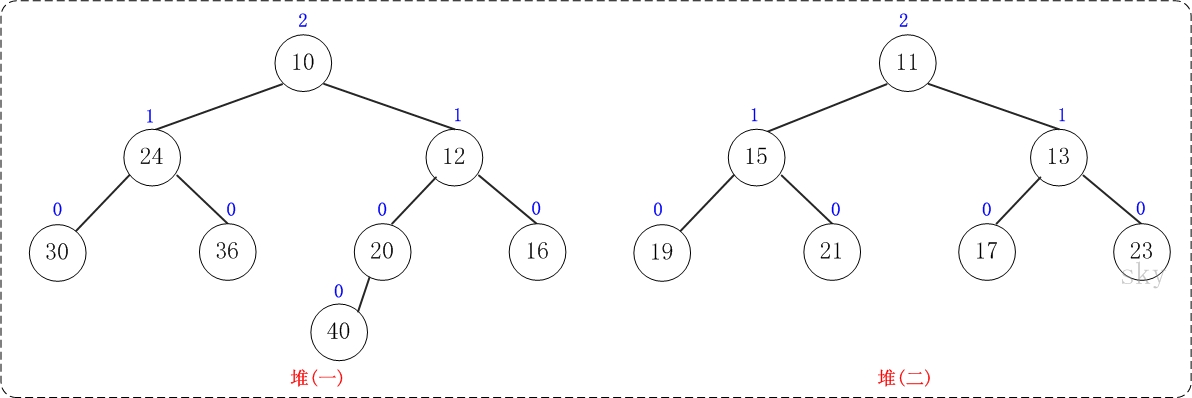

int i;

int a[]= {10,40,24,30,36,20,12,16};

int b[]= {17,13,11,15,19,21,23};

int alen=LENGTH(a);

int blen=LENGTH(b);

SkewHeap ha,hb;

ha=hb=NULL;

printf("== 斜堆(ha)中依次添加: ");

for(i=0; i<alen; i++)

{

printf("%d ", a[i]);

ha = insert_skewheap(ha, a[i]);

}

printf("\n== 斜堆(ha)的详细信息: \n");

print_skewheap(ha);

printf("\n== 斜堆(hb)中依次添加: ");

for(i=0; i<blen; i++)

{

printf("%d ", b[i]);

hb = insert_skewheap(hb, b[i]);

}

printf("\n== 斜堆(hb)的详细信息: \n");

print_skewheap(hb);

// 将"斜堆hb"合并到"斜堆ha"中。

ha = merge_skewheap(ha, hb);

printf("\n== 合并ha和hb后的详细信息: \n");

print_skewheap(ha);

// 销毁斜堆

destroy_skewheap(ha);

}

左倾堆之图文解析和C语言的实现

概要

本章介绍左倾堆,它和二叉堆一样,都是堆结构中的一员。和以往一样,本文会先对左倾堆的理论知识进行简单介绍,然后给出C语言的实现。后续再分别给出C++和Java版本的实现;实现的语言虽不同,但是原理如出一辙,选择其中之一进行了解即可。若文章有错误或不足的地方,请不吝指出!

目录

- 左倾堆的介绍

- 左倾堆的图文解析

- 左倾堆的C实现(完整源码)

- 左倾堆的C测试程序

转载请注明出处:http://www.cnblogs.com/skywang12345/p/3638327.html

左倾堆的介绍

左倾堆(leftist tree 或 leftist heap),又被成为左偏树、左偏堆,最左堆等。

它和二叉堆一样,都是优先队列实现方式。当优先队列中涉及到”对两个优先队列进行合并”的问题时,二叉堆的效率就无法令人满意了,而本文介绍的左倾堆,则可以很好地解决这类问题。

左倾堆的定义

左倾堆是一棵二叉树,它的节点除了和二叉树的节点一样具有左右子树指针外,还有两个属性:键值和零距离。

(01) 键值的作用是来比较节点的大小,从而对节点进行排序。

(02) 零距离(英文名NPL,即Null Path Length)则是从一个节点到一个”最近的不满节点”的路径长度。不满节点是指该该节点的左右孩子至少有有一个为NULL。叶节点的NPL为0,NULL节点的NPL为-1。

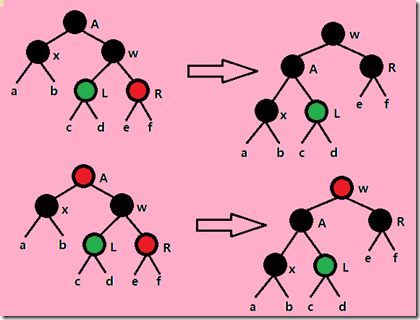

上图是一颗左倾堆,它满足左倾堆的基本性质:

[性质1] 节点的键值小于或等于它的左右子节点的键值。

[性质2] 节点的左孩子的NPL >= 右孩子的NPL。

[性质3] 节点的NPL = 它的右孩子的NPL + 1。

左倾堆,顾名思义,是有点向左倾斜的意思了。它在统计问题、最值问题、模拟问题和贪心问题等问题中有着广泛的应用。此外,斜堆是比左倾堆更为一般的数据结构。当然,今天讨论的是左倾堆,关于斜堆,以后再撰文来表。

前面说过,它能和好的解决”两个优先队列合并”的问题。实际上,左倾堆的合并操作的平摊时间复杂度为O(lg n),而完全二叉堆为O(n)。合并就是左倾树的重点,插入和删除操作都是以合并操作为基础的。插入操作,可以看作两颗左倾树合并;删除操作(移除优先队列中队首元素),则是移除根节点之后再合并剩余的两个左倾树。闲话说到这里,下面开始介绍左倾树的基本方法。

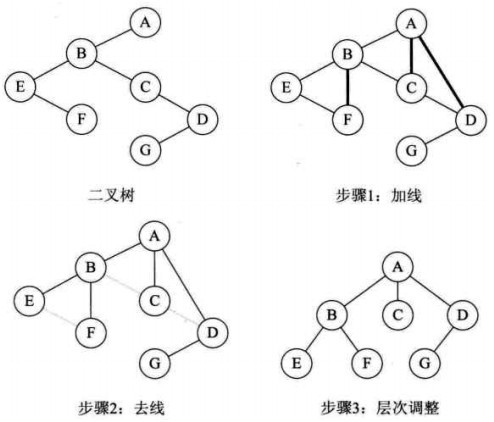

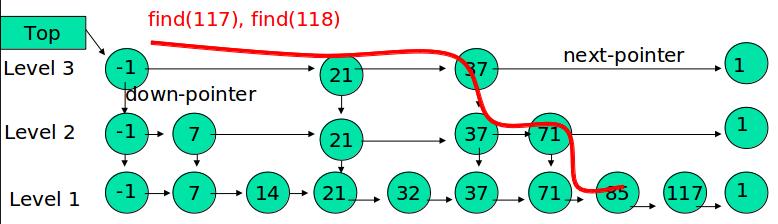

左倾堆的图文解析

合并操作是左倾堆的重点。合并两个左倾堆的基本思想如下:

- 如果一个空左倾堆与一个非空左倾堆合并,返回非空左倾堆。

- 如果两个左倾堆都非空,那么比较两个根节点,取较小堆的根节点为新的根节点。将”较小堆的根节点的右孩子”和”较大堆”进行合并。

- 如果新堆的右孩子的NPL > 左孩子的NPL,则交换左右孩子。

- 设置新堆的根节点的NPL = 右子堆NPL + 1

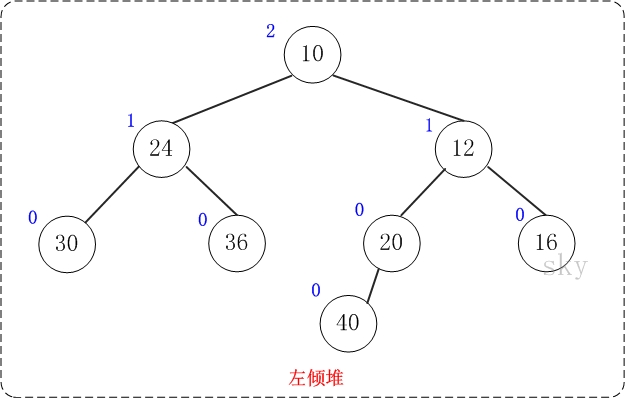

下面通过图文演示合并以下两个堆的过程。

提示:这两个堆的合并过程和测试程序相对应!

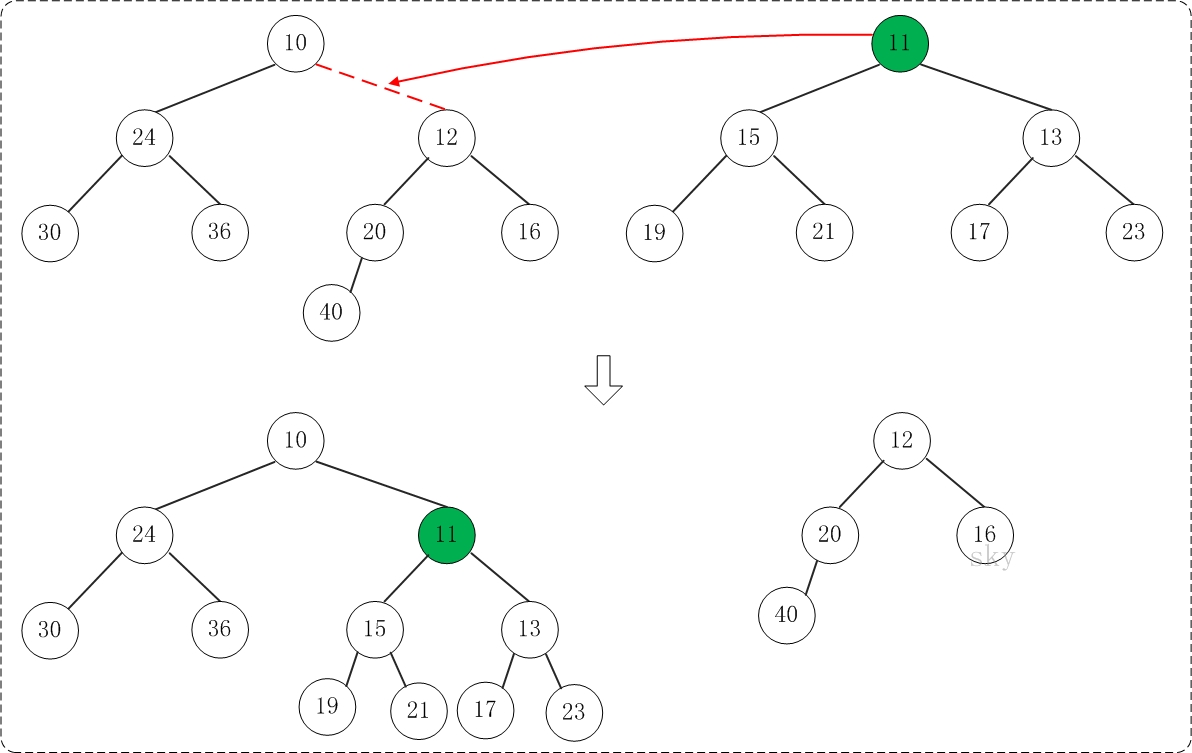

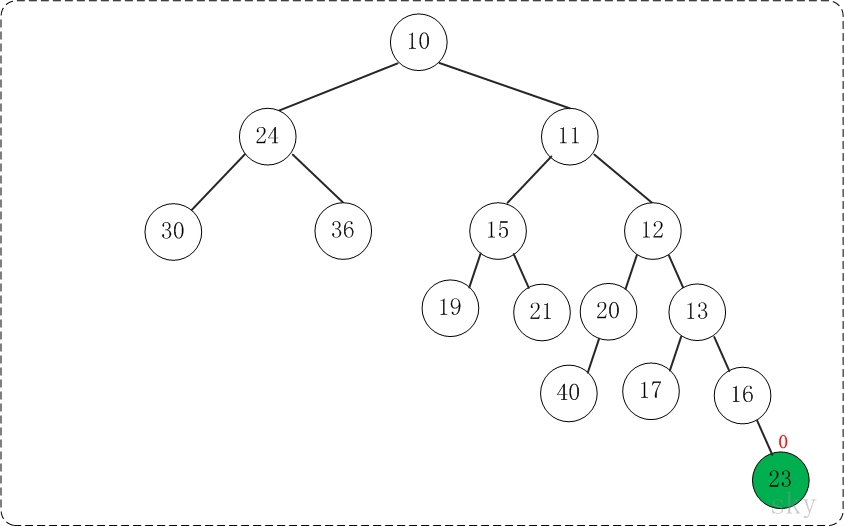

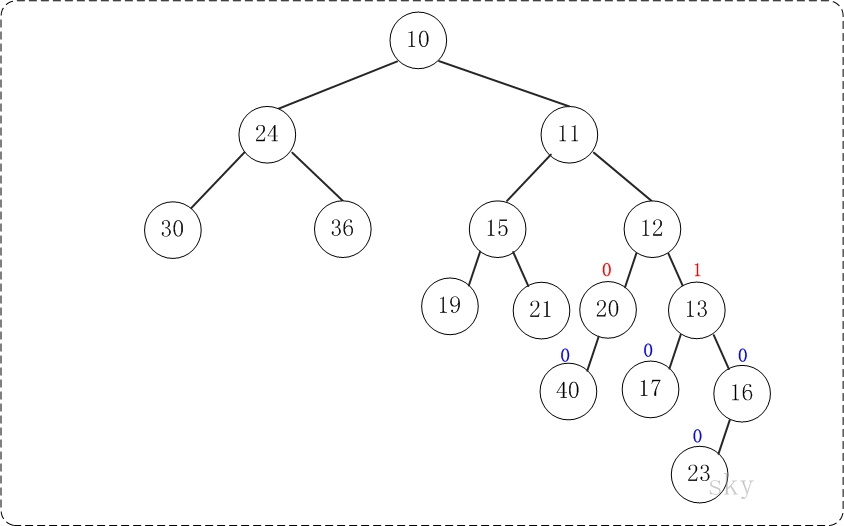

第1步:将”较小堆(根为10)的右孩子”和”较大堆(根为11)”进行合并。

合并的结果,相当于将”较大堆”设置”较小堆”的右孩子,如下图所示:

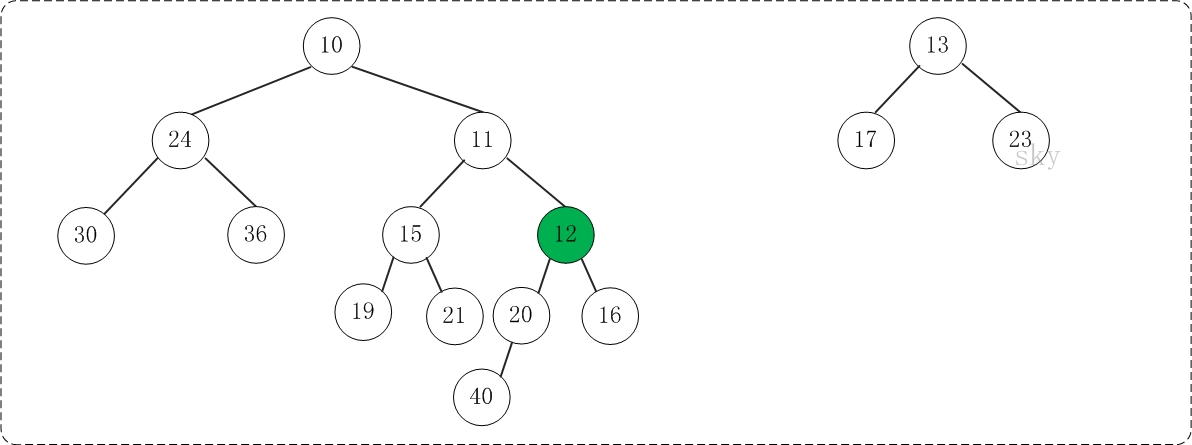

第2步:将上一步得到的”根11的右子树”和”根为12的树”进行合并,得到的结果如下:

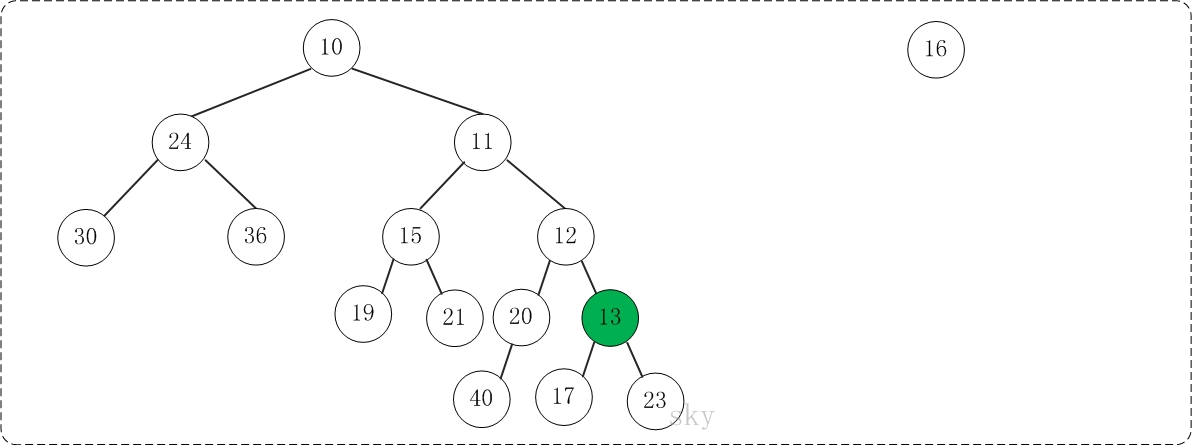

第3步:将上一步得到的”根12的右子树”和”根为13的树”进行合并,得到的结果如下:

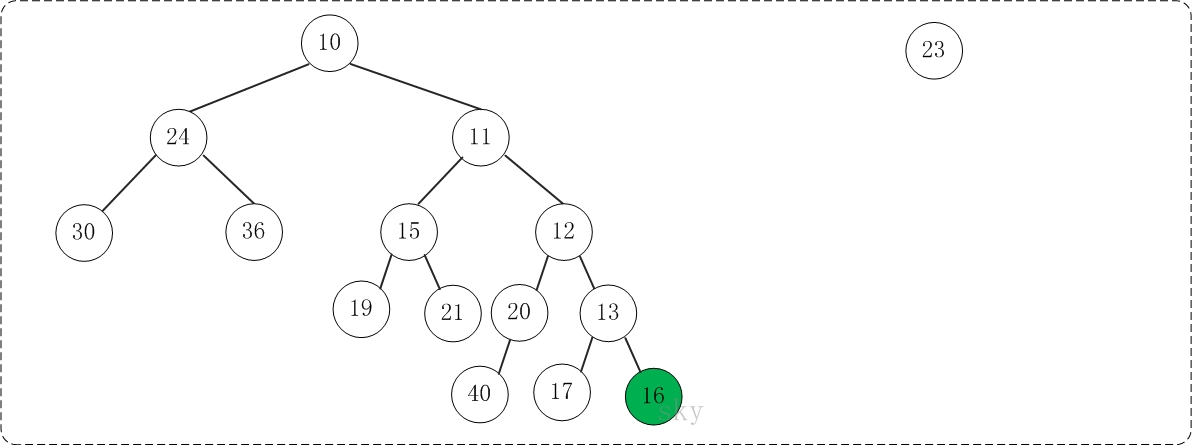

第4步:将上一步得到的”根13的右子树”和”根为16的树”进行合并,得到的结果如下:

第5步:将上一步得到的”根16的右子树”和”根为23的树”进行合并,得到的结果如下:

至此,已经成功的将两棵树合并成为一棵树了。接下来,对新生成的树进行调节。

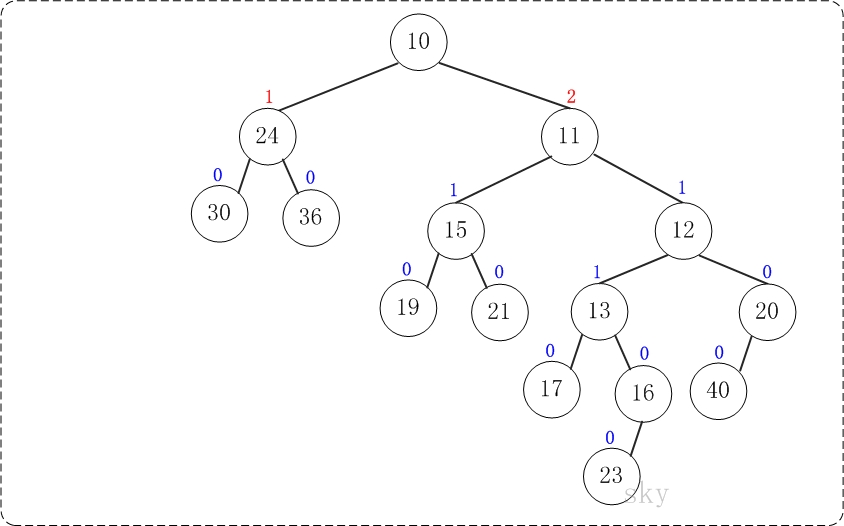

第6步:上一步得到的”树16的右孩子的NPL > 左孩子的NPL”,因此交换左右孩子。得到的结果如下:

第7步:上一步得到的”树12的右孩子的NPL > 左孩子的NPL”,因此交换左右孩子。得到的结果如下:

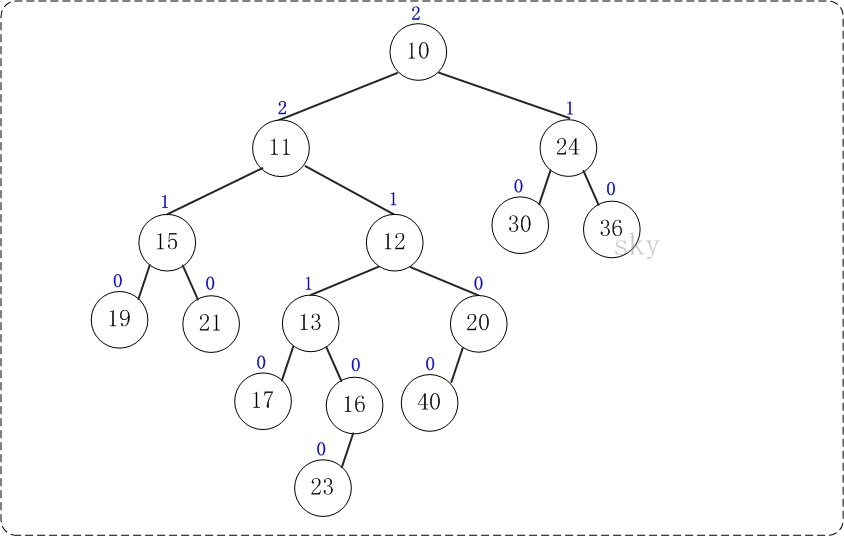

第8步:上一步得到的”树10的右孩子的NPL > 左孩子的NPL”,因此交换左右孩子。得到的结果如下:

至此,合并完毕。上面就是合并得到的左倾堆!

下面看看左倾堆的基本操作的代码

- 头文件LeftistNode是左倾堆对应的节点类。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

typedef int Type;

typedef struct _LeftistNode{

Type key; // 关键字(键值)

int npl; // 零路经长度(Null Path Length)

struct _LeftistNode *left; // 左孩子

struct _LeftistNode *right; // 右孩子

}LeftistNode, *LeftistHeap;

// 前序遍历"左倾堆"

void preorder_leftist(LeftistHeap heap);

// 中序遍历"左倾堆"

void inorder_leftist(LeftistHeap heap);

// 后序遍历"左倾堆"

void postorder_leftist(LeftistHeap heap);

// 获取最小值(保存到pval中),成功返回0,失败返回-1。

int leftist_minimum(LeftistHeap heap, int *pval);

// 合并"左倾堆x"和"左倾堆y",并返回合并后的新树

LeftistNode* merge_leftist(LeftistHeap x, LeftistHeap y);

// 将结点插入到左倾堆中,并返回根节点

LeftistNode* insert_leftist(LeftistHeap heap, Type key);

// 删除结点(key为节点的值),并返回根节点

LeftistNode* delete_leftist(LeftistHeap heap);

// 销毁左倾堆

void destroy_leftist(LeftistHeap heap);

// 打印左倾堆

void print_leftist(LeftistHeap heap);

- 合并

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37/*

* 合并"左倾堆x"和"左倾堆y"

*

* 返回值:

* 合并得到的树的根节点

*/

LeftistNode* merge_leftist(LeftistHeap x, LeftistHeap y)

{

if(x == NULL)

return y;

if(y == NULL)

return x;

// 合并x和y时,将x作为合并后的树的根;

// 这里的操作是保证: x的key < y的key

if(x->key > y->key)

swap_leftist_node(x, y);

// 将x的右孩子和y合并,"合并后的树的根"是x的右孩子。

x->right = merge_leftist(x->right, y);

// 如果"x的左孩子为空" 或者 "x的左孩子的npl<右孩子的npl"

// 则,交换x和y

if(x->left == NULL || x->left->npl < x->right->npl)

{

LeftistNode *tmp = x->left;

x->left = x->right;

x->right = tmp;

}

// 设置合并后的新树(x)的npl

if (x->right == NULL || x->left == NULL)

x->npl = 0;

else

x->npl = (x->left->npl > x->right->npl) ? (x->right->npl + 1) : (x->left->npl + 1);

return x;

}

merge_leftist(x, y)的作用是合并x和y这两个左倾堆,并返回得到的新堆。merge_leftist(x, y)是递归实现的。

添加

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22/*

* 新建结点(key),并将其插入到左倾堆中

*

* 参数说明:

* heap 左倾堆的根结点

* key 插入结点的键值

* 返回值:

* 根节点

*/

LeftistNode* insert_leftist(LeftistHeap heap, Type key)

{

LeftistNode *node; // 新建结点

// 如果新建结点失败,则返回。

if ((node = (LeftistNode *)malloc(sizeof(LeftistNode))) == NULL)

return heap;

node->key = key;

node->npl = 0;

node->left = node->right = NULL;

return merge_leftist(heap, node);

}insert_leftist(heap, key)的作用是新建键值为key的结点,并将其插入到左倾堆中,并返回堆的根节点。

删除

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19/*

* 取出根节点

*

* 返回值:

* 取出根节点后的新树的根节点

*/

LeftistNode* delete_leftist(LeftistHeap heap)

{

if (heap == NULL)

return NULL;

LeftistNode *l = heap->left;

LeftistNode *r = heap->right;

// 删除根节点

free(heap);

return merge_leftist(l, r); // 返回左右子树合并后的新树

}delete_leftist(heap)的作用是删除左倾堆的最小节点,并返回删除节点后的左倾堆根节点。

左倾堆的头文件(leftist.h)

1 |

|

左倾堆的实现文件(leftist.c)

1 | /** |

左倾堆的测试程序(leftist_test.c)

1 | /** |

左倾堆的C测试程序

左倾堆的测试程序已经包含在它的实现文件(leftist_test.c)中了,这里仅给出它的运行结果:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37== 左倾堆(ha)中依次添加: 10 40 24 30 36 20 12 16

== 左倾堆(ha)的详细信息:

10(2) is root

24(1) is 10's left child

30(0) is 24's left child

36(0) is 24's right child

12(1) is 10's right child

20(0) is 12's left child

40(0) is 20's left child

16(0) is 12's right child

== 左倾堆(hb)中依次添加: 17 13 11 15 19 21 23

== 左倾堆(hb)的详细信息:

11(2) is root

15(1) is 11's left child