进程描述

进程和程序

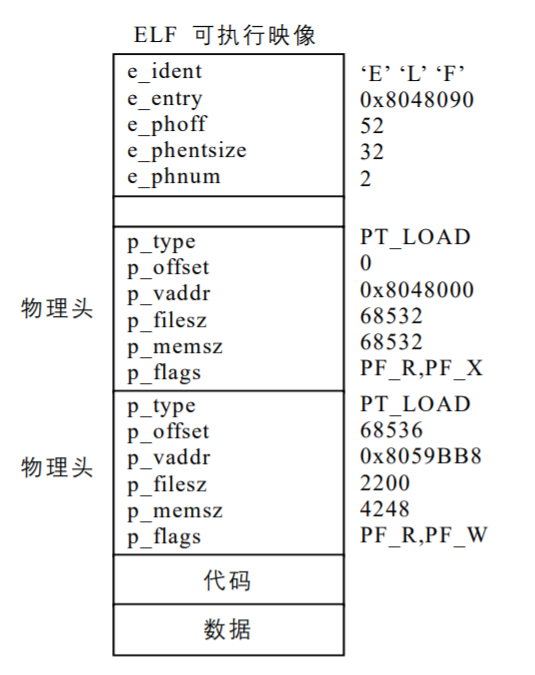

首先我们对进程作一明确定义:所谓进程是由正文段(Text)、用户数据段(User Segment)以及系统数据段(System Segment)共同组成的一个执行环境。程序是一个静态的实体。这里,对可执行映像做进一步解释,可执行映像就是一个可执行文件的内容。程序装入内存后就可以运行了:在指令指针寄存器的控制下,不断地将指令取至CPU运行。

Linux是一个多任务操作系统,也就是说,可以有多个程序同时装入内存并运行,操作系统为每个程序建立一个运行环境即创建进程,每个进程拥有自己的虚拟地址空间,它们之间互不干扰,即使要相互作用(例如多个进程合作完成某个工作),也要通过内核提供的进程间通信机制(IPC)。Linux内核支持多个进程虚拟地并发执行,这是通过不断地保存和切换程序的运行环境而实现的,选择哪个进程运行是由调度程序决定的。

进程是一个动态实体,由 3 个独立的部分组成。

- 正文段(Text):存放被执行的机器指令。这个段是只读的,它允许系统中正在运行的两个或多个进程之间能够共享这一代码。

- 用户数据段(User Segment):存放进程在执行时直接进行操作的所有数据,包括进程使用的全部变量在内。显然,这里包含的信息可以被改变。虽然进程之间可以共享正文段,但是每个进程需要有它自己的专用用户数据段。

- 系统数据段(System Segment):该段有效地存放程序运行的环境。事实上,这正是程序和进程的区别所在。这一部分存放有进程的控制信息。系统中有许多进程,操作系统要管理它们、调度它们运行,就是通过这些控制信息。Linux为每个进程建立了

task_struct数据结构来容纳这些控制信息。

总之,进程是一个程序完整的执行环境。该环境是由正文段、用户数据段、系统数据段的信息交织在一起组成的。

Linux中的进程概述

Linux中的每个进程由一个task_struct数据结构来描述,在Linux中,任务(Task)和进程(Process)是两个相同的术语,task_struct其实就是通常所说的“进程控制块”即PCB。task_struct容纳了一个进程的所有信息,是系统对进程进行控制的唯一手段,也是最有效的手段。

Linux支持多处理机(SMP),所以系统中允许有多个CPU。Linux作为多处理机操作系统时,系统中允许的最大CPU个数为 32。和其他操作系统类似,Linux也支持两种进程:普通进程和实时进程。实时进程具有一定程度上的紧迫性,要求对外部事件做出非常快的响应;而普通进程则没有这种限制。所以,实时进程要比普通进程优先运行。

总之,包含进程所有信息的task_struct数据结构是比较庞大的,但是该数据结构本身并不复杂,我们将它的所有域按其功能可做如下划分:

- 进程状态(State);

- 进程调度信息(Scheduling Information);

- 各种标识符(Identifiers);

- 进程通信有关信息(IPC,Inter_Process Communication);

- 时间和定时器信息(Times and Timers);

- 进程链接信息(Links);

- 文件系统信息(File System);

- 虚拟内存信息(Virtual Memory);

- 页面管理信息(page);

- 对称多处理器(SMP)信息;

- 和处理器相关的环境(上下文)信息(Processor Specific Context);

- 其他信息。

下面我们对task_struct结构进行具体描述。

task_struct`结构描述

进程状态(State)

进程执行时,它会根据具体情况改变状态。进程状态是调度和对换的依据。Linux中的进程主要有如下状态,如表所示。

| 内核表示 | 含义 |

|---|---|

| TASK_RUNNING | 可运行 |

| TASK_INTERRUPTIBLE | 可中断的等待状态 |

| TASK_UNINTERRUPTIBLE | 不可中断的等待状态 |

| TASK_ZOMBIE | 僵死 |

| TASK_STOPPED | 暂停 |

| TASK_SWAPPING | 换入/换出 |

(1)可运行状态:处于这种状态的进程,要么正在运行、要么正准备运行。正在运行的进程就是当前进程(由current所指向的进程),而准备运行的进程只要得到CPU就可以立即投入运行。系统中有一个运行队列(run_queue),用来容纳所有处于可运行状态的进程,调度程序执行时,从中选择一个进程投入运行。当前运行进程一直处于该队列中,也就是说,current`总是指向运行队列中的某个元素,只是具体指向谁由调度程序决定。

(2)等待状态:处于该状态的进程正在等待某个事件(Event)或某个资源,它肯定位于系统中的某个等待队列(wait_queue)中。Linux中处于等待状态的进程分为两种:可中断的等待状态和不可中断的等待状态。处于可中断等待态的进程可以被信号唤醒,如果收到信号,该进程就从等待状态进入可运行状态,并且加入到运行队列中,等待被调度;而处于不可中断等待态的进程是因为硬件环境不能满足而等待,例如等待特定的系统资源,它任何情况下都不能被打断,只能用特定的方式来唤醒它,例如唤醒函数wake_up()等。

(3)暂停状态:此时的进程暂时停止运行来接受某种特殊处理。通常当进程接收到SIGSTOP、SIGTSTP、SIGTTIN或SIGTTOU信号后就处于这种状态。

(4)僵死状态:进程虽然已经终止,但由于某种原因,父进程还没有执行wait()系统调用,终止进程的信息也还没有回收。顾名思义,处于该状态的进程就是死进程,这种进程实际上是系统中的垃圾,必须进行相应处理以释放其占用的资源。

进程调度信息

这一部分信息通常包括进程的类别(普通进程还是实时进程)、进程的优先级等,如表所示。

| 域名 | 含义 |

|---|---|

| need_resched | 调度标志 |

| Nice | 静态优先级 |

| Counter | 动态优先级 |

| Policy | 调度策略 |

| rt_priority | 实时优先级 |

当need_resched被设置时,在“下一次的调度机会”就调用调度程序schedule()。counter代表进程剩余的时间片,是进程调度的主要依据,也可以说是进程的动态优先级,因为这个值在不断地减少;nice是进程的静态优先级,同时也代表进程的时间片,用于对counter赋值,可以用nice()系统调用改变这个值;policy是适用于该进程的调度策略,实时进程和普通进程的调度策略是不同的;rt_priority只对实时进程有意义,它是实时进程调度的依据。

进程的调度策略有 3 种,如表所示。

| 名称 | 解释 | 适用范围 |

|---|---|---|

| SCHED_OTHER | 其他调度 | 普通进程 |

| SCHED_FIFO | 先来先服务调度 | 实时进程 |

| SCHED_RR | 时间片轮转调度 | 实时进程 |

只有root用户能通过sched_setscheduler()系统调用来改变调度策略。

标识符(Identifiers)

每个进程都有一个唯一的进程标识符(PID,process identifier),内核通过这个标识符来识别不同的进程,同时,进程标识符PID也是内核提供给用户程序的接口。PID是 32 位的无符号整数,它被顺序编号:新创建进程的PID通常是前一个进程的PID加 1。

进程通信有关信息

Linux支持多种不同形式的通信机制。它支持典型的UNIX通信机制(IPC Mechanisms):信号(Signals)、管道(Pipes),也支持SystemV通信机制:共享内存(Shared Memory)、信号量和消息队列(Message Queues)。

| 域名 | 含义 |

|---|---|

| Spinlock_t sigmask_lock | 信号掩码的自旋锁 |

| Long blocked | 信号掩码 |

| Struct signal *sig | 信号处理函数 |

| Struct sem_undo *semundo | 为避免死锁而在信号量上设置的取消操作 |

| Struct sem_queue *semsleeping | 与信号量操作相关的等待队列 |

进程链接信息(Links)

程序创建的进程具有父/子关系。因为一个进程能创建几个子进程,而子进程之间有兄弟关系,在task_struct结构中有几个域来表示这种关系。

每个进程的task_struct结构有许多指针,通过这些指针,系统中所有进程的task_struct结构就构成了一棵进程树,这棵进程树的根就是初始化进程init的task_struct结构(init进程是Linux内核建立起来后人为创建的一个进程,是所有进程的祖先进程)。

时间和定时器信息(Times and Timers)

一个进程从创建到终止叫做该进程的生存期(lifetime)。进程在其生存期内使用CPU的时间,内核都要进行记录,以便进行统计、计费等有关操作。进程耗费CPU的时间由两部分组成:一是在用户模式(或称为用户态)下耗费的时间、一是在系统模式(或称为系统态)下耗费的时间。每个时钟滴答,也就是每个时钟中断,内核都要更新当前进程耗费CPU的时间信息。

文件系统信息(File System)

进程可以打开或关闭文件,文件属于系统资源,Linux内核要对进程使用文件的情况进行记录。task_struct结构中有两个数据结构用于描述进程与文件相关的信息。其中,fs_struct中描述了两个VFS索引节点(VFS inode),这两个索引节点叫做root和pwd,分别指向进程的可执行映像所对应的根目录(Home Directory)和当前目录或工作目录。

file_struct结构用来记录了进程打开的文件的描述符(Descriptor)。如表所示。

| 定义形式 | 解释 |

|---|---|

| struct fs_struct *fs | 进程的可执行映像所在的文件系统 |

| struct files_struct *files | 进程打开的文件 |

在文件系统中,每个VFS索引节点唯一描述一个文件或目录,同时该节点也是向更低层的文件系统提供的统一的接口。

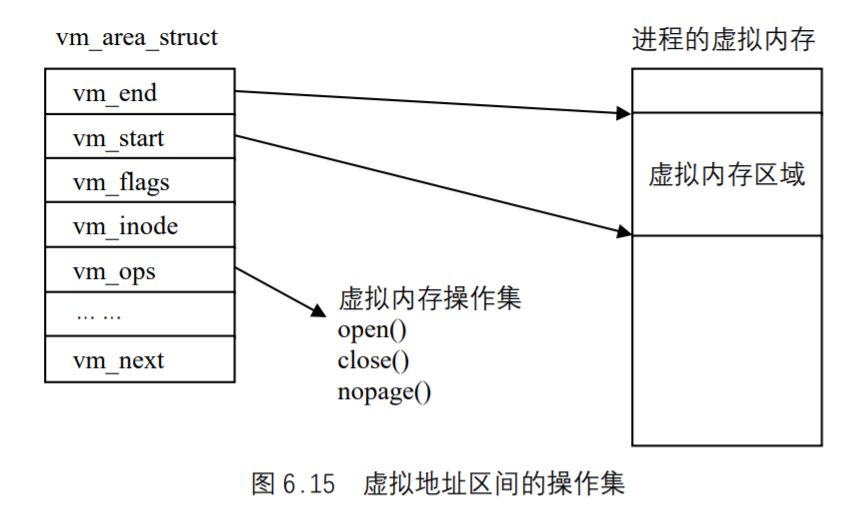

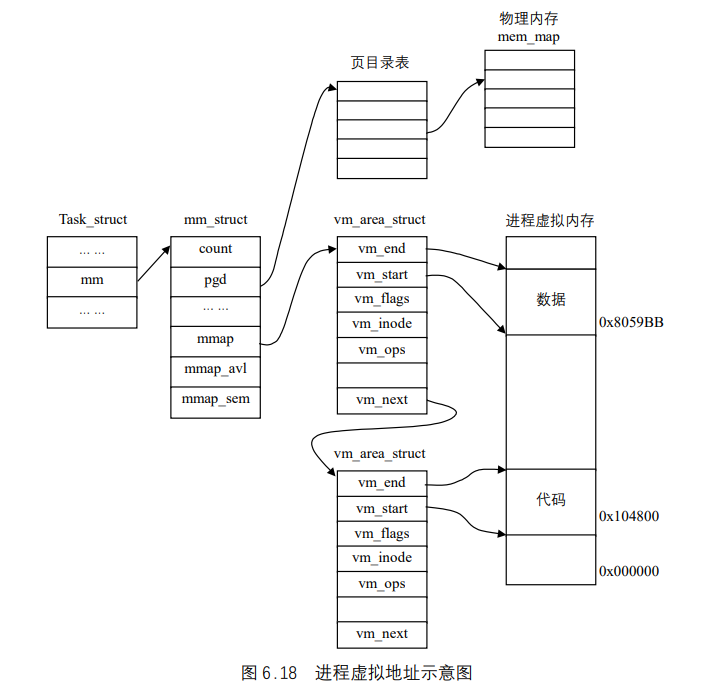

虚拟内存信息(Virtual Memory)

除了内核线程(Kernel Thread),每个进程都拥有自己的地址空间(也叫虚拟空间),用mm_struct来描述。另外Linux 2.4 还引入了另外一个域active_mm,这是为内核线程而引入的。因为内核线程没有自己的地址空间,为了让内核线程与普通进程具有统一的上下文切换方式,当内核线程进行上下文切换时,让切换进来的线程的active_mm指向刚被调度出去的进程的active_mm(如果进程的mm域不为空,则其active_mm域与mm域相同)。内存信息如表所示。

| 定义形式 | 解释 |

|---|---|

| struct mm_struct *mm | 描述进程的地址空间 |

| struct mm_struct *active_mm | 内核线程所借用的地址空间 |

页面管理信息

当物理内存不足时,Linux内存管理子系统需要把内存中的部分页面交换到外存,其交换是以页为单位的。有关页面的描述信息如表。

| 定义形式 | 解释 |

|---|---|

| int swappable | 进程占用的内存页面是否可换出 |

| unsigned long min_flat, maj_flt, nswap | 进程累计的次(minor)缺页次数、主(major)次数及累计换出、换入页面数 |

| unsigned long cmin_flat,cmaj_flt,cnswap | 本进程作为祖先进程,其所有层次子进程的累计的次(minor)缺页次数、主(major)次数及累计换出、换入页面数 |

对称多处理机(SMP)信息

Linux 2.4 对SMP进行了全面的支持,表是与多处理机相关的几个域。

| 定义形式 | 解释 |

|---|---|

| int has_cpu | 进程当前是否拥有CPU |

| int processor | 进程当前正在使用的CPU |

| int lock_depth | 上下文切换时内核锁的深度 |

和处理器相关的环境(上下文)信息(Processor Specific Context)

因为不同的处理器对内部寄存器和堆栈的定义不尽相同,所以叫做“和处理器相关的环境”,也叫做“处理机状态”。当进程暂时停止运行时,处理机状态必须保存在进程的task_struct结构中,当进程被调度重新运行时再从中恢复这些环境,也就是恢复这些寄存器和堆栈的值。处理机信息如表所示。

| 定义形式 | 解释 |

|---|---|

| struct thread_struct *tss | 任务切换状态 |

其他

struct wait_queue *wait_chldexit

在进程结束时,或发出系统调用wait4时,为了等待子进程的结束,而将自己(父进程)睡眠在该等待队列上,设置状态标志为TASK_INTERRUPTIBLE,并且把控制权转给调度程序。

struct rlimit rlim[RLIM_NLIMITS]

每一个进程可以通过系统调用setlimit和getlimit来限制它资源的使用。

int exit_code exit_signal

程序的返回代码以及程序异常终止产生的信号,这些数据由父进程(子进程完成后)轮流查询。

char comm[16]

这个域存储进程执行的程序的名字,这个名字用在调试中。

unsigned long personality

personality进一步描述进程执行的程序属于何种UNIX平台的“个性”信息。通常有PER_Linux,PER_Linux_32BIT,PER_Linux_EM86,PER_SVR4,PER_SVR3,PER_SCOSVR3,PER_WYSEV386,PER_ISCR4,PER_BSD,PER_XENIX和PER_MASK等。

int did_exec:1

按POSIX要求设计的布尔量,区分进程正在执行老程序代码,还是用系统调用execve()装入一个新的程序。

struct linux_binfmt *binfmt

指向进程所属的全局执行文件格式结构,共有a.out、script、elf、java等 4 种。

task_struct`结构在内存中的存放

task_struct结构在内存的存放与内核栈是分不开的,因此,首先讨论内核栈。

进程内核栈

每个进程都有自己的内核栈。当进程从用户态进入内核态时,CPU就自动地设置该进程的内核栈,也就是说,CPU从任务状态段TSS中装入内核栈指针esp。

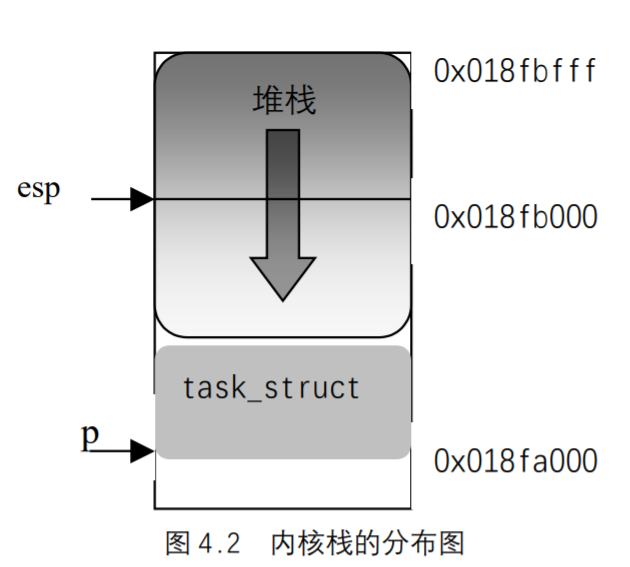

X86 内核栈的分布如图 4.2 所示。

在Intel系统中,栈起始于末端,并朝这个内存区开始的方向增长。从用户态刚切换到内核态以后,进程的内核栈总是空的,因此,esp寄存器直接指向这个内存区的顶端。在图 4.2中,从用户态切换到内核态后,esp寄存器包含的地址为 0x018fc00。进程描述符存放在从0x015fa00 开始的地址。只要把数据写进栈中,esp`的值就递减。

在/include/linux/sched.h中定义了如下一个联合结构:1

2

3

4union task_union {

struct task_struct task;

unsigned long stack[2408];

};

从这个结构可以看出,内核栈占 8KB 的内存区。实际上,进程的task_struct结构所占的内存是由内核动态分配的,更确切地说,内核根本不给task_struct分配内存,而仅仅给内核栈分配 8KB 的内存,并把其中的一部分给task_struct使用。

task_struct结构大约占 1K 字节左右,其具体数字与内核版本有关,因为不同的版本其域稍有不同。因此,内核栈的大小不能超过 7KB,否则,内核栈会覆盖task_struct结构,从而导致内核崩溃。不过,7KB`大小对内核栈已足够。

把task_struct结构与内核栈放在一起具有以下好处:

- 内核可以方便而快速地找到这个结构,用伪代码描述如下:

task_struct = (struct task_struct *) STACK_POINTER & 0xffffe000 - 避免在创建进程时动态分配额外的内存。

task_struct结构的起始地址总是开始于页大小(PAGE_SIZE)的边界。

当前进程(current`宏)

在Linux/include/i386/current.h中定义了current`宏,这是一段与体系结构相关的代码:1

2

3

4

5

6static inline struct task_struct * get_current(void)

{

struct task_struct *current;

__asm__("andl %%esp,%0; ":"=r" (current) : "0" (~8191UL));

return current;

}

实际上,这段代码相当于如下一组汇编指令(设p是指向当前进程task_struct结构的指针):1

2

3movl $0xffffe000, %ecx

andl %esp, %ecx

movl %ecx, p

换句话说,仅仅只需检查栈指针的值,而根本无需存取内存,内核就可以导出task_struct结构的地址。

进程组织方式

为了对系统中的很多进程及处于不同状态的进程进行管理,Linux采用了如下几种组织方式。

哈希表

哈希表是进行快速查找的一种有效的组织方式。Linux在进程中引入的哈希表叫做pidhash,在include/linux/sched.h中定义如下:1

2

3

4

extern struct task_struct *pidhash[PIDHASH_SZ];

其中,PIDHASH_SZ为表中元素的个数,表中的元素是指向task_struct结构的指针。pid_hashfn为哈希函数,把进程的PID转换为表的索引。通过这个函数,可以把进程的PID均匀地散列在它们的域(0 到PID_MAX-1)中。

Linux利用链地址法来处理冲突的PID:也就是说,每一表项是由冲突的PID组成的双向链表,这种链表是由task_struct结构中的pidhash_next和pidhash_pprev域实现的,同一链表中pid的大小由小到大排列。

哈希表pidhash中插入和删除一个进程时可以调用hash_pid()和unhash_pid()函数。对于一个给定的pid,可以通过find_task_by_pid()函数快速地找到对应的进程:1

2

3

4

5

6

7static inline struct task_struct *find_task_by_pid(int pid)

{

struct task_struct *p, **htable = &pidhash[pid_hashfn(pid)];

for(p = *htable; p && p->pid != pid; p = p->pidhash_next)

;

return p;

}

双向循环链表

哈希表的主要作用是根据进程的pid可以快速地找到对应的进程,但它没有反映进程创建的顺序,也无法反映进程之间的亲属关系,因此引入双向循环链表。每个进程task_struct结构中的prev_task和next_task域用来实现这种链表。

宏SET_LINK用来在该链表中插入一个元素:1

2

3

4

5

6

7

8

9

10

从这段代码可以看出,链表的头和尾都为init_task,它对应的是进程 0(pid为 0),也就是所谓的空进程,它是所有进程的祖先。这个宏把进程之间的亲属关系也链接起来。另外,还有一个宏for_each_task():1

2

这个宏是循环控制语句。注意init_task的作用,因为空进程是一个永远不存在的进程,因此用它做链表的头和尾是安全的。

因为进程的双向循环链表是一个临界资源,因此在使用这个宏时一定要加锁,使用完后开锁。

运行队列

当内核要寻找一个新的进程在CPU上运行时,必须只考虑处于可运行状态的进程(即在TASK_RUNNING状态的进程),因为扫描整个进程链表是相当低效的,所以引入了可运行状态进程的双向循环链表,也叫运行队列(runqueue)。

运行队列容纳了系统中所有可以运行的进程,它是一个双向循环队列。

进程的运行队列链表

该队列通过task_struct结构中的两个指针run_list链表来维持。队列的标志有两个:一个是“空进程”idle_task,一个是队列的长度。有两个特殊的进程永远在运行队列中待着:当前进程和空进程。前面我们讨论过,当前进程就是由cureent指针所指向的进程,也就是当前运行着的进程,直到调度程序选定某个进程投入运行后,current才真正指向了当前运行进程;空进程是个比较特殊的进程,只有系统中没有进程可运行时它才会被执行,Linux将它看作运行队列的头,当调度程序遍历运行队列,是从idle_task开始、至idle_task结束的,在调度程序运行过程中,允许队列中加入新出现的可运行进程,新出现的可运行进程插入到队尾,这样的好处是不会影响到调度程序所要遍历的队列成员,可见,idle_task是运行队列很重要的标志。

另一个重要标志是队列长度,也就是系统中处于可运行状态(TASK_RUNNING)的进程数目,用全局整型变量nr_running表示,在/kernel/fork.c中定义如下:1

int nr_running=1;

若nr_running为 0,就表示队列中只有空进程。在这里要说明一下:若nr_running为0,则系统中的当前进程和空进程就是同一个进程。但是Linux会充分利用CPU而尽量避免出现这种情况。

等待队列

在 2.4 版本中,引入了一种特殊的链表—通用双向链表,它是内核中实现其他链表的基础,也是面向对象的思想在C语言中的应用。在等待队列的实现中多次涉及与此链表相关的内容。

通用双向链表

在include/linux/list.h中定义了这种链表:1

2

3struct list_head {

struct list_head *next, *prev;

};

这是双向链表的一个基本框架,在其他使用链表的地方就可以使用它来定义任意一个双向链表,例如:1

2

3

4struct foo_list {

int data;

struct list_head list;

};

对于list_head类型的链表,Linux定义了 5 个宏:1

2

3

4

5

6

7

8

9

10

11

12

13

14

前 3 个宏都是初始化一个空的链表,但用法不同,LIST_HEAD_INIT()在声明时使用,用来初始化结构元素,第 2 个宏用在静态变量初始化的声明中,而第 3 个宏用在函数内部。其中,最难理解的宏为list_entry(),在内核代码的很多处都用到这个宏,例如,在调度程序中,从运行队列中选择一个最值得运行的进程,部分代码如下:1

2

3

4

5

6

7

8

9

10

11static LIST_HEAD(runqueue_head);

struct list_head *tmp;

struct task_struct *p;

list_for_each(tmp, &runqueue_head) {

p = list_entry(tmp, struct task_struct, run_list);

if (can_schedule(p)) {

int weight = goodness(p, this_cpu, prev->active_mm);

if (weight > c)

c = weight, next = p;

}

}

从这段代码可以分析出list_entry(ptr, type, member)宏及参数的含义:ptr是指向list_head类型链表的指针,type为一个结构,而member为结构type中的一个域,类型为list_head,这个宏返回指向type结构的指针。在内核代码中大量引用了这个宏,因此,搞清楚这个宏的含义和用法非常重要。

另外,对list_head类型的链表进行删除和插入(头或尾)的宏为list_del()/list_add()/list_add_tail(),在内核的其他函数中可以调用这些宏。例如,从运行队列中删除、增加及移动一个任务的代码如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21static inline void del_from_runqueue(struct task_struct * p)

{

nr_running--;

list_del(&p->run_list);

p->run_list.next = NULL;

}

static inline void add_to_runqueue(struct task_struct * p)

{

list_add(&p->run_list, &runqueue_head);

nr_running++;

}

static inline void move_last_runqueue(struct task_struct * p)

{

list_del(&p->run_list);

list_add_tail(&p->run_list, &runqueue_head);

}

static inline void move_first_runqueue(struct task_struct * p)

{

list_del(&p->run_list);

list_add(&p->run_list, &runqueue_head);

}

等待队列

运行队列链表把处于TASK_RUNNING状态的所有进程组织在一起。当要把其他状态的进程分组时,不同的状态要求不同的处理,Linux选择了下列方式之一。

TASK_STOPPED或TASK_ZOMBIE状态的进程不链接在专门的链表中,也没必要把它们分组,因为父进程可以通过进程的PID或进程间的亲属关系检索到子进程。- 把

TASK_INTERRUPTIBLE或TASK_UNINTERRUPTIBLE状态的进程再分成很多类,其每一类对应一个特定的事件。在这种情况下,进程状态提供的信息满足不了快速检索进程,因此,有必要引入另外的进程链表。这些链表叫等待队列。

等待队列表示一组睡眠的进程,当某一条件变为真时,由内核唤醒它们。等待队列由循环链表实现。1

2

3

4

5

6struct __wait_queue {

unsigned int flags;

struct task_struct * task;

struct list_head task_list;

};

typedef struct __wait_queue wait_queue_t ;

另外,关于等待队列另一个重要的数据结构—等待队列首部的描述如下:1

2

3

4

5struct __wait_queue_head {

wq_lock_t lock;

struct list_head task_list;

};

typedef struct __wait_queue_head wait_queue_head_t;

下面给出 2.4 版中的一些主要函数及其功能:

init_waitqueue_head()——对等待队列首部进行初始化init_waitqueue_entry()——对要加入等待队列的元素进行初始化waitqueue_active()——判断等待队列中已经没有等待的进程add_wait_queue()——给等待队列中增加一个元素remove_wait_queue()——从等待队列中删除一个元素

注意,在以上函数的实现中,都调用了对list_head类型链表的操作函数(list_del()/list_add()/list_add_tail()),因此可以说,list_head类型相当于`C++中的基类型。

希望等待一个特定事件的进程能调用下列函数中的任一个:

sleep_on()函数对当前的进程起作用,我们把当前进程叫做`P:1

2

3

4

5

6

7

8sleep_on(wait_queue_head_t *q)

{

SLEEP_ON_VAR /*宏定义,用来初始化要插入到等待队列中的元素*/

current->state = TASK_UNINTERRUPTIBLE;

SLEEP_ON_HEAD /*宏定义,把`P`插入到等待队列 */

schedule();

SLEEP_ON_TAIL /*宏定义把`P`从等待队列中删除 */

}

这个函数把P的状态设置为TASK_UNINTERRUPTIBLE,并把P插入等待队列。然后,它调用调度程序恢复另一个程序的执行。当P被唤醒时,调度程序恢复sleep_on()函数的执行,把P从等待队列中删除。

interruptible_sleep_on()与sleep_on()函数是一样的,但稍有不同,前者把进程P的状态设置为TASK_INTERRUPTIBLE而不是TASK_UNINTERRUPTIBLE,因此,通过接受一个信号可以唤醒`P。

sleep_on_timeout()和interruptible_sleep_on_timeout()与前面情况类似,但它们允许调用者定义一个时间间隔,过了这个间隔以后,内核唤醒进程。为了做到这点,它们调用schedule_timeout()函数而不是schedule()函数。

利用wake_up或者wake_up_interruptible宏,让插入等待队列中的进程进入TASK_RUNNING状态,这两个宏最终都调用了try_to_wake_up()函数:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16static inline int try_to_wake_up(struct task_struct * p, int synchronous)

{

unsigned long flags;

int success = 0;

spin_lock_irqsave(&runqueue_lock, flags); /*加锁*/

p->state = TASK_RUNNING;

if (task_on_runqueue(p)) /*判断`p`是否已经在运行队列*/

add_to_runqueue(p); /*不在,则把`p`插入到运行队列*/

if (!synchronous || !(p->cpus_allowed & (1 << smp_processor_id())))

reschedule_idle(p);

success = 1;

out:

spin_unlock_irqrestore(&runqueue_lock, flags); /*开锁*/

return success;

}

在这个函数中,p为要唤醒的进程。如果p不在运行队列中,则把它放入运行队列。如果重新调度正在进行的过程中,则调用reschedule_idle()函数,这个函数决定进程p是否应该抢占某一CPU上的当前进程。

实际上,在内核的其他部分,最常用的还是wake_up或者wake_up_interruptible宏,也就是说,如果你要在内核级进行编程,只需调用其中的一个宏。例如一个简单的实时时钟(RTC)中断程序如下:1

2

3

4

5

6

7

8static DECLARE_WAIT_QUEUE_HEAD(rtc_wait); /*初始化等待队列首部*/

void rtc_interrupt(int irq, void *dev_id, struct pt_regs *regs)

{

spin_lock(&rtc_lock);

rtc_irq_data = CMOS_READ(RTC_INTR_FLAGS);

spin_unlock(&rtc_lock);

wake_up_interruptible(&rtc_wait);

}

这个中断处理程序通过从实时时钟的I/O端口(CMOS_READ宏产生一对outb/inb)读取数据,然后唤醒在rtc_wait等待队列上睡眠的任务。

内核线程

内核线程(thread)或叫守护进程(daemon),在操作系统中占据相当大的比例,当Linux操作系统启动以后,尤其是Xwindow也启动以后,你可以用“ps”命令查看系统中的进程,这时会发现很多以“d”结尾的进程名,这些进程就是内核线程。

内核线程也可以叫内核任务,它们周期性地执行,例如,磁盘高速缓存的刷新,网络连接的维护,页面的换入换出等。在Linux中,内核线程与普通进程有一些本质的区别,从以下几个方面可以看出二者之间的差异。

- 内核线程执行的是内核中的函数,而普通进程只有通过系统调用才能执行内核中的函数。

- 内核线程只运行在内核态,而普通进程既可以运行在用户态,也可以运行在内核态。

- 因为内核线程指只运行在内核态,因此,它只能使用大于

PAGE_OFFSET(3G)的地址空间。另一方面,不管在用户态还是内核态,普通进程可以使用 4GB`的地址空间。

内核线程是由kernel_thread()函数在内核态下创建的,这个函数所包含的代码大部分是内联式汇编语言,但在某种程度上等价于下面的代码:1

2

3

4

5

6

7

8

9

10

11int kernel_thread(int (*fn)(void *), void * arg, unsigned long flags)

{

pid_t p ;

p = clone( 0, flags | CLONE_VM );

if ( p ) /* parent */

return p;

else { /* child */

fn(arg);

exit();

}

}

进程的权能

Linux用“权能(capability)”表示一进程所具有的权力。一种权能仅仅是一个标志,它表明是否允许进程执行一个特定的操作或一组特定的操作。这个模型不同于传统的“超级用户对普通用户”模型,在后一种模型中,一个进程要么能做任何事情,要么什么也不能做,这取决于它的有效`UID。也就是说,超级用户与普通用户的划分过于笼统。如表给出了在Linux内核中已定义的权能。

| 名字 | 描述 |

|---|---|

| CAP_CHOWN | 忽略对文件和组的拥有者进行改变的限制 |

| CAP_DAC_OVERRIDE | 忽略文件的访问许可权 |

| CAP_DAC_READ_SEARCH | 忽略文件/目录读和搜索的许可权 |

| CAP_FOWNER | 忽略对文件拥有者的限制 |

| CAP_FSETID | 忽略对setid和setgid标志的限制 |

| CAP_KILL | 忽略对信号挂起的限制 |

| CAP_SETGID | 允许setgid标志的操作 |

| CAP_SETUID | 允许setuid标志的操作 |

| CAP_SETPCAP | 转移/删除对其他进程所许可的权能 |

| CAP_LINUX_IMMUTABLE | 允许对仅追加和不可变文件的修改 |

| CAP_NET_BIND_SERVICE | 允许捆绑到低于 1024TCP/UDP`的套节字 |

| CAP_NET_BROADCAST | 允许网络广播和监听多点传送 |

| CAP_NET_ADMIN | 允许一般的网络管理。 |

| CAP_NET_RAW | 允许使用RAW和PACKET套节字 |

| CAP_IPC_LOCK | 允许页和共享内存的加锁 |

| CAP_IPC_OWNER | 跳过IPC拥有者的检查 |

| CAP_SYS_MODULE | 允许内核模块的插入和删除 |

| CAP_SYS_RAWIO | 允许通过ioperm() 和iopl()访问I/O端口 |

| CAP_SYS_CHROOT | 允许使用chroot() |

| CAP_SYS_PTRACE | 允许在任何进程上使用ptrace() |

| CAP_SYS_PACCT | 允许配置进程的计账 |

| CAP_SYS_ADMIN | 允许一般的系统管理 |

| CAP_SYS_BOOT | 允许使用reboot() |

| CAP_SYS_NICE | 忽略对nice()的限制 |

| CAP_SYS_RESOURCE | 忽略对几个资源使用的限制 |

| CAP_SYS_TIME | 允许系统时钟和实时时钟的操作 |

| CAP_SYS_TTY_CONFIG | 允许配置tty设备 |

任何时候,每个进程只需要有限种权能,这是其主要优势。因此,即使一位有恶意的用户使用有潜在错误程序,他也只能非法地执行有限个操作类型。

内核同步

信号量

进程间对共享资源的互斥访问是通过“信号量”机制来实现的。信号量机制是操作系统教科书中比较重要的内容之一。Linux内核中提供了两个函数down()和up(),分别对应于操作系统教科书中的P、V操作。

信号量在内核中定义为semaphore数据结构,位于include/i386/semaphore.h:1

2

3

4

5

6

7

8struct semaphore {

atomic_t count;

int sleepers;

wait_queue_head_t wait;

long __magic;

};

其中的count域就是“信号量”中的那个“量”,它代表着可用资源的数量。如果该值大于 0,那么资源就是空闲的,也就是说,该资源可以使用。相反,如果count小于 0,那么这个信号量就是繁忙的,也就是说,这个受保护的资源现在不能使用。在后一种情况下,count`的绝对值表示了正在等待这个资源的进程数。该值为 0 表示有一个进程正在使用这个资源,但没有其他进程在等待这个资源。

wait域存放等待链表的地址,该链表中包含正在等待这个资源的所有睡眠的进程。当然,如果count大于或等于 0,则等待队列为空。为了明确表示等待队列中正在等待的进程数,引入了计数器`sleepers。

down()和up()函数主要应用在文件系统和驱动程序中,把要保护的临界区放在这两个函数中间,用法如下:1

2

3down();

临界区

up();

这两个函数是用嵌入式汇编实现的。

原子操作

避免干扰的最简单方法就是保证操作的原子性,即操作必须在一条单独的指令内执行。有两种类型的原子操作,即位图操作和数学的加减操作。

位图操作

在内核的很多地方用到位图,例如内存管理中对空闲页的管理,位图还有一个广泛的用途就是简单的加锁,例如提供对打开设备的互斥访问。关于位图的操作函数如下,以下函数的参数中,addr`指向位图。

void set_bit(int nr, volatile void *addr):设置位图的第nr位。void clear_bit(int nr, volatile void *addr): 清位图的第nr位。void change_bit(int nr, volatile void *addr): 改变位图的第nr位。int test_and_set_bit(int nr, volatile void *addr): 设置第nr位,并返回该位原来的值,且两个操作是原子操作,不可分割。int test_and_clear_bit(int nr, volatile void *addr): 清第nr为,并返回该位原来的值,且两个操作是原子操作。int test_and_change_bit(int nr, volatile void *addr):改变第nr位,并返回该位原来的值,且这两个操作是原子操作。

这些操作利用了LOCK_PREFIX宏,对于SMP内核,该宏是总线锁指令的前缀,对于单CPU这个宏不起任何作用。这就保证了在SMP环境下访问的原子性。

算术操作

有时候位操作是不方便的,取而代之的是需要执行算术操作,即加、减操作及加 1、减1 操作。典型的例子是很多数据结构中的引用计数域count(如inode结构)。这些操作的原子性是由atomic_t数据类型和表中的函数保证的。atomic_t的类型在include/i386/atomic.h,定义如下:1

typedef struct { volatile int counter; } atomic_t;

| 函数 | 说明 |

|---|---|

atomic_read(v) |

返回*v |

atomic_set(v,i) |

把*v设置成i |

atomic_add(i,v) |

给*v增加i |

atomic_sub(i,v) |

从*v中减去i |

atomic_inc(v) |

给*v`加 1 |

atomic_dec(v) |

从*v`中减去 1 |

atomic_dec_and_test(v) |

从*v`中减去 1,如果结果非空就返回 1;否则返回 0 |

atomic_inc_and_test_greater_zero(v) |

给*v`加 1,如果结果为正就返回 1;否则就返回 0 |

atomic_clear_mask(mask,addr) |

清除由mask所指定的addr中的所有位 |

atomic_set_mask(mask,addr) |

设置由mask所指定的addr中的所有位 |

自旋锁、读写自旋锁和大读者自旋锁

在Linux内核中,临界区的代码或者是由进程上下文来执行,或者是由中断上下文来执行。在单CPU上,可以用cli/sti指令来保护临界区的使用,例如:1

2

3

4

5unsigned long flags;

save_flags(flags);

cli();

/* critical code */

restore_flags(flags);

但是,在SMP上,这种方法明显是没有用的,因为同一段代码序列可能由另一个进程同时执行,而cli()仅能单独地为每个CPU上的中断上下文提供对竞争资源的保护,它无法对运行在不同CPU上的上下文提供对竞争资源的访问。因此,必须用到自旋锁。

所谓自旋锁,就是当一个进程发现锁被另一个进程锁着时,它就不停地“旋转”,不断执行一个指令的循环直到锁打开。自旋锁只对SMP有用,对单CPU没有意义。有 3 种类型的自旋锁:基本的、读写以及大读者自旋锁。读写自旋锁适用于“多个读者少数写者”的场合,例如,有多个读者仅有一个写者,或者没有读者只有一个写者。大读者自旋锁是读写自旋锁的一种,但更照顾读者。大读者自旋锁现在主要用在`Sparc64 和网络系统中。

进程调度与切换

Linux时间系统

时间系统通常又被简称为时钟,它的主要任务是维持系统时间并且防止某个进程独占CPU及其他资源,也就是驱动进程的调度。

时钟硬件

大部分PC机中有两个时钟源,他们分别叫做RTC和OS(操作系统)时钟。RTC(Real Time Clock,实时时钟)也叫做CMOS时钟,它是PC主机板上的一块芯片(或者叫做时钟电路),它靠电池供电,即使系统断电,也可以维持日期和时间。由于它独立于操作系统,所以也被称为硬件时钟,它为整个计算机提供一个计时标准,是最原始最底层的时钟数据。Linux只用RTC来获得时间和日期,同时,通过作用于/dev/rtc设备文件,也允许进程对RTC编程。内核通过0x70和0x71 I/O端口存取RTC。通过执行/sbin/clock系统程序(它直接作用于这两个I/O端口),系统管理员可以配置时钟。

OS时钟产生于PC主板上的定时/计数芯片,由操作系统控制这个芯片的工作,OS时钟的基本单位就是该芯片的计数周期。在开机时操作系统取得RTC中的时间数据来初始化OS时钟,然后通过计数芯片的向下计数形成了OS时钟,所以OS时钟并不是本质意义上的时钟,它更应该被称为一个计数器。OS时钟只在开机时才有效,而且完全由操作系统控制,所以也被称为软时钟或系统时钟。下面我们重点描述OS时钟的产生。

可编程定时/计数器总体上由两部分组成:计数硬件和通信寄存器。通信寄存器包含有控制寄存器、状态寄存器、计数初始值寄存器(16 位)、计数输出寄存器等。通信寄存器在计数硬件和操作系统之间建立联系,用于二者之间的通信,操作系统通过这些寄存器控制计数硬件的工作方式、读取计数硬件的当前状态和计数值等信息。

在Linux内核初始化时,内核写入控制字和计数初值,这样计数硬件就会按照一定的计数方式对晶振产生的输入脉冲信号(5MHz~100MHz的频率)进行计数操作:计数器从计数初值开始,每收到一次脉冲信号,计数器减 1,当计数器减至 0 时,就会输出高电平或低电平,然后,如果计数为循环方式(通常为循环计数方式),则重新从计数初值进行计数。这个输出脉冲将接到中断控制器上,产生中断信号,触发后面要讲的时钟中断,由时钟中断服务程序维持OS时钟的正常工作,所谓维持,其实就是简单的加 1 及细微的修正操作。这就是OS时钟产生的来源。

Linux的时间系统

系统时间是以“时钟滴答”为单位的,而时钟中断的频率决定了一个时钟滴答的长短,例如每秒有 100 次时钟中断,那么一个时钟滴答的就是 10 毫秒(记为 10ms),相应地,系统时间就会每 10ms`增 1。不同的操作系统对时钟滴答的定义是不同的。

Linux中用全局变量jiffies表示系统自启动以来的时钟滴答数目,在/kernel/time.c中定义如下:1

unsigned long volatile jiffies

在jiffies基础上,Linux提供了如下适合人们习惯的时间格式,在/include/linux/time.h中定义如下:1

2

3

4

5

6

7

8

9

10

11

12struct timespec { /* 这是精度很高的表示*/

long tv_sec; /* 秒 (second) */

long tv_nsec; /* 纳秒:十亿分之一秒( nanosecond)*/

};

struct timeval { /* 普通精度 */

int tv_sec; /* 秒 */

int tv_usec; /* 微秒:百万分之一秒(microsecond)*/

};

struct timezone { /* 时区 */

int tz_minuteswest; /* 格林尼治时间往西方的时差 */

int tz_dsttime; /* 时间修正方式 */

};

tv_sec表示秒(second),tv_usec表示微秒(microsecond,百万分之一秒即 10-6秒),tv_nsec表示纳秒(nanosecond,十亿分之一秒即 10-9秒)。定义tb_usec和tv_nsec的目的是为了适用不同的使用要求,不同的场合根据对时间精度的要求选用这两种表示。

时钟中断

时钟中断的产生

操作系统对可编程定时/计数器进行有关初始化,然后定时/计数器就对输入脉冲进行计数(分频),脉冲信号接到中断控制器 8259A_1的 0 号管脚,触发一个周期性的中断,我们就把这个中断叫做时钟中断,时钟中断的周期,也就是脉冲信号的周期,我们叫做“滴答”或“时标”(tick)。从本质上说,时钟中断只是一个周期性的信号,完全是硬件行为,该信号触发CPU去执行一个中断服务程序,但是为了方便,我们就把这个服务程序叫做时钟中断

Linux实现时钟中断的全过程

可编程定时/计数器的初始化

IBM PC中使用的是 8253 或 8254 芯片。Linux对 8253的初始化程序段如下(在/arch/i386/kernel/i8259.c的init_IRQ()`函数中):1

2

3

4

5

6

7

8set_intr_gate(ox20, interrupt[0]);

/* 在`IDT`的第 0x20 个表项中插入一个中断门。这个门中的段选择符设置成内核代码段的选择符,偏移域设置成 0 号中断处理程序的入口地址。*/

outb_p(0x34,0x43);

/* 写计数器 0 的控制字:工作方式 2*/

outb_p(LATCH & 0xff, 0x40);

/* 写计数初值`LSB`计数初值低位字节 */

outb(LATCH >> 8 , 0x40);

/* 写计数初值`MSB`计数初值高位字节*/

LATCH(英文意思为:锁存器,即其中锁存了计数器 0 的初值)为计数器 0 的计数初值,在/include/linux/timex.h中定义如下:1

2

3

与时钟中断相关的函数

下面我们接着介绍时钟中断触发的服务程序,该程序代码比较复杂,分布在不同的源文件中,主要包括如下函数:

- 时钟中断程序:

timer_interrupt(); - 中断服务通用例程:

do_timer_interrupt(); - 时钟函数:

do_timer(); - 中断安装程序:

setup_irq(); - 中断返回函数:

ret_from_intr();

timer_interrupt()大约每 10ms被调用一次,实际上,timer_interrupt()函数是一个封装例程,它真正做的事情并不多,但是,作为一个中断程序,它必须在关中断的情况下执行。如果只考虑单处理机的情况,该函数主要语句就是调用do_timer_interrupt()函数。

do_timer_interrupt()函数有两个主要任务,一个是调用do_timer(),另一个是维持实时时钟(RTC,每隔一定时间段要回写),其实现代码在/arch/i386/kernel/time.c中,1

2

3

4

5

6

7

8static inline void do_timer_interrupt(int irq, void *dev_id, struct pt_regs *regs)

{

do_timer(regs); /* 调用时钟函数,将时钟函数等同于时钟中断未尝不可*/

if(xtime.tv_sec > last_rtc_update + 660)

update_RTC();

/* 每隔 11 分钟就更新`RTC`中的时间信息,以使`OS`时钟和`RTC`时钟保持同步,11 分钟即660 秒,`xtime.tv_sec`的单位是秒,`last_rtc_update`记录的是上次`RTC`更新时的值 */

}

其中,xtime是前面所提到的timeval类型,这是一个全局变量。

时钟函数do_timer() (在/kernel/sched.c中)1

2

3

4

5

6

7

8

9

10

11

12void do_timer(struct pt_regs * regs)

{

(*(unsigned long *)&jiffies)++;

/*更新系统时间,这种写法保证对`jiffies`操作的原子性*/

update_process_times();

++lost_ticks;

if( ! user_mode ( regs ) )

++lost_ticks_system;

mark_bh(TIMER_BH);

if (tq_timer)

mark_bh(TQUEUE_BH);

}

其中,update_process_times()函数与进程调度有关,从函数的名子可以看出,它处理的是与当前进程与时间有关的变量,例如,要更新当前进程的时间片计数器counter,如果counter<=0,则要调用调度程序,要处理进程的所有定时器:实时、虚拟、概况,另外还要做一些统计工作。

中断安装程序

从上面的介绍可以看出,时钟中断与进程调度密不可分,因此,一旦开始有时钟中断就可能要进行调度,在系统进行初始化时,所做的大量工作之一就是对时钟进行初始化,其函数time_init()的代码在/arch/i386/kernel/time.c中,对其简写如下:1

2

3

4

5

6void __init time_init(void)

{

xtime.tv_sec=get_cmos_time();

xtime.tv_usec=0;

setup_irq(0,&irq0);

}

其中的get_cmos_time()函数就是把当时的实际时间从CMOS时钟芯片读入变量xtime中,时间精度为秒。而setup_irq(0, &irq0)就是时钟中断安装函数,irq0指的是一个结构类型irqaction,其定义及初值如下:1

static struct irqaction irq0 = { timer_interrupt, SA_INTERRUPT, 0, "timer", NULL, NULL};

setup_irq(0, &irq0)的代码在/arch/i386/kernel/irq.c中,其主要功能就是将中断程序连入相应的中断请求队列,以等待中断到来时相应的中断程序被执行。

我们将有关函数改写如下,体现时钟中断的大意:1

2

3

4

5

6

7

8do_timer_interrupt()` /*这是一个伪函数 */

{

SAVE_ALL /*保存处理机现场 */

intr_count += 1; /* 这段操作不允许被中断 */

timer_interrupt() /* 调用时钟中断程序 */

intr_count -= 1;

jmp ret_from_intr /* 中断返回函数 */

}

其中,jmp ret_from_intr是一段汇编代码,也是一个较为复杂的过程,它最终要调用jmp ret_from_sys_call,即系统调用返回函数,而这个函数与进程的调度又密切相关,因此,我们重点分析jmp ret_from_sys_call。

系统调用返回函数

系统调用返回函数的源代码在/arch/i386/kernel/entry.S中1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30ENTRY(ret_from_sys_call)

cli # need_resched and signals atomic test

cmpl $0,need_resched(%ebx)

jne reschedule

cmpl $0,sigpending(%ebx)

jne signal_return

restore_all:

RESTORE_ALL

ALIGN

signal_return:

sti # we can get here from an interrupt handler

testl $(VM_MASK),EFLAGS(%esp)

movl %esp,%eax

jne v86_signal_return

xorl %edx,%edx

call SYMBOL_NAME(do_signal)

jmp restore_all

ALIGN

v86_signal_return:

call SYMBOL_NAME(save_v86_state)

movl %eax,%esp

xorl %edx,%edx

call SYMBOL_NAME(do_signal)

jmp restore_all

….

reschedule:

call SYMBOL_NAME(schedule) # test

jmp ret_from_sys_call

这一段汇编代码就是前面我们所说的“从系统调用返回函数”ret_from_sys_call,它是从中断、异常及系统调用返回时的通用接口。这段代码主体就是ret_from_sys_call函数,其执行过程中要调用其他一些函数(实际上是一段代码,不是真正的函数),在此我们列出相关的几个函数。

ret_from_sys_call:主体。reschedule:检测是否需要重新调度。signal_return:处理当前进程接收到的信号。v86_signal_return:处理虚拟 86 模式下当前进程接收到的信号。RESTORE_ALL:我们把这个函数叫做彻底返回函数,因为执行该函数之后,就返回到当前进程的地址空间中去了。

可以看到ret_from_sys_call的主要作用有:检测调度标志need_resched,决定是否要执行调度程序;处理当前进程的信号;恢复当前进程的环境使之继续执行。

Linux的调度程序—Schedule()

进程的合理调度是一个非常复杂的工作,它取决于可执行程序的类型(实时或普通)、调度的策略及操作系统所追求的目标,幸运的是,Linux的调度程序比较简单。

基本原理

系统通过不同的调度算法(Scheduling Algorithm)来实现这种资源的分配。一个好的调度算法应当考虑以下几个方面。

1.公平:保证每个进程得到合理的CPU时间。

2.高效:使CPU保持忙碌状态,即总是有进程在CPU上运行。

3.响应时间:使交互用户的响应时间尽可能短。

4.周转时间:使批处理用户等待输出的时间尽可能短。

5.吞吐量:使单位时间内处理的进程数量尽可能多。

时间片轮转调度算法

时间片(Time Slice)就是分配给进程运行的一段时间。在分时系统中,为了保证人机交互的及时性,系统使每个进程依次地按时间片轮流的方式执行,此时即应采用时间片轮转法进行调度。在通常的轮转法中,系统将所有的可运行(即就绪)进程按先来先服务的原则,排成一个队列,每次调度时把CPU分配给队首进程,并令其执行一个时间片。时间片的大小从几ms到几百ms不等。当执行的时间片用完时,系统发出信号,通知调度程序,调度程序便据此信号来停止该进程的执行,并将它送到运行队列的末尾,等待下一次执行。然后,把处理机分配给就绪队列中新的队首进程,同时也让它执行一个时间片。这样就可以保证运行队列中的所有进程,在一个给定的时间(人所能接受的等待时间)内,均能获得一时间片的处理机执行时间。

优先权调度算法

为了照顾到紧迫型进程在进入系统后便能获得优先处理,引入了最高优先权调度算法。当将该算法用于进程调度时,系统将把处理机分配给运行队列中优先权最高的进程,这时,又可进一步把该算法分成两种方式。

(1)非抢占式优先权算法(又称不可剥夺调度,Nonpreemptive Scheduling),系统一旦将处理机(CPU)分配给运行队列中优先权最高的进程后,该进程便一直执行下去,直至完成;或因发生某事件使该进程放弃处理机时,系统方可将处理机分配给另一个优先权高的进程。这种调度算法主要用于批处理系统中,也可用于某些对实时性要求不严的实时系统中。

(2)抢占式优先权调度算法(又称可剥夺调度,Preemptive Scheduling)该算法的本质就是系统中当前运行的进程永远是可运行进程中优先权最高的那个。在这种方式下,系统同样是把处理机分配给优先权最高的进程,使之执行。但是只要一出现了另一个优先权更高的进程时,调度程序就暂停原最高优先权进程的执行,而将处理机分配给新出现的优先权最高的进程,即剥夺当前进程的运行。因此,在采用这种调度算法时,每当出现一新的可运行进程,就将它和当前运行进程进行优先权比较,如果高于当前进程,将触发进程调度。

这种方式的优先权调度算法,能更好的满足紧迫进程的要求,故而常用于要求比较严格的实时系统中,以及对性能要求较高的批处理和分时系统中。Linux也采用这种调度算法。

多级反馈队列调度

这是时下最时髦的一种调度算法。其本质是:综合了时间片轮转调度和抢占式优先权调度的优点,即:优先权高的进程先运行给定的时间片,相同优先权的进程轮流运行给定的时间片。

Linux进程调度时机

Linux的调度程序是一个叫schedule()的函数,这个函数被调用的频率很高,由它来决定是否要进行进程的切换,如果要切换的话,切换到哪个进程等。我们先来看在什么情况下要执行调度程序,我们把这种情况叫做调度时机。Linux调度时机主要有。

- 进程状态转换的时刻:进程终止、进程睡眠;

- 当前进程的时间片用完时(current->counter=0);

- 设备驱动程序;

- 进程从中断、异常及系统调用返回到用户态时。

- 时机 1,进程要调用

sleep()或exit()等函数进行状态转换,这些函数会主动调用调度程序进行进程调度。 - 时机 2,由于进程的时间片是由时钟中断来更新的,因此,这种情况和时机 4 是一样的。

- 时机 3,当设备驱动程序执行长而重复的任务时,直接调用调度程序。在每次反复循环中,驱动程序都检查

need_resched的值,如果必要,则调用调度程序schedule()主动放弃CPU。 - 时机 4,如前所述,不管是从中断、异常还是系统调用返回,最终都调用

ret_from_sys_call(),由这个函数进行调度标志的检测,如果必要,则调用调用调度程序。

每个时钟中断(timer interrupt)发生时,由 3 个函数协同工作,共同完成进程的选择和切换,它们是:schedule()、do_timer()及ret_form_sys_call()。

schedule():进程调度函数,由它来完成进程的选择(调度)。do_timer():暂且称之为时钟函数,该函数在时钟中断服务程序中被调用,是时钟中断服务程序的主要组成部分,该函数被调用的频率就是时钟中断的频率即每秒钟 100 次;ret_from_sys_call():系统调用返回函数。当一个系统调用或中断完成时,该函数被调用,用于处理一些收尾工作,例如信号处理、核心任务等。

前面我们讲过,时钟中断是一个中断服务程序,它的主要组成部分就是时钟函数do_timer(),由这个函数完成系统时间的更新、进程时间片的更新等工作,更新后的进程时间片counter作为调度的主要依据。

在时钟中断返回时,要调用函数ret_from_sys_call(),前面我们已经讨论过这个函数,在这个函数中有如下几行:1

2

3

4

5

6

7

8

9cmpl $0, _need_resched

jne reschedule

……

restore_all:

RESTORE_ALL

reschedule:

call SYMBOL_NAME(schedule)

jmp ret_from_sys_call

这几行的意思很明显:检测need_resched标志,如果此标志为非 0,那么就转到reschedule处调用调度程序schedule()进行进程的选择。调度程序schedule()会根据具体的标准在运行队列中选择下一个应该运行的进程。当从调度程序返回时,如果发现又有调度标志被设置,则又调用调度程序,直到调度标志为 0,这时,从调度程序返回时由RESTORE_ALL恢复被选定进程的环境,返回到被选定进程的用户空间,使之得到运行。以上就是时钟中断这个最频繁的调度时机。

进程调度的依据

调度程序运行时,要在所有处于可运行状态的进程之中选择最值得运行的进程投入运行。在每个进程的task_struct结构中有如下 5 项:need_resched、nice、counter、policy及rt_priority

need_resched: 在调度时机到来时,检测这个域的值,如果为 1,则调用`schedule() 。counter: 进程处于运行状态时所剩余的时钟滴答数,每次时钟中断到来时,这个值就减 1。当这个域的值变得越来越小,直至为 0 时,就把need_resched域置 1,因此,也把这个域叫做进程的“动态优先级”。nice: 进程的“静态优先级”,这个域决定counter的初值。只有通过nice()、sched_setparam()或setpriority()系统调用才能改变进程的静态优先级。rt_priority: 实时进程的优先级policy: 从整体上区分实时进程和普通进程,因为实时进程和普通进程的调度是不同的,它们两者之间,实时进程应该先于普通进程而运行,可以通过系统调用sched_setscheduler()来改变调度的策略。

对于同一类型的不同进程,采用不同的标准来选择进程。对于普通进程,选择进程的主要依据为counter和nice。对于实时进程,Linux采用了两种调度策略,即FIFO(先来先服务调度)和RR(时间片轮转调度)。因为实时进程具有一定程度的紧迫性,所以衡量一个实时进程是否应该运行,Linux采用了一个比较固定的标准。实时进程的counter只是用来表示该进程的剩余滴答数,并不作为衡量它是否值得运行的标准,这和普通进程是有区别的。

进程可运行程度的衡量

函数goodness()就是用来衡量一个处于可运行状态的进程值得运行的程度。该函数综合使用了上面我们提到的 5 项,给每个处于可运行状态的进程赋予一个权值(weight),调度程序以这个权值作为选择进程的唯一依据。函数主体如下:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27static inline int goodness(struct task_struct * p, struct mm_struct *this_mm)

{

int weight; /* 权值,作为衡量进程是否运行的唯一依据 */

weight=-1;

if (p->policy&SCHED_YIELD)

goto out; /*如果该进程愿意“礼让(yield)”,则让其权值为-1 */

switch(p->policy)

{

/* 实时进程*/

case SCHED_FIFO:

case SCHED_RR:

weight = 1000 + p->rt_priority;

/* 普通进程 */

case SCHED_OTHER:

{

weight = p->counter;

if(!weight)

goto out

/* 做细微的调整*/

if (p->mm=this_mm||!p->mm)

weight = weight+1;

weight+=20-p->nice;

}

}

out:

return weight; /*返回权值*/

}

其中,在sched.h中对调度策略定义如下:1

2

3

4

这个函数比较很简单。首先,根据policy区分实时进程和普通进程。实时进程的权值取决于其实时优先级,其至少是 1000,与conter和nice无关。普通进程的权值需特别说明如下两点。

- 为什么进行细微的调整?如果

p->mm为空,则意味着该进程无用户空间(例如内核线程),则无需切换到用户空间。如果p->mm=this_mm,则说明该进程的用户空间就是当前进程的用户空间,该进程完全有可能再次得到运行。对于以上两种情况,都给其权值加 1,算是对它们小小的“奖励”。 - 进程的优先级

nice是从早期UNIX沿用下来的负向优先级,其数值标志“谦让”的程度,其值越大,就表示其越“谦让”,也就是优先级越低,其取值范围为-20~+19,因此,(20-p->nice)的取值范围就是 0~40。可以看出,普通进程的权值不仅考虑了其剩余的时间片,还考虑了其优先级,优先级越高,其权值越大。

进程调度的实现

调度程序在内核中就是一个函数。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89asmlinkage void schedule(void)

{

struct task_struct *prev, *next, *p; /* prev`表示调度之前的进程, next`表示调度之后的进程 */

struct list_head *tmp;

int this_cpu, c;

if (!current->active_mm)

BUG();/*如果当前进程的`active_mm`为空,出错*/

need_resched_back:

prev = current; /*让`prev`成为当前进程 */

this_cpu = prev->processor;

if (in_interrupt()) {

/*如果`schedule`是在中断服务程序内部执行,就说明发生了错误*/

printk("Scheduling in interrupt\n");

BUG();

}

release_kernel_lock(prev, this_cpu); /*释放全局内核锁,并开`this_CPU的中断*/

spin_lock_irq(&runqueue_lock); /*锁住运行队列,并且同时关中断*/

if (prev->policy == SCHED_RR) /*将一个时间片用完的`SCHED_RR`实时

goto move_rr_last; 进程放到队列的末尾 */

move_rr_back:

switch (prev->state) { /*根据`prev`的状态做相应的处理*/

case TASK_INTERRUPTIBLE: /*此状态表明该进程可以被信号中断*/

if (signal_pending(prev)) { /*如果该进程有未处理的信号,则让其变为可运行状态*/

prev->state = TASK_RUNNING;

break;

}

default: /*如果为可中断的等待状态或僵死状态*/

del_from_runqueue(prev); /*从运行队列中删除*/

case TASK_RUNNING:;/*如果为可运行状态,继续处理*/

}

prev->need_resched = 0;

/*下面是调度程序的正文 */

repeat_schedule: /*真正开始选择值得运行的进程*/

next = idle_task(this_cpu); /*缺省选择空闲进程*/

c = -1000;

if (prev->state == TASK_RUNNING)

goto still_running;

still_running_back:

list_for_each(tmp, &runqueue_head) { /*遍历运行队列*/

p = list_entry(tmp, struct task_struct, run_list);

if ( can_schedule ( p, this_cpu ) ) { / * 单CPU中 ,该函数总返回 1* /

int weight = goodness(p, this_cpu, prev->active_mm);

if (weight > c)

c = weight, next = p;

}

}

/* 如果`c`为 0,说明运行队列中所有进程的权值都为 0,也就是分配给各个进程的时间片都已用完,需重新计算各个进程的时间片 */

if (!c) {

struct task_struct *p;

spin_unlock_irq(&runqueue_lock);/*锁住运行队列*/

read_lock(&tasklist_lock); /* 锁住进程的双向链表*/

for_each_task(p) /* 对系统中的每个进程*/

p->counter = (p->counter >> 1) + NICE_TO_TICKS(p->nice);

read_unlock(&tasklist_lock);

spin_lock_irq(&runqueue_lock);

goto repeat_schedule;

}

spin_unlock_irq(&runqueue_lock);/*对运行队列解锁,并开中断*/

if (prev == next) { /*如果选中的进程就是原来的进程*/

prev->policy &= ~SCHED_YIELD;

goto same_process;

}

/* 下面开始进行进程切换*/

kstat.context_swtch++; /*统计上下文切换的次数*/

{

struct mm_struct *mm = next->mm;

struct mm_struct *oldmm = prev->active_mm;

if (!mm) { /*如果是内核线程,则借用`prev`的地址空间*/

if (next->active_mm) BUG();

next->active_mm = oldmm;

} else { /*如果是一般进程,则切换到`next`的用户空间*/

if (next->active_mm != mm) BUG();

switch_mm(oldmm, mm, next, this_cpu);

}

if (!prev->mm) { /*如果切换出去的是内核线程*/

prev->active_mm = NULL;/*归还它所借用的地址空间*/

mmdrop(oldmm); /*mm_struct`中的共享计数减 1*/

}

}

switch_to(prev, next, prev); /*进程的真正切换,即堆栈的切换*/

__schedule_tail(prev); /*置`prev->policy`的`SCHED_YIELD`为 0 */

same_process:

reacquire_kernel_lock(current);/*针对`SMP*/

if (current->need_resched) /*如果调度标志被置位*/

goto need_resched_back; /*重新开始调度*/

return;

}

- 如果当前进程既没有自己的地址空间,也没有向别的进程借用地址空间,那肯定出错。另外,如果

schedule()在中断服务程序内部执行,那也出错。 - 对当前进程做相关处理,为选择下一个进程做好准备。当前进程就是正在运行着的进程,可是,当进入

schedule()时,其状态却不一定是TASK_RUNNIG,例如,在exit()系统调用中,当前进程的状态可能已被改为TASK_ZOMBE;又例如,在wait4()系统调用中,当前进程的状态可能被置为TASK_INTERRUPTIBLE。因此,如果当前进程处于这些状态中的一种,就要把它从运行队列中删除。 - 从运行队列中选择最值得运行的进程,也就是权值最大的进程。

- 如果已经选择的进程其权值为 0,说明运行队列中所有进程的时间片都用完了(队列中肯定没有实时进程,因为其最小权值为 1000),因此,重新计算所有进程的时间片,其中宏操作

NICE_TO_TICKS就是把优先级nice转换为时钟滴答。 - 进程地址空间的切换。如果新进程有自己的用户空间,也就是说,如果

next->mm与next->active_mm相同,那么,switch_mm()函数就把该进程从内核空间切换到用户空间,也就是加载next的页目录。如果新进程无用户空间(next->mm为空),也就是说,如果它是一个内核线程,那它就要在内核空间运行,因此,需要借用前一个进程(prev)的地址空间,因为所有进程的内核空间都是共享的,因此,这种借用是有效的。 - 用宏

switch_to()进行真正的进程切换。

进程切换

为了控制进程的执行,内核必须有能力挂起正在CPU上运行的进程,并恢复以前挂起的某个进程的执行。这种行为被称为进程切换,任务切换,或上下文切换。Intel在i386 系统结构的设计中考虑到了进程(任务)的管理和调度,并从硬件上支持任务之间的切换。

硬件支持

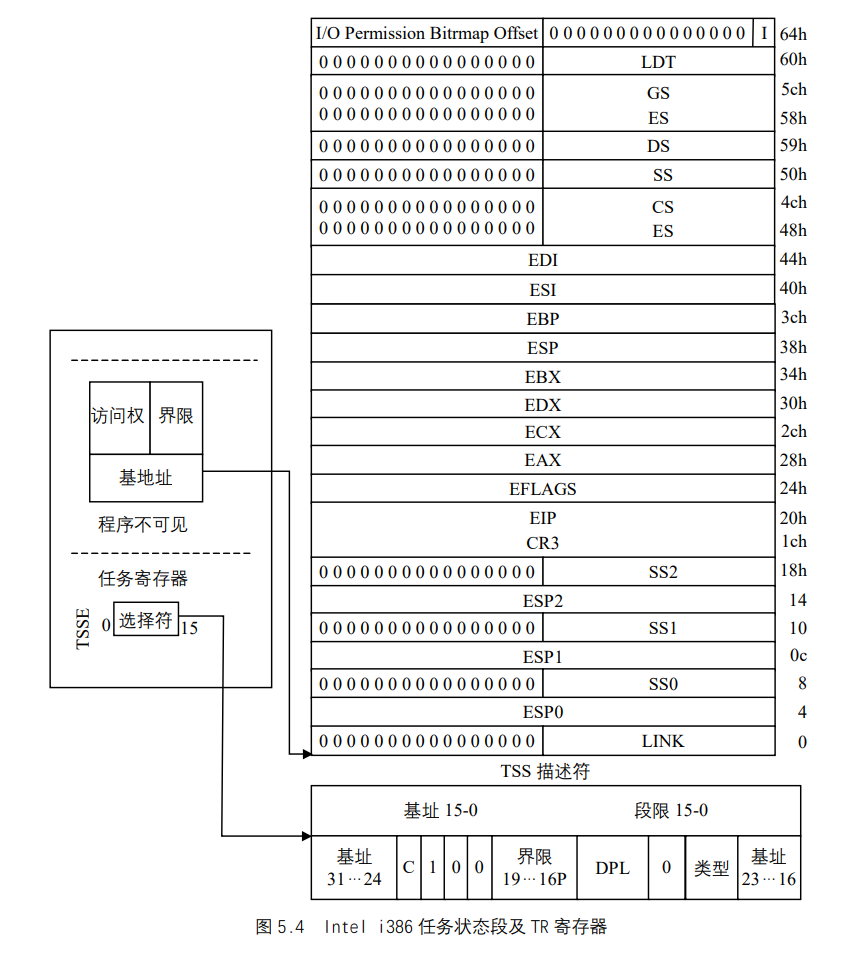

Intel i386 体系结构包括了一个特殊的段类型,叫任务状态段(TSS)。

每个任务包含有它自己最小长度为 104 字节的TSS段,在/include/i386/processor.h中定义为tss_struct结构:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30struct tss_struct {

unsigned short back_link,__blh;

unsigned long esp0;

unsigned short ss0,__ss0h;/*0 级堆栈指针,即Linux中的内核级 */

unsigned long esp1;

unsigned short ss1,__ss1h; /* 1 级堆栈指针,未用*/

unsigned long esp2;

unsigned short ss2,__ss2h; /* 2 级堆栈指针,未用*/

unsigned long __cr3;

unsigned long eip;

unsigned long eflags;

unsigned long eax,ecx,edx,ebx;

unsigned long esp;

unsigned long ebp;

unsigned long esi;

unsigned long edi;

unsigned short es, __esh;

unsigned short cs, __csh;

unsigned short ss, __ssh;

unsigned short ds, __dsh;

unsigned short fs, __fsh;

unsigned short gs, __gsh;

unsigned short ldt, __ldth;

unsigned short trace, bitmap;

unsigned long io_bitmap[IO_BITMAP_SIZE+1];

/*

* pads the TSS to be cacheline-aligned (size is 0x100)

*/

unsigned long __cacheline_filler[5];

};

每个TSS有它自己 8 字节的任务段描述符(Task State Segment Descriptor ,简称TSSD)。这个描述符包括指向TSS起始地址的 32 位基地址域,20 位界限域,界限域值不能小于十进制 104(由TSS段的最小长度决定)。TSS描述符存放在GDT中,它是GDT中的一个表项。

后面将会看到,Linux在进程切换时,只用到TSS中少量的信息,因此Linux内核定义了另外一个数据结构,这就是thread_struct结构:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20struct thread_struct {

unsigned long esp0;

unsigned long eip;

unsigned long esp;

unsigned long fs;

unsigned long gs;

/* Hardware debugging registers */

unsigned long debugreg[8]; /* %%db0-7 debug registers */

/* fault info */

unsigned long cr2, trap_no, error_code;

/* floating point info */

union i387_union i387;

/* virtual 86 mode info */

struct vm86_struct * vm86_info;

unsigned long screen_bitmap;

unsigned long v86flags, v86mask, v86mode, saved_esp0;

/* IO permissions */

int ioperm;

unsigned long io_bitmap[IO_BITMAP_SIZE+1];

};

用这个数据结构来保存cr2寄存器、浮点寄存器、调试寄存器及指定给Intel 80x86 处理器的其他各种各样的信息。需要位图是因为ioperm() 及iopl()系统调用可以允许用户态的进程直接访问特殊的I/O端口。尤其是,如果把eflag寄存器中的IOPL域设置为 3,就允许用户态的进程访问对应的I/O访问权位图位为 0 的任何一个I/O端口。

进程切换

前面所介绍的schedule()中调用了switch_to宏,这个宏实现了进程之间的真正切换,其代码存放于include/i386/system.h:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

"popl %%esi\n\t" \

:"=m" (prev->thread.esp),"=m" (prev->thread.eip), \

"=b" (last) \

:"m" (next->thread.esp),"m" (next->thread.eip), \

"a" (prev), "d" (next), \

"b" (prev)); \

} while (0)

switch_to宏是用嵌入式汇编写成。

thread的类型为前面介绍的thread_struct结构。- 输出参数有 3 个,表示这段代码执行后有 3 项数据会有变化,它们与变量及寄存器的对应关系如下:

- 0%与

prev->thread.esp对应,1%与prev->thread.eip对应,这两个参数都存放在内存,而 2%与ebx寄存器对应,同时说明last参数存放在ebx寄存器中。

- 0%与

- 输入参数有 5 个,其对应关系如下:

- 3%与

next->thread.esp对应,4%与next->thread.eip对应,这两个参数都存放在内存,而 5%、6%和 7%分别与eax、edx及ebx相对应,同时说明prev、next以及prev这 3个参数分别放在这 3 个寄存器中。

- 3%与

- 第 2~4 行就是在当前进程

prev的内核栈中保存esi、edi及ebp寄存器的内容。 - 第 5 行将

prev的内核堆栈指针ebp存入prev->thread.esp中。 - 第 6 行把将要运行进程

next的内核栈指针next->thread.esp置入esp寄存器中。从现在开始,内核对next的内核栈进行操作,因此,这条指令执行从prev到next真正的上下文切换,因为进程描述符的地址与其内核栈的地址紧紧地联系在一起,因此,改变内核栈就意味着改变当前进程。如果此处引用current,那就已经指向next的task_struct`结构了。从这个意义上说,进程的切换在这一行指令执行完以后就已经完成。但是,构成一个进程的另一个要素是程序的执行,这方面的切换尚未完成。 - 第 7 行将标号“1”所在的地址,也就是第一条

popl指令所在的地址保存在prev->thread.eip中,这个地址就是prev下一次被调度运行而切入时的“返回”地址。 - 第 8 行将

next->thread.eip压入next的内核栈。那么,next->thread.eip究竟指向那个地址?实际上,它就是next上一次被调离时通过第 7 行保存的地址,也就是第 11 行popl指令的地址。因为,每个进程被调离时都要执行这里的第 7 行,这就决定了每个进程(除了新创建的进程)在受到调度而恢复执行时都从这里的第 11 行开始。 - 第 9 行通过

jump指令(而不是call指令)转入一个函数__switch_to()。这个函数的具体实现将在下面介绍。当CPU执行到__switch_to()函数的ret指令时,最后进入堆栈的next->thread.eip就变成了返回地址,这就是标号“1”的地址。 - 第 11~13 行恢复

next上次被调离时推进堆栈的内容。从现在开始,next`进程就成为当前进程而真正开始执行。

下面我们来讨论__switch_to()函数。在调用__switch_to()函数之前,对其定义了fastcall:1

extern void FASTCALL(__switch_to(struct task_struct *prev, struct task_struct *next));

fastcall对函数的调用不同于一般函数的调用,因为__switch_to()从寄存器取参数,而不像一般函数那样从堆栈取参数,也就是说,通过寄存器eax和edx把prev和next参数传递给__switch_to()函数。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41void __switch_to(struct task_struct *prev_p, struct task_struct *next_p)

{

struct thread_struct *prev = &prev_p->thread,

*next = &next_p->thread;

struct tss_struct *tss = init_tss + smp_processor_id();

unlazy_fpu(prev_p);/* 如果数学处理器工作,则保存其寄存器的值*/

/* 将`TSS`中的内核级(0 级)堆栈指针换成`next->esp0,这就是`next`进程在内核栈的指针*/

tss->esp0 = next->esp0;

/* 保存`fs`和`gs,但无需保存`es`和`ds,因为当处于内核时,内核段总是保持不变*/

asm volatile("movl %%fs,%0":"=m" (*(int *)&prev->fs));

asm volatile("movl %%gs,%0":"=m" (*(int *)&prev->gs));

/*恢复`next`进程的`fs`和`gs */

loadsegment(fs, next->fs);

loadsegment(gs, next->gs);

/* 如果`next`挂起时使用了调试寄存器,则装载 0~7 个寄存器中的 6 个寄存器,其中第 4、5 个寄存器没有使用 */

if (next->debugreg[7]){

loaddebug(next, 0);

loaddebug(next, 1);

loaddebug(next, 2);

loaddebug(next, 3);

/* no 4 and 5 */

loaddebug(next, 6);

loaddebug(next, 7);

}

if (prev->ioperm || next->ioperm) {

if (next->ioperm) {

/*把`next`进程的`I/O`操作权限位图拷贝到`TSS`中 */

memcpy(tss->io_bitmap, next->io_bitmap,

IO_BITMAP_SIZE*sizeof(unsigned long));

/* 把`io_bitmap`在`tss`中的偏移量赋给`tss->bitmap */

tss->bitmap = IO_BITMAP_OFFSET;

} else

/*如果一个进程要使用`I/O`指令,但是,若位图的偏移量超出`TSS`的范围,

就会产生一个可控制的`SIGSEGV`信号。第一次对`sys_ioperm()的调用会

建立起适当的位图 */

tss->bitmap = INVALID_IO_BITMAP_OFFSET;

}

}

从上面的描述我们看到,尽管Intel本身为操作系统中的进程(任务)切换提供了硬件支持,但是Linux内核的设计者并没有完全采用这种思想,而是用软件实现了进程切换,而且,软件实现比硬件实现的效率更高,灵活性更大。

Linux内存管理

Linux的内存管理概述

Linux的内存管理主要体现在对虚拟内存的管理。我们可以把Linux虚拟内存管理功能概括为以下几点:

- 大地址空间;

- 进程保护;

- 内存映射;

- 公平的物理内存分配;

- 共享虚拟内存。

Linux虚拟内存的实现结构

我们先从整体结构上了解Linux对虚拟内存的实现结构。

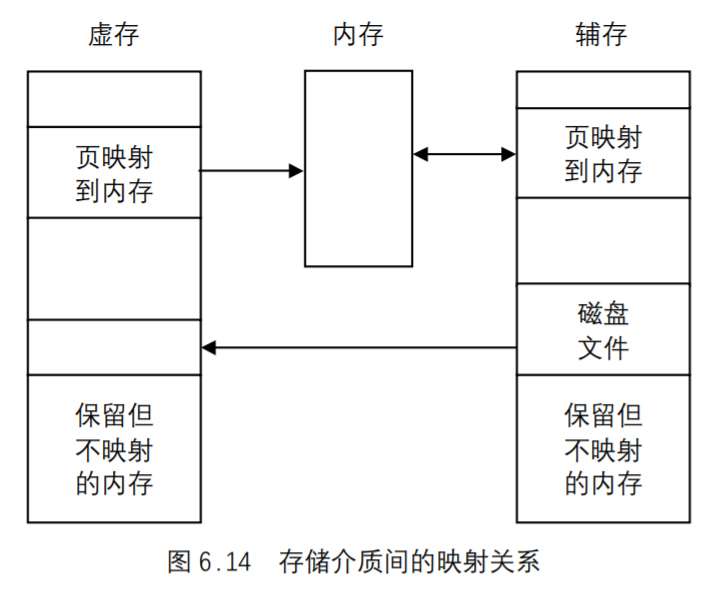

- 内存映射模块(mmap):负责把磁盘文件的逻辑地址映射到虚拟地址,以及把虚拟地址映射到物理地址。

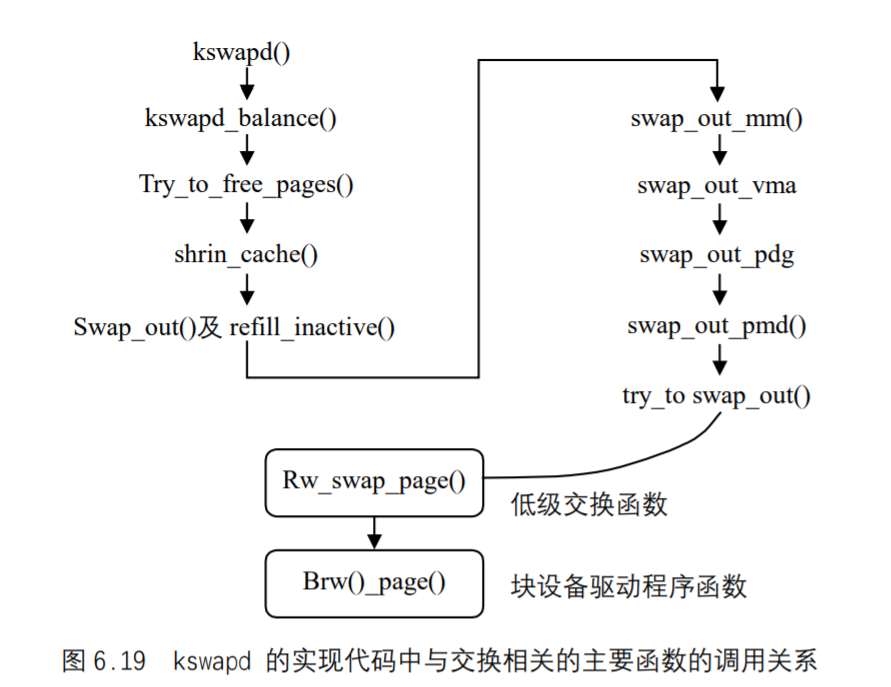

- 交换模块(swap):负责控制内存内容的换入和换出,它通过交换机制,使得在物理内存的页面(RAM`页)中保留有效的页 ,即从主存中淘汰最近没被访问的页,保存近来访问过的页。

- 核心内存管理模块(core):负责核心内存管理功能,即对页的分配、回收、释放及请页处理等,这些功能将被别的内核子系统(如文件系统)使用。

- 结构特定的模块:负责给各种硬件平台提供通用接口,这个模块通过执行命令来改变硬件

MMU的虚拟地址映射,并在发生页错误时,提供了公用的方法来通知别的内核子系统。这个模块是实现虚拟内存的物理基础。

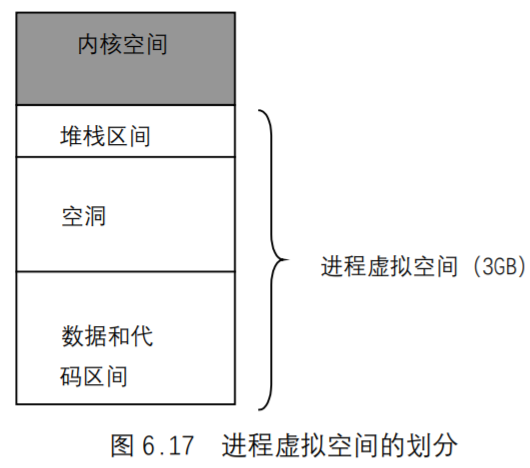

内核空间和用户空间

Linux的虚拟地址空间也为 0~4G字节。Linux内核将这 4G 字节的空间分为两部分。将最高的 1G 字节(从虚拟地址 0xC0000000 到 0xFFFFFFFF),供内核使用,称为“内核空间”。而将较低的 3G 字节(从虚拟地址 0x00000000 到 0xBFFFFFFF),供各个进程使用,称为“用户空间”。因为每个进程可以通过系统调用进入内核,因此,Linux内核由系统内的所有进程共享。于是,从具体进程的角度来看,每个进程可以拥有 4G 字节的虚拟空间。

Linux使用两级保护机制:0 级供内核使用,3 级供用户程序使用。每个进程有各自的私有用户空间(0~3G),这个空间对系统中的其他进程是不可见的。最高的 1G`字节虚拟内核空间则为所有进程以及内核所共享。

虚拟内核空间到物理空间的映射

内核空间中存放的是内核代码和数据,而进程的用户空间中存放的是用户程序的代码和数据。不管是内核空间还是用户空间,它们都处于虚拟空间中。虽然内核空间占据了每个虚拟空间中的最高 1G 字节,但映射到物理内存却总是从最低地址(0x00000000)开始。如图 6.4 所示,对内核空间来说,其地址映射是很简单的线性映射,0xC0000000就是物理地址与线性地址之间的位移量,在Linux代码中就叫做PAGE_OFFSET。

我们来看一下在include/asm/i386/page.h中对内核空间中地址映射的说明及定义:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17/*

* This handles the memory map.. We could make this a config

* option, but too many people screw it up, and too few need

* it.

*

* A __PAGE_OFFSET of 0xC0000000 means that the kernel has

* a virtual address space of one gigabyte, which limits the

* amount of physical memory you can use to about 950MB.

*

* If you want more physical memory than this then see the CONFIG_HIGHMEM4G

* and CONFIG_HIGHMEM64G options in the kernel configuration.

*/

……

源代码的注释中说明,如果你的物理内存大于 950MB,那么在编译内核时就需要加CONFIG_HIGHMEM4G和CONFIG_HIGHMEM64G选项,这种情况我们暂不考虑。如果物理内存小于950MB,则对于内核空间而言,给定一个虚地址x,其物理地址为x - PAGE_OFFSET,给定一个物理地址x,其虚地址为x + PAGE_OFFSET。这里再次说明,宏__pa()仅仅把一个内核空间的虚地址映射到物理地址,而决不适用于用户空间,用户空间的地址映射要复杂得多。

内核映像

在下面的描述中,我们把内核的代码和数据就叫内核映像(Kernel Image)。当系统启动时,Linux内核映像被安装在物理地址 0x00100000 开始的地方,即 1MB 开始的区间(第 1M 留作它用)。然而,在正常运行时, 整个内核映像应该在虚拟内核空间中,因此,连接程序在连接内核映像时,在所有的符号地址上加一个偏移量PAGE_OFFSET,这样,内核映像在内核空间的起始地址就为 0xC0100000。

例如,进程的页目录PGD(属于内核数据结构)就处于内核空间中。在进程切换时,要将寄存器CR3设置成指向新进程的页目录PGD,而该目录的起始地址在内核空间中是虚地址,但CR3所需要的是物理地址,这时候就要用__pa()进行地址转换。在mm_context.h中就有这么一行语句:1

asm volatile("movl %0,%%cr3": :"r" (__pa(next->pgd));

这是一行嵌入式汇编代码,其含义是将下一个进程的页目录起始地址next_pgd,通过__pa()转换成物理地址,存放在某个寄存器中,然后用mov指令将其写入 CR3 寄存器中。经过这行语句的处理,CR3 就指向新进程next的页目录表PGD了。

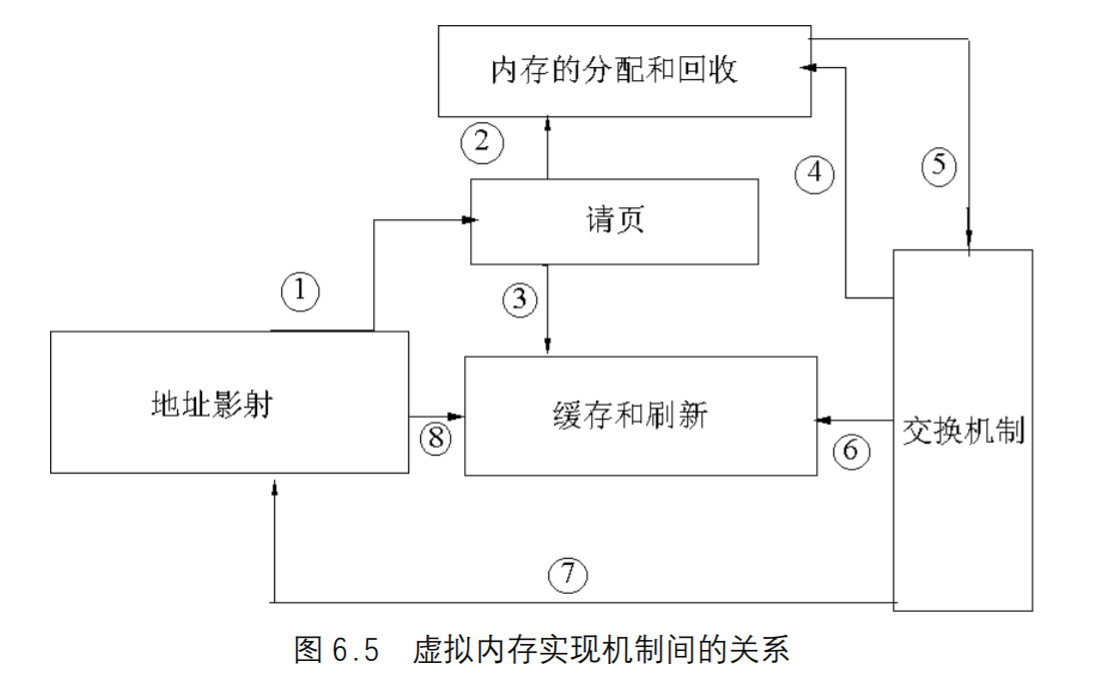

虚拟内存实现机制间的关系

Linux虚拟内存的实现需要各种机制的支持,因此,本章我们将对内存的初始化进行描述以后,围绕以下几种实现机制进行介绍:

- 内存分配和回收机制;

- 地址映射机制;

- 缓存和刷新机制;

- 请页机制;

- 交换机制;

- 内存共享机制。

- 首先内存管理程序通过映射机制把用户程序的逻辑地址映射到物理地址,在用户程序运行时如果发现程序中要用的虚地址没有对应的物理内存时,就发出了请页要求①;

- 如果有空闲的内存可供分配,就请求分配内存②(于是用到了内存的分配和回收),

- 并把正在使用的物理页记录在页缓存中③(使用了缓存机制)。

- 如果没有足够的内存可供分配,那么就调用交换机制,腾出一部分内存④⑤。

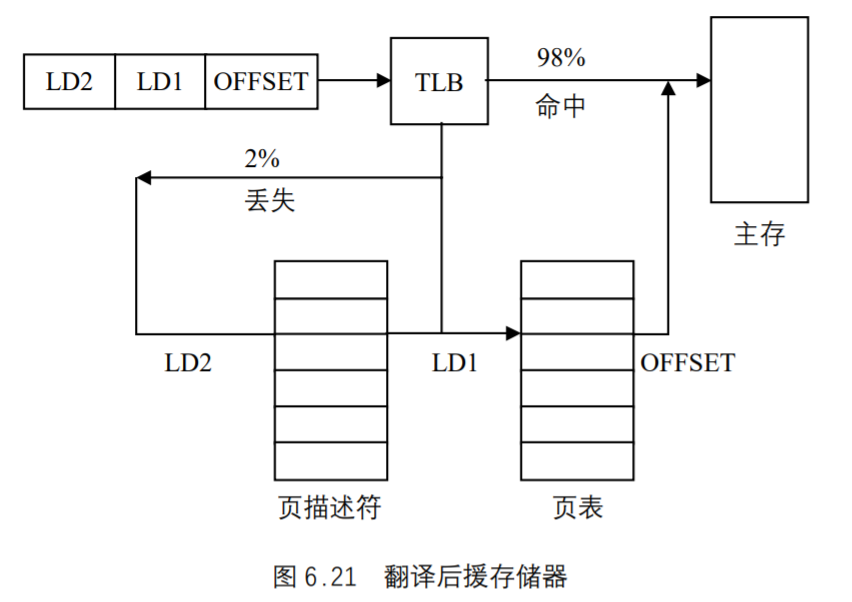

- 另外在地址映射中要通过`TLB(翻译后援存储器)来寻找物理页⑧;

- 交换机制中也要用到交换缓存⑥;

- 并且把物理页内容交换到交换文件中后也要修改页表来映射文件地址⑦。

Linux内存管理的初始化

启用分页机制

当Linux启动时,首先运行在实模式下,随后就要转到保护模式下运行。Linux内核代码的入口点就是/arch/i386/kernel/head.S中的startup_32。

页表的初步初始化

1 | /* |

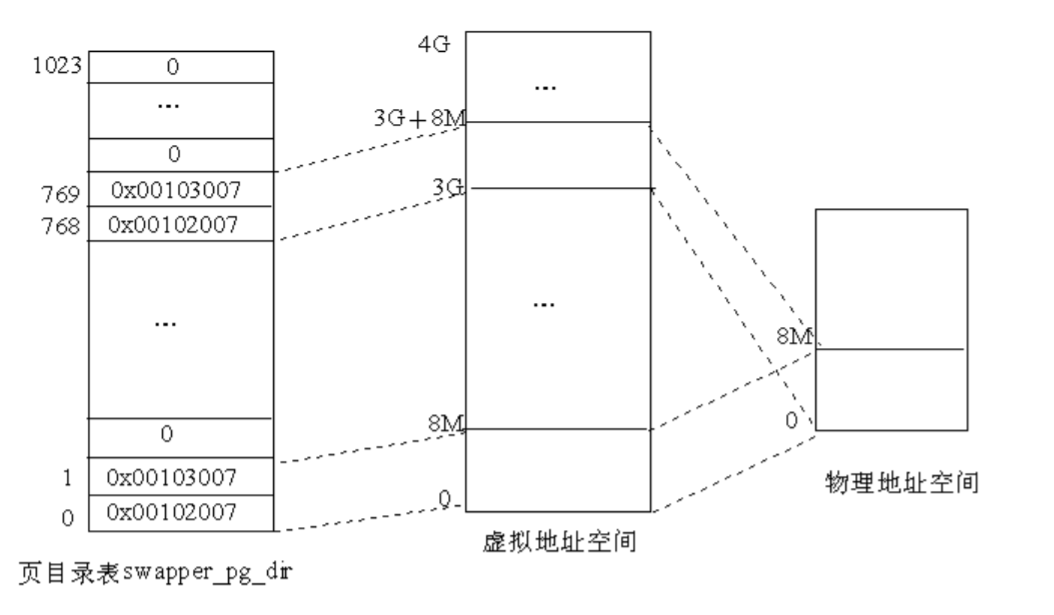

内核的这段代码执行时,因为页机制还没有启用,还没有进入保护模式,因此指令寄存器EIP中的地址还是物理地址,但因为pg0中存放的是虚拟地址(gcc编译内核以后形成的符号地址都是虚拟地址),因此,$pg0-__PAGE_OFFSET获得pg0的物理地址,可见pg0存放在相对于内核代码起点为 0x2000 的地方,即物理地址为 0x00102000,而pg1的物理地址则为 0x00103000。pg0和pg1这个两个页表中的表项则依次被设置为 0x007、0x1007、0x2007等。其中最低的 3 位均为 1,表示这两个页为用户页,可写,且页的内容在内存中。所映射的物理页的基地址则为 0x0、0x1000、0x2000 等,也就是物理内存中的页面 0、1、2、3 等等,共映射 2K个页面,即 8MB 的存储空间。由此可以看出,Linux内核对物理内存的最低要求为 8MB。紧接着存放的是empty_zero_page页(即零页),零页存放的是系统启动参数和命令行参数。

启用分页机制

1 | /* |

我们先来看这段代码的功能。这段代码就是把页目录swapper_pg_dir的物理地址装入控制寄存器cr3,并把cr0 中的最高位置成 1,这就开启了分页机制。但是,启用了分页机制,并不说明Linux内核真正进入了保护模式,因为此时,指令寄存器EIP中的地址还是物理地址,而不是虚地址。jmp 1f指令从逻辑上说不起什么作用,但是,从功能上说它起到丢弃指令流水线中内容的作用,因为这是一个短跳转,EIP中还是物理地址。紧接着的mov和jmp指令把第 2 个标号为 1 的地址装入EAX寄存器并跳转到那儿。在这两条指令执行的过程中, EIP还是指向物理地址“1MB+某处”。因为编译程序使所有的符号地址都在虚拟内存空间中,因此,第 2 个标号 1 的地址就在虚拟内存空间的某处(PAGE_OFFSET+某处),于是,jmp指令执行以后,EIP`就指向虚拟内核空间的某个地址,这就使CPU转入了内核空间,从而完成了从实模式到保护模式的平稳过渡。

然后再看页目录swapper_pg_dir中的内容。从前面的讨论我们知道pg0 和pg1 这两个页表的起始物理地址分别为 0x00102000 和 0x00103000。页目录项的最低 12位用来描述页表的属性。因此,在swapper_pg_dir中的第 0 和第 1 个目录项 0x00102007、0x00103007,就表示pg0 和pg1 这两个页表是用户页表、可写且页表的内容在内存。接着,把swapper_pg_dir中的第 2~767 共 766 个目录项全部置为 0。因为一个页表的大小为 4KB,每个表项占 4 个字节,即每个页表含有 1024 个表项,每个页的大小也为 4KB,因此这 768 个目录项所映射的虚拟空间为 768×1024×4K=3G,也就是swapper_pg_dir表中的前 768 个目录项映射的是用户空间。

最后,在第 768 和 769 个目录项中又存放pg0 和pg1 这两个页表的地址和属性,而把第770~1023 共 254 个目录项置 0。这 256 个目录项所映射的虚拟地址空间为 256×1024×4K=1G,也就是swapper_pg_dir表中的后 256 个目录项映射的是内核空间。由此可以看出,在初始的页目录swapper_pg_dir中,用户空间和内核空间都只映射了开头的两个目录项,即 8MB`的空间,而且有着相同的映射,如图 6.6 所示。

当CPU进入内核代码的起点startup_32后,是以物理地址来取指令的。在这种情况下,如果页目录只映射内核空间,而不映射用户空间的低区,则一旦开启页映射机制以后就不能继续执行了,这是因为,此时CPU中的指令寄存器EIP仍指向低区,仍会以物理地址取指令,直到以某个符号地址为目标作绝对转移或调用子程序为止。所以,Linux内核就采取了上述的解决办法。

但是,在CPU转入内核空间以后,应该把用户空间低区的映射清除掉。页目录swapper_pg_dir经扩充后就成为所有内核线程的页目录。在内核线程的正常运行中,处于内核态的CPU是不应该通过用户空间的虚拟地址访问内存的。清除了低区的映射以后,如果发生CPU在内核中通过用户空间的虚拟地址访问内存,就可以因为产生页面异常而捕获这个错误。

物理内存的初始分布

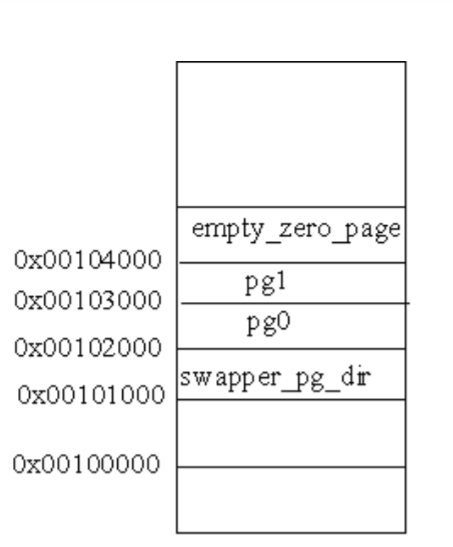

经过这个阶段的初始化,初始化阶段页目录及几个页表在物理空间中的位置如图 6.7 所示。

其中empty_zero_page中存放的是在操作系统的引导过程中所收集的一些数据,叫做引导参数。因为这个页面开始的内容全为 0,所以叫做“零页”,代码中常常通过宏定义ZERO_PAGE来引用这个页面。不过,这个页面要到初始化完成,系统转入正常运行时才会用到。这里假定这些参数已被复制到“零页”,在setup.c中定义了引用这些参数的宏:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22 /*

* This is set up by the setup-routine at boot-time

*/

其中宏PARAM就是empty_zero_page的起始位置。

这里要特别对宏E820_MAP进行说明。E820_MAP是个struct e820entry数据结构的指针,存放在参数块中位移为 0x2d0 的地方。这个数据结构定义在include/i386/e820.h中:1

2

3

4

5

6

7

8

9struct e820map {

int nr_map;

struct e820entry {

unsigned long long addr; /* start of memory segment */

unsigned long long size; /* size of memory segment */

unsigned long type; /* type of memory segment */

} map[E820MAX];

};

extern struct e820map e820;

其中,E820MAX被定义为 32。从这个数据结构的定义可以看出,每个e820entry都是对一个物理区间的描述,并且一个物理区间必须是同一类型。如果有一片地址连续的物理内存空间,其一部分是RAM,而另一部分是ROM,那就要分成两个区间。即使同属RAM,如果其中一部分要保留用于特殊目的,那也属于不同的分区。在e820.h`文件中定义了 4 种不同的类型:1

2

3

4

5

其中E820_NVS表示“Non-Volatile Storage”,即“不挥发”存储器,包括ROM、EPROM、Flash存储器等。

因为历史的原因,把 1MB以上的空间定义为HIGH_MEMORY,这个称呼一直沿用到现在,于是代码中的常数HIGH_MEMORY就定义为“1024×1024”。现在,配备了 128MB 的内存已经是很普遍了。但是,为了保持兼容,就得留出最初 1MB`的空间。这个阶段初始化后,物理内存中内核映像的分布如图 6.8 所示。

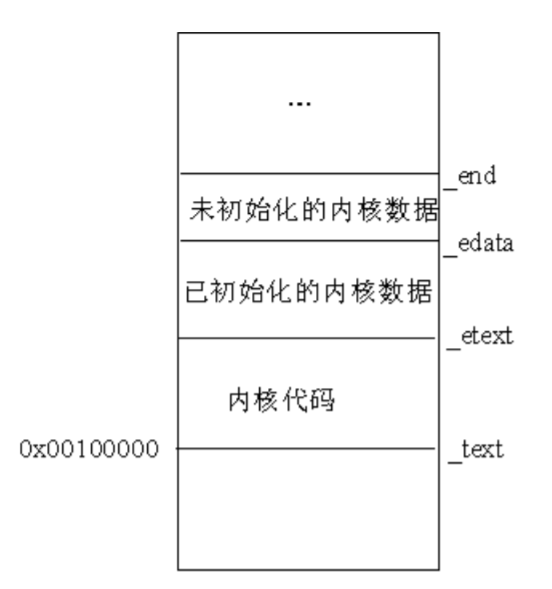

符号_text对应物理地址 0x00100000,表示内核代码的第一个字节的地址。内核代码的结束位置用另一个类似的符号_etext表示。内核数据被分为两组:初始化过的数据和未初始化过的数据。初始化过的数据在_etext后开始,在_edata处结束,紧接着是未初始化过的数据,其结束符号为_end,这也是整个内核映像的结束符号。

物理内存的探测

BIOS能引导操作系统,还担负着加电自检和对资源的扫描探测,包括了对物理内存的自检和扫描。对于这个阶段中获得的内存信息可以通过BIOS调用int 0x15加以检查。由于Linux内核不能作BIOS调用,因此内核本身就得代为检查,并根据获得的信息生成一幅物理内存构成图,然后通过上面提到的参数块传给内核,使得内核能知道系统中内存资源的配置。之所以称为e820 图,是因为在通过int 0x15查询内存的构成时要把调

用参数之一设置成0xe820。

分页机制启用以后,与内存管理相关的操作就是调用init/main.c中的start_kernel()函数,start_kernel()函数要调用一个叫setup_arch()的函数,setup_arch()位于arch/i386/kernel/setup.c文件中,我们所关注的与物理内存探测相关的内容就在这个函数中。

setup_arch()函数

- 首先调用

setup_memory_region()函数,这个函数处理内存构成图(map),并把内存的分布信息存放在全局变量`e820 中。 - 调用

parse_mem_cmdline(cmdline_p)函数。在特殊的情况下,有的系统可能有特殊的RAM空间结构,此时可以通过引导命令行中的选择项来改变存储空间的逻辑结构,使其正确反映内存的物理结构。此函数的作用就是分析命令行中的选择项,并据此对数据结构e820 中的内容作出修正,其代码也在setup.c中。

宏定义:1

2

3

PFN_UP()和PFN_DOWN()都是将地址x转换为页面号(PFN即Page Frame Number的缩写),二者之间的区别为:PFN_UP()返回大于x的第 1 个页面号,而PFN_DOWN()返回小于x的第 1 个页面号。宏PFN_PHYS()返回页面号x的物理地址。

宏定义1

2

3

4

5

6

7/*

* 128MB for vmalloc and initrd

*/

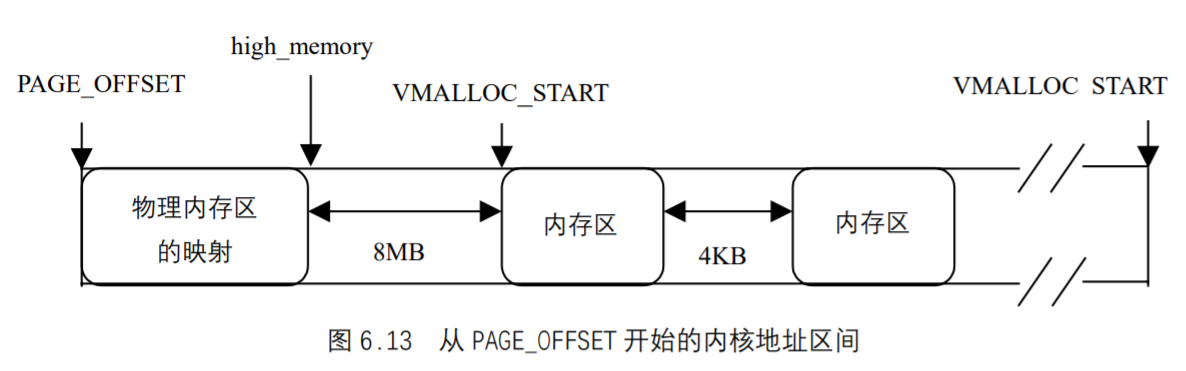

对这几个宏描述如下:

VMALLOC_RESERVE:为vmalloc()函数访问内核空间所保留的内存区,大小为 128MB。MAXMEM:内核能够直接映射的最大RAM容量,为 1GB-128MB=896MB(-PAGE_OFFSET`就等于 1GB)MAXMEM_PFN:返回由内核能直接映射的最大物理页面数。MAX_NONPAE_PFN:给出在 4GB 之上第 1 个页面的页面号。当页面扩充(PAE)功能启用时,才能访问 4GB 以上的内存。

获得内核映像之后的起始页面号:1

2

3

4

5/*

* partially used pages are not usable - thus

* we are rounding upwards:

*/

start_pfn = PFN_UP(__pa(&_end));

在上一节已说明,宏__pa()返回给定虚拟地址的物理地址。其中标识符_end表示内核映像在内核空间的结束位置。因此,存放在变量start_pfn中的值就是紧接着内核映像之后的页面号。

找出可用的最高页面号:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16/*

* Find the highest page frame number we have available

*/

max_pfn = 0;

for (i = 0; i < e820.nr_map; i++) {

unsigned long start, end;

/* RAM? */

if (e820.map[i].type != E820_RAM)

continue;

start = PFN_UP(e820.map[i].addr);

end = PFN_DOWN(e820.map[i].addr + e820.map[i].size);

if (start >= end)

continue;

if (end > max_pfn)

max_pfn = end;

}

上面这段代码循环查找类型为E820_RAM(可用RAM)的内存区,并把最后一个页面的页面号存放在max_pfn中。

确定最高和最低内存范围:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24/*

* Determine low and high memory ranges:

*/

max_low_pfn = max_pfn;

if (max_low_pfn > MAXMEM_PFN) {

max_low_pfn = MAXMEM_PFN;

/* Maximum memory usable is what is directly addressable */

printk(KERN_WARNING "Warning only %ldMB will be used.\n",

MAXMEM>>20);

if (max_pfn > MAX_NONPAE_PFN)

printk(KERN_WARNING "Use a PAE enabled kernel.\n");

else

printk(KERN_WARNING "Use a HIGHMEM enabled kernel.\n");

if (max_pfn > MAX_NONPAE_PFN) {

max_pfn = MAX_NONPAE_PFN;

printk(KERN_WARNING "Warning only 4GB will be used.\n");

printk(KERN_WARNING "Use a PAE enabled kernel.\n");

}

}

有两种情况:

- 如果物理内存

RAM大于 896MB,而小于 4GB,则选用CONFIG_HIGHMEM选项来进行访问; - 如果物理内存

RAM大于 4GB,则选用CONFIG_X86_PAE(启用PAE模式)来进行访问。

上面这段代码检查了这两种情况,并显示适当的警告信息。

1 |

|

如果使用了CONFIG_HIGHMEM选项,上面这段代码仅仅打印出大于 896MB`的可用物理内存数量。

初始化引导时的分配器1

2/* Initialize the boot-time allocator (with low memory only): */

bootmap_size = init_bootmem(start_pfn, max_low_pfn);

通过调用init_bootmem()函数,为物理内存页面管理机制的建立做初步准备,为整个物理内存建立起一个页面位图。这个位图建立在从start_pfn开始的地方,也就是说,把内核映像终点_end上方的若干页面用作物理页面位图。在前面的代码中已经搞清楚了物理内存顶点所在的页面号为max_low_pfn,所以物理内存的页面号一定在 0~max_low_pfn`之间。建立这个位图的目的就是要搞清楚哪一些物理内存页面可以动态分配的。

用bootmem分配器,登记全部低区(0~896MB)的可用RAM页面1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32 /*

* Register fully available low RAM pages with the

* bootmem allocator.

*/

for (i = 0; i < e820.nr_map; i++) {

unsigned long curr_pfn, last_pfn, size;

/*

* Reserve usable low memory

*/

if (e820.map[i].type != E820_RAM)

continue;

/*

* We are rounding up the start address of usable memory:

*/

curr_pfn = PFN_UP(e820.map[i].addr);

if (curr_pfn >= max_low_pfn)

continue;

/*

* ... and at the end of the usable range downwards:

*/

last_pfn = PFN_DOWN(e820.map[i].addr + e820.map[i].size);

if (last_pfn > max_low_pfn)

last_pfn = max_low_pfn;

/*

* .. finally, did all the rounding and playing

* around just make the area go away?

*/

if (last_pfn <= curr_pfn)

continue;

size = last_pfn - curr_pfn;

free_bootmem(PFN_PHYS(curr_pfn), PFN_PHYS(size));

}

这个循环仔细检查所有可以使用的RAM,并调用free_bootmem()函数把这些可用RAM标记为可用。这个函数调用以后,只有类型为 1(可用RAM)的内存被标记为可用的。

保留内存:1

2

3

4

5

6

7

8/*

* Reserve the bootmem bitmap itself as well. We do this in two

* steps (first step was init_bootmem()) because this catches

* the (very unlikely) case of us accidentally initializing the

* bootmem allocator with an invalid RAM area.

*/

reserve_bootmem(HIGH_MEMORY, (PFN_PHYS(start_pfn) +

bootmap_size + PAGE_SIZE-1) - (HIGH_MEMORY));

这个函数把内核和bootmem位图所占的内存标记为“保留”。HIGH_MEMORY为 1MB,即内核开始的地方。

setup_memory_region() 函数

这个函数用来处理BIOS的内存构成图,并把这个构成图拷贝到全局变量`e820 中。如果操作失败,就创建一个伪内存构成图。这个函数的主要操作如下所述。

- 调用

sanitize_e820_map()函数,以删除内存构成图中任何重叠的部分,因为BIOS所报告的内存构成图可能有重叠。 - 调用

copy_e820_map()进行实际的拷贝。 - 如果操作失败,创建一个伪内存构成图,这个伪构成图有两部分:0 到 640K

及 1M到最大物理内存。 - 打印最终的内存构成图。

copy_e820_map() 函数

函数原型为:1

static int __init sanitize_e820_map(struct e820entry * biosmap, char * pnr_map)

其主要操作如下概述。

如果物理内存区间小于 2,那肯定出错。因为

BIOS至少和RAM属于不同的物理区间。1

2if (nr_map < 2)

return -1;从

BIOS构成图中读出一项。1

2

3

4

5

6do {

unsigned long long start = biosmap->addr;

unsigned long long size = biosmap->size;

unsigned long long end = start + size;

unsigned long type = biosmap->type;

}进行检查。

1

2

3/* Overflow in 64 bits? Ignore the memory map. */

if (start > end)

return -1;一些

BIOS把 640KB~1MB 之间的区间作为RAM来用,这是不符合常规的。因为从0xA0000 开始的空间用于图形卡,因此,在内存构成图中要进行修正。如果一个区的起点在0xA0000 以下,而终点在 1MB 之上,就要将这个区间拆开成两个区间,中间跳过从 0xA0000到 1MB边界之间的那一部分。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18/*

* Some BIOSes claim RAM in the 640k - 1M region.

* Not right. Fix it up.

*/

if (type == E820_RAM) {

if (start < 0x100000ULL && end > 0xA0000ULL) {

if (start < 0xA0000ULL)

add_memory_region(start, 0xA0000ULL-start, type)

if (end <= 0x100000ULL)

continue;

start = 0x100000ULL;

size = end - start;

}

}

add_memory_region(start, size, type);

} while (biosmap++,--nr_map);

return 0;

add_memory_region() 函数

这个函数的功能就是在`e820 中增加一项,其主要操作如下所述。

获得已追加在`e820 中的内存区数。

1

int x = e820.nr_map;

如果数目已达到最大(32),则显示一个警告信息并返回。

1

2

3

4if (x == E820MAX) {

printk(KERN_ERR "Oops! Too many entries in the memory map!\n");

return;

}在e820 中增加一项,并给

nr_map加 1。1

2

3

4e820.map[x].addr = start;

e820.map[x].size = size;

e820.map[x].type = type;

e820.nr_map++;

print_memory_map() 函数

这个函数把内存构成图在控制台上输出。例如函数的输出为(BIOS所提供的物理RAM区间):1

2

3

4BIOS-e820: 0000000000000000 - 00000000000a0000 (usable)

BIOS-e820: 00000000000f0000 - 0000000000100000 (reserved)

BIOS-e820: 0000000000100000 - 000000000c000000 (usable)

BIOS-e820: 00000000ffff0000 - 0000000100000000 (reserved)

物理内存的描述

一致存储结构(UMA)和非一致存储结构(NUMA)

在传统的计算机结构中,整个物理内存都是均匀一致的,CPU访问这个空间中的任何一个地址所需要的时间都相同,所以把这种内存称为“一致存储结构(Uniform Memory Architecture)”,简称`UMA。

在多CPU结构中,系统中只有一条总线(例如,PCI`总线),每个CPU模块都有本地的物理内存,但是也可以通过系统总线访问其他CPU模块上的内存,所有的CPU模块都可以通过系统总线来访问公用的存储模块。因此,所有这些物理内存的地址可以互相连续而形成一个连续的物理地址空间。

显然,就某个特定的CPU而言,访问其本地的存储器速度是最快的,而穿过系统总线访问公用存储模块或其他CPU模块上的存储器就比较慢,而且还面临因可能的竞争而引起的不确定性。也就是说,在这样的系统中,其物理存储空间虽然地址连续,但因为所处“位置”不同而导致的存取速度不一致,所以称为“非一致存储结构( Non-Uniform Memory Architecture),简称`NUMA。

为了对NUMA进行描述,引入一个新的概念——“存储节点(或叫节点)”,把访问时间相同的存储空间就叫做一个“存储节点”。一般来说,连续的物理页面应该分配在相同的存储节点上。

Linux把物理内存划分为 3个层次来管理:存储节点(Node)、管理区(Zone)和页面(Page),并用 3 个相应的数据结构来描述。

页面(Page)数据结构

对一个物理页面的描述在/include/linux/mm.h中:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31/*

* Each physical page in the system has a struct page associated with

* it to keep track of whatever it is we are using the page for at the

* moment. Note that we have no way to track which tasks are using

* a page.

*

* Try to keep the most commonly accessed fields in single cache lines

* here (16 bytes or greater). This ordering should be particularly

* beneficial on 32-bit processors.

*

* The first line is data used in page cache lookup, the second line

* is used for linear searches (eg. clock algorithm scans).

*

* TODO: make this structure smaller, it could be as small as 32 bytes.

*/

typedef struct page {

struct list_head list; /* ->mapping has some page lists. */

struct address_space *mapping; /* The inode (or ...) we belong to. */

unsigned long index; /* Our offset within mapping. */

struct page *next_hash; /* Next page sharing our hash bucket in the pagecache hash table. */

atomic_t count; /* Usage count, see below. */

unsigned long flags; /* atomic flags, some possibly updated asynchronously */

struct list_head lru; /* Pageout list, eg. active_list;

protected by pagemap_lru_lock !! */

wait_queue_head_t wait; /* Page locked? Stand in line... */

struct page **pprev_hash; /* Complement to *next_hash. */

struct buffer_head * buffers; /* Buffer maps us to a disk block. */

void *virtual; /* Kernel virtual address (NULL if not kmapped, ie. highmem) */

struct zone_struct *zone; /* Memory zone we are in. */

} mem_map_t;

extern mem_map_t * mem_map;

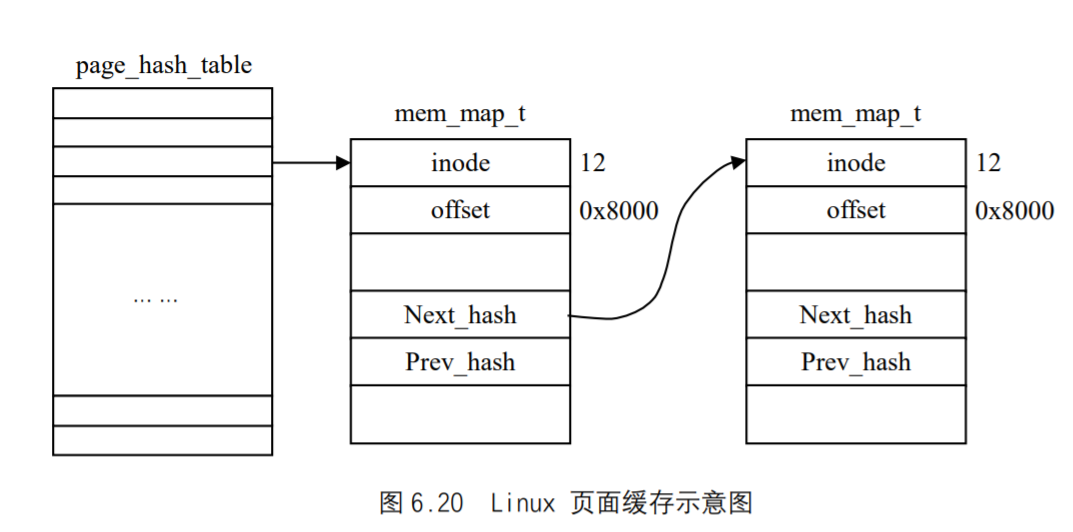

内核中用来表示这个数据结构的变量常常是page或map。当页面的数据来自一个文件时,index代表着该页面中的数据在文件中的偏移量;当页面的内容被换出到交换设备上,则index指明了页面的去向。结构中各个成分的次序是有讲究的,尽量使得联系紧密的若干域存放在一起,这样当这个数据结构被装入到高速缓存中时,联系紧密的域就可以存放在同一缓冲行(Cache Line)中。因为同一缓冲行(其大小为 16字节)中的内容几乎可以同时存取,因此,代码注释中希望这个数据结构尽量地小到用 32个字节可以描述。

系统中的每个物理页面都有一个Page(或mem_map_t)结构。系统在初始化阶段根据内存的大小建立起一个Page结构的数组mem_map,数组的下标就是内存中物理页面的序号。

管理区`Zone

为了对物理页面进行有效的管理,Linux又把物理页面划分为 3 个区:

- 专供

DMA使用的ZONE_DMA区(小于 16MB); - 常规的

ZONE_NORMAL区(大于 16MB`小于 896MB); - 内核不能直接映射的区

ZONE_HIGME区(大于 896MB)。

这里进一步说明为什么对DMA要单独设置管理区。

- 首先,DMA使用的页面是磁盘

I/O所需的,如果在页面的分配过程中,所有的页面全被分配完,那么页面及盘区的交换就无法进行了,这是操作系统决不允许出现的现象。 - 另外,在 i386 CPU中,页式存储管理的硬件支持是在CPU内部实现的,而不像有些CPU那样由一个单独的

MMU来提供,所以DMA对内存的访问不经过MMU提供的地址映射。这样,外部设备就要直接访问物理页面的地址。可是,有些外设(特别是插在ISA总线上的外设接口卡)在这方面往往有些限制,要求用于DMA的物理地址不能过高。另一方面,当DMA所需的缓冲区超过一个物理页面的大小时,就要求两个物理页面在物理上是连续的,但因为此时DMA控制器不能依靠CPU内部的MMU将连续的虚存页面映射到物理上也连续的页面上,因此,用于DMA的物理页面必须加以单独管理。

存储节点(Node)的数据结构

存储节点的数据结构为pglist_data,定义于include/linux/mmzone.h中:1

2

3

4

5

6

7

8

9

10

11

12

13typedef struct pglist_data {

zone_t node_zones[MAX_NR_ZONES];

zonelist_t node_zonelists[GFP_ZONEMASK+1];

int nr_zones;

struct page *node_mem_map;

unsigned long *valid_addr_bitmap;

struct bootmem_data *bdata;

unsigned long node_start_paddr;

unsigned long node_start_mapnr;

unsigned long node_size;

int node_id;

struct pglist_data *node_next;

} pg_data_t;

显然,若干存储节点的pglist_data数据结构可以通过node_next形成一个单链表队列。每个结构中的node_mem_map指向具体节点的page结构数组,而数组node_zone[]就是该节点的最多 3 个页面管理区。

在pglist_data结构里设置了一个node_zonelists数组,其类型定义也在同一文件中:1

2

3

4typedef struct zonelist_struct {

zone_t *zone[MAX_NR_ZONE+1]; //NULL delimited

int gfp_mast;

} zonelist_t;

这里的zone[]是个指针数组,各个元素按特定的次序指向具体的页面管理区,表示分配页面时先试zone[0]所指向的管理区,如果不能满足要求就试zone[1]所指向的管理区,等等。

页面管理机制的初步建立

为了对页面管理机制作出初步准备,Linux使用了一种叫bootmem分配器(Bootmem Allocator)的机制,这种机制仅仅用在系统引导时,它为整个物理内存建立起一个页面位图。这个位图建立在从start_pfn开始的地方,也就是说,内核映像终点_end上方的地方。这个位图用来管理低区(例如小于 896MB),因为在 0 到 896MB 的范围内,有些页面可能保留,有些页面可能有空洞,因此,建立这个位图的目的就是要搞清楚哪一些物理页面是可以动态分配的。用来存放位图的数据结构为bootmem_data(在mm/numa.c中) :1

2

3

4

5

6

7typedef struct bootmem_data {

unsigned long node_boot_start;

unsigned long node_low_pfn;

void *node_bootmem_map;

unsigned long last_offset;

unsigned long last_pos;

} bootmem_data_t;

node_boot_start表示存放bootmem位图的第一个页面(即内核映像结束处的第一个页面)。node_low_pfn表示物理内存的顶点,最高不超过 896MB。node_bootmem_map指向bootmem位图last_offset用来存放在前一次分配中所分配的最后一个字节相对于last_pos的位移量。last_pos用来存放前一次分配的最后一个页面的页面号。这个域用在__alloc_bootmem_core()函数中,通过合并相邻的内存来减少内部碎片。

下面介绍与bootmem相关的几个函数,这些函数位于mm/bootmeme.c中。

init_bootmem()函数

1 | unsigned long __init init_bootmem (unsigned long start, unsigned long pages) |

这个函数仅在初始化时用来建立bootmem分配器。这个函数实际上是init_bootmem_core()函数的封装函数。init_bootmem()函数的参数start表示内核映像结束处的页面号,而pages表示物理内存顶点所在的页面号。而函数init_bootmem_core()就是对contig_page_data变量进行初始化。下面我们来看一下对该变量的定义:1

2

3int numnodes = 1; /* Initialized for UMA platforms */

static bootmem_data_t contig_bootmem_data;

pg_data_t contig_page_data = { bdata: &contig_bootmem_data };

变量contig_page_data的类型就是前面介绍过的pg_data_t数据结构。每个pg_data_t数据结构代表着一片均匀的、连续的内存空间。在连续空间UMA结构中,只有一个节点contig_page_data,而在NUMA结构或不连续空间UMA结构中,有多个这样的数据结构。系统中各个节点的pg_data_t数据结构通过node_next连接在一起成为一个链。有一个全局量pgdat_list则指向这个链。从上面的定义可以看出,contig_page_data是链中的第一个节点。

这里假定整个物理空间为均匀的、连续的,以后若发现这个假定不能成立,则将新的pg_data_t结构加入到链中。pg_data_t结构中有个指针bdata,contig_page_data被初始化为指向bootmem_data_t数据结构。下面我们来看init_bootmem_core()函数的具体代码:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20/*

* Called once to set up the allocator itself.

*/

static unsigned long __init init_bootmem_core (pg_data_t *pgdat, unsigned long mapstart, unsigned long start, unsigned long end)

{

bootmem_data_t *bdata = pgdat->bdata;

unsigned long mapsize = ((end - start)+7)/8;

pgdat->node_next = pgdat_list;

pgdat_list = pgdat;

mapsize = (mapsize + (sizeof(long) - 1UL)) & ~(sizeof(long) - 1UL);

bdata->node_bootmem_map = phys_to_virt(mapstart << PAGE_SHIFT);

bdata->node_boot_start = (start << PAGE_SHIFT);

bdata->node_low_pfn = end;

/*

* Initially all pages are reserved - setup_arch() has to

* register free RAM areas explicitly.

*/

memset(bdata->node_bootmem_map, 0xff, mapsize);

return mapsize;

}

下面对这一函数给予说明。

- 变量

mapsize存放位图的大小。(end - start)给出现有的页面数,再加个 7 是为了向上取整,除以 8 就获得了所需的字节数(因为每个字节映射 8 个页面)。 - 变量

pgdat_list用来指向节点所形成的循环链表首部,因为只有一个节点,因此使pgdat_list指向自己。 - 接下来的一句使

memsize成为下一个 4 的倍数(4 为CPU的字长)。例如,假设有 40 个物理页面,因此,我们可以得出memsize为 5 个字节。所以,上面的操作就变为(5+(4-1))&~(4-1)即(00001000&11111100),最低的两位变为 0,其结果为 8。这就有效地使memsize变为 4 的倍数。 phys_to_virt(mapstart << PAGE_SHIFT)把给定的物理地址转换为虚地址。- 用节点的起始物理地址初始化

node_boot_start(这里为 0x00000000)。 - 用物理内存节点的页面号初始化

node_low_pfn。 - 初始化所有被保留的页面,即通过把页面中的所有位都置为 1 来标记保留的页面。

- 返回位图的大小。

free_bootmem()函数

这个函数把给定范围的页面标记为空闲(即可用),也就是,把位图中某些位清 0,表示相应的物理内存可以投入分配。原函数为:1

2

3

4void __init free_bootmem (unsigned long addr, unsigned long size)

{

return (free_bootmem_core(contig_page_data.bdata, addr, size));

}

从上面可以看出,free_bootmem()是个封装函数,实际的工作是由free_bootmem_core()函数完成的:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24static void __init free_bootmem_core(bootmem_data_t *bdata, unsigned long addr, unsigned long size)

{

unsigned long i;

unsigned long start;

/*

* round down end of usable mem, partially free pages are

* considered reserved.

*/

unsigned long sidx;

unsigned long eidx = (addr + size - bdata->node_boot_start)/PAGE_SIZE;

unsigned long end = (addr + size)/PAGE_SIZE;

if (!size) BUG();

if (end > bdata->node_low_pfn)

BUG();

/*

* Round up the beginning of the address.

*/

start = (addr + PAGE_SIZE-1) / PAGE_SIZE;

sidx = start - (bdata->node_boot_start/PAGE_SIZE);

for (i = sidx; i < eidx; i++) {

if (!test_and_clear_bit(i, bdata->node_bootmem_map))

BUG();

}

}

对此函数的解释如下。

- 变量

eidx被初始化为页面总数。 - 变量

end被初始化为最后一个页面的页面号。 - 进行两个可能的条件检查。

start初始化为第一个页面的页面号(向上取整),而sidx(start index)初始化为相对于node_boot_start的页面号。- 清位图中从

sidx到eidx的所有位,即把这些页面标记为可用。

reserve_bootmem()函数

这个函数用来保留页面。为了保留一个页面,只需要在bootmem位图中把相应的位置为1 即可。原函数为:1

2

3

4void __init reserve_bootmem (unsigned long addr, unsigned long size)

{

reserve_bootmem_core(contig_page_data.bdata, addr, size);

}

reserve_bootmem()为封装函数,实际调用的是reserve_bootmem_core()函数:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25static void __init reserve_bootmem_core ( bootmem_data_t *bdata, unsigned long addr, unsigned long size)

{

unsigned long i;

/*

* round up, partially reserved pages are considered

* fully reserved.

*/

unsigned long sidx = (addr - bdata->node_boot_start)/PAGE_SIZE;

unsigned long eidx = (addr + size - bdata->node_boot_start + PAGE_SIZE-1)/PAGE_SIZE;

unsigned long end = (addr + size + PAGE_SIZE-1)/PAGE_SIZE;

if (!size) BUG();

if (sidx < 0)

BUG();

if (eidx < 0)

BUG();

if (sidx >= eidx)

BUG();

if ((addr >> PAGE_SHIFT) >= bdata->node_low_pfn)

BUG();

if (end > bdata->node_low_pfn)

BUG();

for (i = sidx; i < eidx; i++)

if (test_and_set_bit(i, bdata->node_bootmem_map))

printk("hm, page %08lx reserved twice.\n", i*PAGE_SIZE);

}

对此函数的解释如下。

sidx (start index)初始化为相对于node_boot_start的页面号。- 变量

eidx初始化为页面总数(向上取整)。 - 变量

end初始化为最后一个页面的页面号(向上取整)。 - 进行各种可能的条件检查。

- 把位图中从

sidx到eidx的所有位置 1。

__alloc_bootmem()函数

这个函数以循环轮转的方式从不同节点分配页面。因为在i386 上只有一个节点,因此只循环一次。函数原型为:1

2

3

4

5

6

7void * __alloc_bootmem (unsigned long size,

unsigned long align,

unsigned long goal);

void * __alloc_bootmem_core (bootmem_data_t *bdata,

unsigned long size,

unsigned long align,

unsigned long goal);

其中__alloc_bootmem()为封装函数,实际调用的函数为__alloc_bootmem_core(),因为__alloc_bootmem_core()函数比较长,下面分片断来进行仔细分析。1

2

3

4

5unsigned long i, start = 0;

void *ret;

unsigned long offset, remaining_size;

unsigned long areasize, preferred, incr;

unsigned long eidx = bdata->node_low_pfn - (bdata->node_boot_start >> PAGE_SHIFT);

把eidx初始化为本节点中现有页面的总数。1

2

3if (!size) BUG();

if (align & (align-1))

BUG();

进行条件检查。1

2

3

4

5

6

7

8

9/*

* We try to allocate bootmem pages above 'goal'

* first, then we try to allocate lower pages.

*/

if (goal && (goal >= bdata->node_boot_start) && ((goal >> PAGE_SHIFT) < bdata->node_low_pfn)) {

preferred = goal - bdata->node_boot_start;

} else

preferred = 0;

preferred = ((preferred + align - 1) & ~(align - 1)) >> PAGE_SHIFT;

开始分配后首选页的计算分为两步:

- 如果

goal为非 0 且有效,则给preferred赋初值,否则,其初值为 0。 - 根据参数

align来对齐preferred的物理地址。1

areasize = (size+PAGE_SIZE-1)/PAGE_SIZE;

获得所需页面的总数(向上取整)1

incr = align >> PAGE_SHIFT ? : 1;

根据对齐的大小来选择增加值。除非大于 4KB(很少见),否则增加值为 1。1

2

3

4

5restart_scan:

for (i = preferred; i < eidx; i += incr) {

unsigned long j;

if (test_bit(i, bdata->node_bootmem_map))

continue;

这个循环用来从首选页面号开始,找到空闲的页面号。test_bit()宏用来测试给定的位,如果给定位为 1,则返回 1。1

2

3

4

5

6for (j = i + 1; j < i + areasize; ++j) {

if (j >= eidx)

goto fail_block;

if (test_bit (j, bdata->node_bootmem_map))

goto fail_block;

}

这个循环用来查看在首次满足内存需求以后,是否还有足够的空闲页面。如果没有空闲页,就跳到fail_block。1

2start = i;

goto found;

如果一直到了这里,则说明从i开始找到了足够的页面,跳过fail_block并继续。1

2

3

4

5

6

7fail_block:;

}

if (preferred) {

preferred = 0;

goto restart_scan;

}

return NULL;

如果到了这里,从首选页面中没有找到满足需要的连续页面,就忽略preferred的值,并从 0 开始扫描。如果preferred为 1,但没有找到满足需要的足够页面,则返回NULL。1

found:

已经找到足够的内存,继续处理请求。1

2if (start >= eidx)

BUG();

进行条件检查。1

2

3

4

5

6

7

8

9

10/*

* Is the next page of the previous allocation-end the start

* of this allocation's buffer? If yes then we can 'merge'

* the previous partial page with this allocation.

*/

if (align <= PAGE_SIZE && bdata->last_offset && bdata->last_pos+1 == start) {

offset = (bdata->last_offset+align-1) & ~(align-1);

if (offset > PAGE_SIZE)

BUG();

remaining_size = PAGE_SIZE-offset;

if语句检查下列条件:

- 所请求对齐的值小于页的大小(4KB)。

- 变量

last_offset为非 0。如果为 0,则说明前一次分配达到了一个非常好的页面边界,没有内部碎片。 - 检查这次请求的内存是否与前一次请求的内存是相临的,如果是,则把两次分配合在一起进行。

如果以上 3 个条件都满足,则用前一次分配中最后一页剩余的空间初始化remaining_size。1

2

3

4

5if (size < remaining_size) {

areasize = 0;

// last_pos unchanged

bdata->last_offset = offset+size;

ret = phys_to_virt(bdata->last_pos*PAGE_SIZE + offset + bdata->node_boot_start);

如果请求内存的大小小于前一次分配中最后一页中的可用空间,则没必要分配任何新的页。变量last_offset增加到新的偏移量,而last_pos保持不变,因为没有增加新的页。把这次新分配的起始地址存放在变量ret中。宏phys_to_virt()返回给定物理地址的虚地址。1

2

3

4

5

6} else {

remaining_size = size - remaining_size;

areasize = (remaining_size+PAGE_SIZE-1)/PAGE_SIZE;

ret = phys_to_virt(bdata->last_pos*PAGE_SIZE + offset + bdata->node_boot_start);

bdata->last_pos = start+areasize-1;

bdata->last_offset = remaining_size;

所请求的大小大于剩余的大小。首先求出所需的页面数,然后更新变量last_pos和last_offset。例如,在前一次分配中,如果分配了 9KB,则占用 3 个页面,内部碎片为 12KB-9KB=3KB。因此,page_offset为 1KB,且剩余大小为 3KB。如果新的请求为 1KB,则第 3 个页面本身就能满足要求,但是,如果请求的大小为 10KB,则需要新分配((10KB- 3KB) + PAGE_SIZE-1)/PAGE_SIZE,即 2 个页面,因此,page_offset为 3KB。1

2

3

4

5

6

7 }

bdata->last_offset &= ~PAGE_MASK;

} else {

bdata->last_pos = start + areasize - 1;

bdata->last_offset = size & ~PAGE_MASK;

ret = phys_to_virt(start * PAGE_SIZE + bdata->node_boot_start);

}

如果因为某些条件未满足而导致不能进行合并,则执行这段代码,我们刚刚把last_pos和last_offset直接设置为新的值,而未考虑它们原先的值。last_pos的值还要加上所请求的页面数,而新page_offset值的计算就是屏蔽掉除了获得页偏移量位的所有位,即size &PAGE_MASK,PAGE_MASK为 0x00000FFF,用PAGE_MASK的求反正好得到页的偏移量。1

2

3

4

5

6

7

8

9/*

* Reserve the area now:

*/

for (i = start; i < start+areasize; i++)

if (test_and_set_bit(i, bdata->node_bootmem_map))

BUG();

memset(ret, 0, size);

return ret;

现在,我们有了内存,就需要保留它。宏test_and_set_bit()用来测试并置位,如果某位原先的值为 0,则它返回 0;如果为 1,则返回 1。还有一个条件判断语句,进行条件判断(这种条件出现的可能性非常小,除非RAM坏)。然后,把这块内存初始化为 0,并返回给调用它的函数。

26

free_all_bootmem()函数

这个函数用来在引导时释放页面,并清除bootmem分配器。函数原型为:1

2void free_all_bootmem (void);

void free_all_bootmem_core(pg_data_t *pgdat);

同前面的函数调用形式类似,free_all_bootmem()为封装函数,实际调用free_all_bootmem_core()函数。下面,我们对free_all_bootmem_core()函数分片断来介绍。1

2

3

4

5

6

7

8struct page *page = pgdat->node_mem_map;

bootmem_data_t *bdata = pgdat->bdata;

unsigned long i, count, total = 0;

unsigned long idx;

if (!bdata->node_bootmem_map) BUG();

count = 0;

idx = bdata->node_low_pfn - (bdata->node_boot_start >> PAGE_SHIFT);

把idx初始化为从内核映像结束处到内存顶点处的页面数。1

2

3

4

5

6

7

8for (i = 0; i < idx; i++, page++) {

if (!test_bit(i, bdata->node_bootmem_map)) {

count++;

ClearPageReserved(page);

set_page_count(page, 1);

__free_page(page);

}

}

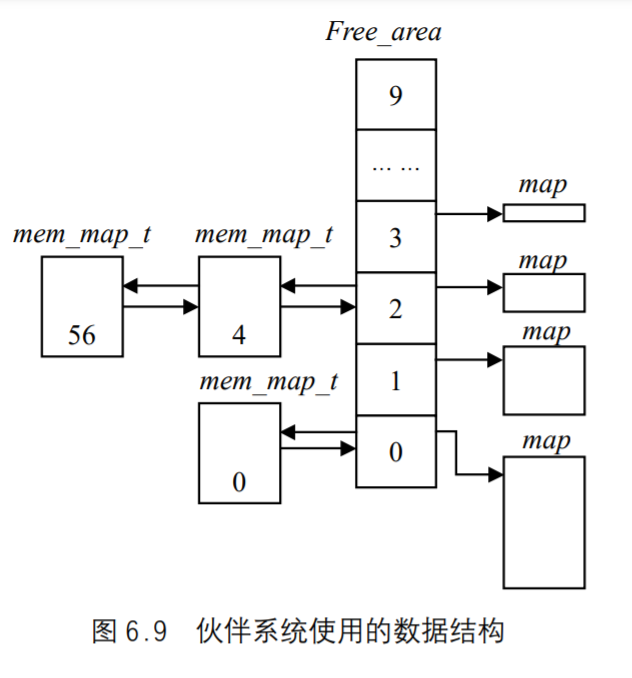

搜索bootmem位图,找到空闲页,并把mem_map中对应的项标记为空闲。set_page_count()函数把page结构的count域置 1,而__free_page()真正的释放页面,并修改伙伴(buddy)系统的位图。1

2

3

4

5

6

7

8

9

10

11

12

13

14total += count;

/*

* Now free the allocator bitmap itself, it's not

* needed anymore:

*/

page = virt_to_page(bdata->node_bootmem_map);

count = 0;

for (i = 0; i < ((bdata->node_low_pfn-(bdata->node_boot_start >> PAGE_SHIFT))/8 + PAGE_SIZE-1)/PAGE_SIZE; i++,page++) {

count++;

ClearPageReserved(page);

set_page_count(page, 1);

__free_page(page);

}

获得bootmem位图的地址,并释放它所在的页面。1

2

3total += count;

bdata->node_bootmem_map = NULL;

return total;

把该存储节点的bootmem_map域置为NULL,并返回空闲页面的总数。

页表的建立

前面已经建立了为内存页面管理所需的数据结构,现在是进一步完善页面映射机制,并且建立起内存页面映射管理机制的时候了,与此相关的主要函数有:1

2paging_init() 函数

pagetable_init() 函数

paging_init() 函数

这个函数仅被调用一次,即由setup_arch()调用以建立页表,对此函数的具体描述如下:1

pagetable_init();

这个函数实际上才真正地建立页表,后面会给出详细描述。1

__asm__( "movl %%ecx,%%cr3\n" ::"c"(__pa(swapper_pg_dir)));

因为pagetable_init()已经建立起页表,因此把swapper_pg_dir(页目录)的地址装入CR3寄存器。1

2

3

4

5

6

7

8

9

/*

* We will bail out later - printk doesnt work right now so

* the user would just see a hanging kernel.

*/

if (cpu_has_pae)

set_in_cr4(X86_CR4_PAE);

__flush_tlb_all();

上面这一句是个宏,它使得转换旁路缓冲区(TLB)无效。TLB总是要维持几个最新的虚地址到物理地址的转换。每当页目录改变时,TLB就需要被刷新。1

2

3

kmap_init();

如果使用了CONFIG_HIGHMEM选项,就要对大于 896MB的内存进行初始化。1

2

3

4{

unsigned long zones_size[MAX_NR_ZONES] = {0, 0, 0};

unsigned int max_dma, high, low;

max_dma = virt_to_phys((char *)MAX_DMA_ADDRESS) >> PAGE_SHIFT;

低于 16MB的内存只能用于DMA,因此,上面这条语句用于存放 16MB的页面。1

2

3

4

5

6

7

8

9

10

11

12low = max_low_pfn;

high = highend_pfn;

if (low < max_dma)

zones_size[ZONE_DMA] = low;

else {

zones_size[ZONE_DMA] = max_dma;

zones_size[ZONE_NORMAL] = low - max_dma;

zones_size[ZONE_HIGHMEM] = high - low;

}

计算 3 个管理区的大小,并存放在zones_size数组中。3 个管理区如下所述。

ZONE_DMA:从 0~16MB 分配给这个区。ZONE_NORMAL:从 16MB~896MB 分配给这个区。ZONE_DMA:896MB以上分配给这个区。

1 | free_area_init(zones_size); |

这个函数用来初始化内存管理区并创建内存映射表,详细介绍参见后面内容。

pagetable_init()函数

这个函数真正地在页目录swapper_pg_dir中建立页表,描述如下:1

2

3

4

5

6

7

8

9

10unsigned long vaddr, end;