一些你可能正感到迷惑的问题

软件是如何访问硬件的

硬件在输入输出上大体分为串行和并行,相应的接口也就是串行接口和并行接口。CPU通过串行接口与串行设备数据传输。并行设备的访问类似,只不过

是通过并行接口进行的。访问外部硬件有两个方式:

- 将某个外设的内存映射到一定范围的地址空间中,CPU通过地址总线访问该内存区域时会落到外设的内存中,这种映射让CPU 访问外设的内存就如同访问主板上的物理内存一样。

- 外设是通过IO接口与CPU通信的,CPU访问外设,就是访问IO接口,由IO接口将信息传递给另一端的外设。

应用程序操作系统是如何配合到一起的

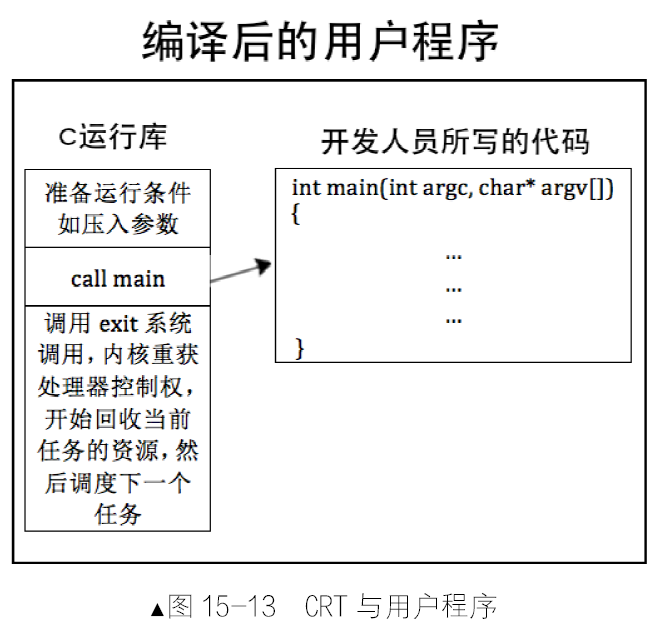

编译器提供了一套库函数,库函数中又有封装的系统调用,这样的代码集合称之为运行库。C 语言的运行库称为C 运行库,就是所谓的CRT(C Runtime Library)。

用户态与内核态是对CPU 来讲的,是指CPU 运行在用户态(特权3 级)还是内核态(特权0 级)。用户进程陷入内核态是指:由于内部或外部中断发生,当前进程被暂时终止执行,其上下文被内核的中断程序保存起来后,开始执行一段内核的代码,所以“用户态与内核态”是对CPU 来说的。

为什么称为“陷入”内核

应用程序处于特权级3,操作系统内核处于特权级0。当用户程序欲访问系统资源时(无论是硬件,还是内核数据结构),它需要进行系统调用。这样CPU 便进入了内核态,也称管态。

内存访问为什么要分段

内存是随机读写设备,即访问其内部任何一处,不需要从头开始找,只要直接给出其地址便可。CPU 采用“段基址+段内偏移地址”的方式来访问任意内存。这

样的好处是程序可以重定位了,尽管程序指令中给的是绝对物理地址,但终究可以同时运行多个程序了。重定位就是将程序中指令的地址改写成另外一个地址,但该地址处的内容还是原地址处的内容。

只要程序分了段,把整个段平移到任何位置后,段内的地址相对于段基址是不变的,无论段基址是多少,只要给出段内偏移地址,CPU 就能访问到正确的指令。于是加载用户程序时,只要将整个段的内容复制到新的位置,再将段基址寄存器中的地址改成该地址,程序便可准确无误地运行,因为程序中用的是段内偏移地址,相对于新的段基址,该偏移地址处的内存内容还是一样的。

代码中为什么分为代码段、数据段?

分段只是为了使程序更加优美。如果是在平坦模型下编程,操作系统将整个4GB 内存都放在同一个段中,我们就不需要来回切换段寄存器所指向的段。对于代码中是否要分段,这取决于操作系统是否在平坦模型下。

指令间不存在空隙,下一条指令的地址是按照前面指令的尺寸大小排下来的,这就是Intel 处理器的程序计数器cs:eip能够自动获得下一条指令的原理,即将当前eip 中的地址加上当前指令机器码的大小便是内存中下一条指令的起始地址。为了让程序内指令接连不断地执行,要把指令全部排在一起,形成一片连续的指令区域,这就是代码段。把数据连续地并排在一起存储形成的段落,就称为数据段。

只要指令逻辑上是连续的就可以,没必要一定得是物理上连续。所以,明确一点,即使数据和代码在物理上混在一起,程序也是可以运行的,这并不意味

着指令被数据“断开”了。只要程序中有指令能够跨过这些数据就行啦,最典型的就是用jmp 跳过数据区。

在保护模式下,有这样一个数据结构,它叫全局描述符表(Global Descriptor Table,GDT),这个表中的每一项称为段描述符。编译器负责挑选出数据具备的属性,从而根据属性将程序片段分类,比如,划分出了只读属性的代码段和可写属性的数据段。操作系统通过设置GDT 全局描述符表来构建段描述符,在段描述符中指定段的位置、大小及属性(包括S 字段和TYPE 字段)。CPU 中的段寄存器提前被操作系统赋予相应的选择子。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32section my_code vstart=0

;通过远跳转的方式给代码段寄存器CS 赋值0x90

jmp 0x90:start

start: ;标号start 只是为了jmp 跳到下一条指令

;初始化数据段寄存器DS

mov ax,section.my_data.start

add ax,0x900 ;加0x900 是因为本程序会被mbr 加载到内存0x900 处

shr ax,4 ;提前右移4 位,因为段基址会被CPU 段部件左移4 位

mov ds,ax

;初始化栈段寄存器SS

mov ax,section.my_stack.start

add ax,0x900 ;加0x900 是因为本程序会被mbr 加载到内存0x900 处

shr ax,4 ;提前右移4 位,因为段基址会被CPU 段部件左移4 位

mov ss,ax

mov sp,stack_top ;初始化栈指针

;此时CS、DS、SS 段寄存器已经初始化完成,下面开始正式工作

push word [var2] ;变量名var2 编译后变成0x4

jmp $

;自定义的数据段

section my_data align=16 vstart=0

var1 dd 0x1

var2 dd 0x6

;自定义的栈段

section my_stack align=16 vstart=0

times 128 db 0

stack_top: ;此处用于栈顶,标号作用域是当前section,

;以当前section 的vstart 为基数

代码是实模式下运行的程序,其中自定义了三个段,代码段取名为my_code,数据段取名为my_data,栈段取名为my_stack。用“jmp 0x90:0”初始化了程序计数器CS 和IP。这样段寄存器CS 就是程序中咱们自己划分的代码段了。各section 中的定义都有align=16 和vstart=0,这是用来指定各section 按16 位对齐的,第 6~10 行是初始化数据段寄存器DS,是用程序中自已划分的段my_data 的地址来初始化的。第 12~17 行是初始化栈段寄存器,原理和数据段差不多,唯一区别是栈段初始化多了个针指针SP,为它初始化的值stack_top 是最后一行,因为栈指针在使用过程中指向的地址越来越低,所以初始化时一

定得是栈段的最高地址。

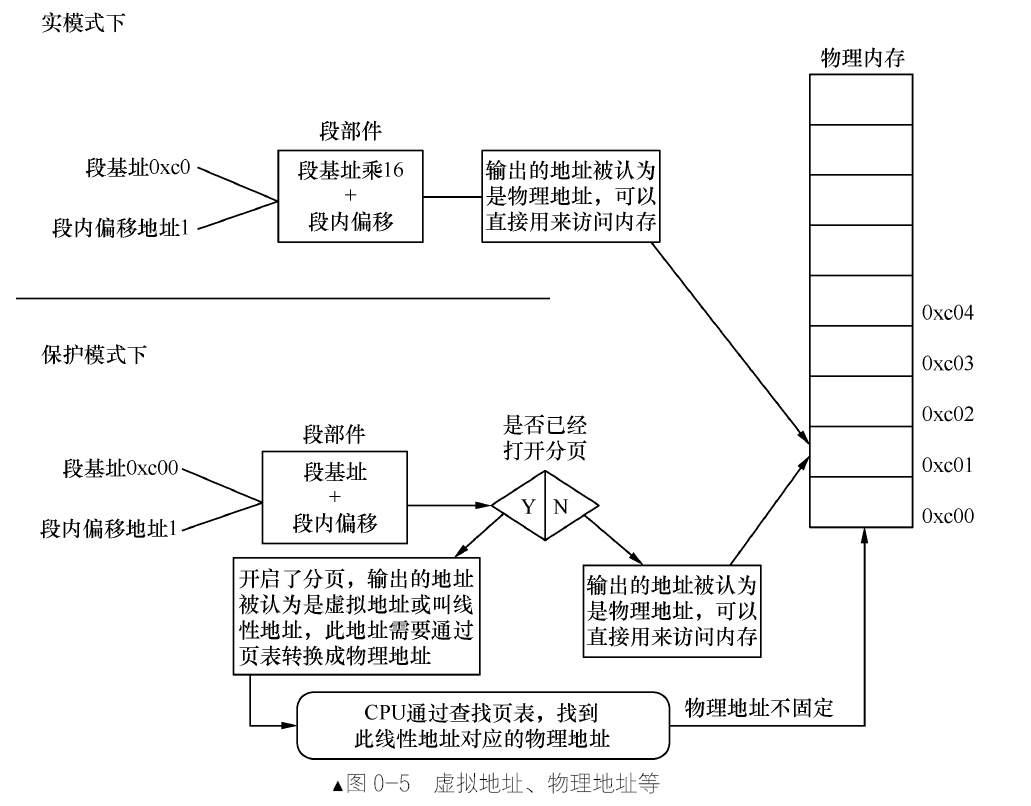

物理地址、逻辑地址、有效地址、线性地址、虚拟地址的区别

物理地址就是物理内存真正的地址,相当于内存中每个存储单元的门牌号,具有唯一性。在实模式下,“段基址+段内偏移地址”经过段部件的处理,直接输出的就是物理地址,CPU 可以直接用此地址访问内存。

而在保护模式下,“段基址+段内偏移地址”称为线性地址,不过,此时的段基址已经不再是真正的地址了,而是一个称为选择子的东西。它本质是个索引,类似于数组下标,通过这个索引便能在GDT 中找到相应的段描述符,在该描述符中记录了该段的起始、大小等信息,这样便得到了段基址。

若没有开启地址分页功能,此线性地址就被当作物理地址来用,可直接访问内存。若开启了分页功能,此线性地址又多了一个名字,就是虚拟地址(虚拟地址、线性地址在分页机制下都是一回事)。虚拟地址要经过CPU 页部件转换成具体的物理地址,这样CPU 才能将其送上地址总线去访问内存。

无论在实模式或是保护模式下,段内偏移地址又称为有效地址,也称为逻辑地址。线性地址或称为虚拟地址,这都不是真实的内存地址。它们都用来描述程序或任务的地址空间。

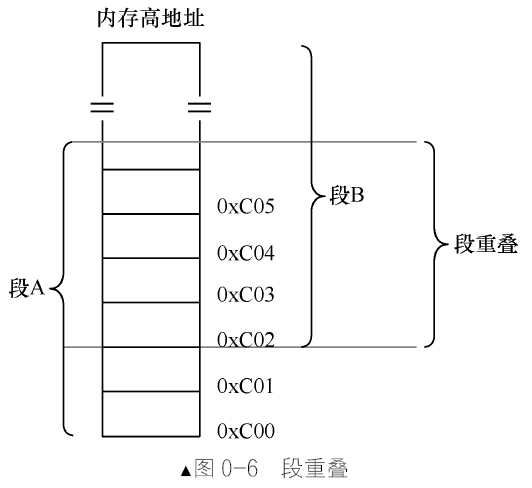

什么是段重叠

CPU 的内存寻址方式是:给我一个段基址,再给我一个相对于该段起始位置的偏移地址,我就能访问到相应内存。它并不要求一个内存地址只隶属于某一个段。用段A 去访问,其偏移为5,用段B 去访问,其偏移量为3。这样一来,用段B 和段A 在地址0xC02 之后,一直到段B偏移地址为0xfffe 的部分,像是重叠在一起了,这就是段重叠了。

什么是平坦模型

所以说平坦模型指的就是一个段。段的大小可以是地址总线能够到达的范围。

cs、ds 这类sreg 段寄存器,位宽是多少

CPU 内部的段寄存器(Segment reg)如下:

- CS—代码段寄存器(Code Segment Register),其值为代码段的段基值。

- DS—数据段寄存器(Data Segment Register),其值为数据段的段基值。

- ES—附加段寄存器(Extra Segment Register),其值为附加数据段的段基值,称为“附加”是因为此段寄存器用途不像其他sreg 那样固定,可以额外做他用。

- FS—附加段寄存器(Extra Segment Register),其值为附加数据段的段基值,同上,用途不固定,使用上灵活机动。

- GS—附加段寄存器(Extra Segment Register),其值为附加数据段的段基值。

- SS—堆栈段寄存器(Stack Segment Register),其值为堆栈段的段值。

在实模式下,CS、DS、ES、SS 中的值为段基址,是具体的物理地址,内存单元的逻辑地址仍为“段基值:段内偏移量”的形式。在保护模式下,装入段寄存器的不再是段地址,而是“段选择子”(Selector),当然,选择子也是数值,其依然为16 位宽度。

什么是工程,什么是协议

软件中的工程是指开发一套软件所需要的全部文件,包括配置环境。

协议是一种大家共同遵守的规约,主要用来实现通信、共享、协作,给大家统一一种接口、一组数据调用或者分析的约定。

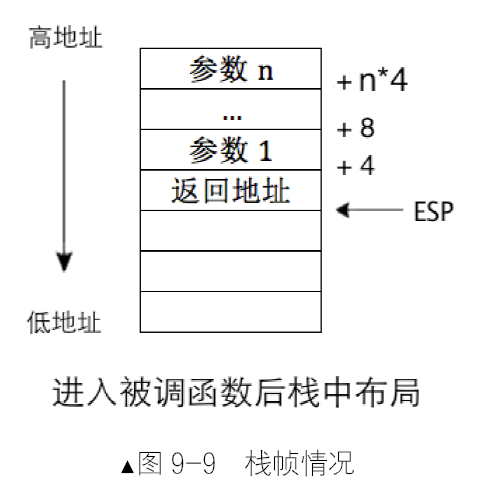

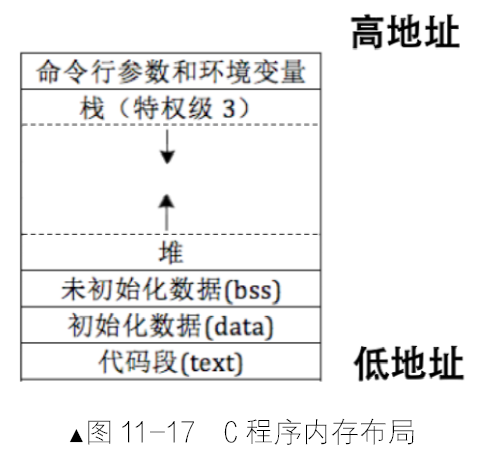

局部变量和函数参数为什么要放在栈中

局部变量只是自己在用,放在数据段中纯属浪费空间,没有必要,故将其放在自己的栈中,随时可以清理,真正体现了局部的意义。

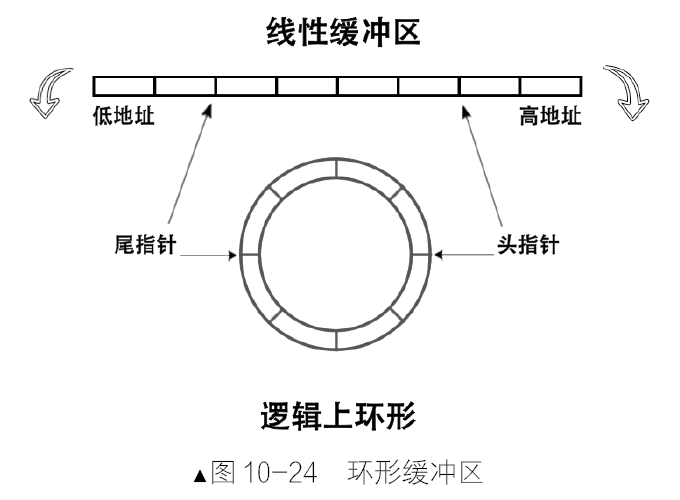

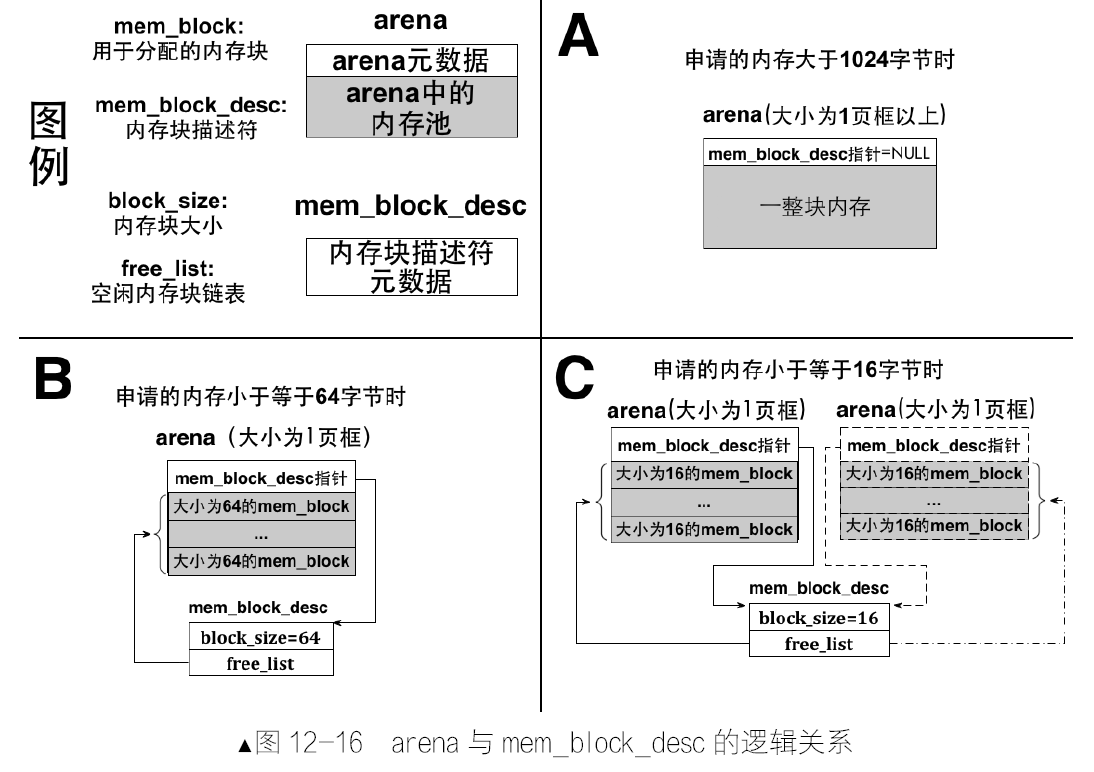

堆是程序运行过程中用于动态内存分配的内存空间,是操作系统为每个用户进程规划的,属于软件范畴。栈是处理器运行必备的内存空间,是硬件必需的,但又是由软件(操作系统)提供的。

栈从高地址往低地址发展,堆是从低地址往高地址发展,堆和栈早晚会碰头,它们各自的大小取决于实际的使用情况,界限并不明朗。

编译型程序与解释型程序的区别

解释型语言,也称为脚本语言,本身是文本文件,是某个应用程序的输入,这个应用程序是脚本解释器。由于只是文本,这些脚本中的代码在脚本解释器看来和字符串无异。也就是说,脚本中的代码从来没真正上过CPU 去执行,CPU 的cs:ip 寄存器从来没指向过它们,在CPU 眼里只看得到脚本解释器

本质上是脚本解释器在时时分析这个脚本,动态根据关键字和语法来做出相应的行为。因此脚本中若出现错误,先前正确的部分也会被正常执行,这和编译型程序有很大区别。

编译型语言编译出来的程序,运行时本身就是一个进程。它是由操作系统直接调用的。也就是由操作系统加载到内存后,操作系统将CS:IP 寄存器指向这个程序的入口,使它直接上CPU 运行。

什么是大端字节序、小端字节序

- 小端:因为低位在低字节,强制转换数据型时不需要再调整字节了。

- 大端:有符号数,其字节最高位不仅表示数值本身,还起到了符号的作用。符号位固定为第一字节,也就是最高位占据最低地址,符号直接可以取出来,容易判断正负。

简要说明一下小端的优势。因为在做强制数据类型转换时,如果转换是由低精度转向高精度,这数值本身没什么变化,如short 是2 字节,将其转换为4 字节的int 类型,无非是由0x1234 变成了0x00001234,数值上是不变的,只是存储形式上变了。如果转换是高精度转向低精度,也就是多个字节的数值要减少一

些存储字节,这必然是要丢弃一部分数值。编译器的转换原则是强制转换到低精度类型,丢弃数值的高字节位,只保留数值的低字节。

对于大端的优势,就硬件而言,就是符号位的判断变得方便了。最高位在最低地址,也就是直接就可以取到了,不用再跨越几个字节,减少了时钟周期。

BIOS 中断、DOS 中断、Linux 中断的区别

BIOS 和DOS 都是存在于实模式下的程序,由它们建立的中断调用都是建立在中断向量表(Interrupt Vector Table,IVT)中的。它们都是通过软中断指令int 中断号来调用的。

中断向量表中的每个中断向量大小是4 字节。这4 字节描述了一个中断处理例程(程序)的段基址和段内偏移地址。BIOS 中断调用的主要功能是提供了硬件访问的方法,该方法使对硬件的操作变得简单易行。BIOS 中断程序处理是用来操作硬件的,故该处理程序中一定到处都是in/out 指令。

DOS 是运行在实模式下的,故其建立的中断调用也建立在中断向量表中,只不过其中断向量号和BIOS的不能冲突。

而 Linux 内核是在进入保护模式后才建立中断例程的,不过在保护模式下,中断向量表已经不存在了,取而代之的是中断描述符表(Interrupt Descriptor Table,IDT)。所以在Linux 下执行的中断调用,访问的中断例程是在中断描述符表中,已不在中断向量表里了。Linux 的系统调用和DOS 中断调用类似,不过Linux 是通过int 0x80 指令进入一个中断程序后再根据eax 寄存器的值来调用不同的子功能函数的。

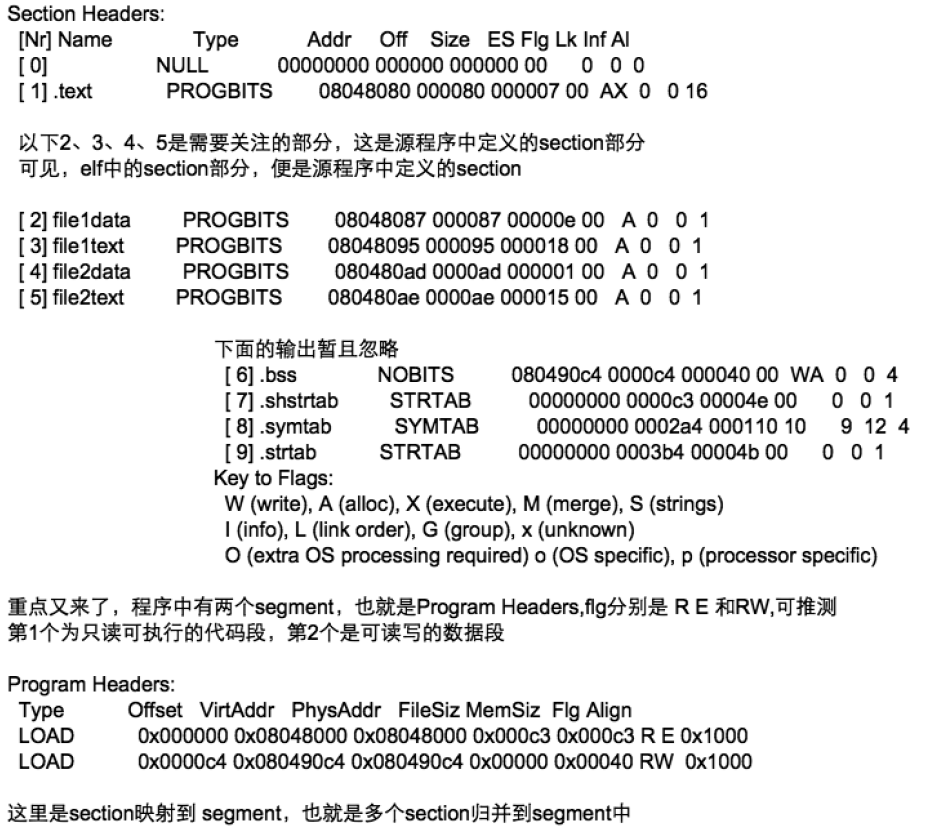

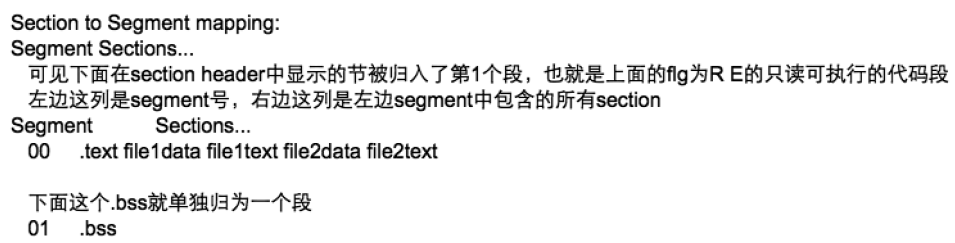

Section 和Segment 的区别

在汇编源码中,通常用语法关键字 section 或segment 来表示一段区域,它们是编译器提供的伪指令,作用是相同的,都是在程序中“逻辑地”规划一段区域,此区域便是节。操作系统在加载程序时,不需要对逐个节进行加载,只要给出相同权限的节的集合就行了,这样操作系统就能为它们分配不同的段选择子,从而指向不同段描述符,实现不同的访问权限了。

section 称为节,是指在汇编源码中经由关键字section 或segment 修饰、逻辑划分的指令或数据区域,汇编器会将这两个关键字修饰的区域在目标文件中编译成节,也就是说“节”最初诞生于目标文件中。

segment 称为段,是链接器根据目标文件中属性相同的多个section 合并后的section 集合,这个集合称为segment,也就是段,链接器把目标文件链接成可执行文件,因此段最终诞生于可执行文件中。我们平时所说的可执行程序内存空间中的代码段和数据段就是指的segment。

Program Headers 部分,此处一共有两个段,第一个段是我们的代码段,通过其Flg 值为RE 便可推断,只读(Readonly)可执行(Execute)。第二个段便是我们的数据段,但此数据段中只包含.bss 节(section),它用于存储全局未初始化数据故其Flg 必然可读写,其属性为RW。

操作系统是如何识别文件系统的

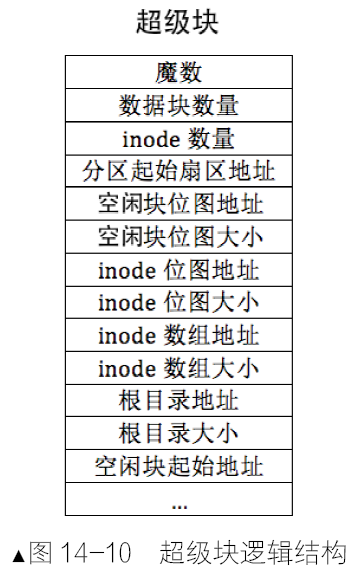

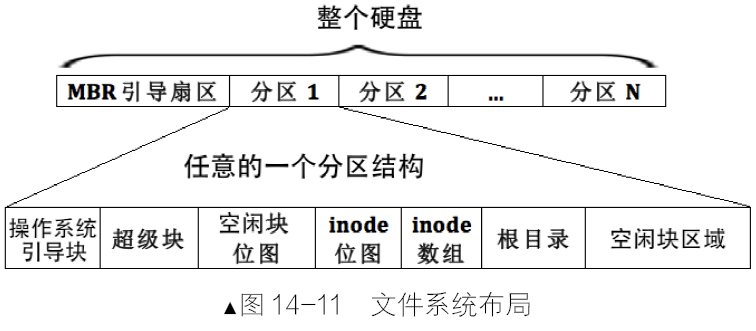

各分区都有超级块,一般位于本分区的第2 个扇区,比如若各分区的扇区以0 开始索引,其第1 个扇区便是超级块的起始扇区。超级块里面记录了此分区的信息,其中就有文件系统的魔数,一种文件系统对应一个魔数。

如何控制 CPU 的下一条指令

我们常说的用于存放下一条指令地址的寄存器称为程序计数器PC。在 x86 体系结构的CPU 中程序计数器PC 并不是单一的某种寄存器,它是一种寄存器组合,指的段寄存器CS 和指令寄存器IP。CS 和IP 是CPU 待执行的下一条指令的段基址和段内偏移地址,不能直接用mov 指令去改变它们。有专门改变执行流的指令,如jmp、call、int、ret,这些指令可以同时修改cs 和ip,它们在硬件级别上实现了原子操作。

库函数是用户进程与内核的桥梁

例如对printf的声明:1

extern int printf (__const char *__restrict __format,...);

头文件被包含进来后,其内容也是原样被展开到include 所在的位置,就是把整个头文件中的内容挪了过来。头文件中一般仅仅有函数声明,这个声明告诉编译器至少两件事。

- 函数返回值类型、参数类型及个数,用来确定分配的栈空间。

- 该函数是外部函数,定义在其他文件,现在无法为其分配地址,需要在链接阶段将该函数体所在的目标文件一同链接时再安排地址。

如果预处理后,主调函数所在的文件中找不到所调用函数的函数体,一定要在链接阶段把该函数体所在的目标文件链接进来。编译器提供的C 运行库中已经为我们准备好了这些标准函数的函数体所在的目标文件,在链接时默默帮我们链接上了。这些目标文件都是待重定位文件,重定位文件意思是文件中的函数是没有地址的,用file 命令查看它们时会显示relocatable,它们中的地址是在与用户程序的目标文件链接成一个可执行文件时由链接器统一分配的。

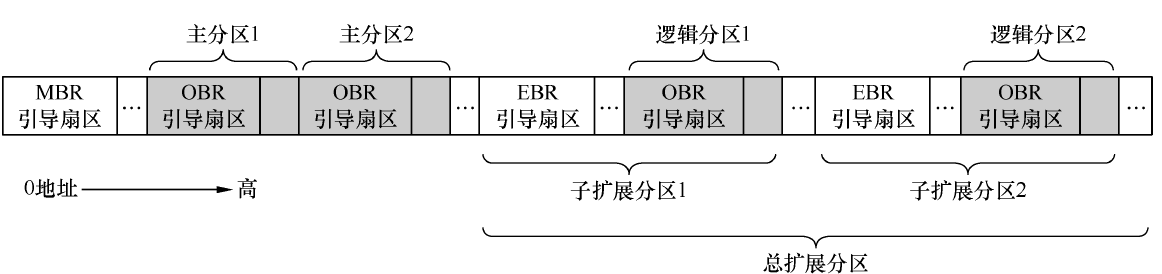

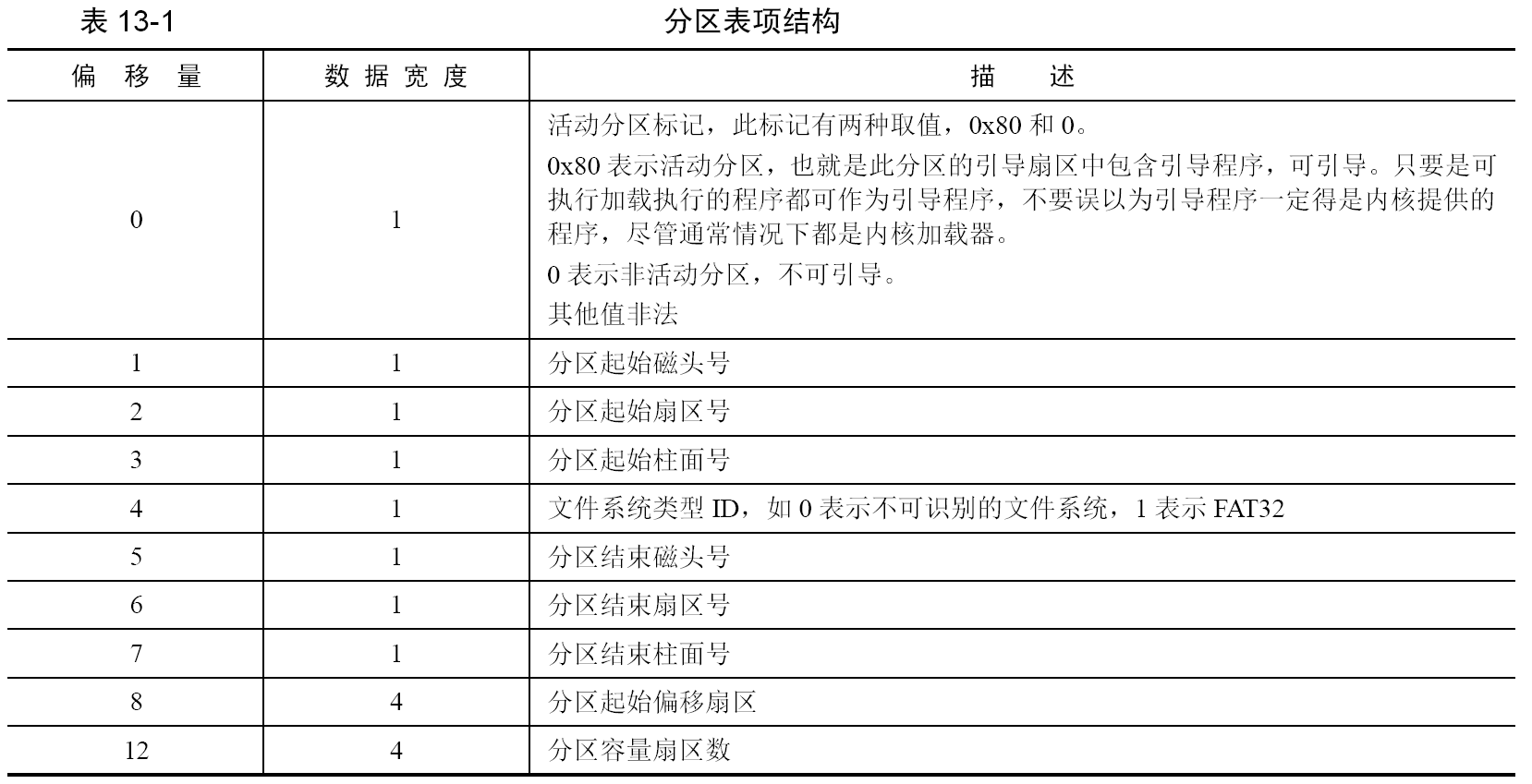

MBR、EBR、DBR 和OBR 各是什么

MBR 是主引导记录,Master 或Main Boot Record,它存在于整个硬盘最开始的那个扇区,即0盘0道1扇区,这个扇区便称为MBR 引导扇区。在 MBR 引导扇区中存储引导程序,为的是从BIOS 手中接过系统的控制权,。BIOS 知道MBR 在0 盘0 道1 扇区,这是约定好的,因此它会将0 盘0 道1 扇区中的MBR 引

导程序加载到物理地址0x7c00,然后跳过去执行,这样BIOS 就把处理器使用权移交给MBR 了。在 MBR 引导扇区中的内容是:

- 446 字节的引导程序及参数;

- 64 字节的分区表;

- 2 字节结束标记0x55 和0xaa。

MBR 的作用相当于下一棒的引导程序总入口,BIOS 把控制权交给MBR 就行了,由MBR 从众多可能的接力选手中挑出合适的人选并交出系统控制权,这个过程就是由“主引导程序”去找“次引导程序”。MBR 引导程序的任务就是把控制权交给操作系统加载器,由该加载器完成操作系统的自举,最终使控制权交付给操作系统内核。

为了让 MBR 知道哪里有操作系统,我们在分区时,如果想在某个分区中安装操作系统,就用分区工具将该分区设置为活动分区,设置活动分区的本质就是把分区表中该分区对应的分区表项中的活动标记为0x80。

“控制权交接”是处理器从“上一棒选手”跳到“下一棒选手”来完成的,内核加载器的入口地址是这里所说的“下一棒选手”,为了MBR 方便找到活动分区上的内核加载器,内核加载器的入口地址也必须在固定的位置,这个位置就是各分区最开始的扇区,这也是约定好的。这个“各分区起始的扇区”中存放的是操作系统

引导程序—内核加载器,因此该扇区称为操作系统引导扇区,其中的引导程序(内核加载器)称为操作系统引导记录OBR,即OS Boot Record,此扇区也称为OBR 引导扇区。在OBR 扇区的前3 个字节存放了跳转指令,这同样是约定,因此MBR 找到活动分区后,就大胆主动跳到活动分区OBR 引导扇区的起始处,该起始处的跳转指令马上将处理器带入操作系统引导程序,从此MBR 完成了交接工作,以后便是内核的天下了。

DBR 是DOS Boot Record,也就是DOS 操作系统的引导记录(程序)。在 DOS 时代只有4 个分区,不存在扩展分区,这4 个分区都相当于主分区,所以各主分区最开始的扇区称为DBR 引导扇区。

这里提到了扩展分区就不得不提到EBR。当初为了解决分区数量限制的问题才有了扩展分区,EBR是扩展分区中为了兼容MBR 才提出的概念,主要是兼容MBR 中的分区表。为扩展分区存储分区表的扇区称为EBR,即Expand Boot Record,

MBR 和EBR 是分区工具创建维护的,不属于操作系统管理的范围,因此操作系统不可以往里面写东西。OBR 是各分区(主分区或逻辑分区)最

开始的扇区,因此属于操作系统管理。DBR、OBR、MBR、EBR 都包含引导程序,因此它们都称为引导扇区,只要该扇区中存在可执行的程序,该扇区就是可引导扇区。若该扇区位于整个硬盘最开始的扇区,并且以0x55 和0xaa 结束,BIOS就认为该扇区中存在MBR,该扇区就是MBR 引导扇区。

部署工作环境

我们需要哪些编译器

NASM 是一个为可移植性与模块化而设计的一个80x86的汇编器。它支持相当多的目标文件格式,包括’Linux’和’NetBSD/FreeBSD’,’a.out’,’ELF’,’COFF’,微软16位的’OBJ’和’Win32’。它还可以输出纯二进制文件。它的语法设计得相当的简洁易懂,和Intel语法相似但更简单。它支持’Pentium’,’P6’,’MMX’,’3DNow!’,’SSE’和’SSE2’指令集。

编写MBR 主引导记录,让我们开始掌权

计算机的启动过程

CPU 的硬件电路被设计成只能运行处于内存中的程序。因此,OS需要被载入内存中,大概上分两部分。

- 程序被加载器(软件或硬件)加载到内存某个区域。

- CPU 的cs:ip 寄存器被指向这个程序的起始地址。

操作系统在加载程序时,是需要某个加载器来将用户程序存储到内存中的。其实“加载器”本质上它就是一堆函数组成的模块。

软件接力第一棒,BIOS

BIOS全称叫Base Input & Output System,即基本输入输出系统。

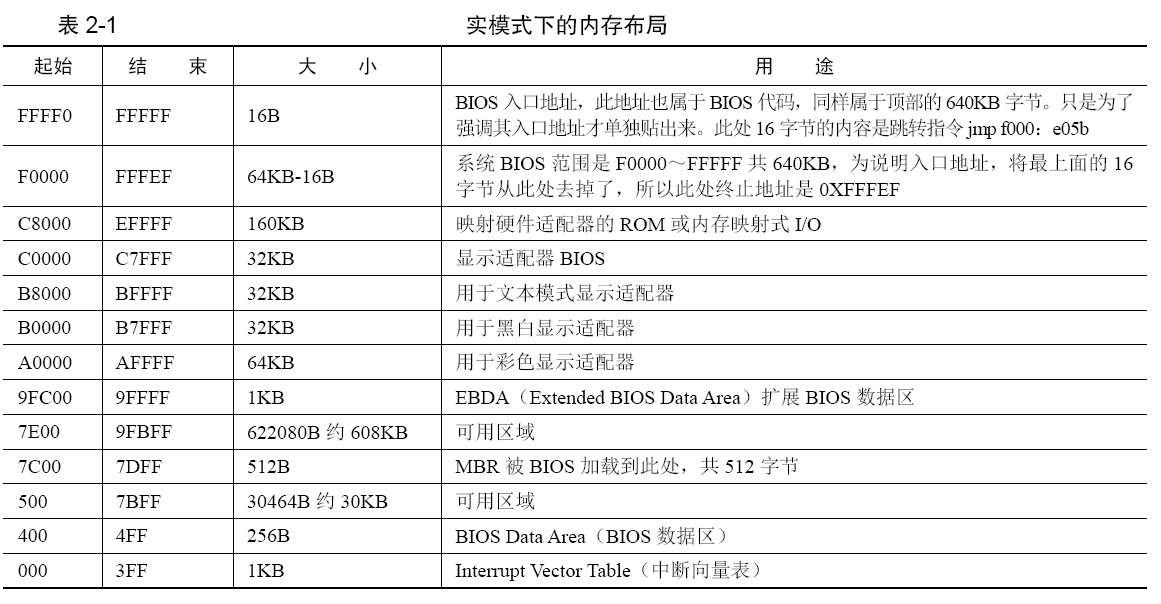

实模式下的1MB内存布局

Intel 8086有20条地址线,故其可以访问1MB的内存空间,即2的20次方=1048576=1MB,地址范围是0x00000到0xFFFFF。下表是实模式下1MB内存布局。

地址0~0x9FFFF处是DRAM(Dynamic Random Access Memory),即动态随机访问内存,我们所装的物理内存就是DRAM,如DDR、DDR2 等。动态指此种存储介质需要定期地刷新,它的空间范围是640KB,这片地址对应到了DRAM,也就是插在主板上的内存条。

地址总线宽度决定了可以访问的内存空间大小,如16位机的地址总线为20位,其地址范围是1MB,但是并不是只有内存条需要通过地址总线访问,需要在地址总线上提前预留出来一些地址空间给其他外设用,留够了以后,地址总线上其余的可用地址再指向DRAM,也就是指插在主板上的内存条,所以地址总线的长度与DRAM的大小不同。

顶部的0xF0000~0xFFFFF,这64KB的内存是ROM,这里面存的就是BIOS的代码。BIOS还建立了中断向量表,这样就可以通过int 中断号来实现相关的硬件调用,当然BIOS建立的这些功能就是对硬件的IO操作,也就是输入输出,加上一些重要的、保证计算机能运行的那些硬件的基本IO操作,就行了。这就是BIOS称为基本输入输出系统的原因。

BIOS被写进ROM。ROM也是块内存,内存就需要被访问。此ROM被映射在低端1MB内存的顶部,即地址0xF0000~0xFFFFF处。只要访问此处的地址便是访问了BIOS,这个映射是由硬件完成的。BIOS本身是个程序,程序要执行,就要有个入口地址才行,此入口地址便是0xFFFF0。

CPU访问内存是用段地址+偏移地址来实现的,由于在实模式之下,段地址需要乘以16后才能与偏移地址相加,求出的和便是物理地址,CPU便拿此地址直接用了。在接电的一瞬间,CPU的cs:ip寄存器被强制初始化为0xF000:0xFFF0。由于开机的时候处于实模式,在实模式下的段基址要乘以16,也就是左移4位,于是0xF000:0xFFF0的等效地址将是0xFFFF0,此地址便是BIOS的入口地址。物理地址0xFFFF0处应该是指令,否则会出错,里面有条指令jmp far f000:e05b,这是条跳转指令,也就是证明了在内存物理地址0xFFFF0处的内容是一条跳转指令。

BIOS最后一项工作校验启动盘中位于0盘0道1扇区的内容。0盘0道1扇区本质上就相当于0盘0道0扇区。CHS方法(即柱面Cylinder磁头Header扇区Sector,另外一种是LBA 方式,暂不关心),0盘说的是0磁头,因为一张盘是有上下两个盘面的,一个盘面上对应一个磁头,所以用磁头Header来表示盘面。0道是指0柱面,柱面Cylinder指的是所有盘面上、编号相同的磁道的集合。在CHS方式中扇区的编号是从1开始的,它就是磁盘上最开始的那个扇区。如果此扇区末尾的两个字节分别是魔数0x55和0xaa,BIOS便认为此扇区中确实存在可执行的程序,便加载到物理地址0x7c00,随后跳转到此地址,继续执行。

8086CPU要求物理地址

0x0~0x3FF存放中断向量表,所以此处不能动了;按 DOS 1.0 要求的最小内存32KB来说,MBR希望给人家尽可能多的预留空间,所以MBR只能放在32KB的末尾;MBR本身也是程序,是程序就要用到栈,估计1KB内存够用了。结合以上三点,选择32KB中的最后1KB最为合适,32KB换算为十六进制为0x8000,减去1KB(0x400)的话,等于0x7c00。这就是倍受质疑的0x7c00 的由来。

让 MBR 先飞一会儿

$$和$$$是编译器NASM 预留的关键字,用来表示当前行和本section的地址,起到了标号的作用。汇编语言中的标号是程序员“显式地”写在明处的,如:1

2code_start:

mov ax, 0code_start这个标号被nasm认为是一个地址,此地址便是mov ax, 0这条指令所在的地址,即其指令机器码存放的内存位置是code_start。code_start只是个标记,CPU并不认识,nasm会用为其安排的地址来替换标号code_start,到了CPU手中,已经被替换为有意义的数字形式的地址了。

在每行都有。如果上面的例子改为:1

2code_start:

jmp $

这就和jmp code_start是等效的。$和code_start是同一个值。

$$$$指代本section的起始地址,此地址同样是编译器给安排的。默认情况下,它们的值是相对于本文件开头的偏移量。如果该section用了vstart=xxxx修饰,$$$$的值则是此section的虚拟起始地址xxxx。$的值是以xxxx为起始地址的顺延。

1 | ;主引导程序 |

代码功能为:在屏幕上打印字符串“1 MBR”,背景色为黑色,前景色为绿色。

- 第3行的

vstart=0x7c00表示本程序在编译时,告诉编译器,把我的起始地址编译为0x7c00。 - 第4~8行是用cs寄存器的值去初始化其他寄存器。由于BIOS是通过

jmp 0:0x7c00跳转到MBR的,故cs此时为0。对于ds、es、fs、gs这类sreg,CPU中不能直接给它们赋值,没有从立即数到段寄存器的电路实现,只有通过其他寄存器来中转,这里我们用的是通用寄存器ax来中转。 - 第9行是

初始化栈指针,在CPU上运行的程序得遵从CPU的规则,mbr也是程序,是程序就要用到栈。目前0x7c00以下暂时是安全的区域,就把它当作栈来用。 - 第11~28行是清屏。这里也演示了BIOS中断

int 0x10的用法。 - 第30~35行是做打印前的工作,先获取光标位置,目的是避免打印字符混乱,覆盖别人的输出。这里还用到了页的概念,往bh寄存器中写入了0,这是告诉BIOS例程,我要获取第0页当前的光标。

- 第38~52行是往光标处打印字符。说一下第48行的

mov ax, 0x1301,13对应的是ah寄存器,这是调用0x13号子功能。01对应的是al寄存器,表示的是写字符方式,其低2位才有意义,各位功能描述如下:- al=0,显示字符串,并且光标返回起始位置。

- al=1,显示字符串,并且光标跟随到新位置。

- al=2,显示字符串及其属性,并且光标返回起始位置。

- al=3,显示字符串及其属性,光标跟随到新位置。

- 第55行执行了个死循环,$是本行指令的地址,这属于伪指令,是汇编器在编译期间分配的地址。在最终编译出来的程序中,$会被替换为指令实际所在行的地址。jmp是个近跳转,$是jmp自己的地址,于是跳到自己所在的地址再执行自己,又是跳到自己所在的地址再继续执行跳转

- 第57行是定义打印的字符串。

- 第58行的是本行到本section的偏移量。由于MBR的最后两个字节是固定的内容,分别是0x55和0xaa,要预留出这2个字节,故本扇区内前512-2=510字节要填满,第50行的

times 510-($-$$) db 0是在用0将本扇区剩余空间填充。

完善MBR

地址、section、vstart 浅尝辄止

本质上,程序中各种数据结构的访问,就是通过该数据结构的起始地址+该数据结构所占内存的大小来实现的。数据的地址,其实就是该数据相对整个程序开头的距离,即偏移量。

- 第1行的mov指令,被置换为0。

- 第2行代码是真指令,不牵涉到符号转换,所以反汇编后的代码同源码一致。

- 第3行引用了var变量的值,[]符号是取所在地址处的内容。在相应的反汇编代码中,相应的第三行中var这个符号地址被编译器替换为

0xd。结合地址列查看一下内容列,地址为0xd 的内容为99,这正是var 的值。 - 第4行源码为

label: mov ax, $,label是个标号,代表指令mov ax, $所在地址。$是个隐式的标号,表示当前行地址。 - 第5行的

jmp label编译后被替换为jmp short 0x8,这是短跳转指令,地址为8处的内容是第4行的mov ax, $,同样吻合。 - 第 6 行的便是数据定义了,定义了双字节变量

var,其值为99。在内容处的第6行可知,内容为99,与源码定义吻合。

“地址”列中的数字和“内容”列中的内容有这样一种关系:地址等于上一个地址+上一个地址处的内容的长度。例如地址列第二行的3等于“上一个地址0”+“上一个地址 0 处的内容:B80000 的长度3”,以此类推。编译器给程序中各符号(变量名或函数名等)分配的地址,就是各符号相对于文件开头的偏移量。

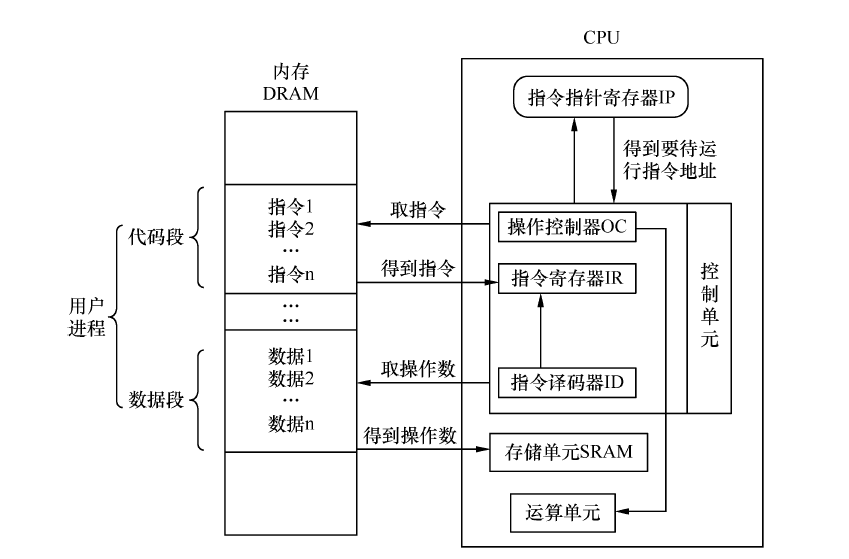

CPU 的实模式

实模式是指8086 CPU 的寻址方式、寄存器大小、指令用法等,是用来反应CPU 在该环境下如何工作的概念。CPU 大体上可以划分为3 个部分,它们是控制单元、运算单元、存储单元。控制单元是 CPU 的控制中心,CPU 需要经过它的帮忙才知道自己下一步要做什么。而控制单元大致由指令寄存器IR(Instruction Register)、指令译码器ID(Instruction Decoder)、操作控制器OC(Operation Controller)组成。

程序被加载到内存后,指令指针寄存器IP指向内存中下一条待执行指令的地址,控制单元根据IP寄存器的指向,将位于内存中的指令逐个装载到指令寄存器中。然后指令译码器将位于指令寄存器中的指令按照指令格式来解码,分析出操作码是什么,操作数在哪里之类的。

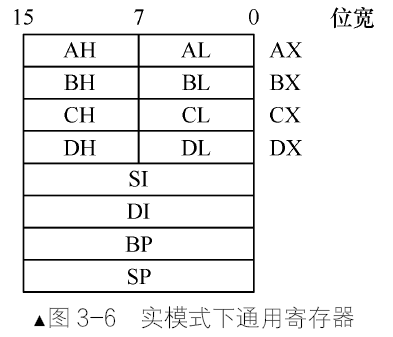

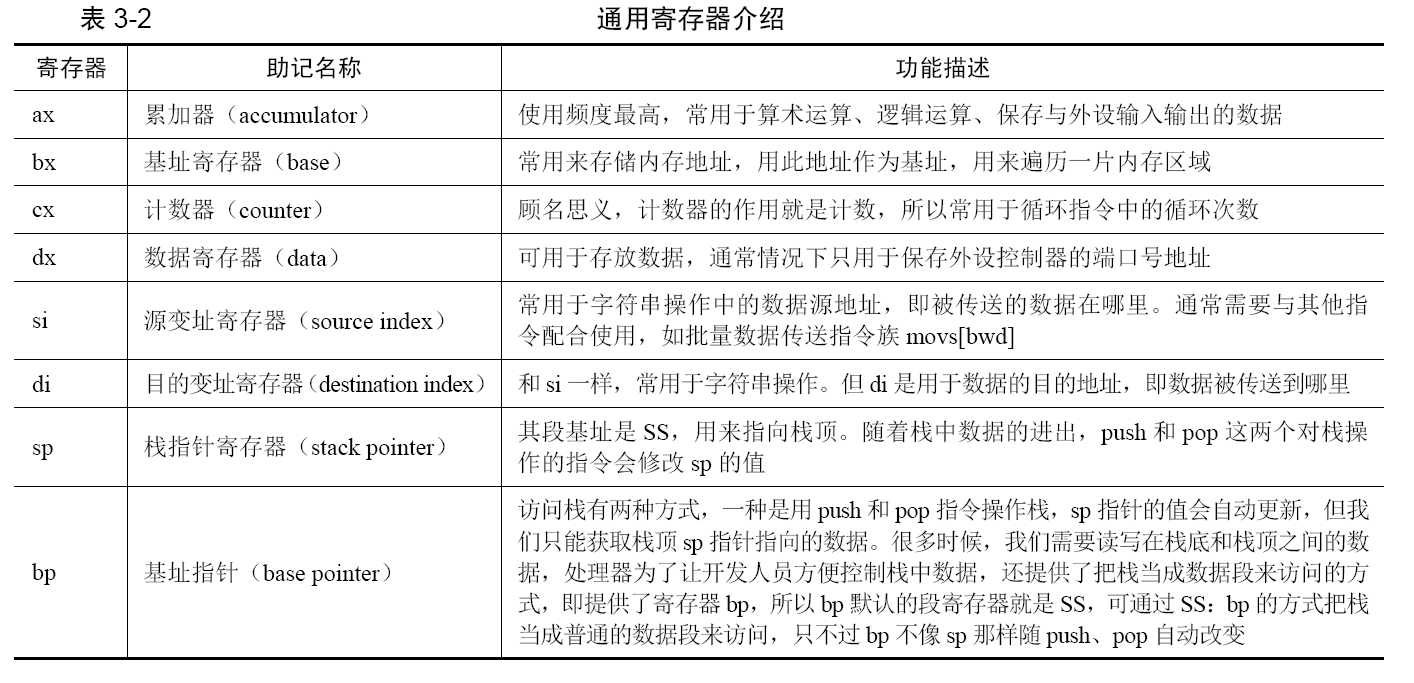

存储单元是指CPU内部的L1、L2缓存及寄存器,待处理的数据就存放在这些存储单元中。寄存器可分为两大类,程序员可以使用的寄存器称为程序可见寄存器,如通用寄存器、段寄存器。程序不可见寄存器是指程序员不可使用,也无法访问到它们,系统运行期间可能要用到寄存器。

运算单元负责算术运算(加减乘除)和逻辑运算(比较、移位),它从控制单元那里接收命令(信号)并执行,它没有自主意识,只是个执行部件。

CPU 中的寄存器大致上分为两大类。

- 一类是其内部使用的,程序员不能使用。我们无法使用一些寄存器,比如全局描述符表寄存器GDTR、中断描述符表寄存器IDTR、局部描述符表寄存器LDTR、

任务寄存器TR、控制寄存器CR0~3、指令指针寄存器IP、标志寄存器flags、调试寄存器DR0~7。 - 另一类是对程序员可见的寄存器。我们进行汇编语言程序设计时,能够直接操作的就是这些寄存器,如段寄存器、通用寄存器。

上面提到的“段基址:段内偏移地址”中的段基址,就是用段寄存器来存储的,段寄存器的作用就是指定一片内存的起始地址,故也称为段基址寄存器。尽管段基址在实模式下要乘以16,在保护模式下只是个选择子(保护模式中会讲),但其作用就是指定一片内存的起始地址。而段内偏移地址,顾名思义,仅仅相对于此起始地址的偏移量。

访问内存就要提供地址,初次访问内存时,该地址肯定不能用内存本身来存,用寄存器来存储内存地址。由于要指定的是内存中的一段区域的起始地址,所以称之为段基址寄存器,也称段寄存器,无论是在实模式下,还是保护模式下,它们都是16位宽。

- 代码段把所有指令都连续排放在一起,形成了一个全部都是指令的区域,里面存储的是指令的操作码及寻址方式等。代码段寄存器CS就是用来指向内存中这段指令区域的起始地址。

- 数据段和代码段类似,只是这段区域存储的是程序运行所需要的数据,属于指令的操作数。数据段寄存器DS便是用来指向此数据区域的起始地址。

- 栈段是在内存中,硬盘文件中可真没有。一般的栈段是由操作系统分配指定的,所以是属于被加载到内存后才有的。栈段寄存器SS 就是用来指向此区域的起始地址。

值得说明的是在16 位CPU 中,只有一个附加段寄存器ES。而FS和GS附加段寄存器是在32 位CPU 中增加的。

IP寄存器是不可见寄存器,CS寄存器是可见寄存器。这两个配合在一起后就是CPU的罗盘。访问内存就要用“段:段内偏移”的形式,所以CS 寄存器用来存代码段段基址,IP 寄存器用来存储代码段段内偏移地址,同CS 寄存器一样都是16 位宽。

- flags 寄存器是计算机的窗口,展示了CPU 内部各项设置、指标。任何一个指令的执行、其执行过程的细节、对计算机造成了哪些影响,都在flags 寄存器中通过一些标志位反映出来。

- 无论是实模式,还是保护模式,通用寄存器有8 个,分别是AX、BX、CX、DX、SI、DI、BP、SP。

拿AX寄存器举例,根据图3-6可知,AX寄存器是由AH寄存器和AL寄存器组成的,它们都是8位寄存器,AX寄存器的低8位是AL寄存器。高8位是AH寄存器。由于某种原因,16位AX寄存器不够用了,将其扩展(Extend)为32位,在AX原有的基础上,增加16位作为高16位便是扩展的AX,即EAX。所以EAX归根结底也是由AL、AH组成的,AL或AH值变了直接影响EAX。

以上的这8个寄存器实际上是通用寄存器,通用是说每个寄存器的功能不单一,可以有多种用途,不像段寄存器SS那样只能用来放栈段基址,通用寄存器可以用来保存任何数据。一般情况下,cx寄存器用作循环的次数控制,bx寄存器用于存储起始地址。

实模式下内存分段的由来

有了保护模式后,为了与老的模式区别开来,所以称老的模式为实模式。实模式的“实”体现在:程序中用到的地址都是真实的物理地址,“段基址:段内偏移”产生的逻辑地址就是物理地址,也就是程序员看到的完全是真实的内存。

为了让16位的寄存器寻址能够访问20位的地址空间,CPU 工程师定位到根本瓶颈是在段寄存器,它要是能提供20位的段地址,哪怕偏移地址是1也照样可以访问到内存的各个角落。于是,通过先把16位的段基址左移4位后变成20位,再加段内偏移地址,这样便形成了20位地址,只要保证了段基址是20位的,偏移地址是多少位都不关心了,从而突破了16位寄存器作为偏移地址而无法访问1MB空间的限制。

拿 0xFFFF 来说,现在能访问的最大的地址是0xFFFF:0xFFFF,经过左移段基址4位后得到的最大地址是:0xFFFF 16 + 0xFFFF = 0xFFFF0 + 0xFFFF = 0xFFFFF + 0xFFF0 = 1M + 16 4KB - 16 - 1 = 0x10FFEF。得到的最大地址是1MB+64KB-16字节,因为这是空间范围,所以要减去1得到地址范围。多出来64K-16 字节,这部分内存就是传说中的高端内存区,但是这部分内存不存在。所以由于超过了20位而产生的进位,就给丢掉了。其作用相当于把地址对1MB取模了。

实模式下CPU 内存寻址方式

下面把8086的寻址模式和大家说说。寻址方式,从大方向来看可以分为三大类:

- 寄存器寻址;

- 立即数寻址;

- 内存寻址。

- 直接寻址;

- 基址寻址;

- 变址寻址;

- 基址变址寻址。

寄存器寻址:最直接的寻址方式就是寄存器寻址,它是指“数”在寄存器中,直接从寄存器中拿数据就行了。例如下面用mul 指令实现0x10*0x9。1

2

3mov ax, 0x10

mov dx, 0x9

mul dx

以上三条指令都是寄存器寻址。第一条命令是将0x10存入ax寄存器,第二条命令是将0x9存入dx,第三条指令是求ax和dx的乘积,乘积的高16位在dx寄存器,低16位在ax寄存器。只要牵扯到寄存器的操作,无论其是源操作数,还是目的操作数,都是寄存器寻址。上面的第一、二条指令,它们的源操作数都是立即数,所以也属于立即数寻址。

立即数寻址:如果操作数“直接”存在指令中,直接拿过来,立即就能用了。为了突显“立即就能用”的高效率,此数便称为立即数。立即数免去了找数的过程。如:1

2mov ax,0x18

mov ds, ax

第一条指令中的源操作数0x18是立即数,目的操作数ax是寄存器,所以它既是立即数寻址,也是寄存器寻址。第二条指令中,源操作数和目的操作数都是寄存器,所以纯粹是寄存器寻址。提醒一下,像这样的寻址也是立即数寻址:1

2mov ax, macro_selector

mov ax, label_start

第一条指令的源操作数macro_selector是个宏,第二条指令的源操作数label_start是个标号,这两个在编译阶段会转换为数字,最终可执行文件中的依然是立即数。

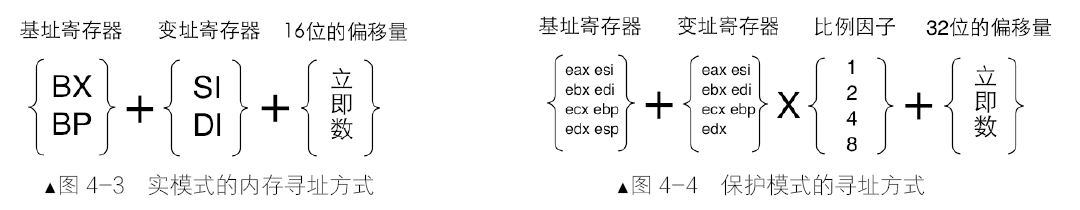

内存寻址:操作数在内存中的寻址方式称为内存寻址。大多数时候操作数位于内存中的某个位置,只知道操作数所在的内存地址,不知道操作数的值,更谈不上将其变成立即数用在指令中了,这就更加有理由让内存寻址成为“应该”。由于访问内存是用“段基址:偏内偏移地址”的形式,此形式只用在内存访问中。默认情况下数据段寄存器是DS,即段基址已经有了,只要再给出段内偏移地址就可以访问内存了,最终起决定作用的、有效的是段内偏移地址,所以段内偏移地址称为有效地址。以下所说的寻址方法都是在内存中寻址的方法。

直接寻址,就是将直接在操作数中给出的数字作为内存地址,通过中括号的形式告诉CPU,取此地址中的值作为操作数。如:1

2mov ax, [0x1234]

mov ax, [fs:0x5678]

0x1234 是段内偏移地址,默认的段地址是DS。这条指令是将内存地址DS:0x1234处的值写入ax寄存器。第二条指令中,由于使用了段跨越前缀fs, 0x5678的段基址则变成了gs寄存器。最终的内存地址是gs寄存器的值*16+0x5678,CPU到此内存地址取值再存入ax寄存器。

基址寻址,就是在操作数中用bx寄存器或寄存器作为地址的起始,地址的变化以它为基础。这里说的是只能用bx 或bp 作为基址寄存器。用寄存器作为内存寻址,到了保护模式下就没这个限制了,基址寄存器可选择的很多。说明一下,bx 寄存器的默认段寄存器是DS,而bp 寄存器的默认段寄存器是SS,即bp 和sp 都是栈的有效地址。

sp寄存器作为栈顶指针,相当于栈中数据的游标,这是专门给push 指令和pop 指令做导航用的寄存器,push 指令往哪个内存压入数据,popd 将哪个地址的数据弹出栈,都要看sp 的值是多少。在实模式下,CPU 字长是16,所以实模式下的push 指令默认情况下是压入2 字节的数据,其工作原理可以分为两步,假如执行push ax:1

2sub sp,2 先将sp 的值减去

mov sp,ax 再将ax 的值mov 加到新的sp 指向的内存

实模式下 pop 指令,其工作原理也分为两步,假如执行pop ax:1

2mov ax, [sp] 先将sp 指向的值mov 到

add sp,2 再将sp 的指针+2

访问栈有两种方式,一种是把栈当成“栈”来使用,也就是用push 和pop 指令操作栈,但这样我们只能访问到栈顶,即sp 指向的地址,没有办法直接访问到栈底和栈顶之间的数据。很多时候,我们需要读写栈中的数据,即需要把栈当成普通数据段那样访问。举个需要直接写栈的例子,比如标志寄存器eflags 无法直接修改,只能用pushf指令把eflags寄存器的内容压到栈中,我们在栈中修改完后,再用popf 把它弹回到eflags 中。处理器为了让开发人员方便控制栈中数据,提供了这种把栈当成数据段来访问的方式,可以用寄存器bp 来给出栈中偏移量,所以bp 默认的段寄存器就是SS,这样就可通过SS:bp 的方式把栈当成普通的数据段来访问。

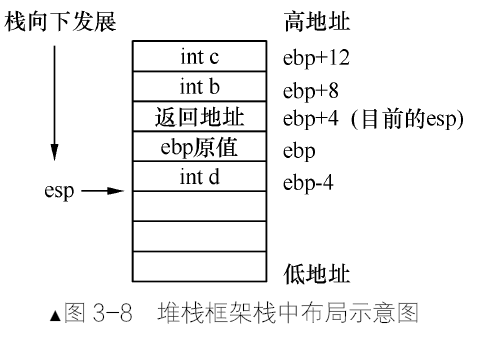

在32 位环境下,ebp寄存器应用在堆栈框架中,堆栈框架是编译器在栈中为局部变量分配内存空间的方式,局部变量存在于函数中,因此有关堆栈框架的汇编指令是在函数的开头和结尾处。下面通过这段代码了解堆栈框架的原理。1

2

3

4

5int a = 0;

function(int b, int c) {

int d;

}

a++;

- 调用

function(1,2);按照C语言调用规范,参数入栈的顺序从右到左:会先压入2,再压入1。每个参数在栈中各占4字节。 - 栈中再压入function的返回地址,此时栈顶的值是执行“a++”相关指令的地址。

下面是堆栈框架的指令。

push ebp;将ebp 压入栈,栈中备份ebp 的值,占用4 字节。mov ebp, esp;将esp 的值复制到ebp,ebp 作为堆栈框架的基址,可用于对栈中的局部变量和其他参数寻址。此时的 ebp 便是栈中局部变量的分界线。在这之后,esp 将自减一定的值为局部变量在栈中分配空间,该值取决于所有局部变量空间大小的总和。sub esp, 4;由于函数function 中有局部变量d,局部变量是在栈中存放的,故esp 要预留出4 字节,专门给变量d 使用。

终于到了应用 ebp 指针的时候,以ebp 为基址对栈中数据寻址。

[ebp-4]是局部变量d,对应上面的第(5)步。[ebp]是ebp 在栈中的备份,对应上面的第(3)步。[ebp+4]是函数的返回地址,对应上面的第(2)步。- 函数中的参数b是用

[ebp+8]访问,参数c用[ebp+12]访问,对应上面的第(1)步。

栈中数据的布局如图 3-8 所示。

- 函数结束后跳过局部变量的空间:mov esp, ebp。

- 恢复ebp 的值:pop ebp。

- 至此函数中堆栈框架的指令结束了,然后是返回指令ret,接着主调函数中执行

add esp, 8来回收参数b 和c 的空间。

堆栈框架的工作是为函数分配局部变量空间,因此应该在刚刚进入函数时就进行为局部变量分配空间的工作,离开函数时再回收局部变量的空间。

数时进行的。

变址寻址其实和基址寻址类似,只是寄存器由bx、bp 换成了si 和di。si 是指源索引寄存器(source index),di 是指目的索引寄存器(destination index)。两个寄存器的默认段寄存器也是ds。mov [di],ax :将寄存器ax的值存入ds:di 指向的内存;mov [si+0x1234], ax :变址中也可以加个偏移量。变址寻址主要是用于字符搬运方面的指令,这两个寄存器在很多指令中都要成对使用,如movsb,movsw,movsd等。

基址变址寻址;从名字上看,这是基址寻址和变址寻址的结合,即基址寄存器bx或bp加一个变址寄存器si或di。如:1

2mov [bx+di], ax

add [bx+si], ax

第一条指令是将ax中的值送入以ds为段基址,bx+di 为偏移地址的内存。第二条指令是将ax与[ds:bx+si]处的值相加后存入内存[ds:bx+si]。

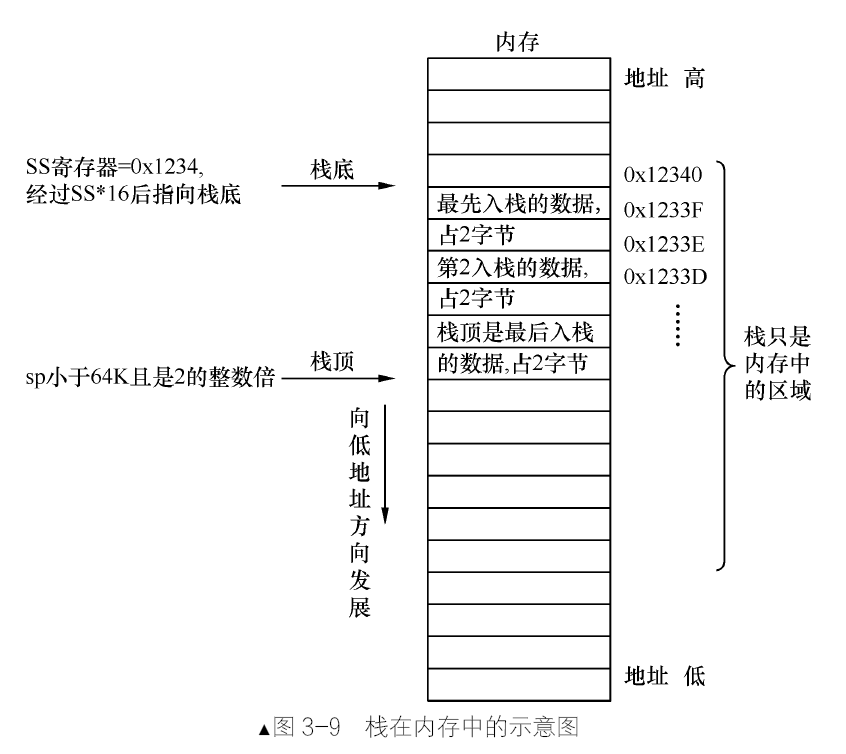

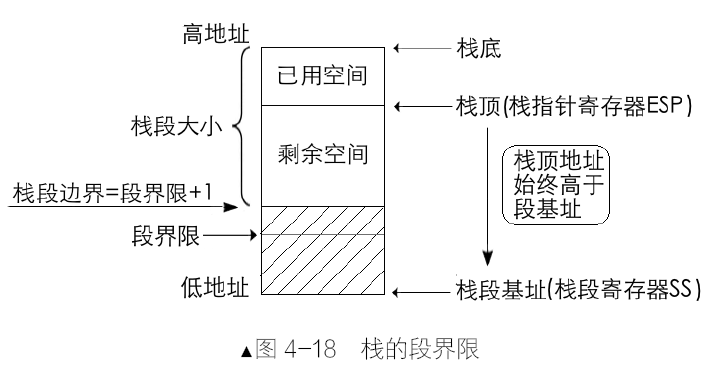

栈

给栈指定一片内存区域,区域的起始地址作为栈基址,存入栈基址寄存器SS中,另一端是动态变化的,用栈指针寄存器SP来指定,栈顶地址肯定小于栈底地址。栈中的内存地址用段基址SS的值*16+栈指针SP(段内偏移地址)形成的20位地址访问到的。硬件提供了相应的方法来存取栈,即push 和pop 指令。push 指令负责把数据压入栈,pop 指令功能相反,将其从栈中取出。

栈指针寄存器SP中的值是段内偏移地址,是栈顶相对于栈底的偏移量。push压入数据的过程是:先将SP减去字长,目的是避免将栈顶的数据破坏,所得的差再存入SP,栈顶在此被更新,这样栈顶就指向了栈中下一个存储单元的位置。再将数据压入SP(新的栈顶)指向的新的内存地址。pop指令相反,栈指针寄存器SP的值增大一个数据单位。由于要弹出的数据就在当前栈顶,所以在弹出数据后,才将SP加上字长,所得的和再存入SP,从而更新了栈顶。

即使是这里的硬件栈,咱们也可以自己维护指针,如push ax可以这样代替:1

2

3mov bp,sp

sub bp, 2

mov [bp],ax

push 和pop 操作是要成对出现的,这样才能维护栈平衡。

实模式下的call/ret

经过代码段段基址寄存器CS16后再加上代码段的段内偏移地址寄存器IP的值,所得的和就是指令存放的内存地址。CPU 在此内存地址处获得指令并执行。所以说,CPU 前进的方向永远是CS:IP 这两个寄存器。call指令用来执行一段新的代码,需要返回指令ret来帮忙。ret(return)指令的功能是在栈顶(寄存器ss:sp 所指向的地址)弹出2 字节的内容来替换IP寄存器。retf(return far)是从栈顶取得4 字节,栈顶处的2 字节用来替换IP 寄存器,另外的2 字节用来替换CS 寄存器。retf指令会使sp指针+4。,*call和ret是一对配合,用于近调用和近返回,call far和retf是一对配合,用于远调用和远返回。

在 8086 处理器中,也就是我们所说的实模式下,call 指令调用函数有四种方式。

- 16 位实模式相对近调用:call 指令所调用目标函数和当前代码段是同一个段,所以只给出段内偏移地址。和“近”有关的调用就可以用关键字

near来修饰,由于是在同一个代码段中,所以只要给出目标函数的相对地址即可。指令格式是call near 立即数地址。。此指令是个3字节指令,0xe8是此操作的操作码,占1 字节,剩下2 字节便是操作数。- 此操作数并不是目标函数的绝对地址,只是相对于目标函数地址的相对增量,所以此操作数并不能直接被CPU使用。CPU在实际执行中还要将此增量还原成绝对地址。所以此相对近调用并不能称为“直接”相对近调用。

- near 的意思同数据类型伪指令word 一样,是指在内存地址处取2 字节内容,或者将操作数强制转换为2 字节。可以认为像near、short、far,这些用在调用或转移中的修饰符(后面会说到),其意义就是数据类型转换。

- 16 位实模式间接绝对近调用。“间接”是指目标函数的地址并没有直接给出,地址要么在寄存器中,要么在内存中,总之不以立即数的形式出现。“绝对”是指目标函数的地址是绝对地址,不像“16 位相对近调用”中的那样是相对地址。指令的一般形式是

call 寄存器寻址或call 内存寻址,如call ax,call [0x1234]。 - 16 位实模式直接绝对远调用。凡是包含“远”,就意指要跨段啦,目标函数和当前指令不在同一个段中。由于是远调用,所以CS 和IP 都要用新的,call 指令将来还是要回来的,所以要在栈中保留回来的路,即先把老的CS 寄存器压入栈,再把老的IP 寄存器压入栈后,用新的CS 和IP 寄存器替换,从此开启新

的旅途。call far 段基址(立即数):段内偏移地址(立即数) - 16 位实模式间接绝对远调用。这和第 3 种的区别就是“直接”变“间接”了。也就是说,段基址和段内偏移地址,都不是立即数。16 位间接绝对远调用指令格式是:

call far 内存寻址,如call far [bx],call far [0x1234]

实模式下的jmp

jmp 转移指令只要更新CS:IP 寄存器或只更新IP 寄存器就好了,不需要保存它们的值,所以跳到新的地址后没办法再回来,它属于“一去不回头”地去执行新指令。和 call 一样,按远近(是否跨段)来划分,大致分为两类,近转移、远转移。不过在转移方式中,还有个更近的,叫短转移。相对近转移和相对短转移相比,就是操作数范围增大了,由8 位宽度变成了16 位宽度,操作数依然是地址相对量,可正可负,范围是-32768~32767。间接,是指操作数并不直接给出,而是存储在寄存器或内存中。绝对地址顾名思义,就是段内偏移地址,指的是“CS:IP”中的IP 值,偏移地址是16位。

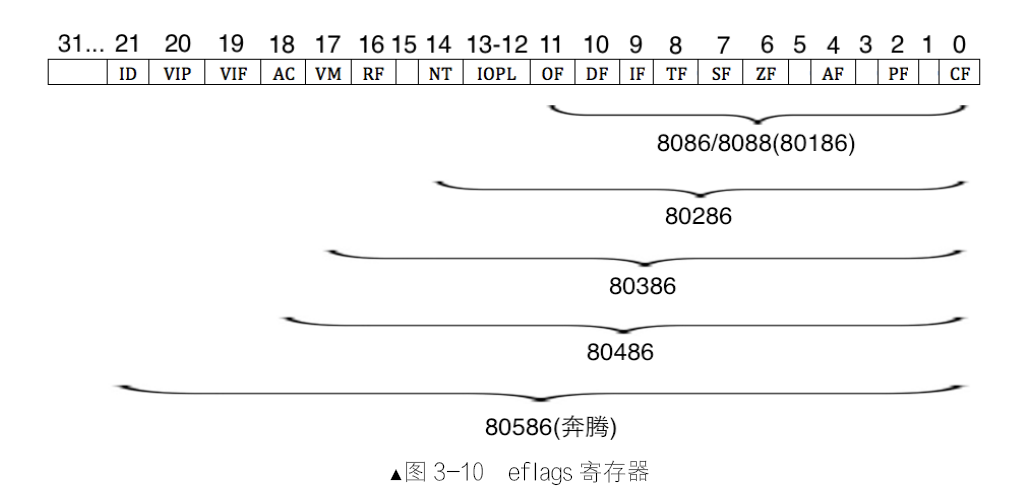

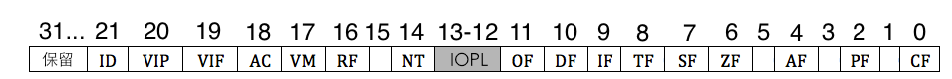

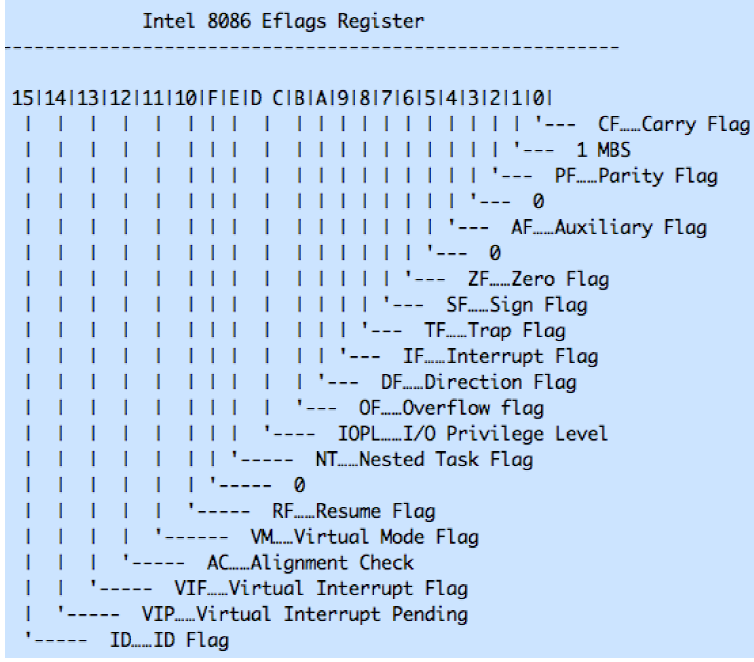

标志寄存器flags

实模式下标志寄存器是16 位的flags,在32 位保护模式下,扩展(extend)了标志寄存器,成为32位的eflags。

- 第0位为CF位,即Carry Flag,意为进位。因为CF 为1 时,也就是最高位有进位或借位,肯定是溢出。

- 第2位为PF位,即Parity Flag,意为奇偶位。用于标记结果低8 位中1 的个数。

- 第4位为AF位,即Auxiliary carry Flag,意为辅助进位标志,用来记录运算结果低4 位的进、借位情况。

- 第6位为ZF位,即Zero Flag,意为零标志位。若计算结果为0,此标志为1,否则为0。

- 第7位为SF位,即Sign Flag,意为符号标志位。若运算结果为负,则SF 位为1,否则为0。

- 第8位为TF位,即Trap Flag,意为陷阱标志位。此位若为1,用于让CPU 进入单步运行方式,若为0,则为连续工作的方式。

- 第9位为IF位,即Interrupt Flag,意为中断标志位。若IF 位为1,表示中断开启,CPU 可以响应外部可屏蔽中断。

- 第10位为DF位,即Direction Flag,意为方向标志位。此标志位用于字符串操作指令中,当DF 为1 时,指令中的操作数地址会自动减少一个单位。

- 第11位为OF位,即Overflow Flag,意为溢出标志位。用来标识计算的结果是否超过了数据类型可表示的范围

有条件转移

如果条件满足,jxx 将会跳转到指定的位置去执行,否则继续顺序地执行下一条指令。其格式为 jxx 目标地址。若条件满足则跳转到目标地址,否则顺序执行下一条指令。其中,目标地址只能是段内偏移地址。在实模式下,由编译器根据当前指令与目标地址的偏移量,自行将其编译成短转移或近转移。条件转移指令一定得在某个能够影响标志位的指令之后进行。

让我们直接对显示器说点什么吧

为了简化CPU 访问外部设备的工作,能够轻松地同任何硬件通信,约定好IO 接口的功能:

- 设置数据缓冲,解决CPU 与外设的速度不匹配

- 设置信号电平转换电路

- 设置数据格式转换

- 设置时序控制电路来同步CPU 和外部设备

- 提供地址译码

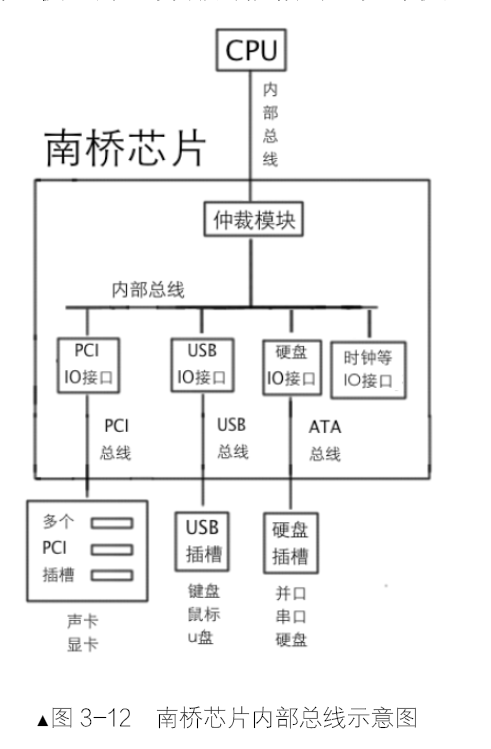

同一时刻,CPU 只能和一个IO 接口通信。使用一个芯片仲裁IO 接口的竞争,还要连接各种内部总线。由于它的使命,它的名字就叫做输入输出控制中心(I/O control hub,ICH),也就是南桥芯片。南桥用于连接pci、pci-express、AGP 等低速设备,北桥用于连接高速设备,如内存。南桥提供了专门用于扩展的接口,这就是PCI 接口。

IO 接口是连接CPU和硬件的桥梁,一端是CPU,另一端是硬件。端口是IO接口开放给CPU的接口。端口也是寄存器,寄存器就有数据宽度,有8位、16位、32位。CPU 提供了专门的指令来干这事,in和out。

in指令用于从端口中读取数据,其一般形式是:

in al, dx;in ax, dx。

其中al 和ax 用来存储从端口获取的数据,dx 是指端口号。这是固定用法,只要用in指令,源操作数(端口号)必须是dx,而目的操作数是用al,还是ax,取决于dx 端口指代的寄存器是8 位宽度,还是16 位宽度。

out 指令用于往端口中写数据,其一般形式是:

- out

dx, al - out

dx,ax - out

立即数, al - out

立即数, ax

注意啦,这和 in 指令相反,in 指令的源操作数是端口号,而out 指令中的目的操作数是端口号。

硬盘介绍

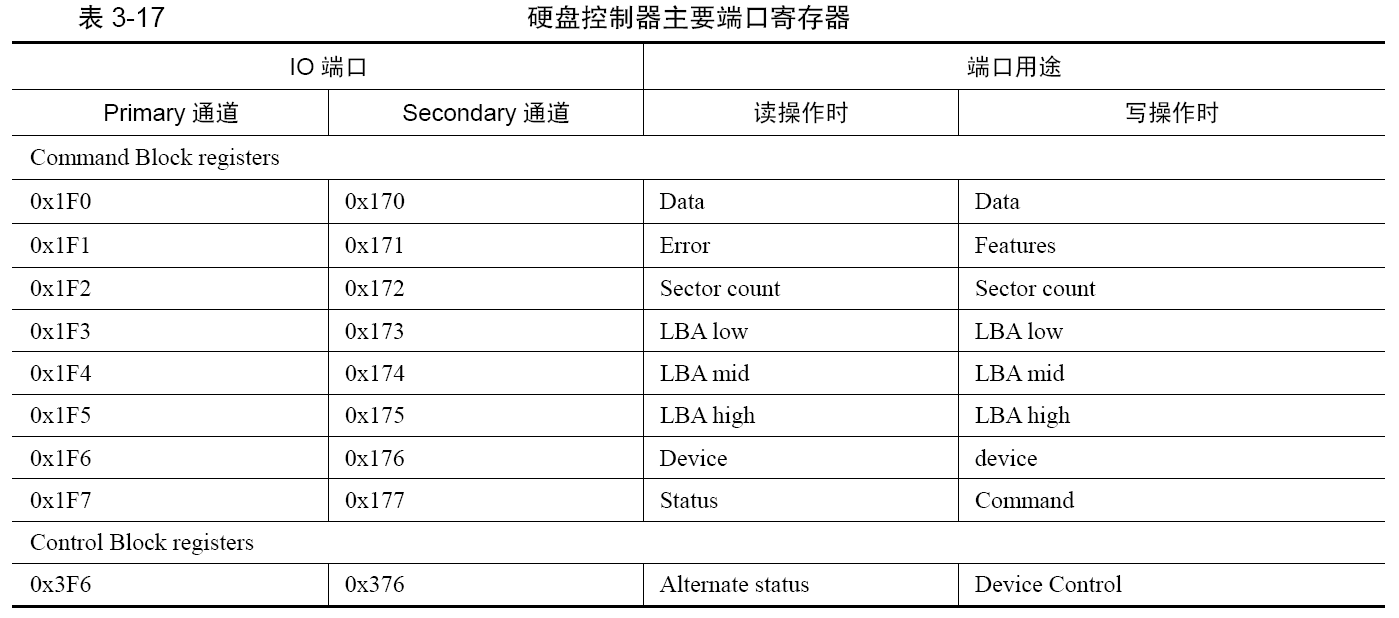

通过读写硬盘控制器的端口让硬盘工作,端口就是位于IO控制器上的寄存器,此处的端口是指硬盘控制器上的寄存器。

端口可以被分为两组,Command Block registers和Control Block registers。Command Block registers

用于向硬盘驱动器写入命令字或者从硬盘控制器获得硬盘状态,Control Block registers 用于控制硬盘工作状态。下面重点介绍Command Block registers 组中的寄存器。

- data寄存器是负责管理数据的,其作用是读取或写入数据。数据的读写还是越快越好,所以此寄存器较其他寄存器宽一些,16 位;

- 读硬盘时,端口0x171或0x1F1的寄存器名字叫Error寄存器,只在读取硬盘失败时有用,里面才会记录失败的信息,尚未读取的扇区数在Sector count 寄存器中;在写硬盘时,此寄存器有了别的用途,用来存储额外参数,叫Feature 寄存器。

- Sector count 寄存器用来指定待读取或待写入的扇区数;

- 用28位比特来描述一个扇区的地址,最大可寻址范围是2的28次方,称为LBA方法,与之对应的LBA low、LBA mid、LBA high三个寄存器都是8位宽度的。

- LBA low 寄存器用来存储28位地址的第0~7位,LBA mid寄存器用来存储第8~15位,LBA high寄存器存储第16~23位。

- device寄存器是个杂项,它的宽度是8位。

- 在此寄存器的低4位用来存储LBA地址的第24~27 位。

- 第4位用来指定通道上的主盘或从盘,0代表主盘,1代表从盘。

- 第6位用来设置是否启用LBA方式,1代表启用LBA模式,0代表启用CHS模式。

- 另外的两位:第5位和第7位是固定为1的,称为MBS位。

- 端口0x1F7或0x177的寄存器名称是Status,它是8位宽度的寄存器,用来给出硬盘的状态信息;在写硬盘时,端口0x1F7或0x177的寄存器名称是command。

一般硬盘操作的基本顺序:

- 先选择通道,往该通道的sector count 寄存器中写入待操作的扇区数。

- 往该通道上的三个LBA 寄存器写入扇区起始地址的低24 位。

- 往device 寄存器中写入LBA 地址的24~27 位,并置第6 位为1,使其为LBA 模式,设置第4位,选择操作的硬盘(master 硬盘或slave 硬盘)。

- 往该通道上的command 寄存器写入操作命令。

- 读取该通道上的status 寄存器,判断硬盘工作是否完成。

- 如果以上步骤是读硬盘,进入下一个步骤。否则,完工。

- 将硬盘数据读出。

硬盘工作完成后,它已经准备好了数据,咱们该怎么获取呢?一般常用的数据传送方式如下。

- 无条件传送方式。数据源设备一定是随时准备好了数据。

- 查询传送方式。称为程序I/O、PIO(Programming Input/Output Model),是指传输之前,由程序先去检测设备的状态。数据源设备在一定的条件下才能传送数据

- 中断传送方式。也称为中断驱动I/O。通知CPU 可以采用中断的方式,当数据源设备准备好数据后,它通过发中断来通知CPU 来拿数据

- 直接存储器存取方式(DMA)。完全由数据源设备和内存直接传输,CPU 直接到内存中拿数据就好了

- I/O 处理机传送方式。

让 MBR 使用硬盘

1 | ;主引导程序 |

程序最开始的%include “boot.inc”,这个%include 是nasm 编译器中的预处理指令,意思是让编译器在编译之前把boot.inc 文件包含进来。

第 50~52 行为函数rd_disk_m_16 传递参数。在此说明一下,汇编语言中定义的函数(或者称为例程,proc),由于汇编语言能够直接操作寄存器,所以其传递参数可以用寄存器,也可以用栈。用寄存器传参数,没有固定的形式,原则上用哪个寄存器都行,此函数需要三个参数,我们选择用eax、bx、cx 寄存器来传递参数。

寄存器 cx 是读入的扇区数,cx 其值为1。到底读入几个扇区,是由实际文件大小来决定的。由于将来会写一个简单的loader,其大小肯定不会超过512 字节,所以此处读入的扇区数置为1 即可。

函数名rd_disk_m_16 的意思是“在16 位模式下读硬盘”。第 64 行的“mov esi,eax”是把eax 中的值先备份到esi 中。因为al 在out 指令中会被用到,这会影响到eax 的低8 位。第 65 行是备份读取的扇区数到di 寄存器,di 寄存器是16 位的,和cx 大小一致。cx 的值会在读取数据时用到,所以在此提前备份。第 67~70 行,按照咱们操作硬盘的约定,先选定一个通道,再往sector count 寄存器中写扇区数。往端口中写入数据用out 指令,注意out 指令中dx 寄存器是用来存储端口号的。其操作格式可见3.3.1 节的结尾部分。

第 74~95 行是将LBA 地址写入三个LBA 寄存器和device 寄存器的低4 位。端口0x1f3 是寄存器LBAlow,端口0x1f4 是寄存器LBA mid,端口0x1f5 是寄存器LBA high。shr 指令是逻辑右移指令,这里主要通过此指令置换出地址的相应部分,写入相应的LBA 寄存器。第93 行的“or al,0xe0”,用了or“或”指令和0xe0 做或运算,拼出device 寄存器的值。高4 位为e,即高4 位的二进制表示为1110,其第5 位和第7 位固定为1,第6 位为1 表示启用LBA。第 97~100 行便是写入命令啦,因为我们这里是读操作,所以读扇区的命令是0x20。通过out 指令写入command 端口0x1f7 后,硬盘就开始工作了。

第 102~109 行检测status 寄存器的BSY 位。由于status 寄存器依然是0x1f7 端口,所以不需要再为dx 重新赋值。105 行的nop 表示空操作,即什么也不做,只是为了增加延迟,相当于sleep 了一小下,目的是减少打扰硬盘的工作。第 111~122 行是从硬盘取数据的过程。由于data 寄存器是16 位,即每次in 操作只读入2 字节,根据读入的数据总量(扇区数*512 字节)来求得执行in 指令的次数。第 123 行返回指令ret,它用来从函数中返回。

保护模式入门

保护模式概述

为什么要有保护模式

实模式的缺点:

- 实模式下操作系统和用户程序属于同一特权级,这哥俩平起平坐,没有区别对待。

- 用户程序所引用的地址都是指向真实的物理地址,也就是说逻辑地址等于物理地址,实实在在地指哪打哪。

- 用户程序可以自由修改段基址,可以不亦乐乎地访问所有内存,没人拦得住。

以上 3 个原因属于安全缺陷,没有安全可言的CPU 注定是不可依赖的,这决定了用户程序乃至操作系统的数据都可以被随意地删改,一旦出事往往都是灾难性的,而且不容易排查。

- 访问超过64KB 的内存区域时要切换段基址,转来转去容易晕乎。

- 一次只能运行一个程序,无法充分利用计算机资源。

- 共20 条地址线,最大可用内存为1MB,这即使在20 年前也不够用。

保护模式下,物理内存地址不能直接被程序访问,程序内部的地址(虚拟地址)需要被转化为物理地址后再去访问。

我们说实模式时,指的是32 位的CPU 运行在16 位模式下的状态,不是CPU 变身成纯粹的16位啦,大家不要感到迷惑。

初见保护模式

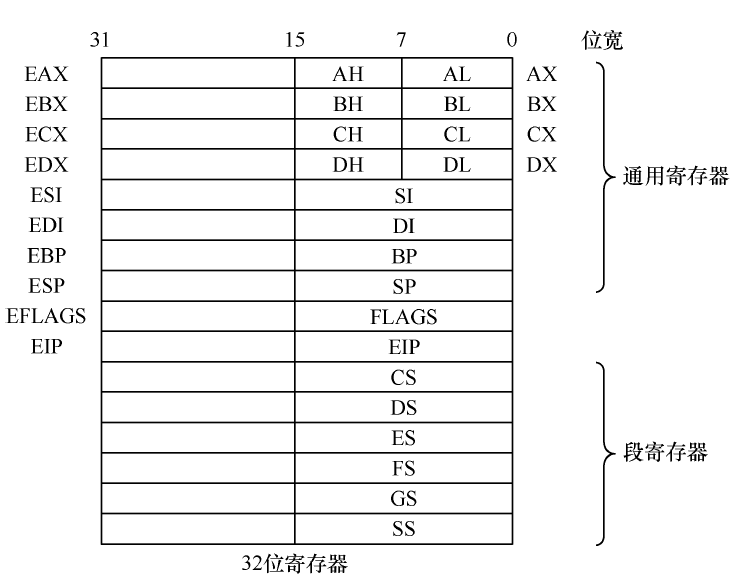

保护模式之寄存器扩展

为了让一个寄存器就能访问 4GB 空间,需要寄存器宽度提升到32 位。除段寄存器外,通用寄存器、指令指针寄存器、标志寄存器都由原来的16 位扩展到了32 位。注意段寄存器用16位就够用了。

寄存器要保持向下兼容,不能推翻之前的方案从头再来,必须在原有的基础上扩展(extend),各寄存器在原有16 位的基础上,再次向高位扩展了16 位,成为了32 位寄存器。经过extend 后的寄存器,统一在名字前加了e 表示扩展,

左边已经标注名字的寄存器有通用寄存器组,名字前统一加了字符E表示扩展,同样,EFLAGS寄存器和EIP分别在FLAGS和IP基础上扩展而成。图下边的6个段寄存器,依然是16 位。寄存器中低16位的部分可以单独使用。高16位没办法单独使用,只能在用32位寄存器时才有机会用到它们。

偏移地址与实模式下的一样,但段基址可不是简单的一个地址的事了,专门找了个数据结构—全局描述符表,其中每一个表项称为段描述符,其大小为64字节,用来描述各个内存段的起始地址、大小、权限等信息。该全局描述符表很大,所以放在了内存中,由GDTR寄存器指向它就行。

这样,段寄存器中保存的内容叫“选择子”,selector,该选择子其实就是个数,用这个数来索引全局描述符表中的段描述符,把全局描述符表当成数组,选择子就像数组下标一样。对段寄存器应用了缓存技术,将段信息用一个寄存器来缓存,这就是段描述符缓冲寄存器。以后每次访问相同的段时,就直接读取该段寄存器对应的段描述符缓冲寄存器。

段描述符缓冲寄存器也可以用在实模式下,在实模式下时,段基址左移4位后的结果就被放入段描述符缓冲寄存器中,以后每次引用一个段时,就直接走段描述符缓冲寄存器,直到该段寄存器被重新赋值。

80286虽然有了保护模式,但其依然是16位的CPU,其通用寄存器还是16位宽。但其与8086不同的是其地址线由20位变为了24位,即寻址空间变成了2的24次方,等于16MB大小。

有了保护模式,之前的实模式下的程序还得兼容,所以便有了个“过渡模式”,即虚拟8086 模式。因为80286是首款具备保护模式的CPU,而之前的CPU都是只有实模式,最有代表性的、应用最广的CPU 是8086。综上所述,CPU 有三种模式:实模式、虚拟8086 模式、保护模式。

保护模式之寻址扩展

在保护模式下的内存寻址中,基址寄存器不再只是bx、bp,而是所有32位的通用寄存器,变址寄存器也是一样,不再只是si、di,而是除esp 之外的所有32 位通用寄存器,偏移量由实模式的16位变成了32位。并且,还可以对变址寄存器乘以一个比例因子,注意比例因子,只能是1、2、4、8。

具体形式如下代码。1

2

3mov eax,[eax+edx*8+0x12345678]

mov eax,[eax+edx*2+0x8]

mov eax,[ecx*4+0x1234]

虽然esp 无法用作变址寄存器,但其可用于基址寄存器。所以,如下代码是正确的。1

2mov eax,[esp]

mov eax,[esp+2]

保护模式之运行模式反转

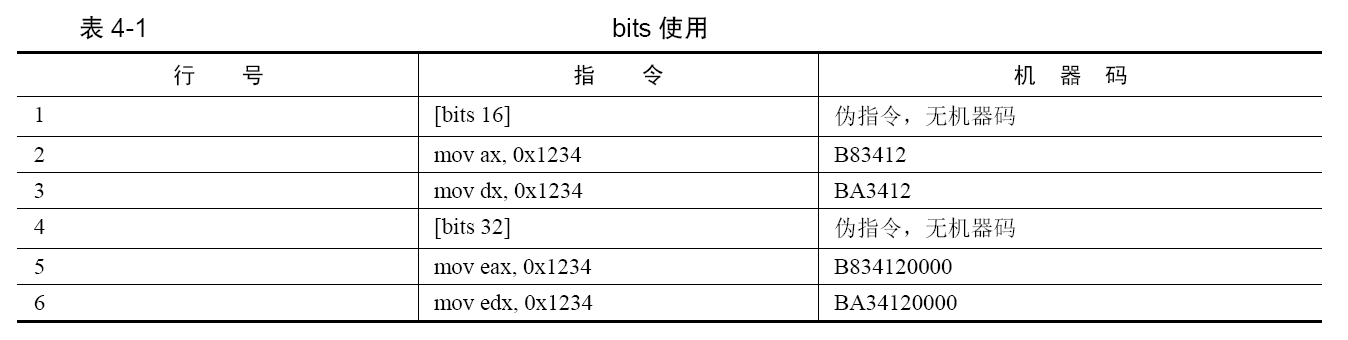

编译器提供了伪指令bits,用它来向编译器传达:我下面的指令都要编译成xx位的,因为我知道下面的代码的运行环境是xx 模式。比如在实模式下,运行的指令都是16 位的,所以编译器要将代码编译成16 位的指令。在实模式下准备好了保护模式所需要的环境后,进入保护模式后的代码就应该是32 位指令。也就是,同一段程序要经历两种模式,所以同一段程序中有两种模式的机器码。bits 指令的范围是从当前bits 标签直到下一个bits 标签的范围,这个范围中的代码将被编译成相应字长的机器码。

bits 的指令格式是[bits 16]或[bits 32]。

- [bits 16]是告诉编译器,下面的代码帮我编译成16 位的机器码。

- [bits 32]是告诉编译器,下面的代码帮我编译成32 位的机器码。

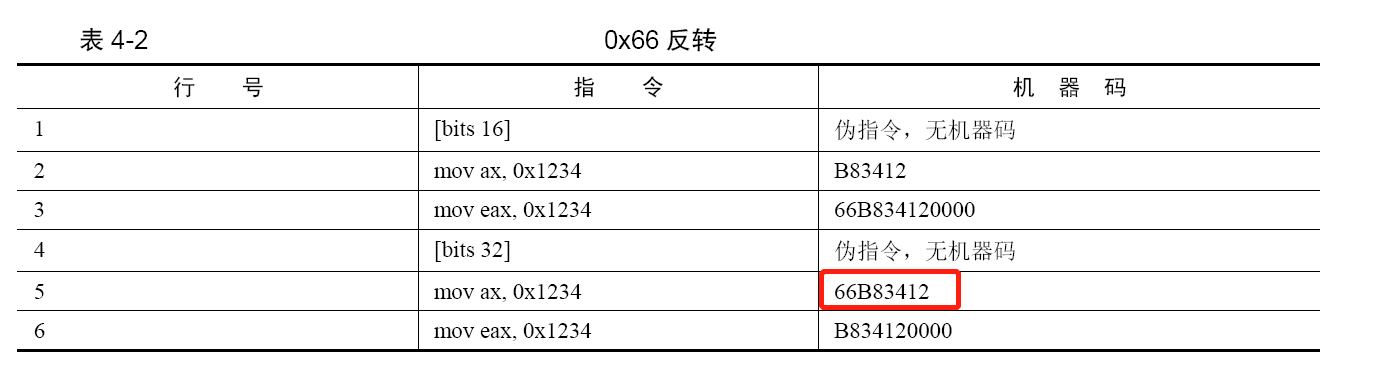

如果要用另一模式下的操作数大小,需要在指令前添加指令前缀0x66,将当前模式临时改变成另一模式。这就是反转的意义,不管是当前模式是什么,总是转变成相反的运行模式。比如,在指令中添加了 0x66 反转前缀之后:

- 假设当前运行模式是 16 位实模式,操作数大小将变为32 位。

- 假设当前运行模式是 32 位保护模式,操作数大小将变为16 位。

- 这个转换只是临时的,只在当前指令有效。

第 5 行是16 位指令,但当前已在32 位模式下,所以要用操作数反转前缀0x66 来临时将当前模式的32 位操作数反转成16 位大小的操作数,故机器码是66B83412。最前面的0x66 正是反转前缀,b8、3412分别是操作码和操作数。

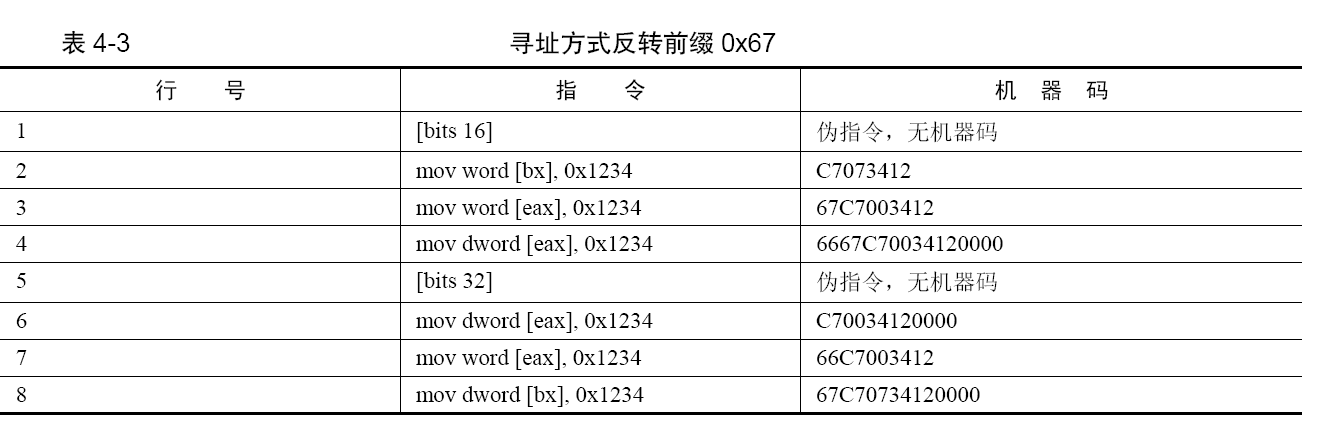

寻址方式反转前缀0x67:不同模式之间不仅可以使用对方模式下的操作数,还可以使用对方模式下的寻址方式。第3行把eax 寄存器作为基址寻址,eax 寄存器不属于实模式,所以在机器码前添加了寻址方式反转前缀0x67。

保护模式之指令扩展

mul 指令是无符号数相乘指令,指令格式是mul 寄存器/内存。其中“寄存器/内存”是乘数。

- 如果乘数是 8 位,则把寄存器al 当作另一个乘数,结果便是16 位,存入寄存器ax。

- 如果乘数是 16 位,则把寄存器ax 当作另一个乘数,结果便是32 位,存入寄存器eax。

- 如果乘数是32 位,则把寄存器eax 当作另一个乘数,结果便是64 位,存入edx:eax,其中edx 是积的高32 位,eax 是积的低32 位。

对于无符号数除法指令div,其格式是div 寄存器/内存,其中的“寄存器/内存”是除法计算中的除数。

- 如果除数是8 位,被除数就是16 位,位于寄存器ax。所得的结果,商在寄存器al,余数在寄存器ah。

- 如果除数是16 位,被除数就是32 位,被除数的高16 位则位于寄存器dx,被除数的低16 位则位于寄存器ax。所得的结果,商在寄存器ax,余数在寄存器dx。

- 如果除数是32 位,被除数就是64 位,被除数的高32 位则位于寄存器edx,被除数的低32 位则位于寄存器eax,所得的结果,商在寄存器eax,余数在寄存器edx。

对于 push 指令,需要根据其操作数的类型,分别讨论,操作数类型如下。

- 立即数。

- 寄存器。

- 内存。

第 1 种情况,对于立即数来说,可以分别压入8 位、16 位、32 位数据。指令格式是:

- push 8 位立即数

- push 16 位立即数

- push 32 位立即数

虽说可以压入8位立即数,但实际上,对于CPU 来说,出于对齐的考虑,操作数要么是16 位,要么是32 位,所以8 位立即数会被扩展成各模式下的默认操作数宽度,即实模式下8 位立即数扩展成为16 位后再入栈,保护模式下扩展成为32 位后再入栈。

在实模式环境下:

- 当压入 8 位立即数时,由于实模式下默认操作数是16 位,CPU 会将其扩展为16 位后再将其入栈,sp-2。

- 当压入 16 位立即数时,CPU 会将其直接入栈,sp-2。

- 当压入 32 位立即数时,CPU 会将其直接入栈,sp-4。

在保护模式下,同样是这些压入立即数的指令,栈指针会有怎样的变化呢?

- 当压入 8 位立即数时,由于保护模式下默认操作数是32 位,CPU 将其扩展为32 位后入栈,esp 指针减4。

- 当压入 16 位立即数时,CPU 直接压入2 字节,esp 指针减2。

- 当压入 32 位立即数时,CPU 直接压入4 字节,esp 指针减4。

实模式下每次压入一个段寄存器,栈指针sp 都会减2。保护模式下每次压入一个段寄存器,栈指针esp 都会减4。对于通用寄存器和内存,无论是在实模式或保护模式:

- 如果压入的是 16 位数据,栈指针减2。

- 如果压入的是 32 位数据,栈指针减4。

全局描述符表

全局描述符表(Global Descriptor Table,GDT)是保护模式下内存段的登记表,这是不同于实模式的显著特征之一。

段描述符

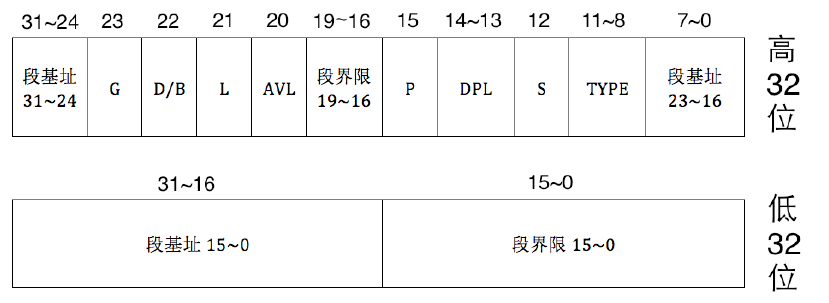

用来描述内存段的属性被放到了一个称为段描述符的结构中,该结构专门用来描述一个内存段,该结构是8字节大小。

保护模式下地址总线宽度是 32 位,段基址需要用32 位地址来表示。段界限表示段边界的扩展最值,即最大扩展到多少或最小扩展到多少。扩展方向只有上下两种。对于数据段和代码段,段的扩展方向是向上,即地址越来越高,此时的段界限用来表示段内偏移的最大值。对于栈段,段的扩展方向是向下,即地址越来越低,此时的段界限用来表示段内偏移的最小值。

段界限用20 个二进制位来表示。只不过此段界限只是个单位量,它的单位要么是字节,要么是4KB,这是由描述符中的G位来指

定的。最终段的边界是此段界限值*单位,故段的大小要么是2的20次方等于1MB,要么是2的32次方(4KB 等于2 的12 次方,12+20=32)等于4GB。

上面所说的1MB 和4GB 只是个范围,并不是具体的边界值。由于段界限只是个偏移量,是从0 算起的,所以实际的段界限边界值=(描述符中段界限+1)*(段界限的粒度大小:4KB 或者1)-1。

如果 G 位为0,表示段界限粒度大小为1 字节,根据上面的公式,实际段界限=(描述符中段界限+1)*1 -1=描述符中段界限,段界限实际大小就等于描述符中的段界限值。

如果 G 位为1,表示段界限粒度大小为4KB 字节,故实际段界限=(描述符中段界限+1)*4k-1。举个例子,如果是平坦模型,段界限为0xFFFFF,G位为1,套用上面公式,段界限边界值=0x100000*0x1000-1=0xFFFFFFFF。

段描述符的低32位分为两部分,前16位用来存储段的段界限的前0~15位,后16位用来存储段基址的0~15位。主要的属性都在段描述符的高32位。

- 0~7位是段基址的16~23,24~31位是段基址的24~31位,加上在段描述符低32位中的段基址0~15位,这下32位基地址才算齐全了。

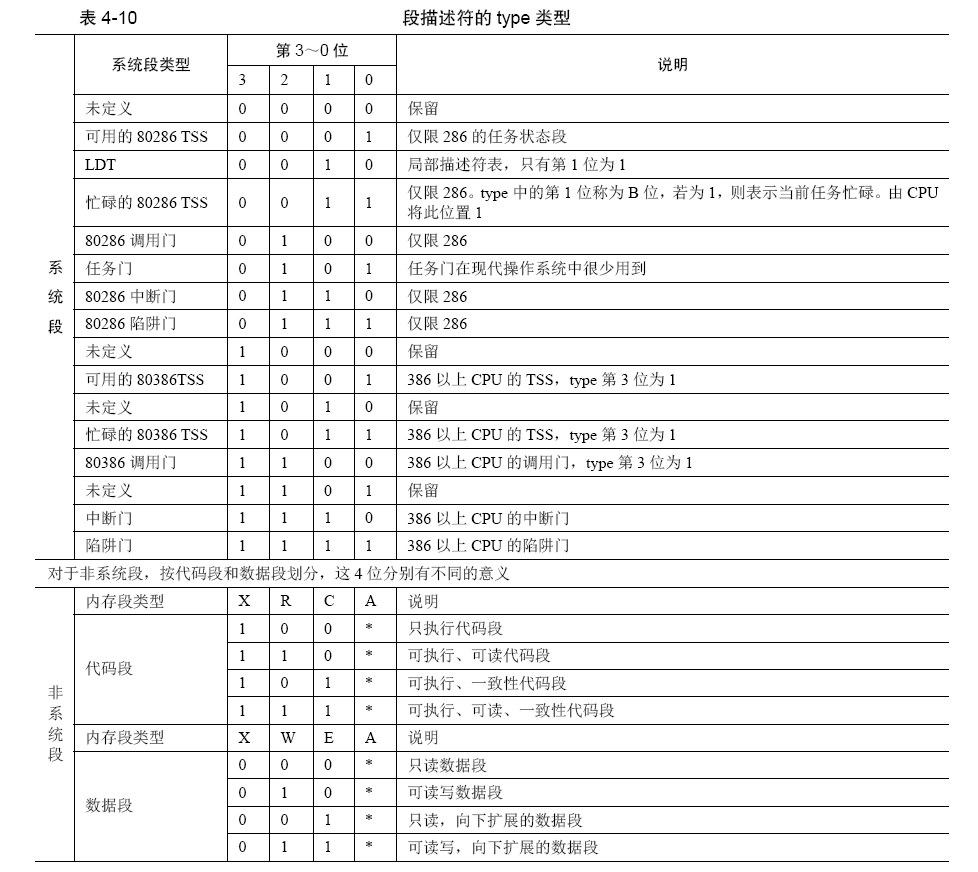

- 8~11 位是type字段,共4位,用来指定本描述符的类型。

- 一个段描述符,分为系统段/数据段,这是由段描述符中的S位决定的,用它指示是否是系统段。S为0时表示系统段,S为1时表示数据段。

- type字段是要和S字段配合在一起才能确定段描述符的确切类型

- 称为“门”的结构便是系统段,也就是硬件系统需要的结构。门的意思就是入口,它通往一段程序。

- 该字段共4 位,用于表示内存段或门的子类型。

- 表中的 A 位表示Accessed位,这是由CPU来设置的,每当该段被CPU访问过后,CPU 就将此位置1。

- C 表示一致性代码段,也称为依从代码段。一致性代码段是指如果自己是转移的目标段,并且自己是一致性代码段,自己的特权级一定要高于当前特权级,转移后的特权级不与自己的DPL 为主,而是与转移前的低特权级一致,也就是听从、依从转移前的低特权级。C 为1 时则表示该段是一致性代码段,C 为0 时则表示该段为非一致性代码段。

- R 表示可读,R 为1 表示可读,R 为0 表示不可读。这个属性一般用来限制代码段的访问。如果指令执行过程中,CPU 发现某些指令对R 为0 的段进行访问,如使用段超越前缀CS 来访问代码段,CPU 将抛出异常。

- X 表示该段是否可执行,EXecutable。我们所说的指令和数据,在CPU 眼中是没有任何区别的,都是010101 这样类似的二进制。所以要用type 中的X 位来标识出是否是可执行的代码。代码段是可执行的,即X 为1。而数据段是不可执行的,即X 为0。

- E 是用来标识段的扩展方向,Extend。E 为0 表示向上扩展,即地址越来越高,通常用于代码段和数据段。E 为1 表示向下扩展,地址越来越低,通常用于栈段。

W 是指段是否可写,Writable。W 为1 表示可写,通常用于数据段。W 为0表示不可写入,通常用于代码段。对于W 为0 的段有写入行为,同样会引发CPU 抛出异常。

段描述符的第12位是S字段,用来指出当前描述符是否是系统段。S为0表示系统段,S为1表示非系统段。

- 段描述符的第13~14位是DPL字段,Descriptor Privilege Level,即描述符特权级,这是保护模式提供的安全解决方案,将计算机世界按权力划分成不同等级,每一种等级称为一种特权级。由于段描述符用来描述一个内存段或一段代码的情况(若描述符类型为“门”),所以描述符中的DPL是指所代表的内存段的特权级。

- 这两位能表示4 种特权级,分别是0、1、2、3 级特权,数字越小,特权级越大。

- 某些指令只能在0 特权级下执行,从而保证了安全。

- 段描述符的第15 位是P 字段,Present,即段是否存在。如果段存在于内存中,P 为1,否则P 为0。P 字段是由CPU 来检查的,如果为0,CPU 将抛出异常。

- 段描述符的第 20 位为AVL 字段,从名字上看它是AVaiLable,可用的。不过这“可用的”是对用户来说的,也就是操作系统可以随意用此位。

- 段描述符的第21 位为L 字段,用来设置是否是64 位代码段。L 为1 表示64 位代码段,否则表示32位代码段。

- 段描述符的第22 位是D/B字段,用来指示有效地址(段内偏移地址)及操作数的大小。与指令相关的内存段是代码段和栈段,所以此字段是D 或B。

- 对于代码段来说,此位是D 位,若D为0,表示指令中的有效地址和操作数是16位,指令有效地址用IP寄存器。

- 若D为1,表示指令中的有效地址及操作数是32 位,指令有效地址用EIP 寄存器。

- 对于栈段来说,此位是B 位,用来指定操作数大小,若B为0用sp寄存器;若B为1用esp寄存器。

- 段描述符的第23位是G 字段,Granularity,粒度,用来指定段界限的单位大小。所以此位是用来配合段界限的。

- 若G为0,表示段界限的单位是1 字节,这样段最大是2的20次方*1字节,即1MB。

- 若G为1,表示段界限的单位是4KB,这样段最大是2 的20次方*4KB字节,即4GB。

全局描述符表GDT、局部描述符表LDT 及选择子

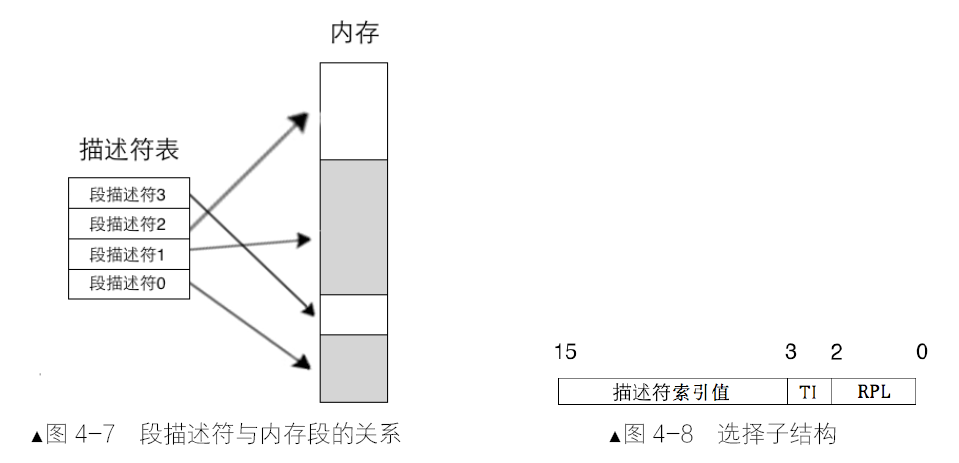

一个段描述符只用来描述一个内存段。代码段要占用一个段描述符、数据段和栈段等,多个内存段也要各自占用一个段描述符,放在全局描述符表,它相当于是描述符的数组,数组中的每个元素都是8 字节的描述符。可以用选择子(马上会讲到)中提供的下标在GDT中索引描述符。

全局描述符表位于内存中,需要用专门的寄存器指向它后,CPU 才知道它在哪里。这个专门的寄存器便是GDTR,即GDT Register,专门用来存储GDT 的内存地址及大小。GDTR 是个48位的寄存器。lgdt为gdtr初始化。

为了进入保护模式才讲述lgdt,因此看上去此指令是在实模式下执行的,但实际上,此指令在保护模式下也能够执行。言外之意便是进入保护模式需要有GDT,但进入保护模式后,还可以再重新换个GDT 加载。在保护模式下重新换个GDT 的原因是实模式下只能访问低端1MB空间,所以GDT只能位于1MB之内。在进入保护模式后,访问的内存空间突破了1MB,可以将GDT 放在合适的位置后再重新加载进来。

lgdt的指令格式是:lgdt 48位内存数据。这 48 位内存数据划分为两部分,其中前16位是GDT以字节为单位的界限值,所以这16位相当于GDT的字节大小减1。后32位是GDT的起始地址。由于GDT的大小是16位二进制,其表示的范围是2

的16次方等于65536字节。每个描述符大小是8字节,GDT中最多可容纳的描述符数量是65536/8=8192个,即GDT 中可容纳8192 个段或门。

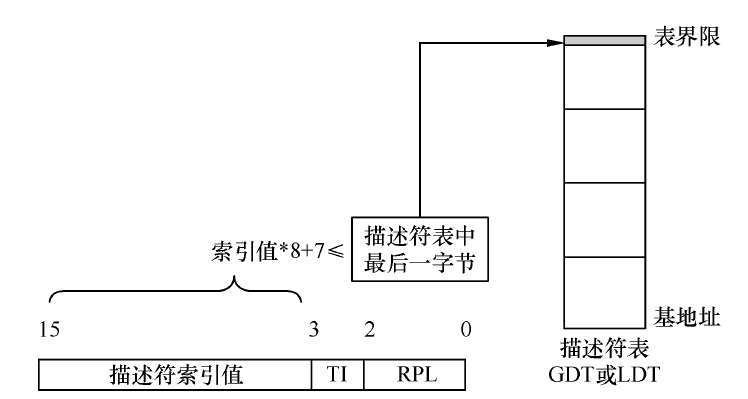

段寄存器 CS、DS、ES、FS、GS、SS,在实模式下时,段中存储的是段基地址,即内存段的起始地址。而在保护模式下时,由于段基址已经存入了段描述符中,所以段寄存器中再存放段基址是没有意义的,在段寄存器中存入的是一个叫作选择子的东西。用此索引值在段描述符表中索引相应的段描述符,这样,便在段描述符中得到了内存段的起始地址和段界限值等相关信息。

由于段寄存器是16位,所以选择子也是16位:

- 在其低2位即第0~1位,用来存储RPL,即请求特权级,可以表示0、1、2、3 四种特权级。

- 在选择子的第2位是TI位,即Table Indicator,用来指示选择子是在GDT中,还是LDT中。

- 选择子的高13 位,即第3~15 位是描述符的索引值,用此值在GDT中索引描述符。前面说过GDT相当于一个描述符数组,所以此选择子中的索引值就是GDT 中的下标

选择子的作用主要是确定段描述符,确定描述符的目的,一是为了特权级、界限等安全考虑,最主要的还是要确定段的基地址。

保护模式下的段寄存器中已经是选择子,不再是直接的段基址。段基址在段描述符中,用给出的选择子索引到描述符后,CPU 自动从段描述符中取出段基址,这样再加上段内偏移地址,便凑成了“段基址:段内偏移地址”的形式。

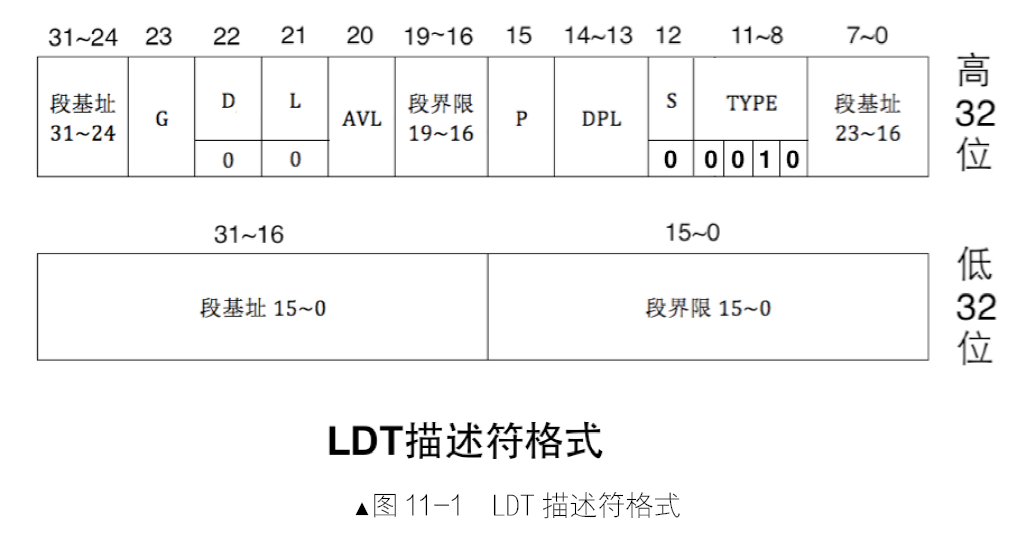

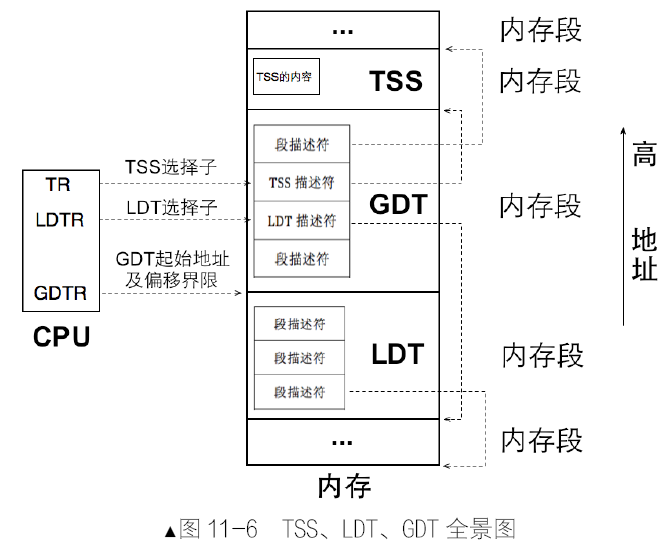

局部描述符表,叫LDT,Local Descriptor Table,它是CPU厂商为在硬件一级原生支持多任务而创造的表,按照CPU 的设想,一个任务对应一个LDT。LDT 也位于内存中,其地址需要先被加载到某个寄存器后,CPU 才能使用LDT,该寄存器是LDTR,即LDT Register。同样也有专门的指令用于加载LDT,即lldt。以后每切换任务时,都要用lldt 指令重新加载任务的私有内存段。

段描述符是需要用选择子去访问的。故,lldt 的指令格式为:lldt 16 位寄存器/16 位内存,无论是寄存器,还是内存,其内容一定是个选择子,该选择子用来在GDT 中索引LDT 的段描述符。

实模式下寄存器都是16位的,如果段基址和段内偏移地址都为16位的最大值,即0xFFFF:0xFFFF,最大地址是0xFFFF0+0xFFFF,即0x10FFEF。由于实模式下的地址线是20位,最大寻址空间0x00000~0xFFFFF。超出1MB内存的部分在逻辑上也是正常的,将超过1MB 的部分自动回绕到0地址,继续从0地址开始映射。相当于把地址对1MB 求模。超过1MB 多余出来的内存被称为高端内存区HMA。

地址(Address)线从0开始编号,在8086/8088 中,20 位地址线表示的内存是2 的20 次方即0x0~0xFFFFF。若地址进位到1MB 以上,如0x100000,由于没有第21 位地址线,相当于丢掉了进位1,变成了0x00000。用某根输出线来控制第21 根地址线(A20)的有效性,故被称为A20Gate。

- 如果 A20Gate 被打开,当访问到0x100000~0x10FFEF 之间的地址时,CPU 将真正访问这块物理内存。

- 如果 A20Gate 被禁止,当访问0x100000~0x10FFEF 之间的地址时,CPU 将采用8086/8088 的地址回绕。

其实打开A20Gate 的方式是极其简单的,将端口0x92 的第1 位置1 就可以了:1

2

3in al,0x92

or al,0000_0010B

out 0x92,al

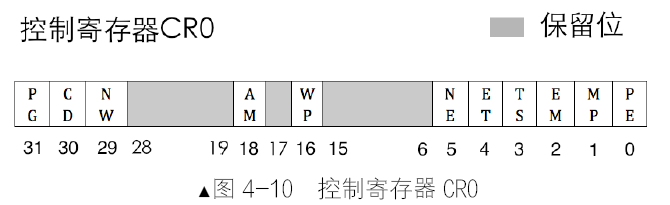

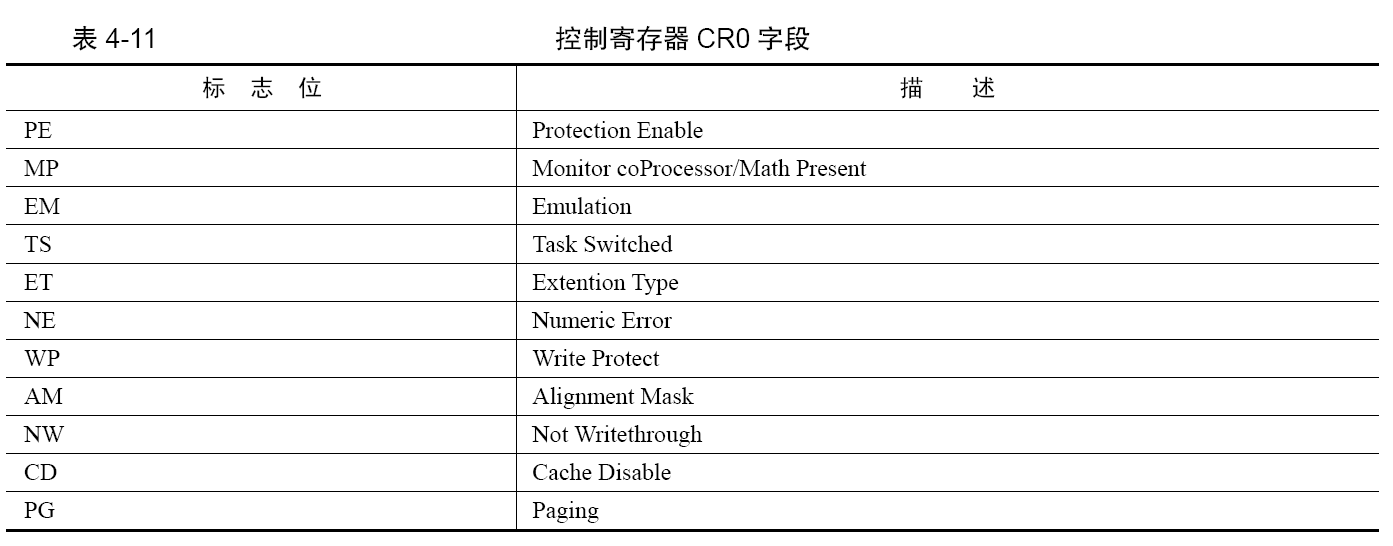

保护模式的开关,CR0 寄存器的PE 位

控制寄存器是CPU 的窗口,既可以用来展示CPU的内部状态,也可用于控制CPU 的运行机制。这次我们要用到的是CR0 寄存器。更准确地说,我们要用到CR0寄存器的第0 位,即PE 位,Protection Enable,此位用于启用保护模式,是保护模式的开关。

处理器微架构简介

流水线

乱序执行

乱序执行,是指在CPU 中运行的指令并不按照代码中的顺序执行,而是按照一定的策略打乱顺序执行,也许后面的指令先执行,当然,得保证指令之间不具备相关性。

x86 发展到后来,虽然还是CISC 指令集,但其内部已经采用RISC 内核,译码对于x86 体系来说,除了按照指令格式分析机器码外,还要将CISC 指令分解成多个RISC 指令。当一个“大”操作被分解成多个“微”操作时,它们之间通常独立无关联,所以非常适合乱序执行。

缓存

根据程序的局部性原理采取缓存策略。

分支预测

对于无条件跳转,直接跳过去就是了。所谓的预测是针对有条件跳转来说的,因为不知道条件成不成立。最简单的统计是根据上一次跳转的结果来预测本次,如果上一次跳转啦,这一次也预测为跳转,否则不跳。

最简单的方法是2 位预测法。用2 位bit 的计数器来记录跳转状态,每跳转一次就加1,直到加到最大值3 就不再加啦,如果未跳转就减1,直到减到最小值0 就不再减了。当遇到跳转指令时,如果计数器的值大于1 则跳转,如果小于等于1 则不跳。

Intel 的分支预测部件中用了分支目标缓冲器(Branch Target Buffer,BTB)。

BTB 中记录着分支指令地址,CPU 遇到分支指令时,先用分支指令的地址在BTB 中查找,若找到相同地址的指令,根据跳转统计信息判断是否把相应的预测分支地址上的指令送上流水线。在真正执行时,根据实际分支流向,更新BTB 中跳转统计信息。

如果 BTB 中没有相同记录该怎么办呢?这时候可以使用Static Predictor,静态预测器,存储在里面的预测策略是固定写死的。比如,转移目标的地址若小于当前转移指令的地址,则认为转移会发生。静态预测器的策略是:若向上跳转则转移会发生,若向下跳转则转移不发生。

如果分支预测错了,也就是说,当前指令执行结果与预测的结果不同,需要将流水线清空。因为处于执行阶段的是当前指令,即分支跳转指令。处于“译码”“取指”的是尚未执行的指令,即错误分支上的指令。

使用远跳转指令清空流水线,更新段描述符缓冲寄存器

段描述符缓冲寄存器在CPU 的实模式和保护模式中都同时使用,在不重新引用一个段时,段描述符缓冲寄存器中的内容是不会更新的,无论是在实模式,还是保护模式下,CPU 都以段描述符缓冲寄存器中的内容为主。实模式进入保护模式时,由于段描述符缓冲寄存器中的内容仅仅是实模式下的20 位的段基址,很多属性位都是错误的值,这对保护模式来说必然会造成错误,所以需要马上更新段描述符缓冲寄存器,也就是要想办法往相应段寄存器中加载选择子。

CPU 为了提高效率而采用了流水线,这样,指令间是重叠执行的。某一行之前的指令都是16 位指令,自此行之后,CPU 便进入了保护模式,但它依然还是16 位的指令,相当于处于16 位保护模式下。为了让其使用32 位偏移地址,所以添加了伪指

令dword,故其机器码前会加0x66 反转前缀。

流水线的工作是这样的:在16位指令代码执行的同时,32位指令及其之后的部分指令已经被送上流水线了,但是,段描述符缓冲寄存器在实模式下时已经在使用了,其低20位是段基址,但其他位默认为0,也就是描述符中的D 位为0,这表示当前的操作数大小是16 位。流水线上的指令全是按照16 位操作数来译码的,所以需要加入一个无条件跳转指令。综上所述,解决问题的关键就是既要改变代码段描述符缓冲寄存器的值,又要清空流水线。

代码段寄存器cs,只有用远过程调用指令call、远转移指令jmp、远返回指令retf 等指令间接改变,没有直接改变cs 的方法,如直接mov cs,xx 是不行的。另外,之前介绍过了流水线原理,CPU 遇到jmp指令时,之前已经送上流水线上的指令只有清空,所以jmp 指令有清空流水线的神奇功效。

保护模式之内存段的保护

向段寄存器加载选择子时的保护

当引用一个内存段时,实际上就是往段寄存器中加载选择子,为了避免出现非法引用内存段的情况,在这时候,处理器会在以下几方面做出检查。

首先根据选择子的值验证段描述符是否超越界限。选择子的高13位是段描述符的索引值,第0~1位是RPL,第2 位是TI 位。首先选择子的索引值一定要小于等于描述符表(GDT 或LDT)中描述符的个数。在往段寄存器中加载选择子时,处理器要求选择子中的索引值要满足下面表达式:描述符表基地址+选择子中的索引值*8+7 <=描述符表基地址+描述符表界限值。

检查过程如下:处理器先检查TI 的值,如果TI 是0,则从全局描述符表寄存器gdtr 中拿到GDT基地址和GDT 界限值。如果TI 是1,则从局部描述符表寄存器ldtr 中拿到LDT 基地址和LDT 界限值。有了描述符表基地址和描述符表界限值后,把选择子的高13 位代入上面的表达式,若不成立,处理器则抛出异常。

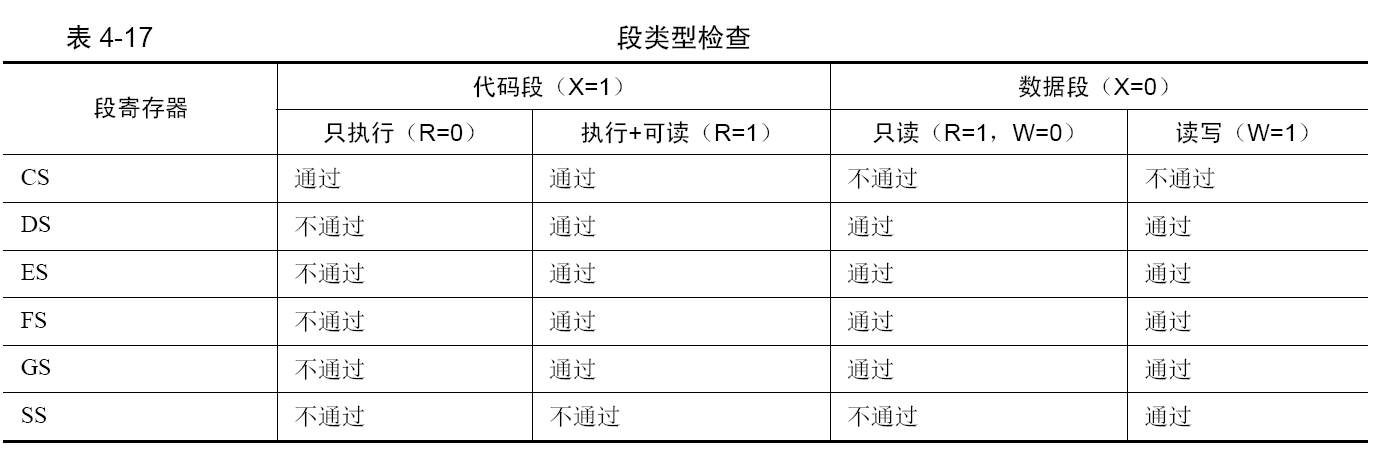

段描述符中还有个type 字段,这用来表示段的类型,也就是不同的段有不同的作用。在选择子检查过后,就要检查段的类型了。这里主要是检查段寄存器的用途和段类型是否匹配。大的原则如下。

- 只有具备可执行属性的段(代码段)才能加载到 CS 段寄存器中。

- 只具备执行属性的段(代码段)不允许加载到除 CS 外的段寄存器中。

- 只有具备可写属性的段(数据段)才能加载到 SS 栈段寄存器中。

- 至少具备可读属性的段才能加载到 DS、ES、FS、GS 段寄存器中。

- 如果 CPU 发现有任意上述规则不符,检查就不会通过。

检查完 type 后,还会再检查段是否存在。CPU 通过段描述符中的P 位来确认内存段是否存在,如果P 位为1,则表示存在,这时候就可以将选择子载入段寄存器了,同时段描述符缓冲寄存器也会更新为选择子对应的段描述符的内容,随后处理器将段描述符中的A 位置为1,表示已经访问过了。如果P 位为0,则表示该内存段不存在,不存在的原因可能是由于内存不足,操作系统将该段移出内存转储到硬盘上了。这时候处理器会抛出异常,自动转去执行相应的异常处理程序,异常处理程序将段从硬盘加载到内存后并将P 位置为1,随后返回。CPU 继续执行刚才的操作,判断P 位。

代码段和数据段的保护

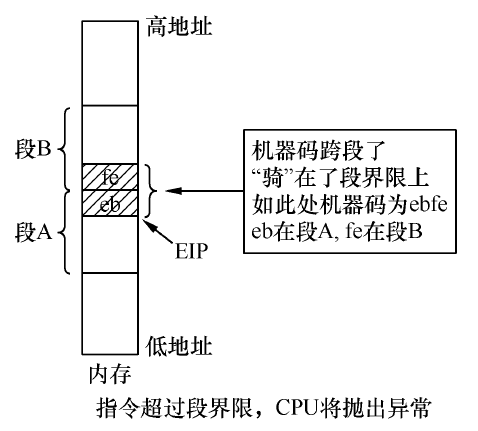

代码段既然也是内存中的区域,所以对于代码段的访问也要用“段基址:段内偏移地址”的形式,在32 位保护模式下,段基址存放在CS 寄存器中,段内偏移地址,即有效地址,存放在EIP 寄存器中。CS:EIP 只是指令的起始地址,指令本身也是有长度的,之前我们见过各种各样的机器码,它们的长度有2 字节的、3 字节的等,如jmp .-2,其机器码为ebfe,大小就是2 字节。CPU 得确保指令“完全、完整”地任意一部分都在当前的代码段内,也就是要满足以下条件:

- EIP 中的偏移地址+指令长度-1≤实际段界限大小

- 如果不满足条件,指令未完整地落在本段内,CPU 则会抛出异常。

数据地址也要遵循此原则:偏移地址+数据长度-1≤实际段界限大小。

栈段的保护

虽然段描述符type 中的e 位用来表示段的扩展方向,但它和别的描述符属性一样,仅仅是用来描述段的性质,即使e 等于1 向下扩展,依然可以引用不断向上递增的内存地址,即使e 等于0 向上扩展,也依然可以引用不断向下递减的内存地址。栈顶指针[e]sp 的值逐渐降低,这是push 指令的作用,与描述符是否向下扩展无关,也就是说,是数据段就可以用作栈。

CPU 对数据段的检查,其中一项就是看地址是否超越段界限。如果将向上扩展的数据段用作栈,那CPU 将按照上一节提到的数据段的方式检查该段。如果用向下扩展的段做栈的话,情况有点复杂,这体现在段界限的意义上。

- 对于向上扩展的段,实际的段界限是段内可以访问的最后一字节。

- 对于向下扩展的段,实际的段界限是段内不可以访问的第一个字节。

栈的段界限是以栈段的基址为基准的,并不是以栈底,因此栈的段界限肯定是位于栈顶之下。地址本身由低向高发展,段界限也是个地址,而栈的扩展方向是由高地址向低地址,与段界限有个碰撞的趋势。为了避免碰撞,将段界限地址+1 视为栈可以访问的下限。段界限+1,才是栈指针可达的下边界。

32 位保护模式下栈的栈顶指针是esp 寄存器,栈的操作数大小是由B 位决定的,我们这里假设B 为1,即操作数是32 位。栈段也是位于内存中,所以它也要受控于段描述符中的G 位。

- 如果 G 为0,

实际的段界限大小=描述符中的段界限。 - 如果 G 为1,

实际的段界限大小=描述符中段界限*0x1000+0xFFF。

同代码段的操作数一样,用于压栈的操作数也有其长度,push 指令每向栈中压入操作数时,实际上就是将esp 指针减去操作数的大小(2 字节或4 字节)后,再将操作数复制到esp 减4 后的新地址。栈指针可访问的最低地址是由实际段界限决定的,但栈段最大可访问的地址是由B 位决定的,我们这里B 位为1,表示32 位操作数,所以栈指针最大可访问地址是0xFFFFFFFF。综上所述,每次向栈中压入数据时就是CPU 检查栈段的时机,它要求必须满足以下条件。

- 实际段界限+1≤esp-操作数大小≤ 0xFFFFFFFF

- 假设现在esp 指针为0xFFFFE002,段描述符的G 位为1,描述符中的段界限为0xFFFFD。故实际段界限为0x1000*FFFFD+0xFFF=0xFFFFDFFF。当执行push ax,压入2 字节的操作数,即esp-2=0xFFFFE000,新的esp 值≥实际段界限0xFFFFDFFF +1。如果执行push eax,压入4 字节的数据,esp-4=0xFFFFDFFE,小于实际段界限0xFFFFDFFF,故CPU 会抛出异常。

- 由于 esp 只是栈段内的偏移地址,其真正物理地址还要加上段基址。假设段基址为0,故该栈段:

- 最大可访问地址为 0+0xFFFFFFFF=0xFFFFFFFF。

- 最小可访问地址为 0+0xFFFFDFFF+1=0xFFFFE000。

- 栈段空间大小为 0xFFFFFFFF-0xFFFFE000=8KB。

保护模式进阶,向内核迈进

获取物理内存容量

在Linux 中有多种方法获取内存容量,如果一种方法失败,就会试用其他方法。比如在Linux 2.6 内核中,是用detect_memory函数来获取内存容量的。其函数在本质上是通过调用BIOS中断0x15 实现的,分别是BIOS 中断0x15 的3 个子功能,子功能号要存放到寄存器EAX 或AX 中,如下。

EAX=0xE820:遍历主机上全部内存。AX=0xE801:分别检测低 15MB 和16MB~4GB 的内存,最大支持4GB。AH=0x88:最多检测出64MB 内存,实际内存超过此容量也按照64MB 返回。

BIOS 中断是实模式下的方法,只能在进入保护模式前调用。获取内存信息,其内部是通过连续调用硬件的应用程序接口来获取内存信息的。BIOS 0x15 中断提供了丰富的功能,具体要调用的功能,需要在寄存器ax 中指定。其中0xE8xx系列的子功能较为强大,0x15 中断的子功能0xE820 和0xE801 都可以用来获取内存,区别是0xE820 返回的是内存布局;而0xE801 直接返回的是内存容量。

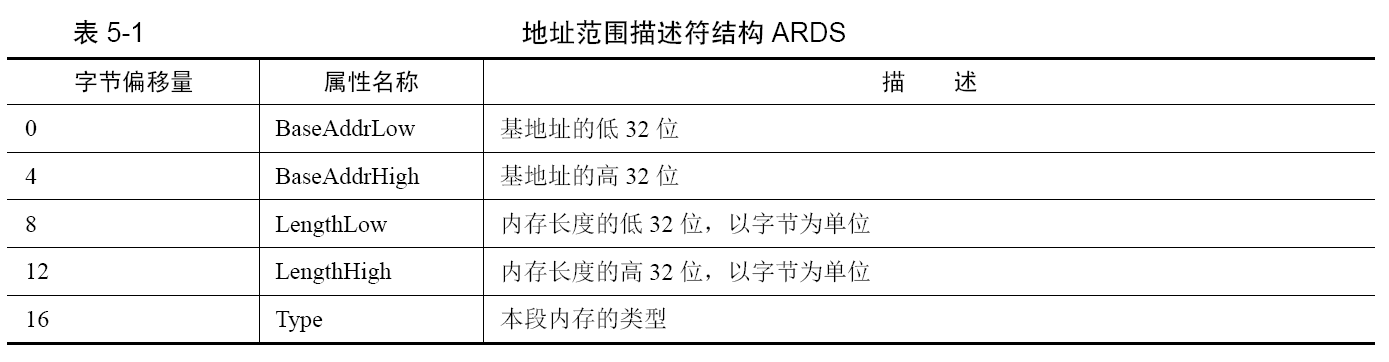

BIOS 中断 0x15 的子功能0xE820 能够获取系统的内存布局,BIOS按照类型属性来划分这片系统内存,所以这种查询呈迭代式,每次BIOS 只返回一种类型的内存信息,直到将所有内存类型返回完毕。子功能0xE820 的强大之处是返回的内存信息较丰富,包括多个属性字段,内存信息的内容是用地址范围描述符来描述的,用于存储这种描述符的结构称之为地址范围描述符ARDS。。每次int 0x15 之后,BIOS就返回这样一个20个字节的数据。

其中的 Type 字段用来描述这段内存的类型,这里所谓的类型是说明这段内存的用途:

- AddressRangeMemory 这段内存可以被操作系统使用

- AddressRangeReserved 内存使用中或者被系统保留,操作系统不可以用此内存

- 其他 将来会用到,目前保留。

BIOS 中断只是一段函数例程,调用它就要为其提供参数:

- 调用前输入

- EAX 子功能号:EAX 寄存器用来指定子功能号,此处输入为0xE820

- EBX ARDS 后续值:内存信息需要按类型分多次返回,由于每次执行一次中断都只返回一种类型内存的ARDS 结构,所以要记录下一个待返回的内存ARDS,在下一次中断调用时通过此值告诉BIOS 该返回哪个ARDS,这就是后续值的作用。第一次调用时一定要置为0,EBX具体值我们不用关注,字取决于具体BIOS 的实现。每次中断返回后,BIOS 会更新此值

- ES:DI ARDS缓冲区:BIOS 将获取到的内存信息写入此寄存器指向的内存,每次都以ARDS 格式返回

- ECX ARDS 结构的字节大小:用来指示BIOS 写入的字节数。调用者和BIOS 都同时支持的大小是20 字节,将来也许会扩展此结构

- EDX 固定为签名标记0x534d4150,此十六进制数字是字符串SMAP 的ASCII 码:BIOS 将调用者正在请求的内存信息写入ES:DI 寄存器所指向的ARDS 缓冲区后,再用此签名校验其中的信息

- 返回后输出:

- CF 位若 CF 位为0 表示调用未出错,CF 为1,表示调用出错

- EAX 字符串SMAP 的ASCII 码0x534d4150

- ES:DI ARDS 缓冲区地址,同输入值是一样的,返回时此结构中已经被BIOS 填充了内存信息

- CX BIOS 写入到ES:DI 所指向的ARDS 结构中的字节数,BIOS 最小写入20 字节

- EBX 后续值:下一个ARDS 的位置。每次中断返回后,BIOS 会更新此值,BIOS 通过此值可以找到下一个待返回的ARDS 结构,咱们不需要改变EBX 的值,下一次中断调用时还会用到它。在CF 位为0 的情况下,若返回后的EBX 值为0,表示这是最后一个ARDS 结构

另一个获取内存容量的方法是BIOS0x15 中断的子功能0xE801。此方法最大只能识别4GB内存,此方法检测到的内存是分别存放到两组寄存器中的。低于15MB 的内存以1KB 为单位大小来记录,单位数量在寄存器AX 和CX 中记录,所以15MB 空间以下的实际内存容量=AX*1024。AX、CX 最大值为0x3c00,即0x3c00*1024=15MB。16MB~4GB是以64KB 为单位大小来记录的,单位数量在寄存器BX 和DX 中记录,所以16MB 以上空间的内存实际大小=BX*64*1024。

- 调用前输入

- AX:Function Code,子功能号:0xE801

- CF位:Carry Flag, 若CF 位为0 表示调用未出错,CF 为1,表示调用出错

- AX:Extended 1, 以1KB 为单位,只显示15MB 以下的内存容量,故最大值为0x3c00,即AX 表示的最大内存为0x3c00*1024=15MB

- BX: Extended 2, 以64KB 为单位,内存空间16MB~4GB 中连续的单位数量,即内存大小为BX641024 字节

- CX: Configured 1, 同AX

- 返回后输出

- DX: Configured 2, 同BX

最后一个获取内存的方法也同样是BIOS 0x15 中断,子功能号是0x88。该方法简单到只能识别最大64MB 的内存。即使内存容量大于64MB,也只会显示63MB,只会显示1MB之上的内存,不包括这1MB。

启用内存分页机制,畅游虚拟空间

CPU 在引用一个段时,都要先查看段描述符。CPU 允许在描述符表中已注册的段不在内存中存在,这就是它提供给软件使用的策略,我们利用它实现段式内存管理。

- 如果该描述符中的P 位为1,表示该段在内存中存在。访问过该段后,CPU 将段描述符中的A 位置1,表示近来刚访问过该段。

- 相反,如果P 位为0,说明内存中并不存在该段,CPU将会抛出异常,转而去执行中断处理程序将相应的段从外存中载入到内存,并将段描述符的P 位置1,中断处理函数结束后返回,CPU 重复执行这个检查,继续查看该段描述符的P 位,此时已经为1 了,在检查通过后,将段描述符的A 位置1。

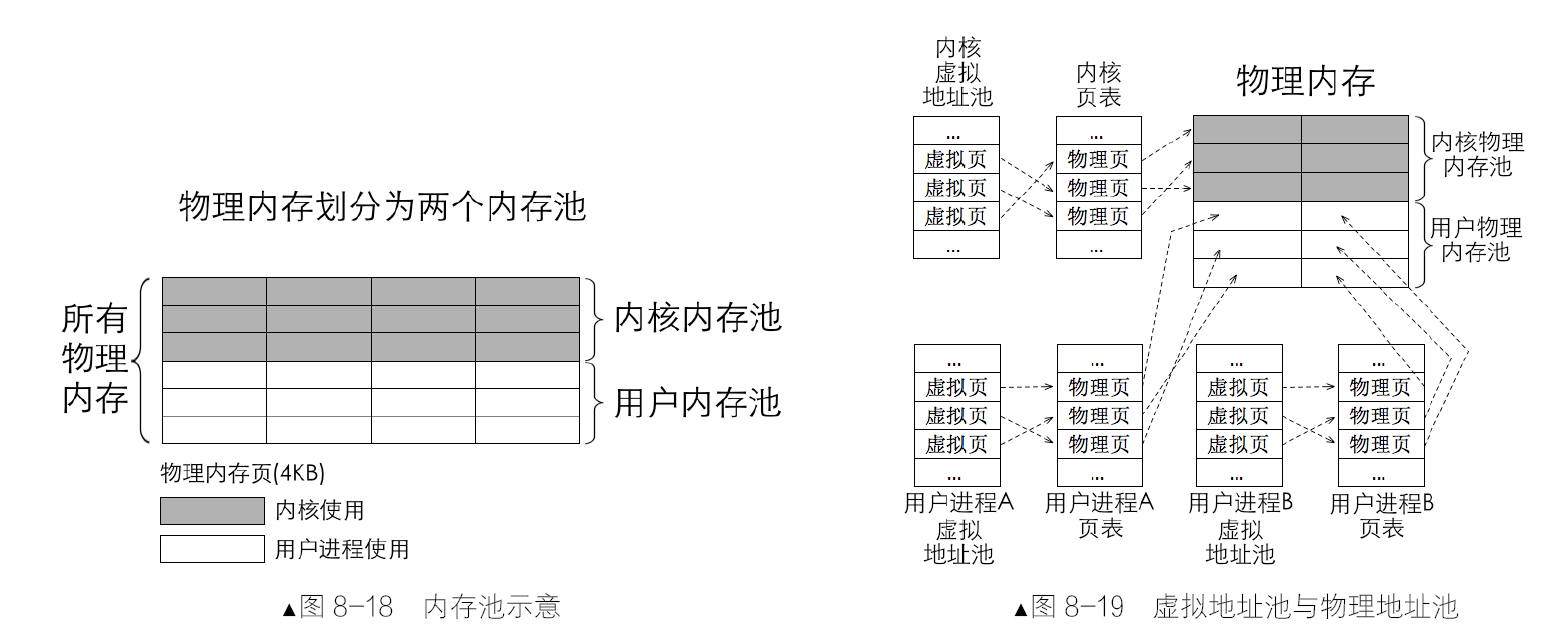

首先要做的是解除线性地址与物理地址一一对应的关系,然后将它们的关系重新建立。通过某种映射关系,可以将线性地址映射到任意物理地址。对于地址转换这种实时性较高的需求,通过一张表来实现,该表就是我们所说的页表。

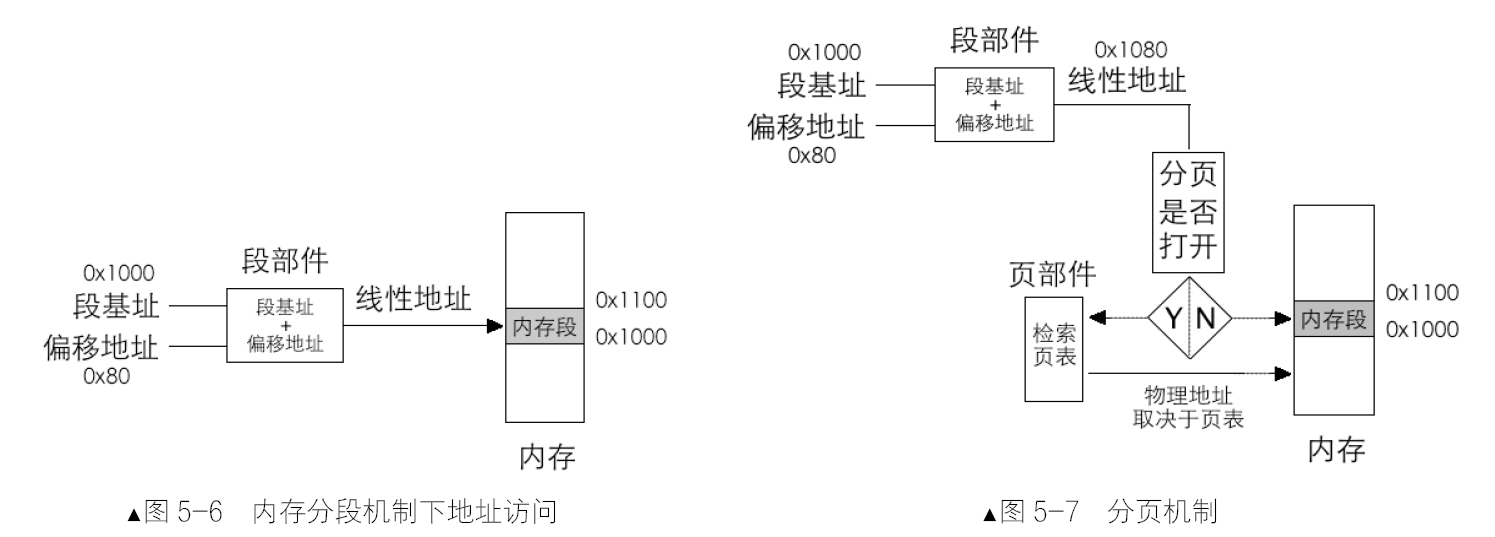

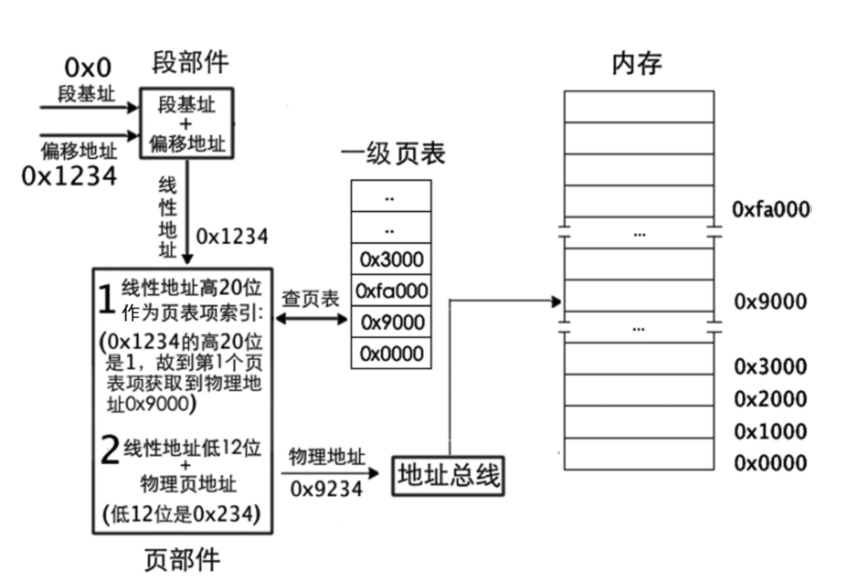

将段基址和段内偏移地址相加求和的工作是由CPU 的段部件自动完成的。整个访问内存的过程如图5-6 所示。分页机制要建立在分段机制的基础上。图 5-7 说明,CPU 在不打开分页机制的情况下,是按照默认的分段方式进行的,段基址和段内偏移地址经过段部件处理后所输出的线性地址,CPU 就认为是物理地址。如果打开了分页机制,段部件输出的线性地址就不再等同于物理地址了,我们称之为虚拟地址,CPU 必须要拿到物理地址才行,此虚拟地址对应的物理地址需要在页表中查找,这项查找工作是由页部件自动完成的。

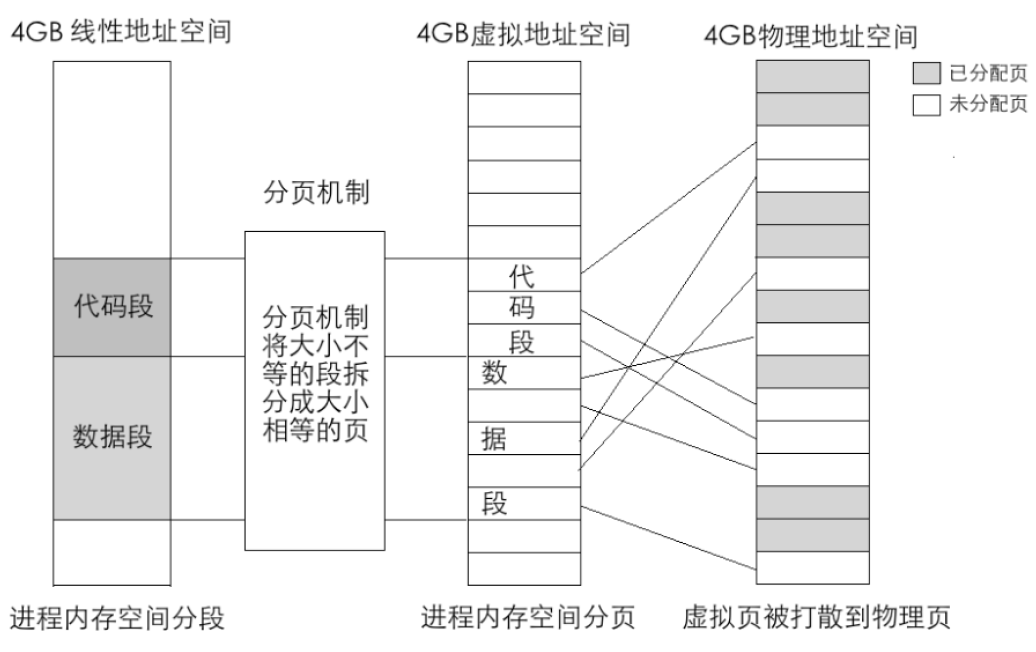

分页机制的思想是:通过映射,可以使连续的线性地址与任意物理内存地址相关联,逻辑上连续的线性地址其对应的物理地址可以不连续。分页机制的作用有两方面。

- 将线性地址转换成物理地址。

- 用大小相等的页代替大小不等的段。

上图表示的是一个进程的地址转换过程,从线性空间到虚拟空间再到物理地址空间,每个空间大小都是4GB。图上的4GB 物理地址空间属于所有进程包括操作系统在内的共享资源,其中标注为已分配页的内存块被分配给了其他进程,当前进程只能使用未分配页。此转换过程对任意一个进程都是一样的,也就是说,每个进程都有自己的4GB 虚拟空间。

在分页机制下,分配情形如图中所示的虚拟地址空间中的代码段和数据段。代码段和数据段在逻辑上被拆分成以页为单位的小内存块。这时的虚拟地址虚如其名,不能存放任何数据。接着操作系统开始为这些虚拟内存页分配真实的物理内存页,它查找物理内存中可用的页,然后在页表中登记这些物理页地址,这样就完成了虚拟页到物理页的映射,每个进程都以为自己独享4GB 地址空间。

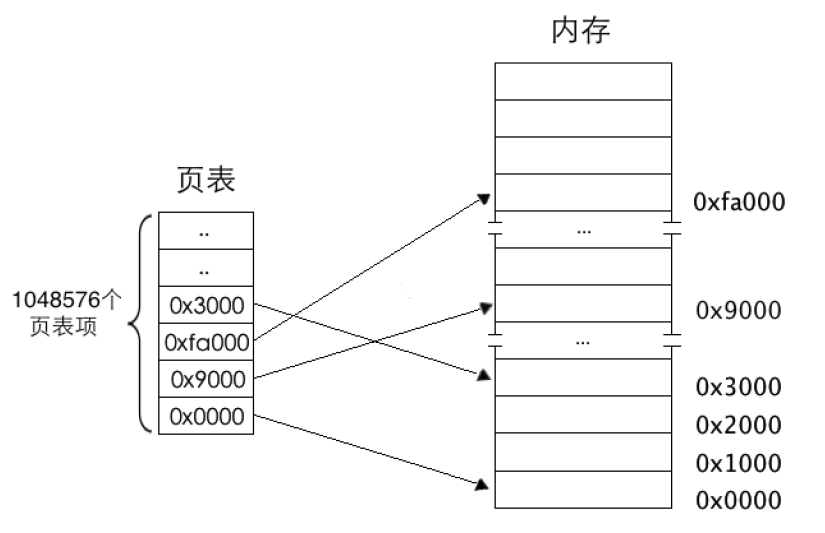

线性地址对应物理地址的这种映射关系需要用页表(Page Table)存储。页表中的每一行(只有一个单元格)称为页表项(Page Table Entry,PTE),其大小是4字节,页表项的作用是存储内存物理地址。当访问一个线性地址时,实际上就是在访问页表项中所记录的物理内存地址。

页是地址空间的计量单位,线性地址的一页也要对应物理地址的一页。一页大小为4KB,这样一来,4GB地址空间被划分成4GB/4KB=1M 个页,也就是4GB 空间中可以容纳1048576 个页,页表中自然也要有1048576个页表项,这就是我们要说的一级页表。

经以上分析,虚拟地址的高20 位可用来定位一个物理页,低12 位可用来在该物理页内寻址。这是如何实现的呢?物理地址写在页表的页表项中,段部件输出的只是线性地址,所以问题就变成了:怎样用线性地址找到页表中对应的页表项。

分页机制打开前要将页表地址加载到控制寄存器cr3中。一个页表项对应一个页,所以,用线性地址的高20 位作为页表项的索引,每个页表项要占用4 字节大小,所以这高20 位的索引乘以4 后才是该页表项相对于页表物理地址的字节偏移量。用cr3 寄存器中的页表物理地址加上此偏移量便是该页表项的物理地址,从该页表项中得到映射的物理页地址,然后用线性地址的低12 位与该物理页地址相加,所得的地址之和便是最终要访问的物理地址。拿mov ax,[0x1234]来说:

段基址为0,段内偏移地址为0x1234,经过段部件处理后,输出的线性地址是0x1234。页部件分析0x1234 的高20 位,用十六进制表示高20 位是0x00001。将此项作为页表项索引,再将该索引乘以4 后加上cr3 寄存器中页表的物理地址,这样便得到索引所指代的页表项的物理地址,从该物理地址处(页表项中)读取所映射的物理页地址:0x9000。线性地址的低12 位是0x234,它作为物理页的页内偏移地址与物理页地址0x9000 相加,和为0x9234,这就是线性地址0x1234 最终转换成的物理地址。

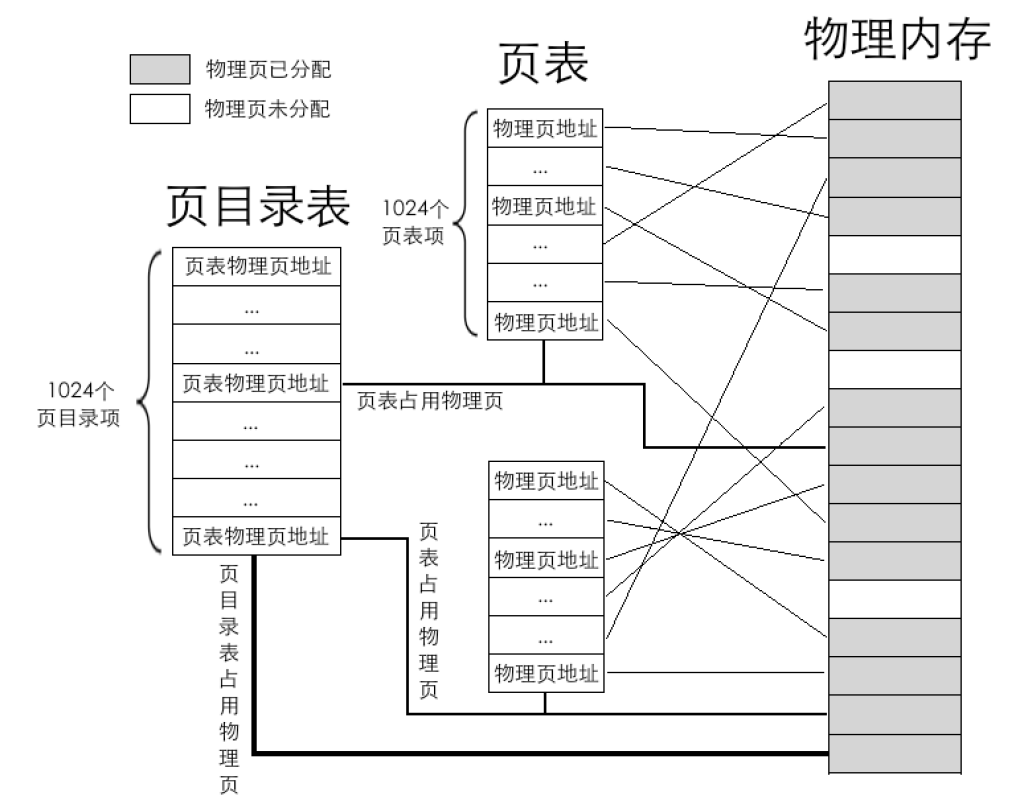

每个页表的物理地址在页目录表中都以页目录项(Page Directory Entry,PDE)的形式存储,页目录项大小同页表项一

样,都用来描述一个物理页的物理地址,其大小都是4字节,而且最多有1024 个页表,所以页目录表也是4KB 大小,同样也是标准页的大小。

页目录表中共1024 个页表,也就是有1024 个页目录项。一个页目录项中记录一个页表物理页地址,物理页地址是指页的物理地址,在页目录项及页表项中记录的都是页的物理地址。每个页表中有1024 个页表项,每个页表项中是一个物理页地址,最终数据写在这页表项中指定的物理页中。图中最粗的线存放页目录表物理页,稍细一点的线指向的是用来存放页表的物理页,其他最细的线是页表项中分配的物理页。

每个页表中可容纳1024个物理页,故每个页表可表示的内存容量是1024*4KB=4MB,所有页表可表示的内存容量是1024*4MB=4GB。页目录中1024 个页表,只需要10 位二进制就能够表示了,所以,虚拟地址的高10 位(第31~22 位)用来在页目录中定位一个页表,也就是这高10 位用于定位页目录中的页目录项PDE,PDE 中有页表物理页地址。由于页表中可容纳1024 个物理页,故只需要10 位二进制就能够表示了。所以虚拟地址的中间10 位(第21~12 位)用来在页表中定位具体的物理页。由于标准页都是4KB,12 位二进制便可以表达4KB 之内的任意地址,故线性地址中余下的12 位(第11~0 位)用于页内偏移量。二级页表地址转换原理是将32 位虚拟地址拆分成高10 位、中间10 位、低12 位三部分,

同一级页表一样,访问任何页表内的数据都要通过物理地址。由于页目录项PDE 和页表项PTE 都是4 字节大小,给出了PDE 和PTE 索引后,还需要在背后悄悄乘以4,再加上页表物理地址,这才是最终要访问的绝对物理地址。转换过程背后的具体步骤如下。

- 用虚拟地址的高10 位乘以4,作为页目录表内的偏移地址,加上页目录表的物理地址,所得的和,便是页目录项的物理地址。读取该页目录项,从中获取到页表的物理地址。

- 用虚拟地址的中间10 位乘以4,作为页表内的偏移地址,加上在第1 步中得到的页表物理地址,所得的和,便是页表项的物理地址。读取该页表项,从中获取到分配的物理页地址。

- 虚拟地址的高10 位和中间10 位分别是PDE 和PTE 的索引值,所以它们需要乘以4。但低12 位就不是索引值啦,其表示的范围是0~0xfff,作为页内偏移最合适,所以虚拟地址的低12 位加上第2 步中得到的物理页地址,所得的和便是最终转换的物理地址。

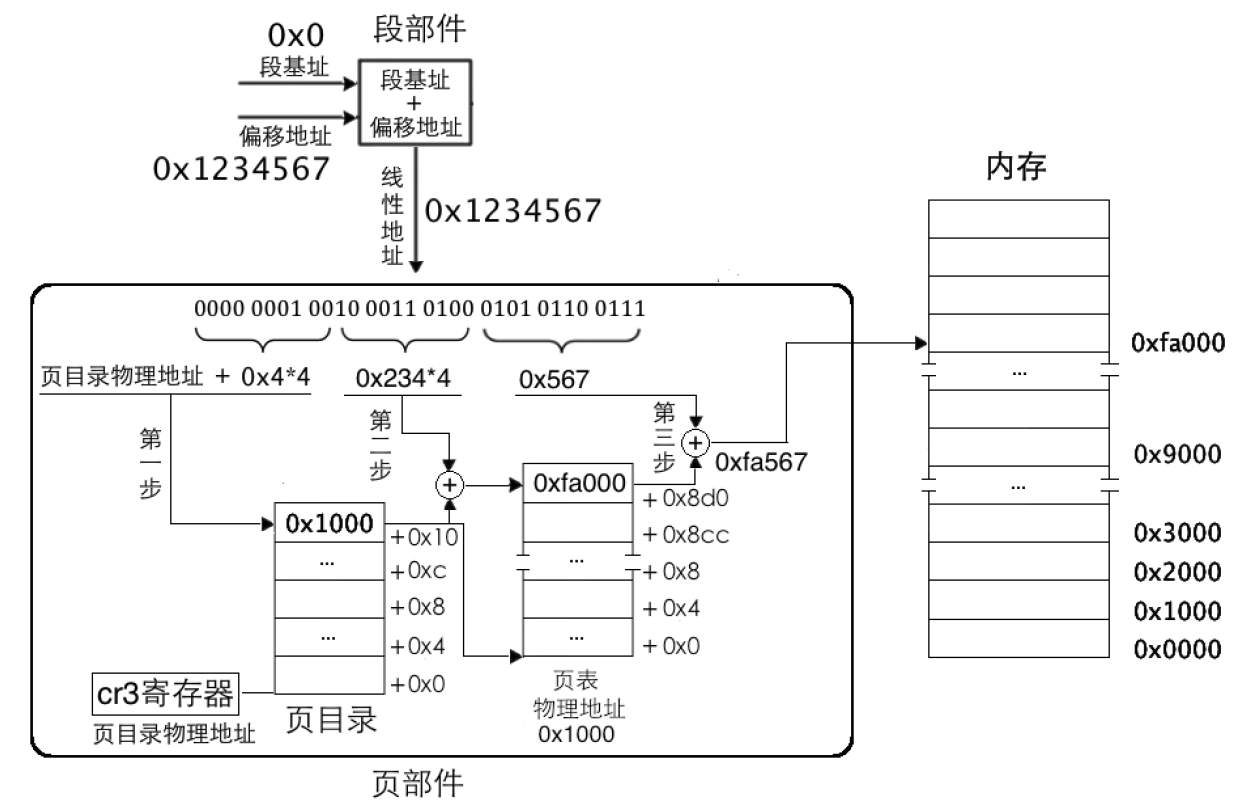

比如 mov ax,[0x1234567]:

指令mov ax,[0x1234567]经过段部件处理,输出的线性地址为0x1234567,页部件首先要把地址拆分成高10位、中间10 位、低12 位三部分。其实低12 位最容易得出,十六进制的每1 位代表4 位二进制,所以低12 位直接就是0x567。

- 高 10 位是0000 0001 00,十六进制为0x4。

- 中间 10 位是10 0011 0100,十六进制为0x234。

低 12 位是0101 0110 0111,十六进制为0x567。

第一步:为了得到页表物理地址,页部件用虚拟地址高 10 位乘以4 的积与页目录表物理地址相加,所得的和便是页目录项地址,读取该页目录项,获取页表物理地址。这里是0x4*4=0x10,页表物理地址存储在cr3寄存器中。要找的页表位于物理地址0x1000。

- 第二步:为了得到具体的物理页,需要找到页表中对应的页表项。页部件用虚拟地址中间 10 位的值乘以4 的积与第一步中得到的页表地址相加,所得的和便是页表项物理地址。这里是

0x234*4=0x8d0,页表项物理地址是0x8d0+0x1000=0x18d0。在该页表项中的值是0xfa000,这意味着分配的物理页地址是0xfa000。 - 第三步:为了得到最终的物理地址,用虚拟地址低12 位作为页内偏移地址与第二步中得到的物理页地址相加,所得的和便是最终的物理地址。这里是

0xfa000+0x567=0xfa567。

页目录项和页表项是4 字节大小,用来存储物理页地址,只有第12~31位才是物理地址,地址的低12位是0,所以只需要记录物理地址高20 位。其他位:

- P,Present,意为存在位。若为1 表示该页存在于物理内存中,若为0 表示该表不在物理内存中。

- RW,Read/Write,意为读写位。若为1 表示可读可写,若为0 表示可读不可写。

- US,User/Supervisor,意为普通用户/超级用户位。若为1 时,表示处于User 级,任意级别(0、1、2、3)特权的程序都可以访问该页。若为0,表示处于Supervisor 级,特权级别为3 的程序不允许访问该页,该页只允许特权级别为0、1、2 的程序可以访问。

- PWT,Page-level Write-Through,意为页级通写位,也称页级写透位。若为1 表示此项采用通写方式,表示该页不仅是普通内存,还是高速缓存。

- PCD,Page-level Cache Disable,意为页级高速缓存禁止位。若为1 表示该页启用高速缓存,为0 表示禁止将该页缓存。这里咱们将其置为0。

- A,Accessed,意为访问位。若为1 表示该页被CPU 访问过,A 位也可以用来记录某一内存页的使用频率

- D,Dirty,意为脏页位。当CPU 对一个页面执行写操作时,就会设置对应页表项的D 位为1。此项仅针对页表项有效,并不会修改页目录项中的D 位。

- PAT,Page Attribute Table,意为页属性表位,能够在页面一级的粒度上设置内存属性。比较复杂,将此位置0 即可。

- G,Global,意为全局位。将虚拟地址与物理地址转换结果存储在TLB(Translation Lookaside Buffer)中。此G 位用来指定该页是否为全局页,为1 表示是全局页,为0 表示不是全局页。若为全局页,该页将在高速缓存TLB 中一直保存,给出虚拟地址直接就出物理地址。

- AVL,意为Available 位,表示可用,谁可以用?当然是软件,操作系统可用该位,CPU 不理会该位的值,那咱们也不理会吧。

控制寄存器cr3 用于存储页表物理地址,所以cr3 寄存器又称为页目录基址寄存器(Page Directory Base Register,PDBR)。只要在cr3 寄存器的第31~12 位中写入物理地址的高20 位就行了。另外,cr3 寄存器的低12 位中,除第3 位的PWT 位和第4 位的PCD 位外,其余位都没用。启动分页机制的开关是将控制寄存器cr0 的PG 位置1,PG 位是cr0 寄存器的最后一位:第31 位。

处理器准备了一个高速缓存,可以匹配高速的处理器速率和低速的内存访问速度,它专门用来存放虚拟地址页框与物理地址页框的映射关系,这个调整缓存就是TLB,即Translation Lookaside Buffer,俗称快表。TLB 中的条目是虚拟地址的高20 位到物理地址高20 位的映射结果,实际上就是从虚拟页框到物理页框的映射。除此之外TLB中还有一些属性位,比如页表项的RW 属性。

有两种方法可以间接更新TLB,一个是针对TLB 中所有条目的方法—重新加载CR3,比如将CR3 寄存器的数据读出来后再写入CR3,这会使整个TLB 失效。另一个方法是针对TLB 中某个条目的更新。处理器提供了指令invlpg(invalidate page),它用于在TLB 中刷新某个虚拟地址对应的条目,处理器是用虚拟地址来检索TLB 的,因此很自然地,指令invlpg 的操作数也是虚拟地址,其指令格式为invlpg m。

加载内核

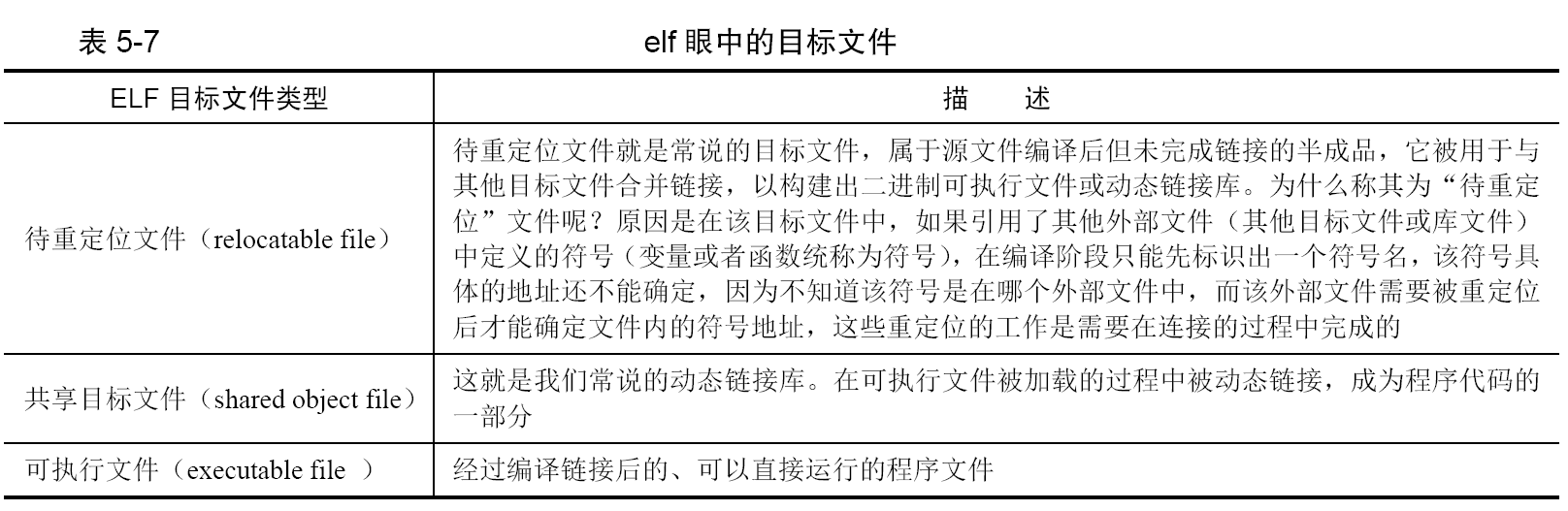

ELF 目标文件归纳见:

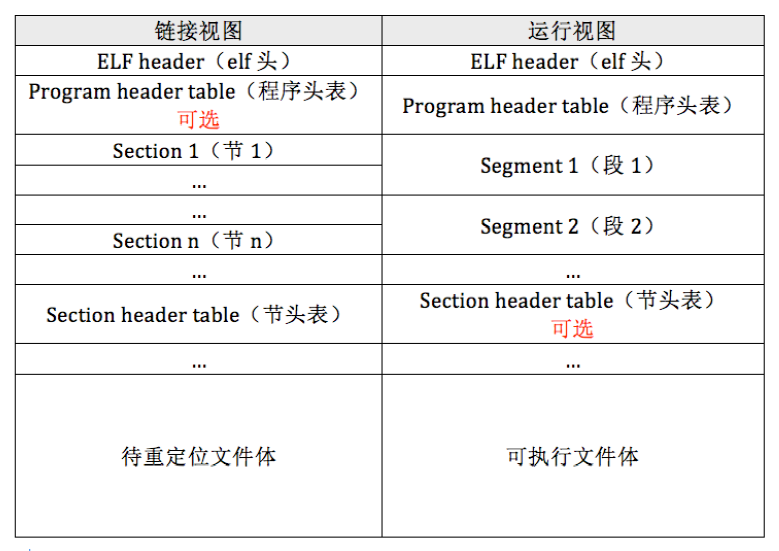

程序中最重要的部分就是段(segment)和节(section),它们是真正的程序体,程序中有很多段,如代码段和数据段等,同样也有很多节,段是由节来组成的,多个节经过链接之后就被合并成一个段了,段和节的信息也是用 header 来描述的,程序头是program header,节头是section header。程序中段的大小和数量是不固定的,节的大小和数量也不固定,用程序头表(program header table)和节头表(section header table)描述。这两个表相当于数组,数组元素分别是程序头program header 和节头section header。在表中,每个成员(数组元素)都统称为条目,即 entry,一个条目代表一个段或一个节的头描述信息。对于程序头表,它本质上就是用来描述段(segment)的,所以您也可以称它为段头表。ELF header 是个用来描述各种“头”的“头”,程序头表和节头表中的元素也是程序头和节头。

无论是在待重定位文件,还是可执行文件中,文件最开头的部分必须是elf header。在ELF header之后紧挨着的是程序头表,这对于可执行文件是必须存在的,而对于待重定位文件是可选的。其他成员的位置要取决于各头表中的说明。

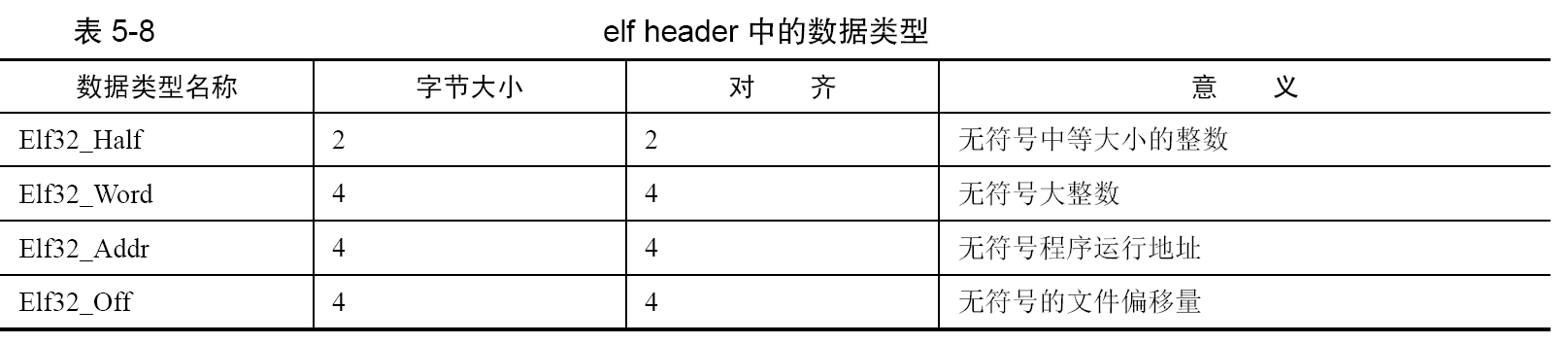

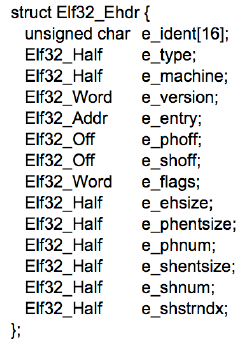

一些重要的数据结构中用到了自定义的数据类型:

C 语言中的结构体能够很直观地表示物理内存结构:

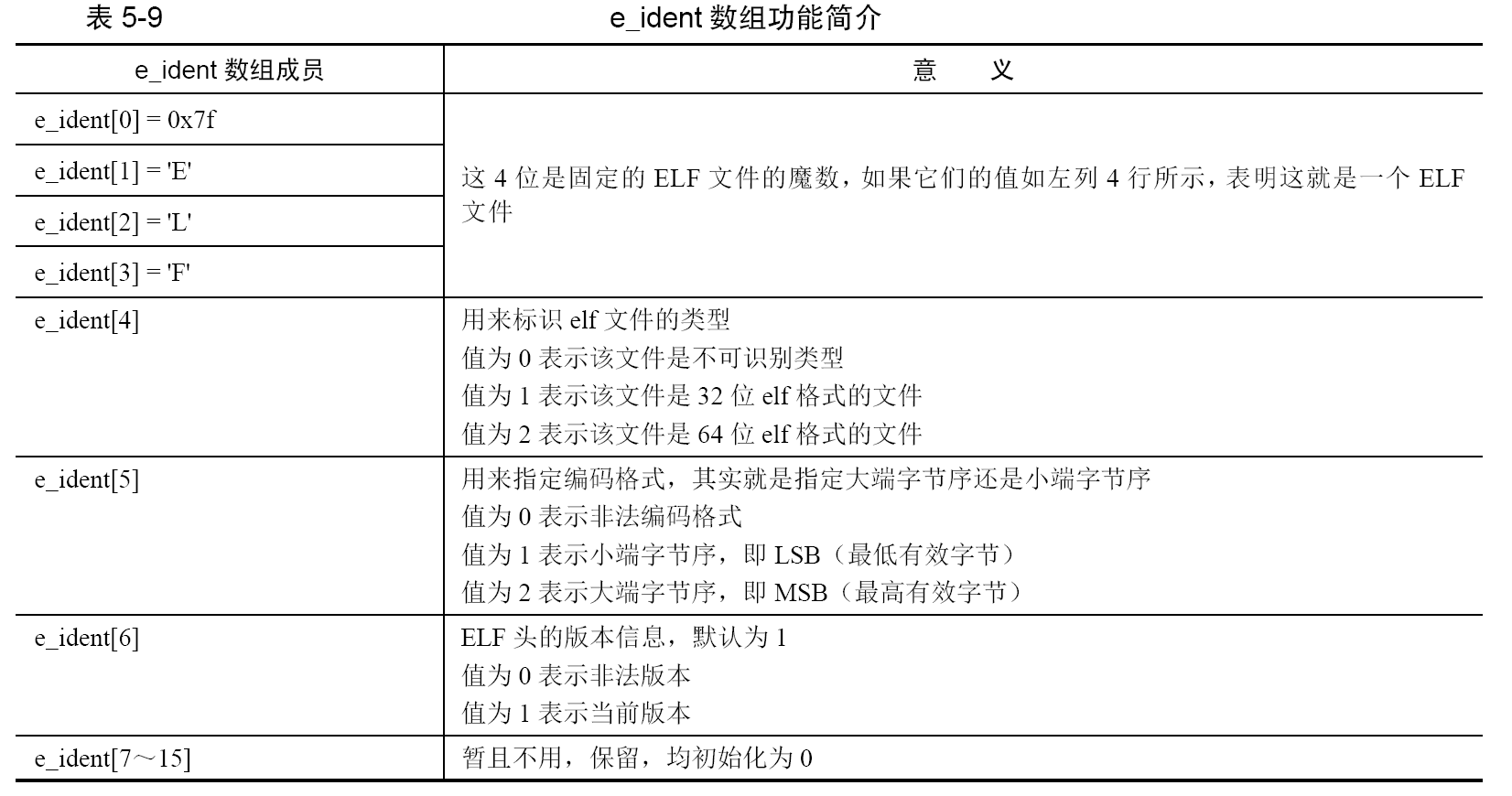

e_ident[16]是16 字节大小的数组,用来表示elf 字符等信息,开头的4 个字节是固定不变的,是elf 文件的魔数,它们分别是0x7f,以及字符串ELF 的ascii码:0x45, 0x4c, 0x46。

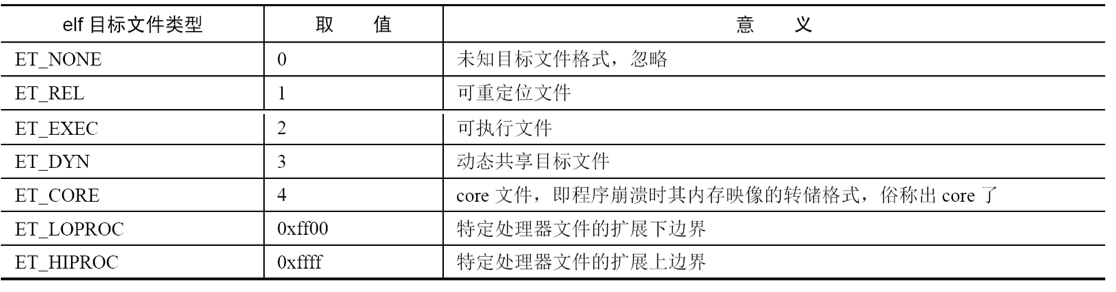

e_type 占用2 字节,是用来指定elf 目标文件的类型,,ET_LOPROC和ET_HIPROC 这两个类型的取值跨度好大,显得似乎有些怪异,其实把它们搞得如此怪异,是为了突显它们的“与众不同”,它们是与硬件相关的参数,在它们之间的取值用来标识与处理器相关的文件格式。

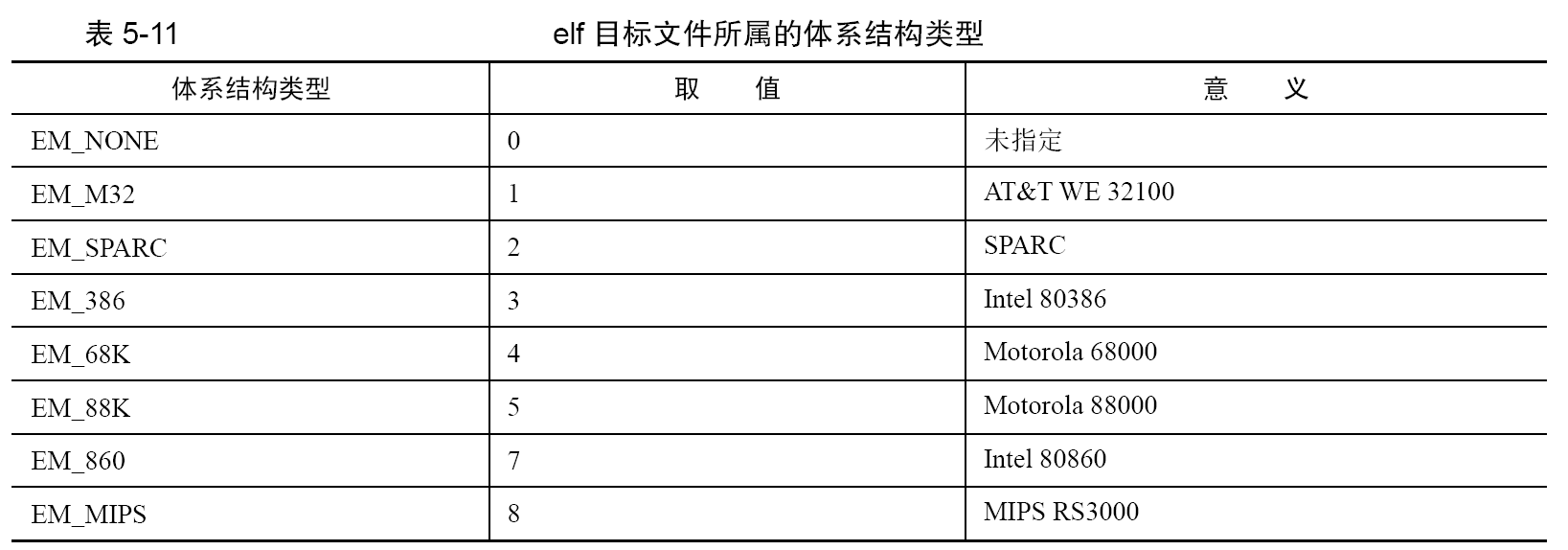

e_machine 占用2 字节,用来描述elf 目标文件的体系结构类型,也就是说该文件要在哪种硬件平台(哪种机器)上才能运行。

e_version 占用4 字节,用来表示版本信息。

- e_entry 占用4 字节,用来指明操作系统运行该程序时,将控制权转交到的虚拟地址。

- e_phoff 占用4 字节,用来指明程序头表(program header table)在文件内的字节偏移量。如果没有程序头表,该值为0。

- e_shoff 占用4 字节,用来指明节头表(section header table)在文件内的字节偏移量。若没有节头表,该值为0。

- e_flags 占用4 字节,用来指明与处理器相关的标志

- e_ehsize 占用2 字节,用来指明elf header 的字节大小。

- e_phentsize 占用2 字节,用来指明程序头表(program header table)中每个条目(entry)的字节大小,即每个用来描述段信息的数据结构的字节大小,该结构是后面要介绍的struct Elf32_Phdr。

- e_phnum 占用2 字节,用来指明程序头表中条目的数量。实际上就是段的个数。

- e_shentsize 占用2 字节,用来指明节头表(section header table)中每个条目(entry)的字节大小,即每个用来描述节信息的数据结构的字节大小。

- e_shnum 占用2 字节,用来指明节头表中条目的数量。实际上就是节的个数。

- e_shstrndx 占用2 字节,用来指明string name table 在节头表中的索引index。

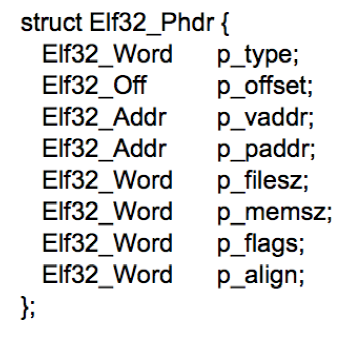

程序头表中的条目的数据结构,这是用来描述各个段的信息用的,此段是指程序中的某个数据或代码的区域段落:

- p_type 占用4 字节,用来指明程序中该段的类型。

- p_offset 占用4 字节,用来指明本段在文件内的起始偏移字节。

- p_vaddr 占用4 字节,用来指明本段在内存中的起始虚拟地址。

- p_paddr 占用4 字节,仅用于与物理地址相关的系统中,因为System V 忽略用户程序中所有的物理地址,所以此项暂且保留,未设定。

- p_filesz 占用4 字节,用来指明本段在文件中的大小。

- p_memsz 占用4 字节,用来指明本段在内存中的大小。

- p_flags 占用4 字节,用来指明与本段相关的标志,本段具有可执行权限、可写权限、可读权限、与操作系统相关、处理器相关

- p_align 占用4 字节,用来指明本段在文件和内存中的对齐方式。如果值为0 或1,则表示不对齐。否则p_align 应该是2 的幂次数。

通过 dd 命令往磁盘上写,命令如下。dd if= kernel.bin of=/your_path/hd60M.img bs=512 count=200 seek=9 conv=notrunc,seek 为9,目的是跨过前9 个扇区(第0~8 个扇区),我们在第9 个扇区写入。count 为200,目的是一次往参数of 指定的文件中写入200 个扇区。

特权级深入浅出

操作系统位于最内环的0 级特权,它要直接控制硬件,掌控各种核心数据,所以它的权利必须最大。系统程序分别位于

1 级特权和2 级特权,运行在这两层的程序一般是虚拟机、驱动程序等系统服务。在最外层的是3 级特权,我们的用户程序

就运行在此层,用户程序被设计为“有需求时找操作系统”,所以它不需要太大的能力,能完成一般工作即可,因此它的权利最弱。

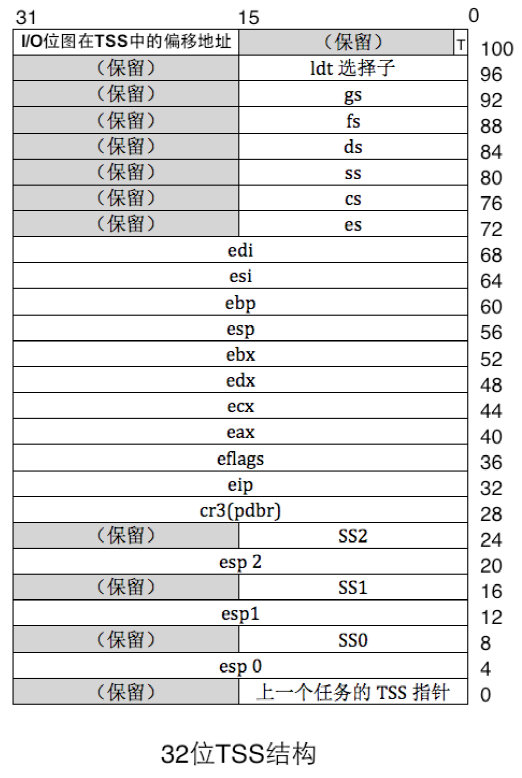

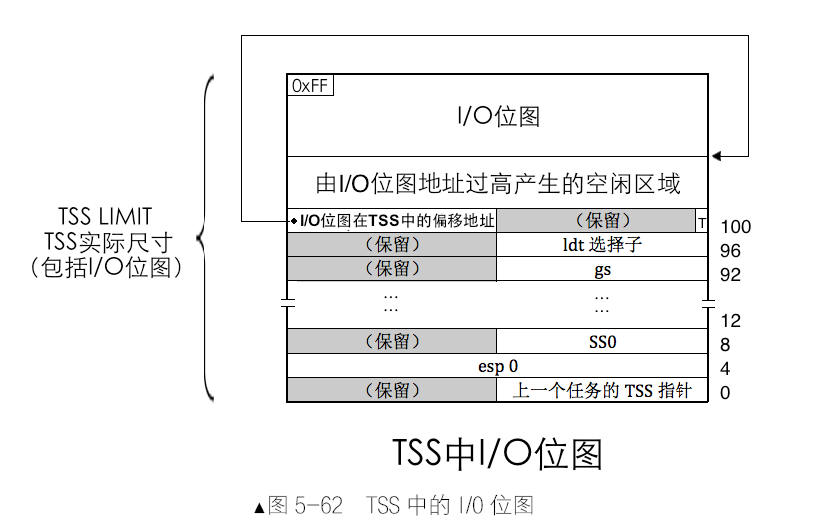

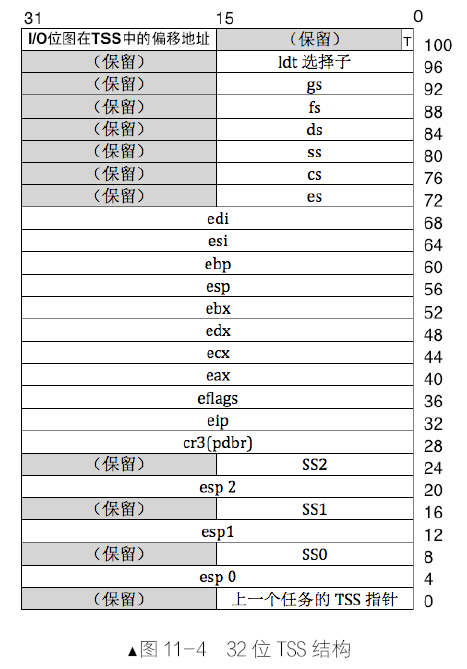

TSS,即Task State Segment,意为任务状态段,它是处理器在硬件上原生支持多任务的一种实现方式,TSS 是一种数据结构,它用于存储任务的环境。TSS 是每个任务都有的结构,它用于一个任务的标识,程序拥有此结构才能运行。

任务在特权级变换时,本质上是处理器的当前特权级在变换,由一个特权级变成了另外一个特权级。处理器在不同特权级下,应该用不同特权级的栈,原因是如果在同一个栈中容纳所有特权级的数据时,这种交叉引用会使栈变得非常混乱,并且,用一个栈容纳多个特权级下的数据,栈容量有限,这很容易溢出。

特权级转移分为两类,一类是由中断门、调用门等手段实现低特权级转向高特权级,另一类则相反,是由调用返回指令从高特权级返回到低特权级,这是唯一一种能让处理器降低特权级的情况。

- 对于特权级由低到高的情况,由于不知道目标特权级对应的栈地址在哪里,所以要提前把目标栈的地址记录在某个地方,当处理器向高特权级转移时再从中取出来加载到SS 和ESP 中以更新栈,这个保存的地方就是TSS。处理器会自动地从TSS 中找到对应的高特权级栈地址。也就是说,除了调用返回外,处理器只能由低特权级向高特权级转移,TSS 中所记录的栈是转移后的高特权级目标栈,所以它一定比当前使用的栈特权级要高,只用于向更高特权级转移时提供相应特权的栈地址。

所以,TSS 中不需要记录3 特权级的栈,因为3 特权级是最低的,没有更低的特权级会向它转移。不是每个任务都有4 个栈,一个任务可有拥有的栈的数量取决于当前特权级是否还有进一步提高的可能,即取决于它最低的特权级别。比如3 特权级的程序,它是最低的特权级,还能提升三级,所以可额外拥有2、1、0 特权级栈,用于将特权分别转移到2、1、0 级时使用。

对于由高特权返回到低特权级的情况,处理器是不需要在TSS 中去寻找低特权级目标栈的。TSS 中只记录2、1、0 特权级的栈,而且,低特权级栈的地址其实已经存在了,这是由处理器的向高特权级转移指令(如int、call 等)实现的机制决定的。

当处理器由低向高特权级转移时,它自动地把当时低特权级的栈地址(SS 和ESP)压入了转移后的高特权级所在的栈中,所以,当用返回指令如retf 或iret 从高特权级向低特权级返回时,处理器可以从当前使用的高特权级的栈中获取低特权级的栈段选择子及偏移量。当下次处理器再进入到高特权级时,它依然会在 TSS 中寻找对应的高特权级栈,而TSS 中栈指针值都是固定的,每次进入高特权级都会重复使用它们。

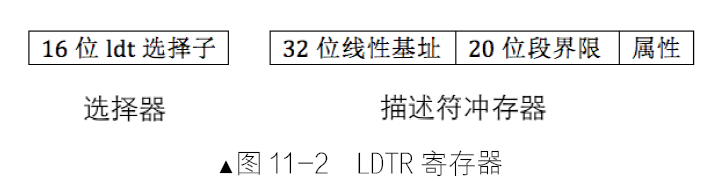

TSS 是硬件支持的系统数据结构,它和GDT 等一样,由软件填写其内容,由硬件使用。GDT 也要加载到寄存器GDTR 中才能被处理器找到,TSS 也是一样,它是由TR(Task Register)寄存器加载的,每次处理器执行不同任务时,将TR 寄存器加载不同任务的TSS 就成了。

计算机特权级的标签体现在DPL、CPL 和RPL,在 CPU 中运行的是指令,其运行过程中的指令总会属于某个代码段,该代码段的特权级,也就是代码段描述符中的DPL,便是当前CPU 所处的特权级,这个特权级称为当前特权级,即CPL(Current Privilege Level),它表示处理器正在执行的代码的特权级别。当前特权级实际上是指处理器当前所处的特权级,是指处理器的特权角色,在任意时刻,当前特权级CPL 保存在CS 选择子中的RPL 部分。

代码是资源的请求者,代码段寄存器CS所指向的是处理器中当前运行的指令,所以代码段寄存器CS 中选择子的RPL 位称为当前特权级CPL,只是代码段寄存器CS 中的RPL 是CPL,其他段寄存器中选择子的RPL 与CPL 无关,因为CPL 是针对具有“能动性”的访问者(执行者)来说的,代码是执行者,它表示访问的请求者,所以CPL 只存放在代码段寄存器CS 中低2 位的RPL 中。

DPL,即Descriptor Privilege Level,描述符特权级,DPL 字段在段描述符中占2位,表示4 个组合,00b、01b、10b、11b,所有特权级都齐了。DPL 是段描述符所代表的内存区域的“门槛”权限,访问者能否迈过此门槛访问到本描述符所代表的资源,其特权级至少要等于这个门槛。

对于受访者为数据段(段描述符中 type 字段中未有X 可执行属性)来说:只有访问者的权限大于等于该DPL 表示的最低权限才能够继续访问,否则连这个门槛都迈不过去。对于受访者为代码段(段描述符中 type 字段中含有X 可执行属性)来说:只有访问者的权限等于该DPL 表示的最低权限才能够继续访问,CPU 没有理由先自降等级后再去做某事。

处理器从中断处理程序中返回到用户态的时候是唯一一种处理器会从高特权降到低特权运行的情况。中断处理都是在 0 特权级下进行的,因为中断的发生多半是外部硬件发生了某种状况或发生了某种不可抗力事件而必须要通知CPU 导致的,所以,在中断的处理过程中需要具备访问硬件的能力。再者,有些中断处理中需要的指令只能在0 特权级下使用,这部分指令称为特权指令。除了从中断处理过程返回外,任何时候CPU 都不允许从高特权级转移到低特权级。比目标代码段特权级低的访问者也会被拒绝访问目标代码段。综上所述,对于受访问者为代码段的情况,只能是平级访问。

一致性代码段也称为依从代码段,Conforming,用来实现从低特权级的代码向高特权级的代码转移。一致性代码段是指如果自己是转移后的目标段,自己的特权级(DPL)一定要大于等于转移前的CPL,即数值上CPL≥DPL,也就是一致性代码段的DPL 是权限的上限,任何在此权限之下的特权级都可以转到此代码段上执行。

该关系用公式表示如下:在数值上,CPL≥一致性代码段的DPL,一致性代码段的一大特点是转移后的特权级不与自己的特权级(DPL)为主,而是与转移前的低特权级一致,听从、依从转移前的低特权级,这就是它称为“依从、一致”的原因。

顺便说一句,代码段可以有一致性和非一致性之分,但所有的数据段总是非一致的,即数据段不允许被比本数据段特权级更低的代码段访问。

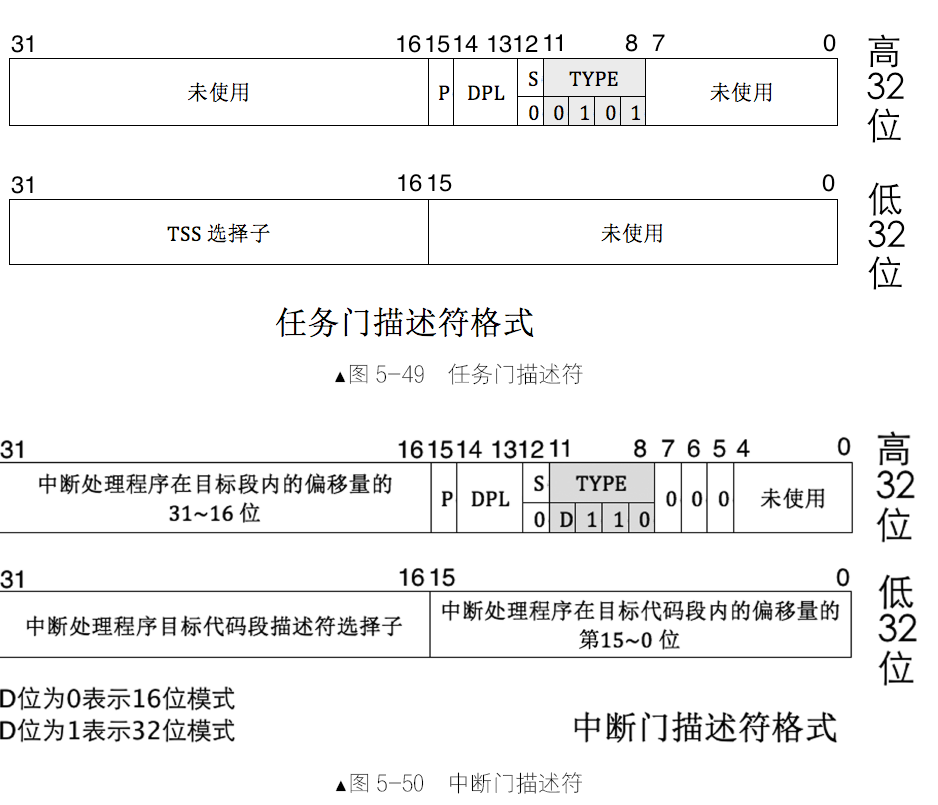

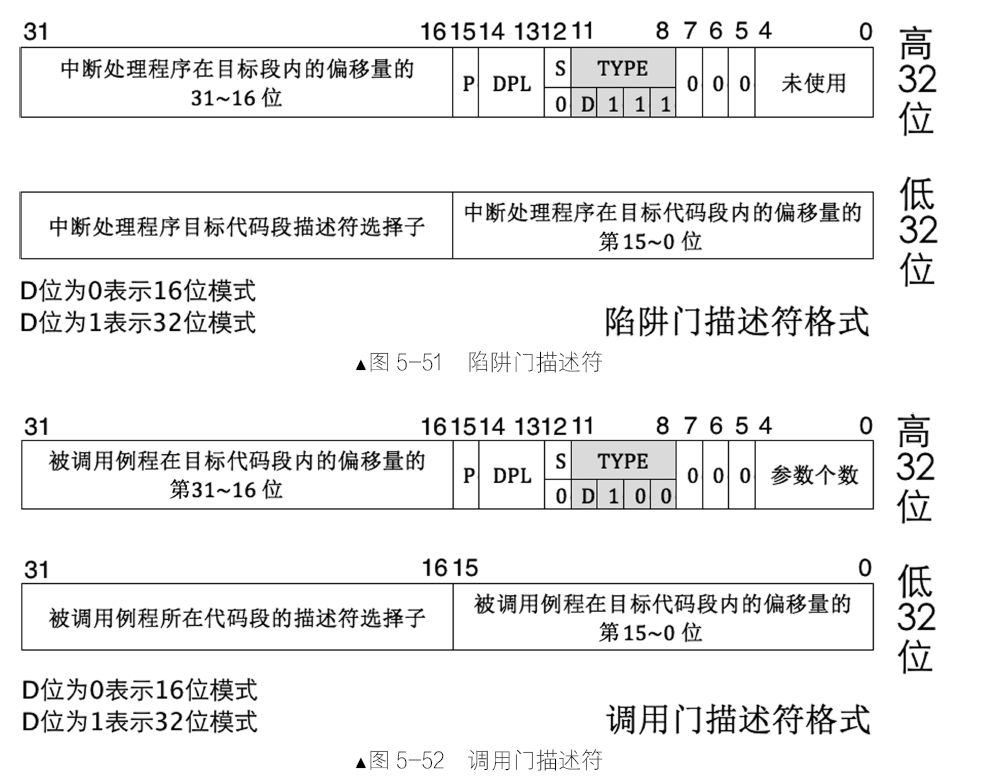

处理器只有通过“门结构”才能由低特权级转移到高特权级,是记录一段程序起始地址的描述符。门结构是记录一段程序起始地址的描述符。有一种称为“门描述符”的结构,用来描述一段程序。进入这种神奇的“门”,处理器便能转移到更高的特权级上。

门描述符同段描述符类似,都是 8 字节大小的数据结构,用来描述门中通向的代码。

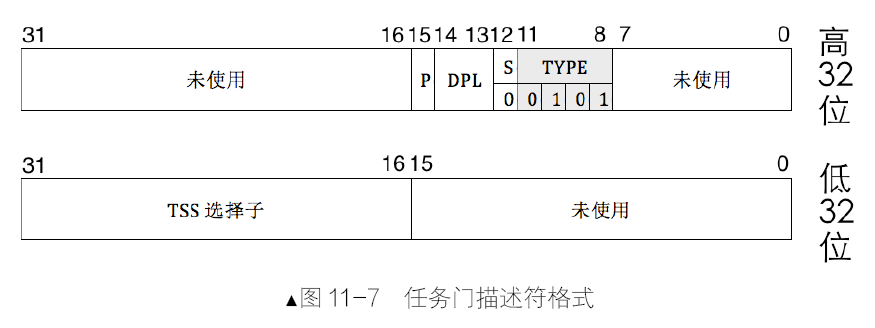

除了任务门外,其他三种门都是对应到一段例程,即对应一段函数,而不是像段描述符对应的是一片内存区域。任务门描述符可以放在GDT、LDT 和IDT中,调用门可以位于GDT、LDT 中,中断门和陷阱门仅位于IDT 中。

任务门、调用门都可以用call 和jmp 指令直接调用,原因是这两个门描述符都位于描述符表中,要么是GDT,要么是LDT,访问它们同普通的段描述符是一样的,也必须要通过选择子,因此只要在call 或jmp 指令后接任务门或调用门的选择子便可调用它们了。陷阱门和中断门只存在于IDT 中,因此不能主动调用,只能由中断信号来触发调用。任务门有点特殊,它用任务TSS 的描述符选择子来描述一个任务。

- 调用门:call 和jmp 指令后接调用门选择子为参数,以调用函数例程的形式实现从低特权向高特权转移,可用来实现系统调用。call 指令使用调用门可以实现向高特权代码转移,jmp 指令使用调用门只能实现向平级代码转移。

- 中断门:以 int 指令主动发中断的形式实现从低特权向高特权转移,Linux 系统调用便用此中断门实现,就是那个著名的int 0x80。中断门只允许存在于IDT 中。

- 陷阱门:以 int3 指令主动发中断的形式实现从低特权向高特权转移,这一般是编译器在调试时用

- 任务门:任务以任务状态段TSS 为单位,用来实现任务切换,它可以借助中断或指令发起。当中断发生时,如果对应的中断向量号是任务门,则会发起任务切换。也可以像调用门那样,用call 或jmp 指令后接任务门的选择子或任务TSS 的选择子。

门的“门槛”是访问者特权级的下限,访问者的特权级再低也不能比门描述符的特权级DPL 低,否则访问者连门都进不去,更谈不上使用调用门。门描述符的DPL 特权级要低于或等于当前特权级CPL,即数值上CPL≤门的DPL,此处可见,门描述符相当于数据段描述符一样,只允许比自己特权级高或相同特权级的程序访问。

门的“门框”是访问者特权级的上限,访问者的特权级再高也不能比门描述符中目标程序所在代码段的DPL 高。门中包含的目标程序所在的段的特权级DPL 要高于或等于当前特权级CPL,即数值上CPL≥目标代码段DPL,进门之后,处理器将以目标代码段DPL 为当前特权级CPL。

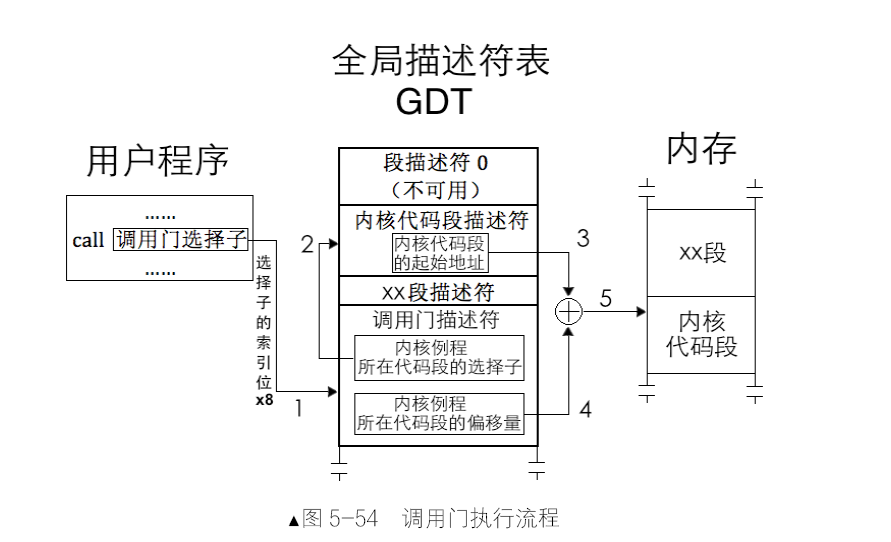

各种门结构存在的目的就是为了让处理器提升特权级,这样处理器才能够做一些低特权级下无法完成的工作。调用门是一个描述符,称为门描述符,其中记录的是内核服务程序所在代码段的选择子及在代码段中的偏移地址。门描述符定义在全局描述符表GDT 和局部描述符表LDT 中,所以,要想使用调用门,就要通过门描述符的选择子。

- 在用户程序中有一句代码

call 调用门选择子,call 指令可以使用调用门,参数就是调用门的选择子,该选择子指向GDT 或LDT 中的某个门描述符,不管选择子中的TI 位是0,还是1,我们暂且认为它是指向GDT 中的调用门。处理器用门描述符选择子的高13 位(索引位)乘以8 作为该描述符在GDT 中的偏移量,再加上寄存器GDTR 中的GDT 基地址,最终找到了门描述符的地址,它位于GDT中从0 起的第3 个描述符位置。 - 在该描述符中记录的是内核例程的地址。我们知道,在保护模式下描述某个内存地址是离不开选择子和偏移量的,所以,门描述符中记录的是内核例程所在代码段的选择子及偏移量。处理器再用代码段选择子,重复之前的步骤,用选择子中高13位的索引值乘以8,再加上GDT 基址,所得到的地址为该代码段选择子所指向的内核代码段描述符地址,在该内核代码段描述符中找到内核代码段基址,用它加上门描述符中记录的内核例程在代码段中的偏移量,最终得到内核例程的起始地址。

为了方便软件开发人员,处理器在固件上实现参数的自动复制,即,将用户进程压在3 特权级栈中的参数自动复制到0 特权级栈中。所以,在图中,其高32 位的起始处有个参数个数,这是处理器将用户提供的参数复制给内核时需要用到的,参数在栈中的顺序是挨着的,所以处理器只需要知道复制几个参数就行了,这就是调用门描述符中“参数个数”的作用,它是专门给处理器准备的。该位是用5 个BIT 来表示的,所以最多可传递31 个参数。

调用门可以用call 指令和jmp 指令调用,jmp 属于一去不回头的指令,基本上用在不需要从调用门返回的场合。call 指令由于会在栈中留下返回地址,所以在执行retf 指令时还能返回。

调用门的过程保护

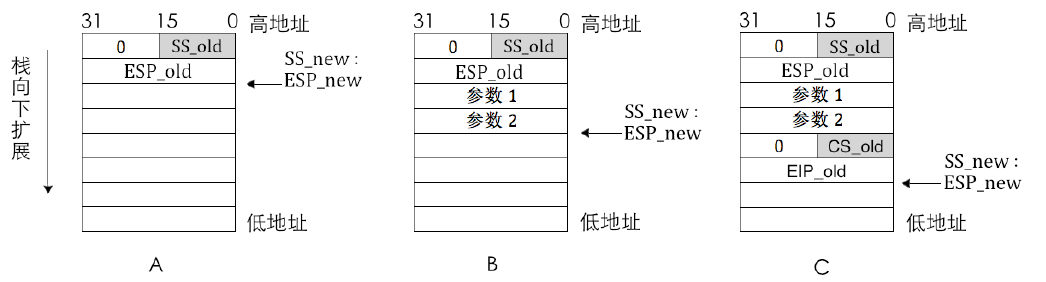

假设用户进程要调用某个调用门,该门描述符中参数的个数是2,也就是用户进程需要为该调用门提供2 个参数才行。调用前的当前特权级为3,调用后的新特权级为0,所以调用门转移前用的是3 特权级栈,调用后用的是0 特权级栈。

- 现在为此调用门提供2个参数,这是在使用调用门前完成的,目前是在3 特权级,所以要在特权级栈中压入参数,分别是参数1 和参数2

- 在这一步骤中要确定新特权级使用的栈,新特权级就是未来的CPL,它就是转移后的目标代码段的DPL。所以,根据门描述符中选择子对应的目标代码段的DPL,处理器自动在TSS 中找到合适的栈段选择子SS 和栈指针ESP,它们作为转移后新的栈,记作SS_new、ESP_new。

- 检查新栈段选择子对应的描述符的DPL 和TYPE,如果未通过检查则处理器引发异常。

- 如果转移后的目标代码段DPL 比CPL 要高,说明栈段选择子SS_new 是特权级更高的栈,这说明需要特权级转换,需要切换到新栈,将旧栈段选择子记作SS_old,旧栈指针记作ESP_old。由于转移前的旧栈段选择子SS_old 及指针ESP_old 得保存到新栈中,这样在高特权级的目标程序执行完成后才能通过retf 指令恢复旧栈。将SS_new 加载到栈段寄存器SS,esp_new 加载到栈指针寄存器esp,这样便启用了新栈。

- 在使用新栈后,将上一步中临时保存的SS_old 和ESP_old 压入到当前新栈中,也就是0 特权级栈。由于咱们讨论的是32 位模式,故栈操作数也是32 位,SS_old 只是16 位数据,将其高16 位用0 填充后入栈保存。

- 在这一步中要将用户栈中的参数复制到转移后的新栈中,根据调用门描述符中的“参数个数”决定复制几个参数。

- 由于调用门描述符中记录的是目标程序所在代码段的选择子及偏移地址,这意味着代码段寄存器CS要用该选择子重新加载,只要段寄存器被加载,段描述符缓冲寄存器就会被刷新,从而相当于切换到了新段上运行,这是段间远转移,所以需要将当前代码段CS 和EIP 都备份在栈中,这两个值分别记作CS_old 和EIP_old,由于CS_old 只是16 位数据,在32 位模式下栈操作数大小是32 位,故将其高16 位用0 填充后再入栈。这两个值是将来恢复用户进程的关键,也就是从内核进程中返回时用的地址。

- 一切就绪,只差运行调用门中指向的程序啦,于是,把门描述符中的代码段选择子装载到代码段寄存器CS,把偏移量装载到指令指针寄存器EIP。

下面是利用 retf 指令从调用门返回的过程:

- 当处理器执行到retf 指令时,它知道这是远返回,所以需要从栈中返回旧栈的地址及返回到低特权级的程序中。这时候它要进行特权级检查。先检查栈中CS选择子,根据其RPL位,即未来的CPL,判断在返回过程中是否要改变特权级。

- 此时栈顶应该指向栈中的EIP_old。在此步骤中获取栈中CS_old 和EIP_old,根据该CS_old 选择子对应的代码段的DPL 及选择子中的RPL 做特权级检查,规则不再赘述。如果检查通过,先从栈中弹出32 位数据,即EIP_old 到寄存器EIP,然后再弹出32 位数据CS_old,此时要临时处理一下,由于所有的段寄存器都是16 位的,当然包括CS,所以丢弃CS_old 的高16 位,将低16 位加载到CS 寄存器。此时栈指针ESP_new 指向最后一个参数。

- 如果返回指令retf 后面有参数,则增加栈指针ESP_new 的值,以跳过栈中参数,retf 后面的参数应该等于参数个数*参数大小。此时,栈指针ESP_new 便指向ESP_old。

- 如果在第1 步中判断出需要改变特权级,从栈中弹出32 位数据ESP_old 到寄存器ESP。同样寄存器 SS 也是16 位的,故再弹出32 位的SS_old,只将其低16 位加载到寄存器SS,此时恢复了旧栈。相当于丢弃寄存器SS 和ESP 中原有的SS_new 和ESP_new。

RPL,Request Privilege Level,请求特权级,代表真正请求者的特权级,其实是代表真正资源需求者的CPL。在请求某特权级为DPL 级别的资源时,参与特权检查的不只是CPL,还要加上RPL,CPL 和RPL的特权必须同时大于等于受访者的特权DPL,即:数值上 CPL≥DPL 并且RPL≤DPL

RPL 引入的目的是避免低特权级的程序访问高特权级的资源。DPL 相当于权限的门槛,它代表进入本描述符所对应内存区域的最低权限,任何想迈过这个门槛的人,它的RPL 和CPL 权限必须都要大于等于DPL,即数值上CPL≤DPL && RPL≤DPL。用来检查当前请求者和真正的资源需求方是否都具有访问受访者的资格。处理器的特权检查,都是只发生在往段寄存器中加载选择子访问描述符的那一瞬间,所以,RPL 放在选择子中是多么的合理。

总结下不通过调用门、直接访问一般数据和代码时的特权检查规则,

- 对于受访者为代码段时:

- 如果目标为非一致性代码段,要求:数值上 CPL=RPL=目标代码段DPL

- 如果目标为一致性代码段,要求:数值上(CPL≥目标代码段DPL && RPL≥目标代码段DPL)

- 受访者若为代码,只有在特权级转移时才会被用到,所以有关代码的特权检查都发生在能够改变代码段寄存器CS 和指令指针寄存器EIP 的指令中,即这些指令要么改变EIP,要么改变CS 和EIP。例如call、jmp、int、ret、sysexit 等能改变程序执行流的指令。

- 对于受访者为数据段时:

- 数值上(CPL ≤目标数据段DPL && RPL ≤ 目标数据段 DPL)

- 栈段的特权级检查比较特殊,因为在各个特权级下,处理器都要有相应的栈(后面会说到),也就是说栈的特权等级要和CPL 相同。所以往段寄存器SS 中赋予数据段选择子时,处理器要求CPL 等于栈段选择子对应的数据段的DPL,即数值上CPL = RPL = 用作栈的目标数据段DPL。

- 受访者若为数据,特权级检查会发生在往数据段寄存器中加载段选择子的时候,数据段寄存器包括DS 和附加段寄存器ES、FS、GS。

RPL 是位于选择子中的,所以,要看当前运行的程序在访问数据或代码时用的是谁提供的选择子,如果用的

是自己提供的选择子,那肯定CPL 和RPL 都出自同一个程序;如果选择子是别人提供的,那就有可能RPL和CPL 出自两段程序。CPL 是对当前正在运行的程序而言的,而RPL 有可能是正在运行的程序。

在保护模式下,处理器中的“阶级”不仅体现在数据和代码的访问,还体现在指令中。

- 一方面将指令分级的原因是有些指令的执行对计算机有着严重的影响,它们只有在0 特权级下被执行,因此被称为特权指令(Privilege Instruction)。

- 另一方面体现在I/O 读写控制上。IO 读写特权是由标志寄存器eflags 中的IOPL 位和TSS 中的IO 位图决定的,它们用来指定执行IO 操作的最小特权级。IO 相关的指令只有在当前特权级大于等于IOPL 时才能执行,所以它们称为IO 敏感指令(I/O Sensitive Instruction),如果当前特权级小于IOPL 时执行这些指令会引发处理器异常。这类指令有in、out、cli、sti。

在eflags 寄存器中第12~13 位便是IOPL(I/O Privilege Level),即IO 特权级,它除了限制当前任务进行IO 敏感指令的最低特权级外,还用来决定任务是否允许操作所有的IO 端口,IOPL 位是打开所有IO 端口的开关。每个任务(内核进程或用户进程)都有自己的eflags 寄存器,所以每个任务都有自己的IOPL,它表示当前任务要想执行全部IO 指令的最低特权级,也就是处理器最低的CPL,只有任务的当前特权级大于等于IOPL才允许执行全部IO 指令,即数值上CPL≤IOPL。通过IO 位图来设置部分端口的访问权限。

I/O 位图是位于TSS 中的,它可以存在,也可以不存在,它只是用来设置对某些特定端口的访问,没有它的话便默认为禁止访问所有端口。有一项是“I/O 位图在TSS 中的偏移地址”,它在TSS 中偏移102 字节的地方,占2 个字节空间,就是图5-47 的左上角,此处用来存储I/O 位图的偏移地址,即此地址是I/O 位图在TSS 中以0 为起始的偏移量。如果某个TSS 存在I/O 位图的话,此处用来保存它的偏移地址。

TSS 中如果有I/O 位图的话,它将位于TSS 的顶端,这就是TSS 的实际尺寸并不固定的原因,当包括I/O 位图时,其大小是“I/O 位图偏移地址”+8192+1 字节,结尾这个1 字节是I/O 位图中最后的0xff。此字节有两个作用。

- 第一,处理器允许I/O 位图中不映射所有的端口,即I/O 位图长度可以不足8KB,但位图的最后一字节必须为0xFF。如果在位图范围外的端口,处理器一律默认禁止访问。这样一来,如果位图最后一字节的0xFF 属于全部65536 个端口范围之内,字节各位全为1 表示禁止访问此字节代表的全部端口,这并没什么过错。

- 第二,如果该字节已经超过了全部端口的范围,它并不用来映射端口,只是用来作为位图的边界标记,用于跨位图最后一个字节时的“余量字节”。避免越界访问TSS 外的内存。

完善内核

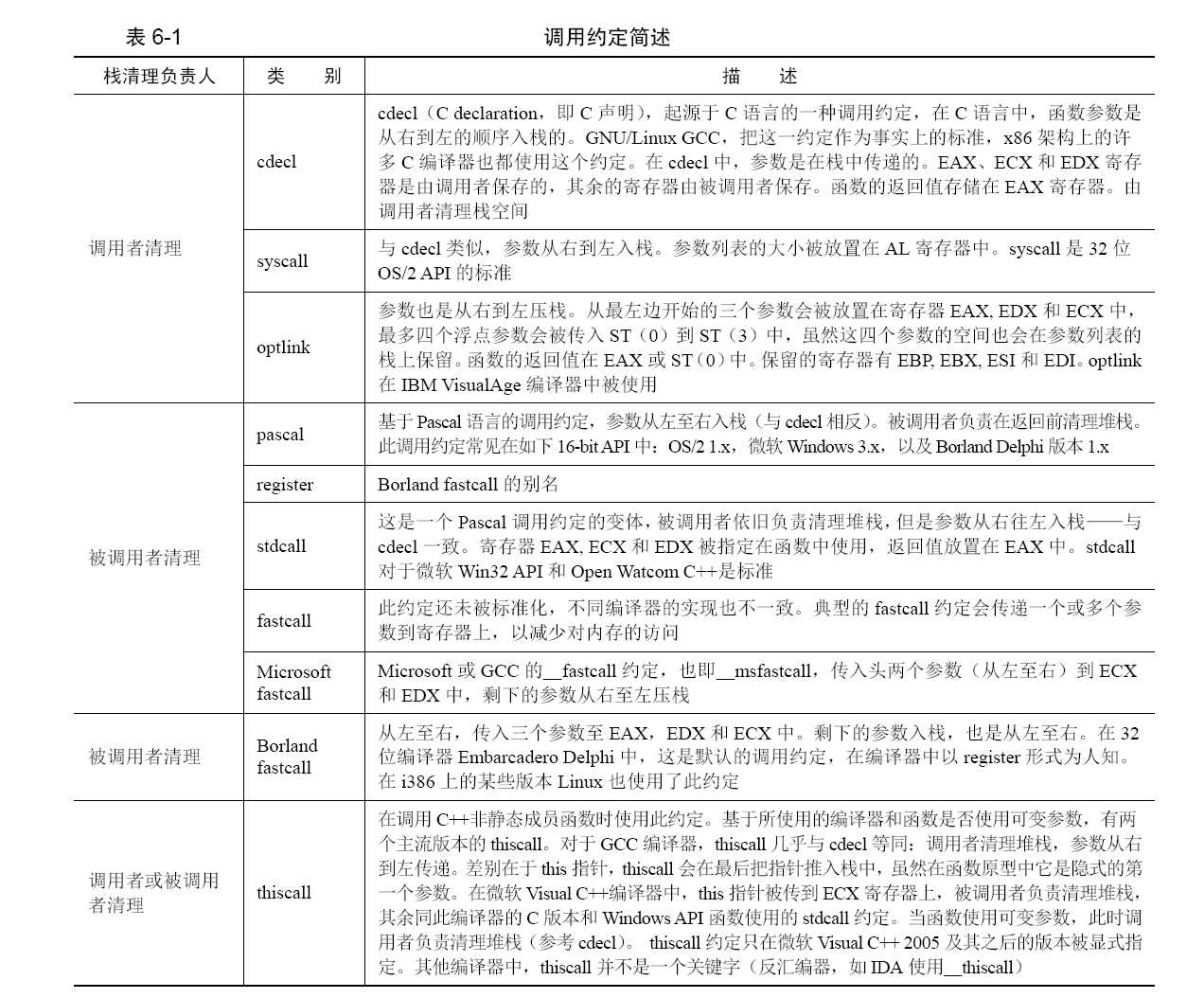

函数调用约定简介

在栈中保存、来传递参数:

- 首先,每个进程都有自己的栈,这就是每个内存自己的专用内存空间。

- 其次,保存参数的内存地址不用再花精力维护,已经有栈机制来维护地址变化了,参数在栈中的位置可以通过栈顶的偏移量来得到。

我们要解决的是参数压栈顺序问题,和栈空间的清理工作呢。我们按照由谁来清理栈空间分类,目前的调用约定见表

stdcall 的调用约定意味着:

- 调用者将所有参数从右向左入栈。

- 被调用者清理参数所占的栈空间。

主调用者:1

2

3

4; 从右到左将参数入栈

push 2 ;压入参数b

push 3 ;压入参数a

call subtract ;调用函数subtract

以上是主调函数,现在看下被调函数 subtract 中做了什么。

被调用者:1

2

3

4

5

6

7

8

9

10

11 push ebp ;压入ebp 备份

mov ebp,esp ;将esp 赋值给ebp

;用ebp 作为基址来访问栈中参数

mov eax,[ebp+0x8] ;偏移8 字节处为第1 个参数a

add eax,[ebp+0xc] ;偏移0xc 字节处是第2 个参数b

;参数a 和b 相加后存入eax

mov esp,ebp ;为防止中间有入栈操作,用ebp 恢复esp

;本句在此例子中可有可无,属于通用代码

pop ebp ;将ebp 恢复

ret 8 ;数字8 表示返回后使esp+8

;函数返回时由被调函数清理了栈中参数

stdcall 是被调用者负责清理栈空间,subtract需要在返回前或返回时完成。在返回前清理栈相对困难一些,清理栈是指将栈顶回退到参数之前。因为返回地址在参数之下,ret 指令执行时必须保证当前栈顶是返回地址。所以通常在返回时“顺便”完成。于是ret 指令便有了这样的变体,其格式为:ret 16 位立即数,这是允许在返回时顺便再将栈指针 esp 修改的指令。

cdecl 调用约定由于起源于C 语言,所以又称为C 调用约定,是C 语言默认的调用约定,最大的亮点是它允许函数中参数的数量不固定。cdecl 的调用约定意味着。

- 调用者将所有参数从右向左入栈。

- 调用者清理参数所占的栈空间。

1 | int subtract(int a, int b); //被调用者 |

主调用者:1

2

3

4

5; 从右到左将参数入栈

push 2 ;压入参数b

push 3 ;压入参数a

call subtract ;调用函数subtract

add esp, 8 ;回收(清理)栈空间

被调用者:1

2

3

4

5

6

7

8

9

10push ebp ;压入ebp 备份

mov ebp,esp ;将esp 赋值给ebp

;用ebp 作为基址来访问栈中参数

mov eax,[ebp+0x8] ;偏移8 字节处为第1 个参数a

add eax,[ebp+0xc] ;偏移0xc 字节处是第2 个参数b

;参数a 和b 相加后存入eax

mov esp,ebp ;为防止中间有入栈操作,用ebp 恢复esp

;本句在此例子中可有可无,属于通用代码

pop ebp ;将ebp 恢复

ret

通过将esp 加上8 字节的方式回收了参数a 和参数b,本例中的其他代码都和stdcall 一样。

汇编语言和 C 语言混合编程

BIOS 中断走的是中断向量表,所以有很多中断号给它用,而系统调用走的是中断描述符表中的一项而已,所以只用了第0x80 项中断。系统调用的子功能要用eax 寄存器来指定。我们要看看系统调用输入参数的传递方式:

- 当输入的参数小于等于5 个时,Linux 用寄存器传递参数。当参数个数大于5 个时,把参数按照顺序放入连续的内存区域,并将该区域的首地址放到ebx 寄存器。这里我们只演示参数小于等于5 个的情况。

- eax 寄存器用来存储子功能号(寄存器eip、ebp、esp 是不能使用的)。5 个参数存放在以下寄存器中,

传送参数的顺序如下。- ebx 存储第1 个参数。

- ecx 存储第2 个参数。

- edx 存储第3 个参数。

- esi 存储第4 个参数。

- edi 存储第5 个参数。

1 | section .data |

第 11~17 行是在模拟调用C 库函数write 的方式。这里是按照C 调用约定将参数从右到左依次入栈,随后调用simu_write 实现字符串打印功能。

第 19~24 行是在演示第2 种系统调用的方式,这是最简单直接可依赖的方式。第0~24 行是在eax中赋予子功能号,参数按照顺序依次写入对应的寄存器。第 31~40 行是simu_write 的实现,它内部在本质上和第2 种方式一样,都是在内部调用int 指令直接和系统通信实现系统调用。

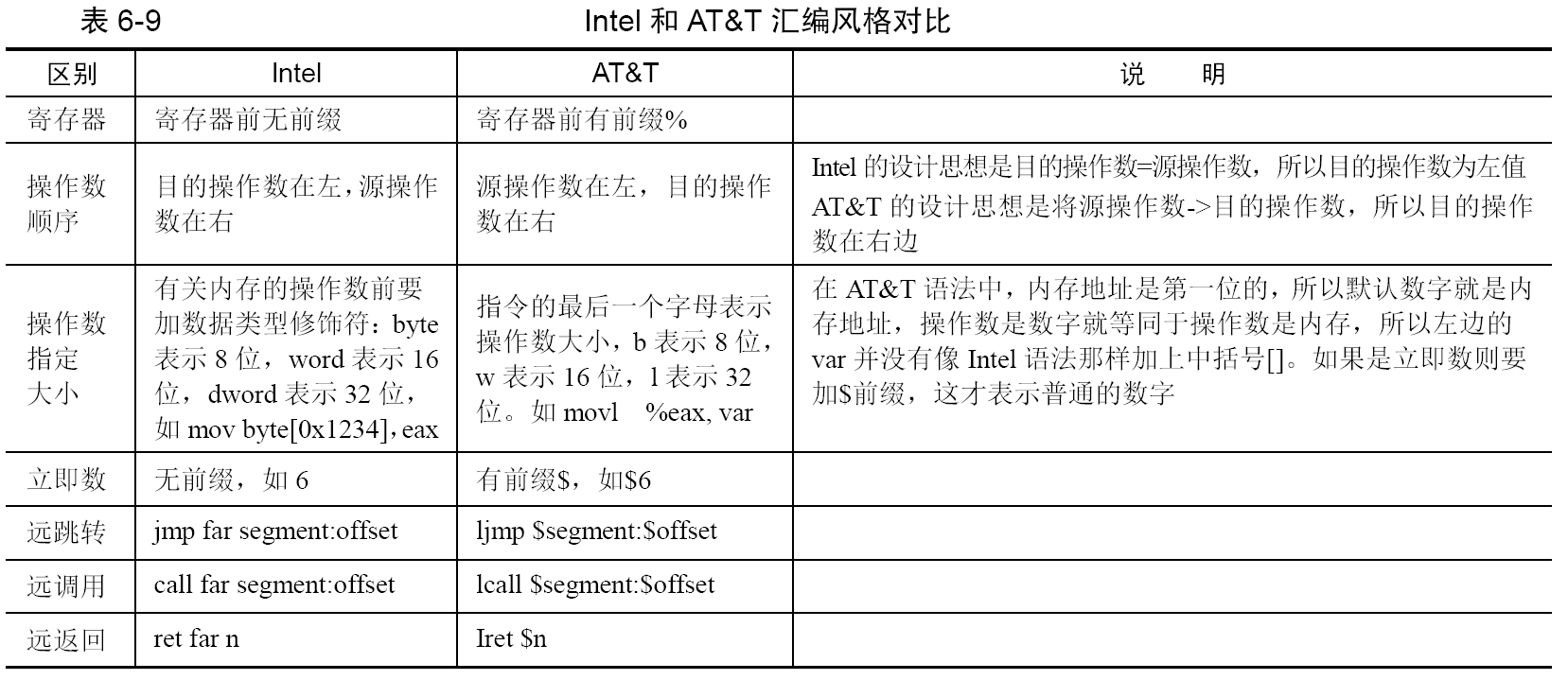

内联汇编

内联汇编称为inline assembly,GCC 支持在C 代码中直接嵌入汇编代码,所以称为GCC inline assembly。GCC只支持AT&T汇编,下表是AT&T汇编和Intel汇编的区别:

在 Intel 语法中,立即数就是普通的数字,如果让立即数成为内存地址,需要将它用中括号括起来,[立即数]这样才表示以“立即数”为地址的内存。而 AT&T 认为,内存地址既然是数字,那数字也应该被当作内存地址,所以,数字被优先认为是内存

地址,也就是说,操作数若为数字,则统统按以该数字为地址的内存来访问。这样,立即数的地位比较次要了,如果想表示成单纯的立即数,需要额外在前面加个前缀$。

在 AT&T 中的内存寻址有固定的格式。segreg(段基址):base_address(offset_address,index,size)。该格式对应的表达式为:segreg(段基址):base_address+ offset_address+ index*size。此表达式的格式和 Intel 32 位内存寻址中的基址变址寻址类似,Intel 的格式:segreg:[base+index*size+offset]

不过与Intel 不同的是AT&T 地址表达式的值是内存地址,直接被当作内存来读写,而不是普通数字。看上去格式有些怪异,但其实这是一种“通用”格式,格式中短短的几个成员囊括了它所有内存寻址的方式,任意一种内存寻址方式,其格式都是这个通用格式的子集,都是格式中各种成员的组合。下面介绍下这些成员项。

- base_address 是基地址,可以为整数、变量名,可正可负。

- offset_address 是偏移地址,index 是索引值,这两个必须是那8 个通用寄存器之一。

- size 是个长度,只能是1、2、4、8(Intel 语法中也是只能乘以这4 个数)。

基本内联汇编是最简单的内联形式,其格式为:asm [volatile] ("assembly code"),各关键字之间可以用空格或制表符分隔,也可以紧凑挨在一起不分隔,各部分意义如下:

- 关键字 asm 用于声明内联汇编表达式,这是内联汇编固定的部分,不可少。

- asm 和asm是一样的,是由gcc 定义的宏:

#define __asm__ asm。 - 关键字volatile 是可选项,它告诉gcc:“不要修改我写的汇编代码,请原样保留”。

volatile和__volatile__是一样的,是由gcc 定义的宏:#define __volatile__ volatile。 - 汇编代码必须位于圆括号中,而且必须用双引号引起来。

- 指令必须用双引号引起来,无论双引号中是一条指令或多条指令。

- 一对双引号不能跨行,如果跨行需要在结尾用反斜杠’\’转义。

- 指令之间用分号’;’、换行符’\n’或换行符加制表符’\n’’\t’分隔。

asm [volatile] (“assembly code”:output : input : clobber/modify)和前面的基本内联汇编相比,扩展内联汇编在圆括号中变成了4 部分,多了output、input 和clobber/modify 三项。其中的每一部分都可以省略,甚至包括assembly code。省略的部分要保留冒号分隔符来占位,如果省略的是后面的一个或多个连续的部分,分隔符也不用保留,比如省略了clobber/modify,不需要保留input 后面的冒号。

- assembly code:还是用户写入的汇编指令,和基本内联汇编一样。

- output:output 用来指定汇编代码的数据如何输出给C 代码使用。内嵌的汇编指令运行结束后,如果想将运行结果存储到c 变量中,就用此项指定输出的位置。output 中每个操作数的格式为:

操作数修饰符约束名(C 变量名) - input:input 用来指定C 中数据如何输入给汇编使用。input 中每个操作数的格式为:

[操作数修饰符] 约束名- 单独强调一下,以上的output()和input()括号中的是C 代码中的变量,output(c 变量)和input(c 变量)就像C 语言中的函数,将C 变量转换成汇编代码的操作数。

- clobber/modify:汇编代码执行后会破坏一些内存或寄存器资源,通过此项通知编译器,可能造成寄存器或内存数据的破坏,这样gcc 就知道哪些寄存器或内存需要提前保护起来。

上面所说的“要求”,在扩展内联汇编中称为“约束”,它所起的作用就是把C 代码中的操作数(变量、立即数)映射为汇编中所使用的操作数,实际就是描述C 中的操作数如何变成汇编操作数。这些约束的作用域是input 和output 部分,约束分为四种:

- 寄存器约束就是要求gcc 使用哪个寄存器,将input 或output 中变量约束在某个寄存器中。常见的寄存器约束有:

- a:表示寄存器eax/ax/al

- b:表示寄存器ebx/bx/bl

- c:表示寄存器ecx/cx/cl

- d:表示寄存器edx/dx/dl

先看下基本内联汇编,见文件 base_asm.c。1

2

3

4

5

6

7

8

9

10

11

int in_a = 1, in_b = 2, out_sum;

void main() {

asm(" pusha; \

movl in_a, %eax; \

movl in_b, %ebx; \

addl %ebx, %eax; \

movl %eax, out_sum; \

popa");

printf("sum is %d\n",out_sum);

}

加法指令的两个输入操作数是in_a 和in_b,输出和存储在变量out_sum 中。在基本内联汇编中的寄存器用单个%做前缀,在扩展内联汇编中,单个%有了新的用途,用来表示占位符,所以在扩展内联汇编中的寄存器前面用两个%做前缀。再看下用扩展内联汇编是怎么做的,见文件 reg_constraint.c。1

2

3

4

5

6

void main() {

int in_a = 1, in_b = 2, out_sum;

asm("addl %%ebx, %%eax":"=a"(out_sum):"a"(in_a),"b"(in_b));

printf("sum is %d\n",out_sum);

}

in_a 和in_b 是在input 部分中输入的,用约束名a 为c 变量in_a 指定了用寄存器eax,用约束名b 为c 变量in_b 指定了用寄存器ebx。addl 指令的结果存放到了寄存器eax 中,在output 中用约束名a 指定了把寄存器eax 的值存储到c 变量out_sum 中。output 中的’=’号是操作数类型修饰符,表示只写,其实就是out_sum=eax的意思。

- 内存约束是要求gcc 直接将位于input 和output 中的C 变量的内存地址作为内联汇编代码的操作数,不需要寄存器做中转,直接进行内存读写,也就是汇编代码的操作数是C 变量的指针。

- m:表示操作数可以使用任意一种内存形式。

- o:操作数为内存变量,但访问它是通过偏移量的形式访问,即包含offset_address 的格式。

下面的文件 mem.c 用约束m 为例。1

2

3

4

5

6

7

void main() {

int in_a = 1, in_b = 2;

printf("in_b is %d\n", in_b);

asm("movb %b0, %1;"::"a"(in_a),"m"(in_b));

printf("in_b now is %d\n", in_b);

}

mem.c 的作用是变量in_b 用in_a 的值替换。in_b 最终变成1。第 5 行是内联汇编,把in_a 施加寄存器约束a,告诉gcc 把变量in_a 放到寄存器eax 中,对in_b 施加内存约束m,告诉gcc 把变量in_b 的指针作为内联代码的操作数。第 5 行对寄存器eax 的引用:%b0,这是用的32 位数据的低8 位,在这里就是指al 寄存器。

立即数即常数,此约束要求gcc 在传值的时候不通过内存和寄存器,直接作为立即数传给汇编代码。由于立即数不是变量,只能作为右值,所以只能放在input 中。

- i:表示操作数为整数立即数

- F:表示操作数为浮点数立即数

- I:表示操作数为0~31 之间的立即数

- J:表示操作数为0~63 之间的立即数

- N:表示操作数为0~255 之间的立即数

- O:表示操作数为0~32 之间的立即数

X:表示操作数为任何类型立即数

通用约束:0~9:此约束只用在input 部分,但表示可与output 和input 中第n 个操作数用相同的寄存器或内存。

为方便对操作数的引用,扩展内联汇编提供了占位符,它的作用是代表约束指定的操作数(寄存器、内存、立即数),我们更多的是在内联汇编中使用占位符来引用操作数。占位符分为序号占位符和名称占位符两种。

- 序号占位符:序号占位符是对在output 和input 中的操作数,按照它们从左到右出现的次序从0 开始编号,一直到9,也就是说最多支持10 个序号占位符。操作数用在 assembly code 中,引用它的格式是%0~9。all:

%%ebx, %%eax":" 1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

150

151

152

153

154

155

156

157- "=a"(out_sum)序号为0,%0 对应的是eax。

- "a"(in_a)序号为1,%1 对应的是eax。

- "b"(in_b)序号为2,%2 对应的是ebx。

必须要人为显式地告诉gcc 我们动了寄存器和内存,只要在clobber/modify部分明确写出来就行了,记得要用双引号把寄存器名称引起来,多个寄存器之间用逗号','分隔,这里的寄存器不用再加两个'%'啦,只写名称即可,如:```asm("movl %%eax, %0;movl %%eax,%%ebx":"=m" (ret_value)::"bx")```

**机器模式**用来在机器层面上指定数据的大小及格式。GCC 支持内联汇编,由于各种约束均不能确切地表达具体的操作数对象,所以引用了机器模式,用来从更细的粒度上描述数据对象的大小及其指定部分。GCC 根据不同的硬件平台,将机器模式定义在多个文件中,其中所有平台都通用的机器模式定义在gcc/machmode.def 文件中,其他与具体平台相关的机器模式定义在自己的平台路径下。

操作码就是**指定操作数为寄存器中的哪个部分**。寄存器按是否可单独使用,可分成几个部分,拿 eax 举例。

- 低部分的一字节:al

- 高部分的一字节:ah

- 两字节部分:ax

- 四字节部分:eax

- h:输出寄存器高位部分中的那一字节对应的寄存器名称,如ah、bh、ch、dh。

- b:输出寄存器中低部分1 字节对应的名称,如al、bl、cl、dl。

- w:输出寄存器中大小为2 个字节对应的部分,如ax、bx、cx、dx。

- k:输出寄存器的四字节部分,如eax、ebx、ecx、edx。

# 中断

操作系统是中断驱动的

## 中断分类

把中断按事件来源分类,来自CPU 外部的中断就称为外部中断,来自CPU 内部的中断称为内部中断。

### 外部中断

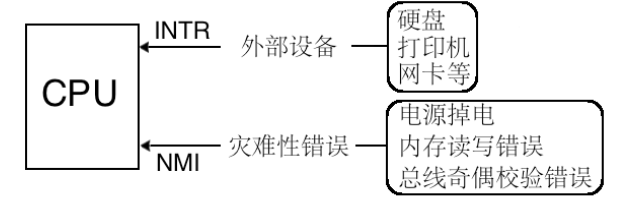

外部中断是指来自CPU 外部的中断,而外部的中断源必须是某个硬件,所以外部中断又称为硬件中断。**所以一种可行的方案是CPU 提供统一的接口作为中断信号的公共线路,所有来自外设的中断信号都共享公共线路连接到CPU**。CPU 为大家提供了两条信号线。外部硬件的中断是通过两根信号线通知CPU 的,这两根信号线就是INTR(INTeRrupt)和NMI(Non Maskable Interrupt)。

CPU 为了区分两种中断类型,**通过不同的引脚加以区分**,同一种类型的中断共用同一根信号线进入CPU,这样CPU 就不需要在每次收到中断时再辨析是哪种类型了。**只要从INTR 引脚收到的中断都是不影响系统运行的**,可以随时处理;而只要从NMI 引脚收到的中断,CPU 都没有运行下去的必要了。

可屏蔽的意思是此外部设备发出的中断,CPU 可以不理会,因为它不会让系统宕机,所以可以通过eflags寄存器的IF 位将所有这些外部设备的中断屏蔽。**把中断处理程序分为上半部和下半部两部分,把中断处理程序中需要立即执行的部分划分到上半部,中断处理程序中那些不紧急的部分则被推迟到下半部中去完成**。当上半部执行完成后就把中断打开了,下半部也属于中断处理程序,所以中断处理程序下半部则是在开中断的情况下执行的。**不可屏蔽中断是通过NMI 引脚进入CPU 的,它表示系统中发生了致命的错误**。不可屏蔽中断可以理解成“即将宕机”中断。

CPU 收到中断后,通过中断向量表或中断描述符表(中断向量表是实模式下的中断处理程序数组,在保护模式下已经被中断描述符表代替)来实现的:

- **首先为每一种中断分配一个中断向量号,中断向量号就是一个整数**,它就是中断向量表或中断描述符表中的索引下标,用来索引中断项。

- 中断发起时,**相应的中断向量号通过NMI 或INTR引脚被传入CPU**,CPU 根据此中断向量号在中断向量表或中断描述符表中检索对应的中断处理程序并去执行。

### 内部中断

内部中断可分为**软中断**和**异常**。

- 软中断,就是**由软件主动发起的中断**,它是主观上的,并不是客观上的某种内部错误。以下是可以发起中断的指令。

- `int 8位立即数`。8位立即数可表示256种中断,这与处理器所支持的中断数是相吻合的。

- `int3`。`int3`是调试断点指令,其所触发的中断向量号是3。

- 我们用gdb 或bochs 调试程序时,实际上就是调试器fork 了一个子进程,**子进程用于运行被调试的程序**。

- 调试器中经常要设置断点,其原理就是**父进程修改了子进程的指令,将其用int3指令替换**,从而子进程调用了int3 指令触发中断。

- 用此指令实现调试的原理是int3 指令的机器码是0xcc,断点本质上是指令的地址,**调试器(父进程)将被调试进程(子进程)断点起始地址的第1 个字节备份好之后,在原地将该指令的第1 字节修改为0xcc**。

- 这样指令执行到断点处时,会去执行机器码为0xcc 的int3 指令,该指令会触发3 号中断,从而会去执行3 号中断对应的中断处理程序。

- 中断处理程序将当前的寄存器和相关内存单元压栈保存,用户在查看寄存器和变量时就是从栈中获取的。

- 当恢复执行所调试的进程时,中断处理程序需要将之前备份的1 字节还原至断点处,然后恢复各寄存器和内存单元的值,修改返回地址为断点地址,用iret 指令退出中断,返回到用户进程继续执行。

- **into**。这是中断溢出指令,它所触发的中断向量号是4。不过,能否引发4 号中断是要看eflags 标志寄存器中的OF 位是否为1,如果是1 才会引发中断。

- **bound**。这是检查数组索引越界指令,它可以触发5 号中断,用于检查数组的索引下标是否在上下边界之内。该指令格式是`bound 16/32位寄存器, 16/32位内存`。目的操作数是用寄存器来存储的,其内容是待检测的数组下标值。源操作数是内存,其内容是数组下标的下边界和上边界。当执行bound 指令时,若**下标处于数组索引的范围之外,则会触发5 号中断**。

- **ud2**。未定义指令,这会触发第6 号中断。该指令表示指令无效,CPU 无法识别。

异常是另一种内部中断,是指令执行期间CPU 内部产生的错误引起的。由于是运行时错误,所以它不受标志寄存器eflags 中的IF 位影响,无法向用户隐瞒。对于中断是否无视eflags 中的IF 位,可以这么理解:

- 首先,只要是导致运行错误的中断类型都会无视IF 位,不受IF 位的管束,如NMI、异常。

- 其次,由于int n 型的软中断用于实现系统调用功能,不能因为IF 位为0 就不顾用户请求,所以为了用户功能正常,软中断必须也无视IF 位。

- 总结:只要中断关系到“正常”运行,就不受IF 位影响。

并不是所有的异常都很致命,按照轻重程度,可以分为以下三种。

- **Fault,也称为故障**。这种错误是可以被修复的一种类型。当发生此类异常时CPU 将机器状态恢复到异常之前的状态,之后调用中断处理程序时,**CPU 将返回地址依然指向导致fault 异常的那条指令**。如操作系统课程中所说的缺页异常page fault,

- **Trap,也称为陷阱**。此异常通常用在调试中,比如int3 指令便引发此类异常,为了让中断处理程序返回后能够继续向下执行,CPU将中断处理程序的返回地址指向导致异常指令的下一个指令地址。

- **Abort,也称为终止**,这是最严重的异常类型,一旦出现,程序将无法继续运行。导致此异常的错误通常是硬件错误,或者某些系统数据结构出错。

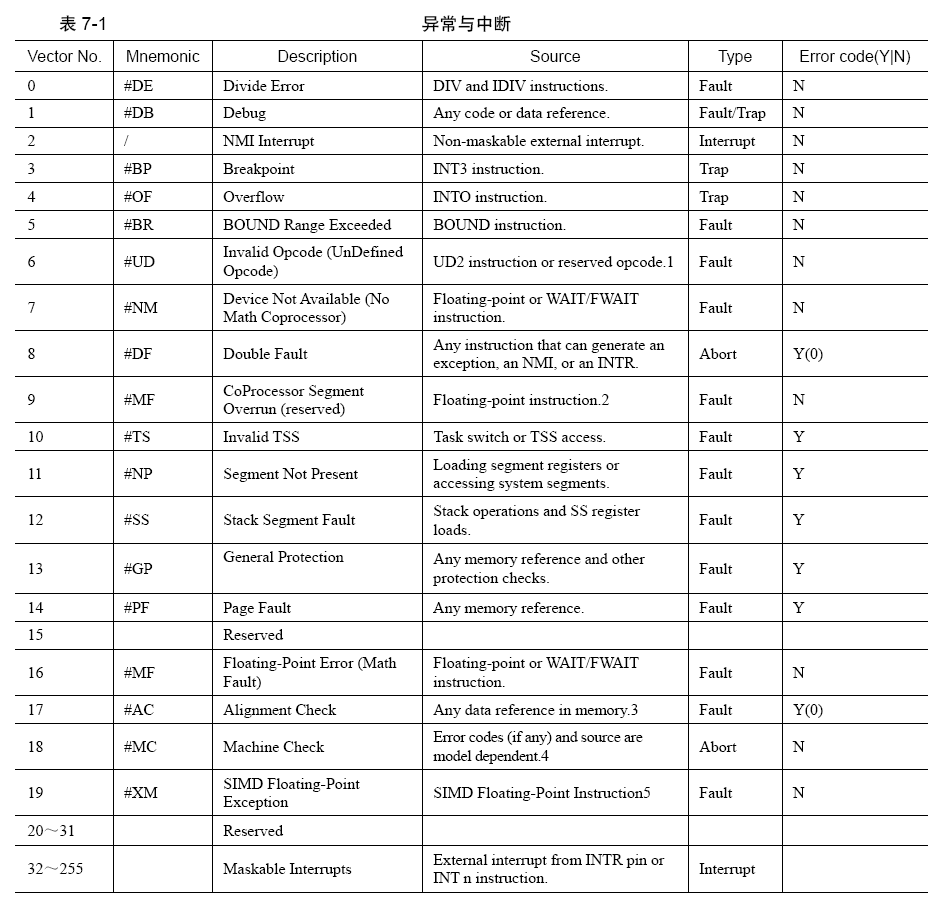

**中断机制的本质是来了一个中断信号后,调用相应的中断处理程序**。为了统一中断管理,把来自外部设备、内部指令的各种中断类型统统归结为一种管理方式,即**为每个中断信号分配一个整数,用此整数作为中断的ID,而这个整数就是所谓的中断向量**,然后用此ID 作为中断描述符表中的索引,这样就能找到对应的表项,进而从中找到对应的中断处理程序。

## 中断描述符表

**中断描述符表(Interrupt Descriptor Table,IDT)是保护模式下用于存储中断处理程序入口的表**,当CPU 接收一个中断时,需要用中断向量在此表中检索对应的描述符,在该描述符中找到中断处理程序的起始地址,然后执行中断处理程序。实模式下用于存储中断处理程序入口的表叫**中断向量表(Interrupt Vector Table,IVT)**。

**位于地址0~0x3ff 的是中断向量表IVT,它是实模式下用于存储中断处理程序入口的表**。对比中断向量表,中断描述符表有两个区别。

- 中断描述符表地址不限制,在哪里都可以。

- 中断描述符表中的每个描述符用8 字节描述。

在CPU 内部有个**中断描述符表寄存器**(IDTR),该寄存器分为两部分:**第0~15 位是表界限**,即IDT 大小减1,第16~47 位是**IDT 的基地址**,只有寄存器IDTR指向了IDT,当CPU 接收到中断向量号时才能找到中断向量处理程序,这样中断系统才能正常运作。同加载GDTR 一样,加载IDTR 也有个专门的指令—lidt,其用法是:`lidt 48 位内存数据`,在这48 位内存数据中,前16 位是IDT 表界限,后32 位是IDT 线性基地址。

完整的中断过程分为CPU 外和CPU 内两部分。

- CPU 外:外部设备的中断由中断代理芯片接收,处理后将该中断的中断向量号发送到CPU。

- CPU 内:CPU 执行该中断向量号对应的中断处理程序。

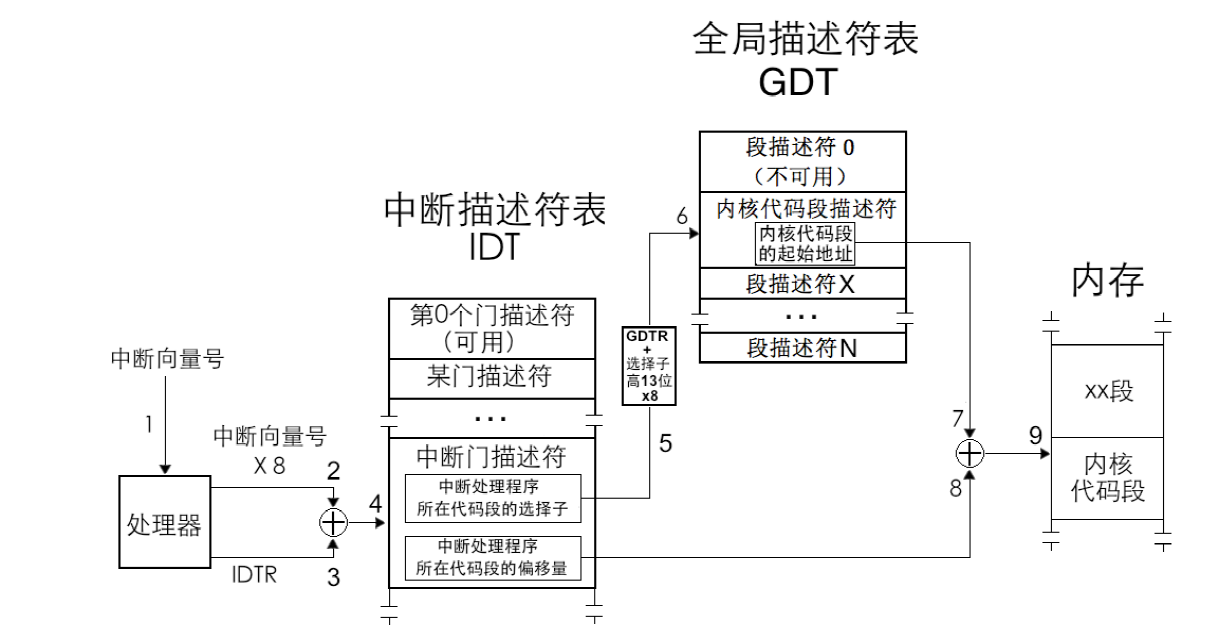

- **处理器根据中断向量号定位中断门描述符**,然后再去执行该中断描述符中的中断处理程序。**由于中断描述符是8 个字节,所以处理器用中断向量号乘以8 后,再与IDTR 中的中断描述符表地址相加**,所求的地址之和便是该中断向量号对应的中断描述符。

- **处理器进行特权级检查**。中断门的特权检查同调用门类似,对于软件主动发起的软中断,**当前特权级CPL 必须在门描述符DPL 和门中目标代码段DPL 之间**。这是为了防止位于3 特权级下的用户程序主动调用某些只为内核服务的例程。

- 如果是由软中断`int n`、`int3`和`into`引发的中断,这些是用户进程中主动发起的中断,**处理器要检查当前特权级CPL 和门描述符DPL**,这是检查进门的特权下限,如果`CPL 权限大于等于DPL`,即`数值上CPL≤门描述符DPL`,特权级“门槛”检查通过,进入下一步的“门框”检查。否则,处理器抛出异常。

- 这一步**检查特权级的上限**(门框):**处理器要检查当前特权级CPL 和门描述符中所记录的选择子对应的目标代码段DPL**,如果CPL 权限小于目标代码段DPL,即**数值上CPL>目标代码段DPL**,检查通过。否则CPL 若大于等于目标代码段DPL,处理器将引发异常,也就是说,**除了用返回指令从高特权级返回,特权转移只能发生在由低向高**。

- 若中断是由外部设备和异常引起的,只直接检查CPL 和目标代码段的DPL,要求CPL 权限小于目标代码段DPL,即**数值上CPL >目标代码段DPL**,否则处理器引发异常。

- 执行中断处理程序。特权级检查通过后,**将门描述符目标代码段选择子加载到代码段寄存器CS 中,把门描述符中中断处理程序的偏移地址加载到EIP**,开始执行中断处理程序。

**指令cli 使IF 位为0,这称为关中断,指令sti 使IF 位为1,这称为开中断。**

**进入中断时要把NT 位和TF 位置为0**。TF 表示Trap Flag,也就是陷阱标志位,这用在调试环境中,**当TF 为0 时表示禁止单步执行**;NT 位表示Nest Task Flag,即**任务嵌套标志位**,也就是用来标记任务嵌套调用的情况。**任务嵌套调用是指CPU 将当前正执行的旧任务挂起,转去执行另外的新任务,待新任务执行完后,CPU 再回到旧任务继续执行**。

- 将旧任务TSS 选择子写到了新任务TSS 中的“上一个任务TSS 的指针”字段中。

- 将新任务标志寄存器eflags 中的NT 位置1,表示新任务之所以能够执行,是因为有别的任务调用了它。

当CPU 执行iret 时,它会去检查NT 位的值,**如果NT 位为1,这说明当前任务是被嵌套执行的**,因此会从自己TSS 中“上一个任务TSS 的指针”字段中获取旧任务,然后去执行该任务。如果NT 位的值为0,这表示当前是在中断处理环境下,于是就执行正常的中断退出流程。

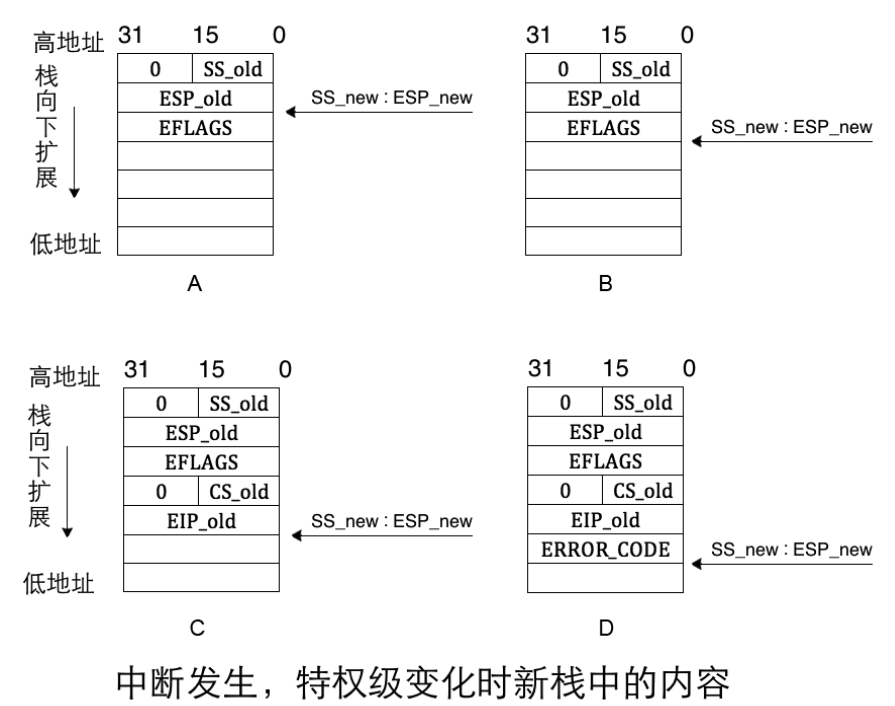

处理器根据中断向量号在中断描述符表中**找到相应的中断门描述符**,**门描述符中保存的是中断处理程序所在代码段的选择子及在段内偏移量**,处理器从该描述符中加载目标代码段选择子到代码段寄存器CS 及偏移量到指令指针寄存器EIP。当前进程被中断打断后,为了从中断返回后能继续运行该进程,**处理器自动把CS 和EIP 的当前值保存到中断处理程序使用的栈中**。不同特权级别下处理器使用不同的栈,至于中断处理程序使用的是哪个栈,要视它当时所在的特权级别,因为中断是可以在任何特权级别下发生的。

**除了要保存CS、EIP 外,还需要保存标志寄存器EFLAGS**,如果涉及到特权级变化,还要压入SS 和ESP 寄存器。

- **处理器根据中断向量号找到对应的中断描述符后,拿CPL 和中断门描述符中选择子对应的目标代码段的DPL 比对**:

- 若CPL 权限比DPL 低,即数值上CPL > DPL,这表示要向高特权级转移,需要切换到高特权级的栈。这也意味着当执行完中断处理程序后,若要正确返回到当前被中断的进程,同样需要将栈恢复为此时的旧栈。保存当前旧栈SS 和ESP 的值,TSS 中找到同目标代码段DPL 级别相同的栈加载到寄存器SS 和ESP 中。

- 在新栈中压入EFLAGS 寄存器;

- 由于要切换到目标代码段,**对于这种段间转移,要将CS 和EIP 保存到当前栈中备份**,

- 某些异常会有错误码,此错误码用于报告异常是在哪个段上发生的,错误码会紧跟在EIP 之后入栈,记作ERROR_CODE。

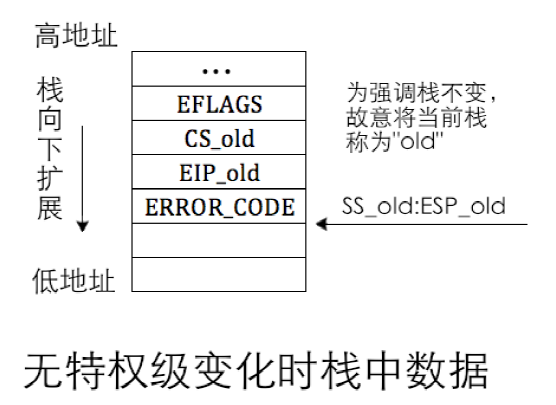

如果在第1 步中判断未涉及到特权级转移,便不会到TSS 中寻找新栈,而是继续使用当前旧栈,因此也谈不上恢复旧栈,此时中断发生时栈中数据不包括SS_old 和ESP_old。

中断返回是用`iret`指令实现的,即interrupt ret,**此指令专用于从中断处理程序返回**,iret 指令并不清楚栈中数据的正确性,它只负责把栈顶处往上的数据,每次4 字节,**一定要保证从栈顶往上的顺序是EIP、CS、EFLAGS**,根据特权级是否有变化,还有ESP、SS。若处理器发现返回后特权级会变化,还会继续将两个双字数据返回到ESP、SS,其中SS也是16 位寄存器,所以同样也是弹出32 位数据后,只将其中的低16 位加载到SS。**16 位模式下用iretw,32 位模式下用iretd**。

假设栈顶已位于EIP_old:

- 当处理器执行到iret 指令时,它知道要执行远返回,**首先需要从栈中返回被中断进程的代码段选择子CS_old 及指令指针EIP_old**。这时候它要进行特权级检查。先检查栈中CS 选择子CS_old,根据其RPL 位,即未来的CPL,判断在返回过程中是否要改变特权级。

- 栈中CS 选择子是CS_old,根据CS_old 对应的代码段的DPL 及CS_old 中的RPL 做特权级检查。**如果检查通过,随即需要更新寄存器CS 和EIP**。如果进入中断时未涉及特权级转移,此时栈指针是ESP_old,否则栈指针是ESP_new

- **将栈中保存的EFLAGS 弹出到标志寄存器EFLAGS**。如果在第1 步中判断返回后要改变特权级,此时栈指针是ESP_new,它指向栈中的ESP_old。否则进入中断时属于平级转移,用的是旧栈,此时栈指针是ESP_old,栈中已无因此次中断发生而入栈的数据,栈指针指向中断发生前的栈顶。

- 如果在第1 步中判断出返回时需要改变特权级,此时便需要**将ESP_old和SS_old 分别加载到寄存器ESP 及SS**

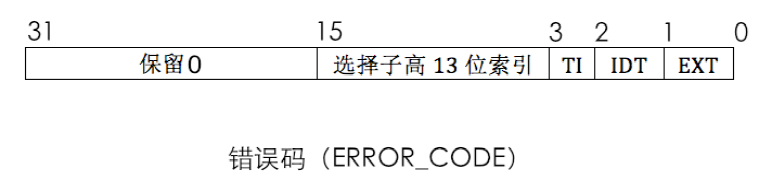

错误码的低2位不再是RPL,而**是EXT和IDT**。总之,**错误码本质上就是个描述符选择子**,通过低3 位属性来修饰此选择子指向是哪个表中的哪个描述符。

- EXT 表示EXTernal event,即外部事件,**用来指明中断源是否来自处理器外部**,如果中断源是不可屏蔽中断NMI 或外部设备,EXT 为1,否则为0。

- IDT 表示**选择子是否指向中断描述符表IDT**,IDT 位为1,则表示此选择子指向中断描述符表,否则指向全局描述符表GDT 或局部描述符表LDT。

- **TI为0时用来指明选择子是从GDT 中检索描述符,为1 时是从LDT 中检索描述符**。

中断返回时,iret 指令并不会把错误码从栈中弹出,所以在中断处理程序中需要手动用栈指针跨过错误码或将其弹出。否则栈顶处若不是EIP(EIP_old)的话,iret 返回时将会载入错误的值到后续寄存器。

## 可编程中断控制器 8259A

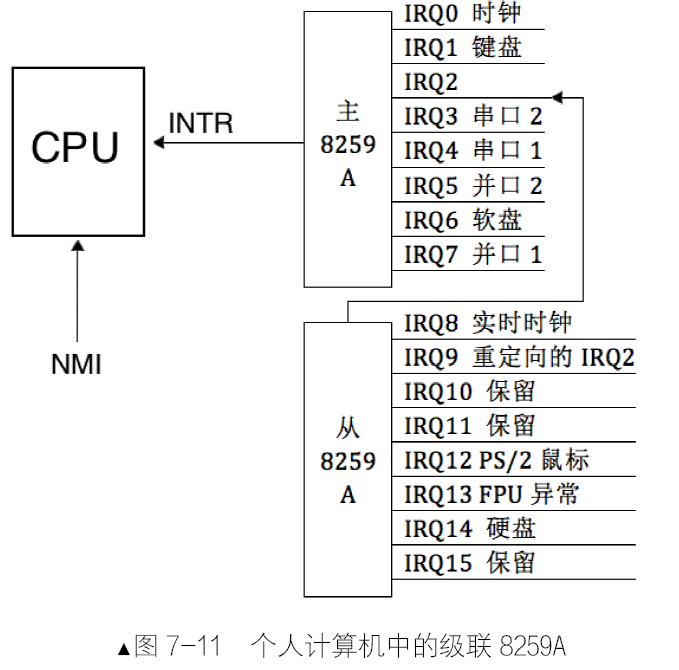

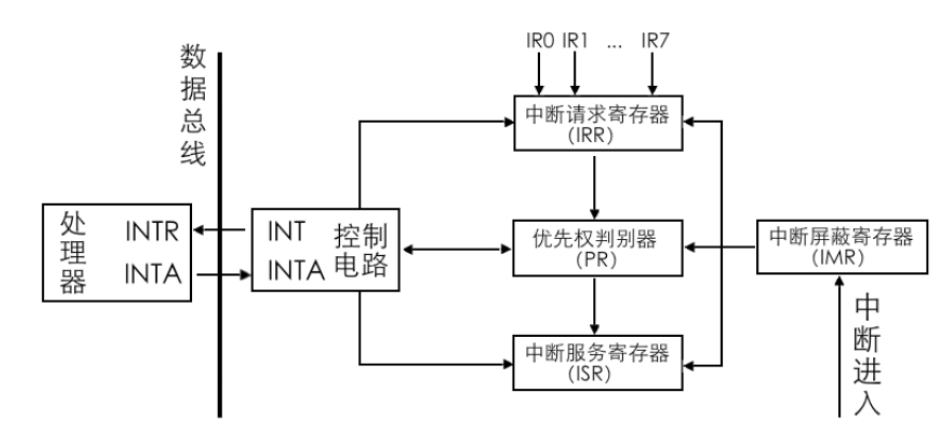

8259A 的作用是负责所有来自外设的中断。8259A 用于管理和控制可屏蔽中断,它表现在屏蔽外设中断,对它们实行优先级判决,向CPU 提供中断向量号等功能。将多个8259A级联,每一个8259A 就被称为1 片。**n 片8259A 通过级联可支持7n+1 个中断源**,级联时只能有一片8259A为主片master,其余的均为从片slave。来自从片的中断只能传递给主片,再由主片向上传递给CPU,也就是说**只有主片才会向CPU 发送INT 中断信号**。,8259A 在收到了中断后,对中断判优,将优先级最高的中断转发给CPU 处理。8259A 在收到了中断后,对中断判优,将优先级最高的中断转发给CPU 处理。

- INT:8259A 选出优先级最高的中断请求后,发信号通知CPU。

- INTA:INT Acknowledge,中断响应信号。位于8259A 中的INTA 接收来自CPU 的INTA 接口的中断响应信号。

- IMR:Interrupt Mask Register,中断屏蔽寄存器,宽度是8 位,用来屏蔽某个外设的中断。

- IRR:Interrupt Request Register,中断请求寄存器,宽度是8 位。它的作用是接受经过IMR 寄存器过滤后的中断信号并锁存,此寄存器中全是等待处理的中断,“相当于”5259A 维护的未处理中断信号队列。

- PR:Priority Resolver,优先级仲裁器。当有多个中断同时发生,或当有新的中断请求进来时,将

它与当前正在处理的中断进行比较,找出优先级更高的中断。

- ISR:In-Service Register,中断服务寄存器,宽度是8 位。当某个中断正在被处理时,保存在此寄存器中。

寄存器都是8 位,8259A 共8 个IRQ 接口,可以用8 位寄存器中的每一位代表8259A 的每个IRQ 接口。

# 内存管理系统

## makefile 简介

makefile 基本语法包括三部分,这三部分加在一起称为一组规则:

1. 目标文件是指此规则中想要生成的文件,可以是.o 结尾的目标文件,也可以是可执行文件,也可以是个伪目标,后面会介绍伪目标。

2. 依赖文件是指要生成此规则中的目标文件,需要哪些文件。通常依赖文件不是1 个,所以此处是个依赖文件的列表。

3. 命令是指此规则中要执行的动作,这些动作是指各种shell 命令,一个命令要单独占用一行,在行首必须以Tab 开头。

make 程序分别获取依赖文件和目标文件的mtime,对比依赖文件的mtime 是否比目标文件的mtime 新,就知道是否要执行规则中的命令。在Linux 中,文件分为属性和数据两部分,每个文件有三种时间,分别用于记录与文件属性和文件数据相关的时间,这三个时间分别是:

1. atime,即access time,表示访问文件数据部分时间,每次读取文件数据部分时就会更新atime,强调下,

是读取文件数据(内容)时改变atime。

2. ctime,即change time,表示文件属性或数据的改变时间,每当文件的属性或数据被修改时,就会更新ctime,也就是说ctime 同时跟踪文件属性和文件数据变化的时间。

3. mtime,即modify time,表示文件数据部分的修改时间,每次文件的数据被修改时就会更新mtime。

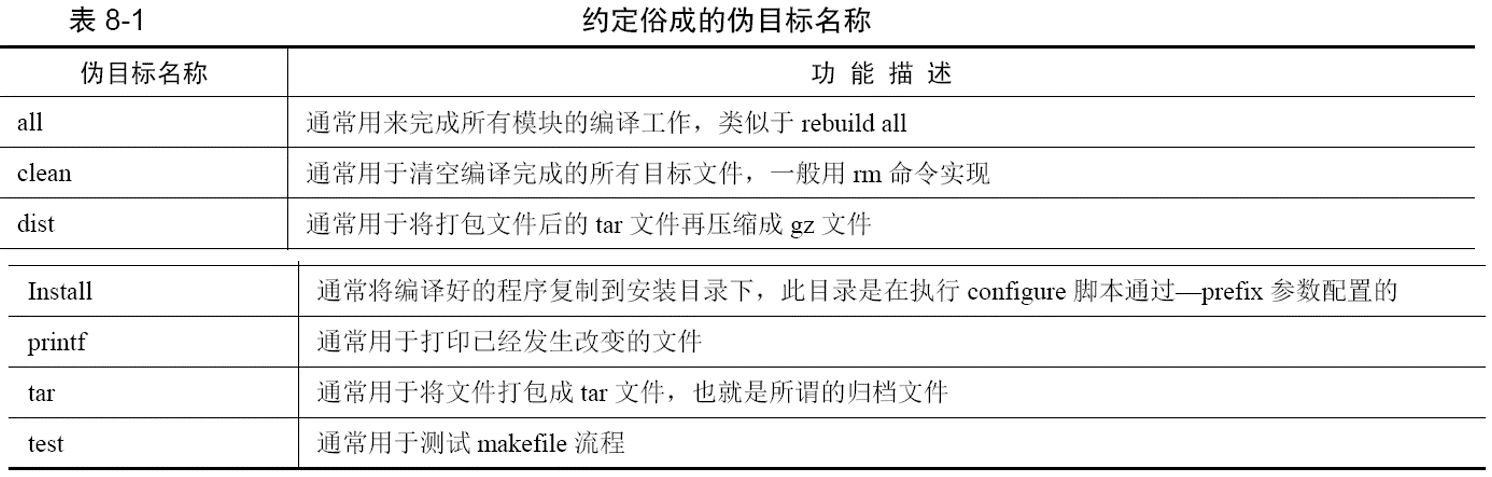

**规则中的命令并不总是被执行**,**当规则中不存在依赖文件时,这个目标文件名就称为—伪目标**。伪目标所在的规则纯粹地执行命令,只要给make 指定该伪目标名做参数,就能让伪目标规则中的命令直接执行。

@echo “test ok”test2.o:test2.c1

2

3

4

5

6

7

8由于makefile 中仅有这一个目标all,所以如果此时执行make all 或make,程序只会输出test ok。为了避免伪目标和真实目标文件同名的情况,可以**用关键字“.PHONY”来修饰伪目标**,格式为`.PHONY:伪目标名`,

伪目标的命名并没有固定的规则,用户可以按照自己的意愿定义成自己喜欢的名字。

在makefile 中的目标,是以递归的方式逐层向上查找目标的,就好像是从迷宫的出口往回找来时的路一样,由果寻因,逐个向上推导。

写个makefile:

gcc -c -o test2.o test2.c

test1.o:test1.c

gcc -c -o test1.o test1.c

test.bin:test1.o test2.o

gcc -o test.bin test1.o test2.o

all:test.bin

@echo “compile done”%.o:%.c1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27第1~4 行都是在准备.o 目标文件,第5~6 行是将.o 文件生成二进制文件test.bin。第7 行的目标all 是为了编译test.bin:

1. make 未找到文件GNUmakefile,便继续找文件makefile,找到后,根据命令的参数all,从文件中找到all 所在的规则。

2. make 发现all 的依赖文件test.bin 不存在,于是就去找以test.bin 为目标文件的规则。

3. 第5 行终于找到了test.bin 的规则,但make 发现,test.bin 的依赖文件test1.o 和test2.o 都不存在,于是先去找以test1.o 为目标文件的规则。

4. 同样经过千辛万苦,在第3 行找到了生成test1.o 的规则,但它的依赖文件是test1.c,由于test1.o本身不存在,所以不用再查看test1.c 的mtime,直接执行此规则的命令,即第4 行的`gcc -c -o test1.o test1.c`,用test1.c 来编译test1.o。

5. 生成test1.o 后,执行流程返回到test.bin 所在的规则,即第5 行,此时make 发现test2.o 也不存在,于是继续递归查找目标test2.o。

6. 同样,在第1 行发现test2.o 所在的规则,由于test2.o 本身不存在,也不再检查其所依赖文件test2.c的mtime,直接执行规则中的编译命令`gcc -c -o test2.o test2.c` 生成test2.o。

7. 生成test2.o 后,此时执行流程又回到了第5 行,make 发现两个依赖文件test1.o 和test2.o 都准备齐了,于是执行本规则的命令,即第6 行的`gcc -o test.bin test1.o test2.o`,将这两个目标文件生成可执行文件test.bin。

8. test.bin 终于生成了,此时回到了第2 步目标all 所在的规则,于是执行所在规则中的命令`@echo"compile done"`,打印字符串表示编译完成。

可以在makefile 中定义变量。变量定义的格式:`变量名=值(字符串)`,多个值之间用空格分开。make 程序在处理时会用空格将值打散,然后遍历每一个值。另外,值仅支持字符串类型,即使是数字也被当作字符串来处理。变量引用的格式:`$(变量名)`。这样,每次引用变量时,变量名就会被其值(字符串)替换。

makefile 中另一个必须的功能是注释,如同shell 脚本一样,makefile 中用#来单行注释,只要各行第一个非空字符(除空格、tab)是’#’,本行内容便被注释了。如果在行尾是反斜杠字符’\’,这表示下一行也应被处理为当前行,所以,连同下一行也被注释掉。

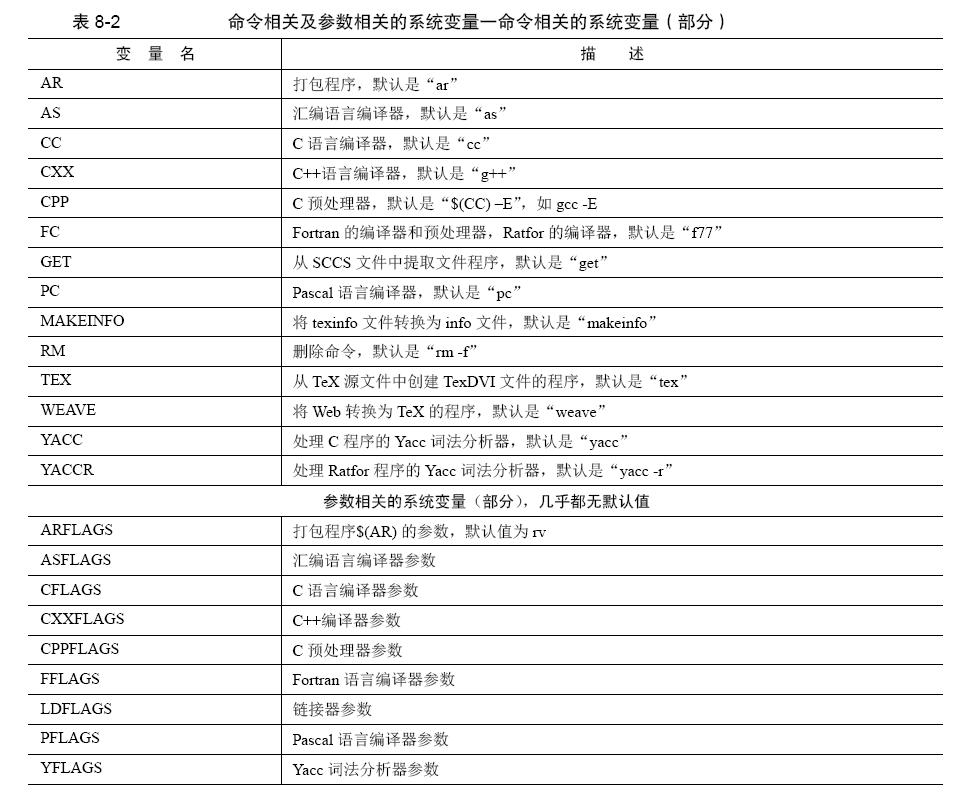

下面列出了常见的部分语言程序的隐含规则。

- C 程序:“x.o”的生成依赖于“x.c”,生成x.o 的命令为:`$(CC) -c $(CPPFLAGS) $(CFLAGS)`。

- C++程序:“x.o”的生成依赖于“x.cc”或者“x.C”,生成x.o 的命令为:`$(CXX) -c $(CPPFLAGS) $(CFLAGS)`

make 还支持一种**自动化变量**,此变量**代表一组文件名,无论是目标文件名,还是依赖文件名,此变量值的范围属于这组文件名集合**,也就是说,自动化变量相当于对文件名集合循环遍历一遍。对于不同的文件名集合,有不同的自动化变量名,下面列举一些。

- `$@`,表示**规则中的目标文件名集合**,如果存在多个目标文件,`$@`则表示其中每一个文件名。